GitHub Copilot może wygenerować setki przypadków testowych w ciągu kilku minut — kontrolowane eksperymenty pokazują, że programiści kończą pracę o 35% szybciej — ale jest jeden haczyk: te generowane przez AI testy są tak przydatne, jak Twoja zdolność do śledzenia ich, organizowania i tworzenia połączeń z resztą cyklu pracy.

W tym przewodniku opisano, jak używać GitHub Copilot do szybkiego tworzenia szkieletów przypadków testowych, a następnie pokazano, jak efektywnie nimi zarządzać, aby nie stały się kolejną stertą porzuconych plików z kodem.

Dlaczego testy jednostkowe mają znaczenie dla jakości oprogramowania

Pisanie testów jednostkowych jest często postrzegane jako żmudne zadanie, ale pomijanie ich prowadzi do powstania niestabilnego kodu.

Gdy nie masz zabezpieczenia w postaci testów, nawet niewielka refaktoryzacja może spowodować pojawienie się błędów regresji — błędów, które zakłócają istniejącą funkcjonalność i podważają zaufanie użytkowników. Badania IBM pokazują, że naprawa błędów wykrytych po wydaniu produktu kosztuje 15 razy więcej.

Powoduje to powstanie cyklu, w którym programiści unikają ulepszania kodu, ponieważ obawiają się, że coś może się zepsuć, co prowadzi do narastania długu technicznego.

Generowanie testów wspomagane przez AI pomaga przełamać ten cykl — obecnie 89% organizacji testuje lub wdraża generatywne cykle pracy oparte na AI w zakresie inżynierii jakości i testowania. Korzystając z narzędzia takiego jak GitHub Copilot do tworzenia szkieletu przypadków testowych, możesz skupić się na tym, co najważniejsze: projektowaniu znaczących testów i udoskonalaniu pokrycia przypadków skrajnych.

Oto dlaczego konsekwentne testowanie jednostkowe się opłaca:

- Zapobieganie regresji: Dobre testy działają jak bariera ochronna, zapewniając, że nowe funkcje lub poprawki błędów nie spowodują niezamierzonego uszkodzenia innych elementów.

- Dokumentacja na żywo: w przeciwieństwie do statycznej dokumentacji, która może stać się nieaktualna, testy jednostkowe służą jako wykonalne przykłady tego, jak powinien zachowywać się kod.

- Pewność refaktoryzacji: Dzięki kompleksowemu pokryciu testami możesz refaktoryzować i ulepszać swój kod, mając pewność, że natychmiast dowiesz się, czy zmiana ma niezamierzone konsekwencje.

Aby lepiej zrozumieć, w jaki sposób agenci AI zmieniają świat kodowania, wykraczając poza samo generowanie testów, obejrzyj ten przegląd asystentów kodowania opartych na AI i ich możliwości:

Jak ustawić GitHub Copilot do generowania przypadków testowych

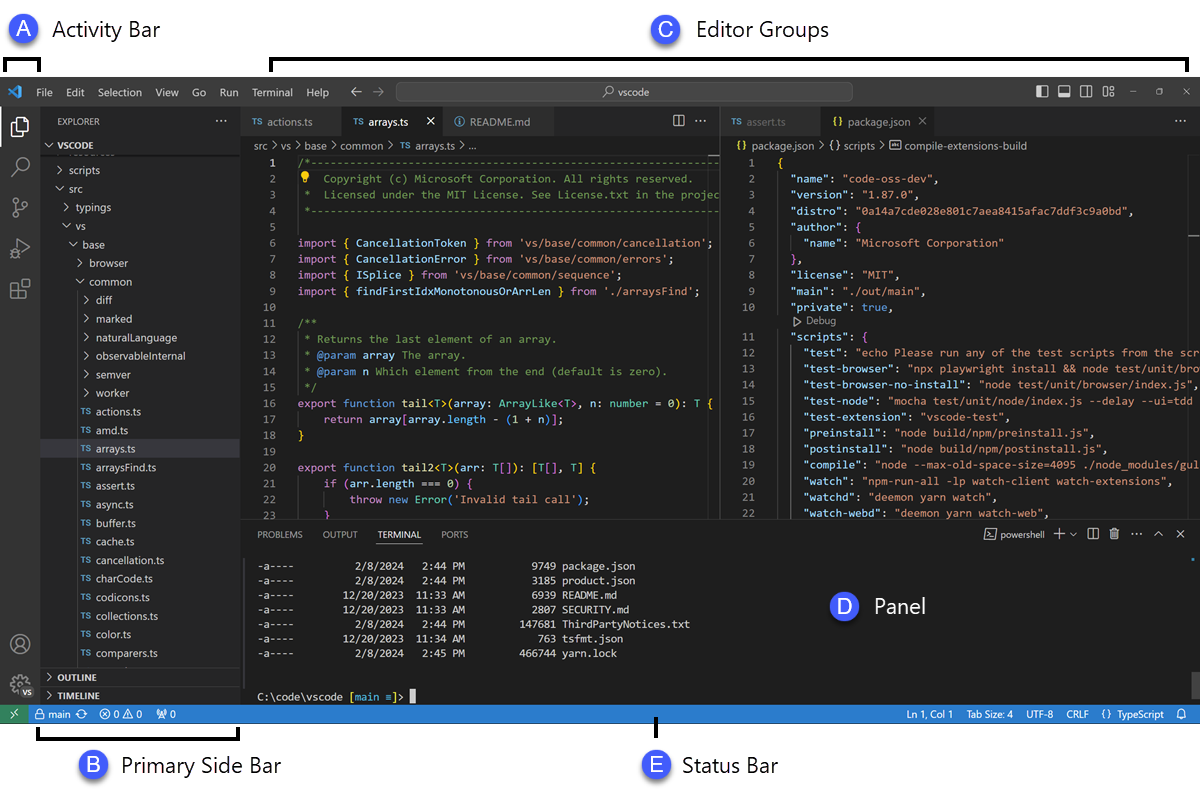

Zanim zaczniesz generować testy, musisz zainstalować i skonfigurować GitHub Copilot w swoim zintegrowanym środowisku programistycznym (IDE). Proces ustawień jest prosty i zajmuje tylko kilka minut, ale prawidłowe wykonanie zapewnia Copilotowi kontekst potrzebny do dostarczania odpowiednich sugestii.

Przed rozpoczęciem potrzebujesz kilku rzeczy:

- Aktywna subskrypcja GitHub Copilot (Indywidualna, Business lub Enterprise)

- Środowisko IDE z wsparciem, takie jak VS Code, JetBrains IDE (np. IntelliJ lub PyCharm) lub Neovim.

- Framework testowy, taki jak pytest, Jest lub JUnit, już zainstalowany w projekcie.

Zainstaluj rozszerzenie GitHub Copilot.

Najpierw musisz zainstalować rozszerzenie Copilot w swoim IDE. Proces ten jest podobny w większości redaktorów, które oferują wsparcie.

- Otwórz sklep z rozszerzeniami swojego środowiska IDE. W VS Code jest to ikona Rozszerzenia na pasku bocznym; w środowiskach IDE JetBrains znajdziesz ją w Ustawieniach → Wtyczki.

- Wyszukaj „GitHub Copilot”.

- Zainstaluj zarówno główne rozszerzenie GitHub Copilot, jak i rozszerzenie GitHub Copilot Chat, aby w pełni korzystać z możliwości programu.

- Zostaniesz poproszony o ponowne uruchomienie środowiska IDE, aby instalacja była zakończona.

Po ponownym uruchomieniu zostaniesz poproszony o zalogowanie się na swoje konto GitHub. Ten krok służy do uwierzytelnienia Twojej subskrypcji. Po zalogowaniu się w pasku statusu IDE powinna pojawić się mała ikona Copilot, potwierdzająca, że narzędzie jest aktywne i gotowe do użycia.

Skonfiguruj swoją strukturę testową

GitHub Copilot generuje bardziej trafne testy, gdy zrozumie specyfikę ustawień testowych Twojego projektu. Robi to, analizując istniejące pliki testowe i konfigurację, aby poznać i dopasować się do wzorców stosowanych przez Twój zespół.

- W przypadku projektów Python korzystających z pytest: Upewnij się, że masz zainstalowany pytest (pip install pytest). Jeśli masz plik conftest.py lub jakiekolwiek istniejące pliki testowe (nawet jeden), Copilot wykorzysta je jako punkt odniesienia do generowania nowych testów.

- W przypadku projektów JavaScript/TypeScript korzystających z Jest: Copilot wyszuka plik jest. config. js oraz zależność Jest w pliku package. json, aby zrozumieć ustawienia.

- W przypadku projektów Java korzystających z JUnit: upewnij się, że zależności JUnit są poprawnie zdefiniowane w pliku pom.xml (dla Maven) lub build.gradle (dla Gradle).

Posiadanie co najmniej jednego dobrze napisanego pliku testowego w projekcie jest jednym z najlepszych sposobów na poprowadzenie Copilota. Copilot przejmie Twoje konwencje nazewnictwa, style asercji i sposób strukturyzowania testów, co doprowadzi do uzyskania bardziej spójnych wyników.

Zintegruj Copilot ze swoim IDE

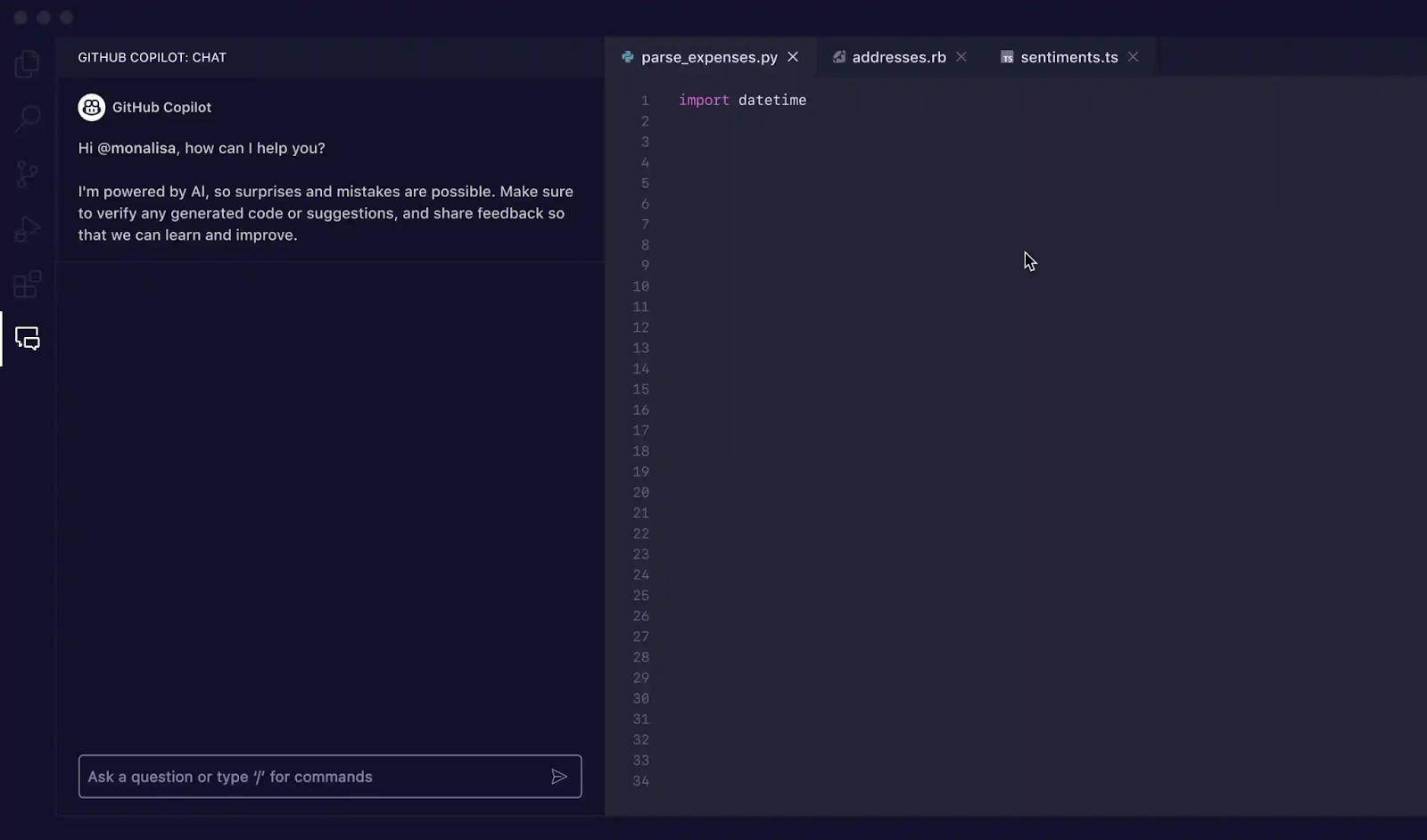

Po zainstalowaniu rozszerzeń nadszedł czas, aby zapoznać się z interfejsem Copilot w swoim IDE. Głównym sposobem interakcji z nim w celu generowania testów jest panel Copilot Chat.

Okno czatu można otworzyć za pomocą skrótu klawiaturowego Ctrl+Cmd+I (na komputerach Mac) lub Ctrl+Alt+I (w systemach Windows/Linux) albo klikając ikonę Copilot Chat na pasku aktywności środowiska IDE. Ten widok czatu jest centrum dowodzenia służącym do generowania testów.

Copilot rozpoznaje kontekst, co oznacza, że odczytuje aktualnie otwarte pliki, strukturę plików projektu oraz wybrany kod. Aby uzyskać najlepsze wyniki, zawsze otwieraj i zapewnij widoczność w redaktorze plikowi zawierającemu funkcję lub klasę, którą chcesz przetestować.

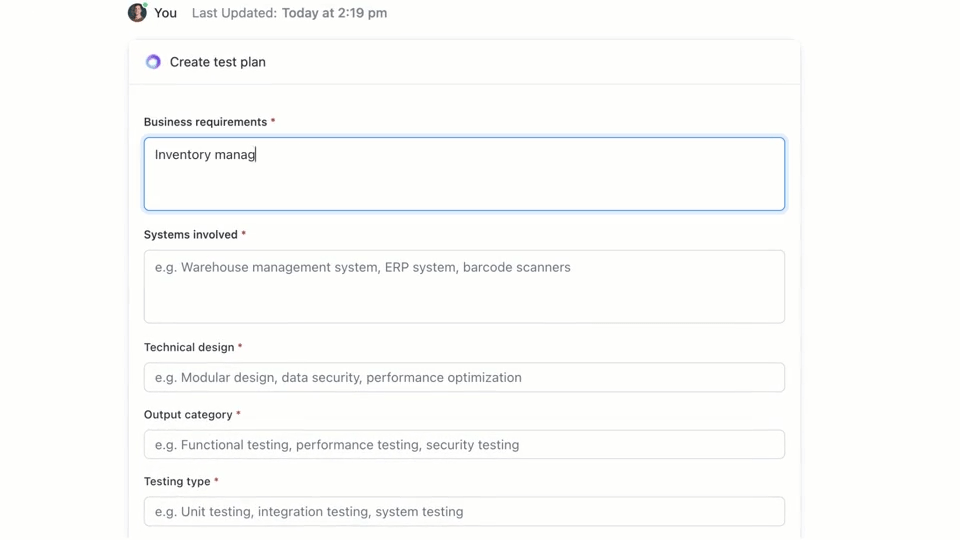

🌟 ClickUp Brain, kontekstowa AI zintegrowana z ClickUp, może szybko stworzyć dla Ciebie plan testów. Wypróbuj już dziś.

Jak pisać przypadki testowe za pomocą GitHub Copilot

GitHub Copilot oferuje trzy podstawowe sposoby generowania przypadków testowych: za pomocą panelu czatu z szczegółowymi podpowiedziami, za pomocą szybkich poleceń / oraz za pomocą inteligentnych akcji bezpośrednio w redaktorze. Każda z tych metod jest dostosowana do różnych sytuacji w ramach cyklu pracy, w zależności od tego, czy potrzebujesz szybkości, czy precyzyjnej kontroli.

Korzystaj z podpowiedzi Copilot Chat

Korzystanie z Copilot Chat z konkretną podpowiedzią jest najskuteczniejszą metodą generowania przypadków testowych. Najlepiej sprawdza się w przypadku złożonych funkcji lub klas, gdzie trzeba zdefiniować konkretne scenariusze, symulować zależności lub obsługiwać trudne przypadki graniczne.

Oto podstawowy cykl pracy:

- Otwórz panel czatu Copilot.

- W redaktorze zaznacz funkcję, klasę lub blok kodu, który chcesz przetestować.

- Napisz jasną, konkretną podpowiedź w panelu czatu, opisując potrzebne testy.

Na przykład możesz napisać takie podpowiedzi:

- „Napisz testy jednostkowe dla wybranej funkcji, obejmujące ścieżkę pomyślną, przypadki skrajne, takie jak puste dane wejściowe, oraz obsługę błędów dla nieprawidłowych danych”.

- „Wygeneruj testy pytest dla tej klasy i utwórz elementy stałe, aby symulować połączenie z bazą danych”.

- „Utwórz testy Jest dla tego komponentu React, które symulują kliknięcia użytkownika i weryfikują zmiany stanu”.

Im więcej szczegółów podasz w podpowiedzi, tym lepsze będą wygenerowane testy.

Używaj poleceń /, takich jak /tests.

Jeśli potrzebujesz szybko wygenerować testy i nie potrzebujesz bardzo szczegółowych scenariuszy, polecenie /tests slash będzie Twoim najlepszym przyjacielem. To najszybszy sposób na uzyskanie solidnej podstawy pokrycia testowego.

Aby z niego skorzystać:

- Otwórz panel czatu Copilot.

- Wybierz kod, który chcesz przetestować w redaktorze.

- W oknie czatu po prostu wpisz /tests i naciśnij Enter.

Copilot natychmiast wygeneruje zestaw testów jednostkowych w oparciu o strukturę i logikę wybranego kodu. Spróbuje objąć podstawową funkcjonalność i niektóre typowe dane wejściowe. Jeśli wyniki nie są do końca poprawne, zawsze można je udoskonalić, wpisując podpowiedź uzupełniającą, np. „Dodaj teraz test dla przypadku, gdy dane wejściowe są puste”.

Korzystaj z inteligentnych akcji redaktora

W sytuacjach, gdy chcesz wygenerować testy bez przerywania przepływu, możesz skorzystać z inteligentnych akcji bezpośrednio z redaktora kodu. Dzięki temu nie musisz przełączać się do panelu czatu.

- Zaznacz funkcję lub klasę, którą chcesz przetestować.

- Kliknij prawym przyciskiem myszy na zaznaczeniu, aby otworzyć menu kontekstowe.

- Przejdź do opcji Generuj kod w menu kontekstowym i wybierz Generuj testy.

Copilot wygeneruje testy i zazwyczaj wyświetli je w nowej, tymczasowej zakładce redaktora. Możesz tam przejrzeć kod, a następnie zdecydować się na utworzenie nowego pliku testowego lub dołączenie testów do istniejącego pliku.

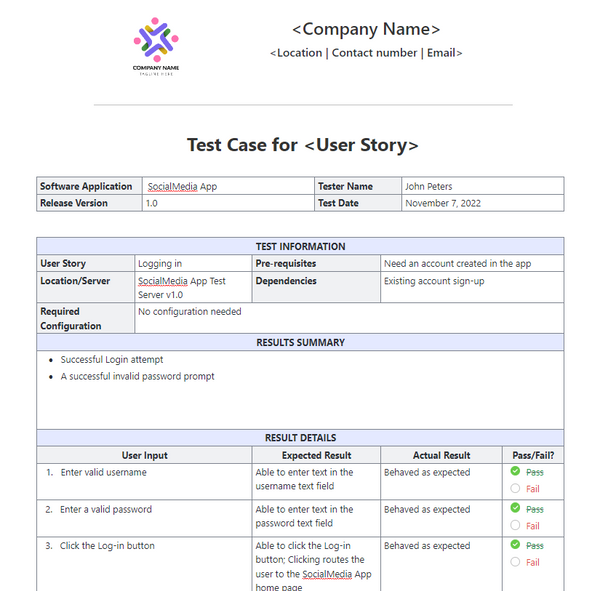

📚 Przeczytaj również: Szablony przypadków testowych do testowania oprogramowania

GitHub Copilot podsuwa podpowiedź podczas generowania przypadków testowych

Twoje podpowiedzi są kierownicą dla GitHub Copilot. Ogólne podpowiedzi prowadzą do ogólnych testów, ale dobrze skonstruowane podpowiedzi, które dają AI konkretne instrukcje, mają dla niej wyniki w postaci kompleksowych i użytecznych przypadków testowych. Kluczem jest poinformowanie Copilot nie tylko co ma testować, ale także jak ma to testować.

Oto kilka szablonów, które można dostosować do różnych scenariuszy:

| Scenariusz | Szablon podpowiedzi |

|---|---|

| Podstawowy test jednostkowy | „Napisz testy jednostkowe dla funkcji [nazwa_funkcji] przy użyciu [framework]. Upewnij się, że uwzględniasz normalne dane wejściowe, wartości graniczne, takie jak zero lub liczby ujemne, oraz nieprawidłowe dane wejściowe, takie jak null lub undefined”. |

| Klasa z zależnościami | „Wygeneruj testy dla klasy [ClassName]. Użyj [mocking_library], aby utworzyć makiety dla zależności [DependencyName] i [AnotherDependencyName]”. |

| Funkcje asynchroniczne | „Utwórz testy dla tej funkcji asynchronicznej. Uwzględnij testy dla przypadku powodzenia, przypadku odrzucenia obietnicy oraz scenariusza przekroczenia limitu czasu żądania”. |

| Punkt końcowy API | „Napisz testy integracyjne dla tego punktu końcowego API. Uwzględnij powodzenie żądania GET, żądanie POST z prawidłowymi danymi, żądanie z brakującym tokenem uwierzytelniającym oraz żądanie z nieprawidłowymi danymi, które powinno zwrócić błąd 400”. |

| Walidacja danych | „Wygeneruj testy dla tej funkcji walidacji. Dodaj test dla prawidłowego obiektu, a następnie dodaj osobne testy dla każdego błędu reguły walidacji, aby upewnić się, że zwracane są prawidłowe komunikaty o błędach”. |

Wskazówki dotyczące ulepszania podpowiedzi:

- Określ jasno framework: W każdym przypadku dokonuj wzmianki o frameworku testowym (np. pytest, Jest, JUnit), aby zapewnić poprawność składni.

- Określ swoje cele dotyczące pokrycia: Wykorzystaj zaawansowane techniki podpowiedzi AI, aby poprosić o określone rodzaje pokrycia, takie jak „przypadki skrajne”, „obsługa błędów” lub „testowanie graniczne”.

- Odwołaj się do własnych wzorców: jeśli masz dobry plik przykładowy, możesz polecić Copilotowi „postępować zgodnie ze wzorcem testowania w tests/test_user. py”.

- Żądaj konkretnych asercji: zamiast pozwalać Copilotowi zgadywać, możesz poprosić go o „stwierdzenie, że dla nieprawidłowego wprowadzenia danych zostanie wygenerowany błąd ValueError”.

📚 Przeczytaj również: Najlepsze narzędzia do zapewnienia jakości w testowaniu oprogramowania

Przykłady generowania testów za pomocą GitHub Copilot

Oto jak to działa w praktyce.

Generuj testy jednostkowe w języku Python

Wyobraź sobie, że masz funkcję w języku Python, która oblicza całkowitą cenę elementów w koszyku, uwzględniając rabat.

Próbna funkcja do przetestowania:

Podpowiedź użyta: „Napisz testy pytest dla calculate_total. Uwzględnij pustą listę elementów, pojedynczy element, wiele elementów, zastosowanie rabatu, rabat 0%, rabat 100% oraz nieprawidłowy procent rabatu, który powinien wywołać błąd ValueError”.

Wygenerowane wyniki testów:

Copilot poprawnie użył pytest. raises do sprawdzenia wyjątku i uwzględnił główne scenariusze. Nadal możesz chcieć dodać testy dla ujemnych cen lub ilości jako ręczne udoskonalenie.

Generuj testy jednostkowe w TypeScript za pomocą Jest

Teraz wypróbujmy funkcję TypeScript, która formatuje nazwę użytkownika.

Próbna funkcja do przetestowania:

Podpowiedź użyta: „Wygeneruj testy Jest dla formatDisplayName. Uwzględnij użytkownika z imieniem i nazwiskiem, użytkownika z pseudonimem, użytkownika z pustym imieniem oraz użytkownika posiadającego tylko pseudonim”.

Wygenerowane wyniki testów:

Wygenerowane testy wykorzystują standardowe bloki describe i it z Jest i poprawnie obsługują różne ścieżki logiczne.

Najlepsze praktyki dotyczące generowania testów w GitHub Copilot

Wykorzystanie Copilot do generowania testów znacznie zwiększa wydajność, ale wymaga starannego nadzoru w celu zapewnienia jakości.

- Sprawdź każdy test: To złota zasada. Copilot nie rozumie logiki Twojej firmy, więc może wygenerować test, który przejdzie, ale sprawdzi coś niewłaściwego. Zawsze czytaj wygenerowany kod i zadaj sobie pytanie: „Czy to rzeczywiście weryfikuje prawidłowe działanie?”.

- Ręcznie sprawdź pokrycie przypadków skrajnych: Copilot dobrze radzi sobie z wykrywaniem typowych przypadków skrajnych, takich jak puste dane wejściowe lub puste ciągi znaków, ale może pominąć przypadki specyficzne dla danej dziedziny. Czy w przypadku aplikacji e-commerce przetestowano, co się stanie, gdy suma w koszyku będzie dokładnie równa minimalnej kwocie wymaganej do bezpłatnej wysyłki? Nadal jesteś ekspertem

- Zachowaj spójne konwencje nazewnictwa: nazwy testów generowane przez AI mogą być czasami ogólnikowe. Poświęć chwilę, aby zmienić ich nazwy zgodnie ze stylem Twojego zespołu. Opisowa nazwa, taka jak test_login_fails_with_incorrect_password, jest znacznie bardziej przydatna niż test_login_2.

- Natychmiastowe uruchamianie testów: Nie pozwól, aby wygenerowane testy pozostawały niewykorzystane. Uruchom je od razu, aby wychwycić wszelkie błędy składniowe lub oczywiste niepowodzenia przed commitowaniem kodu.

- Zintegruj z CI/CD: Dodaj wygenerowane testy do swojego procesu ciągłej integracji. Testy uruchamiane wyłącznie lokalnie mają ograniczoną wartość.

- Uważaj na niestabilne testy: Czasami AI może generować testy, które są „niestabilne” — czasami przechodzą, a czasami nie. Często zdarza się to w przypadku testów obejmujących sygnatury czasowe lub dane losowe. Zawsze zastępuj je deterministycznymi, przewidywalnymi wartościami.

📮ClickUp Insight: Nasze badania pokazują, że chociaż 34% użytkowników korzysta z systemów AI z pełnym zaufaniem, nieco większa grupa (38%) stosuje podejście „ufaj, ale weryfikuj”. Samodzielne narzędzie, które nie jest zaznajomione z kontekstem Twojej pracy, często wiąże się z większym ryzykiem generowania niedokładnych lub niezadowalających odpowiedzi.

Właśnie dlatego stworzyliśmy ClickUp Brain, sztuczną inteligencję, która łączy zarządzanie projektami, zarządzanie wiedzą i współpracę w całym obszarze roboczym oraz zintegrowane narzędzia innych firm. Uzyskaj kontekstowe odpowiedzi bez konieczności przełączania się między aplikacjami i zwiększ wydajność pracy 2–3-krotnie, tak jak nasi klienci z Seequent.

Ograniczenia korzystania z GitHub Copilot do generowania przypadków testowych

Chociaż GitHub Copilot znacznie zwiększa wydajność, nie jest to panaceum na testowanie oprogramowania. Znajomość jego limitów jest kluczem do skutecznego korzystania z niego i uniknięcia typowych pułapek. Jest to „drugi pilot”, a nie pilot — to Ty nadal odpowiadasz za plan lotu.

Największym ograniczeniem jest brak kontekstu biznesowego. Copilot analizuje strukturę kodu, ale nie ma pojęcia, do czego faktycznie służy aplikacja dla użytkowników. Nie może wiedzieć, że użytkownik „premium” powinien mieć dostęp do określonych funkcji, a użytkownik „podstawowy” nie, chyba że logika ta jest wyraźnie zaznaczona w odczytywanym kodzie.

Oto kilka innych kluczowych ograniczeń, o których należy pamiętać:

- Może pomijać krytyczne, specyficzne dla danej dziedziny przypadki skrajne: Copilot świetnie radzi sobie z wyszukiwaniem ogólnych przypadków skrajnych, ale nie zna tych dziwnych, specyficznych dla Twojej branży, takich jak obliczenia finansowe, które wymagają innego traktowania lat przestępnych.

- Nie ma dostępu do systemów zewnętrznych: Copilot nie może generować znaczących testów integracyjnych dla bazy danych lub API stron trzecich, ponieważ nie może się z nimi połączyć. Może stworzyć szkielet kodu, ale szczegóły trzeba będzie uzupełnić samodzielnie.

- Może to dać fałszywe poczucie pewności: Widok 100% pokrycia testowego może sprawiać ogromną satysfakcję, ale jeśli testy sprawdzają niewłaściwe rzeczy, liczba ta nie ma żadnego znaczenia. Dlatego tak ważna jest weryfikacja przez człowieka.

- Limity okna kontekstowego: Bardzo duże pliki lub złożone hierarchie klas mogą przekroczyć okno kontekstowe Copilot, co spowoduje wyświetlenie niekompletnych lub ogólnych sugestii jako wynik.

📚 Przeczytaj również: Jak korzystać z GitHub Copilot do tworzenia oprogramowania backendowego

Jak tworzyć przypadki testowe i zarządzać nimi w ClickUp

Generowanie przypadków testowych za pomocą GitHub Copilot to tylko połowa cyklu pracy. Po utworzeniu testów zespoły nadal muszą je śledzić, połączyć z wymaganiami i zarządzać ich wykonywaniem w ramach sprintów i wydań.

ClickUp zapewnia scentralizowane miejsce pracy, w którym przypadki testowe generowane przez sztuczną inteligencję mogą współistnieć z zadaniami programistycznymi, błędami i planami sprintów — dzięki czemu testowanie nie pozostaje uwięzione w poszczególnych środowiskach IDE.

ClickUp działa jako zintegrowany obszar roboczy oparty na sztucznej inteligencji, łącząc zarządzanie projektami, dokumentację i komunikację zespołu w jednym systemie. Dla zespołów programistów oznacza to, że zarządzanie przypadkami testowymi nie wymaga już oddzielnego narzędzia ani arkusza kalkulacyjnego.

Testy, wymagania, pull requesty i dyskusje dotyczące wydania pozostają ze sobą połączone, co ogranicza rozproszenie kontekstu i sprawia, że kontrola jakości staje się kluczowym elementem cyklu pracy nad oprogramowaniem.

Szablon przypadku testowego ClickUp został zaprojektowany, aby pomóc Ci śledzić postępy przypadków testowych. Ułatwia on:

- Przejrzyj wyniki testów i podejmuj decyzje dotyczące poprawek błędów w oparciu o dane.

- Opracuj niestandardowe plany testów dla każdego projektu.

- Organizuj i ustalaj priorytety przypadków testowych, aby uzyskać maksymalną wydajność.

Zacznij od utworzenia dedykowanej listy ClickUp, która będzie służyć jako repozytorium przypadków testowych. Każdy przypadek testowy, niezależnie od tego, czy został wygenerowany przez AI, czy napisany ręcznie, staje się zadaniem.

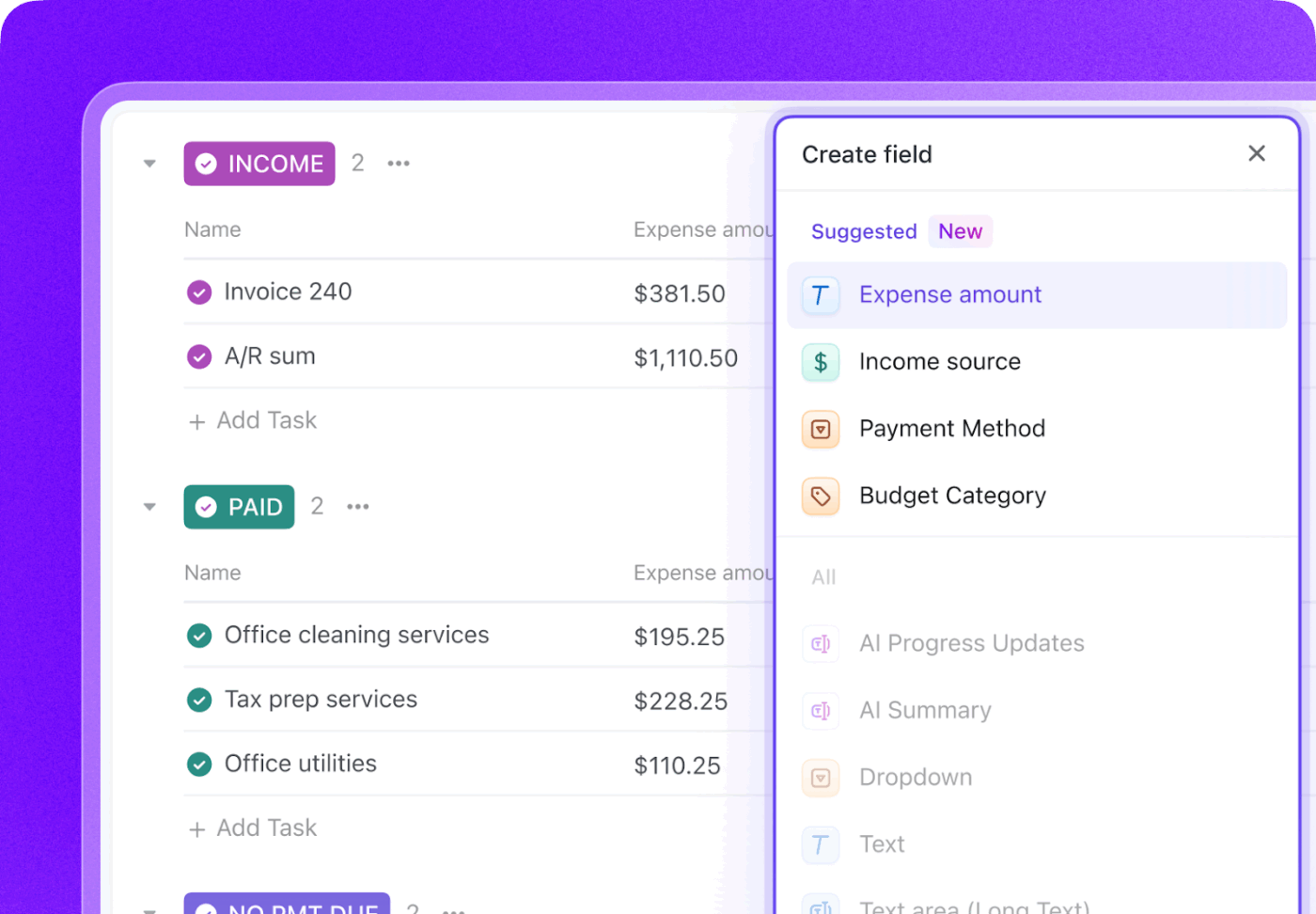

Wzbogać każdy przypadek testowy o kluczowe metadane, korzystając z pól niestandardowych ClickUp, aby prowadzić śledzenie dokładnie tego, co jest ważne dla Twojego zespołu.

- Typ testu: lista rozwijana dla testów jednostkowych, integracyjnych, kompleksowych lub ręcznych

- Status automatyzacji: status pokazujący, czy test jest zautomatyzowany, czy nie.

- Priorytet: wysoki, średni lub niski

- Data ostatniego uruchomienia: pole daty służące do śledzenia, kiedy test został ostatnio wykonany.

Śledź cały cykl życia testów za pomocą niestandardowych statusów ClickUp, tworząc cykl pracy, który przenosi testy ze statusu „Nie przeprowadzono” do statusu „Zaliczono”, „Nie zaliczono” lub „Zablokowano”. Dzięki temu wszyscy członkowie zespołu, od programistów po menedżerów produktu, mają natychmiastową widoczność na temat postępów w wykonywaniu testów.

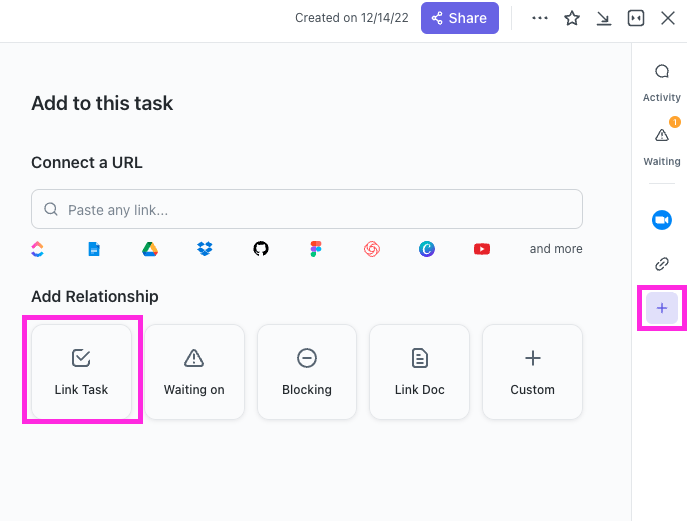

Dzięki ClickUp Relationships zadania związane z przypadkami testowymi można bezpośrednio powiązać z historiami użytkowników, funkcjami lub epicami. Jeśli test zakończy się niepowodzeniem, możesz utworzyć zadanie zgłoszenia błędu i powiązać je zarówno z nieudanym testem, jak i oryginalną historią, tworząc kompletny łańcuch identyfikowalności.

Sporządź raporty o błędach w kilka sekund, wskazując ClickUp Brain nieudane zadanie testowe. Ponieważ ma on dostęp do kontekstu całego obszaru roboczego, może pobrać szczegóły z połączonej historii użytkownika i samego przypadku testowego.

🌟 Szablon raportu testowego ClickUp pozwala szybciej tworzyć raporty, zapewniając jednocześnie identyfikację i rozwiązanie problemów wymagających poprawy.

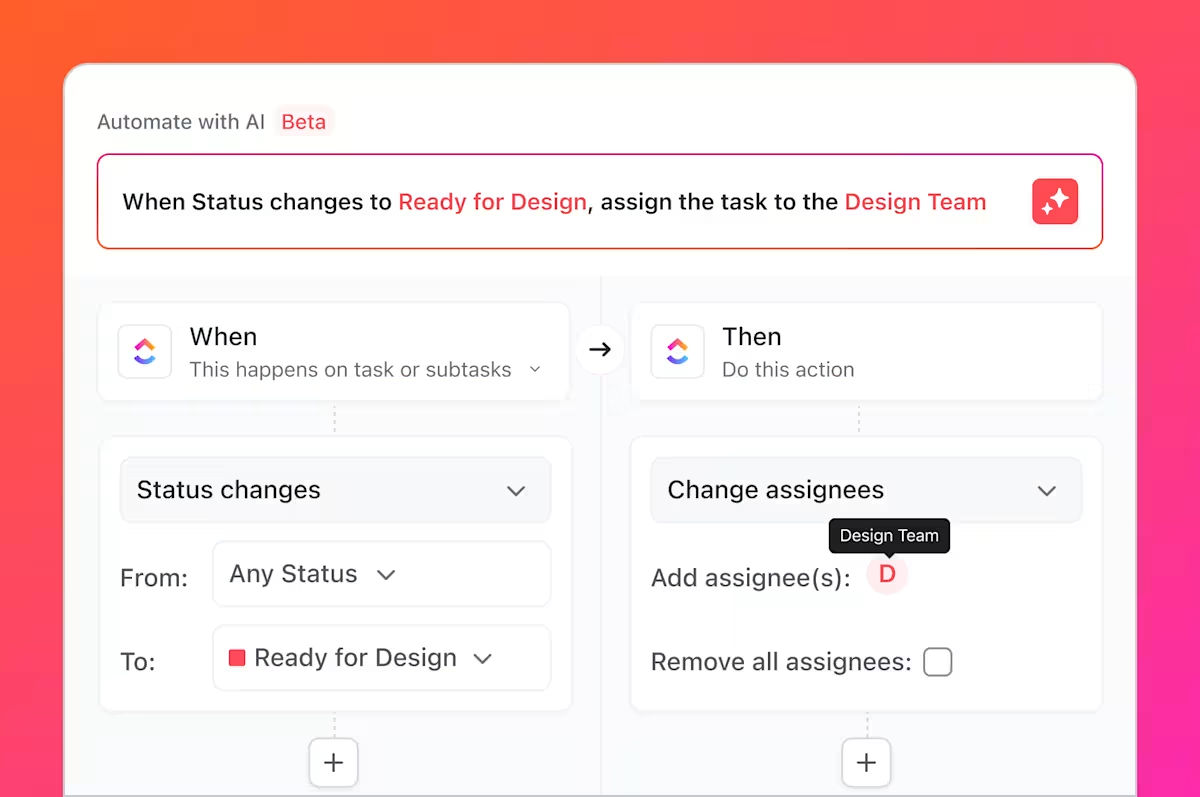

Ale to nie wszystko, co możesz zrobić. Pamiętasz te wszystkie żmudne zadania, o których mówiliśmy, nudne i powtarzalne czynności, które zawsze wiążą się z testowaniem? Możesz je zautomatyzować za pomocą automatyzacji ClickUp.

Skonfiguruj reguły, takie jak „Gdy status przypadku testowego zostanie zmieniony na Niepowodzenie, automatycznie utwórz nowe zadanie na liście błędów i przypisz je głównemu programiście”.

Dzięki integracji GitHub z ClickUp zadania związane z przypadkami testowymi można połączone z commitami i pull requestami. Po scaleniu zmian w kodzie połączone zadania testowe są automatycznie aktualizowane, dzięki czemu pracownicy działu kontroli jakości, programiści i menedżerowie ds. wydawania nowych wersji mają aktualne informacje na temat zmian i elementów wymagających ponownego przetestowania.

Panele ClickUp pozwalają na śledzenie postępów testów w czasie rzeczywistym, wizualizowanie liczby błędów, wykonywanie przypadków testowych i nie tylko.

Cykl pracy łączy testy generowane przez AI w GitHub Copilot z zarządzaniem przypadkami testowymi w całym zespole w ClickUp, zapewniając zespołom jeden system do planowania, śledzenia, automatyzacji i ulepszania procesu kontroli jakości bez konieczności ciągłej ręcznej koordynacji.

Obejrzyj ten film, aby uzyskać wskazówki dotyczące tworzenia wydajnego cyklu pracy w zakresie zarządzania wydaniami:

Uprość zarządzanie przypadkami testowymi dzięki ClickUp

Testy generowane przez AI nie są już odizolowanymi artefaktami; są zintegrowanymi elementami procesu rozwoju, posiadającymi widoczność, możliwą do śledzenia i wykorzystania przez cały zespół.

GitHub Copilot szybko generuje przypadki testowe, ale sama szybkość nie gwarantuje jakości. Bez jasnej własności, identyfikowalności wymagań i widoczności w ramach sprintów nawet dobrze napisane testy mogą stać się nieaktualne lub zostać pominięte. Właśnie dlatego tak ważny jest system rejestracji.

Zarządzając przypadkami testowymi w ClickUp, zespoły przekształcają wyniki generowane przez sztuczną inteligencję w powtarzalny cykl pracy kontroli jakości, który łączy testy z wymaganiami, zmianami w kodzie i harmonogramem wydawania nowych wersji. Zamiast żonglować narzędziami i ręcznymi aktualizacjami, zespoły ds. kontroli jakości i inżynierii pracują we wspólnej, kontekstowej przestrzeni roboczej. Rezultatem jest nie tylko większa liczba testów, ale także większa pewność co do tego, co jest dostarczane i dlaczego.

Chcesz zarządzać przypadkami testowymi równolegle ze sprintami i wydaniami? Zacznij korzystać z ClickUp już dziś za darmo.

Często zadawane pytania

Tak, Copilot może analizować strukturę i logikę starszej wersji kodu w celu wygenerowania podstawowych testów. Jednak testy te będą prawdopodobnie wymagały znacznego ręcznego przeglądu i udoskonalenia, ponieważ AI nie będzie miała kontekstu dotyczącego nieudokumentowanych zachowań lub historycznych reguł biznesowych.

Dokładność składniowa jest bardzo wysoka, ale dokładność logiczna zależy od przejrzystości kodu i szczegółowości podpowiedzi. Zawsze sprawdzaj twierdzenia, aby upewnić się, że weryfikują one istotne wymagania biznesowe, a nie tylko potwierdzają bieżącą (i potencjalnie wadliwą) implementację.

Tak, Copilot oferuje doskonałe wsparcie dla pytest, unittest i innych popularnych frameworków testowych języka Python. Doskonale rozpoznaje i replikuje istniejące wzorce w projekcie, takie jak użycie fixtur lub testów parametrycznych.

Skuteczne zespoły używają scentralizowanej platformy do zarządzania projektami, żeby zarządzać zestawami testów. Śledząc każdy przypadek testowy jako zadanie z niestandardowymi metadanymi dotyczącymi statusu i priorytetu, zyskują widoczność w wynikach pokrycia i wykonania, łącząc proces kontroli jakości bezpośrednio z planowaniem sprintów i śledzeniem błędów.