Man mano che gli LLM diventano più potenti, il prompting non è più la parte difficile. Il contesto diventa il vincolo.

L'ingegneria del contesto consiste nel fornire le informazioni giuste nel formato giusto agli LLM (modelli linguistici di grandi dimensioni).

Cosa rende difficile l'ingegneria del contesto?

È necessario progettare ogni livello dello stack per acquisire il contesto e renderlo disponibile. Se si invia troppo poco contesto, gli LLM non sapranno cosa fare. Se si invia troppo contesto, si esauriscono i token. Quindi, come trovare l'equilibrio?

Di seguito condividiamo tutto ciò che c'è da sapere sull'ingegneria del contesto.

Che cos'è l'ingegneria del contesto IA?

L'ingegneria del contesto IA è il processo di progettazione e ottimizzazione delle istruzioni e del contesto rilevante per gli LLM e i modelli avanzati di IA e multimodali, affinché possano svolgere le loro attività in modo efficace.

Va oltre la semplice scrittura di prompt. L'ingegneria del contesto determina:

- Quali informazioni vengono visualizzate

- Da dove proviene (memoria, strumenti, database, documenti)

- Come è formattato (schemi, riepiloghi/riassunti, vincoli)

- Quando viene inserito nel ciclo di ragionamento del modello

🌟 Lo scopo: ottimizzare le informazioni fornite nella finestra di contesto dell'LLM e filtrare le informazioni superflue.

In che modo il contesto migliora le risposte dell'IA?

Senza contesto, un LLM prevede la continuazione del testo più probabile dal punto di vista statistico. D'altra parte, una buona ingegneria del contesto migliora i risultati:

- Ragionamento di ancoraggio: il modello basa le sue risposte su fatti noti anziché su ipotesi statistiche.

- Ridurre le allucinazioni: vincoli chiari e dati rilevanti restringono lo spazio delle soluzioni.

- Migliorare la coerenza: input simili producono output simili perché la forma del contesto è stabile.

- Riduzione dei costi e della latenza: un contesto mirato è meglio che scaricare interi documenti o cronologie.

Riassumendo con le parole di Tobi Lutke, CEO di Shopify:

Preferisco di gran lunga il termine "ingegneria del contesto" a quello di "ingegneria dei prompt". Descrive meglio l'abilità fondamentale: l'arte di fornire tutto il contesto necessario affinché l'attività possa essere risolta in modo plausibile dall'LLM.

Preferisco di gran lunga il termine "ingegneria del contesto" a quello di "ingegneria dei prompt". Descrive meglio l'abilità fondamentale: l'arte di fornire tutto il contesto necessario affinché l'attività possa essere risolta in modo plausibile dall'LLM.

Il ruolo dell'ingegneria del contesto nei flussi di lavoro basati sull'IA

Nei flussi di lavoro basati sull'IA, gli LLM non sono strumenti autonomi. Operano all'interno di sistemi che dispongono già di dati, regole e stati.

L'ingegneria del contesto consente al modello di capire dove si trova nel flusso di lavoro e cosa è autorizzato a fare dopo.

Quando il modello è consapevole dello stato attuale, delle azioni passate e degli input mancanti, può raccomandare o eseguire il passaggio successivo corretto invece di generare consigli generici.

Ciò significa anche fornire in modo esplicito la logica aziendale, come le regole di approvazione, i vincoli di conformità e i percorsi di escalation. Quando questi elementi fanno parte del contesto, le decisioni dell'IA rimangono allineate alla realtà operativa.

Infine, l'ingegneria del contesto consente flussi di lavoro multi-step e agentici, garantendo passaggi puliti di stato e decisioni in ogni passaggio.

Questo impedisce che gli errori si aggravino con l'aumentare dei flussi di lavoro, migliorando così l'efficacia del contesto.

👀 Lo sapevate? Il 95% delle implementazioni GenAI aziendali fallisce, non perché i modelli siano deboli, ma perché le organizzazioni non riescono a integrare l'IA nei flussi di lavoro reali.

Gli strumenti di IA generici come ChatGPT funzionano bene per i singoli individui, ma falliscono su larga scala perché non imparano dal contesto del sistema, dalle regole aziendali o dallo stato in evoluzione. In altre parole, la maggior parte dei fallimenti dell'IA sono fallimenti di integrazione e di contesto, non fallimenti del modello.

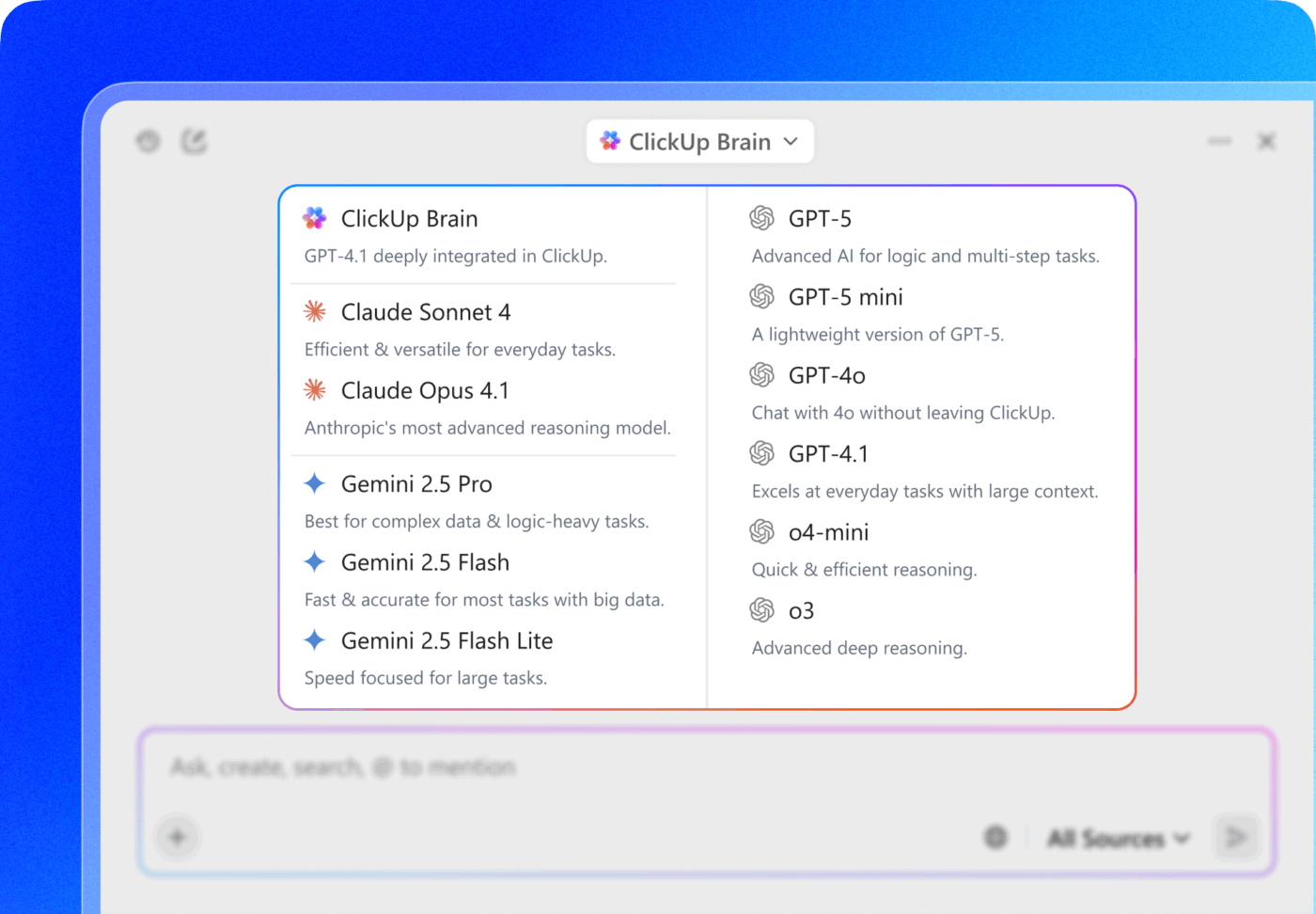

📮ClickUp Insight: Il 62% dei nostri intervistati si affida a strumenti di IA conversazionale come ChatGPT e Claude. La loro interfaccia chatbot familiare e le loro capacità versatili (generare contenuti, analizzare dati e altro) potrebbero essere il motivo per cui sono così popolari in diversi ruoli e settori. Tuttavia, se un utente deve passare a un'altra scheda per porre una domanda all'IA ogni volta, i costi associati al cambio di contesto e al passaggio da una scheda all'altra si accumulano nel tempo. Non con ClickUp Brain, però. Si trova direttamente nell'area di lavoro di ClickUp, sa a cosa stai lavorando, è in grado di comprendere i prompt di testo normale e ti fornisce risposte altamente pertinenti alle tue attività! Ottieni un miglioramento della produttività doppio con ClickUp!

Come funziona l'ingegneria del contesto?

L'ingegneria del contesto funziona modellando progressivamente le informazioni prima che raggiungano il modello.

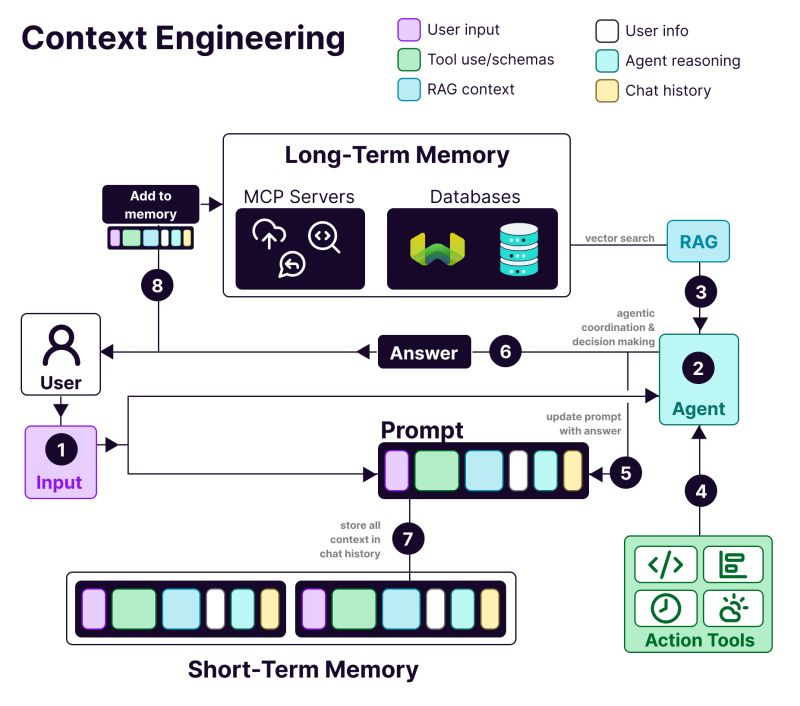

L'anatomia di un sistema basato sull'ingegneria del contesto include:

- 𝗨𝘀𝗲𝗿 i𝗻𝗳𝗼𝗿𝗺𝗮𝘁𝗶𝗼𝗻: preferenze, cronologia e dati di personalizzazione

- T𝗼𝗼𝗹 u𝘀𝗲: API, calcolatori, motori di ricerca: tutto ciò di cui l'LLM ha bisogno per terminare il proprio lavoro.

- 𝗥𝗔𝗚 c𝗼𝗻𝘁𝗲𝘅𝘁: informazioni recuperate da database vettoriali come Weaviate

- 𝗨𝘀𝗲𝗿 i𝗻𝗽𝘂𝘁: La query o l'attività effettiva da svolgere

- 𝗔𝗴𝗲𝗻𝘁 r𝗲𝗮𝘀𝗼𝗻𝗶𝗻𝗴: Il processo di pensiero e la catena decisionale dell'LLM

- 𝗖𝗵𝗮𝘁 h𝗶𝘀𝘁𝗼𝗿𝘆: Interazioni precedenti che garantiscono continuità

Vantaggi dell'ingegneria del contesto nei sistemi di IA

Ecco perché è necessario l'ingegneria del contesto quando si sviluppano applicazioni di IA:

Risultati più accurati

Fornire un contesto rilevante per la decisione riduce l'ambiguità. Il modello ragiona sulla base di fatti, vincoli e stati noti invece di affidarsi a ipotesi probabilistiche.

Comportamento coerente su larga scala

Strutture di contesto stabili producono output ripetibili. Input simili portano a decisioni simili, essenziali per i flussi di lavoro di produzione.

Riduzione dei costi e della latenza

Un contesto mirato e compresso evita lo spreco di token. I sistemi rispondono più rapidamente senza dover caricare ripetutamente intere cronologie o documenti.

Automazioni più sicure

Il contesto codifica le regole aziendali e le autorizzazioni. Ciò consente all'IA di agire senza violare le politiche o trigger azioni rischiose.

Flussi di lavoro multi-step migliori

I passaggi di contesto puliti preservano lo stato tra i vari passaggi. Gli errori non si aggravano man mano che i flussi di lavoro diventano più complessi o agentici.

Debugging e iterazione più semplici

Il contesto strutturato rende visibili gli errori. È possibile risalire agli errori causati da input mancanti, obsoleti o classificati in modo errato, invece di dare la colpa al modello.

Maggiore adozione da parte delle aziende

I sistemi di IA che rispettano il contesto del flusso di lavoro sembrano affidabili: una differenza fondamentale tra i progetti pilota e gli strumenti destinati all'adozione a livello di azienda.

📚 Per saperne di più: Come sfruttare l'IA con l'accesso ai dati in tempo reale

👀 Lo sapevate? L'IA sensibile al contesto influisce direttamente sulla produttività. Uno studio del Boston Consulting Group ha rilevato che i team di comunicazione possono recuperare il 26-36% del loro tempo grazie all'IA generativa e, con flussi di lavoro riprogettati e sistemi agentici in grado di comprendere il contesto, i guadagni in termini di produttività possono arrivare fino al 50%.

Ingegneria del contesto IA vs. Ingegneria dei prompt

Prompt engineering: chiedi a ChatGPT di scrivere un'email di annuncio di una nuova funzionalità. Stai scrivendo le istruzioni per una singola attività.

Ingegneria del contesto: stai creando un bot per il servizio clienti. Deve ricordare i ticket precedenti, accedere ai dettagli dell'account utente e conservare la cronologia delle conversazioni.

Come spiegato dal ricercatore di IA Andrej Karpathy:

Le persone associano i prompt a brevi descrizioni di attività che si darebbero a un LLM nell'uso quotidiano. In ogni app LLM di livello industriale, l'ingegneria del contesto è l'arte e la scienza delicata di riempire la finestra del contesto con le informazioni giuste per il passaggio successivo.

Le persone associano i prompt a brevi descrizioni di attività che si darebbero a un LLM nell'uso quotidiano. In ogni app LLM di livello industriale, l'ingegneria del contesto è l'arte e la scienza delicata di riempire la finestra del contesto con le informazioni giuste per il passaggio successivo.

+1 per il "context engineering" rispetto al "prompt engineering".

Le persone associano i prompt a brevi descrizioni di attività che si darebbero a un LLM nell'uso quotidiano. In ogni app LLM di livello industriale, l'ingegneria del contesto è l'arte e la scienza delicata di riempire la finestra del contesto... https://t.co/Ne65F6vFcf

— Andrej Karpathy (@karpathy) 25 giugno 2025

+1 per il "context engineering" rispetto al "prompt engineering".

Le persone associano i prompt a brevi descrizioni di attività che si darebbero a un LLM nell'uso quotidiano. In ogni app LLM di livello industriale, l'ingegneria del contesto è l'arte e la scienza delicata di riempire la finestra del contesto... https://t.co/Ne65F6vFcf

— Andrej Karpathy (@karpathy) 25 giugno 2025

| Approccio | Su cosa si concentra | Ideale per |

| Prompt engineering | Creazione di istruzioni e formati di output per il modello | Attività una tantum, generazione di contenuti, output specifici per formato |

| Ingegneria del contesto | Fornire dati, stati e vincoli rilevanti al modello | IA conversazionale, strumenti di analisi dei documenti, assistenti di codifica |

| Entrambi insieme | Combinando istruzioni chiare con il contesto a livello di sistema | Applicazioni di IA di produzione che richiedono prestazioni costanti e affidabili |

La maggior parte delle applicazioni utilizza una combinazione di ingegneria dei prompt e ingegneria del contesto. Nel sistema di ingegneria del contesto sono comunque necessari prompt ben scritti.

La differenza è che questi prompt funzionano con informazioni di base gestite con attenzione. Non è necessario ricominciare ogni volta.

📮 ClickUp Insight: Più della metà degli intervistati digita quotidianamente su tre o più strumenti, combattendo contro la " diffusione dell'IA " e i flussi di lavoro frammentati.

Anche se può sembrare produttivo e impegnativo, il tuo contesto si sta semplicemente perdendo tra le varie app, per non parlare dell'energia che consumi digitando. Brain MAX riunisce tutto: basta parlare una volta e i tuoi aggiornamenti, attività e note finiscono esattamente dove devono essere in ClickUp. Niente più attivazioni/disattivazioni tra le app, niente più caos: solo produttività centralizzata e senza interruzioni.

Applicazioni dell'ingegneria del contesto nell'IA

Le aree chiave in cui l'ingegneria del contesto IA è già stata implementata sono 👇

Supporto clienti e automazione dell'helpdesk

La maggior parte dei chatbot tratta ogni messaggio come nuovo, costringendo gli utenti a ripetere più volte le stesse cose.

Con l'ingegneria del contesto, l'IA può fare riferimento alla cronologia dell'utente, alle interazioni precedenti, ai registri degli acquisti e alla documentazione del prodotto. In questo modo, risponde come un collega che conosce già il problema.

📌 Esempio reale: il team del supporto di Coda gestisce domande tecniche sui prodotti che richiedono la comprensione dei messaggi precedenti e il riferimento alla documentazione dei prodotti. Per scalare l'assistenza, utilizzano Intercom Fin. Fin legge la documentazione e le conversazioni precedenti prima di rispondere, aiutando a risolvere autonomamente il 50-70% delle domande dei clienti, mantenendo un elevato CSAT.

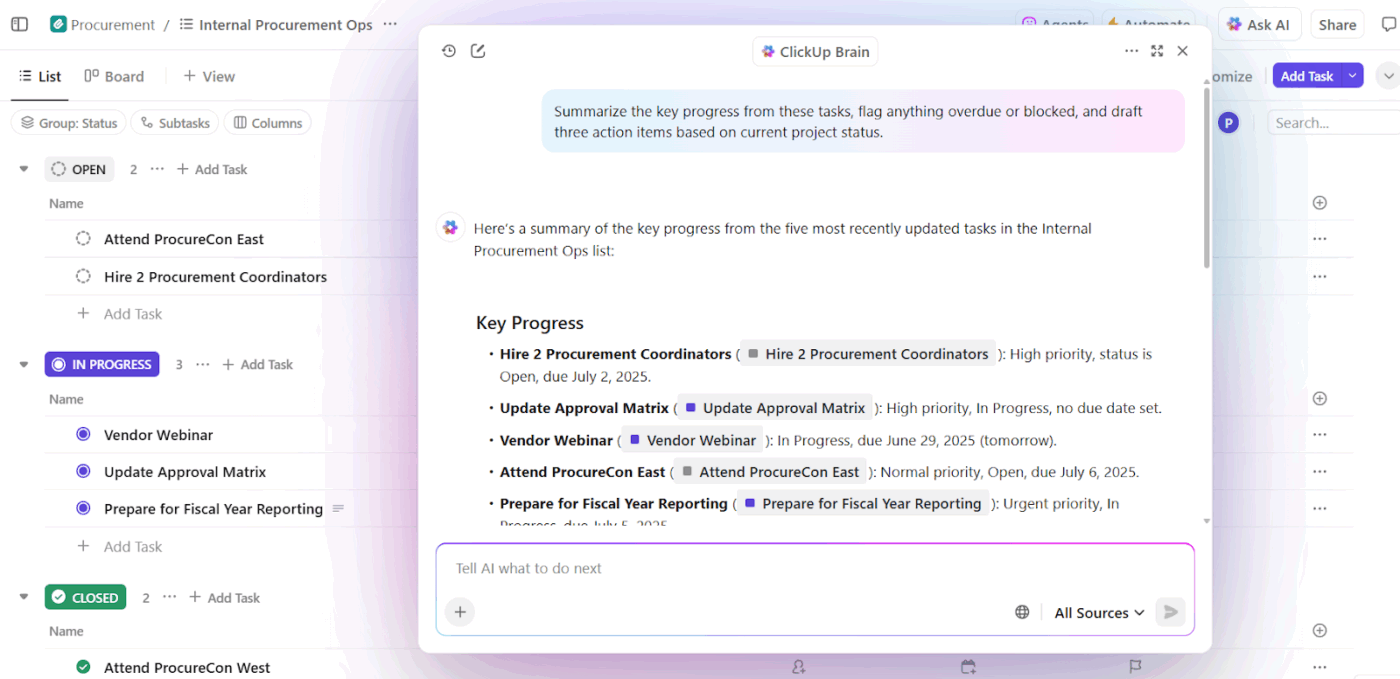

Assistenti di scrittura IA e produttività sul posto di lavoro

Gli strumenti di scrittura basati sull'IA offrono valore solo quando comprendono su cosa stai lavorando, perché è importante e cosa esiste già. Senza quel contesto, consentono di risparmiare tempo nella stesura, ma richiedono comunque pesanti riscritture e allineamenti manuali.

È qui che l'ingegneria del contesto IA cambia i risultati. Basando l'IA sullo stato delle attività, sui documenti, sulle decisioni passate e sulle convenzioni del team, gli assistenti di scrittura passano dalla generazione di testi generici a un supporto consapevole del flusso di lavoro.

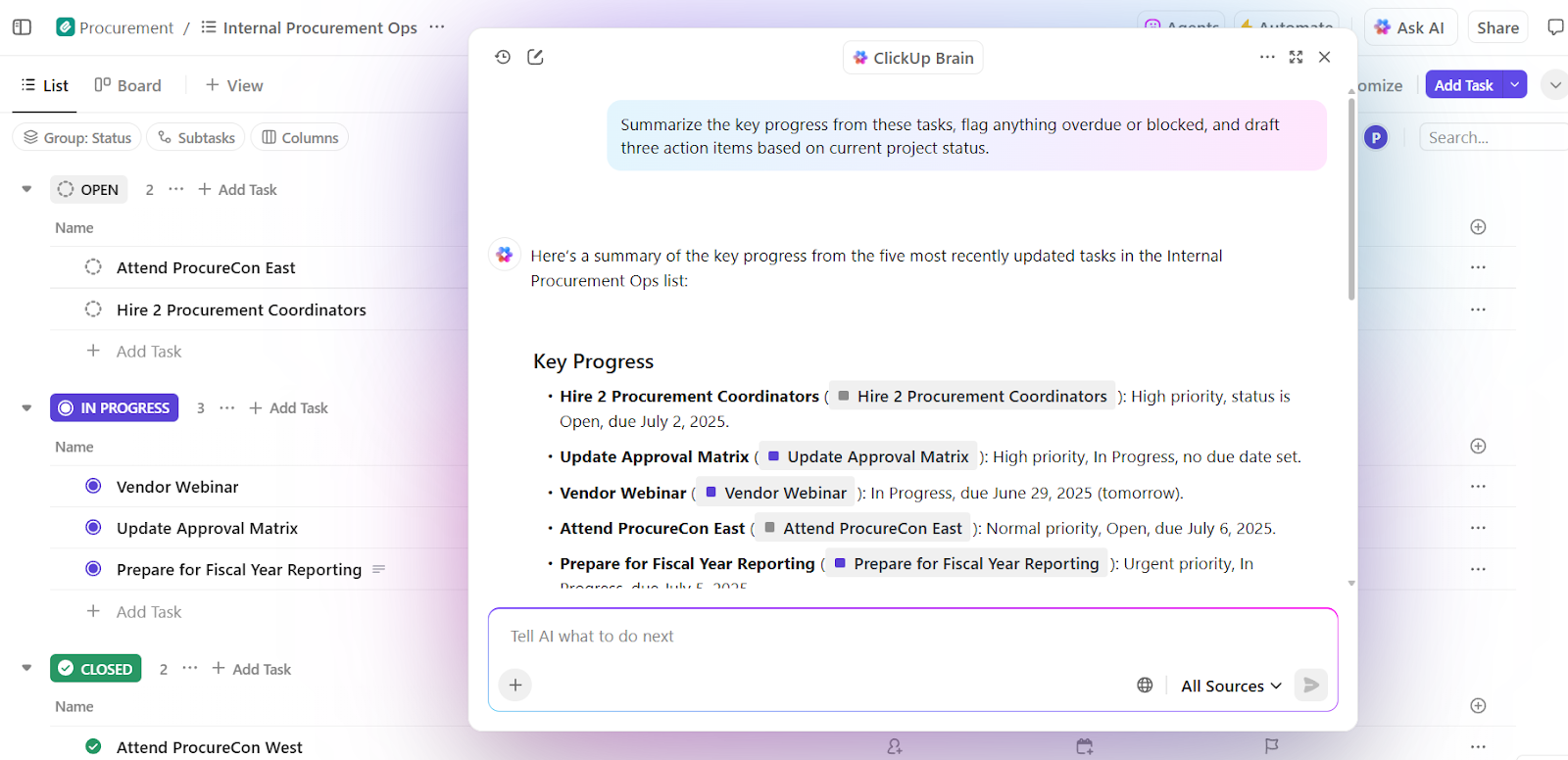

📌 Esempio reale: ClickUp Brain, l'IA nativa di ClickUp, applica l'ingegneria del contesto a livello di area di lavoro. Invece di chiedere agli utenti di incollare il contesto nei prompt, estrae il contesto direttamente da attività, documenti, commenti, priorità e Sequenze.

Una capacità fondamentale è il processo decisionale contestuale. Esso valuta i progetti in corso insieme alla capacità del team e alle prestazioni passate per far emergere intuizioni attuabili.

Innanzitutto, Brain è in grado di rilevare sovraccarichi, ritardi e colli di bottiglia. Oltre a riepilogare il problema, raccomanda anche adeguamenti concreti sotto forma di ridistribuzione delle attività, aggiornamento delle sequenze e ridefinizione delle priorità.

Poiché queste decisioni si basano sul contesto di un'area di lavoro reale, il risultato è immediatamente utilizzabile. Non è necessario ribadire il contesto, spiegare le priorità o allineare manualmente i consigli alla realtà.

Teams che utilizzano ClickUp Brain riportano tassi di integrazione completa 2,26 volte superiori e i punteggi di frustrazione IA più bassi (27,1%).

Intelligenza commerciale e CRM

I flussi di lavoro commerciali comprendono email, riunioni, CRM e fogli di calcolo. Senza contesto, l'IA non è in grado di comprendere lo slancio dell'affare o l'intenzione dell'acquirente.

L'ingegneria del contesto offre all'IA visibilità sulle conversazioni degli acquirenti, sulle sequenze, sul tono della comunicazione e sul coinvolgimento passato. Questo aiuta a far emergere intuizioni, individuare accordi in fase di stallo e suggerire la giusta azione successiva.

📌 Esempio reale: il team commerciale di Microsoft utilizza Copilot for Sales, che estrae il contesto da Outlook, dalle chiamate Teams, dagli aggiornamenti CRM e dalle note per fornire le giuste informazioni e redigere i follow-up. I team interni hanno registrato un aumento del 20% delle trattative concluse con successo e un incremento del 9,4% dei ricavi per venditore, dimostrando come l'IA basata sul contesto amplifichi le prestazioni.

Assistenti sanitari e clinici basati sull'IA

Le decisioni mediche si basano sull'anamnesi del paziente, sui referti di laboratorio, sulle prescrizioni e sulle note del medico, ma queste informazioni sono spesso archiviate in sistemi scollegati tra loro. Ciò comporta una notevole perdita di tempo per i medici, che devono reinserire i dati e rischiano di trascurare dettagli fondamentali. A volte dedicano quasi il 40% del loro tempo al lavoro amministrativo.

L'ingegneria del contesto IA collega questi punti dati. Offre supporto ai medici con riepiloghi/riassunti accurati, bozze di documentazione, evidenzia la storia clinica rilevante e mette in luce i potenziali rischi o i passaggi successivi.

📌 Esempio reale: Atrium Health utilizza Nuance DAX Copilot, sviluppato in collaborazione con Microsoft, per documentare automaticamente le visite cliniche utilizzando registrazioni precedenti e conversazioni in tempo reale. Come risultato, i medici hanno risparmiato 30-40 minuti al giorno sulla documentazione, mentre uno studio condotto su 12 specialità mediche ha riportato una maggiore efficienza e soddisfazione dei provider senza compromettere la sicurezza dei pazienti.

Assistenti alle risorse umane e al reclutamento

Le decisioni di reclutamento dipendono dal contesto, come le competenze, il feedback dei colloqui, l'idoneità al ruolo e i dati sulle assunzioni passate. L'ingegneria del contesto basata sull'IA consente di analizzare curriculum, descrizioni dei lavori, trascrizioni dei colloqui e modelli storici per identificare più rapidamente le corrispondenze più significative.

📌 Esempio reale: i team aziendali di Micron utilizzano Eightfold AI, una piattaforma di talent intelligence che analizza curriculum, requisiti di ruolo, percorsi di carriera interni e risultati di assunzioni passate per prevedere l'idoneità al lavoro. La piattaforma valuta i candidati in base alle competenze e al potenziale. Il risultato? Ampliamento del proprio bacino di talenti e assunzione di otto candidati in più al mese con un team di reclutamento snello.

Strumenti e piattaforme di supporto per l'ingegneria del contesto

Quali strumenti aiutano a implementare l'ingegneria del contesto su larga scala?

1. LangChain (ideale per assemblare il contesto a livello di programmazione)

LangChain è un framework di orchestrazione open source per la creazione di sistemi di IA in cui il contesto deve essere assemblato, aggiornato e instradato a livello di programmazione.

Lo strumento AI agent aiuta gli sviluppatori a collegare gli LLM con strumenti, origini dati, memoria e logica di controllo, invece di affidarsi a prompt statici.

Core LangChain gestisce il concatenamento e il recupero, mentre LangGraph consente flussi di lavoro basati su grafici e con stato per ragionamenti complessi e con più passaggi.

DeepAgents si basa su questi principi per fornire supporto ad agenti autonomi a lungo termine con pianificazione, sottoagenti e contesto persistente.

Insieme, questi componenti rendono LangChain un livello di controllo per l'ingegneria del contesto, decidendo quando il contesto viene recuperato, come si evolve e dove fluisce attraverso i flussi di lavoro degli agenti.

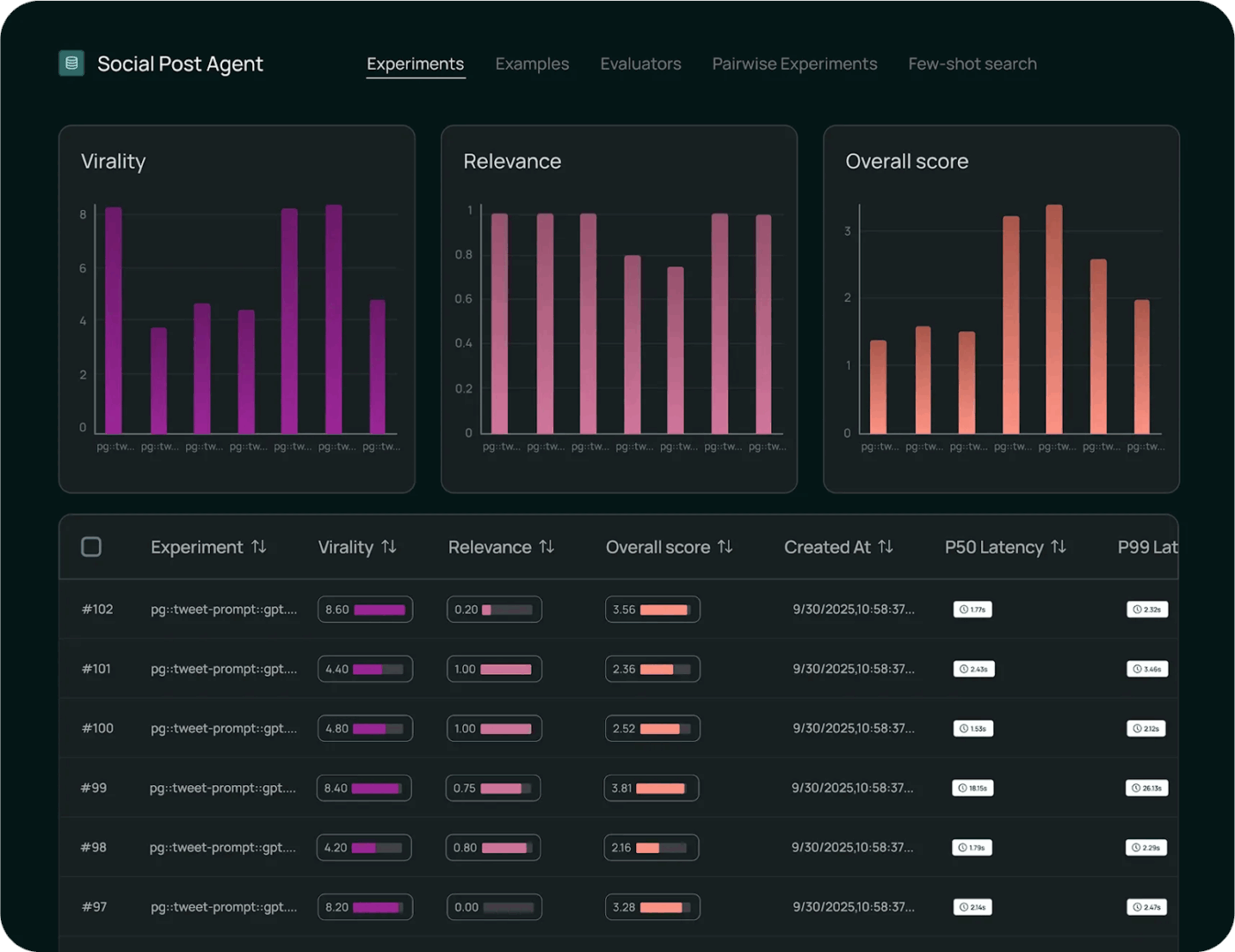

Le migliori funzionalità di LangChain

- Monitorare l'esecuzione con strumenti di osservabilità per effettuare il monitoraggio delle chiamate al modello, della latenza, degli errori e del flusso del contesto end-to-end per il debug e approfondimenti sulle prestazioni.

- Valutare sistematicamente il comportamento del modello utilizzando framework di test integrati che misurano la correttezza, confrontano i risultati e convalidano le modifiche rispetto ai benchmark.

- Implementa flussi di lavoro su larga scala con ambienti gestiti che supportano il versioning, il controllo del rollout e l'esecuzione pronta per la produzione di catene e agenti.

Limiti di LangChain

- Lo strumento ha una curva di apprendimento ripida per i principianti e la documentazione, aggiornata ogni pochi giorni, lo rende difficile da gestire.

Prezzi di LangChain

- Sviluppatore: Gratis

- Plus: 39 $/utente/mese

- Enterprise: Prezzi personalizzati

Valutazioni e recensioni di LangChain

- G2: 4,7/5 (oltre 30 recensioni)

- Capterra: Valutazioni e recensioni insufficienti

Cosa dicono gli utenti reali di LangChain?

Come ha scritto un utente su Reddit:

Dopo aver testato diversi metodi, quello che mi è piaciuto di più è stato l'uso di strumenti standard con i flussi di lavoro langgraph. Quindi ho racchiuso i flussi di lavoro deterministici in agenti che l'LLM principale chiama come strumenti. In questo modo, l'LLM principale offre un'esperienza utente dinamica e autentica e si limita a passare il testimone a un flusso di lavoro che fa il lavoro pesante e restituisce il risultato all'LLM principale.

Dopo aver testato diversi metodi, quello che mi è piaciuto di più è stato l'uso di strumenti standard con i flussi di lavoro langgraph. Quindi ho racchiuso i flussi di lavoro deterministici in agenti che l'LLM principale chiama come strumenti. In questo modo, l'LLM principale offre un'esperienza utente dinamica e autentica e si limita a passare il testimone a un flusso di lavoro che fa il lavoro pesante e restituisce il risultato all'LLM principale.

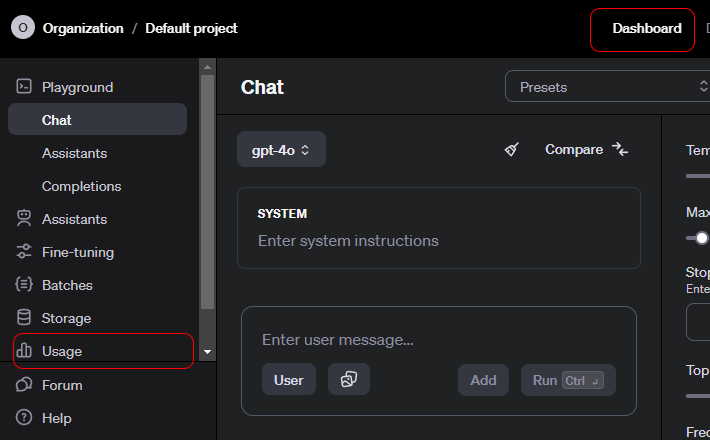

2. API OpenAI (l'API Contextual AI fornisce un contesto strutturato, la chiamata di strumenti e controlli a livello di sistema)

L'API OpenAI è un'interfaccia generica che consente di accedere a modelli avanzati di IA generativa che alimentano un'ampia gamma di applicazioni.

Gli sviluppatori lo utilizzano per integrare la comprensione e la generazione del linguaggio nei prodotti. Offre anche il supporto per la sintesi, la traduzione, l'assistenza al codice e il ragionamento.

L'API supporta chat, incorporamenti, chiamate di funzione, moderazione e input multimodali, consentendo interazioni strutturate con i modelli. OpenAI è particolarmente adatto alla prototipazione rapida, poiché gestisce l'autenticazione, il ridimensionamento e la versione.

La facilità d'uso è attribuibile al modo in cui l'API astrae il comportamento complesso del modello in endpoint semplici e affidabili.

Le migliori funzionalità dell'API OpenAI

- Generare output sensibili al contesto su testo, codice e input multimodali per attività e ragionamenti in linguaggio naturale.

- Creare embedding ricchi per potenziare la ricerca semantica, il clustering e i flussi di lavoro di recupero basati su vettori.

- Richiamare funzioni e strumenti tramite chiamate strutturate che consentono ai modelli di interagire con sistemi e servizi esterni.

Limitazione dell'API OpenAI

- Nessuna memoria a lungo termine nativa. L'API è stateless per impostazione predefinita.

Prezzi dell'API OpenAI

GPT-5. 2

- Input: 1,750 $ / 1 milione di token

- Input memorizzato nella cache: 0,175 $ / 1 milione di token

- Risultato: 14.000 $ / 1 milione di token

GPT-5. 2 Pro

- Input: 21,00 $ / 1 milione di token

- Input memorizzato nella cache: Non disponibile

- Risultato: 168,00 $ / 1 milione di token

GPT-5 Mini

- Input: 0,250 $ / 1 milione di token

- Input memorizzato nella cache: 0,025 $ / 1 milione di token

- Output: 2.000 $ / 1 milione di token

Valutazioni e recensioni dell'API OpenAI

- G2: Recensioni insufficienti

- Capterra: recensioni insufficienti

Cosa dicono gli utenti reali dell'API OpenAI?

Come ha scritto un utente su Reddit:

Le API di OpenAI sono come tutte le altre, quindi dal punto di vista tecnico non dovrebbe esserci alcuna curva di apprendimento. Tutti gli endpoint, i parametri e le risposte di esempio sono ben documentati. Se avete un'esperienza di sviluppo di base, non dovreste aver bisogno di un corso. Concordo con il punto precedente sull'importanza di imparare Python. Le librerie Python contengono tutte le informazioni necessarie per semplificare la vita. Se si desidera continuare a utilizzare JS, sono disponibili anche librerie Node. La curva di apprendimento più impegnativa sarà quella relativa al loro utilizzo strategico. Prima di provare a crearli con il codice, è consigliabile dedicare un po' di tempo a provare i messaggi di sistema, i prompt utente e i parametri nel Playground. (Sono abbastanza sicuro che sia possibile ottenere codice di esempio dal Playground dopo aver trovato qualcosa che funziona).

Le API di OpenAI sono come tutte le altre, quindi dal punto di vista tecnico non dovrebbe esserci alcuna curva di apprendimento. Tutti gli endpoint, i parametri e le risposte di esempio sono ben documentati. Se avete un'esperienza di sviluppo di base, non dovreste aver bisogno di un corso. Concordo con il punto precedente sull'importanza di imparare Python. Le librerie Python contengono tutte le informazioni necessarie per semplificare la vita. Se si desidera continuare a utilizzare JS, sono disponibili anche librerie Node. La curva di apprendimento più impegnativa sarà quella relativa al loro utilizzo strategico. Prima di provare a crearli con il codice, è consigliabile dedicare un po' di tempo a provare i messaggi di sistema, i prompt utente e i parametri nel Playground. (Sono abbastanza sicuro che sia possibile ottenere codice di esempio dal Playground dopo aver trovato qualcosa che funziona).

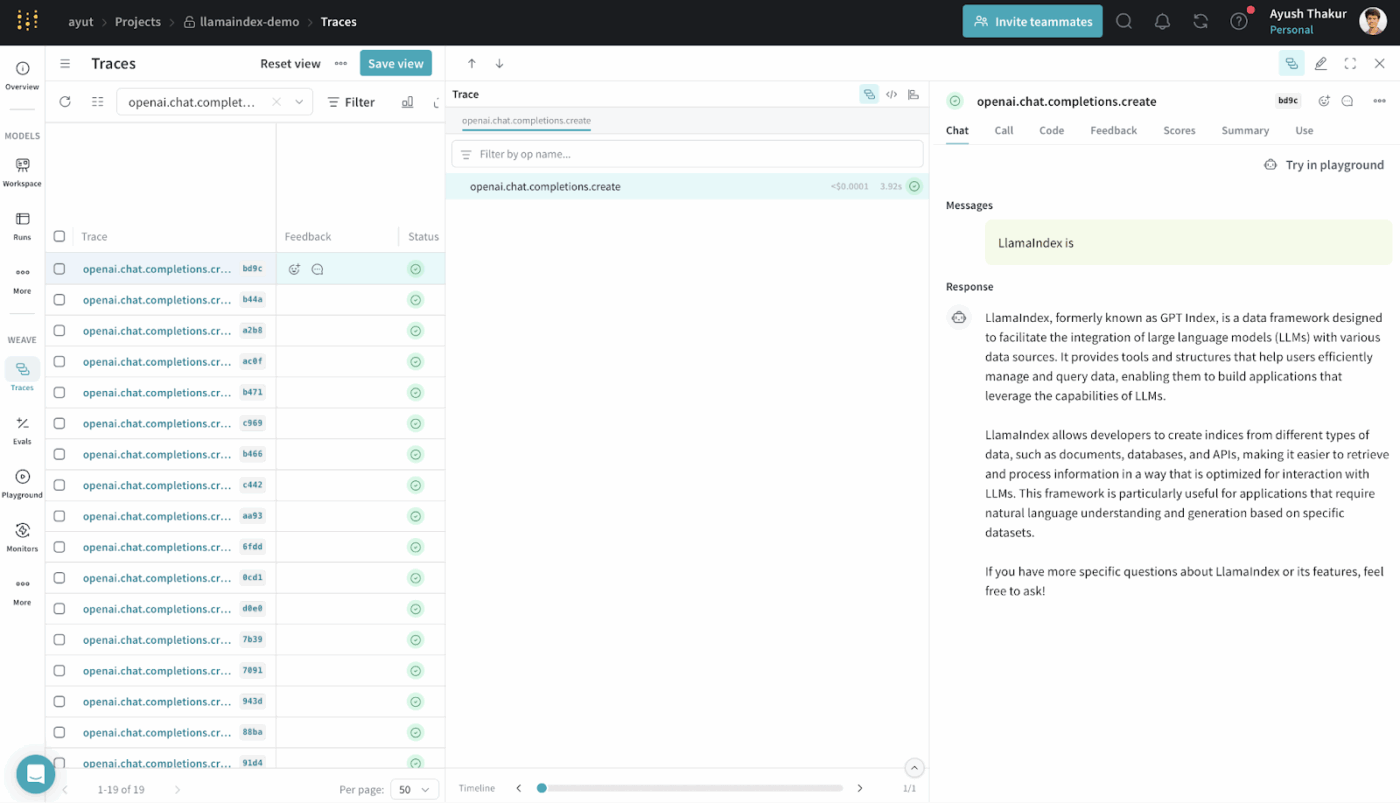

3. LlamaIndex (il migliore per il sistema di generazione di potenziamento del recupero)

LlamaIndex è un framework di dati open source progettato per rendere i dati esterni accessibili e utilizzabili dai modelli linguistici di grandi dimensioni.

Fornisce connettori, indici e interfacce di query che trasformano i dati strutturati e non strutturati in rappresentazioni che gli LLM possono elaborare in modo efficiente.

È possibile creare sistemi RAG senza un'infrastruttura personalizzata complessa. Il sistema astrae il recupero, la vettorizzazione e il ranking di rilevanza.

È comunemente utilizzato per casi d'uso quali la ricerca semantica, il riassunto e la risposta a domande, basati su dati reali.

Le migliori funzionalità di LlamaIndex

- Indice le origini dati eterogenee in strutture ricercabili che gli LLM possano queryare in modo efficace.

- Recupera il contesto in modo strategico utilizzando la ricerca vettoriale e la pianificazione delle query per un'iniezione precisa delle prove.

- Comprimere e riepilogare il contesto per mantenere il ragionamento efficiente e pertinente.

Prezzi di LlamaIndex

- Free

- Starter: 50 $ al mese

- Pro: 500 $ al mese

- Enterprise: prezzi personalizzati

Valutazioni e recensioni di LlamaIndex

- G2: Recensioni insufficienti

- Capterra: recensioni insufficienti

Cosa dicono gli utenti reali di LlamaIndex?

Un utente effettua la condivisione su Reddit:

Onestamente penso che la maggior parte dei framework genAi come langchain e llamaindex non siano così efficaci e rendano il codice più complesso. È preferibile utilizzare Python vanilla.

Onestamente penso che la maggior parte dei framework genAi come langchain e llamaindex non siano così efficaci e rendano il codice più complesso. È preferibile utilizzare Python vanilla.

4. ClickUp BrainGPT (il miglior assistente IA per la tua area di lavoro)

La maggior parte degli strumenti in questo elenco ti aiutano con aspetti specifici dell'ingegneria del contesto. Assemblano prompt, recuperano dati o orchestrano flussi di lavoro.

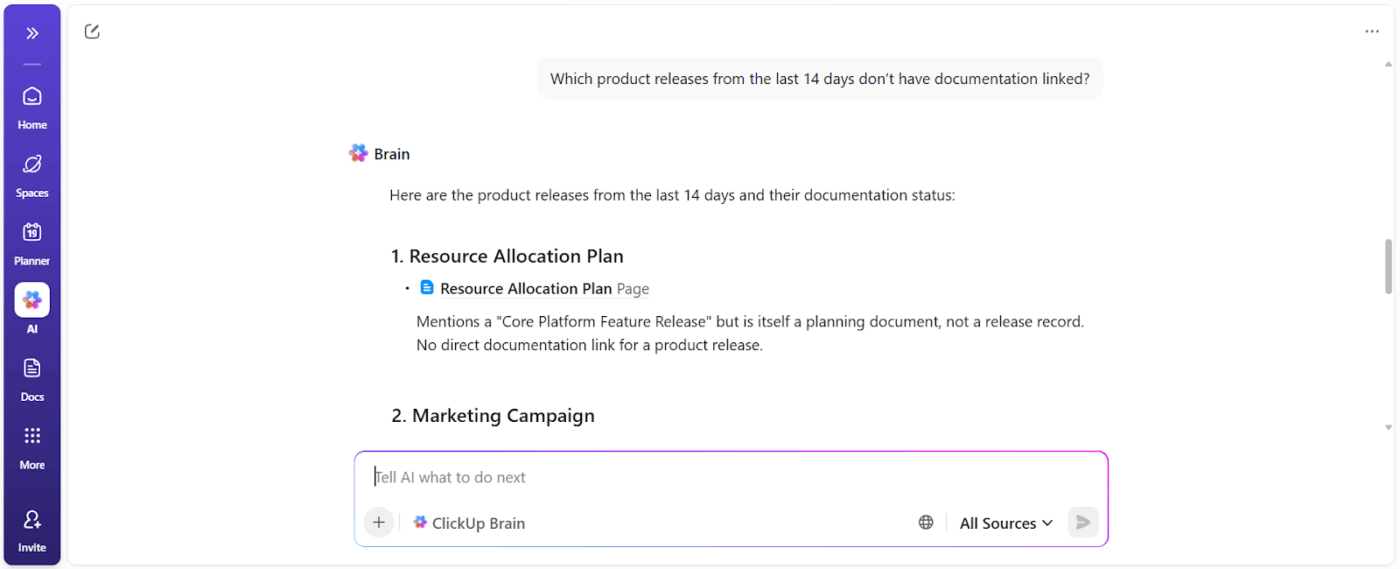

ClickUp Brain adotta un approccio diverso. Essendo il primo spazio di lavoro AI convergente al mondo, ClickUp unifica i tuoi progetti, le tue attività, i tuoi documenti e le tue comunicazioni in un'unica piattaforma, con un'IA sensibile al contesto integrata al suo interno.

Ecco come 👇

Lavora con un'IA che capisce te e il tuo lavoro

ClickUp Brain comprende il contesto del tuo lavoro.

Il contesto viene estratto dalle tue attività di ClickUp, dai documenti, dai commenti, dalle dipendenze, dagli stati, dalle sequenze e dalla titolarità. Non è necessario incollare il background o spiegare la cronologia del progetto ogni volta che si pone una domanda basata sui dati dell'area di lavoro.

📌 Ad esempio, quando un manager chiede: "Cosa sta rallentando la campagna del terzo trimestre?", il sistema scansiona l'area di lavoro e individua ostacoli concreti come:

- Attività non assegnate

- Approvazioni in sospeso

- Recensioni bloccate

- Dipendenze in attesa di risorse

Si ottiene un rapporto di blocco che mostra i titolari delle azioni e l'impatto temporale.

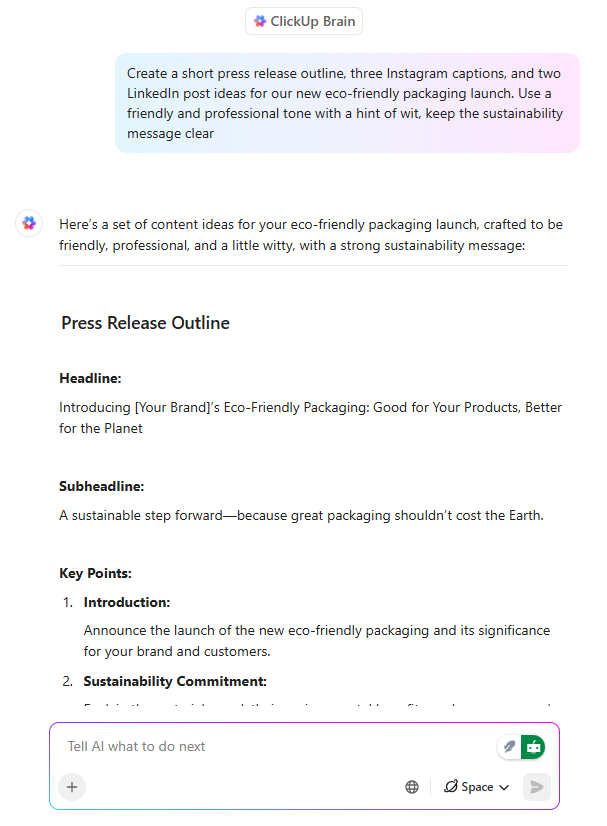

Scrittura IA già allineata con l'esecuzione

ClickUp Brain funge da assistente di scrittura IA, ma con una differenza fondamentale: scrive tenendo conto di ciò che il team sta realizzando.

Quando un PM o un marketer redige un messaggio di lancio all'interno di un documento ClickUp, Brain può:

- Definire le proposte di valore utilizzando il contesto del prodotto esistente

- Personalizza i messaggi per i diversi livelli di pubblico

- Riscrivere i contenuti per adattarli al tono, alla chiarezza o agli obiettivi di posizionamento

Ancora più importante, la scrittura rimane collegata alle attività, alle Sequenze e alle approvazioni. Non c'è alcuna discrepanza tra la documentazione e il lavoro. Un notevole risparmio di tempo, poiché non è necessario reinterpretare i contenuti in un secondo momento.

💡 Suggerimento professionale: scegli tra diversi modelli di IA delle famiglie ChatGPT, Claude e Gemini direttamente all'interno di ClickUp Brain!

- Utilizza un modello veloce e leggero per riepilogare gli appunti delle riunioni all'interno di un'attività.

- Passa a un modello più orientato al ragionamento quando analizzi le prestazioni delle campagne su documenti, attività e dashboard.

La vera mossa vincente? Abbina la selezione del modello al contesto di connessione di ClickUp (attività, commenti, documenti e campi personalizzati ), in modo che il modello non sia solo "intelligente", ma operi all'interno della realtà del tuo spazio di lavoro.

Automazioni delle attività contestuali che riducono il sovraccarico manuale

Con le attività basate sull'intelligenza artificiale, ClickUp trasforma il contesto in azione. Le funzionalità principali includono:

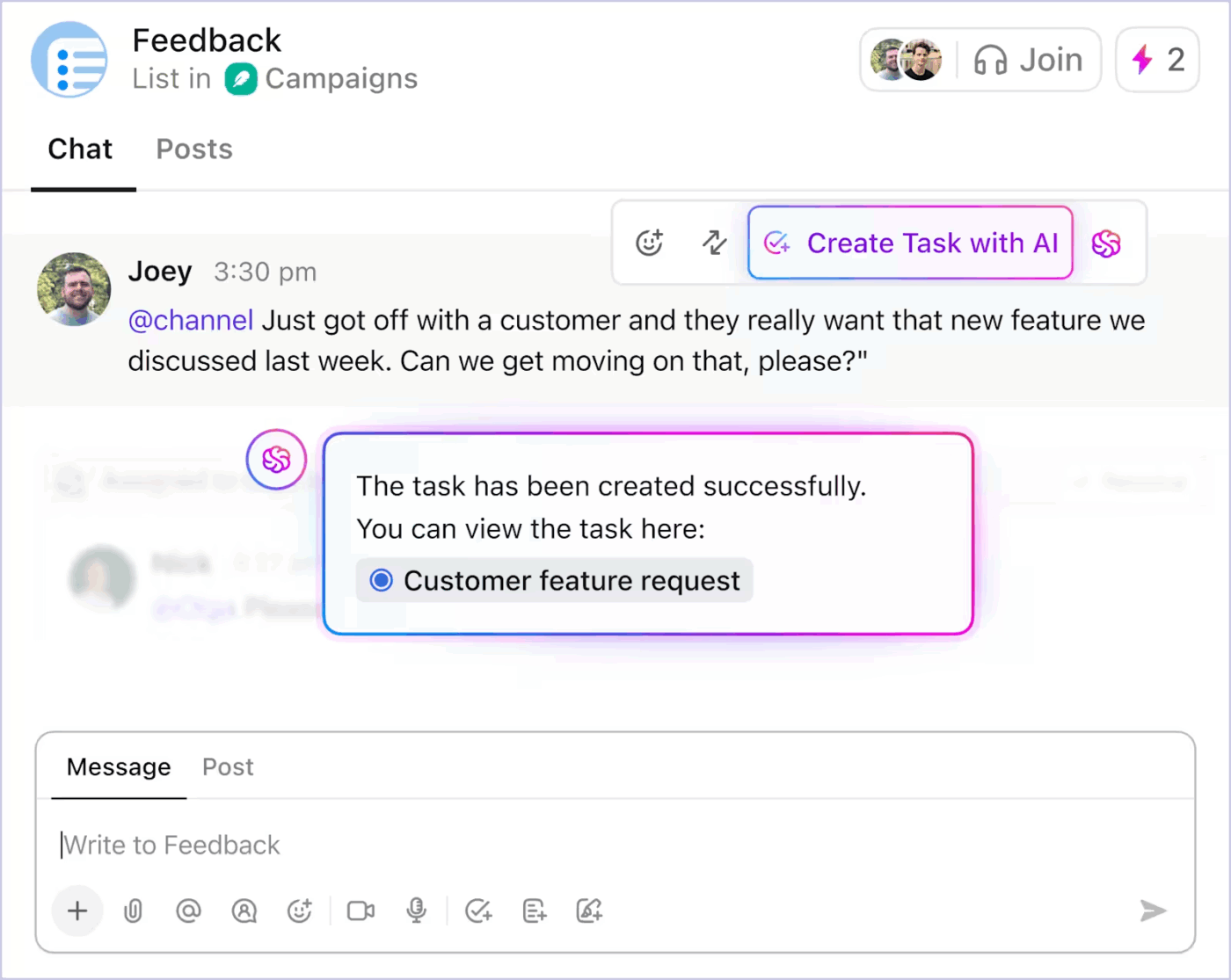

- Converte le discussioni dalla chat di ClickUp in attività

- Generare attività secondarie e descrizioni delle attività da un titolo di attività esistente in base all'ambito

- Suggerisci i passaggi successivi quando il lavoro si blocca

- Automatizza gli aggiornamenti di routine utilizzando lo stato reale del progetto

Ecco come puoi utilizzare l'automazione delle attività basata sull'intelligenza artificiale in ClickUp per ridurre il lavoro ripetitivo 👇

Poiché le automazioni sono guidate dal contesto in tempo reale, i team dedicano meno tempo a tradurre l'intento in struttura. Il lavoro procede senza costanti interventi manuali.

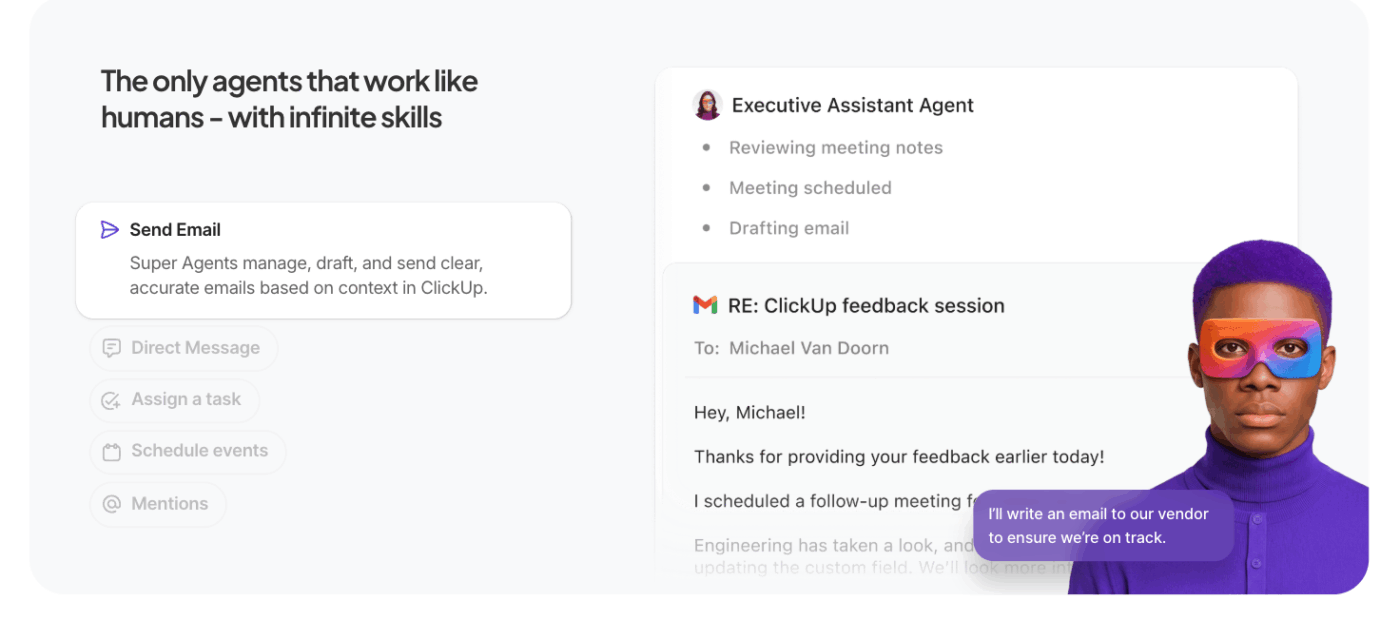

Lascia che siano gli agenti IA a fare il lavoro pesante

I Super Agent di ClickUp estendono l'IA contestuale di ClickUp oltre le singole query, consentendo un'esecuzione autonoma in più passaggi.

Invece di attendere prompt specifici, questi agenti IA per l'automazione agiscono per conto tuo all'interno dell'area di lavoro, svolgendo attività, regole e risultati in base al contesto e agli obiettivi da te definiti.

Cosa li distingue dagli agenti normali:

- Esecuzione proattiva delle attività: gli agenti interpretano il contesto dell'area di lavoro (attività, dipendenze, tempistiche) ed eseguono sequenze come l'aggiornamento degli stati, la creazione di attività secondarie o la notifica ai titolari senza indicazioni manuali.

- Flussi di lavoro orientati agli obiettivi: si definisce un obiettivo di alto livello (ad esempio, "Risolvere gli ostacoli nella campagna del terzo trimestre") e l'agente pianifica, recupera il contesto ed esegue le azioni che fanno avanzare il lavoro.

- Contesto e memoria persistenti: gli agenti mantengono lo stato attraverso i vari passaggi, consentendo loro di ragionare su ciò che è già stato terminato e ciò che resta da fare, migliorando l'accuratezza e riducendo il lavoro ridondante.

- Integrazione con gli strumenti dell'area di lavoro: interagiscono con le attività di ClickUp, i documenti e i commenti, nonché con gli strumenti collegati, coordinandosi tra i sistemi per completare i flussi di lavoro invece di suggerire azioni senza contesto.

📚 Per saperne di più: Cosa sono gli agenti riflessi basati su modelli

Le migliori funzionalità di ClickUp

- Porta l'IA sul tuo desktop e nelle app connesse con ClickUp Brain MAX: effettua ricerche nella tua area di lavoro, trascrivi il parlato in testo, passa da un modello IA all'altro e agisci su attività, documenti e chat senza interrompere il tuo flusso di lavoro.

- Trova le risposte all'istante con Enterprise Search : effettua ricerche tra attività, documenti, commenti, file e strumenti collegati, in modo che il contesto critico non venga mai sepolto o isolato.

- Cattura rapidamente le idee con Talk to Text : detta note, piani o aggiornamenti e converti il parlato in lavoro strutturato senza perdere la concentrazione o lo slancio.

- Riduci il lavoro manuale con ClickUp Dashboards : attiva automaticamente aggiornamenti delle attività, assegnazioni e follow-up in base al contesto reale dell'area di lavoro e ai cambiamenti di stato.

- Mantieni le discussioni concrete con ClickUp Chat: discuti decisioni, feedback e approvazioni direttamente insieme alle attività, in modo che le conversazioni rimangano legate all'esecuzione.

- Sostituisci le riunioni con SyncUps: condividi aggiornamenti asincroni, ottieni riepiloghi/riassunti generati dall'IA e mantieni i team allineati senza chiamate ricorrenti.

- Coordinare i team con Teams Hub: visualizzare l'attività, la titolarità, le priorità e la capacità del team in un unico posto per individuare i rischi e riequilibrare il lavoro in anticipo.

- Pianifica la tua giornata con ClickUp Calendario : ottieni piani giornalieri assistiti dall'IA basati su scadenze, priorità e carico di lavoro, in modo che la tua concentrazione personale sia in linea con gli obiettivi del team.

Limiti di ClickUp

- Le sue funzionalità e opzioni di personalizzazione possono sopraffare i nuovi utenti.

Prezzi di ClickUp

Valutazioni e recensioni di ClickUp

- G2: 4,7/5 (oltre 10.585 recensioni)

- Capterra: 4. 6/5 (oltre 4.500 recensioni)

Cosa dicono gli utenti reali di ClickUp AI?

Un utente di ClickUp effettua la condivisione della propria esperienza su G2:

ClickUp Brain MAX è stato un'aggiunta incredibile al mio flusso di lavoro. Il modo in cui combina più LLM in un'unica piattaforma rende le risposte più veloci e affidabili, e la conversione da voce a testo in tutta la piattaforma fa risparmiare un sacco di tempo. Apprezzo molto anche la sicurezza di livello aziendale, che mi dà tranquillità quando gestisco informazioni sensibili. […] Ciò che spicca di più è come mi aiuta a eliminare le distrazioni e a pensare in modo più chiaro, sia che io stia riepilogando riunioni, redigendo contenuti o facendo brainstorming di nuove idee. È come avere un assistente IA all-in-one che si adatta a qualsiasi mia esigenza.

ClickUp Brain MAX è stato un'aggiunta incredibile al mio flusso di lavoro. Il modo in cui combina più LLM in un'unica piattaforma rende le risposte più veloci e affidabili, e la conversione da voce a testo in tutta la piattaforma fa risparmiare un sacco di tempo. Apprezzo molto anche la sicurezza di livello aziendale, che mi dà tranquillità quando gestisco informazioni sensibili. […] Ciò che spicca di più è come mi aiuta a eliminare le distrazioni e a pensare in modo più chiaro, sia che io stia riepilogando riunioni, redigendo contenuti o facendo brainstorming di nuove idee. È come avere un assistente IA all-in-one che si adatta a qualsiasi mia esigenza.

Sfide e considerazioni quando si lavora con l'ingegneria del contesto IA

Ecco le sfide principali di cui devi essere consapevole. Il contesto può sfuggire di mano, anche quando il modello offre supporto per finestre di contesto da 1 milione di token. Ecco le sfide principali di cui devi essere consapevole 👇

Contaminazione del contesto

Se un'allucinazione o un'inferenza errata si insinua nel contesto e viene ripetutamente citata, il modello la tratta come un fatto. Questo contesto avvelenato può bloccare i flussi di lavoro in ipotesi non valide che persistono nel tempo e degradano la qualità dell'output.

Distrazione dal contesto

I contesti più ampi sono allettanti, ma quando diventano troppo grandi, i modelli iniziano a concentrarsi eccessivamente sulla cronologia accumulata e a sottoutilizzare ciò che hanno appreso durante l'addestramento. Ciò può indurre l'IA a ripetersi sui dettagli passati invece di sintetizzare il passaggio successivo migliore.

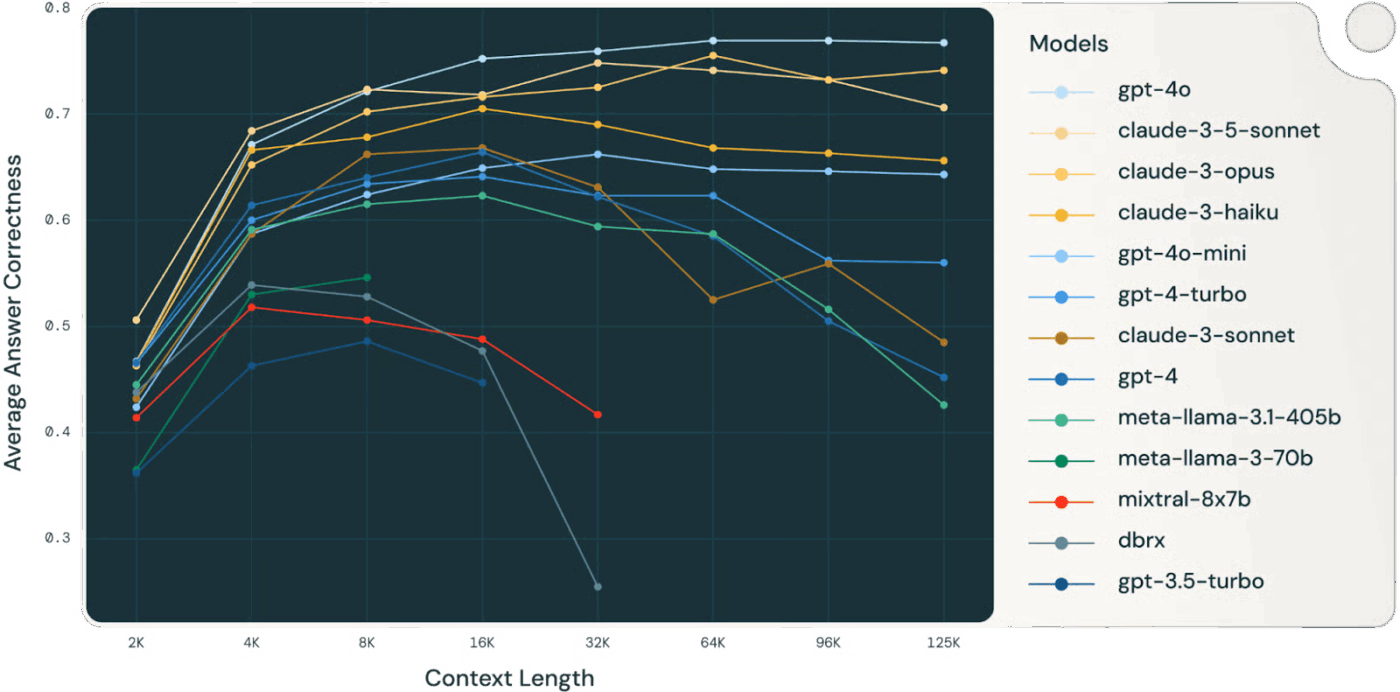

👀 Lo sapevate? Uno studio di Databricks ha rilevato che l'accuratezza del modello per Llama 3. 1 405B ha iniziato a diminuire intorno ai 32.000 token, ben prima che la finestra di contesto fosse piena. I modelli più piccoli hanno subito un degrado ancora più precoce.

I modelli spesso perdono qualità di ragionamento molto prima di "esaurire" il contesto, rendendo la selezione e la compressione del contesto più importanti della dimensione grezza del contesto stesso.

📚 Per saperne di più: Che cos'è la ricerca sul posto di lavoro e come migliora la produttività dei dipendenti

Confusione contestuale

Le informazioni irrilevanti o con un segnale debole nel contesto competono per l'attenzione con i dati critici. Quando il modello si sente costretto a utilizzare ogni token di contesto, le decisioni diventano confuse e l'accuratezza ne risente, anche se tecnicamente ci sono "più" informazioni.

Conflitto di contesto

Man mano che le informazioni si accumulano, nuovi fatti o descrizioni di strumenti possono contraddire i contenuti precedenti. Quando esistono contesti contrastanti, i modelli faticano a conciliare segnali contrastanti, portando a risultati incoerenti o incongruenti.

Sovraccarico di strumenti e problemi di selezione

Quando nel contesto sono incluse troppe definizioni di strumenti, senza alcun filtro, il modello può richiamare strumenti irrilevanti o dare priorità a quelli non ottimali. Il caricamento selettivo dei soli strumenti rilevanti riduce la confusione e migliora la qualità delle decisioni.

Complessità ingegneristica e manutenzione

Una gestione efficace del contesto richiede una continua potatura, riassunzione, scaricamento e messa in quarantena del contesto. I sistemi devono decidere quando comprimere la cronologia e quando recuperare nuove informazioni, richiedendo un'infrastruttura ben ponderata piuttosto che trucchi ad hoc.

Disciplina nel budget dei token

Ogni token influenza il comportamento; finestre di contesto più ampie non garantiscono risultati migliori. È necessario trattare il contesto come una risorsa gestita, valutando la rilevanza e l'attualità rispetto al costo dei token e al budget di attenzione del modello.

⚠️ Statistica: quasi il 60% dei dipendenti ammette di utilizzare strumenti di IA pubblici non autorizzati sul posto di lavoro, spesso incollando dati aziendali sensibili su piattaforme senza alcun controllo.

E c'è di peggio: il 63% delle organizzazioni non dispone di politiche di governance dell'IA per monitorare, limitare o persino rilevare questo utilizzo nascosto dell'IA.

Risultato? I tuoi dati vengono divulgati perché nessuno controlla come viene utilizzata l'IA.

Il futuro dell'ingegneria del contesto

Questo segna il passaggio dalla sperimentazione alla scalabilità. Il contesto non sarà più gestito dagli esseri umani, ma generato e gestito dal codice. Sarà una funzione della struttura stessa del sistema.

Riassumeremo questo concetto utilizzando come base l'eccellente articolo di Serge Liatko sulla comunità di sviluppatori OpenAI:

L'ingegneria del contesto si evolve nell'architettura del flusso di lavoro

L'ingegneria del contesto lascerà sempre più spazio all'architettura automatizzata del flusso di lavoro. L'attività non si limiterà più all'inserimento dei token corretti.

Un'ingegneria del contesto efficace comporta l'orchestrazione di intere sequenze di ragionamenti, strumenti e flussi di dati che si adattano automaticamente alle mutevoli esigenze.

Ciò significa costruire sistemi dinamici in grado di autogestire il contesto corretto all'interno di flussi di lavoro olistici.

L'orchestrazione automatizzata sostituisce i prompt manuali

La prossima frontiera è l'IA che si organizza da sola. Collegherà il recupero, gli strumenti, la memoria e la logica aziendale senza che gli esseri umani debbano creare manualmente ogni prompt o pacchetto di contesto. Anziché fornire esplicitamente ogni singolo dato, i sistemi dedurranno quale contesto è rilevante e lo gestiranno automaticamente in base agli obiettivi e alla cronologia.

🧠 Questo sta già accadendo con i Super Agenti di ClickUp. Sono compagni di squadra IA ambientali e sempre attivi, che aiutano a comprendere ed eseguire il lavoro proprio come fanno gli esseri umani. Migliorano continuamente dalle interazioni passate utilizzando una memoria ricca (preferenze di apprendimento, azioni recenti e cronologia dei progetti) e possono agire in modo proattivo, segnalare problemi o fornire approfondimenti senza attendere un prompt.

L'automazione end-to-end diventa la vera leva della produttività

Con l'evoluzione dell'ingegneria del contesto, i guadagni in termini di produttività derivano dai flussi di lavoro automatizzati. Gli LLM agiscono come agenti, coordinando gli strumenti, monitorando lo stato ed eseguendo logiche in più passaggi senza la microgestione da parte dell'utente.

Non sarà necessario inserire manualmente il contesto mancante. Il sistema curerà il contesto per fornire supporto alla memoria a lungo termine e al ragionamento.

Il contesto unificato migliora il lavoro dell'IA

L'accuratezza dell'IA viene compromessa quando il contesto è frammentato tra strumenti, flussi di lavoro e persone. Quando le informazioni sono disperse, i modelli sono costretti a fare delle ipotesi.

Le aree di lavoro AI convergenti come ClickUp eccellono in questo, unificando lavoro, dati e IA nella vostra strategia contestuale.

Pronti a provare? Registratevi gratis su ClickUp.