Wraz ze wzrostem mocy modeli LLM, wyświetlanie podpowiedzi nie jest już trudnym zadaniem. Ograniczeniem staje się kontekst.

Inżynieria kontekstowa polega na dostarczaniu odpowiednich informacji w odpowiednim formacie do modeli LLM (dużych modeli językowych).

Co sprawia, że inżynieria kontekstowa jest trudna?

Musisz zaprojektować każdą warstwę stosu, aby uchwycić kontekst i udostępnić go. Jeśli wyślesz zbyt mało kontekstu, modele LLM nie będą wiedzieć, co robić. Jeśli wyślesz zbyt dużo kontekstu, zabraknie Ci tokenów. Jak więc znaleźć równowagę?

Poniżej udostępniamy wszystko, co należy wiedzieć o inżynierii kontekstowej.

Czym jest inżynieria kontekstu AI?

Inżynieria kontekstowa AI to proces projektowania i optymalizacji instrukcji oraz odpowiedniego kontekstu dla modeli LLM, zaawansowanych modeli AI i modeli multimodalnych, aby mogły one skutecznie wykonywać swoje zadania.

To wykracza poza pisanie podpowiedzi. Inżynieria kontekstu określa:

- Jakie informacje są ujawniane

- Skąd pochodzi (pamięć, narzędzia, bazy danych, dokumenty)

- Jak jest formatowany (schematy, streszczenia, ograniczenia)

- Kiedy jest on wprowadzany do pętli rozumowania modelu

🌟 Cel: Optymalizacja informacji podawanych w oknie kontekstowym modelu LLM i odfiltrowanie niepotrzebnych informacji.

W jaki sposób kontekst poprawia odpowiedzi AI?

Bez kontekstu model LLM przewiduje najbardziej prawdopodobną statystycznie kontynuację tekstu. Z drugiej strony, dobra inżynieria kontekstu poprawia wyniki poprzez:

- Ankryowanie rozumowania: model opiera swoje odpowiedzi na znanych faktach, a nie na statystycznych przypuszczeniach.

- Ograniczanie halucynacji: jasne ograniczenia i odpowiednie dane zawężają przestrzeń rozwiązań.

- Poprawa spójności: podobne dane wejściowe dają podobne wyniki, ponieważ kształt kontekstu jest stabilny.

- Obniżenie kosztów i opóźnień: ukierunkowany kontekst jest lepszy niż zrzucanie całych dokumentów lub historii.

Podsumowując to słowami Tobi Lutke, dyrektora generalnego Shopify:

Bardziej podoba mi się termin „inżynieria kontekstu” niż „inżynieria podpowiedzi”. Lepiej opisuje on podstawową umiejętność: sztukę dostarczania całego kontekstu zadania, aby model LLM mógł je rozwiązać w sposób wiarygodny.

Bardziej podoba mi się termin „inżynieria kontekstu” niż „inżynieria podpowiedzi”. Lepiej opisuje on podstawową umiejętność: sztukę dostarczania całego kontekstu zadania, aby model LLM mógł je rozwiązać w sposób wiarygodny.

Rola inżynierii kontekstowej w cyklach pracy opartych na AI

W cyklach pracy opartych na AI modele LLM nie są samodzielnymi narzędziami. Działają one w ramach systemów, które już posiadają dane, reguły i stan.

Inżynieria kontekstowa pozwala modelowi zrozumieć, gdzie znajduje się w cyklu pracy i co może zrobić dalej.

Gdy model jest świadomy aktualnego stanu, przeszłych działań i brakujących danych wejściowych, może zalecić lub wykonać właściwy kolejny krok zamiast generować ogólne porady.

Oznacza to również wyraźne określenie logiki biznesowej, takiej jak zasady zatwierdzania, ograniczenia zgodności i ścieżki eskalacji. Gdy są one częścią kontekstu, decyzje AI pozostają zgodne z rzeczywistością operacyjną.

Wreszcie, inżynieria kontekstowa umożliwia wieloetapowe i agencyjne cykle pracy, zapewniając przejrzyste przekazywanie stanu i decyzji na każdym kroku.

Zapobiega to kumulowaniu się błędów w miarę skalowania cykli pracy, poprawiając tym samym skuteczność kontekstu.

👀 Czy wiesz, że... 95% wdrożeń GenAI w przedsiębiorstwach kończy się niepowodzeniem nie dlatego, że modele są słabe, ale dlatego, że organizacje nie potrafią zintegrować AI z rzeczywistymi cyklami pracy.

Ogólne narzędzia AI, takie jak ChatGPT, sprawdzają się dobrze w przypadku osób indywidualnych, ale zawodzą na większą skalę, ponieważ nie uczą się na podstawie kontekstu systemowego, reguł biznesowych ani zmieniającego się stanu. Innymi słowy, większość niepowodzeń AI wynika z błędów integracji i kontekstu, a nie z błędów modelu.

📮ClickUp Insight: 62% naszych respondentów korzysta z narzędzi AI do konwersacji, takich jak ChatGPT i Claude. Ich znany interfejs chatbota i wszechstronne możliwości — generowanie zawartości, analiza danych i nie tylko — mogą być powodem, dla którego są one tak popularne w różnych rolach i branżach. Jeśli jednak użytkownik musi za każdym razem przełączać się do innej zakładki, aby zadać pytanie AI, związane z tym koszty przełączania i zmiany kontekstu z czasem się sumują. Nie dotyczy to jednak ClickUp Brain. Działa on bezpośrednio w Twoim obszarze roboczym, wie, nad czym pracujesz, rozumie zwykłe teksty i udziela odpowiedzi, które są bardzo istotne dla Twoich zadań! Z ClickUp zwiększ swoją wydajność dwukrotnie!

Jak działa inżynieria kontekstowa?

Inżynieria kontekstowa polega na stopniowym kształtowaniu informacji, zanim trafią one do modelu.

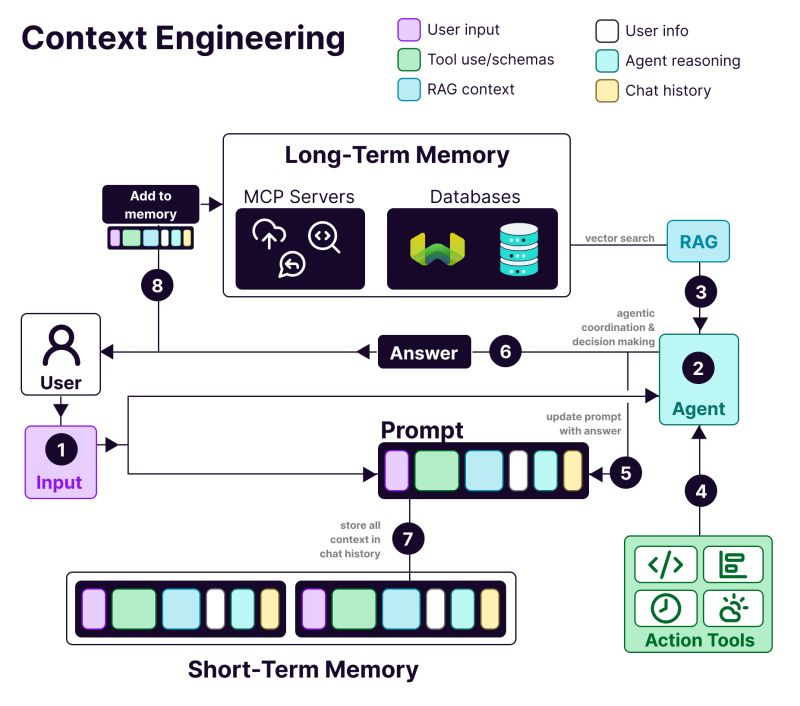

Anatomia systemu opartego na inżynierii kontekstowej obejmuje:

- 𝗨𝘀𝗲𝗿 i𝗻𝗳𝗼𝗿𝗺𝗮𝘁𝗶𝗼𝗻: Preferencje, historia i dane personalizacyjne

- T𝗼𝗼𝗹 u𝘀𝗲: API, kalkulatory, wyszukiwarki — wszystko, czego potrzebuje model LLM, aby zrealizować zadanie.

- 𝗥𝗔𝗚 c𝗼𝗻𝘁𝗲𝘅𝘁: Pobrane informacje z baz danych wektorowych, takich jak Weaviate.

- 𝗨𝘀𝗲𝗿 i𝗻𝗽𝘂𝘁: Rzeczywiste zapytanie lub zadanie do wykonania

- 𝗔𝗴𝗲𝗻𝘁 r𝗲𝗮𝘀𝗼𝗻𝗶𝗻𝗴: Proces myślowy i łańcuch decyzyjny modelu LLM

- 𝗖𝗵𝗮𝘁 h𝗶𝘀𝘁𝗼𝗿𝘆: Poprzednie interakcje zapewniające ciągłość

Korzyści płynące z inżynierii kontekstowej w systemach AI

Oto dlaczego podczas tworzenia aplikacji AI potrzebna jest inżynieria kontekstowa:

Bardziej dokładne wyniki

Dostarczenie kontekstu istotnego dla podejmowania decyzji zmniejsza niejasności. Model opiera się na znanych faktach, ograniczeniach i stanach, zamiast polegać na prawdopodobieństwach.

Spójne zachowanie na dużą skalę

Stabilne struktury kontekstowe zapewniają powtarzalne wyniki. Podobne dane wejściowe prowadzą do podobnych decyzji, co jest niezbędne w cyklach pracy.

Zmniejszone koszty i opóźnienia

Ukierunkowany, skompresowany kontekst pozwala uniknąć marnowania tokenów. Systemy reagują szybciej, bez konieczności wielokrotnego ładowania pełnej historii lub dokumentów.

Bezpieczniejsza automatyzacja

Kontekst koduje reguły biznesowe i uprawnienia. Dzięki temu AI może działać bez naruszania zasad lub wywoływania ryzykownych działań jako wyzwalacz.

Lepsze wieloetapowe cykle pracy

Czyste przekazywanie kontekstu pozwala zachować stan na wszystkich krokach. Błędy nie kumulują się wraz ze wzrostem złożoności lub aktywności cykli pracy.

Łatwiejsze debugowanie i iteracja

Strukturalny kontekst zapewnia widoczność błędów. Można je przypisać brakującym, nieaktualnym lub nieprawidłowo sklasyfikowanym danym wejściowym, zamiast obwiniać model.

Silniejsze wdrożenie w przedsiębiorstwach

Systemy AI, które uwzględniają kontekst cyklu pracy, wydają się niezawodne — jest to kluczowa różnica między wersjami pilotażowymi a narzędziami przeznaczonymi do wdrożenia w całym przedsiębiorstwie.

📚 Czytaj więcej: Jak wykorzystać AI dzięki dostępowi do danych w czasie rzeczywistym

👀 Czy wiesz, że... Sztuczna inteligencja uwzględniająca kontekst ma bezpośredni wpływ na wydajność. Badanie przeprowadzone przez Boston Consulting Group wykazało, że same zespoły ds. komunikacji mogą odzyskać 26–36% swojego czasu dzięki generatywnej sztucznej inteligencji, a dzięki przeprojektowanym cyklom pracy i systemom agencyjnym, które rozumieją kontekst, wzrost wydajności może sięgnąć nawet 50%.

Inżynieria kontekstu AI a inżynieria podpowiedzi

Inżynieria podpowiedzi: Poproś ChatGPT o napisanie wiadomości e-mail z ogłoszeniem o nowej funkcji. Piszesz instrukcje dotyczące pojedynczego zadania.

Inżynieria kontekstu: Tworzysz bota do obsługi klienta. Musi on pamiętać poprzednie zgłoszenia, mieć dostęp do szczegółów konta użytkownika i przechowywać historię rozmów.

Jak wyjaśnia badacz AI Andrej Karpathy:

Ludzie kojarzą podpowiedzi z krótkimi opisami zadań, które podaje się modelowi LLM w codziennym użytkowaniu. W każdej przemysłowej aplikacji LLM inżynieria kontekstu jest delikatną sztuką i nauką wypełniania okna kontekstowego odpowiednimi informacjami potrzebnymi do wykonania kolejnego kroku.

Ludzie kojarzą podpowiedzi z krótkimi opisami zadań, które podaje się modelowi LLM w codziennym użytkowaniu. W każdej przemysłowej aplikacji LLM inżynieria kontekstu jest delikatną sztuką i nauką wypełniania okna kontekstowego odpowiednimi informacjami potrzebnymi do wykonania kolejnego kroku.

+1 dla „inżynierii kontekstowej” zamiast „inżynierii podpowiedzi”.

Ludzie kojarzą podpowiedzi z krótkimi opisami zadań, które podaje się modelowi LLM w codziennym użytkowaniu. W każdej przemysłowej aplikacji LLM inżynieria kontekstowa jest delikatną sztuką i nauką wypełniania okna kontekstowego… https://t.co/Ne65F6vFcf

— Andrej Karpathy (@karpathy) 25 czerwca 2025 r.

+1 dla „inżynierii kontekstowej” zamiast „inżynierii podpowiedzi”.

Ludzie kojarzą podpowiedzi z krótkimi opisami zadań, które podaje się modelowi LLM w codziennym użytkowaniu. W każdej przemysłowej aplikacji LLM inżynieria kontekstowa jest delikatną sztuką i nauką wypełniania okna kontekstowego… https://t.co/Ne65F6vFcf

— Andrej Karpathy (@karpathy) 25 czerwca 2025 r.

| Podejście | Na czym się koncentruje | Najlepsze zastosowanie |

| Inżynieria podpowiedzi | Tworzenie instrukcji i formatów wyjściowych dla modelu | Zadania jednorazowe, generowanie zawartości, wyniki specyficzne dla formatu |

| Inżynieria kontekstu | Dostarczanie modelowi odpowiednich danych, stanu i ograniczeń | Sztuczna inteligencja konwersacyjna, narzędzia do analizy dokumentów, asystenci kodowania |

| Oba razem | Połączenie jasnych instrukcji z kontekstem na poziomie systemu | Produkcyjne aplikacje AI, które wymagają spójnej, niezawodnej wydajności |

Większość aplikacji wykorzystuje połączenie inżynierii podpowiedzi i inżynierii kontekstu. W systemie inżynierii kontekstu nadal potrzebne są dobrze napisane podpowiedzi.

Różnica polega na tym, że te podpowiedzi działają w oparciu o starannie zarządzane informacje ogólne. Nie trzeba zaczynać od nowa za każdym razem.

📮 ClickUp Insight: Ponad połowa respondentów codziennie korzysta z trzech lub więcej narzędzi, zmagając się z „ rozrostem AI ” i rozproszonymi cyklami pracy.

Chociaż może się to wydawać produktywne i zajęte, Twój kontekst po prostu gubi się w różnych aplikacjach, nie wspominając już o energii zużywanej na pisanie. Brain MAX łączy to wszystko: wystarczy raz powiedzieć, a Twoje aktualizacje, zadania i notatki trafią dokładnie tam, gdzie powinny w ClickUp. Koniec z przełączaniem się, koniec z chaosem — tylko płynna, scentralizowana wydajność.

Zastosowania inżynierii kontekstowej AI

Kluczowe obszary, w których już wdrażana jest inżynieria kontekstowa AI, to 👇

Obsługa klienta i automatyzacja pomocy technicznej

Większość chatbotów traktuje każdą wiadomość jako nową, zmuszając użytkowników do ciągłego powtarzania się.

Dzięki inżynierii kontekstowej AI może odwoływać się do historii użytkownika, poprzednich interakcji, zapisów zakupów i dokumentacji produktu. Dzięki temu reaguje jak członek zespołu, który już zna problem.

📌 Przykład z życia: Zespół wsparcia technicznego Coda zajmuje się pytaniami technicznymi dotyczącymi produktów, które wymagają zrozumienia wcześniejszych wiadomości i odniesień do dokumentacji produktu. Aby zwiększyć skalę wsparcia, używają Intercom Fin. Fin czyta dokumentację i wcześniejsze rozmowy przed udzieleniem odpowiedzi, pomagając samodzielnie rozwiązać 50–70% pytań klientów, jednocześnie utrzymując wysoki poziom CSAT.

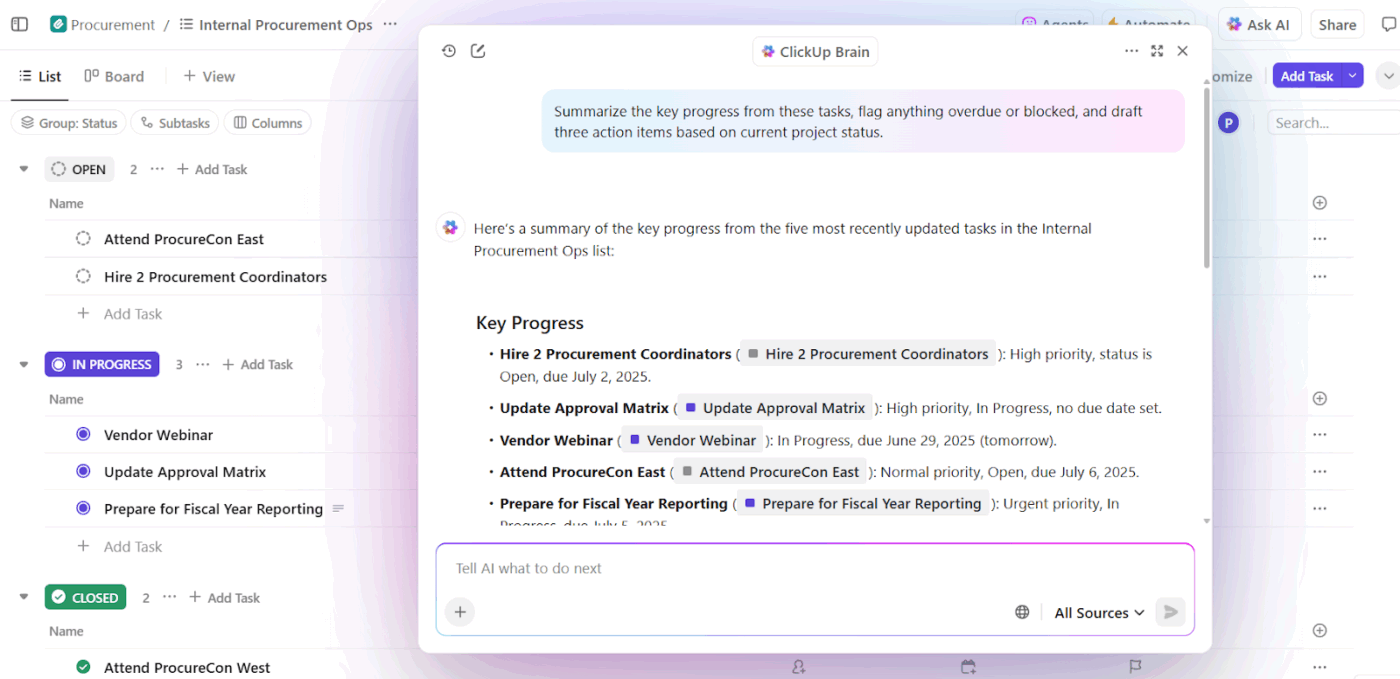

Asystenci AI do pisania i zwiększania wydajności w miejscu pracy

Narzędzia AI do pisania przynoszą wartość tylko wtedy, gdy rozumieją, nad czym pracujesz, dlaczego jest to ważne i co już istnieje. Bez tego kontekstu oszczędzają czas na tworzeniu szkicu, ale nadal wymagają znacznych poprawek i ręcznego dostosowywania.

W tym miejscu inżynieria kontekstowa AI zmienia wyniki. Opierając AI na stanie zadania, dokumentach, poprzednich decyzjach i konwencjach zespołu, asystenci pisania przechodzą od generowania ogólnych tekstów do wsparcia uwzględniającego cykl pracy.

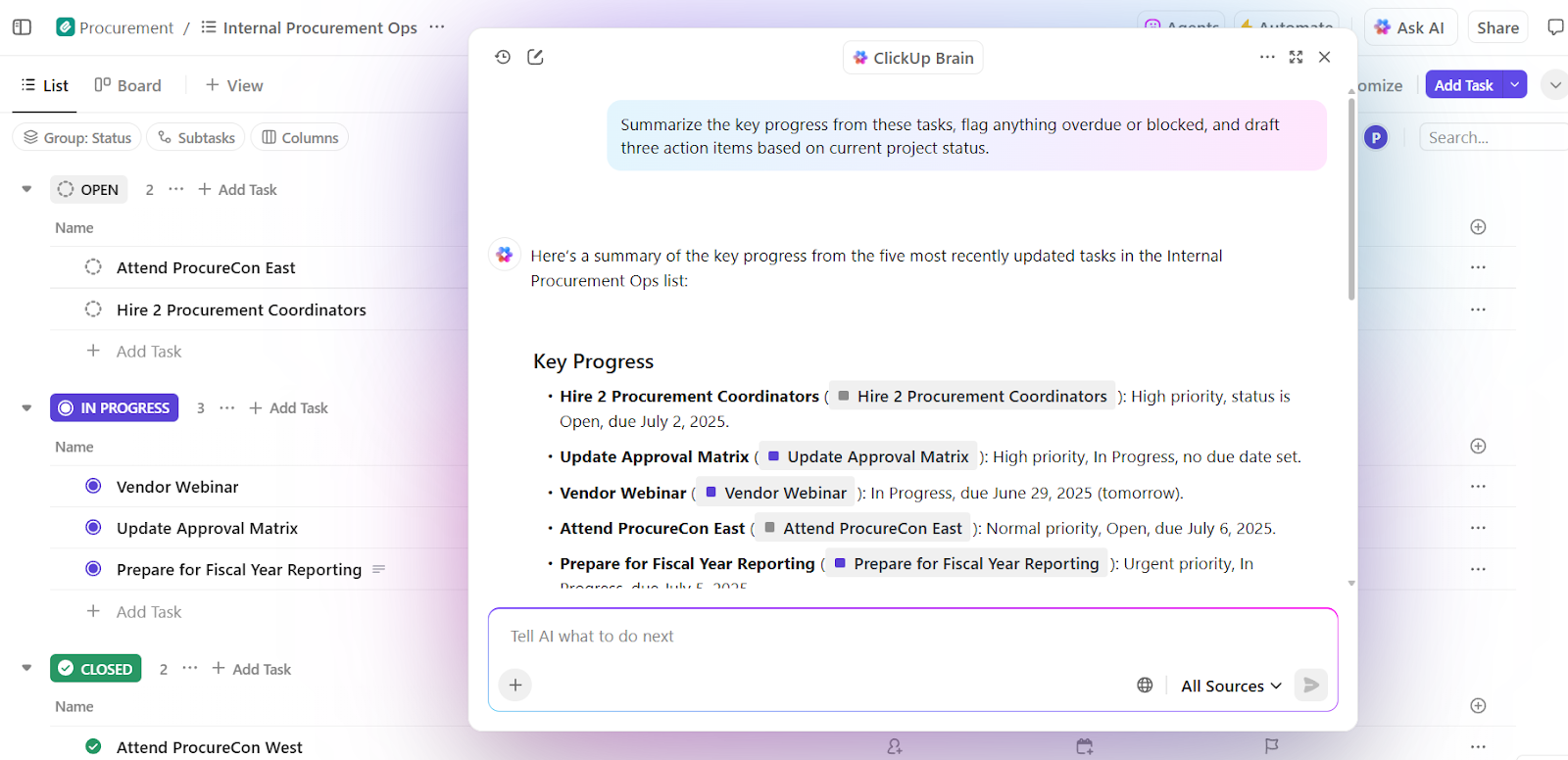

📌 Przykład z życia: ClickUp Brain, natywna AI ClickUp, stosuje inżynierię kontekstową na poziomie obszaru roboczego. Zamiast prosić użytkowników o wklejenie informacji dodatkowych do podpowiedzi, pobiera kontekst bezpośrednio z zadań, dokumentów, komentarzy, priorytetów i osi czasu.

Kluczową umiejętnością jest podejmowanie decyzji w oparciu o kontekst. Ocenia ona bieżące projekty wraz z obciążeniem zespołu i dotychczasowymi wynikami, aby uzyskać praktyczne wnioski.

Po pierwsze, Brain potrafi wykrywać przeciążenia, opóźnienia i wąskie gardła. Oprócz podsumowania problemu, zaleca również konkretne zmiany – w postaci redystrybucji zadań, aktualizacji osi czasu i ponownego rozłożenia priorytetów.

Ponieważ decyzje te są oparte na kontekście rzeczywistego obszaru roboczego, wynik jest natychmiast gotowy do użycia. Nie ma potrzeby ponownego przedstawiania kontekstu, wyjaśniania priorytetów ani ręcznego dostosowywania zaleceń do rzeczywistości.

Zespoły korzystające z ClickUp Brain odnotowują 2,26-krotnie wyższy wskaźnik pełnej integracji i najniższy poziom frustracji związanej z AI (27,1%).

Sprzedaż i inteligencja CRM

Cykl pracy sprzedaży obejmuje e-maile, spotkania, systemy CRM i arkusze kalkulacyjne. Bez kontekstu AI nie jest w stanie zrozumieć dynamiki transakcji ani intencji kupującego.

Inżynieria kontekstowa zapewnia AI widoczność w rozmowach kupujących, na osiach czasu, w tonie komunikacji i w dotychczasowych interakcjach. Pomaga to w uzyskaniu wglądu w sytuację, wykryciu utkniętych transakcji i zaproponowaniu odpowiedniego kolejnego działania.

📌 Przykład z życia: Własny zespół sprzedaży firmy Microsoft korzysta z Copilot for Sales, który pobiera kontekst z Outlooka, rozmów w Teams, aktualizacji CRM i notatek, aby wyświetlać odpowiednie informacje i tworzyć projekty działań następczych. Zespoły wewnętrzne odnotowały 20-procentowy wzrost liczby wygranych transakcji i 9,4-procentowy wzrost przychodów na sprzedawcę, co pokazuje, jak AI oparta na kontekście zwiększa wydajność.

Asystenci AI w służbie zdrowia i medycynie klinicznej

Decyzje medyczne opierają się na historii pacjenta, wynikach badań laboratoryjnych, receptach i notatkach lekarskich, ale informacje te często znajdują się w oddzielnych systemach. Prowadzi to do tego, że lekarze tracą dużo czasu na ponowne wprowadzanie danych i ryzykują przeoczenie kluczowych szczegółów. Czasami prawie 40% swojego czasu poświęcają na prace administracyjne.

Inżynieria kontekstowa AI zapewnia połączenie tych punktów danych. Oferuje wsparcie lekarzom, dostarczając dokładne podsumowania, projekty dokumentacji, podkreślając istotną historię i wskazując potencjalne ryzyko lub kolejne kroki.

📌 Przykład z życia: Atrium Health korzysta z Nuance DAX Copilot, opracowanego we współpracy z Microsoftem, do automatycznego dokumentowania wizyt klinicznych na podstawie wcześniejszych zapisów i rozmów w czasie rzeczywistym. W wyniku lekarze zaoszczędzili 30–40 minut dziennie na dokumentacji, a badanie obejmujące 12 specjalizacji medycznych wykazało wyższą wydajność i satysfakcję dostawców usług medycznych bez uszczerbku dla bezpieczeństwa pacjentów.

Asystenci ds. kadr i rekrutacji

Decyzje rekrutacyjne zależą od kontekstu, takiego jak umiejętności, opinie z rozmów kwalifikacyjnych, dopasowanie do stanowiska i dane dotyczące poprzednich zatrudnień. Inżynieria kontekstowa AI pozwala analizować CV, opisy stanowisk, transkrypcje rozmów kwalifikacyjnych i historyczne wzorce, aby szybciej identyfikować najlepszych kandydatów.

📌 Przykład z życia: Zespoły Enterprise w firmie Micron korzystają z Eightfold AI, platformy analizującej CV, wymagania stanowisk, wewnętrzne ścieżki kariery i wyniki poprzednich rekrutacji w celu przewidywania dopasowania kandydatów do stanowisk. Platforma ocenia kandydatów na podstawie umiejętności i potencjału. Wynik? Rozszerzenie puli talentów i zatrudnienie ośmiu dodatkowych kandydatów miesięcznie przy niewielkim zespole rekrutacyjnym.

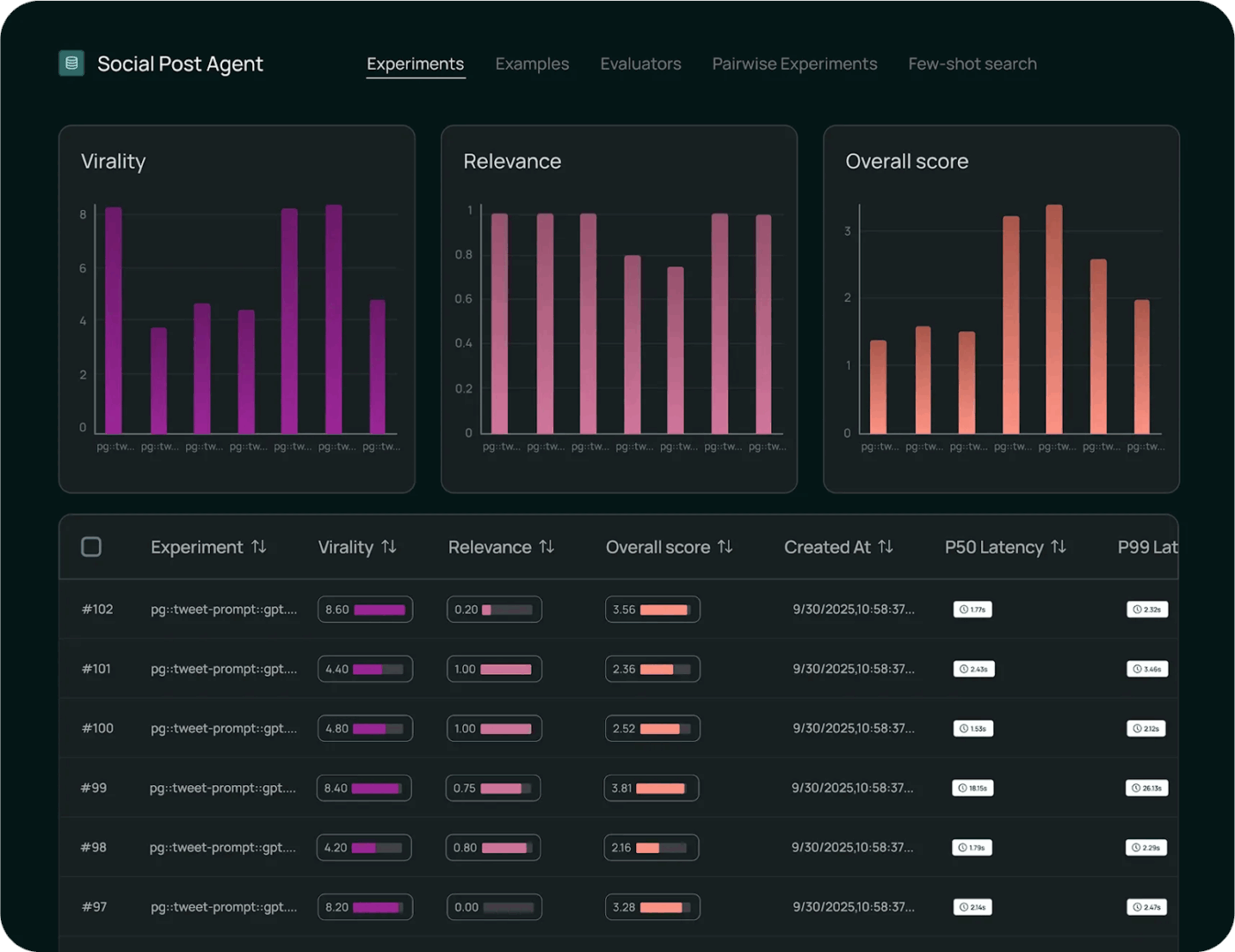

Narzędzia i platformy z wsparciem dla inżynierii kontekstowej

Jakie narzędzia pomagają wdrożyć inżynierię kontekstową na dużą skalę?

1. LangChain (najlepiej tworzyć kontekst programowo)

LangChain to otwarta platforma do tworzenia systemów AI, w których kontekst musi być gromadzony, aktualizowany i kierowany programowo.

Narzędzie AI agent pomaga programistom przeprowadzić połączenie modeli LLM z narzędziami, źródłami danych, pamięcią i logiką sterowania, zamiast polegać na statycznych podpowiedziach.

Core LangChain obsługuje łańcuchowanie i pobieranie, a LangGraph umożliwia stanowe, oparte na grafach cykle pracy dla złożonego, wieloetapowego rozumowania.

DeepAgents opiera się na tej podstawie w celu zapewnienia wsparcia dla długotrwałych, autonomicznych agentów poprzez planowanie, podagenci i trwały kontekst.

Wszystkie te elementy sprawiają, że LangChain jest warstwą kontrolną dla inżynierii kontekstowej, decydującą o tym, kiedy kontekst jest pobierany, jak się rozwija i gdzie przepływa w ramach cykli pracy agentów.

Najlepsze funkcje LangChain

- Monitoruj wykonywanie za pomocą narzędzi obserwacyjnych, aby przeprowadzać śledzenie wywołania modeli, opóźnienia, błędów i przepływu kontekstu od początku do końca w celu debugowania i uzyskania informacji o wydajności.

- Systematycznie oceniaj zachowanie modelu za pomocą wbudowanych frameworków testowych, które mierzą poprawność, porównują wyniki i weryfikują zmiany w odniesieniu do benchmarków.

- Wdrażaj cykle pracy na dużą skalę dzięki zarządzanym środowiskom, które zapewniają wsparcie dla wersjonowania, kontroli wdrażania oraz gotowego do produkcji wykonywania łańcuchów i agentów.

Ograniczenia LangChain

- Narzędzie to wymaga długiego okresu nauki dla początkujących, a dokumentacja, aktualizowana co kilka dni, sprawia, że jest ono przytłaczające.

Ceny LangChain

- Programista: Free

- Plus: 39 USD/użytkownik/miesiąc

- Enterprise: Ceny niestandardowe

Oceny i recenzje LangChain

- G2: 4,7/5 (ponad 30 recenzji)

- Capterra: Za mało ocen i recenzji

Co użytkownicy mówią o LangChain w praktyce?

Według użytkownika serwisu Reddit:

Po przetestowaniu kilku różnych metod, ostatecznie najbardziej spodobało mi się używanie standardowych narzędzi wywoływanych za pomocą langgraph worfklows. Tak więc opakowuję deterministyczne cykle pracy jako agenty, które główny LLM wywołuje jako narzędzia. W ten sposób główny LLM zapewnia prawdziwie dynamiczny interfejs użytkownika i po prostu przekazuje ciężkie zadania cykli pracy, które następnie ładnie zwraca swoje wyniki do głównego LLM.

Po przetestowaniu kilku różnych metod, ostatecznie najbardziej spodobało mi się używanie standardowych narzędzi wywoływanych za pomocą langgraph worfklows. Tak więc opakowuję deterministyczne cykle pracy jako agenty, które główny LLM wywołuje jako narzędzia. W ten sposób główny LLM zapewnia prawdziwie dynamiczny interfejs użytkownika i po prostu przekazuje ciężkie zadania cykli pracy, które następnie ładnie zwraca swoje wyniki do głównego LLM.

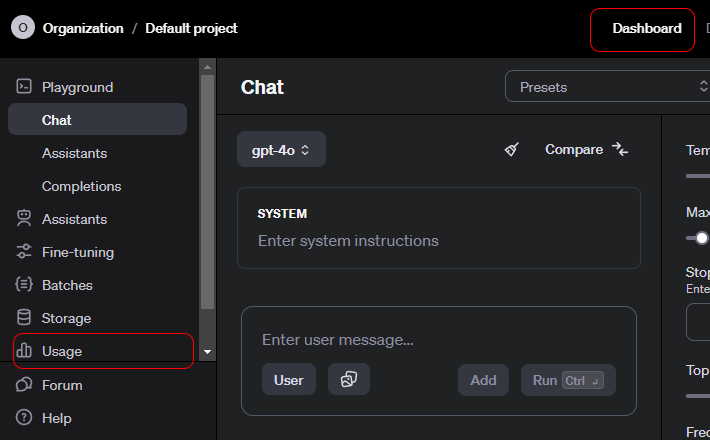

2. OpenAI API (Contextual AI API zapewnia ustrukturyzowany kontekst, wywoływanie narzędzi i kontrolę na poziomie systemu)

OpenAI API to uniwersalny interfejs umożliwiający dostęp do zaawansowanych modeli generatywnej sztucznej inteligencji, które zasilają szeroki zakres aplikacji.

Programiści wykorzystują ją do integracji rozumienia i generowania języka w produktach. Oferuje ona wsparcie dla funkcji podsumowywania, tłumaczenia, pomocy w pisaniu kodu i wnioskowania.

API oferuje wsparcie dla czatu, osadzania, wywoływania funkcji, moderacji i wielomodalnych danych wejściowych, umożliwiając ustrukturyzowaną interakcję z modelami. OpenAI doskonale nadaje się do szybkiego prototypowania, ponieważ oferuje wsparcie dla uwierzytelniania, skalowania i wersjonowania.

Łatwość użytkowania wynika z tego, że API przekształca złożone zachowania modelu w proste, niezawodne punkty końcowe.

Najlepsze funkcje API OpenAI

- Generuj wyniki uwzględniające kontekst w tekstach, kodach i danych multimodalnych dla zadań związanych z językiem naturalnym i wnioskowaniem.

- Stwórz bogate osadzenia, aby usprawnić wyszukiwanie semantyczne, klastrowanie i cykle pracy odzyskiwania oparte na wektorach.

- Wywołuj funkcje i narzędzia za pomocą ustrukturyzowanych wywołań, które umożliwiają modelom interakcję z zewnętrznymi systemami i usługami.

Limit API OpenAI

- Brak natywnej pamięci długotrwałej. API jest domyślnie bezstanowe.

Ceny API OpenAI

GPT-5. 2

- Wkład: 1,750 USD / 1 mln tokenów

- Wprowadzone dane w pamięci podręcznej: 0,175 USD / 1 mln tokenów

- Wynik: 14 000 USD / 1 mln tokenów

GPT-5. 2 Pro

- Wkład: 21,00 USD / 1 mln tokenów

- Wprowadzone dane w pamięci podręcznej: Niedostępne

- Wynik: 168,00 USD / 1 mln tokenów

GPT-5 Mini

- Wkład: 0,250 USD / 1 mln tokenów

- Wprowadzone dane w pamięci podręcznej: 0,025 USD / 1 mln tokenów

- Wynik: 2000 USD / 1 mln tokenów

Oceny i recenzje API OpenAI

- G2: Niewystarczająca liczba recenzji

- Capterra: Za mało recenzji

Co użytkownicy mówią o OpenAI API w praktyce?

Według użytkownika serwisu Reddit:

Interfejsy API OpenAI są takie same jak wszystkie inne, więc z technicznego punktu widzenia nie powinno być żadnej krzywej uczenia się. Wszystkie punkty końcowe, parametry i przykładowe odpowiedzi są dobrze udokumentowane. Jeśli masz podstawowe doświadczenie w programowaniu, nie powinieneś potrzebować kursu. Zgadzam się z powyższym punktem dotyczącym nauki języka Python. Biblioteki Python zawierają wszystkie istotne informacje, które ułatwiają życie. Jeśli chcesz pozostać przy JS, dostępne są również biblioteki Node. Największym wyzwaniem będzie nauka strategicznego wykorzystania tych narzędzi. Poświęć trochę czasu na wypróbowanie komunikatów systemowych, podpowiedzi użytkownika i parametrów w Playground, zanim spróbujesz zbudować je za pomocą kodu. (Jestem prawie pewien, że po znalezieniu czegoś, co działa, możesz uzyskać próbkę kodu z Playground).

Interfejsy API OpenAI są takie same jak wszystkie inne, więc z technicznego punktu widzenia nie powinno być żadnej krzywej uczenia się. Wszystkie punkty końcowe, parametry i przykładowe odpowiedzi są dobrze udokumentowane. Jeśli masz podstawowe doświadczenie w programowaniu, nie powinieneś potrzebować kursu. Zgadzam się z powyższym punktem dotyczącym nauki języka Python. Biblioteki Python zawierają wszystkie istotne informacje, które ułatwiają życie. Jeśli chcesz pozostać przy JS, dostępne są również biblioteki Node. Największym wyzwaniem będzie nauka strategicznego wykorzystania tych narzędzi. Poświęć trochę czasu na wypróbowanie komunikatów systemowych, podpowiedzi użytkownika i parametrów w Playground, zanim spróbujesz zbudować je za pomocą kodu. (Jestem prawie pewien, że po znalezieniu czegoś, co działa, możesz uzyskać próbkę kodu z Playground).

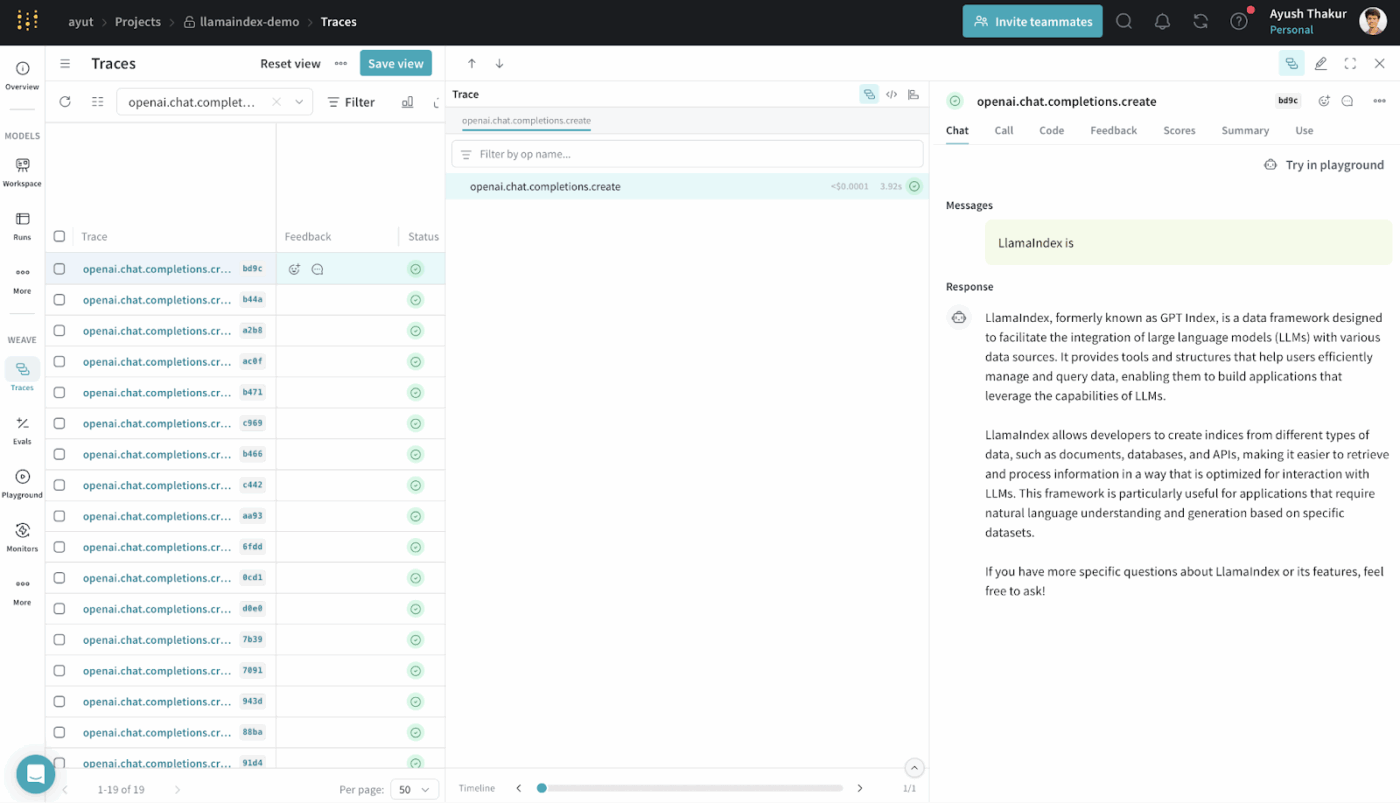

3. LlamaIndex (najlepszy system generowania rozszerzeń wyszukiwania)

LlamaIndex to otwarta platforma danych, która ma na celu udostępnienie danych zewnętrznych i umożliwienie ich wykorzystania przez duże modele językowe.

Zapewnia łącznik, indeksy i interfejsy zapytań, które przekształcają dane ustrukturyzowane i nieustrukturyzowane w reprezentacje, które modele LLM mogą efektywnie przetwarzać.

Można budować systemy RAG bez głębokiej infrastruktury niestandardowej. Abstrakcjonuje ona odzyskiwanie, wektoryzację i ranking trafności.

Jest to powszechnie stosowane w takich przypadkach, jak wyszukiwanie semantyczne, streszczanie i odpowiadanie na pytania w oparciu o rzeczywiste dane.

Najlepsze funkcje LlamaIndex

- Indeksuj heterogeniczne źródła danych w strukturach umożliwiających wyszukiwanie, które modele LLM mogą skutecznie wykorzystywać do zadawania zapytań.

- Strategicznie odzyskuj kontekst, korzystając z wyszukiwania wektorowego i planowania zapytań, aby precyzyjnie wprowadzać dowody.

- Skompresuj i podsumuj kontekst, aby rozumowanie było wydajne i trafne.

Ceny LlamaIndex

- Free

- Pakiet startowy: 50 USD/miesiąc

- Zaleta: 500 USD/miesiąc

- Enterprise: Niestandardowe ceny

Oceny i recenzje LlamaIndex

- G2: Niewystarczająca liczba recenzji

- Capterra: Za mało recenzji

Co użytkownicy mówią o LlamaIndex w praktyce?

Użytkownik udostępnia swoją opinię na Reddicie:

Szczerze mówiąc, uważam, że większość frameworków genAi, takich jak langchain czy llamaindex, nie jest zbyt dobra i komplikuje kod. Lepiej jest używać zwykłego języka Python.

Szczerze mówiąc, uważam, że większość frameworków genAi, takich jak langchain czy llamaindex, nie jest zbyt dobra i komplikuje kod. Lepiej jest używać zwykłego języka Python.

4. ClickUp BrainGPT (najlepszy jako asystent AI w obszarze roboczym)

Większość narzędzi z tej listy pomaga w konkretnych aspektach inżynierii kontekstowej. Tworzą one podpowiedzi, pobierają dane lub koordynują cykle pracy.

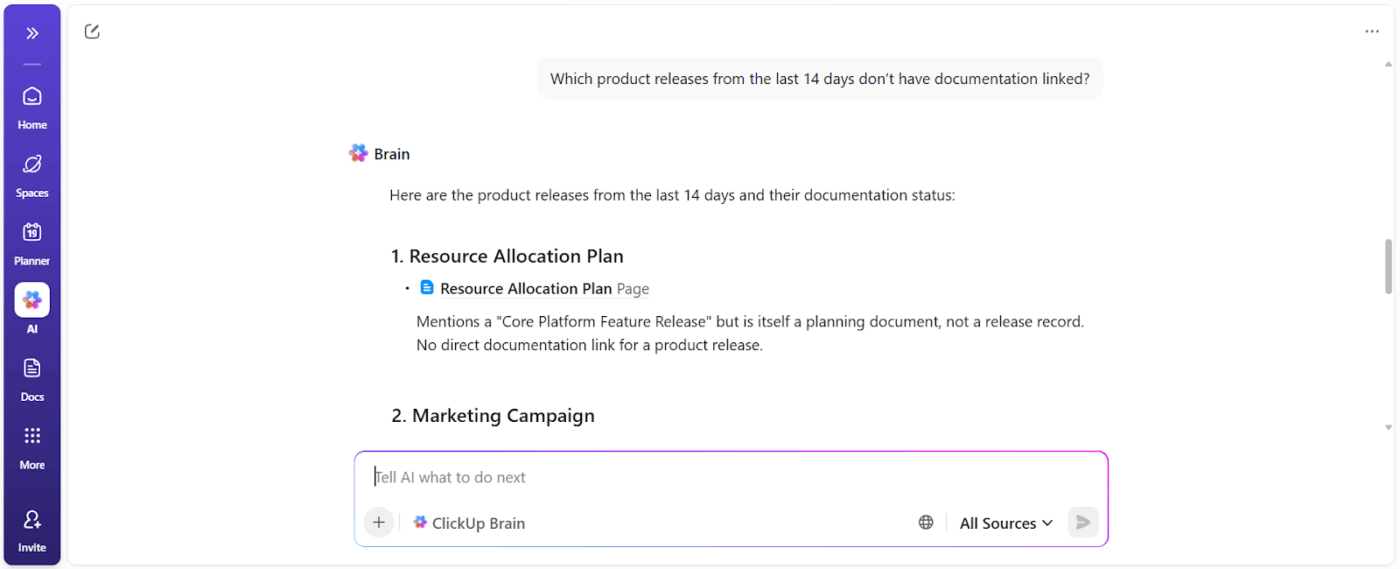

ClickUp Brain stosuje inne podejście. Jako pierwsze na świecie zintegrowane środowisko pracy oparte na AI, ClickUp łączy projekty, zadania, dokumenty i komunikację w jednej platformie, wyposażonej w AI rozpoznającą kontekst.

Oto jak to zrobić 👇

Współpracuj z AI, która rozumie Ciebie i Twoją pracę.

ClickUp Brain rozumie kontekst Twojej pracy.

Pobiera kontekst z zadań ClickUp, dokumentów, komentarzy, zależności, statusów, osi czasu i własności. Nie musisz wklejać informacji o tle ani wyjaśniać historii projektu za każdym razem, gdy zadajesz pytanie oparte na danych z obszaru roboczego ClickUp.

📌 Na przykład, gdy menedżer pyta: „Co spowalnia kampanię w trzecim kwartale?”, skanuje on obszar roboczy i wyszukuje konkretne przeszkody, takie jak:

- Niezadane zadania

- Oczekujące na zatwierdzenie

- Zablokowane recenzje

- Zależności oczekujące na zasoby

Otrzymujesz raport blokujący, który pokazuje właścicieli działań i wpływ czasu.

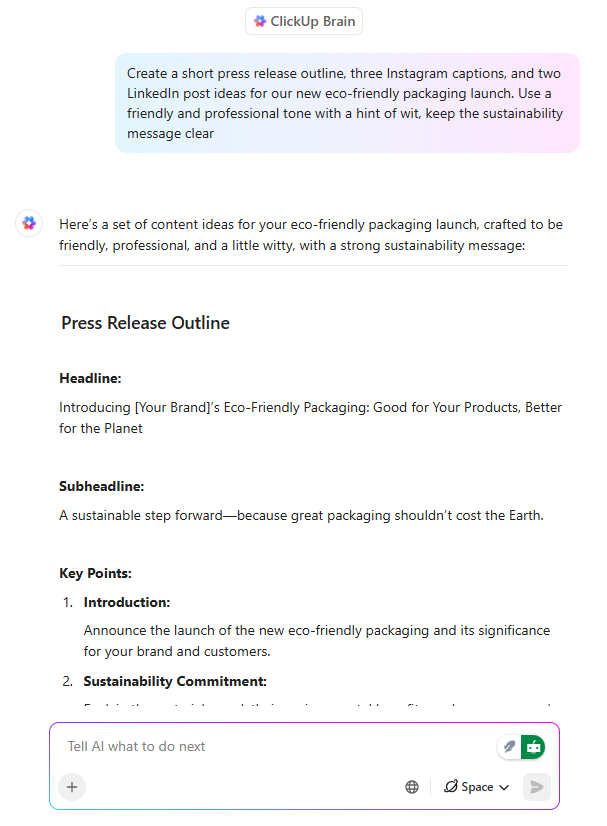

Pisanie AI, które jest już dostosowane do realizacji

ClickUp Brain działa jak asystent pisania oparty na AI, ale z jedną istotną różnicą: pisze z uwzględnieniem tego, nad czym pracuje zespół.

Kiedy kierownik projektu lub marketer tworzy projekt komunikatu w ClickUp dokumencie, Brain może:

- Zdefiniuj propozycje wartości, korzystając z istniejącego kontekstu produktu.

- Dostosuj komunikaty do różnych grup odbiorców

- Przepisz zawartość, aby dopasować ton, jasność lub cele pozycjonowania.

Co ważniejsze, pisanie pozostaje połączone z zadaniami, osiami czasu i zatwierdzeniami. Nie ma rozbieżności między dokumentacją a pracą. Pozwala to zaoszczędzić dużo czasu, ponieważ nie ma potrzeby ponownej interpretacji zawartości w późniejszym czasie.

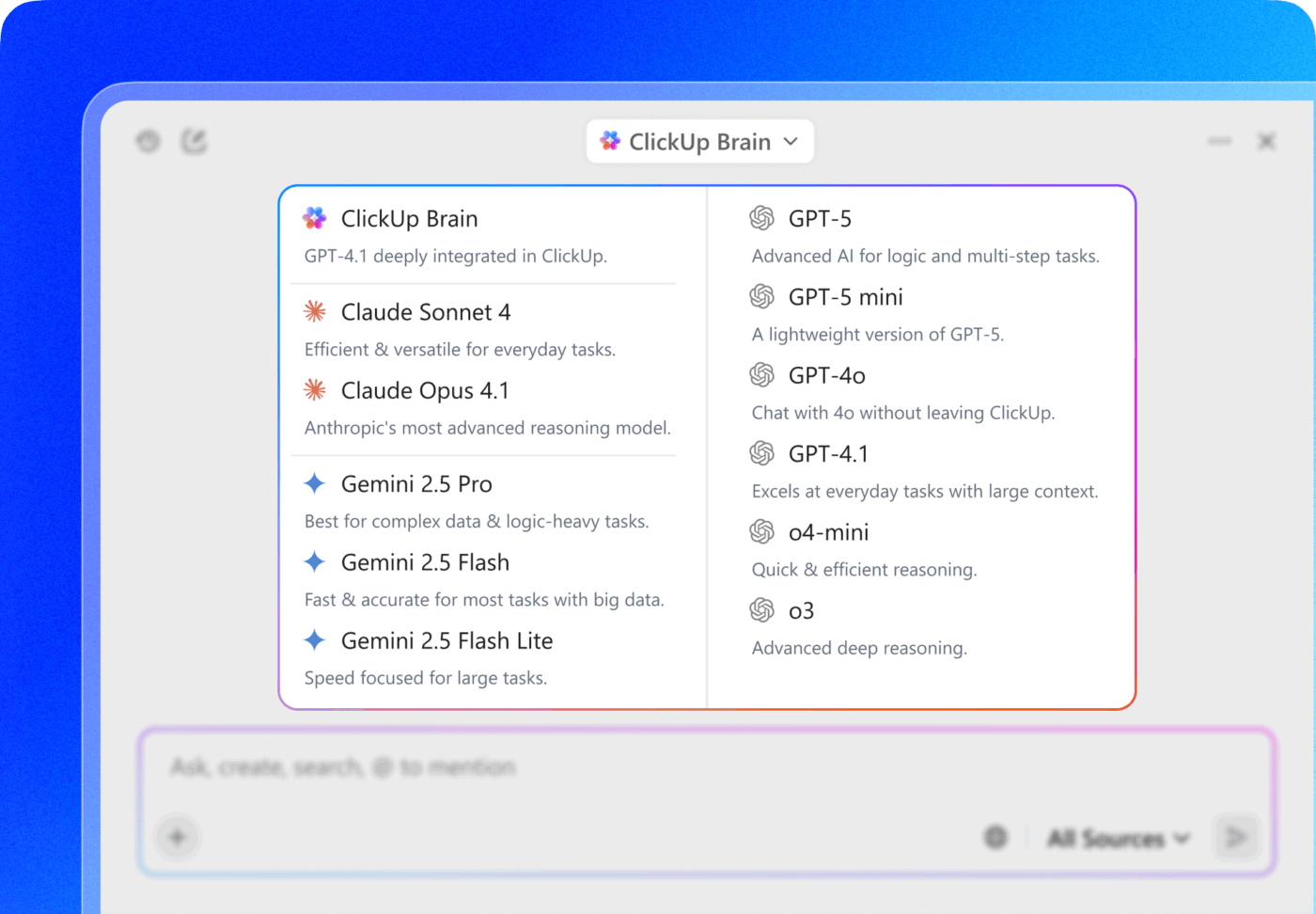

💡 Wskazówka dla profesjonalistów: Wybierz jeden z wielu modeli AI z rodzin ChatGPT, Claude i Gemini bezpośrednio w ClickUp Brain!

- Użyj szybkiego, lekkiego modelu do podsumowania notatek ze spotkania w ramach zadania.

- Przejdź na model bardziej oparty na rozumowaniu, gdy analizujesz wyniki kampanii w dokumentach, zadaniach i pulpitach nawigacyjnych.

Prawdziwy ruch strategiczny? Połącz wybór modelu z połączonym kontekstem ClickUp — zadaniami, komentarzami, dokumentami i polami niestandardowymi — dzięki czemu model będzie nie tylko „inteligentny”, ale także będzie działał w rzeczywistym obszarze roboczym.

Automatyzacja zadań kontekstowych, która zmniejsza nakłady pracy ręcznej

Dzięki zadaniom opartym na AI ClickUp przekształca kontekst w działanie. Najważniejsze funkcje obejmują:

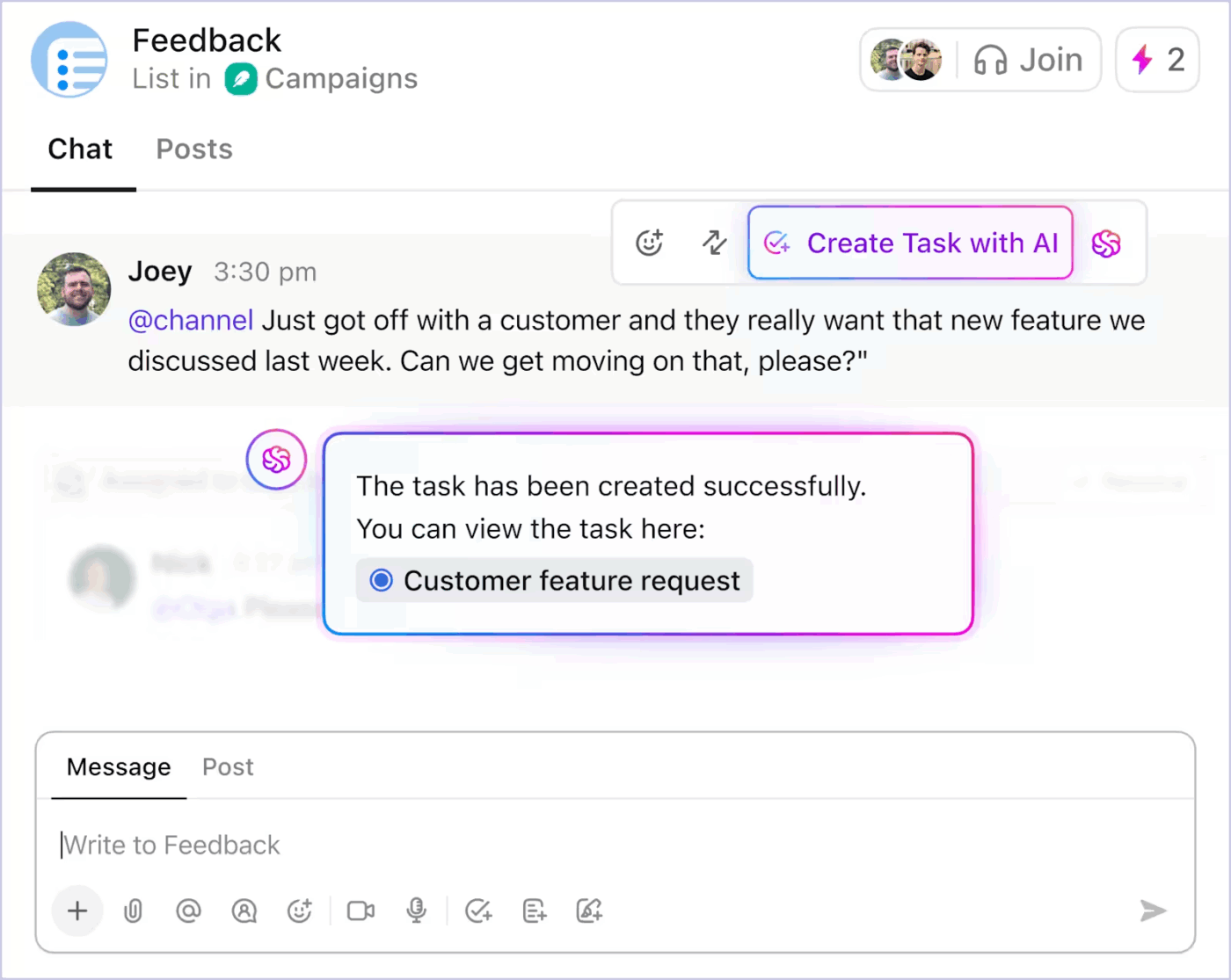

- Konwertuje dyskusje z czatu ClickUp na zadania

- Generuj podzadania i opisy zadań na podstawie istniejącego tytułu zadania w oparciu o zakres.

- Zaproponuj kolejne kroki, gdy praca utknie w martwym punkcie

- Zautomatyzuj rutynowe aktualizacje, korzystając z rzeczywistego stanu projektu.

Oto jak można wykorzystać automatyzację zadań opartą na AI w ClickUp, aby ograniczyć żmudną pracę 👇

Ponieważ automatyzacja opiera się na kontekście na żywo, zespoły poświęcają mniej czasu na przekładanie intencji na strukturę. Praca postępuje bez ciągłej ręcznej interwencji.

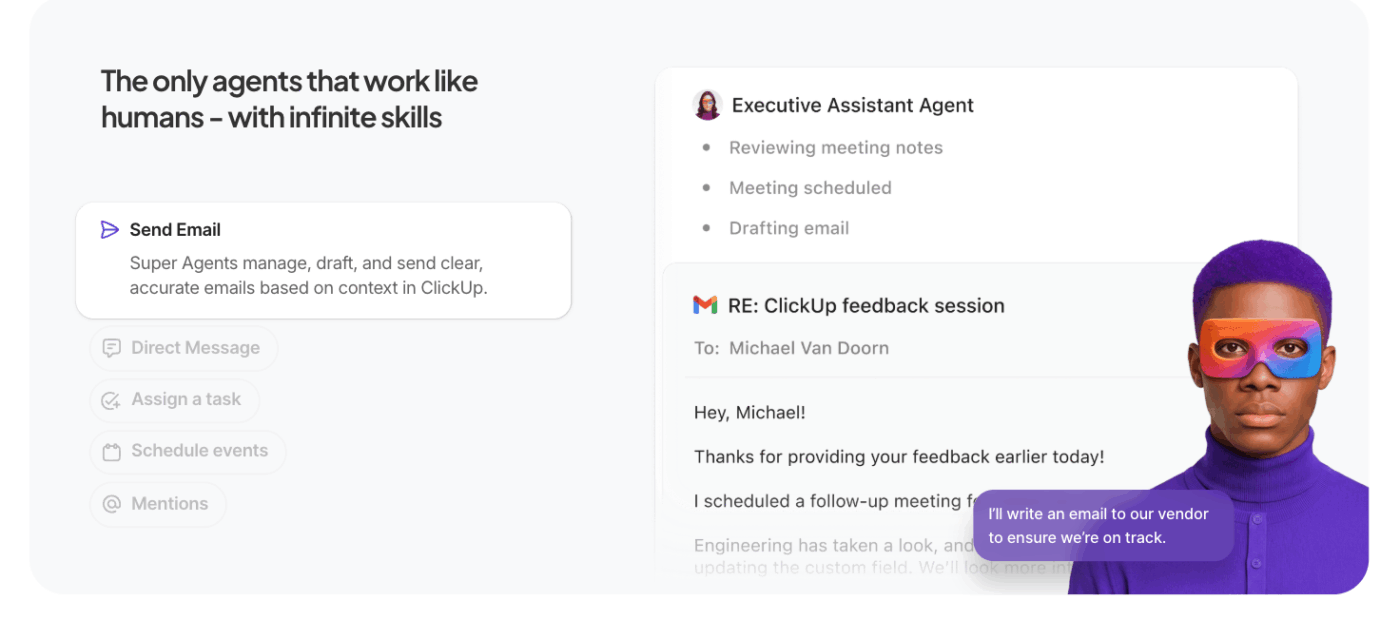

Niech agenci AI wykonają ciężką pracę do zrobienia

Super agenci ClickUp rozszerzają kontekstową AI ClickUp poza pojedyncze zapytania do autonomicznej, wieloetapowej realizacji.

Zamiast czekać na konkretne podpowiedzi, agenci AI do automatyzacji działają w Twoim imieniu w obszarze roboczym, realizując zadania, zasady i wyniki w oparciu o kontekst i cele, które zdefiniujesz.

Co odróżnia je od zwykłych agentów:

- Proaktywne wykonywanie zadań: agenci interpretują kontekst obszaru roboczego — zadania, zależności, osie czasu — i wykonują sekwencje, takie jak aktualizowanie statusów, tworzenie podzadań lub powiadamianie właścicieli bez ręcznego kierowania.

- Cykle pracy zorientowane na cel: definiujesz ogólny cel (np. „Rozwiązanie problemów blokujących kampanię w trzecim kwartale”), a agent planuje, pobiera kontekst i wykonuje działania, które posuwają pracę do przodu.

- Trwały kontekst i pamięć: agenci zachowują stan na poszczególnych krokach, co pozwala im rozważać, co już zostało zrobione, a co pozostało do zrobienia, poprawiając dokładność i ograniczając zbędną pracę.

- Integracja z narzędziami do obszaru roboczego: Współpracują one z zadaniami ClickUp, dokumentami i komentarzami ClickUp, a także z połączonymi narzędziami, koordynując działania między systemami w celu realizacji cykli pracy, zamiast sugerować działania bez kontekstu.

📚 Czytaj więcej: Czym są agenci refleksyjni oparci na modelach

Najlepsze funkcje ClickUp

- Wprowadź sztuczną inteligencję na swój pulpit i do połączonych aplikacji dzięki ClickUp Brain MAX: przeszukuj swój obszar roboczy, transkrybuj mowę na tekst, przełączaj się między najlepszymi modelami AI i podejmuj działania dotyczące zadań, dokumentów i czatów bez przerywania przepływu pracy.

- Znajdź odpowiedzi natychmiast dzięki Enterprise Search : przeszukuj zadania, dokumenty, komentarze, pliki i połączone narzędzia, aby kluczowy kontekst nigdy nie został zagubiony lub odizolowany.

- Szybko zapisuj pomysły dzięki funkcji Talk to Text : dyktuj notatki, plany lub aktualizacje i zamieniaj mowę na uporządkowaną pracę bez utraty koncentracji i tempa.

- Zmniejsz ilość pracy ręcznej dzięki ClickUp Dashboards : automatycznie uruchamiaj aktualizacje zadań, przypisania i działania następcze w oparciu o rzeczywisty kontekst obszaru roboczego i zmiany stanu.

- Utrzymuj dyskusje na poziomie praktycznym dzięki ClickUp Chat: omawiaj decyzje, opinie i zatwierdzenia bezpośrednio przy zadaniach, aby rozmowy były powiązane z realizacją.

- Zastąp spotkania SyncUps: udostępniaj asynchroniczne aktualizacje, otrzymuj generowane przez AI podsumowania i utrzymuj spójność Teams bez konieczności wykonywania powtarzających się połączeń.

- Koordynuj pracę zespołów za pomocą Teams Hub: przeglądaj aktywność zespołu, zadania przypisane do zespołu, priorytety i obciążenie w jednym miejscu, aby wcześnie wykrywać zagrożenia i równoważyć obciążenie pracą.

- Zaplanuj swój dzień za pomocą ClickUp Kalendarza : Uzyskaj wspomagane przez AI plany dzienne oparte na terminach, priorytetach i obciążeniu pracą, dzięki czemu osobiste priorytety będą zgodne z celami zespołu.

Ograniczenia ClickUp

- Zestaw funkcji i opcje dostosowywania mogą przytłaczać nowych użytkowników.

Ceny ClickUp

Oceny i recenzje ClickUp

- G2: 4,7/5 (ponad 10 585 recenzji)

- Capterra: 4,6/5 (ponad 4500 recenzji)

Co użytkownicy mówią o ClickUp AI w praktyce?

Użytkownik ClickUp również udostępnia swoje doświadczenie na G2:

ClickUp Brain MAX jest niesamowitym dodatkiem do mojego cyklu pracy. Sposób, w jaki łączy wiele modeli LLM w jednej platformie, sprawia, że odpowiedzi są szybsze i bardziej niezawodne, a funkcja zamiany mowy na tekst w całej platformie pozwala zaoszczędzić mnóstwo czasu. Bardzo doceniam również bezpieczeństwo na poziomie Enterprise, które zapewnia spokój ducha podczas obsługi poufnych informacji. […] Najbardziej wyróżnia się to, jak pomaga mi to przełamać szum informacyjny i myśleć jaśniej — niezależnie od tego, czy podsumowuję spotkania, tworzę zawartość, czy burzę mózgów nad nowymi pomysłami. To tak, jakbym miał wszechstronnego asystenta AI, który dostosowuje się do wszystkiego, czego potrzebuję.

ClickUp Brain MAX jest niesamowitym dodatkiem do mojego cyklu pracy. Sposób, w jaki łączy wiele modeli LLM w jednej platformie, sprawia, że odpowiedzi są szybsze i bardziej niezawodne, a funkcja zamiany mowy na tekst w całej platformie pozwala zaoszczędzić mnóstwo czasu. Bardzo doceniam również bezpieczeństwo na poziomie Enterprise, które zapewnia spokój ducha podczas obsługi poufnych informacji. […] Najbardziej wyróżnia się to, jak pomaga mi to przełamać szum informacyjny i myśleć jaśniej — niezależnie od tego, czy podsumowuję spotkania, tworzę zawartość, czy burzę mózgów nad nowymi pomysłami. To tak, jakbym miał wszechstronnego asystenta AI, który dostosowuje się do wszystkiego, czego potrzebuję.

Wyzwania i kwestie do rozważenia podczas pracy z inżynierią kontekstową AI

Oto kluczowe wyzwania, o których musisz pamiętać. Kontekst może wymknąć się spod kontroli, nawet przy wsparciu modelu dla okien kontekstowych o wielkości 1 miliona tokenów. Oto kluczowe wyzwania, o których musisz pamiętać 👇

Zatrucie kontekstem

Jeśli do kontekstu wkradnie się halucynacja lub błędne wnioskowanie i będzie się do nich wielokrotnie odwoływać, model potraktuje je jako fakt. Ten zatruty kontekst może zablokować cykle pracy w nieprawidłowych założeniach, które utrzymują się przez długi czas i obniżają jakość wyników.

Rozproszenie uwagi kontekstu

Większe konteksty są kuszące, ale gdy kontekst staje się zbyt duży, modele zaczynają nadmiernie skupiać się na zgromadzonej historii i nie wykorzystują w pełni tego, czego nauczyły się podczas szkolenia. Może to spowodować, że AI będzie zapętlać się na szczegółach z przeszłości zamiast syntetyzować kolejny najlepszy krok.

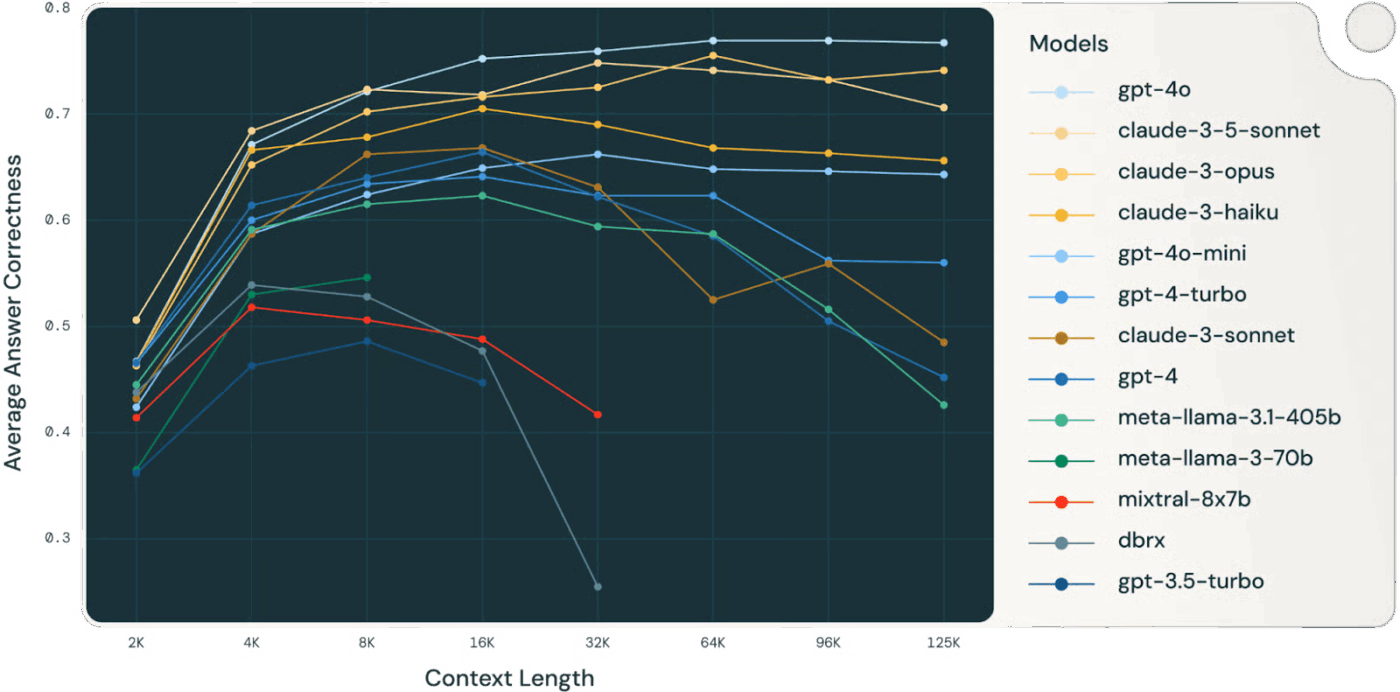

👀 Czy wiesz, że... Badanie przeprowadzone przez Databricks wykazało, że dokładność modelu Llama 3. 1 405B zaczęła spadać przy około 32 000 tokenów, na długo przed zapełnieniem okna kontekstowego. Mniejsze modele ulegały degradacji jeszcze wcześniej.

Modele często tracą jakość rozumowania na długo przed „wyczerpaniem” kontekstu, co sprawia, że wybór i kompresja kontekstu są ważniejsze niż jego surowa wielkość.

Zamieszanie związane z kontekstem

Nieistotne lub mało znaczące informacje w kontekście konkurują o uwagę z danymi krytycznymi. Gdy model czuje się zmuszony do wykorzystania każdego tokenu kontekstowego, decyzje stają się niejasne, a dokładność spada — nawet jeśli technicznie rzecz biorąc, jest „więcej” informacji.

Konflikt kontekstowy

W miarę gromadzenia się informacji nowe fakty lub opisy narzędzi mogą być sprzeczne z wcześnią zawartością. W przypadku sprzeczności kontekstowych modele mają trudności z pogodzeniem konkurencyjnych sygnałów, co prowadzi do niespójnych lub niekonsekwentnych wyników.

Przeciążenie narzędziami i problemy z wyborem

Gdy w kontekście znajduje się zbyt wiele definicji narzędzi, które nie są filtrowane, model może wywołać nieistotne narzędzia lub nadać priorytet tym, które nie są optymalne. Selektywne ładowanie tylko istotnych narzędzi zmniejsza zamieszanie i poprawia jakość decyzji.

Złożoność inżynierii i konserwacja

Skuteczne zarządzanie kontekstem wymaga ciągłego przycinania, podsumowywania, odciążania i izolowania kontekstu. Systemy muszą decydować, kiedy kompresować historię, a kiedy pobierać nowe informacje, co wymaga przemyślanej infrastruktury, a nie doraźnych podpowiedzi.

Dyscyplina budżetu tokenów

Każdy token wpływa na zachowanie; większe okna kontekstowe nie gwarantują lepszych wyników. Należy traktować kontekst jako zasób zarządzany, rozważając trafność i aktualność w stosunku do kosztu tokenów i budżetu uwagi modelu.

⚠️ Statystyki: Prawie 60% pracowników przyznaje, że używa w pracy nieautoryzowanych publicznych narzędzi AI, często wklejając poufne dane firmowe na platformy bez żadnej kontroli.

Sytuacja jest jeszcze gorsza: 63% organizacji nie posiada żadnych zasad dotyczących zarządzania AI, które pozwalałyby monitorować, ograniczać, a nawet wykrywać takie ukryte wykorzystanie AI.

Wynik? Twoje dane wyciekają, ponieważ nikt nie monitoruje sposobu wykorzystania AI.

Przyszłość inżynierii kontekstowej

To oznacza przejście od eksperymentów do skalowania. Kontekstem nie będą już zarządzać ludzie, ale będzie on generowany i zarządzany przez kod. Będzie to funkcja własnej struktury systemu.

Podsumujemy to, opierając się na znakomitym artykule Serge'a Liatko opublikowanym w społeczności programistów OpenAI:

Inżynieria kontekstowa ewoluuje w kierunku architektury cyklu pracy.

Inżynieria kontekstowa będzie coraz częściej ustępować miejsca zautomatyzowanej architekturze cyklu pracy. Zadanie nie będzie się ograniczać do podawania odpowiednich tokenów.

Skuteczna inżynieria kontekstowa będzie wymagała koordynacji całych sekwencji rozumowania, narzędzi i przepływów danych, które automatycznie dostosowują się do zmieniających się potrzeb.

Oznacza to tworzenie dynamicznych systemów, które będą samodzielnie zarządzać odpowiednim kontekstem w ramach holistycznych cykli pracy.

Automatyzacja zastępuje ręczne wyświetlanie podpowiedzi

Kolejnym wyzwaniem jest AI, która sama się organizuje. Będzie ona łączyć wyszukiwanie, narzędzia, pamięć i logikę biznesową bez konieczności ręcznego tworzenia przez ludzi każdej podpowiedzi lub pakietu kontekstowego. Zamiast dostarczać wyraźnie każdy element danych, systemy będą wnioskować, który kontekst jest istotny, i zarządzać nim automatycznie w oparciu o cele i historię.

🧠 Tak właśnie dzieje się w przypadku ClickUp Super Agents. Są to ambientowi i zawsze aktywni współpracownicy AI, którzy pomagają zrozumieć i wykonywać zadania tak samo jak ludzie. Nieustannie doskonalą się na podstawie poprzednich interakcji, korzystając z bogatej pamięci — preferencji dotyczących uczenia się, ostatnich działań i historii projektów — i mogą proaktywnie podejmować działania, eskalować problemy lub przedstawiać spostrzeżenia bez czekania na podpowiedź.

Automatyzacja od początku do końca staje się prawdziwym motorem wydajności.

Wraz z rozwojem inżynierii kontekstowej wzrost wydajności wynika z zautomatyzowanych cykli pracy. Modele LLM działają jako agenci, koordynując narzędzia, monitorując stan i wykonując wieloetapową logikę bez mikrozarządzania ze strony użytkownika.

Nie musisz ręcznie wprowadzać brakującego kontekstu. System będzie selekcjonował kontekst w celu zapewnienia wsparcia dla pamięci długotrwałej i rozumowania.

Unified Context sprawia, że AI działa lepiej

Dokładność AI spada, gdy kontekst jest rozdrobniony między narzędzia, cykle pracy i osoby. Gdy informacje są rozproszone, modele są zmuszone do zgadywania.

Zintegrowane obszary robocze AI, takie jak ClickUp, doskonale sobie z tym radzą — łącząc pracę, dane i AI w strategii kontekstowej.

Chcesz spróbować? Zarejestruj się bezpłatnie w ClickUp.