GitHub Copilot kan binnen enkele minuten honderden testcases genereren – uit gecontroleerde experimenten blijkt dat ontwikkelaars 35% sneller klaar zijn – maar hier zit een addertje onder het gras: die door AI gegenereerde tests zijn alleen nuttig als u ze kunt bijhouden, organiseren en koppelen aan de rest van uw werkstroom.

Deze handleiding laat u zien hoe u GitHub Copilot kunt gebruiken om snel testcases op te zetten en laat u vervolgens zien hoe u deze effectief kunt beheren, zodat ze niet gewoon weer een stapel verweesde codebestanden worden.

Waarom unit tests belangrijk zijn voor de kwaliteit van software

Het schrijven van unit tests wordt vaak gezien als een vervelende klus, maar als je ze overslaat, leidt dat tot kwetsbare code.

Als u geen vangnet van tests hebt, kan een kleine refactor regressiefouten veroorzaken: bugs die bestaande functies verstoren en het vertrouwen van gebruikers ondermijnen. Uit onderzoek van IBM blijkt dat het repareren van fouten die na de release worden ontdekt, 15 keer meer kost.

Dit creëert een cyclus waarin ontwikkelaars geen verbeteringen aan de code aanbrengen omdat ze bang zijn dat er iets kapot gaat, wat leidt tot een oplopende technische schuld.

AI-ondersteunde testgeneratie helpt deze cyclus te doorbreken. 89% van de organisaties test of implementeert momenteel generatieve AI-werkstroomen in kwaliteitsengineering en testen. Door een tool als GitHub Copilot te gebruiken om testcases op te zetten, kunt u zich concentreren op wat belangrijk is: het ontwerpen van zinvolle tests en het verfijnen van de dekking van randgevallen.

Dit is waarom consistente unit-tests de moeite waard zijn:

- Regressiepreventie: Goede tests fungeren als een vangrail en zorgen ervoor dat nieuwe functies of bugfixes niet onbedoeld iets anders kapotmaken.

- Levende documentatie: in tegenstelling tot statische documentatie die verouderd kan raken, dienen unit-tests als uitvoerbare voorbeelden van hoe uw code zich zou moeten gedragen.

- Vertrouwen in refactoring: wanneer u over uitgebreide testdekking beschikt, kunt u uw codebase refactoren en verbeteren met het vertrouwen dat u onmiddellijk weet of een wijziging onbedoelde gevolgen heeft.

Om beter te begrijpen hoe AI-agenten het coderingslandschap transformeren, en niet alleen het genereren van tests, bekijk dan dit overzicht van AI-aangedreven codeerassistenten en hun mogelijkheden:

Hoe u GitHub Copilot instelt voor het genereren van testcases

Voordat u kunt beginnen met het genereren van tests, moet u GitHub Copilot installeren en configureren in uw geïntegreerde ontwikkelomgeving (IDE). De installatie is eenvoudig en duurt slechts enkele minuten, maar als u het goed doet, zorgt u ervoor dat Copilot de context heeft die het nodig heeft om relevante suggesties te doen.

Voordat u begint, heeft u een aantal dingen nodig:

- Een actief GitHub Copilot-abonnement (Individual, Business of Enterprise)

- Een ondersteunde IDE, zoals VS Code, een JetBrains IDE (zoals IntelliJ of PyCharm) of Neovim

- Een testframework zoals pytest, Jest of JUnit dat al in uw project is geïnstalleerd.

Installeer de GitHub Copilot-extensie

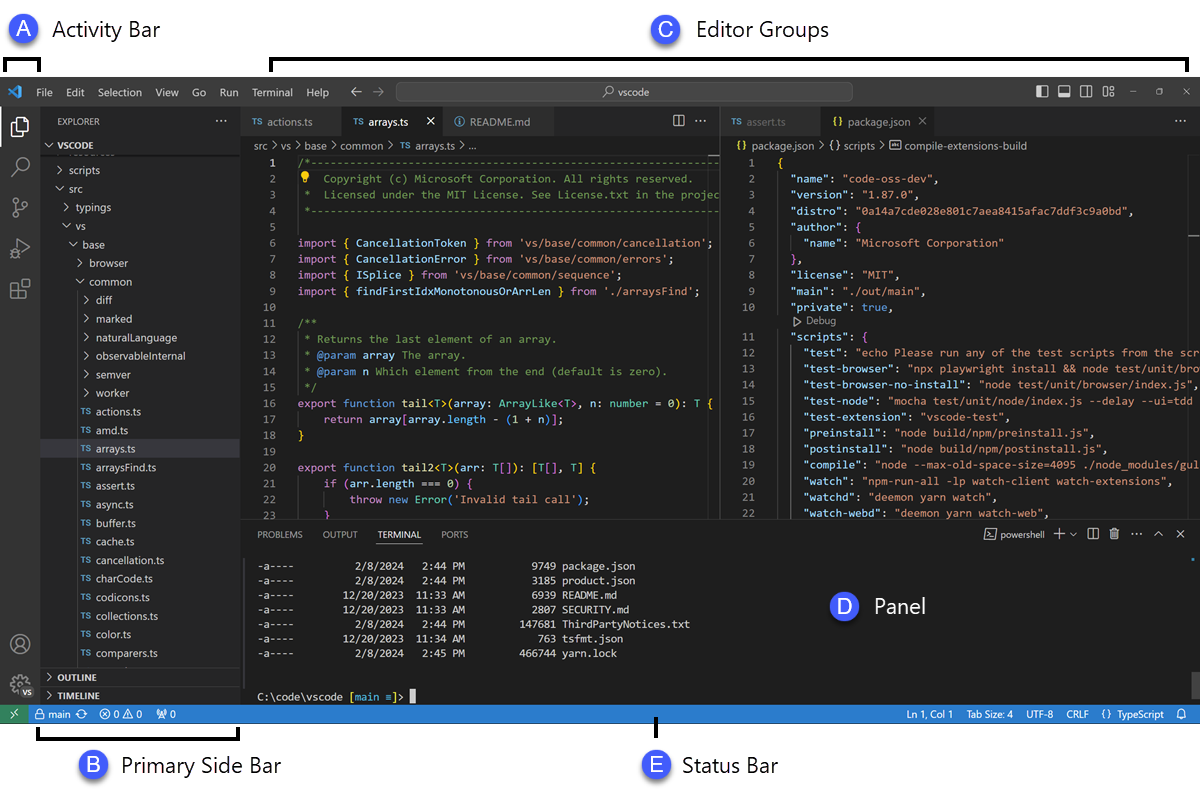

Eerst moet u de Copilot-extensie in uw IDE installeren. Dit proces is vergelijkbaar voor de meeste editors die worden ondersteund.

- Open de extensiemarktplaats van uw IDE. In VS Code is dit het pictogram Extensies in de zijbalk; in JetBrains IDE's vindt u het onder Instellingen → Plug-ins.

- Zoek naar "GitHub Copilot"

- Installeer zowel de hoofd-extensie GitHub Copilot als de extensie GitHub Copilot Chat voor de volledige ervaring.

- U wordt gevraagd uw IDE opnieuw op te starten om de installatie voltooien.

Na het opnieuw opstarten wordt u gevraagd om in te loggen met uw GitHub-account. Deze stap voert de verificatie van uw abonnement uit. Nadat u bent ingelogd, ziet u een klein Copilot-pictogram in de statusbalk van uw IDE, wat aangeeft dat het actief en klaar voor gebruik is.

Configureer uw testframework

GitHub Copilot genereert relevantere tests wanneer het de specifieke testinstallatie van uw project begrijpt. Het doet dit door uw bestaande testbestanden en configuratie te analyseren om de patronen van uw team te leren kennen en hierop in te spelen.

- Voor Python-projecten die pytest gebruiken: Zorg ervoor dat u pytest hebt geïnstalleerd (pip install pytest). Als u een conftest.py-bestand of bestaande testbestanden (zelfs één) hebt, gebruikt Copilot deze als referentie voor het genereren van nieuwe tests.

- Voor JavaScript/TypeScript-projecten die Jest gebruiken: Copilot zoekt naar een jest.config.js-bestand en uw Jest-afhankelijkheid in uw package.json om uw installatie te begrijpen.

- Voor Java-projecten die JUnit gebruiken: Zorg ervoor dat uw JUnit-afhankelijkheden correct zijn gedefinieerd in uw pom.xml-bestand (voor Maven) of build.gradle-bestand (voor Gradle).

Het hebben van ten minste één goed geschreven testbestand in uw project is een van de beste manieren om Copilot te begeleiden. Het pikt uw naamgevingsconventies, assertiestijlen en de manier waarop u uw tests structureert op, wat leidt tot consistentere output.

Integreer Copilot met uw IDE

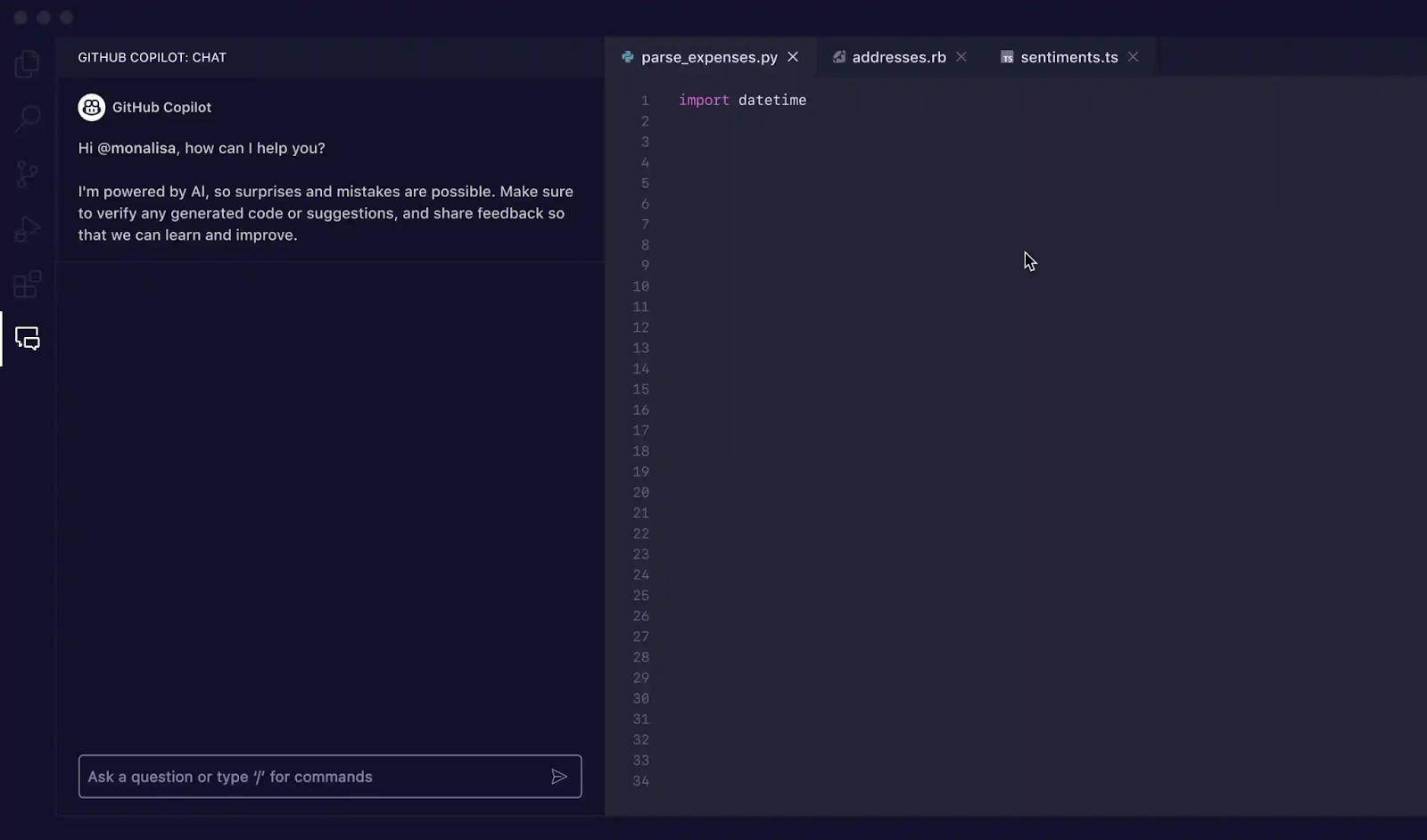

Nu de extensies zijn geïnstalleerd, is het tijd om vertrouwd te raken met de Copilot-interface in uw IDE. De belangrijkste manier waarop u hiermee communiceert voor het genereren van tests is via het Copilot Chat-paneel.

U kunt de chatweergave openen met de snelkoppeling Ctrl+Cmd+I (op Mac) of Ctrl+Alt+I (op Windows/Linux), of door op het Copilot Chat-pictogram in de activiteitenbalk van uw IDE te klikken. Deze chatweergave is uw commandocentrum voor het genereren van tests.

Copilot is contextbewust, wat betekent dat het je momenteel geopende bestanden, de bestandsstructuur van je project en alle code die je hebt geselecteerd, leest. Voor het beste resultaat moet je het bestand met de functie of klasse die je wilt testen altijd geopend en met zichtbaarheid hebben in je editor.

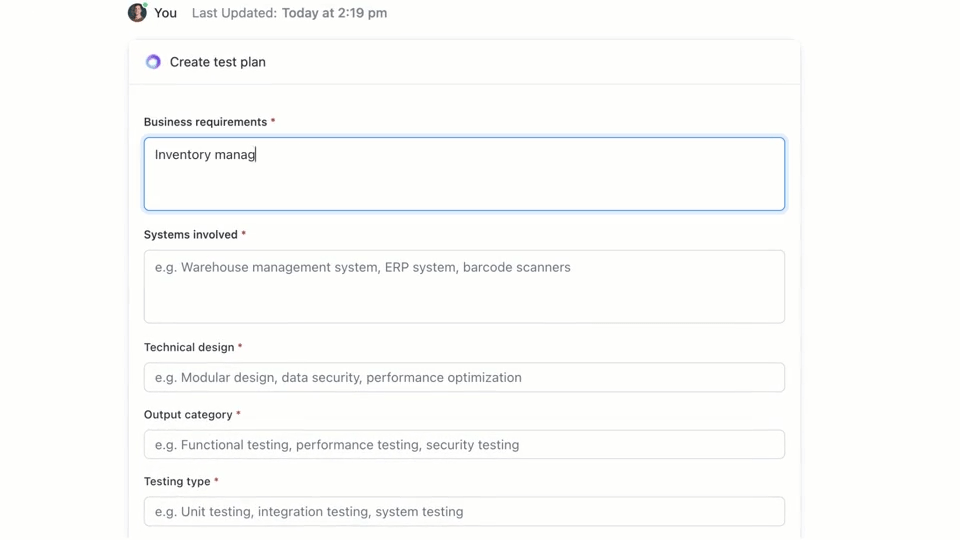

🌟 ClickUp Brain, de contextuele AI die in ClickUp is geïntegreerd, kan snel een testplan voor u maken. Probeer het vandaag nog uit.

Hoe u testcases schrijft met GitHub Copilot

GitHub Copilot biedt u drie primaire manieren om testcases te genereren: met behulp van het chatpaneel met gedetailleerde prompts, met behulp van snelle slash-commando's en met behulp van slimme acties direct in uw editor. Elke methode is geschikt voor verschillende situaties binnen uw werkstroom, afhankelijk van of u snelheid of fijne controle nodig hebt.

Gebruik Copilot Chat-prompts

Het gebruik van Copilot Chat met een specifieke prompt is de krachtigste methode voor het genereren van testcases. Dit is het meest geschikt voor complexe functies of klassen waarbij u specifieke scenario's moet definiëren, afhankelijkheden moet simuleren of lastige randgevallen moet afhandelen.

Dit is de basiswerkstroom:

- Open het Copilot-chatten-paneel

- Markeer in uw editor de functie, klasse of het blok code dat u wilt testen.

- Schrijf een duidelijke, specifieke prompt in het chatvenster waarin u de tests beschrijft die u nodig hebt.

Als voorbeeld kunt u prompts schrijven zoals:

- "Schrijf unit-tests voor de geselecteerde functie die het happy path, randgevallen zoals lege invoer en foutafhandeling voor ongeldige gegevens dekken."

- "Genereer pytest-tests voor deze klasse en maak fixtures om de database-verbinding te simuleren."

- "Maak Jest-tests voor deze React-component die klikken van gebruikers simuleren en de statuswijzigingen verifiëren."

Hoe meer details u in uw prompt opgeeft, hoe beter de gegenereerde tests zullen zijn.

Gebruik slash-commando's zoals /tests

Wanneer u snel tests moet genereren en geen zeer specifieke scenario's nodig hebt, is het /tests-commando uw beste vriend. Het is de snelste manier om een solide basis voor testdekking te krijgen.

Om het te gebruiken:

- Open het Copilot-chatten-paneel

- Selecteer de code die u wilt testen in uw editor.

- Typ tijdens het chatten gewoon /tests en druk op Enter.

Copilot genereert onmiddellijk een reeks unit-tests op basis van de structuur en logica van de door u geselecteerde code. Het probeert de primaire functionaliteit en enkele veelvoorkomende invoeren te dekken. Als de resultaten niet helemaal kloppen, kunt u ze altijd verfijnen met een vervolgprompt zoals: "Voeg nu een test toe voor wanneer de invoer null is. "

Gebruik slimme acties in de editor

Als u tests wilt genereren zonder uw werkstroom te onderbreken, kunt u slimme acties rechtstreeks vanuit uw code-editor gebruiken. Zo hoeft u niet over te schakelen naar het chatvenster.

- Markeer de functie of klasse die u wilt testen.

- Klik met de rechtermuisknop op de selectie om het contextmenu te openen.

- Ga naar Code genereren in het contextmenu en selecteer Tests genereren.

Copilot genereert de tests en toont ze doorgaans in een nieuw, tijdelijk tabblad in de editor. U kunt de code daar bekijken en vervolgens kiezen om een nieuw testbestand aan te maken of de tests toe te voegen aan een bestaand bestand.

📚 Lees ook: Testcasesjablonen voor het testen van software

GitHub Copilot-prompts voor het genereren van testcases

Uw prompts zijn het stuurwiel voor GitHub Copilot. Algemene prompts leiden tot algemene tests, maar goed opgestelde prompts die de AI specifieke instructies geven, hebben als resultaat uitgebreide en bruikbare testcases. De sleutel is om Copilot niet alleen te vertellen wat er getest moet worden, maar ook hoe het getest moet worden.

Hier zijn enkele sjablonen die u kunt aanpassen voor verschillende scenario's:

| Scenario | Prompt-sjabloon |

|---|---|

| Basisunit-test | “Schrijf unit-tests voor de functie [functienaam] met behulp van [framework]. Zorg ervoor dat u normale invoer, grenswaarden zoals nul of negatieve nummers en ongeldige invoer zoals null of undefined meeneemt. ” |

| Klasse met afhankelijkheden | "Genereer tests voor de klasse [ClassName]. Gebruik [mocking_library] om mock-ups te maken voor de afhankelijkheden [DependencyName] en [AnotherDependencyName]." |

| Asynchrone functies | “Maak tests voor deze asynchrone functie. Voeg tests toe voor het geval van succes, een geval waarin de belofte wordt afgewezen en een scenario voor time-outs bij verzoeken. ” |

| API-eindpunt | “Schrijf integratietests voor dit API-eindpunt. Behandel een succesvolle GET-aanvraag, een POST-aanvraag met geldige gegevens, een aanvraag met een ontbrekend token voor verificatie en een aanvraag met ongeldige gegevens die een 400-fout zou moeten opleveren. ” |

| Gegevensvalidatie | “Genereer tests voor deze validatiefunctie. Voeg een test toe voor een geldig object en voeg vervolgens afzonderlijke tests toe voor elke validatieregel die niet voldoet, om ervoor te zorgen dat de juiste foutmeldingen worden weergegeven. ” |

Tips voor snelle verbeteringen:

- Wees duidelijk over het framework: er moet altijd een vermelding zijn van het testframework (bijv. pytest, Jest, JUnit) om ervoor te zorgen dat de syntaxis correct is.

- Definieer uw dekkingsdoelen: gebruik geavanceerde AI-prompttechnieken om specifieke soorten dekking te vragen, zoals 'randgevallen', 'foutafhandeling' of 'grenswaardentests'.

- Verwijs naar uw eigen patronen: als u een goed voorbeeldbestand hebt, kunt u Copilot vragen om "het testpatroon in tests/test_user.py te volgen".

- Specifieke beweringen aanvragen: in plaats van Copilot te laten raden, kunt u het vragen om "te beweren dat er een ValueError wordt gegenereerd voor ongeldige invoer".

Voorbeelden van het genereren van tests met GitHub Copilot

Zo werkt dit in de praktijk.

Genereer unit-tests in Python

Stel je voor dat je een Python-functie hebt die de totale prijs van items in een winkelwagen berekent, inclusief korting.

Voorbeeldfunctie om te testen:

Gebruikte prompt: "Schrijf pytest-tests voor calculate_total. Dek een lege lijst met items, een enkel item, meerdere items, het toepassen van een korting, een korting van 0%, een korting van 100% en een ongeldig kortingspercentage dat een ValueError zou moeten opleveren."

Gegenereerde testuitvoer:

Copilot heeft pytest. raises correct gebruikt om te controleren op de uitzondering en heeft de belangrijkste scenario's gedekt. Mogelijk wilt u nog steeds tests voor negatieve prijzen of hoeveelheden toevoegen als handmatige verfijning.

Genereer unit-tests in TypeScript met Jest

Laten we nu eens een TypeScript-functie proberen die de naam van een gebruiker formatteert.

Voorbeeldfunctie om te testen:

Gebruikte prompt: "Genereer Jest-tests voor formatDisplayName. Neem een gebruiker met een voor- en achternaam, een gebruiker met een bijnaam, een gebruiker met een lege voornaam en een gebruiker met alleen een bijnaam mee."

Gegenereerde testuitvoer:

De gegenereerde tests maken gebruik van de standaard describe- en it-blokken van Jest en verwerken de verschillende logische paden correct.

Best practices voor het genereren van tests met GitHub Copilot

Het gebruik van Copilot voor het genereren van tests zorgt voor een enorme verhoging van de productiviteit, maar vereist zorgvuldig toezicht om de kwaliteit te waarborgen.

- Controleer elke afzonderlijke test: Dit is de gouden regel. Copilot begrijpt uw bedrijfslogica niet, dus het kan een test genereren die slaagt, maar het verkeerde beweert. Lees altijd de gegenereerde code en vraag uzelf af: "Controleert dit daadwerkelijk het juiste gedrag?"

- Controleer handmatig de dekking van randgevallen: Copilot is goed in het opsporen van veelvoorkomende randgevallen, zoals null-invoer of lege reeksen, maar kan domeinspecifieke gevallen missen. Heeft het voor een e-commerce-app getest wat er gebeurt als het totaalbedrag van een winkelwagen precies het minimum is voor gratis verzending? U bent nog steeds de expert.

- Houd consistente naamgevingsconventies aan: door AI gegenereerde testnamen kunnen soms erg algemeen zijn. Neem even de tijd om ze te hernoemen zodat ze aansluiten bij de stijl van uw team. Een beschrijvende naam als test_login_fails_with_incorrect_password is veel nuttiger dan test_login_2.

- Voer tests onmiddellijk uit: laat gegenereerde tests niet onuitgevoerd blijven. Voer ze meteen uit om syntaxis fouten of duidelijk falende beweringen op te sporen voordat u de code vastlegt.

- Integreer met CI/CD: voeg gegenereerde tests toe aan uw continue integratiepijplijn. Tests die alleen lokaal worden uitgevoerd, bieden beperkte waarde.

- Pas op voor onbetrouwbare tests: soms kan AI tests genereren die 'onbetrouwbaar' zijn: ze slagen soms en falen soms. Dit gebeurt vaak bij tests met tijdstempels of willekeurige gegevens. Vervang deze altijd door deterministische, voorspelbare waarden.

📮ClickUp Insight: Uit onze enquêtes blijkt dat 34% van de gebruikers volledig vertrouwt op AI-systemen, terwijl een iets grotere groep (38%) een 'vertrouwen maar verifiëren'-benadering hanteert. Een standalone tool die niet bekend is met uw werkcontext brengt vaak een hoger risico met zich mee op onnauwkeurige of onbevredigende reacties.

Daarom hebben we ClickUp Brain ontwikkeld, de AI die uw projectmanagement, kennisbeheer en samenwerking binnen uw werkruimte en geïntegreerde tools van derden met elkaar verbindt. Krijg contextuele reacties zonder het schakelen en ervaar een 2-3x hogere werkefficiëntie, net als onze klanten bij Seequent.

Limieten van het gebruik van GitHub Copilot voor het genereren van testcases

Hoewel GitHub Copilot een enorme verhoging van de productiviteit oplevert, is het geen wondermiddel voor het testen van software. Het is belangrijk om de beperkingen ervan te kennen om het effectief te kunnen gebruiken en veelvoorkomende valkuilen te vermijden. Het is een 'copiloot', geen piloot – u blijft verantwoordelijk voor het vluchtplan.

De grootste beperking is het gebrek aan zakelijke context. Copilot analyseert de structuur van uw code, maar heeft geen idee wat uw applicatie eigenlijk voor uw gebruikers moet doen. Het kan niet weten dat een "premium" gebruiker toegang moet hebben tot bepaalde functies, terwijl een "basis" gebruiker dat niet mag, tenzij die logica expliciet duidelijk is in de code die het leest.

Hier zijn nog enkele andere sleutelbeperkingen om in gedachten te houden:

- Het kan cruciale, domeinspecifieke randgevallen missen: Copilot is uitstekend in het vinden van algemene randgevallen, maar het kent de vreemde gevallen die specifiek zijn voor uw branche niet, zoals een financiële berekening die schrikkeljaren anders moet behandelen.

- Het heeft geen toegang tot externe systemen: Copilot kan geen zinvolle integratietests genereren voor uw database of een API van een derde partij, omdat het geen verbinding daarmee kan maken. Het kan de code opzetten, maar u moet zelf de details invullen.

- Het kan een vals gevoel van vertrouwen geven: Het kan geweldig voelen om 100% testdekking te zien, maar als de tests de verkeerde dingen beweren, is dat dekkingspercentage zinloos. Daarom is menselijke beoordeling zo belangrijk.

- Limieten van het contextvenster: Zeer grote bestanden of complexe klassenhiërarchieën kunnen de limiet van het contextvenster van Copilot overschrijden, wat kan resulteren in onvolledige of algemene suggesties.

Hoe u testcases kunt maken en beheren in ClickUp

Het genereren van testcases met GitHub Copilot is slechts de helft van de werkstroom. Zodra de tests bestaan, moeten teams ze nog steeds bijhouden, ze koppelen aan vereisten en de uitvoering ervan beheren tijdens Sprints en releases.

ClickUp biedt een gecentraliseerde werkruimte waar door AI gegenereerde testcases naast ontwikkelingstaken, bugs en sprintplannen kunnen worden opgeslagen, zodat testen niet beperkt blijft tot individuele IDE's.

ClickUp fungeert als een geconvergeerde AI-werkruimte, waarin projectmanagement, documentatie en teamcommunicatie in één systeem worden samengebracht. Voor softwareteams betekent dit dat testcasebeheer niet langer een aparte tool of spreadsheet is.

Tests, vereisten, pull-aanvragen en discussies over releases blijven allemaal met elkaar verbonden, waardoor contextversnippering wordt verminderd en QA een eersteklas onderdeel van de leveringswerkstroom wordt.

De testcasesjabloon van ClickUp is ontworpen om u te helpen de voortgang van testcases bij te houden. Het maakt het gemakkelijk om:

- Bekijk testresultaten en neem datagestuurde beslissingen over bugfixes.

- Ontwikkel aangepaste testplannen voor elk project

- Organiseer en prioriteer testcases voor maximale efficiëntie.

Begin met het maken van een speciale ClickUp-lijst die als uw testcasopslagplaats fungeert. Elke testcase, of deze nu door AI is gegenereerd of handmatig is geschreven, wordt een Taak.

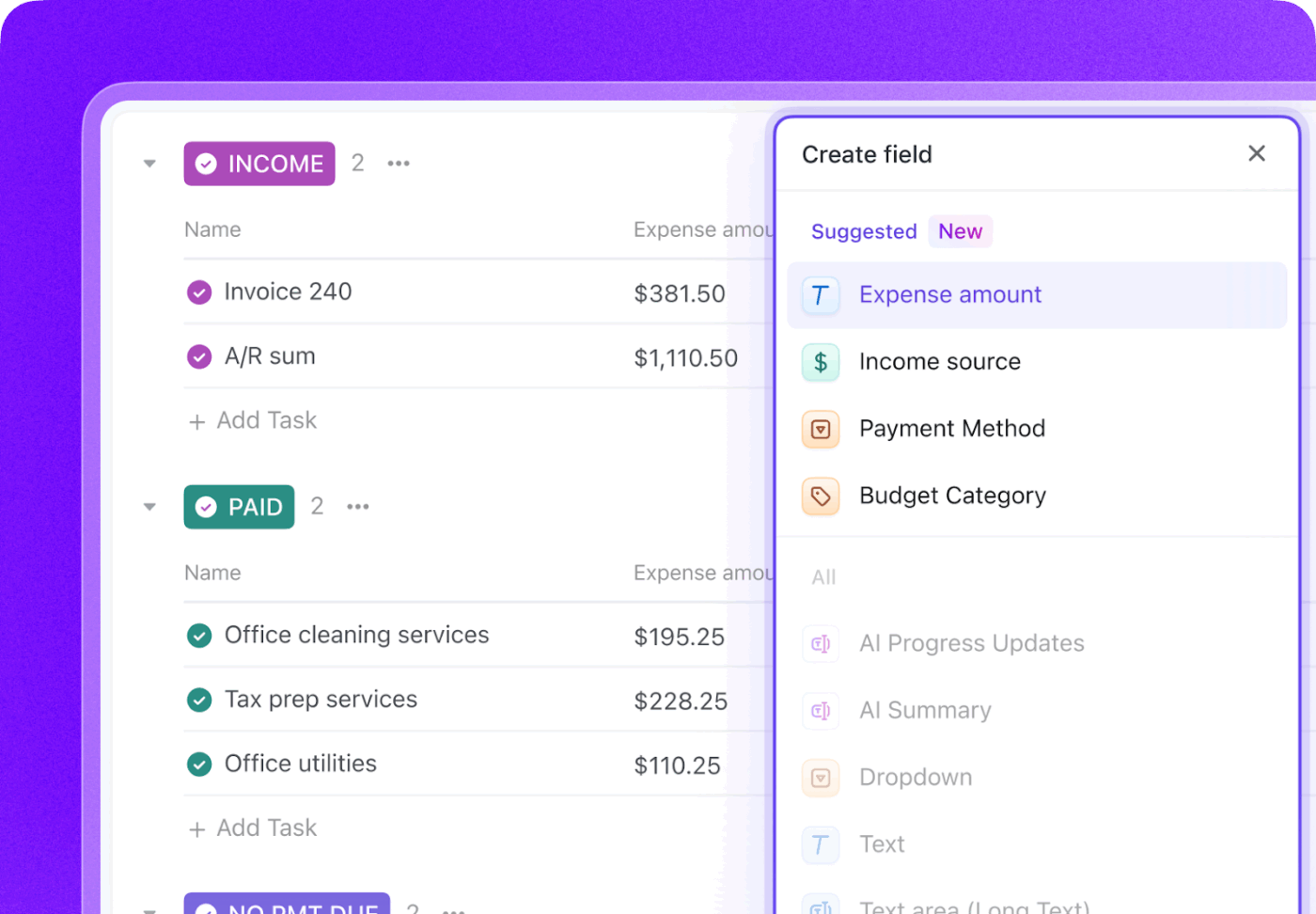

Verrijk elke testcase met cruciale metadata met behulp van ClickUp aangepaste velden om precies bij te houden wat belangrijk is voor uw team.

- Testtype: Dropdown voor Unit, Integratie, End-to-End of Handmatig

- Automatiseringstatus: Een status die aangeeft of de test geautomatiseerd is of niet.

- Prioriteit: Hoog, gemiddeld of laag

- Laatste uitvoeringsdatum: Een veld om bij te houden wanneer de test voor het laatst is uitgevoerd.

Volg uw volledige testcyclus met ClickUp aangepaste statussen door een werkstroom te creëren die tests verplaatst van Niet uitgevoerd naar Geslaagd, Mislukt of Geblokkeerd. Zo krijgt iedereen in het team, van ontwikkelaars tot productmanagers, direct zichtbaarheid in de voortgang van de testuitvoering.

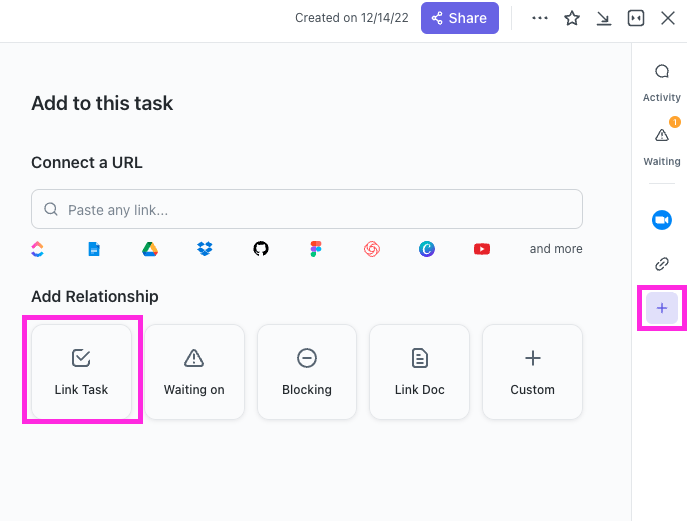

Met ClickUp Relationships kunnen testcasetaken rechtstreeks worden gekoppeld aan user stories, functies of epics. Als een test mislukt, kunt u een bugrapporttaak aanmaken en deze koppelen aan zowel de mislukte test als het oorspronkelijke verhaal, waardoor een volledige traceerbaarheidsketen ontstaat.

Stel binnen enkele seconden bugrapporten op door ClickUp Brain naar een mislukte testcasetaak te verwijzen. Omdat het de context van uw hele werkruimte heeft, kan het details uit de gekoppelde user story en de testcase zelf halen.

🌟 Het testrapportsjabloon van ClickUp stelt u in staat sneller rapporten te maken en tegelijkertijd problemen te identificeren en aan te pakken die verbetering behoeven.

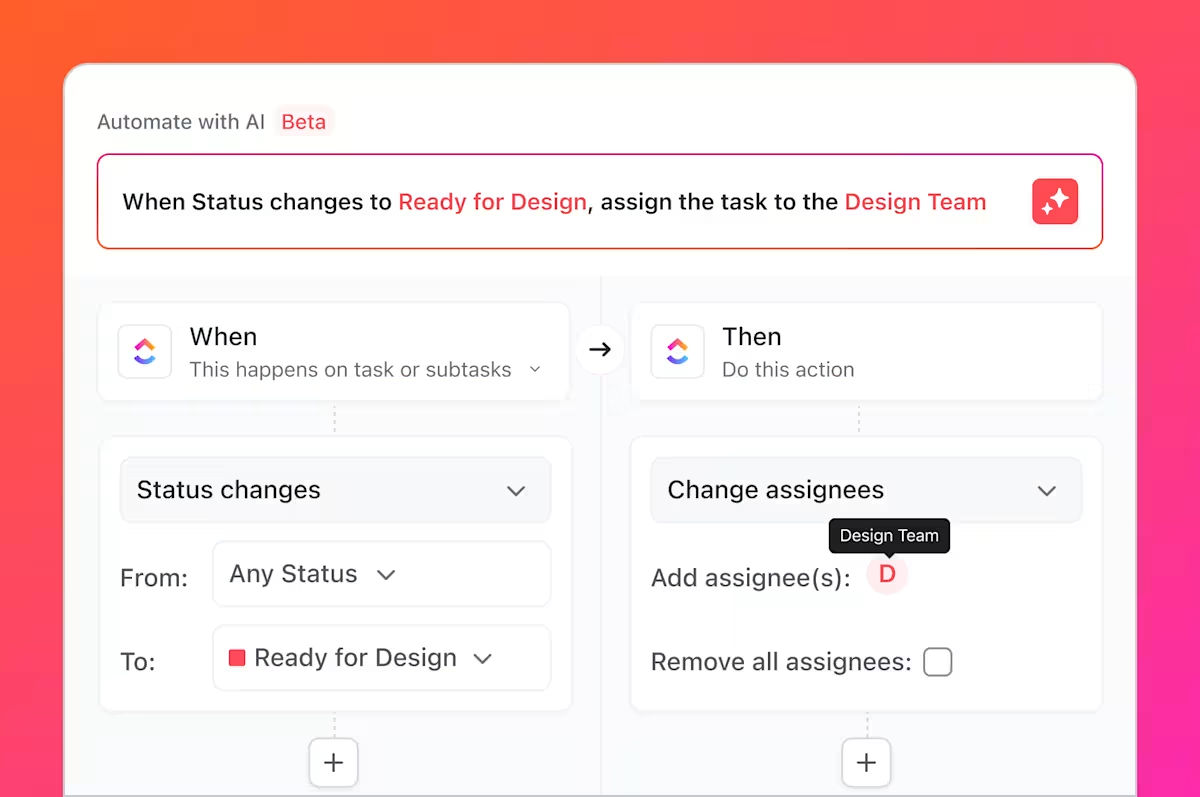

Maar dat is niet alles wat u nog kunt doen. U kent vast wel al dat drukke werk waar we het over hadden, die saaie en repetitieve taken die altijd bij testen horen? U kunt deze automatiseren met ClickUp-automatiseringen.

Stel regels in zoals "Wanneer de status van een testcase wordt gewijzigd in Mislukt, maak dan automatisch een nieuwe Taak aan in de Bugs List en wijs deze toe aan de hoofdontwikkelaar. "

Door GitHub te integreren met ClickUp kunnen testcasetaken worden gekoppeld aan commits en pull-aanvragen. Wanneer code-wijzigingen worden samengevoegd, worden gerelateerde testtaken automatisch bijgewerkt, zodat QA, ontwikkelaars en releasemanagers op de hoogte blijven van wat er is gewijzigd en wat opnieuw moet worden getest.

Met ClickUp Dashboards kunt u de voortgang van tests in realtime bijhouden, het aantal bugs visualiseren, de uitvoering van testcases bekijken en nog veel meer.

Samen overbrugt deze werkstroom de kloof tussen door AI gegenereerde tests in GitHub Copilot en team-breed testcasemanagement in ClickUp, waardoor teams één systeem krijgen om hun QA-proces te plannen, bij te houden, te automatiseren en te verbeteren zonder voortdurende handmatige coördinatie.

Bekijk deze video voor tips over het opzetten van een efficiënte werkstroom voor releasebeheer:

Vereenvoudig het beheer van testcases met ClickUp

Door AI gegenereerde tests zijn niet langer geïsoleerde artefacten; ze zijn geïntegreerde componenten van uw ontwikkelingsproces, met zichtbaarheid, traceerbaarheid en bruikbaarheid voor het hele team.

GitHub Copilot genereert snel testcases, maar snelheid alleen is geen garantie voor kwaliteit. Zonder duidelijke eigendom, traceerbaarheid van vereisten en zichtbaarheid tijdens Sprints kunnen zelfs goed geschreven tests verouderd raken of over het hoofd worden gezien. Daarom is een registratiesysteem zo belangrijk.

Door testcases in ClickUp te beheren, zetten teams door AI gegenereerde output om in een herhaalbare QA-werkstroom, die tests koppelt aan vereisten, code-wijzigingen en tijdlijnen. In plaats van te jongleren met tools en handmatige updates, werken QA- en engineeringteams vanuit een gedeelde, contextuele werkruimte. Het resultaat is niet alleen meer tests, maar ook meer vertrouwen in wat er wordt geleverd en waarom.

Klaar om uw testcases naast uw Sprints en releases te beheren? Ga vandaag nog gratis aan de slag met ClickUp.

Veelgestelde vragen

Ja, Copilot kan de structuur en logica van verouderde code analyseren om een basislijn van tests te genereren. Deze tests zullen echter waarschijnlijk aanzienlijke handmatige controle en verfijning vereisen, aangezien de AI geen context heeft over niet-gedocumenteerd gedrag of historische bedrijfsregels.

De syntactische nauwkeurigheid is zeer hoog, maar de logische nauwkeurigheid hangt af van de duidelijkheid van uw code en de specificiteit van uw prompts. Controleer altijd de beweringen om er zeker van te zijn dat ze zinvolle zakelijke vereisten verifiëren en niet alleen de huidige (en mogelijk gebrekkige) implementatie bevestigen.

Ja, Copilot ondersteunt pytest, unittest en andere populaire Python-testframeworks uitstekend. Het is bedreven in het herkennen en repliceren van bestaande patronen in uw project, zoals het gebruik van fixtures of geparametriseerde tests.

Effectieve teams gebruiken een gecentraliseerd projectmanagementplatform om hun testsuites te beheren. Door elke testcase bij te houden als een taak met aangepaste metadata voor status en prioriteit, krijgen ze zichtbaarheid in de dekking en uitvoeringsresultaten, waardoor het QA-proces rechtstreeks wordt gekoppeld aan sprintplanning en bugtracking.