Da LLMs immer leistungsfähiger werden, ist das Prompting nicht mehr der schwierige Teil. Der Kontext wird zur Einschränkung.

Kontext-Engineering bedeutet, den LLMs (großen Sprachmodellen) die richtigen Informationen im richtigen Format zur Verfügung zu stellen.

Was macht Context Engineering so schwierig?

Sie müssen jede Ebene des Stacks so gestalten, dass der Kontext erfasst und verfügbar gemacht wird. Wenn Sie zu wenig Kontext senden, wissen die LLMs nicht, was sie zu erledigen haben. Wenn Sie zu viel Kontext senden, gehen Ihnen die Tokens aus. Wie finden Sie also das richtige Gleichgewicht?

Im Folgenden geben wir Ihnen alles mit, was Sie über Context Engineering wissen müssen.

Was ist KI-Kontext-Engineering?

KI-Kontext-Engineering ist der Prozess der Gestaltung und Optimierung von Anweisungen und relevantem Kontext für LLMs und fortschrittliche KI- und multimodale Modelle, damit diese ihre Aufgaben effektiv ausführen können.

Das geht über das Verfassen von Prompts hinaus. Das Context Engineering bestimmt:

- Welche Informationen werden angezeigt?

- Woher er stammt (Speicher, tools, Datenbanken, Dokumente)

- Wie es formatiert ist (Schemas, Zusammenfassungen, Einschränkungen)

- Wann wird es in die Argumentationsschleife des Modells eingebracht?

🌟 Der Zweck: Die Informationen, die Sie im Kontextfenster des LLM bereitstellen, zu optimieren und störende Informationen herauszufiltern.

Wie verbessert Kontext die Antworten der KI?

Ohne Kontext prognostiziert ein LLM die statistisch wahrscheinlichste Fortsetzung des Textes. Andererseits verbessert gutes Context Engineering die Ergebnisse durch:

- Verankerung der Argumentation: Das Modell stützt seine Antworten auf bekannte Fakten statt auf statistische Vermutungen.

- Halluzinationen reduzieren: Klare Einschränkungen und relevante Daten schränken den Lösungsraum ein.

- Verbesserung der Konsistenz: Ähnliche Eingaben führen zu ähnlichen Ausgaben, da die Form des Kontexts stabil ist.

- Kosten und Latenz senken: Gezielter Kontext ist besser als das Auslesen ganzer Dokumente oder Historien.

Zusammengefasst in den Worten von Tobi Lutke, CEO von Shopify:

Mir gefällt der Begriff „Kontext-Engineering” besser als „Prompt-Engineering”. Er beschreibt die Kernkompetenz besser: die Kunst, den gesamten Kontext für die Aufgabe bereitzustellen, damit sie vom LLM plausibel gelöst werden kann.

Mir gefällt der Begriff „Kontext-Engineering” besser als „Prompt-Engineering”. Er beschreibt die Kernkompetenz besser: die Kunst, den gesamten Kontext für die Aufgabe bereitzustellen, damit sie vom LLM plausibel gelöst werden kann.

Die Rolle des Context Engineering in KI-gesteuerten Workflows

In KI-gesteuerten Workflows sind LLMs keine eigenständigen Tools. Sie arbeiten innerhalb von Systemen, die bereits über Daten, Regeln und Status verfügen.

Kontext-Engineering ermöglicht es dem Modell zu verstehen, wo es sich im Workflow befindet und was es als Nächstes zu erledigen hat.

Wenn das Modell den aktuellen Zustand, vergangene Aktionen und fehlende Eingaben kennt, kann es den richtigen nächsten Schritt empfehlen oder ausführen, anstatt allgemeine Ratschläge zu geben.

Das bedeutet auch, dass Geschäftslogik wie Genehmigungsregeln, Compliance-Beschränkungen und Eskalationspfade explizit bereitgestellt werden müssen. Wenn diese Teil des Kontexts sind, bleiben die KI-Entscheidungen mit der betrieblichen Realität im Einklang.

Schließlich ermöglicht Context Engineering mehrstufige und agentenbasierte Workflows, indem es eine saubere Übergabe von Status und Entscheidungen bei jedem Schritt gewährleistet.

Dadurch wird verhindert, dass sich Fehler mit zunehmender Skalierung der Workflows häufen, wodurch die Kontexteffektivität verbessert wird.

👀 Wussten Sie schon? 95 % der GenAI-Implementierungen in Unternehmen scheitern, nicht weil die Modelle schwach sind, sondern weil Unternehmen es nicht schaffen, KI in reale Workflows zu integrieren.

Generische KI-Tools wie ChatGPT funktionieren gut für Einzelpersonen, versagen jedoch in großem Maßstab, da sie nicht aus dem Systemkontext, den Geschäftsregeln oder dem sich entwickelnden Zustand lernen. Mit anderen Worten: Die meisten KI-Fehler sind Integrations- und Kontextfehler, keine Modellfehler.

📮ClickUp Insight: 62 % unserer Befragten verlassen sich auf dialogorientierte KI-Tools wie ChatGPT und Claude. Ihre vertraute Chatbot-Oberfläche und ihre vielseitigen Fähigkeiten – zum Generieren von Inhalten, Analysieren von Daten und mehr – könnten der Grund dafür sein, dass sie in verschiedenen Rollen und Branchen so beliebt sind. Wenn ein Benutzer jedoch jedes Mal zu einer anderen Registerkarte wechseln muss, um der KI eine Frage zu stellen, summieren sich die damit verbundenen Kosten des Umschaltens und des Kontextwechsels mit der Zeit. Nicht so bei ClickUp Brain. Es befindet sich direkt in Ihrer ClickUp-Workspace, weiß, woran Sie gerade arbeiten, versteht Nur-Text-Befehle und gibt Ihnen Antworten, die für Ihre Aufgaben hochrelevant sind! Erleben Sie mit ClickUp eine Verdopplung Ihrer Produktivität!

Wie funktioniert Context Engineering?

Beim Context Engineering werden Informationen schrittweise aufbereitet, bevor sie das Modell erreichen.

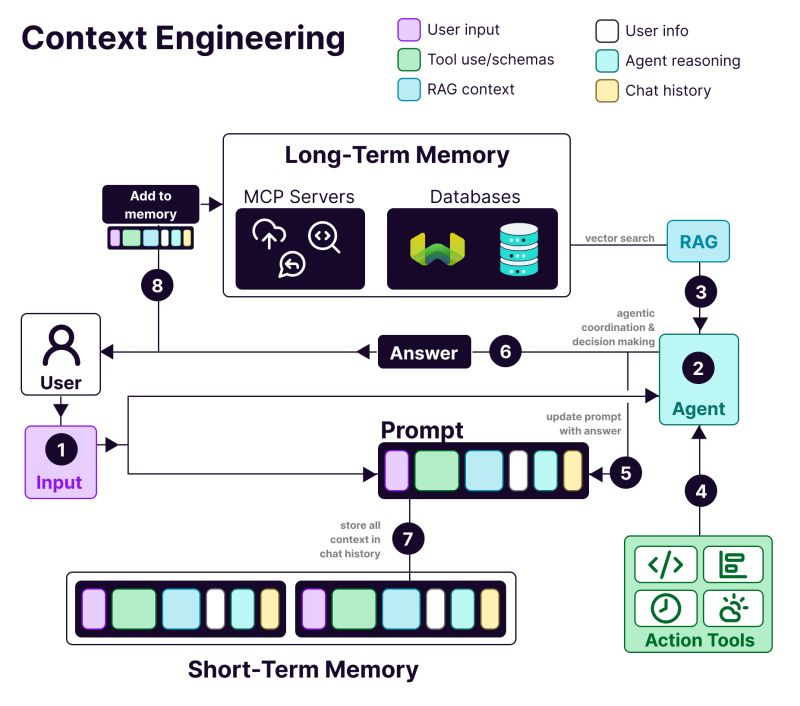

Die Anatomie eines kontextorientierten Systems umfasst:

- 𝗨𝘀𝗲𝗿 i𝗻𝗳𝗼𝗿𝗺𝗮𝘁𝗶𝗼𝗻: Präferenzen, Verlauf und Personalisierungsdaten

- T𝗼𝗼𝗹 u𝘀𝗲: APIs, Rechner, Suchmaschinen – alles, was das LLM benötigt, um seine Aufgabe zu erledigen.

- 𝗥𝗔𝗚 c𝗼𝗻𝘁𝗲𝘅𝘁: Abgerufene Informationen aus Vektordatenbanken wie Weaviate

- 𝗨𝘀𝗲𝗿 i𝗻𝗽𝘂𝘁: Die eigentliche Abfrage oder Aufgabe

- 𝗔𝗴𝗲𝗻𝘁 r𝗲𝗮𝘀𝗼𝗻𝗶𝗻𝗴: Der Denkprozess und die Entscheidungsfindung des LLM

- 𝗖𝗵𝗮𝘁 h𝗶𝘀𝘁𝗼𝗿𝘆: Frühere Interaktionen, die für Kontinuität sorgen

Vorteile von Context Engineering in KI-Systemen

Hier sind die Gründe, warum Sie beim Erstellen von KI-Anwendungen Context Engineering benötigen:

Genauere Ergebnisse

Die Bereitstellung entscheidungsrelevanter Kontexte reduziert Unklarheiten. Das Modell argumentiert innerhalb bekannter Fakten, Einschränkungen und Zustände, anstatt sich auf probabilistische Vermutungen zu stützen.

Konsistentes Verhalten in großem Maßstab

Stabile Kontextstrukturen führen zu wiederholbaren Ergebnissen. Ähnliche Eingaben führen zu ähnlichen Entscheidungen – unerlässlich für Workflows.

Reduzierte Kosten und Latenz

Ein gezielter, komprimierter Kontext vermeidet Token-Verschwendung. Systeme reagieren schneller, ohne wiederholt vollständige Historien oder Dokumente laden zu müssen.

Sicherere Automatisierung

Der Kontext kodiert Geschäftsregeln und Berechtigungen. Dadurch kann die KI handeln, ohne gegen Richtlinien zu verstoßen oder als Auslöser für riskante Aktionen zu dienen.

Bessere mehrstufige Workflows

Saubere Kontextübergaben bewahren den Status über alle Schritte hinweg. Fehler summieren sich nicht, wenn Workflows komplexer oder agentialer werden.

Einfacheres Debugging und Iteration

Strukturierter Kontext macht Fehler sichtbar. Sie können Fehler auf fehlende, veraltete oder falsch bewertete Eingaben zurückführen, anstatt dem Modell die Schuld zu geben.

Stärkere Akzeptanz in Unternehmen

KI-Systeme, die den Workflow-Kontext berücksichtigen, wirken zuverlässig – ein entscheidender Unterschied zwischen Pilotprojekten und Tools für den unternehmensweiten Einsatz.

📚 Weiterlesen: Wie man KI mit Zugriff auf Echtzeitdaten nutzt

👀 Wussten Sie schon? Kontextbewusste KI wirkt sich direkt auf die Produktivität aus. Eine Studie der Boston Consulting Group hat ergeben, dass allein Kommunikationsteams mit generativer KI heute 26 bis 36 % ihrer Zeit zurückgewinnen können. Mit neu gestalteten Workflows und agentenbasierten Systemen, die den Kontext verstehen, kann die Produktivität sogar um bis zu 50 % gesteigert werden.

KI-Kontext-Engineering vs. Prompt-Engineering

Prompt Engineering: Bitten Sie ChatGPT, eine E-Mail zur Ankündigung eines neuen Features zu verfassen. Sie schreiben Anweisungen für eine einzelne Aufgabe.

Kontext-Engineering: Sie entwickeln einen Kundenservice-Bot. Dieser muss sich frühere Tickets merken, auf Informationen zum Benutzerkonto zugreifen und die Unterhaltung speichern können.

Wie der KI-Forscher Andrej Karpathy erklärt:

Menschen assoziieren Prompts mit kurzen Beschreibungen von Aufgaben, die man einem LLM im täglichen Gebrauch geben würde. In jeder industrietauglichen LLM-App ist Context Engineering die delikate Kunst und Wissenschaft, das Kontextfenster mit genau den richtigen Informationen für den nächsten Schritt zu füllen.

Menschen assoziieren Prompts mit kurzen Beschreibungen von Aufgaben, die man einem LLM im täglichen Gebrauch geben würde. In jeder industrietauglichen LLM-App ist Context Engineering die delikate Kunst und Wissenschaft, das Kontextfenster mit genau den richtigen Informationen für den nächsten Schritt zu füllen.

+1 für „Kontext-Engineering” gegenüber „Prompt-Engineering”.

Menschen assoziieren Prompts mit kurzen Beschreibungen von Aufgaben, die man einem LLM im täglichen Gebrauch geben würde. In jeder industrietauglichen LLM-App ist Context Engineering die heikle Kunst und Wissenschaft, das Kontextfenster zu füllen... https://t.co/Ne65F6vFcf

— Andrej Karpathy (@karpathy) 25. Juni 2025

+1 für „Kontext-Engineering” gegenüber „Prompt-Engineering”.

Menschen assoziieren Prompts mit kurzen Beschreibungen von Aufgaben, die man einem LLM im täglichen Gebrauch geben würde. In jeder industrietauglichen LLM-App ist Context Engineering die heikle Kunst und Wissenschaft, das Kontextfenster zu füllen... https://t.co/Ne65F6vFcf

— Andrej Karpathy (@karpathy) 25. Juni 2025

| Ansatz | Worauf es sich konzentriert | Am besten geeignet für |

| Prompt-Engineering | Erstellen von Anweisungen und Formaten für das Modell | Einmalige Aufgaben, Generierung von Inhalten, formatspezifische Ausgaben |

| Kontext-Engineering | Bereitstellung relevanter Daten, Zustände und Einschränkungen für das Modell | Konversations-KI, Tools zur Dokumentenanalyse, Programmierassistenten |

| Beides zusammen | Kombinieren Sie klare Anweisungen mit Kontext auf Systemebene. | Produktions-KI-Anwendungen, die eine konsistente, zuverlässige Leistung erfordern |

Die meisten Anwendungen verwenden eine Kombination aus Prompt Engineering und Context Engineering. Sie benötigen weiterhin gut geschriebene Prompts in Ihrem Context-Engineering-System.

Der Unterschied besteht darin, dass diese Eingabeaufforderungen mit sorgfältig verwalteten Hintergrundinformationen arbeiten. Man muss nicht jedes Mal von vorne beginnen.

📮 ClickUp Insight: Mehr als die Hälfte der Befragten tippt täglich in drei oder mehr tools und kämpft damit gegen „AI Sprawl ” und verstreute Workflows.

Auch wenn es sich produktiv und geschäftig anfühlt, geht Ihr Kontext einfach zwischen den Apps verloren, ganz zu schweigen von der Energie, die Sie beim Tippen verbrauchen. Brain MAX bringt alles zusammen: Sprechen Sie einmal, und Ihre Updates, Aufgaben und Notizen landen genau dort, wo sie in ClickUp hingehören. Kein Umschalten mehr, kein Chaos mehr – nur nahtlose, zentralisierte Produktivität.

Anwendungen von KI-Kontext-Engineering

Die wichtigsten Bereiche, in denen KI-Kontext-Engineering bereits implementiert wird, sind 👇

Kundensupport und Helpdesk-Automatisierung

Die meisten Chatbots behandeln jede Nachricht als neu, sodass die Benutzer sich immer wieder wiederholen müssen.

Mit Context Engineering kann die KI auf die Historie des Benutzers, frühere Interaktionen, Kaufdaten und Produktdokumentationen zurückgreifen. So reagiert sie wie ein Teamkollege, der das Problem bereits kennt.

📌 Beispiel aus der Praxis: Das Support-Team von Coda bearbeitet technische Produktfragen, für die das Verständnis früherer Nachrichten und das Nachschlagen in der Produktdokumentation erforderlich ist. Um den Support zu skalieren, verwenden sie Intercom Fin. Fin liest vor der Beantwortung die Dokumentation und frühere Unterhaltungen und hilft so, 50–70 % der Kundenfragen autonom zu lösen und gleichzeitig eine hohe Kundenzufriedenheit aufrechtzuerhalten.

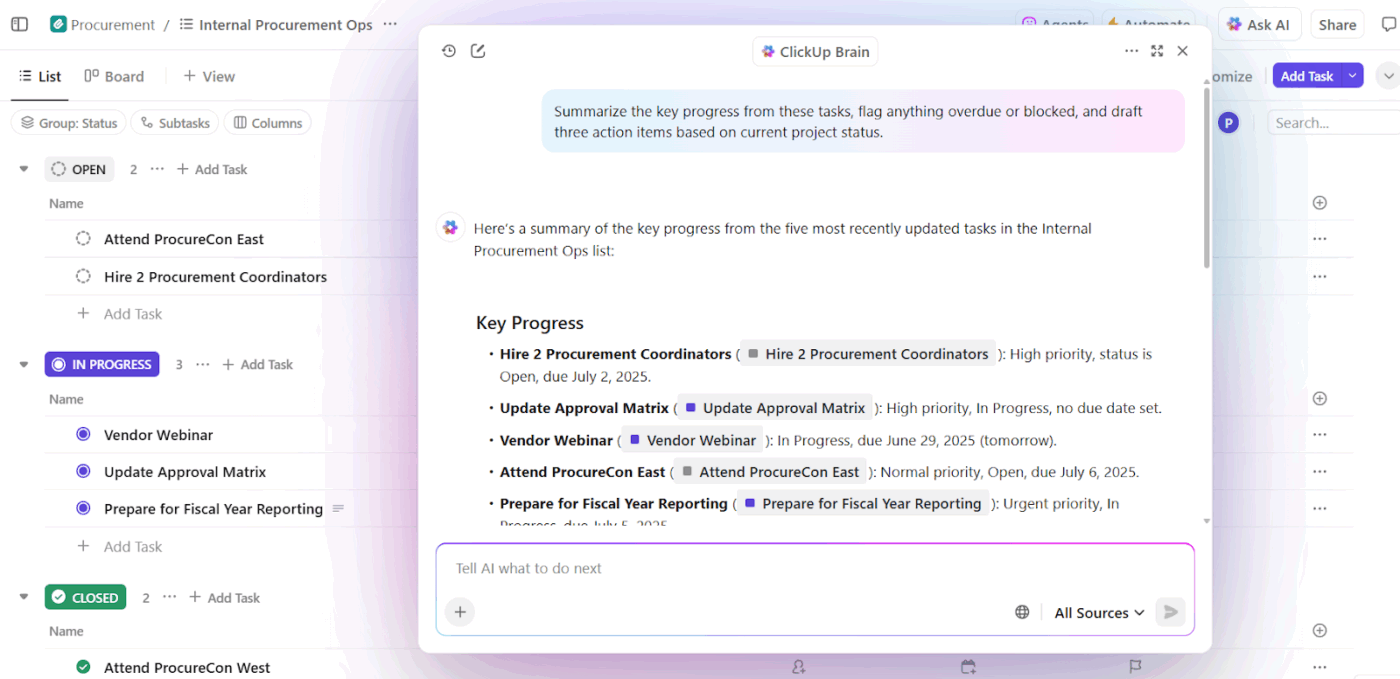

KI-Assistenten für das Schreiben und die Produktivität am Arbeitsplatz

KI-Schreibtools liefern nur dann einen Wert, wenn sie verstehen, woran Sie arbeiten, warum es wichtig ist und was bereits existiert. Ohne diesen Kontext sparen sie zwar Zeit beim Entwerfen, erfordern aber dennoch umfangreiche Überarbeitungen und manuelle Anpassungen.

Hier verändert Context Engineering AI die Ergebnisse. Indem sie KI auf den Aufgabenstatus, Dokumente, frühere Entscheidungen und Teamkonventionen stützen, entwickeln sich Schreibassistenten von der generischen Texterstellung zu einem workfloworientierten Support.

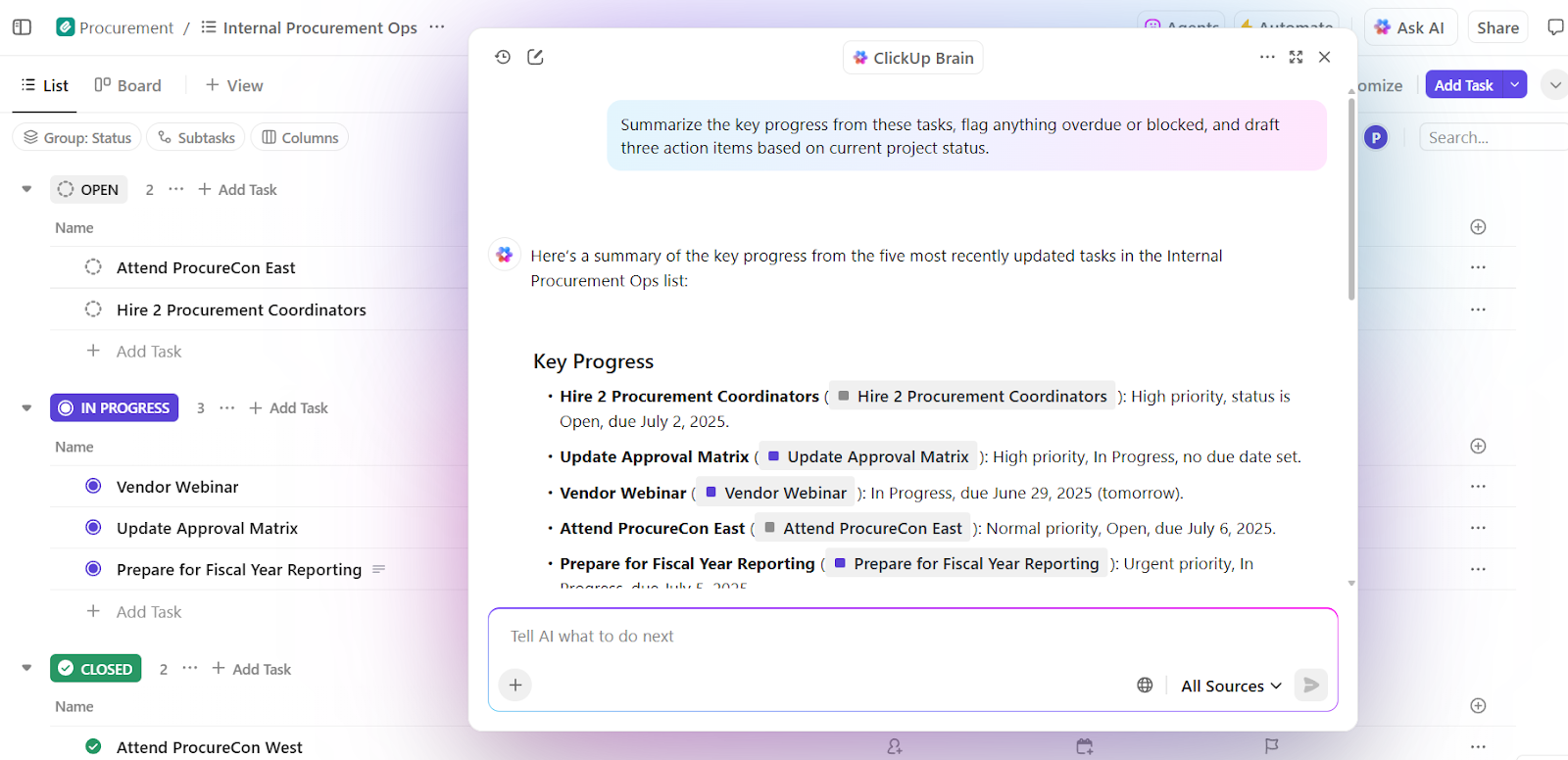

📌 Beispiel aus der Praxis: ClickUp Brain, die native KI von ClickUp, wendet Context Engineering auf Ebene des Workspaces an. Anstatt Benutzer aufzufordern, Hintergrundinformationen in Eingabeaufforderungen einzufügen, bezieht es den Kontext direkt aus Aufgaben, Dokumenten, Kommentaren, Prioritäten und Zeitleisten.

Eine wichtige Fähigkeit ist die kontextbezogene Entscheidungsfindung. Dabei werden laufende Projekte zusammen mit der Team-Kapazität und der bisherigen Leistung bewertet, um umsetzbare Erkenntnisse zu gewinnen.

Zunächst einmal kann Brain Überlastungen, Verzögerungen und Engpässe erkennen. Es fasst das Problem nicht nur zusammen, sondern empfiehlt auch konkrete Anpassungen – in Form einer Neuverteilung von Aufgaben, einer Aktualisierung von Zeitleisten und einer Neugewichtung von Prioritäten.

Da diese Entscheidungen auf einem Live-Workspace-Kontext basieren, ist das Ergebnis sofort nutzbar. Es ist nicht notwendig, den Hintergrund erneut darzulegen, Prioritäten zu erklären oder Empfehlungen manuell an die Realität anzupassen.

Teams, die ClickUp Brain verwenden, berichten von 2,26-mal höheren Vollintegrationsraten und den niedrigsten KI-Frustrationswerten (27,1 %).

Vertriebs- und CRM-Intelligenz

Vertriebsworkflows umfassen E-Mails, Meetings, CRMs und Tabellenkalkulationen. Ohne Kontext kann KI weder die Dynamik eines Geschäfts noch die Absichten des Käufers verstehen.

Context Engineering verschafft der KI Sichtbarkeit in Käufengespräche, Zeitleisten, Kommunikationston und vergangene Interaktionen. Dies hilft dabei, Erkenntnisse zu gewinnen, ins Stocken geratene Geschäfte zu erkennen und die richtigen nächsten Schritte vorzuschlagen.

📌 Beispiel aus der Praxis: Das Vertriebsteam von Microsoft nutzt Copilot for Sales, das Kontextinformationen aus Outlook, Teams-Anrufen, CRM-Updates und Notizen abruft, um die richtigen Erkenntnisse zu gewinnen und Follow-ups zu entwerfen. Interne Teams verzeichneten einen Anstieg der abgeschlossenen Geschäfte um 20 % und einen Umsatzanstieg pro Verkäufer um 9,4 %, was zeigt, wie kontextgesteuerte KI die Leistung steigert.

KI-Assistenten im Gesundheitswesen und in der Klinik

Medizinische Entscheidungen basieren auf der Krankengeschichte des Patienten, Laborberichten, Rezepten und Arztnotizen, aber diese Informationen befinden sich oft in voneinander getrennten Systemen. Dies führt dazu, dass Ärzte viel Zeit mit der erneuten Eingabe von Daten verlieren und Gefahr laufen, wichtige Details zu übersehen. Manchmal verbringen sie fast 40 % ihrer Zeit mit Verwaltungsaufgaben.

KI-Kontext-Engineering schafft die Verbindung zwischen diesen Datenpunkten. Es unterstützt Ärzte mit präzisen Zusammenfassungen, Entwürfen für Dokumentationen, hebt relevante Vorgeschichten hervor und zeigt potenzielle Risiken oder nächste Schritte auf.

📌 Beispiel aus der Praxis: Atrium Health nutzt Nuance DAX Copilot, das in Zusammenarbeit mit Microsoft entwickelt wurde, um klinische Besuche anhand früherer Aufzeichnungen und Echtzeit-Unterhaltungen automatisch zu dokumentieren. Als Ergebnis sparen Ärzte täglich 30 bis 40 Minuten Zeit bei der Dokumentation. Eine Studie, die 12 medizinische Fachbereiche umfasste, ergab eine höhere Effizienz und Zufriedenheit der Anbieter, ohne dass die Patientensicherheit beeinträchtigt wurde.

HR- und Recruiting-Assistenten

Einstellungsentscheidungen hängen vom Kontext ab, wie z. B. Fähigkeiten, Feedback aus Vorstellungsgesprächen, Eignung für die Rolle und Daten aus früheren Einstellungen. Mit KI-Kontext-Engineering können Sie Lebensläufe, Stellenbeschreibungen, Transkripte von Vorstellungsgesprächen und historische Muster analysieren, um schneller passende Kandidaten zu finden.

📌 Beispiel aus der Praxis: Die Teams des Unternehmens Micron nutzen Eightfold AI, eine Talent-Intelligence-Plattform, die Lebensläufe, Anforderungen an Rollen, interne Karrierewege und frühere Einstellungsergebnisse analysiert, um die Eignung für eine Rolle vorherzusagen. Die Plattform bewertet Kandidaten anhand ihrer Fähigkeiten und ihres Potenzials. Das Ergebnis? Eine Erweiterung der Talent-Pipeline und die Einstellung von acht weiteren Kandidaten pro Monat mit einem schlanken Recruiting-Team.

Tools und Plattformen, die das Context Engineering unterstützen

Welche Tools helfen Ihnen dabei, Context Engineering in großem Maßstab zu implementieren?

1. LangChain (Am besten, den Kontext programmgesteuert zusammenzustellen)

LangChain ist ein Open-Source-Orchestrierungsframework für den Aufbau von KI-Systemen, bei denen der Kontext programmgesteuert zusammengestellt, aktualisiert und weitergeleitet werden muss.

Das KI-Agent-Tool hilft Entwicklern dabei, LLMs mit Tools, Datenquellen, Speicher und Steuerungslogik zu verbinden, anstatt sich auf statische Eingabeaufforderungen zu verlassen.

Core LangChain übernimmt das Verketten und Abrufen, während LangGraph zustandsbehaftete, graphbasierte Workflows für komplexe, mehrstufige Schlussfolgerungen ermöglicht.

DeepAgents baut auf dieser Grundlage auf und unterstützt langlebige, autonome Agenten mit Planung, Subagenten und persistenter Kontextinformation.

Zusammen machen diese Komponenten LangChain zu einer Kontrollschicht für das Context Engineering, die entscheidet, wann der Kontext abgerufen wird, wie er sich entwickelt und wo er in den Workflows der Agenten fließt.

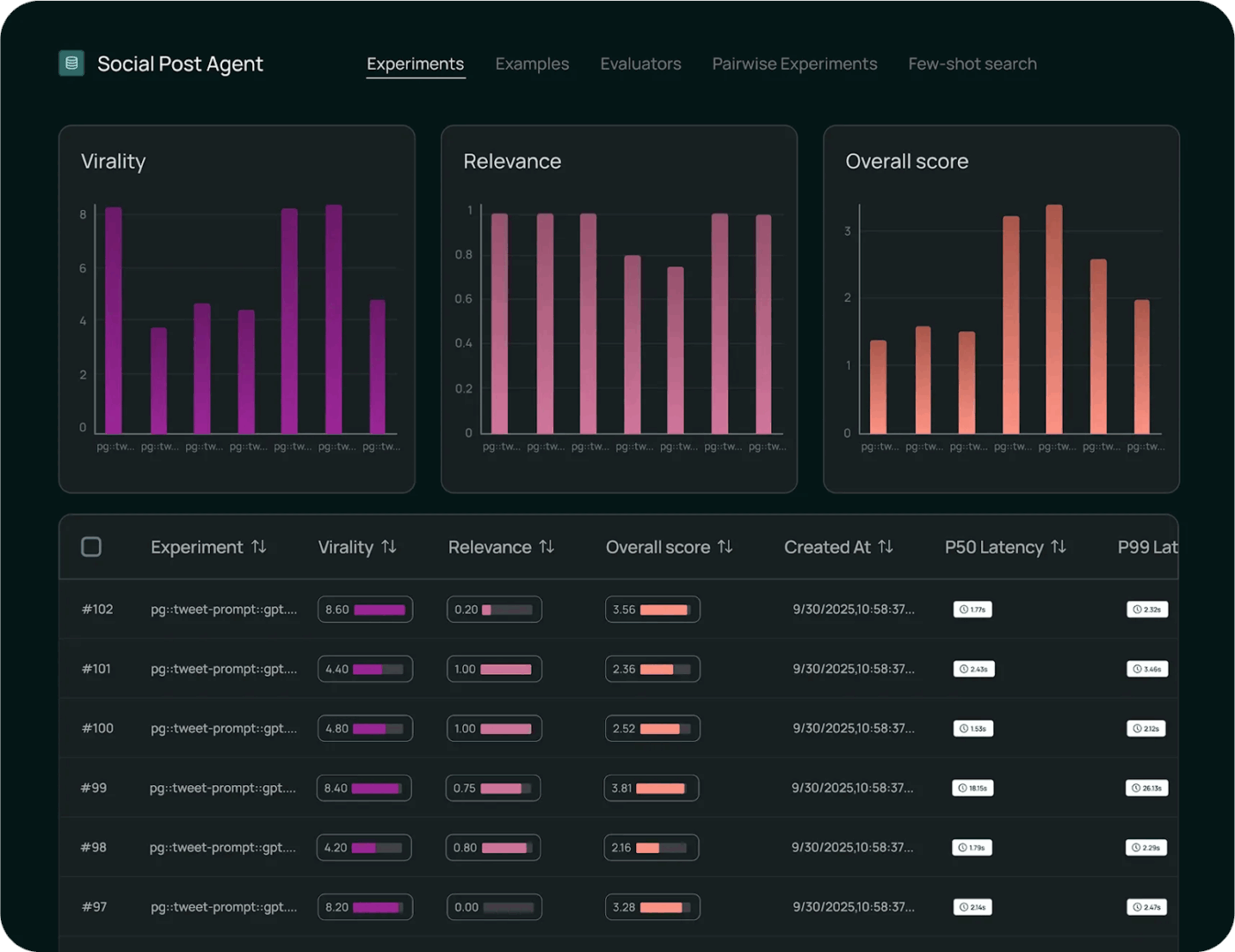

Die besten Features von LangChain

- Überwachen Sie die Ausführung mit Observability-Tools für die Nachverfolgung von Modellaufrufen, Latenz, Fehlern und dem Kontext-Flow durchgängig, um Einblicke in die Fehlerbehebung und Leistung zu gewinnen.

- Bewerten Sie das Modellverhalten systematisch mithilfe integrierter Testframeworks, die die Korrektheit messen, Ergebnisse vergleichen und Änderungen anhand von Benchmarks validieren.

- Stellen Sie Workflows in großem Maßstab mit verwalteten Umgebungen bereit, die Versionierung, Rollout-Kontrolle und produktionsreife Ausführung von Ketten und Agenten unterstützen.

Einschränkungen von LangChain

- The tool has a steep learning curve for beginners, and the documentation, which is updated every few days, makes it overwhelming.

Preise für LangChain

- Entwickler: Kostenlos

- Plus: 39 $/Benutzer/Monat

- Unternehmen: Benutzerdefinierte Preisgestaltung

LangChain-Bewertungen und Rezensionen

- G2: 4,7/5 (über 30 Bewertungen)

- Capterra: Nicht genügend Bewertungen und Rezensionen

Was sagen echte Benutzer über LangChain?

Laut einem Benutzer auf Reddit:

Nachdem ich verschiedene Methoden getestet habe, bin ich schließlich bei der Verwendung von Standard-Tool-Aufrufen mit Langgraph-Workflows hängen geblieben. Ich verpacke also die deterministischen Workflows als Agenten, die das Haupt-LLM als tools aufruft. Auf diese Weise bietet das Haupt-LLM eine echte dynamische Benutzererfahrung und übergibt die Schwerarbeit einfach an einen Workflow, der seine Ergebnisse dann wieder an das Haupt-LLM zurückgibt.

Nachdem ich verschiedene Methoden getestet habe, bin ich schließlich bei der Verwendung von Standard-Tool-Aufrufen mit Langgraph-Workflows hängen geblieben. Ich verpacke also die deterministischen Workflows als Agenten, die das Haupt-LLM als Tools aufruft. Auf diese Weise bietet das Haupt-LLM eine echte dynamische Benutzererfahrung und übergibt die Schwerarbeit einfach an einen Workflow, der sie dann wieder an das Haupt-LLM zurückgibt.

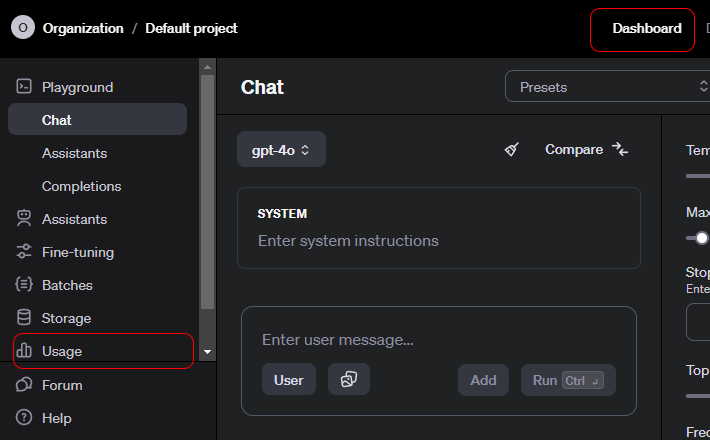

2. OpenAI API (Contextual AI API bietet strukturierten Kontext, Tool-Aufrufe und Kontrollen auf Systemebene)

Die OpenAI-API ist eine universelle Schnittstelle für den Zugriff auf fortschrittliche generative KI-Modelle, die einen breiten Bereich an Anwendungen unterstützen.

Entwickler nutzen es, um Sprachverständnis und -generierung in Produkte zu integrieren. Es unterstützt auch Zusammenfassungen, Übersetzungen, Code-Assistenz und Schlussfolgerungen.

Die API unterstützt Chat, Einbettungen, Funktionsaufrufe, Moderation und multimodale Eingaben und ermöglicht so strukturierte Interaktionen mit Modellen. OpenAI eignet sich gut für Rapid Prototyping, da es Authentifizierung, Skalierung und Versionierung übernimmt.

Die Benutzerfreundlichkeit ist darauf zurückzuführen, dass die API komplexes Modellverhalten in einfache, zuverlässige Endpunkte abstrahiert.

Die besten Features der OpenAI-API

- Generieren Sie kontextbezogene Ausgaben für Text, Code und multimodale Eingaben für Aufgaben und Schlussfolgerungen in natürlicher Sprache.

- Erstellen Sie reichhaltige Einbettungen, um semantische Suche, Clustering und vektorbasierte Abruf-Workflows zu unterstützen.

- Rufen Sie Funktionen und tools über strukturierte Aufrufe auf, die es Modellen ermöglichen, mit externen Systemen und Diensten zu interagieren.

Limit der OpenAI-API

- Kein natives Langzeitgedächtnis. Die API ist standardmäßig zustandslos.

Preise für die OpenAI-API

GPT-5. 2

- Eingabe: 1,750 $ / 1 Million Tokens

- Zwischengespeicherte Eingabe: 0,175 $ / 1 Million Tokens

- Ergebnis: 14.000 $ / 1 Million Tokens

GPT-5. 2 Pro

- Eingabe: 21,00 $ / 1 Million Tokens

- Zwischengespeicherte Eingabe: Nicht verfügbar

- Ergebnis: 168,00 $ / 1 Million Tokens

GPT-5 Mini

- Eingabe: 0,250 $ / 1 Million Tokens

- Zwischengespeicherte Eingabe: 0,025 $ / 1 Million Tokens

- Ausgabe: 2.000 $ / 1 Million Tokens

OpenAI API-Bewertungen und Rezensionen

- G2: Nicht genügend Bewertungen

- Capterra: Nicht genügend Bewertungen

Was sagen Benutzer aus der Praxis über die OpenAI-API?

Laut einem Benutzer auf Reddit:

Die APIs von OpenAI sind wie alle anderen auch, sodass aus technischer Sicht keine Lernkurve erforderlich sein sollte. Alle Endpunkte, Parameter und Beispielantworten sind gut dokumentiert. Wenn Sie über grundlegende Entwicklungserfahrung verfügen, sollten Sie keinen Kurs benötigen. Ich stimme dem oben genannten Punkt zu, Python zu lernen. Die Python-Bibliotheken enthalten alle relevanten Informationen, um Ihnen das Leben zu erleichtern. Es gibt auch Node-Bibliotheken, wenn Sie bei JS bleiben möchten. Die größte Lernkurve wird darin bestehen, wie man sie strategisch einsetzt. Verbringen Sie einige Zeit damit, Systemmeldungen, Benutzeraufforderungen und Parameter im Playground auszuprobieren, bevor Sie versuchen, sie mit Code zu erstellen. (Ich bin mir ziemlich sicher, dass Sie Beispielcode aus dem Playground erhalten können, nachdem Sie etwas gefunden haben, das funktioniert. )

Die APIs von OpenAI sind wie alle anderen auch, sodass aus technischer Sicht keine Lernkurve erforderlich sein sollte. Alle Endpunkte, Parameter und Beispielantworten sind gut dokumentiert. Wenn Sie über grundlegende Entwicklungserfahrung verfügen, sollten Sie keinen Kurs benötigen. Ich stimme dem oben genannten Punkt zu, Python zu lernen. Die Python-Bibliotheken enthalten alle relevanten Informationen, um Ihnen das Leben zu erleichtern. Es gibt auch Node-Bibliotheken, wenn Sie bei JS bleiben möchten. Die größte Lernkurve wird darin bestehen, wie man sie strategisch einsetzt. Verbringen Sie einige Zeit damit, Systemmeldungen, Benutzeraufforderungen und Parameter im Playground auszuprobieren, bevor Sie versuchen, sie mit Code zu erstellen. (Ich bin mir ziemlich sicher, dass Sie Beispielcode aus dem Playground erhalten können, nachdem Sie etwas gefunden haben, das funktioniert. )

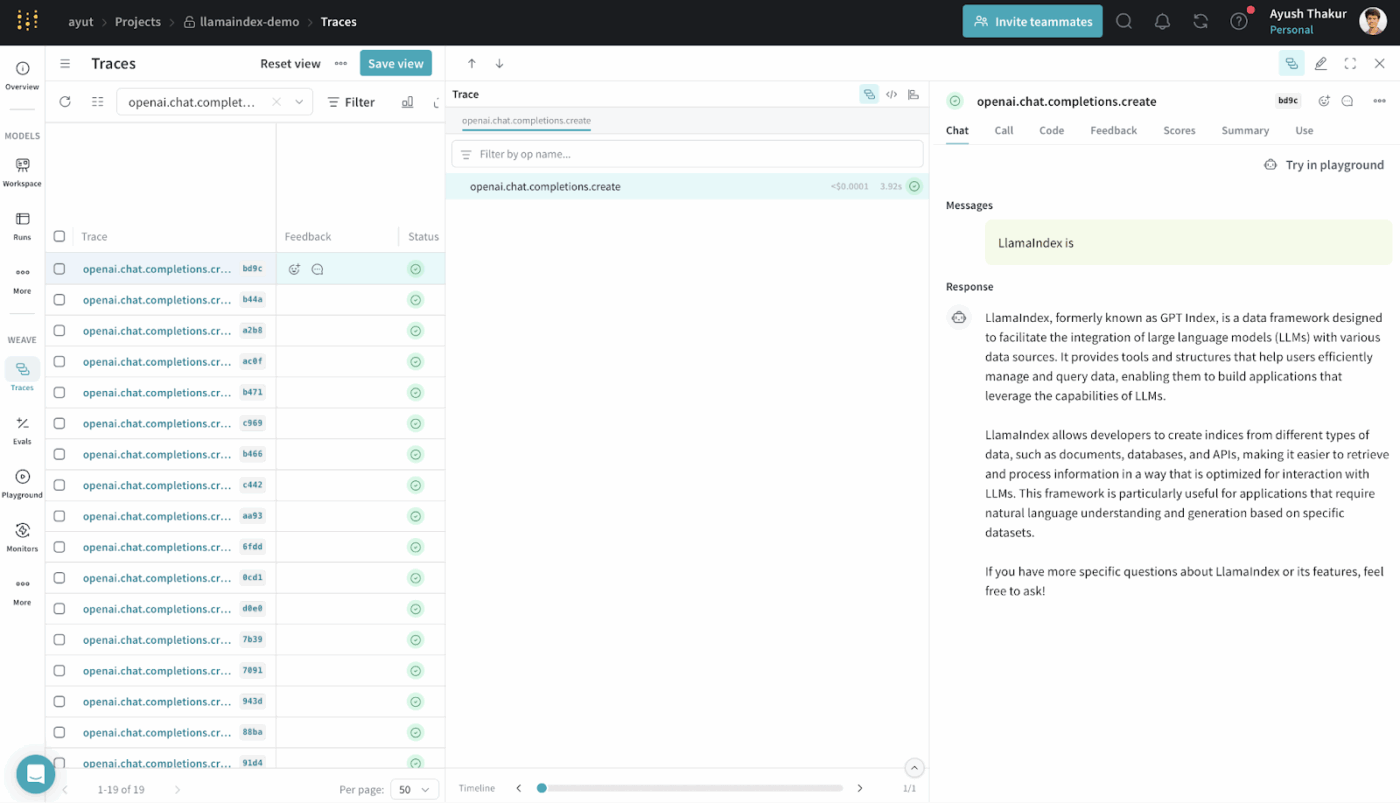

3. LlamaIndex (am besten geeignet für Systeme zur Erweiterung der Suchergebnisse)

LlamaIndex ist ein Open-Source-Datenframework, das entwickelt wurde, um externe Daten für große Sprachmodelle zugänglich und nutzbar zu machen.

Es bietet Konnektoren, Indizes und Abfrage-Schnittstellen, die strukturierte und unstrukturierte Daten in Darstellungen umwandeln, die LLMs effizient verarbeiten können.

Sie können RAG-Systeme ohne komplexe benutzerdefinierte Infrastruktur aufbauen. Diese abstrahiert die Abfrage, Vektorisierung und Relevanzbewertung.

Es wird häufig für Anwendungsfälle wie semantische Suche, Zusammenfassung und Beantwortung von Fragen verwendet, die auf realen Daten basieren.

Die besten Features von LlamaIndex

- Indizieren Sie heterogene Datenquellen in durchsuchbaren Strukturen, die LLMs effektiv für Abfragen nutzen können.

- Rufen Sie den Kontext strategisch mithilfe von Vektorsuche und Abfrageplanung ab, um präzise Beweise einzubringen.

- Komprimieren und fassen Sie den Kontext zusammen, um die Argumentation effizient und relevant zu halten.

Preise für LlamaIndex

- Free

- Starter: 50 $/Monat

- Pro: 500 $/Monat

- Unternehmen: Benutzerdefinierte Preisgestaltung

LlamaIndex-Bewertungen und Rezensionen

- G2: Nicht genügend Bewertungen

- Capterra: Nicht genügend Bewertungen

Was sagen Benutzer aus der Praxis über LlamaIndex?

Ein Benutzer gibt auf Reddit frei:

Ehrlich gesagt finde ich, dass die meisten dieser genAi-Frameworks wie Langchain und LlamaIndex nicht besonders gut sind und den Code komplizierter machen. Es ist besser, Vanilla Python zu verwenden.

Ehrlich gesagt finde ich, dass die meisten dieser genAi-Frameworks wie Langchain und LlamaIndex nicht besonders gut sind und den Code komplizierter machen. Es ist besser, Vanilla Python zu verwenden.

4. ClickUp BrainGPT (Am besten als KI-Assistent für Ihren Workspace geeignet)

Die meisten Tools in dieser Liste helfen Ihnen bei bestimmten Aspekten des Context Engineering. Sie stellen Prompts zusammen, rufen Daten ab oder koordinieren Workflows.

ClickUp Brain verfolgt einen anderen Ansatz. Als weltweit erster konvergierter KI-Arbeitsbereich vereint ClickUp Ihre Projekte, Aufgaben, Dokumente und Kommunikationen auf einer einzigen Plattform, in die eine kontextsensitive KI integriert ist.

So geht's 👇

Arbeiten Sie mit einer KI, die Sie und Ihre Arbeit versteht.

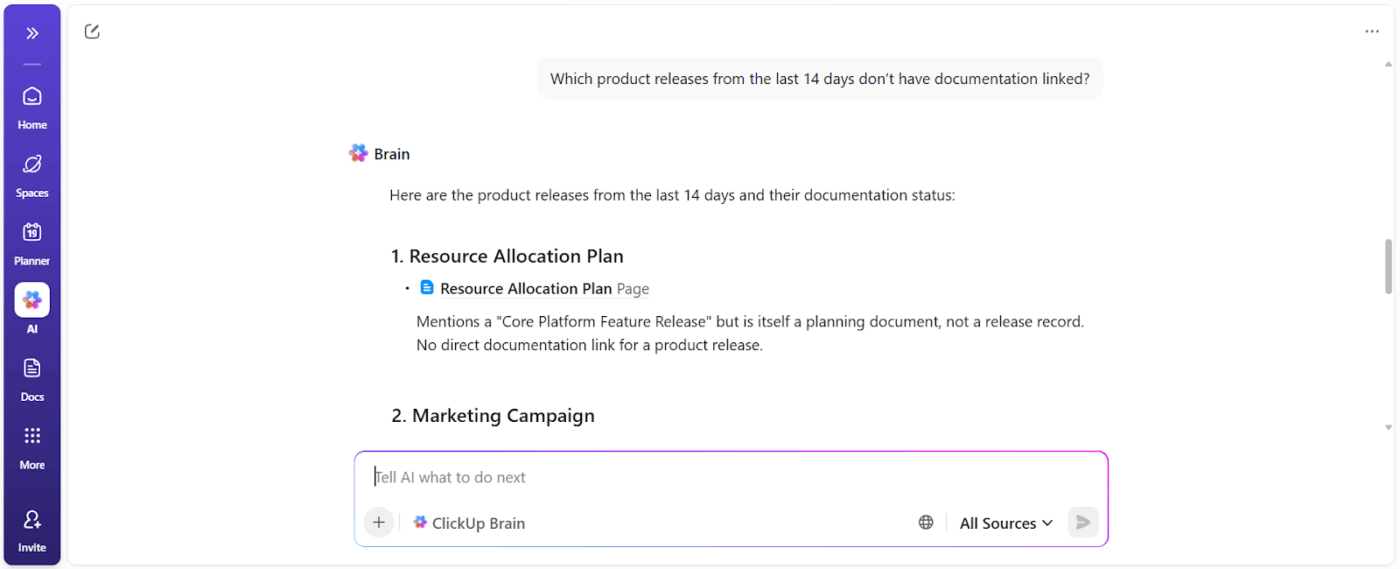

ClickUp Brain versteht den Kontext Ihrer Arbeit.

Es zieht den Kontext aus Ihren ClickUp-Aufgaben, Dokumenten, Kommentaren, Abhängigkeiten, Status, Zeitleisten und Eigentümerschaften. Sie müssen nicht jedes Mal, wenn Sie eine Frage auf der Grundlage von Workspace-Daten stellen, den Hintergrund einfügen oder die Projektgeschichte erklären.

📌 Als Beispiel fragt ein Manager beispielsweise: „Was bremst die Kampagne für das dritte Quartal?“, wird der Workspace gescannt und konkrete Hindernisse wie die folgenden angezeigt:

- Nicht zugewiesene Aufgaben

- Ausstehende Genehmigungen

- Ins Stocken geratene Bewertungen

- Abhängigkeiten, die auf Assets warten

Sie erhalten einen Blocker-Bericht, der die Eigentümer der Maßnahmen und die zeitlichen Auswirkungen aufzeigt.

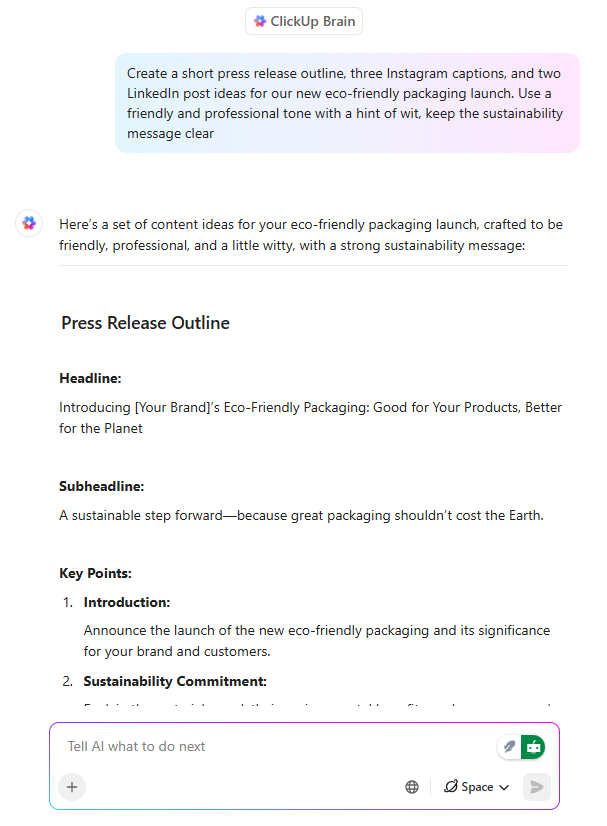

KI-Texte, die bereits auf die Ausführung abgestimmt sind

ClickUp Brain fungiert als KI-Schreibassistent, jedoch mit einem entscheidenden Unterschied: Es schreibt mit dem Bewusstsein dafür, was das Team aufbaut.

Wenn ein Produktmanager oder Marketer in einem ClickUp-Dokument eine Launch-Nachricht entwirft, kann Brain:

- Definieren Sie Wertversprechen unter Verwendung des bestehenden Produktkontexts.

- Passen Sie Ihre Botschaften an verschiedene Zielgruppen an

- Schreiben Sie Inhalte um, damit sie den Zielen in Bezug auf Ton, Klarheit oder Positionierung entsprechen.

Noch wichtiger ist, dass das Geschriebene mit Aufgaben, Zeitleisten und Genehmigungen in Verbindung bleibt. Es gibt keine Diskrepanz zwischen der Dokumentation und der Arbeit. Das spart viel Zeit, da Inhalte später nicht neu interpretiert werden müssen.

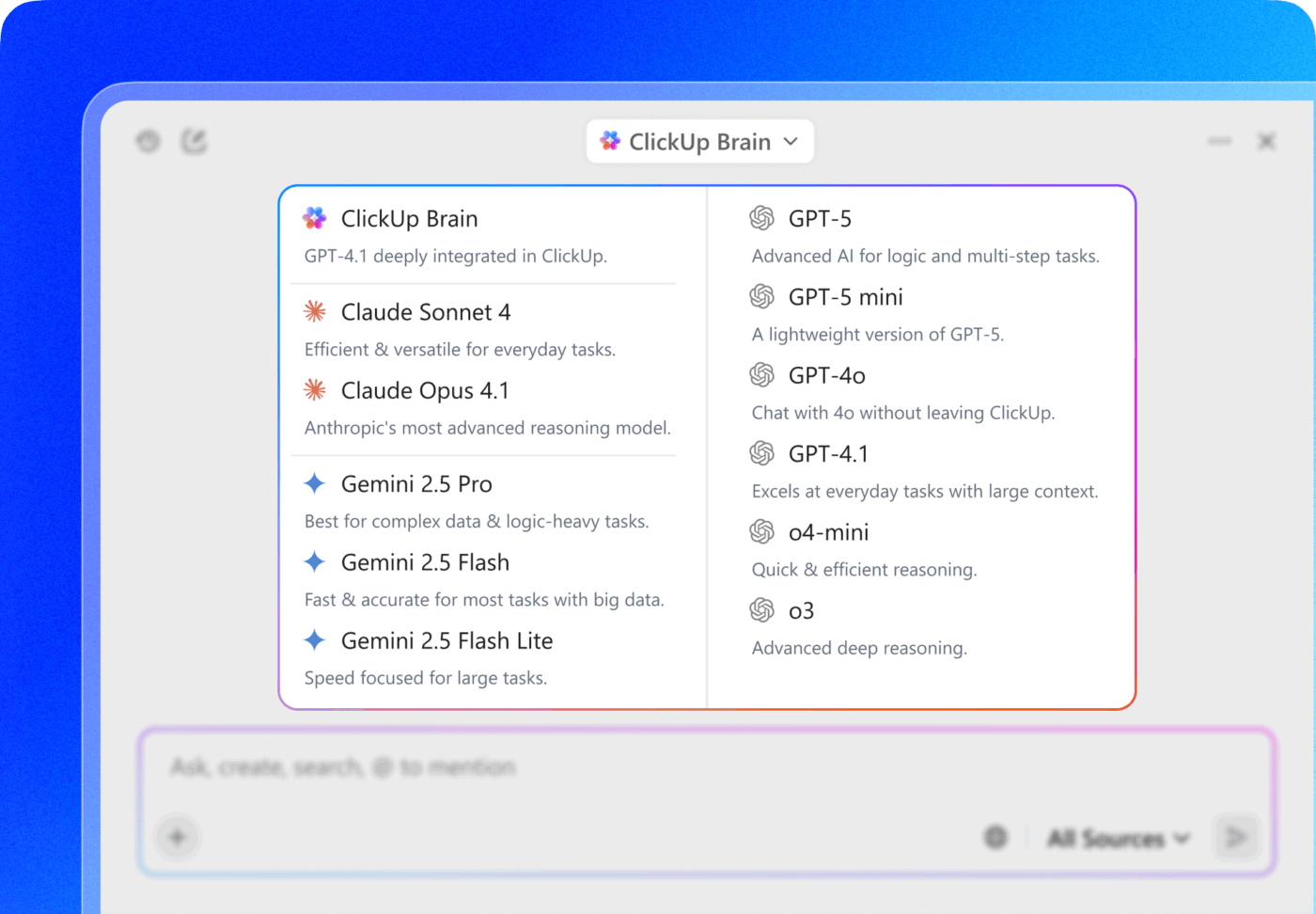

💡 Profi-Tipp: Wählen Sie direkt in ClickUp Brain zwischen mehreren KI-Modellen aus den Familien ChatGPT, Claude und Gemini!

- Verwenden Sie ein schnelles, leichtgewichtiges Modell, um Notizen vom Meeting innerhalb einer Aufgabe zusammenzufassen.

- Wechseln Sie zu einem Modell, das stärker auf Schlussfolgerungen setzt, wenn Sie die Kampagnenleistung in Dokumenten, Aufgaben und Dashboards analysieren.

Der eigentliche Clou? Kombinieren Sie die Modellauswahl mit der Verbindung zum Kontext von ClickUp – Aufgaben, Kommentare, Dokumente und Benutzerdefinierte Felder –, damit das Modell nicht nur „intelligent” ist, sondern auch in Ihrer tatsächlichen Arbeitsumgebung funktioniert.

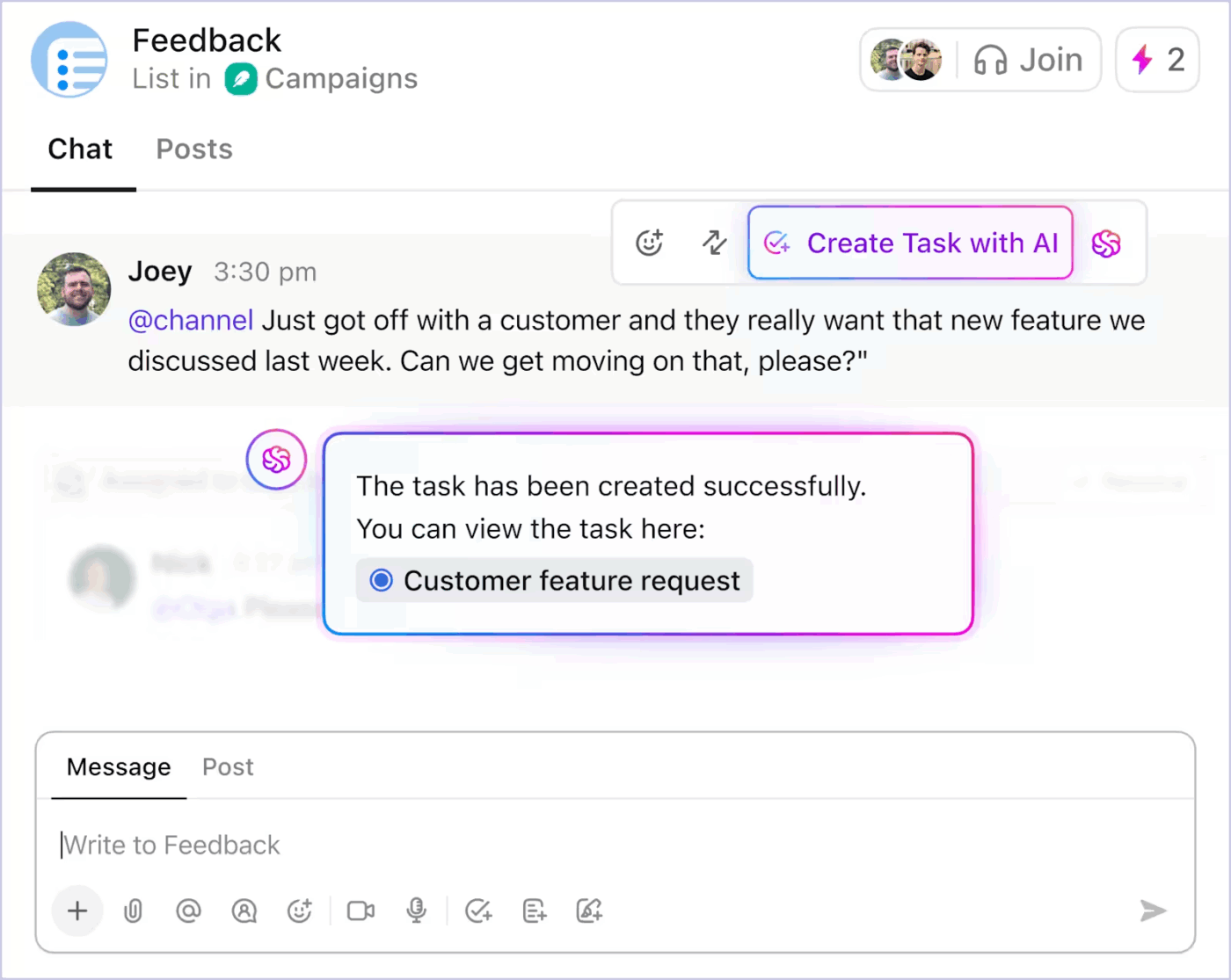

Kontextbezogene Automatisierung von Aufgaben, die den manuellen Aufwand reduziert

Mit KI-gestützten Aufgaben verwandelt ClickUp Kontext in Aktionen. Zu den wichtigsten Features gehören:

- Wandelt Diskussionen aus dem ClickUp-Chat in Aufgaben um

- Generieren Sie Unteraufgaben und Aufgabenbeschreibungen aus einem bestehenden Titel der Aufgabe basierend auf dem Umfang.

- Schlagen Sie nächste Schritte vor, wenn die Arbeit ins Stocken gerät.

- Automatisieren Sie routinemäßige Aktualisierungen anhand des tatsächlichen Projektstatus.

So können Sie die KI-gestützte Automatisierung der Aufgaben in ClickUp nutzen, um Routinearbeiten zu reduzieren 👇

Da die Automatisierung durch Live-Kontext gesteuert wird, verbringen Teams weniger Zeit damit, Absichten in Strukturen zu übersetzen. Die Arbeit schreitet ohne ständige manuelle Eingriffe voran.

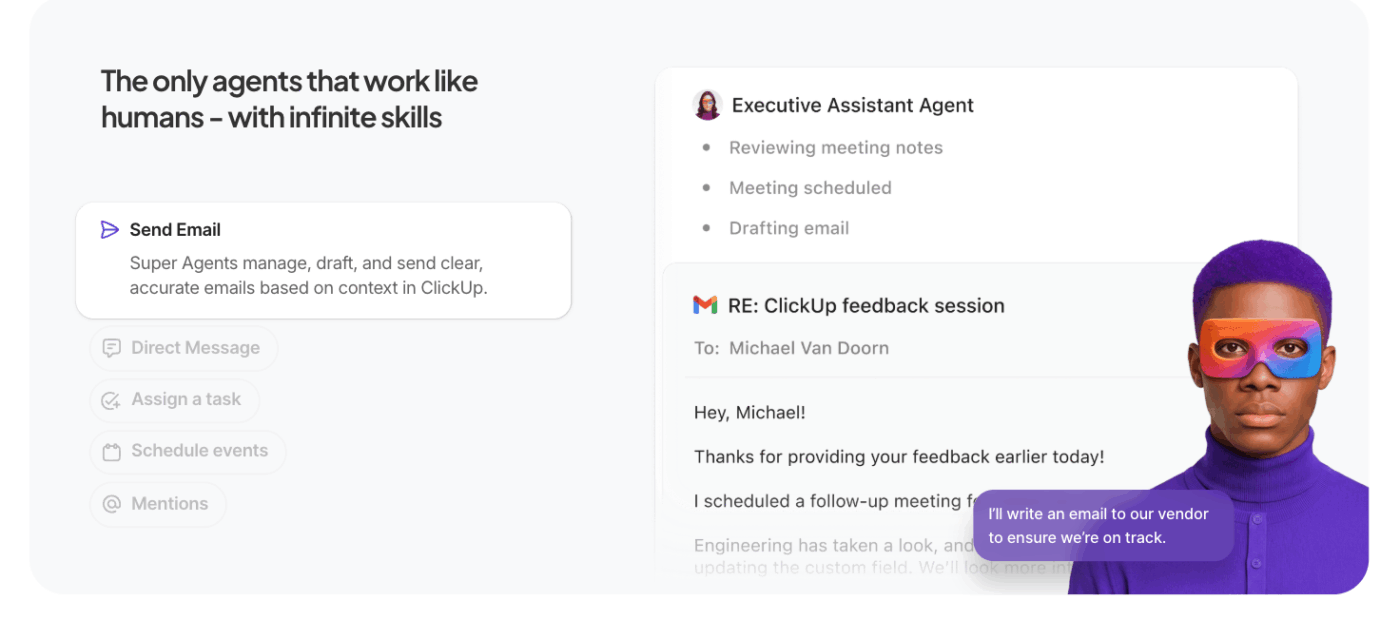

Überlassen Sie die Schwerarbeit den KI-Agenten

ClickUp Super Agents erweitern die kontextbezogene KI von ClickUp über einzelne Abfragen hinaus auf autonome, mehrstufige Ausführungen.

Anstatt auf bestimmte Eingaben zu warten, handeln diese KI-Agenten für die Automatisierung in Ihrem Namen innerhalb des Workspace und bearbeiten Aufgaben, Regeln und Ergebnisse auf der Grundlage des von Ihnen definierten Kontexts und Ihrer Ziele.

Was sie von normalen Agenten unterscheidet:

- Proaktive Aufgabenausführung: Agenten interpretieren den Kontext des Workspaces – Aufgaben, Abhängigkeiten, Zeitleisten – und führen Sequenzen wie Statusaktualisierungen, das Erstellen von Unteraufgaben oder die Benachrichtigung von Eigentümern ohne manuelle Anweisungen aus.

- Zielorientierte Workflows: Sie definieren ein übergeordnetes Ziel (z. B. „Hindernisse in der Q3-Kampagne beseitigen“) und der Agent plant, ruft den Kontext ab und führt Maßnahmen durch, die die Arbeit vorantreiben.

- Persistenter Kontext und Speicher: Agenten behalten ihren Status über mehrere Schritte hinweg bei, sodass sie darüber nachdenken können, was bereits erledigt wurde und was noch zu erledigen ist. Dadurch wird die Genauigkeit verbessert und redundante Arbeit reduziert.

- Integration mit Workspace-Tools: Sie interagieren mit ClickUp Aufgaben, Dokumenten und Kommentaren sowie verbundenen Tools und koordinieren systemübergreifend die Workflows, anstatt Aktionen ohne Kontext vorzuschlagen.

📚 Weiterlesen: Was sind modellbasierte Reflex-Agenten?

Die besten Features von ClickUp

- Bringen Sie KI auf Ihren Desktop und in Ihre verbundenen Apps mit ClickUp Brain MAX: Durchsuchen Sie Ihren Workspace, wandeln Sie Sprache in Text um, wechseln Sie zwischen den besten KI-Modellen und führen Sie Aktionen für Aufgaben, Dokumente und Chats durch, ohne Ihren Flow zu unterbrechen.

- Finden Sie Antworten sofort mit Enterprise Search : Durchsuchen Sie Aufgaben, Dokumente, Kommentare, Dateien und verbundene Tools, damit wichtige Kontexte nie verloren gehen oder isoliert werden.

- Ideen schnell festhalten mit Talk to Text : Diktieren Sie Notizen, Pläne oder Updates und wandeln Sie Sprache in strukturierte Arbeit um, ohne den Fokus zu verlieren oder an Schwung zu verlieren.

- Reduzieren Sie manuelle Arbeit mit ClickUp Dashboards : Lösen Sie Aufgabenaktualisierungen, Zuweisungen und Nachverfolgungen automatisch aus, basierend auf dem tatsächlichen Kontext des Workspaces und Statusänderungen.

- Halten Sie Unterhaltungen mit ClickUp Chat umsetzbar: Besprechen Sie Entscheidungen, Feedback und Genehmigungen direkt neben den Aufgaben, damit die Unterhaltungen mit der Ausführung verknüpft bleiben.

- Ersetzen Sie Meetings durch SyncUps: Freigeben Sie asynchrone Updates, erhalten Sie KI-generierte Zusammenfassungen und halten Sie Teams ohne wiederkehrende Anrufe auf dem Laufenden.

- Teams mit Teams Hub koordinieren: Zeigen Sie Teamaktivitäten, Eigentümerschaft, Prioritäten und Kapazitäten an einem Ort an, um Risiken zu erkennen und die Arbeit frühzeitig neu zu verteilen.

- Planen Sie Ihren Tag mit ClickUp Kalender : Erhalten Sie KI-gestützte Tagespläne auf der Grundlage von Terminen, Prioritäten und Workload, damit Ihre persönlichen Schwerpunkte mit den Team-Zielen übereinstimmen.

Limitierungen von ClickUp

- Die zahlreichen Features und benutzerdefinierten Anpassungsmöglichkeiten können neue Benutzer überfordern.

Preise für ClickUp

ClickUp-Bewertungen und Rezensionen

- G2: 4,7/5 (über 10.585 Bewertungen)

- Capterra: 4,6/5 (über 4.500 Bewertungen)

Was sagen echte Benutzer über ClickUp AI?

Ein ClickUp-Benutzer gibt seine Erfahrungen ebenfalls auf G2 frei:

ClickUp Brain MAX ist eine unglaubliche Bereicherung für meinen Workflow. Durch die Kombination mehrerer LLMs auf einer Plattform sind die Antworten schneller und zuverlässiger, und die Sprach-zu-Text-Funktion auf der gesamten Plattform spart enorm viel Zeit. Ich schätze auch die Sicherheit auf Unternehmensniveau sehr, die mir beim Umgang mit sensiblen Informationen ein beruhigendes Gefühl gibt. […] Am meisten beeindruckt mich, wie es mir hilft, den Überblick zu behalten und klarer zu denken – egal, ob ich Meetings zusammenfasse, Inhalte entwerfe oder neue Ideen brainstorme. Es fühlt sich an, als hätte ich einen All-in-One-KI-Assistenten, der sich an meine Bedürfnisse anpasst.

ClickUp Brain MAX ist eine unglaubliche Bereicherung für meinen Workflow. Durch die Kombination mehrerer LLMs auf einer Plattform sind die Antworten schneller und zuverlässiger, und die Sprach-zu-Text-Funktion auf der gesamten Plattform spart enorm viel Zeit. Ich schätze auch die Sicherheit auf Enterprise-Niveau sehr, die mir beim Umgang mit sensiblen Informationen ein beruhigendes Gefühl gibt. […] Am meisten beeindruckt mich, wie es mir hilft, den Überblick zu behalten und klarer zu denken – egal, ob ich Meetings zusammenfasse, Inhalte entwerfe oder neue Ideen brainstorme. Es fühlt sich an, als hätte ich einen All-in-One-KI-Assistenten, der sich an meine Bedürfnisse anpasst.

Herausforderungen und Überlegungen bei der Arbeit mit KI-Kontext-Engineering

Hier sind die wichtigsten Herausforderungen, die Sie beachten müssen. Der Kontext kann außer Kontrolle geraten, selbst wenn das Modell 1 Million Token-Kontextfenster unterstützt. Hier sind die wichtigsten Herausforderungen, die Sie beachten müssen 👇

Kontextvergiftung

Wenn eine Halluzination oder eine falsche Schlussfolgerung in den Kontext gelangt und wiederholt referenziert wird, behandelt das Modell sie als Tatsache. Dieser vergiftete Kontext kann Workflows in ungültigen Annahmen festhalten, die über einen längeren Zeitraum bestehen bleiben und die Ausgabequalität beeinträchtigen.

Kontext-Ablenkung

Größere Kontexte sind verlockend, aber wenn der Kontext zu groß wird, beginnen die Modelle, sich zu sehr auf die gesammelte Historie zu konzentrieren und das während des Trainings Gelernte zu wenig zu nutzen. Dies kann dazu führen, dass die KI sich in Details aus der Vergangenheit verstrickt, anstatt den nächstbesten Schritt zu synthetisieren.

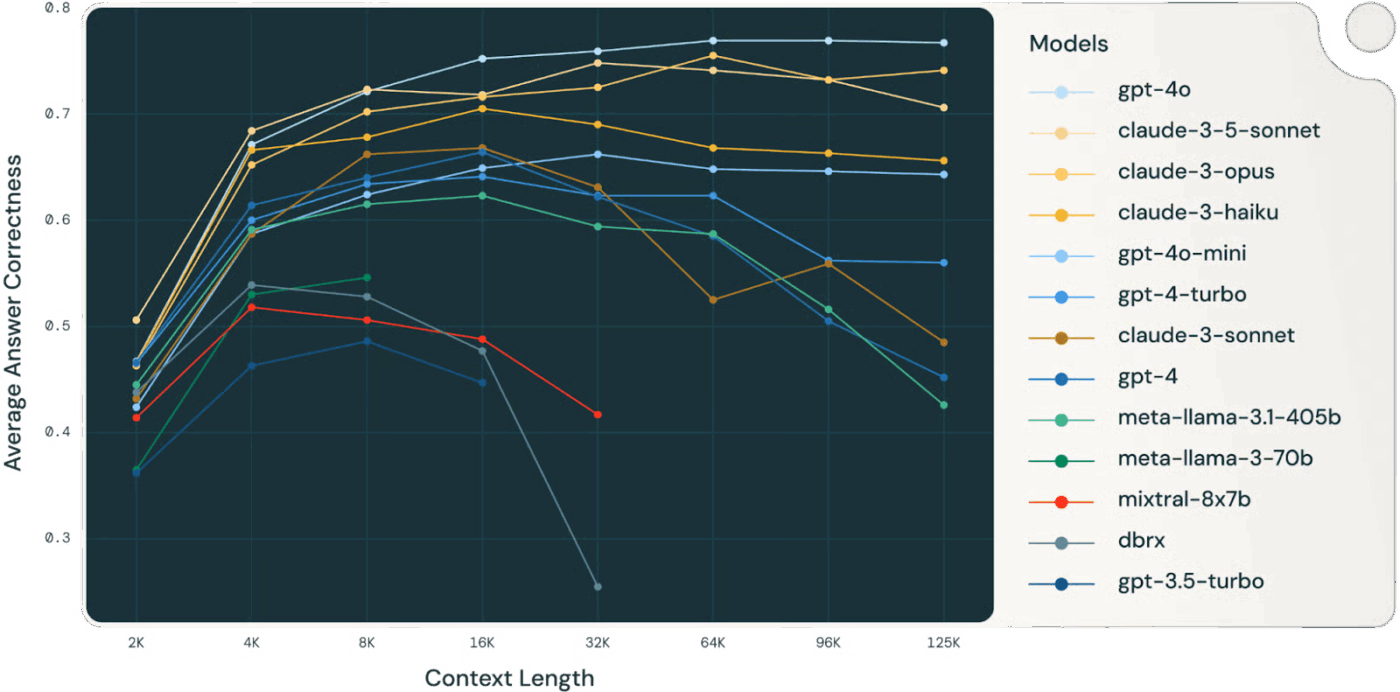

👀 Wussten Sie schon? Eine Studie von Databricks ergab, dass die Modellgenauigkeit für Llama 3. 1 405B bei etwa 32.000 Tokens zu sinken begann, also lange bevor das Kontextfenster voll war. Kleinere Modelle zeigten sogar noch früher eine Verschlechterung.

Modelle verlieren oft schon lange bevor ihnen der Kontext „ausgeht“ an Qualität in ihrer Argumentation, sodass die Auswahl und Komprimierung des Kontexts wertvoller ist als die reine Größe des Kontexts.

📚 Weiterlesen: Was ist die Arbeitsplatzsuche und wie verbessert sie die Produktivität der Mitarbeiter?

Kontextverwirrung

Irrelevante oder wenig aussagekräftige Informationen im Kontext konkurrieren mit wichtigen Daten um Aufmerksamkeit. Wenn das Modell gezwungen ist, jedes Kontext-Token zu verwenden, werden Entscheidungen unübersichtlich und die Genauigkeit leidet – selbst wenn technisch gesehen „mehr“ Informationen vorhanden sind.

Konflikt zwischen Kontexten

Mit zunehmender Informationsmenge können neue Fakten oder Tool-Beschreibungen früheren Inhalten widersprechen. Bei widersprüchlichen Kontexten haben Modelle Schwierigkeiten, konkurrierende Signale in Einklang zu bringen, was zu inkonsistenten oder inkohärenten Ergebnissen führt.

Tool-Überlastung und Auswahlprobleme

Wenn zu viele tool-Definitionen ungefiltert in den Kontext aufgenommen werden, kann das Modell irrelevante tools aufrufen oder suboptimale tools priorisieren. Das selektive Laden nur relevanter tools verringert Verwirrung und verbessert die Entscheidungsqualität.

Komplexität und Wartung

Effektives Kontextmanagement erfordert kontinuierliches Bereinigen, Zusammenfassen, Auslagern und Isolieren von Kontext. Systeme müssen entscheiden, wann sie den Verlauf komprimieren und wann sie neue Informationen abrufen, was eine durchdachte Infrastruktur statt ad hoc-Tricks erfordert.

Disziplin beim Token-Budget

Jedes Token beeinflusst das Verhalten; größere Kontextfenster garantieren keine besseren Ergebnisse. Sie müssen den Kontext als verwaltete Ressource behandeln und dabei Relevanz und Aktualität gegen Token-Kosten und das Aufmerksamkeitsbudget des Modells abwägen.

⚠️ Statistik-Alarm: Fast 60 % der Mitarbeiter geben zu, dass sie bei der Arbeit nicht autorisierte öffentliche KI-Tools verwenden und oft sensible Unternehmensdaten in Plattformen einfügen, die keinerlei Kontrolle unterliegen.

Und es kommt noch schlimmer: 63 % der Unternehmen verfügen über keine KI-Governance-Richtlinien, um diese Schatten-KI-Nutzung zu überwachen, einzuschränken oder gar zu erkennen.

Das Ergebnis? Ihre Daten werden offengelegt, weil niemand überwacht, wie die KI eingesetzt wird.

Die Zukunft des Context Engineering

Dies markiert den Übergang vom Experimentieren zur Skalierung. Der Kontext wird nicht mehr von Menschen verwaltet, sondern durch Code generiert und verwaltet. Er wird zu einer Funktion der Struktur des Systems selbst.

Wir fassen dies anhand des ausgezeichneten Artikels von Serge Liatko in der OpenAI-Entwickler-Community zusammen:

Kontext-Engineering entwickelt sich zur Workflow-Architektur

Kontext-Engineering wird zunehmend einer automatisierten Workflow-Architektur weichen. Die Aufgabe wird sich nicht mehr darauf beschränken, die richtigen Tokens zu liefern.

Effektives Context Engineering umfasst die Orchestrierung ganzer Sequenzen von Argumentationen, tools und Datenflüssen, die sich automatisch an veränderte Anforderungen anpassen.

Das bedeutet, dynamische Systeme zu entwickeln, die den richtigen Kontext innerhalb ganzheitlicher Workflows selbst verwalten.

Automatisierte Automatisierung ersetzt manuelle Eingabeaufforderungen

Die nächste Herausforderung ist eine KI, die sich selbst organisiert. Sie wird Abruf, Tools, Speicher und Geschäftslogik miteinander verbinden, ohne dass Menschen jede Eingabeaufforderung oder jedes Kontextpaket manuell erstellen müssen. Anstatt jede einzelne Datenkomponente explizit bereitzustellen, werden die Systeme anhand von Zielen und Verlaufsdaten ableiten, welcher Kontext relevant ist, und diesen automatisch verwalten.

🧠 Dies geschieht bereits mit ClickUp Super Agents. Sie sind umgebungsbezogene und stets aktive KI-Teamkollegen, die ihnen helfen, Aufgaben genauso wie Menschen zu verstehen und auszuführen. Sie verbessern sich kontinuierlich anhand vergangener Interaktionen, indem sie ihr umfangreiches Gedächtnis nutzen – sie lernen Präferenzen, aktuelle Aktionen und die Projektgeschichte – und können proaktiv Maßnahmen ergreifen, Probleme eskalieren oder Erkenntnisse aufzeigen, ohne auf eine Aufforderung zu warten.

End-to-End-Automatisierung wird zum echten Hebel für die Produktivität

Mit der Weiterentwicklung des Context Engineering lassen sich Produktivitätssteigerungen durch automatisierte Workflows erzielen. LLMs fungieren als Agenten, koordinieren Tools, überwachen den Status und führen mehrstufige Logik aus, ohne dass der Benutzer sich um die Details kümmern muss.

Sie müssen fehlenden Kontext nicht manuell eingeben. Das System kuratiert den Kontext, um das Langzeitgedächtnis und das logische Denken zu unterstützen.

Unified Context verbessert die Leistungsfähigkeit von KI

Die Genauigkeit der KI leidet, wenn der Kontext zwischen Tools, Workflows und Personen fragmentiert ist. Wenn Informationen verstreut sind, müssen die Modelle Vermutungen anstellen.

Konvergierte KI-Workspaces wie ClickUp sind hier besonders gut geeignet, da sie Arbeit, Daten und KI in Ihrer Kontextstrategie vereinen.

Sind Sie bereit, es auszuprobieren? Melden Sie sich kostenlos bei ClickUp an.