Większość zespołów Enterprise badających LLaMA utknie w tym samym miejscu: pobierają wagi modelu, wpatrują się w okno terminala i zdają sobie sprawę, że nie mają pojęcia, co dalej.

Wyzwanie to jest powszechne — chociaż 88% firm wykorzystuje AI w co najmniej jednej funkcji, tylko 7% wdrożyło ją w całej organizacji.

Ten przewodnik przeprowadzi Cię przez zakończony proces, od wyboru odpowiedniego rozmiaru modelu do Twojego zastosowania po dostosowanie go do danych Twojej firmy, dzięki czemu będziesz mógł wdrożyć działające rozwiązanie AI, które faktycznie rozumie kontekst Twojej działalności.

Czym jest LLaMA i dlaczego ma znaczenie dla AI w przedsiębiorstwie?

LLaMA (skrót od Large Language Model Meta AI) to rodzina otwartych modeli językowych stworzonych przez Meta. Ogólnie rzecz biorąc, wykonuje te same podstawowe zadania, co modele takie jak GPT lub Gemini: rozumie język, generuje tekst i potrafi wnioskować na podstawie informacji. Duża różnica polega na tym, w jaki sposób przedsiębiorstwa mogą z niego korzystać.

Ponieważ LLaMA jest rozwiązaniem otwartym, firmy nie są zmuszone do interakcji z nim wyłącznie za pośrednictwem interfejsu API typu „czarna skrzynka”. Mogą uruchamiać go na własnej infrastrukturze, dostosowywać na podstawie danych wewnętrznych oraz kontrolować sposób i miejsce jego wdrożenia.

Dla przedsiębiorstw to ogromna sprawa — zwłaszcza gdy prywatność danych, zgodność z przepisami i przewidywalność kosztów mają większe znaczenie niż nowatorskość.

Ta elastyczność sprawia, że LLaMA jest szczególnie atrakcyjna dla zespołów, które chcą głęboko zintegrować sztuczną inteligencję ze swoimi cyklami pracy, a nie tylko dodać ją jako samodzielnego chatbota. Pomyśl o wewnętrznych asystentach wiedzy, automatyzacji obsługi klienta, narzędziach dla programistów lub funkcjach sztucznej inteligencji wbudowanych bezpośrednio w produkty — bez wysyłania poufnych danych poza organizację.

Krótko mówiąc, LLaMA ma znaczenie dla sztucznej inteligencji w Enterprise, ponieważ daje zespołom wybór w zakresie wdrażania, dostosowywania i integracji sztucznej inteligencji z rzeczywistymi systemami biznesowymi. A ponieważ sztuczna inteligencja przechodzi od etapu eksperymentów do codziennego funkcjonowania, ten poziom kontroli staje się nie tyle „miłym dodatkiem”, co raczej wymogiem.

Jak rozpocząć pracę z LLaMA dla aplikacji Enterprise

1. Zdefiniuj przypadek użycia w Enterprise

Przed pobraniem czegokolwiek należy dokładnie określić cykle pracy, w których AI może mieć realny wpływ. Kluczowe znaczenie ma dopasowanie przypadku użycia AI do rozmiaru modelu — mniejsze modele 8B są wydajne w przypadku prostych zadań, natomiast większe modele 70B+ lepiej sprawdzają się w przypadku złożonych procesów rozumowania.

Aby pomóc Ci zidentyfikować odpowiednie zastosowania AI dla Twojej firmy, obejrzyj ten przegląd praktycznych przypadków użycia AI w różnych funkcjach przedsiębiorstwa i branżach:

Typowe punkty wyjścia to:

- Przetwarzanie dokumentów: Podsumowywanie długich raportów lub wyodrębnianie kluczowych informacji z umów.

- Pomoc w zakresie kodu: generowanie standardowego kodu, wyjaśnianie starszych wersji systemów lub sugerowanie optymalizacji.

- Pobieranie wiedzy: odpowiadanie na pytania pracowników poprzez przeszukiwanie wewnętrznej dokumentacji przy użyciu techniki zwanej Retrieval-Augmented Generation (RAG).

- Tworzenie zawartości: Przygotowywanie wstępnych wersji komunikatów lub tekstów marketingowych.

2. Skonfiguruj wymagania wstępne i zależności

Następnie przygotuj sprzęt i oprogramowanie. Wielkość modelu determinuje Twoje potrzeby; model LLaMA 8B wymaga karty graficznej z około 15 GB pamięci VRAM, natomiast model 70B wymaga 131 GB lub więcej.

Twój zestaw oprogramowania powinien zawierać Python 3. 8+, PyTorch, sterowniki CUDA oraz ekosystem Hugging Face (transformatory, przyspieszenie i bitsandbytes).

3. Uzyskaj dostęp i pobierz wagi modelu LLaMA

Wagi modelu można pobrać z oficjalnej strony Meta poświęconej Llama lub z hubu modeli Hugging Face. Konieczne będzie zaakceptowanie licencji Llama 3 Community License, która zezwala na komercyjne wykorzystanie. W zależności od ustawień należy pobrać wagi w formacie safetensors lub GGUF.

4. Skonfiguruj swoje środowisko programistyczne

Po pobraniu wag nadszedł czas na skonfigurowanie środowiska. Zainstaluj niezbędne biblioteki Python, w tym transformatory, akceleratory i bity i bajty do kwantyzacji — procesu, który zmniejsza zużycie pamięci przez model.

Załaduj model z odpowiednimi ustawieniami i uruchom prostą podpowiedź, aby upewnić się, że wszystko działa poprawnie, zanim przejdziesz do dostosowywania.

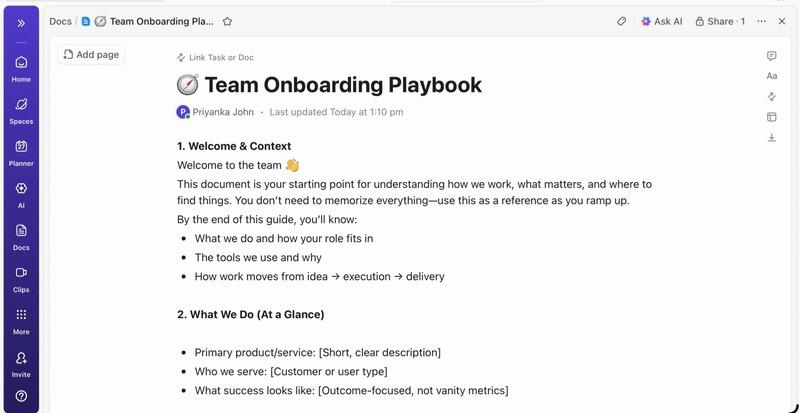

💡Jeśli nie masz dedykowanego zespołu ds. infrastruktury ML, cały ten proces może okazać się niemożliwy do zrealizowania. Dzięki ClickUp Brain możesz całkowicie pominąć złożoność wdrażania. Zapewnia on funkcje AI, takie jak pomoc w pisaniu i automatyzacja zadań, bezpośrednio w obszarze roboczym, w którym już działa Twój zespół — bez konieczności pobierania modeli lub zapewniania procesorów graficznych.

Jak dostosować LLaMA do danych przedsiębiorstwa niestandardowo

Wykorzystanie podstawowego modelu LLaMA to dobry początek, ale nie zrozumie on unikalnych akronimów, nazw projektów ani wewnętrznych procesów Twojej firmy. Prowadzi to do generycznych, nieprzydatnych odpowiedzi, które nie rozwiązują rzeczywistych problemów biznesowych.

Sztuczna inteligencja dla Enterprise staje się użyteczna dzięki niestandardowemu dostosowaniu — szkoleniu modelu w oparciu o konkretną terminologię i bazę wiedzy.

Przygotuj dane szkoleniowe specyficzne dla danej dziedziny.

Powodzenie niestandardowej AI zależy bardziej od jakości danych szkoleniowych niż od rozmiaru modelu lub mocy obliczeniowej. Zacznij od zebrania i oczyszczenia informacji wewnętrznych.

- Dokumentacja wewnętrzna: zbieraj specyfikacje produktów, przewodniki dotyczące procesów i dokumenty dotyczące zasad.

- Komunikacja historyczna: zbieraj szablony wiadomości e-mail, odpowiedzi na zgłoszenia do wsparcia technicznego i podsumowania spotkań.

- Terminologia domeny: kompilacja glosariuszy, definicji akronimów i języka specyficznego dla branży.

Po zebraniu informacji sformatuj je w pary instrukcja-odpowiedź w celu nadzorowanego dostosowania. Na przykład instrukcja może brzmieć „Podsumuj ten bilet pomocy technicznej”, a odpowiedzią będzie przejrzyste, zwięzłe podsumowanie. Ten krok ma kluczowe znaczenie dla nauczenia modelu wykonywania określonych zadań na podstawie danych.

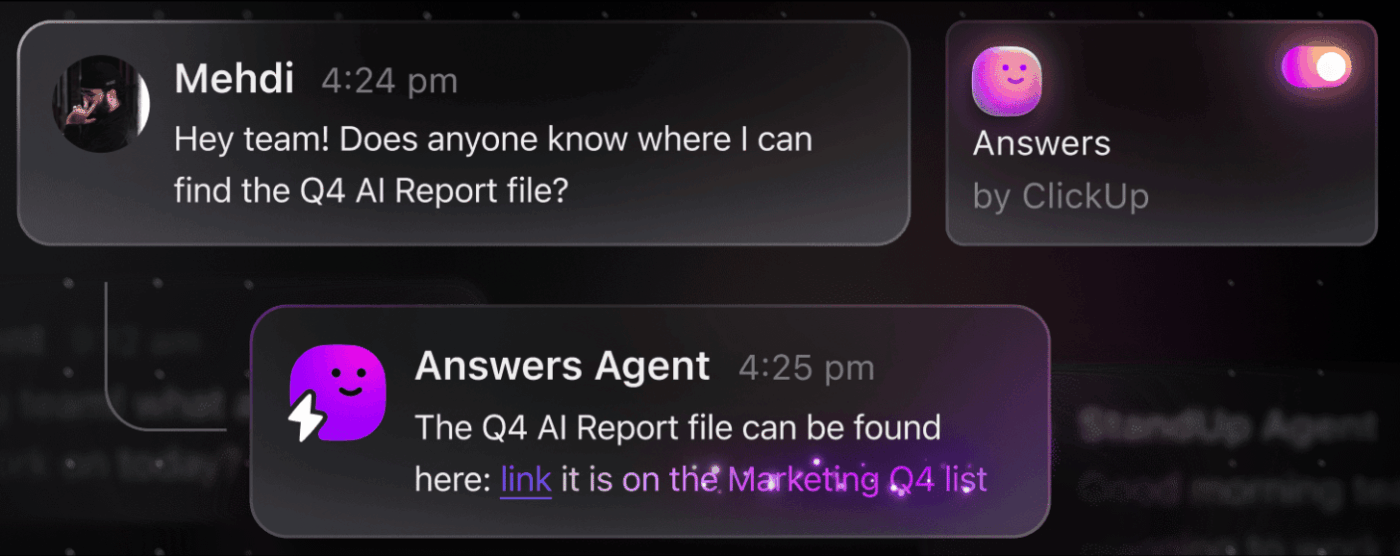

📮 ClickUp Insight: Przeciętny profesjonalista spędza ponad 30 minut dziennie na wyszukiwaniu informacji związanych z pracą — to ponad 120 godzin rocznie straconych na przeszukiwanie wiadomości e-mail, wątków na Slacku i rozproszonych plików. Inteligentny asystent AI wbudowany w Twój obszar roboczy może to zmienić.

Wprowadź ClickUp Brain. Zapewnia natychmiastowe wgląd i odpowiedzi, wyświetlając odpowiednie dokumenty, rozmowy i szczegóły zadań w ciągu kilku sekund — dzięki czemu możesz przestać szukać i zacząć pracować.

💫 Rzeczywiste wyniki: zespoły takie jak QubicaAMF odzyskały ponad 5 godzin tygodniowo dzięki ClickUp — to ponad 250 godzin rocznie na osobę — eliminując przestarzałe procesy zarządzania wiedzą. Wyobraź sobie, co Twój zespół mógłby osiągnąć, mając dodatkowy tydzień wydajności w każdym kwartale!

Dostosuj LLaMA do kontekstu swojej działalności biznesowej

Dostosowywanie to proces dostosowywania istniejącej wiedzy LLaMA do konkretnego przypadku użycia, co znacznie poprawia jej dokładność w zadaniach związanych z konkretną dziedziną. Zamiast szkolić model od podstaw, można skorzystać z metod efektywnych pod względem parametrów, które aktualizują tylko niewielki podzbiór parametrów modelu, oszczędzając czas i zasoby obliczeniowe.

Popularne metody dostosowywania obejmują:

- LoRA (Low-Rank Adaptation): metoda ta polega na szkoleniu małych matryc „adapterów” zamiast całego modelu, co zapewnia wysoką wydajność.

- QLoRA: Łączy LoRA z kwantyzacją, umożliwiając dostosowywanie na pojedynczym procesorze graficznym o pojemności 48 GB, zapewniając jednocześnie pełną wydajność dostosowywania.

- Pełne dostosowanie: aktualizuje wszystkie parametry modelu, oferując najwyższy poziom personalizacji niestandardowej, ale wymagając znacznej mocy obliczeniowej.

📚 Przeczytaj również: Narzędzia generatywnej AI dla przedsiębiorstw zmieniające sposób pracy

Ocena i iteracja wydajności modelu

Skąd wiadomo, czy niestandardowy model faktycznie działa? Ocena AI musi wykraczać poza proste wyniki dokładności i mierzyć rzeczywistą użyteczność. Twórz zestawy danych do oceny, które odzwierciedlają przypadki użycia w produkcji, i śledź wskaźniki istotne dla Twojej firmy, takie jak jakość odpowiedzi, dokładność faktograficzna i opóźnienia.

- Ocena jakościowa: Poproś recenzentów o ocenę wyników pod kątem tonu, przydatności i poprawności.

- Wskaźniki ilościowe: wykorzystaj automatyczne oceny, takie jak BLEU lub perplexity, aby prowadzić śledzenie wydajności na dużą skalę.

- Monitorowanie produkcji: po wdrożeniu śledź opinie użytkowników i wskaźniki błędów, aby zidentyfikować obszary wymagające poprawy.

💡Ten iteracyjny proces szkolenia i oceny może stać się projektem samym w sobie. Zarządzaj cyklem rozwoju AI bezpośrednio w ClickUp, zamiast gubić się w arkuszach kalkulacyjnych.

Scentralizuj wskaźniki wydajności i wyniki oceny w jednym widoku dzięki pulpitom nawigacyjnym ClickUp. Śledź wersje modeli, parametry szkolenia i wyniki oceny wraz z innymi pracami nad produktem za pomocą pól niestandardowych ClickUp, dzięki czemu wszystko będzie uporządkowane i widoczne. 🛠️

Najważniejsze zastosowania LLaMA w Enterprise

Zespoły często popadają w paraliż analityczny, nie potrafiąc przejść od abstrakcyjnego entuzjazmu związanego z AI do konkretnych zastosowań. Elastyczność LLaMA sprawia, że nadaje się on do szerokiego zakresu cykli pracy w Enterprise, pomagając w automatyzacji zadań i zwiększeniu wydajności pracy.

Oto kilka najlepszych przykładów zastosowań niestandardowego modelu LLaMA:

- Wewnętrzni asystenci wiedzy: przestań tracić czas na szukanie informacji. Wdroż LLaMA z RAG, aby stworzyć chatbota, który może natychmiast odpowiadać na pytania pracowników, przeszukując wewnętrzne wiki, dokumenty dotyczące zasad i komunikację z poprzednich projektów.

- Automatyzacja obsługi klienta: dostosuj model na podstawie historii zgłoszeń, aby automatycznie tworzyć odpowiedzi, kategoryzować zapytania i eskalować złożone problemy do odpowiedniego pracownika.

- Generowanie i przegląd kodu: pomóż zespołowi inżynierów pracować wydajniej. Użyj LLaMA do generowania standardowego kodu, wyjaśniania złożonych starszych wersji systemów, a nawet identyfikowania potencjalnych błędów w pull requestach, zanim staną się problemem.

- Przetwarzanie dokumentów: zamień duże ilości tekstu w użyteczne informacje. Podsumowuj długie raporty, wyodrębniaj kluczowe terminy z umów prawnych lub generuj zwięzłe notatki ze spotkań na podstawie surowych transkrypcji w ciągu kilku sekund.

- Cykl pracy nad zawartością: Pokonaj blok twórczy. Twórz projekty tekstów marketingowych, opisów produktów i ogłoszeń wewnętrznych, które następnie redaktorzy mogą dopracować i udoskonalić.

💡Dostęp do wielu z tych przypadków użycia od razu po uruchomieniu dzięki ClickUp Brain.

- Podsumowuj wątki zadań, twórz szkice aktualizacji projektów i generuj zawartość dzięki wspomaganej AI funkcji pisania ClickUp.

- Znajdź odpowiedzi z całego obszaru roboczego natychmiast dzięki funkcji wyszukiwania w Enterprise ClickUp i gotowemu agentowi Ambient Answers.

- Twórz inteligentne cykle pracy, które zajmą się rutynowymi zadaniami za Ciebie dzięki ClickUp automatyzacji.

Ograniczenia korzystania z LLaMA w AI dla przedsiębiorstw

Chociaż samodzielne hostowanie LLaMA zapewnia znaczną kontrolę, nie jest to pozbawione wyzwań. Teams często nie doceniają nakładów operacyjnych, angażując się w konserwację zamiast w innowacje. Przed podjęciem decyzji o „budowie” należy koniecznie zrozumieć potencjalne przeszkody.

Oto kilka kluczowych limitów, które należy wziąć pod uwagę:

- Wymagania infrastrukturalne: Uruchamianie dużych modeli jest kosztowne i wymaga wydajnych procesorów graficznych klasy Enterprise, których wiele organizacji nie posiada.

- Wymagana wiedza techniczna: Wdrożenie, dostosowanie i utrzymanie dużego modelu językowego wymaga specjalistycznych umiejętności inżynierii ML, na które istnieje duże zapotrzebowanie.

- Ciągłe obciążenie związane z konserwacją: nie jest to rozwiązanie typu „ustaw i zapomnij”. Modele wymagają ciągłego monitorowania, aktualizacji zabezpieczeń i ponownego szkolenia w miarę rozwoju Businessu.

- Ryzyko halucynacji: Podobnie jak wszystkie modele LLM, LLaMA może czasami generować informacje, które brzmią wiarygodnie, ale są nieprawidłowe. Aplikacje dla Enterprise wymagają solidnych zabezpieczeń i nadzoru ludzkiego, aby ograniczyć to ryzyko.

- Brak wbudowanych funkcji dla Enterprise: kluczowe funkcje, takie jak kontrola dostępu, rejestrowanie audytowe i narzędzia zapewniające zgodność z przepisami, muszą być tworzone i zarządzane oddzielnie, co dodatkowo zwiększa złożoność systemu.

💡Możesz ominąć te ograniczenia, korzystając z ClickUp Brain. Zapewnia on zarządzaną sztuczną inteligencję w ramach istniejącego obszaru roboczego, dając Ci możliwości sztucznej inteligencji dla przedsiębiorstw bez dodatkowych kosztów operacyjnych. Zyskaj bezpieczeństwo na poziomie przedsiębiorstwa i wyeliminuj konieczność utrzymania infrastruktury dzięki ClickUp, dzięki czemu Twój zespół będzie mógł skupić się na swojej podstawowej pracy.

📮ClickUp Insight: 88% respondentów naszej ankiety korzysta ze sztucznej inteligencji do zadań osobistych, ale ponad 50% unika jej stosowania w pracy. Trzy główne przeszkody? Brak płynnej integracji, braki w wiedzy lub obawy dotyczące bezpieczeństwa.

A co, jeśli sztuczna inteligencja jest wbudowana w Twoje środowisko pracy i jest już bezpieczna? ClickUp Brain, wbudowany asystent AI ClickUp, sprawia, że staje się to rzeczywistością. Rozumie podpowiedzi w prostym języku, rozwiązując wszystkie trzy problemy związane z wdrażaniem sztucznej inteligencji, jednocześnie zapewniając połączenie między czatem, zadaniami, dokumentami i wiedzą w całym obszarze roboczym. Znajdź odpowiedzi i spostrzeżenia za pomocą jednego kliknięcia!

Alternatywne narzędzia AI do zastosowań w Enterprise

Wybór odpowiedniego narzędzia AI spośród wielu dostępnych opcji stanowi wyzwanie dla każdego zespołu. Próbujesz rozważyć zalety i wady różnych modeli, ale obawiasz się, że wybierzesz niewłaściwy i zmarnujesz zasoby.

Często prowadzi to do rozrostu AI — nieplanowanego rozprzestrzeniania się narzędzi AI i platform AI bez nadzoru i strategii — gdzie Teams subskrybują wiele niepowiązanych ze sobą usług, co powoduje więcej pracy zamiast jej zmniejszenia.

Oto krótkie zestawienie głównych graczy i ich pozycji na rynku:

| Narzędzie | Najlepsze dla | Kluczowe kwestie |

|---|---|---|

| LLaMA (samodzielnie hostowana) | Maksymalna kontrola, suwerenność danych | Wymaga infrastruktury ML i wiedzy specjalistycznej. |

| OpenAI GPT-4 | Najwyższa wydajność, minimalne ustawienia | Dane opuszczają Twoje środowisko, ceny oparte na wykorzystaniu |

| Claude (Anthropic) | Zadania wymagające długiego kontekstu, nacisk na bezpieczeństwo | Podobne kompromisy jak w przypadku GPT-4 |

| Mistral | Rezydencja danych w Europie, wydajność | Mniejszy ekosystem niż LLaMA |

| ClickUp Brain | Zintegrowana AI w obszarze roboczym, bez wdrażania | Najlepsze rozwiązanie dla zespołów, które chcą wdrożyć AI w istniejących cyklach pracy. |

Zamiast tworzyć połączenia między wieloma narzędziami, aby zaspokoić swoje potrzeby, dlaczego nie skorzystać z AI wbudowanej bezpośrednio w miejsce, w którym pracujesz? Jest to sedno oferty ClickUp jako pierwszego na świecie zintegrowanego obszaru roboczego AI — pojedynczej, bezpiecznej platformy, na której znajdują się projekty, dokumenty, rozmowy i analizy.

Ujednolica narzędzia, eliminując rozproszenie kontekstu, czyli fragmentację, która występuje, gdy zespoły tracą godziny na przełączanie się między aplikacjami i wyszukiwanie informacji potrzebnych do zrobienia swojej pracy.

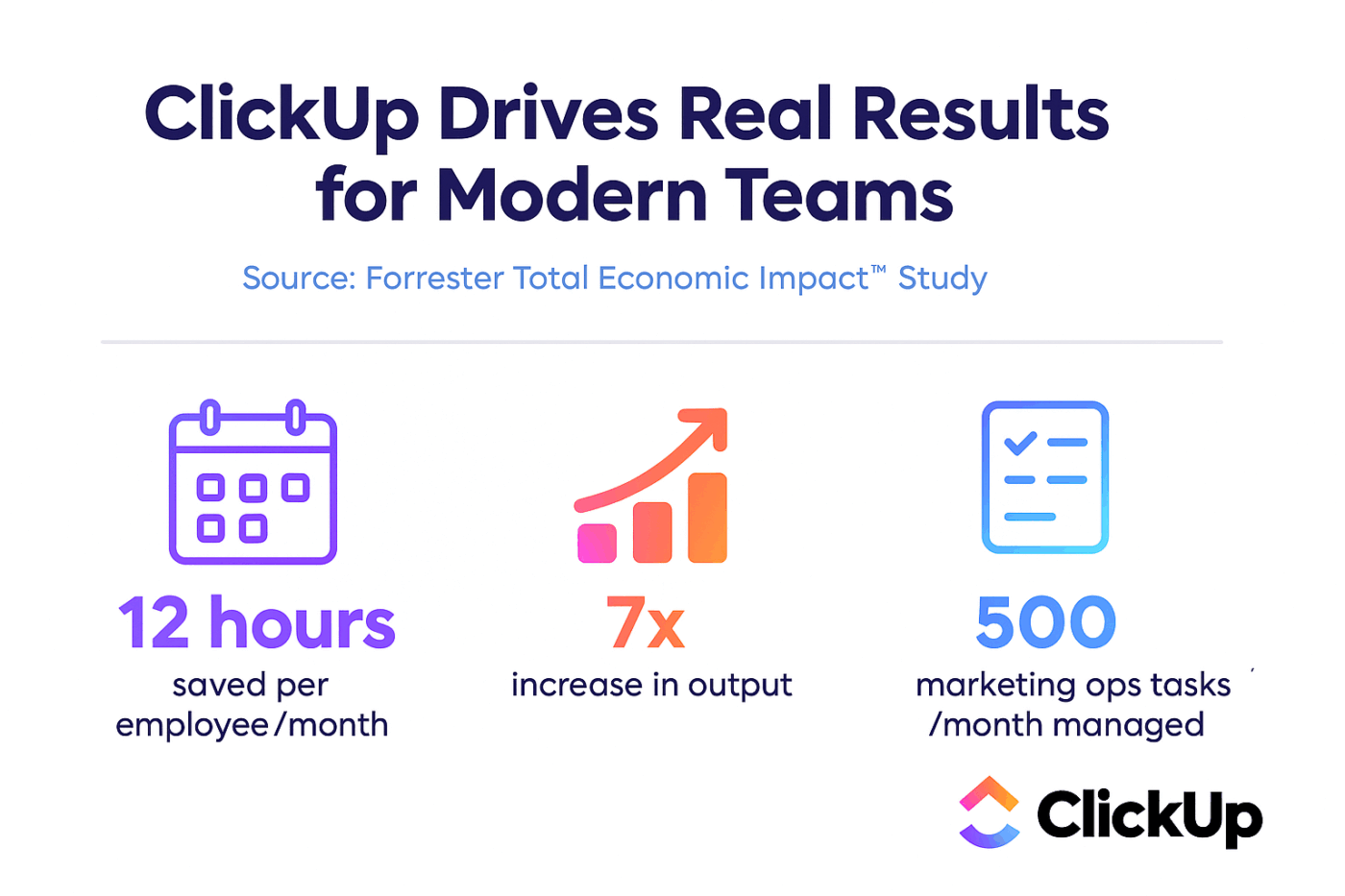

ClickUp + kontekstowa sztuczna inteligencja = wymierna transformacja

Według badania Forrester Economic Impact™ zespoły korzystające z ClickUp osiągnęły 384% zwrotu z inwestycji i zaoszczędziły 92 400 godzin w ciągu trzech lat.

Kiedy kontekst, cykle pracy i inteligencja znajdują się w jednym miejscu, Teams nie tylko pracują. Osiągają sukcesy.

ClickUp zapewnia również funkcje bezpieczeństwa i administracji wymagane w przypadku wdrożeń korporacyjnych, takie jak zgodność z SOC 2 Type II, integracja SSO, provisioning SCIM oraz szczegółowe kontrole uprawnień.

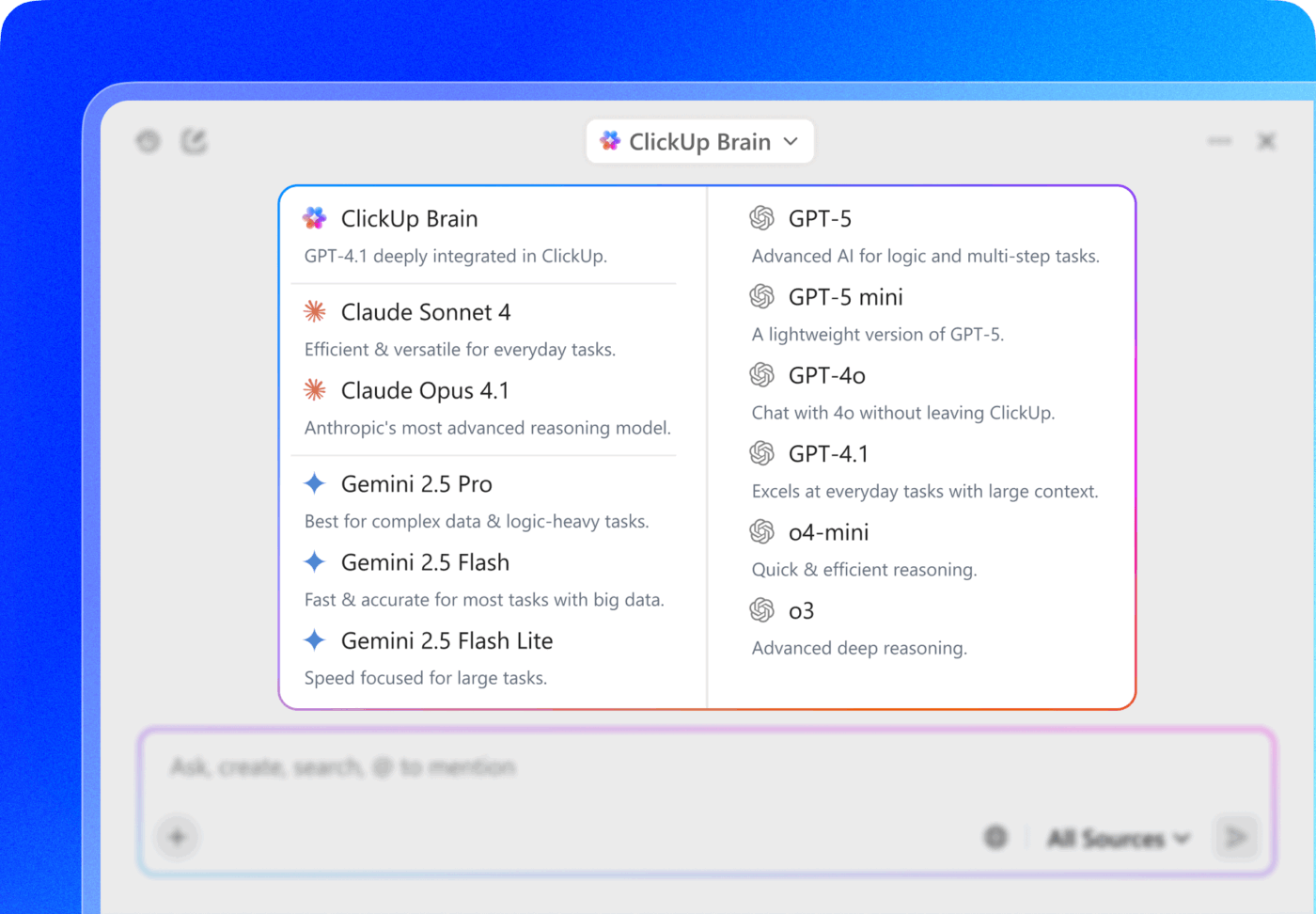

Dostęp do wielu modeli LLM w ClickUp Brain MAX pozwala wybierać spośród modeli premium, takich jak ChatGPT, Claude i Gemini, bezpośrednio z interfejsu wyszukiwania. Platforma automatycznie kieruje zapytanie do najlepszego modelu do danego zadania, dzięki czemu otrzymujesz to, co najlepsze, bez konieczności zarządzania wieloma subskrypcjami.

Zamiast budować warstwę AI od podstaw za pomocą LLaMA, skorzystaj z ClickUp, aby uzyskać cały zestaw funkcji — możliwości AI, zarządzanie projektami, dokumentację i komunikację — w jednym miejscu.

Rozwijaj się dzięki Enterprise AI z ClickUp

LLaMA daje zespołom przedsiębiorstw otwartą alternatywę dla zamkniętych interfejsów API AI, oferując znaczną kontrolę, przewidywalność kosztów i możliwość niestandardowego dostosowania. Jednak powodzenie zależy nie tylko od technologii. Wymaga dopasowania odpowiedniego modelu do konkretnego przypadku użycia, inwestycji w wysokiej jakości dane szkoleniowe oraz stworzenia solidnych procesów oceny.

Decyzja „budować czy kupować” ostatecznie zależy od możliwości technicznych Twojego zespołu. Chociaż tworzenie niestandardowego rozwiązania zapewnia maksymalną elastyczność, wiąże się również ze znacznymi kosztami. Prawdziwym wyzwaniem nie jest tylko dostęp do AI, ale jej integracja z codziennymi cyklami pracy bez tworzenia dodatkowych silosów danych i rozrostu AI.

Wprowadź możliwości LLM bezpośrednio do zarządzania projektami, dokumentacji i komunikacji zespołowej dzięki ClickUp Brain — bez konieczności tworzenia i utrzymywania skomplikowanej infrastruktury. Zacznij korzystać z ClickUp za darmo i wprowadź możliwości AI bezpośrednio do istniejących cykli pracy. 🙌

Często zadawane pytania (FAQ)

Tak, licencja społecznościowa Llama 3 zezwala na komercyjne wykorzystanie przez większość organizacji. Tylko firmy mające ponad 700 milionów aktywnych użytkowników miesięcznie muszą uzyskać oddzielną licencję od Meta.

LLaMA zapewnia większą kontrolę nad danymi i przewidywalne koszty dzięki samodzielnemu hostowaniu, podczas gdy GPT-4 oferuje wyższą wydajność od razu po uruchomieniu i wymaga mniej ustawień. Aby zwiększyć wydajność, skorzystaj z pomocy AI bez konieczności zarządzania modelami bazowymi dzięki zintegrowanym narzędziom, takim jak ClickUp Brain.

Samodzielne hostowanie LLaMA pozwala przechowywać dane w Twojej infrastrukturze, co jest doskonałym rozwiązaniem pod względem lokalizacji danych. Jednakże, jesteś odpowiedzialny za wdrożenie własnych kontroli dostępu, dzienników audytowych i filtrów zawartości — funkcji bezpieczeństwa, które są zazwyczaj zawarte w zarządzanych usługach AI.

Wdrożenie i dostosowanie LLaMA wymaga znacznych umiejętności inżynierii ML. Zespoły, które nie mają takiej wiedzy, mogą uzyskać dostęp do funkcji opartych na LLaMA za pośrednictwem zarządzanych platform, takich jak ClickUp Brain, które zapewniają funkcje AI bez konieczności wdrażania modeli lub konfiguracji technicznej.