GitHub Copilot è in grado di generare centinaia di casi di test in pochi minuti (esperimenti controllati dimostrano che gli sviluppatori finiscono il 35% più velocemente ), ma c'è un inconveniente: questi test generati dall'IA sono utili solo nella misura in cui sei in grado di effettuare il monitoraggio, l'organizzazione e la connessione con il resto del tuo flusso di lavoro di sviluppo.

Questa guida ti illustra come utilizzare GitHub Copilot per creare rapidamente casi di test, quindi ti mostra come gestirli in modo efficace affinché non diventino solo un altro mucchio di file di codice orfani.

Perché i test unitari sono importanti per la qualità del software

Scrivere test unitari è spesso considerato un compito noioso, ma saltarli porta a un codice fragile.

Quando non si dispone di una rete di sicurezza costituita dai test, una piccola rifattorizzazione può introdurre difetti di regressione, ovvero bug che compromettono le funzioni esistenti e minano la fiducia degli utenti. Una ricerca IBM dimostra che i difetti scoperti dopo il rilascio costano 15 volte di più da correggere.

Questo crea un ciclo in cui gli sviluppatori evitano di migliorare il codice per paura di causare malfunzionamenti, con conseguente aumento del debito tecnico.

La generazione di test assistita dall'IA aiuta a rompere questo ciclo: l'89% delle organizzazioni sta attualmente sperimentando o implementando flussi di lavoro generativi basati sull'IA nell'ambito dell'ingegneria della qualità e dei test. Utilizzando uno strumento come GitHub Copilot per creare schemi di casi di test, puoi concentrarti su ciò che conta davvero: progettare test significativi e perfezionare la copertura dei casi limite.

Ecco perché i test unitari costanti sono vantaggiosi:

- Prevenzione della regressione: dei buoni test fungono da barriera di protezione, assicurando che le nuove funzionalità/funzioni o le correzioni di bug non danneggino involontariamente qualcos'altro.

- Documentazione vivente: a differenza della documentazione statica che può diventare obsoleta, i test unitari fungono da esempi eseguibili di come dovrebbe comportarsi il tuo codice.

- Fiducia nel refactoring: quando si dispone di una copertura di test completa, è possibile rifattorizzare e migliorare il codice con la certezza di sapere immediatamente se una modifica ha conseguenze indesiderate.

Per comprendere meglio come gli agenti IA stanno trasformando il panorama della codifica oltre la semplice generazione di test, guarda questa panoramica degli assistenti di codifica basati sull'IA e delle loro capacità:

Come impostare GitHub Copilot per la generazione di casi di test

Prima di poter iniziare a generare test, è necessario installare e configurare GitHub Copilot nel proprio ambiente di sviluppo integrato (IDE). La configurazione è semplice e richiede solo pochi minuti, ma farlo correttamente garantisce che Copilot disponga del contesto necessario per fornire suggerimenti pertinenti.

Prima di iniziare, avrai bisogno di alcune cose:

- Una sottoscrizione attiva a GitHub Copilot (Individual, Business o Enterprise)

- Un IDE con supporto, come VS Code, un IDE JetBrains (come IntelliJ o PyCharm) o Neovim.

- Un framework di test come pytest, Jest o JUnit già installato nel tuo progetto

Installa l'estensione GitHub Copilot

Per prima cosa, devi installare l'estensione Copilot nel tuo IDE. Questo processo è simile nella maggior parte degli editor supportati.

- Apri il marketplace delle estensioni del tuo IDE. In VS Code, si tratta dell'icona Estensioni nella barra laterale; negli IDE JetBrains, la troverai nelle impostazioni → Plugin.

- Cerca "GitHub Copilot"

- Installa sia l'estensione principale GitHub Copilot che l'estensione GitHub Copilot Chat per un'esperienza completa.

- Ti verrà richiesto di riavviare l'IDE per completare l'installazione.

Dopo il riavvio, ti verrà chiesto di accedere con il tuo account GitHub. Questo passaggio effettua l'autenticazione della tua sottoscrizione. Una volta effettuato l'accesso, dovresti vedere una piccola icona Copilot nella barra di stato del tuo IDE, a conferma che è attivo e pronto all'uso.

Configura il tuo framework di test

GitHub Copilot genera test più pertinenti quando comprende la configurazione di test specifica del tuo progetto. Lo fa analizzando i file di test e la configurazione esistenti per apprendere e adattarsi ai modelli del tuo team.

- Per i progetti Python che utilizzano pytest: assicurati di avere pytest installato (pip install pytest). Se hai un file conftest.py o qualsiasi file di test esistente (anche uno solo), Copilot li utilizzerà come riferimento per generare nuovi test.

- Per i progetti JavaScript/TypeScript che utilizzano Jest: Copilot cercherà un file jest. config. js e la tua dipendenza Jest nel tuo package. json per comprendere la tua configurazione.

- Per i progetti Java che utilizzano JUnit: assicurati che le dipendenze JUnit siano definite correttamente nel file pom.xml (per Maven) o build.gradle (per Gradle).

Avere almeno un file di test ben scritto nel tuo progetto è uno dei modi migliori per guidare Copilot. Copilot rileverà le tue convenzioni di denominazione, gli stili di asserzione e il modo in cui strutturi i tuoi test, portando a risultati più coerenti.

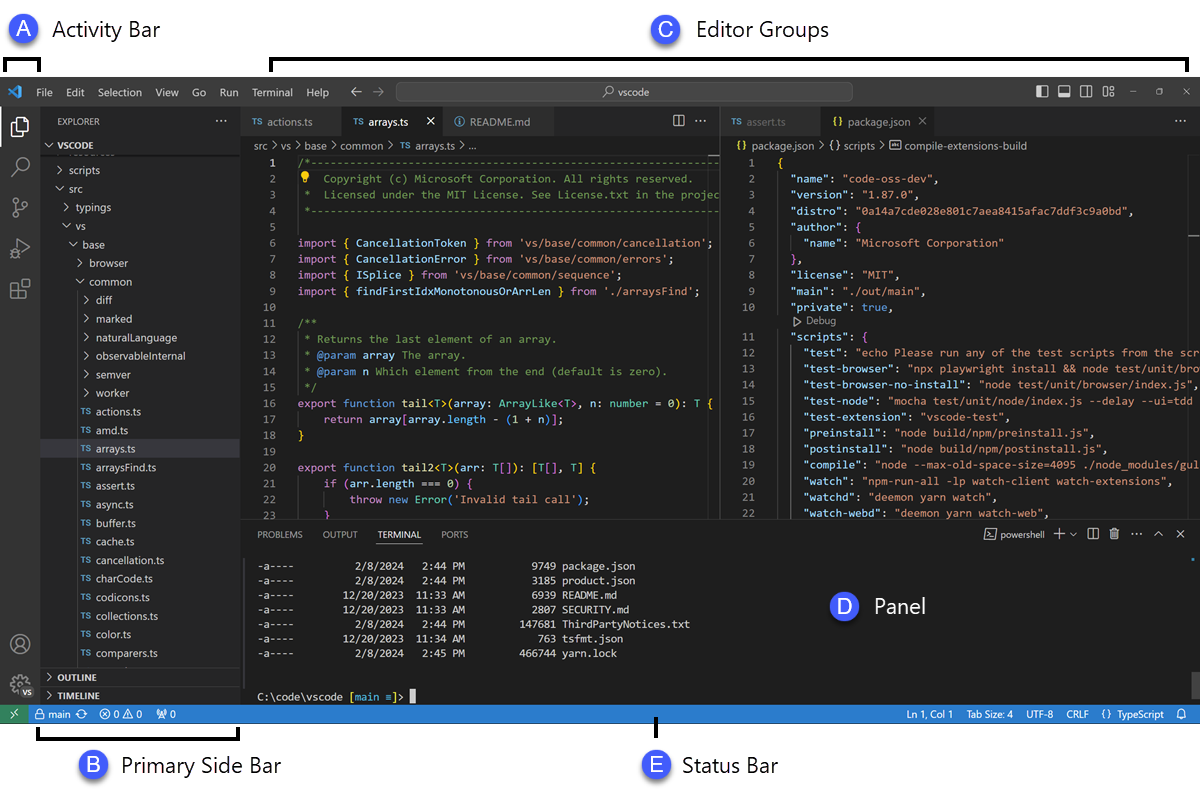

Integra Copilot con il tuo IDE

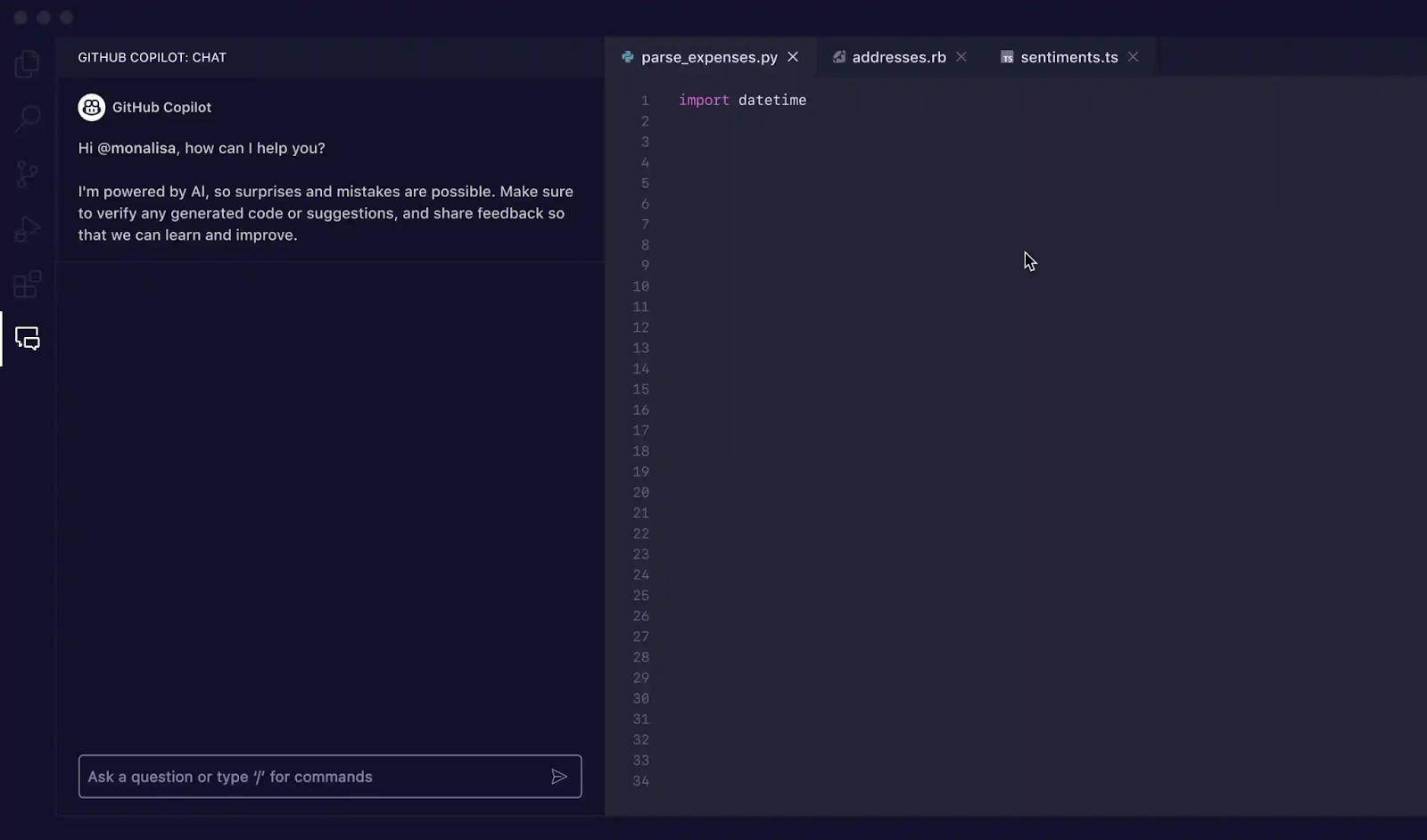

Una volta installate le estensioni, è il momento di familiarizzare con l'interfaccia di Copilot nel tuo IDE. Il modo principale per interagire con esso per la generazione dei test è attraverso il pannello Copilot Chat.

Puoi aprire la finestra di chat con la scorciatoia da tastiera Ctrl+Cmd+I (su Mac) o Ctrl+Alt+I (su Windows/Linux), oppure facendo clic sull'icona Copilot Chat nella barra delle attività del tuo IDE. Questo pannello di chat è il tuo Centro di comando per la generazione dei test.

Copilot è sensibile al contesto, il che significa che legge i file attualmente aperti, la struttura dei file del progetto e qualsiasi codice selezionato. Per ottenere i migliori risultati, assicurati che il file contenente la funzione o la classe che desideri testare sia sempre aperto e con visibilità nell'editor.

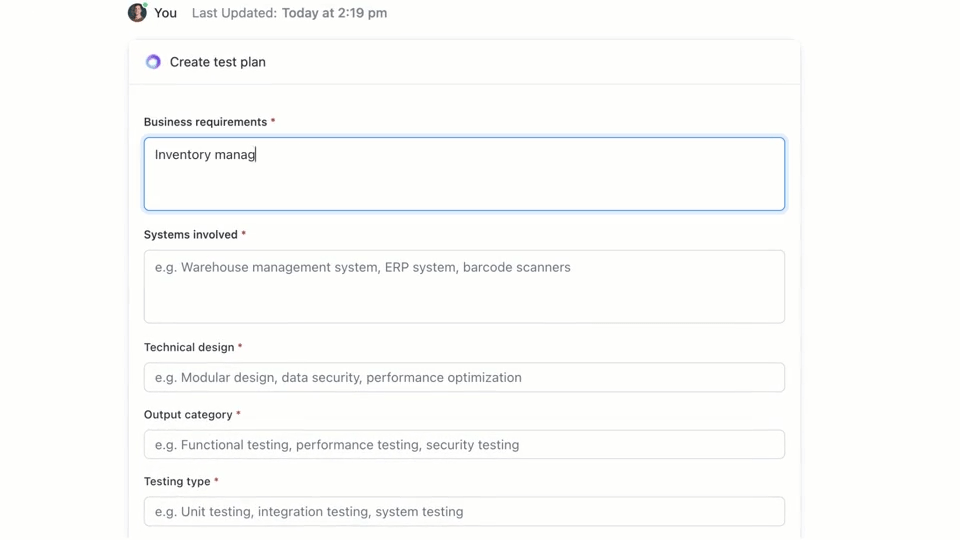

🌟 ClickUp Brain, l'IA contestuale integrata in ClickUp, può creare rapidamente un piano di test per te. Provalo oggi stesso.

Come scrivere casi di test con GitHub Copilot

GitHub Copilot offre tre modi principali per generare casi di test: utilizzando il pannello di chat con prompt dettagliati, utilizzando comandi slash e utilizzando azioni intelligenti direttamente nell'editor. Ogni metodo è adatto a situazioni diverse all'interno del flusso di lavoro di sviluppo, a seconda che sia necessaria velocità o un controllo più accurato.

Utilizza i prompt di Copilot Chat

L'utilizzo di Copilot Chat con un prompt specifico è il metodo più efficace per la generazione di casi di test. È ideale per funzioni o classi complesse in cui è necessario definire scenari specifici, simulare dipendenze o gestire casi limite difficili.

Ecco il flusso di lavoro di base:

- Apri il pannello Copilot Chat

- Nel tuo editor, evidenzia la funzione, la classe o il blocco di codice che desideri testare.

- Scrivi un prompt chiaro e specifico nel pannello della chat descrivendo i test di cui hai bisogno.

Ad esempio, potresti scrivere prompt come:

- "Scrivi test unitari per la funzione selezionata coprendo il percorso ottimale, i casi limite come gli input vuoti e la gestione degli errori per i dati non validi".

- "Genera test pytest per questa classe e crea fixture per simulare la connessione al database".

- "Crea test Jest per questo componente React che simulano i clic degli utenti e verificano i cambiamenti di stato".

Più dettagli fornisci nel tuo prompt, migliori saranno i test generati.

Utilizza comandi slash come /tests

Quando hai bisogno di generare test rapidamente e non richiedi scenari altamente specifici, il comando slash /tests è il tuo migliore amico. È il modo più veloce per ottenere una solida base di copertura dei test.

Per utilizzarlo:

- Apri il pannello Copilot Chat

- Seleziona il codice che desideri testare nel tuo editor

- Nella finestra di chat, digita semplicemente /tests e premi Invio.

Copilot genererà immediatamente una serie di test unitari basati sulla struttura e sulla logica del codice selezionato. Cercherà di coprire le funzionalità principali e alcuni input comuni. Se i risultati non sono del tutto corretti, è sempre possibile perfezionarli con un prompt di follow-up del tipo: "Ora aggiungi un test per quando l'input è nullo".

Utilizza le azioni intelligenti dell'editor

Quando desideri generare test senza interrompere il tuo flusso di lavoro, puoi utilizzare azioni intelligenti direttamente dal tuo editor di codice. In questo modo non dovrai passare al pannello della chat.

- Evidenzia la funzione o la classe che desideri testare

- Fai clic con il pulsante destro del mouse sulla selezione per aprire il menu contestuale.

- Vai su Genera codice nel menu contestuale e seleziona Genera test.

Copilot genererà i test e li mostrerà in una nuova scheda temporanea dell'editor. Qui potrai rivedere il codice e scegliere se creare un nuovo file di test o aggiungere i test a uno esistente.

📚 Leggi anche: Modelli di casi di test per il testing del software

Prompt di GitHub Copilot per la generazione di casi di test

I tuoi prompt sono il volante di GitHub Copilot. Prompt generici portano a test generici, ma prompt ben strutturati che forniscono all'IA istruzioni specifiche danno come risultato casi di test completi e utili. La chiave è dire a Copilot non solo cosa testare, ma come testarlo.

Ecco alcuni modelli che puoi adattare a diversi scenari:

| Scenario | Modello di prompt |

|---|---|

| Test unitario di base | "Scrivi test unitari per la funzione [nome_funzione] utilizzando [framework]. Assicurati di coprire input normali, valori limite come zero o numeri negativi e input non validi come null o undefined." |

| Classe con dipendenze | "Genera test per la classe [ClassName]. Usa [mocking_library] per creare mock per le dipendenze [DependencyName] e [AnotherDependencyName]." |

| Funzioni asincrone | "Crea test per questa funzione asincrona. Includi test per l'esito positivo, un caso in cui la promessa viene rifiutata e uno scenario per i timeout delle richieste." |

| Endpoint API | "Scrivi test di integrazione per questo endpoint API. Copri una richiesta GET con esito positivo, una richiesta POST con dati validi, una richiesta con un token di autenticazione mancante e una richiesta con dati non validi che dovrebbe restituire un errore 400." |

| Convalida dei dati | "Genera test per questa funzione di convalida. Includi un test per un oggetto valido, quindi aggiungi test separati per ogni errore della regola di convalida per assicurarti che vengano restituiti i messaggi di errore corretti." |

Suggerimenti per il miglioramento dei prompt:

- Sii esplicito riguardo al framework: effettua sempre una menzione del framework di test (ad esempio, pytest, Jest, JUnit) per assicurarti che la sintassi sia corretta.

- Definisci i tuoi obiettivi di copertura: utilizza tecniche avanzate di prompting IA per richiedere tipi specifici di copertura, come "casi limite", "gestione degli errori" o "test di confine".

- Fai riferimento ai tuoi modelli: se disponi di un buon file di esempio, puoi dire a Copilot di "seguire il modello di test in tests/test_user. py".

- Richiedi asserzioni specifiche: invece di lasciare che Copilot indovini, puoi chiedergli di "asserire che viene generato un ValueError per un input non valido".

Esempi di generazione di test con GitHub Copilot

Ecco come funziona nel lavoro.

Genera test unitari in Python

Immagina di avere una funzione Python che calcola il prezzo totale degli elementi in un carrello della spesa, compreso lo sconto.

Funzione di campione da testare:

Prompt utilizzato: "Scrivi test pytest per calculate_total. Copri un elenco vuoto di elementi, un singolo elemento, più elementi, l'applicazione di uno sconto, uno sconto dello 0%, uno sconto del 100% e una percentuale di sconto non valida che dovrebbe generare un ValueError. "

Risultato del test generato:

Copilot ha utilizzato correttamente pytest. raises per verificare l'eccezione e ha coperto gli scenari principali. Potresti comunque voler aggiungere test per prezzi o quantità negativi come perfezionamento manuale.

Genera test unitari in TypeScript con Jest

Ora proviamo una funzione TypeScript che formatta il nome di un utente.

Funzione di campione da testare:

Prompt utilizzato: "Genera test Jest per formatDisplayName. Copri un utente con nome e cognome, un utente con un nickname, un utente con nome vuoto e un utente con solo un nickname."

Risultato del test generato:

I test generati utilizzano i blocchi standard describe e it di Jest e gestiscono correttamente i diversi percorsi logici.

Best practice per la generazione di test con GitHub Copilot

L'utilizzo di Copilot per la generazione di test aumenta notevolmente la produttività, ma richiede un'attenta supervisione per garantire la qualità.

- Rivedi ogni singolo test: questa è la regola d'oro. Copilot non comprende la tua logica aziendale, quindi potrebbe generare un test che supera il controllo ma verifica l'aspetto sbagliato. Leggi sempre il codice generato e chiediti: "Questo verifica effettivamente il comportamento corretto?"

- Verifica manualmente la copertura dei casi limite: Copilot è efficace nell'individuare casi limite comuni come input nulli o stringhe vuote, ma potrebbe non rilevare quelli specifici del dominio. Per un'app di e-commerce, ha testato cosa succede quando il totale del carrello è esattamente il minimo per la spedizione gratis? Sei ancora tu l'esperto

- Mantieni convenzioni di denominazione coerenti: i nomi dei test generati dall'IA possono talvolta essere generici. Prenditi un momento per rinominarli in modo che corrispondano allo stile del tuo team. Un nome descrittivo come test_login_fails_with_incorrect_password è molto più utile di test_login_2.

- Esegui immediatamente i test: non lasciare i test generati inattivi. Eseguili subito per individuare eventuali errori di sintassi o asserzioni chiaramente errate prima di eseguire il commit del codice.

- Integrazione con CI/CD: aggiungi i test generati alla tua pipeline di integrazione continua. I test eseguiti solo localmente offrono un valore limitato.

- Attenzione ai test instabili: a volte l'IA può generare test "instabili", che a volte superano il test e altre volte falliscono. Questo accade spesso con i test che coinvolgono timestamp o dati casuali. Sostituiscili sempre con valori deterministici e prevedibili.

📮ClickUp Insight: I nostri sondaggi mostrano che mentre il 34% degli utenti opera con completa fiducia nei sistemi di IA, un gruppo leggermente più ampio (38%) mantiene un approccio di "fiducia ma verifica". Uno strumento autonomo che non ha familiarità con il tuo contesto di lavoro spesso comporta un rischio maggiore di generare risposte inaccurate o insoddisfacenti.

Ecco perché abbiamo creato ClickUp Brain, l'intelligenza artificiale che collega la project management, la gestione delle conoscenze e la collaborazione nel tuo spazio di lavoro e negli strumenti di terze parti integrati. Ottieni risposte contestualizzate senza costi aggiuntivi e aumenta di 2-3 volte l'efficienza del lavoro, proprio come i nostri clienti di Seequent.

Limiti dell'utilizzo di GitHub Copilot per la generazione di casi di test

Sebbene GitHub Copilot sia un potente strumento per aumentare la produttività, non è una soluzione miracolosa per il test del software. Conoscere i suoi limiti è fondamentale per utilizzarlo in modo efficace ed evitare errori comuni. È un "copilota", non il pilota: sei tu a decidere il piano di volo.

Il limite maggiore è la mancanza di contesto aziendale. Copilot analizza la struttura del codice, ma non ha idea di cosa dovrebbe effettivamente fare l'applicazione per gli utenti. Non può sapere che un utente "premium" dovrebbe avere accesso a determinate funzionalità/funzioni mentre un utente "base" non dovrebbe, a meno che tale logica non sia esplicitamente chiara nel codice che sta leggendo.

Ecco alcuni altri vincoli chiave da tenere a mente:

- Può tralasciare casi limite critici specifici del dominio: Copilot è ottimo per individuare casi limite generici, ma non conosce quelli particolari specifici del tuo settore, come un calcolo finanziario che richiede un trattamento diverso degli anni bisestili.

- Non ha accesso a sistemi esterni: Copilot non può generare test di integrazione significativi per il tuo database o API di terze parti perché non può effettuare la connessione ad essi. Può creare lo scaffold del codice, ma dovrai inserire i dettagli.

- Può dare un falso senso di sicurezza: vedere una copertura dei test del 100% può essere fantastico, ma se i test stanno affermando cose sbagliate, quel numero di copertura è insignificante. Ecco perché la revisione umana è così importante.

- Limiti della finestra di contesto: file molto grandi o gerarchie di classi complesse possono superare la finestra di contesto di Copilot, con il risultato di suggerimenti incompleti o generici.

📚 Leggi anche: Come utilizzare GitHub Copilot per lo sviluppo backend

Come creare e gestire casi di test in ClickUp

La generazione di casi di test con GitHub Copilot è solo metà del flusso di lavoro. Una volta creati i test, i team devono comunque effettuare il monitoraggio, collegarli ai requisiti e gestirne l'esecuzione durante gli sprint e i rilasci.

ClickUp offre uno spazio di lavoro centralizzato in cui i casi di test generati dall'intelligenza artificiale possono coesistere con attività di sviluppo, bug e piani sprint, in modo che i test non rimangano confinati all'interno dei singoli IDE.

ClickUp funge da spazio di lavoro AI convergente, riunendo in un unico sistema la gestione dei progetti, la documentazione e la comunicazione tra i membri del team. Per i team di sviluppo software, ciò significa che la gestione dei casi di test non richiede più strumenti o fogli di calcolo separati.

Test, requisiti, richieste pull e discussioni sul rilascio rimangono tutti collegati, riducendo la dispersione del contesto e rendendo il controllo qualità una parte fondamentale del flusso di lavoro di consegna.

Il modello di caso di test di ClickUp è progettato per aiutarti nel monitoraggio dello stato di avanzamento dei casi di test. Rende facile:

- Esamina i risultati dei test e prendi decisioni basate sui dati per la correzione dei bug.

- Sviluppa piani di test personalizzati per ogni progetto

- Organizza e assegna priorità ai casi di test per ottenere la massima efficienza.

Inizia creando un elenco ClickUp dedicato che fungerà da repository dei casi di test. Ogni caso di test, sia esso generato dall'IA o scritto manualmente, diventa un'attività.

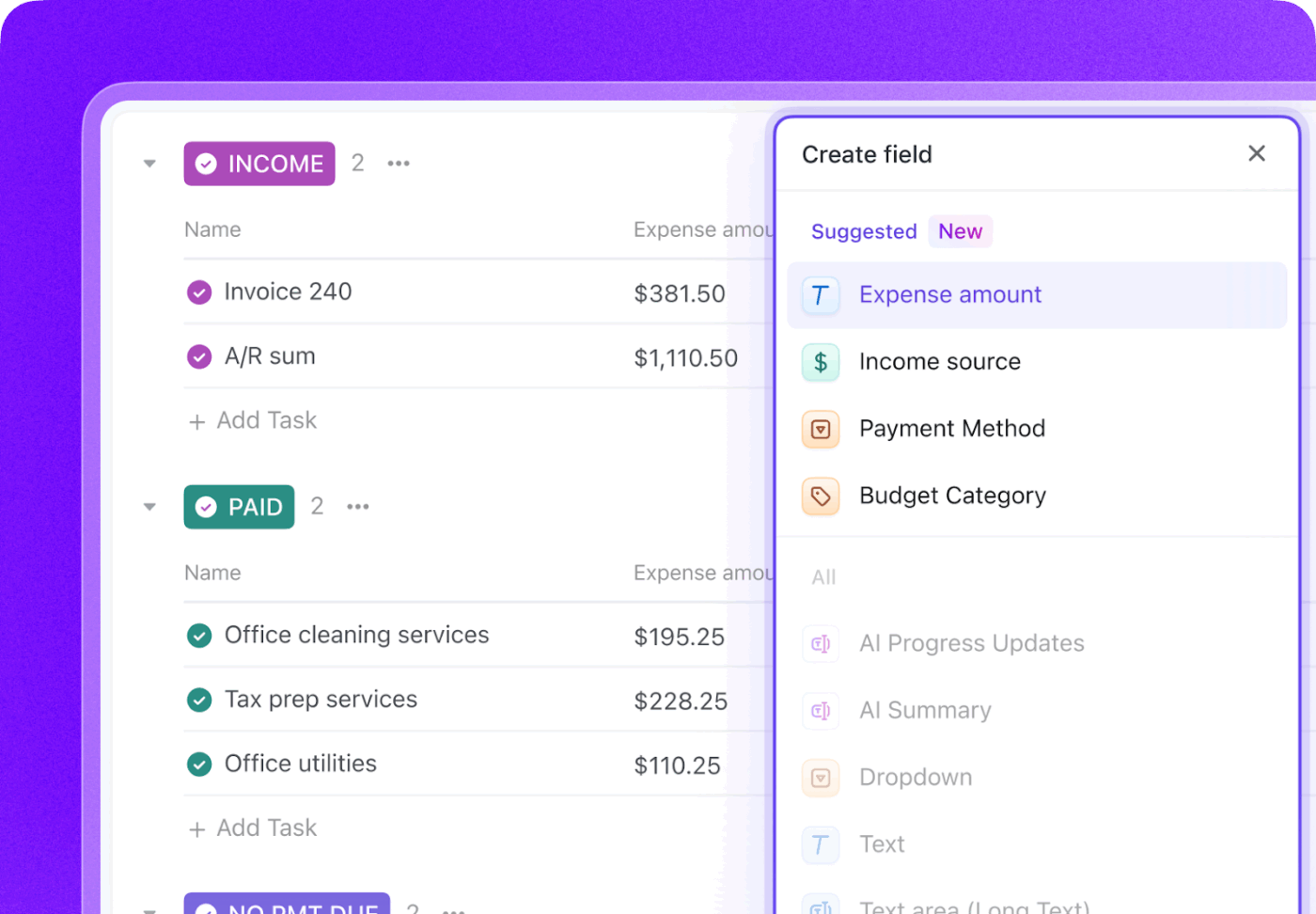

Arricchisci ogni caso di test con metadati cruciali utilizzando i campi personalizzati di ClickUp per effettuare il monitoraggio di ciò che è importante per il tuo team.

- Tipo di test: elenco a discesa per Unit, Integration, End-to-End o Manual

- Stato dell'automazione: uno stato che indica se il test è automatizzato o non automatizzato.

- Priorità: alta, media o bassa

- Data dell'ultima esecuzione: un campo data per effettuare il monitoraggio quando il test è stato eseguito l'ultima volta.

Tieni traccia dell'intero ciclo di vita dei test con gli stati personalizzati di ClickUp creando un flusso di lavoro che sposta i test da Non eseguito a Superato, Fallito o Bloccato. Ciò offre a tutti i membri del team, dagli sviluppatori ai product manager, una visibilità immediata sullo stato di avanzamento dell'esecuzione dei test.

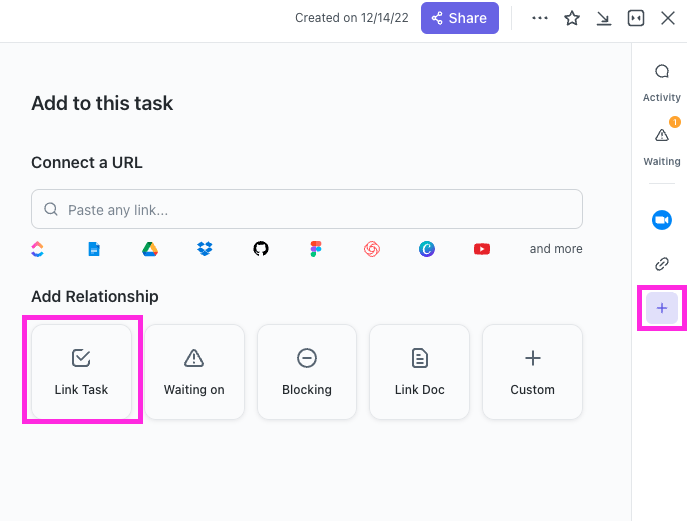

Con ClickUp Relazioni, le attività dei casi di test possono essere collegate direttamente alle user story, alle funzionalità/funzioni o alle epiche. Se un test fallisce, puoi creare un'attività di segnalazione bug e collegarla sia al test fallito che alla story originale, creando una catena completa di tracciabilità.

Redigi segnalazioni di bug in pochi secondi indicando a ClickUp Brain un'attività di test fallita. Poiché dispone del contesto dell'intero spazio di lavoro, può estrarre i dettagli dalla user story collegata e dal test stesso.

🌟 Il modello di report di test di ClickUp ti consente di creare report più rapidamente, assicurandoti al contempo di identificare e risolvere i problemi che necessitano di miglioramenti.

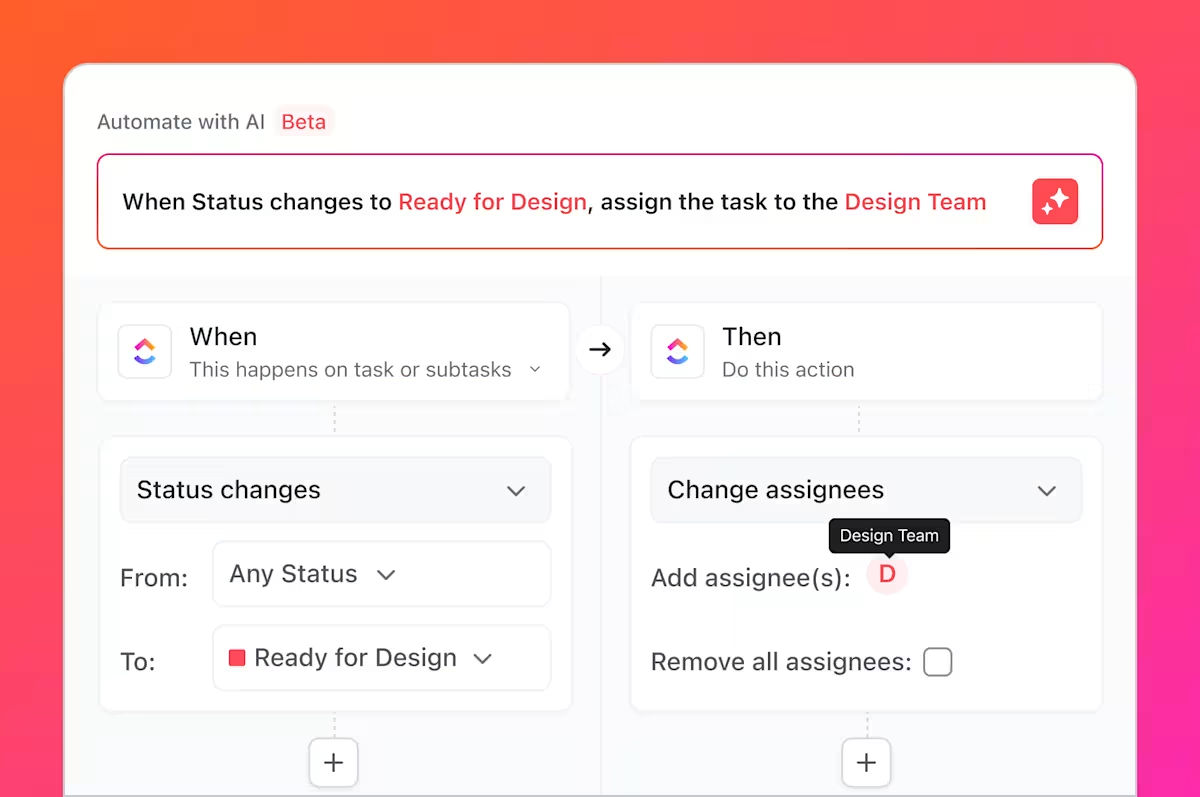

Ma non è tutto quello che puoi fare. Hai presente tutte quelle attività noiose e ripetitive di cui abbiamo parlato, che i test comportano sempre? Puoi automatizzarle utilizzando ClickUp Automazioni.

Imposta regole come "Quando lo stato di un caso di test viene modificato in Fallito, crea automaticamente una nuova attività nell'Elenco dei bug e assegnala allo sviluppatore capo".

Integrando GitHub con ClickUp, le attività dei casi di test possono essere collegate ai commit e alle richieste pull. Quando le modifiche al codice vengono unite, le attività di test correlate si aggiornano automaticamente, mantenendo il controllo qualità, gli sviluppatori e i responsabili del rilascio allineati su ciò che è stato modificato e ciò che deve essere nuovamente testato.

Le dashboard di ClickUp consentono di effettuare il monitoraggio in tempo reale dello stato di avanzamento dei test, visualizzare il numero di bug, l'esecuzione dei casi di test e altro ancora.

Insieme, questo flusso di lavoro colma il divario tra i test generati dall'IA in GitHub Copilot e la gestione dei casi di test a livello di team in ClickUp, offrendo ai team un unico sistema per pianificare, effettuare il monitoraggio, effettuare l'automazione e migliorare il loro processo di controllo qualità senza un costante coordinamento manuale.

Guarda questo video per suggerimenti su come creare un flusso di lavoro efficiente per la gestione delle versioni:

Semplifica la gestione dei casi di test con ClickUp

I test generati dall'IA non sono più artefatti isolati, ma componenti integrati del processo di sviluppo, con visibilità, tracciabilità e utilizzabilità per tutto il team.

GitHub Copilot genera rapidamente casi di test, ma la velocità da sola non garantisce la qualità. Senza una chiara titolarità delle responsabilità, la tracciabilità dei requisiti e la visibilità tra gli sprint, anche i test ben scritti possono diventare obsoleti o essere trascurati. È qui che entra in gioco l'importanza di un sistema di registrazione.

Gestendo i casi di test in ClickUp, i team trasformano i risultati generati dall'IA in un flusso di lavoro QA ripetibile, che collega i test ai requisiti, alle modifiche del codice e alle tempistiche di rilascio. Invece di destreggiarsi tra strumenti e aggiornamenti manuali, i team di QA e di ingegneria lavorano da uno spazio di lavoro condiviso e contestualizzato. Il risultato non è solo un numero maggiore di test, ma anche una maggiore fiducia in ciò che viene distribuito e nel perché.

Sei pronto a gestire i tuoi casi di test insieme ai Sprints e alle release? Inizia oggi stesso con ClickUp gratis.

Domande frequenti

Sì, Copilot è in grado di analizzare la struttura e la logica del codice legacy per generare una baseline di test. Tuttavia, questi test richiederanno probabilmente una revisione e un perfezionamento manuali significativi, poiché l'IA non avrà il contesto sui comportamenti non documentati o sulle regole aziendali storiche.

L'accuratezza sintattica è molto elevata, ma l'accuratezza logica dipende dalla chiarezza del codice e dalla specificità dei prompt. Rivedi sempre le asserzioni per assicurarti che verifichino requisiti aziendali significativi, non solo che confermino l'implementazione attuale (e possibilmente imperfetta).

Sì, Copilot offre un eccellente supporto per pytest, unittest e altri popolari framework di test Python. È in grado di riconoscere e replicare i modelli esistenti nel tuo progetto, come l'uso di fixture o test parametrizzati.

I team efficaci utilizzano una piattaforma centralizzata di project management per gestire le loro suite di test. Monitorando ogni caso di test come un'attività con metadati personalizzati per lo stato e la priorità, ottengono visibilità sulla copertura e sui risultati dell'esecuzione, collegando il processo di controllo qualità direttamente alla pianificazione dello sprint e al monitoraggio dei bug.