La maggior parte dei team aziendali che esplorano LLaMA si bloccano allo stesso punto: scaricano i pesi del modello, fissano la finestra del terminale e si rendono conto di non avere idea di cosa fare dopo.

Questa sfida è molto diffusa: mentre l'88% delle aziende utilizza l'IA in almeno una funzione, solo il 7% l'ha estesa a tutta l'organizzazione.

Questa guida ti accompagna attraverso l'intero processo, dalla selezione della dimensione del modello più adatta al tuo caso d'uso alla sua messa a punto sui dati della tua azienda, in modo da poter implementare una soluzione di IA funzionante che comprenda effettivamente il contesto della tua attività.

Che cos'è LLaMA e perché è importante per l'IA dell'azienda?

LLaMA (abbreviazione di Large Language Model Meta IA) è una famiglia di modelli linguistici open-weight creati da Meta. A livello generale, svolge le stesse funzioni fondamentali di modelli come GPT o Gemini: comprende il linguaggio, genera testo ed è in grado di ragionare sulle informazioni. La grande differenza sta nel modo in cui le aziende possono utilizzarlo.

Poiché LLaMA è open-weight, le aziende non sono costrette a interagire con esso solo attraverso un'API black-box. Possono eseguirlo sulla propria infrastruttura, ottimizzarlo sui dati interni e controllare come e dove viene implementato.

Per le aziende, questo è un vantaggio enorme, soprattutto quando la privacy dei dati, la conformità e la prevedibilità dei costi sono più importanti della novità.

Questa flessibilità rende LLaMA particolarmente interessante per i team che desiderano integrare profondamente l'IA nei propri flussi di lavoro, non solo come chatbot autonomo. Si pensi ad assistenti interni per la gestione delle conoscenze, automazioni per il supporto clienti, strumenti di sviluppo o funzionalità IA integrate direttamente nei prodotti, senza inviare dati sensibili all'esterno dell'organizzazione.

In breve, LLaMA è importante per l'IA dell'azienda perché offre ai team la possibilità di scegliere l'implementazione, la personalizzazione e l'integrazione dell'IA nei sistemi aziendali reali. E man mano che l'IA passa dalla fase sperimentale a quella operativa quotidiana, tale livello di controllo diventa meno un "optional" e più un requisito indispensabile.

Come iniziare a utilizzare LLaMA per le applicazioni aziendali

1. Definisci il tuo caso d'uso per l'azienda

Prima di scaricare qualsiasi cosa, individua i flussi di lavoro esatti in cui l'IA può avere un impatto reale. È fondamentale abbinare il caso d'uso dell'IA alle dimensioni del modello: i modelli più piccoli da 8B sono efficienti per attività semplici, mentre quelli più grandi da 70B+ sono più adatti per ragionamenti complessi.

Per aiutarti a identificare le applicazioni di IA più adatte alla tua attività, guarda questa panoramica di casi d'uso pratici dell'IA in diverse funzioni aziendali e settori industriali:

I punti di partenza comuni includono:

- Elaborazione di documenti: riepilogare lunghi rapporti o estrarre informazioni chiave dai contratti.

- Assistenza alla codifica: generazione di codice boilerplate, spiegazione dei sistemi legacy o suggerimenti di ottimizzazione.

- Recupero delle conoscenze: rispondere alle domande dei dipendenti cercando nella documentazione interna utilizzando una tecnica chiamata Retrieval-Augmented Generation (RAG).

- Generazione di contenuti: redazione di bozze di comunicazioni o testi di marketing di prima stesura.

2. Configurare i prerequisiti e le dipendenze

Successivamente, preparate l'hardware e il software. La dimensione del modello determina le vostre esigenze: un modello LLaMA 8B richiede una GPU con circa 15 GB di VRAM, mentre un modello 70B necessita di 131 GB o più.

Il tuo stack software dovrebbe includere Python 3. 8+, PyTorch, driver CUDA e l'ecosistema Hugging Face (transformers, accelerate e bitsandbytes).

3. Accedere e scaricare i pesi del modello LLaMA

È possibile ottenere i pesi del modello dalla pagina ufficiale di download di Llama di Meta o dall'hub dei modelli Hugging Face. È necessario accettare la licenza Llama 3 Community, che consente l'uso commerciale. A seconda della configurazione, i pesi verranno scaricati in formato safetensors o GGUF.

4. Configura il tuo ambiente di sviluppo

Una volta scaricati i pesi, è il momento di configurare l'ambiente. Installare le librerie Python necessarie, tra cui transformers, accelerate e bitsandbytes per la quantizzazione, un processo che riduce l'impronta di memoria del modello.

Carica il modello con le impostazioni corrette ed esegui un semplice prompt per assicurarti che tutto funzioni correttamente prima di passare alla personalizzazione.

💡Se non disponi di un team dedicato all'infrastruttura ML, l'intero processo potrebbe rivelarsi impossibile. Elimina completamente la complessità dell'implementazione con ClickUp Brain. Offre funzionalità di IA come l'assistenza alla scrittura e l'automazione delle attività direttamente all'interno dell'area di lavoro in cui opera già il tuo team, senza necessità di scaricare modelli o fornire GPU.

Come personalizzare LLaMA per i dati dell'azienda

L'utilizzo di un modello LLaMA di base è un buon inizio, ma non sarà in grado di comprendere gli acronimi, i nomi dei progetti o i processi interni specifici della tua azienda. Ciò porta a risposte generiche e inutili che non risolvono i reali problemi aziendali.

L'IA dell'azienda diventa utile grazie alla personalizzazione, ovvero all'addestramento del modello sulla tua terminologia e base di conoscenze specifiche.

Prepara i tuoi dati di addestramento specifici per il tuo dominio

L'esito positivo della tua IA personalizzata dipende più dalla qualità dei tuoi dati di addestramento che dalle dimensioni del modello o dalla potenza di calcolo. Inizia raccogliendo e pulendo le tue informazioni interne.

- Documentazione interna: raccogli le specifiche dei prodotti, le guide ai processi e i documenti relativi alle politiche aziendali.

- Comunicazioni storiche: raccogli modelli di email, risposte ai ticket di supporto e riassunti delle riunioni.

- Terminologia di dominio: compilare glossari, definizioni di acronimi e linguaggio specifico del settore.

Una volta raccolte, formattare queste informazioni in coppie di istruzioni-risposte per la messa a punto supervisionata. Ad esempio, un'istruzione potrebbe essere "Riassumi questo ticket di supporto" e la risposta sarebbe un riepilogo/riassunto chiaro e conciso. Questo passaggio è fondamentale per insegnare al modello come eseguire attività specifiche con i propri dati.

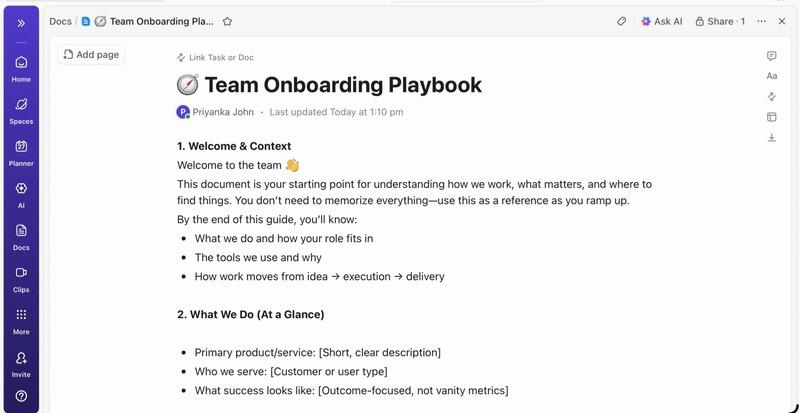

📮 ClickUp Insight: in media, un professionista trascorre più di 30 minuti al giorno alla ricerca di informazioni relative al lavoro, il che significa oltre 120 ore all'anno perse a setacciare e-mail, thread di Slack e file sparsi. Un assistente IA intelligente integrato nell'area di lavoro di ClickUp può cambiare questa situazione.

Entra in ClickUp Brain. Fornisce approfondimenti e risposte immediate facendo emergere i documenti, le conversazioni e i dettagli delle attività giusti in pochi secondi, così puoi smettere di cercare e iniziare a lavorare.

💫 Risultati reali: team come QubicaAMF hanno recuperato più di 5 ore alla settimana utilizzando ClickUp, ovvero oltre 250 ore all'anno a persona, eliminando processi di gestione delle conoscenze obsoleti. Immagina cosa potrebbe creare il tuo team con una settimana in più di produttività ogni trimestre!

Ottimizza LLaMA in base al tuo contesto aziendale

La messa a punto è il processo di adattamento delle conoscenze esistenti di LLaMA al tuo caso d'uso specifico, che migliora notevolmente la sua accuratezza nelle attività specifiche del dominio. Invece di addestrare un modello da zero, puoi utilizzare metodi efficienti in termini di parametri che aggiornano solo un piccolo sottoinsieme dei parametri del modello, risparmiando tempo e risorse computazionali.

I metodi di messa a punto più diffusi includono:

- LoRA (Low-Rank Adaptation): questo metodo addestra piccole matrici "adattatrici" invece dell'intero modello, rendendolo altamente efficiente.

- QLoRA: combina LoRA con la quantizzazione per consentire la messa a punto su una singola GPU da 48 GB, garantendo al contempo prestazioni di messa a punto complete.

- Ottimizzazione completa: aggiorna tutti i parametri del modello, offrendo il massimo livello di personalizzazione ma richiedendo una notevole potenza di calcolo.

Valutare e iterare le prestazioni del modello

Come sapere se il modello personalizzato funziona davvero? La valutazione dell'IA deve andare oltre i semplici punteggi di accuratezza e misurare l'utilità nel mondo reale. Crea set di dati di valutazione che rispecchino i tuoi casi d'uso di produzione e effettua il monitoraggio delle metriche importanti per la tua attività, come la qualità della risposta, l'accuratezza fattuale e la latenza.

- Valutazione qualitativa: chiedi a revisori umani di valutare i risultati in termini di tono, utilità e correttezza.

- Metriche quantitative: utilizza punteggi automatizzati come BLEU o perplexity per effettuare il monitoraggio delle prestazioni su larga scala.

- Monitoraggio della produzione: una volta implementato, monitora il feedback degli utenti e i tassi di errore per identificare le aree di miglioramento.

💡Questo processo iterativo di formazione e valutazione può diventare un progetto a sé stante. Gestisci il ciclo di vita dello sviluppo dell'IA direttamente in ClickUp invece di perderti nei fogli di calcolo.

Centralizza le metriche delle prestazioni e i risultati delle valutazioni in un'unica vista con i dashboard di ClickUp. Tieni traccia delle versioni dei modelli, dei parametri di formazione e dei punteggi di valutazione insieme agli altri tuoi prodotti con i campi personalizzati di ClickUp, mantenendo tutto organizzato e visibile. 🛠️

Principali casi d'uso aziendali per LLaMA

I team spesso rimangono bloccati in una paralisi analitica, incapaci di passare dall'entusiasmo astratto per l'IA ad applicazioni concrete. La flessibilità di LLaMA lo rende adatto a un'ampia gamma di flussi di lavoro aziendali, aiutandoti ad automatizzare le attività e a lavorare in modo più efficiente.

Ecco alcuni dei principali casi d'uso di un modello LLaMA personalizzato:

- Assistenti di conoscenza interni: smettete di perdere tempo a cercare informazioni. Implementate LLaMA con RAG per creare un chatbot in grado di rispondere istantaneamente alle domande dei dipendenti cercando nei vostri wiki interni, nei documenti sulle politiche aziendali e nelle comunicazioni relative a progetti passati.

- Automazione del supporto clienti: ottimizza un modello sulla cronologia dei ticket per redigere automaticamente le risposte, classificare le richieste e inoltrare i problemi complessi all'agente umano più adatto.

- Generazione e revisione del codice: aiuta il tuo team di ingegneri a lavorare in modo più efficiente. Utilizza LLaMA per generare codice boilerplate, spiegare sistemi legacy complessi e persino identificare potenziali bug nelle richieste pull prima che diventino problemi.

- Elaborazione di documenti: trasforma grandi volumi di testo in informazioni utili. Riepiloga lunghi rapporti, estrai termini chiave da contratti legali o genera note concise delle riunioni da trascrizioni grezze in pochi secondi.

- Flussi di lavoro per la creazione di contenuti: supera il blocco dello scrittore. Redigi bozze di testi di marketing, descrizioni di prodotti e annunci interni che i tuoi editor umani potranno poi perfezionare e rifinire.

💡Accedi a molti di questi casi d'uso pronti all'uso con ClickUp Brain.

- Riassumi le threads di attività, redigi bozze di aggiornamenti di progetto e genera contenuti con l'assistenza alla scrittura basata sull'IA di ClickUp.

- Trova immediatamente le risposte in tutta l'area di lavoro di ClickUp con la ricerca Enterprise di ClickUp e l'agente Ambient Answers predefinito.

- Crea flussi di lavoro intelligenti che gestiscono le attività di routine al posto tuo con ClickUp Automazioni.

Limiti dell'utilizzo di LLaMA per l'IA dell'azienda

Sebbene l'hosting autonomo di LLaMA offra un controllo significativo, non è privo di difficoltà. I team spesso sottovalutano i costi operativi, impantanandosi nella manutenzione invece che nell'innovazione. Prima di impegnarsi nel percorso di "costruzione", è fondamentale comprendere i potenziali ostacoli.

Ecco alcune delle principali limitazioni da considerare:

- Requisiti infrastrutturali: l'esecuzione di modelli di grandi dimensioni è costosa e richiede GPU potenti e di livello aziendale che molte organizzazioni non hanno a disposizione.

- Competenze tecniche necessarie: l'implementazione, la messa a punto e la manutenzione di un modello linguistico di grandi dimensioni richiedono competenze ingegneristiche specializzate nel campo del machine learning, molto richieste sul mercato.

- Onere di manutenzione continua: non si tratta di una soluzione "imposta e dimentica". I modelli richiedono un monitoraggio costante, aggiornamenti di sicurezza e riqualificazione man mano che la tua attività si evolve.

- Rischio di allucinazioni: come tutti gli LLM, LLaMA può talvolta generare informazioni plausibili ma errate. Le applicazioni delle aziende richiedono solide misure di sicurezza e la supervisione umana per mitigare questo rischio.

- Nessuna funzionalità aziendale integrata: funzionalità critiche come il controllo degli accessi, la registrazione degli audit e gli strumenti di conformità devono essere sviluppate e gestite separatamente, aggiungendo un ulteriore livello di complessità.

💡È possibile aggirare queste limitazioni utilizzando ClickUp Brain. Fornisce un'intelligenza artificiale gestita all'interno del tuo spazio di lavoro esistente, offrendoti funzionalità di intelligenza artificiale aziendale senza costi operativi aggiuntivi. Ottieni una sicurezza di livello aziendale ed elimina la manutenzione dell'infrastruttura con ClickUp, liberando il tuo team affinché possa concentrarsi sul proprio lavoro principale.

📮ClickUp Insight: l'88% dei partecipanti al nostro sondaggio utilizza l'IA per le proprie attività personali, ma oltre il 50% evita di utilizzarla sul lavoro. I tre principali ostacoli? Mancanza di integrazione perfetta, lacune di conoscenza o preoccupazioni relative alla sicurezza.

Ma cosa succede se l'IA è integrata nel tuo spazio di lavoro ed è già sicura? ClickUp Brain, l'assistente IA integrato di ClickUp, rende tutto questo realtà. Comprende i prompt in linguaggio semplice, risolvendo tutte e tre le preoccupazioni relative all'adozione dell'IA e creando una connessione tra chat, attività, documenti e conoscenze in tutto lo spazio di lavoro. Trova risposte e approfondimenti con un solo clic!

Strumenti di IA alternativi per casi d'uso aziendali

Scegliere lo strumento di IA giusto tra le numerose opzioni disponibili è una sfida per qualsiasi team. Stai cercando di capire i compromessi tra i diversi modelli, ma temi di scegliere quello sbagliato e sprecare risorse.

Questo spesso porta all'AI Sprawl, ovvero alla proliferazione non pianificata di strumenti e piattaforme di IA senza supervisione o strategia, in cui i team si abbonano a più servizi scollegati tra loro, creando più lavoro invece che meno.

Ecco una breve panoramica dei principali attori e del loro ruolo:

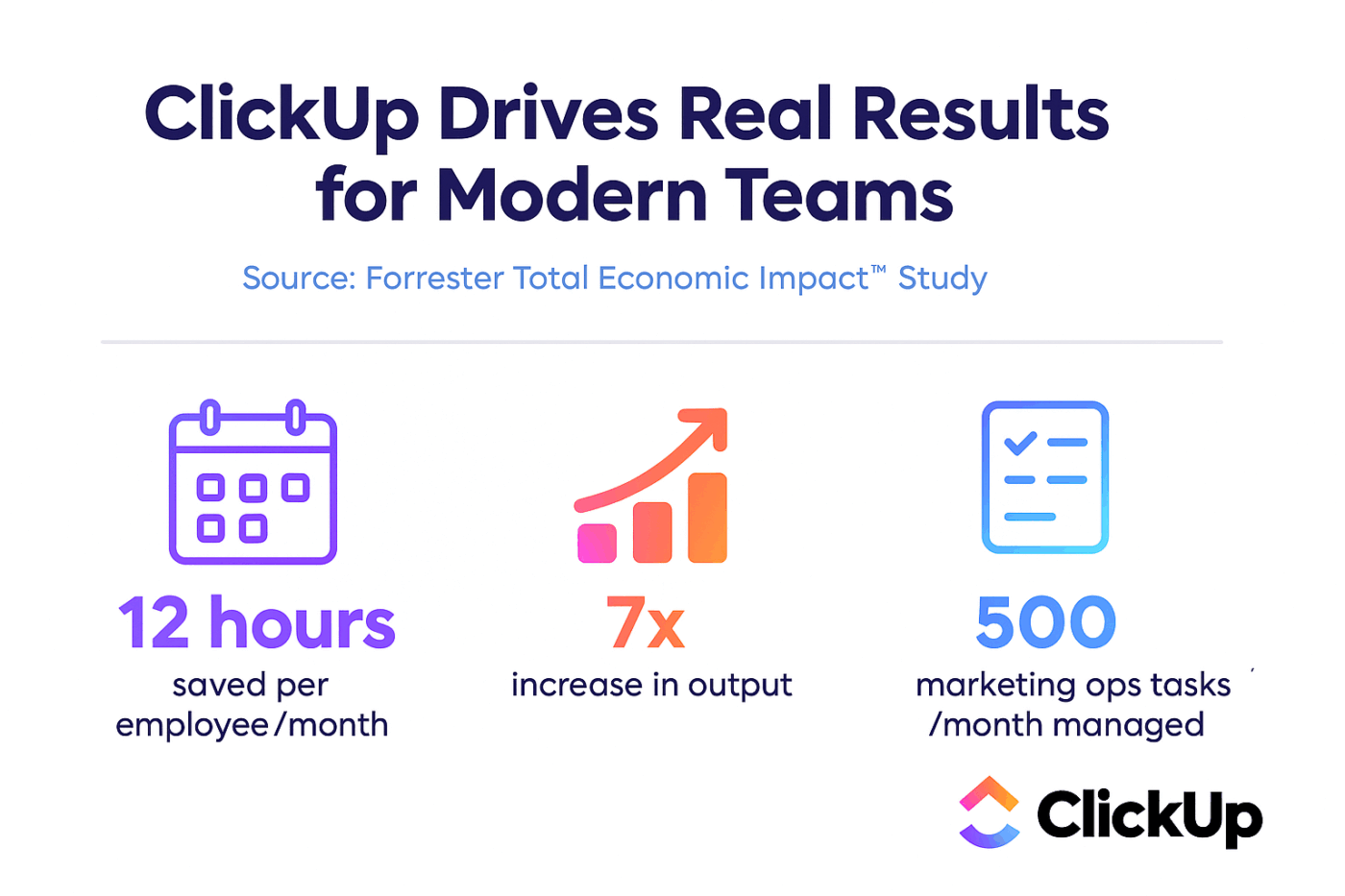

| Strumento | Ideale per | Considerazioni chiave |

|---|---|---|

| LLaMA (self-hosted) | Massimo controllo, sovranità dei dati | Richiede infrastruttura ML e competenze specifiche. |

| OpenAI GPT-4 | Massima capacità, configurazione minima | I dati escono dal tuo ambiente, prezzi basati sull'utilizzo |

| Claude (Anthropic) | Attività a lungo termine, attenzione alla sicurezza | Compromessi simili a GPT-4 |

| Mistral | Residenza dei dati in Europa, efficienza | Ecosistema più piccolo rispetto a LLaMA |

| ClickUp Brain | IA integrata nell'area di lavoro, nessuna implementazione | Ideale per i team che desiderano integrare l'IA nei flussi di lavoro esistenti. |

Invece di collegare più strumenti per soddisfare le tue esigenze, perché non accedere all'IA integrata direttamente nel luogo in cui svolgi il tuo lavoro? Questo è il cuore di ciò che ClickUp offre come primo spazio di lavoro AI convergente al mondo: un'unica piattaforma sicura in cui progetti, documenti, conversazioni e analisi convivono.

Unifica i tuoi strumenti per eliminare la frammentazione del contesto, ovvero la frammentazione che si verifica quando i team perdono ore a passare da un'app all'altra e a cercare le informazioni necessarie per svolgere il proprio lavoro.

ClickUp + IA contestuale = trasformazione misurabile

Secondo uno studio di Forrester Economic Impact™, i team che utilizzano ClickUp hanno registrato un ROI del 384% e risparmiato 92.400 ore entro il terzo anno.

Quando contesto, flussi di lavoro e intelligenza sono riuniti in un unico posto, i team non si limitano a lavorare. Vincono.

ClickUp offre anche le funzionalità di sicurezza e amministrazione richieste dalle implementazioni aziendali, con conformità SOC 2 Tipo II, integrazione SSO, provisioning SCIM e controlli granulari delle autorizzazioni.

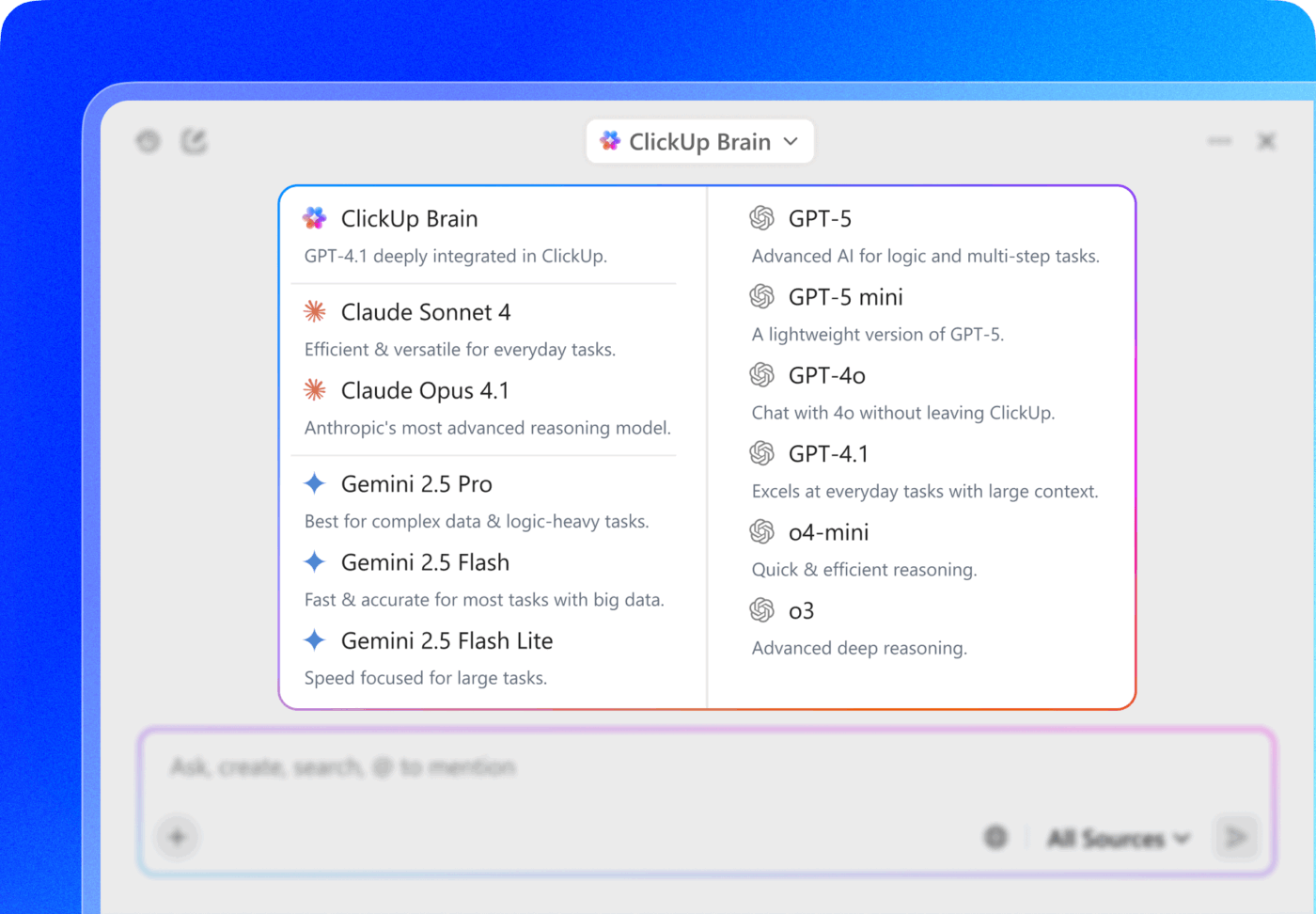

L'accesso multi-LLM di ClickUp Brain MAX consente di scegliere tra modelli premium come ChatGPT, Claude e Gemini direttamente dall'interfaccia di ricerca. La piattaforma indirizza automaticamente la query al modello più adatto al compito, consentendo di ottenere il meglio senza dover gestire più sottoscrizioni.

Ottieni l'intero stack (funzionalità di IA, project management, documentazione e comunicazione) in un unico posto con ClickUp, invece di creare da zero il livello di IA con LLaMA.

Passate all'IA Enterprise con ClickUp

LLaMA offre ai team dell'azienda un'alternativa aperta alle API di IA chiuse, garantendo un controllo significativo, la prevedibilità dei costi e la personalizzazione. Ma l'esito positivo non dipende solo dalla tecnologia. È necessario abbinare il modello giusto al caso d'uso giusto, investire in dati di formazione di alta qualità e creare processi di valutazione robusti.

La decisione "costruire o acquistare" dipende in ultima analisi dalla capacità tecnica del tuo team. Sebbene la creazione di una soluzione personalizzata offra la massima flessibilità, comporta anche costi significativi. La vera sfida non è solo accedere all'IA, ma integrarla nei flussi di lavoro quotidiani senza creare ulteriore proliferazione dell'IA e silos di dati.

Integra le funzionalità LLM direttamente nella project management, nella documentazione e nella comunicazione del team con ClickUp Brain, senza la complessità di dover creare e mantenere un'infrastruttura. Inizia gratis con ClickUp e integra le funzionalità di IA direttamente nei tuoi flussi di lavoro esistenti. 🙌

Domande frequenti (FAQ)

Sì, la licenza Llama 3 Community consente l'uso commerciale per la maggior parte delle organizzazioni. Solo le aziende con oltre 700 milioni di utenti attivi al mese devono ottenere una licenza separata da Meta.

LLaMA offre un maggiore controllo dei dati e costi prevedibili grazie all'auto-hosting, mentre GPT-4 offre prestazioni immediate più elevate con una configurazione minima. Per quanto riguarda la produttività, tuttavia, è possibile ottenere assistenza IA senza gestire i modelli sottostanti attraverso strumenti integrati come ClickUp Brain.

L'hosting autonomo di LLaMA mantiene i dati sulla tua infrastruttura, il che è ottimo per la residenza dei dati. Tuttavia, sei responsabile dell'implementazione dei tuoi controlli di accesso, dei registri di audit e dei filtri dei contenuti, ovvero delle funzionalità di sicurezza che sono tipicamente incluse nei servizi di IA gestiti.

L'implementazione e la messa a punto diretta di LLaMA richiedono competenze ingegneristiche significative nel campo del machine learning. I team che non dispongono di tali competenze possono accedere alle funzionalità basate su LLaMA attraverso piattaforme gestite come ClickUp Brain, che fornisce funzionalità di IA senza alcuna implementazione di modelli o configurazione tecnica.