Çoğu AI dağıtım projesi, takımların yanlış modeli seçmesi nedeniyle değil, üç ay sonra kimse neden bu modeli seçtiğini veya kurulumu nasıl tekrarlayacağını hatırlayamadığı için başarısız olur. AI projelerinin %46'sı, kavram kanıtlama aşaması ile yaygın olarak benimsenmesi arasında iptal edilir.

Bu kılavuz, Hugging Face'i AI dağıtımı için kullanma konusunda size yol gösterir – model seçiminden testine ve dağıtım sürecinin yönetimine kadar – böylece takımınız Slack konu dizilerinde ve dağınık elektronik tablolarda kritik kararları kaybetmeden daha hızlı teslimat yapabilir.

Hugging Face nedir?

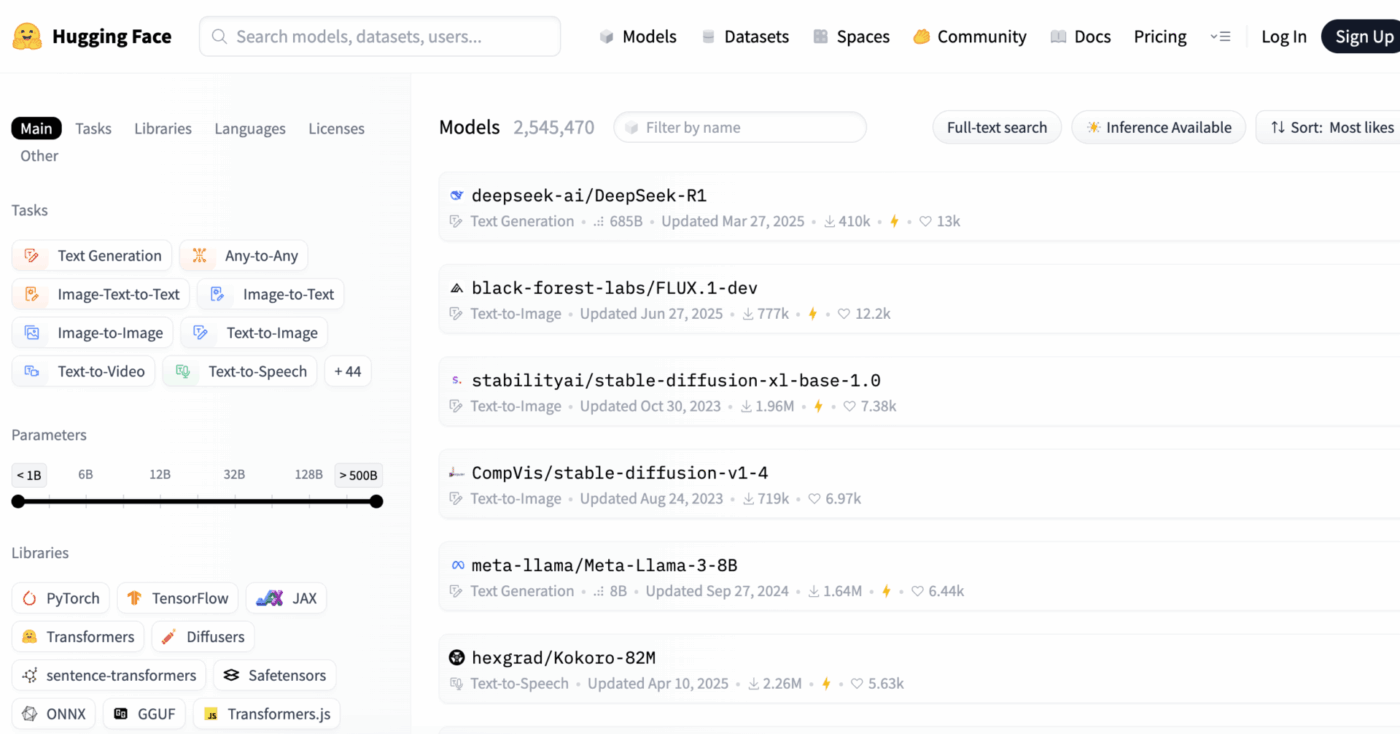

Hugging Face, makine öğrenimi uygulamaları oluşturmak ve dağıtmak için önceden eğitilmiş AI modelleri, veri kümeleri ve araçlar sağlayan açık kaynaklı bir platform ve topluluk merkezidir.

Bunu, aylarca zaman ve önemli miktarda kaynak harcayarak sıfırdan AI modelleri oluşturmak yerine, kullanıma hazır AI modelleri bulabileceğiniz devasa bir dijital kütüphane olarak düşünün.

Makine öğrenimi mühendisleri ve veri bilimcileri için tasarlanmıştır, ancak araçları, yapay zekayı ş Akışlarına entegre etmek için işlevler arası ürün, tasarım ve mühendislik takımları tarafından giderek daha fazla kullanılmaktadır.

Biliyor muydunuz: Kuruluşların %63'ü AI için uygun veri yönetimi uygulamalarına sahip değildir. Bu durum genellikle projelerin durmasına ve kaynakların boşa harcanmasına neden olur.

Birçok takım için temel zorluk, AI dağıtımının karmaşıklığıdır. Bu süreç, binlerce seçenek arasından doğru modeli seçmeyi, altyapıyı yönetmeyi, deneylerin sürümlerini oluşturmayı ve teknik ve teknik olmayan paydaşların uyum içinde olmasını sağlamayı içerir.

Hugging Face, 2 milyondan fazla model içeren merkezi bir depo olan Model Hub'ı sunarak bu süreci basitleştirir. Platformun transformers kütüphanesi, bu modelleri açan anahtardır ve sadece birkaç satır Python kodu ile bunları yüklemenizi ve kullanmanızı sağlar.

Ancak, bu güçlü araçlara rağmen, AI dağıtımı proje yönetimi açısından bir zorluk olmaya devam ediyor ve başarıyı garantilemek için model seçimi, test etme ve piyasaya sürme süreçlerinin dikkatle izlenmesi gerekiyor.

📮ClickUp Insight: Bilgi çalışanlarının %92'si, sohbet, e-posta ve elektronik tablolara dağılmış önemli kararları kaybetme riskiyle karşı karşıya. Kararları kaydetmek ve izlemek için birleşik bir sistem olmadan, kritik iş içgörüleri dijital gürültüde kaybolur.

ClickUp'ın Görev Yönetimi özellikleri sayesinde, bu konuda endişelenmenize gerek kalmaz. Tek bir tıklama ile sohbet, görev yorumları, belgeler ve e-postalardan görevler oluşturun!

📚 Ayrıca okuyun: LLM, NLP ve AI ş akışları için en iyi Hugging Face alternatifleri

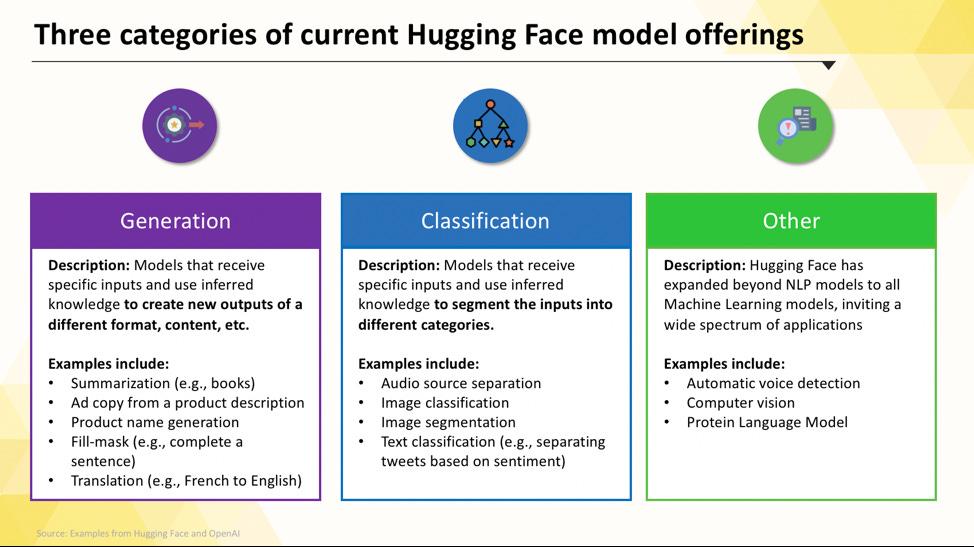

Dağıtabileceğiniz Hugging Face Modelleri

Hugging Face Hub'ı ilk kez kullanmaya başladığınızda, bu platformda gezinmek zor gelebilir. Yüz binlerce model arasından projenize en uygun olanı bulmak için anahtar kategorileri anlamak çok önemlidir. Modeller, tek bir amaç için tasarlanmış küçük ve verimli seçeneklerden, karmaşık mantık işlemlerini gerçekleştirebilen büyük ve genel amaçlı modellere kadar aralıkta bulunur.

Göreve özel dil modelleri

Takımınızın tek bir, iyi tanımlanmış sorunu çözmesi gerektiğinde, genellikle büyük, genel amaçlı bir modele ihtiyaç duymazsınız. Böyle bir modeli çalıştırmak için gereken zaman ve maliyet, özellikle daha küçük, daha odaklanmış bir AI aracı daha iyi sonuç verecekse, çok yüksek olabilir. İşte bu noktada görevlere özel modeller devreye girer.

Bunlar, belirli bir fonksiyon için eğitilmiş ve optimize edilmiş modellerdir. Uzmanlaşmış oldukları için, genellikle daha büyük modellerden daha küçük, daha hızlı ve daha kaynak verimlidirler.

Bu, hız ve maliyetin önemli faktörler olduğu üretim ortamları için idealdir. Birçoğu standart CPU donanımında bile çalışabilir, bu da pahalı GPU'lar olmadan erişilebilir olmalarını sağlar.

Görevlere özgü modellerin yaygın türleri şunlardır:

- Metin sınıflandırma: Bunu, metni önceden tanımlanmış etiketlere göre sınıflandırmak için kullanın. Örneğin, müşteri geri bildirimlerini "olumlu" veya "olumsuz" kategorilerine ayırmak veya destek biletlerini konuya göre etiketlemek gibi.

- Duygu analizi: Bu, bir metnin duygusal tonunu belirlemenize yardımcı olur ve sosyal medyada marka izleme için yararlıdır.

- Adlandırılmış varlık tanıma: Yapılandırılmamış verileri yapılandırmaya yardımcı olmak için belgelerden kişiler, yerler ve kuruluşlar gibi belirli varlıkları çıkarın.

- Özetleme: Uzun makaleleri veya raporları kısa özetlere dönüştürerek takımınızın değerli okuma zamanından tasarruf edin.

- Çeviri: Metni bir dilden diğerine otomatik olarak dönüştürün

📚 Ayrıca okuyun: Metin Özetleme için Hugging Face'i Kullanma

Büyük dil modelleri

Bazen, projeniz basit sınıflandırma veya özetlemeden daha fazlasını gerektirir. Yaratıcı pazarlama metinleri oluşturabilen, kod yazabilen veya karmaşık kullanıcı sorularını konuşma tarzında yanıtlayabilen bir AI'ya ihtiyacınız olabilir. Bu senaryolar için, muhtemelen Büyük Dil Modeli'ne (LLM) başvuracaksınız.

LLM'ler, internetten alınan büyük miktarda metin ve veriyle eğitilmiş milyarlarca parametreye sahip modellerdir. Bu kapsamlı eğitim, onların nüansları, bağlamı ve karmaşık mantığı anlamalarını sağlar. Hugging Face'te bulunan popüler açık kaynaklı LLM'ler arasında Llama, Mistral ve Falcon ailelerinden modeller bulunur.

Bu gücün bedeli, ihtiyaç duydukları önemli hesaplama kaynaklarıdır. Bu modellerin dağıtımı neredeyse her zaman çok fazla bellek (VRAM) içeren güçlü GPU'lar gerektirir.

Modelleri daha erişilebilir hale getirmek için, performansında küçük bir maliyetle modelin boyutunu azaltan ve daha az güçlü donanımlarda çalışmasına olanak tanıyan niceleme gibi teknikleri kullanabilirsiniz.

📚 Ayrıca okuyun: AI'da LLM Ajanları Nedir ve Nasıl Çalışır?

Metin-görüntü ve çok modlu modeller

Verileriniz her zaman sadece metin değildir. Takımınızın bir pazarlama kampanyası için görseller oluşturması, bir toplantının ses kaydını metne dönüştürmesi veya bir videosunun içeriğini anlaması gerekebilir. İşte bu noktada, farklı veri türlerinde çalışmak üzere tasarlanmış çok modlu modeller hayati önem kazanır.

En popüler multimodal model türü, metin açıklamalarından görüntüler üreten metinden görüntüye modelidir. Stable Diffusion gibi modeller, difüzyon adı verilen bir teknik kullanarak basit komutlardan çarpıcı görseller oluşturur. Ancak olanaklar, görüntü oluşturmanın çok ötesine uzanır.

Hugging Face'ten dağıtabileceğiniz diğer yaygın multimodal modeller şunlardır:

- Resim altyazısı: Resimler için açıklayıcı metinleri otomatik olarak oluşturun; bu, erişilebilirlik ve içerik yönetimi için mükemmeldir.

- Konuşma tanıma: OpenAI'nin Whisper gibi modellerle konuşulan sesi yazılı metne dönüştürün.

- Görsel soru cevaplama: Bir görüntü hakkında sorular sorun ve "Bu fotoğraftaki arabanın rengi nedir?" gibi metin tabanlı cevaplar alın.

LLM'ler gibi, bu modeller de hesaplama açısından yoğundur ve genellikle verimli bir şekilde çalışmak için GPU gerektirir.

📚 Ayrıca okuyun: Çarpıcı Görseller Oluşturmak için 50'den Fazla AI Görüntü İpucu

Bu farklı AI model türlerinin pratik iş uygulamalarına nasıl dönüştüğünü görmek için, çeşitli sektörler ve fonksiyonlardaki gerçek dünya AI kullanım örneklerinin genel bakışını izleyin.

Kuruluşunuzun AI olgunluk seviyesi nedir?

316 profesyonel ile yaptığımız anket, gerçek AI dönüşümünün sadece AI özelliklerini benimsemekten daha fazlasını gerektirdiğini ortaya koyuyor. AI olgunluk değerlendirmesini yaparak kuruluşunuzun durumunu ve puanınızı iyileştirmek için yapılacakları öğrenin.

AI Dağıtımı için Hugging Face'i Ayarlama

İlk modelinizi dağıtmadan önce, yerel ortamınızı ve Hugging Face hesabınızı doğru şekilde kurmanız gerekir. Farklı üyelerin tutarsız kurulumları olması, klasik "benim makinemde çalışıyor" sorununa yol açarak takımlar için yaygın bir sıkıntı kaynağıdır. Bu süreci standartlaştırmak için birkaç dakika ayırmak, daha sonra saatlerce süren sorun giderme çalışmalarından kurtarır.

- Hugging Face hesabı oluşturun ve erişim belirteci oluşturun. Öncelikle, Hugging Face web sitesinde ücretsiz bir hesap açın. Giriş yaptıktan sonra profilinize gidin, "Ayarlar"ı tıklayın ve ardından "Erişim Belirteçleri" sekmesine gidin. En az "okuma" izinlerine sahip yeni bir belirteç oluşturun; modelleri indirmek için buna ihtiyacınız olacak.

- Gerekli Python kütüphanelerini yükleyin. Terminalinizi açın ve ihtiyacınız olan temel kütüphaneleri yükleyin. İki temel kütüphane transformers ve huggingface_hub'dır. Bunları pip kullanarak yükleyebilirsiniz: pip install transformers huggingface_hub

- Kimlik doğrulamayı yapılandırın. Erişim belirteçinizi kullanmak için, huggingface-cli login komutunu çalıştırarak komut satırı üzerinden oturum açabilir ve istendiğinde belirteçinizi yapıştırabilir veya sisteminizde bir ortam değişkeni olarak ayarlayabilirsiniz. Komut satırı üzerinden oturum açmak, genellikle başlamak için en kolay yoldur.

- Kurulumu doğrulayın. Her şeyin çalıştığını doğrulamanın en iyi yolu, basit bir kod parçası çalıştırmaktır. Transformatör kütüphanesinden pipeline fonksiyonunu kullanarak temel bir model yüklemeyi deneyin. Hata olmadan çalışırsa, kullanıma hazırsınız demektir.

Hub'daki bazı modellerin "kapalı" olduğunu unutmayın; bu, belirteçinizle erişebilmeniz için modelin sayfasında lisans koşullarını kabul etmeniz gerektiği anlamına gelir.

Ayrıca, kimin hangi kimlik bilgilerine sahip olduğunu ve hangi ortam yapılandırmalarının kullanıldığını izlemenin başlı başına bir proje yönetimi görevi olduğunu ve takımınız büyüdükçe bunun daha da önemli hale geldiğini unutmayın.

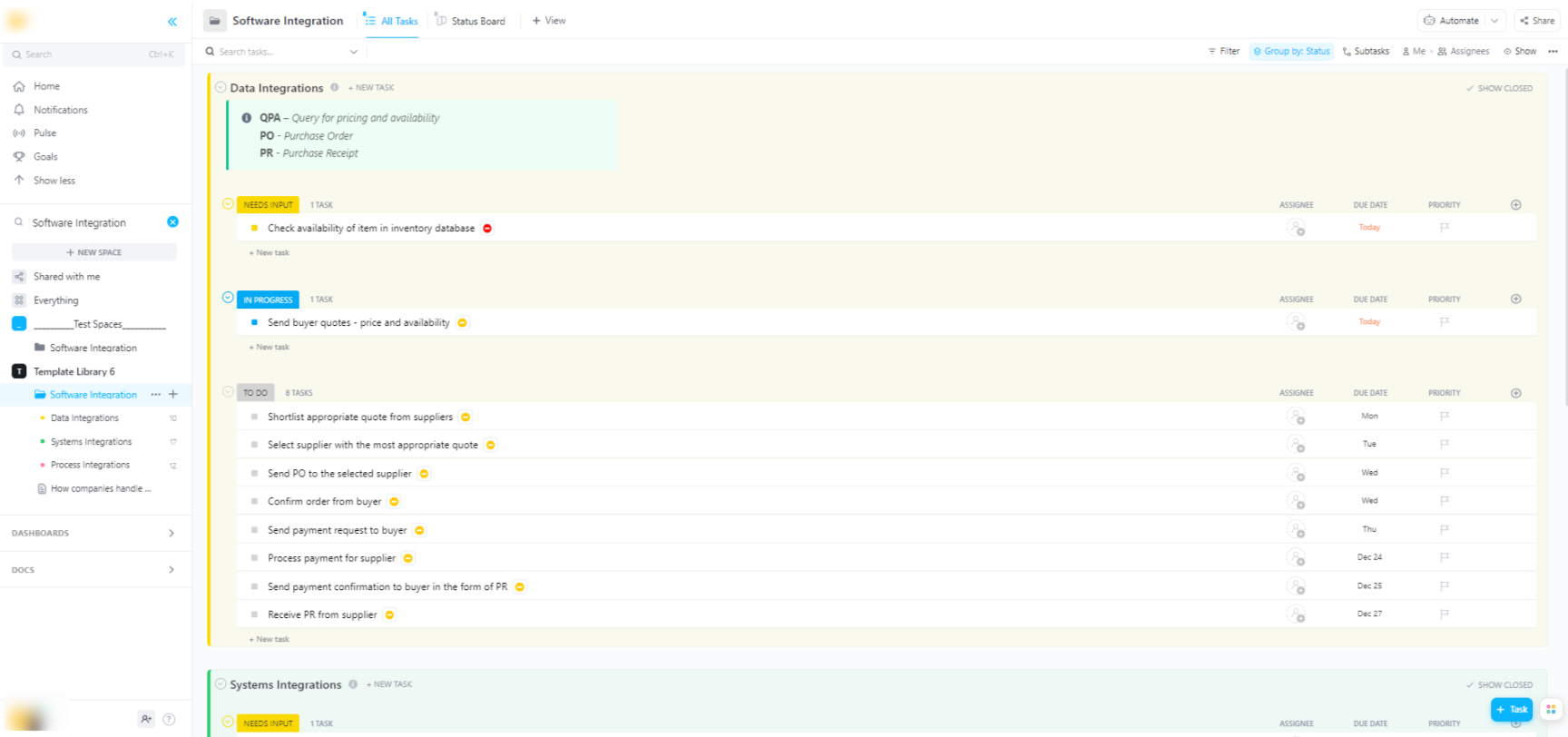

🌟 Hugging Face modellerini daha geniş yazılım sistemlerine entegre ediyorsanız, ClickUp'ın Yazılım Entegrasyon Şablonu ş akışlarını görselleştirmenize ve çok adımlı teknik entegrasyonları izlemenize yardımcı olur.

Şablon, aşağıdakileri yapabileceğiniz, takip etmesi kolay bir sistem sunar:

- Farklı yazılım çözümleri arasındaki bağlantıları görselleştirin

- Daha sorunsuz bir işbirliği için görevler oluşturun ve bunları takım üyelerine atayın.

- Entegrasyonlarla ilgili tüm görevleri tek bir yerde düzenleyin

Hugging Face Modellerinin Dağıtım Seçenekleri

Bir modeli yerel olarak test ettikten sonra, bir sonraki soru şudur: model nerede barındırılacak? Bir modeli, başkaları tarafından kullanılabileceği bir üretim ortamına dağıtmak kritik bir adımdır, ancak seçenekler kafa karıştırıcı olabilir. Yanlış yolu seçmek, yavaş performans, yüksek maliyetler veya kullanıcı trafiğini kaldıramama gibi sorunlara yol açabilir.

Seçiminiz, beklenen trafik, bütçe ve hızlı bir prototip mi yoksa ölçeklenebilir, üretime hazır bir uygulama mı geliştirdiğiniz gibi özel ihtiyaçlarınıza bağlı olacaktır.

Hugging Face Spaces

Hızlı bir şekilde bir demo veya dahili araç oluşturmanız gerekiyorsa, Hugging Face Spaces genellikle en iyi seçimdir. Spaces, makine öğrenimi uygulamalarını barındırmak için ücretsiz bir platformdur ve takımınızla veya paydaşlarınızla paylaşabileceğiniz prototipler oluşturmak için mükemmeldir.

Gradio veya Streamlit gibi popüler çerçeveleri kullanarak uygulamanızın kullanıcı arayüzünü oluşturabilirsiniz. Bu sayede, sadece birkaç satır Python kodu ile etkileşimli demolar oluşturmak çok kolay hale gelir.

Bir Alan oluşturmak, tercih ettiğiniz SDK'yı seçmek, Git deposu ile kodunuzun bağlantısını kurmak ve donanımınızı seçmek kadar basittir. Spaces, temel uygulamalar için ücretsiz bir CPU katmanı sunarken, daha zorlu modeller için ücretli GPU donanımına yükseltebilirsiniz.

Sınırlamaları unutmayın:

- Yüksek trafiğe sahip API'ler için uygun değildir: Spaces, binlerce eşzamanlı API isteğini karşılamak için değil, demolar için tasarlanmıştır.

- Soğuk başlatma: Alanınız etkin değilse, kaynakları korumak için "uyku moduna" geçebilir ve bu da ona tekrar erişen ilk kullanıcı için gecikmeye neden olabilir.

- Git tabanlı iş akışı: Tüm uygulama kodunuz, sürüm kontrolü için ideal olan bir Git deposu aracılığıyla yönetilir.

Hugging Face Inference API

Bir modeli mevcut bir uygulamaya entegre etmeniz gerektiğinde, muhtemelen bir API kullanmak isteyeceksiniz. Hugging Face Inference API, altta yatan altyapıyı kendiniz yönetmenize gerek kalmadan modelleri çalıştırmanıza olanak tanır. Verilerinizle birlikte bir HTTP isteği göndermeniz ve tahmin sonucunu almanız yeterlidir.

Bu yaklaşım, sunucular, ölçeklendirme veya bakım ile uğraşmak istemediğinizde idealdir. Hugging Face, bu hizmet için iki ana seviye sunar:

- Ücretsiz Çıkarım API'si: Bu, geliştirme ve test için ideal olan, hız sınırlamalı, paylaşımlı bir altyapı seçeneğidir. Trafiğin az olduğu kullanım durumları veya yeni başladığınız durumlar için mükemmeldir.

- Çıkarım Uç Noktaları: Üretim uygulamaları için Çıkarım Uç Noktaları'nı kullanmak isteyeceksiniz. Bu, size özel, otomatik ölçeklendirme altyapısı sağlayan ücretli bir hizmettir ve uygulamanızın yoğun yük altında bile hızlı ve güvenilir olmasını sağlar.

API'yi kullanmak, istek başlığında kimlik doğrulama belirteçinizle birlikte modelin uç nokta URL'sine bir JSON yükü göndermek anlamına gelir.

Bulut platformu dağıtımı

Amazon Web Services (AWS), Google Cloud Platform (GCP) veya Microsoft Azure gibi büyük bir bulut sağlayıcısında zaten önemli bir varlığa sahip olan takımlar için, bu platformlarda dağıtım yapmak en mantıklı seçim olabilir. Bu yaklaşım size en fazla kontrolü sağlar ve modeli mevcut bulut hizmetlerinizle ve güvenlik protokollerinizle entegre etmenize olanak tanır.

Genel iş akışı, Docker kullanarak modelinizi ve bağımlılıklarını "konteynerize etmek" ve ardından bu konteyneri bir bulut bilgi işlem hizmetine dağıtmaktan oluşur. Her bulut sağlayıcısı, bu süreci basitleştiren hizmetler ve entegrasyonlara sahiptir:

- AWS SageMaker: Hugging Face modellerinin eğitimi ve dağıtımı için yerel entegrasyonlar sunar.

- Google Bulut Vertex AI: Hub'dan yönetilen uç noktalara modeller dağıtmanıza olanak tanır.

- Azure Machine Learning: Hugging Face modellerini içe aktarmak ve sunmak için araçlar sağlar.

Bu yöntem daha fazla kurulum ve DevOps uzmanlığı gerektirse de, ortam üzerinde tam kontrol sahibi olmanız gereken büyük ölçekli, kurumsal düzeyde dağıtımlar için genellikle en iyi seçenektir.

Çıkarım için Hugging Face Modellerini Çalıştırma

AI dağıtımı için Hugging Face'i kullanırken, "çıkarım çalıştırma" eğitilmiş modelinizi yeni, görülmemiş veriler üzerinde tahminlerde bulunmak için kullanma sürecidir. Bu, modelinizin onu dağıtmak için yaptığınız işi yaptığı andır. Bu adımı doğru yapmak, duyarlı ve verimli bir uygulama oluşturmak için çok önemlidir.

Takımlar için en büyük hayal kırıklığı, yavaş veya verimsiz olan ve kötü bir kullanıcı deneyimi ile yüksek operasyonel maliyetlere yol açabilen çıkarım kodu yazmaktır. Neyse ki, transformers kütüphanesi, her biri basitlik ve kontrol arasında kendi avantaj ve dezavantajlarına sahip olan çeşitli çıkarım yürütme yöntemleri sunar.

- Pipeline API: Bu, başlamak için en kolay ve en yaygın yoldur. Pipeline() fonksiyonu, veri ön işleme, model iletme ve son işlemeyi sizin için gerçekleştirerek karmaşıklığın çoğunu ortadan kaldırır. Duygu analizi gibi birçok standart görev için, yalnızca bir satır kodla tahmin elde edebilirsiniz.

- AutoModel + AutoTokenizer: Çıkarım sürecini daha fazla kontrol etmeniz gerektiğinde, AutoModel ve AutoTokenizer sınıflarını doğrudan kullanabilirsiniz. Bu, metninizi nasıl belirteçlere ayıracağınızı ve modelin ham çıktısını nasıl insan tarafından okunabilir bir tahmine dönüştüreceğinizi manuel olarak yönetmenizi sağlar. Bu yaklaşım, özel bir görev üzerinde iş yaparken veya belirli bir ön veya son işlem mantığını uygulamak gerektiğinde kullanışlıdır.

- Toplu işleme: Verimliliği en üst düzeye çıkarmak için, özellikle GPU'da, girdileri tek tek değil, toplu olarak işlemelisiniz. Tek bir ileri geçişte model aracılığıyla bir grup girdi göndermek, her birini ayrı ayrı göndermekten çok daha hızlıdır.

Çıkarım kodunuzun performansını izlemek, dağıtım yaşam döngüsünün anahtar bir parçasıdır. Gecikme süresi (bir tahminin ne kadar sürdüğü) ve verim (saniyede kaç tahmin yapabileceğiniz) gibi metrikleri izlemek, özellikle farklı takım üyeleri yeni model sürümlerini denerken, koordinasyon ve net dokümantasyon gerektirir.

📚 Ayrıca okuyun: Kullanılacak En İyi AI Takım İşbirliği Araçları

Adım Adım Örnek: Hugging Face Modelini Dağıtma

Basit bir duygu analizi modelini dağıtmanın tam bir örneğini inceleyelim. Bu adımları izleyerek, model seçiminden canlı, test edilebilir bir uç noktaya ulaşabilirsiniz.

- Modelinizi seçin: Hugging Face Hub'a gidin ve soldaki filtreleri kullanarak "Metin Sınıflandırma" işlevi gören modelleri arayın. İyi bir başlangıç noktası distilbert-base-uncased-finetuned-sst-2-english modelidir. Model kartını okuyarak performansını ve nasıl kullanıldığını öğrenin.

- Bağımlılıkları yükleyin: Yerel Python ortamınızda gerekli kütüphanelerin yüklü olduğundan emin olun. Bu model için sadece transformers ve torch'a ihtiyacınız olacak. pip install transformers torch komutunu çalıştırın.

- Yerel olarak test edin: Dağıtımdan önce, modelin makinenizde beklendiği gibi çalıştığından her zaman emin olun. Pipeline'ı kullanarak modeli yüklemek için küçük bir Python komut dosyası yazın ve örnek bir cümle ile test edin. Örneğin: classifier = pipeline("sentiment-analysis", model="distilbert-base-uncased-finetuned-sst-2-english") ve ardından classifier("ClickUp en iyi verimlilik platformudur!")

- Dağıtım oluşturma: Bu örnekte, hızlı ve kolay bir dağıtım için Hugging Face Spaces'ı kullanacağız. Yeni bir Alan oluşturun, Gradio SDK'yı seçin ve modelinizi yükleyen ve onunla etkileşim kurmak için basit bir Gradio arayüzü tanımlayan bir uygulama.py dosyası oluşturun.

- Dağıtımı doğrulayın: Alanınız çalışmaya başladığında, etkileşimli arayüzü kullanarak test edebilirsiniz. Ayrıca, alanın uç noktasına doğrudan API isteği göndererek JSON yanıtı alabilir ve programın çalıştığını doğrulayabilirsiniz.

Bu adımları tamamladıktan sonra, canlı bir modele sahip olursunuz. Projenin bir sonraki aşaması, modelin kullanımını izlemek, güncellemeleri planlamak ve model popüler hale gelirse altyapıyı ölçeklendirmek olacaktır.

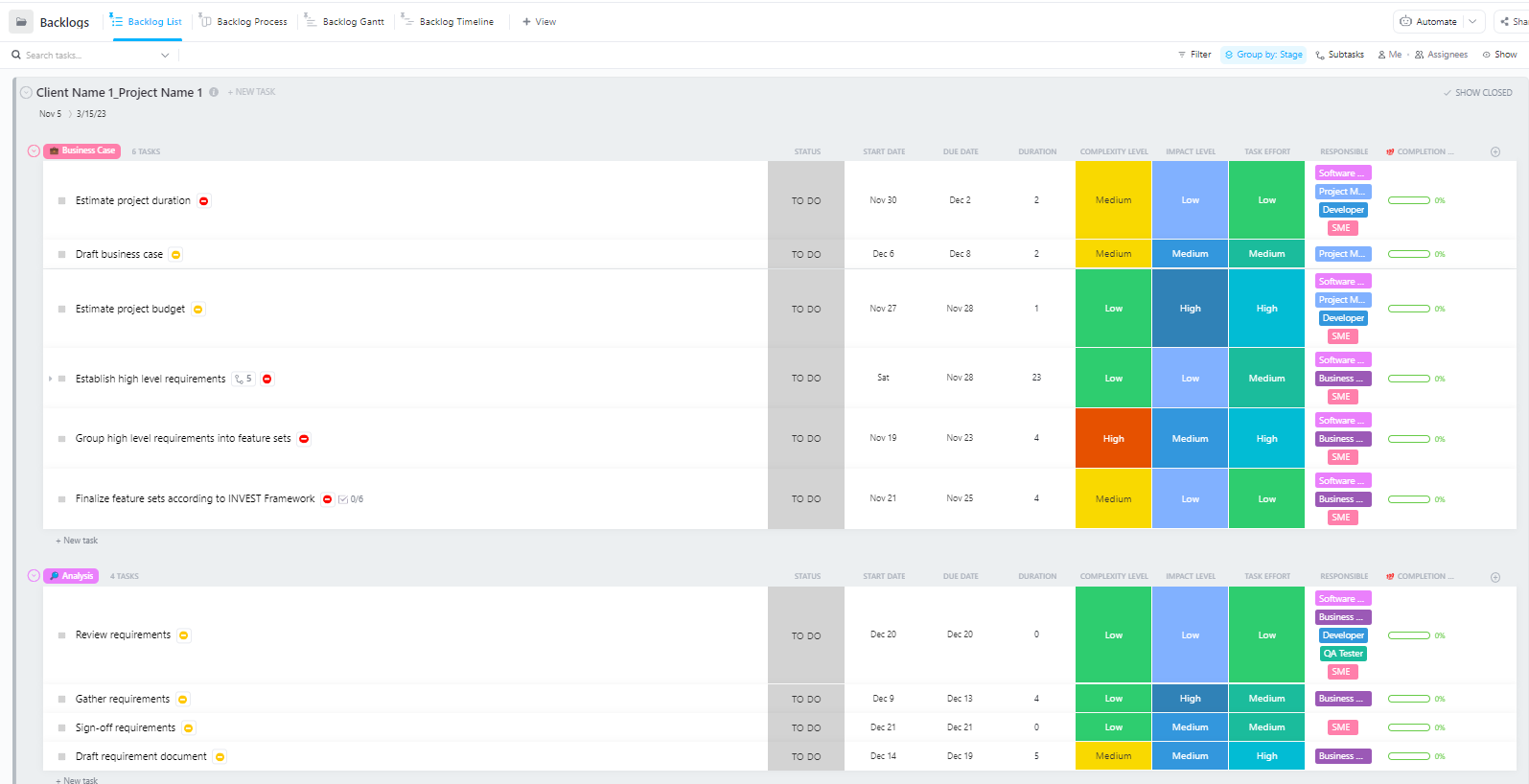

Karmaşık AI dağıtım projeleri için, veri hazırlığından üretim dağıtımına kadar birçok aşama içeren takımlar için ClickUp'ın Yazılım Proje Yönetimi Gelişmiş Şablonu kapsamlı bir yapı sunar.

Bu şablon, takımlara şu konularda yardımcı olur:

- Birden fazla dönüm noktası, görev, kaynak ve bağımlılık içeren projeleri yönetin

- Gantt grafikleri ve zaman çizelgeleriyle proje ilerlemesini görselleştirin.

- Ekip arkadaşlarınızla sorunsuz bir şekilde işbirliği yaparak projenin başarıyla tamamlanmasını sağlayın.

Hugging Face Dağıtımında Sık Karşılaşılan Zorluklar ve Bunları Çözme Yöntemleri

Net bir planınız olsa bile, dağıtım sırasında birkaç engelle karşılaşmanız muhtemeldir. Anlaşılmaz bir hata mesajına bakmak son derece sinir bozucu olabilir ve takımınızın ilerlemesini durdurabilir. İşte en yaygın zorluklardan bazıları ve bunların çözüm yolları. 🛠️

🚨Sorun: "Model kimlik doğrulama gerektiriyor"

- Neden: Lisans koşullarını kabul etmenizi gerektiren "kapalı" bir modele erişmeye çalışıyorsunuz.

- Çözüm: Hub'daki modelin sayfasına gidin, lisans sözleşmesini okuyun ve kabul edin. Kullandığınız erişim belirteçinin "okuma" izinlerine sahip olduğundan emin olun.

🚨Sorun: "CUDA bellek yetersiz"

- Neden: Yüklemeye çalıştığınız model, GPU'nuzun belleği (VRAM) için çok büyük.

- Çözüm: En hızlı çözüm, modelin daha küçük bir sürümünü veya nicelendirilmiş bir sürümünü kullanmaktır. Ayrıca, çıkarım sırasında toplu iş boyutunu küçültmeyi de deneyebilirsiniz.

🚨Sorun: "trust_remote_code hata"

- Neden: Hub'daki bazı modellerin çalışması için özel kod gerekir ve güvenlik nedenleriyle kütüphane bunu ön tanımlı olarak yürütmez.

- Çözüm: Modeli yüklerken trust_remote_code=True ekleyerek bu sorunu aşabilirsiniz. Ancak, güvenli olduğundan emin olmak için her zaman önce kaynak kodunu gözden geçirmelisiniz.

🚨Sorun: "Belirteç uyuşmazlığı"

- Neden: Kullandığınız tokenizer, modelin eğitildiği tokenizer ile tam olarak aynı değildir, bu da hatalı girdilere ve düşük performansa neden olur.

- Çözüm: Tokenizer'ı her zaman modelin kendisiyle aynı model kontrol noktasından yükleyin. Örneğin, AutoTokenizer. from_pretrained("model-name")

🚨Sorun: "Hız sınırı aşıldı"

- Neden: Kısa bir dönemde ücretsiz Inference API'ye çok fazla istek gönderdiniz.

- Çözüm: Üretim kullanımı için, özel bir Inference Endpoint'e yükseltin. Geliştirme için, aynı isteği birden çok kez göndermekten kaçınmak için önbellekleme uygulayabilirsiniz.

Hangi çözümlerin hangi sorunlar için işe yaradığını izlemek çok önemlidir. Bu bulguları belgelemek için merkezi bir yer olmadan, takımlar genellikle aynı sorunu tekrar tekrar çözmek zorunda kalırlar.

📮 ClickUp Insight: Her 4 çalışandan 1'i, iş yerinde bağlam oluşturmak için dört veya daha fazla araç kullanıyor. Önemli bir ayrıntı bir e-postada gizli kalabilir, bir Slack konu dizisinde genişletilebilir ve ayrı bir araçta belgelenebilir, bu da takımların işlerini yapmak yerine bilgi aramakla zaman kaybetmelerine neden olabilir.

ClickUp, tüm iş akışınızı tek bir platformda birleştirir. ClickUp E-posta Proje Yönetimi, ClickUp Sohbet, ClickUp Belgeler ve ClickUp Brain gibi özelliklerle her şey birbirine bağlı, senkronize ve anında erişilebilir hale gelir. "İşle ilgili işlere" veda edin ve verimlilik zamanınızı geri kazanın.

💫 Gerçek Sonuçlar: Takımlar, ClickUp'ı kullanarak eski bilgi yönetimi süreçlerini ortadan kaldırarak her hafta 5 saatten fazla zaman kazanabiliyorlar. Bu, kişi başına yıllık 250 saatten fazla bir zaman tasarrufu anlamına geliyor. Takımınızın her çeyrekte fazladan bir hafta daha verimlilikle neler yaratabileceğini bir düşünün!

ClickUp'ta AI Dağıtım Projelerini Yönetme

AI dağıtımı için Hugging Face'i kullanmak, modelleri paketlemeyi, barındırmayı ve sunmayı kolaylaştırır, ancak gerçek dünyadaki dağıtımın koordinasyon yükünü ortadan kaldırmaz. Takımlar hala hangi modellerin test edildiğini izlemek, yapılandırmaları uyumlu hale getirmek, kararları belgelemek ve ML mühendislerinden ürün ve operasyon ekibine kadar herkesin aynı sayfada olmasını sağlamak zorundadır.

Mühendislik takımınız farklı modelleri test ederken, ürün ekibiniz gereksinimleri belirlerken ve paydaşlar güncellemeler isterken, bilgiler Slack, e-posta, elektronik tablolar ve çeşitli belgelere dağılır.

Bu iş dağınıklığı —birbiriyle iletişim kurmayan, birbirinden bağımsız birden fazla araçta iş faaliyetlerinin parçalanması—karışıklığa neden olur ve herkesin işini yavaşlatır.

Dünyanın ilk Birleşik AI Çalışma Alanı olan ClickUp, proje yönetimi, dokümantasyon ve takım iletişimini tek bir çalışma alanına getirerek burada anahtar bir rol oynar.

Bu yakınsama, teknik ve teknik olmayan paydaşların beş farklı araçta çalışmak zorunda kalmadan paylaşılan görünürlük gerektiren AI dağıtım projeleri için özellikle değerlidir.

Güncellemeleri biletlere, belgelere ve sohbet konularına dağıtmak yerine, takımlar tüm dağıtım yaşam döngüsünü tek bir yerden yönetebilir.

ClickUp, AI dağıtım projenizi şu şekilde destekleyebilir:

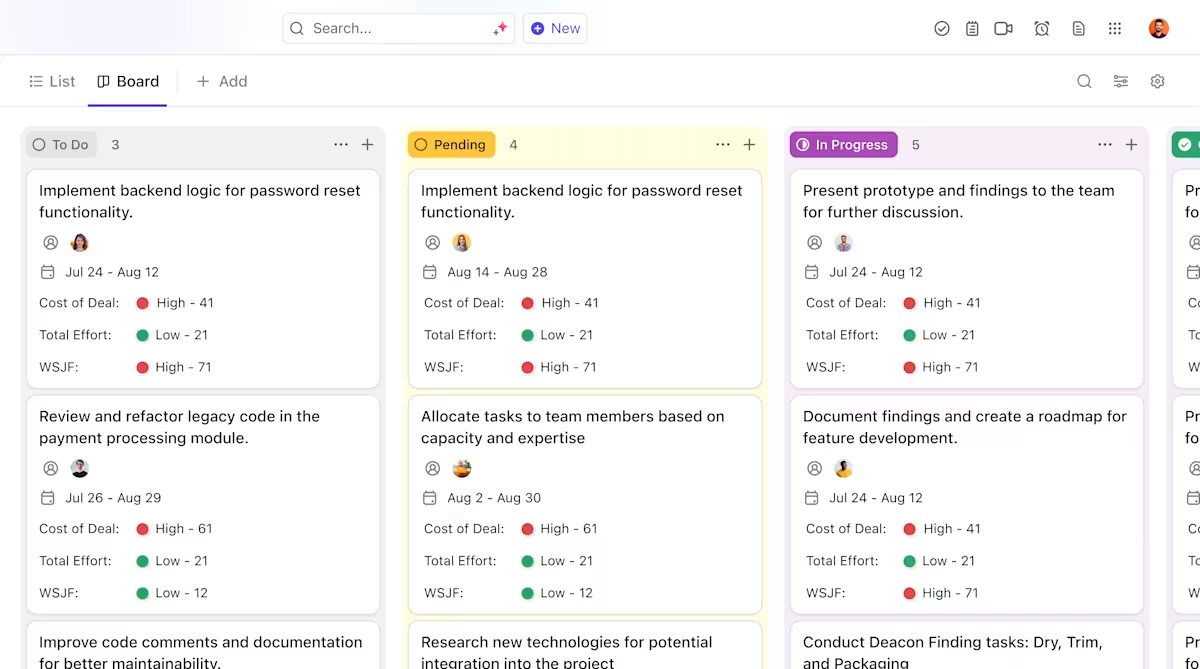

- Model yaşam döngüleri boyunca net sahiplik ve izleme: ClickUp görevlerini kullanarak Hugging Face modellerini değerlendirme, test, hazırlık ve üretim aşamalarında takip edin; tüm takım tarafından görülebilen özel durumlar, sahipler ve engelleyiciler ile.

- Merkezi, canlı dağıtım belgeleri: Dağıtım çalışma kitaplarını, ortam yapılandırmalarını ve sorun giderme kılavuzlarını ClickUp Docs'ta saklayın, böylece belgeler modellerinizle birlikte gelişir ve arama ve referanslama kolaylığı sağlar. Belgeler görevlerle bağlantılı olduğundan, belgeleriniz ilgili işlerin hemen yanında yer alır.

- İş yükünü artırmadan bağlam içinde işbirliği: Tartışmaları, kararları ve güncellemeleri doğrudan görevler ve belgelerle ilişkilendirerek, dağınık Slack konularına, e-postalara ve bağlantısız proje araçlarına olan bağımlılığı azaltın.

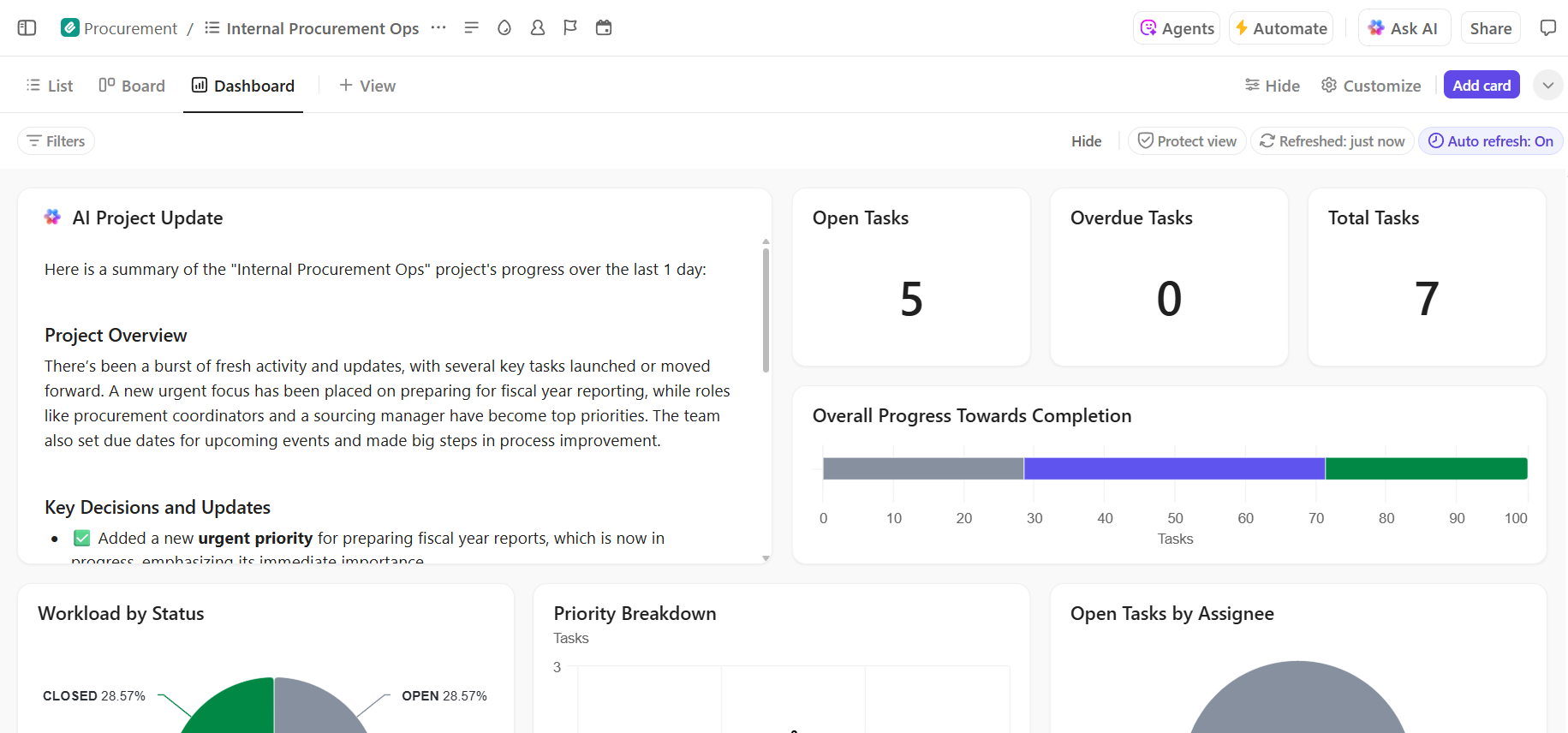

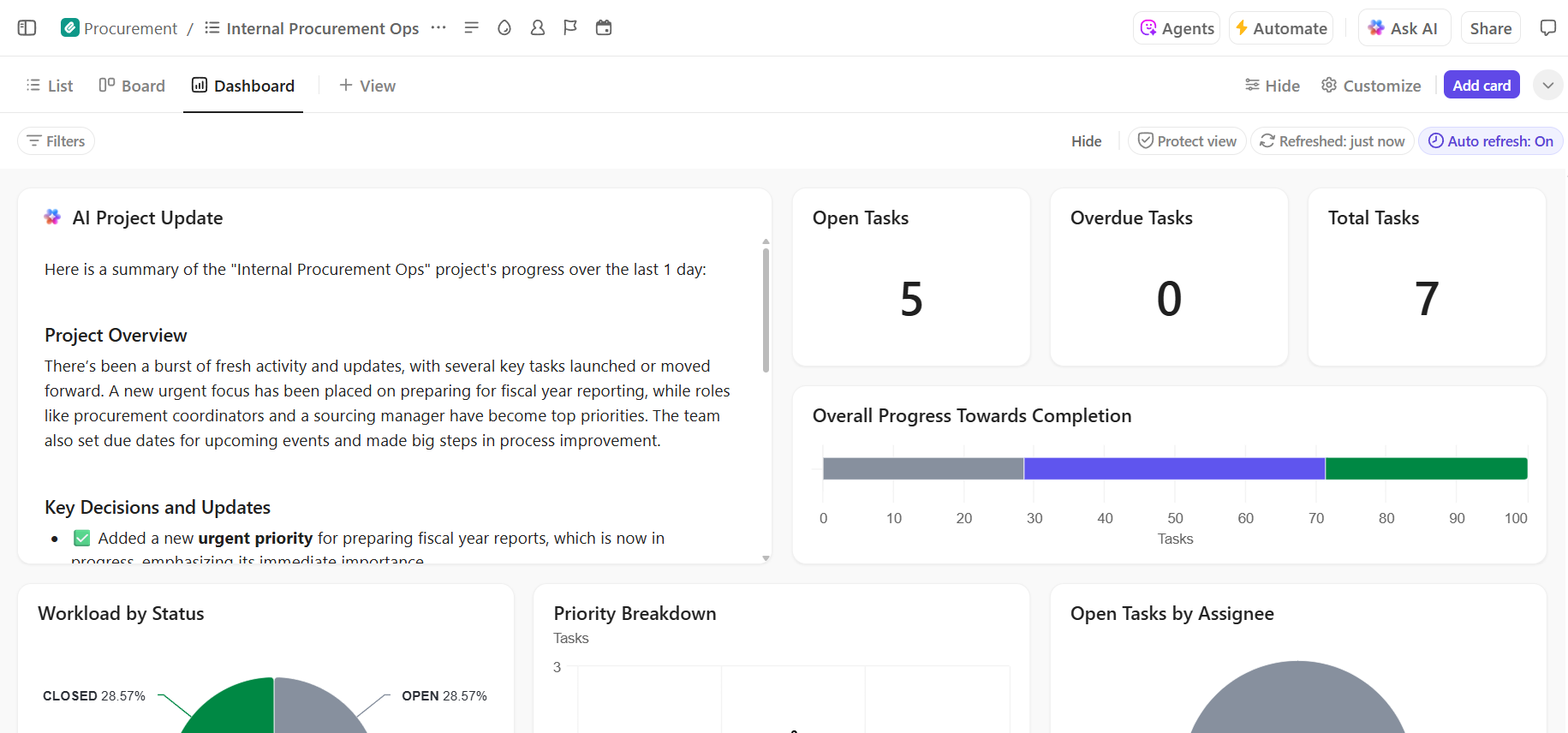

- Dağıtım sürecine ilişkin uçtan uca görünürlük: Gerçek zamanlı ilerlemeyi ve darboğazları gösteren ClickUp gösterge panellerini kullanarak dağıtım sürecini izleyin, riskleri erken tespit edin ve takım kapasitesini dengeleyin.

- Yerleşik AI ile daha hızlı katılım ve karar geri çağırma: ClickUp Brain'i kullanarak uzun dağıtım belgelerini özetleyin, geçmiş dağıtımlardan ilgili içgörüleri ortaya çıkarın ve yeni takım üyelerinin geçmiş bağlamı araştırmadan hızla uyum sağlamasına yardımcı olun.

ClickUp ile AI Dağıtım Projenizi Sorunsuz Bir Şekilde Yönetin

Hugging Face'in başarıyla kullanılması, sağlam bir teknik altyapı ve net, organize bir proje yönetimine bağlıdır. Teknik zorluklar çözülebilir olsa da, projelerin başarısız olmasına genellikle koordinasyon ve iletişim sorunları neden olur.

Tek bir platformda net bir iş akışı oluşturarak, takımınız daha hızlı sonuçlar elde edebilir ve bağlamın yayılması nedeniyle yaşanan sıkıntıları önleyebilir. Bağlamın yayılması, takımların bilgi aramak, uygulamalar arasında geçiş yapmak ve birden fazla platformda güncellemeleri tekrarlamak için saatler harcamasına neden olur.

İş için her şeyi içeren uygulama ClickUp, proje yönetimi, dokümantasyon ve takım iletişimini tek bir yerde bir araya getirerek, tüm AI dağıtım yaşam döngüsü için tek bir doğru kaynak sunar.

AI dağıtım projelerinizi bir araya getirin ve araç karmaşasını ortadan kaldırın. Bugün ClickUp ile ücretsiz olarak başlayın.

Sık Sorulan Sorular (SSS)

Evet, Hugging Face, Model Hub'a erişim, demolar için CPU destekli Spaces ve test için hız sınırlı Inference API'yi içeren cömert bir ücretsiz paket sunar. Özel donanım veya daha yüksek sınırlar gerektiren üretim ihtiyaçları için ücretli planlar mevcuttur.

Spaces, görsel bir ön uç ile etkileşimli uygulamaları barındırmak için tasarlanmıştır ve bu da onu demolar ve dahili araçlar için ideal hale getirir. Inference API, modellere programlı erişim sağlar ve bunları basit HTTP istekleri aracılığıyla uygulamalarınıza entegre etmenizi sağlar.

Kesinlikle. Hugging Face Spaces'te barındırılan etkileşimli demolar sayesinde, teknik bilgiye sahip olmayan takım üyeleri tek bir satır kod yazmadan modelleri deneyebilir ve geri bildirimde bulunabilir.

Ücretsiz katmanın temel sınırlamaları, Inference API'daki hız sınırlamaları, yavaş olabilen Spaces için paylaşılan CPU donanımının kullanımı ve etkin olmayan uygulamaların uyanması için bir süre beklemek zorunda kalınan "soğuk başlatmalar"dır. /