De meeste teams van ondernemingen die LLaMA verkennen, lopen op hetzelfde punt vast: ze downloaden de modelgewichten, staren naar een terminalvenster en beseffen dat ze geen idee hebben wat ze nu moeten doen.

Deze uitdaging komt veel voor: hoewel 88% van de bedrijven AI in ten minste één functie gebruikt, heeft slechts 7% dit op organisatiebreed niveau geschaald.

Deze handleiding loodst u door het volledige proces, van de selectie van de juiste modelgrootte voor uw gebruikssituatie tot het afstemmen ervan op de gegevens van uw bedrijf, zodat u een werkende AI-oplossing kunt implementeren die uw bedrijfscontext daadwerkelijk begrijpt.

Wat is LLaMA en waarom is het belangrijk voor Enterprise AI?

LLaMA (afkorting van Large Language Model Meta AI) is een familie van open-weight taalmodellen die door Meta is ontwikkeld. Op hoog niveau doet het dezelfde kernzaken als modellen als GPT of Gemini: het begrijpt taal, genereert tekst en kan redeneren op basis van informatie. Het grote verschil is hoe ondernemingen het kunnen gebruiken.

Omdat LLaMA open-weight is, zijn bedrijven niet gedwongen om er alleen via een black-box API mee te werken. Ze kunnen het op hun eigen infrastructuur draaien, het afstemmen op interne gegevens en bepalen hoe en waar het wordt geïmplementeerd.

Voor ondernemingen is dat een enorme stap, vooral wanneer gegevensprivacy, naleving en voorspelbaarheid van kosten belangrijker zijn dan nieuwigheid.

Deze flexibiliteit maakt LLaMA bijzonder aantrekkelijk voor teams die AI diep in hun werkstroom willen integreren, en niet alleen als een op zichzelf staande chatbot willen gebruiken. Denk aan interne kennisassistenten, automatisering van klantenservice, ontwikkelaarstools of AI-functies die rechtstreeks in producten zijn ingebouwd, zonder dat gevoelige gegevens buiten de organisatie worden verzonden.

Kortom, LLaMA is belangrijk voor AI voor ondernemingen omdat het teams keuze biedt op het gebied van implementatie, aanpassing en AI-integratie in echte bedrijfssystemen. En naarmate AI zich ontwikkelt van experiment naar dagelijkse bedrijfsvoering, wordt dat niveau van controle minder een 'nice to have' en meer een vereiste.

Aan de slag met LLaMA voor applicaties van ondernemingen

1. Definieer uw zakelijke use case voor de onderneming

Voordat u iets downloadt, moet u precies bepalen in welke werkstroommen AI echt een verschil kan maken. Het is belangrijk om de AI-toepassing af te stemmen op de modelgrootte: kleinere 8B-modellen zijn efficiënt voor eenvoudige taken, terwijl grotere 70B+-modellen beter zijn voor complexe redeneringen.

Bekijk dit overzicht van praktische AI-toepassingen in verschillende functies van ondernemingen en sectoren om u te helpen de juiste AI-toepassingen voor uw bedrijf te vinden:

Veelvoorkomende startpunten zijn onder meer:

- Documentverwerking: lange rapporten samenvatten of belangrijke informatie uit contracten halen

- Code-assistentie: genereren van standaardcode, uitleggen van verouderde systemen of voorstellen doen voor optimalisaties.

- Kennisopvraging: beantwoorden van vragen van medewerkers door interne documentatie te doorzoeken met behulp van een techniek die Retrieval-Augmented Generation (RAG) wordt genoemd.

- Contentgeneratie: het opstellen van eerste versies van communicatie- of marketingteksten

2. Stel vereisten en afhankelijkheden in

Zorg vervolgens dat uw hardware en software in orde zijn. De grootte van het model bepaalt uw behoeften; een LLaMA 8B-model vereist een GPU met ongeveer 15 GB VRAM, terwijl een 70B-model 131 GB of meer nodig heeft.

Uw softwarestack moet Python 3. 8+, PyTorch, CUDA-stuurprogramma's en het Hugging Face-ecosysteem (transformers, accelerate en bitsandbytes) bevatten.

3. Toegang tot en downloaden van LLaMA-modelgewichten

U kunt de modelgewichten downloaden van de officiële Llama-downloadpagina van Meta of de Hugging Face -modelhub. U moet de Llama 3 Community License accepteren, die commercieel gebruik toestaat. Afhankelijk van uw installatie downloadt u de gewichten in safetensors- of GGUF-format.

4. Configureer uw ontwikkelomgeving

Nu de gewichten zijn gedownload, is het tijd om uw omgeving in te stellen. Installeer de benodigde Python-bibliotheken, waaronder transformers, accelerate en bitsandbytes voor kwantisering – een proces dat het geheugengebruik van het model vermindert.

Laad het model met de juiste instellingen en voer een eenvoudige testprompt uit om te controleren of alles correct werkt voordat u verdergaat met het aangepaste ontwerp.

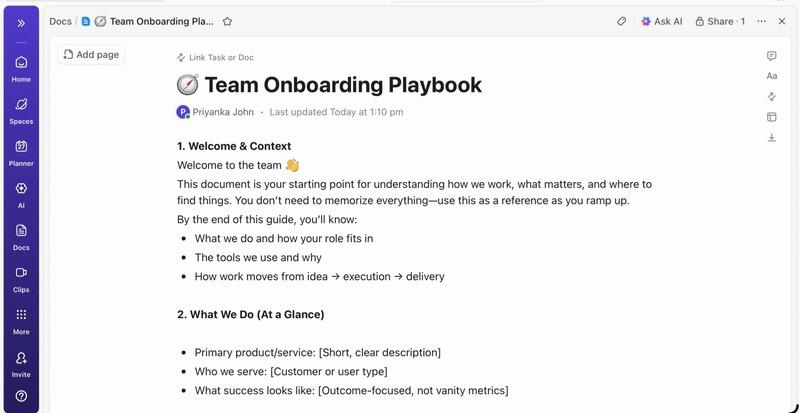

💡Als u geen speciaal ML-infrastructuurteam heeft, kan dit hele proces onhaalbaar zijn. Sla de complexe implementatie volledig over met ClickUp Brain. Het biedt AI-mogelijkheden zoals schrijfhulp en taaktautomatisering direct binnen de werkruimte waar uw team al werkt – zonder dat u modellen hoeft te downloaden of GPU's hoeft aan te schaffen.

Hoe u LLaMA kunt aanpassen voor uw gegevens van de onderneming

Het gebruik van een basis LLaMA-model is een goed begin, maar het begrijpt de unieke acroniemen, projectnamen of interne processen van uw bedrijf niet. Dit leidt tot generieke, onbruikbare antwoorden die geen oplossing bieden voor echte zakelijke problemen.

Enterprise AI wordt nuttig door aangepast maatwerk: het model trainen op basis van uw specifieke terminologie en kennisbank.

Bereid uw domeinspecifieke trainingsgegevens voor

Het succes van uw aangepaste AI hangt meer af van de kwaliteit van uw trainingsgegevens dan van de grootte van het model of de rekenkracht. Begin met het verzamelen en opschonen van uw interne informatie.

- Interne documentatie: verzamel productspecificaties, procesgidsen en beleidsdocumenten.

- Historische communicatie: verzamel e-mailsjablonen, reacties op supporttickets en samenvattingen van vergaderingen.

- Domeinterminologie: Stel woordenlijsten, afkortingen en branchespecifieke taal samen.

Zodra u deze informatie hebt verzameld, format u deze om in instructie-responsparen voor begeleide afstemming. Een instructie kan bijvoorbeeld zijn: "Vat dit supportticket samen", en de respons zou een duidelijke, beknopte samenvatting zijn. Deze stap is cruciaal om het model te leren hoe het specifieke taken met uw gegevens moet uitvoeren.

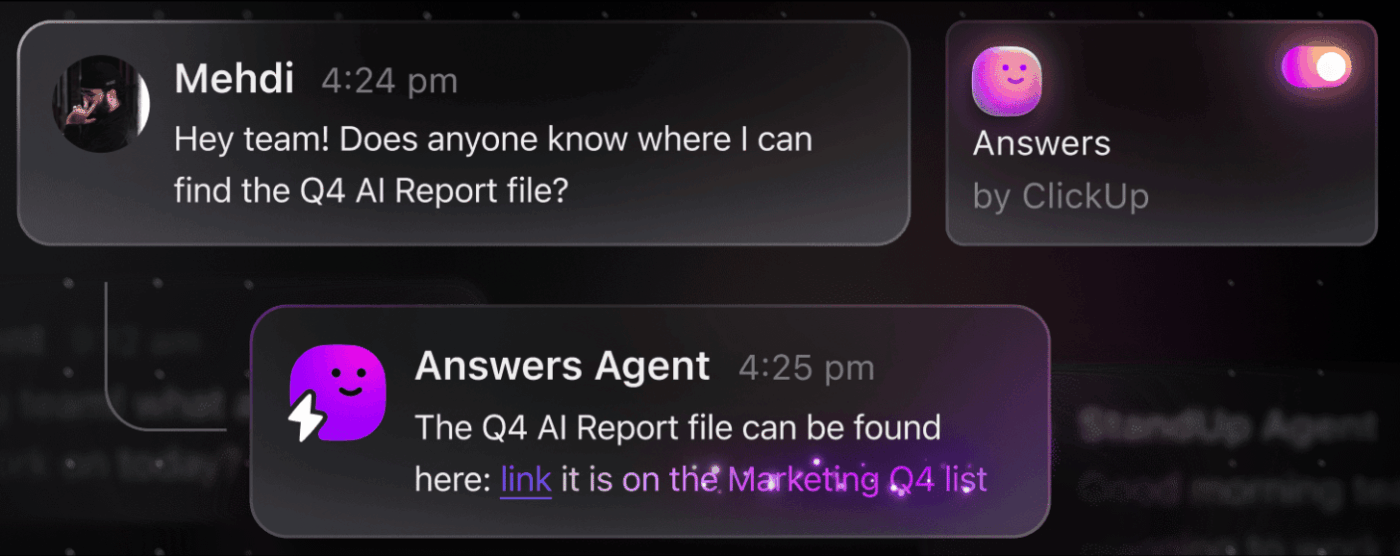

📮 ClickUp Insight: De gemiddelde professional besteedt meer dan 30 minuten per dag aan het zoeken naar werkgerelateerde informatie. Dat is meer dan 120 uur per jaar die verloren gaat aan het doorzoeken van e-mails, Slack-threads en verspreide bestanden. Een intelligente AI-assistent die in uw ClickUp-werkruimte is ingebouwd, kan daar verandering in brengen.

Maak kennis met ClickUp Brain. Het levert direct inzichten en antwoorden door binnen enkele seconden de juiste documenten, gesprekken en taakdetails naar boven te halen, zodat u kunt stoppen met zoeken en aan de slag kunt gaan.

💫 Echte resultaten: teams zoals QubicaAMF hebben met ClickUp meer dan 5 uur per week teruggewonnen – dat is meer dan 250 uur per jaar per persoon – door verouderde kennisbeheerprocessen te elimineren. Stel je eens voor wat je team zou kunnen creëren met een extra week productiviteit per kwartaal!

Verfijn LLaMA met uw Business-context

Afstemmen is het proces waarbij de bestaande kennis van LLaMA wordt aangepast aan uw specifieke gebruikssituatie, waardoor de nauwkeurigheid bij domeinspecifieke taken aanzienlijk wordt verbeterd. In plaats van een model helemaal opnieuw te trainen, kunt u parameter-efficiënte methoden gebruiken die slechts een klein deel van de parameters van het model bijwerken, waardoor u tijd en rekenkracht bespaart.

Populaire methoden voor het afstemmen zijn onder meer:

- LoRA (Low-Rank Adaptation): Deze methode traint kleine "adapter"-matrices in plaats van het hele model, waardoor het zeer efficiënt is.

- QLoRA: Dit combineert LoRA met kwantisering om afstemming mogelijk te maken op een enkele 48 GB GPU, terwijl de volledige afstemmingsprestaties behouden blijven.

- Volledige afstemming: hiermee worden alle parameters van het model bijgewerkt, wat de meest diepgaande aanpassing oplevert, maar ook aanzienlijke rekenkracht vereist.

Evalueer en herhaal de prestaties van het model

Hoe weet u of uw aangepaste model daadwerkelijk werkt? AI-evaluatie moet verder gaan dan eenvoudige nauwkeurigheidsscores en het nut in de praktijk meten. Creëer evaluatiedatasets die uw productiegebruiksscenario's weerspiegelen en houd statistieken bij die belangrijk zijn voor uw bedrijf, zoals responskwaliteit, feitelijke nauwkeurigheid en latentie.

- Kwalitatieve evaluatie: laat menselijke beoordelaars de output beoordelen op toon, bruikbaarheid en juistheid.

- Kwantitatieve statistieken: gebruik geautomatiseerde scores zoals BLEU of perplexiteit om prestaties op grote schaal bij te houden.

- Productiebewaking: houd na de implementatie gebruikersfeedback en foutpercentages bij om verbeterpunten te identificeren.

💡Dit iteratieve proces van training en evaluatie kan een project op zich worden. Beheer uw AI-ontwikkelingscyclus rechtstreeks in ClickUp in plaats van te verdwalen in spreadsheets.

Centraliseer prestatiestatistieken en evaluatieresultaten in één weergave met ClickUp Dashboards. Houd modelversies, trainingsparameters en evaluatiescores bij naast uw andere productwerk met aangepaste velden van ClickUp, zodat alles georganiseerd en zichtbaar blijft. 🛠️

Belangrijkste use cases voor LLaMA in de onderneming

Teams raken vaak verstrikt in analyseverlamming en slagen er niet in om de abstracte opwinding over AI om te zetten in concrete toepassingen. Dankzij zijn flexibiliteit is LLaMA geschikt voor een breed bereik aan werkstroomen in de onderneming, waardoor u taken kunt automatiseren en efficiënter kunt werken.

Hier zijn enkele van de belangrijkste gebruiksscenario's voor een aangepast LLaMA-model:

- Interne kennisassistenten: Verspil geen tijd meer met het zoeken naar informatie. Implementeer LLaMA met RAG om een chatbot te creëren die direct vragen van medewerkers kan beantwoorden door te zoeken in uw interne wiki's, beleidsdocumenten en eerdere projectcommunicatie.

- Automatisering van de klantenservice: verfijn een model op basis van uw ticketgeschiedenis om automatisch antwoorden op te stellen, vragen te categoriseren en complexe problemen door te geven aan de juiste medewerker.

- Codegeneratie en -controle: help uw engineeringteam efficiënter te werken. Gebruik LLaMA om standaardcode te genereren, verouderde systemen uit te leggen en zelfs potentiële bugs in pull-aanvragen te identificeren voordat ze problemen worden.

- Documentverwerking: zet grote hoeveelheden tekst om in bruikbare informatie. Vat lange rapporten samen, haal belangrijke termen uit juridische contracten of genereer binnen enkele seconden beknopte aantekeningen van vergaderingen op basis van ruwe transcripties.

- Werkstroom voor het aanmaken van content: Overwin writer's block. Stel marketingteksten, productbeschrijvingen en interne aankondigingen op die uw menselijke editors vervolgens kunnen verfijnen en perfectioneren.

💡Krijg direct toegang tot veel van deze use cases met ClickUp Brain.

- Samenvat taakthreads, stel projectupdates op en genereer content met de AI-aangedreven schrijfhulp van ClickUp.

- Vind direct antwoorden uit uw hele werkruimte met ClickUp's Enterprise Search en de vooraf gebouwde Ambient Answers -agent.

- Bouw intelligente werkstroomen die routinematig werk voor u afhandelen met ClickUp-automatiseringen.

Beperkingen van het gebruik van LLaMA voor AI in ondernemingen

Hoewel zelfhosting van LLaMA aanzienlijke controle biedt, is het niet zonder uitdagingen. Teams onderschatten vaak de operationele overhead en raken verstrikt in onderhoud in plaats van innovatie. Voordat u zich vastlegt op het 'bouw'-pad, is het cruciaal om de mogelijke hindernissen te begrijpen.

Hier zijn enkele sleutel-limieten waarmee u rekening moet houden:

- Infrastructuurvereisten: Het uitvoeren van grote modellen is duur en vereist krachtige GPU's van enterprise-kwaliteit die veel organisaties niet tot hun beschikking hebben.

- Vereiste technische expertise: voor het implementeren, afstemmen en onderhouden van een groot taalmodel zijn gespecialiseerde ML-engineeringvaardigheden vereist waar veel vraag naar is.

- Doorlopende onderhoudslast: Dit is geen oplossing die u eenmaal instelt en vervolgens kunt vergeten. Modellen moeten voortdurend worden gecontroleerd, updates voor veiligheid krijgen en opnieuw worden getraind naarmate uw Business zich ontwikkelt.

- Risico op hallucinaties: Net als alle LLM's kan LLaMA soms aannemelijk klinkende maar onjuiste informatie genereren. Toepassingen voor ondernemingen vereisen robuuste beveiligingsmaatregelen en menselijk toezicht om dit risico te beperken.

- Geen ingebouwde functies voor de onderneming: cruciale functies zoals toegangscontrole, auditlogging en compliance-tools moeten afzonderlijk worden gebouwd en beheerd, wat een extra laag van complexiteit toevoegt.

💡U kunt deze limieten omzeilen door ClickUp Brain te gebruiken. Dit biedt beheerde AI binnen uw bestaande werkruimte, waardoor u beschikt over AI-mogelijkheden voor ondernemingen zonder de operationele overhead. Profiteer van veiligheid op ondernemingsniveau en elimineer infrastructuuronderhoud met ClickUp, zodat uw team zich kan concentreren op zijn kernwerkzaamheden.

📮ClickUp Insight: 88% van de respondenten in onze enquête gebruikt AI voor persoonlijke taken, maar meer dan 50% schuwt het gebruik ervan op het werk. De drie belangrijkste belemmeringen? Gebrek aan naadloze integratie, kennislacunes of bezorgdheid over de veiligheid.

Maar wat als AI in uw werkruimte is ingebouwd en al veilig is? ClickUp Brain, de ingebouwde AI-assistent van ClickUp, maakt dit mogelijk. Het begrijpt prompts in gewone taal en lost alle drie de zorgen over AI-implementatie op, terwijl het uw chat, taken, documenten en kennis in de hele werkruimte met elkaar verbindt. Vind antwoorden en inzichten met één enkele klik!

Alternatieve AI-tools voor toepassingen in de onderneming

Het kiezen van de juiste AI-tool uit de vele beschikbare opties is een uitdaging voor elk team. U probeert de voor- en nadelen van verschillende modellen tegen elkaar af te wegen, maar u bent bang dat u de verkeerde kiest en middelen verspilt.

Dit leidt vaak tot AI-wildgroei – de ongeplande proliferatie van AI-tools en -platforms zonder toezicht of strategie – waarbij teams zich abonneren op meerdere losstaande diensten, waardoor er meer werk ontstaat in plaats van minder.

Hier volgt een kort overzicht van de belangrijkste spelers en waar ze thuishoren:

| Tool | Meest geschikt voor | Belangrijkste overwegingen |

|---|---|---|

| LLaMA (zelf gehost) | Maximale controle, gegevenssoevereiniteit | Vereist ML-infrastructuur en expertise |

| OpenAI GPT-4 | Hoogste capaciteit, minimale installatie | Gegevens verlaten uw omgeving, prijsstelling op basis van gebruik |

| Claude (Anthropic) | Taak met een lange context, focus op veiligheid | Vergelijkbare afwegingen als bij GPT-4 |

| Mistral | Europese gegevensopslag, efficiëntie | Kleiner ecosysteem dan LLaMA |

| ClickUp Brain | Geïntegreerde AI voor de werkruimte, geen implementatie nodig | Ideaal voor teams die AI willen integreren in bestaande werkstroomen. |

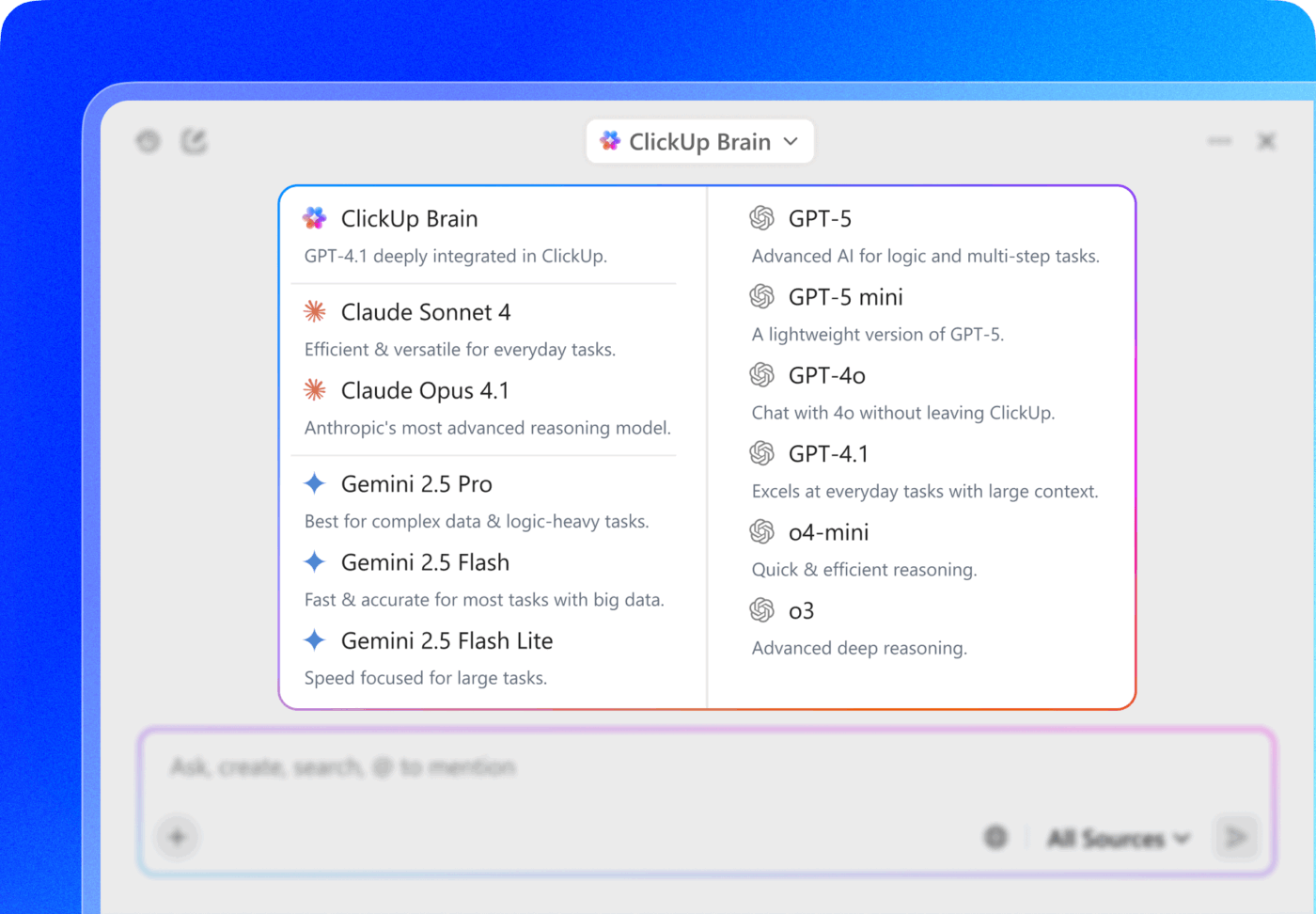

In plaats van meerdere tools aan elkaar te koppelen om aan uw behoeften te voldoen, kunt u ook rechtstreeks toegang krijgen tot AI op de plek waar u werkt. Dit is de kern van wat ClickUp biedt als 's werelds eerste Converged AI-werkruimte: één enkel, veilig platform waar projecten, documenten, gesprekken en analyses samenkomen.

Het brengt uw tools samen om contextversnippering tegen te gaan, de fragmentatie die ontstaat wanneer teams uren verspillen met het schakelen tussen apps en het zoeken naar de informatie die ze nodig hebben om hun werk te doen.

ClickUp + Contextuele AI = Meetbare transformatie

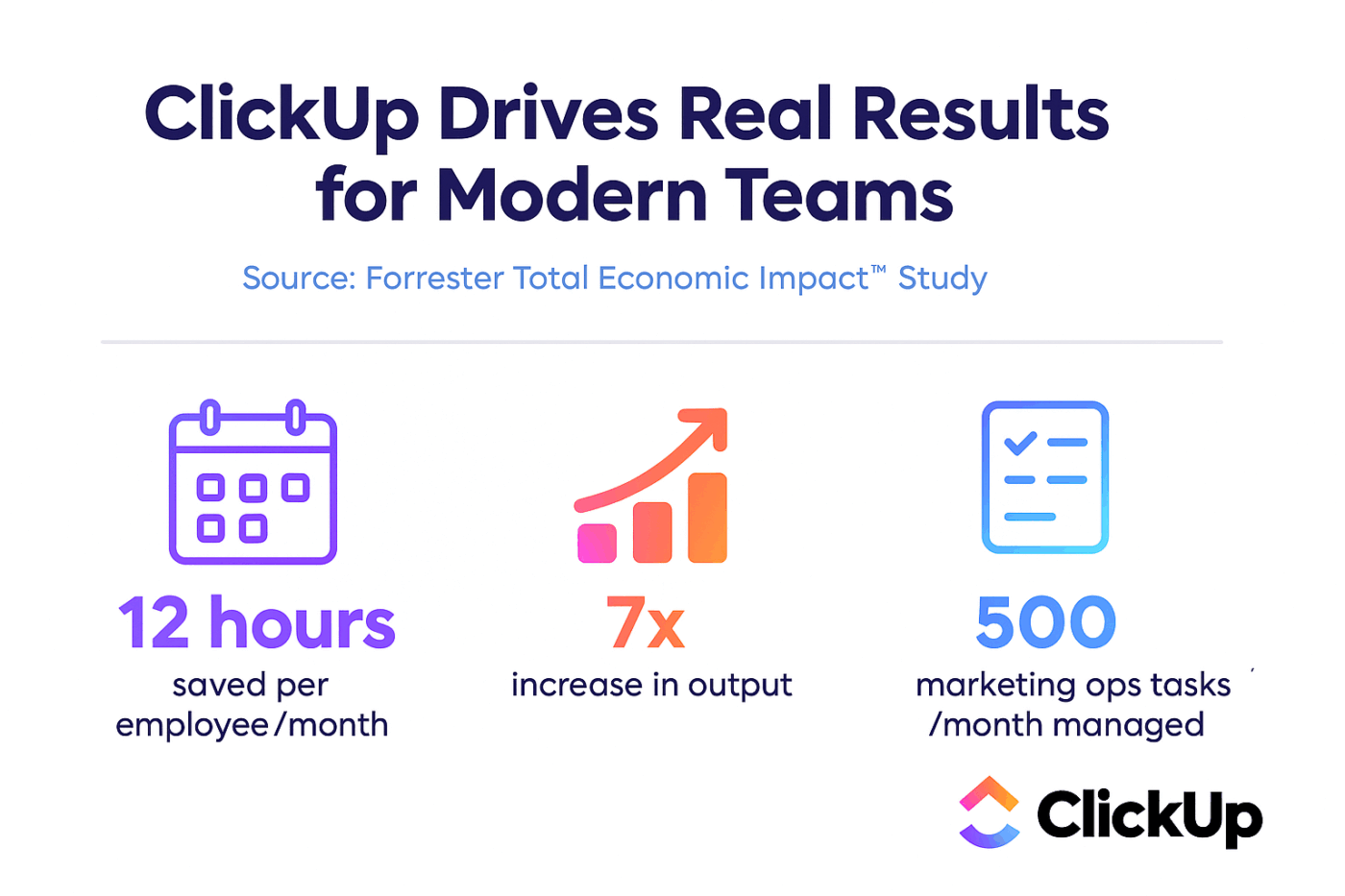

Volgens een onderzoek van Forrester Economic Impact™ realiseerden teams die ClickUp gebruikten een ROI van 384% en bespaarden ze 92.400 uur in het derde jaar.

Wanneer context, werkstroomen intelligentie op één plek samenkomen, werken teams niet alleen. Ze winnen.

ClickUp biedt ook de mogelijkheden voor veiligheid en beheer die nodig zijn voor implementaties in ondernemingen, met SOC 2 Type II-compliance, SSO-integratie, SCIM-provisioning en gedetailleerde toestemmingcontroles.

Met de multi-LLM-toegang van ClickUp Brain MAX kunt u rechtstreeks vanuit de zoekinterface kiezen tussen premiummodellen zoals ChatGPT, Claude en Gemini. Het platform stuurt uw query automatisch door naar het beste model voor de taak, zodat u het beste van alle werelden krijgt zonder meerdere abonnementen te hoeven beheren.

Krijg de volledige stack – AI-mogelijkheden, projectmanagement, documentatie en communicatie – allemaal op één plek met ClickUp, in plaats van de AI-laag helemaal opnieuw op te bouwen met LLaMA.

Ga vooruit met Enterprise AI met ClickUp

LLaMA biedt ondernemingsteams een open alternatief voor gesloten AI-API's, met aanzienlijke controle, voorspelbare kosten en aangepaste aanpassingsmogelijkheden. Maar succes hangt niet alleen af van technologie. Het vereist het koppelen van het juiste model aan de juiste use case, investeren in hoogwaardige trainingsdata en het opzetten van robuuste evaluatieprocessen.

De keuze tussen 'bouwen of kopen' hangt uiteindelijk af van de technische capaciteit van uw team. Het bouwen van een aangepaste oplossing biedt maximale flexibiliteit, maar brengt ook aanzienlijke overheadkosten met zich mee. De echte uitdaging is niet alleen toegang krijgen tot AI, maar deze ook integreren in uw dagelijkse werkstroom zonder meer AI-wildgroei en datasilo's te creëren.

Breng LLM-mogelijkheden rechtstreeks in uw projectmanagement, documentatie en teamcommunicatie met ClickUp Brain, zonder de complexiteit van het bouwen en onderhouden van infrastructuur. Ga gratis aan de slag met ClickUp en breng AI-mogelijkheden rechtstreeks in uw bestaande werkstroom. 🙌

Veelgestelde vragen (FAQ)

Ja, de Llama 3 Community License staat commercieel gebruik toe voor de meeste organisaties. Alleen bedrijven met meer dan 700 miljoen actieve gebruikers per maand moeten een aparte licentie van Meta aanschaffen.

LLaMA biedt meer controle over gegevens en voorspelbare kosten door zelfhosting, terwijl GPT-4 betere prestaties biedt zonder veel installaties. Voor productiviteit kunt u echter AI-assistentie krijgen zonder de onderliggende modellen te beheren via geïntegreerde tools zoals ClickUp Brain.

Bij zelfhosting van LLaMA blijven de gegevens op uw infrastructuur staan, wat ideaal is voor gegevensopslag. U bent echter zelf verantwoordelijk voor het implementeren van uw eigen toegangscontroles, auditlogs en content-filters – functies voor veiligheid die doorgaans bij beheerde AI-services zijn inbegrepen.

Het implementeren en afstemmen van LLaMA vereist aanzienlijke ML-engineeringvaardigheden. Teams zonder deze expertise kunnen toegang krijgen tot op LLaMA gebaseerde mogelijkheden via beheerde platforms zoals ClickUp Brain, dat AI-functies biedt zonder dat er modellen hoeven te worden geïmplementeerd of technische configuraties hoeven te worden uitgevoerd.