Hầu hết các dự án triển khai AI thất bại không phải vì nhóm đã chọn sai mô hình, mà vì sau ba tháng, không ai còn nhớ lý do tại sao họ chọn mô hình đó hoặc cách tái tạo thiết lập, với 46% dự án AI bị hủy bỏ giữa giai đoạn chứng minh khái niệm và triển khai rộng rãi.

Hướng dẫn này sẽ hướng dẫn bạn cách sử dụng Hugging Face để triển khai AI – từ việc lựa chọn và kiểm thử mô hình đến quản lý quy trình triển khai – giúp nhóm của bạn triển khai nhanh hơn mà không mất các quyết định quan trọng trong các chủ đề trên Slack và bảng tính phân tán.

Hugging Face là gì?

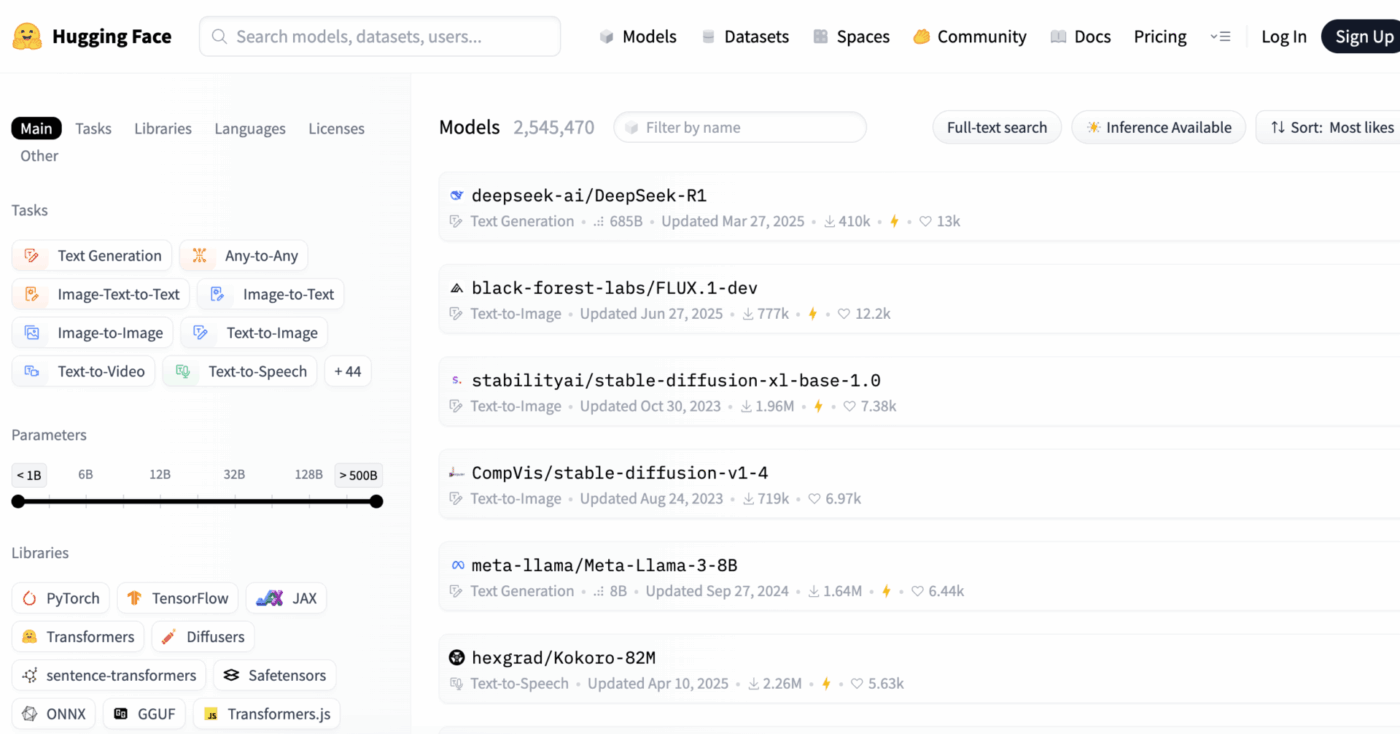

Hugging Face là một nền tảng mã nguồn mở và trung tâm cộng đồng cung cấp các mô hình AI đã được huấn luyện sẵn, bộ dữ liệu và công cụ để xây dựng và triển khai các ứng dụng học máy.

Hãy tưởng tượng nó như một thư viện kỹ thuật số khổng lồ, nơi bạn có thể tìm thấy các mô hình AI sẵn sàng sử dụng thay vì phải mất hàng tháng và nguồn lực đáng kể để xây dựng chúng từ đầu.

Nó được thiết kế cho các kỹ sư học máy và nhà khoa học dữ liệu, nhưng các công cụ của nó ngày càng được các nhóm đa chức năng về sản phẩm, thiết kế và kỹ thuật sử dụng để tích hợp AI vào quy trình làm việc của họ.

Bạn có biết: 63% tổ chức thiếu các thực hành quản lý dữ liệu phù hợp cho AI. Điều này thường dẫn đến các dự án bị đình trệ và lãng phí tài nguyên.

Thách thức chính đối với nhiều nhóm là sự phức tạp của quá trình triển khai AI. Quy trình này bao gồm việc lựa chọn mô hình phù hợp từ hàng nghìn tùy chọn, quản lý hạ tầng cơ sở, quản lý phiên bản thí nghiệm và đảm bảo sự đồng thuận giữa các bên liên quan kỹ thuật và phi kỹ thuật.

Hugging Face đơn giản hóa quy trình này bằng cách cung cấp Model Hub, một kho lưu trữ trung tâm với hơn 2 triệu mô hình. Thư viện Transformers của nền tảng này là khóa để truy cập các mô hình này, cho phép bạn tải và sử dụng chúng chỉ với vài dòng mã Python.

Tuy nhiên, ngay cả với những công cụ mạnh mẽ này, việc triển khai AI vẫn là một thách thức trong quản lý dự án, đòi hỏi việc theo dõi cẩn thận quá trình lựa chọn mô hình, kiểm thử và triển khai để đảm bảo thành công.

📮ClickUp Insight: 92% nhân viên văn phòng có nguy cơ mất các quyết định quan trọng bị phân tán trên các cuộc trò chuyện, email và bảng tính. Nếu không có hệ thống thống nhất để ghi lại và đang theo dõi các quyết định, những thông tin quan trọng của kinh doanh sẽ bị lạc trong "tiếng ồn kỹ thuật số".

Với tính năng Quản lý Công việc của ClickUp, bạn không cần lo lắng về điều này. Tạo công việc từ trò chuyện, bình luận công việc, tài liệu và email chỉ với một cú nhấp chuột!

📚 Xem thêm: Các lựa chọn thay thế hàng đầu cho Hugging Face trong LLMs, NLP và quy trình làm việc AI

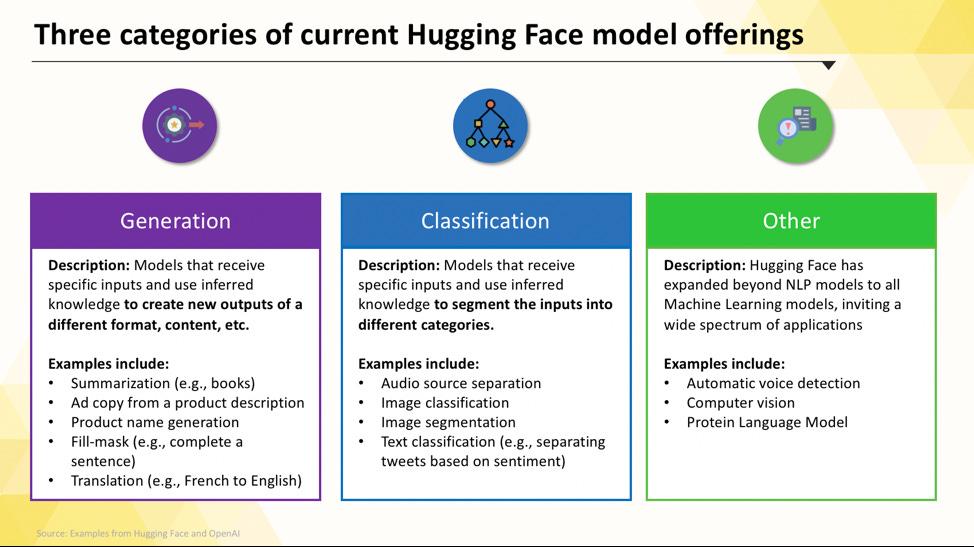

Các mô hình Hugging Face bạn có thể triển khai

Khi mới bắt đầu, việc điều hướng Hugging Face Hub có thể khiến bạn cảm thấy choáng ngợp. Với hàng trăm nghìn mô hình, khóa là hiểu rõ các danh mục chính để tìm ra mô hình phù hợp nhất cho dự án của bạn. Phạm vi các mô hình này rất rộng, từ những mô hình nhỏ gọn, hiệu quả được thiết kế cho một mục đích cụ thể đến những mô hình lớn, đa năng có thể xử lý các tác vụ phức tạp.

Các mô hình ngôn ngữ chuyên dụng cho từng công việc

Khi nhóm của bạn cần giải quyết một vấn đề cụ thể và rõ ràng, bạn thường không cần đến một mô hình AI lớn và đa năng. Thời gian và chi phí để chạy mô hình như vậy có thể quá cao, đặc biệt khi một công cụ AI nhỏ gọn và tập trung hơn sẽ hiệu quả hơn. Đây chính là lúc các mô hình chuyên biệt cho từng công việc phát huy tác dụng.

Đây là những mô hình đã được đào tạo và tối ưu hóa cho một hàm cụ thể. Vì chúng chuyên biệt, chúng thường nhỏ gọn hơn, nhanh hơn và tiết kiệm tài nguyên hơn so với các mô hình lớn hơn.

Điều này khiến chúng trở nên lý tưởng cho môi trường sản xuất, nơi tốc độ và chi phí là yếu tố quan trọng. Nhiều mô hình thậm chí có thể chạy trên phần cứng CPU tiêu chuẩn, giúp chúng dễ dàng tiếp cận mà không cần đến GPU đắt tiền.

Các loại mô hình chuyên dụng phổ biến bao gồm:

- Phân loại văn bản: Sử dụng tính năng này để phân loại văn bản vào các nhãn đã định sẵn, chẳng hạn như phân loại phản hồi của khách hàng thành các nhóm “tích cực” hoặc “tiêu cực” hoặc gắn thẻ các phiếu hỗ trợ theo chủ đề.

- Phân tích cảm xúc: Điều này giúp bạn xác định tông màu cảm xúc của một đoạn văn bản, rất hữu ích cho việc theo dõi thương hiệu trên mạng xã hội.

- Nhận dạng thực thể được đặt tên: Trích xuất các thực thể cụ thể như người, địa điểm và tổ chức từ tài liệu để giúp cấu trúc dữ liệu không cấu trúc.

- Tóm tắt: Tóm tắt các bài viết hoặc báo cáo dài thành các bản tóm tắt ngắn gọn, giúp nhóm của bạn tiết kiệm thời gian đọc.

- Dịch: Chuyển đổi văn bản từ ngôn ngữ này sang ngôn ngữ khác một cách tự động.

📚 Đọc thêm: Cách sử dụng Hugging Face cho tóm tắt văn bản

Các mô hình ngôn ngữ lớn

Đôi khi, dự án của bạn đòi hỏi nhiều hơn chỉ là phân loại hoặc tóm tắt đơn giản. Bạn có thể cần một AI có thể tạo nội dung tiếp thị sáng tạo, viết mã hoặc trả lời các câu hỏi phức tạp của người dùng theo cách trong cuộc hội thoại. Trong những trường hợp này, bạn có thể sẽ sử dụng Mô hình Ngôn ngữ Lớn (LLM).

LLMs là các mô hình có hàng tỷ tham số được đào tạo trên lượng lớn văn bản và dữ liệu từ internet. Quá trình đào tạo rộng lớn này cho phép chúng hiểu được sự tinh tế, ngữ cảnh và suy luận phức tạp. Các mô hình LLMs nguồn mở phổ biến có sẵn trên Hugging Face bao gồm các mô hình từ các gia đình Llama, Mistral và Falcon.

Đổi lại cho sức mạnh này là yêu cầu về tài nguyên tính toán đáng kể. Việc triển khai các mô hình này gần như luôn đòi hỏi GPU mạnh mẽ với dung lượng bộ nhớ lớn (VRAM).

Để làm cho chúng dễ tiếp cận hơn, bạn có thể sử dụng các kỹ thuật như lượng tử hóa, giúp giảm kích thước mô hình với chi phí hiệu suất nhỏ, cho phép nó chạy trên phần cứng có cấu hình thấp hơn.

Mô hình chuyển văn bản thành hình ảnh và mô hình đa phương thức

Dữ liệu của bạn không phải lúc nào cũng chỉ là văn bản. Nhóm của bạn có thể cần tạo hình ảnh cho chiến dịch tiếp thị, chuyển đổi âm thanh từ cuộc họp thành văn bản, hoặc phân tích nội dung của video. Đây chính là lúc các mô hình đa phương thức (multimodal models) – được thiết kế để xử lý nhiều loại dữ liệu khác nhau – trở nên thiết yếu.

Loại mô hình đa phương thức phổ biến nhất là mô hình chuyển văn bản thành hình ảnh, tạo ra hình ảnh từ mô tả văn bản. Các mô hình như Stable Diffusion sử dụng kỹ thuật gọi là khuếch tán để tạo ra hình ảnh ấn tượng từ các lời nhắc đơn giản. Tuy nhiên, tiềm năng của chúng còn mở rộng xa hơn việc tạo hình ảnh.

Các mô hình đa phương thức phổ biến khác mà bạn có thể triển khai từ Hugging Face bao gồm:

- Chú thích hình ảnh: Tự động tạo văn bản mô tả cho hình ảnh, rất hữu ích cho việc truy cập và quản lý nội dung.

- Nhận dạng giọng nói: Chuyển đổi âm thanh nói thành văn bản bằng các mô hình như Whisper của OpenAI.

- Trả lời câu hỏi bằng hình ảnh: Hỏi câu hỏi về một hình ảnh và nhận câu trả lời bằng văn bản, ví dụ: “Màu sắc của chiếc xe trong bức ảnh này là gì?”

Giống như các mô hình ngôn ngữ lớn (LLMs), các mô hình này đòi hỏi nhiều tài nguyên tính toán và thường cần GPU để chạy hiệu quả.

Để hiểu cách các loại mô hình AI khác nhau được áp dụng vào các ứng dụng kinh doanh thực tế, hãy xem tổng quan về các trường hợp sử dụng AI trong thực tế trên nhiều ngành công nghiệp và hàm khác nhau.

Mức độ trưởng thành AI của tổ chức bạn là gì?

Cuộc khảo sát của chúng tôi với 316 chuyên gia cho thấy rằng sự chuyển đổi AI thực sự không chỉ đơn thuần là áp dụng các tính năng AI. Hãy thực hiện đánh giá mức độ trưởng thành AI để xem tổ chức của bạn đang ở đâu và những việc cần làm để cải thiện điểm số của mình.

Cách cài đặt Hugging Face cho việc triển khai AI

Trước khi có thể triển khai mô hình đầu tiên, bạn cần thiết lập môi trường cục bộ và tài khoản Hugging Face một cách chính xác. Đây là vấn đề thường gặp khiến các nhóm gặp khó khăn khi các thành viên có cấu hình không nhất quán, dẫn đến tình trạng “nó hoạt động trên máy của tôi”. Dành vài phút để chuẩn hóa quy trình này sẽ giúp tiết kiệm hàng giờ khắc phục sự cố sau này.

- Tạo tài khoản Hugging Face và tạo token truy cập. Đầu tiên, đăng ký tài khoản miễn phí trên trang web Hugging Face. Sau khi đăng nhập, truy cập vào hồ sơ của bạn, nhấp vào “Cài đặt”, sau đó chuyển đến tab “Token”. Tạo token mới với quyền truy cập “đọc” tối thiểu; bạn sẽ cần token này để tải xuống các mô hình.

- Cài đặt các thư viện Python cần thiết. Mở terminal và cài đặt các thư viện chính bạn sẽ cần. Hai thư viện quan trọng nhất là transformers và huggingface_hub. Bạn có thể cài đặt chúng bằng pip: pip install transformers huggingface_hub

- Cấu hình xác thực. Để sử dụng token truy cập của bạn, bạn có thể đăng nhập qua dòng lệnh bằng cách chạy lệnh huggingface-cli login và dán token của bạn khi được yêu cầu, hoặc bạn có thể cài đặt nó làm biến môi trường trong hệ thống của bạn. Việc đăng nhập qua dòng lệnh thường là cách dễ nhất để bắt đầu.

- Kiểm tra thiết lập. Cách tốt nhất để xác nhận mọi thứ hoạt động bình thường là chạy một đoạn mã đơn giản. Hãy thử tải một mô hình cơ bản bằng hàm pipeline từ thư viện transformers. Nếu nó chạy mà không gặp lỗi, bạn đã sẵn sàng để bắt đầu.

Lưu ý rằng một số mô hình trên Hub là “gated”, nghĩa là bạn phải đồng ý với các điều khoản cấp phép của mô hình trên trang mô hình trước khi có thể truy cập chúng bằng token của mình.

Ngoài ra, hãy nhớ rằng việc theo dõi ai có quyền truy cập nào và các cấu hình môi trường nào đang được sử dụng là một công việc quản lý dự án riêng biệt, và nó trở nên quan trọng hơn khi nhóm của bạn phát triển.

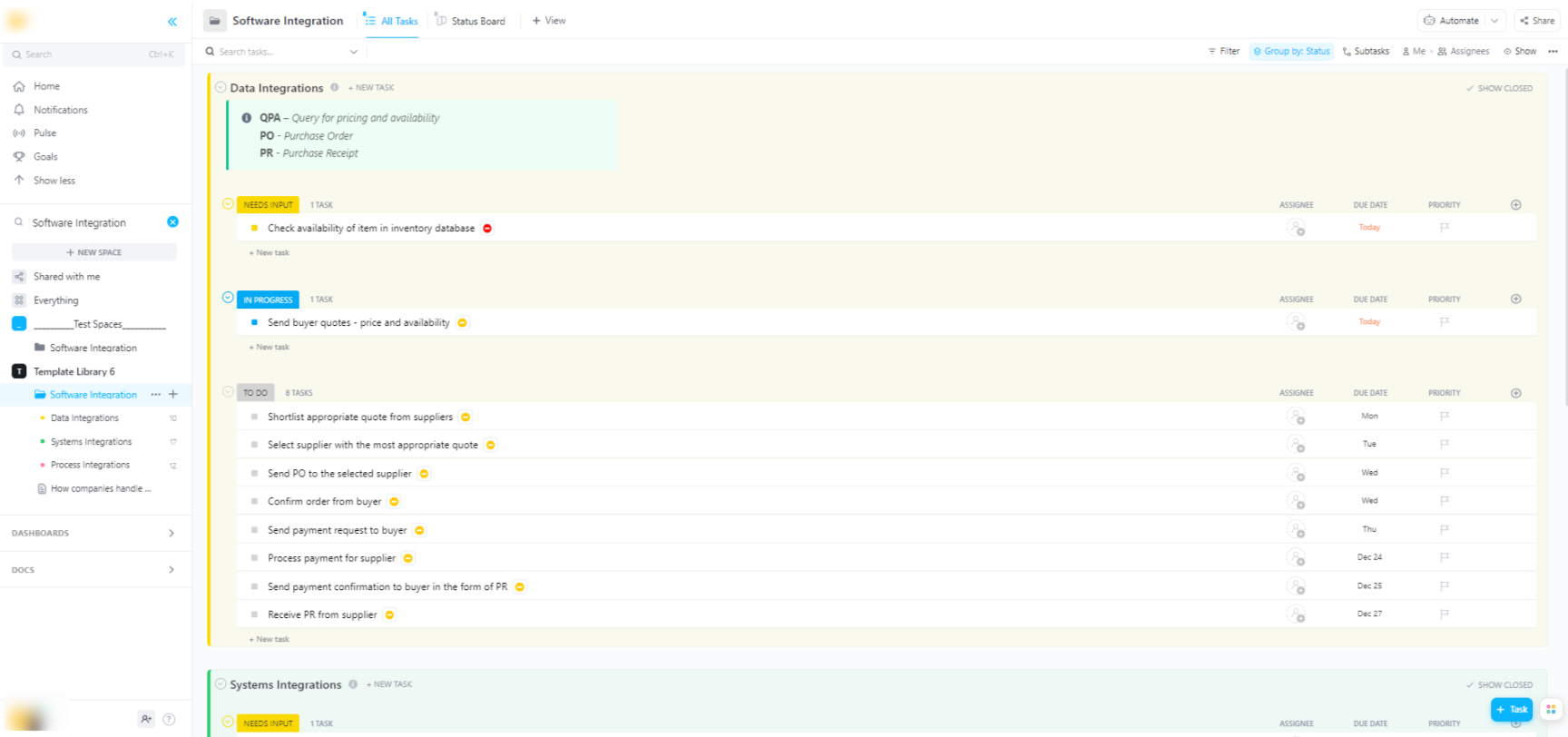

🌟 Nếu bạn đang tích hợp các mô hình Hugging Face vào các hệ thống phần mềm lớn hơn, Mẫu Tích hợp Phần mềm của ClickUp giúp trực quan hóa quy trình làm việc và đang theo dõi các tích hợp kỹ thuật nhiều bước.

Mẫu này cung cấp cho bạn một hệ thống dễ dàng theo dõi, nơi bạn có thể:

- Hiển thị các kết nối giữa các giải pháp phần mềm khác nhau

- Tạo và giao công việc cho các thành viên trong nhóm để hợp tác hiệu quả hơn.

- Tổ chức tất cả các công việc liên quan đến tích hợp tại một nơi duy nhất.

Các tùy chọn triển khai cho mô hình Hugging Face

Sau khi đã thử nghiệm mô hình trên môi trường cục bộ, câu hỏi tiếp theo là: mô hình sẽ được triển khai ở đâu? Việc triển khai mô hình vào môi trường sản xuất để người khác có thể sử dụng là một bước quan trọng, nhưng các tùy chọn có thể gây nhầm lẫn. Lựa chọn sai hướng có thể dẫn đến hiệu suất chậm, chi phí cao hoặc không thể xử lý lưu lượng người dùng.

Lựa chọn của bạn sẽ phụ thuộc vào nhu cầu cụ thể của bạn, chẳng hạn như lưu lượng truy cập dự kiến, ngân sách và liệu bạn đang xây dựng một bản mẫu nhanh hay một ứng dụng có khả năng mở rộng, sẵn sàng cho sản xuất.

Hugging Face Không gian

Nếu bạn cần nhanh chóng tạo một bản demo hoặc công cụ nội bộ, Hugging Face Spaces thường là lựa chọn tốt nhất. Spaces là nền tảng miễn phí để lưu trữ các ứng dụng học máy, và nó hoàn hảo để xây dựng các bản mẫu mà bạn có thể chia sẻ với nhóm hoặc các bên liên quan.

Bạn có thể xây dựng giao diện người dùng cho ứng dụng của mình bằng các khung làm việc phổ biến như Gradio hoặc Streamlit, giúp bạn dễ dàng tạo các bản demo tương tác chỉ với vài dòng mã Python.

Tạo một không gian đơn giản như việc lựa chọn SDK ưa thích của bạn, kết nối kho lưu trữ Git với mã nguồn của bạn và chọn phần cứng. Mặc dù Spaces cung cấp gói CPU miễn phí cho các ứng dụng cơ bản, bạn có thể nâng cấp lên phần cứng GPU trả phí cho các mô hình đòi hỏi cao hơn.

Lưu ý các giới hạn:

- Không dành cho API có lưu lượng truy cập cao: Spaces được thiết kế cho các bản demo, không dành cho việc xử lý hàng nghìn yêu cầu API đồng thời.

- Khởi động lạnh: Nếu không gian của bạn không hoạt động, nó có thể "ngủ đông" để tiết kiệm tài nguyên, gây ra sự chậm trễ cho người dùng đầu tiên truy cập lại.

- Quy trình làm việc dựa trên Git: Tất cả mã nguồn ứng dụng của bạn được quản lý thông qua kho lưu trữ Git, rất hữu ích cho việc kiểm soát phiên bản.

API Suy luận Hugging Face

Khi cần tích hợp mô hình vào ứng dụng hiện có, bạn có thể muốn sử dụng API. API Suy luận Hugging Face cho phép bạn chạy mô hình mà không cần quản lý hạ tầng cơ sở nào. Bạn chỉ cần gửi yêu cầu HTTP với dữ liệu của mình và nhận kết quả dự đoán trở lại.

Phương pháp này lý tưởng khi bạn không muốn phải lo lắng về máy chủ, mở rộng quy mô hoặc bảo trì. Hugging Face cung cấp hai gói dịch vụ chính cho dịch vụ này:

- API Suy luận Miễn phí: Đây là tùy chọn hạ tầng chia sẻ có giới hạn băng thông, rất phù hợp cho phát triển và thử nghiệm. Nó lý tưởng cho các trường hợp sử dụng có lưu lượng thấp hoặc khi bạn mới bắt đầu.

- Điểm cuối suy luận (Inference Endpoints): Đối với các ứng dụng sản xuất, bạn nên sử dụng Điểm cuối suy luận. Đây là dịch vụ trả phí cung cấp cho bạn hạ tầng chuyên dụng, tự động mở rộng quy mô, đảm bảo ứng dụng của bạn hoạt động nhanh chóng và đáng tin cậy ngay cả khi chịu tải nặng.

Sử dụng API yêu cầu gửi một payload JSON đến URL endpoint của mô hình kèm theo token xác thực của bạn trong tiêu đề yêu cầu.

Triển khai trên nền tảng đám mây

Đối với các nhóm đã có sự hiện diện đáng kể trên các nền tảng đám mây lớn như Amazon Web Services (AWS), Google Cloud Platform (GCP) hoặc Microsoft Azure, việc triển khai trên các nền tảng này có thể là lựa chọn hợp lý nhất. Phương pháp này mang lại cho bạn quyền kiểm soát tối đa và cho phép tích hợp mô hình với các dịch vụ đám mây hiện có và các giao thức bảo mật của bạn.

Quy trình chung bao gồm việc “đóng gói” mô hình và các phụ thuộc của nó bằng Docker, sau đó triển khai container đó lên dịch vụ tính toán đám mây. Mỗi nhà cung cấp đám mây đều có các dịch vụ và tích hợp giúp đơn giản hóa quy trình này:

- AWS SageMaker: Cung cấp tích hợp sẵn cho việc đào tạo và triển khai các mô hình Hugging Face.

- Google Cloud Vertex AI: Cho phép bạn triển khai các mô hình từ Hub đến các điểm cuối được quản lý.

- Azure Machine Learning: Cung cấp các công cụ để nhập và triển khai các mô hình Hugging Face.

Mặc dù phương pháp này đòi hỏi nhiều công đoạn thiết lập và chuyên môn về DevOps, nhưng nó thường là lựa chọn tốt nhất cho các triển khai quy mô lớn, cấp doanh nghiệp, nơi bạn cần kiểm soát hoàn toàn môi trường.

Cách chạy các mô hình Hugging Face cho việc suy luận

Khi sử dụng Hugging Face để triển khai AI, “chạy suy luận” là quá trình sử dụng mô hình đã được huấn luyện của bạn để đưa ra dự đoán trên dữ liệu mới, chưa từng thấy. Đây là lúc mô hình của bạn thực hiện công việc mà bạn đã triển khai nó. Việc thực hiện bước này đúng cách là yếu tố quan trọng để xây dựng một ứng dụng phản hồi nhanh và hiệu quả.

Điều khiến các nhóm cảm thấy bực bội nhất là viết mã suy luận chậm hoặc kém hiệu quả, điều này có thể dẫn đến trải nghiệm người dùng kém và chi phí vận hành cao. May mắn thay, thư viện Transformers cung cấp nhiều cách để thực hiện suy luận, mỗi cách đều có những ưu nhược điểm riêng giữa tính đơn giản và khả năng kiểm soát.

- Pipeline API: Đây là cách đơn giản và phổ biến nhất để bắt đầu. Hàm pipeline() giúp loại bỏ hầu hết sự phức tạp, xử lý tiền xử lý dữ liệu, truyền mô hình và hậu xử lý cho bạn. Đối với nhiều công việc tiêu chuẩn như phân tích cảm xúc, bạn có thể nhận được dự đoán chỉ với một dòng mã.

- AutoModel + AutoTokenizer: Khi bạn cần kiểm soát nhiều hơn quá trình suy luận, bạn có thể sử dụng trực tiếp các lớp AutoModel và AutoTokenizer. Điều này cho phép bạn tự tay xử lý cách văn bản được phân tách thành token và cách đầu ra thô của mô hình được chuyển đổi thành dự đoán có thể đọc được bởi con người. Phương pháp này hữu ích khi bạn làm việc với công việc tùy chỉnh hoặc cần triển khai logic tiền xử lý hoặc hậu xử lý cụ thể.

- Xử lý theo lô: Để tối ưu hóa hiệu suất, đặc biệt trên GPU, bạn nên xử lý đầu vào theo lô thay vì từng cái một. Gửi một lô đầu vào qua mô hình trong một lần truyền dữ liệu duy nhất sẽ nhanh hơn đáng kể so với gửi từng cái một.

Theo dõi hiệu suất của mã suy luận là một phần quan trọng trong chu kỳ triển khai. Theo dõi các chỉ số như độ trễ (thời gian cần thiết để thực hiện một dự đoán) và thông lượng (số lượng dự đoán có thể thực hiện mỗi giây) đòi hỏi sự phối hợp và tài liệu rõ ràng, đặc biệt khi các thành viên trong nhóm thử nghiệm các phiên bản mô hình mới.

Ví dụ từng bước: Triển khai mô hình Hugging Face

Hãy cùng tìm hiểu một ví dụ hoàn chỉnh về việc triển khai mô hình phân tích cảm xúc đơn giản. Thực hiện các bước này sẽ giúp bạn từ việc chọn mô hình đến có được một điểm cuối hoạt động và có thể kiểm tra.

- Lựa chọn mô hình của bạn: Truy cập Hugging Face Hub và sử dụng các bộ lọc bên trái để tìm kiếm các mô hình thực hiện “Phân loại văn bản”. Một điểm khởi đầu tốt là distilbert-base-uncased-finetuned-sst-2-english. Đọc thẻ mô hình của nó để hiểu hiệu suất và cách sử dụng.

- Cài đặt các gói phụ thuộc: Trong môi trường Python cục bộ của bạn, hãy đảm bảo đã cài đặt các thư viện cần thiết. Đối với mô hình này, bạn chỉ cần cài đặt transformers và torch. Chạy lệnh pip install transformers torch

- Kiểm tra trên máy cục bộ: Trước khi triển khai, luôn đảm bảo mô hình hoạt động như mong đợi trên máy của bạn. Viết một skript Python nhỏ để tải mô hình bằng pipeline và kiểm tra với một câu mẫu. Ví dụ: classifier = pipeline("sentiment-analysis", model="distilbert-base-uncased-finetuned-sst-2-english") tiếp theo là classifier("ClickUp là nền tảng năng suất tốt nhất!")

- Tạo triển khai: Trong ví dụ này, chúng ta sẽ sử dụng Hugging Face Spaces để triển khai nhanh chóng và dễ dàng. Tạo một không gian mới, lựa chọn Gradio SDK và tạo ứng dụng.py để tải mô hình của bạn và định nghĩa giao diện Gradio đơn giản để tương tác với nó.

- Xác minh triển khai: Sau khi không gian của bạn đã hoạt động, bạn có thể sử dụng giao diện tương tác để kiểm tra. Bạn cũng có thể thực hiện yêu cầu API trực tiếp đến điểm cuối của không gian để nhận phản hồi JSON, xác nhận rằng nó hoạt động một cách chương trình.

Sau các bước này, bạn đã có một mô hình hoạt động. Giai đoạn tiếp theo của dự án sẽ bao gồm theo dõi việc sử dụng mô hình, lập kế hoạch cập nhật và có thể mở rộng hạ tầng nếu mô hình trở nên phổ biến.

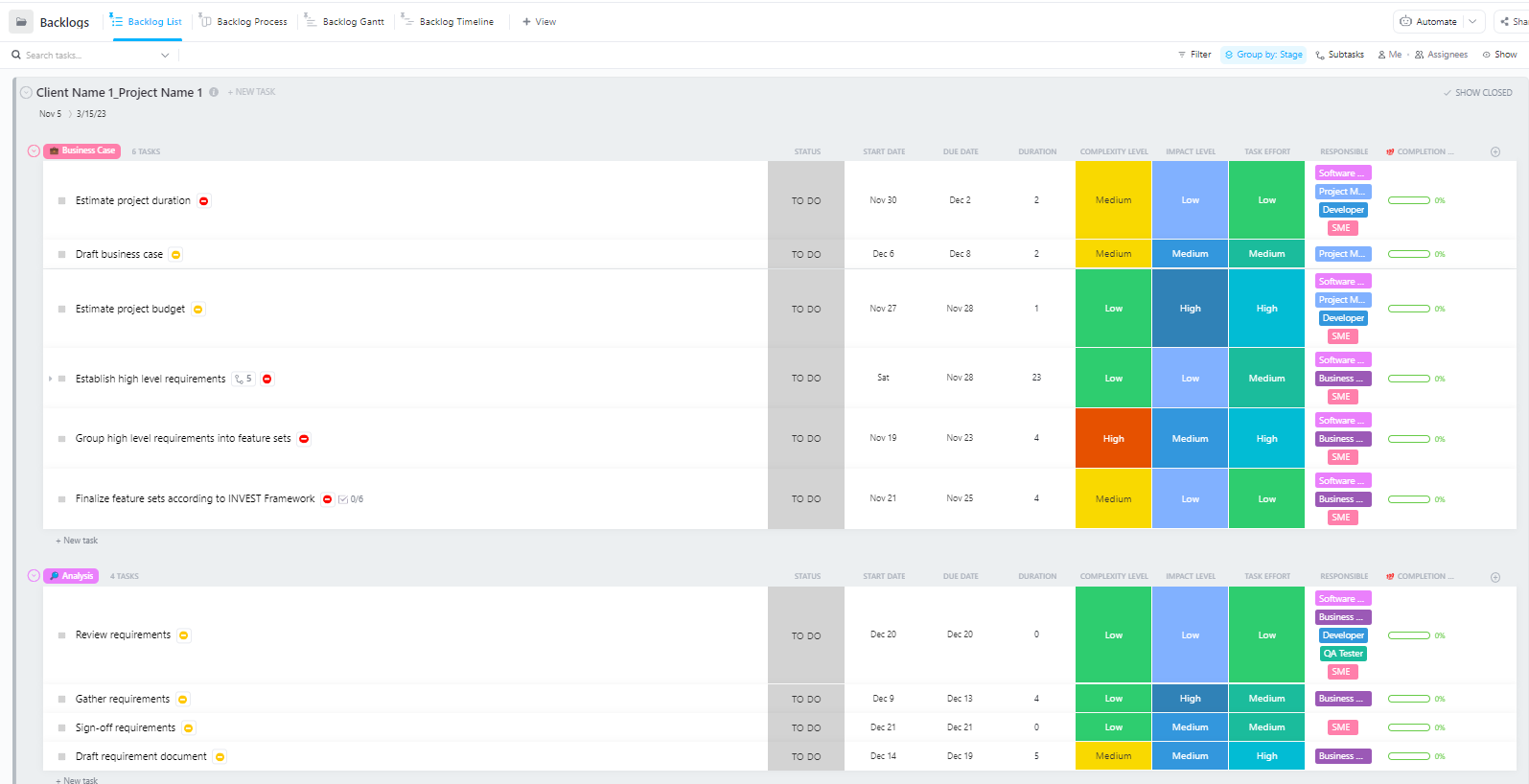

Đối với các nhóm quản lý các dự án triển khai AI phức tạp với nhiều giai đoạn – từ chuẩn bị dữ liệu đến triển khai sản xuất – Mẫu Quản lý Dự án Phần mềm Nâng cao của ClickUp cung cấp một cấu trúc toàn diện.

Mẫu này giúp các nhóm:

- Quản lý dự án với nhiều cột mốc, công việc, tài nguyên và mối quan hệ phụ thuộc.

- Theo dõi tiến độ dự án với biểu đồ Gantt và dòng thời gian.

- Hợp tác mượt mà với đồng nghiệp để đảm bảo hoàn thành thành công.

Các thách thức phổ biến khi triển khai Hugging Face và cách khắc phục chúng

Ngay cả khi có kế hoạch rõ ràng, bạn vẫn có thể gặp một số trở ngại trong quá trình triển khai. Nhìn vào một thông báo lỗi khó hiểu có thể gây bực bội và làm gián đoạn tiến độ của nhóm. Dưới đây là một số thách thức phổ biến nhất và cách khắc phục chúng. 🛠️

🚨Vấn đề: “Mô hình yêu cầu xác thực”

- Nguyên nhân: Bạn đang cố gắng truy cập một mô hình “có điều kiện” yêu cầu bạn chấp nhận các điều khoản cấp phép của nó.

- Giải pháp: Truy cập trang mô hình trên Hub, đọc và chấp nhận thỏa thuận cấp phép. Đảm bảo token truy cập bạn đang sử dụng có quyền truy cập “đọc”.

🚨Vấn đề: “CUDA hết bộ nhớ”

- Nguyên nhân: Mô hình bạn đang cố gắng tải quá lớn so với bộ nhớ GPU (VRAM) của bạn.

- Giải pháp: Cách khắc phục nhanh nhất là sử dụng phiên bản nhỏ hơn của mô hình hoặc phiên bản đã được lượng tử hóa. Bạn cũng có thể thử giảm kích thước lô trong quá trình suy luận.

🚨Vấn đề: “lỗi trust_remote_code”

- Nguyên nhân: Một số mô hình trên Hub yêu cầu mã tùy chỉnh để chạy, và vì lý do bảo mật, thư viện sẽ không thực thi mã đó theo mặc định.

- Giải pháp: Bạn có thể bỏ qua điều này bằng cách thêm trust_remote_code=True khi tải mô hình. Tuy nhiên, bạn nên luôn kiểm tra mã nguồn trước để đảm bảo an toàn.

🚨Vấn đề: “Sự không khớp của tokenizer”

- Nguyên nhân: Bộ phân tích token (tokenizer) mà bạn đang sử dụng không chính xác là bộ phân tích token được sử dụng để đào tạo mô hình, dẫn đến đầu vào không chính xác và hiệu suất kém.

- Giải pháp: Luôn tải tokenizer từ cùng một điểm kiểm tra mô hình (model checkpoint) với chính mô hình đó. Ví dụ: AutoTokenizer. from_pretrained("model-name")

🚨Vấn đề: “Vượt quá giới hạn tốc độ”

- Nguyên nhân: Bạn đã thực hiện quá nhiều yêu cầu đến API suy luận miễn phí trong một kỳ ngắn.

- Giải pháp: Đối với mục đích sản xuất, hãy nâng cấp lên Endpoint suy luận chuyên dụng. Đối với phát triển, bạn có thể triển khai bộ nhớ đệm để tránh gửi cùng một yêu cầu nhiều lần.

Theo dõi các giải pháp phù hợp với từng vấn đề là điều quan trọng. Nếu không có một nơi trung tâm để ghi chép lại những phát hiện này, các nhóm thường phải giải quyết cùng một vấn đề lặp đi lặp lại.

📮 ClickUp Insight: 1 trong 4 nhân viên sử dụng bốn công cụ trở lên chỉ để tạo bối cảnh làm việc. Một chi tiết quan trọng có thể bị ẩn trong email, được mở rộng trong một chủ đề trên Slack và được ghi chép trong một công cụ riêng biệt, buộc các nhóm phải lãng phí thời gian tìm kiếm thông tin thay vì hoàn thành công việc.

ClickUp tích hợp toàn bộ quy trình làm việc của bạn vào một nền tảng thống nhất. Với các tính năng như Quản lý Dự án Email ClickUp, Trò chuyện ClickUp, Tài liệu ClickUp và ClickUp Brain, mọi thứ đều được kết nối, đồng bộ và truy cập ngay lập tức. Hãy tạm biệt “công việc về công việc” và lấy lại thời gian năng suất của bạn.

💫 Kết quả thực tế: Các nhóm có thể tiết kiệm được 5+ giờ mỗi tuần bằng cách sử dụng ClickUp – tương đương hơn 250 giờ mỗi năm cho mỗi người – bằng cách loại bỏ các quy trình quản lý kiến thức lỗi thời. Hãy tưởng tượng nhóm của bạn có thể tạo ra điều gì với thêm một tuần năng suất mỗi quý!

Cách quản lý dự án triển khai AI trong ClickUp

Sử dụng Hugging Face cho việc triển khai AI giúp việc đóng gói, lưu trữ và cung cấp mô hình trở nên dễ dàng hơn – nhưng nó không loại bỏ được gánh nặng phối hợp trong quá trình triển khai thực tế. Các nhóm vẫn cần theo dõi các mô hình đang được thử nghiệm, thống nhất về cấu hình, ghi chép quyết định và đảm bảo mọi người – từ kỹ sư AI đến đội ngũ sản phẩm và vận hành – đều đồng bộ thông tin.

Khi nhóm kỹ thuật của bạn đang thử nghiệm các mô hình khác nhau, nhóm sản phẩm đang xác định yêu cầu, và các bên liên quan yêu cầu cập nhật, thông tin bị phân tán trên Slack, email, bảng tính và các tài liệu khác nhau.

Sự phân tán công việc – việc các hoạt động công việc bị phân tán trên nhiều công cụ không kết nối với nhau – gây ra sự nhầm lẫn và làm chậm tiến độ của mọi người.

Đây là nơi ClickUp, không gian làm việc AI tích hợp đầu tiên trên thế giới, đóng vai trò quan trọng bằng cách kết hợp quản lý dự án, tài liệu và giao tiếp nhóm vào một không gian làm việc duy nhất.

Sự hội tụ này đặc biệt có giá trị đối với các dự án triển khai AI, nơi các bên liên quan kỹ thuật và phi kỹ thuật cần chia sẻ tầm nhìn mà không phải sử dụng năm công cụ khác nhau.

Thay vì phân tán các bản cập nhật trên các phiếu yêu cầu, tài liệu và chủ đề trò chuyện, các nhóm có thể quản lý toàn bộ vòng đời triển khai tại một nơi duy nhất.

Dưới đây là cách ClickUp có thể hỗ trợ dự án triển khai AI của bạn:

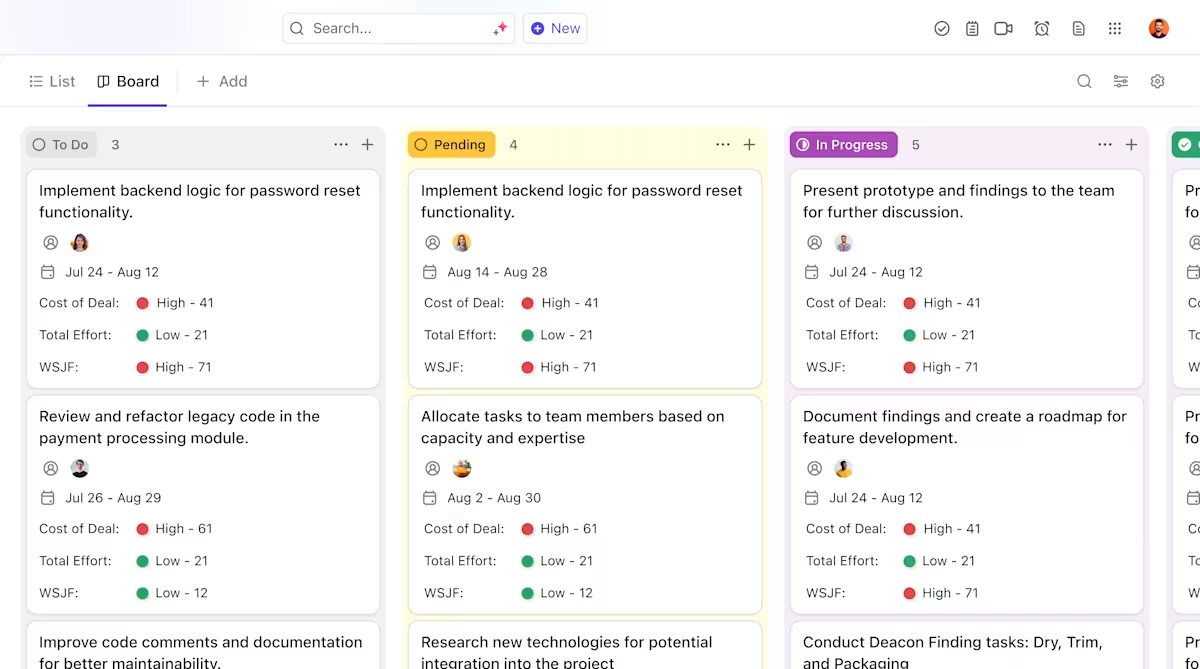

- Quản lý quyền sở hữu và theo dõi xuyên suốt vòng đời mô hình: Sử dụng nhiệm vụ ClickUp để theo dõi các mô hình Hugging Face qua các giai đoạn đánh giá, thử nghiệm, triển khai thử nghiệm và sản xuất, với các trạng thái tùy chỉnh, chủ sở hữu và rào cản được hiển thị cho toàn bộ nhóm.

- Tài liệu triển khai tập trung, luôn cập nhật: Quản lý tài liệu triển khai, cấu hình môi trường và hướng dẫn khắc phục sự cố trong ClickUp Docs, để tài liệu phát triển cùng với mô hình của bạn và luôn dễ dàng tìm kiếm và tham khảo. Vì Docs được kết nối với các công việc, tài liệu của bạn luôn được lưu trữ ngay bên cạnh công việc liên quan.

- Hợp tác trong bối cảnh mà không gây rối loạn công việc: Giữ các cuộc thảo luận, quyết định và cập nhật trực tiếp liên quan đến các công việc và tài liệu, giảm sự phụ thuộc vào các chủ đề Slack phân tán, email và các công cụ dự án không liên kết.

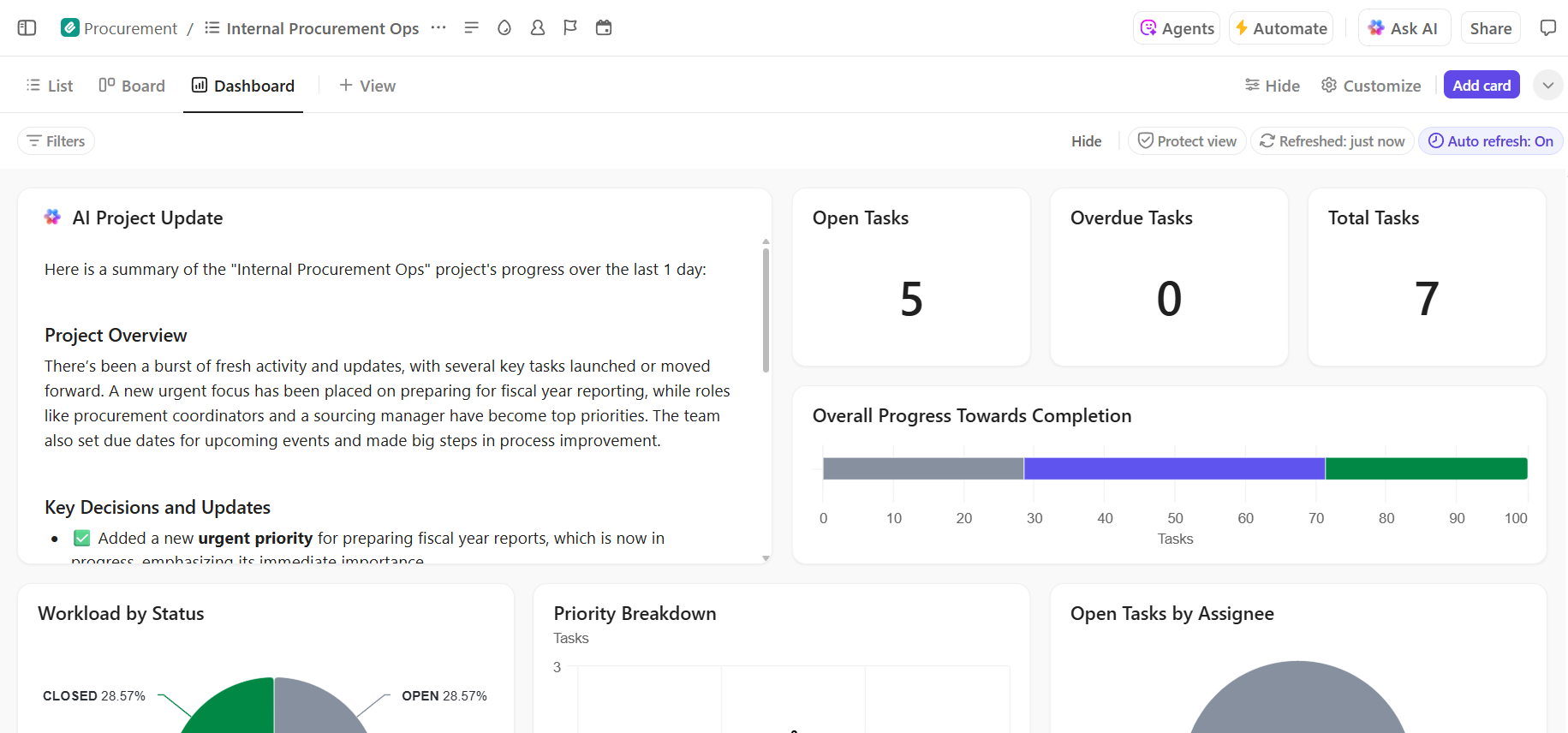

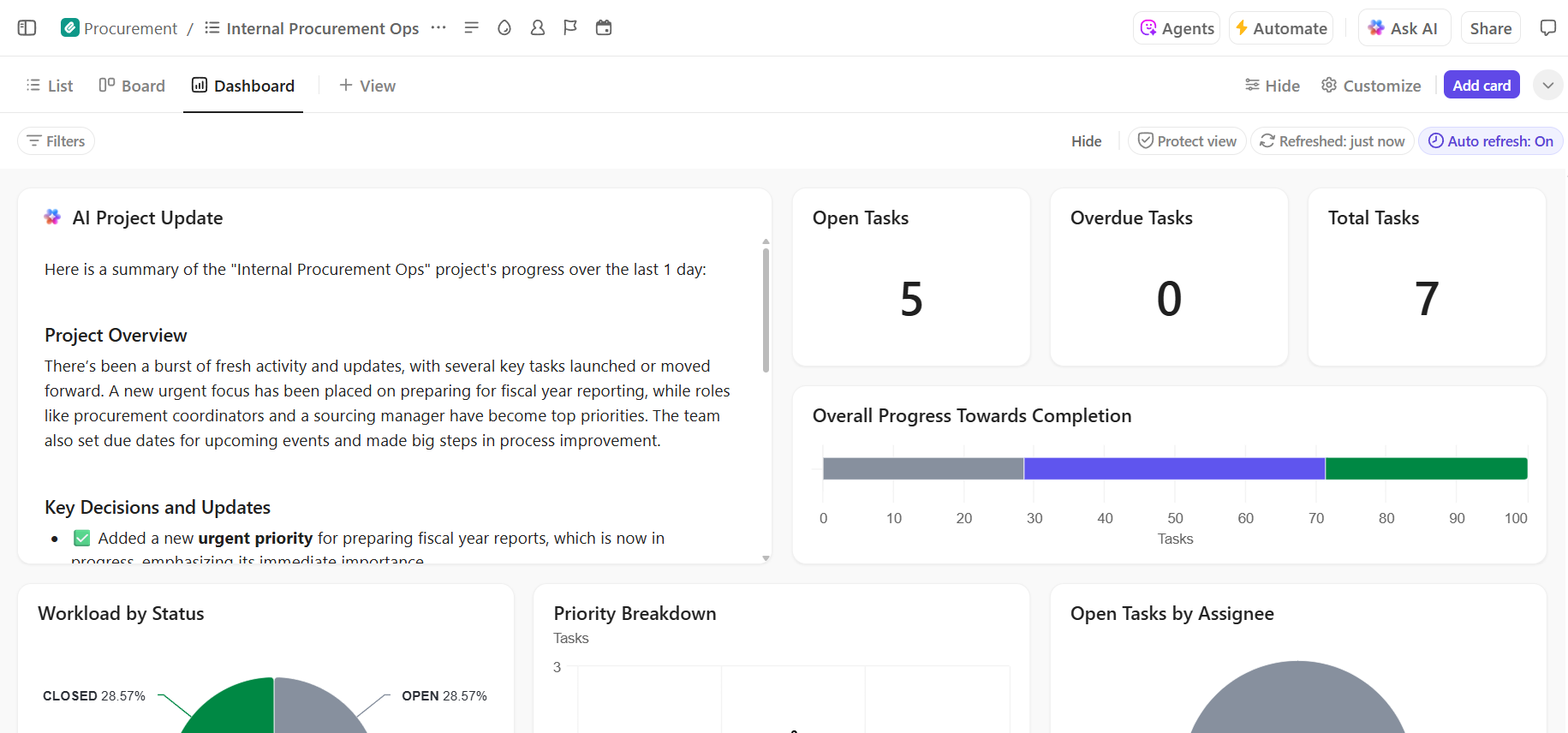

- Tầm nhìn toàn diện về tiến độ triển khai: Theo dõi quy trình triển khai, phát hiện rủi ro sớm và cân bằng sức chứa của nhóm bằng cách sử dụng bảng điều khiển ClickUp hiển thị tiến độ thời gian thực và các điểm nghẽn.

- Tăng tốc quá trình onboarding và truy xuất quyết định với AI tích hợp: Sử dụng ClickUp Brain để tóm tắt các tài liệu triển khai dài, trích xuất thông tin liên quan từ các lần triển khai trước đó và giúp các thành viên mới nhanh chóng làm quen mà không cần phải đào sâu vào bối cảnh lịch sử.

📚 Đọc thêm: Cách tự động hóa quy trình với AI để có các quy trình làm việc nhanh hơn, thông minh hơn.

Quản lý dự án triển khai AI của bạn một cách trơn tru trong ClickUp

Việc triển khai Hugging Face thành công phụ thuộc vào nền tảng kỹ thuật vững chắc và quản lý dự án rõ ràng, có tổ chức. Mặc dù các thách thức kỹ thuật có thể giải quyết được, nhưng thường chính sự thiếu phối hợp và giao tiếp kém là nguyên nhân khiến các dự án thất bại.

Bằng cách thiết lập một quy trình làm việc rõ ràng trên một nền tảng duy nhất, nhóm của bạn có thể triển khai nhanh hơn và tránh được sự phiền toái do thông tin phân tán – khi các nhóm lãng phí hàng giờ tìm kiếm thông tin, chuyển đổi giữa các ứng dụng và cập nhật lại thông tin trên nhiều nền tảng khác nhau.

ClickUp, ứng dụng toàn diện cho công việc, tích hợp quản lý dự án, tài liệu và giao tiếp nhóm vào một nền tảng duy nhất, cung cấp cho bạn nguồn thông tin chính xác duy nhất cho toàn bộ vòng đời triển khai AI của bạn.

Tập trung các dự án triển khai AI của bạn và loại bỏ sự hỗn loạn về công cụ. Bắt đầu miễn phí với ClickUp ngay hôm nay.

Câu hỏi thường gặp (FAQ)

Đúng vậy, Hugging Face cung cấp gói miễn phí hào phóng bao gồm truy cập vào Model Hub, không gian demo chạy trên CPU và API suy luận có giới hạn tốc độ để thử nghiệm. Đối với nhu cầu sản xuất yêu cầu phần cứng chuyên dụng hoặc giới hạn cao hơn, các kế hoạch trả phí có sẵn.

Spaces được thiết kế để lưu trữ các ứng dụng tương tác có giao diện người dùng trực quan, phù hợp cho các bản demo và công cụ nội bộ. Giao diện API suy luận cung cấp quyền truy cập lập trình vào các mô hình, cho phép bạn tích hợp chúng vào ứng dụng của mình thông qua các yêu cầu HTTP đơn giản.

Hoàn toàn có thể. Thông qua các demo tương tác được tổ chức trên Hugging Face Spaces, các thành viên không chuyên về kỹ thuật trong nhóm có thể thử nghiệm và đưa ra phản hồi về các mô hình mà không cần viết một dòng mã nào.

Những hạn chế chính của gói miễn phí bao gồm giới hạn tốc độ trên API Suy luận, việc sử dụng phần cứng CPU được chia sẻ cho Spaces (có thể chậm) và hiện tượng “khởi động lạnh” (cold starts), nơi các ứng dụng không hoạt động cần một lúc để khởi động lại. /