Naarmate LLM's krachtiger worden, is het geven van prompts niet langer het moeilijkste deel. Context wordt de beperkende factor.

Context engineering brengt de juiste informatie in het juiste format naar LLM's (grote taalmodellen).

Wat maakt context engineering zo moeilijk?

Je moet elke laag van de stack ontwerpen om context vast te leggen en beschikbaar te maken. Als je te weinig context verstuurt, weten de LLM's niet wat ze moeten doen. Verstuur je te veel context, dan raak je zonder tokens. Dus hoe vind je de juiste balans?

Hieronder delen we alles wat je moet weten over context engineering.

Wat is AI-context engineering?

AI-context engineering is het proces van het ontwerpen en optimaliseren van instructies en relevante context voor LLM's en geavanceerde AI- en multimodale modellen, zodat ze hun taken effectief kunnen uitvoeren.

Het gaat verder dan het schrijven van prompts. Context engineering bepaalt:

- Welke informatie wordt getoond?

- Waar het vandaan komt (geheugen, tools, databases, documenten)

- Hoe het format is (schema's, samenvattingen, beperkingen)

- Wanneer het in de redeneringslus van het model wordt geïnjecteerd

🌟 Het doel: De informatie die je in het contextvenster van de LLM verstrekt optimaliseren en ruis filteren.

Hoe verbetert context de reacties van AI?

Zonder context voorspelt een LLM de statistisch meest waarschijnlijke voortzetting van de tekst. Aan de andere kant verbetert goede context engineering de output door:

- Verankering van redeneringen: het model baseert zijn antwoorden op bekende feiten in plaats van op statistische gissingen.

- Hallucinaties verminderen: duidelijke beperkingen en relevante gegevens verkleinen de ruimte voor oplossingen.

- Consistentie verbeteren: vergelijkbare inputs leveren vergelijkbare outputs op omdat de contextvorm stabiel is.

- Kosten en latentie verlagen: gerichte context is beter dan het dumpen van hele documenten of geschiedenissen.

Om het samen te vatten in de woorden van Tobi Lutke, CEO van Shopify:

Ik vind de term context engineering veel beter dan prompt engineering. Het beschrijft de kernvaardigheid beter: de kunst om alle context te bieden zodat de Taak op een plausibele manier door de LLM kan worden opgelost.

Ik vind de term context engineering veel beter dan prompt engineering. Het beschrijft de kernvaardigheid beter: de kunst om alle context te bieden zodat de Taak op een plausibele manier door de LLM kan worden opgelost.

De rol van context engineering in AI-gestuurde werkstroomen

In AI-gestuurde werkstroomen zijn LLM's geen op zichzelf staande tools. Ze werken binnen systemen die al beschikken over data, regels en status.

Context engineering stelt het model in staat om te begrijpen waar het zich in de werkstroom bevindt en wat er vervolgens nog te doen is.

Wanneer het model zich bewust is van de huidige toestand, eerdere acties en ontbrekende input, kan het de juiste volgende stap aanbevelen of uitvoeren in plaats van algemeen advies te geven.

Dit betekent ook dat je expliciet bedrijfslogica moet verstrekken, zoals goedkeuringsregels, nalevingsbeperkingen en escalatiepaden. Wanneer deze deel uitmaken van de context, blijven AI-beslissingen in lijn met de operationele realiteit.

Ten slotte maakt context engineering meerstaps- en agentische werkstroomen mogelijk door te zorgen voor een soepele overdracht van status en beslissingen bij elke stap.

Dit voorkomt dat fouten zich opstapelen naarmate werkstroomen worden opgeschaald, waardoor de effectiviteit van de context wordt verbeterd.

👀 Wist je dat? 95% van de GenAI-implementaties in ondernemingen mislukt, niet omdat de modellen zwak zijn, maar omdat organisaties er niet in slagen AI in echte werkstroomen te integreren.

Generieke AI-tools zoals ChatGPT werken goed voor individuen, maar falen op grote schaal omdat ze niet leren van de systeemcontext, bedrijfsregels of veranderende omstandigheden. Met andere woorden, de meeste AI-mislukkingen zijn integratie- en contextmislukkingen, geen modelmislukkingen.

📮ClickUp Insight: 62% van onze respondenten vertrouwt op conversationele AI-tools zoals ChatGPT en Claude. Hun vertrouwde chatbot-interface en veelzijdige mogelijkheden – om content te genereren, gegevens te analyseren en meer – kunnen de reden zijn waarom ze zo populair zijn in diverse rollen en sectoren. Als een gebruiker echter elke keer naar een ander tabblad moet overschakelen om de AI een vraag te stellen, lopen de bijbehorende kosten voor het overschakelen en het wisselen van context na verloop van tijd op. Met ClickUp Brain is dat echter niet het geval. Het bevindt zich in je werkruimte, weet waar je mee bezig bent, begrijpt eenvoudige tekstprompts en geeft je antwoorden die zeer relevant zijn voor je taken! Ervaar een verdubbeling van je productiviteit met ClickUp!

Hoe werkt context engineering?

Context engineering werkt door informatie geleidelijk vorm te geven voordat deze het model bereikt.

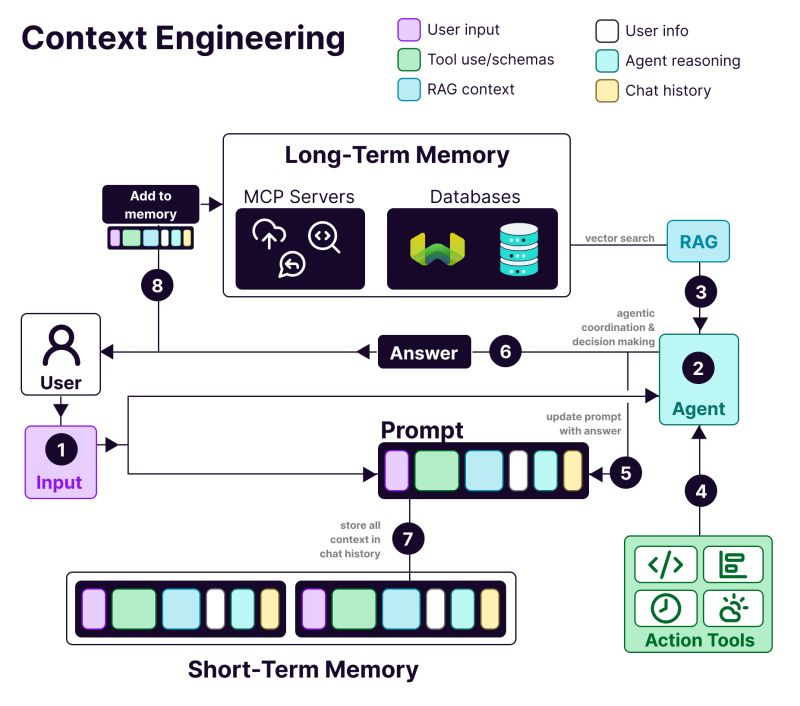

De anatomie van een context-engineered systeem omvat:

- 𝗨𝘀𝗲𝗿 i𝗻𝗳𝗼𝗿𝗺𝗮𝘁𝗶𝗼𝗻: voorkeuren, geschiedenis en personalisatiegegevens

- T𝗼𝗼𝗹 u𝘀𝗲: API's, rekenmachines, zoekmachines – alles wat de LLM nodig heeft om de klus te klaren.

- 𝗥𝗔𝗚 c𝗼𝗻𝘁𝗲𝘅𝘁: Informatie opgehaald uit vector databases zoals Weaviate

- 𝗨𝘀𝗲𝗿 i𝗻𝗽𝘂𝘁: De daadwerkelijke query of taak die moet worden uitgevoerd

- 𝗔𝗴𝗲𝗻𝘁 r𝗲𝗮𝘀𝗼𝗻𝗶𝗻𝗴: Het denkproces en de besluitvormingsketen van de LLM

- 𝗖𝗵𝗮𝘁 h𝗶𝘀𝘁𝗼𝗿𝘆: Eerdere interacties die continuïteit bieden

Voordelen van context engineering in AI-systemen

Dit is waarom je context engineering nodig hebt bij het bouwen van AI-toepassingen:

Nauwkeurigere outputs

Door beslissingsrelevante context te bieden, wordt ambiguïteit verminderd. Het model redeneert binnen bekende feiten, beperkingen en toestanden in plaats van te vertrouwen op probabilistische gissingen.

Consistent gedrag op grote schaal

Stabiele contextstructuren produceren herhaalbare outputs. Vergelijkbare inputs leiden tot vergelijkbare beslissingen – essentieel voor werkstroomen.

Lagere kosten en latentie

Gerichte, gecomprimeerde context voorkomt verspilling van tokens. Systemen reageren sneller zonder herhaaldelijk volledige geschiedenissen of documenten te laden.

Veiligere automatisering

Context codeert bedrijfsregels en toestemmingen. Hierdoor kan AI handelen zonder beleid te schenden of risicovolle acties te triggeren.

Betere meerstapswerkstroomen

Schone context-overdrachten behouden de status tijdens alle stappen. Fouten stapelen zich niet op naarmate werkstroomen complexer of agentischer worden.

Eenvoudiger debuggen en itereren

Gestructureerde context maakt fouten zichtbaar. Je kunt fouten herleiden tot ontbrekende, verouderde of verkeerd gerangschikte inputs in plaats van het model de schuld te geven.

Sterkere acceptatie door ondernemingen

AI-systemen die rekening houden met de context van de werkstroom voelen betrouwbaar aan – een cruciaal verschil tussen pilots en tools voor bedrijfsbrede implementatie.

👀 Wist je dat? Contextbewuste AI heeft een directe invloed op de productiviteit. Uit een onderzoek van Boston Consulting Group blijkt dat communicatieteams alleen al 26-36% van hun tijd kunnen terugwinnen met generatieve AI. Met opnieuw ontworpen werkstroomsystemen en agentische systemen die context begrijpen, kan de productiviteitswinst oplopen tot 50%.

AI-context engineering versus prompt engineering

Prompt engineering: Vraag ChatGPT om een e-mail te schrijven waarin een nieuwe functie wordt aangekondigd. Je schrijft instructies voor een enkele Taak.

Context engineering: Je bouwt een klantenservicebot. Deze moet eerdere tickets onthouden, toegang hebben tot gegevens over gebruikersaccounts en de geschiedenis van de gesprekken bijhouden.

Zoals AI-onderzoeker Andrej Karpathy uitlegt:

Mensen associëren prompts met korte beschrijvingen van taken die je een LLM in het dagelijks gebruik zou geven. In elke industriële LLM-app is context engineering de delicate kunst en wetenschap van het vullen van het contextvenster met precies de juiste informatie voor de volgende stap.

Mensen associëren prompts met korte beschrijvingen van taken die je een LLM in het dagelijks gebruik zou geven. In elke industriële LLM-app is context engineering de delicate kunst en wetenschap van het vullen van het contextvenster met precies de juiste informatie voor de volgende stap.

+1 voor "context engineering" boven "prompt engineering".

Mensen associëren prompts met korte beschrijvingen van taken die je een LLM in het dagelijks gebruik zou geven. In elke industriële LLM-app is context engineering de delicate kunst en wetenschap van het vullen van het contextvenster... https://t.co/Ne65F6vFcf

— Andrej Karpathy (@karpathy) 25 juni 2025

+1 voor "context engineering" boven "prompt engineering".

Mensen associëren prompts met korte beschrijvingen van taken die je een LLM in het dagelijks gebruik zou geven. In elke industriële LLM-app is context engineering de delicate kunst en wetenschap van het vullen van het contextvenster... https://t.co/Ne65F6vFcf

— Andrej Karpathy (@karpathy) 25 juni 2025

| Aanpak | Waar het zich op richt | Meest geschikt voor |

| Prompt engineering | Instructies en formaten voor het model opstellen | Eenmalige taken, contentgeneratie, formaatspecifieke outputs |

| Context engineering | Relevante gegevens, status en beperkingen aan het model verstrekken | Conversational AI, tools voor documentanalyse, codeerassistenten |

| Beide samen | Combineer duidelijke instructies met context op systeemniveau | Productie-AI-toepassingen die consistente, betrouwbare prestaties vereisen |

De meeste toepassingen maken gebruik van een combinatie van prompt engineering en context engineering. Je hebt nog steeds goed geschreven prompts nodig in je context engineering-systeem.

Het verschil is dat die prompts werken met zorgvuldig beheerde achtergrondinformatie. Je hoeft niet elke keer opnieuw te beginnen.

📮 ClickUp Insight: Meer dan de helft van de respondenten typt dagelijks in drie of meer tools en kampt met " AI Sprawl " en versnipperde werkstroom.

Hoewel het misschien productief en druk aanvoelt, raakt je context gewoon verloren tussen verschillende apps, om nog maar te zwijgen van de energie die het typen kost. Brain MAX brengt alles samen: spreek één keer en je updates, taken en aantekeningen komen precies terecht waar ze thuishoren in ClickUp. Geen schakelen meer, geen chaos meer – alleen naadloze, gecentraliseerde productiviteit.

Toepassingen van AI-context engineering

De sleutelgebieden waarop AI-context engineering al wordt geïmplementeerd, zijn 👇

Klantenservice en helpdeskautomatisering

De meeste chatbots behandelen elk bericht als nieuw, waardoor gebruikers zich steeds opnieuw moeten herhalen.

Met context engineering kan AI verwijzen naar de geschiedenis van de gebruiker, eerdere interacties, aankoopgegevens en productdocumentatie. Hierdoor reageert het als een teamgenoot die het probleem al kent.

📌 Praktijkvoorbeeld: Het ondersteuningsteam van Coda behandelt technische productvragen waarvoor kennis van eerdere berichten en productdocumentatie nodig is. Om de ondersteuning op te schalen, gebruiken ze Intercom Fin. Fin leest documentatie en eerdere gesprekken voordat het antwoordt, waardoor 50-70% van de vragen van klanten autonoom kan worden opgelost met behoud van een hoge CSAT.

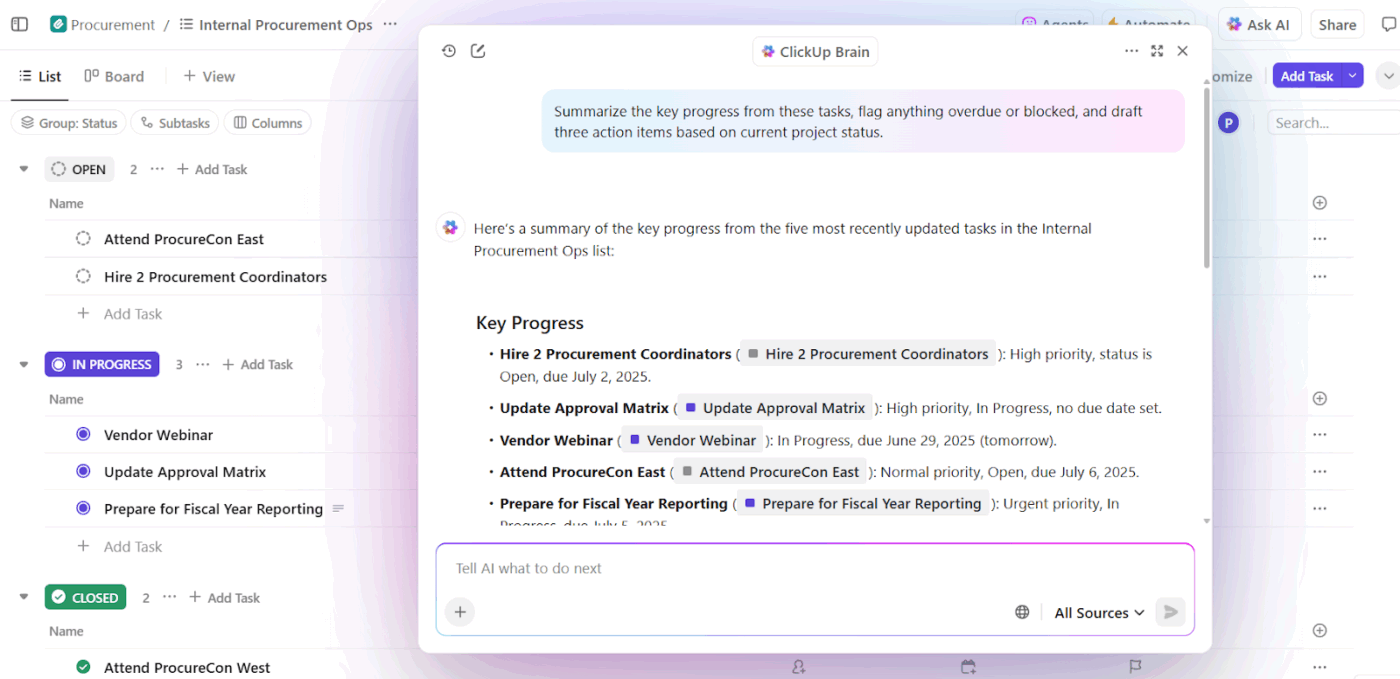

AI-schrijf- en productiviteitsassistenten op de werkplek

AI-schrijftools leveren alleen waarde als ze begrijpen waar je mee bezig bent, waarom het belangrijk is en wat er al bestaat. Zonder die context besparen ze tijd bij het opstellen van concepten, maar vereisen ze nog steeds veel herschrijven en handmatige aanpassingen.

Dit is waar context engineering AI het verschil maakt. Door AI te baseren op de status van taken, documenten, eerdere beslissingen en teamconventies, evolueren schrijfassistenten van het genereren van generieke teksten naar werkstroom-bewuste ondersteuning.

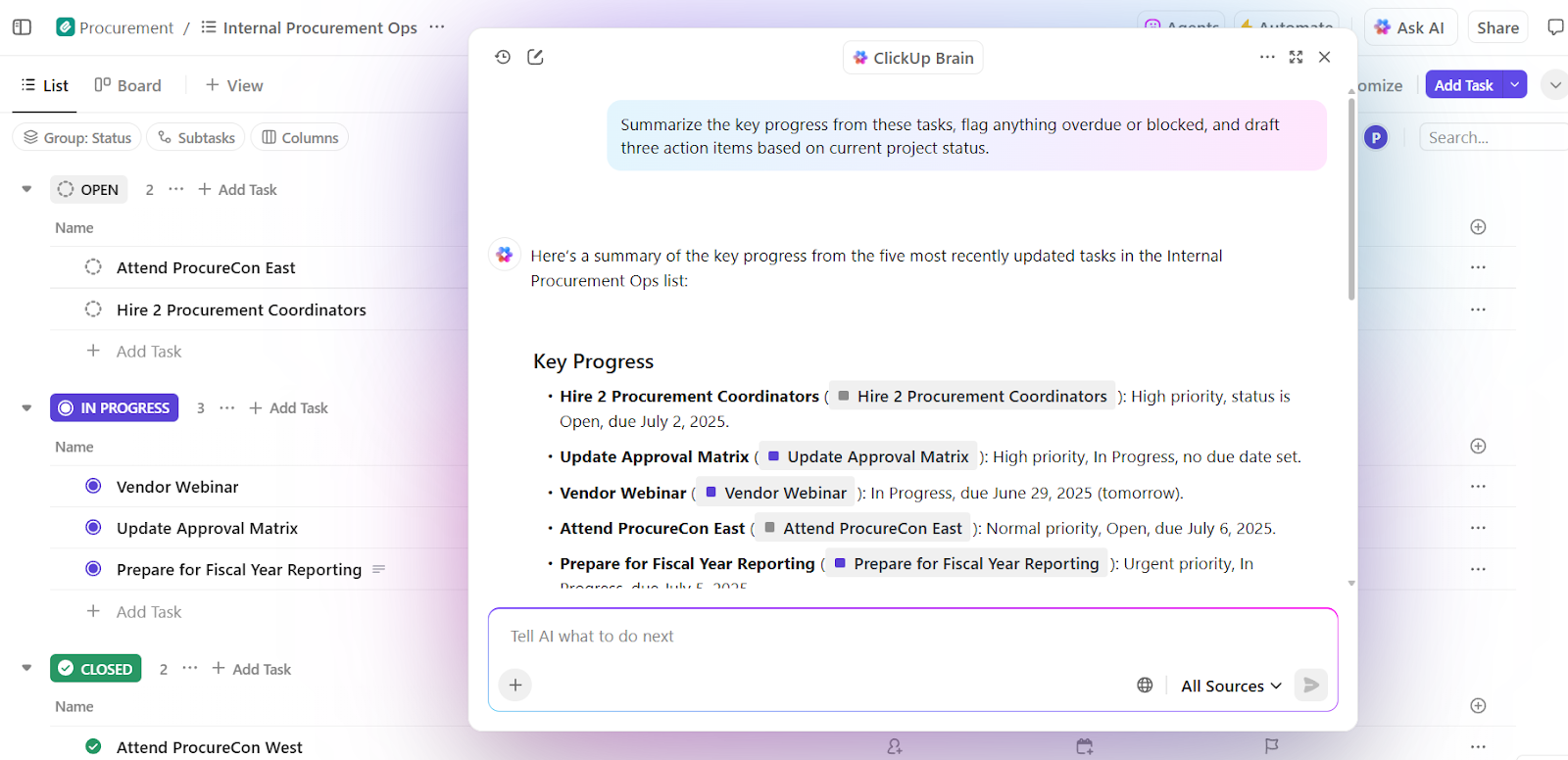

📌 Praktijkvoorbeeld: ClickUp Brain, de eigen AI van ClickUp, past context engineering toe op werkplekniveau. In plaats van gebruikers te vragen achtergrondinformatie in prompts te plakken, haalt het de context rechtstreeks uit taken, documenten, opmerkingen, prioriteiten en tijdlijnen.

Een belangrijke vaardigheid is contextuele besluitvorming. Hierbij worden lopende projecten geëvalueerd in combinatie met de capaciteit van het team en prestaties uit het verleden om bruikbare inzichten te verkrijgen.

Ten eerste kan Brain overbelasting, vertragingen en knelpunten detecteren. Naast een samenvatting van het probleem doet het ook concrete aanbevelingen voor aanpassingen, in de vorm van de verdeling van taken, het bijwerken van tijdlijnen en de verdeling van prioriteiten.

Omdat deze beslissingen gebaseerd zijn op een live werkruimte-context, is de output direct bruikbaar. Het is niet nodig om de achtergrond opnieuw uit te leggen, prioriteiten toe te lichten of aanbevelingen handmatig af te stemmen op de werkelijkheid.

Teams die ClickUp Brain gebruiken, melden 2,26 keer hogere volledige integratiepercentages en de laagste AI-frustratiescores (27,1%).

Verkoop- en CRM-informatie

Verkoopwerkstroomen omvatten e-mails, vergaderingen, CRM's en spreadsheets. Zonder context kan AI het momentum van een deal of de intentie van een koper niet begrijpen.

Context engineering geeft AI zichtbaarheid in gesprekken met kopers, tijdlijnen, communicatietoon en eerdere interacties. Dit helpt om inzichten naar boven te halen, vastgelopen deals op te sporen en de juiste volgende actie voor te stellen.

📌 Praktijkvoorbeeld: het eigen verkoopteam van Microsoft gebruikt Copilot for Sales, dat context haalt uit Outlook, Teams-gesprekken, CRM-updates en aantekeningen om de juiste inzichten naar voren te brengen en follow-ups op te stellen. Interne teams zagen een stijging van 20% in het aantal gewonnen deals en een stijging van 9,4% in de omzet per verkoper, wat aantoont hoe contextgedreven AI de prestaties verbetert.

Gezondheidszorg en klinische AI-assistenten

Medische beslissingen zijn gebaseerd op de geschiedenis van de patiënt, laboratoriumrapporten, recepten en aantekeningen van artsen, maar deze informatie staat vaak in losstaande systemen. Hierdoor verliezen artsen veel tijd met het opnieuw invoeren van gegevens en lopen ze het risico cruciale details over het hoofd te zien. Soms besteden ze bijna 40% van hun tijd aan administratief werk.

AI-context engineering vormt deze gegevenspunten in een verbinding. Het ondersteunt clinici met nauwkeurige samenvattingen, conceptdocumentatie, relevante geschiedenis en brengt potentiële risico's of volgende stappen aan het licht.

📌 Praktijkvoorbeeld: Atrium Health gebruikt Nuance DAX Copilot, ontwikkeld in samenwerking met Microsoft, om klinische bezoeken automatisch te documenteren aan de hand van eerdere dossiers en realtime gesprekken. Als resultaat bespaarden clinici 30 tot 40 minuten per dag op documentatie, terwijl een onderzoek onder 12 medische specialismen een hogere efficiëntie en tevredenheid van providers rapporteerde zonder dat dit ten koste ging van de veiligheid van patiënten.

HR- en recruitmentassistenten

Wervingsbeslissingen zijn afhankelijk van context, zoals vaardigheden, feedback uit sollicitatiegesprekken, geschiktheid voor de rol en gegevens over eerdere aanwervingen. Met AI-context engineering kun je cv's, functieomschrijvingen, transcripties van sollicitatiegesprekken en historische patronen analyseren om sneller geschikte kandidaten te vinden.

📌 Praktijkvoorbeeld: De enterprise-teams bij Micron gebruiken Eightfold AI, een talent intelligence-platform dat cv's, rol-eisen, interne carrièrepaden en eerdere wervingsresultaten analyseert om te voorspellen of iemand geschikt is voor een rol. Het platform beoordeelt kandidaten op basis van vaardigheden en potentieel. Het resultaat? Een uitbreiding van hun talentpijplijn en acht extra kandidaten per maand met een klein wervingsteam.

Tools en platforms die context engineering ondersteunen

Welke tools helpen je bij het implementeren van context engineering op grote schaal?

1. LangChain (het beste om context programmatisch samen te stellen)

LangChain is een open-source orchestration framework voor het bouwen van AI-systemen waarbij context programmatisch moet worden samengesteld, bijgewerkt en gerouteerd.

De AI-agenttool helpt ontwikkelaars om verbinding te maken met LLM's via tools, databronnen, geheugen en besturingslogica in plaats van te vertrouwen op statische prompts.

Core LangChain zorgt voor het koppelen en ophalen, terwijl LangGraph stateful, grafiekgebaseerde werkstroommogelijkheden biedt voor complexe, meerstapsredeneringen.

DeepAgents bouwt voort op deze basis om langlopende, autonome agents te ondersteunen met planning, subagents en persistente context.

Samen vormen deze componenten LangChain tot een controlelaag voor context engineering, die bepaalt wanneer context wordt opgehaald, hoe deze zich ontwikkelt en waar deze door agentische werkstroom stroomt.

De beste functies van LangChain

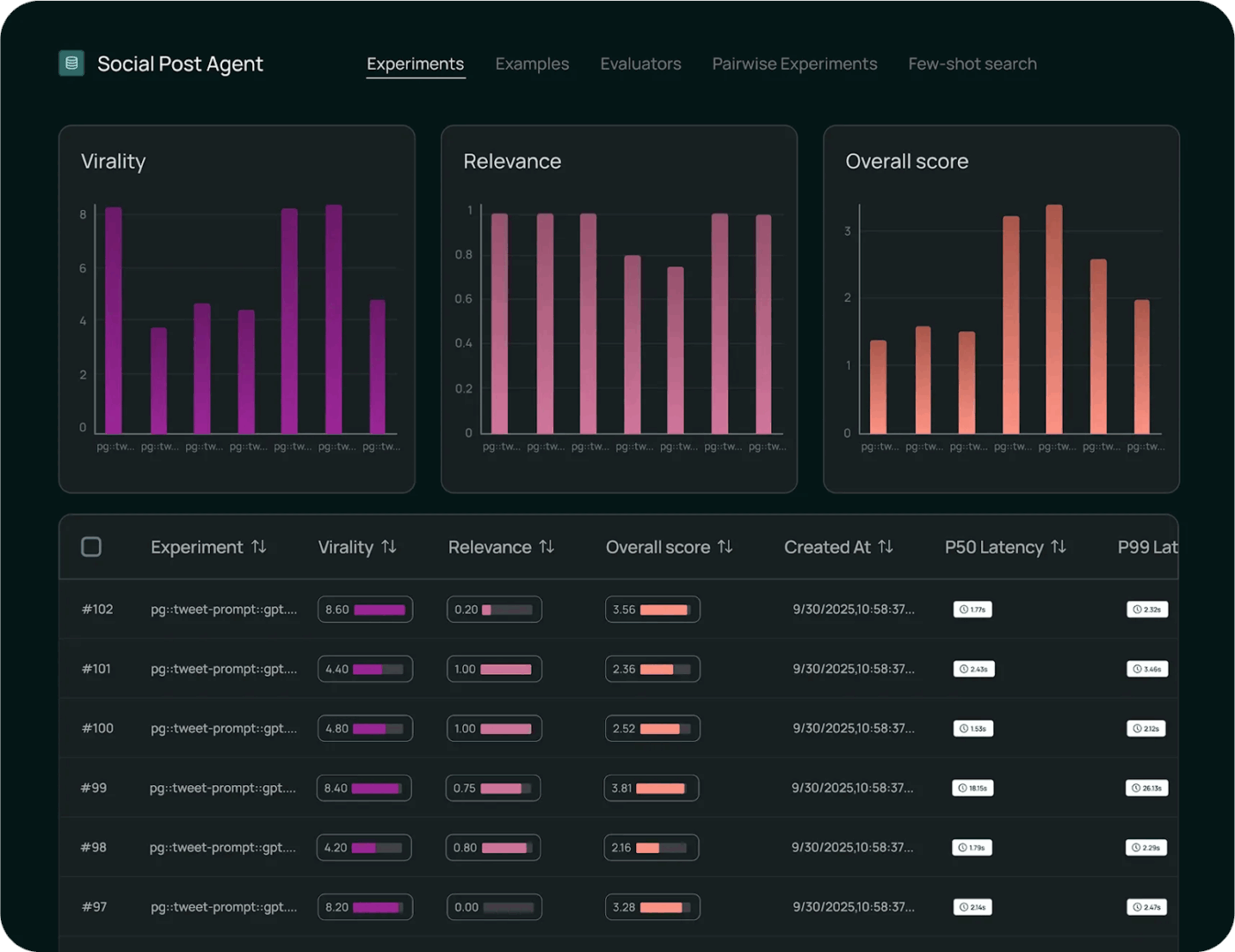

- Monitor de uitvoering met observability tools om modelaanroepen, latentie, fouten en werkstroom end-to-end bij te houden voor debugging en prestatie-inzichten.

- Evalueer het gedrag van het model systematisch met behulp van ingebouwde testframeworks die de juistheid meten, outputs vergelijken en wijzigingen valideren aan de hand van benchmarks.

- Implementeer werkstroomen op grote schaal met beheerde omgevingen die versiebeheer, roll-outcontrole en productieklare uitvoering van chains en agents ondersteunen.

Beperkingen van LangChain

- De tool heeft een steile leercurve voor beginners en de documentatie, die om de paar dagen wordt bijgewerkt, maakt het overweldigend.

Prijzen van LangChain

- Ontwikkelaar: Gratis

- Plus: $39/gebruiker/maand

- Enterprise: Aangepaste prijzen

LangChain-beoordelingen en recensies

- G2: 4,7/5 (meer dan 30 beoordelingen)

- Capterra: Onvoldoende beoordelingen en recensies

Wat zeggen gebruikers in de praktijk over LangChain?

Volgens een gebruiker op Reddit:

Na een aantal verschillende methoden te hebben getest, ben ik uiteindelijk uitgekomen bij het gebruik van standaard tool calling met langgraph-werkstroomen. Ik verpak de deterministische werkstroomen dus als agents die de hoofd-LLM als tools aanroept. Op deze manier biedt de hoofd-LLM een echte dynamische UX en draagt hij het zware werk gewoon over aan een werkstroom, die vervolgens zijn output netjes teruggeeft aan de hoofd-LLM.

Na een aantal verschillende methoden te hebben getest, ben ik uiteindelijk uitgekomen bij het gebruik van standaard tool calling met langgraph-werkstroomen. Ik verpak de deterministische werkstroomen dus als agents die de hoofd-LLM als tools aanroept. Op deze manier biedt de hoofd-LLM een echte dynamische UX en draagt hij het zware werk gewoon over aan een werkstroom, die vervolgens zijn output netjes teruggeeft aan de hoofd-LLM.

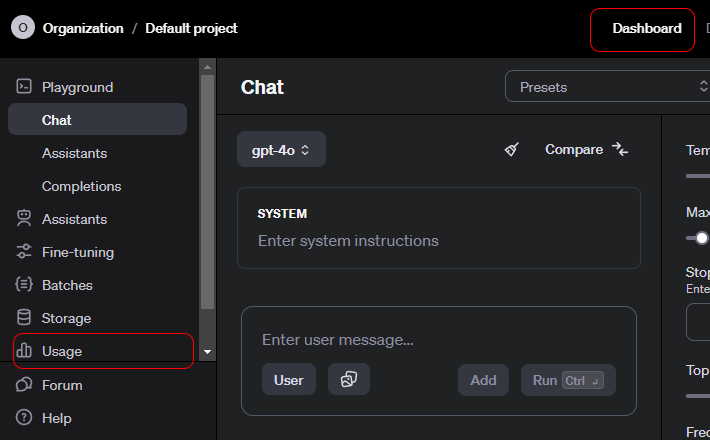

2. OpenAI API (Contextual AI API biedt gestructureerde context, tool-aanroepen en controles op systeemniveau)

De OpenAI API is een algemene interface voor toegang tot geavanceerde generatieve AI-modellen die een breed bereik aan toepassingen mogelijk maken.

Ontwikkelaars gebruiken het om taalbegrip en -generatie in producten te integreren. Het ondersteunt ook samenvatting, vertaling, code-assistentie en redeneren.

De API ondersteunt chat, embeddings, functieaanroepen, moderatie en multimodale invoer, waardoor gestructureerde interacties met modellen mogelijk zijn. OpenAI is zeer geschikt voor rapid prototyping, omdat het verificatie, schaalbaarheid en versiebeheer afhandelt.

Het gebruiksgemak is te danken aan de manier waarop de API complex modelgedrag abstraheert tot eenvoudige, betrouwbare eindpunten.

De beste functies van de OpenAI API

- Genereer contextbewuste outputs voor tekst, code en multimodale inputs voor natuurlijke taakken en redeneringen.

- Creëer rijke embeddings om semantisch zoeken, clustering en vectorgebaseerde werkstroomen mogelijk te maken.

- Roep functies en tools aan via gestructureerde oproepen waarmee modellen kunnen communiceren met externe systemen en diensten.

Limiet van de OpenAI API

- Geen native langetermijngeheugen. De API is standaard stateless.

Prijzen van OpenAI API

GPT-5. 2

- Input: $1. 750 / 1 miljoen tokens

- Cache-input: $0,175 / 1 miljoen tokens

- Output: $14.000 / 1 miljoen tokens

GPT-5. 2 Pro

- Input: $ 21,00 / 1 miljoen tokens

- Cache-input: Niet beschikbaar

- Output: $168,00 / 1 miljoen tokens

GPT-5 Mini

- Input: $0,250 / 1 miljoen tokens

- Cached input: $0,025 / 1 miljoen tokens

- Output: $ 2.000 / 1 miljoen tokens

OpenAI API-beoordelingen en recensies

- G2: Onvoldoende beoordelingen

- Capterra: Niet genoeg beoordelingen

Wat zeggen echte gebruikers over OpenAI API?

Volgens een gebruiker op Reddit:

De API's van OpenAI zijn net als alle andere, dus vanuit technisch oogpunt zou er geen leercurve moeten zijn. Alle eindpunten, parameters en voorbeelden van reacties zijn goed gedocumenteerd. Als je basiservaring hebt met ontwikkelen, heb je geen cursus nodig. Ik ben het eens met het bovenstaande punt om Python te leren. De Python-bibliotheken bevatten alle relevante informatie om het leven gemakkelijker te maken. Er zijn ook Node-bibliotheken als je bij JS wilt blijven. De grootste leercurve zal zijn hoe je ze strategisch kunt gebruiken. Besteed wat tijd aan het uitproberen van systeemberichten, gebruikersprompts en parameters in de Playground voordat je probeert om het met code te bouwen. (Ik ben er vrij zeker van dat je voorbeeldcode kunt krijgen van Playground nadat je iets hebt gevonden dat werkt. )

De API's van OpenAI zijn net als alle andere, dus vanuit technisch oogpunt zou er geen leercurve moeten zijn. Alle eindpunten, parameters en voorbeelden zijn goed gedocumenteerd. Als je basiservaring hebt met ontwikkelen, heb je geen cursus nodig. Ik ben het eens met het bovenstaande punt om Python te leren. De Python-bibliotheken bevatten alle relevante informatie om het leven gemakkelijker te maken. Er zijn ook Node-bibliotheken als je bij JS wilt blijven. De grootste leercurve zal zijn hoe je ze strategisch kunt gebruiken. Besteed wat tijd aan het uitproberen van systeemberichten, gebruikersprompts en parameters in de Playground voordat je probeert om het met code te bouwen. (Ik ben er vrij zeker van dat je voorbeeldcode kunt krijgen van Playground nadat je iets hebt gevonden dat werkt. )

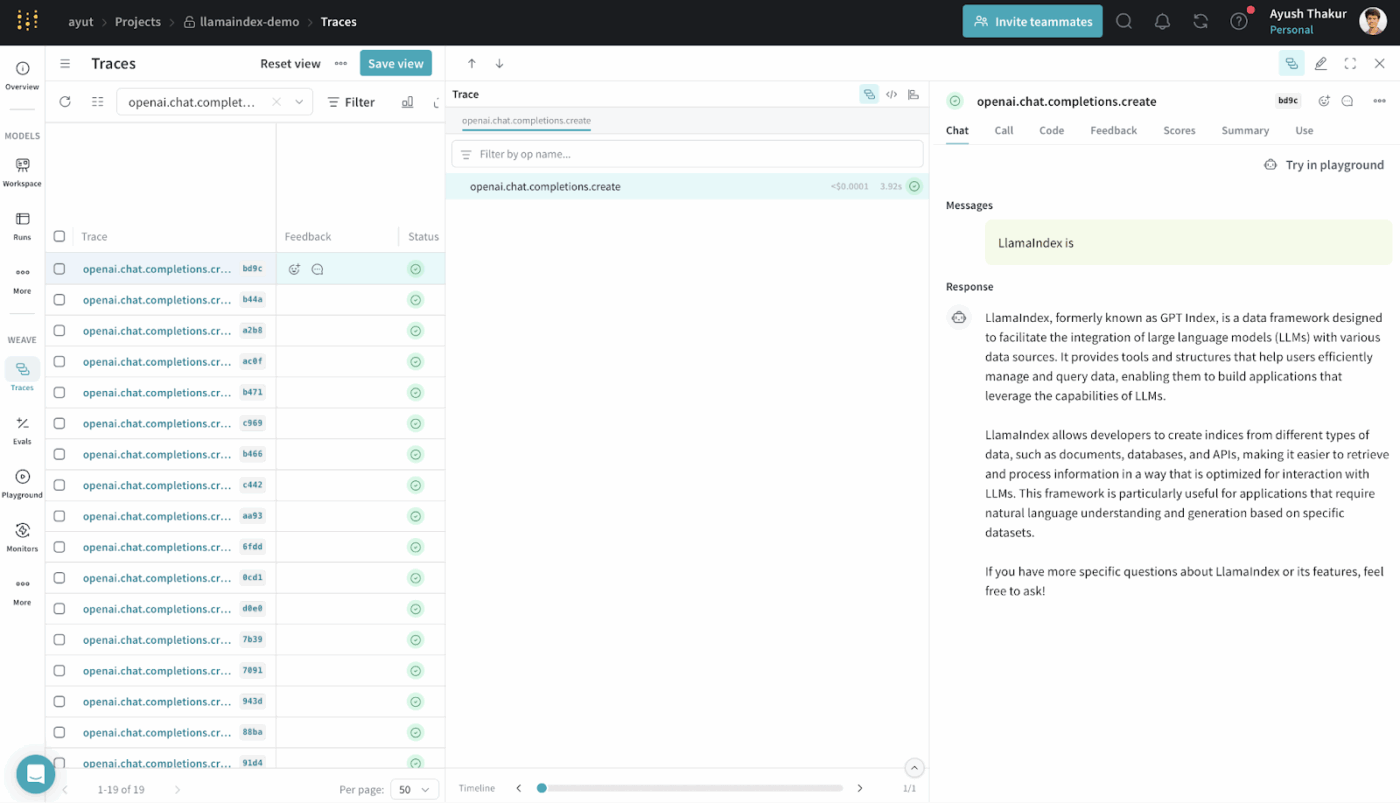

3. LlamaIndex (het beste voor het genereren van een systeem voor het verbeteren van het ophalen van informatie)

LlamaIndex is een open-source dataframework dat is ontworpen om externe data toegankelijk en bruikbaar te maken voor grote taalmodellen.

Het biedt connectoren, indexen en query-interfaces die gestructureerde en ongestructureerde data omzetten in representaties waar LLM's efficiënt over kunnen redeneren.

Je kunt RAG-systemen bouwen zonder diepgaande aangepaste infrastructuur. Het abstraheert het ophalen, vectoriseren en rangschikken op relevantie.

Het wordt vaak gebruikt voor toepassingen zoals semantisch zoeken, samenvatten en het beantwoorden van vragen, gebaseerd op echte gegevens.

De beste functies van LlamaIndex

- Indexeer heterogene databronnen in doorzoekbare structuren die LLM's effectief kunnen queryen.

- Haal context strategisch op met behulp van vectorzoekopdrachten en queryplanning voor nauwkeurige bewijsinjectie.

- Comprimeer en vat de context samen om het redeneren efficiënt en relevant te houden.

Prijzen van LlamaIndex

- Free

- Starter: $50/maand

- Pro: $500/maand

- Enterprise: Aangepaste prijzen

LlamaIndex-beoordelingen en recensies

- G2: Onvoldoende beoordelingen

- Capterra: Niet genoeg beoordelingen

Wat zeggen echte gebruikers over LlamaIndex?

Een gebruiker deelt op Reddit:

Eerlijk gezegd vind ik de meeste genAi-frameworks zoals langchain en llamaindex niet zo goed en maken ze de code alleen maar ingewikkelder. Het is beter om vanilla python te gebruiken.

Eerlijk gezegd vind ik de meeste genAi-frameworks zoals langchain en llamaindex niet zo goed en maken ze de code alleen maar ingewikkelder. Het is beter om vanilla python te gebruiken.

4. ClickUp BrainGPT (het beste als je AI-assistent voor je werkruimte)

De meeste tools in deze lijst helpen je met specifieke aspecten van context engineering. Ze stellen prompts samen, halen gegevens op of coördineren werkstroomen.

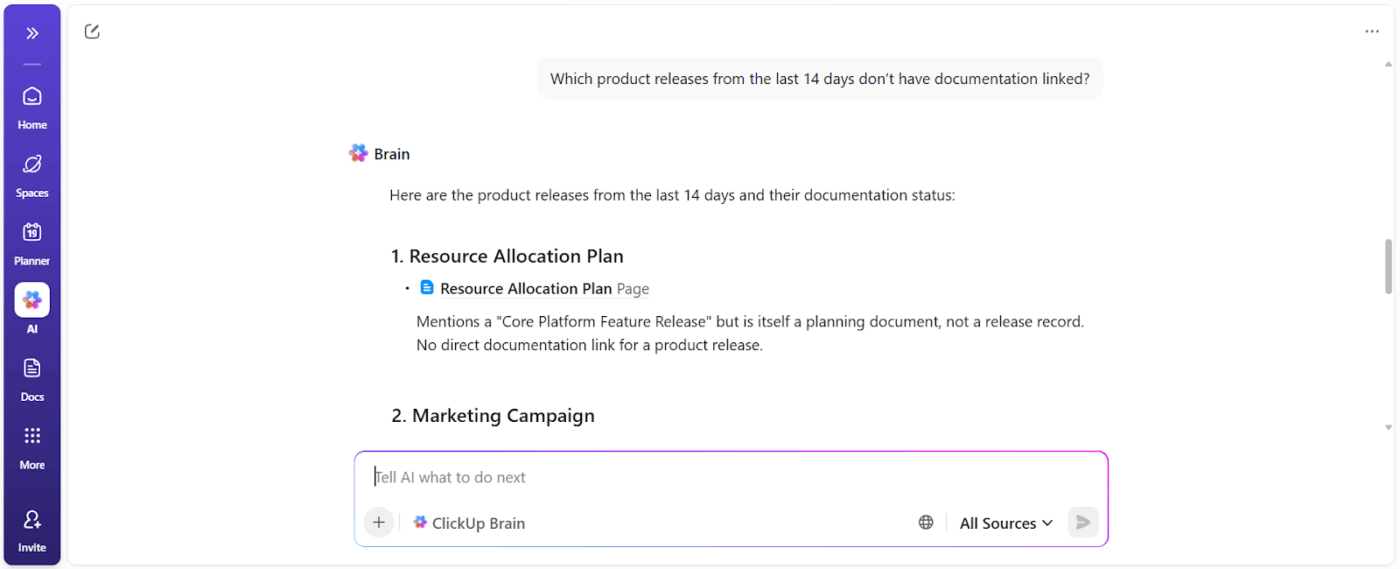

ClickUp Brain kiest voor een andere aanpak. Als 's werelds eerste Converged AI-werkruimte brengt ClickUp je projecten, taken, documenten en communicatie samen op één platform, met een contextbewuste AI die erin is ingebouwd.

Hier volgt hoe 👇

Werk met AI die jou en je werk begrijpt

ClickUp Brain begrijpt de context van je werk.

Het haalt context uit je ClickUp-taken, documenten, opmerkingen, afhankelijkheden, statussen, tijdlijnen en eigendom. Je hoeft niet elke keer dat je een vraag stelt op basis van werkruimtegegevens de achtergrond te plakken of de projectgeschiedenis uit te leggen.

📌 Als voorbeeld, wanneer een manager vraagt: "Wat vertraagt de campagne voor het derde kwartaal?" Het scant de werkruimte en brengt concrete belemmeringen naar boven, zoals:

- Niet-toegewezen taken

- In afwachting van goedkeuring

- Vertraagde beoordelingen

- Afhankelijkheden die wachten op assets

Je krijgt een blokkeringsrapport dat de eigenaars van acties en de tijdsimpact laat zien.

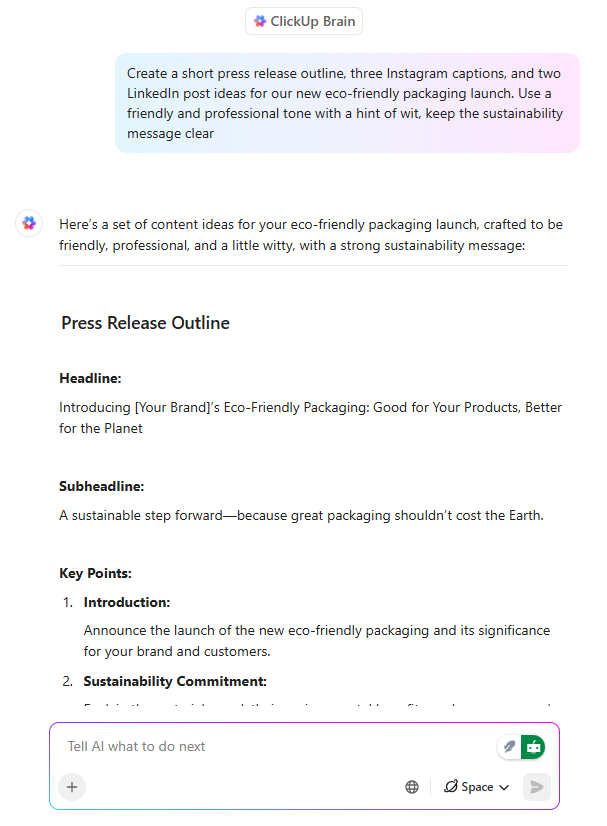

AI-schrijven dat al is afgestemd op de uitvoering

ClickUp Brain fungeert als een AI-schrijfassistent, maar met een cruciaal verschil: het schrijft met kennis van wat het team aan het bouwen is.

Wanneer een productmanager of marketeer een lanceringsbericht opstelt in een ClickUp-document, kan Brain:

- Definieer waardeproposities aan de hand van de bestaande productcontext.

- Pas berichten aan voor verschillende doelgroepen

- Herschrijf content zodat deze aansluit bij de toon, duidelijkheid of positioneringsdoelen.

Nog belangrijker is dat het schrijven verbonden blijft met taken, tijdlijnen en goedkeuringen. Er is geen discrepantie tussen de documentatie en het werk. Dit zorgt voor een sterke verbinding tussen de documentatie en het werk, waardoor er weinig tijd verloren gaat bij het opnieuw interpreteren van de content later.

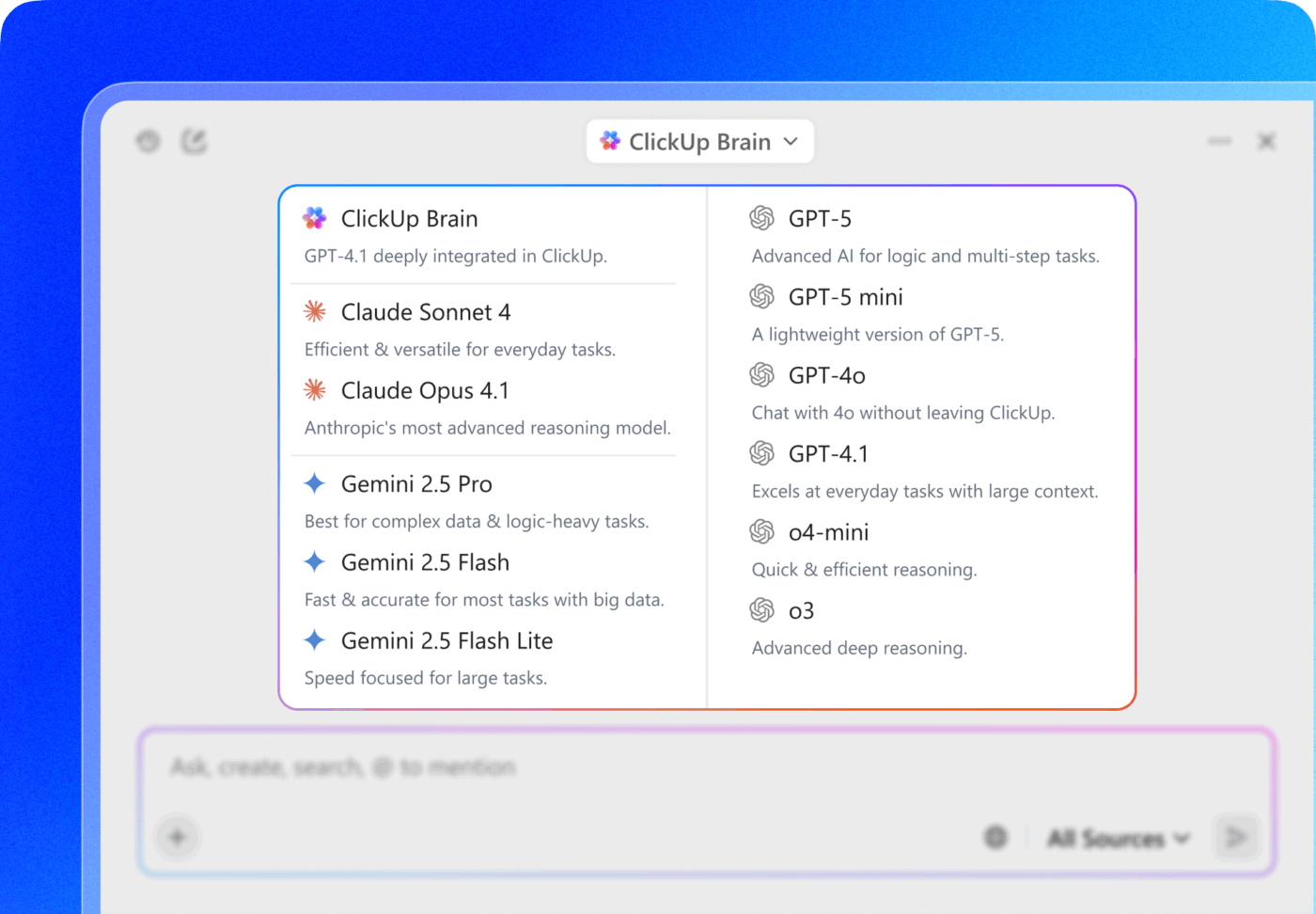

💡 Pro-tip: Kies uit meerdere AI-modellen van ChatGPT, Claude en Gemini, rechtstreeks in ClickUp Brain!

- Gebruik een snel, lichtgewicht model om aantekeningen van een vergadering binnen een Taak samen te vatten.

- Schakel over naar een model dat meer op redeneren is gebaseerd wanneer je de campagneprestaties analyseert in documenten, taken en dashboards.

De echte krachtige zet? Koppel de selectie van het model aan de verbonden context van ClickUp – taken, opmerkingen, documenten en aangepaste velden – zodat het model niet alleen 'slim' is, maar ook binnen de realiteit van je werkelijke werkruimte functioneert.

Contextuele taaktautomatisering die handmatige overhead vermindert

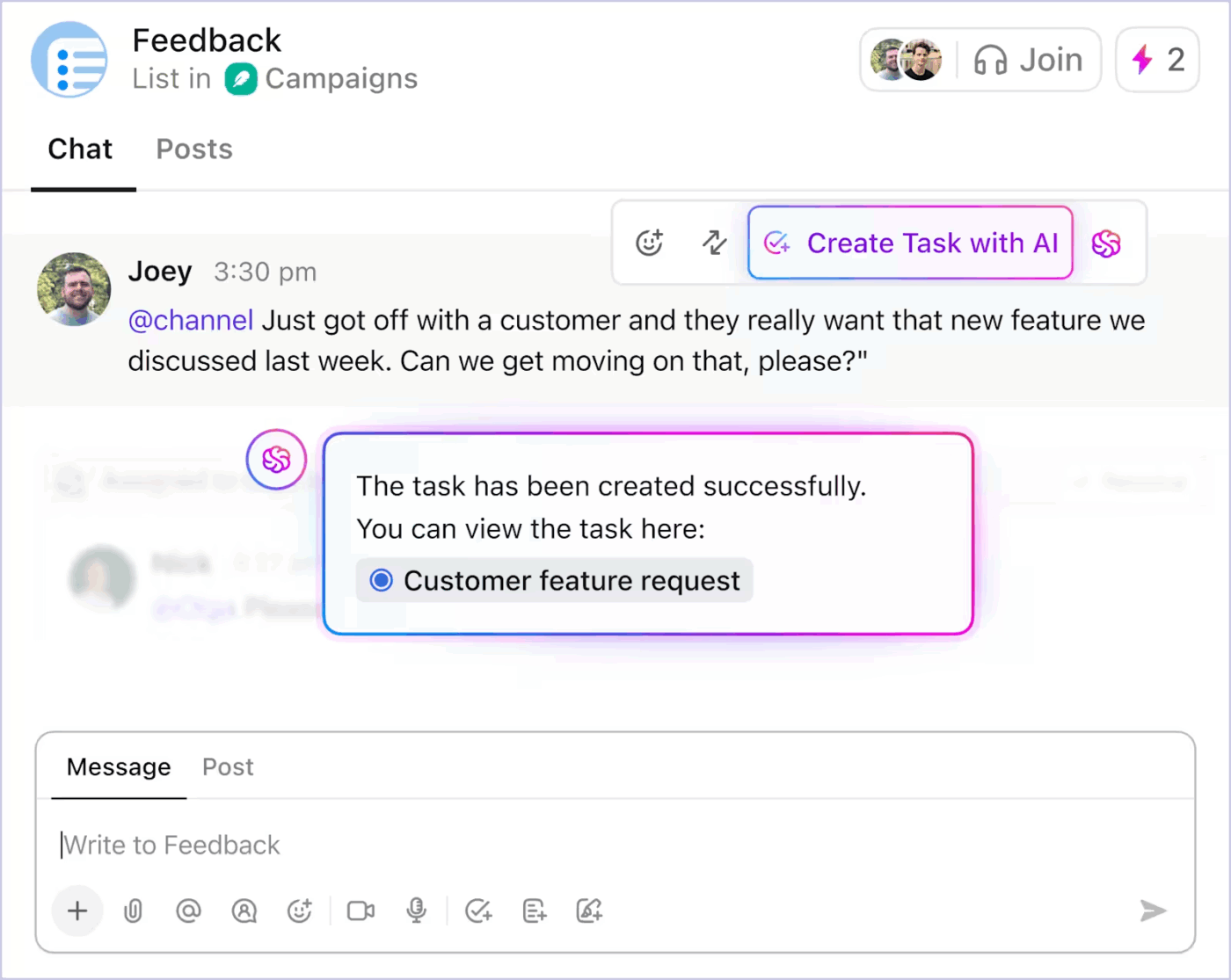

Met AI-aangedreven taken zet ClickUp context om in actie. De belangrijkste functies zijn:

- Zet discussies uit ClickUp Chat om in taken

- Genereer subtaaken en taakbeschrijvingen op basis van een bestaande taaktitel en de reikwijdte ervan.

- Suggereer volgende stappen wanneer het werk stilvalt

- Automatiseer routinematige updates met behulp van de werkelijke projectstatus

Hier leest u hoe u AI-aangedreven automatisering van Taak-automatisering in ClickUp kunt gebruiken om het saaie werk te verminderen 👇

Omdat automatisering wordt aangestuurd door live context, besteden teams minder tijd aan het vertalen van intenties naar structuur. Het werk vordert zonder voortdurende handmatige tussenkomst.

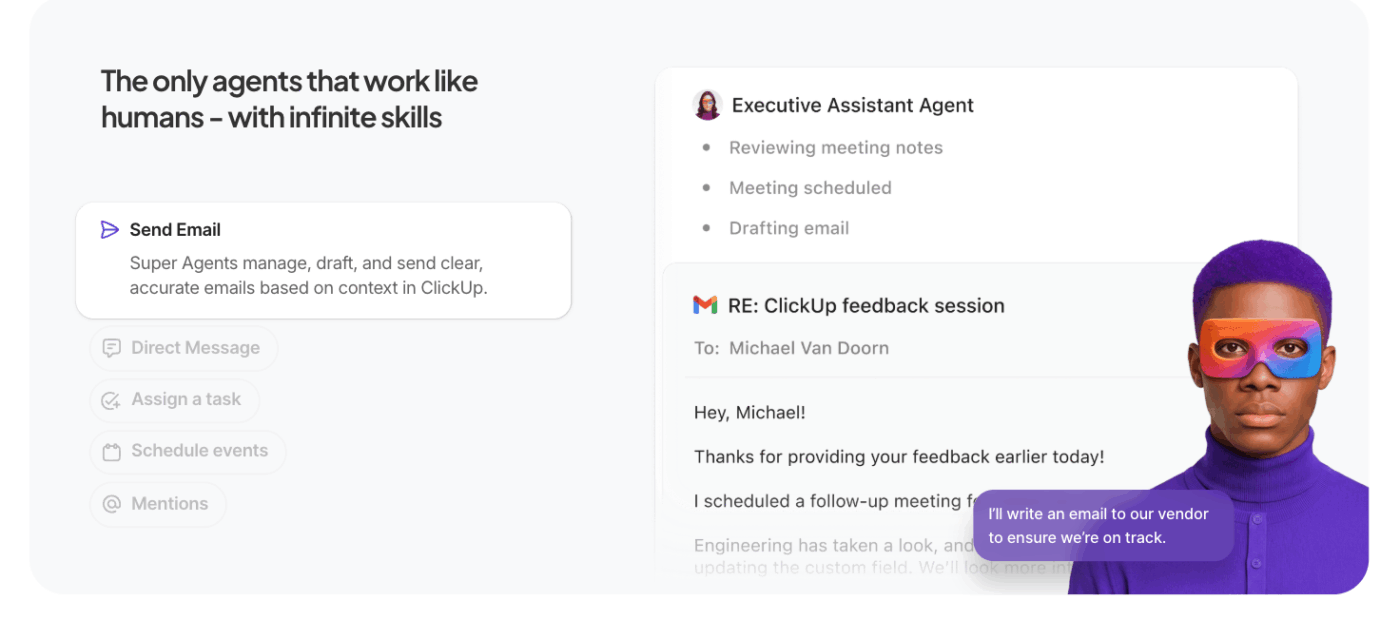

Laat AI-agenten het zware werk doen

ClickUp Super Agents breiden de contextuele AI van ClickUp uit van enkele queries naar autonome, meerstapsuitvoering.

In plaats van te wachten op specifieke prompts, handelen deze AI-agenten voor automatisering namens jou binnen de werkruimte en werken ze taken, regels en resultaten af op basis van de context en doelen die jij definieert.

Wat hen onderscheidt van gewone agenten:

- Proactieve taakuitvoering: Agenten interpreteren de context van de werkruimte – taken, afhankelijkheden, tijdlijnen – en voeren reeksen uit zoals het bijwerken van statussen, het aanmaken van subtaaken of het informeren van eigenaren zonder handmatige aanwijzingen.

- Doelgerichte werkstroom: je definieert een doel op hoog niveau (bijvoorbeeld 'Obstakels in de Q3-campagne oplossen') en de agent plant, haalt context op en voert acties uit die het werk vooruit helpen.

- Persistente context en geheugen: Agenten behouden hun status tijdens alle stappen, waardoor ze kunnen redeneren over wat er al is gedaan en wat er nog te doen is, waardoor de nauwkeurigheid wordt verbeterd en redundant werk wordt verminderd.

- Integratie met werkruimte-tools: Ze communiceren met ClickUp-taaken, documenten en opmerkingen, evenals met gekoppelde tools, en coördineren tussen systemen om werkstroomen te voltooien in plaats van acties zonder context voor te stellen.

📚 Lees meer: Wat zijn modelgebaseerde reflexagenten?

De beste functies van ClickUp

- Breng AI naar je desktop en verbonden apps met ClickUp Brain MAX: zoek in je hele werkruimte, transcribeer spraak naar tekst, schakel tussen de beste AI-modellen en onderneem actie op taken, documenten en chats zonder je werkstroom te onderbreken.

- Vind direct antwoorden met Enterprise Search : zoek in taken, documenten, opmerkingen, bestanden en gekoppelde tools, zodat cruciale context nooit verborgen blijft of in silo's terechtkomt.

- Leg ideeën snel vast met Talk to Text : dicteer aantekeningen, plannen of updates en zet spraak om in gestructureerd werk zonder je concentratie te verliezen of momentum te verliezen.

- Verminder handmatig werk met ClickUp Dashboards : trigger automatisch taakupdates, toewijzingen en follow-ups op basis van de werkelijke context van de werkruimte en statuswijzigingen.

- Houd discussies praktisch met ClickUp Chat: Bespreek beslissingen, feedback en goedkeuringen direct naast taken, zodat gesprekken gekoppeld blijven aan de uitvoering.

- Vervang vergaderingen door SyncUps : deel asynchrone updates, ontvang door AI gegenereerde samenvattingen en houd teams op één lijn zonder terugkerende telefoongesprekken.

- Coördineer teams met Teams Hub: bekijk teamactiviteiten, eigendom, prioriteiten en capaciteit op één plek om risico's te signaleren en het werk vroegtijdig opnieuw in balans te brengen.

- Plan je dag met ClickUp Kalender : krijg AI-ondersteunde dagplannen op basis van deadlines, prioriteiten en werklast, zodat je persoonlijke focus aansluit bij de teamdoelen.

Limieten van ClickUp

- De functies en aanpassingsmogelijkheden kunnen nieuwe gebruikers overweldigen.

Prijzen van ClickUp

ClickUp-beoordelingen en recensies

- G2: 4,7/5 (10.585+ beoordelingen)

- Capterra: 4. 6/5 (4.500+ beoordelingen)

Wat zeggen echte gebruikers over ClickUp AI?

Een ClickUp-gebruiker deelt ook zijn ervaringen op G2:

ClickUp Brain MAX is een geweldige aanvulling op mijn werkstroom. Door meerdere LLM's in één platform te combineren, zijn de reacties sneller en betrouwbaarder, en de spraak-naar-tekstfunctie op het platform bespaart enorm veel tijd. Ik waardeer ook de veiligheid op niveau van de onderneming, die me gemoedsrust geeft bij het omgaan met gevoelige informatie. […] Wat het meest opvalt, is hoe het me helpt om door de ruis heen te kijken en helderder te denken – of ik nu vergaderingen samenvat, content opstel of brainstorm over nieuwe ideeën. Het voelt alsof ik een alles-in-één AI-assistent heb die zich aanpast aan wat ik nodig heb.

ClickUp Brain MAX is een geweldige aanvulling op mijn werkstroom. Door meerdere LLM's in één platform te combineren, zijn de reacties sneller en betrouwbaarder, en de spraak-naar-tekstfunctie op het platform bespaart enorm veel tijd. Ik waardeer ook de veiligheid op niveau van de onderneming, die me gemoedsrust geeft bij het omgaan met gevoelige informatie. […] Wat het meest opvalt, is hoe het me helpt om door de ruis heen te kijken en helderder te denken – of ik nu vergaderingen samenvat, content opstel of brainstorm over nieuwe ideeën. Het voelt alsof ik een alles-in-één AI-assistent heb die zich aanpast aan wat ik nodig heb.

Uitdagingen en overwegingen bij het werk met AI-context engineering

Dit zijn de belangrijkste uitdagingen waar je je bewust van moet zijn. Context kan uit de hand lopen, zelfs als het model 1 miljoen token-contextvensters ondersteunt. Dit zijn de belangrijkste uitdagingen waar je je bewust van moet zijn 👇

Contextvergiftiging

Als er een hallucinatie of onjuiste gevolgtrekking in de context terechtkomt en daar herhaaldelijk naar wordt verwezen, behandelt het model dit als een feit. Deze vergiftigde context kan werkstroom vastzetten in ongeldige aannames die in de loop van de tijd blijven bestaan en de kwaliteit van de output verslechteren.

Contextdistractie

Grotere contexten zijn verleidelijk, maar wanneer de context te groot wordt, gaan modellen zich te veel richten op de verzamelde geschiedenis en maken ze te weinig gebruik van wat ze tijdens de training hebben geleerd. Dit kan ertoe leiden dat de AI blijft hangen in details uit het verleden in plaats van de beste volgende stap te synthetiseren.

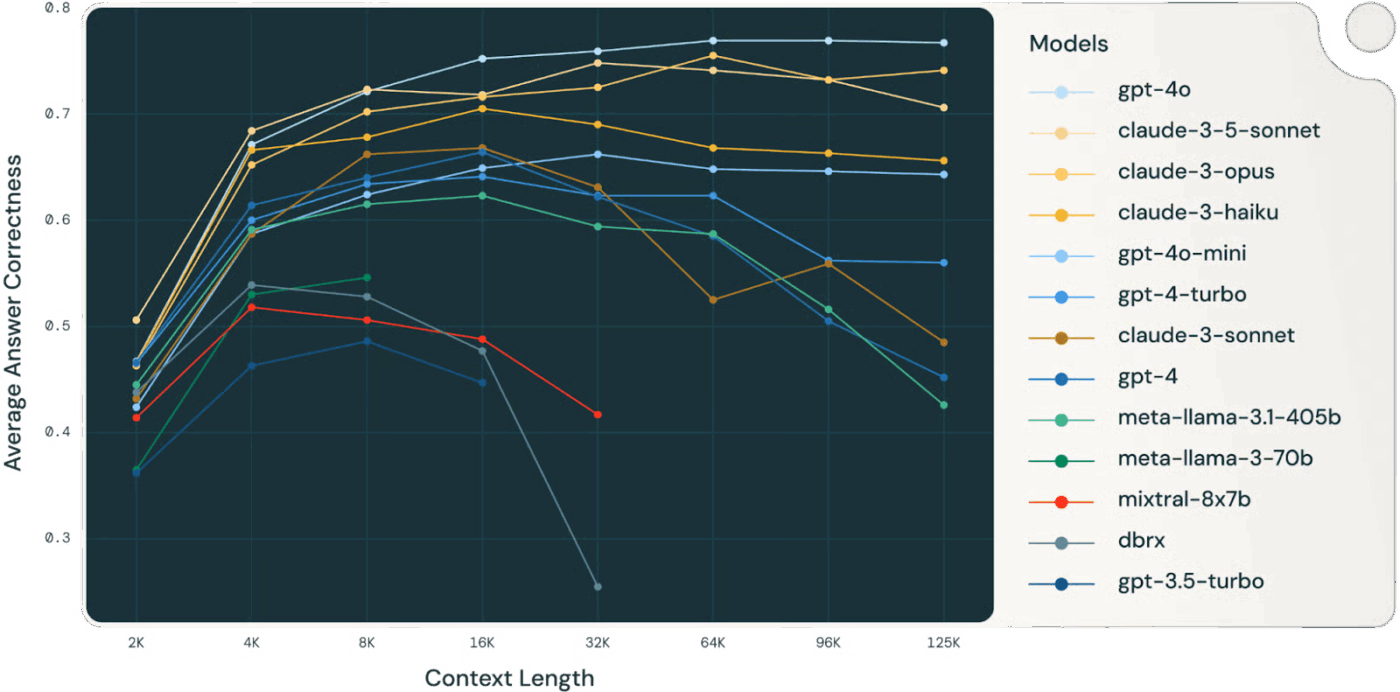

👀 Wist je dat? Uit een onderzoek van Databricks bleek dat de nauwkeurigheid van het model voor Llama 3. 1 405B begon af te nemen bij ongeveer 32.000 tokens, ruim voordat het contextvenster vol was. Kleinere modellen verslechterden zelfs nog eerder.

Modellen verliezen vaak hun redeneerkwaliteit lang voordat ze "zonder" context komen te zitten, waardoor contextselectie en -compressie waardevoller zijn dan de ruwe contextgrootte.

Contextverwarring

Irrelevante of weinigzeggende informatie in de context concurreert met cruciale gegevens om aandacht. Wanneer het model zich genoodzaakt voelt om elk context-token te gebruiken, worden beslissingen verward en lijdt de nauwkeurigheid daaronder, zelfs als er technisch gezien 'meer' informatie is.

Contextconflict

Naarmate er meer informatie wordt verzameld, kunnen nieuwe feiten of toolbeschrijvingen in tegenspraak zijn met eerdere content. Wanneer er sprake is van tegenstrijdige context, hebben modellen moeite om concurrerende signalen met elkaar te verzoenen, wat leidt tot inconsistente of onsamenhangende outputs.

Overdaad aan tools en selectieproblemen

Wanneer er te veel tooldefinities ongefilterd in de context worden opgenomen, kan het model irrelevante tools aanroepen of suboptimale tools prioriteit geven. Door selectief alleen relevante tools te laden, wordt verwarring voorkomen en de kwaliteit van de beslissingen verbeterd.

Complexiteit van engineering en onderhoud

Effectief contextbeheer vereist voortdurende snoei, samenvatting, offloading en quarantaine van context. Systemen moeten beslissen wanneer ze de geschiedenis moeten comprimeren en wanneer ze nieuwe informatie moeten ophalen, wat een doordachte infrastructuur vereist in plaats van ad-hocprompttrucs.

Discipline bij het toewijzen van tokens

Elke token beïnvloedt het gedrag; grotere contextvensters garanderen geen betere resultaten. Je moet context behandelen als een beheerde bron, waarbij je relevantie en actualiteit afweegt tegen tokenkosten en het aandachtsbudget van het model.

⚠️ Statistiek: Bijna 60% van de werknemers geeft toe dat ze ongeautoriseerde openbare AI-tools gebruiken op het werk, waarbij ze vaak gevoelige bedrijfsgegevens plakken in platforms zonder enig toezicht.

En het wordt nog erger: 63% van de organisaties heeft geen AI-governancebeleid om dit schaduwgebruik van AI te monitoren, beperken of zelfs maar op te sporen.

Het resultaat? Je gegevens lekken omdat niemand in de gaten houdt hoe AI wordt gebruikt.

De toekomst van context engineering

Dit markeert de overgang van experimenteren naar schaalvergroting. Context wordt niet langer door mensen beheerd, maar gegenereerd en beheerd door code. Het wordt een functie van de eigen structuur van het systeem.

We vatten dit samen aan de hand van het uitstekende artikel van Serge Liatko op de OpenAI-ontwikkelaarscommunity:

Context engineering evolueert naar werkstroomarchitectuur

Context engineering zal steeds meer plaatsmaken voor geautomatiseerde werkstroomarchitectuur. De taak zal niet beperkt blijven tot het invoeren van de juiste tokens.

Effectieve context engineering omvat het coördineren van volledige reeksen van redeneringen, tools en werkstroomstromen die zich automatisch aanpassen aan veranderende behoeften.

Dit betekent dat er dynamische systemen moeten worden gebouwd die zelf de juiste context beheren binnen holistische werkstroomen.

Automatisering van orkestratie vervangt handmatige prompts

De volgende grens is AI die zichzelf organiseert. Deze vormt een verbinding tussen retrieval, tools, geheugen en bedrijfslogica zonder dat mensen elke prompt of contextbundel handmatig hoeven te maken. In plaats van elk stukje data expliciet aan te leveren, zullen systemen afleiden welke context relevant is en deze automatisch beheren op basis van doelen en geschiedenis.

🧠 Dit gebeurt al met ClickUp Super Agents. Het zijn ambient en altijd actieve AI-teamgenoten, waardoor ze werk net als mensen kunnen begrijpen en uitvoeren. Ze verbeteren zich voortdurend op basis van eerdere interacties met behulp van een rijk geheugen – voorkeuren, recente acties en projectgeschiedenis – en kunnen proactief actie ondernemen, problemen escaleren of inzichten naar voren brengen zonder op een prompt te wachten.

End-to-end automatisering wordt de echte hefboom voor productiviteit

Naarmate context engineering zich verder ontwikkelt, komt productiviteitswinst voort uit geautomatiseerde werkstroom. LLM's fungeren als agenten, coördineren tools, monitoren de status en voeren meerstapslogica uit zonder micromanagement door de gebruiker.

Je hoeft ontbrekende context niet handmatig in te voeren. Het systeem selecteert context om het langetermijngeheugen en redeneren te ondersteunen.

Unified Context zorgt ervoor dat AI beter werkt bij het werk

De nauwkeurigheid van AI gaat achteruit wanneer de context versnipperd is over tools, werkstroomen en mensen. Wanneer informatie verspreid is, moeten de modellen gissen.

Geconvergeerde AI-werkruimten zoals ClickUp blinken hierin uit: ze brengen werk, data en AI samen in je contextstrategie.

Klaar om het te proberen? Meld je gratis aan bij ClickUp.