Code-beoordelingen: de enige plek waar 'LGTM' kan betekenen 'ziet er goed uit' ... of 'voeg dit samen voordat ik alles heroverweeg'.

Wanneer code-beoordelingen goed werk, worden bugs verholpen voordat ze uw gebruikers frustreren, blijven teams op één lijn en verspreidt kennis zich sneller tijdens een productieonderbreking.

En als ze niet werken? Dan blijft uw pull-aanvraag dagenlang liggen. Reviewers verdwijnen soms volledig of laten cryptische opmerkingen achter zoals 'hmm' en verdwijnen weer. Het ene team eist gedetailleerde uitleg voor elke puntkomma, het andere team keurt alles goed wat compileert, en niemand kan het eens worden over basisnormen.

In deze blogpost zullen we bekijken hoe ontwikkelaars code reviews tussen teams kunnen stroomlijnen om deze chaos te vermijden en producten te leveren die mensen kunnen gebruiken.

We zullen ook bekijken hoe ClickUp in deze werkstroom past. 📝

Voordelen van een gestandaardiseerd code review-proces

Gestandaardiseerde beoordelingen signaleren problemen op consistente wijze, ongeacht wie de beoordeling uitvoert. De checklist voor code-beoordeling signaleert systematisch veiligheidskwetsbaarheden, prestatieproblemen en ingrijpende wijzigingen.

Hier zijn enkele voordelen die zich in de loop van de tijd opstapelen. 📈

- Snellere beoordelingen: auteurs weten wat er van hen verwacht wordt voordat ze code schrijven, waardoor PR's vaker in één keer worden goedgekeurd.

- Beter leren: Juniorontwikkelaars verbeteren sneller wanneer constructieve feedback consistente principes volgt in plaats van individuele voorkeuren van reviewers.

- Minder wrijving: Niemand verspilt tijd met discussies over format wanneer uw linter dit al afdwingt.

- Voorspelbare resultaten: ontwikkelaars richten zich op het schrijven van hoogwaardige code in plaats van zich zorgen te maken over welke reviewer ze toegewezen krijgen.

🔍 Wist u dat? De term 'pull request' werd pas populair nadat GitHub in 2008 werd gelanceerd. Zij introduceerden de Pull Request Template (PRT) om ontwikkelaars te helpen de pull request op een relevante, consistente manier te bewerken. Daarvoor gebruikten ontwikkelaars e-mailthreads of patchbestanden om wijzigingen voor te stellen en te bespreken.

Veelvoorkomende uitdagingen bij code-beoordelingen tussen teams

Code reviews tussen teams mislukken wanneer organisatorische grenzen verwarring creëren over verantwoordelijkheden, geconcentreerd werk verstoren of tegenstrijdige verwachtingen introduceren.

Dit zijn de meest voorkomende problemen:

- Verschillende coderingsstijlen botsen, waardoor beoordelingen veranderen in discussies over format in plaats van logica.

- Communicatie wordt een probleem wanneer teams verschillende tools gebruiken of technische jargon spreken. Het kan dagen duren om een eenvoudige vraag te beantwoorden, waardoor uw hele pull-aanvraag wordt geblokkeerd.

- Niemand weet wie de beslisser is wanneer er meerdere teams betrokken zijn. U komt in een onzekere situatie terecht, wachtend op goedkeuring van iemand die vindt dat het niet zijn verantwoordelijkheid is.

- Tijdzones zorgen voor wachtproblemen waardoor elke feedbackronde een hele dag in beslag neemt, waardoor een gesprek van 30 minuten uitgroeit tot een uitwisseling van een week.

- Formele codebeoordelingen worden genegeerd omdat uw werk geen prioriteit heeft voor het andere team. Zij zijn gefocust op hun eigen deadlines, terwijl uw code in de wachtrij blijft staan.

- Codereviewers missen context over waarom dingen werken zoals ze werken in uw codebase. Ze kunnen iets als fout markeren bij het behandelen van een bekend randgeval, of echte problemen missen omdat ze uw domein niet begrijpen.

🚀 Voordeel van ClickUp: ClickUp Brain geeft het ontwikkelingsteam de ontbrekende context die de meeste code-beoordelingen vertraagt. Omdat de AI-aangedreven assistent uw werkruimte begrijpt, kan hij uitleggen waarom een bepaalde functie bestaat of wat een stukje logica moet doen.

Stel dat iemand een regel in uw checkout-werkstroom markeert. De AI voor softwareteams kan hen vertellen dat het deel uitmaakt van een edge-case-fix uit een vorige sprint, en relevante documenten en taken uit de werkruimte halen voor extra context. Op die manier hoeven reviewers minder tijd te besteden aan het raden van de bedoeling.

📌 Probeer deze prompt: Leg het doel uit van de herhalingslogica in de checkout-API en vertel me of deze gekoppeld is aan een eerdere bug of functie-update.

Best practices om code-beoordelingen over teams te stroomlijnen

Code-beoordelingen vertragen vaak de productiviteit van ontwikkelaars wanneer er meerdere teams bij betrokken zijn. Hier leest u hoe ontwikkelaars beoordelingen tussen teams kunnen stroomlijnen en de productiviteit op peil kunnen houden. 👇

Schrijf gedetailleerde PR-beschrijvingen

Schrijf niet langer 'Bug in betalingswerkstroom verholpen', maar leg uit wat er mis was en waarom uw oplossing werkt. U wilt ook:

- Voeg de ticketlink toe, de stappen om het oorspronkelijke probleem te reproduceren en wat u hebt getest.

- Maak een lijst van de teams waarmee u overleg hebt gepleegd bij het wijzigen van de gedeelde infrastructuur.

- Voeg een sectie 'Focus je review hier' toe die verwijst naar de 50 regels die belangrijk zijn in je pull-aanvraag van 300 regels.

Wanneer een reviewer uw wijziging in twee minuten in plaats van twintig minuten begrijpt, krijgt u snellere en betere feedback.

💡 Pro-tip: Wanneer u wijzigingen voorstelt, leg dan uit waarom een wijziging belangrijk is. Dit creëert een kennistraject dat herhaalde vragen vermindert en toekomstige reviewers helpt.

Maak eigendom duidelijk

Voeg een CODEOWNERS-bestand toe dat automatisch de juiste personen tag.

Zet een tabel in je README: 'Wijzigingen in authenticatiecode → @security-team vereist, @backend-team optioneel'. Wanneer iemand een PR opent die de code van vijf teams raakt, weten ze precies op wie ze moeten wachten en wie er alleen is om kennis te delen.

Handhaaf responstijden en ontlast uzelf

Deadlines worden niet uitgesteld omdat iemand het druk heeft, dus het helpt als het hele team responsiviteit bij reviews als onderdeel van de normale werkstroom beschouwt.

Heb je binnen 24 uur nog geen reactie ontvangen? Neem dan contact met hen op. Als het meer dan 48 uur geleden is, escaleer het dan naar hun leidinggevende of zoek een andere reviewer. En als een reviewer tien filosofische opmerkingen achterlaat, kun je hem vragen om 'binnen 10 minuten even te bellen' en het live uit te praten.

💡 Pro-tip: Label PR's vooraf op basis van risico en omvang. Tag elke PR als laag risico, gemiddeld risico of hoog risico en noteer of deze van invloed is op meerdere teams. Op deze manier verlopen peer reviews sneller, weten reviewers direct waar ze hun aandacht op moeten richten en worden wijzigingen met een hoog risico extra kritisch bekeken.

Leg architectuurbeslissingen vast

Wanneer u een niet voor de hand liggende keuze maakt, zoals het gebruik van Redis in plaats van Postgres voor caching, noteer dit dan in een Architecture Decision Record (ADR) of teamwiki. En zorg ervoor dat u ernaar gekoppeld bent in uw PR.

Hierdoor hoeven externe reviewers geen vragen meer te stellen over beslissingen die al zijn besproken en genomen. Bovendien voorkomen nieuwe leden dat ze dezelfde fouten maken.

Maak voorbeeld-PR's voor veelvoorkomende patronen

Als iemand een uitstekende cross-team PR neerzet (goede beschrijving, goed gestructureerde code, alle randgevallen afgehandeld), maak er dan een bladwijzer van. Deel deze met nieuwe mensen en raadpleeg deze bij het beoordelen.

'Zo gaan we gewoonlijk om met service-to-service-authenticatie' met een link is beter dan het elke keer helemaal opnieuw uit te leggen. Bouw een bibliotheek met goede voorbeelden waar uw organisatie van kan leren.

Tools om code review-werkstroom te verbeteren

Dit zijn de beste tools voor het verbeteren van code-beoordelingen tussen teams. 🧑💻

ClickUp (het meest geschikt voor gecentraliseerde code-beoordelingen en communicatie tussen teams)

De softwareprojectmanagementoplossing van ClickUp is de alles-in-één-app voor werk die projectmanagement, kennisbeheer en chat combineert, allemaal aangedreven door AI die u helpt sneller en slimmer te werken.

Voor ontwikkelteams die meerdere pull-aanvragen, beoordelingscycli en documentatie-updates beheren, zorgt dit voor structuur en verantwoordelijkheid in elke fase van het codebeoordelingsproces.

Zo blijven reviews vlot verlopen en blijft de communicatie tussen teams duidelijk. 💻

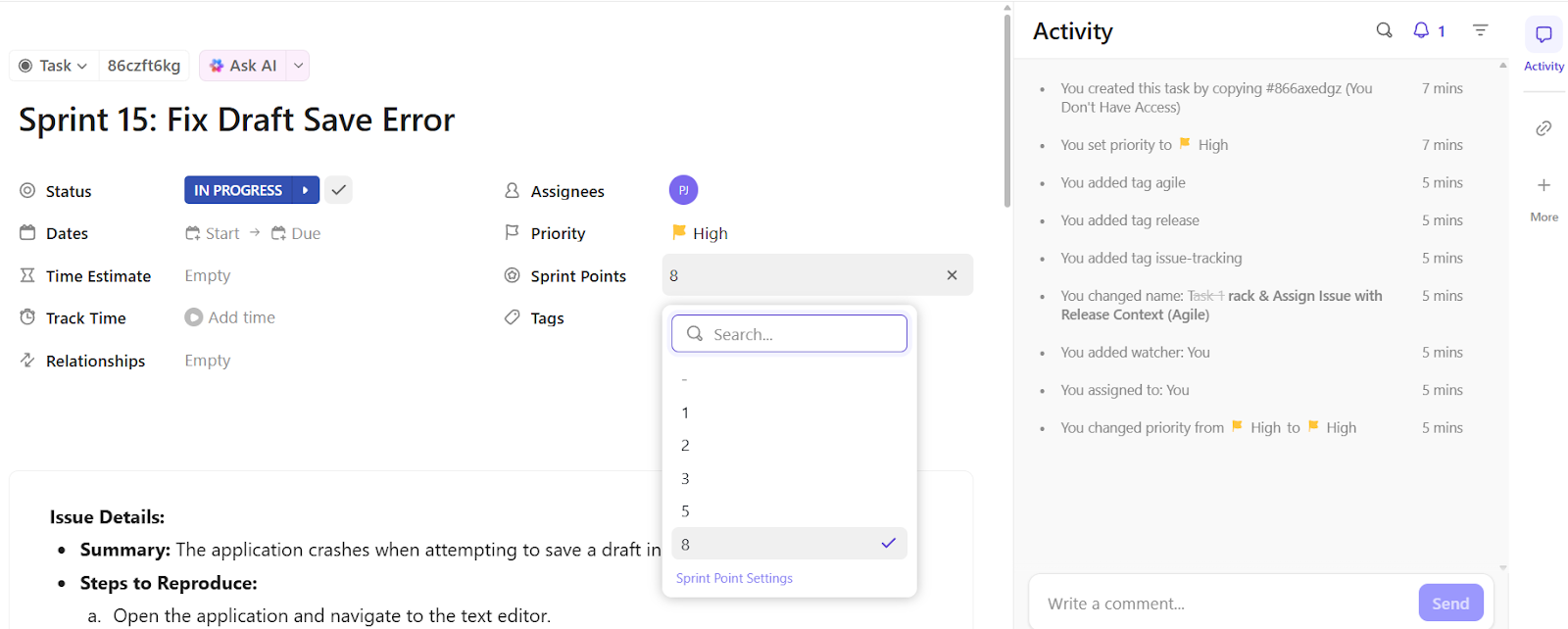

Houd beoordelingen transparant en in beweging

ClickUp-taak geeft elke pull-aanvraag een eigen plek. Elke taak legt de context van de review, de toewijzingen van reviewers en de voortgang op één plek vast, zodat geen enkele PR verloren gaat of blijft wachten. Teams kunnen vervolgens reviewtaken filteren op sprint, repository of status om snel te zien wat er nog in behandeling is.

Stel dat uw backend-ontwikkelaar een PR pusht voor API-responsoptimalisatie. Ze maken een taak aan met de naam 'API-caching voor product-endpoints optimaliseren' en koppelen de PR hieraan. De taak bevat testresultaten, tags van reviewers en een korte checklist met aandachtspunten. Reviewers plaatsen hun aantekeningen rechtstreeks in de taak, werken de status bij naar 'Wijzigingen aangevraagd' en wijzen de taak opnieuw toe aan het DevOps-team.

Automatiseer alles wat u vertraagt

ClickUp Automatiseringen elimineert vervelende handmatige stappen die beoordelingen vaak vertragen. Het systeem handelt terugkerende acties af, zoals het toewijzen van beoordelaars, de voortgang van taken en teamnotificaties, zodat engineers zich kunnen concentreren op het geven van daadwerkelijke feedback.

U kunt automatisering-regels opstellen, zoals:

- Wijs reviewers automatisch toe op basis van bestandstype of team (bijvoorbeeld alle frontend/PR's aan UI-reviewers).

- Breng de hoofdontwikkelaar op de hoogte als een PR langer dan 48 uur niet is beoordeeld.

- Maak subtaak voor QA-tests of documentatie zodra een PR wordt samengevoegd.

Verander feedbackchaos in duidelijke actie

ClickUp Brain, een AI-tool voor ontwikkelaars, maakt het opvolgen van reviews moeiteloos. Het vat de feedback van reviewers direct samen, identificeert knelpunten en zet dit alles om in uitvoerbare taken met eigenaren en deadlines.

Stel je een PR-thread voor met 300 reacties vol opmerkingen als 'nit', 'later repareren' en 'moet getest worden'. Met één prompt haalt ClickUp Brain de sleutelproblemen eruit, maakt het subtaaken aan zoals 'API-foutafhandeling bijwerken' of 'unit-tests voor paginering toevoegen' en wijst het deze toe aan de juiste ontwikkelaars.

✅ Probeer deze prompts:

- Vat alle feedback over deze Taak samen en wijs actiepunten toe.

- Genereer een update voor het project op basis van alle PR-gerelateerde opmerkingen van deze week.

- Lijst blokkades met recente code review thread-vermelding.

Leg de volgende stappen vast voordat ze verdwijnen

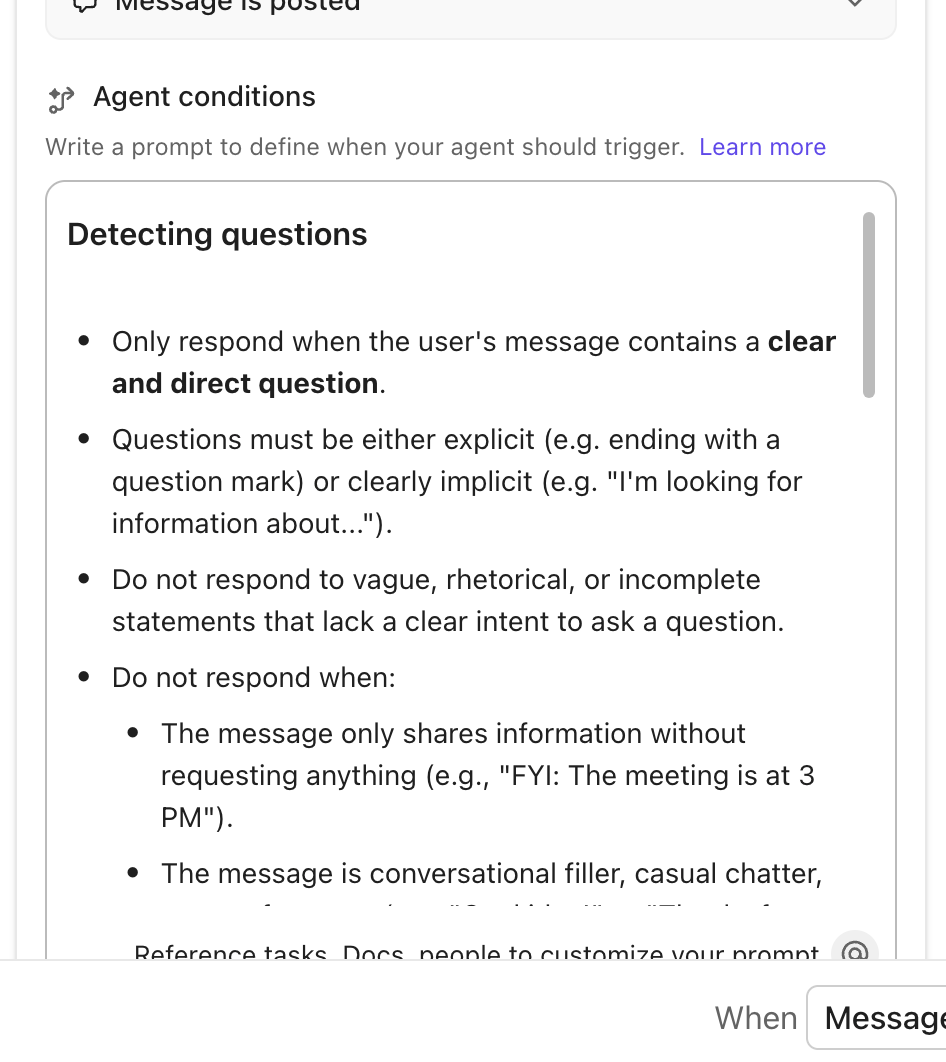

Reviewdiscussies brengen vaak toekomstige verbeteringen aan het licht, zoals kleine refactors, prestatieverbeteringen of testbehoeften. ClickUp AI Agents verwerken deze automatisch en zetten reviewinzichten om in traceerbare taken zonder handmatige invoer.

U kunt AI-agents gebruiken om:

- Detecteer terugkerende problemen (bijv. ontbrekende tests) en maak vervolgacties voor deze problemen.

- Wijs backlog-items automatisch toe op basis van discussiepatronen

- Identificeer en registreer veelvoorkomende bugs die tijdens beoordelingen worden gemeld via rapportage.

Meerdere PR's wijzen als voorbeeld op ontbrekende unit-tests in dezelfde module. Een AI-agent kan een nieuwe taak aanmaken met de naam 'Unit-tests toevoegen voor UserService.js', deze toewijzen aan QA en alle gerelateerde PR's koppelen.

De beste functies van ClickUp

- Verbinding maken met tools van derden: Verbind opslagplaatsen zoals GitHub, GitLab en Bitbucket met uw werkruimte. Elke toewijzing, PR en vertakking wordt synchroniseerd met de bijbehorende ClickUp-taak met ClickUp-integraties.

- Houd coderingsnormen toegankelijk: Sla uw coderingsrichtlijnen, checklist voor reviewers en herbruikbare codefragmenten op in een gezamenlijk ClickUp Doc om werkversnippering te voorkomen.

- Zorg voor duidelijke documentatie: Vraag ClickUp Brain's AI Writer for Work om lange PR's samen te vatten, relevante secties te extraheren of code-documentatie op te stellen in uw eigen stijl.

Limieten van ClickUp

- Uitgebreide, aangepaste mogelijkheden kunnen overweldigend zijn voor nieuwe gebruikers.

Prijzen van ClickUp

ClickUp-beoordelingen en recensies

- G2: 4,7/5 (meer dan 10.400 beoordelingen)

- Capterra: 4,6/5 (meer dan 4400 beoordelingen)

📮 ClickUp Insight: Wanneer systemen falen, worden werknemers creatief, maar dat is niet altijd een goede zaak. 17% van de werknemers vertrouwt op persoonlijke workarounds, zoals het opslaan van e-mails, het maken van schermafbeeldingen of het nauwgezet maken van eigen aantekeningen om hun werk bij te houden. Ondertussen kan 20% van de werknemers niet vinden wat ze nodig hebben en vraagt het aan collega's, waardoor de concentratie van beide partijen wordt verstoord. Met ClickUp kunt u e-mails omzetten in traceerbare taken, chats koppelen aan taken, antwoorden krijgen van AI en nog veel meer, allemaal binnen één werkruimte!

💫 Echte resultaten: Teams zoals QubicaAMF hebben met ClickUp meer dan 5 uur per week teruggewonnen – dat is meer dan 250 uur per jaar per persoon – door verouderde kennisbeheerprocessen te elimineren. Stel je eens voor wat je team zou kunnen creëren met een extra week productiviteit per kwartaal!

2. Gerrit (het beste voor nauwkeurige beoordelingen op toewijzingniveau)

Gerrit werkt met een patch-gebaseerd beoordelingssysteem dat elke toewijzing behandelt als een afzonderlijke wijziging die goedkeuring vereist voordat deze kan worden samenvoegd. Beoordelaars kennen labels toe, zoals Code-Review +2 of Verified +1, waardoor een stemsysteem ontstaat dat bepaalt of een wijziging klaar is om te worden samenvoegd. Deze aanpak voorkomt het probleem van 'goedkeuren en vergeten' dat bij andere tools vaak voorkomt.

De beste functies van Gerrit

- Gebruik de Git-compatibele SSH- en HTTPS-servers om naadloos samen te werken met uw bestaande Git-werkstroom.

- Herhaal individuele patches door middel van meerdere revisies zonder de opslagplaatsgeschiedenis te vervuilen.

- Zorg ervoor dat elke regel code dezelfde strenge controle doorloopt met de refs/for/ vertakking-conventie.

Limieten van Gerrit

- Het is moeilijk om een samenvoegingsconflict rechtstreeks vanaf het platform op te lossen, omdat het soms automatisch uitlogt.

Prijzen van Gerrit

- Brons: $ 13.000/jaar (maximaal 100 gebruikers)

- Zilver: $ 18.000/jaar (maximaal 100 gebruikers)

- Gold: $ 39.000/jaar (maximaal 100 gebruikers)

- Platinum: $ 90.000/jaar (maximaal 100 gebruikers)

Gerrit-beoordelingen en -reviews

- G2: 4,3/5 (meer dan 30 beoordelingen)

- Capterra: Onvoldoende beoordelingen

🔍 Wist u dat? Veel open-sourceprojecten, zoals Linux, zijn nog steeds sterk afhankelijk van patch-gebaseerde reviewwerkstroom die doet denken aan de jaren 70.

3. GitHub (het meest geschikt voor gedistribueerde asynchrone code-beoordelingen)

Pull-aanvragen vormen de ruggengraat van de review-werkstroom van GitHub en creëren thread-gesprekken rond voorgestelde wijzigingen. Ontwikkelaars kunnen specifieke regelbewerkingen voorstellen die auteurs rechtstreeks vanuit de interface kunnen toepassen, waardoor het heen en weer gestuur met opmerkingen als 'probeer dit eens' wordt voorkomen. Bovendien zorgt het bijhouden van threadresoluties ervoor dat er geen feedback verloren gaat in langdurige discussies.

De beste functies van GitHub

- Krijg AI-aangedreven code-beoordelingen met GitHub Copilot terwijl ontwikkelaars code schrijven.

- Automatiseer routing met 'vereiste reviewers' en CODEOWNERS, zodat de juiste mensen de wijzigingen zien die van invloed zijn op hun domeinen.

- Gebruik het asynchrone model van GitHub om ervoor te zorgen dat beoordelingen continu plaatsvinden.

Limiet van GitHub

- De instellingen en toestemming zijn verwarrend, vooral voor ondernemingen die meerdere opslagplaatsen beheren.

Prijzen van GitHub

- Free

- Team: $4/maand per gebruiker

- Enterprise: $ 21 per maand per gebruiker

GitHub-beoordelingen en recensies

- G2: 4,6/5 (meer dan 2600 beoordelingen)

- Capterra: 4,3/5 (meer dan 6140 beoordelingen)

🧠 Leuk weetje: Het concept van code review dateert uit de jaren 50, toen programmeurs die aan vroege mainframes zoals de IBM 704 werkten, handmatig elkaars ponskaarten op fouten controleerden voordat ze taken uitvoerden.

4. SonarQube (het beste voor geautomatiseerde beveiligingsscanwerkstroom)

SonarQube voert geautomatiseerde beoordelingen uit door middel van statische analyse, waarbij meer dan 6500 regels in meer dan 35 talen worden toegepast om bugs, kwetsbaarheden en veiligheidlekken op te sporen. De AI-agent voor codering wordt aangesloten op uw CI/CD-pijplijn en fungeert als poortwachter voordat de code bij menselijke beoordelaars terechtkomt.

De beste functies van SonarQube

- Gebruik de kwaliteitspoorten die drempels voor slagen/zakken instellen op basis van testdekking, duplicatie en veiligheidstoetsen.

- Laat de Static Application Security Testing (SAST)-engine beveiligingskwetsbaarheden opsporen en advies geven over het verhelpen van fouten voordat het testen begint.

- Visualiseer de accumulatie van technische schulden in de loop van de tijd om te beslissen welk refactoring-werk het belangrijkst is.

Limieten van SonarQube

- Het signaleert mogelijke problemen, maar kan niet beoordelen of uw bedrijfslogica klopt.

Prijzen van SonarQube

- Free

- Team: $32/maand

- Onderneming: Aangepaste prijzen

Beoordelingen en recensies van SonarQube

- G2: 4,5/5 (meer dan 120 beoordelingen)

- Capterra: 4,5/5 (meer dan 60 beoordelingen)

🤝 Vriendelijke herinnering: Moedig reviewers aan om 30-60 minuten per sessie te besteden. Langere sessies verminderen de focus en vergroten de kans dat subtiele bugs over het hoofd worden gezien.

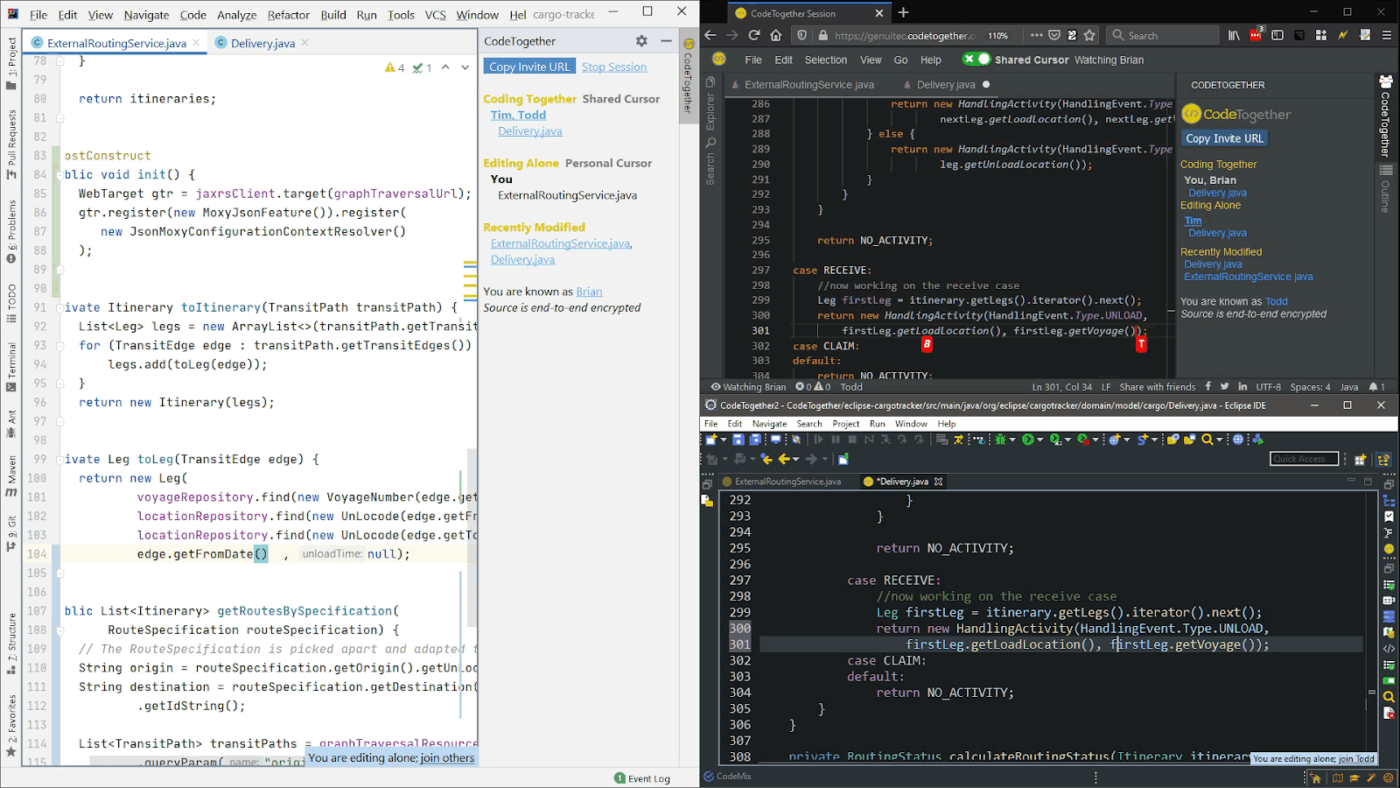

5. CodeTogether (het meest geschikt voor synchrone paarreviews)

CodeTogether brengt realtime collaboratieve code review rechtstreeks naar uw code editor en verandert het gebruikelijke asynchrone reviewproces in live pair programming sessies. Ontwikkelaars kunnen meedoen vanuit Eclipse, IntelliJ of VS Code. Gasten hoeven zelfs niet dezelfde IDE te gebruiken als de host en kunnen zelfs via een browser meedoen.

De beste functies van CodeTogether

- Gebruik de spraak-, video- en tekst chatten die rechtstreeks in de softwareontwikkelomgeving zijn geïntegreerd.

- Behoud uw eigen editorvoorkeuren, thema's en snelkoppelingen terwijl u aan gedeelde code werkt.

- Sessies opnemen voor documentatie- of trainingsdoeleinden binnen de tool

Limieten van CodeTogether

- Heeft geen offline mogelijkheden en werkt mogelijk niet met oudere software of meerdere talen.

Prijzen van CodeTogether

- Startersabonnement: $ 10 per maand per gebruiker

- Business-abonnement: $49/maand per gebruiker

- Enterprise-abonnement: Aangepaste prijzen

Beoordelingen en recensies van CodeTogether

- G2: Onvoldoende reviews

- Capterra: Onvoldoende beoordelingen

Strategieën voor samenwerking tussen teams

Hier leest u hoe u samenwerking tot stand kunt brengen die ondanks afstand, verschillende schema's en concurrerende prioriteiten toch succesvol is. 🪄

Ontwerp vanaf het begin voor asynchroon

De kans is groot dat uw teamoverschrijdende reviewers niet eens tegelijkertijd met u online zijn. In plaats van te proberen een 'snel telefoontje' in te lassen, is er een betere manier:

- Zet alles vooraan in de PR-beschrijving: schrijf deze alsof de reviewer zich op een ander halfrond bevindt en pas over 12 uur zal reageren. Welk probleem lost u op? Wat heeft u geprobeerd dat niet werkte? Waar zit het lastige deel?

- Maak een video voor alles wat complex is: loop uw wijzigingen door in een ClickUp Clip; dat is beter dan meer dan 20 chatberichten verspreid over twee dagen. Beoordelaars kunnen deze op dubbele snelheid bekijken en begrijpen wat u hebt gebouwd.

- Beantwoord de voor de hand liggende vragen: Zorg ervoor dat vragen als 'Waarom heb je de bestaande UserService niet gebruikt?' worden beantwoord in je beschrijving.

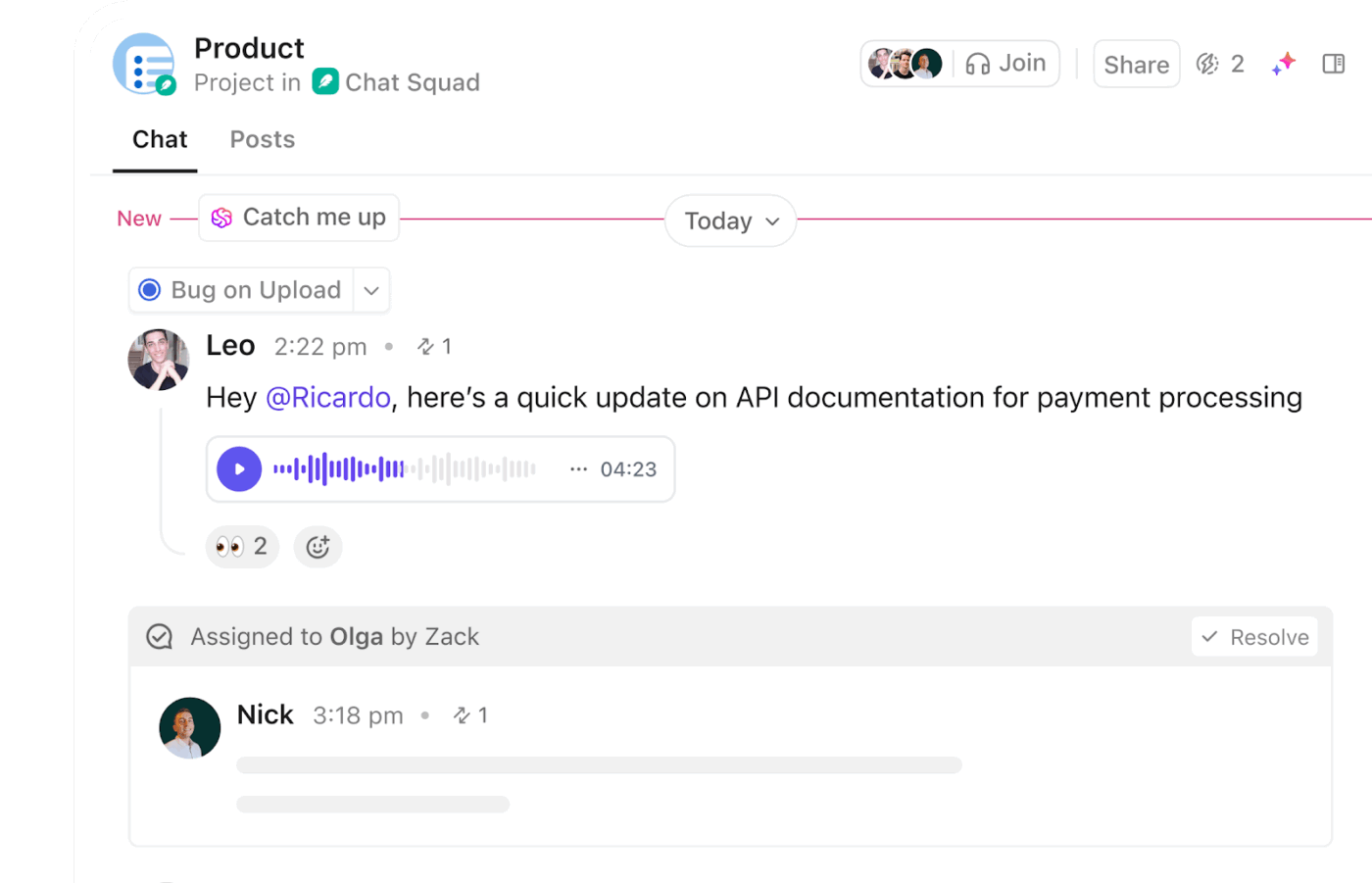

🚀 Voordeel van ClickUp: Asynchrone beoordelingen werken alleen als de communicatie duidelijk en gemakkelijk te volgen blijft. ClickUp Chat houdt die gesprekken in verbinding met het werk zelf, zodat updates niet zomaar verloren gaan.

U kunt uw pull-aanvraag-link posten, snel context delen en teamgenoten taggen die de review moeten uitvoeren. Deze functies zijn ook compatibel met mobiele apparaten.

Behandel documentatie niet langer als huiswerk

Het schrijven van code-documentatie maakt deel uit van het leveren van de functie. Elke teamoverschrijdende PR moet:

- Link naar het architectuurdocument waarin wordt uitgelegd waarom uw service bestaat en hoe deze in het geheel past.

- Werk het runbook bij wanneer u iets wijzigt in de manier waarop iets wordt geïmplementeerd of geschaald.

- Voeg diagrammen toe voor alles waarbij meer dan twee services met elkaar communiceren.

Dit is wat er meestal gebeurt: de eerste teamoverschrijdende PR is lastig omdat er geen documentatie is en je deze als onderdeel van die PR schrijft. De volgende vijf PR's verlopen soepel omdat reviewers zelf aan de slag kunnen. Bij de tiende PR beoordelen nieuwe teamleden je code vol vertrouwen, omdat de kennis nu buiten je hoofd ligt.

Koppel uw tools aan elkaar

Handmatig schakelen tussen contexten heeft een negatieve invloed op reviews. Verbind alles met elkaar:

- PR's worden automatisch gekoppeld aan tickets, zodat reviewers de zakelijke context kunnen zien.

- Tickets linken terug naar PR's, zodat productmanagers kunnen zien wat er is geleverd.

- CI/CD-opmerkingen over zowel succesvolle als mislukte implementaties

Het doel is dat u met één klik op een link het hele verhaal te zien krijgt.

🚀 Voordeel van ClickUp: Met ClickUp Brain MAX kunt u uw tools uniformiseren en AI-wildgroei elimineren. Dankzij de contextuele universele zoekfunctie kunt u binnen enkele seconden gerelateerde PR's, tickets en documenten uit ClickUp, GitHub en zelfs Google Drive ophalen. Gebruik spraakopdrachten om tickets aan te maken of bij te werken zonder van tabblad te wisselen, terwijl AI-aangedreven automatisering ervoor zorgt dat updates door uw hele ecosysteem worden verspreid.

Beoordeel samen de dingen die niet kapot kunnen gaan

Eén reviewer voor refactoring? Dat werkt. Eén reviewer voor verificatiewijzigingen die van invloed zijn op elke microservice? Dat vraagt om een incident om 2 uur 's nachts. Voor kritieke systemen:

- Wijs ten minste twee reviewers toe; de ene spoort logische fouten op, de andere signaleert veiligheidsproblemen.

- Maak in uw 'Codeowners'-kanaal duidelijk welke paden een paar review nodig hebben.

- Verontschuldig je niet voor de extra controle. De eerste keer dat een paar review een bug ontdekt die de productie zou hebben platgelegd, verdient het zichzelf honderd keer terug.

Ja, het is traag, maar productie-incidenten zijn nog trager.

🔍 Wist u dat? Michael Fagan ontwikkelde in de jaren 70 bij IBM het eerste formele systeem voor peer code review: de Fagan Inspection. Dit gestructureerde proces definieert rollen en stappen zoals planning, voorbereiding, inspectievergaderingen, herwerking en follow-up om defecten vroeg in de ontwikkelingscyclus op te sporen.

Wissel de beoordelingstaken tussen teams af

Als steeds dezelfde persoon alle externe PR's beoordeelt, ontstaat er een bottleneck, wat kan leiden tot burn-out. Dit is hoe een ideaal scenario eruitziet:

- Wijs een wekelijkse reviewer toe voor teamoverschrijdend werk in alle teams.

- Zet het in een gedeelde kalender, zodat iedereen weet wie er dienst heeft.

- Reken ermee in bij de sprintplanning; reviewen is geen 'extra' taak, maar onderdeel van het werk.

- Wissel elke week of twee weken af, zodat de kennis zich verspreidt.

De persoon die aan de beurt is, weet dat hij of zij die week de blokkades wegneemt. Terwijl alle anderen weten dat ze zich op hun eigen werk kunnen concentreren.

Voer elk kwartaal retrospectieven uit voor code-beoordelingen.

Hier hebben we het specifiek over beoordelingen tussen teams:

- Laat de slechtste PR van het afgelopen kwartaal zien en bespreek wat het zo pijnlijk maakte.

- Benadruk de beste PR en maak er een sjabloon van dat iedereen kan kopiëren.

- Stem over waarover je niet meer wilt discussiëren en leg de beslissing vervolgens vast.

- Breng bijna-ongelukken aan het licht waarbij beoordelingen bijna een kritieke bug niet hebben opgemerkt.

Hier verandert u 'we moeten betere PR's schrijven' in 'dit is precies hoe een goede PR er voor ons team uitziet'.

Het succes van gestroomlijnde code-beoordelingen meten

Het is moeilijk om een betere programmeur te worden als je geen metingen uitvoert. De meeste teams houden echter ijdelheidstatistieken bij die geen indicatie geven of beoordelingen effectief zijn.

Dit is wat belangrijk is. 📊

Beoordeel de doorlooptijd (maar houd deze goed bij)

Als u alleen gemiddelden meet, moet u er rekening mee houden dat deze de PR's verbergen die een week lang blijven liggen terwijl uw functie ten onder gaat. Dit is waar u op moet letten:

- Tijd tot eerste review: De industriestandaard is 24 uur. Als die van u drie dagen is, is dat uw knelpunt.

- Tijd om samen te voegen: Moet voor de meeste PR's minder dan 72 uur zijn, vanaf het moment van openen tot het moment van implementeren.

- P95-tijden, geen gemiddelden: als uw gemiddelde twee dagen is, maar uw 95e percentiel twee weken, dan wordt de helft van uw team voortdurend geblok.

Bugs die tijdens de review worden ontdekt versus bugs in productie

Het hele doel van reviews is om bugs op te sporen voordat klanten dat doen. Bijhouden:

- Hoeveel P0/P1-incidenten zijn terug te voeren op recent samengevoegde code? Als dit meer dan 10% is, werken uw beoordelingen niet.

- Welke soorten bugs worden er bij reviews ontdekt? SQL-injectie-kwetsbaarheden? Geweldig. Ontbrekende puntkomma's? Dat moet uw linter kunnen afhandelen.

- Welke types ontsnappen naar productie? Als reviews stijlproblemen opmerken maar race conditions missen, dan review je de verkeerde dingen.

🔍 Wist u dat? Angst voor code-beoordelingen is niet beperkt tot juniorontwikkelaars. Uit onderzoek blijkt dat ontwikkelaars van alle ervaringsniveaus angst kunnen ervaren in verband met code-beoordelingen. Dit weerlegt de gangbare mythe dat alleen minder ervaren ontwikkelaars hier last van hebben.

Tevredenheid van ontwikkelaars

Uw team zal u vertellen of beoordelingen werk doen, maar alleen als u dat elk kwartaal vraagt:

- Zijn beoordelingen nuttig of slechts bureaucratie? (schaal van 1-10)

- Voelt u zich geblokkeerd door het wachten op beoordelingen?

- Zijn opmerkingen constructief of pietluttig?

- Vindt u het vervelend om teamoverschrijdende reviews aan te vragen?

Als de tevredenheid daalt, zien uw statistieken er misschien prima uit, maar is uw ontwikkelingsproces niet meer in orde. Misschien zijn reviewers te veel bezig met het discussiëren over variabelenamen en zien ze architecturale problemen over het hoofd. Misschien voelen beoordelingen tussen teams vijandig aan. De cijfers vertellen u dit niet, maar uw team wel.

💡 Pro-tip: Creëer een driemaandelijkse feedbackloop met een ClickUp-formulier om te begrijpen hoe het beoordelingsproces door het team wordt ervaren. Met behulp van een sjabloon voor softwareontwikkeling kunt u een korte enquête opstellen met gerichte vragen, zoals hoe nuttig beoordelingen zijn, of ze blokkades veroorzaken en of feedback constructief wordt ervaren.

Snelheid (maar wees slim)

Heeft het stroomlijnen van reviews er daadwerkelijk voor gezorgd dat u sneller kunt leveren?

- Verhaalpunten of functies per Sprint voor en na wijzigingen

- Tijd tussen toewijzing en productie in de hele pijplijn

- Maar let ook op bugrapporten; als de snelheid verdubbelt maar het aantal productie-incidenten verdrievoudigt, hebt u uzelf 'gestroomlijnd' tot een kwaliteitscrisis.

Het doel is hier om een duurzame snelheid te bereiken met behoud van kwaliteit. Meet beide, anders meet u alleen maar hoe snel u bugs kunt leveren.

Bouw een dashboard dat mensen kunnen bekijken

Maak een ClickUp-dashboard om elke pull-aanvraag, reviewer en uitkomst op één plek bij te houden en te zien wat uw releasecyclus vertraagt.

Maak kaarten aan die het volgende benadrukken:

- PR's die langer dan 48 uur wachten met de namen van de eigenaren (niets motiveert zo goed als publieke verantwoordelijkheid)

- Gemiddelde reviewtijd per team, zodat knelpunten duidelijk zichtbaar zijn

- Beoordelingen voltooid per persoon om free-riders op te sporen

- Gevonden bugs versus ontdekte bugs als kwaliteitscontrole

Plak het op een bord in het kantoor of deel het tijdens de stand-up op maandag. Als statistieken zichtbaar zijn, zijn ze belangrijk.

Bekijk deze video om te leren hoe u een dashboard voor softwareprojectmanagement kunt maken:

U kunt ook rapporten plannen in ClickUp om ervoor te zorgen dat de juiste personen deze inzichten automatisch ontvangen. Voeg gewoon hun e-mailadressen toe, selecteer een regelmatige frequentie (dagelijks, wekelijks, maandelijks) en zij ontvangen een pdf-overzicht.

Daarna kunt u eenvoudig commentaarpatronen bekijken:

- Gemiddeld aantal opmerkingen per PR: Als dit 30 of meer is, is er iets mis. Zijn de PR's te groot? Zijn de normen onduidelijk? Zijn de reviewers aan het bikeshedden?

- Revisierondes: Als PR's gemiddeld vier rondes doorlopen, bent u niet duidelijk over wat er moet veranderen.

- Goedkeuringen zonder opmerkingen: Als alles zonder feedback wordt goedgekeurd, zijn beoordelingen slechts schijnvertoning.

Dit is wat Teresa Sothcott, PMO bij VMware, te zeggen had over ClickUp:

ClickUp Dashboard zijn voor ons een echte gamechanger, omdat we nu een realtime weergave hebben van wat er gebeurt. We kunnen gemakkelijk zien welk werk we hebben voltooid en welk werk nog lopend is.

ClickUp Dashboards zijn voor ons een echte gamechanger, omdat we nu een realtime weergave hebben van wat er gebeurt. We kunnen gemakkelijk zien welk werk we hebben voltooid en welk werk nog in uitvoering is.

Balans tussen beoordelingen door verschillende teams

Doen sommige teams al het werk, terwijl andere teams niets doen?

- Aantal aangevraagde beoordelingen versus aantal gegeven beoordelingen per team: Als uw team 50 verzoeken verstuurt en er vijf voltooit, is dat onhoudbaar.

- Responspercentages: Welke teams negeren routinematig PR's tussen teams?

Gebruik deze gegevens om verwachtingen opnieuw in evenwicht te brengen of te formaliseren. 'Wij beoordelen uw werk, u beoordeelt het onze' moet expliciet zijn, niet iets waarop alleen maar gehoopt wordt.

Git in de werkstroom met ClickUp

Sterke code-beoordelingen helpen teams vooruit. Ze zetten feedback om in samenwerking, voorkomen verrassingen op het laatste moment en helpen elke ontwikkelaar zich zelfverzekerd te voelen voordat hij tot samenvoeging overgaat. Wanneer het proces een werkstroom is, voelt de hele releasecyclus lichter aan.

ClickUp geeft die werkstroom een serieuze upgrade. Het koppelt reviewtaken, teamupdates en discussies aan elkaar in een verbinding, terwijl ClickUp Brain alles in beweging houdt. Reviewverzoeken vinden automatisch de juiste personen, opmerkingen worden omgezet in uitvoerbare taken en elk pull-aanvraag blijft zichtbaar zonder dat je updates hoeft bij te houden.

Meld u vandaag nog gratis aan bij ClickUp en ontdek hoe snel code-beoordelingen kunnen verlopen als alles (en iedereen) op elkaar is afgestemd. ✅

Veelgestelde vragen (FAQ's)

Om codebeoordelingen te stroomlijnen, moet u ervoor zorgen dat pull-aanvragen beheersbaar blijven door codewijzigingen tot een limiet van ongeveer 200-400 regels per keer te beperken. Stel duidelijke beoordelingschecklists op en geef tijdig feedback. Automatisering, zoals linting, statische analyse en CI/CD-integraties, kan routinematige kwaliteitscontroles afhandelen.

Wijs reviewers toe op basis van expertise en gebruik samenwerkingstools om opmerkingen te centraliseren. ClickUp kan helpen door PR's aan taken te koppelen, zodat iedereen weet wie wat beoordeelt en deadlines zichtbaar zijn in alle tijdzones.

Handhaaf coderingsnormen, voer geautomatiseerde tests uit en gebruik statische analysetools om de codekwaliteit te verbeteren. Voer regelmatig gestructureerde peer reviews uit en geef prioriteit aan schone, leesbare en goed geteste code. ClickUp Dashboard kan kwaliteitsstatistieken bijhouden, checklists voor reviewers bijhouden en rapportage maken om de gezondheid van de code te monitoren.

Platforms zoals GitHub, GitLab en Bitbucket zijn ideaal voor beoordelingen tussen teams. Code-beoordelingstools zoals Danger of SonarQube kunnen controles automatiseren. Bovendien zorgt de integratie van PR-bijhouden in ClickUp ervoor dat iedereen op één lijn blijft en worden knelpunten verminderd.

Meestal werken twee tot drie reviewers het beste. Eén moet bekend zijn met het codegebied, terwijl een ander een frisse blik kan bieden. Voor routinematige wijzigingen of kleinere teams kan één reviewer volstaan, terwijl kritieke of grote wijzigingen meer dan drie reviewers vereisen.

Automatisering kan tests uitvoeren, de code controleren, kwetsbaarheden signaleren en herinneringen sturen voor openstaande beoordelingen. De automatiseringsmogelijkheden van ClickUp kunnen PR's toewijzen, statussen bijwerken en beoordelaars op de hoogte stellen, waardoor het proces sneller en consistenter verloopt.