À mesure que les LLM deviennent plus puissants, l'invite n'est plus la partie la plus difficile. C'est le contexte qui devient la contrainte.

L'ingénierie contextuelle consiste à fournir les bonnes informations dans le bon format aux LLM (grands modèles linguistiques).

Qu'est-ce qui rend l'ingénierie contextuelle difficile ?

Vous devez concevoir chaque couche de la pile afin de capturer le contexte et de le rendre disponible. Si vous envoyez trop peu de contexte, les LLM ne sauront pas quoi faire. Si vous envoyez trop de contexte, vous manquerez de jetons. Alors, comment trouver le juste équilibre ?

Ci-dessous, nous partageons tout ce que vous devez savoir sur l'ingénierie contextuelle.

Qu'est-ce que l'ingénierie contextuelle de l'IA ?

L'ingénierie contextuelle de l'IA consiste à concevoir et à optimiser les instructions et le contexte pertinent pour que les LLM, l'IA avancée et les modèles multimodaux puissent accomplir leurs tâches efficacement.

Cela va au-delà de la rédaction d'invites. L'ingénierie contextuelle détermine :

- Quelles informations sont mises en avant ?

- D'où provient-il (mémoire, outils, bases de données, documents) ?

- Comment il est mis en forme (schémas, résumés, contraintes)

- Quand il est injecté dans la boucle de raisonnement du modèle

🌟 L'objectif : optimiser les informations que vous fournissez dans la fenêtre contextuelle du LLM et filtrer les informations parasites.

Comment le contexte améliore-t-il les réponses de l'IA ?

Sans contexte, un LLM prédit la suite du texte la plus probable d'un point de vue statistique. En revanche, une bonne ingénierie contextuelle améliore les résultats en :

- Ancrage du raisonnement : le modèle fonde ses réponses sur des faits connus plutôt que sur des suppositions statistiques.

- Réduire les hallucinations : des contraintes claires et des données pertinentes réduisent l'espace de solution.

- Améliorer la cohérence : des entrées similaires produisent des sorties similaires, car la forme du contexte est stable.

- Réduire les coûts et la latence : un contexte ciblé est préférable au transfert de documents ou d'historiques entiers.

Pour résumer, comme le dit Tobi Lutke, PDG de Shopify :

Je préfère nettement le terme « ingénierie contextuelle » à celui d'« ingénierie des invites ». Il décrit mieux la compétence fondamentale : l'art de fournir tout le contexte nécessaire pour que la tâche puisse être résolue de manière plausible par le LLM.

Je préfère nettement le terme « ingénierie contextuelle » à celui d'« ingénierie des invites ». Il décrit mieux la compétence fondamentale : l'art de fournir tout le contexte nécessaire pour que la tâche puisse être résolue de manière plausible par le LLM.

Le rôle de l'ingénierie contextuelle dans les flux de travail basés sur l'IA

Dans les flux de travail basés sur l'IA, les LLM ne sont pas des outils autonomes. Ils fonctionnent au sein de systèmes qui disposent déjà de données, de règles et d'un état.

L'ingénierie contextuelle permet au modèle de comprendre où il se situe dans le flux de travail et ce qu'il est autorisé à faire ensuite.

Lorsque le modèle connaît l'état actuel, les actions passées et les entrées manquantes, il peut recommander ou exécuter la bonne étape suivante au lieu de générer des conseils génériques.

Cela implique également de fournir explicitement la logique métier, telle que les règles d'approbation, les contraintes de conformité et les procédures d'escalade. Lorsque ces éléments font partie du contexte, les décisions prises par l'IA restent en phase avec la réalité opérationnelle.

Enfin, l'ingénierie contextuelle permet des flux de travail en plusieurs étapes et agentifs en garantissant des transferts clairs de l'état et des décisions à chaque étape.

Cela empêche les erreurs de s'accumuler à mesure que les flux de travail évoluent, améliorant ainsi l'efficacité du contexte.

👀 Le saviez-vous ? 95 % des implémentations GenAI en entreprise échouent, non pas parce que les modèles sont faibles, mais parce que les organisations ne parviennent pas à intégrer l'IA dans leurs flux de travail réels.

Les outils d'IA génériques tels que ChatGPT fonctionnent bien pour les particuliers, mais échouent à grande échelle car ils n'apprennent pas à partir du contexte du système, des règles de l'entreprise ou de l'évolution de la situation. En d'autres termes, la plupart des échecs de l'IA sont des échecs d'intégration et de contexte, et non des échecs de modèle.

📮ClickUp Insight : 62 % de nos répondants s'appuient sur des outils d'IA conversationnelle tels que ChatGPT et Claude. Leur interface de chatbot familière et leurs capacités polyvalentes (génération de contenu, analyse de données, etc.) pourraient expliquer leur popularité auprès de divers rôles et secteurs. Cependant, si un utilisateur doit passer à un autre onglet pour poser une question à l'IA à chaque fois, les coûts associés à l'activation/désactivation du contexte et à la commutation s'accumulent au fil du temps. Ce n'est pas le cas avec ClickUp Brain. Il se trouve directement dans votre environnement de travail, sait sur quoi vous travaillez, comprend les invites en texte simple et vous donne des réponses très pertinentes pour vos tâches ! Doublez votre productivité avec ClickUp !

Comment fonctionne l'ingénierie contextuelle ?

L'ingénierie contextuelle consiste à façonner progressivement les informations avant qu'elles n'atteignent le modèle.

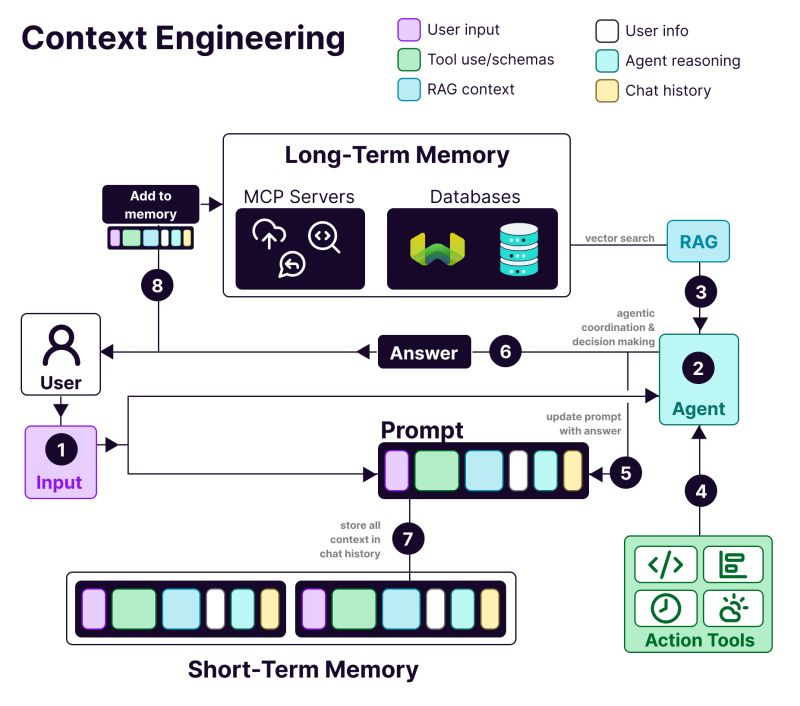

L'anatomie d'un système à ingénierie contextuelle comprend :

- 𝗨𝘀𝗲𝗿 i𝗻𝗳𝗼𝗿𝗺𝗮𝘁𝗶𝗼𝗻 : préférences, historique et données de personnalisation

- T𝗼𝗼𝗹 u𝘀𝗲 : API, calculatrices, moteurs de recherche... tout ce dont le LLM a besoin pour accomplir la tâche à faire.

- 𝗥𝗔𝗚 c𝗼𝗻𝘁𝗲𝘅𝘁 : informations extraites de bases de données vectorielles telles que Weaviate.

- 𝗨𝘀𝗲𝗿 i𝗻𝗽𝘂𝘁 : La requête ou la tâche à accomplir

- 𝗔𝗴𝗲𝗻𝘁 r𝗲𝗮𝘀𝗼𝗻𝗶𝗻𝗴 : Le processus de réflexion et la chaîne décisionnelle du LLM

- 𝗖𝗵𝗮𝘁 h𝗶𝘀𝘁𝗼𝗿𝘆 : interactions précédentes qui assurent la continuité

Avantages de l'ingénierie contextuelle dans les systèmes /IA

Voici pourquoi vous avez besoin de l'ingénierie contextuelle lorsque vous développez des applications IA :

Des résultats plus précis

Fournir un contexte pertinent pour la prise de décision réduit l'ambiguïté. Le modèle raisonne à partir de faits, de contraintes et d'états connus au lieu de s'appuyer sur des suppositions probabilistes.

Un comportement cohérent à grande échelle

Des structures contextuelles stables produisent des résultats reproductibles. Des entrées similaires conduisent à des décisions similaires, ce qui est essentiel pour les flux de travail de production.

Réduction des coûts et de la latence

Un contexte ciblé et compressé évite le gaspillage de jetons. Les systèmes réagissent plus rapidement sans avoir à charger à plusieurs reprises l'historique complet ou les documents.

Une automatisation plus sûre

Le contexte encode les règles métier et les permissions. Cela permet à l'IA d'agir sans enfreindre les politiques ni déclencher d'actions risquées.

De meilleurs flux de travail en plusieurs étapes

Des transferts de contexte propres préservent l'état à chaque étape. Les erreurs ne s'accumulent pas à mesure que les flux de travail deviennent plus complexes ou plus agissants.

Débogage et itération plus faciles

Un contexte structuré rend les échecs visibles. Vous pouvez remonter à la source des erreurs (entrées manquantes, obsolètes ou mal classées) au lieu de blâmer le modèle.

Adoption plus forte par les entreprises

Les systèmes d'IA qui respectent le contexte du flux de travail semblent fiables, ce qui constitue une différence essentielle entre les pilotes et les outils destinés à être adoptés à l'échelle de l'entreprise.

📚 Pour en savoir plus : Comment tirer parti de l'IA grâce à l'accès à des données en temps réel

👀 Le saviez-vous ? L'IA contextuelle a un impact direct sur la productivité. Une étude du Boston Consulting Group a révélé que les équipes de communication peuvent à elles seules récupérer 26 à 36 % de leur temps grâce à l'IA générative. Avec des flux de travail repensés et des systèmes agissants qui comprennent le contexte, les gains de productivité peuvent atteindre 50 %.

Ingénierie contextuelle IA vs ingénierie des invites

Ingénierie des invites : demandez à ChatGPT de rédiger un e-mail annonçant une nouvelle fonctionnalité. Vous rédigez des instructions pour une seule tâche.

Ingénierie contextuelle : vous développez un bot de service client. Il doit se souvenir des tickets précédents, accéder aux détails du compte utilisateur et conserver l'historique des discussions.

Comme l'explique Andrej Karpathy, chercheur en IA :

Les gens associent les invitations à de courtes descriptions de tâches que vous donneriez à un LLM dans votre utilisation quotidienne. Dans toutes les applications LLM de niveau industriel, l'ingénierie contextuelle est l'art et la science délicats qui consistent à remplir la fenêtre contextuelle avec les informations adéquates pour l'étape suivante.

Les gens associent les invites à de courtes descriptions de tâches que vous donneriez à un LLM dans votre utilisation quotidienne. Dans toutes les applications LLM de niveau industriel, l'ingénierie contextuelle est l'art et la science délicats qui consistent à remplir la fenêtre contextuelle avec les informations adéquates pour l'étape suivante.

+1 pour « l'ingénierie contextuelle » plutôt que « l'ingénierie des instructions ».

Les gens associent les invites à de courtes descriptions de tâches que vous donneriez à un LLM dans votre utilisation quotidienne. Dans toutes les applications LLM de niveau industriel, l'ingénierie contextuelle est l'art et la science délicats de remplir la fenêtre contextuelle... https://t.co/Ne65F6vFcf

— Andrej Karpathy (@karpathy) 25 juin 2025

+1 pour « l'ingénierie contextuelle » plutôt que « l'ingénierie des instructions ».

Les gens associent les invites à de courtes descriptions de tâches que vous donneriez à un LLM dans votre utilisation quotidienne. Dans toutes les applications LLM de niveau industriel, l'ingénierie contextuelle est l'art et la science délicats de remplir la fenêtre contextuelle... https://t.co/Ne65F6vFcf

— Andrej Karpathy (@karpathy) 25 juin 2025

| Approche | Ce sur quoi il se concentre | Utilisation optimale |

| Ingénierie des invites | Élaboration d'instructions et de formats de sortie pour le modèle | Tâches ponctuelles, génération de contenu, sorties spécifiques à un format |

| Ingénierie contextuelle | Fournir des données, des états et des contraintes pertinents au modèle | IA conversationnelle, outils d'analyse de documents, assistants de codage |

| Les deux à la fois | Combiner des instructions claires avec un contexte au niveau du système | Applications d'IA de production qui nécessitent des performances cohérentes et fiables |

La plupart des applications utilisent une combinaison d'ingénierie des invites et d'ingénierie contextuelle. Vous avez toujours besoin d'invites bien rédigées dans votre système d'ingénierie contextuelle.

La différence réside dans le fait que ces invites fonctionnent avec des informations contextuelles soigneusement gérées. Vous n'avez pas besoin de recommencer à chaque fois.

📮 ClickUp Insight : Plus de la moitié des personnes interrogées utilisent quotidiennement trois outils ou plus, luttant contre la « prolifération de l'IA » et la dispersion des flux de travail.

Même si cela peut sembler productif et intense, votre contexte se perd simplement entre les différentes applications, sans parler de l'énergie dépensée à taper au clavier. Brain MAX rassemble tout cela : parlez une seule fois, et vos mises à jour, tâches et notes atterrissent exactement là où elles doivent être dans ClickUp. Plus besoin d'activer/désactiver les applications, plus de chaos, juste une productivité centralisée et fluide.

Applications de l'ingénierie contextuelle de l'IA

Les principaux domaines dans lesquels l'ingénierie contextuelle de l'IA est déjà mise en œuvre sont les suivants 👇

Automatisation du service client et du service d'assistance

La plupart des chatbots traitent chaque message comme s'il était nouveau, obligeant les utilisateurs à se répéter sans cesse.

Grâce à l'ingénierie contextuelle, l'IA peut se référer à l'historique de l'utilisateur, aux interactions précédentes, aux enregistrements d'achat et à la documentation sur les produits. Elle peut ainsi répondre comme un collègue qui connaît déjà le problème.

📌 Exemple concret : l'équipe d'assistance de Coda traite les questions techniques sur les produits qui nécessitent de comprendre les messages passés et de se référer à la documentation produit. Pour adapter l'assistance, elle utilise Intercom Fin. Fin lit la documentation et les discussions précédentes avant de répondre, ce qui permet de résoudre de manière autonome 50 à 70 % des questions des clients tout en maintenant un niveau élevé de satisfaction client.

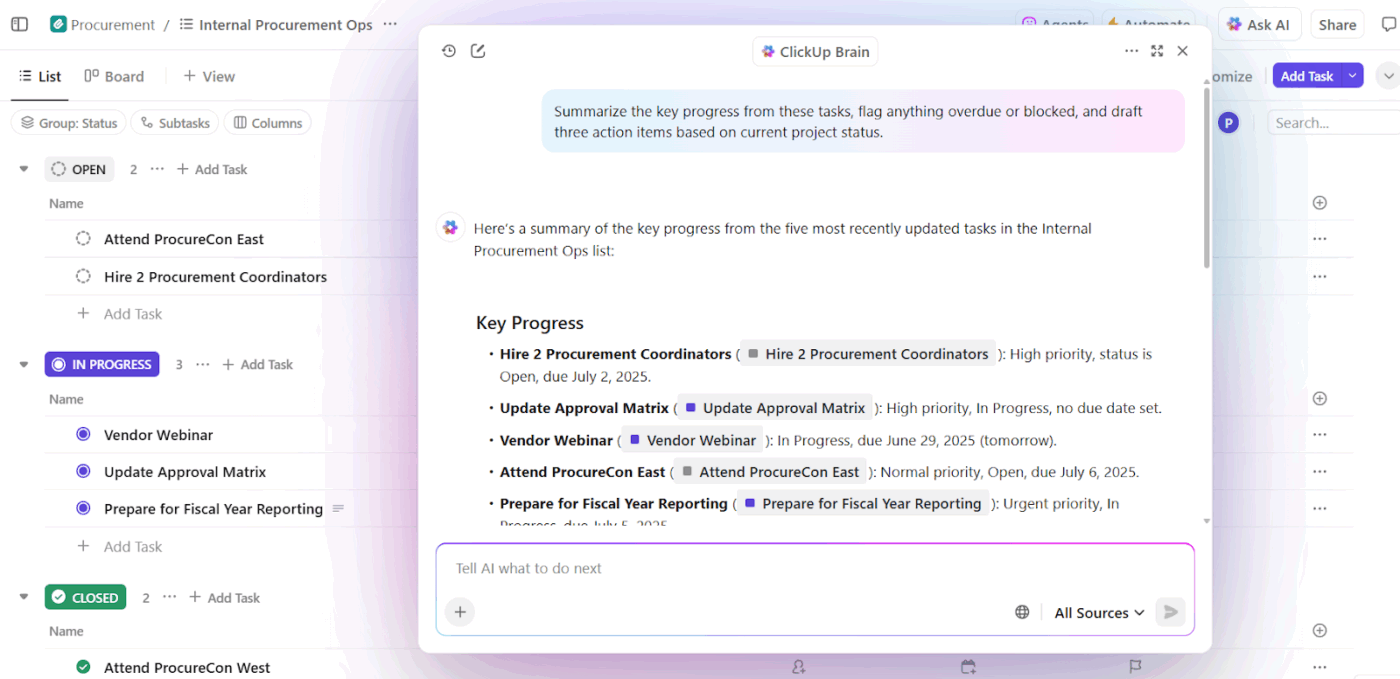

Rédaction IA et assistants de productivité au travail

Les outils d'écriture IA n'apportent de valeur ajoutée que lorsqu'ils comprennent ce sur quoi vous travaillez, pourquoi c'est important et ce qui existe déjà. Sans ce contexte, ils permettent de gagner du temps lors de la rédaction, mais nécessitent tout de même d'importantes réécritures et un alignement manuel.

C'est là que l'IA d'ingénierie contextuelle change la donne. En ancrant l'IA dans l'état des tâches, les documents, les décisions passées et les conventions de l'équipe, les assistants de rédaction passent de la génération de textes génériques à une assistance tenant compte du flux de travail.

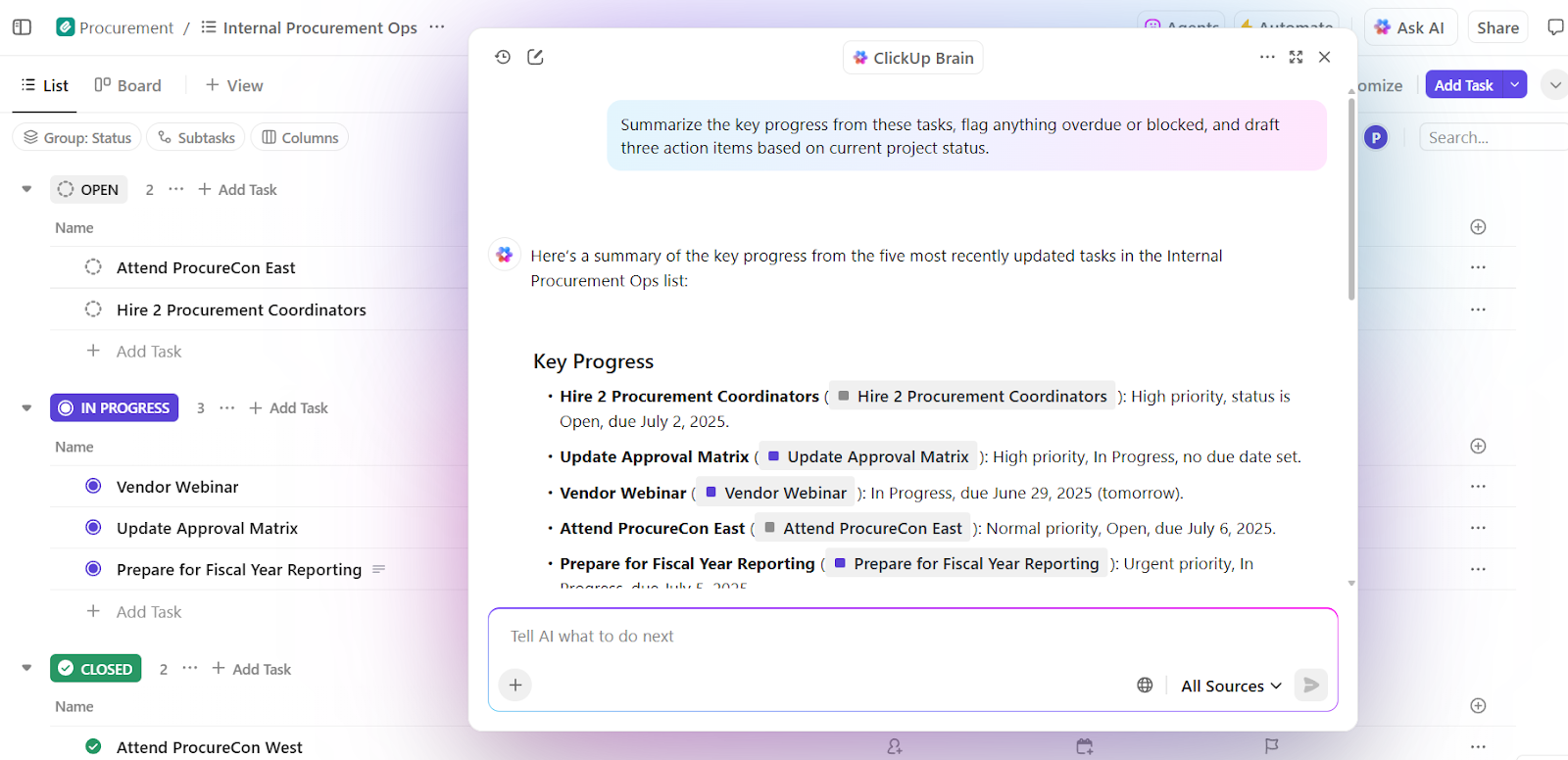

📌 Exemple concret : ClickUp Brain, l'IA native de ClickUp, applique l'ingénierie contextuelle au niveau de l'environnement de travail. Au lieu de demander aux utilisateurs de coller des informations contextuelles dans les invites, elle extrait directement le contexte des tâches, des documents, des commentaires, des priorités et des échéanciers.

Une capacité clé est la prise de décision contextuelle. Elle évalue les projets en cours ainsi que la capacité de l'équipe et les performances passées afin de faire émerger des informations exploitables.

Tout d'abord, Brain peut détecter les surcharges, les retards et les goulots d'étranglement. En plus de résumer le problème, il recommande également des ajustements concrets, sous la forme d'une redistribution des tâches, d'une mise à jour des échéanciers et d'une redistribution des priorités.

Comme ces décisions s'inscrivent dans le contexte d'un environnement de travail en temps réel, le résultat est immédiatement utilisable. Il n'est pas nécessaire de rappeler le contexte, d'expliquer les priorités ou d'aligner manuellement les recommandations sur la réalité.

Les équipes qui utilisent ClickUp Brain rapportent des taux d'intégration complète 2,26 fois plus élevés et les scores de frustration liés à l'IA les plus bas (27,1 %).

Intelligence commerciale et CRM pour l'équipe commerciale

Les flux de travail de l'équipe commerciale englobent les e-mails, les réunions, les CRM et les feuilles de calcul. Sans contexte, l'IA ne peut pas comprendre la dynamique d'une transaction ou l'intention d'un acheteur.

L'ingénierie contextuelle permet à l'IA d'avoir une visibilité sur les discussions des acheteurs, les échéanciers, le ton des communications et les interactions passées. Cela permet de faire émerger des informations, de détecter les transactions bloquées et de suggérer la bonne action à entreprendre.

📌 Exemple concret : l'équipe commerciale de Microsoft utilise Copilot for Sales, qui extrait le contexte d'Outlook, des appels Teams, des mises à jour CRM et des notes pour faire ressortir les bonnes informations et rédiger des suivis. Les équipes internes ont constaté une augmentation de 20 % des contrats remportés et une hausse de 9,4 % du chiffre d'affaires par vendeur, ce qui montre à quel point l'IA contextuelle amplifie les performances.

Assistants IA dans le domaine de la santé et de la clinique

Les décisions médicales s'appuient sur les antécédents des patients, les rapports de laboratoire, les ordonnances et les notes des médecins, mais ces informations sont souvent stockées dans des systèmes déconnectés. Les médecins perdent ainsi beaucoup de temps à saisir à nouveau les données et risquent de négliger des détails essentiels. Ils consacrent parfois près de 40 % de leur temps à du travail administratif.

L'ingénierie contextuelle de l'IA établit la connexion entre ces points de données. Elle fournit aux cliniciens de l'assistance en leur fournissant des résumés précis, des brouillons de documentation, en mettant en évidence les antécédents pertinents et en faisant ressortir les risques potentiels ou les prochaines étapes.

📌 Exemple concret : Atrium Health utilise Nuance DAX Copilot, développé en partenariat avec Microsoft, pour documenter automatiquement les consultations cliniques à partir des dossiers antérieurs et des discussions en temps réel. Les cliniciens ont ainsi gagné 30 à 40 minutes par jour sur la documentation, tandis qu'une étude portant sur 12 spécialités médicales a révélé un résultat positif en termes d'efficacité et de satisfaction des fournisseurs sans compromettre la sécurité des patients.

Assistants RH et recrutement

Les décisions de recrutement dépendent du contexte, comme les compétences, les commentaires issus des entretiens, l'adéquation au rôle et les données historiques sur les embauches. L'ingénierie contextuelle basée sur l'IA vous permet d'analyser les CV, les descriptions de rôle, les transcriptions d'entretiens et les tendances historiques afin d'identifier plus rapidement les candidats les plus adaptés.

📌 Exemple concret : les équipes de Micron utilisent Eightfold IA, une plateforme d'intelligence des talents qui analyse les CV, les exigences des rôles, les parcours professionnels internes et les résultats des recrutements passés afin de prédire l'adéquation des candidats aux rôles. La plateforme évalue les candidats en fonction de leurs compétences et de leur potentiel. Le résultat ? L'élargissement de leur vivier de talents et le recrutement de huit candidats supplémentaires par mois avec une équipe de recrutement réduite.

Outils et plateformes offrant l'assistance pour l'ingénierie contextuelle

Quels outils vous aident à mettre en œuvre l'ingénierie contextuelle à grande échelle ?

1. LangChain (idéal pour assembler le contexte de manière programmatique)

LangChain est un framework d'orchestration open source permettant de créer des systèmes d'IA dans lesquels le contexte doit être assemblé, mis à jour et acheminé de manière programmatique.

L'outil d'agent IA aide les développeurs à établir des connexions entre les LLM et des outils, des sources de données, de la mémoire et une logique de contrôle plutôt que de s'appuyer sur des invitations statiques.

Core LangChain gère le chaînage et la récupération, tandis que LangGraph permet des flux de travail basés sur des graphes et avec état pour un raisonnement complexe en plusieurs étapes.

DeepAgents s'appuie sur cette base pour fournir l'assistance aux agents autonomes à long terme avec planification, sous-agents et contexte persistant.

Ensemble, ces composants font de LangChain une couche de contrôle pour l'ingénierie contextuelle, qui décide quand le contexte est récupéré, comment il évolue et où il circule dans les flux de travail des agents.

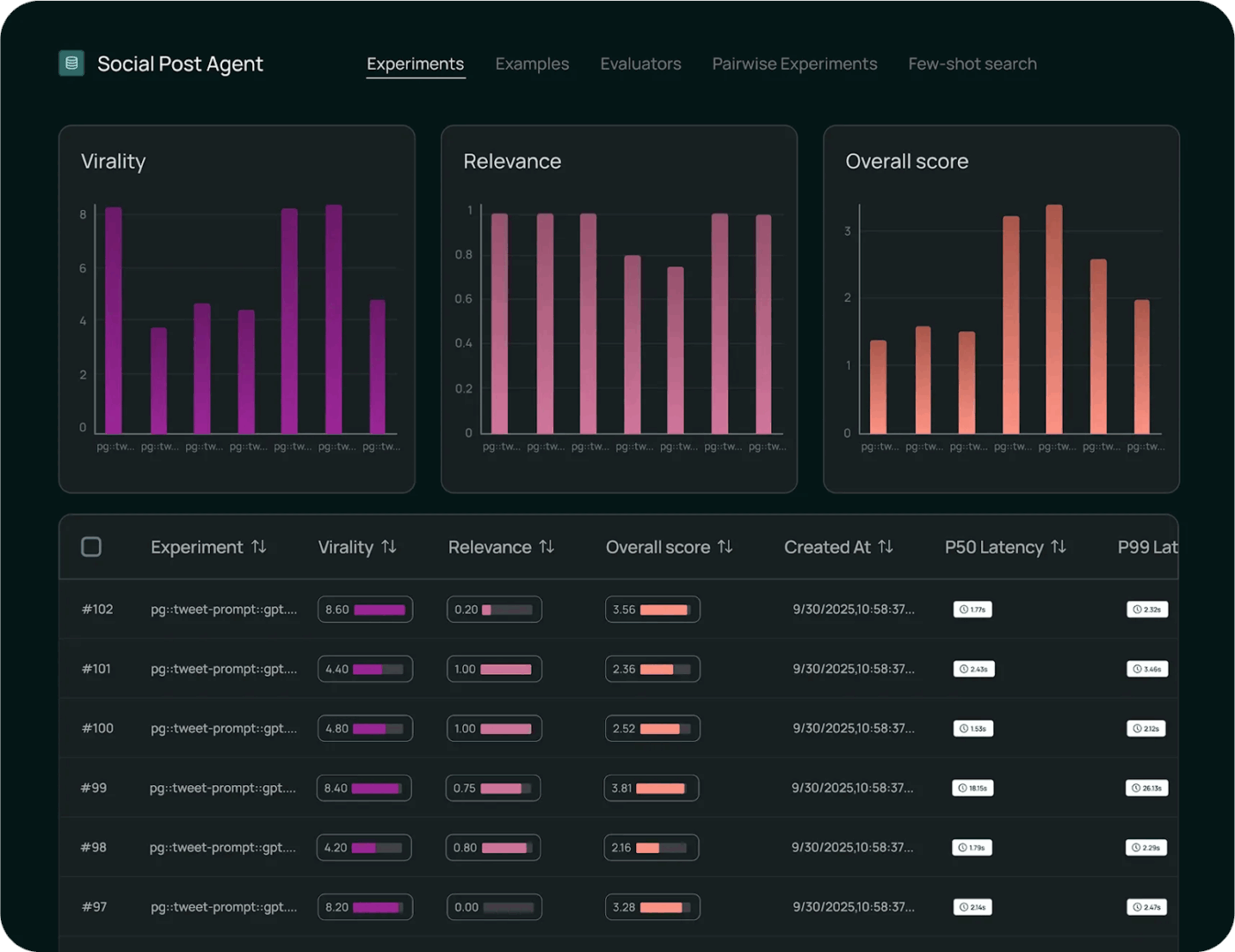

Les meilleures fonctionnalités de LangChain

- Surveillez l'exécution à l'aide d'outils d'observabilité afin de suivre les appels de modèle, la latence, les erreurs et le flux contextuel de bout en bout pour le débogage et l'analyse des performances.

- Évaluez systématiquement le comportement du modèle à l'aide de cadres de test intégrés qui mesurent l'exactitude, comparent les résultats et valident les changements par rapport à des références.

- Déployez des flux de travail à grande échelle avec des environnements gérés qui prennent en charge la gestion des versions, le contrôle du déploiement et l'exécution prête à la production des chaînes et des agents.

Limites de LangChain

- L'outil présente une courbe d'apprentissage abrupte pour les débutants, et la documentation, mise à jour tous les quelques jours, rend son utilisation fastidieuse.

Tarification LangChain

- Développeur : Gratuit

- Plus : 39 $/utilisateur/mois

- Enterprise : tarification personnalisée

Évaluations et avis sur LangChain

- G2 : 4,7/5 (plus de 30 avis)

- Capterra : pas assez d'évaluations et d'avis

Que disent les utilisateurs réels à propos de LangChain ?

Selon un utilisateur de Reddit:

Après avoir testé plusieurs méthodes différentes, j'ai fini par préférer l'utilisation d'appels d'outils standard avec les flux de travail Langgraph. J'ai donc encapsulé les flux de travail déterministes sous forme d'agents que le LLM principal appelle comme des outils. De cette façon, le LLM principal offre une expérience utilisateur véritablement dynamique et se contente de confier les tâches lourdes à un flux de travail qui renvoie ensuite ses résultats au LLM principal.

Après avoir testé plusieurs méthodes différentes, j'ai fini par préférer l'utilisation d'appels d'outils standard avec les flux de travail Langgraph. J'ai donc encapsulé les flux de travail déterministes sous forme d'agents que le LLM principal appelle comme des outils. De cette façon, le LLM principal offre une expérience utilisateur véritablement dynamique et se contente de confier les tâches lourdes à un flux de travail qui renvoie ensuite ses résultats au LLM principal.

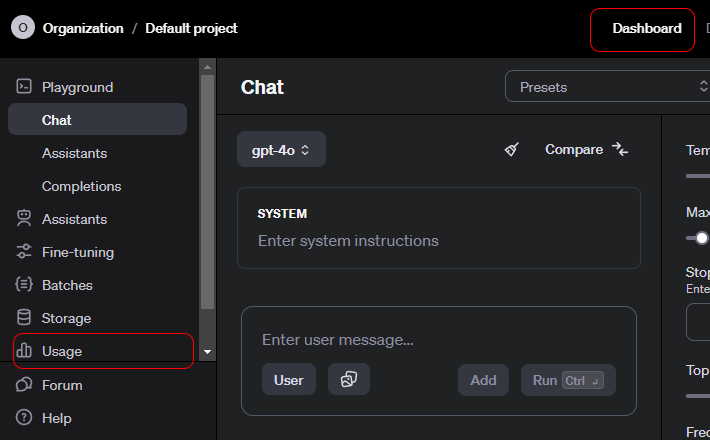

2. API OpenAI (l'API Contextual AI fournit un contexte structuré, des appels d'outils et des contrôles au niveau du système)

L'API OpenAI est une interface polyvalente permettant d'accéder à des modèles d'IA générative avancés qui alimentent un large éventail d'applications.

Les développeurs l'utilisent pour intégrer la compréhension et la génération du langage dans leurs produits. Il prend également en charge la résumation, la traduction, l'assistance au codage et le raisonnement.

L'API prend en charge le chat, les intégrations, l'appel de fonctions, la modération et les entrées multimodales, permettant ainsi des interactions structurées avec les modèles. OpenAI est parfaitement adapté au prototypage rapide, car il gère l'authentification, la mise à l'échelle et la gestion des versions.

La facilité d'utilisation est attribuée à la manière dont l'API résume le comportement complexe du modèle en points de terminaison simples et fiables.

Les meilleures fonctionnalités de l'API OpenAI

- Générez des résultats contextuels à partir de textes, de codes et d'entrées multimodales pour les tâches et le raisonnement en langage naturel.

- Créez des intégrations riches pour alimenter la recherche sémantique, le clustering et les flux de travail de récupération basés sur des vecteurs.

- Invoquez des fonctions et des outils via des appels structurés qui permettent aux modèles d'interagir avec des systèmes et services externes.

Limitation de l'API OpenAI

- Pas de mémoire à long terme native. L'API est par défaut sans état.

Tarification de l'API OpenAI

GPT-5. 2

- Entrée : 1,750 $ / 1 million de jetons

- Entrée mise en cache : 0,175 $ / 1 million de jetons

- Résultat : 14 000 $ / 1 million de jetons

GPT-5. 2 Pro

- Entrée : 21,00 $ / 1 million de jetons

- Entrée mise en cache : non disponible

- Résultat : 168,00 $ / 1 million de jetons

GPT-5 Mini

- Entrée : 0,250 $ / 1 million de jetons

- Entrée mise en cache : 0,025 $ / 1 million de jetons

- Résultat : 2 000 $ / 1 million de jetons

Évaluations et avis sur l'API OpenAI

- G2 : Pas assez d'avis

- Capterra : pas assez d'avis

Que disent les utilisateurs réels à propos de l'API OpenAI ?

Selon un utilisateur de Reddit:

Les API d'OpenAI sont comme toutes les autres, donc d'un point de vue technique, il ne devrait y avoir aucune courbe d'apprentissage. Tous les points de terminaison, paramètres et exemples de réponses sont bien documentés. Si vous avez une expérience de base en développement, vous ne devriez pas avoir besoin de suivre une formation. Je suis d'accord avec le point ci-dessus concernant l'apprentissage de Python. Les bibliothèques Python contiennent toutes les informations pertinentes pour vous faciliter la vie. Il existe également des bibliothèques Node si vous souhaitez rester avec JS. Le plus grand défi sera d'apprendre à les utiliser de manière stratégique. Prenez le temps d'essayer les messages système, les invitations utilisateur et les paramètres dans le Playground avant d'essayer de les créer avec du code. (Je suis presque sûr que vous pouvez obtenir des échantillons de code dans le Playground après avoir trouvé quelque chose qui fonctionne. )

Les API d'OpenAI sont comme toutes les autres, donc d'un point de vue technique, il ne devrait y avoir aucune courbe d'apprentissage. Tous les points de terminaison, paramètres et exemples de réponses sont bien documentés. Si vous avez une expérience de base en développement, vous ne devriez pas avoir besoin de suivre une formation. Je suis d'accord avec le point ci-dessus concernant l'apprentissage de Python. Les bibliothèques Python contiennent toutes les informations pertinentes pour vous faciliter la vie. Il existe également des bibliothèques Node si vous souhaitez rester avec JS. Le plus grand défi sera d'apprendre à les utiliser de manière stratégique. Prenez le temps d'essayer les messages système, les invitations utilisateurs et les paramètres dans le Playground avant d'essayer de les créer avec du code. (Je suis presque sûr que vous pouvez obtenir des échantillons de code dans le Playground après avoir trouvé quelque chose qui fonctionne. )

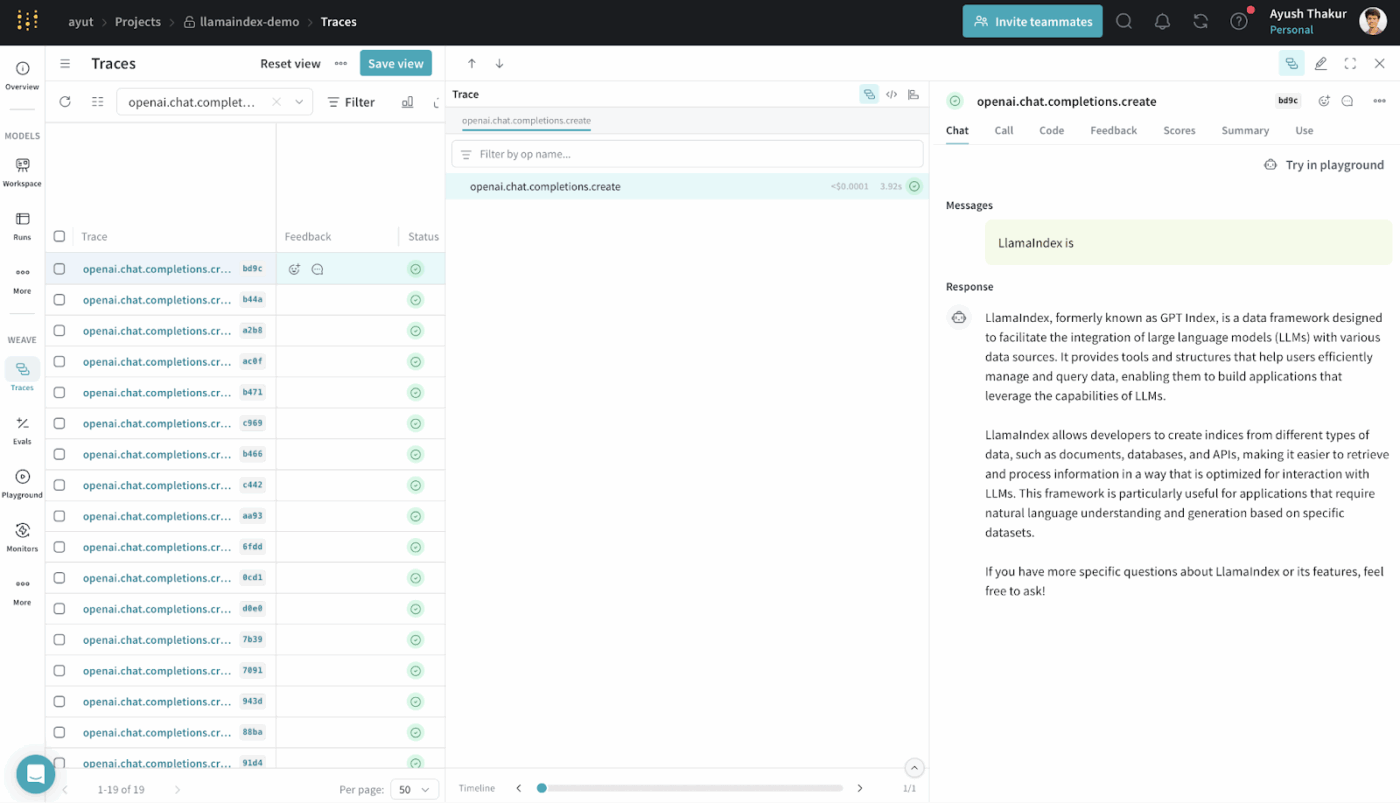

3. LlamaIndex (le meilleur pour le système de génération d'augmentation de la récupération)

LlamaIndex est un cadre de données open source conçu pour rendre les données externes accessibles et utilisables par les grands modèles linguistiques.

Il fournit des connecteurs, des index et des interfaces de requête qui transforment les données structurées et non structurées en représentations que les LLM peuvent traiter efficacement.

Vous pouvez créer des systèmes RAG sans infrastructure personnalisée complexe. Cela permet d'abstraire la récupération, la vectorisation et le classement par pertinence.

Il est couramment utilisé pour des cas d'utilisation tels que la recherche sémantique, la résumation et la réponse à des questions, sur la base de données réelles.

Les meilleures fonctionnalités de LlamaIndex

- Indexez les sources de données hétérogènes dans des structures consultables que les LLM peuvent utiliser pour poser des requêtes efficaces.

- Récupérez le contexte de manière stratégique à l'aide de la recherche vectorielle et de la planification des requêtes pour une injection précise des preuves.

- Compressez et résumez le contexte pour que le raisonnement reste efficace et pertinent.

Tarification de LlamaIndex

- Free

- Débutant : 50 $/mois

- Avantage : 500 $/mois

- Enterprise : tarification personnalisée

Évaluations et avis sur LlamaIndex

- G2 : Pas assez d'avis

- Capterra : pas assez d'avis

Que disent les utilisateurs réels à propos de LlamaIndex ?

Un utilisateur partage son expérience sur Reddit:

Honnêtement, je pense que la plupart des frameworks genAi tels que langchain et llamaindex ne sont pas très bons et compliquent le code. Il vaut mieux utiliser Python vanilla.

Honnêtement, je pense que la plupart des frameworks genAi tels que langchain et llamaindex ne sont pas très bons et compliquent le code. Il vaut mieux utiliser Python vanilla.

4. ClickUp BrainGPT (le meilleur assistant IA pour votre environnement de travail)

La plupart des outils de cette liste vous aident à réaliser des tâches spécifiques d'ingénierie contextuelle. Ils assemblent des invites, récupèrent des données ou orchestrent des flux de travail.

ClickUp Brain adopte une approche différente. Premier environnement de travail IA convergent au monde, ClickUp unifie vos projets, tâches, documents et communications au sein d'une plateforme unique, dotée d'une IA contextuelle intégrée.

Voici comment 👇

Travaillez avec une IA qui vous comprend, vous et votre travail.

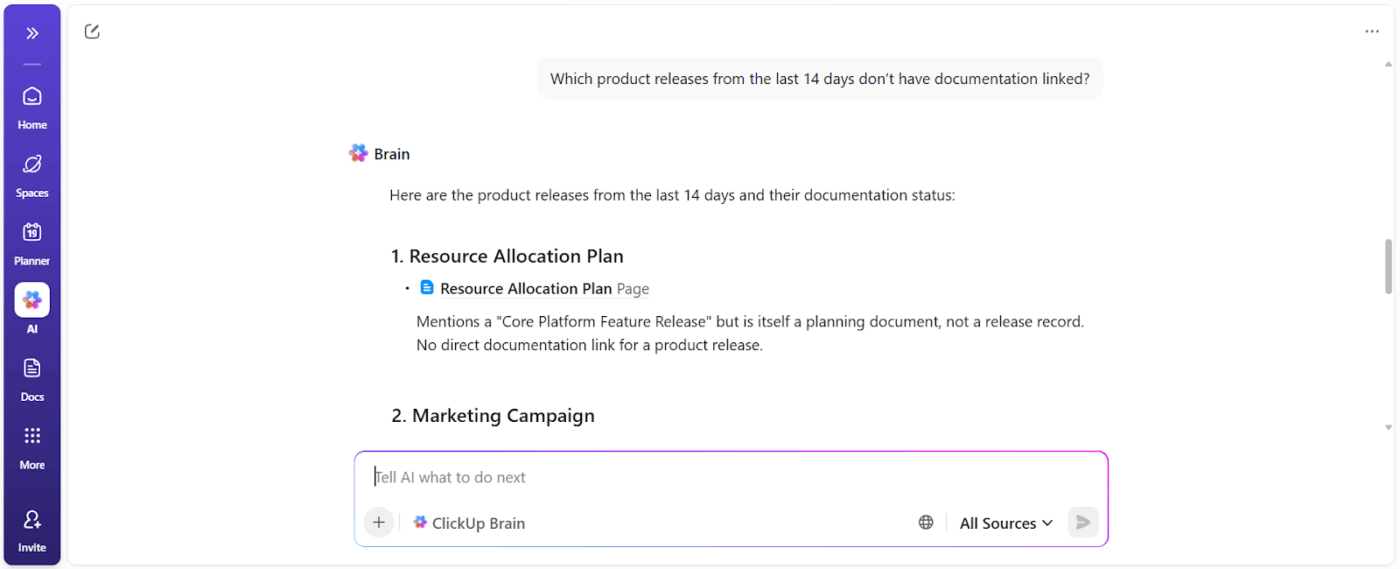

ClickUp Brain comprend le contexte de votre travail.

Il extrait le contexte de vos tâches ClickUp, documents, commentaires, dépendances, statuts, échéanciers et propriétés. Vous n'avez pas besoin de coller le contexte ou d'expliquer l'historique du projet chaque fois que vous lui posez une question basée sur les données de l'environnement de travail.

📌 Par exemple, lorsqu'un responsable demande : « Qu'est-ce qui ralentit la campagne du troisième trimestre ? », le système analyse l'environnement de travail et fait remonter les obstacles concrets tels que :

- Tâches non attribuées

- En attente d'approbation

- Avis en attente

- Dépendances en attente d'actifs

Vous obtenez un rapport de blocage qui indique les propriétaires des actions et l'impact en termes de temps.

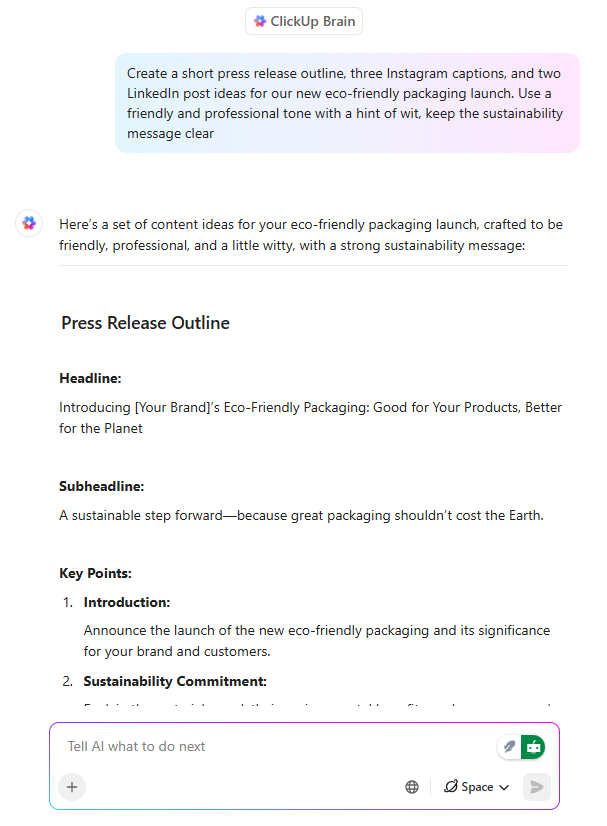

Une écriture IA déjà alignée sur l'exécution

ClickUp Brain agit comme un assistant de rédaction IA, mais avec une différence essentielle : il rédige en tenant compte de ce que l'équipe est en train de construire.

Lorsqu'un chef de produit ou un responsable marketing rédige un message de lancement dans un document ClickUp, Brain peut :

- Définissez des propositions de valeur en utilisant le contexte produit existant.

- Adaptez vos messages aux différents niveaux d'audience

- Réécrivez le contenu pour qu'il corresponde aux objectifs en matière de ton, de clarté ou de positionnement.

Plus important encore, la rédaction doit rester liée aux tâches, aux échéanciers et aux validations. Il n'y a pas de décalage entre la documentation et le travail. Cela permet de gagner beaucoup de temps, car le contenu n'a pas besoin d'être réinterprété par la suite.

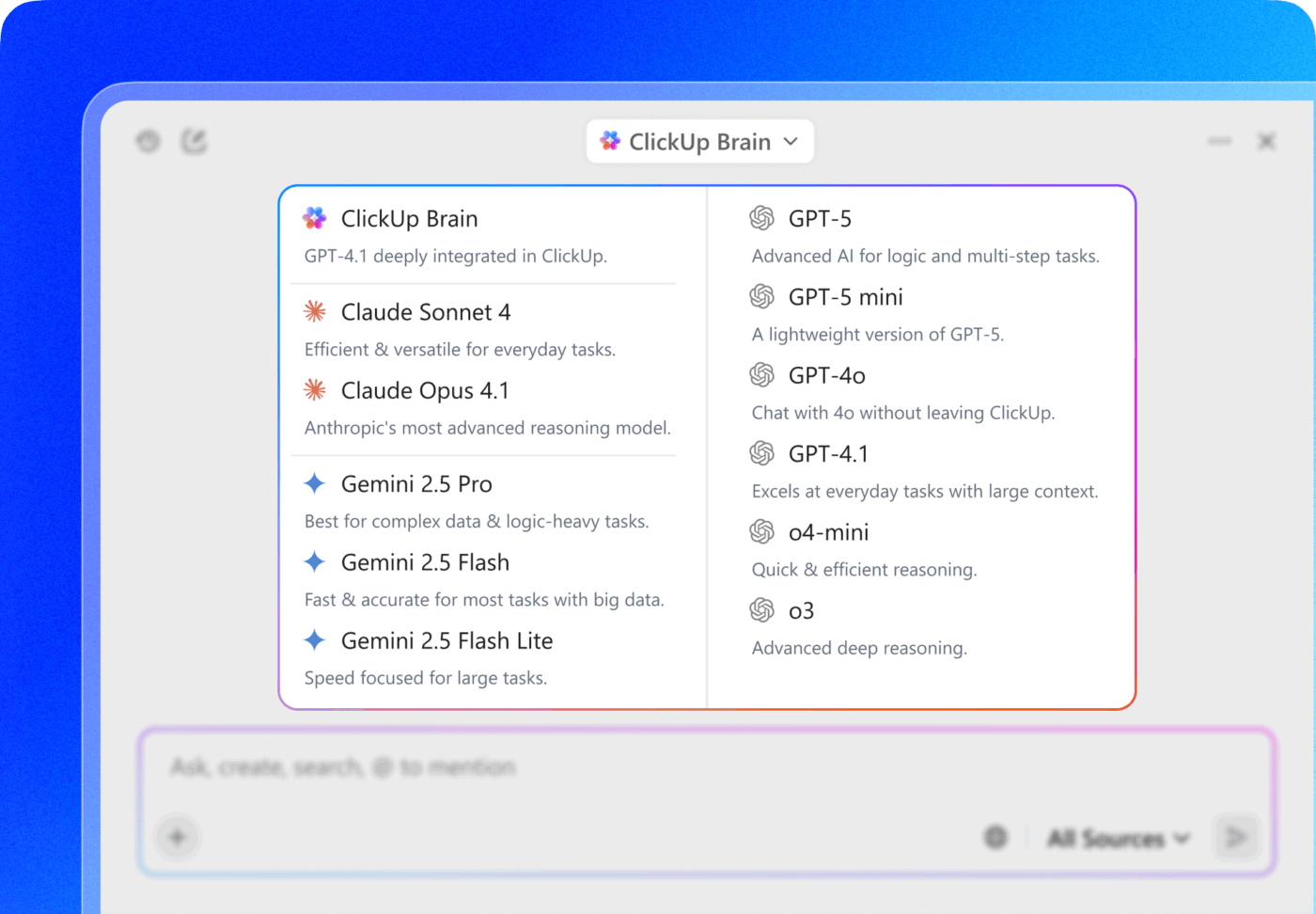

💡 Conseil de pro : choisissez parmi plusieurs modèles d'IA des familles ChatGPT, Claude et Gemini directement dans ClickUp Brain !

- Utilisez un modèle rapide et léger pour résumer les notes de réunion dans une tâche.

- Passez à un modèle plus axé sur le raisonnement lorsque vous analysez les performances des campagnes dans les documents, les tâches et les tableaux de bord.

La véritable stratégie gagnante ? Associez la sélection du modèle à la connexion du contexte de ClickUp (tâches, commentaires, documents et champs personnalisés ) afin que le modèle ne soit pas seulement « intelligent », mais qu'il fonctionne également dans la réalité de votre environnement de travail.

Automatisation des tâches contextuelles qui réduit la charge de travail manuelle

Grâce à ses tâches basées sur l'IA, ClickUp transforme le contexte en action. Les principales fonctionnalités sont les suivantes :

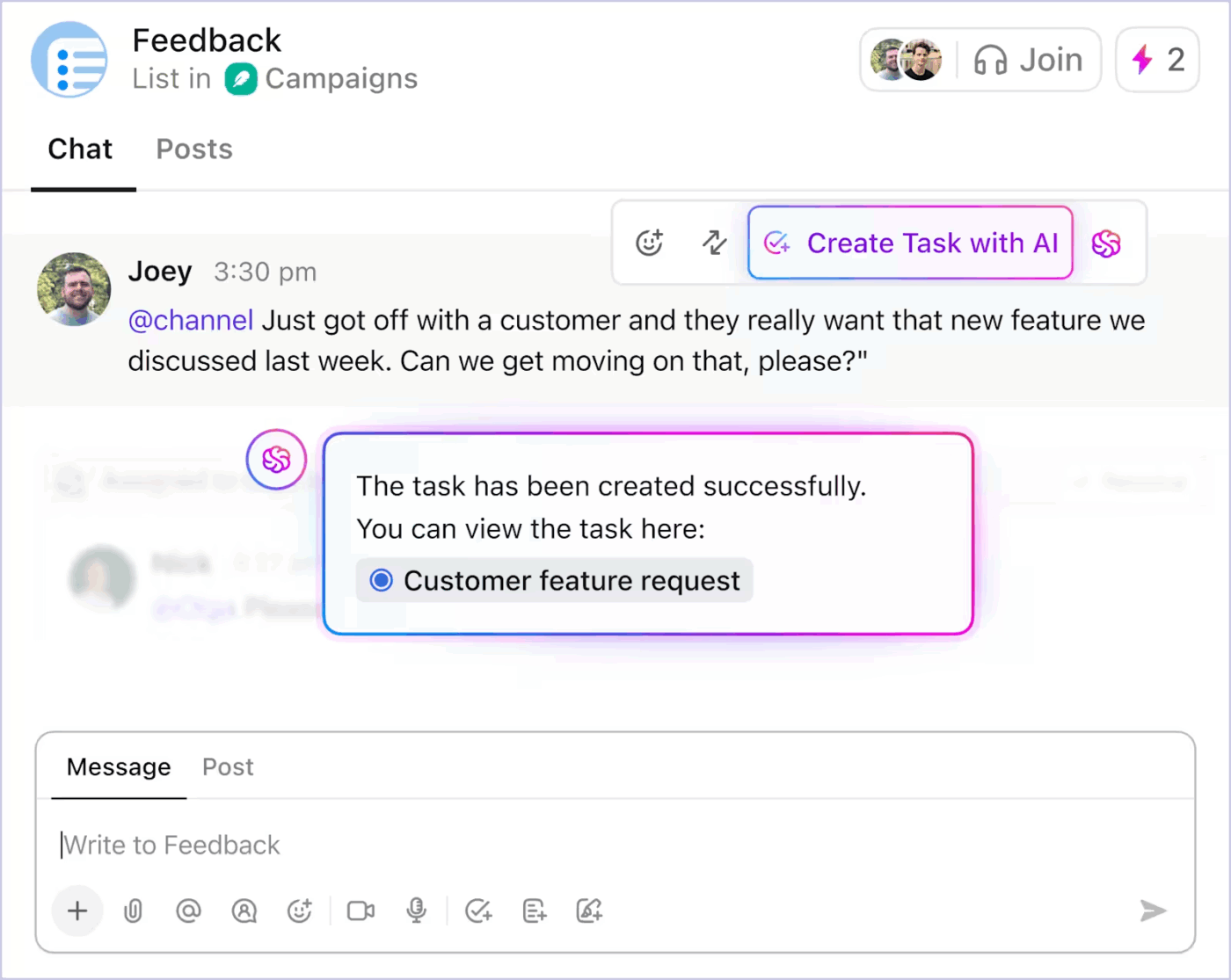

- Convertit les discussions de ClickUp Chat en tâches

- Générez des sous-tâches et des descriptions de tâches à partir d'un titre de tâche existant en fonction de la portée.

- Suggérer les prochaines étapes lorsque le travail est au point mort

- Automatisez les mises à jour de routine à l'aide de l'état réel du projet.

Voici comment vous pouvez utiliser l'automatisation des tâches basée sur l'IA dans ClickUp pour réduire le travail fastidieux 👇

L'automatisation étant guidée par le contexte en temps réel, les équipes passent moins de temps à traduire l'intention en structure. Le travail avance sans intervention manuelle constante.

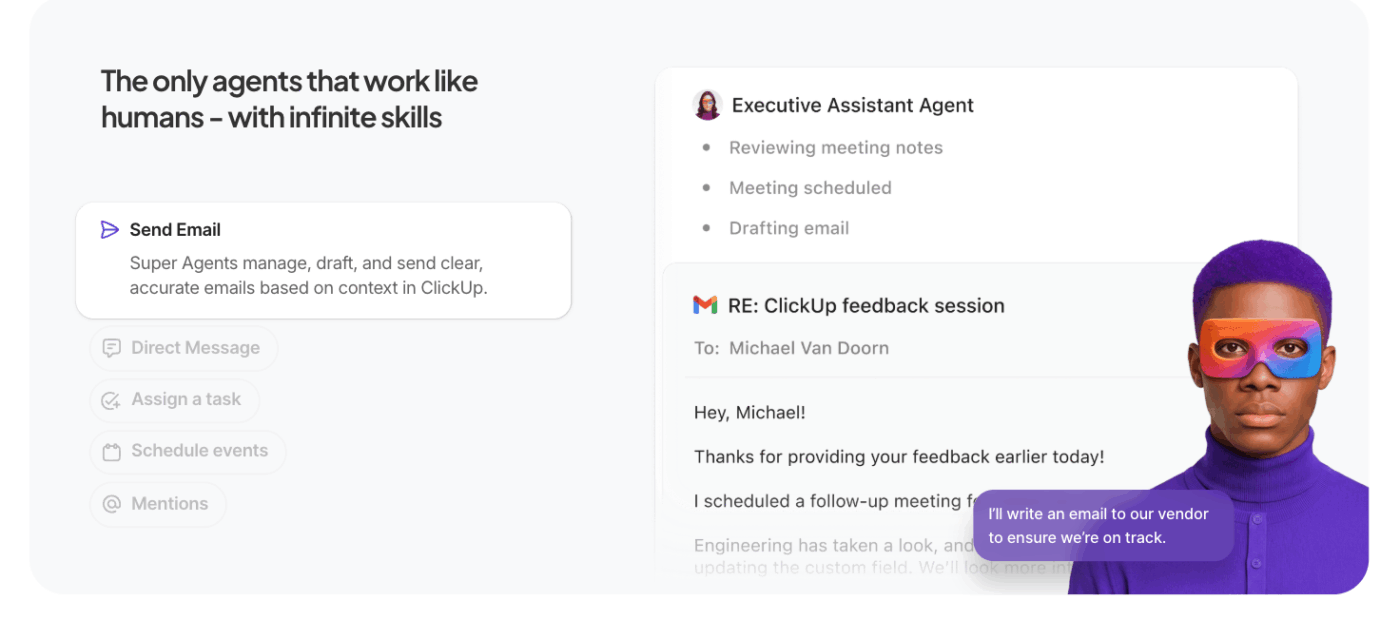

Laissez les agents IA faire le gros du travail à faire

Les super agents ClickUp étendent l'IA contextuelle de ClickUp au-delà des requêtes uniques pour permettre une exécution autonome en plusieurs étapes.

Au lieu d'attendre des invitations spécifiques, ces agents IA dédiés à l'automatisation agissent en votre nom dans l'environnement de travail, en traitant les tâches, les règles et les résultats en fonction du contexte et des objectifs que vous définissez.

Ce qui les distingue des agents classiques :

- Exécution proactive des tâches : les agents interprètent le contexte de l'environnement de travail (tâches, dépendances, échéanciers) et exécutent des séquences telles que la mise à jour des statuts, la création de sous-tâches ou la notification des propriétaires sans instruction manuelle.

- Flux de travail orientés vers les objectifs : vous définissez un objectif général (par exemple, « Résoudre les obstacles dans la campagne du troisième trimestre ») et l'agent planifie, récupère le contexte et exécute les actions qui font avancer le travail.

- Contexte et mémoire persistants : les agents conservent leur état d'une étape à l'autre, ce qui leur permet de raisonner sur ce qui est déjà terminé et ce qui reste à faire, améliorant ainsi la précision et réduisant le travail redondant.

- Intégration avec les outils de l'environnement de travail : ils interagissent avec les tâches ClickUp, les documents et les commentaires, ainsi qu'avec les outils en connexion, en coordonnant les différents systèmes pour achever les flux de travail au lieu de suggérer des actions sans contexte.

📚 Pour en savoir plus : Que sont les agents réflexifs basés sur des modèles?

Les meilleures fonctionnalités de ClickUp

- Intégrez l'IA à votre bureau et à vos applications connectées avec ClickUp Brain MAX: effectuez des recherches dans votre environnement de travail, transcrivez la parole en texte, passez d'un modèle d'IA à l'autre et effectuez des actions sur des tâches, des documents et des chats sans interrompre votre flux de travail.

- Trouvez des réponses instantanément avec Enterprise Search : effectuez des recherches dans les tâches, les documents, les commentaires, les fichiers et les outils connectés afin que les informations contextuelles essentielles ne soient jamais perdues ou cloisonnées.

- Capturez rapidement vos idées avec Talk to Text : dictez vos notes, vos projets ou vos mises à jour et convertissez votre discours en travail structuré sans perdre votre concentration ni votre élan.

- Réduisez le travail manuel grâce aux tableaux de bord ClickUp : déclenchez automatiquement les mises à jour des tâches, les affectations et les suivis en fonction du contexte réel de l'environnement de travail et des changements d'état.

- Gardez les discussions exploitables avec ClickUp Chat : discutez des décisions, des commentaires et des approbations directement à côté des tâches afin que les discussions restent liées à l'exécution.

- Remplacez les réunions par des SyncUps: partagez des mises à jour asynchrones, obtenez des résumés générés par l'IA et assurez la cohésion des équipes sans appels récurrents.

- Coordonnez vos équipes avec Teams Hub : affichez l'activité, les responsabilités, les priorités et les capacités de vos équipes en un seul endroit afin d'identifier les risques et de rééquilibrer le travail dès le début.

- Planifiez votre journée avec ClickUp Calendrier : obtenez des plans quotidiens assistés par l'IA en fonction des délais, des priorités et de la charge de travail, afin que vos objectifs personnels s'alignent sur ceux de votre équipe.

Limites de ClickUp

- Ses fonctionnalités et ses options de personnalisation peuvent intimider les nouveaux utilisateurs.

Tarifs ClickUp

Évaluations et avis sur ClickUp

- G2 : 4,7/5 (plus de 10 585 avis)

- Capterra : 4,6/5 (plus de 4 500 avis)

Que disent les utilisateurs réels à propos de ClickUp AI ?

Un utilisateur de ClickUp partage également son expérience sur G2:

ClickUp Brain MAX a été un ajout incroyable à mon flux de travail. La façon dont il combine plusieurs LLM dans une seule plateforme rend les réponses plus rapides et plus fiables, et la conversion de la parole en texte sur toute la plateforme permet de gagner énormément de temps. J'apprécie également beaucoup la sécurité de niveau entreprise, qui me permet de traiter des informations sensibles en toute tranquillité. […] Ce qui ressort le plus, c'est la façon dont il m'aide à faire le tri et à penser plus clairement, que ce soit pour résumer des réunions, rédiger du contenu ou réfléchir à de nouvelles idées. C'est comme avoir un assistant IA tout-en-un qui s'adapte à tous mes besoins.

ClickUp Brain MAX a été un ajout incroyable à mon flux de travail. La façon dont il combine plusieurs LLM dans une seule plateforme rend les réponses plus rapides et plus fiables, et la conversion de la parole en texte sur toute la plateforme permet de gagner énormément de temps. J'apprécie également beaucoup la sécurité de niveau entreprise, qui me permet de traiter des informations sensibles en toute tranquillité. […] Ce qui ressort le plus, c'est la façon dont il m'aide à faire le tri et à penser plus clairement, que ce soit pour résumer des réunions, rédiger du contenu ou réfléchir à de nouvelles idées. C'est comme avoir un assistant IA tout-en-un qui s'adapte à tous mes besoins.

Défis et considérations liés au travail avec l'ingénierie contextuelle de l'IA

Voici les principaux défis dont vous devez être conscient. Le contexte peut devenir incontrôlable, même lorsque le modèle prend en charge des fenêtres contextuelles d'un million de jetons. Voici les principaux défis dont vous devez être conscient 👇

Empoisonnement du contexte

Si une hallucination ou une inférence incorrecte s'introduit dans le contexte et est référencée à plusieurs reprises, le modèle la traite comme un fait. Ce contexte empoisonné peut bloquer les flux de travail dans des hypothèses invalides qui persistent dans le temps et dégradent la qualité du résultat.

Distraction contextuelle

Les contextes plus larges sont tentants, mais lorsqu'ils deviennent trop vastes, les modèles commencent à se concentrer excessivement sur l'historique accumulé et sous-utilisent ce qu'ils ont appris pendant leur formation. Cela peut amener l'IA à se focaliser sur des détails passés au lieu de synthétiser la meilleure étape suivante.

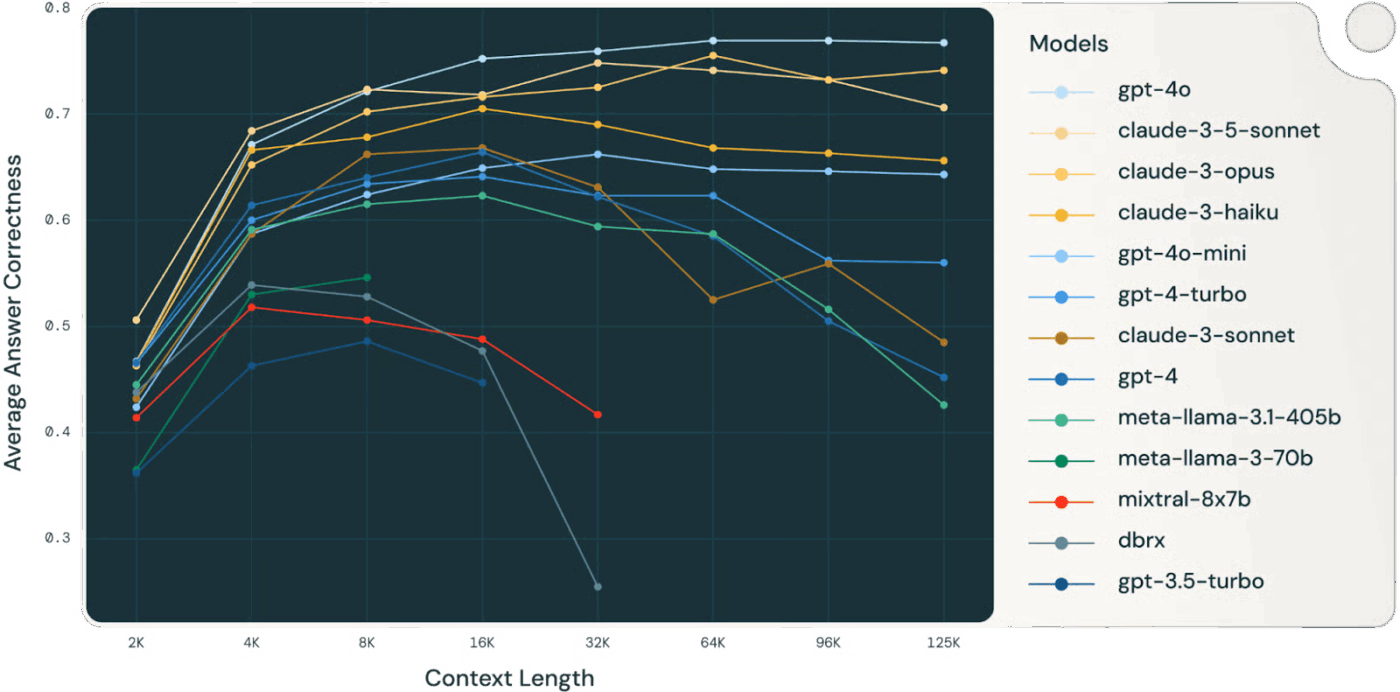

👀 Le saviez-vous ? Une étude Databricks a révélé que la précision du modèle Llama 3. 1 405B commençait à baisser à partir de 32 000 jetons, bien avant que la fenêtre contextuelle ne soit pleine. Les modèles plus petits se dégradaient encore plus tôt.

Les modèles perdent souvent leur capacité de raisonnement bien avant d'être « à court » de contexte, ce qui rend la sélection et la compression du contexte plus importantes que la taille brute du contexte.

📚 En savoir plus : Qu'est-ce que la recherche sur le lieu de travail et comment améliore-t-elle la productivité des employés?

Confusion contextuelle

Les informations non pertinentes ou peu significatives dans le contexte rivalisent avec les données critiques pour attirer l'attention. Lorsque le modèle se sent obligé d'utiliser tous les jetons contextuels, les décisions deviennent confuses et la précision en pâtit, même s'il y a techniquement « plus » d'informations.

Conflit de contexte

À mesure que les informations s'accumulent, de nouveaux faits ou descriptions d'outils peuvent contredire le contenu précédent. En cas de conflit de contexte, les modèles ont du mal à concilier les signaux contradictoires, ce qui conduit à des résultats incohérents ou inconsistants.

Surcharge d'outils et problèmes de sélection

Lorsque trop de définitions d'outils sont incluses dans le contexte, sans être filtrées, le modèle peut faire appel à des outils non pertinents ou donner la priorité à des outils sous-optimaux. Le chargement sélectif des seuls outils pertinents atténue la confusion et améliore la qualité des décisions.

Complexité technique et maintenance

Une gestion efficace du contexte nécessite un élagage, la résumation, le déchargement et la mise en quarantaine continus du contexte. Les systèmes doivent décider quand compresser l'historique et quand récupérer de nouvelles informations, ce qui exige une infrastructure bien pensée plutôt que des astuces ponctuelles.

Discipline budgétaire en matière de jetons

Chaque jeton influence le comportement ; des fenêtres contextuelles plus grandes ne garantissent pas de meilleurs résultats. Vous devez traiter le contexte comme une ressource gérée, en évaluant la pertinence et l'actualité par rapport au coût des jetons et au budget d'attention du modèle.

⚠️ Alerte statistique : près de 60 % des employés admettent utiliser des outils d'IA publics non autorisés au travail, collant souvent des données sensibles de l'entreprise dans des plateformes sans aucun contrôle.

Et pire encore : 63 % des organisations n'ont mis en place aucune politique de gouvernance de l'IA pour surveiller, restreindre ou même détecter cette utilisation fantôme de l'IA.

Résultat ? Vos données fuient parce que personne ne surveille la manière dont l'IA est utilisée.

L'avenir de l'ingénierie contextuelle

Cela marque le passage de l'expérimentation à la mise à l'échelle. Le contexte ne sera plus géré par des humains, mais généré et géré par du code. Il sera la fonction de la structure même du système.

Nous allons résumer cela en nous appuyant sur l'excellent article de Serge Liatko publié sur la communauté des développeurs OpenAI :

L'ingénierie contextuelle évolue vers l'architecture des flux de travail.

L'ingénierie contextuelle cédera de plus en plus la place à l'architecture de flux de travail automatisée. La tâche ne se limitera pas à fournir les bons jetons.

Une ingénierie contextuelle efficace implique d'orchestrer des séquences complètes de raisonnement, d'outils et de flux de données qui s'adaptent automatiquement à l'évolution des besoins.

Cela implique de créer des systèmes dynamiques qui gèrent automatiquement le bon contexte au sein de flux de travail holistiques.

L'automatisation de l'orchestration remplace les invitations manuelles

La prochaine étape est l'IA qui s'organise elle-même. Elle reliera la récupération, les outils, la mémoire et la logique métier sans que les humains aient à créer manuellement chaque invite ou ensemble de contextes. Plutôt que de fournir explicitement chaque donnée, les systèmes déduiront quel contexte est pertinent et le géreront automatiquement en fonction des objectifs et de l'historique.

🧠 C'est déjà le cas avec les super agents ClickUp. Ce sont des coéquipiers IA ambient et toujours actifs, qui les aident à comprendre et à exécuter le travail comme le feraient des humains. Ils s'améliorent continuellement à partir des interactions passées en utilisant une mémoire riche (préférences d'apprentissage, actions récentes et historique des projets) et peuvent agir de manière proactive, escalader les problèmes ou faire émerger des idées sans attendre une invite, des instructions.

L'automatisation de bout en bout devient le véritable levier de productivité.

À mesure que l'ingénierie contextuelle évolue, les gains de productivité proviennent des flux de travail automatisés. Les LLM agissent comme des agents, coordonnant les outils, surveillant l'état et exécutant une logique en plusieurs étapes sans microgestion de la part de l'utilisateur.

Vous n'aurez pas besoin de saisir manuellement le contexte manquant. Le système sélectionnera le contexte afin de fournir l'assistance nécessaire à la mémoire à long terme et au raisonnement.

Le contexte unifié améliore le travail de l'IA

La précision de l'IA est compromise lorsque le contexte est fragmenté entre les outils, les flux de travail et les personnes. Lorsque les informations sont dispersées, les modèles sont obligés de deviner.

Les environnements de travail IA convergents tels que ClickUp excellent dans ce domaine, en unifiant le travail, les données et l'IA dans votre stratégie contextuelle.

Prêt à essayer ? Inscrivez-vous gratuitement sur ClickUp.