La mayoría de los equipos de corporación que exploran LLaMA se quedan atascados en el mismo punto: descargan los pesos del modelo, se quedan mirando la ventana de la terminal y se dan cuenta de que no tienen ni idea de qué hacer a continuación.

Este reto es muy común: aunque el 88 % de las empresas utilizan la IA en al menos una función, solo el 7 % la han ampliado a toda la organización.

Esta guía le acompaña a lo largo de todo el proceso, desde la selección del tamaño de modelo adecuado para su caso de uso hasta su ajuste con los datos de su empresa, para que pueda implementar una solución de IA funcional que realmente comprenda el contexto de su negocio.

¿Qué es LLaMA y por qué es importante para la IA de la corporación?

LLaMA (abreviatura de Large Language Model Meta IA) es una familia de modelos de lenguaje de peso abierto creados por Meta. A alto nivel, hace lo mismo que modelos como GPT o Gemini: entiende el lenguaje, genera texto y puede razonar a partir de la información. La gran diferencia es cómo pueden utilizarlo las corporaciones.

Dado que LLaMA es de peso abierto, las empresas no se ven obligadas a interactuar con él únicamente a través de una API de caja negra. Pueden ejecutarlo en su propia infraestructura, ajustarlo con datos internos y controlar cómo y dónde se implementa.

Para las corporaciones, esto es muy importante, especialmente cuando la privacidad de los datos, el cumplimiento normativo y la previsibilidad de los costes son más importantes que la novedad.

Esta flexibilidad hace que LLaMA resulte especialmente atractivo para los equipos que desean integrar profundamente la IA en sus flujos de trabajo, y no solo añadirla como un chatbot independiente. Piense en asistentes de conocimiento internos, automatización del soporte al cliente, herramientas para desarrolladores o funciones de IA integradas directamente en los productos, sin enviar datos confidenciales fuera de la organización.

En resumen, LLaMA es importante para la IA empresarial porque ofrece a los equipos opciones en cuanto a la implementación, la personalización y la integración de la IA en sistemas empresariales reales. Y a medida que la IA pasa de la experimentación a las operaciones cotidianas, ese nivel de control deja de ser algo «deseable» para convertirse en un requisito.

Cómo empezar a utilizar LLaMA para aplicaciones de corporación

1. Defina su caso de uso de la corporación.

Antes de descargar nada, identifique los flujos de trabajo exactos en los que la IA puede tener un impacto real. Adaptar el caso de uso de la IA al tamaño del modelo es clave: los modelos más pequeños de 8B son eficaces para tareas sencillas, mientras que los modelos más grandes de 70B+ son mejores para razonamientos complejos.

Para ayudarle a identificar las aplicaciones de IA adecuadas para su empresa, vea esta panorámica de casos prácticos de uso de la IA en diferentes funciones empresariales y sectores:

Algunos puntos de partida comunes son:

- Procesamiento de documentos: resumir informes largos o extraer información clave de contratos.

- Asistencia con el código: generar código repetitivo, explicar sistemas heredados/as o sugerir optimizaciones.

- Recuperación de conocimientos: responder a las preguntas de los empleados buscando en la documentación interna mediante una técnica denominada «generación aumentada por recuperación» (RAG, por sus siglas en inglés).

- Generación de contenido: redacción de comunicaciones preliminares o textos de marketing.

2. Configure los requisitos previos y las dependencias.

A continuación, prepare su hardware y software. El tamaño del modelo determina sus necesidades; un modelo LLaMA 8B requiere una GPU con aproximadamente 15 GB de VRAM, mientras que un modelo 70B necesita 131 GB o más.

Su pila de software debe incluir Python 3. 8+, PyTorch, controladores CUDA y el ecosistema Hugging Face (transformadores, aceleradores y bitsandbytes).

3. Acceda y descargue los pesos del modelo LLaMA.

Puede obtener los pesos del modelo en la página oficial de descargas de Llama de Meta o en el hub de modelos Hugging Face. Deberá aceptar la licencia comunitaria de Llama 3, que permite el uso comercial. Dependiendo de su configuración, descargará los pesos en formato safetensors o GGUF.

4. Configure su entorno de desarrollo.

Una vez descargados los pesos, es el momento de ajustar su entorno. Instale las bibliotecas Python necesarias, incluyendo transformadores, aceleradores y bitsandbytes para la cuantificación, un proceso que reduce el consumo de memoria del modelo.

Cargue el modelo con los ajustes adecuados y ejecute una sencilla indicación para asegurarse de que todo funciona correctamente antes de pasar a la personalización.

💡Si no dispone de un equipo dedicado a la infraestructura de ML, todo este proceso puede resultar inviable. Evite por completo la complejidad de la implementación con ClickUp Brain. Ofrece capacidades de IA, como asistencia para la redacción y automatización de tareas, directamente en el entorno de trabajo en el que ya opera su equipo, sin necesidad de descargar modelos ni aprovisionar GPU.

Cómo personalizar LLaMA para los datos de su corporación.

Usar un modelo LLaMA básico es un buen comienzo, pero no entenderá las siglas, los nombres de proyectos o los procesos internos únicos de su empresa. Esto da lugar a respuestas genéricas e inútiles que no resuelven los problemas empresariales reales.

La IA empresarial resulta útil gracias a la personalización: entrenar el modelo con su terminología y base de conocimientos específicos.

Prepare sus datos de entrenamiento específicos para su dominio.

El éxito de su IA personalizada depende más de la calidad de sus datos de entrenamiento que del tamaño del modelo o la potencia de cálculo. Empiece por recopilar y limpiar su información interna.

- Documentación interna: recopile especificaciones de productos, guías de procesos y documentos de políticas.

- Comunicaciones históricas: recopile plantillas de correo electrónico, respuestas a tickets de soporte y resúmenes de reuniones.

- Terminología del dominio: compile glosarios, definiciones de acrónimos y lenguaje específico del sector.

Una vez recopilada, formatee esta información en pares de instrucciones y respuestas para el ajuste supervisado. Por ejemplo, una instrucción podría ser «Resuma este ticket de soporte» y la respuesta sería un resumen claro y conciso. Este paso es crucial para enseñar al modelo cómo realizar tareas específicas con sus datos.

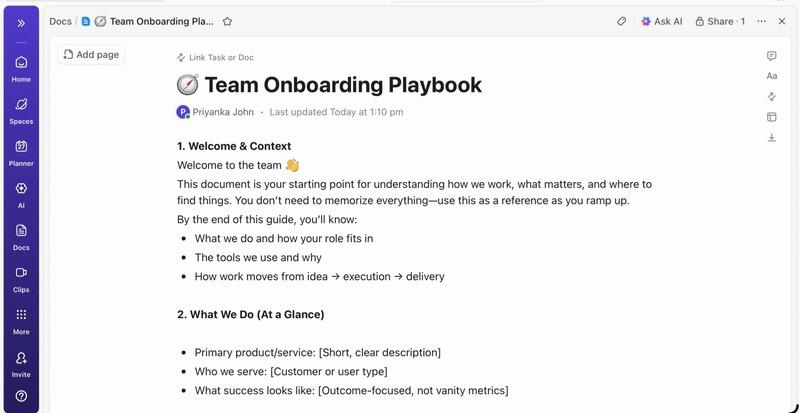

📮 ClickUp Insight: El profesional medio dedica más de 30 minutos al día a buscar información relacionada con el trabajo, lo que supone más de 120 horas al año perdidas en buscar entre correos electrónicos, hilos de Slack y archivos dispersos. Un asistente de IA inteligente integrado en su entorno de trabajo puede cambiar eso.

Entra en ClickUp Brain. Proporciona información y respuestas instantáneas al mostrar los documentos, conversaciones y detalles de tareas adecuados en cuestión de segundos, para que puedas dejar de buscar y empezar a trabajar.

💫 Resultados reales: equipos como QubicaAMF recuperaron más de 5 horas semanales utilizando ClickUp, lo que supone más de 250 horas anuales por persona, al eliminar procesos de gestión del conocimiento obsoletos. ¡Imagina lo que tu equipo podría crear con una semana extra de productividad cada trimestre!

Ajuste LLaMA a su contexto empresarial.

El ajuste es el proceso de adaptar los conocimientos existentes de LLaMA a su caso de uso específico, lo que mejora drásticamente su precisión en tareas específicas del dominio. En lugar de entrenar un modelo desde cero, puede utilizar métodos eficientes en cuanto a parámetros que solo actualizan un pequeño subconjunto de los parámetros del modelo, lo que ahorra tiempo y recursos computacionales.

Entre los métodos de ajuste más populares se incluyen:

- LoRA (adaptación de rango bajo): este método entrena pequeñas matrices «adaptadoras» en lugar de todo el modelo, lo que lo hace muy eficiente.

- QLoRA: combina LoRA con cuantificación para permitir el ajuste fino en una sola GPU de 48 GB, al tiempo que iguala el rendimiento del ajuste fino completo.

- Ajuste completo: actualiza todos los parámetros del modelo, lo que ofrece el nivel más profundo de personalización, pero requiere una potencia computacional significativa.

Evaluar y repetir el rendimiento del modelo.

¿Cómo saber si su modelo personalizado funciona realmente? La evaluación de la IA debe ir más allá de las simples puntuaciones de precisión y medir la utilidad en el mundo real. Cree conjuntos de datos de evaluación que reflejen sus casos de uso en producción y realice el seguimiento de las métricas que son importantes para su empresa, como la calidad de la respuesta, la precisión factual y la latencia.

- Evaluación cualitativa: haga que revisores humanos evalúen los resultados en cuanto a tono, utilidad y corrección.

- Métricas cuantitativas: utilice puntuaciones automatizadas como BLEU o perplejidad para realizar el seguimiento del rendimiento a gran escala.

- Supervisión de la producción: una vez implementado, realice el seguimiento de los comentarios de los usuarios y las tasas de error para identificar áreas de mejora.

💡Este proceso iterativo de formación y evaluación puede convertirse en un proyecto en sí mismo. Gestione el ciclo de vida del desarrollo de la IA directamente en ClickUp en lugar de perderse en hojas de cálculo.

Centralice las métricas de rendimiento y los resultados de la evaluación en una sola vista con los paneles de ClickUp. Realice un seguimiento de las versiones de los modelos, los parámetros de entrenamiento y las puntuaciones de evaluación junto con el resto de su trabajo relacionado con el producto con los campos personalizados de ClickUp, manteniendo todo organizado y con visibilidad. 🛠️

Principales casos de uso empresariales de LLaMA

Los equipos a menudo se quedan estancados en el análisis paralizante, incapaces de pasar del entusiasmo abstracto por la IA a aplicaciones concretas. La flexibilidad de LLaMA lo hace adecuado para una amplia gama de flujos de trabajo empresariales, ayudándole a automatizar tareas y trabajar de forma más eficiente.

Estos son algunos de los principales casos de uso de un modelo LLaMA personalizado:

- Asistentes de conocimiento internos: Deje de perder tiempo buscando información. Implemente LLaMA con RAG para crear un chatbot que pueda responder instantáneamente a las preguntas de los empleados buscando en sus wikis internos, documentos de políticas y comunicaciones de proyectos anteriores.

- Automatización del soporte al cliente: ajuste un modelo basado en su historial de tickets para redactar respuestas automáticamente, clasificar consultas y derivar los problemas complejos al agente humano adecuado.

- Generación y revisión de código: ayude a su equipo de ingeniería a trabajar de forma más eficiente. Utilice LLaMA para generar código repetitivo, explicar sistemas heredados complejos e incluso identificar posibles errores en las solicitudes de validación antes de que se conviertan en incidencias.

- Procesamiento de documentos: convierta grandes volúmenes de texto en información útil. Resuma informes extensos, extraiga términos clave de contratos legales o genere notas concisas de reuniones a partir de transcripciones sin procesar en cuestión de segundos.

- Flujos de trabajo de creación de contenido: supere el bloqueo del escritor. Redacte borradores de textos de marketing, descripciones de productos y anuncios internos que sus editores humanos puedan perfeccionar y pulir.

💡Acceda a muchos de estos casos de uso listos para usar con ClickUp Brain.

- Resuma hilos de tareas, redacte actualizaciones de proyectos y genere contenido con la asistencia de escritura basada en IA de ClickUp.

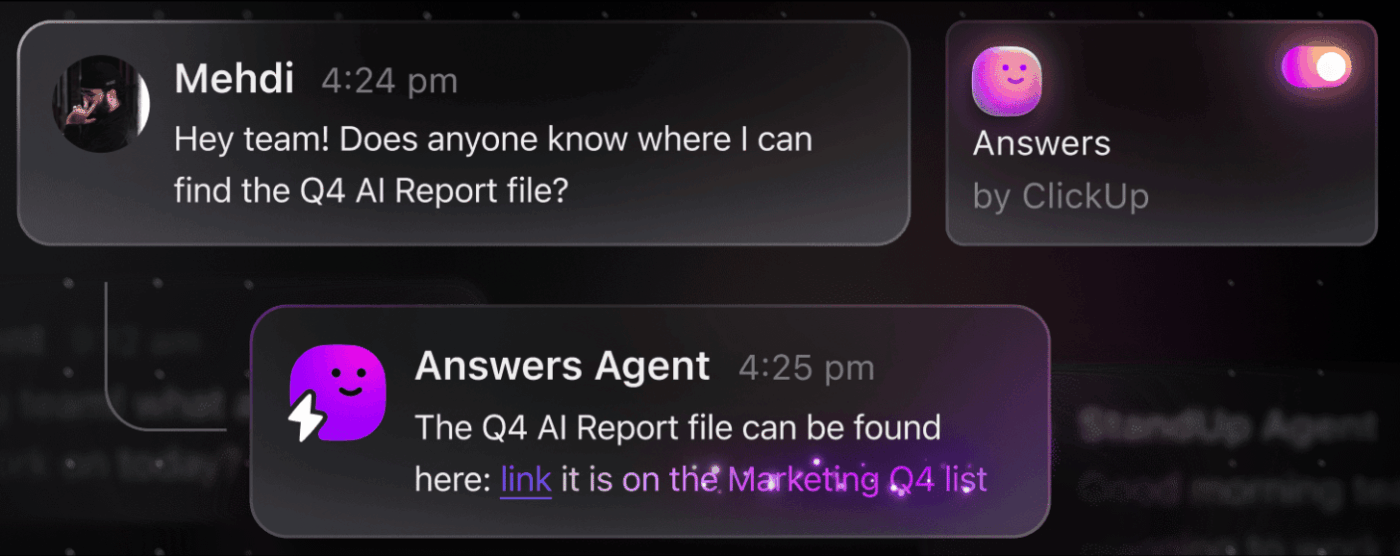

- Encuentre respuestas en todo su entorno de trabajo de ClickUp al instante con la búsqueda empresarial de ClickUp y el agente preconfigurado Ambient Answers.

- Cree flujos de trabajo inteligentes que se encarguen del trabajo rutinario por usted con ClickUp Automatizaciones.

Limitaciones del uso de LLaMA para la IA empresarial

Aunque el autoalojamiento de LLaMA ofrece un control significativo, no está exento de retos. Los equipos suelen subestimar los gastos operativos y se ven atrapados en el mantenimiento en lugar de dedicarse a la innovación. Antes de confirmar la vía de la «creación», es fundamental comprender los posibles obstáculos.

Estas son algunas de las limitaciones clave que hay que tener en cuenta:

- Requisitos de infraestructura: ejecutar modelos grandes es caro y requiere GPU potentes de nivel de corporación que muchas organizaciones no tienen a su disposición.

- Conocimientos técnicos necesarios: la implementación, el ajuste y el mantenimiento de un modelo de lenguaje grande requieren habilidades especializadas en ingeniería de aprendizaje automático, que tienen una gran demanda.

- Carga de mantenimiento continuo: no se trata de una solución del tipo «configúrelo y olvídese». Los modelos necesitan una supervisión constante, actualizaciones de seguridad y reentrenamiento a medida que su empresa evoluciona.

- Riesgo de alucinación: al igual que todos los LLM, LLaMA puede generar en ocasiones información que parece plausible, pero que es incorrecta. Las aplicaciones de corporación requieren barreras de protección robustas y supervisión humana para mitigar este riesgo.

- Sin funciones de corporación integradas: las funciones críticas, como el control de acceso, el registro de auditoría y las herramientas de cumplimiento, deben crearse y gestionarse por separado, lo que añade otra capa de complejidad.

💡Puede evitar estas limitaciones utilizando ClickUp Brain. Proporciona IA gestionada dentro de su entorno de trabajo existente, lo que le ofrece capacidades de IA empresarial sin los gastos operativos adicionales. Obtenga seguridad de nivel empresarial y elimine el mantenimiento de la infraestructura con ClickUp, lo que liberará a su equipo para que se centre en su trabajo principal.

📮ClickUp Insight: el 88 % de los encuestados utiliza la IA para sus tareas personales, pero más del 50 % evita utilizarla en el trabajo. ¿Las tres barreras principales? La falta de integración fluida, las lagunas de conocimiento o las preocupaciones en materia de seguridad.

Pero, ¿qué pasa si la IA está integrada en su entorno de trabajo y ya es segura? ClickUp Brain, el asistente de IA integrado de ClickUp, lo hace realidad. Entiende las indicaciones en lenguaje sencillo, resolviendo las tres preocupaciones relacionadas con la adopción de la IA, al tiempo que conecta su chat, tareas, documentos y conocimientos en todo el entorno de trabajo. ¡Encuentre respuestas e información con un solo clic!

Herramientas de IA alternativas para casos de uso en corporaciones.

Elegir la herramienta de IA adecuada entre las muchas opciones disponibles es un reto para cualquier equipo. Intenta averiguar las ventajas e inconvenientes de los diferentes modelos, pero le preocupa elegir el equivocado y malgastar recursos.

Esto suele conducir a la proliferación descontrolada de la IA, es decir, la proliferación no planificada de herramientas y plataformas de IA sin supervisión ni estrategia, en la que los equipos se suscriben a múltiples servicios desconectados, lo que genera más trabajo en lugar de menos.

A continuación, se ofrece un breve resumen de los principales actores y su papel:

| Herramienta | Ideal para | Consideraciones clave |

|---|---|---|

| LLaMA (autohospedado) | Máximo control, soberanía de los datos. | Requiere infraestructura y experiencia en ML. |

| OpenAI GPT-4 | Máxima capacidad, configuración mínima. | Los datos salen de su entorno, precios basados en el uso. |

| Claude (Anthropic) | Tareas de contexto largo, enfoque en la seguridad. | Ventajas e inconvenientes similares a los de GPT-4. |

| Mistral | Residencia de datos en Europa, eficiencia. | Ecosistema más pequeño que LLaMA. |

| ClickUp Brain | IA integrada en el entorno de trabajo, sin implementación. | Ideal para equipos que desean incorporar la IA en sus flujos de trabajo existentes. |

En lugar de conectar varias herramientas para satisfacer sus necesidades, ¿por qué no acceder a la IA integrada directamente en el lugar donde se desarrolla su trabajo? Esta es la esencia de lo que ofrece ClickUp como el primer entorno de trabajo de IA convergente del mundo: una plataforma única y segura donde conviven proyectos, documentos, conversaciones y análisis.

Unifica sus herramientas para eliminar la dispersión del contexto, la fragmentación que se produce cuando los equipos pierden horas cambiando de una aplicación a otra y buscando la información que necesitan para realizar su trabajo.

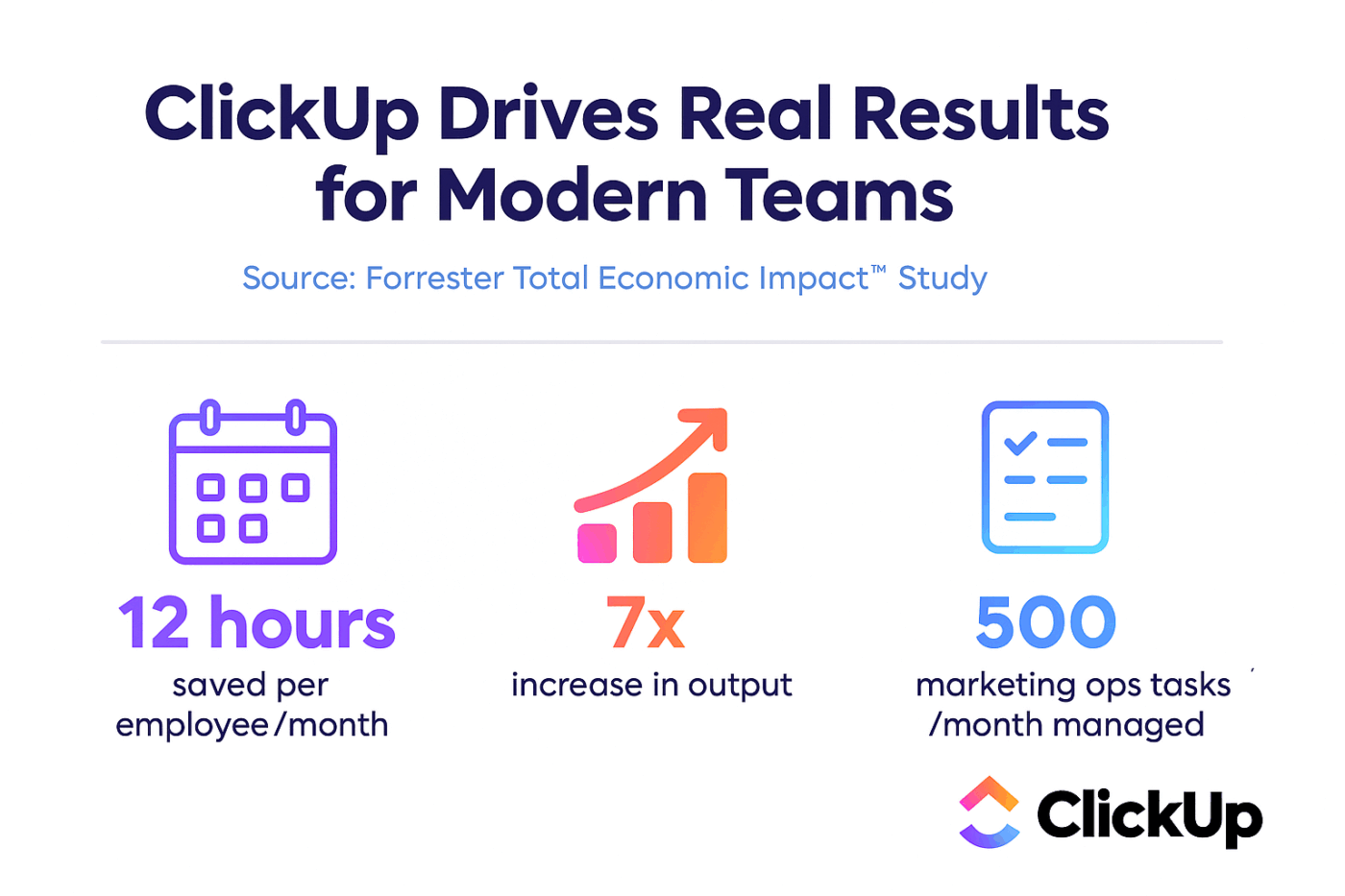

ClickUp + IA contextual = Transformación cuantificable

Según un estudio de Forrester Economic Impact™, los equipos que utilizaron ClickUp obtuvieron un retorno de la inversión del 384 % y ahorraron 92 400 horas en el tercer año.

Cuando el contexto, los flujos de trabajo y la inteligencia conviven en un mismo lugar, los equipos no solo realizan trabajo. Triunfan.

ClickUp también proporciona las capacidades de seguridad y administración que requieren las implementaciones empresariales, con cumplimiento SOC 2 Tipo II, integración SSO, aprovisionamiento SCIM y controles de permisos granulares.

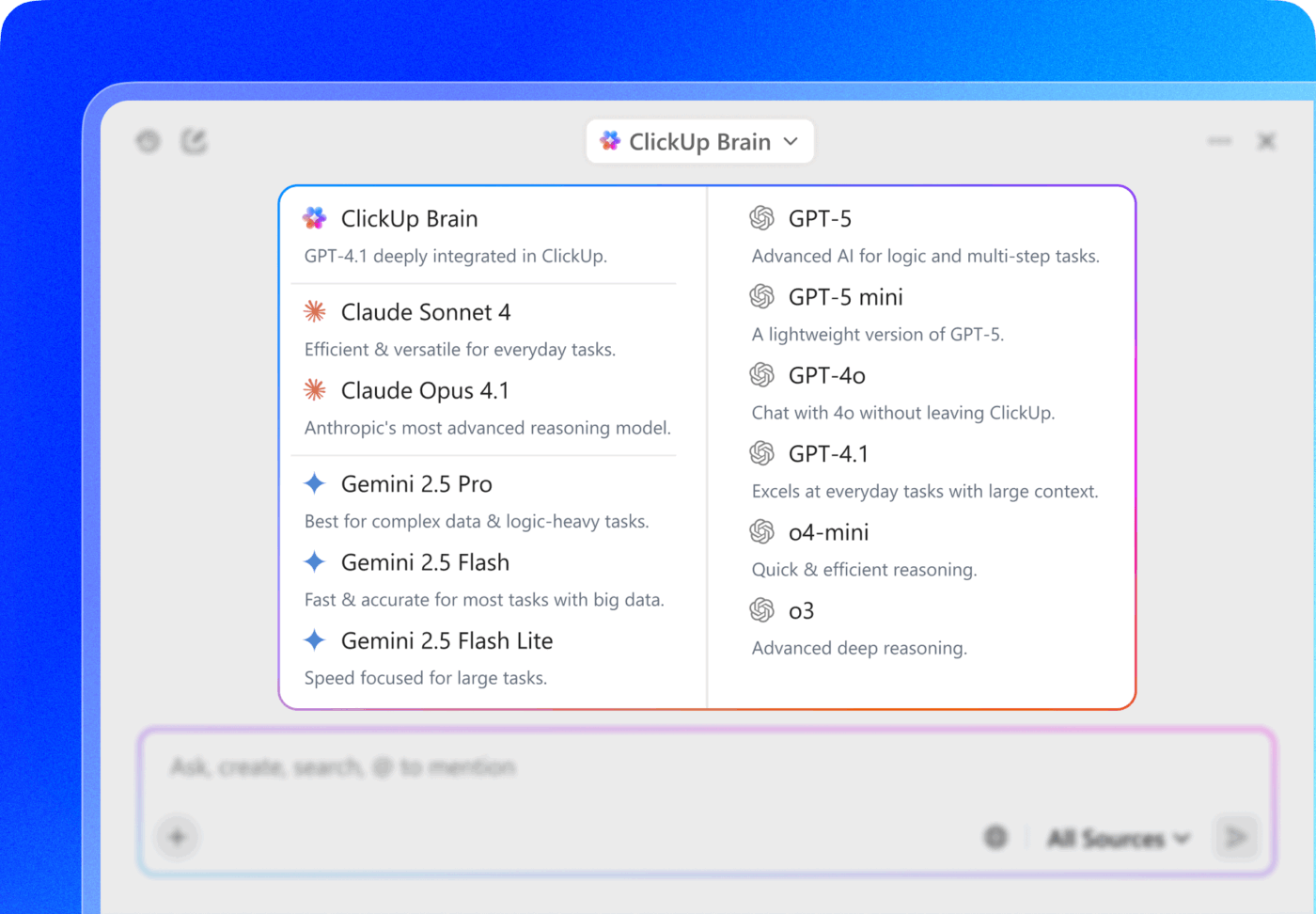

El acceso multi-LLM de ClickUp Brain MAX le permite elegir entre modelos premium como ChatGPT, Claude y Gemini directamente desde la interfaz de búsqueda. La plataforma dirige automáticamente su consulta al mejor modelo para la tarea, de modo que usted obtiene lo mejor de todos los mundos sin tener que gestionar múltiples suscripciones.

Obtenga todo lo que necesita (capacidades de IA, gestión de proyectos, documentación y comunicación) en un solo lugar con ClickUp, en lugar de crear la capa de IA desde cero con LLaMA.

Avance con la IA empresarial con ClickUp.

LLaMA ofrece a los equipos de corporación una alternativa abierta a las API de IA cerradas, lo que proporciona un control significativo, previsibilidad de costes y personalización. Pero el éxito depende de algo más que la tecnología. Requiere encontrar el modelo adecuado para cada caso de uso, invertir en datos de entrenamiento de alta calidad y crear procesos de evaluación sólidos.

La decisión entre «crear o comprar» depende en última instancia de la capacidad técnica de su equipo. Aunque crear una solución personalizada ofrece la máxima flexibilidad, también conlleva unos gastos generales considerables. El verdadero reto no es solo acceder a la IA, sino integrarla en sus flujos de trabajo diarios sin crear más dispersión de IA y silos de datos.

Incorpore las capacidades de LLM directamente en la gestión de proyectos, la documentación y la comunicación del equipo con ClickUp Brain, sin la complejidad de crear y mantener una infraestructura. Empiece a utilizar ClickUp de forma gratuita e incorpore las capacidades de IA directamente en sus flujos de trabajo existentes. 🙌

Preguntas frecuentes (FAQ)

Sí, la licencia comunitaria de Llama 3 permite el uso comercial para la mayoría de las organizaciones. Solo las empresas con más de 700 millones de usuarios activos mensuales necesitan obtener una licencia independiente de Meta.

LLaMA proporciona un mayor control de los datos y costes predecibles gracias al autoalojamiento, mientras que GPT-4 ofrece un mayor rendimiento inmediato con menos configuración. Sin embargo, para mejorar la productividad, obtenga asistencia de IA sin tener que gestionar los modelos subyacentes mediante herramientas integradas como ClickUp Brain.

El autoalojamiento de LLaMA mantiene los datos en su infraestructura, lo que es ideal para la residencia de datos. Sin embargo, usted es responsable de implementar sus propios controles de acceso, registros de auditoría y filtros de contenido, funciones de seguridad que suelen incluirse en los servicios de IA gestionados.

La implementación y el ajuste de LLaMA directamente requieren importantes conocimientos de ingeniería de aprendizaje automático. Los equipos que no cuentan con esta experiencia pueden acceder a las capacidades basadas en LLaMA a través de plataformas gestionadas como ClickUp Brain, que proporciona funciones de IA sin necesidad de implementar modelos ni realizar configuraciones técnicas.