O GitHub Copilot pode gerar centenas de casos de teste em minutos — com experimentos controlados mostrando que os desenvolvedores concluem 35% mais rápido —, mas há um porém: esses testes gerados por IA só são úteis na medida em que você consegue rastreá-los, organizá-los e conectá-los ao restante do seu fluxo de trabalho de desenvolvimento.

Este guia mostra como usar o GitHub Copilot para criar estruturas de casos de teste rapidamente e, em seguida, mostra como gerenciá-los de forma eficaz para que não se tornem apenas mais uma pilha de arquivos de código órfãos.

Por que os testes de unidade são importantes para a qualidade do software

Escrever testes de unidade é frequentemente visto como uma tarefa tediosa, mas ignorá-los leva a um código frágil.

Quando você não tem uma rede de segurança de testes, uma pequena refatoração pode introduzir defeitos de regressão — bugs que prejudicam a funcionalidade existente e minam a confiança do usuário. Uma pesquisa da IBM mostra que os defeitos descobertos após o lançamento custam 15 vezes mais para serem corrigidos.

Isso cria um ciclo em que os desenvolvedores evitam melhorar o código por medo de que algo dê errado, levando a um aumento da dívida técnica.

A geração de testes assistida por IA ajuda a quebrar esse ciclo, com 89% das organizações agora testando ou implantando fluxos de trabalho de IA generativa em engenharia de qualidade e testes. Ao usar uma ferramenta como o GitHub Copilot para criar casos de teste, você pode se concentrar no que importa: projetar testes significativos e refinar a cobertura de casos extremos.

Veja por que testes de unidade consistentes valem a pena:

- Prevenção de regressão: bons testes funcionam como uma barreira de proteção, garantindo que novos recursos ou correções de bugs não danifiquem acidentalmente outras partes do código.

- Documentação viva: ao contrário da documentação estática, que pode ficar desatualizada, os testes de unidade servem como exemplos executáveis de como seu código deve se comportar.

- Confiança na refatoração: quando você tem uma cobertura de teste abrangente, pode refatorar e melhorar sua base de código com a confiança de que saberá imediatamente se uma alteração tiver consequências indesejadas.

Para entender melhor como os agentes de IA estão transformando o cenário da codificação além da simples geração de testes, assista a esta visão geral dos assistentes de codificação com tecnologia de IA e seus recursos:

Como configurar o GitHub Copilot para geração de casos de teste

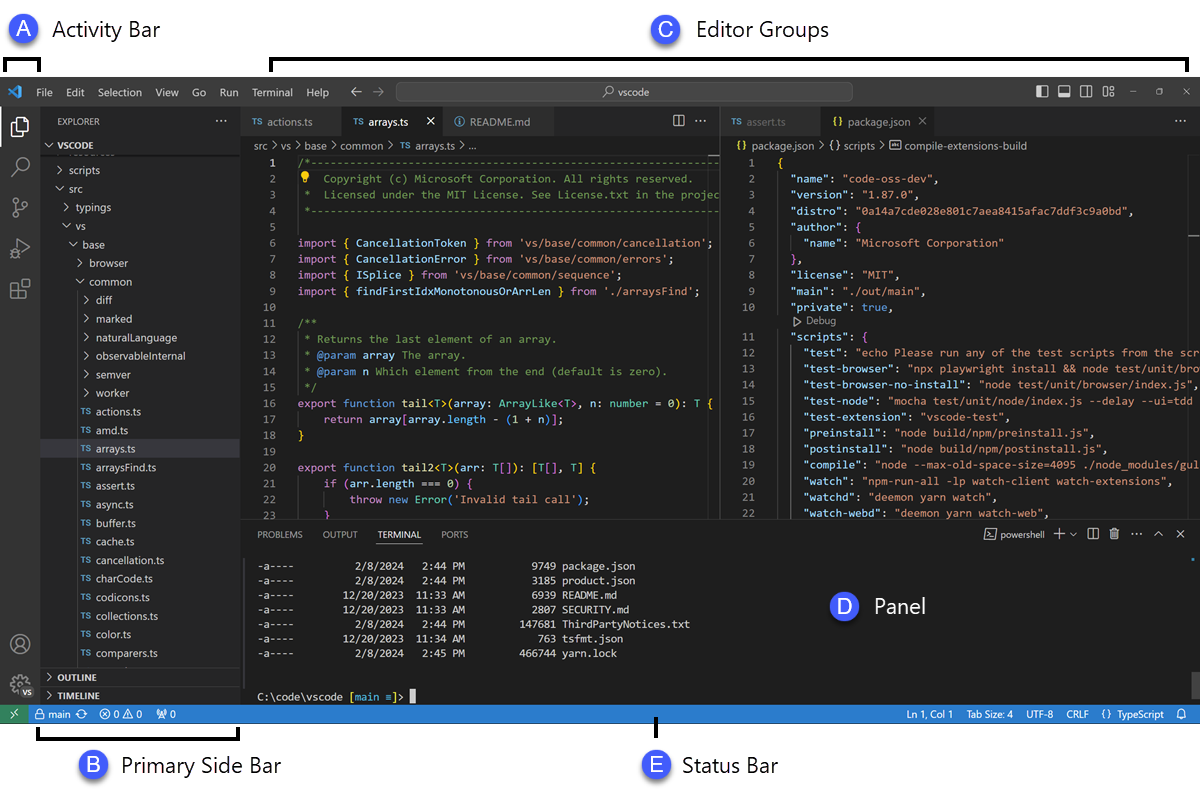

Antes de começar a gerar testes, você precisa instalar e configurar o GitHub Copilot em seu ambiente de desenvolvimento integrado (IDE). O processo de configuração é simples e leva apenas alguns minutos, mas fazê-lo corretamente garante que o Copilot tenha o contexto necessário para fornecer sugestões relevantes.

Você precisará de algumas coisas antes de começar:

- Uma assinatura ativa do GitHub Copilot (Individual, Business ou Enterprise)

- Um IDE compatível, como VS Code, um IDE JetBrains (como IntelliJ ou PyCharm) ou Neovim.

- Uma estrutura de testes como pytest, Jest ou JUnit já instalada em seu projeto

Instale a extensão GitHub Copilot

Primeiro, você precisa instalar a extensão Copilot em seu IDE. Esse processo é semelhante na maioria dos editores compatíveis.

- Abra a loja de extensões do seu IDE. No VS Code, esse é o ícone Extensões na barra lateral; nos IDEs da JetBrains, você o encontrará em Configurações → Plug-ins.

- Pesquise por “GitHub Copilot”.

- Instale a extensão principal do GitHub Copilot e a extensão GitHub Copilot Chat para ter uma experiência completa.

- Você será solicitado a reiniciar seu IDE para concluir a instalação.

Após reiniciar, você será solicitado a fazer login com sua conta GitHub. Essa etapa autentica sua assinatura. Depois de fazer login, você verá um pequeno ícone do Copilot na barra de status do seu IDE, confirmando que ele está ativo e pronto para uso.

Configure sua estrutura de testes

O GitHub Copilot gera testes mais relevantes quando compreende a configuração específica de testes do seu projeto. Ele faz isso analisando seus arquivos de teste e configuração existentes para aprender e corresponder aos padrões da sua equipe.

- Para projetos Python que usam pytest: Certifique-se de ter o pytest instalado (pip install pytest). Se você tiver um arquivo conftest.py ou qualquer arquivo de teste existente (mesmo que seja apenas um), o Copilot os usará como referência para gerar novos testes.

- Para projetos JavaScript/TypeScript que utilizam Jest: o Copilot procurará um arquivo jest.config.js e sua dependência Jest em seu package.json para entender sua configuração.

- Para projetos Java que utilizam JUnit: Certifique-se de que suas dependências JUnit estejam corretamente definidas em seu arquivo pom.xml (para Maven) ou build.gradle (para Gradle).

Ter pelo menos um arquivo de teste bem escrito em seu projeto é uma das melhores maneiras de orientar o Copilot. Ele aprenderá suas convenções de nomenclatura, estilos de afirmação e como você estrutura seus testes, levando a resultados mais consistentes.

Integre o Copilot ao seu IDE

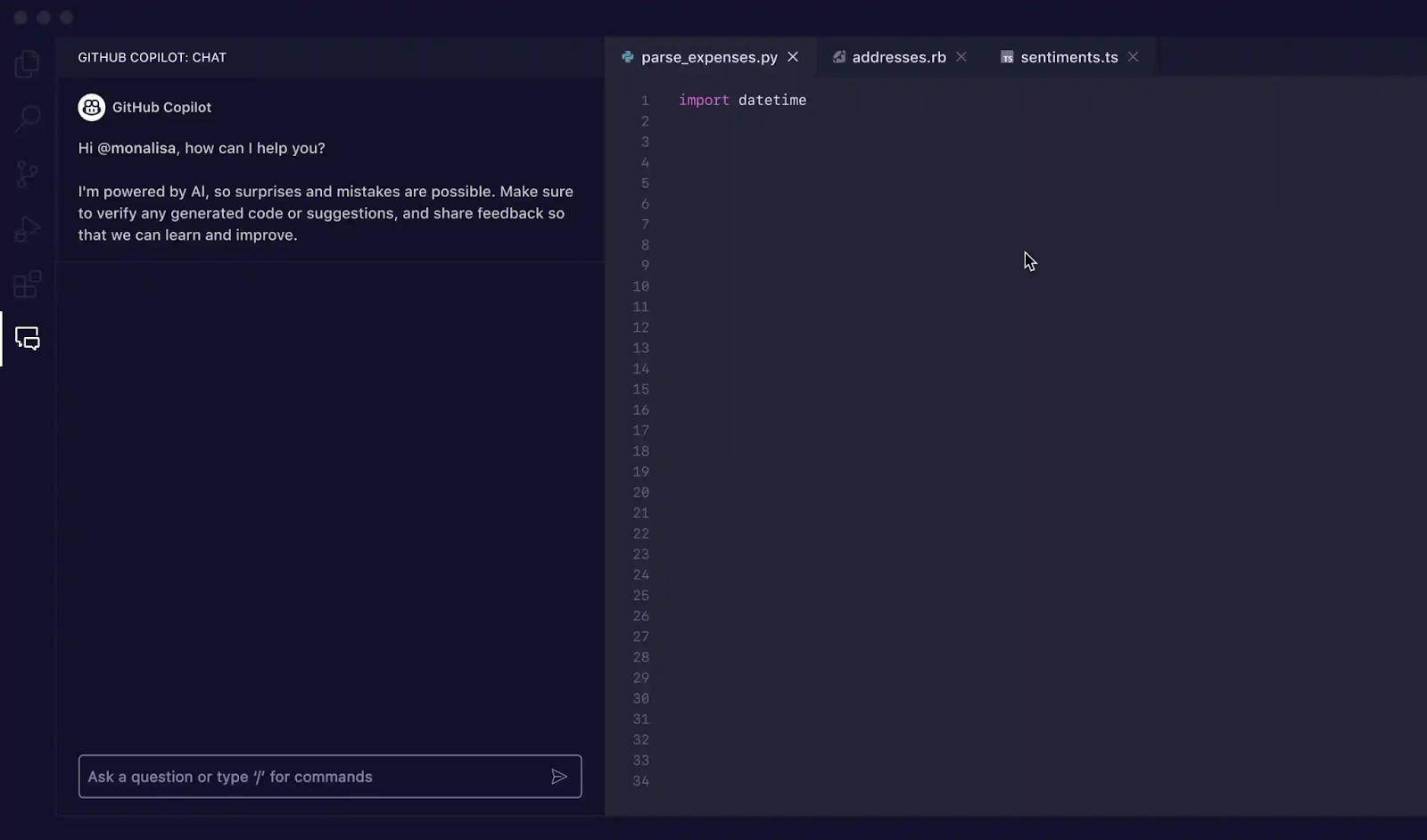

Com as extensões instaladas, é hora de se familiarizar com a interface do Copilot no seu IDE. A principal forma de interagir com ele para a geração de testes é através do painel Copilot Chat.

Você pode abrir a janela de bate-papo com o atalho de teclado Ctrl+Cmd+I (no Mac) ou Ctrl+Alt+I (no Windows/Linux) ou clicando no ícone Copilot Chat na barra de atividades do seu IDE. Esse painel de bate-papo é o seu centro de comando para gerar testes.

O Copilot é sensível ao contexto, o que significa que ele lê os arquivos abertos no momento, a estrutura de arquivos do seu projeto e qualquer código que você tenha selecionado. Para obter os melhores resultados, mantenha sempre o arquivo que contém a função ou classe que você deseja testar aberto e visível no seu editor.

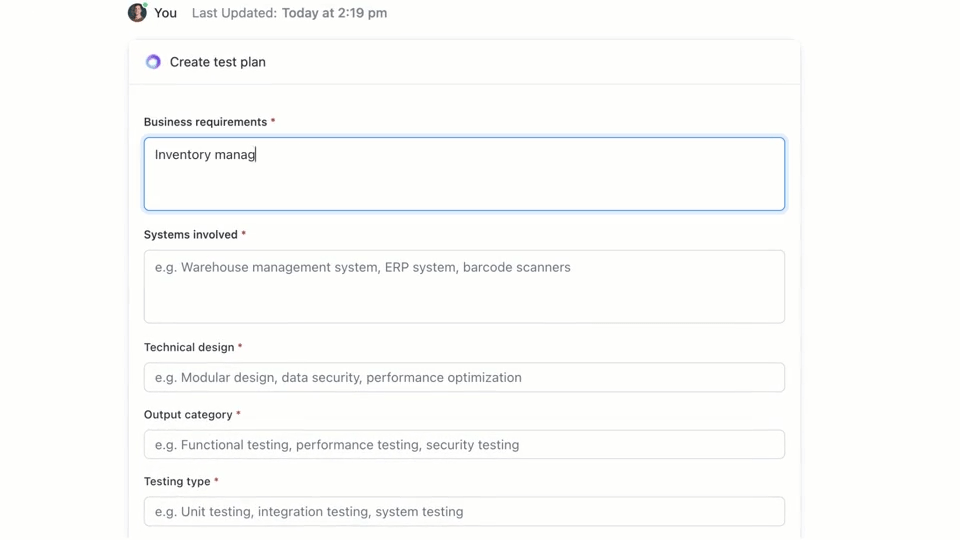

🌟 O ClickUp Brain, a IA contextual integrada ao ClickUp, pode criar rapidamente um plano de teste para você. Experimente hoje mesmo.

Como escrever casos de teste com o GitHub Copilot

O GitHub Copilot oferece três maneiras principais de gerar casos de teste: usando o painel de bate-papo com prompts detalhados, usando comandos rápidos de barra e usando ações inteligentes diretamente no seu editor. Cada método é adequado para diferentes situações dentro do seu fluxo de trabalho de desenvolvimento, dependendo se você precisa de velocidade ou controle refinado.

Use os prompts do Copilot Chat

Usar o Copilot Chat com um prompt específico é o método mais poderoso para a geração de casos de teste. É ideal para funções ou classes complexas em que você precisa definir cenários específicos, simular dependências ou lidar com casos extremos complicados.

Aqui está o fluxo de trabalho básico:

- Abra o painel Copilot Chat.

- No seu editor, destaque a função, classe ou bloco de código que deseja testar.

- Escreva uma mensagem clara e específica no painel de bate-papo descrevendo os testes de que você precisa.

Por exemplo, você pode escrever prompts como:

- “Escreva testes de unidade para a função selecionada, cobrindo o caminho feliz, casos extremos como entradas vazias e tratamento de erros para dados inválidos”.

- “Gere testes pytest para esta classe e crie fixtures para simular a conexão com o banco de dados”

- “Crie testes Jest para este componente React que simulam cliques do usuário e verificam as alterações de estado”

Quanto mais detalhes você fornecer no prompt, melhores serão os testes gerados.

Use comandos de barra, como /tests.

Quando você precisa gerar testes rapidamente e não requer cenários altamente específicos, o comando /tests é o seu melhor amigo. É a maneira mais rápida de obter uma base sólida de cobertura de teste.

Para usá-lo:

- Abra o painel Copilot Chat.

- Selecione o código que deseja testar no seu editor.

- Na caixa de bate-papo, basta digitar /tests e pressionar Enter.

O Copilot irá gerar imediatamente um conjunto de testes unitários com base na estrutura e na lógica do código selecionado. Ele tentará cobrir a funcionalidade principal e algumas entradas comuns. Se os resultados não estiverem corretos, você sempre poderá refiná-los com um prompt de acompanhamento como: “Agora adicione um teste para quando a entrada for nula”.

Use ações inteligentes do editor

Para momentos em que você deseja gerar testes sem interromper seu fluxo, você pode usar ações inteligentes diretamente do seu editor de código. Isso evita que você precise alternar para o painel de bate-papo.

- Destaque a função ou classe que você deseja testar.

- Clique com o botão direito do mouse na seleção para abrir o menu de contexto.

- Navegue até Gerar código no menu de contexto e selecione Gerar testes.

O Copilot irá gerar os testes e, normalmente, mostrá-los em uma nova guia temporária do editor. Você pode revisar o código lá e, em seguida, optar por criar um novo arquivo de teste ou anexar os testes a um já existente.

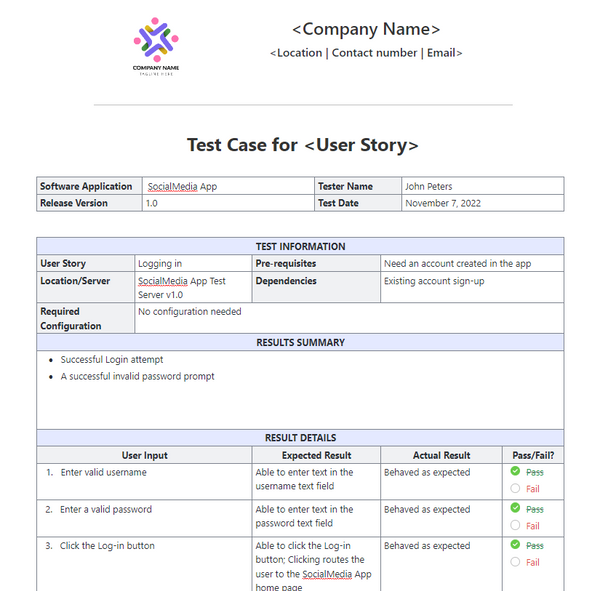

📚 Leia também: Modelos de casos de teste para testes de software

Prompts do GitHub Copilot para geração de casos de teste

Suas instruções são o volante do GitHub Copilot. Instruções genéricas levam a testes genéricos, mas instruções bem elaboradas que dão instruções específicas à IA resultam em casos de teste abrangentes e úteis. O segredo é dizer ao Copilot não apenas o que testar, mas como testar.

Aqui estão alguns modelos que você pode adaptar para diferentes cenários:

| Cenário | Modelo de prompt |

|---|---|

| Teste de unidade básico | “Escreva testes de unidade para a função [nome_da_função] usando [framework]. Certifique-se de cobrir entradas normais, valores limite como zero ou números negativos e entradas inválidas como nulo ou indefinido.” |

| Classe com dependências | “Gere testes para a classe [ClassName]. Use [mocking_library] para criar simulações para as dependências [DependencyName] e [AnotherDependencyName].” |

| Funções assíncronas | “Crie testes para esta função assíncrona. Inclua testes para o caso de sucesso, um caso em que a promessa é rejeitada e um cenário para tempos limite de solicitação.” |

| Ponto final da API | “Escreva testes de integração para este endpoint da API. Cubra uma solicitação GET bem-sucedida, uma solicitação POST com dados válidos, uma solicitação com um token de autenticação ausente e uma solicitação com dados inválidos que deve retornar um erro 400.” |

| Validação de dados | “Gere testes para esta função de validação. Inclua um teste para um objeto válido e, em seguida, adicione testes separados para cada falha na regra de validação para garantir que as mensagens de erro corretas sejam retornadas.” |

Dicas para aprimorar prompts:

- Seja explícito sobre a estrutura: sempre mencione a estrutura de teste (por exemplo, pytest, Jest, JUnit) para garantir que a sintaxe esteja correta.

- Defina suas metas de cobertura: use técnicas avançadas de prompt de IA para solicitar tipos específicos de cobertura, como “casos extremos”, “tratamento de erros” ou “testes de limite”.

- Consulte seus próprios padrões: se você tiver um bom arquivo de exemplo, pode instruir o Copilot a “seguir o padrão de teste em tests/test_user.py”.

- Solicite afirmações específicas: em vez de deixar o Copilot adivinhar, você pode pedir que ele “afirme que um ValueError é gerado para entradas inválidas”.

Exemplos de geração de testes com o GitHub Copilot

Veja como isso funciona na prática.

Gere testes de unidade em Python

Imagine que você tem uma função Python que calcula o preço total dos itens em um carrinho de compras, incluindo um desconto.

Função de amostra para teste:

Prompt usado: “Escreva testes pytest para calculate_total. Cubra uma lista vazia de itens, um único item, vários itens, aplicando um desconto, um desconto de 0%, um desconto de 100% e uma porcentagem de desconto inválida que deve gerar um ValueError. ”

Resultado do teste gerado:

O Copilot usou corretamente o pytest. raises para verificar a exceção e cobriu os principais cenários. Você ainda pode querer adicionar testes para preços ou quantidades negativas como um refinamento manual.

Gere testes de unidade em TypeScript com o Jest.

Agora, vamos experimentar uma função TypeScript que formata o nome de um usuário.

Função de exemplo para testar:

Prompt usado: “Gere testes Jest para formatDisplayName. Abranja um usuário com nome e sobrenome, um usuário com apelido, um usuário com nome vazio e um usuário apenas com apelido.”

Resultado do teste gerado:

Os testes gerados usam os blocos padrão describe e it do Jest e lidam corretamente com os diferentes caminhos lógicos.

Práticas recomendadas para geração de testes com o GitHub Copilot

Usar o Copilot para geração de testes é um grande aumento de produtividade, mas requer supervisão cuidadosa para garantir a qualidade.

- Revise cada teste: essa é a regra de ouro. O Copilot não entende sua lógica de negócios, então pode gerar um teste que seja aprovado, mas que afirme algo errado. Sempre leia o código gerado e pergunte: “Isso realmente verifica o comportamento correto?”

- Verifique manualmente a cobertura de casos extremos: o Copilot é bom em detectar casos extremos comuns, como entradas nulas ou strings vazias, mas pode deixar passar casos específicos do domínio. Para um aplicativo de comércio eletrônico, ele testou o que acontece quando o total do carrinho é exatamente o mínimo para frete grátis? Você ainda é o especialista.

- Mantenha convenções de nomenclatura consistentes: os nomes de testes gerados por IA podem, às vezes, ser genéricos. Reserve um momento para renomeá-los de acordo com o estilo da sua equipe. Um nome descritivo como test_login_fails_with_incorrect_password é muito mais útil do que test_login_2.

- Execute os testes imediatamente: não deixe os testes gerados sem serem executados. Execute-os imediatamente para detectar erros de sintaxe ou asserções obviamente falhas antes de confirmar o código.

- Integre com CI/CD: adicione testes gerados ao seu pipeline de integração contínua. Testes que só são executados localmente oferecem valor limitado.

- Cuidado com testes instáveis: às vezes, a IA pode gerar testes que são “instáveis” — eles são aprovados em algumas ocasiões e reprovados em outras. Isso geralmente acontece com testes que envolvem carimbos de data/hora ou dados aleatórios. Sempre substitua esses dados por valores determinísticos e previsíveis.

📮ClickUp Insight: Nossas pesquisas mostram que, enquanto 34% dos usuários operam com total confiança nos sistemas de IA, um grupo ligeiramente maior (38%) mantém uma abordagem de “confiar, mas verificar”. Uma ferramenta independente que não está familiarizada com o seu contexto de trabalho geralmente apresenta um risco maior de gerar respostas imprecisas ou insatisfatórias.

É por isso que criamos o ClickUp Brain, a IA que conecta seu gerenciamento de projetos, gerenciamento de conhecimento e colaboração em todo o seu espaço de trabalho e ferramentas integradas de terceiros. Obtenha respostas contextuais sem o custo adicional e experimente um aumento de 2 a 3 vezes na eficiência do trabalho, assim como nossos clientes da Seequent.

Limitações do uso do GitHub Copilot para geração de casos de teste

Embora o GitHub Copilot seja um grande impulsionador da produtividade, ele não é uma solução milagrosa para testes de software. Conhecer suas limitações é fundamental para usá-lo de forma eficaz e evitar armadilhas comuns. Ele é um “copiloto”, não o piloto — você ainda é responsável pelo plano de voo.

A maior limitação é a falta de contexto comercial. O Copilot analisa a estrutura do seu código, mas não tem ideia do que seu aplicativo realmente deve fazer para seus usuários. Ele não pode saber que um usuário “premium” deve ter acesso a determinados recursos, enquanto um usuário “básico” não deve, a menos que essa lógica esteja explicitamente clara no código que está lendo.

Aqui estão algumas outras restrições importantes a serem lembradas:

- Ele pode deixar passar casos extremos críticos específicos do domínio: o Copilot é ótimo para encontrar casos extremos gerais, mas não conhece os casos estranhos específicos do seu setor, como um cálculo financeiro que precisa lidar com anos bissextos de maneira diferente.

- Não tem acesso a sistemas externos: o Copilot não pode gerar testes de integração significativos para seu banco de dados ou API de terceiros porque não consegue se conectar a eles. Ele pode criar o código, mas você precisará preencher os detalhes.

- Pode dar uma falsa sensação de confiança: ver 100% de cobertura de teste pode ser ótimo, mas se os testes estiverem afirmando coisas erradas, esse número de cobertura não tem sentido. É por isso que a revisão humana é tão importante.

- Limites da janela de contexto: arquivos muito grandes ou hierarquias de classes complexas podem exceder a janela de contexto do Copilot, resultando em sugestões incompletas ou genéricas.

📚 Leia também: Como usar o GitHub Copilot para desenvolvimento de back-end

Como criar e gerenciar casos de teste no ClickUp

Gerar casos de teste com o GitHub Copilot é apenas metade do fluxo de trabalho. Depois que os testes são criados, as equipes ainda precisam acompanhá-los, vinculá-los aos requisitos e gerenciar a execução em sprints e lançamentos.

O ClickUp oferece um espaço de trabalho centralizado onde casos de teste gerados por IA podem coexistir com tarefas de desenvolvimento, bugs e planos de sprint — para que os testes não fiquem presos em IDEs individuais.

O ClickUp atua como um espaço de trabalho de IA convergente, reunindo gerenciamento de projetos, documentação e comunicação da equipe em um único sistema. Para equipes de software, isso significa que o gerenciamento de casos de teste não é mais uma ferramenta ou planilha separada.

Testes, requisitos, solicitações de pull e discussões sobre lançamentos permanecem conectados, reduzindo a dispersão do contexto e tornando o controle de qualidade uma parte essencial do fluxo de trabalho de entrega.

O modelo de caso de teste do ClickUp foi projetado para ajudá-lo a acompanhar o progresso dos casos de teste. Ele facilita:

- Analise os resultados dos testes e tome decisões baseadas em dados sobre correções de bugs.

- Desenvolva planos de teste personalizados para cada projeto.

- Organize e priorize casos de teste para obter a máxima eficiência.

Comece criando uma lista dedicada no ClickUp para servir como seu repositório de casos de teste. Cada caso de teste, seja ele gerado por IA ou escrito manualmente, se torna uma tarefa.

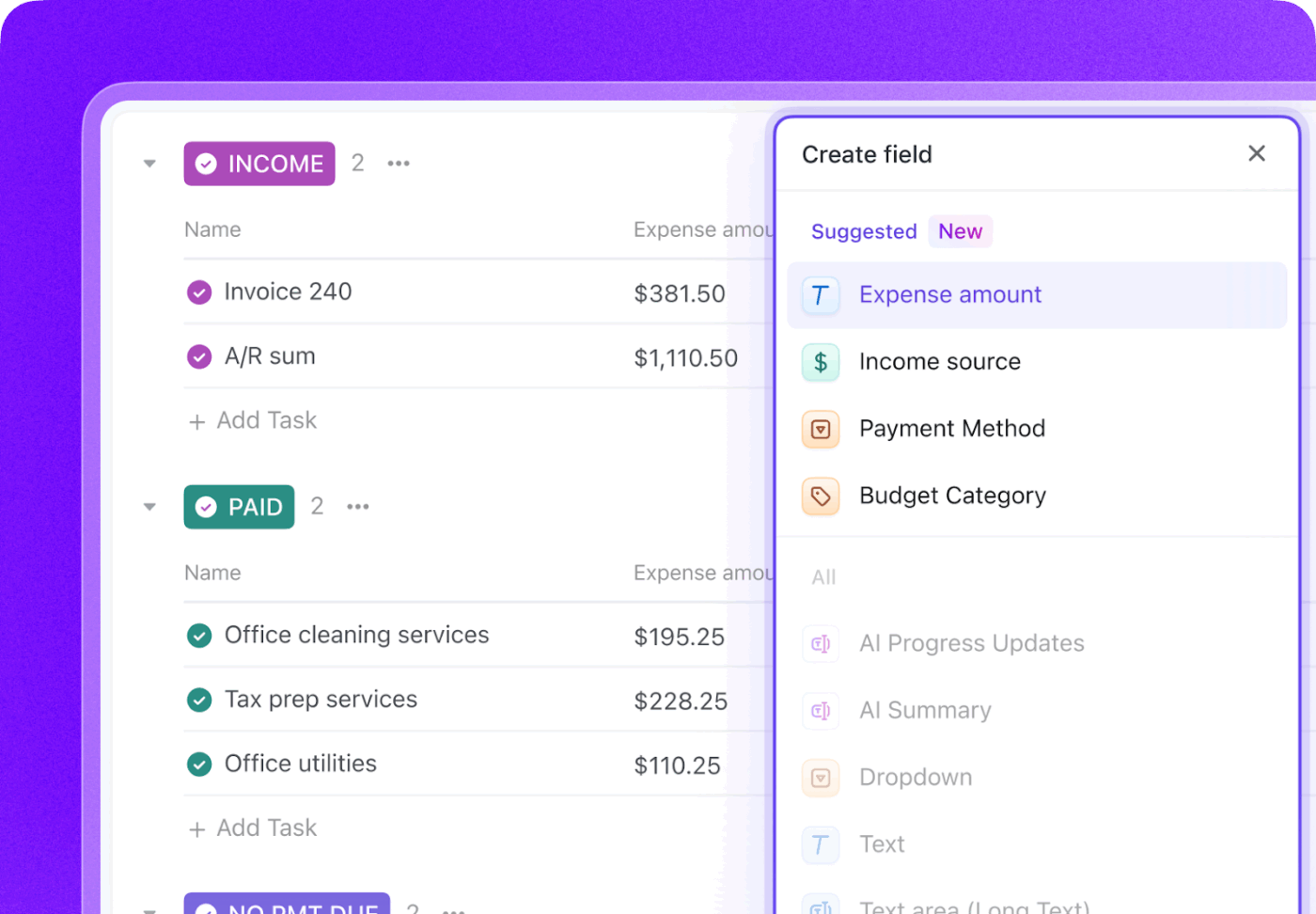

Enriqueça cada caso de teste com metadados cruciais usando os campos personalizados do ClickUp para acompanhar exatamente o que é importante para sua equipe.

- Tipo de teste: menu suspenso para unidade, integração, ponta a ponta ou manual

- Status da automação: um status para mostrar se o teste é automatizado ou não automatizado.

- Prioridade: Alta, Média ou Baixa

- Data da última execução: um campo de data para acompanhar quando o teste foi executado pela última vez.

Acompanhe todo o ciclo de vida dos testes com os status personalizados do ClickUp, criando um fluxo de trabalho que move os testes de Não executado para Aprovado, Reprovado ou Bloqueado. Isso dá a todos na equipe, de desenvolvedores a gerentes de produto, visibilidade instantânea do andamento da execução dos testes.

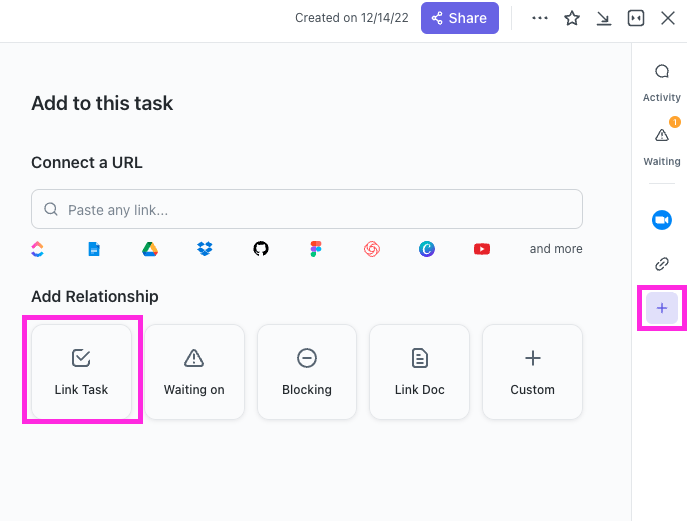

Com o ClickUp Relationships, as tarefas de casos de teste podem ser vinculadas diretamente a histórias de usuários, recursos ou épicos. Se um teste falhar, você pode criar uma tarefa de relatório de bug e vinculá-la ao teste com falha e à história original, criando uma cadeia completa de rastreabilidade.

Elabore relatórios de bugs em segundos, apontando o ClickUp Brain para uma tarefa de caso de teste com falha. Como ele tem o contexto de todo o seu espaço de trabalho, pode extrair detalhes da história do usuário vinculada e do próprio caso de teste.

🌟 O modelo de relatório de teste do ClickUp permite criar relatórios mais rapidamente, garantindo que você identifique e resolva os problemas que precisam ser melhorados.

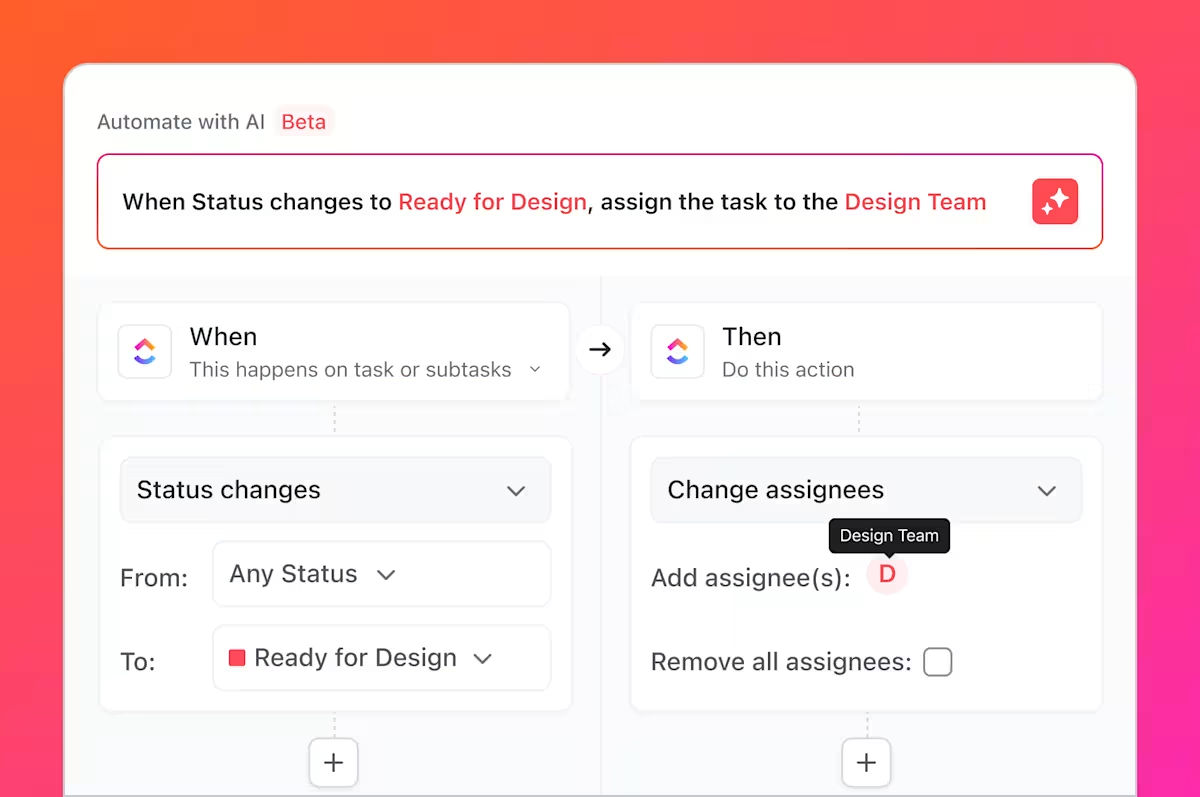

Mas isso não é tudo o que você pode fazer. Você sabe todas as tarefas repetitivas e enfadonhas de que falamos, que sempre envolvem os testes? Você pode automatizá-las usando o ClickUp Automations.

Configure regras como “Quando o status de um caso de teste for alterado para Falha, crie automaticamente uma nova tarefa na Lista de Bugs e atribua-a ao desenvolvedor líder”.

Ao integrar o GitHub com o ClickUp, as tarefas de casos de teste podem ser vinculadas a commits e pull requests. Quando as alterações no código são mescladas, as tarefas de teste relacionadas são atualizadas automaticamente, mantendo o controle de qualidade, os desenvolvedores e os gerentes de lançamento alinhados sobre o que foi alterado e o que precisa ser testado novamente.

Os painéis do ClickUp permitem que você acompanhe o progresso dos testes em tempo real, visualize a contagem de bugs, a execução de casos de teste e muito mais.

Juntos, esse fluxo de trabalho preenche a lacuna entre os testes gerados por IA no GitHub Copilot e o gerenciamento de casos de teste em toda a equipe no ClickUp, oferecendo às equipes um único sistema para planejar, acompanhar, automatizar e melhorar seu processo de controle de qualidade sem a necessidade de coordenação manual constante.

Assista a este vídeo para obter dicas sobre como criar um fluxo de trabalho eficiente para gerenciamento de lançamentos:

Simplifique o gerenciamento de casos de teste com o ClickUp

Os testes gerados por IA não são mais artefatos isolados; eles são componentes integrados do seu processo de desenvolvimento, visíveis, rastreáveis e acionáveis para toda a equipe.

O GitHub Copilot gera casos de teste rapidamente, mas a velocidade por si só não garante a qualidade. Sem propriedade clara, rastreabilidade de requisitos e visibilidade entre sprints, mesmo testes bem escritos podem se tornar obsoletos ou serem ignorados. É aí que um sistema de registro se torna importante.

Ao gerenciar casos de teste no ClickUp, as equipes transformam os resultados gerados por IA em um fluxo de trabalho de controle de qualidade repetível, que conecta os testes aos requisitos, às alterações de código e aos cronogramas de lançamento. Em vez de lidar com várias ferramentas e atualizações manuais, as equipes de controle de qualidade e engenharia trabalham em um espaço de trabalho compartilhado e contextual. O resultado não é apenas mais testes, mas também mais confiança no que está sendo entregue e por quê.

Pronto para gerenciar seus casos de teste junto com seus sprints e lançamentos? Comece hoje mesmo gratuitamente com o ClickUp.

Perguntas frequentes

Sim, o Copilot pode analisar a estrutura e a lógica do código legado para gerar uma linha de base de testes. No entanto, esses testes provavelmente exigirão uma revisão e um refinamento manuais significativos, pois a IA não terá contexto sobre comportamentos não documentados ou regras de negócios históricas.

A precisão sintática é muito alta, mas a precisão lógica depende da clareza do seu código e da especificidade das suas instruções. Sempre revise as afirmações para garantir que elas estejam verificando requisitos comerciais significativos, e não apenas confirmando a implementação atual (e possivelmente falha).

Sim, o Copilot oferece excelente suporte para pytest, unittest e outras estruturas de teste populares do Python. Ele é hábil em reconhecer e replicar padrões existentes em seu projeto, como o uso de fixtures ou testes parametrizados.

Equipes eficazes usam uma plataforma centralizada de gerenciamento de projetos para gerenciar seus conjuntos de testes. Ao acompanhar cada caso de teste como uma tarefa com metadados personalizados para status e prioridade, elas ganham visibilidade sobre a cobertura e os resultados da execução, conectando o processo de controle de qualidade diretamente ao planejamento de sprints e ao rastreamento de bugs.