À medida que os LLMs se tornam mais poderosos, o prompt deixa de ser a parte difícil. O contexto passa a ser a restrição.

A engenharia de contexto consiste em fornecer as informações certas no formato certo aos LLMs (grandes modelos de linguagem).

O que torna a engenharia de contexto difícil?

Você precisa projetar cada camada da pilha para capturar o contexto e torná-lo disponível. Se você enviar muito pouco contexto, os LLMs não saberão o que fazer. Se enviar muito contexto, você ficará sem tokens. Então, como encontrar o equilíbrio?

Abaixo, compartilhamos tudo o que você precisa saber sobre engenharia de contexto.

O que é engenharia de contexto de IA?

A engenharia de contexto de IA é o processo de projetar e otimizar instruções e contexto relevante para que os LLMs e modelos avançados de IA e multimodais realizem suas tarefas com eficácia.

Isso vai além da redação de prompts. A engenharia de contexto determina:

- Que informações são exibidas

- De onde ele vem (memória, ferramentas, bancos de dados, documentos)

- Como ele é formatado (esquemas, resumos, restrições)

- Quando ele é injetado no ciclo de raciocínio do modelo

🌟 O objetivo: otimizar as informações que você está fornecendo na janela de contexto do LLM e filtrar as informações ruidosas.

Como o contexto melhora as respostas da IA?

Sem contexto, um LLM prevê a continuação do texto mais provável estatisticamente. Por outro lado, uma boa engenharia de contexto melhora os resultados ao:

- Raciocínio de ancoragem: o modelo baseia suas respostas em fatos conhecidos, em vez de suposições estatísticas.

- Reduzindo alucinações: restrições claras e dados relevantes estreitam o espaço de soluções.

- Melhorando a consistência: entradas semelhantes geram saídas semelhantes porque a forma do contexto é estável.

- Reduzindo custos e latência: o contexto direcionado é melhor do que despejar documentos ou históricos inteiros.

Resumindo nas palavras de Tobi Lutke, CEO da Shopify:

Gosto muito mais do termo engenharia de contexto do que engenharia de prompt. Ele descreve melhor a habilidade essencial: a arte de fornecer todo o contexto para que a tarefa seja plausivelmente solucionável pelo LLM.

Gosto muito mais do termo engenharia de contexto do que engenharia de prompt. Ele descreve melhor a habilidade essencial: a arte de fornecer todo o contexto para que a tarefa seja plausivelmente solucionável pelo LLM.

O papel da engenharia de contexto em fluxos de trabalho orientados por IA

Em fluxos de trabalho orientados por IA, os LLMs não são ferramentas independentes. Eles operam dentro de sistemas que já possuem dados, regras e estado.

A engenharia de contexto permite que o modelo entenda onde está no fluxo de trabalho e o que pode fazer a seguir.

Quando o modelo está ciente do estado atual, das ações passadas e das entradas ausentes, ele pode recomendar ou executar o próximo passo correto, em vez de gerar conselhos genéricos.

Isso também significa fornecer explicitamente a lógica de negócios, como regras de aprovação, restrições de conformidade e caminhos de escalonamento. Quando esses elementos fazem parte do contexto, as decisões da IA permanecem alinhadas com a realidade operacional.

Por fim, a engenharia de contexto permite fluxos de trabalho com várias etapas e agentes, garantindo transferências claras de estado e decisões em cada etapa.

Isso evita que os erros se acumulem à medida que os fluxos de trabalho aumentam, melhorando assim a eficácia do contexto.

👀 Você sabia? 95% das implementações de GenAI nas empresas falham, não porque os modelos sejam fracos, mas porque as organizações não conseguem integrar a IA aos fluxos de trabalho reais.

Ferramentas genéricas de IA, como o ChatGPT, funcionam bem para indivíduos, mas falham em grande escala porque não aprendem com o contexto do sistema, as regras de negócios ou o estado em evolução. Em outras palavras, a maioria das falhas de IA são falhas de integração e contexto, não falhas de modelo.

📮ClickUp Insight: 62% dos nossos entrevistados confiam em ferramentas de IA conversacional, como ChatGPT e Claude. Sua interface familiar de chatbot e habilidades versáteis — para gerar conteúdo, analisar dados e muito mais — podem ser a razão pela qual são tão populares em diversas funções e setores. No entanto, se um usuário tiver que alternar para outra guia para fazer uma pergunta à IA todas as vezes, os custos associados à alternância e à mudança de contexto se acumulam com o tempo. Mas não com o ClickUp Brain. Ele fica bem no seu espaço de trabalho, sabe no que você está trabalhando, entende prompts de texto simples e fornece respostas altamente relevantes para suas tarefas! Experimente uma melhoria de 2x na produtividade com o ClickUp!

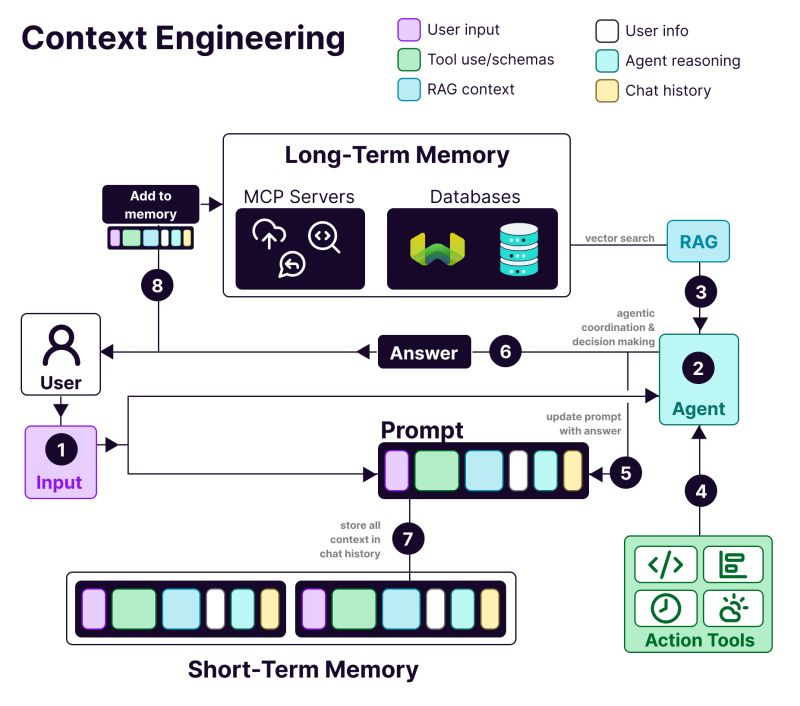

Como funciona a engenharia de contexto?

A engenharia de contexto funciona moldando progressivamente as informações antes que elas cheguem ao modelo.

A anatomia de um sistema com engenharia de contexto inclui:

- 𝗨𝘀𝗲𝗿 i𝗻𝗳𝗼𝗿𝗺𝗮𝘁𝗶𝗼𝗻: preferências, histórico e dados de personalização

- T𝗼𝗼𝗹 u𝘀𝗲: APIs, calculadoras, mecanismos de pesquisa — tudo o que o LLM precisa para realizar o trabalho.

- 𝗥𝗔𝗚 c𝗼𝗻𝘁𝗲𝘅𝘁: Informações recuperadas de bancos de dados vetoriais como o Weaviate

- 𝗨𝘀𝗲𝗿 i𝗻𝗽𝘂𝘁: A consulta ou tarefa real em questão

- 𝗔𝗴𝗲𝗻𝘁 r𝗲𝗮𝘀𝗼𝗻𝗶𝗻𝗴: O processo de pensamento e a cadeia de tomada de decisões do LLM

- 𝗖𝗵𝗮𝘁 h𝗶𝘀𝘁𝗼𝗿𝘆: Interações anteriores que proporcionam continuidade

Benefícios da engenharia de contexto em sistemas de IA

Veja por que você precisa de engenharia de contexto ao criar aplicativos de IA:

Resultados mais precisos

Fornecer um contexto relevante para a decisão reduz a ambiguidade. O modelo raciocina com base em fatos, restrições e estados conhecidos, em vez de se basear em suposições probabilísticas.

Comportamento consistente em escala

Estruturas de contexto estáveis produzem resultados repetíveis. Entradas semelhantes levam a decisões semelhantes, o que é essencial para fluxos de trabalho de produção.

Custo e latência reduzidos

Um contexto direcionado e compactado evita o desperdício de tokens. Os sistemas respondem mais rapidamente sem carregar repetidamente históricos ou documentos completos.

Automação mais segura

O contexto codifica regras de negócios e permissões. Isso permite que a IA atue sem violar políticas ou desencadear ações arriscadas.

Fluxos de trabalho melhores em várias etapas

Transferências de contexto limpas preservam o estado entre as etapas. Os erros não se acumulam à medida que os fluxos de trabalho se tornam mais complexos ou agenticos.

Depuração e iteração mais fáceis

O contexto estruturado torna as falhas visíveis. Você pode rastrear erros até entradas ausentes, obsoletas ou mal classificadas, em vez de culpar o modelo.

Maior adoção pelas empresas

Os sistemas de IA que respeitam o contexto do fluxo de trabalho parecem confiáveis — uma diferença crítica entre pilotos e ferramentas para adoção em toda a empresa.

👀 Você sabia? A IA sensível ao contexto afeta diretamente a produtividade. Um estudo do Boston Consulting Group descobriu que apenas as equipes de comunicação podem recuperar 26 a 36% do seu tempo hoje com a IA generativa e, com fluxos de trabalho redesenhados e sistemas agênicos que entendem o contexto, os ganhos de produtividade podem chegar a 50%.

Engenharia de contexto de IA vs. Engenharia de prompt

Engenharia de prompt: peça ao ChatGPT para escrever um e-mail anunciando um novo recurso. Você está escrevendo instruções para uma única tarefa.

Engenharia de contexto: você está criando um bot de atendimento ao cliente. Ele precisa lembrar tickets anteriores, acessar detalhes da conta do usuário e manter o histórico de conversas.

Conforme explicado pelo pesquisador de IA Andrej Karpathy:

As pessoas associam prompts a descrições curtas de tarefas que você daria a um LLM no uso diário. Em todos os aplicativos LLM de nível industrial, a engenharia de contexto é a delicada arte e ciência de preencher a janela de contexto com as informações certas para a próxima etapa.

As pessoas associam prompts a descrições curtas de tarefas que você daria a um LLM no uso diário. Em todos os aplicativos LLM de nível industrial, a engenharia de contexto é a delicada arte e ciência de preencher a janela de contexto com as informações certas para a próxima etapa.

+1 para “engenharia de contexto” em vez de “engenharia de prompt”.

As pessoas associam prompts a descrições curtas de tarefas que você daria a um LLM no uso diário. Em todos os aplicativos LLM de nível industrial, a engenharia de contexto é a delicada arte e ciência de preencher a janela de contexto... https://t.co/Ne65F6vFcf

— Andrej Karpathy (@karpathy) 25 de junho de 2025

+1 para “engenharia de contexto” em vez de “engenharia de prompt”.

As pessoas associam prompts a descrições curtas de tarefas que você daria a um LLM no uso diário. Em todos os aplicativos LLM de nível industrial, a engenharia de contexto é a delicada arte e ciência de preencher a janela de contexto... https://t.co/Ne65F6vFcf

— Andrej Karpathy (@karpathy) 25 de junho de 2025

| Abordagem | Em que se concentra | Ideal para uso em |

| Engenharia de prompts | Elaborando instruções e formatos de saída para o modelo | Tarefas pontuais, geração de conteúdo, resultados específicos de formato |

| Engenharia de contexto | Fornecendo dados, estado e restrições relevantes para o modelo | IA conversacional, ferramentas de análise de documentos, assistentes de codificação |

| Ambos juntos | Combinar instruções claras com contexto no nível do sistema | Aplicações de IA de produção que precisam de desempenho consistente e confiável |

A maioria dos aplicativos usa uma combinação de engenharia de prompts e engenharia de contexto. Você ainda precisa de prompts bem escritos em seu sistema de engenharia de contexto.

A diferença é que essas instruções funcionam com informações de fundo cuidadosamente gerenciadas. Você não precisa começar do zero todas as vezes.

📮 ClickUp Insight: Mais da metade dos entrevistados digita em três ou mais ferramentas diariamente, lutando contra a “ proliferação da IA ” e fluxos de trabalho dispersos.

Embora possa parecer produtivo e ocupado, seu contexto está simplesmente se perdendo entre os aplicativos, sem mencionar o desgaste energético causado pela digitação. O Brain MAX reúne tudo isso: fale uma vez e suas atualizações, tarefas e notas vão parar exatamente onde devem estar no ClickUp. Chega de alternar entre aplicativos, chega de caos — apenas produtividade centralizada e integrada.

Aplicações da engenharia de contexto de IA

As principais áreas em que a engenharia de contexto de IA já está sendo implementada são 👇

Automação do suporte ao cliente e do helpdesk

A maioria dos chatbots trata cada mensagem como nova, forçando os usuários a se repetirem várias vezes.

Com a engenharia de contexto, a IA pode consultar o histórico do usuário, interações anteriores, registros de compras e documentação do produto. Com isso, ela responde como um colega de equipe que já conhece o problema.

📌 Exemplo real: A equipe de suporte da Coda lida com perguntas técnicas sobre produtos que exigem a compreensão de mensagens anteriores e a consulta à documentação do produto. Para ampliar o suporte, eles usam o Intercom Fin. O Fin lê a documentação e as conversas anteriores antes de responder, ajudando a resolver de 50 a 70% das perguntas dos clientes de forma autônoma, mantendo um alto nível de satisfação do cliente.

Assistentes de redação de IA e produtividade no local de trabalho

As ferramentas de redação de IA só agregam valor quando entendem no que você está trabalhando, por que isso é importante e o que já existe. Sem esse contexto, elas economizam tempo na redação, mas ainda exigem muitas reescritas e alinhamento manual.

É aqui que a IA de engenharia de contexto muda os resultados. Ao basear a IA no estado da tarefa, nos documentos, nas decisões anteriores e nas convenções da equipe, os assistentes de redação passam da geração de textos genéricos para um suporte consciente do fluxo de trabalho.

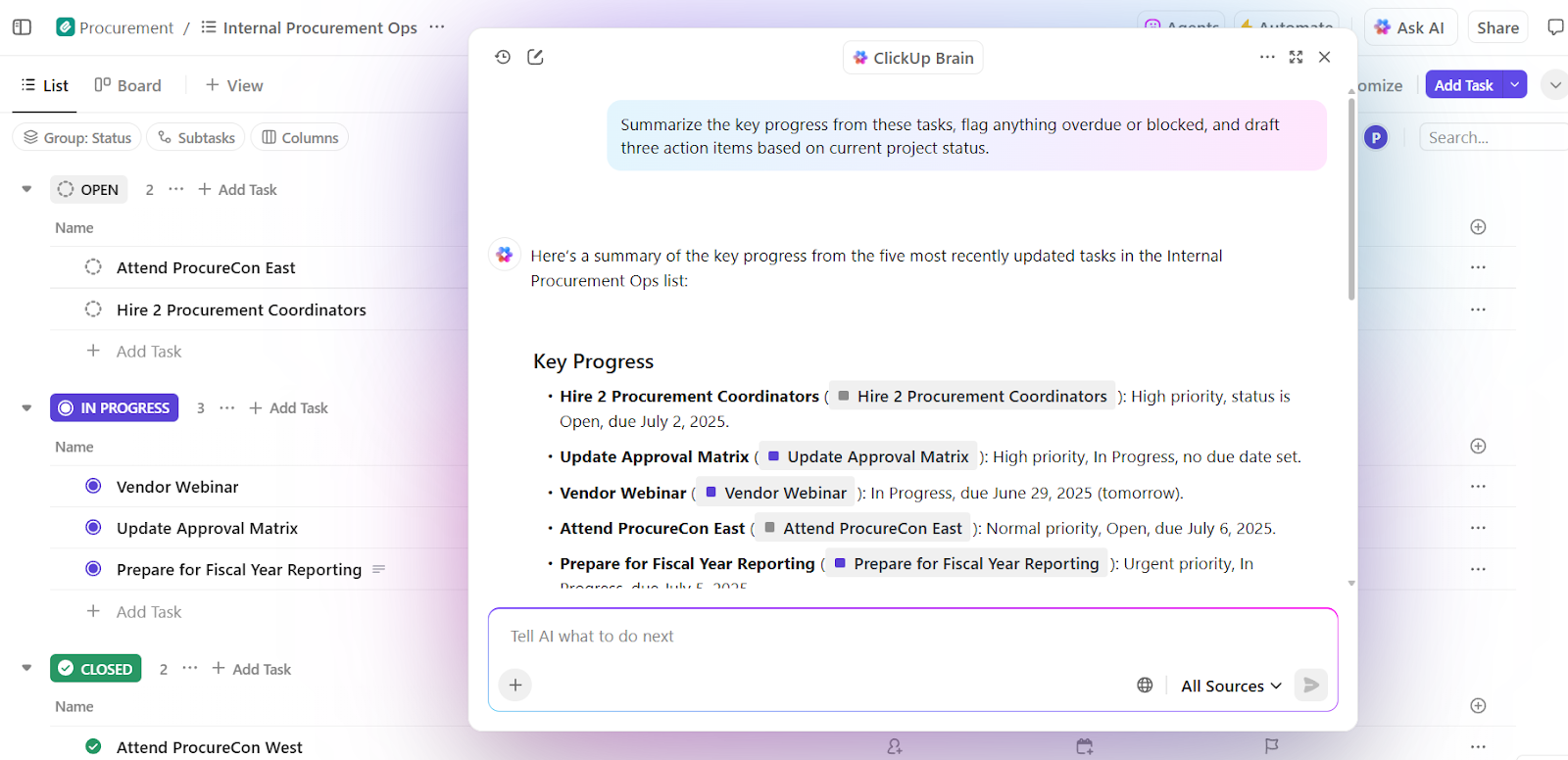

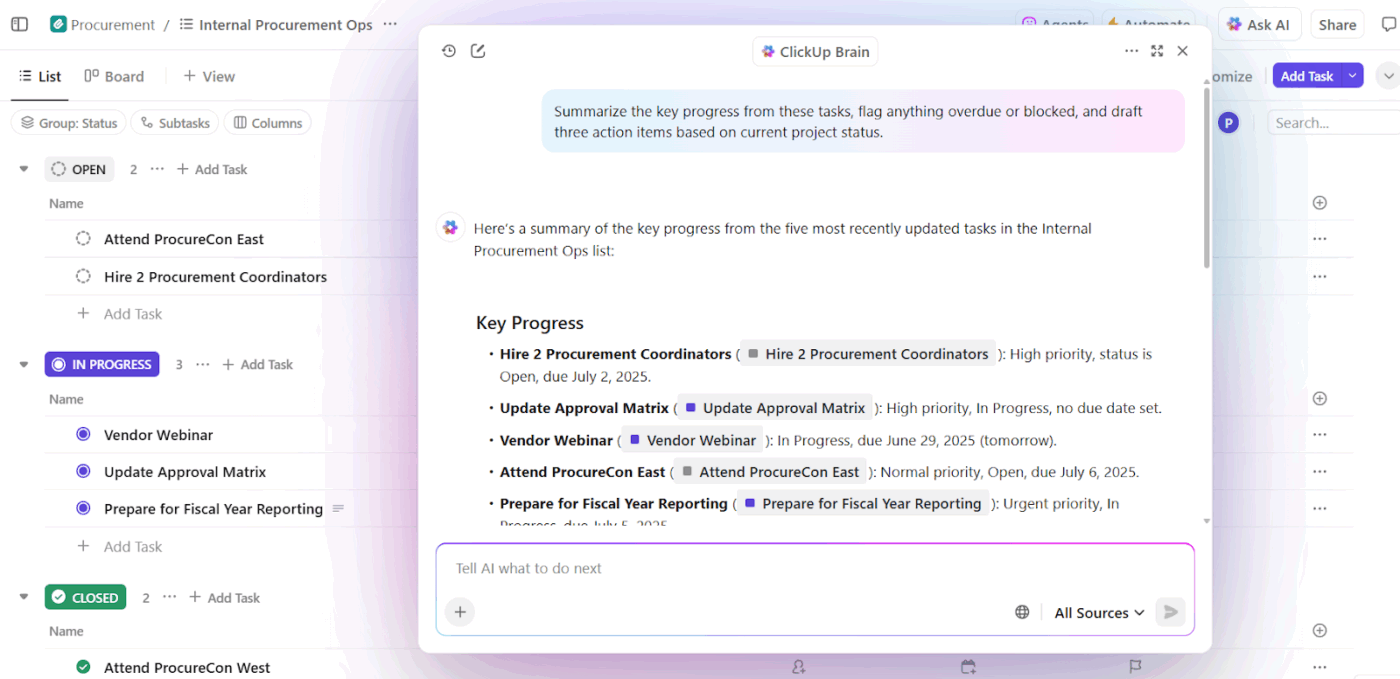

📌 Exemplo real: O ClickUp Brain, a IA nativa do ClickUp, aplica a engenharia de contexto no nível do espaço de trabalho. Em vez de pedir aos usuários que coloquem o histórico nas solicitações, ele extrai o contexto diretamente de tarefas, documentos, comentários, prioridades e cronogramas.

Uma capacidade fundamental é a tomada de decisões contextuais. Ela avalia os projetos em andamento juntamente com a capacidade da equipe e o desempenho anterior para revelar insights acionáveis.

Primeiro, o Brain pode detectar sobrecargas, atrasos e gargalos. Além de resumir o problema, ele também recomenda ajustes concretos, como redistribuir tarefas, atualizar cronogramas e redistribuir prioridades.

Como essas decisões são baseadas em um contexto de espaço de trabalho ativo, o resultado é imediatamente utilizável. Não há necessidade de reafirmar o contexto, explicar prioridades ou alinhar manualmente as recomendações com a realidade.

As equipes que utilizam o ClickUp Brain relatam taxas de integração total 2,26 vezes maiores e os menores índices de frustração com a IA (27,1%).

Inteligência de vendas e CRM

Os fluxos de trabalho de vendas abrangem e-mails, reuniões, CRMs e planilhas. Sem contexto, a IA não consegue entender o momentum do negócio ou a intenção do comprador.

A engenharia de contexto dá à IA visibilidade das conversas dos compradores, cronogramas, tom de comunicação e envolvimento anterior. Isso ajuda a revelar insights, detectar negócios paralisados e sugerir a próxima ação correta.

📌 Exemplo real: a equipe de vendas da Microsoft usa o Copilot for Sales, que extrai contexto do Outlook, chamadas do Teams, atualizações do CRM e notas para revelar os insights certos e elaborar follow-ups. As equipes internas observaram um aumento de 20% nas negociações fechadas e um aumento de 9,4% na receita por vendedor, mostrando como a IA orientada por contexto amplifica o desempenho.

Assistentes de IA na área da saúde e clínica

As decisões médicas dependem do histórico do paciente, relatórios laboratoriais, prescrições e anotações do médico, mas essas informações geralmente ficam em sistemas desconectados. Isso faz com que os médicos percam muito tempo reinserindo dados e corram o risco de ignorar detalhes críticos. Às vezes, eles gastam quase 40% do tempo em trabalho administrativo.

A engenharia de contexto de IA conecta esses pontos de dados. Ela auxilia os médicos com resumos precisos, rascunhos de documentação, destaca históricos relevantes e revela riscos potenciais ou próximos passos.

📌 Exemplo real: A Atrium Health usa o Nuance DAX Copilot, desenvolvido em parceria com a Microsoft, para documentar automaticamente consultas clínicas usando registros anteriores e conversas em tempo real. Como resultado, os médicos economizaram de 30 a 40 minutos por dia em documentação, enquanto um estudo em 12 especialidades médicas relatou maior eficiência e satisfação dos profissionais sem comprometer a segurança dos pacientes.

Assistentes de RH e recrutamento

As decisões de recrutamento dependem do contexto, como habilidades, feedback de entrevistas, adequação à função e dados de contratações anteriores. A engenharia de contexto de IA permite analisar currículos, descrições de cargos, transcrições de entrevistas e padrões históricos para identificar combinações ideais mais rapidamente.

📌 Exemplo real: As equipes empresariais da Micron usam a Eightfold AI, uma plataforma de inteligência de talentos que analisa currículos, requisitos de cargos, planos de carreira internos e resultados de contratações anteriores para prever a adequação ao cargo. A plataforma avalia os candidatos com base em suas habilidades e potencial. O resultado? Expansão do pipeline de talentos e contratação de mais oito candidatos por mês com uma equipe de recrutamento enxuta.

Ferramentas e plataformas que oferecem suporte à engenharia de contexto

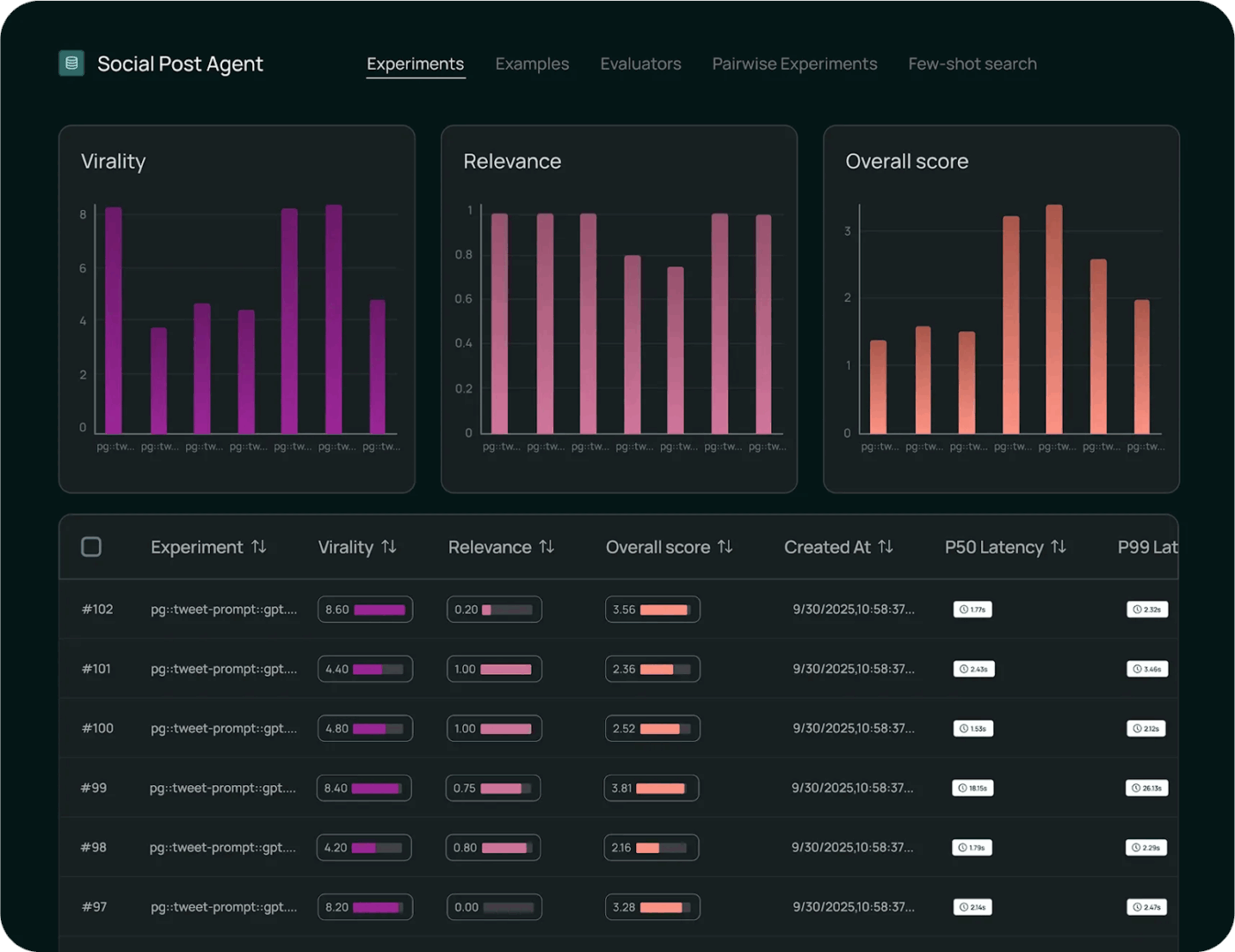

Quais ferramentas ajudam você a implementar a engenharia de contexto em escala?

1. LangChain (melhor para montar o contexto programaticamente)

LangChain é uma estrutura de orquestração de código aberto para a construção de sistemas de IA em que o contexto deve ser montado, atualizado e roteado programaticamente.

A ferramenta de agente de IA ajuda os desenvolvedores a conectar LLMs com ferramentas, fontes de dados, memória e lógica de controle, em vez de depender de prompts estáticos.

O Core LangChain lida com o encadeamento e a recuperação, enquanto o LangGraph permite fluxos de trabalho baseados em gráficos e com estado para raciocínios complexos e com várias etapas.

A DeepAgents se baseia nesse princípio para oferecer suporte a agentes autônomos de longa duração com planejamento, subagentes e contexto persistente.

Juntos, esses componentes tornam o LangChain uma camada de controle para a engenharia de contexto, decidindo quando o contexto é buscado, como ele evolui e onde ele flui pelos fluxos de trabalho dos agentes.

Melhores recursos do LangChain

- Monitore a execução com ferramentas de observabilidade para rastrear chamadas de modelo, latência, erros e fluxo de contexto de ponta a ponta para obter insights de depuração e desempenho.

- Avalie o comportamento do modelo de forma sistemática usando estruturas de teste integradas que medem a correção, comparam resultados e validam alterações em relação a benchmarks.

- Implemente fluxos de trabalho em escala com ambientes gerenciados que oferecem suporte a controle de versões, controle de implementação e execução pronta para produção de cadeias e agentes.

Limitações do LangChain

- A ferramenta tem uma curva de aprendizado íngreme para iniciantes, e a documentação, atualizada a cada poucos dias, torna-a um pouco confusa.

Preços do LangChain

- Desenvolvedor: Gratuito

- Mais: US$ 39/usuário/mês

- Empresa: Preços personalizados

Avaliações e comentários do LangChain

- G2: 4,7/5 (mais de 30 avaliações)

- Capterra: Não há avaliações e comentários suficientes

O que os usuários reais estão dizendo sobre o LangChain?

De acordo com um usuário do Reddit:

Depois de testar alguns métodos diferentes, acabei gostando de usar a chamada de ferramentas padrão com fluxos de trabalho langgraph. Então, eu envolvo os fluxos de trabalho determinísticos como agentes que o LLM principal chama como ferramentas. Dessa forma, o LLM principal oferece uma experiência de usuário dinâmica genuína e simplesmente passa para um fluxo de trabalho para fazer o trabalho pesado, que então devolve sua saída de forma organizada para o LLM principal.

Depois de testar alguns métodos diferentes, acabei gostando de usar a chamada de ferramentas padrão com fluxos de trabalho langgraph. Então, eu envolvo os fluxos de trabalho determinísticos como agentes que o LLM principal chama como ferramentas. Dessa forma, o LLM principal oferece uma experiência de usuário dinâmica genuína e simplesmente passa para um fluxo de trabalho para fazer o trabalho pesado, que então devolve sua saída de forma organizada para o LLM principal.

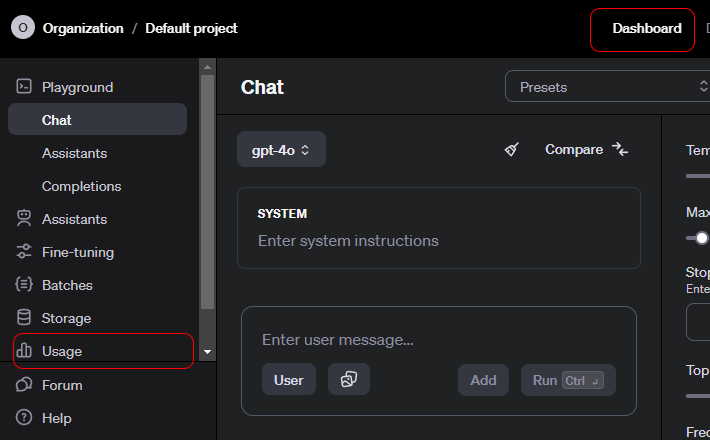

2. API OpenAI (a API de IA contextual fornece contexto estruturado, chamada de ferramentas e controles no nível do sistema)

A API OpenAI é uma interface de uso geral para acessar modelos avançados de IA generativa que alimentam uma ampla gama de aplicações.

Os desenvolvedores usam isso para integrar a compreensão e a geração de linguagem aos produtos. Também oferece suporte a resumos, traduções, assistência de código e raciocínio.

A API oferece suporte a bate-papo, incorporações, chamadas de função, moderação e entradas multimodais, permitindo interações estruturadas com modelos. A OpenAI é ideal para prototipagem rápida, pois lida com autenticação, dimensionamento e controle de versão.

A facilidade de uso é atribuída à forma como a API abstrai o comportamento complexo do modelo em pontos finais simples e confiáveis.

Melhores recursos da API OpenAI

- Gere resultados sensíveis ao contexto em textos, códigos e entradas multimodais para tarefas e raciocínios em linguagem natural.

- Crie embeddings ricos para impulsionar a pesquisa semântica, o agrupamento e os fluxos de trabalho de recuperação baseados em vetores.

- Invoque funções e ferramentas por meio de chamadas estruturadas que permitem que os modelos interajam com sistemas e serviços externos.

Limitação da API da OpenAI

- Sem memória de longo prazo nativa. A API é stateless por padrão.

Preços da API da OpenAI

GPT-5. 2

- Entrada: US$ 1,750 / 1 milhão de tokens

- Entrada em cache: $0,175 / 1 milhão de tokens

- Resultado: $14.000 / 1 milhão de tokens

GPT-5. 2 Pro

- Entrada: $21,00 / 1 milhão de tokens

- Entrada em cache: Não disponível

- Resultado: $168,00 / 1 milhão de tokens

GPT-5 Mini

- Entrada: US$ 0,250 / 1 milhão de tokens

- Entrada em cache: $0,025 / 1 milhão de tokens

- Resultado: $2.000 / 1 milhão de tokens

Avaliações e comentários sobre a API da OpenAI

- G2: Não há avaliações suficientes

- Capterra: Avaliações insuficientes

O que os usuários reais estão dizendo sobre a API da OpenAI?

De acordo com um usuário do Reddit:

As APIs da OpenAI são como qualquer outra, portanto, do ponto de vista técnico, não deve haver nenhuma curva de aprendizado. Todos os pontos finais, parâmetros e respostas de exemplo estão bem documentados. Se você tem experiência básica em desenvolvimento, não deve precisar de um curso. Concordo com o ponto acima sobre aprender Python. As bibliotecas Python têm todas as informações relevantes para facilitar a vida. Também existem bibliotecas Node, se você quiser continuar com JS. A maior curva de aprendizado será como usá-las estrategicamente. Passe algum tempo experimentando mensagens do sistema, prompts do usuário e parâmetros no Playground antes de tentar construir com código. (Tenho certeza de que você pode obter um código de amostra do Playground depois de encontrar algo que funcione. )

As APIs da OpenAI são como qualquer outra, portanto, do ponto de vista técnico, não deve haver nenhuma curva de aprendizado. Todos os pontos finais, parâmetros e respostas de exemplo estão bem documentados. Se você tem experiência básica em desenvolvimento, não deve precisar de um curso. Concordo com o ponto acima sobre aprender Python. As bibliotecas Python têm todas as informações relevantes para facilitar a vida. Também existem bibliotecas Node, se você quiser continuar com JS. A maior curva de aprendizado será como usá-las estrategicamente. Passe algum tempo experimentando mensagens do sistema, prompts do usuário e parâmetros no Playground antes de tentar construir com código. (Tenho certeza de que você pode obter um código de amostra do Playground depois de encontrar algo que funcione. )

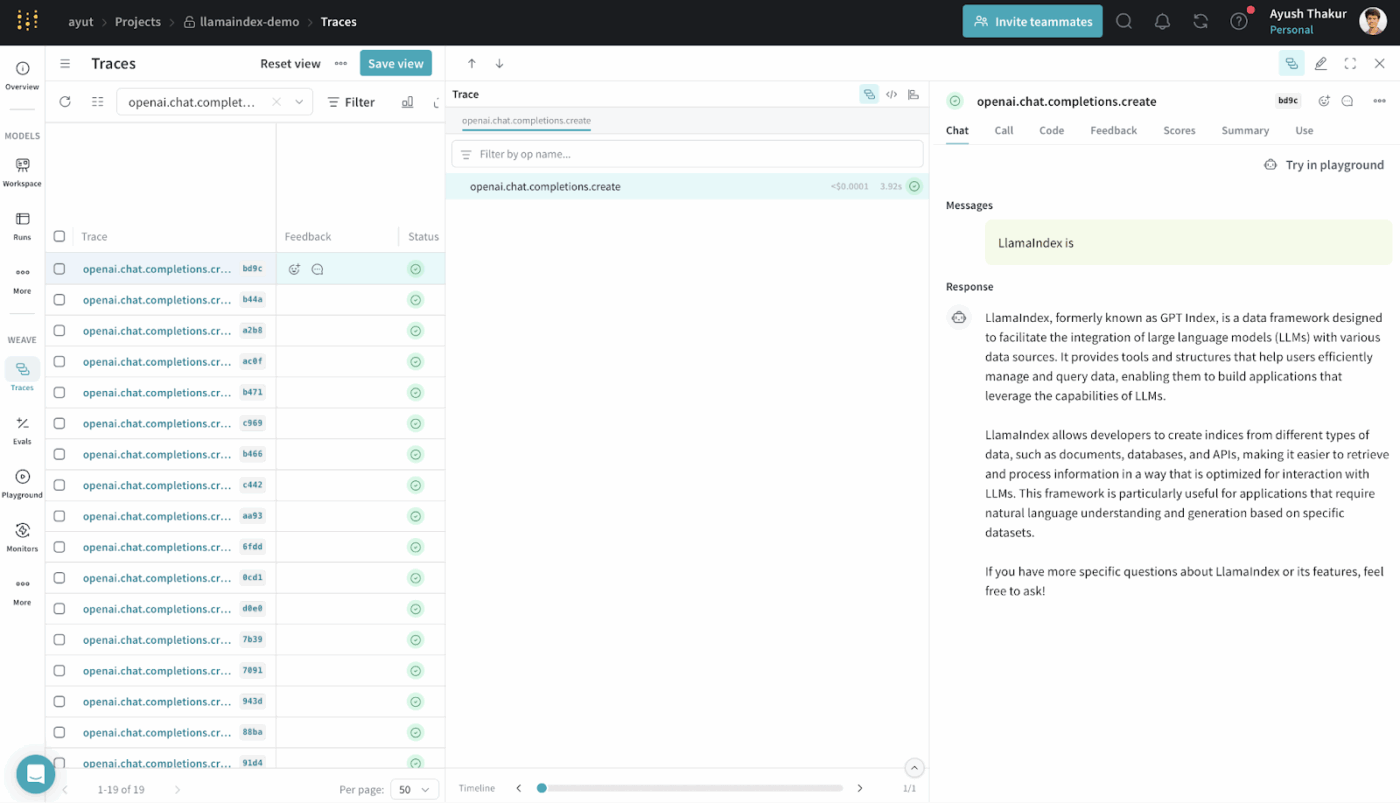

3. LlamaIndex (ideal para sistemas de geração de aumento de recuperação)

O LlamaIndex é uma estrutura de dados de código aberto projetada para tornar os dados externos acessíveis e utilizáveis para grandes modelos de linguagem.

Ele fornece conectores, índices e interfaces de consulta que transformam dados estruturados e não estruturados em representações que os LLMs podem processar com eficiência.

Você pode construir sistemas RAG sem uma infraestrutura personalizada profunda. Ele abstrai a recuperação, a vetorização e a classificação por relevância.

É comumente usado para casos de uso como pesquisa semântica, resumo e resposta a perguntas, com base em dados reais.

Melhores recursos do LlamaIndex

- Indexe fontes de dados heterogêneas em estruturas pesquisáveis que os LLMs possam consultar de forma eficaz.

- Recupere o contexto estrategicamente usando pesquisa vetorial e planejamento de consultas para injeção precisa de evidências.

- Comprima e resuma o contexto para manter o raciocínio eficiente e relevante.

Preços do LlamaIndex

- Gratuito

- Inicial: US$ 50/mês

- Prós: US$ 500/mês

- Empresa: Preços personalizados

Avaliações e comentários do LlamaIndex

- G2: Não há avaliações suficientes

- Capterra: Avaliações insuficientes

O que os usuários reais estão dizendo sobre o LlamaIndex?

Um usuário compartilha no Reddit:

Sinceramente, acho que a maioria dessas estruturas de IA de última geração, como langchain e llamaindex, não são tão boas e tornam o código mais complicado. É melhor usar o python básico.

Sinceramente, acho que a maioria dessas estruturas de IA de última geração, como langchain e llamaindex, não são tão boas e tornam o código mais complicado. É melhor usar o python básico.

4. ClickUp BrainGPT (o melhor assistente de IA para o seu espaço de trabalho)

A maioria das ferramentas desta lista ajuda você com partes específicas da engenharia de contexto. Elas montam prompts, recuperam dados ou orquestram fluxos de trabalho.

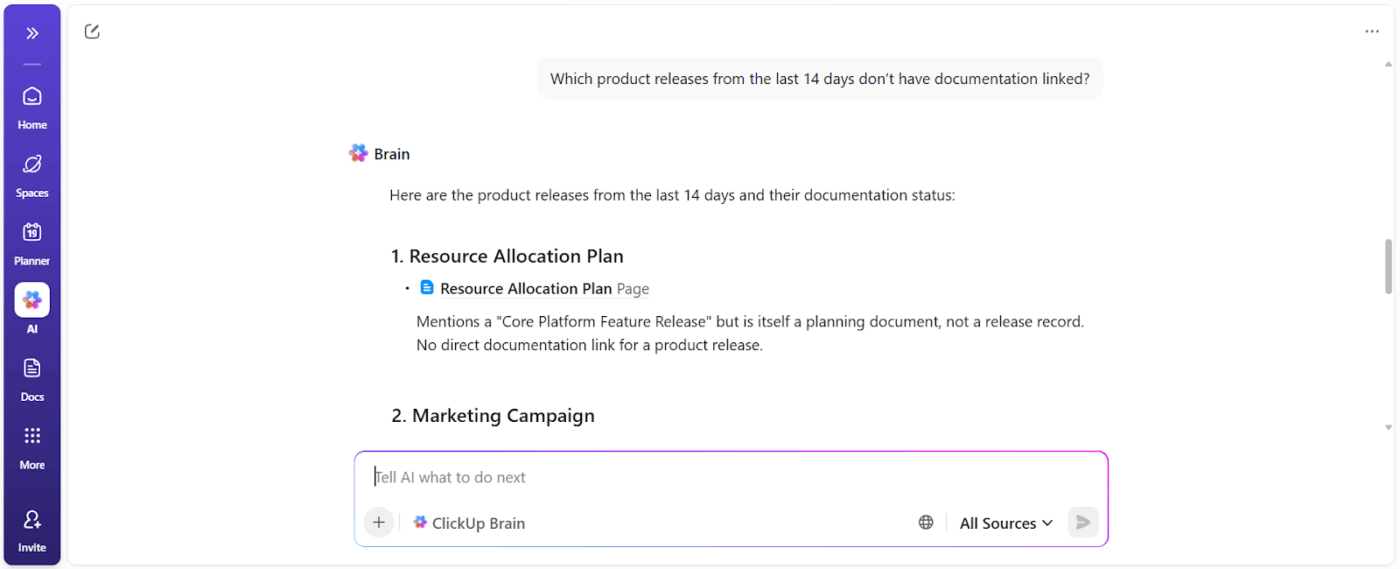

O ClickUp Brain adota uma abordagem diferente. Como o primeiro espaço de trabalho de IA convergente do mundo, o ClickUp unifica seus projetos, tarefas, documentos e comunicações em uma única plataforma, com uma IA sensível ao contexto incorporada.

Veja como 👇

Trabalhe com uma IA que entenda você e seu trabalho

O ClickUp Brain entende o contexto do seu trabalho.

Ele extrai o contexto das suas tarefas, documentos, comentários, dependências, status, cronogramas e propriedade do ClickUp. Você não precisa colar o histórico ou explicar a história do projeto toda vez que fizer uma pergunta com base nos dados do espaço de trabalho.

📌 Por exemplo, quando um gerente pergunta: “O que está atrasando a campanha do terceiro trimestre?” Ele examina o espaço de trabalho e revela obstáculos concretos, como:

- Tarefas não atribuídas

- Aprovações pendentes

- Avaliações paralisadas

- Dependências aguardando ativos

Você recebe um relatório de bloqueadores que mostra os responsáveis pelas ações e o impacto no tempo.

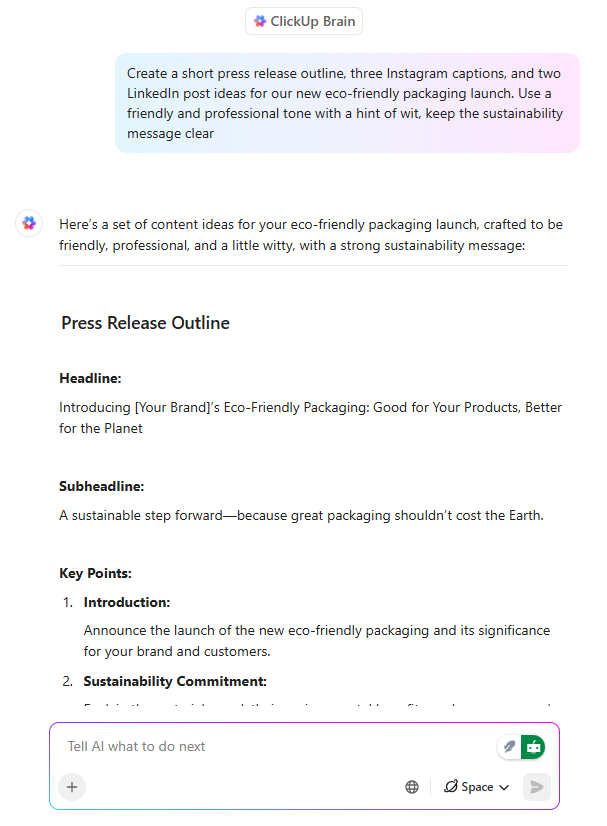

Redação de IA já alinhada com a execução

O ClickUp Brain atua como um assistente de redação de IA, mas com uma diferença fundamental: ele escreve com consciência do que a equipe está construindo.

Quando um gerente de produto ou profissional de marketing redige mensagens de lançamento dentro de um documento do ClickUp, o Brain pode:

- Defina propostas de valor usando o contexto do produto existente.

- Adapte as mensagens para diferentes níveis de público

- Reescreva o conteúdo para corresponder ao tom, clareza ou objetivos de posicionamento.

Mais importante ainda, que a redação permaneça conectada às tarefas, cronogramas e aprovações. Não há desconexão entre a documentação e o trabalho. Uma grande economia de tempo, pois o conteúdo não precisa ser reinterpretado posteriormente.

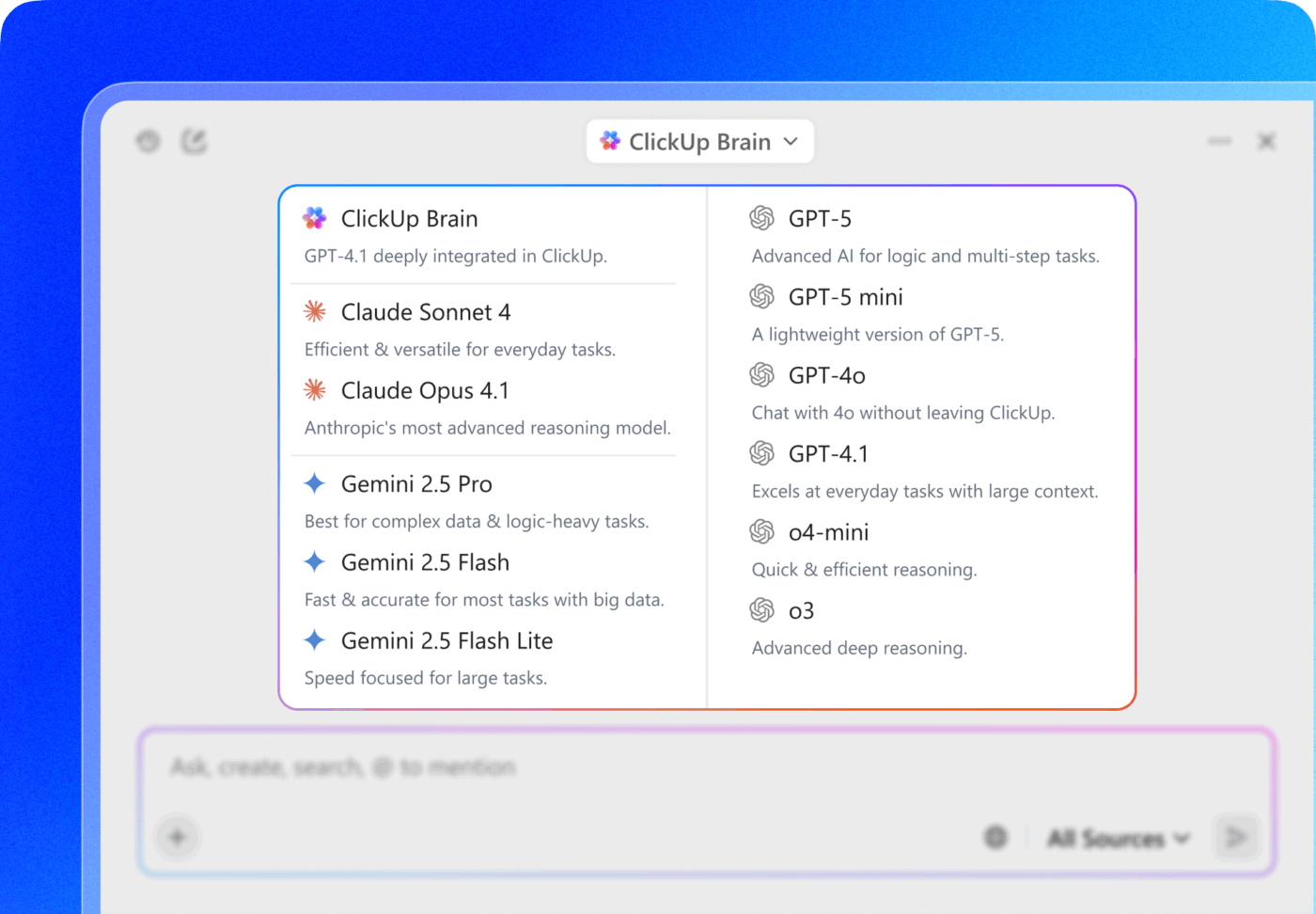

💡 Dica profissional: escolha entre vários modelos de IA das famílias ChatGPT, Claude e Gemini diretamente no ClickUp Brain!

- Use um modelo rápido e leve para resumir as notas da reunião dentro de uma tarefa.

- Mude para um modelo mais baseado em raciocínio ao analisar o desempenho da campanha em documentos, tarefas e painéis.

A verdadeira jogada de poder? Combine a seleção do modelo com o contexto conectado do ClickUp — tarefas, comentários, documentos e campos personalizados — para que o modelo não seja apenas “inteligente”, mas também opere dentro da realidade do seu espaço de trabalho.

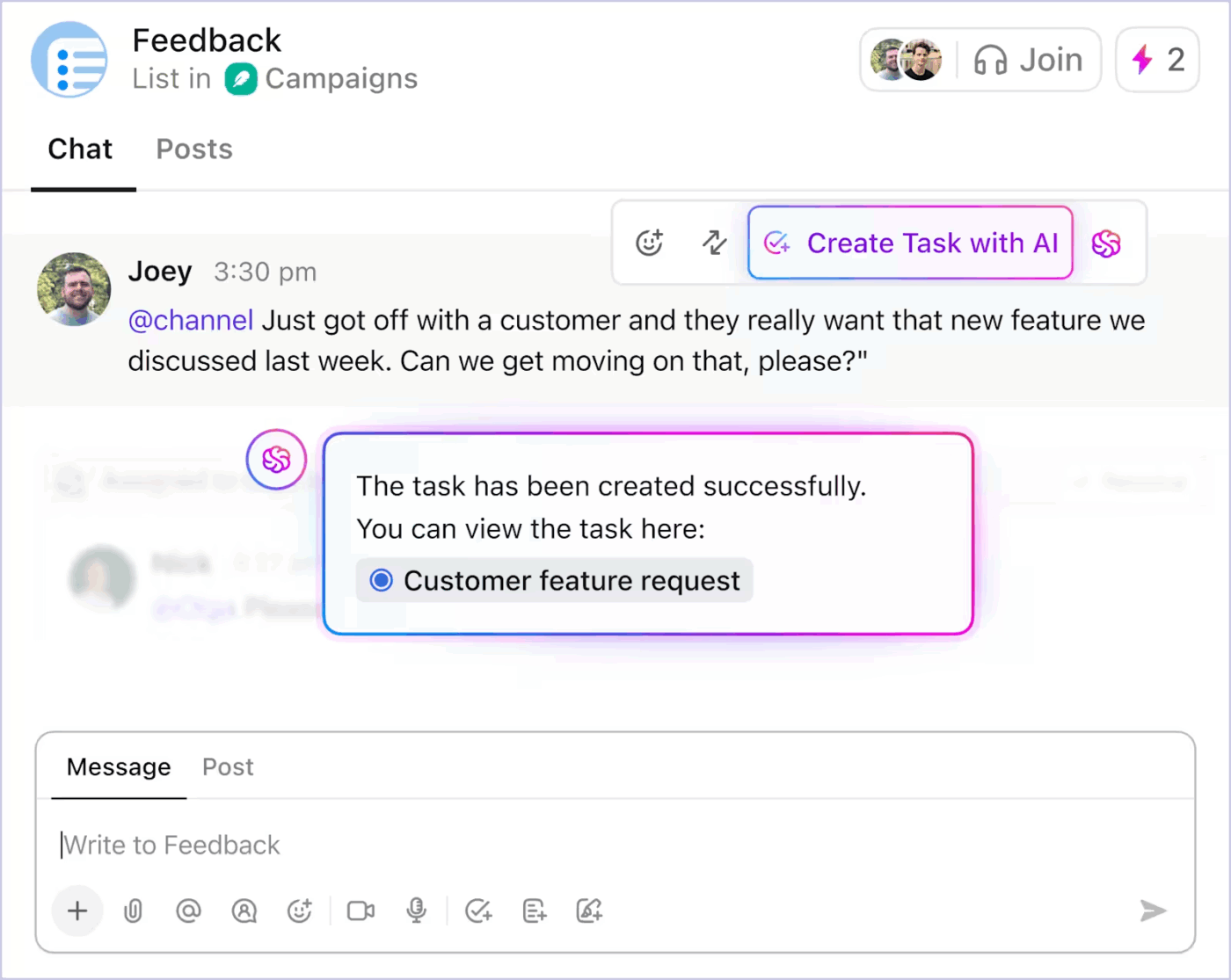

Automação de tarefas contextuais que reduz a sobrecarga manual

Com as tarefas alimentadas por IA, o ClickUp transforma o contexto em ação. Os principais recursos incluem:

- Converte discussões do ClickUp Chat em tarefas

- Gere subtarefas e descrições de tarefas a partir de um título de tarefa existente com base no escopo.

- Sugira os próximos passos quando o trabalho parar

- Automatize atualizações de rotina usando o estado real do projeto

Veja como você pode usar a automação de tarefas com IA no ClickUp para reduzir o trabalho pesado 👇

Como a automação é impulsionada pelo contexto em tempo real, as equipes gastam menos tempo traduzindo a intenção em estrutura. O trabalho avança sem intervenção manual constante.

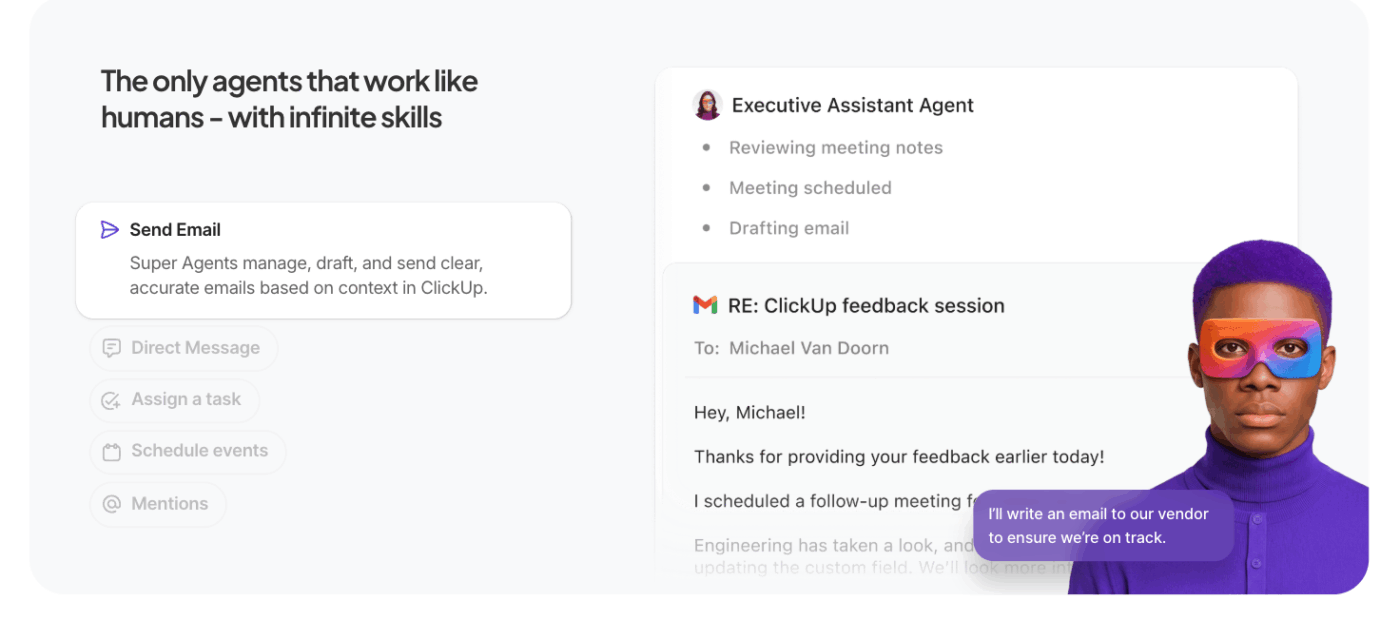

Deixe que os agentes de IA façam o trabalho pesado.

Os Super Agentes do ClickUp ampliam a IA contextual do ClickUp além de consultas únicas para uma execução autônoma em várias etapas.

Em vez de esperar por comandos específicos, esses agentes de IA para automação agem em seu nome dentro do espaço de trabalho, executando tarefas, regras e resultados com base no contexto e nas metas que você define.

O que os diferencia dos agentes comuns:

- Execução proativa de tarefas: os agentes interpretam o contexto do espaço de trabalho — tarefas, dependências, cronogramas — e executam sequências como atualizar status, criar subtarefas ou notificar proprietários sem orientação manual.

- Fluxos de trabalho orientados para objetivos: você define um objetivo de alto nível (por exemplo, “Resolver bloqueios na campanha do terceiro trimestre”) e o agente planeja, recupera o contexto e executa ações que fazem o trabalho avançar.

- Contexto e memória persistentes: os agentes mantêm o estado ao longo das etapas, permitindo-lhes raciocinar sobre o que já foi feito e o que ainda falta, melhorando a precisão e reduzindo o trabalho redundante.

- Integração com ferramentas do espaço de trabalho: elas interagem com o ClickUp Tasks, Docs e comentários, bem como com ferramentas conectadas, coordenando entre sistemas para concluir fluxos de trabalho, em vez de sugerir ações sem contexto.

📚 Leia mais: O que são agentes reflexivos baseados em modelos

Melhores recursos do ClickUp

- Traga a IA para o seu desktop e aplicativos conectados com o ClickUp Brain MAX: pesquise em todo o seu espaço de trabalho, transcreva fala para texto, alterne entre os principais modelos de IA e execute ações em tarefas, documentos e bate-papos sem sair do seu fluxo de trabalho.

- Encontre respostas instantaneamente com a Pesquisa Empresarial: pesquise em tarefas, documentos, comentários, arquivos e ferramentas conectadas para que o contexto crítico nunca fique oculto ou isolado.

- Capture ideias rapidamente com o Talk to Text: dite notas, planos ou atualizações e converta a fala em trabalho estruturado sem perder o foco ou o ritmo.

- Reduza o trabalho manual com os Painéis ClickUp : acione atualizações de tarefas, atribuições e acompanhamentos automaticamente com base no contexto real do espaço de trabalho e nas mudanças de estado.

- Mantenha as discussões práticas com o ClickUp Chat: discuta decisões, feedbacks e aprovações diretamente junto com as tarefas, para que as conversas permaneçam ligadas à execução.

- Substitua as reuniões por SyncUps: compartilhe atualizações assíncronas, obtenha resumos gerados por IA e mantenha as equipes alinhadas sem chamadas recorrentes.

- Coordene equipes com o Teams Hub: visualize as atividades, responsabilidades, prioridades e capacidade da equipe em um só lugar para identificar riscos e reequilibrar o trabalho antecipadamente.

- Planeje seu dia com o ClickUp Calendar: obtenha planos diários assistidos por IA com base em prazos, prioridades e carga de trabalho, para que seu foco pessoal se alinhe aos objetivos da equipe.

Limitações do ClickUp

- Seu conjunto de recursos e opções de personalização podem sobrecarregar novos usuários.

Preços do ClickUp

Avaliações e comentários do ClickUp

- G2: 4,7/5 (mais de 10.585 avaliações)

- Capterra: 4,6/5 (mais de 4.500 avaliações)

O que os usuários reais estão dizendo sobre o ClickUp AI?

Um usuário do ClickUp também compartilha sua experiência no G2:

O ClickUp Brain MAX foi uma adição incrível ao meu fluxo de trabalho. A maneira como ele combina vários LLMs em uma única plataforma torna as respostas mais rápidas e confiáveis, e a conversão de voz em texto em toda a plataforma economiza muito tempo. Também aprecio muito a segurança de nível empresarial, que me dá tranquilidade ao lidar com informações confidenciais. [...] O que mais se destaca é como ele me ajuda a eliminar o ruído e pensar com mais clareza — seja resumindo reuniões, redigindo conteúdo ou fazendo brainstorming de novas ideias. É como ter um assistente de IA completo que se adapta a tudo o que eu preciso.

O ClickUp Brain MAX foi uma adição incrível ao meu fluxo de trabalho. A maneira como ele combina vários LLMs em uma única plataforma torna as respostas mais rápidas e confiáveis, e a conversão de voz em texto em toda a plataforma economiza muito tempo. Também aprecio muito a segurança de nível empresarial, que me dá tranquilidade ao lidar com informações confidenciais. [...] O que mais se destaca é como ele me ajuda a eliminar o ruído e pensar com mais clareza — seja resumindo reuniões, redigindo conteúdo ou fazendo brainstorming de novas ideias. É como ter um assistente de IA completo que se adapta a tudo o que eu preciso.

Desafios e considerações ao trabalhar com engenharia de contexto de IA

Aqui estão os principais desafios que você deve estar ciente. O contexto pode sair do controle, mesmo quando o modelo suporta janelas de contexto de 1 milhão de tokens. Aqui estão os principais desafios que você deve estar ciente 👇

Contaminação do contexto

Se uma alucinação ou inferência incorreta se infiltrar no contexto e for repetidamente referenciada, o modelo a tratará como fato. Esse contexto contaminado pode prender os fluxos de trabalho em suposições inválidas que persistem ao longo do tempo e prejudicam a qualidade da produção.

Distração de contexto

Contextos maiores são tentadores, mas quando o contexto fica muito grande, os modelos começam a se concentrar excessivamente no histórico acumulado e subutilizam o que aprenderam durante o treinamento. Isso pode fazer com que a IA fique presa em detalhes do passado, em vez de sintetizar o próximo melhor passo.

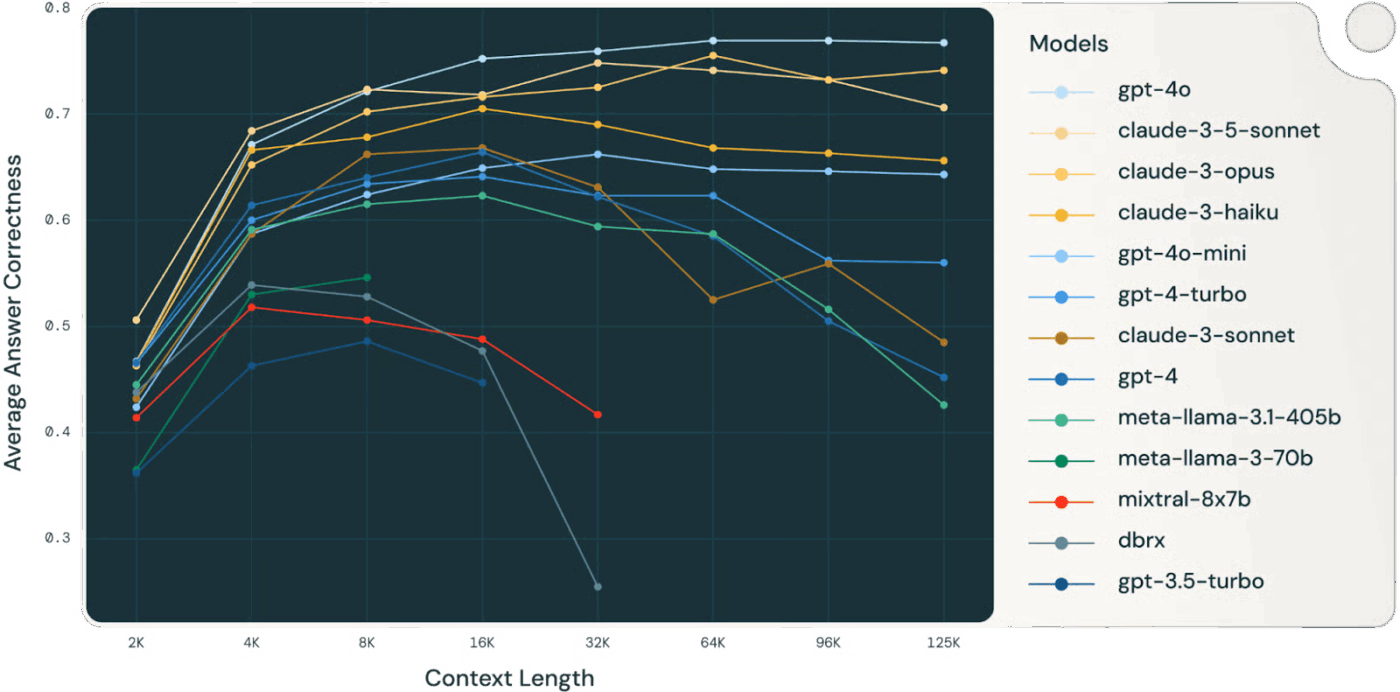

👀 Você sabia? Um estudo da Databricks descobriu que a precisão do modelo para o Llama 3. 1 405B começou a cair em torno de 32.000 tokens, bem antes da janela de contexto ficar cheia. Modelos menores se degradaram ainda mais cedo.

Os modelos muitas vezes perdem a qualidade do raciocínio muito antes de “ficarem sem” contexto, tornando a seleção e a compressão do contexto mais valiosas do que o tamanho bruto do contexto.

📚 Leia mais: O que é a pesquisa no local de trabalho e como ela melhora a produtividade dos funcionários

Confusão de contexto

Informações irrelevantes ou de baixo sinal no contexto competem pela atenção com dados críticos. Quando o modelo se sente compelido a usar todos os tokens de contexto, as decisões ficam confusas e a precisão é prejudicada, mesmo que tecnicamente haja “mais” informações.

Conflito de contexto

À medida que as informações se acumulam, novos fatos ou descrições de ferramentas podem contradizer o conteúdo anterior. Quando existe um contexto conflitante, os modelos têm dificuldade em conciliar sinais conflitantes, levando a resultados inconsistentes ou incoerentes.

Problemas de sobrecarga e seleção de ferramentas

Quando muitas definições de ferramentas são incluídas no contexto, sem filtragem, o modelo pode chamar ferramentas irrelevantes ou priorizar aquelas que não são ideais. O carregamento seletivo apenas das ferramentas relevantes diminui a confusão e melhora a qualidade da decisão.

Complexidade da engenharia e manutenção

O gerenciamento eficaz do contexto requer poda, resumo, descarregamento e quarentena contínuos do contexto. Os sistemas devem decidir quando compactar o histórico e quando buscar novas informações, exigindo uma infraestrutura bem planejada, em vez de truques ad hoc.

Disciplina no orçamento de tokens

Cada token influencia o comportamento; janelas de contexto maiores não garantem melhores resultados. Você precisa tratar o contexto como um recurso gerenciado, ponderando a relevância e a atualidade em relação ao custo do token e ao orçamento de atenção do modelo.

⚠️ Alerta estatístico: Quase 60% dos funcionários admitem que usam ferramentas públicas de IA não autorizadas no trabalho, muitas vezes colando dados confidenciais da empresa em plataformas sem qualquer supervisão.

E fica pior: 63% das organizações não têm políticas de governança de IA para monitorar, restringir ou mesmo detectar esse uso oculto de IA.

Resultado? Seus dados estão vazando porque ninguém está monitorando como a IA está sendo usada.

O futuro da engenharia de contexto

Isso marca a transição da experimentação para a escala. O contexto não será mais gerenciado por humanos, mas gerado e gerenciado por código. Será uma função da própria estrutura do sistema.

Resumiremos isso usando como base o excelente artigo de Serge Liatko na comunidade de desenvolvedores da OpenAI:

A engenharia de contexto evolui para a arquitetura do fluxo de trabalho

A engenharia de contexto dará cada vez mais lugar à arquitetura de fluxo de trabalho automatizada. A tarefa não se limitará a alimentar os tokens certos.

Uma engenharia de contexto eficaz envolverá a orquestração de sequências completas de raciocínio, ferramentas e fluxos de dados que se adaptam automaticamente às necessidades em constante mudança.

Isso significa construir sistemas dinâmicos que autogerenciem o contexto certo dentro de fluxos de trabalho holísticos.

A orquestração automatizada substitui o prompt manual

A próxima fronteira é a IA que se organiza sozinha. Ela conectará recuperação, ferramentas, memória e lógica de negócios sem que os humanos precisem criar manualmente cada prompt ou pacote de contexto. Em vez de fornecer explicitamente cada dado, os sistemas inferirão qual contexto é relevante e o gerenciarão automaticamente com base em objetivos e histórico.

🧠 Isso já está acontecendo com os Super Agentes do ClickUp. Eles são companheiros de equipe de IA ambientais e sempre ativos, o que os ajuda a entender e executar o trabalho da mesma forma que os humanos. Eles melhoram continuamente a partir de interações passadas usando uma memória rica — aprendendo preferências, ações recentes e histórico de projetos — e podem agir proativamente, escalar problemas ou apresentar insights sem esperar por um prompt.

A automação de ponta a ponta se torna o verdadeiro impulsionador da produtividade.

À medida que a engenharia de contexto evolui, os ganhos de produtividade vêm de fluxos de trabalho automatizados. Os LLMs atuam como agentes, coordenando ferramentas, monitorando o estado e executando lógicas de várias etapas sem a microgestão do usuário.

Você não precisará inserir manualmente o contexto que falta. O sistema selecionará o contexto para apoiar a memória de longo prazo e o raciocínio.

O contexto unificado faz a IA funcionar melhor

A precisão da IA é comprometida quando o contexto se fragmenta entre ferramentas, fluxos de trabalho e pessoas. Quando as informações estão dispersas, os modelos são forçados a adivinhar.

Espaços de trabalho de IA convergentes, como o ClickUp, são excelentes nisso: unificam trabalho, dados e IA em sua estratégia de contexto.

Pronto para experimentar? Inscreva-se gratuitamente no ClickUp.