Prywatność jest podstawowym prawem człowieka. Prywatność ta ma również wpływ na wszystkie aspekty dzisiejszej sztucznej inteligencji. Według raportu firmy Cisco 64% osób obawia się, że podczas korzystania z narzędzi AI może przypadkowo udostępnić poufne informacje.

To jeden z powodów, dla których narzędzia AI offline zyskują na popularności. Gdy model działa lokalnie, można pisać, kodować, streszczać i tworzyć — bez konieczności przesyłania wszystkiego do chmury lub utknięcia w martwym punkcie w przypadku utraty połączenia Wi-Fi.

Na tej liście przedstawimy najlepsze narzędzia AI, które działają w trybie offline, a wśród nich super aplikację, która pomaga uporządkować wyniki pracy tych narzędzi w jeden spójny, super bezpieczny system.

Czym są narzędzia AI offline?

Narzędzia AI offline to aplikacje, które uruchamiają duże modele językowe (LLM) na Twoim urządzeniu lokalnym, bez konieczności połączenia z internetem po pobraniu modelu. Dane modelu są przechowywane bezpośrednio na Twoim komputerze, więc całe przetwarzanie lub wnioskowanie odbywa się na Twoim własnym procesorze lub karcie graficznej.

Przetwarzanie na urządzeniu ma kilka kluczowych zalet:

- Pełna prywatność danych: Twoje poufne informacje nigdy nie opuszczają Twojego komputera.

- Brak opłat cyklicznych: Po zakupie narzędzia i modelu nie ponosisz żadnych kosztów subskrypcyjnych.

- Działa wszędzie: Można z niego korzystać w samolocie, w odległej chatce lub podczas awarii Internetu.

- Pełna kontrola: sam wybierasz, które modele chcesz używać i jak je skonfigurować.

Najlepsze narzędzia AI offline w skrócie

Oto krótkie podsumowanie najlepszych dostępnych obecnie narzędzi AI offline.

| Nazwa narzędzia | Najważniejsze funkcje | Najlepsze dla | Ceny* |

| ClickUp | Tryb offline dla zadań i przypomnień, ClickUp Brain MAX, który obejmuje funkcję zamiany mowy na tekst, wyszukiwanie w aplikacjach połączonych, zarządzanie dokumentami i wiedzą, automatyzację, a także integracje i API. | Teams, które potrzebują możliwości przechwytywania danych offline oraz wykonywania zadań online, zarządzania i kontekstu AI w jednym obszarze roboczym. | Free Forever; możliwość niestandardowego dostosowania dla przedsiębiorstw |

| GPT4All | Czat lokalny z otwartymi modelami, LocalDocs do prywatnych pytań i odpowiedzi dotyczących dokumentów, wyszukiwanie i pobieranie modeli w aplikacji, lokalny serwer API zgodny z OpenAI. | Użytkownicy dbający o prywatność, którzy chcą prostego czatu offline z lokalnymi dokumentami | Dostępny Free Plan; plany płatne zaczynają się od 40 USD/użytkownik/miesiąc |

| Studio LM | Wyszukiwanie i pobieranie modeli, interfejs czatu oraz lokalny RAG, serwer kompatybilny z OpenAI lub REST API, ustawienia wstępne i dostosowywanie wydajności | Programiści i zaawansowani użytkownicy, którzy chcą mieć dopracowany modelowy warsztat offline | Free |

| Ollama | Model jednej komendy, lokalny interfejs API REST ze strumieniowaniem, pliki modeli do ponownego wykorzystania konfiguracji oraz osadzenia dla potoków RAG. | Programiści, którzy chcą mieć lokalne środowisko uruchomieniowe z priorytetem CLI i silną warstwą API. | Dostępny Free Plan; plany płatne zaczynają się od 20 USD miesięcznie. |

| Styczeń ai | Interfejs użytkownika w stylu ChatGPT, asystenci i wsparcie MCP, rozszerzenia zapewniające dodatkowe możliwości oraz opcjonalni dostawcy kompatybilni z OpenAI. | Użytkownicy nietechniczni, którzy chcą mieć przejrzystego asystenta offline z możliwością dostosowania niestandardowego | Bezpłatny i otwarty |

| Llamafile | Pakietowanie pojedynczego modelu wykonywalnego, przenośna dystrybucja między systemami operacyjnymi, tryb lokalnego serwera z interfejsem użytkownika i API, minimalne zależności środowiskowe. | Użytkownicy, którzy chcą mieć przenośny plik AI bez konieczności instalacji, który można uruchomić w dowolnym miejscu. | Bezpłatny i otwarty |

| PrywatnyGPT | Własne hostowanie pozyskiwania i indeksowania dokumentów, offline RAG Q&A, filtrowanie kontekstowe według dokumentów, modułowy LLM i stos magazynów wektorowych. | Teams, które potrzebują offline'owych pytań i odpowiedzi dotyczących wewnętrznych plików z kontrolowanym procesem RAG. | Bezpłatny i otwarty |

| Szept. cpp | Lokalne zamienianie mowy na tekst, kwantyzowane modele dla mniejszego zużycia zasobów, wsparcie VAD, opcjonalna obsługa FFmpeg dla większej liczby formatów | Użytkownicy, którzy potrzebują transkrypcji całkowicie offline, którą mogą osadzić w aplikacjach | Bezpłatny i otwarty |

| Interfejs użytkownika do generowania tekstu | Interfejs użytkownika oparty na przeglądarce dla modeli lokalnych, szablony podpowiedzi Jinja2, kontrolki generowania, rozgałęzienie czatu i edycja wiadomości | Użytkownicy, którzy chcą maksymalnej niestandardowej personalizacji w lokalnym interfejsie internetowym | Bezpłatny i otwarty |

| llama.cpp | Wysokowydajny silnik wnioskowania, szerokie wsparcie dla kwantyzacji, lokalny serwer z punktami końcowymi w stylu OpenAI, osadzanie i wsparcie dla ponownego rankingu. | Programiści tworzący niestandardowe aplikacje AI lub backendy działające w trybie offline | Bezpłatny i otwarty |

Jak oceniamy oprogramowanie w ClickUp

Nasz zespół redakcyjny stosuje przejrzysty, oparty na badaniach i niezależny od dostawców proces, dzięki czemu możesz mieć pewność, że nasze rekomendacje opierają się na rzeczywistej wartości produktów.

Oto szczegółowy opis tego, jak oceniamy oprogramowanie w ClickUp.

Czego szukać w najlepszych narzędziach AI, które działają w trybie offline

Ocena narzędzi AI offline może wydawać się skomplikowana i myląca, co może prowadzić do wyboru narzędzia, które może nawet nie działać na Twoim komputerze. Najważniejszą rzeczą, którą należy wziąć pod uwagę, jest to, co chcesz osiągnąć. Deweloper tworzący aplikację opartą na sztucznej inteligencji ma zupełnie inne potrzeby niż osoba, która potrzebuje prywatnego, offline'owego chatbota AI do pomocy w pisaniu.

Oto kluczowe kryteria oceny:

- Łatwość ustawień: Czy wymaga wiedzy technicznej i pracy z wierszem komend, czy też jest to prosta instalacja jednym kliknięciem?

- Wybór modelu: Czy możesz łatwo wybierać spośród szerokiej gamy modeli, czy też masz do wyboru tylko kilka?

- Gwarancje prywatności: Czy narzędzie przetwarza wszystkie dane lokalnie, czy też zawiera ukryte komponenty w chmurze?

- Wymagania sprzętowe: Czy program będzie działał dobrze na Twoim obecnym komputerze, czy też konieczna będzie jego aktualizacja?

- Możliwości integracji: Czy można przeprowadzić połączenie tego narzędzia z innymi posiadanymi narzędziami, czy jest to całkowicie samodzielna aplikacja?

- Zastosowanie: Czy jest przeznaczony do ogólnych rozmów, zadawania pytań dotyczących dokumentów, transkrypcji audio czy generowania kodu?

10 najlepszych narzędzi AI, które działają w trybie offline

Widok ogólny na najlepsze narzędzia AI offline 👇

1. ClickUp (najlepsze rozwiązanie do przechowywania zadań, dokumentów i kontekstu AI w jednym miejscu podczas pracy offline i online)

ClickUp, pierwsze na świecie zintegrowane środowisko pracy oparte na sztucznej inteligencji, zostało zbudowane w oparciu o „sztuczną inteligencję offline”, która nie ogranicza się jedynie do generowania odpowiedzi. Dzieje się tak, ponieważ nadal potrzebne jest miejsce, w którym wyniki tych działań przekształcają się w decyzje, zadania i kolejne kroki, które nie znikają w plikach i czatach.

W przeciwieństwie do wielu rozwiązań offline, które wymagają długotrwałej instalacji i łączenia narzędzi, ClickUp zapewnia kompletną warstwę wykonawczą w jednym miejscu, z wykorzystaniem AI działającej w tym samym kontekście przestrzeni roboczej.

Na początek masz tryb offline ClickUp, który włącza się automatycznie i pozwala kontynuować pracę, gdy nie masz połączenia z internetem. Oznacza to, że wszystkie Twoje zadania, przypomnienia i notatki są dostępne w trybie offline, a w razie potrzeby możesz dodawać nowe. Po ponownym połączeniu się z internetem nowe zadania i przypomnienia są automatycznie synchronizowane z Twoim obszarem roboczym (żegnaj utrata kontekstu 👋).

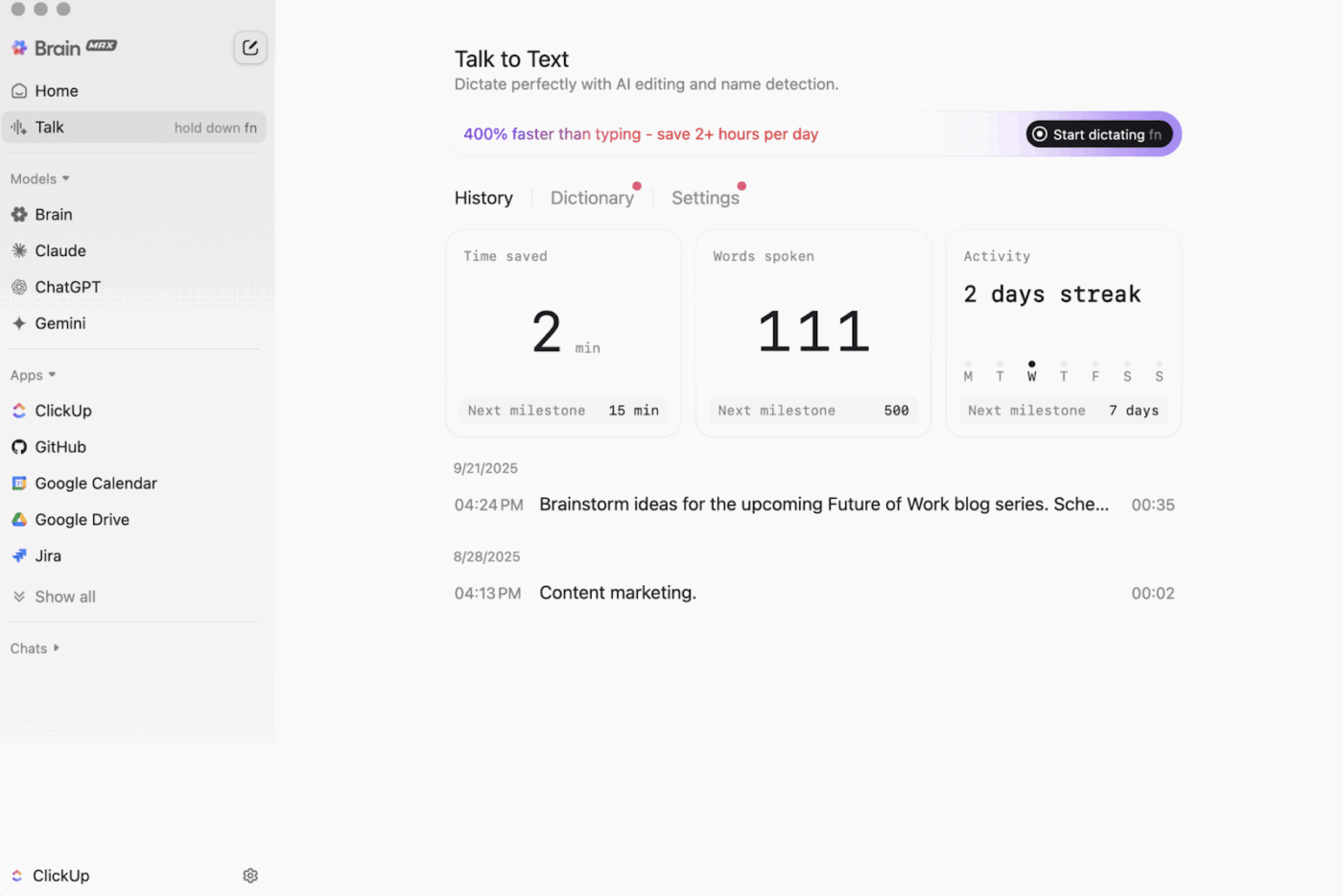

Jest też ClickUp Brain MAX , kompan AI na komputery stacjonarne, który stawia prywatność na pierwszym miejscu i może przechowywać i przeszukiwać cały obszar roboczy, połączone aplikacje, a nawet internet.

Dzięki funkcji Talk-to-Text Brain MAX może zamieniać Twój głos na tekst bez użycia rąk. Obejmuje to tworzenie wiadomości e-mail, pisanie dokumentów lub szybkie zapisywanie aktualizacji, gdy jesteś w biegu.

Brain MAX oferuje również uniwersalną sztuczną inteligencję, stworzoną do rozmów z najnowszymi modelami AI do kodowania, pisania, złożonego rozumowania i nie tylko. Oznacza to, że możesz zadawać pytania najlepszym modelom AI w jednym miejscu, w tym ClickUp Brain oraz opcjom takim jak OpenAI, Claude i Gemini, bez konieczności przełączania się między narzędziami.

Co więcej, ClickUp Security dodaje zabezpieczenia, które narzędzia offline często pomijają. Pomyśl o szyfrowaniu, szczegółowych uprawnieniach i kontrolach administracyjnych, takich jak SSO, provisioning i logi audytowe, wszystkie zaprojektowane dla zespołów, które potrzebują bezpieczeństwa na poziomie Enterprise.

ClickUp AI Knowledge Management bardzo pomaga w przekazywaniu zadań z trybu offline do trybu online. Zapewnia Twojemu zespołowi hub przechowywania różnych zasobów w dokumentach i wiki, a następnie wykorzystuje ClickUp Brain do uzyskania natychmiastowych odpowiedzi z całego obszaru roboczego, dzięki czemu odpowiedni kontekst jest dostępny w momencie wznowienia pracy.

🎬 Agenci w akcji: Wykorzystaj Super Agentów, aby przekształcić zsynchronizowaną pracę w kolejne kroki!

Super agenci ClickUp to wspierani przez sztuczną inteligencję współpracownicy, których można tworzyć i dostosowywać do własnych potrzeb, aby wykonywali wieloetapowe cykle pracy w obszarze roboczym ClickUp. Można skonfigurować konkretne wyzwalacze, instrukcje i dostęp do narzędzi, aby zapewnić, że działają oni w wyznaczonych granicach.

Na przykład po zsynchronizowaniu zadań offline Super Agent może przeskanować nowe elementy, podsumować zmiany, wyodrębnić kroki, przygotować aktualizację i przekazać ją odpowiedniemu właścicielowi do przeglądu.

A ponieważ Super Agenci są zarządzalni, możesz kontrolować, do czego mają dostęp za pomocą uprawnień i sprawdzać, co robią. 🔐

Najlepsze funkcje ClickUp

- Znajdź wszystko w swoich narzędziach: Sortuj i przeszukuj cały obszar roboczy oraz połączone aplikacje z jednego miejsca dzięki ClickUp Enterprise Search.

- Zbuduj prawdziwą bazę wiedzy: Twórz wiki i dokumentację za pomocą ClickUp Docs, korzystając z zagnieżdżonych stron, szablonów, pomocy AI i nie tylko.

- Zachowaj połączenie ze swoim stosem: synchronizuj pracę z narzędziami takimi jak Slack i GitHub bez opuszczania ClickUp dzięki integracjom ClickUp.

- Twórz niestandardowe cykle pracy: Korzystaj z interfejsu API ClickUp z tokenami osobistymi lub Uwierzytelnianiem OA 2. 0, aby zasilać dostosowane automatyzacje i integracje.

- Zautomatyzuj swoją pracę: używaj wyzwalaczy, takich jak przypisywanie właścicieli, aktualizowanie statusów lub rozpoczynanie przekazywania zadań w oparciu o zmiany w zadaniach dzięki automatyzacji ClickUp.

Ograniczenia ClickUp

- Ze względu na szeroki zakres funkcji niektórzy użytkownicy mogą napotkać trudności związane z nauką obsługi.

Ceny ClickUp

Oceny i recenzje ClickUp

- G2: 4,7/5 (ponad 10 000 recenzji)

- Capterra: 4,6/5 (ponad 4000 recenzji)

Co użytkownicy mówią o ClickUp w praktyce?

Recenzent G2 pisze:

Tablice Agile, integracje i personalizacja. Podoba mi się również to, że mogę po prostu przejść w tryb offline i nadal pracować nad zadaniami. Dodatkowo mogę wysyłać e-maile do dowolnej listy i automatycznie tworzyć zadania. Redaktor tekstu jest fantastyczny, działa zarówno w trybie MD, jak i za pomocą skrótów, umożliwiając podgląd zawartości w linii.

Płyty Agile, integracje i personalizacja. Podoba mi się również to, że mogę po prostu przejść w tryb offline i nadal pracować nad zadaniami. Dodatkowo mogę wysyłać e-maile na dowolną listę i automatycznie tworzyć zadania. Redaktor tekstu jest fantastyczny, działa zarówno w trybie MD, jak i za pomocą skrótów, umożliwiając podgląd zawartości w linii.

2. GPT4All (najlepszy do prywatnych, offline'owych rozmów z lokalnymi modelami LLM)

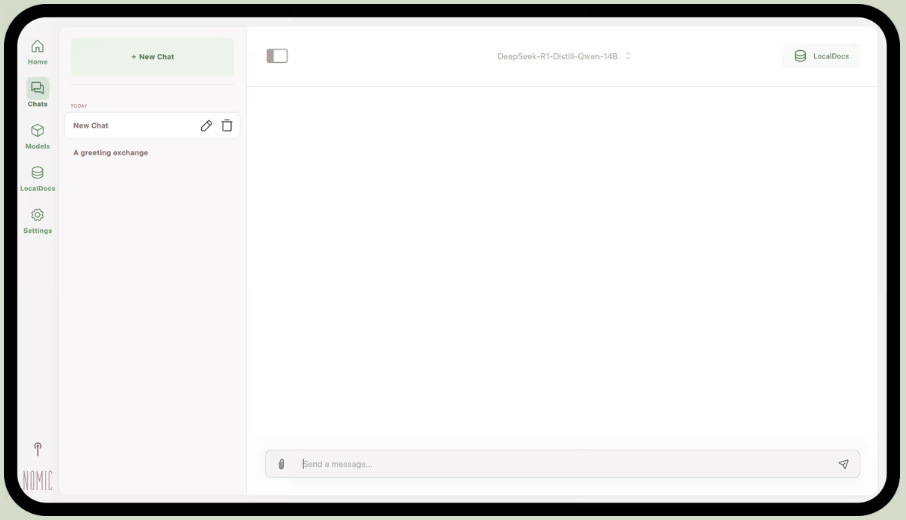

GPT4All, część Nomic.ai, to aplikacja komputerowa, która umożliwia uruchamianie otwartych modeli językowych bezpośrednio na komputerze, dzięki czemu można rozmawiać z asystentem AI bez konieczności korzystania z internetu lub wywoływania interfejsów API w chmurze. Jest przeznaczona dla osób, które preferują ustawienia „local-first”, w których podpowiedzi, odpowiedzi i pliki pozostają na urządzeniu.

Jego najlepszą funkcją jest LocalDocs, która wykorzystuje formę generowania wspomaganego wyszukiwaniem, aby umożliwić prywatną rozmowę z własnymi dokumentami. Można wskazać aplikacji folder z plikami PDF lub tekstowymi, a ona utworzy lokalną bazę wiedzy, do której można kierować pytania.

GPT4All zawiera również wyselekcjonowaną bibliotekę popularnych modeli, takich jak Llama i Mistral, które można pobrać bezpośrednio za pośrednictwem aplikacji.

Najlepsze funkcje GPT4All

- Uruchom lokalny serwer API (kompatybilny z OpenAI), aby korzystać z modeli GPT4All w innych aplikacjach i automatyzacjach.

- Wyszukuj, porównuj i pobieraj modele GGUF z poziomu aplikacji, korzystając z opcji sortowania według polubień, pobrań i daty dodania.

- Dostosuj długość kontekstu, maksymalną długość wyjściową, top-p, top-k, karę za powtórzenia, wątki procesora, a nawet odciążanie warstwy GPU (plus wsparcie Metal na Apple Silicon).

Ograniczenia GPT4All

- Wydajność w dużym stopniu zależy od sprzętu komputerowego.

- Indeksowanie dużych zbiorów dokumentów może przebiegać powoli.

Ceny GPT4All

- Bezpłatna aplikacja komputerowa

- Business: 40 USD miesięcznie za użytkownika (Nomic AI/AI)

- Enterprise: Niestandardowe ceny (Nomic AI)

Oceny i recenzje GPT4All

- G2: Za mało recenzji

- Capterra: Za mało recenzji

Co użytkownicy mówią o GPT4All w praktyce?

Użytkownik serwisu Reddit pisze:

To najlepsze rozwiązanie, jakie wypróbowałem z RAG, przewyższa Wszystko, a nawet LM Studio pod względem prostoty. Podoba mi się sposób mapowania do folderu oraz śledzenie i obsługa zmian. Podobnie jak pozostałe rozwiązania, jest ono wciąż na wczesnym etapie rozwoju, ale w najbliższym czasie będzie moim domyślnym wyborem.

To najlepsze rozwiązanie, jakie wypróbowałem z RAG, przewyższa wszystko inne, a nawet LM Studio pod względem prostoty. Podoba mi się sposób, w jaki można je przypisać do folderu, a ono śledzi i obsługuje zmiany za użytkownika. Podobnie jak pozostałe rozwiązania, jest jeszcze na wczesnym etapie rozwoju, ale w najbliższym czasie będzie moim domyślnym wyborem.

📮 ClickUp Insight: 88% respondentów naszej ankiety korzysta z AI do zadań osobistych, ale ponad 50% unika jej używania w pracy. Trzy główne przeszkody? Brak płynnej integracji, braki w wiedzy lub obawy dotyczące bezpieczeństwa. Ale co, jeśli AI jest wbudowana w Twój obszar roboczy i jest już bezpieczna? ClickUp Brain,

Wbudowany asystent AI ClickUp sprawia, że staje się to rzeczywistością. Rozumie on podpowiedzi w prostym języku, rozwiązując wszystkie trzy problemy związane z wdrażaniem AI, jednocześnie zapewniając połączenie między czatem, zadaniami, dokumentami i wiedzą w całym obszarze roboczym. Znajdź odpowiedzi i spostrzeżenia za pomocą jednego kliknięcia!

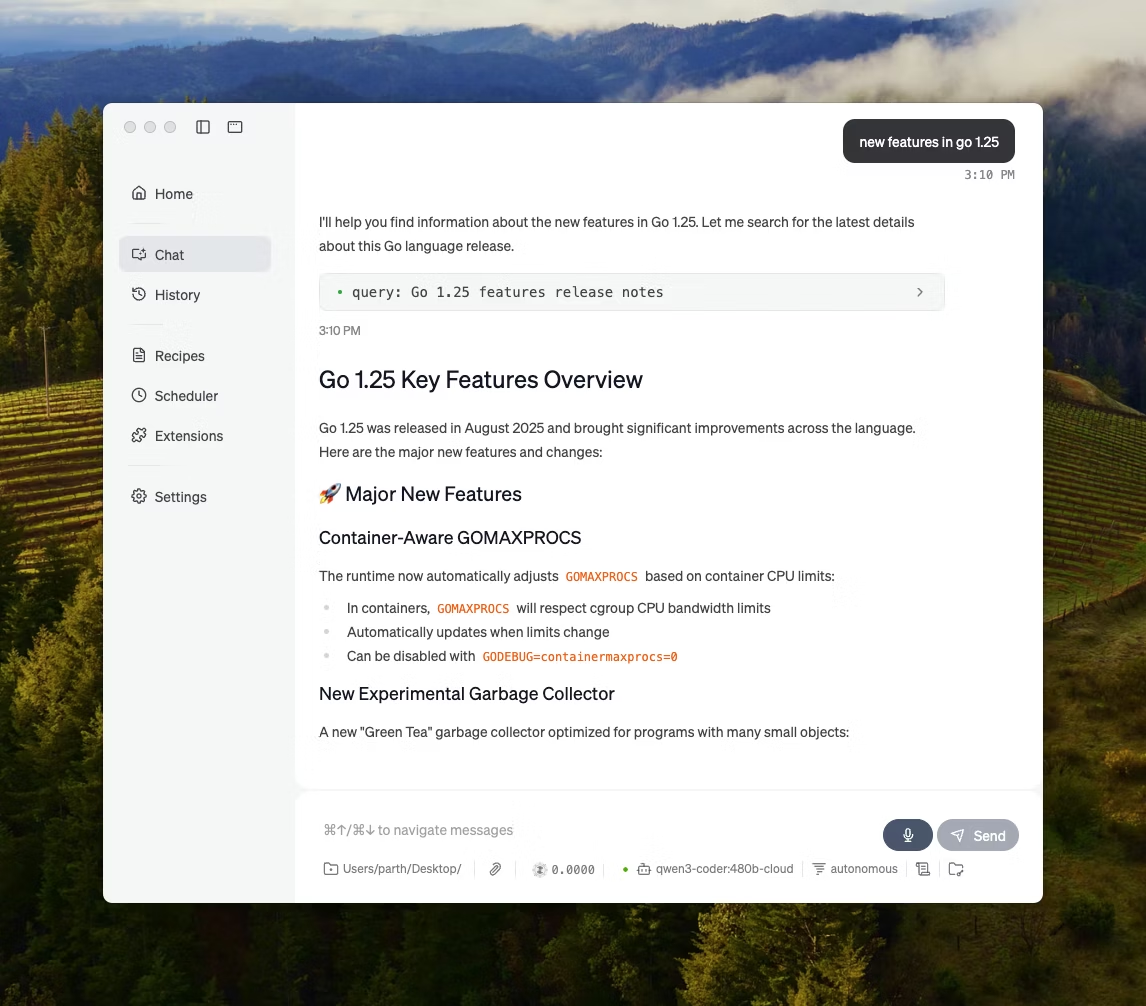

3. LM Studio (najlepsze rozwiązanie dla dopracowanego środowiska pracy offline z możliwością dostosowania wydajności)

za pośrednictwem LM Studio

LM Studio to lokalna aplikacja komputerowa oparta na AI, służąca do wyszukiwania, testowania i uruchamiania modeli open source w interfejsie użytkownika bez konieczności korzystania z terminala. Jest przeznaczona do eksperymentów, takich jak wybór modelu, uruchamianie go lokalnie oraz iterowanie podpowiedzi i ustawień z bardziej ścisłą pętlą sprzężenia zwrotnego niż w przypadku większości ustawień opartych na interfejsie CLI.

Oferuje również wsparcie dla czatowania z dokumentami całkowicie w trybie offline (lokalny RAG), gdzie do rozmowy można dołączać załączniki i odwoływać się do nich podczas udzielania odpowiedzi. Dzięki temu idealnie nadaje się do badań offline, notatek studyjnych lub wewnętrznych cykli pracy związanych z dokumentami, gdzie przesyłanie plików nie jest możliwe.

LM Studio zapewnia również szczegółową kontrolę nad działaniem AI, oferując opcje dostosowania temperatury, długości kontekstu i wykorzystania procesora graficznego.

Najlepsze funkcje LM Studio

- Użyj trybu zgodności OpenAI lub własnego interfejsu API REST LM Studio, w zależności od wymagań Twojej aplikacji.

- LM Studio oferuje zarówno JavaScript, jak i Python SDK do tworzenia lokalnych cykli pracy na podstawie Twoich modeli.

- Zapisz monit systemowy + parametry jako ustawienie wstępne, a następnie używaj go ponownie w czatach (ustawienia wstępne można również importować z pliku/URL i publikować w celu udostępnienia za pośrednictwem LM Studio Hub).

Ograniczenia LM Studio

- LM Studio może spowodować zawieszenie komputera podczas działania DeepSeek R1 32B.

- Niektórzy użytkownicy zgłaszają aplikację jako zagrożenie dla bezpieczeństwa danych i prywatności ze względu na nieaudytowany kod źródłowy typu closed-source.

Cennik LM Studio

- Bezpłatny do użytku domowego i służbowego

Oceny i recenzje LM Studio

- G2: Za mało recenzji

- Capterra: Za mało recenzji

Co mówią o LM Studio prawdziwi użytkownicy?

Użytkownik serwisu Reddit pisze:

Jest świetny. Po prostu działa, bardzo łatwo go uruchomić i zacząć korzystać. Ma najładniejszy interfejs użytkownika spośród wszystkich konkurentów.

Jest świetny. Po prostu działa, bardzo łatwo go uruchomić i zacząć korzystać. Ma najładniejszy interfejs użytkownika spośród wszystkich konkurentów.

4. Ollama (najlepsze rozwiązanie do uruchamiania lokalnych modeli LLM za pomocą prostego interfejsu CLI + lokalnego serwera)

Ollama to lokalny model runner, który działa bardziej jak środowisko uruchomieniowe LLM niż samodzielna aplikacja do czatu. Jest to rozwiązanie typu „terminal-first”, zaprojektowane do pobierania i uruchamiania otwartych modeli za pomocą szybkich komend (np. ollama run llama3), a następnie udostępniania ich za pośrednictwem lokalnej usługi, na której mogą działać inne interfejsy.

Siła Ollamy tkwi w jej interfejsie API REST. Gdy Ollama działa w tle, każda aplikacja może się z nią komunikować za pomocą prostych żądań HTTP. Pomaga to wbudować funkcje AI w Twoje własne oprogramowanie.

Ollama oferuje również bibliotekę popularnych modeli, które można pobrać za pomocą jednej komendy, a także umożliwia tworzenie niestandardowych konfiguracji modeli, które są podobne do plików Dockerfile dla AI.

Najlepsze funkcje Ollamy

- Twórz wielokrotnego użytku, wersjonowalne przepisy modelowe (wybór modelu bazowego, szablony podpowiedzi, komunikaty systemowe, parametry, adaptery) przy użyciu pliku Modelfile.

- Uruchamiaj modele poprzez punkty końcowe, takie jak czat/generowanie, z opcjonalnym strumieniowaniem w celu uzyskania tokenów w czasie rzeczywistym w aplikacjach i skryptach.

- Generuj osadzenia dla semantycznych procesów wyszukiwania i pobierania danych, korzystając z funkcji osadzania Ollama i zalecanych modeli osadzania.

Ollama limits

- Nie posiada wbudowanego interfejsu graficznego, więc użytkownicy bez wiedzy technicznej będą potrzebowali oddzielnego narzędzia frontendowego.

- Aplikacja komputerowa Ollama dla systemu macOS może przestać odpowiadać w trybie offline, nawet jeśli modele zostały już pobrane, podczas gdy interfejs CLI nadal działa.

Ceny Ollama

- Free

- Pro: 20 USD miesięcznie

- Maksymalnie: 100 USD miesięcznie

Oceny i recenzje Ollama

- G2: Za mało recenzji

- Capterra: Za mało recenzji

Co prawdziwi użytkownicy mówią o Ollama?

Recenzent serwisu Producthunt pisze:

Łatwe wdrożenie i zarządzanie. Ollama sprawia, że uruchamianie lokalnych modeli LLM jest niezwykle proste. Połącz je z OpenWebUI, aby uzyskać najlepsze wrażenia.

Łatwe wdrożenie i zarządzanie. Ollama sprawia, że uruchamianie lokalnych modeli LLM jest niezwykle proste. Połącz je z OpenWebUI, aby uzyskać najlepsze wrażenia.

🧠 Ciekawostka: Funkcja zamiany mowy na tekst początkowo rozpoznawała wyłącznie cyfry. System AUDREY (1952) opracowany przez Bell Labs rozpoznawał cyfry od 0 do 9, a w notatce napisano, że najlepiej działał, gdy mówił jego wynalazca.

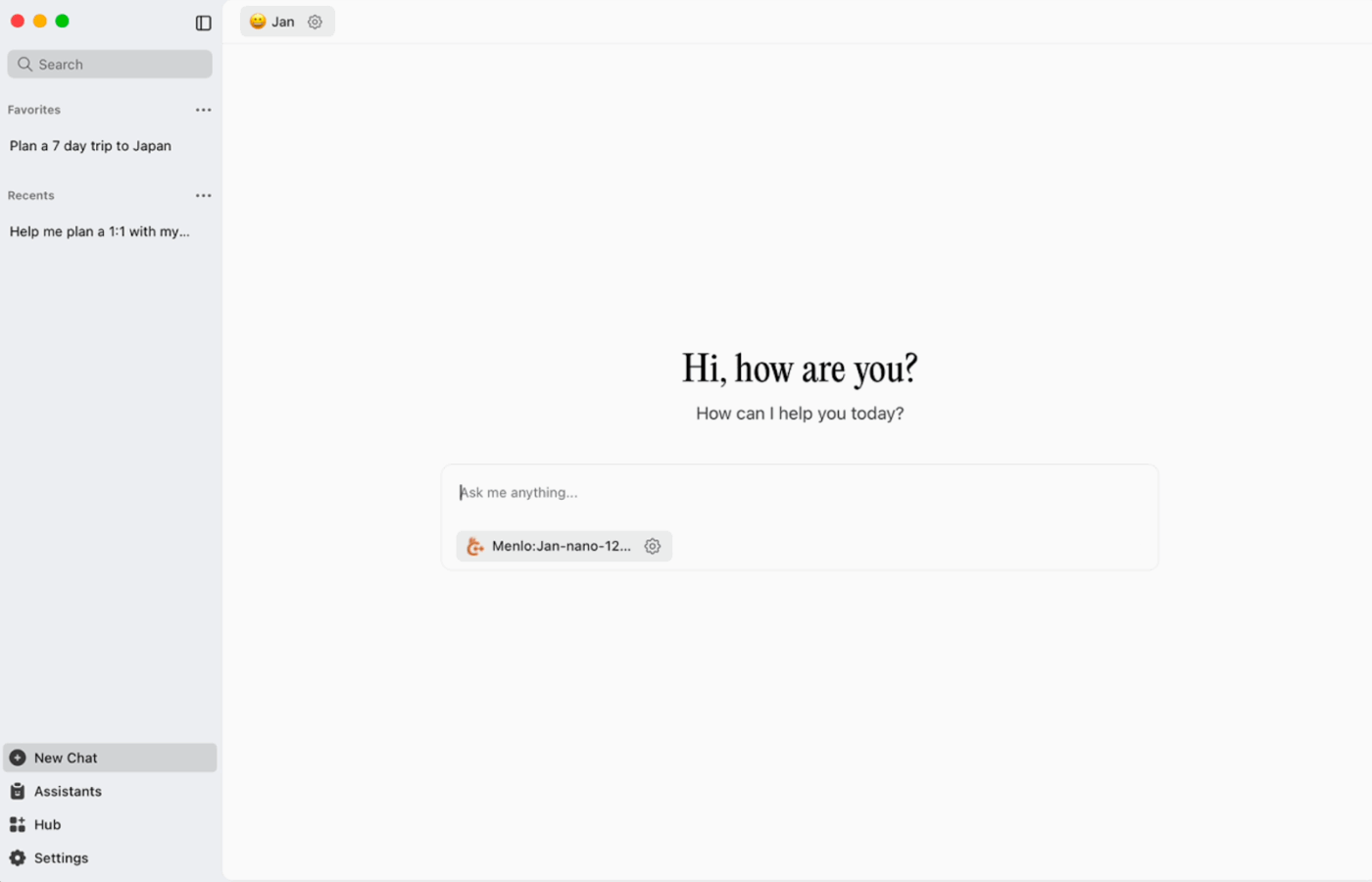

5. Jan. ai (najlepszy dla asystenta offline typu ChatGPT, który stawia prywatność na pierwszym miejscu)

Jan. ai to otwartoźródłowy asystent komputerowy, który zapewnia funkcję czatu podobną do ChatGPT w systemach macOS, Windows i Linux, z domyślnym ustawieniem lokalnego pierwszeństwa. Działa na urządzeniu wtedy, kiedy tego chcesz, a historia rozmów i dane dotyczące użytkowania są przechowywane lokalnie i nie opuszczają komputera.

Oferuje wsparcie dla lokalnego uruchamiania modeli open source, a także umożliwia opcjonalne połączenia ze zdalnymi dostawcami, takimi jak API zgodne z OpenAI, co zapewnia elastyczność, gdy priorytetem jest korzystanie w trybie offline, ale czasami potrzebny jest dostęp do chmury.

Najlepsze funkcje Jan. ai

- Twórz asystentów z własnymi instrukcjami i ustawieniami, a następnie przełączaj się między nimi w zakładce Asystenci, zamiast za każdym razem przepisywać podpowiedzi.

- Połącz Jan z narzędziami MCP i źródłami danych przy użyciu otwartego standardu stworzonego z myślą o cyklach pracy opartych na narzędziach.

- Zainstaluj rozszerzenia, aby dodać nowe funkcje, takie jak wyszukiwanie w Internecie lub interpreter kodu. To modułowe podejście pozwala zacząć od prostych rozwiązań i stopniowo zwiększać możliwości.

Ograniczenia AI w styczniu

- Jan może zezwolić na załadowanie pliku modelu, który nie został jeszcze w pełni pobrany, co może powodować niejasne lub niespójne działanie do momentu, kiedy pobieranie pliku będzie zakończone.

- Włączenie API może zakłócać działanie czatów wielowątkowych, a podstawowe punkty końcowe, takie jak „pobierz załadowany model” lub „zamień model”, mogą nie działać płynnie.

Styczeń ai wycena

- Otwarta platforma

Styczeń. Oceny i recenzje AI

- G2: Za mało recenzji

- Capterra: Za mało recenzji

Co użytkownicy mówią o Jan. ai?

Użytkownik serwisu Reddit pisze:

Jan. ai to moja ulubiona lokalna aplikacja LLM. Jest świetna.

Jan. ai to moja ulubiona lokalna aplikacja LLM. Jest świetna.

6. Llamafile (najlepszy do pakowania LLM do przenośnego pliku wykonywalnego)

Llamafile to projekt prowadzony przez Mozillę, który łączy w jednym pliku wykonywalnym pełny open-source LLM. Zamiast instalować środowisko uruchomieniowe, zarządzać zależnościami lub podłączać oddzielny interfejs użytkownika, wystarczy pobrać jeden plik i uruchomić go jak aplikację.

Główną ideą jest dystrybucja. Plik „llamafile” zawiera wagi modelu oraz skompilowane środowisko uruchomieniowe, stworzone z myślą o działaniu w wielu systemach operacyjnych przy minimalnych ustawieniach. Jest to szczególnie przydatne, gdy narzędzie offline musi być udostępnione współpracownikom, studentom lub klientom, którzy nie będą zajmować się rozwiązywaniem problemów związanych z instalacją.

Najlepsze funkcje Llamafile

- Llamafile łączy llama.cpp z Cosmopolitan Libc, aby zapewnić wsparcie dla szerokiej przenośności plików binarnych, ograniczając prace związane z pakowaniem specyficznym dla platformy.

- Tryb serwera zapewnia graficzny interfejs użytkownika oraz punkt końcowy uzupełnień zgodny z OpenAI API, przydatny do lokalnego tworzenia aplikacji i zamiany wywołań chmury podczas testowania.

- Pakiety llamafiles są zaprojektowane do działania na popularnych komputerach x86_64 i ARM64, co ułatwia dystrybucję w mieszanych flotach.

Ograniczenia Llamafile

- Wybór modelu ma limit i obejmuje tylko to, co zostało spakowane jako plik Llamafile.

- Rozmiary plików są bardzo duże, ponieważ cały model jest osadzony.

Ceny Llamafile

- Bezpłatny i otwarty

Oceny i recenzje Llamafile

- G2: Za mało recenzji

- Capterra: Za mało recenzji

🧠 Ciekawostka: Pierwsza strona internetowa jest nadal dostępna. CERN hostuje ją pod adresem info.cern.ch, nazywając ją „stroną główną pierwszej strony internetowej”.

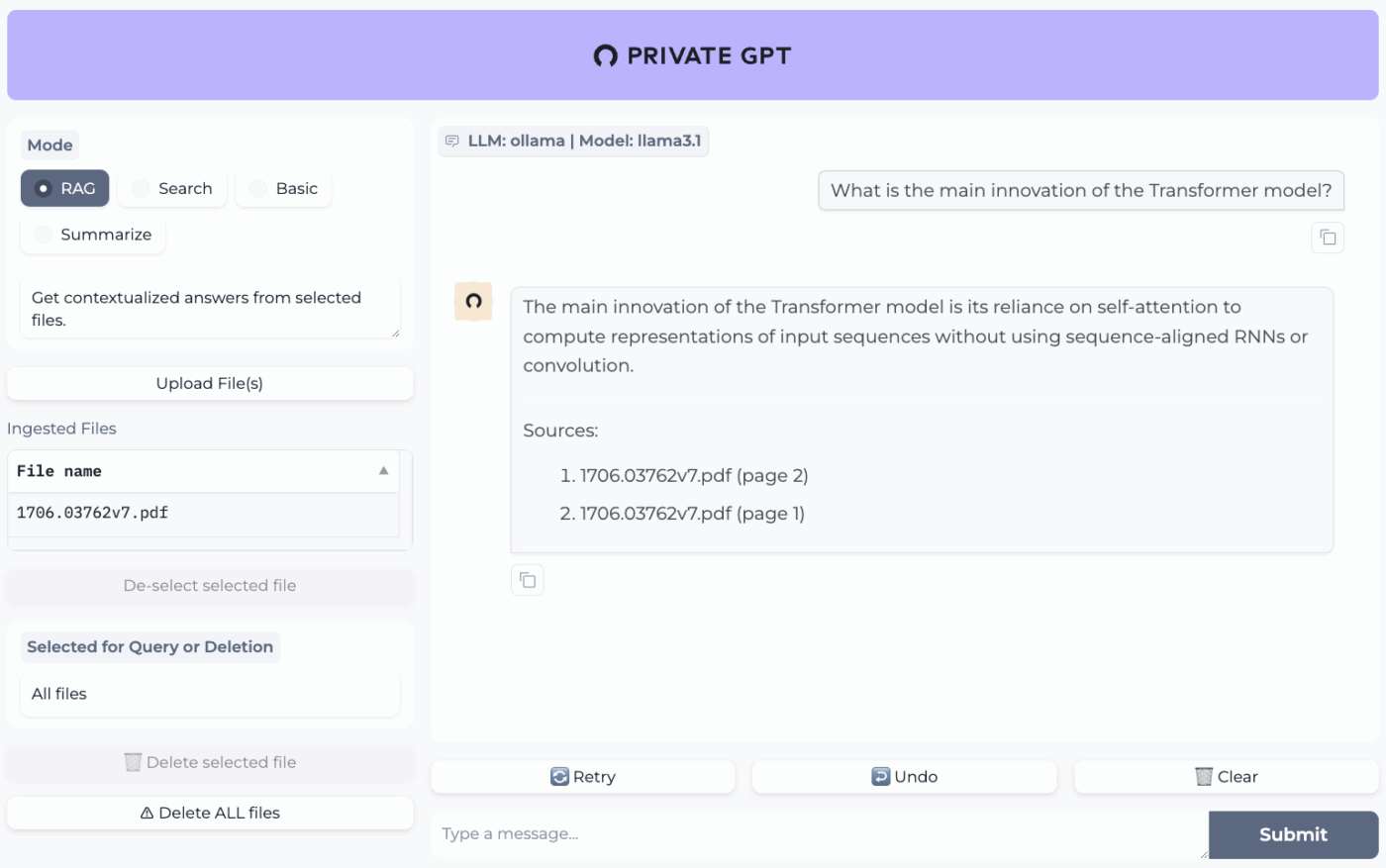

7. PrivateGPT (najlepsze rozwiązanie do offline'owych pytań i odpowiedzi dotyczących plików z własnym stosem RAG)

PrivateGPT to gotowy do użycia, samodzielnie hostowany projekt stworzony z myślą o cyklu pracy typu „czatuj ze swoimi dokumentami”. Pobiera on lokalne pliki, indeksuje je i odpowiada na pytania, pobierając odpowiedni kontekst z własnej zawartości, zamiast polegać na pamięci chatbota w chmurze. Projekt został zaprojektowany tak, aby działał całkowicie w trybie offline, z zapewnieniem, że dane pozostają w środowisku wykonawczym użytkownika.

To, co odróżnia tę aplikację od ogólnych aplikacji do czatu offline, to architektura modułowa. Innymi słowy, można łączyć i dopasowywać LLM, dostawcę osadzeń i magazyn wektorów w oparciu o ograniczenia sprzętowe i prywatności, a następnie uruchamiać wszystko za pomocą lokalnego API + UI.

Najlepsze funkcje PrivateGPT

- Pobieraj pliki PDF, DOCX, PPT/PPTX/PPTM, CSV, EPUB, Markdown, JSON, MBOX, IPYNB, obrazy (JPG/PNG/JPEG), a nawet MP3/MP4 za pomocą wbudowanego potoku pobierania.

- Konfiguruj profile warstw za pomocą PGPT_PROFILES (na przykład local,cuda), aby połączyć wiele plików ustawień i przełączać wdrożenia bez konieczności przepisywania podstawowej konfiguracji.

- Filtruj odpowiedzi dla określonego podzbioru pobranych dokumentów za pomocą context_filter podczas wywoływania punktów końcowych uzupełnień kontekstowych.

Ograniczenia PrivateGPT

- Ma wyższe wymagania sprzętowe ze względu na jednoczesne uruchamianie wielu komponentów.

- Pobieranie wielu dokumentów z jednego pliku (na przykład jeden plik PDF generujący jeden dokument na stronę) może zwiększyć objętość indeksowania i złożoność podczas zarządzania dużymi plikami przesyłanymi do serwisu.

Ceny PrivateGPT

- Otwarta platforma

Oceny i recenzje PrivateGPT

- G2: Za mało recenzji

- Capterra: Za mało recenzji

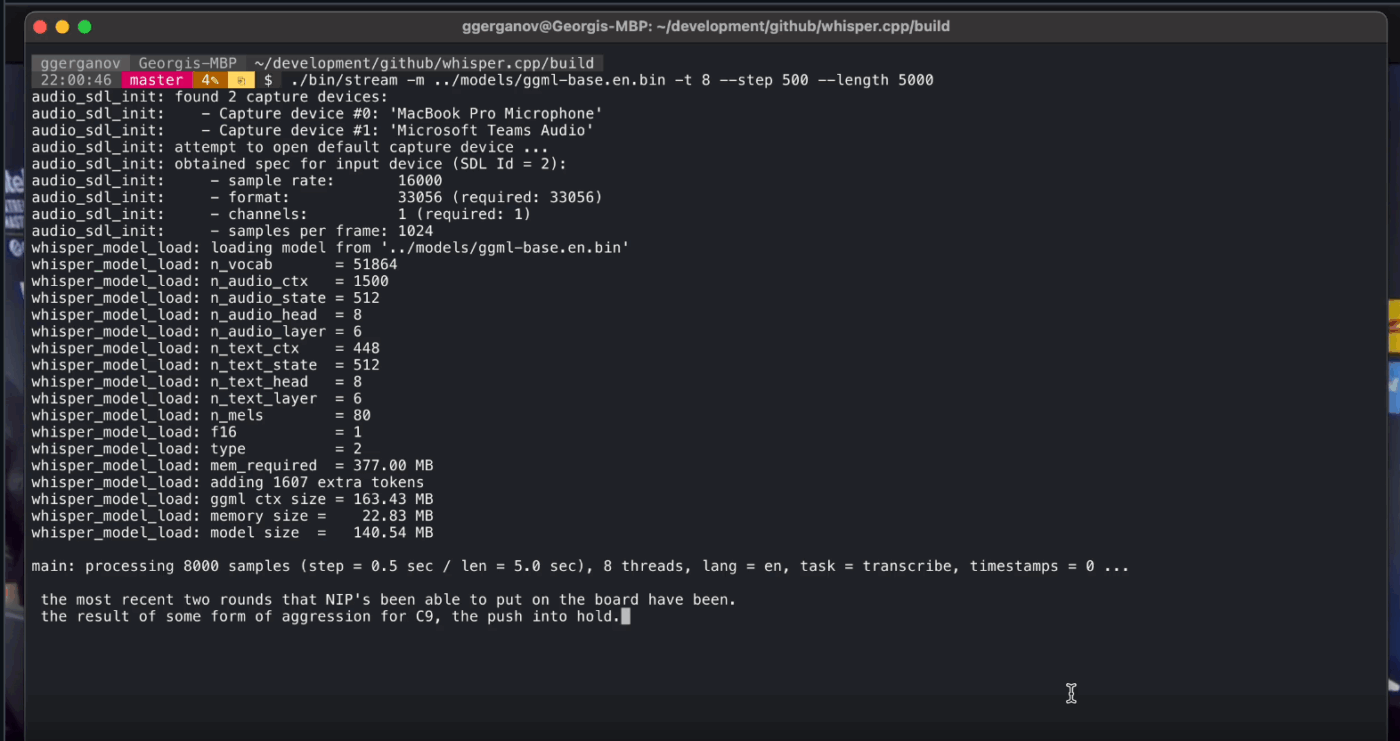

8. Whisper. cpp (najlepszy do całkowicie offline'owego zamiany mowy na tekst, który można osadzić w aplikacjach)

Whisper. cpp to wysokowydajna implementacja modelu automatycznego rozpoznawania mowy Whisper firmy OpenAI w języku C/C++, stworzona z myślą o lokalnym działaniu bez dużych zależności środowiskowych. Jest popularna w przypadku offline'owych procesów transkrypcji, gdzie potrzebny jest mały, przenośny plik binarny lub biblioteka w stylu C, którą można dołączyć do własnego produktu.

Jest również elastyczny w różnych środowiskach, a oficjalne wsparcie obejmuje komputery stacjonarne, urządzenia mobilne, WebAssembly, Docker, a nawet sprzęt klasy Raspberry Pi, co sprawia, że nadaje się do narzędzi offline, które muszą działać w więcej niż jednym miejscu.

Skrót „cpp” w nazwie oznacza, że program skupia się na wydajności. Ta implementacja jest znacznie szybsza i zużywa mniej pamięci niż alternatywne rozwiązania oparte na języku Python, umożliwiając transkrypcję w czasie rzeczywistym na nowoczesnych komputerach bez konieczności stosowania wydajnej karty graficznej.

Whisper. Najlepsze funkcje cpp

- Uruchom funkcję wykrywania aktywności głosowej (VAD) w ramach projektu, aby segmentować mowę i ograniczyć ilość transkrypcji zawierających szumy i puste fragmenty audio w cyklach pracy typu streaming.

- Kwantyzuj modele Whisper, aby zmniejszyć wymagania dotyczące dysku i pamięci, dzięki wielu opcjom kwantyzacji zaprojektowanym z myślą o szybszym lokalnym wnioskowaniu.

- Skompiluj z opcjonalnym wsparciem FFmpeg w systemie Linux, aby obsługiwać więcej formatów wejściowych poza podstawową ścieżką tylko dla plików WAV.

Ograniczenia Whisper.cpp

- Whisper. cpp CLI domyślnie oczekuje 16-bitowych plików WAV, co powoduje konieczność wykonania dodatkowego kroku konwersji podczas pracy z plikami MP3, MP4, M4A lub innymi popularnymi formatami.

- Nie przyczepia on natywnie mówców (diaryzacja), co utrudnia prawidłowe przypisanie cytatów w nagraniach z wieloma mówcami.

Whisper. Ceny cpp

- Otwarta platforma

Whisper. cpp oceny i recenzje

- G2: Za mało recenzji

- Capterra: Za mało recenzji

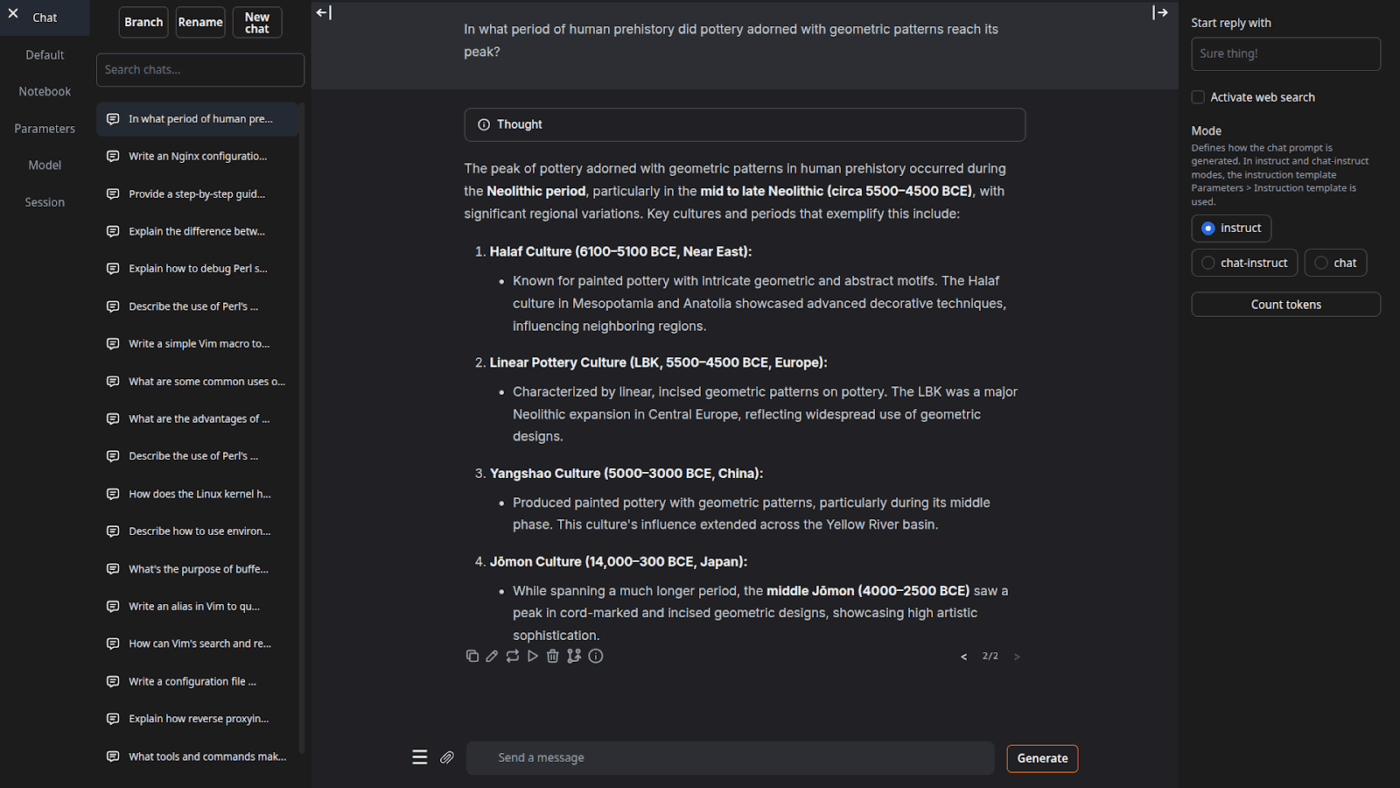

9. Interfejs użytkownika do generowania tekstu (najlepszy dla użytkowników, którzy chcą mieć przeglądarkowy kokpit dla lokalnych modeli LLM)

Text Generation Web UI (często nazywane „oobabooga”) to interfejs internetowy oparty na Gradio, służący do uruchamiania lokalnych modeli, kładący duży nacisk na kontrolę i eksperymentowanie. Działa on bardziej jak pełnoprawne stanowisko robocze: wiele backendów modeli, wiele trybów interakcji i wiele pokręteł do sterowania zachowaniem generowania.

Wykorzystuje również cykle pracy „pisarza/programisty”, które wiele narzędzi offline pomija, oferując takie funkcje, jak automatyzacja formatowania podpowiedzi, generowanie w stylu notatnika i rozgałęzianie rozmów. W przypadku ustawień offline, które nadal wymagają interfejsu użytkownika sieci Web, jest to jeden z najbardziej konfigurowalnych interfejsów użytkownika w tej kategorii.

Najlepsze funkcje interfejsu użytkownika do generowania tekstu

- Automatyczne formatowanie podpowiedzi przy użyciu szablonów Jinja2, co zmniejsza liczbę błędów w formatowaniu podpowiedzi w różnych rodzinach modeli.

- Dostosuj dziesiątki ustawień, aby precyzyjnie dostosować wyniki działania AI do swoich konkretnych potrzeb, niezależnie od tego, czy chodzi o kreatywne pisanie, kodowanie czy odgrywanie ról.

- Edycja wiadomości z nawigacją po wersjach i rozgałęzieniami rozmów, zachowująca wiele kierunków tej samej rozmowy bez konieczności rozpoczynania jej od nowa.

Limity interfejsu użytkownika generowania tekstu

- Instalator jednoklikowy wymaga około 10 GB przestrzeni na dysku i pobiera PyTorch, co sprawia, że ustawienia wydają się uciążliwe na komputerach o ograniczonej pojemności pamięci.

- Punkt końcowy osadzeń zgodny z OpenAI wykorzystuje sentence-transformers/all-mpnet-base-v2 z osadzeniami 768-wymiarowymi, co może naruszyć założenia w potokach zbudowanych w oparciu o domyślne ustawienia OpenAI 1536-wymiarowe.

Ceny interfejsu użytkownika do generowania tekstu

- Otwarta platforma

Oceny i recenzje interfejsu użytkownika do generowania tekstu

- G2: Za mało recenzji

- Capterra: Za mało recenzji

10. Llama. cpp (najlepszy do wysokowydajnej lokalnej inferencji LLM na procesorach CPU i GPU)

Llama. cpp to silnik wnioskowania C/C++ i zestaw narzędzi do lokalnego uruchamiania modeli LLM przy minimalnych zależnościach i wysokiej wydajności na szerokim zakresie sprzętu. Jest to nie tyle „aplikacja do czatowania”, co raczej lokalne środowisko uruchomieniowe, w którym można budować cykle pracy, niezależnie od tego, czy jest to interfejs CLI, lokalny serwer HTTP, czy biblioteka wbudowana w własny produkt.

Chociaż Llama.cpp nie jest aplikacją dla użytkowników końcowych, stanowi silnik napędzający wiele narzędzi z tej listy, w tym GPT4All i LM Studio. Wprowadził format modelu GGUF, który stał się standardem dla uruchamiania dużych modeli na sprzęcie konsumenckim poprzez efektywne zmniejszenie ich rozmiaru.

Oferuje również powiązania z popularnymi językami programowania, takimi jak Python i Rust, a jego tryb serwera może zapewnić API zgodne z OpenAI.

Najlepsze funkcje Llama. cpp

- Uruchom lokalny serwer zgodny z API OpenAI z wbudowanym interfejsem użytkownika i punktem końcowym /v1/chat/completions przy użyciu llama-server.

- Uruchom model osadzania (a nawet model ponownego rankingu) z tego samego serwera dla offline'owych potoków RAG przy użyciu /embedding i /reranking.

- Kwantyzuj modele do 1,5–8 bitów, aby zmniejszyć zużycie pamięci i przyspieszyć lokalną inferencję, a następnie przyspiesz działanie za pomocą backendów CUDA/Metal oraz Vulkan/SYCL, jeśli są dostępne.

Ograniczenia Llama.cpp

- Llama. cpp nie jest dostarczane jako dopracowany asystent pulpitu, co oznacza, że korzystanie z niego w trybie offline często wymaga użycia komend CLI lub hostingu llama-server, a wielu użytkowników korzysta z interfejsów użytkownika innych firm do codziennego czatowania.

- Kompatybilność Llama.cpp z OpenAI nie zawsze jest identyczna z każdą funkcją klienta OpenAI, a użytkownicy zgłaszają niezgodności dotyczące ustrukturyzowanych parametrów wyjściowych, takich jak response_format w /v1/chat/completions.

Llama. Ceny cpp

- Otwarta platforma

Co użytkownicy mówią o Llama. cpp?

Recenzent Sourceforge pisze:

Wspaniałe. Demokratyzacja AI dla wszystkich. I to działa świetnie!

Wspaniałe. Demokratyzacja AI dla wszystkich. I to działa świetnie!

Zamień wyniki pracy AI w rzeczywiste zadania dzięki ClickUp

Wybór odpowiedniego narzędzia AI offline polega przede wszystkim na dopasowaniu narzędzia do zadania.

Jeśli tu jesteś, prawdopodobnie zależy Ci na trzech rzeczach: prywatności, niezależności od internetu i wolności od kolejnej subskrypcji.

Narzędzia z tej listy spełniają te wymagania na różne sposoby. Oznacza to, że niektóre z nich lepiej nadają się do pisania i kodowania, inne do wyszukiwania, tworzenia notatek lub pracy twórczej.

Jednak dla zespołów większym wyzwaniem jest nie tylko lokalne uruchamianie AI. Chodzi o przekształcenie wyników działania AI w rzeczywiste cykle pracy.

Dzięki funkcji AI ClickUp, wbudowanej w zadania, dokumenty i wiedzę, możesz łatwo wyświetlić kolejne kroki w tym samym miejscu, w którym odbywa się praca (wszystko to przy zachowaniu bezpieczeństwa na poziomie przedsiębiorstwa).

Wypróbuj ClickUp za darmo i zobacz, jak wygląda połączenie AI i realizacji zadań. ✨

Często zadawane pytania dotyczące narzędzi AI offline

Tak, po początkowym pobraniu plików modelu wiele narzędzi AI może działać całkowicie na Twoim urządzeniu bez konieczności połączenia z Internetem. Dzięki temu idealnie nadają się one do obsługi wrażliwych danych lub pracy w lokalizacjach o słabej łączności.

Lokalne modele LLM przetwarzają wszystkie dane na Twoim urządzeniu osobistym, więc Twoje informacje nigdy nie opuszczają Twojego komputera, podczas gdy sztuczna inteligencja oparta na chmurze wysyła Twoje podpowiedzi do zdalnych serwerów w celu przetworzenia. Lokalne narzędzia są zazwyczaj bezpłatne po ustawieniach, podczas gdy sztuczna inteligencja oparta na chmurze często wiąże się z subskrypcjami, ale może oferować bardziej zaawansowane modele.

Mniejsze modele z 1–3 miliardami parametrów mogą działać na większości nowoczesnych laptopów z 8 GB pamięci RAM. Większe, bardziej wydajne modele z 7 miliardami lub więcej parametrami działają najlepiej z 16 GB lub więcej pamięci RAM i dedykowanym procesorem graficznym, a komputery Apple Silicon Mac i procesory graficzne NVIDIA zapewniają znaczny wzrost wydajności.

![10 najlepszych narzędzi AI, które działają w trybie offline w [roku]](https://clickup.com/blog/wp-content/uploads/2026/01/image-1298.png)