La privacy è un diritto umano fondamentale. E tale privacy riguarda anche tutti gli aspetti dell'intelligenza artificiale odierna. In un rapporto di Cisco, il 64% delle persone teme di poter effettuare accidentalmente una condivisione di informazioni sensibili quando utilizza strumenti di IA.

Questo è uno dei motivi per cui gli strumenti di IA offline stanno diventando sempre più popolari. Quando il modello viene eseguito localmente, è possibile scrivere, creare codice, riepilogare e creare senza dover caricare tutto sul cloud o rimanere bloccati in caso di interruzione del Wi-Fi.

In questo elenco tratteremo i migliori strumenti di IA che funzionano offline, tra cui una super app che ti aiuta a organizzare ciò che questi strumenti producono in un unico sistema coeso e super sicuro.

Cosa sono gli strumenti di IA offline?

Gli strumenti di IA offline sono applicazioni software che eseguono modelli linguistici di grandi dimensioni (LLM) sul dispositivo locale, senza necessità di connessione a Internet dopo aver scaricato il modello. I dati del modello vengono memorizzati direttamente sul computer, quindi tutta l'elaborazione, o inferenza, avviene sulla propria CPU o GPU.

Questa elaborazione sul dispositivo presenta diversi vantaggi chiave:

- Privacy dei dati completa: le tue informazioni sensibili non lasciano mai il tuo computer

- Nessun costo ricorrente: una volta acquistati lo strumento e il modello, non sono previsti costi di sottoscrizione.

- Funziona ovunque: puoi utilizzarlo in aereo, in una baita isolata o durante un'interruzione della connessione Internet.

- Controllo totale: scegli tu quali modelli utilizzare e come configurarli

I migliori strumenti di IA offline in sintesi

Ecco un breve riassunto dei migliori strumenti di IA offline disponibili oggi.

| Nome dello strumento | Funzionalità principali | Ideale per | Prezzi* |

| ClickUp | Modalità offline per attività e promemoria, ClickUp Brain MAX che include Talk-to-Text, ricerca aziendale tra app collegate, gestione di documenti e conoscenze, automazioni, integrazioni e API. | Teams che necessitano di acquisizione offline più esecuzione online, governance e contesto IA in un unico spazio di lavoro | Gratis per sempre; personalizzazione disponibile per le aziende |

| GPT4All | Chat locale con modelli aperti, LocalDocs per domande e risposte su documenti privati, ricerca e scaricamento di modelli nell'app, server API locale compatibile con OpenAI. | Utenti attenti alla privacy che desiderano un chatbot desktop offline semplice con documenti locali | Piano Free disponibile; piani a pagamento a partire da 40 $/utente/mese |

| LM Studio | Ricerca e scaricamento di modelli, interfaccia utente chat più RAG locale, server compatibile con OpenAI o API REST, preimpostazioni e ottimizzazione delle prestazioni | Sviluppatori e utenti esperti che desiderano un ambiente di lavoro offline perfezionato | Free |

| Ollama | Un modello di comando, API REST locale con streaming, file modello per configurazioni riutilizzabili e incorporamenti per pipeline RAG. | Sviluppatori che desiderano un runtime locale CLI-first con un solido livello API | Piano Free disponibile; piani a pagamento a partire da 20 $ al mese |

| Gennaio ai | Interfaccia utente offline in stile ChatGPT, assistenti e supporto MCP, estensioni per funzionalità aggiuntive e provider opzionali compatibili con OpenAI. | Utenti non tecnici che desiderano un assistente offline pulito e personalizzato | Gratis e open source |

| Llamafile | Modello eseguibile singolo, distribuzione portatile su diversi sistemi operativi, modalità server locale con interfaccia utente web e API, runtime con dipendenze minime. | Utenti che desiderano un file IA portatile che non richiede installazione e che può essere eseguito ovunque | Gratis e open source |

| PrivateGPT | Acquisizione e indice dei documenti self-hosted, domande e risposte RAG offline, filtraggio contestuale per documento, LLM modulare e stack di archiviazione vettoriale. | Teams che necessitano di domande e risposte offline su file interni con una pipeline RAG controllabile | Gratis e open source |

| Whisper. cpp | Conversione locale da voce a testo, modelli quantizzati per un minor utilizzo delle risorse, supporto VAD, gestione FFmpeg opzionale per più formati | Utenti che necessitano di una trascrizione completamente offline da poter incorporare nelle app | Gratis e open source |

| Interfaccia utente web per la generazione di testo | Interfaccia utente basata su browser per modelli locali, modelli di prompt Jinja2, controlli di generazione, ramificazione della chat e modifica dei messaggi | Utenti che desiderano una personalizzazione massima in un'interfaccia web locale | Gratis e open source |

| llama.cpp | Motore di inferenza ad alte prestazioni, ampio supporto alla quantizzazione, server locale con endpoint in stile OpenAI, incorporamenti e supporto al riclassificamento. | Sviluppatori che realizzano app o backend IA offline personalizzati | Gratis e open source |

Come valutiamo i software su ClickUp

Il nostro team editoriale segue un processo trasparente, supportato da ricerche e indipendente dai fornitori, quindi puoi fidarti che i nostri consigli si basano sul valore reale dei prodotti.

Ecco una panoramica dettagliata di come valutiamo i software su ClickUp.

Cosa cercare nei migliori strumenti di IA che funzionano offline

Valutare gli strumenti di IA offline può sembrare un compito tecnico e complicato, che potrebbe portarti a scegliere uno strumento che potrebbe non funzionare sul tuo computer. La cosa più importante da considerare è ciò che desideri ottenere. Uno sviluppatore che crea un'app basata sull'IA ha esigenze molto diverse rispetto a chi desidera semplicemente un chatbot privato e offline basato sull'IA che lo assista nella scrittura.

Ecco i criteri chiave da valutare:

- Facilità di configurazione: richiede conoscenze tecniche e l'uso della riga di comando o è sufficiente un semplice clic per installarlo?

- Selezione dei modelli: è possibile scegliere facilmente tra un'ampia gamma di modelli o si è limitati a pochi modelli?

- Garanzie sulla privacy: lo strumento elabora tutti i dati localmente o ci sono componenti cloud nascosti?

- Requisiti hardware: funzionerà bene sul tuo computer attuale o è necessario un aggiornamento?

- Capacità di integrazione: è in grado di effettuare la connessione agli altri strumenti in uso o è un'applicazione completamente autonoma?

- Adeguatezza all'uso previsto: è progettato per chattare genericamente, porre domande sui documenti, effettuare la trascrizione di audio o generare codice?

I 10 migliori strumenti di IA che funzionano offline

Ecco una vista dettagliata dei migliori strumenti offline di IA 👇

1. ClickUp (ideale per conservare attività, documenti e contesto IA in un unico posto sia per il lavoro offline che online)

ClickUp, il primo spazio di lavoro AI convergente al mondo, è basato su blocchi di "AI offline" che non si limitano a generare una risposta. Questo perché è comunque necessario un luogo in cui tale output diventi una decisione, un'attività e un passaggio successivo che non scompaia tra file e chat.

A differenza di molte configurazioni offline che richiedono lunghe installazioni e l'integrazione di diversi strumenti, ClickUp offre un livello di esecuzione completo in un unico posto, con l'intelligenza artificiale che opera all'interno dello stesso contesto di lavoro.

Per cominciare, c'è la modalità offline di ClickUp, che si attiva automaticamente e consente di continuare a lavorare anche quando si è offline. Ciò significa che tutti i tuoi compiti, promemoria e note rimangono accessibili anche offline, con la possibilità di aggiungerne altri se necessario. Una volta ricollegato, i nuovi compiti e promemoria vengono sincronizzati automaticamente con la tua area di lavoro (dì addio alla perdita di contesto 👋).

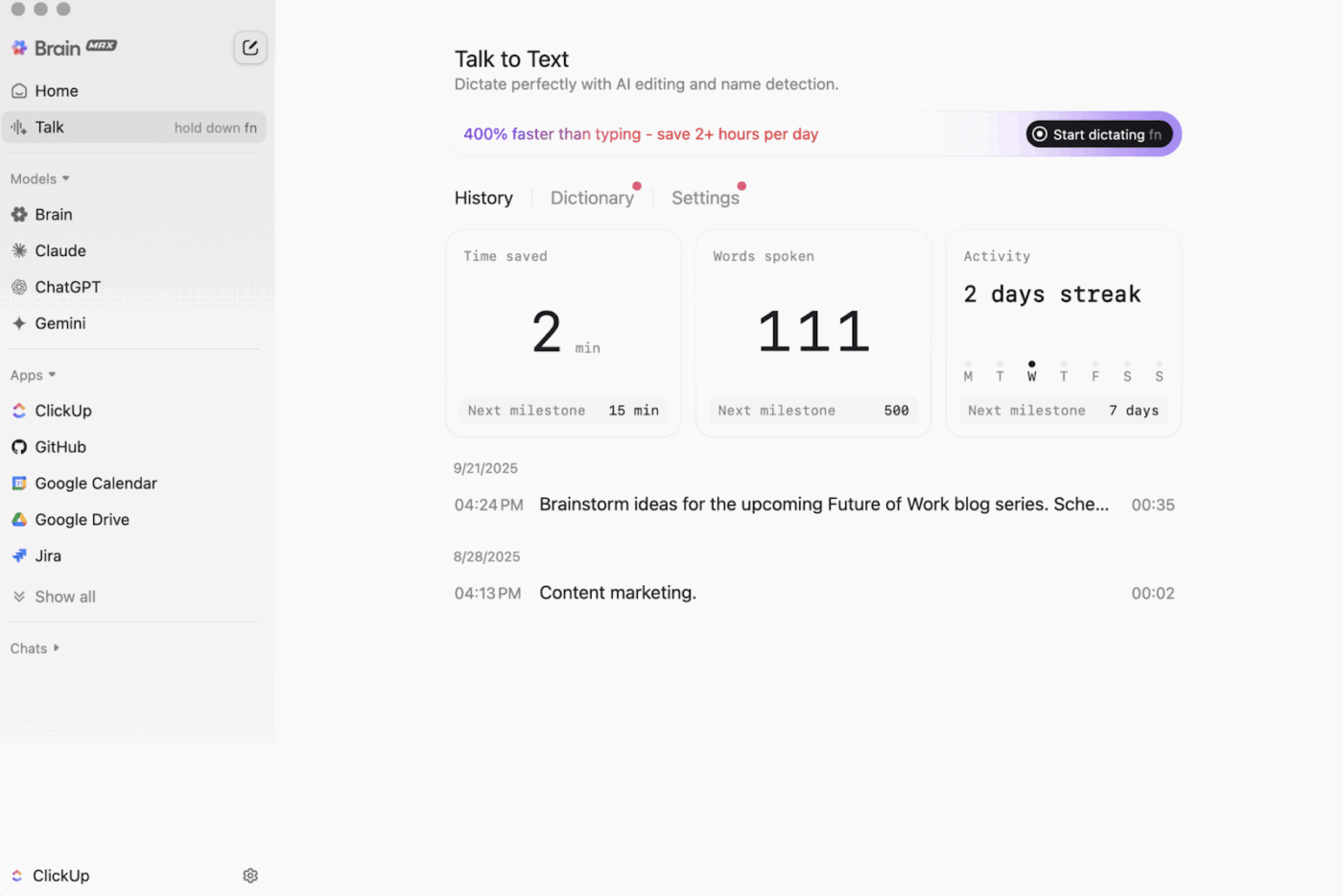

Poi c'è ClickUp Brain MAX , il compagno AI desktop che mette al primo posto la privacy, in grado di archiviare ed effettuare ricerche nell'intero spazio di lavoro, nelle app collegate e persino sul web.

Con Talk-to-Text integrato, Brain MAX può convertire la tua voce in testo senza usare le mani. Ciò include la stesura di un'email, la scrittura di un documento o la registrazione di un rapido aggiornamento mentre sei in movimento.

Brain MAX ti offre anche Universal AI, progettato per chattare con i più recenti modelli di IA per la codifica, la scrittura, il ragionamento complesso e altro ancora. Ciò significa che puoi porre domande ai migliori modelli di IA in un unico posto, tra cui ClickUp Brain e opzioni come OpenAI, Claude e Gemini, senza dover attivare/disattivare lo strumento.

Inoltre, ClickUp Security aggiunge misure di sicurezza che gli strumenti offline spesso tralasciano. Si pensi alla crittografia, alle autorizzazioni granulari e ai controlli degli amministratori come SSO, provisioning e registri di audit, tutti progettati per i team che necessitano di sicurezza di livello aziendale.

ClickUp AI Knowledge Manager è di grande aiuto nel passaggio dall'offline all'online. Fornisce al tuo team un hub in cui archiviare diverse risorse in Docs e wiki, quindi utilizza ClickUp Brain per estrarre risposte immediate dall'intero spazio di lavoro, in modo che il contesto giusto sia disponibile nel momento in cui si riprende il lavoro.

🎬 Agenti in azione: usa i Super Agenti per trasformare il lavoro di sincronizzazione nei passaggi successivi!

I Super Agenti di ClickUp sono compagni di squadra basati sull'IA che puoi creare e personalizzare per eseguire flussi di lavoro in più fasi all'interno della tua area di lavoro di ClickUp. Puoi configurare trigger specifici, istruzioni e accesso agli strumenti per garantire che agiscano entro i limiti da te stabiliti.

Ad esempio, dopo la sincronizzazione delle attività offline, un Super Agente può scansionare i nuovi elementi, riepilogare le modifiche apportate, individuare le azioni da intraprendere, redigere una bozza di aggiornamento e inviarla al titolare competente per la revisione.

E poiché i Super Agent sono gestibili, puoi controllare a cosa possono accedere tramite autorizzazioni e verificare ciò che fanno. 🔐

Le migliori funzionalità di ClickUp

- Trova qualsiasi cosa tra i tuoi strumenti: ordina e cerca nell'intero spazio di lavoro, oltre alle app collegate, da un unico posto con ClickUp Enterprise Search.

- Crea una vera e propria base di conoscenze: crea wiki e documenti con ClickUp Docs utilizzando pagine nidificate, modelli, assistenza IA e altro ancora.

- Mantieni la connessione della tua pila: effettua la sincronizzazione del lavoro con strumenti come Slack e GitHub senza uscire da ClickUp grazie alle integrazioni ClickUp.

- Crea flussi di lavoro personalizzati: utilizza l'API ClickUp con token personali o OAuth 2.0 per potenziare automazioni e integrazioni su misura.

- Automatizza il tuo stack: attiva azioni come l'assegnazione di titolari, l'aggiornamento degli stati o l'avvio di passaggi di consegne in base alle modifiche delle attività con ClickUp Automazioni.

Limitazioni di ClickUp

- A causa dell'ampia gamma di funzionalità, alcuni utenti potrebbero dover affrontare una curva di apprendimento.

Prezzi di ClickUp

Valutazioni e recensioni di ClickUp

- G2: 4,7/5 (oltre 10.000 recensioni)

- Capterra: 4,6/5 (oltre 4.000 recensioni)

Cosa dicono gli utenti reali di ClickUp?

Un recensore di G2 afferma:

Bacheche agili, integrazioni e personalizzazione. Inoltre, mi piace il fatto che posso semplicemente andare offline e continuare a lavorare sulle attività. Inoltre, posso inviare e-mail a qualsiasi elenco e creare automaticamente delle attività. L'editor di testo è fantastico, funziona sia in modalità MD che con scorciatoie, consentendo di visualizzare in anteprima il contenuto in linea.

Bacheche agili, integrazioni e personalizzazione. Inoltre, mi piace il fatto che posso semplicemente andare offline e continuare a lavorare sulle attività. Inoltre, posso inviare e-mail a qualsiasi elenco e creare automaticamente delle attività. L'editor di testo è fantastico, funziona sia in modalità MD che con scorciatoie, consentendo di visualizzare in anteprima il contenuto in linea.

2. GPT4All (Ideale per chat privata offline con IA e LLM locali)

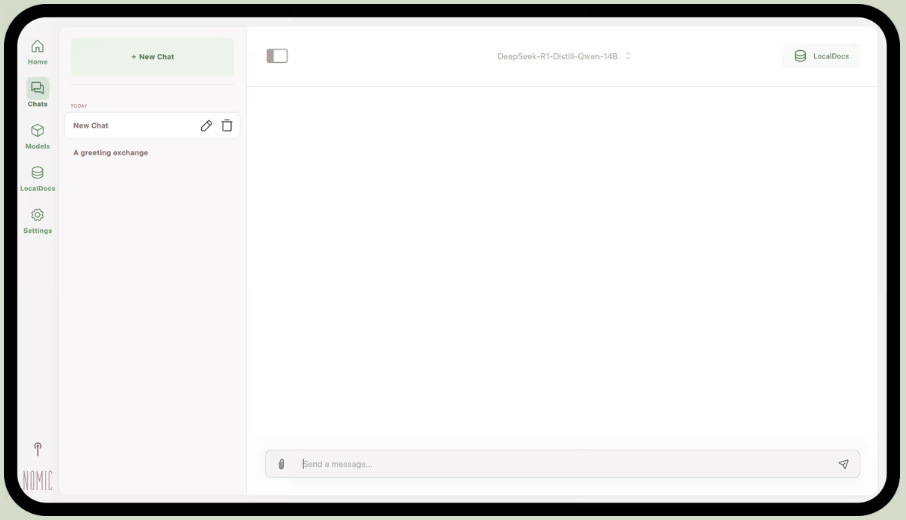

Parte di Nomic.ai, GPT4All è un'app desktop che consente di eseguire modelli linguistici open source di grandi dimensioni direttamente sul proprio computer, in modo da poter chattare con un assistente IA senza dover ricorrere a Internet o alle chiamate API cloud. È stata creata per chi desidera una configurazione "local-first", in cui prompt, risposte e file rimangono sul dispositivo.

La sua funzionalità migliore è LocalDocs, che utilizza una forma di generazione potenziata dal recupero per consentirti di chattare in privato con i tuoi documenti. Puoi indicare all'app una cartella di file PDF o di testo e questa creerà una base di conoscenza locale a cui potrai porre domande.

GPT4All include anche una libreria curata di modelli popolari come Llama e Mistral, che è possibile scaricare direttamente tramite l'app.

Le migliori funzionalità di GPT4All

- Avvia un server API locale (compatibile con OpenAI) per utilizzare i modelli GPT4All all'interno di altre app e automazioni.

- Cerca, confronta e scarica i modelli GGUF dall'interno dell'app, con opzioni di ordinamento come Mi piace, download e data di caricamento.

- Regola la lunghezza del contesto, la lunghezza massima dell'output, top-p, top-k, la penalità di ripetizione, i thread della CPU e persino l'offloading del livello GPU (oltre al supporto Metal su Apple Silicon).

Limitazioni di GPT4All

- Le prestazioni sono fortemente dipendenti dall'hardware del computer.

- L'indice di grandi raccolte di documenti può essere lento.

Prezzi GPT4All

- App desktop gratis

- Aziendale: 40 $ al mese per utente (Nomic IA)

- Enterprise: Prezzi personalizzati (Nomic IA)

Valutazioni e recensioni di GPT4All

- G2: Recensioni insufficienti

- Capterra: Recensioni insufficienti

Cosa dicono gli utenti reali di GPT4All?

Un utente di Reddit dice:

Questo è il migliore che ho provato con RAG, batte tutti, persino LM Studio in termini di semplicità. Mi piace il modo in cui lo si mappa su una cartella e effettua il monitoraggio e gestisce le modifiche per te. È ancora agli inizi, come gli altri, ma sarà il mio preferito per il breve termine.

Questo è il migliore che ho provato con RAG, batte tutti, persino LM Studio in termini di semplicità. Mi piace il modo in cui lo si mappa su una cartella e effettua il monitoraggio e gestisce le modifiche per te. È ancora agli inizi, come gli altri, ma sarà il mio predefinito per il breve termine.

📮 Approfondimento ClickUp: l'88% dei partecipanti al nostro sondaggio utilizza l'IA per le proprie attività personali, ma oltre il 50% evita di utilizzarla sul lavoro. Quali sono i tre principali ostacoli? Mancanza di integrazione perfetta, lacune di conoscenza o preoccupazioni relative alla sicurezza. Ma cosa succederebbe se l'IA fosse integrata nella tua area di lavoro e fosse già sicura? ClickUp Brain,

L'assistente AI integrato di ClickUp rende tutto questo realtà. Comprende i prompt in linguaggio semplice, risolvendo tutte e tre le preoccupazioni relative all'adozione dell'IA e stabilendo la connessione tra chat, attività, documenti e conoscenze in tutta l'area di lavoro. Trova risposte e approfondimenti con un solo clic!

3. LM Studio (ideale per un ambiente di lavoro offline ottimizzato con regolazione delle prestazioni)

tramite LM Studio

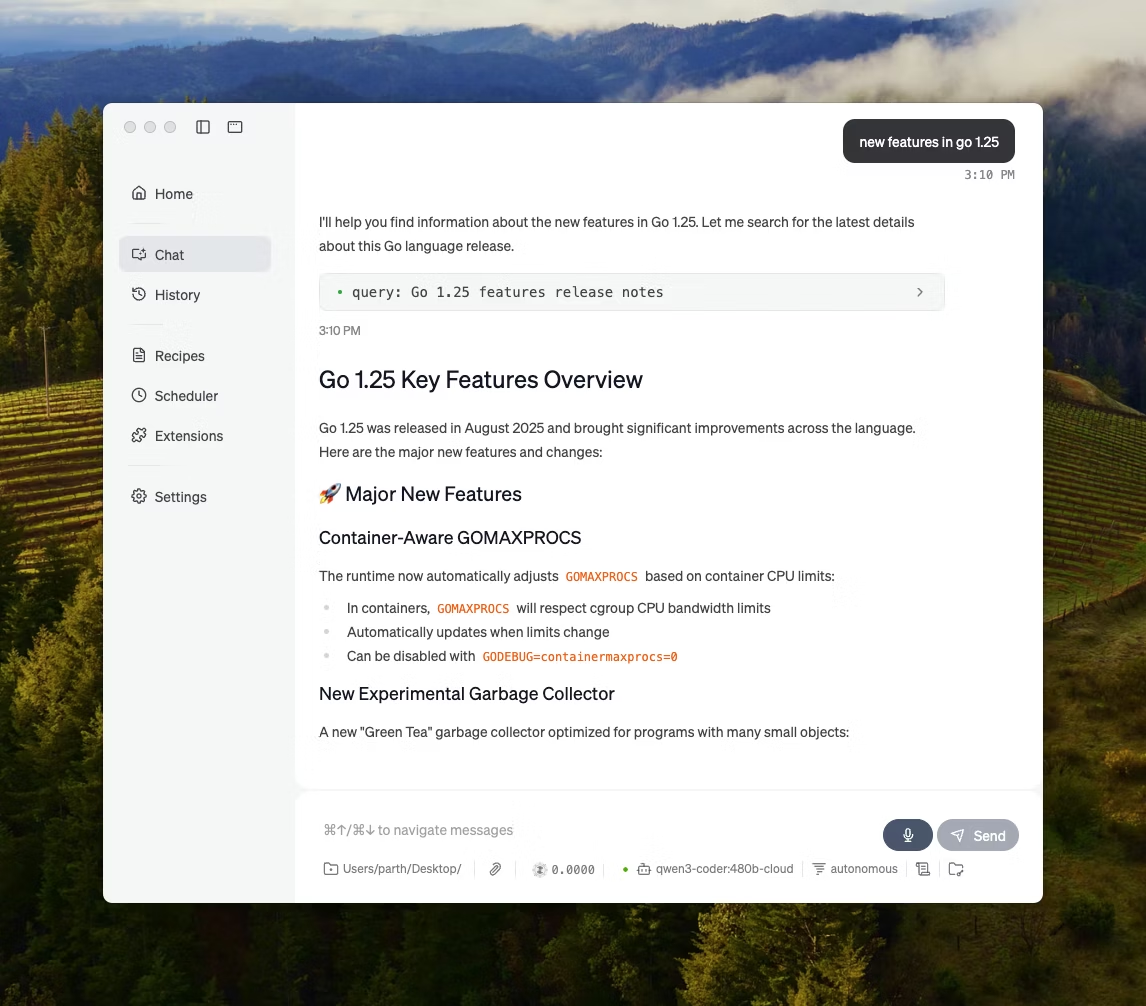

LM Studio è un'app desktop locale basata sull'IA che consente di trovare, testare ed eseguire modelli open source in un'interfaccia utente, senza dover ricorrere a un terminale. È pensata per la sperimentazione, ad esempio per scegliere un modello, eseguirlo localmente e iterare su prompt e impostazioni con un ciclo di feedback più stretto rispetto alla maggior parte delle configurazioni CLI-first.

Supporta anche la chat con documenti completamente offline (RAG locale), dove puoi allegare file a una conversazione e usarli come riferimento nelle risposte. Questo lo rende perfetto per ricerche offline, appunti di studio o flussi di lavoro con documenti interni dove non è possibile fare upload.

LM Studio offre anche un controllo dettagliato sul funzionamento dell'IA, con opzioni per regolare la temperatura, la lunghezza del contesto e l'utilizzo della GPU.

Le migliori funzionalità di LM Studio

- Utilizza la modalità di compatibilità OpenAI o l'API REST di LM Studio, a seconda delle esigenze della tua app.

- LM Studio offre opzioni SDK sia in JavaScript che in Python per creare flussi di lavoro locali basati sui vostri modelli.

- Salva un prompt di sistema + parametri come preimpostazione, quindi riutilizzalo nelle chat (le preimpostazioni possono anche essere importate da un file/URL e pubblicate per essere condivise tramite LM Studio Hub)

Limitazioni di LM Studio

- LM Studio può bloccare il computer durante l'esecuzione di DeepSeek R1 32B.

- Alcuni utenti segnalano l'app come un problema per la sicurezza dei dati e la privacy a causa del codice closed-source non verificato.

Prezzi LM Studio

- Gratis per uso domestico e lavorativo

Valutazioni e recensioni di LM Studio

- G2: Recensioni insufficienti

- Capterra: Recensioni insufficienti

Cosa dicono gli utenti reali di LM Studio?

Un utente di Reddit dice:

È fantastico. Funziona alla perfezione, è facilissimo da avviare e utilizzare. Ha l'interfaccia utente più bella tra tutti i concorrenti.

È fantastico. Funziona alla perfezione, è facilissimo da avviare e utilizzare. Ha l'interfaccia utente più bella tra tutti i concorrenti.

4. Ollama (Ideale per eseguire LLM locali con una semplice CLI + server locale)

Ollama è un runner di modelli locale che si comporta più come un runtime LLM che come un'app di chat autonoma. È incentrato sul terminale, progettato per estrarre ed eseguire modelli aperti con comandi rapidi (come ollama run llama3), quindi esporli attraverso un servizio locale su cui possono poggiare altre interfacce.

Il punto di forza di Ollama risiede nella sua API REST. Una volta che Ollama è in esecuzione in background, qualsiasi applicazione può comunicare con esso tramite semplici richieste HTTP. Ciò consente di integrare funzionalità/funzioni IA nel proprio software.

Ollama offre anche una libreria di modelli popolari che possono essere scaricati con un solo comando, ed è possibile creare configurazioni di modelli personalizzate, simili ai Dockerfile per l'IA.

Le migliori funzionalità di Ollama

- Creare ricette di modelli riutilizzabili e versionabili (selezione del modello di base, modelli di prompt, messaggi di sistema, parametri, adattatori) utilizzando un Modelfile.

- Esegui modelli tramite endpoint come chat/generate con streaming opzionale per l'output di token in tempo reale in app e script.

- Genera incorporamenti per pipeline di ricerca e recupero semantico utilizzando la funzionalità di incorporamento di Ollama e i modelli di incorporamento consigliati.

Limiti di Ollama

- Non dispone di un'interfaccia grafica integrata, quindi gli utenti non esperti di tecnologia avranno bisogno di uno strumento frontend separato.

- L'app desktop macOS di Ollama potrebbe non rispondere mentre si è offline, anche se i modelli sono già stati scaricati, mentre la CLI continua a funzionare.

Prezzi Ollama

- Free

- Pro: 20 $ al mese

- Massimo: 100 $ al mese

Valutazioni e recensioni di Ollama

- G2: Recensioni insufficienti

- Capterra: Recensioni insufficienti

Cosa dicono gli utenti reali di Ollama?

Un recensore di Producthunt afferma:

Facile da implementare e gestire. Ollama semplifica l'esecuzione dei modelli di linguaggio locali (LLM). Abbinalo a OpenWebUI per un'esperienza ottimale.

Facile da implementare e gestire. Ollama semplifica l'esecuzione dei modelli di linguaggio locali (LLM). Abbinalo a OpenWebUI per un'esperienza ottimale.

🧠 Curiosità: la conversione da voce a testo è iniziata con il riconoscimento dei soli numeri. Il sistema AUDREY (1952) dei Bell Labs riconosceva i numeri da 0 a 9 e, secondo un account, funzionava meglio quando era il suo inventore a pronunciarli.

5. Jan. IA (Ideale per un assistente offline in stile ChatGPT che mette al primo posto la privacy)

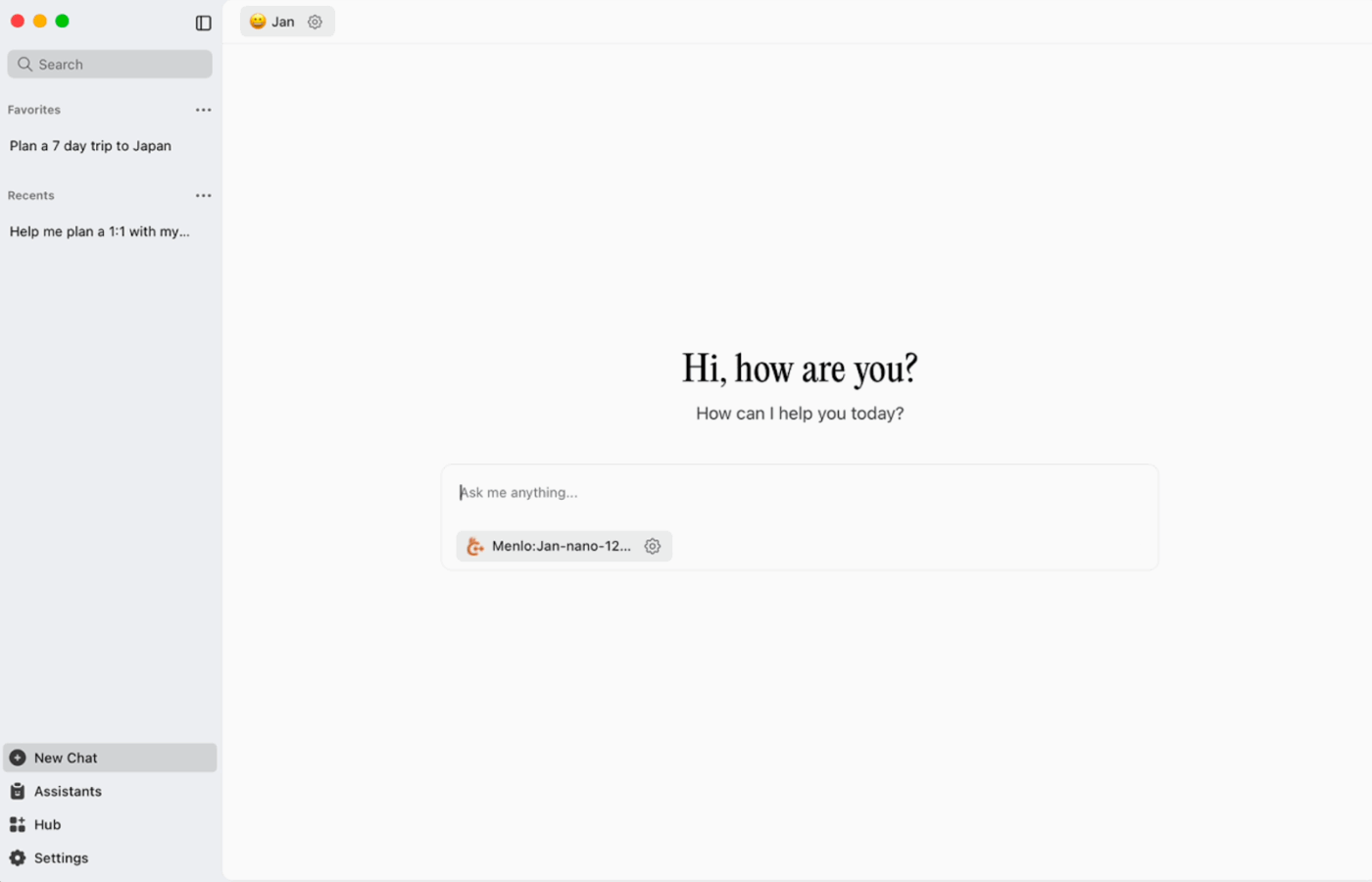

Jan. ai è un assistente desktop open source che offre un'esperienza di chat simile a ChatGPT su macOS, Windows e Linux, con utilizzo locale come impostazione predefinita. Funziona sul dispositivo quando lo desideri, mentre la cronologia delle conversazioni e i dati di utilizzo vengono archiviati localmente e non lasciano il tuo computer.

Supporta l'esecuzione locale di modelli open source e consente anche connessioni opzionali a provider remoti come API compatibili con OpenAI, il che lo rende flessibile quando l'uso offline ha la priorità, ma a volte è necessario l'accesso al cloud.

Gennaio: le migliori funzionalità/funzioni di ai

- Crea assistenti con le loro istruzioni e impostazioni personalizzate, quindi passa da uno all'altro dalla scheda Assistenti invece di riscrivere ogni volta i prompt.

- Connetti Jan agli strumenti MCP e alle origini dati utilizzando uno standard aperto creato per flussi di lavoro basati sull'utilizzo di strumenti.

- Installa le estensioni per aggiungere nuove funzionalità/funzioni come la ricerca web o un interprete di codice. Questo approccio modulare ti consente di iniziare in modo semplice e aggiungere più potenza man mano che procedi.

Limiti di gennaio

- Jan può consentire il caricamento di un file modello che non è stato ancora scaricato completamente, il che può creare un comportamento confuso o incoerente fino a quando il download del file non è completato.

- L'attivazione dell'API può interferire con le chat threaded e gli endpoint di base come "get loaded model" o "swap model" potrebbero non funzionare correttamente.

Gennaio ai prezzi

- Codice aperto

Valutazioni e recensioni di gennaio

- G2: Recensioni insufficienti

- Capterra: Recensioni insufficienti

Cosa dicono gli utenti reali di Jan. IA?

Un utente di Reddit dice:

Jan. ai è la mia app LLM locale preferita. È fantastica.

Jan. ai è la mia app LLM locale preferita. È fantastica.

6. Llamafile (ideale per impacchettare un LLM in un file eseguibile portatile)

Llamafile è un progetto guidato da Mozilla che raggruppa un LLM open source completo in un unico file eseguibile. Invece di installare un runtime, gestire le dipendenze o collegare un'interfaccia utente separata, è sufficiente scaricare un file ed eseguirlo come un'app.

L'idea centrale è la distribuzione. Un "llamafile" include i pesi del modello più un runtime compilato, progettato per funzionare su più sistemi operativi con una configurazione minima. È particolarmente utile quando uno strumento offline deve essere condiviso con colleghi, studenti o clienti che non sono in grado di risolvere i problemi di installazione.

Le migliori funzionalità di Llamafile

- Llamafile combina llama.cpp con Cosmopolitan Libc per fornire supporto per un'ampia portabilità binaria, riducendo il lavoro di packaging specifico per piattaforma.

- La modalità server fornisce una GUI web e un endpoint di completamento compatibile con l'API OpenAI, utile per lo sviluppo di app locali e la sostituzione delle chiamate cloud durante i test.

- I file lama confezionati sono progettati per funzionare su macchine x86_64 e ARM64 comuni, il che semplifica la distribuzione su flotte miste.

Limitazioni di Llamafile

- La selezione dei modelli è limitata a ciò che è stato confezionato come Llamafile.

- Le dimensioni dei file sono molto grandi poiché l'intero modello è incorporato.

Prezzi di Llamafile

- Gratis en open source

Valutazioni e recensioni di Llamafile

- G2: Recensioni insufficienti

- Capterra: Recensioni insufficienti

🧠 Curiosità: il primo sito web è ancora visitabile. Il CERN lo ospita letteralmente all'indirizzo info.cern.ch, definendolo la "casa del primo sito web".

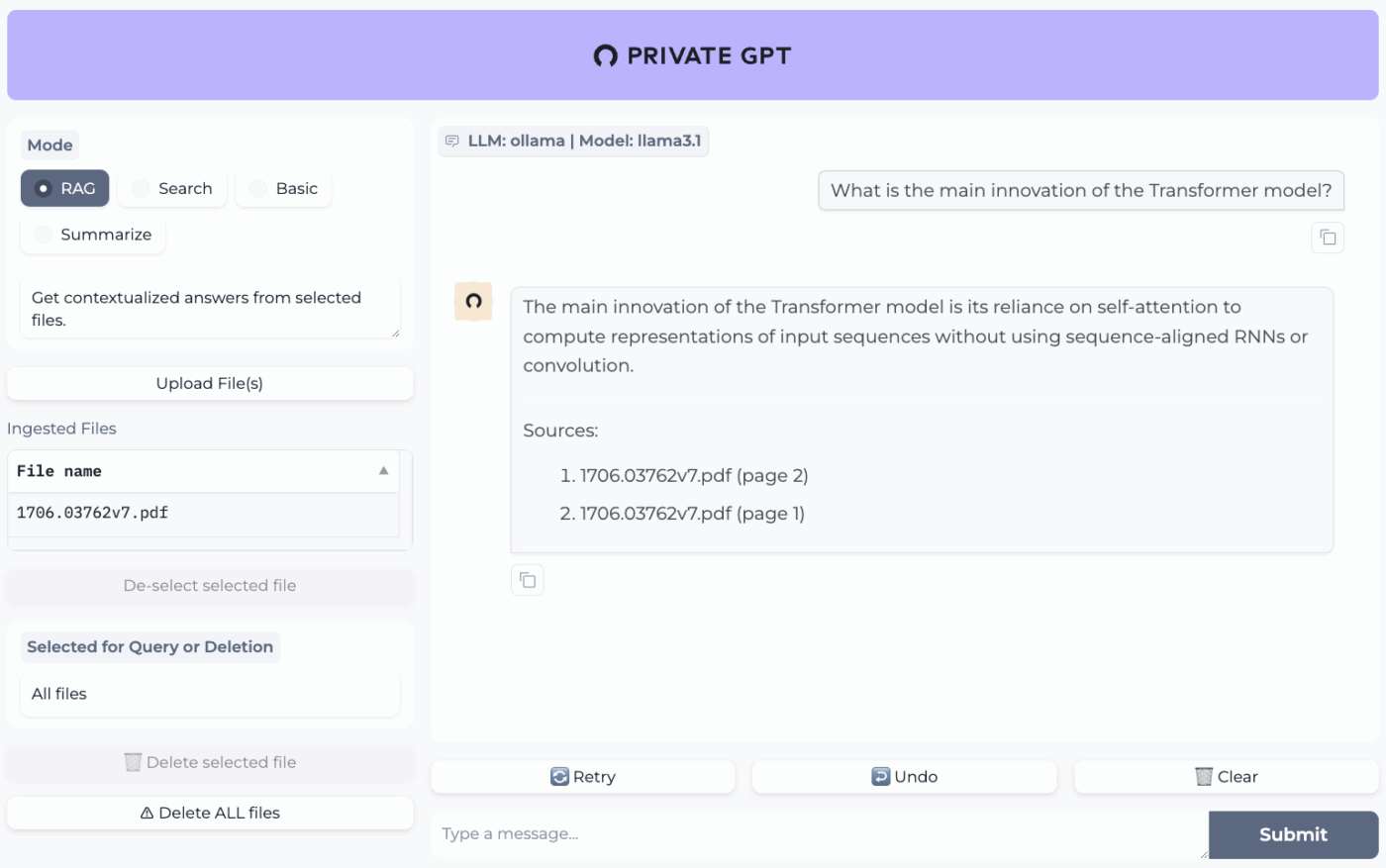

7. PrivateGPT (Ideale per domande e risposte offline sui tuoi file con uno stack RAG self-hosted)

PrivateGPT è un progetto pronto per la produzione e self-hosted, creato per i flussi di lavoro di "chat con i tuoi documenti". Acquisisce i file locali, li indicizza e risponde alle domande recuperando il contesto pertinente dai tuoi contenuti invece di affidarsi alla memoria di un chatbot cloud. Il progetto è progettato per funzionare completamente offline, con la garanzia che i dati rimangono all'interno del tuo ambiente di esecuzione.

Ciò che lo rende diverso dalle app di chat offline generiche è l'architettura modulare. In altre parole, è possibile combinare LLM, provider di incorporamento e archivio vettoriale in base alle proprie limitazioni hardware e di privacy, quindi eseguire tutto dietro un'API + UI locale.

Le migliori funzionalità di PrivateGPT

- Importa file PDF, DOCX, PPT/PPTX/PPTM, CSV, EPUB, Markdown, JSON, MBOX, IPYNB, immagini (JPG/PNG/JPEG) e persino MP3/MP4 utilizzando la pipeline di importazione integrata.

- Profili di configurazione dei livelli con PGPT_PROFILES (ad esempio, local,cuda) per unire più file di impostazioni e cambiare le distribuzioni senza riscrivere la configurazione di base.

- Filtra le risposte a un sottoinsieme specifico di documenti acquisiti utilizzando context_filter quando chiami gli endpoint di completamento contestuale.

Limitazioni di PrivateGPT

- Ha requisiti hardware più elevati a causa dell'esecuzione simultanea di più componenti

- L'acquisizione di più documenti da un unico file (ad esempio, un PDF che genera un documento per ogni pagina) può aumentare il volume e la complessità dell'indicizzazione quando si gestiscono upload di grandi dimensioni.

Prezzi PrivateGPT

- Codice aperto

Valutazioni e recensioni di PrivateGPT

- G2: Recensioni insufficienti

- Capterra: Recensioni insufficienti

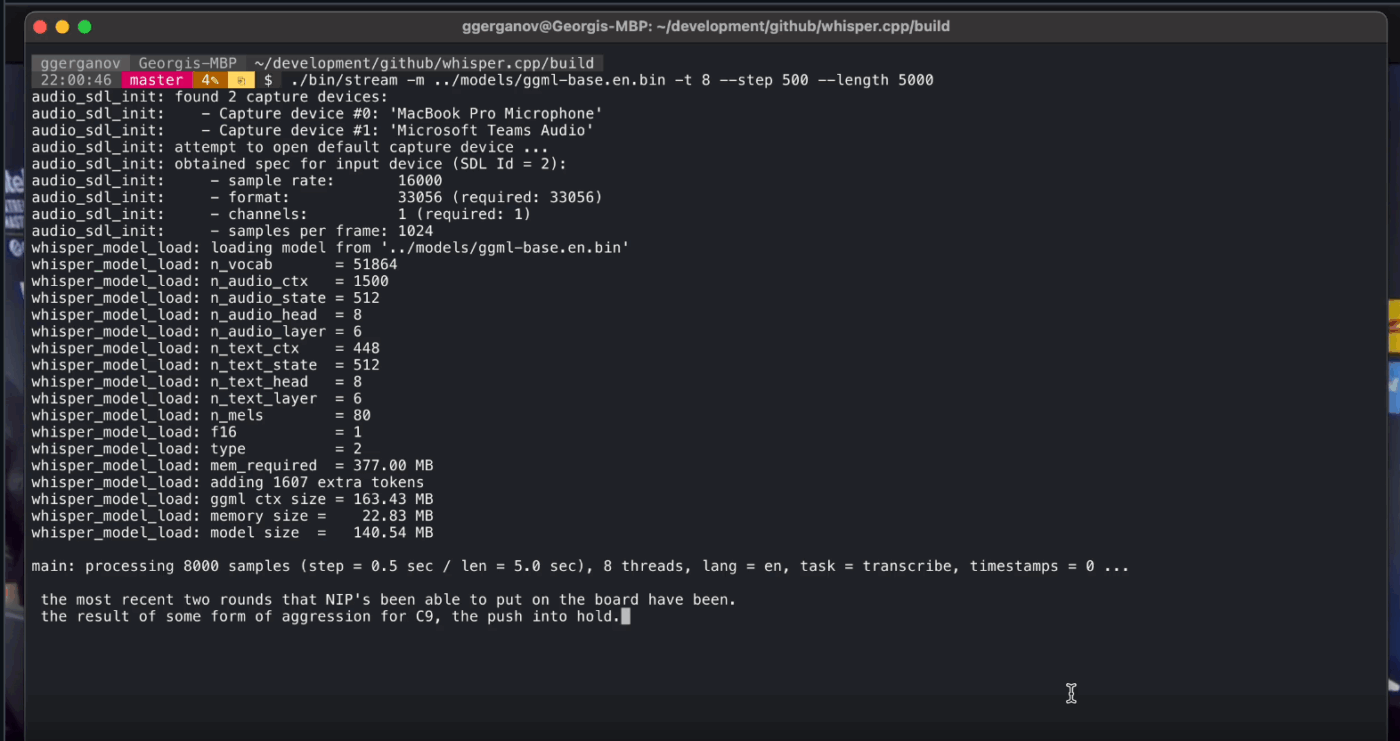

8. Whisper. cpp (Ideale per la conversione da voce a testo completamente offline che è possibile integrare nelle app)

Whisper. cpp è un'implementazione C/C++ ad alte prestazioni del modello di riconoscimento vocale automatico Whisper di OpenAI, progettato per funzionare localmente senza pesanti dipendenze di runtime. È molto diffuso nelle pipeline di trascrizione offline in cui è necessario un binario piccolo e portatile o una libreria in stile C che possa essere integrata nel proprio prodotto.

È anche flessibile in diversi ambienti, con supporto ufficiale che copre desktop, dispositivi mobili, WebAssembly, Docker e persino hardware di classe Raspberry Pi, il che lo rende adatto per strumenti offline che devono essere eseguiti in più di un luogo.

Il suffisso "cpp" nel nome indica la sua attenzione alle prestazioni. Questa implementazione è significativamente più veloce e utilizza meno memoria rispetto alle alternative basate su Python, rendendo possibile la trascrizione in tempo reale sui computer moderni senza bisogno di una GPU potente.

Whisper. Le migliori funzionalità di cpp

- Eseguire il rilevamento dell'attività vocale (VAD) come parte del progetto per segmentare il parlato e ridurre le trascrizioni rumorose e prive di audio nei flussi di lavoro in stile streaming.

- Quantizza i modelli Whisper per ridurre i requisiti di disco e memoria, con più opzioni di quantizzazione progettate per un'inferenza locale più veloce.

- Compilare con supporto FFmpeg opzionale su Linux per gestire più formati di input oltre al percorso di base solo WAV.

Limitazioni di Whisper.cpp

- Whisper. La CLI di cpp richiede per impostazione predefinita input WAV a 16 bit, il che aggiunge un ulteriore passaggio di conversione quando si lavora con MP3, MP4, M4A o altri formati comuni.

- Non etichetta in modo nativo i parlanti (diarizzazione), il che rende difficile attribuire correttamente le citazioni nelle registrazioni con più parlanti.

Whisper. Prezzi cpp

- Codice aperto

Whisper. Valutazioni e recensioni cpp

- G2: Recensioni insufficienti

- Capterra: Recensioni insufficienti

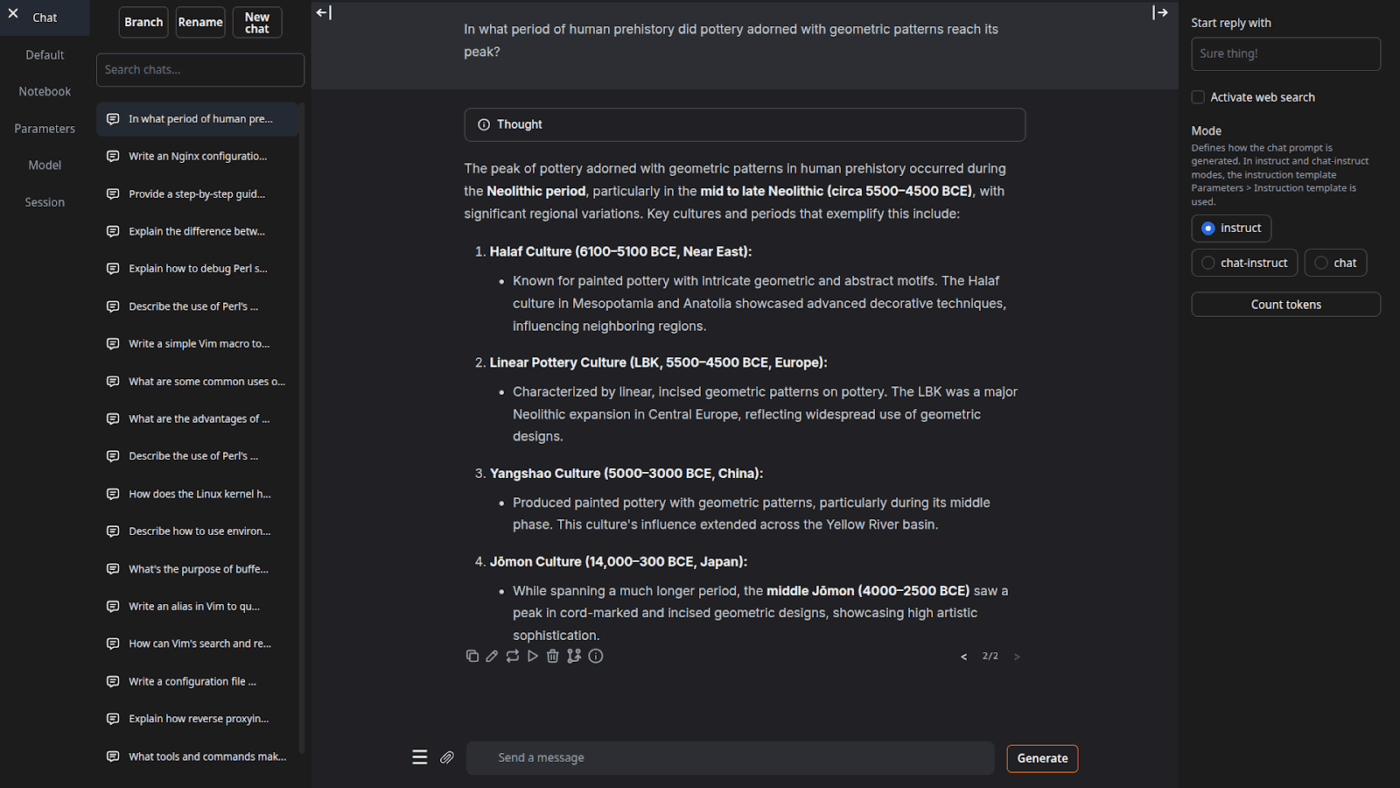

9. Interfaccia utente web per la generazione di testo (ideale per gli utenti che desiderano una console basata su browser per LLM locali)

Text Generation Web UI (spesso chiamata "oobabooga") è un'interfaccia web basata su Gradio per l'esecuzione di modelli locali con una forte enfasi sul controllo e la sperimentazione. Si comporta più come un banco di lavoro completo: più backend di modelli, più modalità di interazione e molte opzioni per il comportamento di generazione.

Si adatta anche ai flussi di lavoro "writer/dev" che molti strumenti offline ignorano, con funzionalità quali l'automazione del formato dei prompt, la generazione in stile notebook e il branching delle conversazioni. Per le configurazioni offline che necessitano comunque di un'interfaccia utente web, è uno dei frontend più configurabili in questa categoria.

Le migliori funzionalità/funzioni dell'interfaccia utente web per la generazione di testo

- Formattazione automatica dei prompt utilizzando i modelli Jinja2, riducendo gli errori di formattazione dei prompt tra le diverse famiglie di modelli

- Regola decine di impostazioni per ottimizzare i risultati dell'IA in base alle tue esigenze specifiche, che si tratti di scrittura creativa, programmazione o giochi di ruolo.

- Modifica dei messaggi con navigazione tra le versioni e ramificazione delle conversazioni, mantenendo più direzioni della stessa chat senza ricominciare da capo

Limitazioni dell'interfaccia utente web per la generazione di testo

- Il programma di installazione con un solo clic richiede circa 10 GB di spazio su disco e scarica PyTorch, il che rende la configurazione piuttosto pesante su macchine con spazio di archiviazione limitato.

- L'endpoint di incorporamento compatibile con OpenAI utilizza sentence-transformers/all-mpnet-base-v2 con incorporamenti a 768 dimensioni, che possono infrangere le ipotesi nelle pipeline costruite attorno alle impostazioni predefinite a 1536 dimensioni di OpenAI.

Prezzi dell'interfaccia utente web per la generazione di testo

- Codice aperto

Valutazioni e recensioni dell'interfaccia utente web per la generazione di testo

- G2: Recensioni insufficienti

- Capterra: Recensioni insufficienti

10. Llama. cpp (Ideale per inferenze LLM locali ad alte prestazioni su CPU e GPU)

Llama. cpp è un motore di inferenza C/C++ e una toolchain per l'esecuzione locale di LLM con dipendenze minime e prestazioni elevate su un ampio intervallo di hardware. Non è tanto un'app per chattare quanto piuttosto un runtime locale attorno al quale è possibile costruire flussi di lavoro, che si tratti di una CLI, di un server HTTP locale o di una libreria incorporata nel proprio prodotto.

Sebbene non sia un'applicazione per l'utente finale, Llama. cpp è il motore che alimenta molti degli strumenti presenti in questo elenco, tra cui GPT4All e LM Studio. Ha introdotto il formato del modello GGUF, che è diventato lo standard per l'esecuzione di modelli di grandi dimensioni su hardware consumer, riducendone efficacemente la dimensione.

Offre anche binding per linguaggi di programmazione popolari come Python e Rust, e la sua modalità server può fornire un'API compatibile con OpenAI.

Llama. cpp funzionalità/funzioni migliori

- Avvia un server locale compatibile con l'API OpenAI con un'interfaccia utente web integrata e un endpoint /v1/chat/completions utilizzando llama-server.

- Esegui un modello di incorporamento (e anche un modello di riclassificazione) dallo stesso server per pipeline RAG offline utilizzando /embedding e /reranking.

- Quantizza i modelli da 1,5 bit a 8 bit per ridurre l'utilizzo della memoria e velocizzare l'inferenza locale, quindi accelera le esecuzioni con CUDA/Metal più backend Vulkan/SYCL quando disponibili.

Limitazioni di Llama.cpp

- Llama. cpp non viene fornito come assistente desktop completo, il che significa che l'utilizzo offline spesso richiede comandi CLI o l'hosting di llama-server, e molti utenti si affidano a interfacce utente di terze parti per chattare quotidianamente.

- La compatibilità di Llama.cpp con OpenAI non è sempre perfettamente allineata con tutte le funzionalità/funzioni del client OpenAI e gli utenti segnalano discrepanze relative ai parametri di output strutturati come response_format in /v1/chat/completions.

Llama. Prezzi cpp

- Codice aperto

Cosa dicono gli utenti reali di Llama. cpp?

Un recensore di Sourceforge afferma:

Fantastico. Democratizzare l'IA per tutti. E funziona alla grande!

Fantastico. Democratizzare l'IA per tutti. E funziona alla grande!

Trasforma i risultati dell'IA offline in lavoro reale con ClickUp

Scegliere lo strumento di IA offline giusto significa in realtà abbinare lo strumento al lavoro da svolgere.

Se sei qui, probabilmente stai ottimizzando tre aspetti: privacy, indipendenza dalla dipendenza da Internet e libertà dall'essere vincolato a un'altra sottoscrizione.

Gli strumenti presenti in questo elenco offrono risultati in tal senso in modi diversi. Ciò significa che alcuni sono più adatti alla scrittura e alla programmazione, altri alla ricerca, alla creazione di note o al lavoro creativo.

Ma per i team, la sfida più grande non è solo quella di eseguire l'IA a livello locale. È trasformare i risultati dell'IA in flussi di lavoro reali.

Grazie alle funzionalità di IA di ClickUp integrate nelle tue attività, nei tuoi documenti e nelle tue conoscenze, puoi facilmente individuare i passaggi successivi nello stesso luogo in cui svolgi il tuo lavoro (il tutto con una sicurezza di livello aziendale).

Prova ClickUp gratis e scopri come funziona quando l'IA e l'esecuzione finalmente convivono. ✨

Domande frequenti sugli strumenti di IA offline

Sì, dopo aver scaricato i file del modello, molti strumenti di IA possono funzionare interamente sul tuo dispositivo senza bisogno di Internet. Questo li rende perfetti per gestire dati sensibili o lavorare in posizioni con scarsa connessione.

Gli LLM locali elaborano tutti i dati sul tuo dispositivo personale, quindi le tue informazioni non lasciano mai il tuo computer, mentre l'IA basata su cloud invia i tuoi prompt a server remoti per l'elaborazione. Gli strumenti locali sono generalmente gratis dopo la configurazione, mentre l'IA cloud spesso comporta costi di sottoscrizione, ma può offrire modelli più potenti.

I modelli più piccoli con 1-3 miliardi di parametri possono essere eseguiti sulla maggior parte dei laptop moderni con 8 GB di RAM. I modelli più grandi e potenti con 7 miliardi o più di parametri offrono prestazioni ottimali con 16 GB o più di RAM e una GPU dedicata, con i Mac Apple Silicon e le GPU NVIDIA che garantiscono un significativo aumento delle prestazioni.

![I 10 migliori strumenti di IA che funzionano offline nel [anno]](https://clickup.com/blog/wp-content/uploads/2026/01/image-1298.png)