A medida que los LLM se vuelven más potentes, las indicaciones ya no son lo más difícil. El contexto se convierte en la limitación.

La ingeniería de contexto consiste en proporcionar la información adecuada en el formato adecuado a los LLM (modelos de lenguaje grandes).

¿Qué hace que la ingeniería de contexto sea difícil?

Es necesario diseñar cada capa de la pila para capturar el contexto y hacerlo disponible. Si se envía muy poco contexto, los LLM no sabrán qué hacer. Si se envía demasiado contexto, se agotarán los tokens. Entonces, ¿cómo se encuentra el equilibrio?

A continuación, compartimos todo lo que necesitas saber sobre la ingeniería de contexto.

¿Qué es la ingeniería de contexto de IA?

La ingeniería de contexto de IA es el proceso de diseñar y optimizar instrucciones y contexto relevante para que los LLM y los modelos avanzados de IA y multimodales realicen sus tareas de manera eficaz.

Va más allá de la redacción de indicaciones. La ingeniería de contexto determina:

- Qué información se muestra

- De dónde proviene (memoria, herramientas, bases de datos, documentos)

- Cómo se establece el formato (esquemas, resúmenes, restricciones)

- Cuándo se inyecta en el bucle de razonamiento del modelo

🌟 El objetivo: optimizar la información que se proporciona en la ventana de contexto del LLM y filtrar la información ruidosa.

¿Cómo mejora el contexto las respuestas de la IA?

Sin contexto, un LLM predice la continuación del texto más probable desde el punto de vista estadístico. Por otro lado, una buena ingeniería de contexto mejora los resultados al:

- Razonamiento de anclaje: el modelo basa sus respuestas en hechos conocidos en lugar de conjeturas estadísticas.

- Reducir las alucinaciones: las restricciones claras y los datos relevantes reducen el espacio de soluciones.

- Mejorar la coherencia: entradas similares producen resultados similares porque la figura del contexto es estable.

- Reducción del coste y la latencia: el objetivo es el contexto específico, que es mejor que volcar documentos o historiales completos.

Resumiéndolo en palabras de Tobi Lutke, director ejecutivo de Shopify:

Me gusta mucho más el término «ingeniería de contexto» que «ingeniería de indicaciones». Describe mejor la habilidad fundamental: el arte de proporcionar todo el contexto para que el LLM pueda resolver la tarea de forma plausible.

Me gusta mucho más el término «ingeniería de contexto» que «ingeniería de indicaciones». Describe mejor la habilidad fundamental: el arte de proporcionar todo el contexto para que el LLM pueda resolver la tarea de forma plausible.

El rol de la ingeniería de contexto en los flujos de trabajo impulsados por la IA.

En los flujos de trabajo impulsados por la IA, los LLM no son herramientas independientes. Operan dentro de sistemas que ya cuentan con datos, reglas y estado.

La ingeniería de contexto permite al modelo comprender dónde se encuentra en el flujo de trabajo y qué es lo pendiente que debe hacer a continuación.

Cuando el modelo es consciente del estado actual, las acciones pasadas y las entradas que faltan, puede recomendar o ejecutar el siguiente paso correcto en lugar de generar consejos genéricos.

Esto también implica proporcionar explícitamente la lógica empresarial, como las reglas de aprobación, las restricciones de cumplimiento y las vías de escalamiento. Cuando estos elementos forman parte del contexto, las decisiones de la IA se mantienen alineadas con la realidad operativa.

Por último, la ingeniería de contexto permite flujos de trabajo de varios pasos y con agentes, ya que garantiza traspasos limpios del estado y las decisiones en cada paso.

Esto evita que los errores se acumulen a medida que aumentan los flujos de trabajo, lo que mejora la eficacia del contexto.

👀 ¿Sabías que... El 95 % de las implementaciones de GenAI en las corporaciones fracasan, no porque los modelos sean deficientes, sino porque las organizaciones no logran integrar la IA en los flujos de trabajo reales.

Las herramientas de IA genéricas como ChatGPT funcionan bien para individuos, pero fallan a gran escala porque no aprenden del contexto del sistema, las reglas de negocio o el estado en evolución. En otras palabras, la mayoría de los fallos de la IA son fallos de integración y de contexto, no fallos del modelo.

📮ClickUp Insight: El 62 % de nuestros encuestados confía en herramientas de IA conversacional como ChatGPT y Claude. Su interfaz de chatbot familiar y sus versátiles capacidades (para generar contenido, analizar datos y mucho más) podrían ser la razón por la que son tan populares en diversos roles y sectores. Sin embargo, si un usuario tiene que cambiar a otra pestaña para hacer una pregunta a la IA cada vez, los costes asociados al cambio de contexto y al cambio de pestaña se acumulan con el tiempo. Pero no con ClickUp Brain. Se encuentra en tu entorno de trabajo de ClickUp, sabe en qué estás trabajando, puede entender indicaciones de texto sin formato y te da respuestas muy relevantes para tus tareas. ¡Experimenta una mejora del doble en la productividad con ClickUp!

¿Cómo funciona la ingeniería de contexto?

La ingeniería de contexto funciona dando forma progresivamente a la información antes de que llegue al modelo.

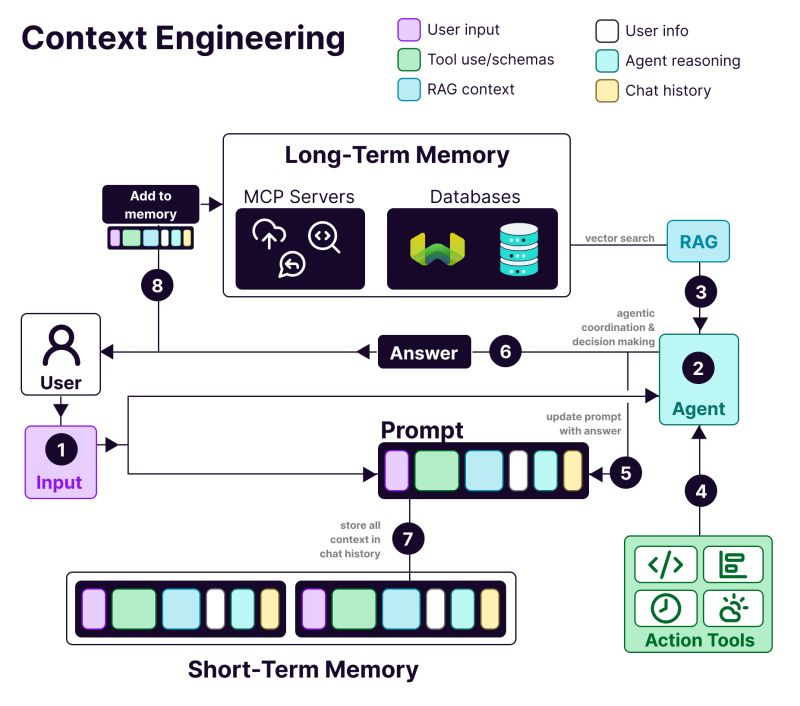

La anatomía de un sistema diseñado para el contexto incluye:

- 𝗨𝘀𝗲𝗿 i𝗻𝗳𝗼𝗿𝗺𝗮𝘁𝗶𝗼𝗻: Preferencias, historial y datos de personalización.

- T𝗼𝗼𝗹 u𝘀𝗲: API, calculadoras, motores de búsqueda... todo lo que el LLM necesite para realizar su trabajo.

- 𝗥𝗔𝗚 c𝗼𝗻𝘁𝗲𝘅𝘁: Información obtenida de bases de datos vectoriales como Weaviate.

- 𝗨𝘀𝗲𝗿 i𝗻𝗽𝘂𝘁: La consulta o tarea real que se está realizando.

- 𝗔𝗴𝗲𝗻𝘁 r𝗲𝗮𝘀𝗼𝗻𝗶𝗻𝗴: El proceso de pensamiento y la cadena de toma de decisiones del LLM.

- 𝗖𝗵𝗮𝘁 h𝗶𝘀𝘁𝗼𝗿𝘆: Interacciones previas que proporcionan continuidad.

Ventajas de la ingeniería de contexto en los sistemas de IA

He aquí por qué necesitas la ingeniería de contexto al crear aplicaciones de IA:

Resultados más precisos

Proporcionar un contexto relevante para la toma de decisiones reduce la ambigüedad. El modelo razona dentro de hechos, restricciones y estados conocidos, en lugar de basarse en conjeturas probabilísticas.

Comportamiento coherente a gran escala

Las estructuras de contexto estables producen resultados repetibles. Entradas similares conducen a decisiones similares, lo cual es esencial para los flujos de trabajo de producción.

Reducción del coste y la latencia

Un contexto específico y comprimido evita el desperdicio de tokens. Los sistemas responden más rápido sin tener que cargar repetidamente historiales o documentos completos.

Automatización más segura

El contexto codifica las reglas y los permisos empresariales. Esto permite a la IA actuar sin infringir las políticas ni actuar como desencadenante de acciones arriesgadas.

Mejores flujos de trabajo de varios pasos

Las transferencias de contexto limpias preservan el estado entre los distintos pasos. Los errores no se acumulan a medida que los flujos de trabajo se vuelven más complejos o agenticos.

Depuración e iteración más sencillas

El contexto estructurado hace visible el error. Se pueden rastrear los errores hasta entradas que faltan, obsoletas o mal clasificadas, en lugar de culpar al modelo.

Mayor adopción por parte de las corporaciones

Los sistemas de IA que respetan el contexto del flujo de trabajo resultan fiables, lo que supone una diferencia fundamental entre las pruebas piloto y las herramientas para su adopción en toda la corporación.

📚 Más información: Cómo aprovechar la IA con acceso a datos en tiempo real

👀 ¿Sabías que...? La IA sensible al contexto tiene un impacto directo en la productividad. Un estudio de Boston Consulting Group reveló que solo los equipos de comunicación pueden recuperar entre el 26 % y el 36 % de su tiempo actual con la IA generativa, y que con flujos de trabajo rediseñados y sistemas agenticos que comprenden el contexto, el aumento de la productividad puede alcanzar el 50 %.

Ingeniería de contexto de IA frente a ingeniería de indicaciones

Ingeniería de indicaciones: Pídele a ChatGPT que redacte un correo electrónico para anunciar una nueva función. Estás escribiendo indicaciones para una sola tarea.

Ingeniería de contexto: estás creando un bot de atención al cliente. Necesita recordar tickets anteriores, acceder a los detalles de la cuenta del usuario y mantener el historial de conversaciones.

Como explica el investigador en IA Andrej Karpathy:

La gente asocia las indicaciones con breves descripciones de tareas que se le darían a un LLM en su uso diario. En todas las aplicaciones LLM de potencia industrial, la ingeniería de contexto es el delicado arte y ciencia de llenar la ventana de contexto con la información adecuada para el siguiente paso.

La gente asocia las indicaciones con breves descripciones de tareas que se le darían a un LLM en su uso diario. En todas las aplicaciones LLM de potencia industrial, la ingeniería de contexto es el delicado arte y ciencia de llenar la ventana de contexto con la información adecuada para el siguiente paso.

+1 para la «ingeniería de contexto» frente a la «ingeniería de indicaciones».

La gente asocia las indicaciones con descripciones breves de tareas que se le darían a un LLM en su uso diario. En todas las aplicaciones LLM de potencia industrial, la ingeniería de contexto es el delicado arte y ciencia de llenar la ventana de contexto... https://t.co/Ne65F6vFcf

— Andrej Karpathy (@karpathy) 25 de junio de 2025

+1 para la «ingeniería de contexto» frente a la «ingeniería de indicaciones».

La gente asocia las indicaciones con descripciones breves de tareas que se le darían a un LLM en su uso diario. En todas las aplicaciones LLM de potencia industrial, la ingeniería de contexto es el delicado arte y ciencia de llenar la ventana de contexto... https://t.co/Ne65F6vFcf

— Andrej Karpathy (@karpathy) 25 de junio de 2025

| Enfoque | En qué se centra | Ideal para |

| Ingeniería de indicaciones | Elaboración de instrucciones y formatos de salida para el modelo | Tareas puntuales, generación de contenido, resultados específicos de formato. |

| Ingeniería de contexto | Proporcionar datos, estado y restricciones relevantes al modelo. | IA conversacional, herramientas de análisis de documentos, asistentes de codificación. |

| Ambos juntos. | Combinar instrucciones claras con contexto a nivel del sistema. | Aplicaciones de IA de producción que necesitan un rendimiento constante y fiable. |

La mayoría de las aplicaciones utilizan una combinación de ingeniería de indicaciones e ingeniería de contexto. Aún así, se necesitan indicaciones bien redactadas en el sistema de ingeniería de contexto.

La diferencia es que esas indicaciones funcionan con información de fondo cuidadosamente gestionada. No es necesario empezar cada vez desde cero.

📮 ClickUp Insight: Más de la mitad de los encuestados escriben en tres o más herramientas a diario, luchando contra la « proliferación de la IA » y los flujos de trabajo dispersos.

Aunque pueda parecer productivo y ajetreado, tu contexto simplemente se pierde entre las aplicaciones, por no hablar del gasto de energía que supone escribir. Brain MAX lo reúne todo: habla una vez y tus actualizaciones, tareas y notas llegarán exactamente donde deben estar en ClickUp. Se acabó el cambio constante, se acabó el caos: solo productividad fluida y centralizada.

Aplicaciones de la ingeniería de contexto de IA

Las áreas clave en las que ya se está implementando la ingeniería de contexto de IA son 👇

Automatización del soporte al cliente y del servicio de asistencia técnica

La mayoría de los chatbots tratan cada mensaje como si fuera nuevo, lo que obliga a los usuarios a repetirse una y otra vez.

Con la ingeniería de contexto, la IA puede consultar el historial del usuario, las interacciones anteriores, los registros de compra y la documentación del producto. De este modo, responde como un compañero de equipo que ya conoce el problema.

📌 Ejemplo real: El equipo de soporte de Coda gestiona preguntas técnicas sobre productos que requieren comprender mensajes anteriores y consultar la documentación del producto. Para ampliar el soporte, utilizan Intercom Fin. Fin lee la documentación y las conversaciones anteriores antes de responder, lo que ayuda a resolver entre el 50 % y el 70 % de las preguntas de los clientes de forma autónoma, al tiempo que se mantiene un alto nivel de satisfacción del cliente.

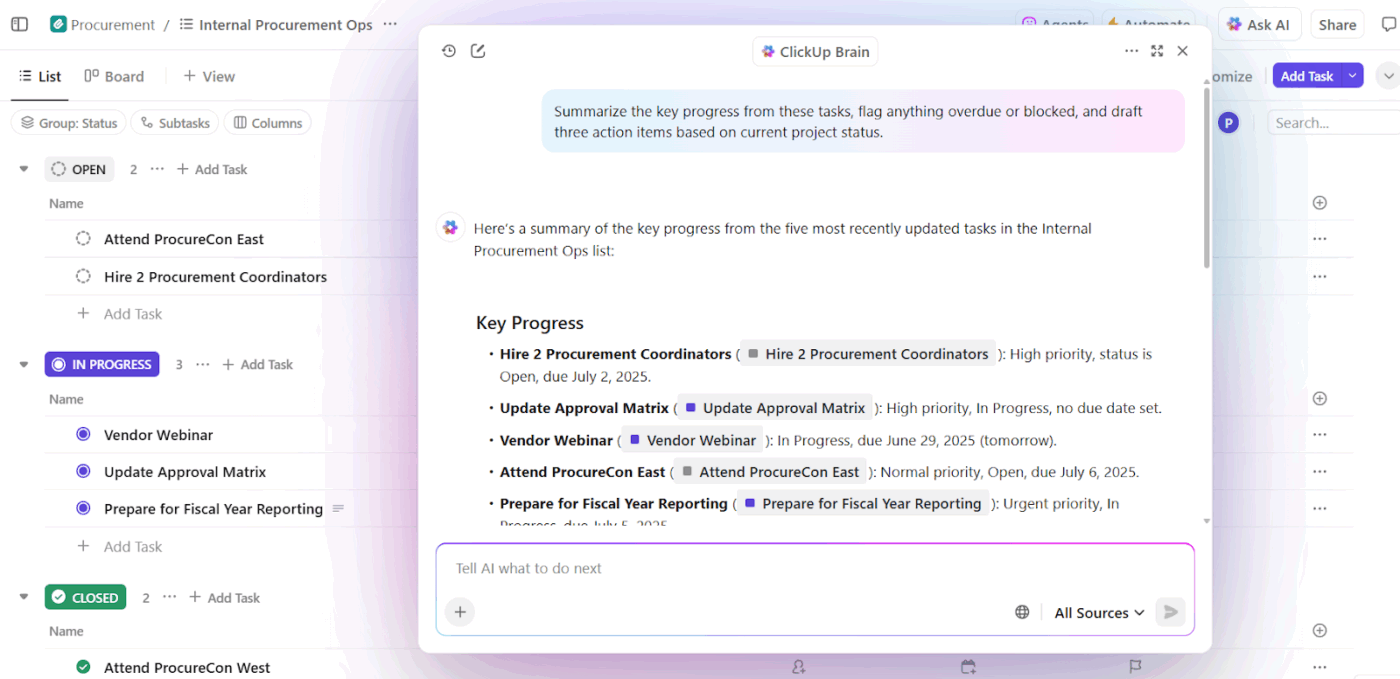

Asistentes de escritura con IA y productividad en el lugar de trabajo

Las herramientas de escritura con IA solo aportan valor cuando comprenden en qué estás trabajando, por qué es importante y qué existe ya. Sin ese contexto, ahorran tiempo en la redacción, pero siguen requiriendo muchas reescrituras y ajustes manuales.

Aquí es donde la ingeniería de contexto de la IA cambia los resultados. Al basar la IA en el estado de las tareas, los documentos, las decisiones pasadas y las convenciones del equipo, los asistentes de redacción pasan de la generación de textos genéricos a un soporte consciente del flujo de trabajo.

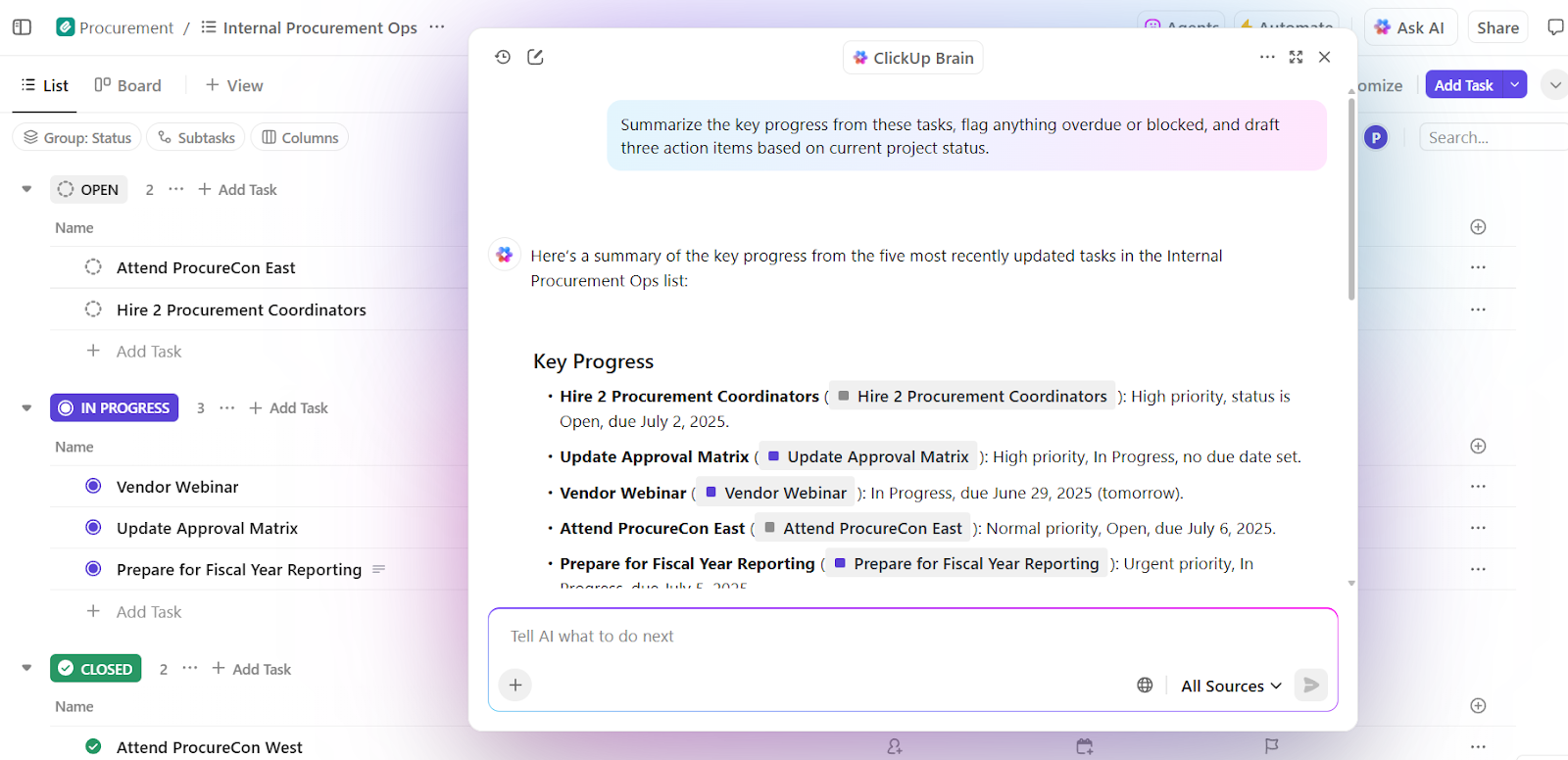

📌 Ejemplo real: ClickUp Brain, la IA nativa de ClickUp, aplica la ingeniería de contexto a nivel del entorno de trabajo. En lugar de pedir a los usuarios que peguen el contexto en las indicaciones, extrae el contexto directamente de las tareas, los documentos, los comentarios, las prioridades y los cronogramas.

Una capacidad clave es la toma de decisiones contextuales. Evalúa los proyectos en curso junto con la capacidad del equipo y el rendimiento pasado para obtener información útil.

En primer lugar, Brain puede detectar sobrecargas, retrasos y cuellos de botella. Además de resumir el problema, también recomienda ajustes concretos, como redistribuir tareas, actualizar cronogramas y reasignar prioridades.

Dado que estas decisiones se basan en el contexto de un entorno de trabajo en tiempo real, el resultado se puede utilizar de inmediato. No es necesario volver a explicar los antecedentes, explicar las prioridades ni ajustar manualmente las recomendaciones a la realidad.

Los equipos que utilizan ClickUp Brain registran unas tasas de integración completa 2,26 veces superiores y los índices de frustración con la IA más bajos (27,1 %).

Inteligencia del equipo de ventas y CRM

Los flujos de trabajo de ventas abarcan correos electrónicos, reuniones, CRM y hojas de cálculo. Sin contexto, la IA no puede comprender el impulso de la negociación ni la intención del comprador.

La ingeniería de contexto proporciona a la IA visibilidad sobre las conversaciones de los compradores, los cronogramas, el tono de la comunicación y la interacción pasada. Esto ayuda a obtener información, detectar acuerdos estancados y sugerir la siguiente acción adecuada.

📌 Ejemplo real: El propio equipo de ventas de Microsoft utiliza Copilot for Sales, que extrae contexto de Outlook, llamadas de Teams, actualizaciones de CRM y notas para obtener la información adecuada y redactar seguimientos. Los equipos internos observaron un aumento del 20 % en los acuerdos cerrados y un incremento del 9,4 % en los ingresos por vendedor, lo que demuestra cómo la IA basada en el contexto amplifica el rendimiento.

Asistentes de IA para la asistencia sanitaria y clínica

Las decisiones médicas se basan en el historial del paciente, los informes de laboratorio, las recetas y las notas del médico, pero esta información suele encontrarse en sistemas desconectados. Esto hace que los médicos pierdan mucho tiempo volviendo a introducir datos y corran el riesgo de pasar por alto detalles críticos. A veces dedican casi el 40 % de su tiempo a tareas administrativas.

La ingeniería de contexto de IA establece la conexión entre estos puntos de datos. Ayuda a los médicos con resúmenes precisos, borradores de documentación, destaca el historial relevante y muestra los riesgos potenciales o los siguientes pasos a seguir.

📌 Ejemplo real: Atrium Health utiliza Nuance DAX Copilot, desarrollado en colaboración con Microsoft, para documentar automáticamente las visitas clínicas utilizando registros anteriores y conversaciones en tiempo real. Como resultado, los médicos ahorraron entre 30 y 40 minutos al día en documentación, mientras que un estudio realizado en 12 especialidades médicas reveló una mayor eficiencia y satisfacción de los proveedores sin comprometer la seguridad de los pacientes.

Asistentes de RR. HH. y reclutamiento

Las decisiones de contratación dependen del contexto, como las habilidades, los comentarios de las entrevistas, la adecuación al rol y los datos de contrataciones anteriores. La ingeniería de contexto con IA permite analizar currículos, descripciones de puestos, transcripciones de entrevistas y patrones históricos para identificar más rápidamente las candidaturas más adecuadas.

📌 Ejemplo real: Los equipos empresariales de Micron utilizan Eightfold IA, una plataforma de inteligencia de talento que analiza currículos, requisitos de puestos, trayectorias profesionales internas y resultados de contrataciones anteriores para predecir la idoneidad de los candidatos. La plataforma evalúa a los candidatos en función de sus habilidades y su potencial. ¿El resultado? La ampliación de su cartera de talentos y la contratación de ocho candidatos más al mes con un equipo de selección reducido.

Herramientas y plataformas con compatibilidad para la ingeniería de contexto

¿Qué herramientas te ayudan a implementar la ingeniería de contexto a gran escala?

1. LangChain (lo mejor para ensamblar el contexto mediante programación)

LangChain es un marco de orquestación de código abierto para crear sistemas de IA en los que el contexto debe ensamblarse, actualizarse y enrutarse mediante programación.

La herramienta de agente de IA ayuda a los desarrolladores a conectar los LLM con herramientas, fuentes de datos, memoria y lógica de control, en lugar de depender de indicaciones estáticas.

Core LangChain se encarga del encadenamiento y la recuperación, mientras que LangGraph permite flujos de trabajo basados en grafos con estado para razonamientos complejos de varios pasos.

DeepAgents se basa en este principio para ofrecer compatibilidad con agentes autónomos de larga duración que planifican, subagentes y contexto persistente.

En conjunto, estos componentes convierten a LangChain en una capa de control para la ingeniería de contexto, que decide cuándo se captura el contexto, cómo evoluciona y dónde fluye a través de los flujos de trabajo de los agentes.

Las mejores funciones de LangChain

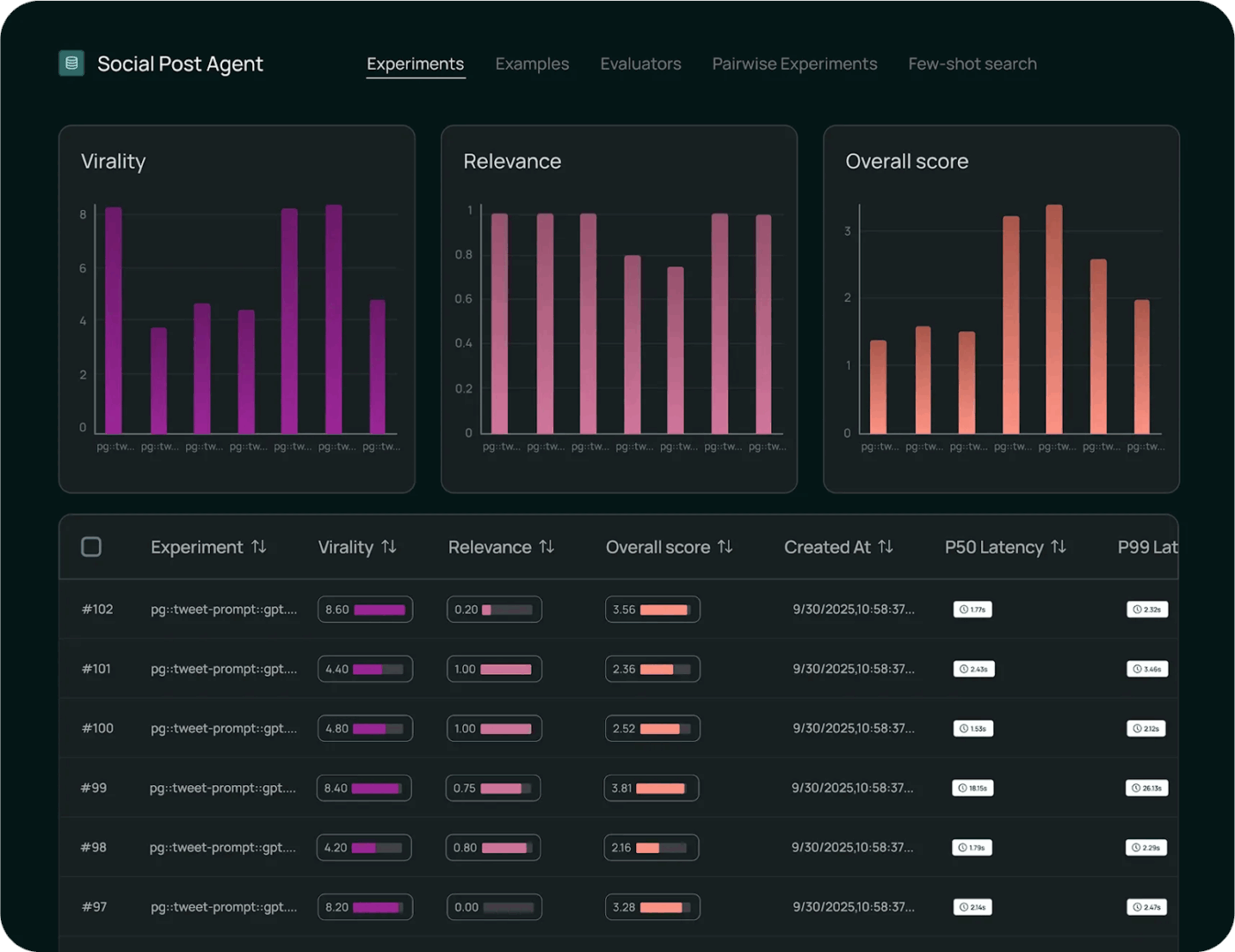

- Supervise la ejecución con herramientas de observabilidad para realizar el seguimiento de las llamadas al modelo, la latencia, los errores y el flujo de contexto de extremo a extremo para obtener información sobre la depuración y el rendimiento.

- Evalúa el comportamiento del modelo de forma sistemática utilizando marcos de pruebas integrados que miden la corrección, comparan los resultados y validan los cambios con respecto a los puntos de referencia.

- Implemente flujos de trabajo a escala con entornos gestionados que ofrezcan compatibilidad con versiones, control de implementaciones y ejecución lista para producción de cadenas y agentes.

Limitaciones de LangChain

- La herramienta tiene una curva de aprendizaje pronunciada para los principiantes, y la documentación, que se actualiza cada pocos días, resulta abrumadora.

Precios de LangChain

- Desarrollador: Gratis, gratuito/a

- Más: 39 $/usuario/mes

- Enterprise: Precios personalizados

Valoraciones y reseñas de LangChain

- G2: 4,7/5 (más de 30 reseñas)

- Capterra: No hay suficientes valoraciones y reseñas.

¿Qué opinan los usuarios reales sobre LangChain?

Según un usuario de Reddit:

Después de probar varios métodos diferentes, lo que más me ha gustado es utilizar la llamada a herramientas estándar con flujos de trabajo de Langgraph. Así que envuelvo los flujos de trabajo deterministas como agentes que el LLM principal llama como herramientas. De esta manera, el LLM principal proporciona una experiencia de usuario dinámica genuina y simplemente pasa el trabajo pesado a un flujo de trabajo, que luego devuelve su resultado al LLM principal.

Después de probar varios métodos diferentes, lo que más me ha gustado es utilizar la llamada a herramientas estándar con flujos de trabajo de Langgraph. Así que envuelvo los flujos de trabajo deterministas como agentes que el LLM principal llama como herramientas. De esta manera, el LLM principal proporciona una experiencia de usuario dinámica genuina y simplemente pasa el trabajo pesado a un flujo de trabajo, que luego devuelve su resultado al LLM principal.

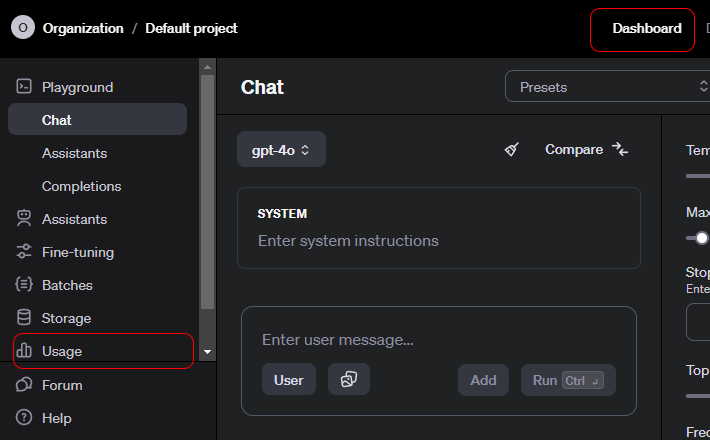

2. API de OpenAI (la API de IA contextual proporciona contexto estructurado, llamada de herramientas y controles a nivel del sistema).

La API de OpenAI es una interfaz de uso general para acceder a modelos avanzados de IA generativa que impulsan una amplia gama de aplicaciones.

Los desarrolladores lo utilizan para integrar la comprensión y la generación del lenguaje en los productos. También ofrece compatibilidad con la resumición, las traducciones, la asistencia con el código y el razonamiento.

La API tiene compatibilidad con chat, incrustaciones, llamadas a funciones, moderación y entradas multimodales, lo que permite interacciones estructuradas con los modelos. OpenAI es ideal para la creación rápida de prototipos, ya que se encarga de la autenticación, el escalado y el control de versiones.

La facilidad de uso se atribuye a la forma en que la API abstrae el complejo comportamiento del modelo en puntos finales sencillos y fiables.

Las mejores funciones de la API de OpenAI

- Genere resultados sensibles al contexto en texto, código y entradas multimodales para tareas y razonamientos en lenguaje natural.

- Crea incrustaciones ricas para potenciar la búsqueda semántica, la agrupación y los flujos de trabajo de recuperación basados en vectores.

- Invoca funciones y herramientas a través de llamadas estructuradas que permiten a los modelos interactuar con sistemas y servicios externos.

Limitación de la API de OpenAI

- Sin memoria nativa a largo plazo. La API es sin estado de forma predeterminada, por defecto.

Precios de la API de OpenAI

GPT-5. 2

- Entrada: 1,750 $ / 1 millón de tokens

- Entrada almacenada en caché: 0,175 $ / 1 millón de tokens

- Resultado: 14 000 $ / 1 millón de tokens

GPT-5. 2 Pro

- Entrada: 21,00 $ / 1 millón de tokens

- Entrada almacenada en caché: No disponible

- Resultado: 168,00 $ / 1 millón de tokens

GPT-5 Mini

- Entrada: 0,250 $ / 1 millón de tokens

- Entrada almacenada en caché: 0,025 $ / 1 millón de tokens

- Resultado: 2000 $ / 1 millón de tokens

Valoraciones y reseñas de la API de OpenAI

- G2: No hay suficientes reseñas

- Capterra: No hay suficientes reseñas.

¿Qué opinan los usuarios reales sobre la API de OpenAI?

Según un usuario de Reddit:

Las API de OpenAI son como cualquier otra, por lo que, desde un punto de vista técnico, no debería haber ninguna curva de aprendizaje. Todos los puntos finales, parámetros y respuestas de ejemplo están bien documentados. Si tienes experiencia básica en desarrollo, no deberías necesitar un curso. Estoy de acuerdo con el punto anterior sobre aprender Python. Las bibliotecas de Python tienen toda la información relevante para facilitarte la vida. También hay bibliotecas Node si quieres seguir con JS. La mayor curva de aprendizaje será cómo utilizarlas estratégicamente. Dedica algo de tiempo a probar los mensajes del sistema, las indicaciones para el usuario y los parámetros en el Playground antes de intentar construirlo con código. (Estoy bastante seguro de que puedes obtener código de muestra del Playground después de encontrar algo que funcione).

Las API de OpenAI son como cualquier otra, por lo que, desde un punto de vista técnico, no debería haber ninguna curva de aprendizaje. Todos los puntos finales, parámetros y respuestas de ejemplo están bien documentados. Si tienes experiencia básica en desarrollo, no deberías necesitar un curso. Estoy de acuerdo con el punto anterior sobre aprender Python. Las bibliotecas de Python tienen toda la información relevante para facilitarte la vida. También hay bibliotecas Node si quieres seguir con JS. La mayor curva de aprendizaje será cómo utilizarlas estratégicamente. Dedica algo de tiempo a probar los mensajes del sistema, las indicaciones para el usuario y los parámetros en el Playground antes de intentar construirlo con código. (Estoy bastante seguro de que puedes obtener código de ejemplo del Playground después de encontrar algo que funcione).

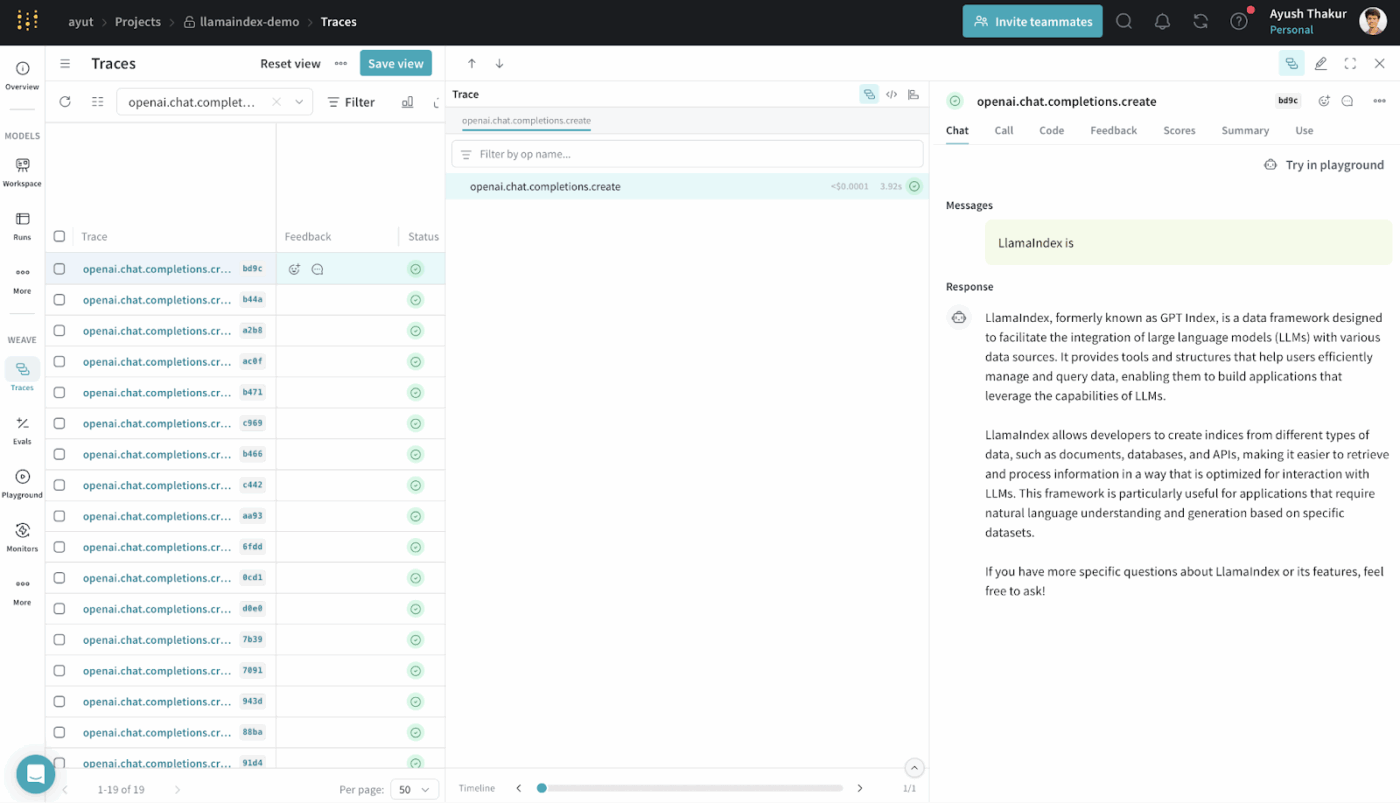

3. LlamaIndex (el mejor sistema de generación de aumento de recuperación)

LlamaIndex es un marco de datos de código abierto diseñado para que los datos externos sean accesibles y utilizables para los modelos de lenguaje grandes.

Proporciona conectores, índices e interfaces de consulta que transforman los datos estructurados y no estructurados en representaciones que los LLM pueden razonar de manera eficiente.

Se pueden crear sistemas RAG sin una infraestructura personalizada compleja. Estos sistemas abstraen la recuperación, la vectorización y la clasificación por relevancia.

Se utiliza habitualmente para casos de uso como la búsqueda semántica, el resumen y la respuesta a preguntas, basándose en datos reales.

Las mejores funciones de LlamaIndex

- Crea índices de fuentes de datos heterogéneas en estructuras buscables que los LLM puedan utilizar para realizar consultas de forma eficaz.

- Recupera el contexto de forma estratégica utilizando la búsqueda vectorial y la planificación de consultas para una inyección precisa de pruebas.

- Comprimir y resumir el contexto para mantener un razonamiento eficiente y relevante.

Precios de LlamaIndex

- Free

- Inicio: 50 $ al mes

- Ventaja: 500 $ al mes

- Corporación: Precios personalizados

Valoraciones y reseñas de LlamaIndex

- G2: No hay suficientes reseñas

- Capterra: No hay suficientes reseñas.

¿Qué opinan los usuarios reales sobre LlamaIndex?

Un usuario comparte en Reddit:

Sinceramente, creo que la mayoría de estos marcos de genAi, como langchain o llamaindex, no son tan buenos y complican el código. Es mejor usar Python básico.

Sinceramente, creo que la mayoría de estos marcos de genAi, como langchain o llamaindex, no son tan buenos y complican el código. Es mejor usar Python básico.

4. ClickUp BrainGPT (el mejor asistente de IA para tu entorno de trabajo)

La mayoría de las herramientas de esta lista te ayudan con aspectos específicos de la ingeniería de contexto. Recopilan indicaciones, recuperan datos u organizan flujos de trabajo.

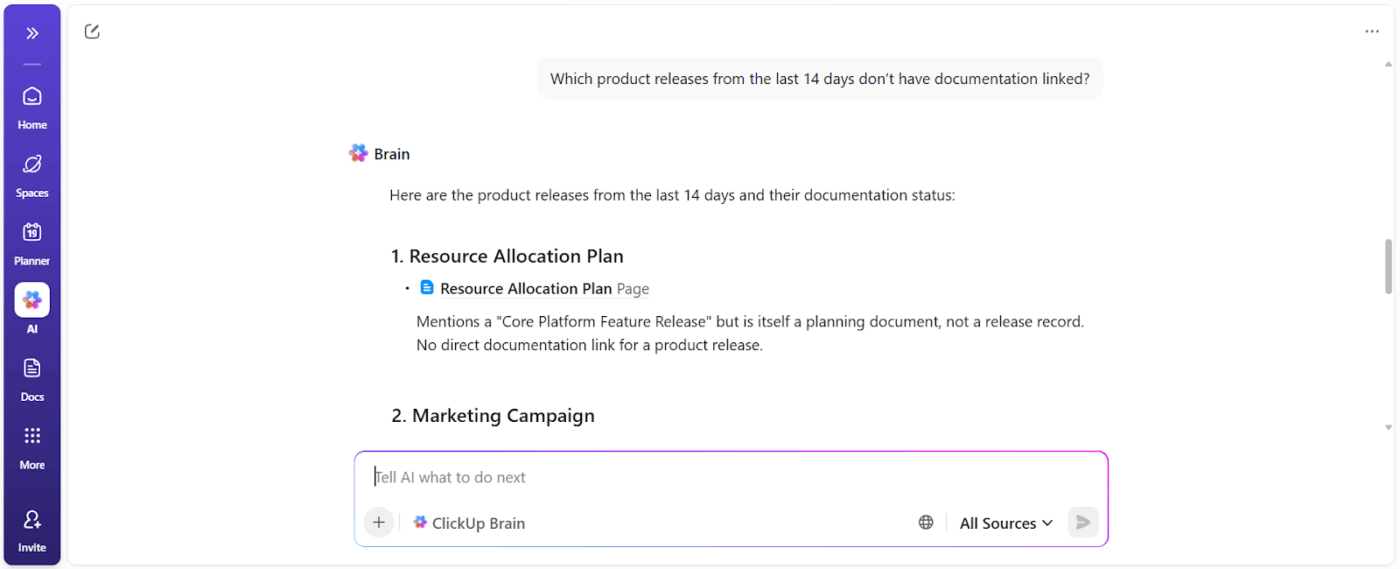

ClickUp Brain adopta un enfoque diferente. Como primer entorno de trabajo de IA convergente del mundo, ClickUp unifica tus proyectos, tareas, documentos y comunicaciones en una única plataforma, con una IA sensible al contexto integrada en su interior.

Así es como se hace 👇

Trabaja con una IA que te entienda a ti y a tu trabajo.

ClickUp Brain entiende el contexto de tu trabajo.

Extrae el contexto de tus tareas de ClickUp, documentos, comentarios, dependencias, estados, cronogramas y propiedad de ClickUp. No es necesario que pegues el contexto ni expliques el historial del proyecto cada vez que le hagas una pregunta basada en los datos del entorno de trabajo de ClickUp.

📌 Por ejemplo, cuando un gerente pregunta: «¿Qué está ralentizando la campaña del tercer trimestre?», escanea el entorno de trabajo y muestra obstáculos concretos como:

- Tareas sin asignar

- A la espera de aprobaciones

- Revisiones estancadas

- Dependencias en espera de activos

Se obtiene un informe de bloqueadores que muestra los propietarios de las acciones y el impacto en el tiempo.

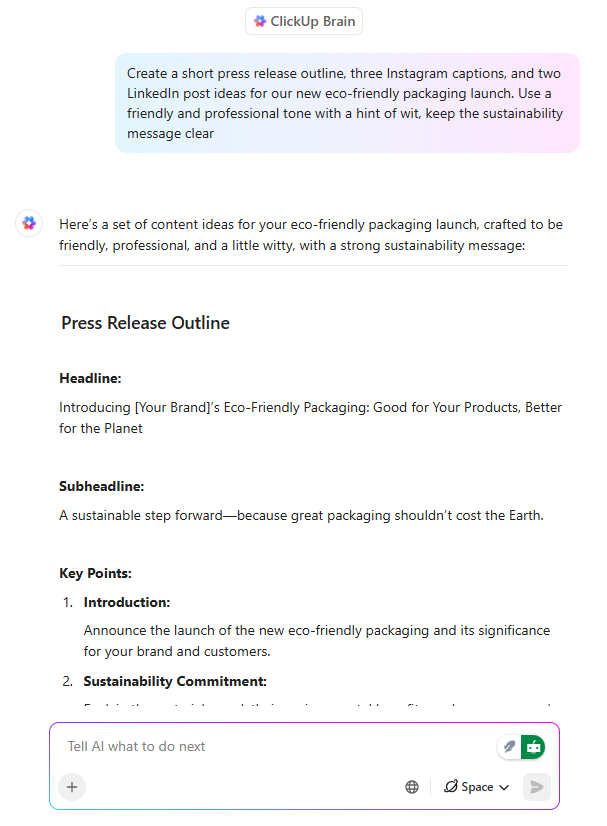

Redacción con IA que ya está alineada con la ejecución

ClickUp Brain actúa como un asistente de escritura con IA, pero con una diferencia fundamental: escribe teniendo en cuenta lo que el equipo está creando.

Cuando un gestor de proyectos o un comercial redacta un mensaje de lanzamiento en un documento de ClickUp, Brain puede:

- Defina las propuestas de valor utilizando el contexto del producto existente.

- Adaptar los mensajes a los diferentes niveles de audiencia

- Reescribe el contenido para que coincida con el tono, la claridad o las metas de posición.

Y lo que es más importante, que la redacción siga estando relacionada con las tareas, los cronogramas y las aprobaciones. No hay desconexión entre la documentación y el trabajo. Se ahorra mucho tiempo, ya que no es necesario reinterpretar el contenido más adelante.

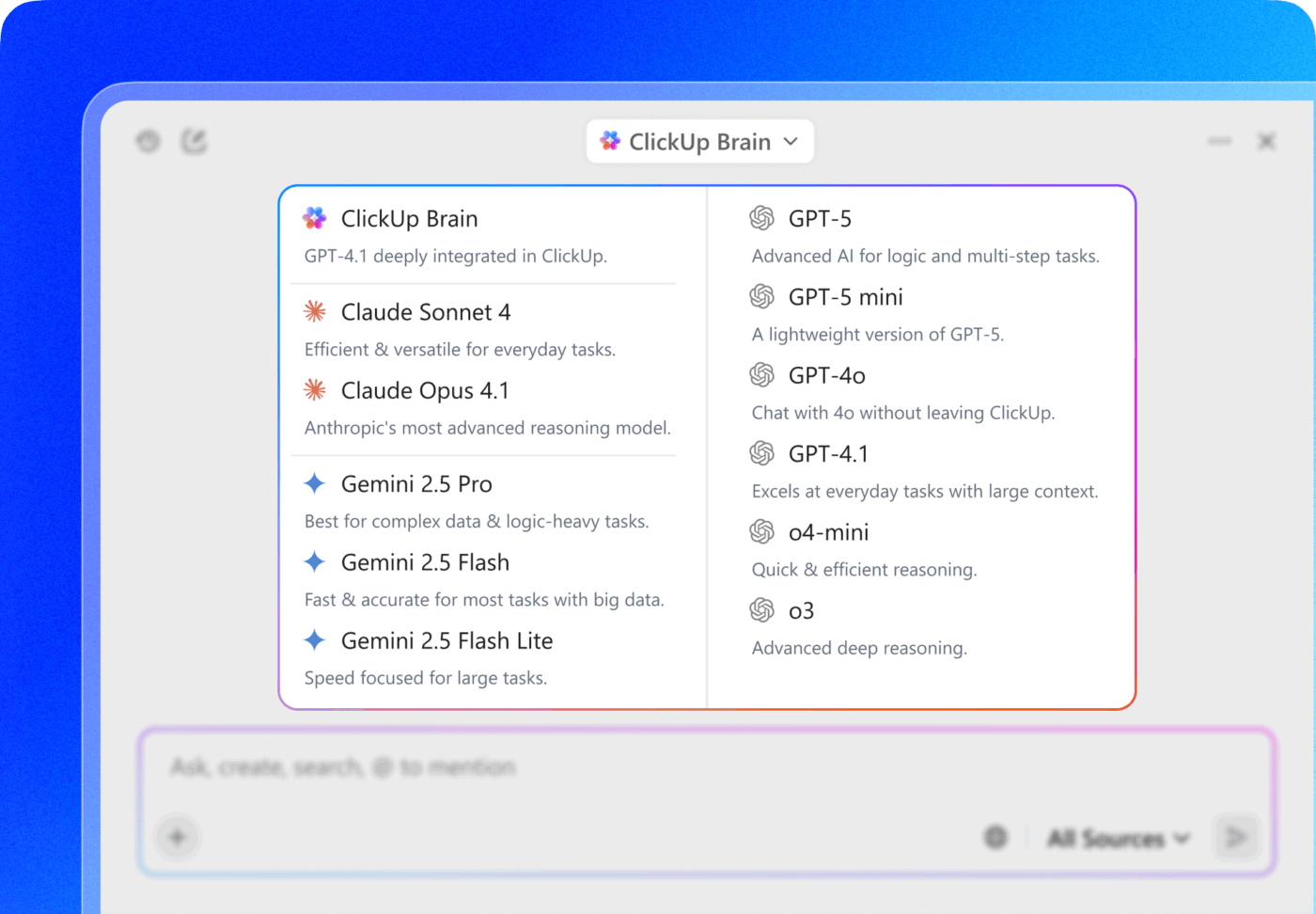

💡 Consejo profesional: ¡Elige entre varios modelos de IA de las familias ChatGPT, Claude y Gemini directamente en ClickUp Brain!

- Utiliza un modelo rápido y ligero para resumir las notas de las reuniones dentro de una tarea.

- Cambie a un modelo más basado en el razonamiento cuando analice el rendimiento de las campañas en documentos, tareas y paneles.

¿La verdadera jugada maestra? Combina la selección del modelo con el contexto conectado de ClickUp (tareas, comentarios, documentos y Campos personalizados ) para que el modelo no solo sea «inteligente», sino que funcione dentro de la realidad de tu entorno de trabajo.

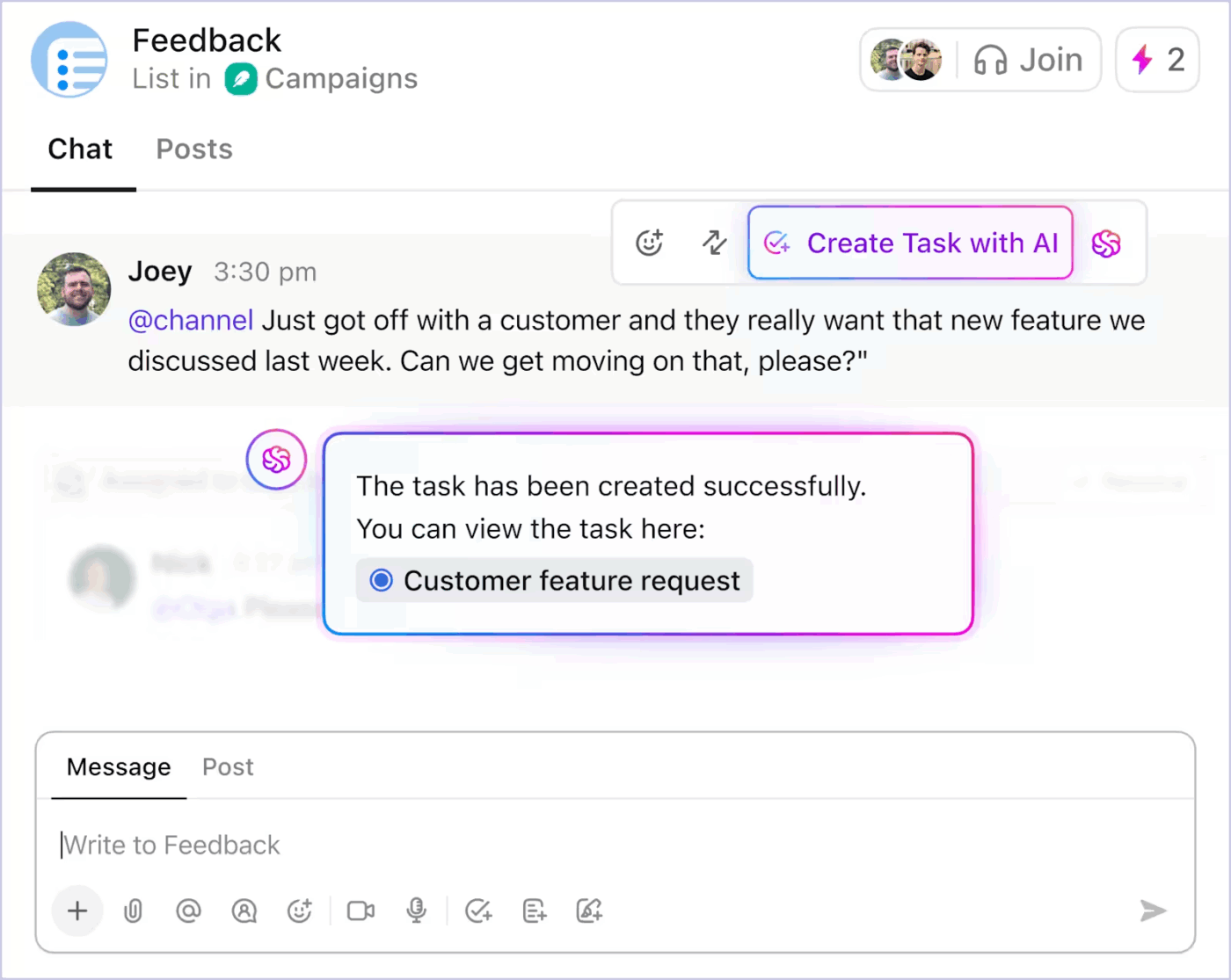

Automatización de tareas contextuales que reduce la sobrecarga manual.

Con las tareas impulsadas por IA, ClickUp convierte el contexto en acción. Las funciones principales incluyen:

- Convierte las conversaciones de ClickUp Chat en tareas.

- Genera subtareas y descripciones de tareas a partir del título de una tarea existente en función del alcance.

- Sugerir los siguientes pasos cuando el trabajo se estanca.

- Automatizar las actualizaciones rutinarias utilizando el estado real del proyecto.

A continuación te explicamos cómo puedes utilizar la automatización de tareas basada en IA en ClickUp para reducir el trabajo pesado 👇.

Dado que la automatización se basa en el contexto en tiempo real, los equipos dedican menos tiempo a traducir la intención en estructura. El trabajo avanza sin necesidad de una intervención manual constante.

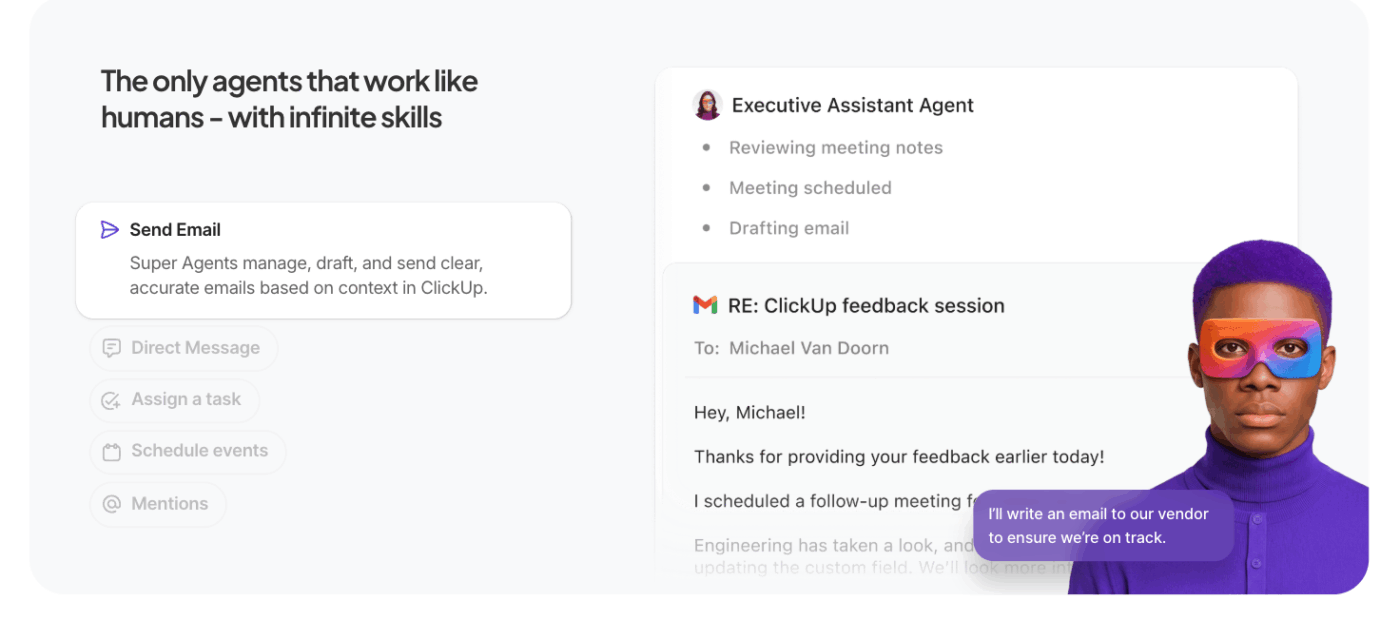

Deja que los agentes IA hagan el trabajo pesado.

Los superagentes de ClickUp amplían la IA contextual de ClickUp más allá de las consultas individuales para permitir una ejecución autónoma en varios pasos.

En lugar de esperar indicaciones específicas, estos agentes de IA para la automatización «actúan» en tu nombre dentro del entorno de trabajo, realizando tareas, reglas y resultados basados en el contexto y las metas que tú definas.

Lo que los diferencia de los agentes habituales:

- Ejecución proactiva de tareas: los agentes interpretan el contexto del entorno de trabajo (tareas, dependencias, cronogramas) y llevan a cabo secuencias como actualizar estados, crear subtareas o notificar a los propietarios sin necesidad de instrucciones manuales.

- Flujos de trabajo orientados a metas: se define una meta de alto nivel (por ejemplo, «Resolver los obstáculos de la campaña del tercer trimestre») y el agente planifica, recupera el contexto y ejecuta las acciones que hacen avanzar el trabajo.

- Contexto y memoria persistentes: los agentes mantienen el estado a lo largo de los pasos, lo que les permite razonar sobre lo que ya se ha hecho y lo que queda pendiente, mejorando la precisión y reduciendo el trabajo redundante.

- Integración con herramientas del entorno de trabajo: interactúan con tareas de ClickUp, documentos y comentarios, así como con herramientas conectadas, coordinándose entre sistemas para completar flujos de trabajo en lugar de sugerir acciones sin contexto.

📚 Más información: ¿Qué son los agentes reflexivos basados en modelos?

Las mejores funciones de ClickUp

- Incorpore la IA a su escritorio y a sus aplicaciones conectadas con ClickUp Brain MAX: realice búsquedas en su entorno de trabajo, transcriba voz a texto, cambie entre los mejores modelos de IA y realice acciones en tareas, documentos y chats sin salir de su flujo de trabajo.

- Encuentre respuestas al instante con Enterprise Search : busque en tareas, documentos, comentarios, archivos y herramientas conectadas para que el contexto crítico nunca quede oculto o aislado.

- Captura ideas rápidamente con Talk to Text : dicta notas, planes o actualizaciones y convierte el habla en trabajo estructurado sin perder la concentración ni el impulso.

- Reduzca el trabajo manual con ClickUp Dashboards : active automáticamente actualizaciones de tareas, asignaciones y seguimientos basándose en el contexto real del entorno de trabajo y los cambios de estado.

- Mantén las conversaciones prácticas con ClickUp Chat: debate las decisiones, los comentarios y las aprobaciones directamente junto con las tareas para que las conversaciones sigan vinculadas a la ejecución.

- Sustituye las reuniones por SyncUps: comparte actualizaciones asíncronas, obtén resúmenes generados por IA y mantén a los equipos alineados sin llamadas recurrentes.

- Coordina equipos con Teams Hub: visualiza la actividad, la propiedad, las prioridades y la capacidad del equipo en un solo lugar para detectar riesgos y reequilibrar el trabajo con antelación.

- Planifica tu día con ClickUp Calendario : obtén planes diarios asistidos por IA basados en plazos, prioridades y carga de trabajo, para que tu enfoque personal se alinee con las metas del equipo.

Limitaciones de ClickUp

- Su conjunto de funciones y opciones de personalización pueden abrumar a los nuevos usuarios.

Precios de ClickUp

Valoraciones y reseñas de ClickUp

- G2: 4,7/5 (más de 10 585 reseñas)

- Capterra: 4. 6/5 (más de 4500 reseñas)

¿Qué opinan los usuarios reales sobre ClickUp AI?

Un usuario de ClickUp también comparte su experiencia en G2:

ClickUp Brain MAX ha sido una incorporación increíble a mi flujo de trabajo. La forma en que combina múltiples LLM en una sola plataforma hace que las respuestas sean más rápidas y fiables, y la conversión de voz a texto en toda la plataforma supone un gran ahorro de tiempo. También aprecio mucho la seguridad de nivel empresarial, que me da tranquilidad a la hora de manejar información confidencial. […] Lo que más destaca es cómo me ayuda a eliminar el ruido y pensar con más claridad, ya sea resumiendo reuniones, redactando contenido o pensando en nuevas ideas. Es como tener un asistente de IA todo en uno que se adapta a lo que necesito.

ClickUp Brain MAX ha sido una incorporación increíble a mi flujo de trabajo. La forma en que combina múltiples LLM en una sola plataforma hace que las respuestas sean más rápidas y fiables, y la conversión de voz a texto en toda la plataforma supone un gran ahorro de tiempo. También aprecio mucho la seguridad de nivel corporativo, que me da tranquilidad a la hora de manejar información confidencial. […] Lo que más destaca es cómo me ayuda a eliminar el ruido y pensar con más claridad, ya sea resumiendo reuniones, redactando contenido o pensando en nuevas ideas. Es como tener un asistente de IA todo en uno que se adapta a lo que necesito.

Retos y consideraciones a la hora de trabajar con ingeniería de contexto de IA

Estos son los principales retos que debes tener en cuenta. El contexto puede descontrolarse, incluso cuando el modelo tiene compatibilidad con ventanas de contexto de 1 millón de tokens. Estos son los principales retos que debes tener en cuenta 👇

Contaminación del contexto

Si se cuela una alucinación o una inferencia incorrecta en el contexto y se hace referencia a ella repetidamente, el modelo la trata como un hecho. Este contexto contaminado puede bloquear los flujos de trabajo en suposiciones inválidas que persisten en el tiempo y degradan la calidad del resultado.

Distracción del contexto

Los contextos más amplios son tentadores, pero cuando el contexto crece demasiado, los modelos comienzan a centrarse excesivamente en el historial acumulado y a infrautilizar lo que han aprendido durante el entrenamiento. Esto puede hacer que la IA se quede atascada en detalles del pasado en lugar de sintetizar el siguiente paso más adecuado.

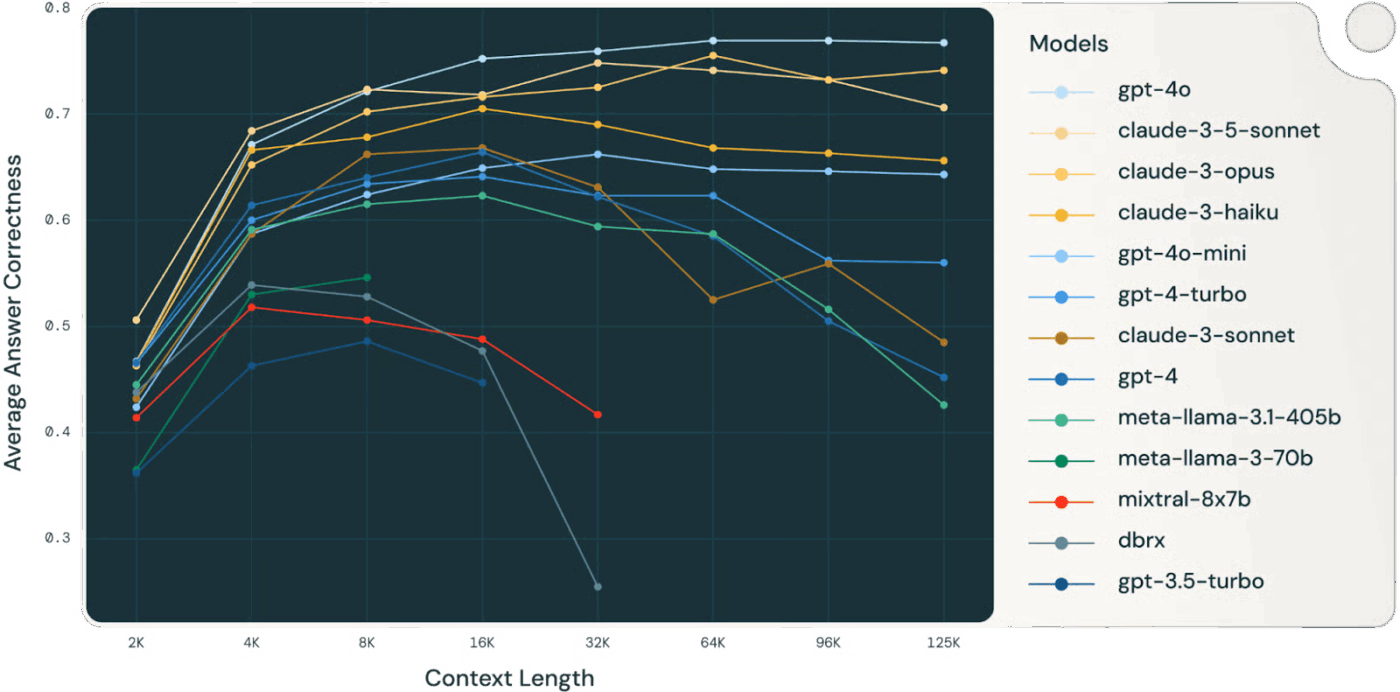

👀 ¿Sabías que...? Un estudio de Databricks descubrió que la precisión del modelo para Llama 3. 1 405B comenzó a disminuir alrededor de los 32 000 tokens, mucho antes de que se llenara la ventana de contexto. Los modelos más pequeños se degradaron incluso antes.

Los modelos suelen perder calidad de razonamiento mucho antes de «agotar» el contexto, lo que hace que la selección y compresión del contexto sean más valiosas que el tamaño bruto del contexto.

📚 Más información: ¿Qué es la búsqueda en el lugar de trabajo y cómo mejora la productividad de los empleados?

Confusión contextual

La información irrelevante o de baja señal en el contexto compite por la atención con los datos críticos. Cuando el modelo se ve obligado a utilizar todos los tokens de contexto, las decisiones se vuelven confusas y la precisión se ve afectada, incluso si técnicamente hay «más» información.

Conflicto de contexto

A medida que se acumula la información, los nuevos datos o las descripciones de las herramientas pueden contradecir el contenido anterior. Cuando existe un contexto contradictorio, los modelos tienen dificultades para conciliar las señales conflictivas, lo que da lugar a resultados incoherentes o inconsistentes.

Sobrecarga de herramientas y problemas de selección

Cuando se incluyen demasiadas definiciones de herramientas en el contexto, sin filtrar, el modelo puede llamar a herramientas irrelevantes o dar prioridad a otras que no son óptimas. La carga selectiva de solo las herramientas relevantes mitiga la confusión y mejora la calidad de las decisiones.

Complejidad de la ingeniería y mantenimiento

Una gestión eficaz del contexto requiere una poda, resumir, descarga y cuarentena continuos del contexto. Los sistemas deben decidir cuándo comprimir el historial y cuándo capturar información nueva, lo que exige una infraestructura bien pensada en lugar de indicaciones ad hoc.

Disciplina en el presupuesto de tokens

Cada token influye en el comportamiento; las ventanas de contexto más grandes no garantizan mejores resultados. Es necesario tratar el contexto como un recurso gestionado, sopesando la relevancia y la actualidad frente al coste de los tokens y el presupuesto de atención del modelo.

⚠️ Alerta estadística: casi el 60 % de los empleados admite que utiliza herramientas de IA públicas no autorizadas en el trabajo, a menudo pegando datos confidenciales de la empresa en plataformas sin ningún tipo de supervisión.

Y la cosa empeora: el 63 % de las organizaciones no cuentan con políticas de gobernanza de IA para supervisar, restringir o incluso detectar este uso oculto de la IA.

¿El resultado? Tus datos se filtran porque nadie supervisa cómo se utiliza la IA.

El futuro de la ingeniería de contexto

Esto marca la transición de la experimentación a la escala. El contexto ya no será gestionado por humanos, sino generado y gestionado por código. Será una función de la propia estructura del sistema.

Resumiremos esto utilizando como base el excelente artículo de Serge Liatko en la comunidad de desarrolladores de OpenAI:

La ingeniería de contexto evoluciona hacia la arquitectura del flujo de trabajo.

La ingeniería de contexto dará paso cada vez más a la arquitectura de flujos de trabajo automatizados. La tarea no se limitará a introducir los tokens adecuados.

Una ingeniería de contexto eficaz implicará la coordinación de secuencias completas de razonamiento, herramientas y flujos de datos que se adapten automáticamente a las necesidades cambiantes.

Esto implica crear sistemas dinámicos que autogestionen el contexto adecuado dentro de flujos de trabajo holísticos.

La automatización de la orquestación sustituye a las indicaciones manuales.

La próxima frontera es la IA que se organiza por sí misma. Conectará la recuperación, las herramientas, la memoria y la lógica empresarial sin que los humanos tengan que crear manualmente cada indicación o paquete de contexto. En lugar de proporcionar explícitamente cada dato, los sistemas inferirán qué contexto es relevante y lo gestionarán automáticamente en función de las metas y el historial.

🧠 Esto ya está sucediendo con ClickUp Super Agents. Son compañeros de equipo de IA ambientales y siempre activos, lo que les ayuda a comprender y ejecutar el trabajo tal y como lo hacen los humanos. Mejoran continuamente a partir de interacciones pasadas utilizando una memoria rica (preferencias de aprendizaje, acciones recientes e historial de proyectos) y pueden actuar de forma proactiva, escalar problemas o aportar ideas sin esperar a que se les solicite una indicación.

La automatización integral se convierte en la verdadera palanca de la productividad.

A medida que evoluciona la ingeniería de contexto, las ganancias en productividad provienen de los flujos de trabajo automatizados. Los LLM actúan como agentes, coordinando herramientas, supervisando el estado y ejecutando lógica de múltiples pasos sin la microgestión del usuario.

No será necesario introducir manualmente el contexto que falta. El sistema seleccionará el contexto para apoyar la memoria a largo plazo y el razonamiento.

El contexto unificado mejora el trabajo de la IA.

La precisión de la IA se rompe cuando el contexto se fragmenta entre herramientas, flujos de trabajo y personas. Cuando la información está dispersa, los modelos se ven obligados a adivinar.

Los entornos de trabajo de IA convergentes como ClickUp destacan en esto: unifican el trabajo, los datos y la IA en tu estrategia de contexto.

¿Listo para intentarlo? Regístrate en ClickUp de forma gratuita.