Hugging Face ha creado un impresionante ecosistema para desarrolladores de ML, desde su enorme hub de modelos hasta sus herramientas de implementación sin fisuras.

Pero a veces tu proyecto requiere algo diferente. Quizás necesites una infraestructura especializada, seguridad de nivel empresarial o flujos de trabajo personalizados que otras alternativas a Hugging Face gestionan mejor.

Tanto si estás creando chatbots, ajustando LLM o ejecutando procesos de PLN que harían llorar de alegría a tu científico de datos, hay un montón de plataformas listas para satisfacer tus necesidades de IA.

En este blog, hemos recopilado las mejores alternativas a Hugging Face, desde potentes API en la nube hasta kits de herramientas de código abierto y plataformas de flujo de trabajo de IA integrales.

Las mejores alternativas a Hugging Face de un vistazo

Aquí tienes una comparación de las mejores alternativas a Hugging Face. 📄

| Herramienta | Ideal para | Mejores funciones | Precios* |

| ClickUp | Incorpore la IA directamente a la gestión diaria de su trabajo, desde tareas hasta documentos y automatización. Tamaño del equipo: ideal para particulares, startups y corporaciones. | IA Notetaker, Autopilot Agents, Brain MAX, Enterprise AI Search, generación de imágenes en pizarras blancas, acceso a Claude/ChatGPT/Gemini, automatización mediante lenguaje natural. | Gratis para siempre, con personalizaciones disponibles para corporaciones. |

| OpenAI | Creación con modelos de lenguaje avanzados y API para texto, imágenes e incrustaciones. Tamaño del equipo: ideal para desarrolladores de IA y startups que crean con LLM. | Ajuste fino, procesamiento de PDF/imágenes, análisis semántico de archivos, paneles de control de costes, indicaciones de temperatura/sistema. | Basado en el uso |

| Anthropic Claude | Creación de conversaciones más seguras y ricas en contexto, y respuestas LLM bien pensadas. Tamaño del equipo: ideal para equipos que necesitan seguridad, contexto amplio y razonamiento ético. | Búsqueda web en tiempo real, generación de resultados estructurados (JSON/XML), memoria de alto contexto, compatibilidad con matemáticas/estadísticas. | Basado en el uso |

| Cohere | Diseño de soluciones de PLN multilingües y seguras a escala de corporación Tamaño del equipo: Ideal para equipos orientados al cumplimiento normativo con necesidades de PLN multilingües. | Ajuste fino de datos privados, compatibilidad con más de 100 idiomas, paneles de análisis, inferencia escalable, integración SSO/SAML/RBAC. | Desde 0,0375 $/1 millón de tokens (Comando R7B); precios personalizados. |

| Replicar | Explora y ejecuta modelos de código abierto sin preocuparte por la configuración o los servidores. Tamaño del equipo: ideal para desarrolladores que prueban modelos de IA o crean MVP. | Modelos bifurcables, control de versiones con pruebas A/B, predicción por lotes y compatibilidad con webhooks. | Pago por uso; los precios varían según el modelo. |

| TensorFlow | Creación de sistemas de aprendizaje automático totalmente personalizados con el máximo control Tamaño del equipo: Ideal para ingenieros de ML que necesitan un control total sobre los modelos. | Supervisión de TensorBoard, conversión ONNX/SavedModel, funciones de pérdida personalizadas, entrenamiento de precisión mixta. | Free (código abierto); el uso de la computación se factura por separado. |

| Azure Machine Learning | Conecta modelos de ML al ecosistema de Microsoft con automatización y escalabilidad. Tamaño del equipo: ideal para equipos de corporación en el ecosistema Azure. | AutoML, desencadenantes de reentrenamiento, explicabilidad de modelos con SHAP/LIME, detección de desviaciones, clústeres informáticos escalables. | Precios personalizados |

| Google Gemini | Interactúa con múltiples tipos de datos (texto, código, imágenes y vídeo) a través de un único modelo de IA. Tamaño del equipo: ideal para equipos de investigación y análisis multimodal. | Comprensión de imágenes/gráficos, ejecución de Python en tiempo real, resumen de vídeos, razonamiento a partir de entradas mixtas. | Gratis; planes de pago disponibles en función del acceso al modelo. |

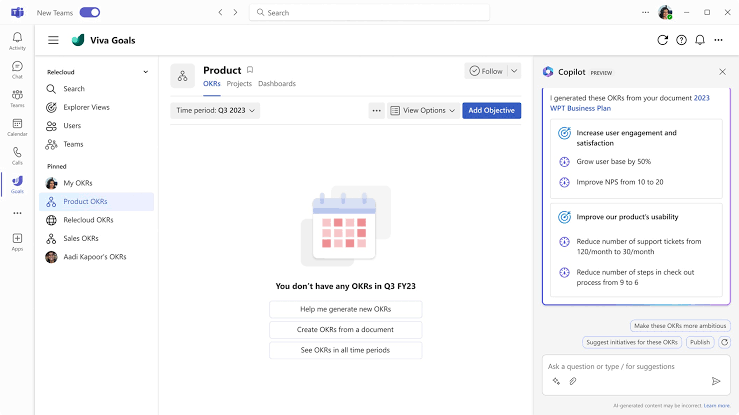

| Microsoft Copilot | Aumenta la productividad dentro de las aplicaciones de Microsoft 365 como Word, Excel y OutlookTamaño del equipo: Ideal para usuarios empresariales en el ecosistema de Microsoft 365. | Automatización de funciones de Excel, generación de diapositivas PPT, redacción de agendas/correos electrónicos, vinculación de tareas de Outlook. | Gratis; los planes de pago comienzan en 20 $ al mes. |

| IBM WatsonX | Operación de IA en sectores altamente regulados con total auditabilidad y control Tamaño del equipo: Ideal para bancos, organizaciones sanitarias y del sector público. | Detección de sesgos, plantillas de seguridad inmediata, pruebas de robustez adversaria, flujos de trabajo con intervención humana. | Gratis; los planes de pago comienzan en 1050 $ al mes. |

| BigML. com | Creación y explicación de modelos predictivos sin necesidad de código ni de aprendizaje automático. Tamaño del equipo: ideal para analistas y usuarios sin conocimientos de código. | Modelado visual de arrastrar y soltar, aprendizaje conjunto, agrupación, previsión de series temporales. | Prueba gratuita de 14 días; planes de pago a partir de 30 $ al mes. |

| LangChain | Creación de agentes de IA y flujos de trabajo que combinan múltiples modelos, herramientas y API. Tamaño del equipo: ideal para desarrolladores de IA que crean herramientas basadas en agentes. | Seguimiento y registro, almacenamiento en caché de llamadas API, lógica de respaldo, respuestas en streaming, marcos de evaluación personalizados. | Gratis; los planes de pago comienzan en 39 $ al mes. |

| Weights & Biases | Mantenga los experimentos de aprendizaje automático organizados, reproducibles y orientados al rendimiento. Tamaño del equipo: ideal para equipos de investigación de ML y laboratorios de IA. | Búsquedas de hiperparámetros, paneles de control en tiempo real, uso compartido público de experimentos, perfiles de GPU y versiones de experimentos. | Gratis; los planes de pago comienzan en 50 $ al mes. |

| ClearML | Gestión del ciclo de vida completo de MLOps, desde el seguimiento hasta la coordinación y la implementación. Tamaño del equipo: ideal para equipos de ML con muchas operaciones y uso interno de infraestructura. | Registro de auditoría, implementación azul-verde, integración CI/CD, programación fuera de horas punta, registro de modelos, herramientas de reproducibilidad. | Gratis; los planes de pago comienzan en 15 $ al mes por usuario. |

| Amazon SageMaker | Ejecución, ajuste y escalado de modelos de ML de forma nativa en la infraestructura de AWS Tamaño del equipo: Ideal para equipos basados en AWS que desarrollan a gran escala. | Etiquetado de datos Ground Truth, cuadernos gestionados, ajuste automático de hiperparámetros, puntos finales escalables, supervisión CloudWatch. | Unified Studio: gratis; otros precios dependen de la computación y el uso. |

Cómo evaluamos el software en ClickUp

Nuestro equipo editorial sigue un proceso transparente, respaldado por investigaciones y neutral con respecto a los proveedores, por lo que puede confiar en que nuestras recomendaciones se basan en el valor real del producto.

Aquí tienes un resumen detallado de cómo evaluamos el software en ClickUp.

¿Por qué optar por alternativas a Hugging Face?

He aquí por qué tiene sentido explorar alternativas a Hugging Face:

- Funciones de IA personalizadas: Encuentre plataformas con modelos de lenguaje grandes especializados para tareas específicas, como la visión artificial o el procesamiento del lenguaje natural avanzado.

- Flujos de trabajo simplificados: elija soluciones con una configuración más sencilla o interfaces sin código para acelerar la creación de prototipos y mejorar la eficiencia operativa.

- Planes rentables: descubra opciones con niveles gratuitos o precios más bajos para una gestión de datos consciente del presupuesto.

- Capacidades de integración mejoradas: busca herramientas que se sincronicen a la perfección con tu infraestructura tecnológica actual, como CRM o plataformas en la nube.

- Rendimiento escalable: opta por plataformas de IA que gestionen conjuntos de datos más grandes u ofrezcan un procesamiento más rápido para proyectos de gran envergadura.

- Mayor soporte empresarial: seleccione alternativas a Hugging Face con soporte dedicado para equipos que necesitan soluciones robustas y seguras.

- Entrenamiento de modelos personalizados: explora opciones con ajustes avanzados para crear modelos únicos y de alto rendimiento.

- Opciones de implementación innovadoras: elige herramientas con métodos de alojamiento o implementación únicos para facilitar el escalado.

🔍 ¿Sabías que...? Gracias a los transformadores, herramientas como GPT y BERT pueden leer frases completas. Capta el tono, la intención y el contexto de una forma que los modelos antiguos nunca pudieron. Por eso, la IA actual suena más natural cuando responde.

Las mejores alternativas a Hugging Face

Estas son nuestras opciones para las mejores alternativas a Hugging Face. 👇

1. ClickUp (la mejor opción para integrar la IA directamente en la gestión de proyectos, documentos y flujos de trabajo)

Todo el mundo utiliza la IA, pero la mayor parte de ella vive en silos. Tienes una herramienta para escribir, otra para resumir y una tercera para programar, pero ninguna de ellas se comunica con tu trabajo. Eso crea más expansión de la IA y un caos innecesario.

ClickUp resuelve ese problema integrando la IA donde resulta útil: en tus tareas, documentos y actualizaciones del equipo.

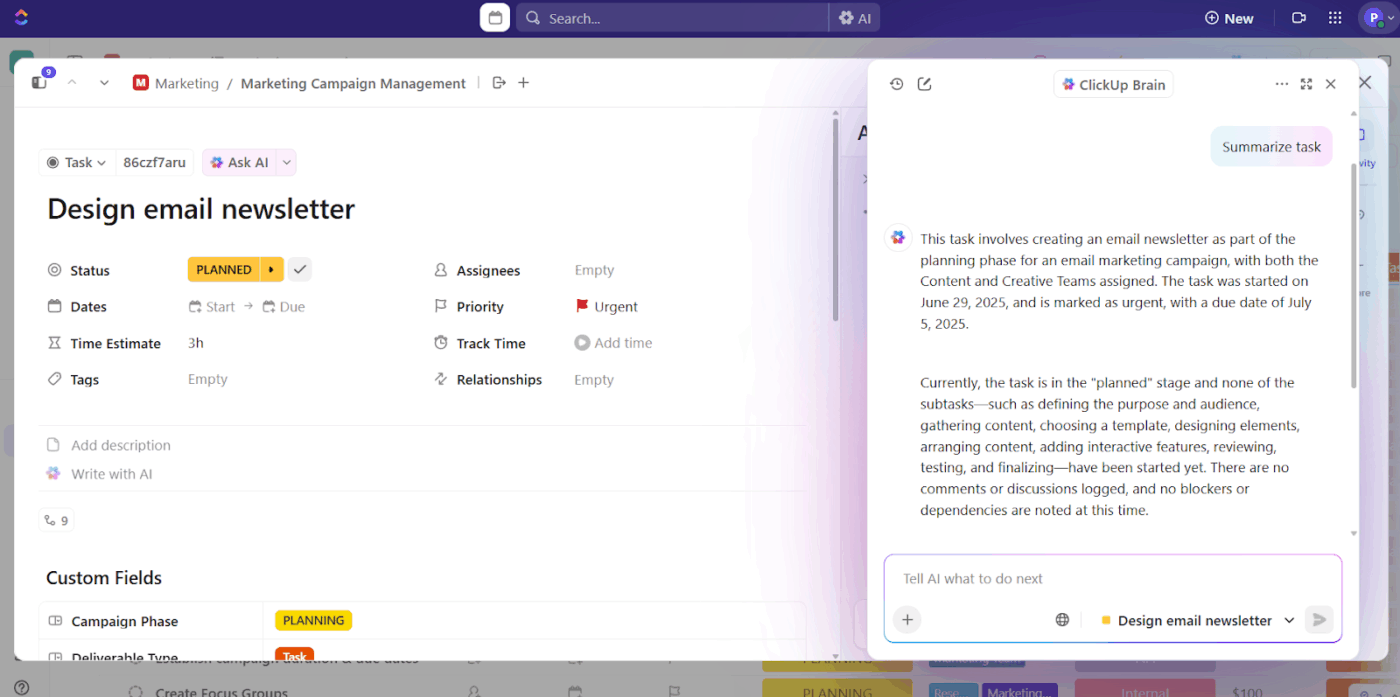

Escribe, resumir y realiza la automatización en contexto.

ClickUp Brain está integrado en todas las partes de la plataforma. Escribe contenido, resume actualizaciones, genera informes y reescribe descripciones de tareas confusas, justo donde se realiza el trabajo.

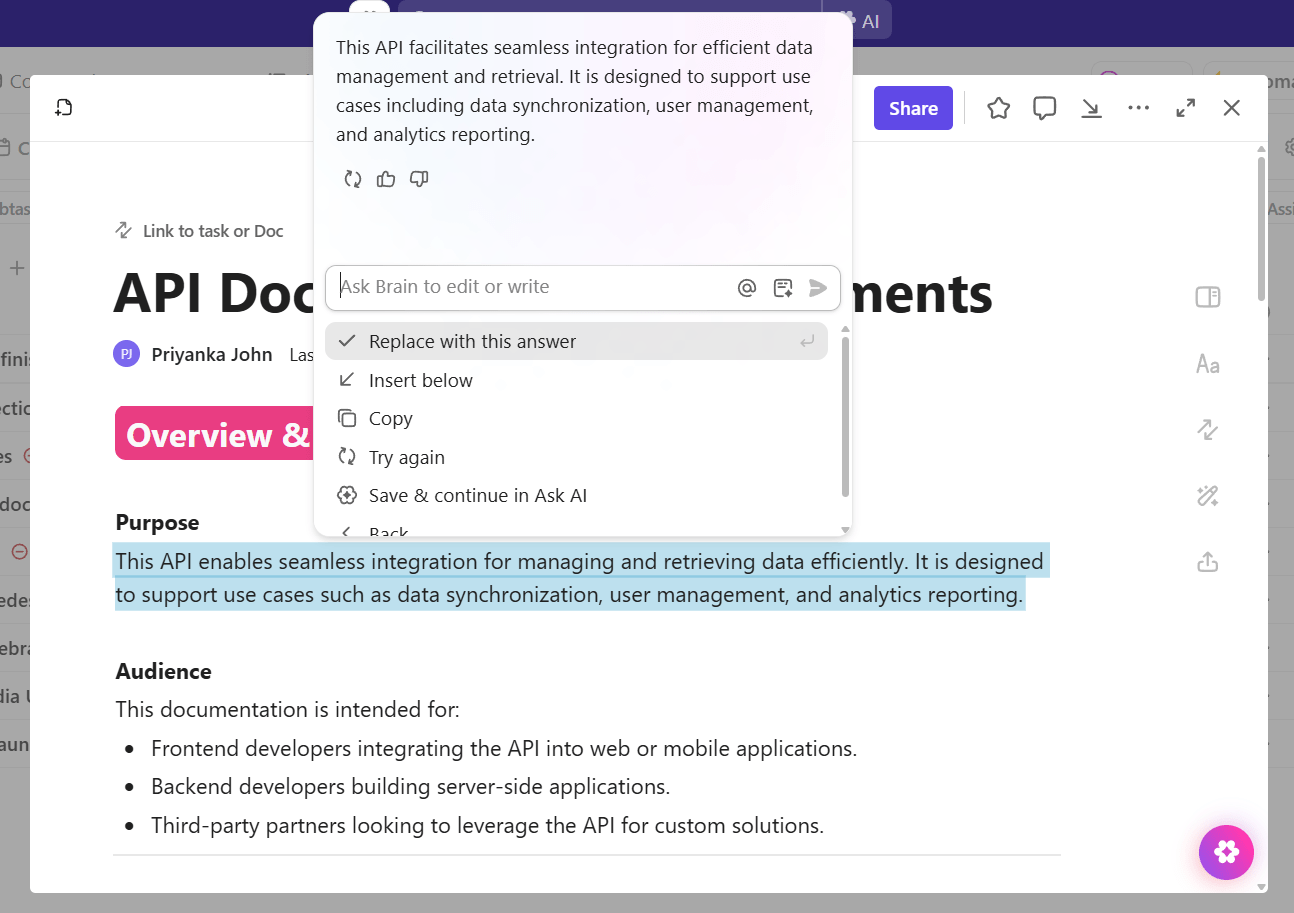

Supongamos que estás documentando los requisitos de la API para los desarrolladores.

Pega las especificaciones técnicas en un documento de ClickUp, añade viñetas sobre la autenticación y los límites de velocidad, y luego da una indicación a ClickUp Brain para que cree documentación fácil de usar para los desarrolladores con ejemplos de código.

El asistente de IA conectado estructura tus notas preliminares en secciones claras sin salir del documento, donde tu equipo podrá consultarlas.

Otros ejemplos:

- Convierte un documento de reunión extenso en un resumen del proyecto para el jefe de tu equipo.

- Reescribe las descripciones de tareas vagas para que los siguientes pasos queden más claros.

- Redacta actualizaciones periódicas para los clientes utilizando la actividad de tareas de la semana pasada.

- Resuma un hilo de planificación y asigne seguimientos a los propietarios.

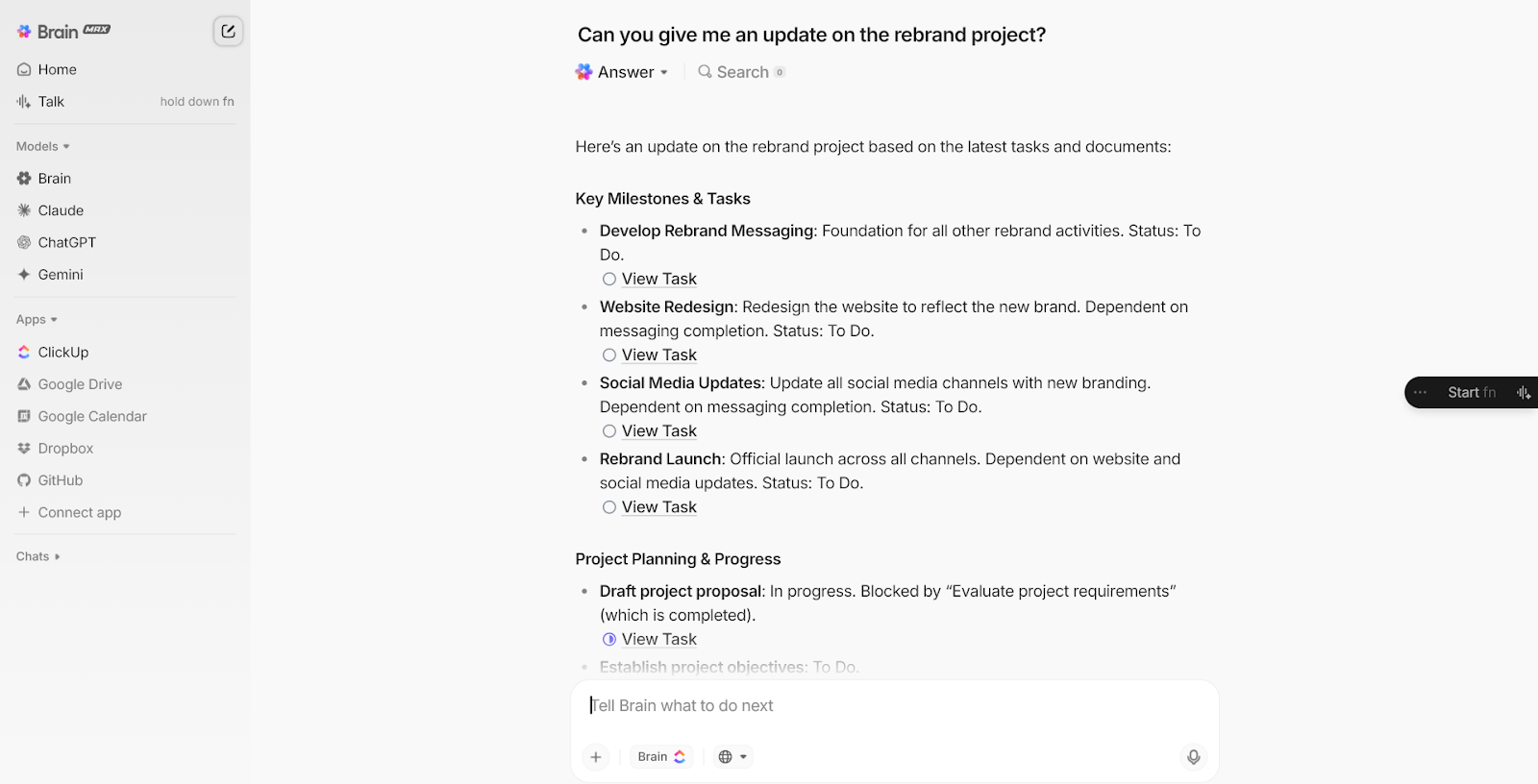

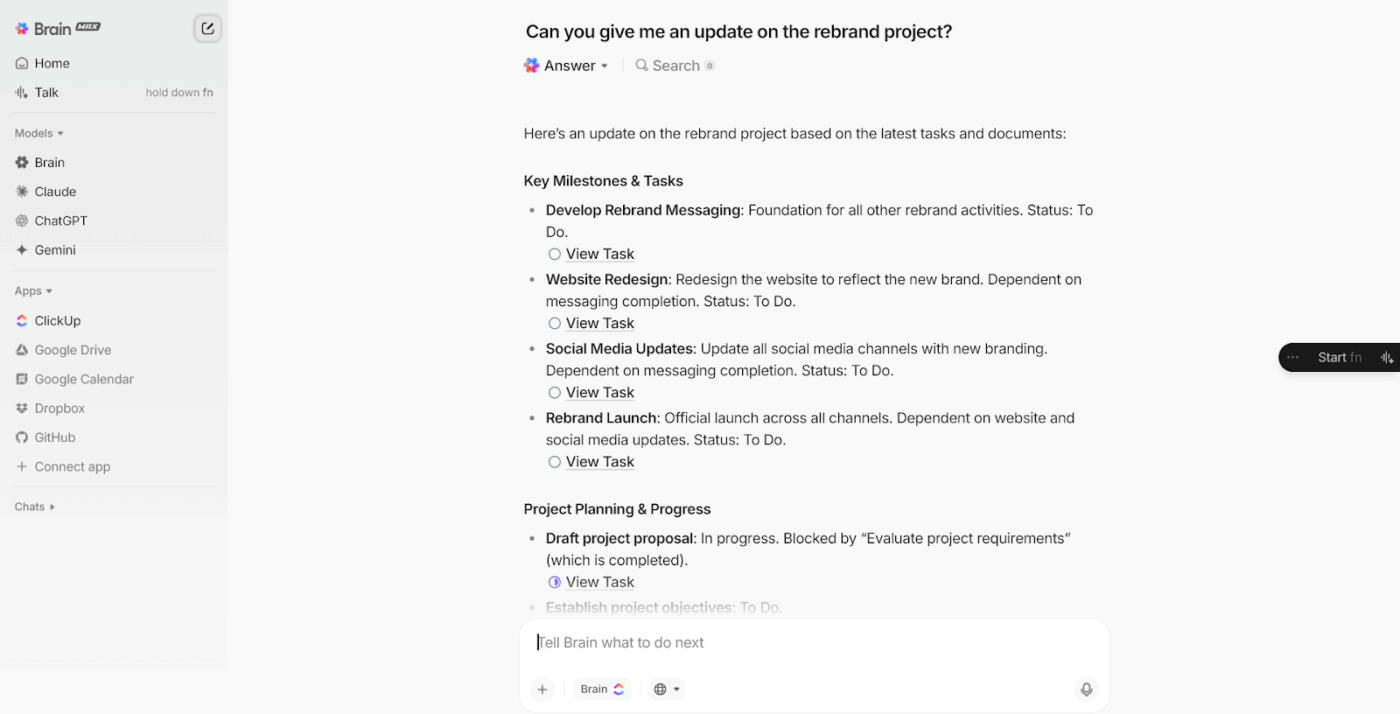

Encuentre respuestas, obstáculos e informes en cuestión de segundos.

Sí, ClickUp Brain te ayuda a trabajar dentro de tareas y documentos. Pero a veces necesitas dar un paso atrás: un espacio enfocado para hacer preguntas, aclarar dudas y avanzar rápidamente.

Eso es precisamente para lo que se ha creado ClickUp Brain MAX.

Te ofrece un espacio dedicado para trabajar con IA, separado de tus tareas y documentos, pero con una conexión total a ellos. Como tu compañero de IA de escritorio, te ayuda a pensar en el trabajo, encontrar respuestas y avanzar más rápido sin cambiar de herramienta ni volver a explicar el contexto.

Escribe una pregunta y obtendrás resultados basados en datos del entorno de trabajo en tiempo real, no en resultados aislados de IA. Entiende el contexto del proyecto, los niveles de prioridad y las asignaciones de los propietarios. Incluso puedes formular tu consulta en voz alta.

ClickUp Brain MAX es un sistema basado en la voz, siempre a tu alcance y diseñado para reducir la carga mental que supone la gestión del trabajo.

Supongamos que estás liderando un lanzamiento interfuncional. Te preguntas: «¿Qué está bloqueando el lanzamiento de la campaña?». Brain MAX muestra las tareas vencidas, los propietarios asignados, los documentos enlazados y los comentarios marcados listos para actuar.

Otros casos de uso en el mundo real:

- Solicite una lista de tareas vencidas agrupadas por la persona asignada.

- Obtenga un resumen de los hitos completados este trimestre.

- Obtenga una vista en tiempo real de los obstáculos en todos los proyectos activos.

- Detecta los riesgos antes de que se agraven, basándote en la actividad de las tareas.

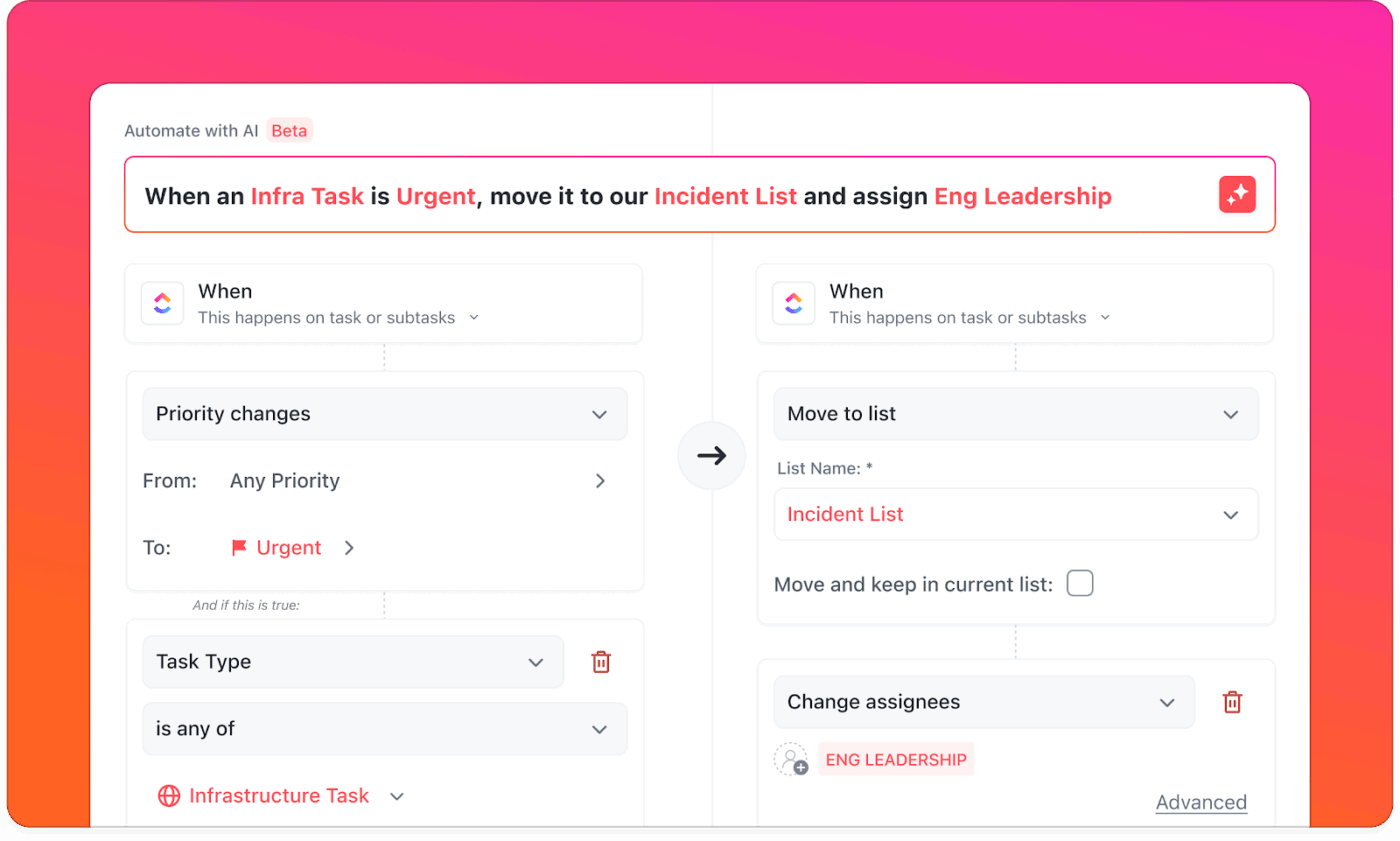

Automatice tareas sin reglas.

Ya no es necesario buscar entre desencadenantes y acciones. Solo tiene que describir lo que desea en lenguaje natural y la IA creará la automatización en ClickUp.

Por ejemplo, su equipo de éxito del cliente se encarga de tareas repetitivas cada vez que se registra un cliente de corporación. Usted le indica a ClickUp Brain: Cuando una tarea se etiquete como «Incorporación de corporación», cree subtareas para la llamada inicial, el paquete de bienvenida, la asignación técnica y los recordatorios de seguimiento.

La IA crea esta automatización de flujos de trabajo de varios pasos y le permite probarla antes de ponerla en marcha.

Las mejores funciones de ClickUp

- Agentes de IA que funcionan: Implemente agentes especializados de ClickUp AI Autopilot que se encargan de tareas periódicas, como actualizaciones de proyectos e informes de estado, sin necesidad de un complejo entrenamiento de modelos.

- Evite la dependencia de un único proveedor: acceda a Claude, GPT, Gemini y otros modelos de IA líderes a través de una interfaz intuitiva sin necesidad de reconstruir los flujos de trabajo.

- No pierda nunca el contexto: utilice el tomador de notas con IA de ClickUp para capturar y resumir automáticamente las reuniones con elementos que se sincronizan directamente con sus tareas.

- Encuentre cualquier cosa: busque en todo su trabajo con Enterprise AI Search en ClickUp, que comprende el contexto de su equipo.

- Escala sin complejidad: obtén funciones de IA de nivel empresarial sin tener que gestionar la infraestructura ni las claves de API: todo funciona desde el primer momento.

- Lluvia de ideas visual: Genere imágenes directamente en las pizarras blancas de ClickUp mediante indicaciones a ClickUp Brain y, a continuación, convierta esas ideas en planes de proyectos viables.

- Chatea sin cambiar de aplicación: mantén las conversaciones conectadas a tu trabajo real con ClickUp Chat.

- Planifica de forma más inteligente: deja que ClickUp Calendario bloquee automáticamente el tiempo de concentración y sugiera reuniones óptimas en función de los plazos del proyecto.

Limitaciones de ClickUp

- No puedes modificar, bifurcar ni contribuir a la infraestructura de IA subyacente como puedes hacerlo con Hugging Face.

Precios de ClickUp

Valoraciones y reseñas de ClickUp

- G2: 4,7/5 (más de 10 385 opiniones)

- Capterra: 4,6/5 (más de 4000 reseñas)

¿Qué opinan los usuarios reales sobre ClickUp?

Esta reseña de G2 lo dice todo sobre esta plataforma de colaboración de IA:

El nuevo Brain MAX ha mejorado enormemente mi productividad. La posibilidad de utilizar múltiples modelos de IA, incluidos modelos de razonamiento avanzado, a un precio asequible facilita la centralización de todo en una sola plataforma. Funciones como la conversión de voz a texto, la automatización de tareas y la integración con otras aplicaciones hacen que el flujo de trabajo sea mucho más fluido e inteligente.

El nuevo Brain MAX ha mejorado enormemente mi productividad. La posibilidad de utilizar múltiples modelos de IA, incluidos modelos de razonamiento avanzado, a un precio asequible facilita la centralización de todo en una sola plataforma. Funciones como la conversión de voz a texto, la automatización de tareas y la integración con otras aplicaciones hacen que el flujo de trabajo sea mucho más fluido e inteligente.

📮 Información de ClickUp: El 30 % de nuestros encuestados confía en herramientas de IA para la investigación y la recopilación de información. Pero, ¿existe alguna IA que te ayude a encontrar ese archivo perdido en el trabajo o ese hilo importante de Slack que olvidaste guardar?

¡Sí! La búsqueda conectada con IA de ClickUp puede buscar instantáneamente en todo el contenido de tu entorno de trabajo, incluidas las aplicaciones integradas de terceros, y obtener información, recursos y respuestas. ¡Ahorra hasta 5 horas a la semana con la búsqueda avanzada de ClickUp!

2. OpenAI (la mejor opción para acceder a modelos avanzados de generación de lenguaje e imágenes)

a través de OpenAI

OpenAI fue noticia cuando se lanzó ChatGPT y, de repente, todo el mundo volvió a hablar de la IA. Sus modelos GPT se encargan de todo, desde escribir correos electrónicos hasta depurar código, mientras que DALL-E convierte tus indicaciones de texto más descabelladas en imágenes reales.

Lo que distingue a OpenAI es cómo han empaquetado la IA. Obtienes acceso a modelos que antes estaban bloqueados en laboratorios de investigación. Claro, estás pagando por la comodidad, pero cuando los plazos son ajustados y los clientes te están presionando, esa comodidad se vuelve invaluable.

Las mejores funciones de OpenAI

- Ajusta los modelos a tus conjuntos de datos específicos para que se adapten a la voz de tu marca, tu estilo de redacción o tu experiencia en el sector.

- Controle el comportamiento del modelo mediante indicaciones del sistema y ajustes de temperatura para ajustar los niveles de creatividad y el formato de las respuestas.

- Procesa múltiples formatos de archivo, incluidos PDF, imágenes y documentos, para realizar un análisis y una extracción exhaustivos del contenido.

- Realice un seguimiento de los costes de uso y establezca límites de gasto a través de paneles de facturación detallados que desglosan los gastos por modelo y proyecto.

- Crea incrustaciones para aplicaciones de búsqueda semántica que comprendan el significado en lugar de limitarse a buscar coincidencias de palabras clave.

Limitaciones de OpenAI

- Opciones de personalización limitadas para la arquitectura de modelos.

- La dependencia de llamadas API externas afecta a la funcionalidad sin conexión.

- Los límites de velocidad pueden afectar a las aplicaciones de gran volumen en diversos sectores.

- OpenAI se ha enfrentado a múltiples demandas y escrutinio por recopilar datos de entrenamiento de la web sin consentimiento.

Precios de OpenAI

- GPT-4. 1 Entrada: 2 $ por cada millón de tokens Entrada almacenada en caché: 0,50 $ por cada millón de tokens Salida: 8 $ por cada millón de tokens

- Entrada: 2 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,50 $ por cada millón de tokens.

- Resultado: 8 $ por cada millón de tokens.

- GPT-4. 1 mini Entrada: 0,40 $ por cada millón de tokens Entrada en caché: 0,10 $ por cada millón de tokens Salida: 1,60 $ por cada millón de tokens

- Entrada: 0,40 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,10 $ por cada millón de tokens.

- Resultado: 1,60 $ por cada millón de tokens.

- GPT-4. 1 nano Entrada: 0,100 $ por cada millón de tokens Entrada almacenada en caché: 0,025 $ por cada millón de tokens Salida: 0,400 $ por cada millón de tokens

- Entrada: 0,100 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,025 $ por cada millón de tokens.

- Resultado: 0,400 $ por cada millón de tokens.

- OpenAI o3 Entrada: 2 $ por cada millón de tokens Entrada almacenada en caché: 0,50 $ por cada millón de tokens Salida: 8 $ por cada millón de tokens

- Entrada: 2 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,50 $ por cada millón de tokens.

- Resultado: 8 $ por cada millón de tokens.

- OpenAI o4-mini Entrada: 1,100 $ por cada millón de tokens Entrada almacenada en caché: 0,275 $ por cada millón de tokens Salida: 4,400 $ por cada millón de tokens

- Entrada: 1,100 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,275 $ por cada millón de tokens.

- Resultado: 4400 $ por cada millón de tokens.

- Ajustes de modelos GPT-4. 1 Entrada: 3 $ por cada millón de tokens Entrada en caché: 0,75 $ por cada millón de tokens Salida: 12 $ por cada millón de tokens Formación: 25 $ por cada millón de tokens GPT-4. 1 mini Entrada: 0,80 $ por cada millón de tokens Entrada en caché: 0,20 $ por cada millón de tokens Salida: 3,20 $ por cada millón de tokens Entrenamiento: 5 $ por cada millón de tokens GPT-4. 1 nano Entrada: 0,20 $ por cada millón de tokens Entrada almacenada en caché: 0,05 $ por cada millón de tokens Salida: 0,80 $ por cada millón de tokens Entrenamiento: 1,50 $ por cada millón de tokens o4-mini Entrada: 4 $ por cada millón de tokens Entrada almacenada en caché: 1 $ por cada millón de tokens Salida: 16 $ por cada millón de tokens Formación: 100 $ por hora de formación

- GPT-4. 1 Entrada: 3 $ por cada millón de tokens Entrada almacenada en caché: 0,75 $ por cada millón de tokens Salida: 12 $ por cada millón de tokens Formación: 25 $ por cada millón de tokens

- Entrada: 3 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,75 $ por cada millón de tokens.

- Resultado: 12 $ por cada millón de tokens.

- Formación: 25 $ por cada millón de tokens.

- GPT-4. 1 mini Entrada: 0,80 $ por cada millón de tokens Entrada almacenada en caché: 0,20 $ por cada millón de tokens Salida: 3,20 $ por cada millón de tokens Formación: 5 $ por cada millón de tokens

- Entrada: 0,80 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,20 $ por cada millón de tokens.

- Resultado: 3,20 $ por cada millón de tokens.

- Formación: 5 $ por cada millón de tokens.

- GPT-4. 1 nano Entrada: 0,20 $ por cada millón de tokens Entrada almacenada en caché: 0,05 $ por cada millón de tokens Salida: 0,80 $ por cada millón de tokens Formación: 1,50 $ por cada millón de tokens

- Entrada: 0,20 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,05 $ por cada millón de tokens.

- Resultado: 0,80 $ por cada millón de tokens.

- Formación: 1,50 $ por cada millón de tokens.

- o4-mini Entrada: 4 $ por cada millón de tokens Entrada almacenada en caché: 1 $ por cada millón de tokens Salida: 16 $ por cada millón de tokens Formación: 100 $ por hora de formación

- Entrada: 4 $ por cada millón de tokens.

- Entrada almacenada en caché: 1 $ por cada millón de tokens.

- Resultado: 16 $ por cada millón de tokens.

- Formación: 100 $ por hora de formación.

- Entrada: 2 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,50 $ por cada millón de tokens.

- Resultado: 8 $ por cada millón de tokens.

- Entrada: 0,40 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,10 $ por cada millón de tokens.

- Resultado: 1,60 $ por cada millón de tokens.

- Entrada: 0,100 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,025 $ por cada millón de tokens.

- Resultado: 0,400 $ por cada millón de tokens.

- Entrada: 2 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,50 $ por cada millón de tokens.

- Resultado: 8 $ por cada millón de tokens.

- Entrada: 1,100 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,275 $ por cada millón de tokens.

- Resultado: 4400 $ por cada millón de tokens.

- GPT-4. 1 Entrada: 3 $ por cada millón de tokens Entrada almacenada en caché: 0,75 $ por cada millón de tokens Salida: 12 $ por cada millón de tokens Formación: 25 $ por cada millón de tokens

- Entrada: 3 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,75 $ por cada millón de tokens.

- Resultado: 12 $ por cada millón de tokens.

- Formación: 25 $ por cada millón de tokens.

- GPT-4. 1 mini Entrada: 0,80 $ por cada millón de tokens Entrada almacenada en caché: 0,20 $ por cada millón de tokens Salida: 3,20 $ por cada millón de tokens Formación: 5 $ por cada millón de tokens

- Entrada: 0,80 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,20 $ por cada millón de tokens.

- Resultado: 3,20 $ por cada millón de tokens.

- Formación: 5 $ por cada millón de tokens.

- GPT-4. 1 nano Entrada: 0,20 $ por cada millón de tokens Entrada almacenada en caché: 0,05 $ por cada millón de tokens Salida: 0,80 $ por cada millón de tokens Formación: 1,50 $ por cada millón de tokens

- Entrada: 0,20 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,05 $ por cada millón de tokens.

- Resultado: 0,80 $ por cada millón de tokens.

- Formación: 1,50 $ por cada millón de tokens.

- o4-mini Entrada: 4 $ por cada millón de tokens Entrada almacenada en caché: 1 $ por cada millón de tokens Salida: 16 $ por cada millón de tokens Formación: 100 $ por hora de formación

- Entrada: 4 $ por cada millón de tokens.

- Entrada almacenada en caché: 1 $ por cada millón de tokens.

- Resultado: 16 $ por cada millón de tokens.

- Formación: 100 $ por hora de formación.

- Entrada: 3 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,75 $ por cada millón de tokens.

- Resultado: 12 $ por cada millón de tokens.

- Formación: 25 $ por cada millón de tokens.

- Entrada: 0,80 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,20 $ por cada millón de tokens.

- Resultado: 3,20 $ por cada millón de tokens.

- Formación: 5 $ por cada millón de tokens.

- Entrada: 0,20 $ por cada millón de tokens.

- Entrada almacenada en caché: 0,05 $ por cada millón de tokens.

- Resultado: 0,80 $ por cada millón de tokens.

- Formación: 1,50 $ por cada millón de tokens.

- Entrada: 4 $ por cada millón de tokens.

- Entrada almacenada en caché: 1 $ por cada millón de tokens.

- Resultado: 16 $ por cada millón de tokens.

- Formación: 100 $ por hora de formación.

Valoraciones y reseñas de OpenAI

- G2: 4,7/5 (más de 830 opiniones)

- Capterra: 4,5/5 (más de 220 opiniones)

¿Qué opinan los usuarios reales sobre OpenAI?

De una reseña de G2:

Su API es increíble, con una interfaz de usuario excelente, y no he tenido ningún problema al usar chatgpt. Me ha encantado y recomiendo encarecidamente que lo pruebes, lo descargues y tomes una decisión rápidamente.

Su API es increíble, con una interfaz de usuario excelente, y no he tenido ningún problema al usar chatgpt. Me ha encantado y recomiendo encarecidamente que lo pruebes, lo descargues y tomes una decisión rápidamente.

🎥 Vea: Cómo utilizar ClickUp Brain como su asistente personal, en cualquier momento y en cualquier lugar.

💡 Consejo profesional: No te bases en una sola métrica. Desglosa la evaluación de LLM en función de cómo maneja las entradas estructuradas (por ejemplo, tablas, listas) frente a las indicaciones no estructuradas (tareas abiertas). Detectarás los patrones de fallo más rápidamente.

3. Anthropic Claude (la mejor opción para mantener conversaciones de IA seguras y contextuales)

vía Anthropic

Claude adopta un enfoque diferente en cuanto a la seguridad de la IA. En lugar de aplicar filtros de contenido, Anthropic lo entrenó para analizar los problemas con detenimiento. Notarás que Claude tiene en cuenta múltiples perspectivas antes de responder, lo que lo hace ideal para debates matizados sobre temas complejos.

La ventana de contexto es enorme, por lo que puede introducir documentos completos y mantener conversaciones reales sobre el contenido.

Piense en aquellas ocasiones en las que ha querido debatir un artículo de investigación o analizar un informe extenso. Claude maneja estas situaciones con naturalidad. Además, recuerda todo lo que se ha dicho anteriormente en la conversación, por lo que no tendrá que repetirse constantemente.

Las mejores funciones de Anthropic Claude

- Escribe y depura código en docenas de lenguajes de programación, explicando la lógica y sugiriendo mejoras sobre la marcha.

- Busca en la web en tiempo real para acceder a información actualizada y verificar datos durante las conversaciones.

- Analice dilemas éticos complejos y temas matizados, presentando perspectivas equilibradas en lugar de respuestas simplificadas.

- Realice cálculos matemáticos avanzados y análisis estadísticos con explicaciones paso a paso y verificación.

- Genere resultados estructurados como JSON, XML y YAML que sigan esquemas específicos para integraciones de API.

Limitaciones de Anthropic Claude

- Tiene una selección de modelos más reducida en comparación con las alternativas a Claude.

- Menos flexibilidad para el entrenamiento de modelos personalizados.

- Mayor latencia para algunas tareas especializadas.

Precios de Anthropic Claude

- Claude Opus 4 Entrada: 15 $ por cada millón de tokens Salida: 75 $ por cada millón de tokens Almacenamiento en caché de indicaciones: Escritura: 18,75 $ por cada millón de tokens Lectura: 1,50 $ por cada millón de tokens

- Entrada: 15 $ por cada millón de tokens.

- Resultado: 75 $ por cada millón de tokens.

- Almacenamiento en caché de indicaciones: Escritura: 18,75 $ por cada millón de tokens Lectura: 1,50 $ por cada millón de tokens

- Escribir: 18,75 $ por cada millón de tokens.

- Leer: 1,50 $ por cada millón de tokens.

- Claude Sonnet 4 Entrada: 3 $ por cada millón de tokens Salida: 15 $ por cada millón de tokens Almacenamiento en caché de indicaciones: Escritura: 3,75 $ por cada millón de tokens Lectura: 0,30 $ por cada millón de tokens

- Entrada: 3 $ por cada millón de tokens.

- Resultado: 15 $ por cada millón de tokens.

- Almacenamiento en caché de indicaciones: Escritura: 3,75 $ por cada millón de tokens Lectura: 0,30 $ por cada millón de tokens

- Escribir: 3,75 $ por cada millón de tokens.

- Leer: 0,30 $ por cada millón de tokens.

- Claude Haiku 3. 5 Entrada: 0,80 $ por cada millón de tokens Salida: 4 $ por cada millón de tokens Almacenamiento en caché de indicaciones: Escritura: 1 $ por cada millón de tokens Lectura: 0,08 $ por cada millón de tokens

- Entrada: 0,80 $ por cada millón de tokens.

- Resultado: 4 $ por cada millón de tokens.

- Almacenamiento en caché de indicaciones: Escritura: 1 $ por cada millón de tokens Lectura: 0,08 $ por cada millón de tokens

- Escribir: 1 $ por cada millón de tokens

- Leer: 0,08 $ por cada millón de tokens.

- Entrada: 15 $ por cada millón de tokens.

- Resultado: 75 $ por cada millón de tokens.

- Almacenamiento en caché de indicaciones: Escritura: 18,75 $ por cada millón de tokens Lectura: 1,50 $ por cada millón de tokens

- Escribir: 18,75 $ por cada millón de tokens.

- Leer: 1,50 $ por cada millón de tokens.

- Escribir: 18,75 $ por cada millón de tokens.

- Leer: 1,50 $ por cada millón de tokens.

- Entrada: 3 $ por cada millón de tokens.

- Resultado: 15 $ por cada millón de tokens.

- Almacenamiento en caché de indicaciones: Escritura: 3,75 $ por cada millón de tokens Lectura: 0,30 $ por cada millón de tokens

- Escribir: 3,75 $ por cada millón de tokens.

- Leer: 0,30 $ por cada millón de tokens.

- Escribir: 3,75 $ por cada millón de tokens.

- Leer: 0,30 $ por cada millón de tokens.

- Entrada: 0,80 $ por cada millón de tokens.

- Resultado: 4 $ por cada millón de tokens.

- Almacenamiento en caché de indicaciones: Escritura: 1 $ por cada millón de tokens Lectura: 0,08 $ por cada millón de tokens

- Escribir: 1 $ por cada millón de tokens.

- Leer: 0,08 $ por cada millón de tokens.

- Escribir: 1 $ por cada millón de tokens

- Leer: 0,08 $ por cada millón de tokens.

Valoraciones y reseñas de Anthropic Claude

- G2: 4,4/5 (más de 55 opiniones)

- Capterra: 4,5/5 (más de 20 reseñas)

¿Qué opinan los usuarios reales sobre Anthropic Claude?

Basado en un comentario de Reddit:

¿Sinceramente? Claude parece una buena «persona». Tiene en cuenta el bienestar humano en sus decisiones con una profundidad que no se ve de forma nativa en otros modelos. Si me viera obligado a elegir un LLM para ser el líder mundial, Claude sería mi primera opción. No confiaría necesariamente en los demás en la misma medida sin una formación ética o de constitución de la personalidad.

¿Sinceramente? Claude parece una buena «persona». Tiene en cuenta el bienestar humano en sus decisiones con una profundidad que no se ve de forma nativa en otros modelos. Si me viera obligado a elegir un LLM para ser el líder mundial, Claude sería mi primera opción. No confiaría necesariamente en los demás en la misma medida sin una formación ética o de constitución de la personalidad.

🧠 Dato curioso: En 2012, un modelo llamado AlexNet superó a los humanos en el reconocimiento de imágenes. Era más rápido, más preciso y no se cansaba. Ese momento cambió la forma en que la gente veía el potencial de la IA en campos como la sanidad, la seguridad y la robótica.

📖 Lea también: Las mejores alternativas y competidores de Anthropic IA.

4. Cohere (la mejor para crear soluciones de procesamiento del lenguaje natural de nivel empresarial)

vía Cohere

Cohere ha creado su plataforma específicamente para empresas que necesitan inteligencia artificial, pero que no pueden permitirse comprometer la privacidad de los datos. Sus capacidades multilingües abarcan más de 100 idiomas, lo que es muy importante si se trata con clientes globales o mercados internacionales.

Las incrustaciones funcionan especialmente bien para aplicaciones de búsqueda en las que es necesario comprender el significado, en lugar de limitarse a buscar coincidencias de palabras clave. También puede entrenar sus propios clasificadores de IA personalizados, lo que resulta muy práctico para equipos que necesitan soluciones de IA pero no cuentan con científicos de datos dedicados.

Las mejores funciones de Cohere

- Ajuste los modelos utilizando sus datos propios, al tiempo que mantiene un control total sobre los conjuntos de datos de entrenamiento y los pesos de los modelos.

- Escala la capacidad de inferencia automáticamente en función de los patrones de demanda sin tener que gestionar la infraestructura de GPU subyacente.

- Implemente sistemas de generación aumentada con recuperación que puedan citar fuentes y proporcionar atribución para el contenido generado.

- Supervise el rendimiento de los modelos y los patrones de uso a través de completos paneles de análisis y sistemas de alertas.

- Integre con los sistemas de autenticación existentes utilizando SSO, SAML y controles de acceso basados en roles para realizar el seguimiento de los experimentos.

Limitaciones de Cohere

- Comunidad más pequeña y menos integraciones de terceros.

- Capacidades de visión artificial limitadas en comparación con las plataformas multimodales.

- Hay menos modelos preentrenados disponibles para dominios especializados.

- Documentación con extensión menor para casos de uso avanzados y configuraciones híbridas.

Precios de Cohere

- Comando A Entrada: 2,50 $ por cada millón de tokens Salida: 10 $ por cada millón de tokens

- Entrada: 2,50 $ por cada millón de tokens.

- Resultado: 10 $ por cada millón de tokens.

- Comando R Entrada: 0,15 $ por cada millón de tokens Salida: 0,60 $ por cada millón de tokens

- Entrada: 0,15 $ por cada millón de tokens.

- Resultado: 0,60 $ por cada millón de tokens.

- Comando R7B Entrada: 0,0375 $ por cada millón de tokens Salida: 0,15 $ por cada millón de tokens

- Entrada: 0,0375 $ por cada millón de tokens.

- Resultado: 0,15 $ por cada millón de tokens.

- Entrada: 2,50 $ por cada millón de tokens.

- Resultado: 10 $ por cada millón de tokens.

- Entrada: 0,15 $ por cada millón de tokens.

- Resultado: 0,60 $ por cada millón de tokens.

- Entrada: 0,0375 $ por cada millón de tokens.

- Resultado: 0,15 $ por cada millón de tokens.

Valoraciones y reseñas de Cohere

- G2: No hay suficientes reseñas.

- Capterra: No hay suficientes reseñas.

¿Qué opinan los usuarios reales sobre Cohere?

Configurar Cohere fue bastante fácil y la documentación era muy sencilla de seguir. Poder ver cómo nuestros usuarios utilizan la app fue realmente útil y genial para empezar. […] La versión gratuita del software tiene un conjunto de sesiones muy limitado y, a medida que nuestra base de usuarios ha crecido, la app nos resulta menos útil, ya que hay más sesiones ocultas tras un muro de pago.

Configurar Cohere fue bastante fácil y la documentación era muy sencilla de seguir. Poder ver cómo nuestros usuarios utilizan la app fue realmente útil y genial para empezar. […] La versión gratuita del software tiene un conjunto de sesiones muy limitado y, a medida que nuestra base de usuarios ha crecido, la aplicación nos resulta menos útil, ya que hay más sesiones ocultas tras un muro de pago.

🔍 ¿Sabías que...? Modelos como GPT‑4 y Grok 4 cambiaron sus respuestas cuando se les rechazó (aunque su primera respuesta fuera correcta). Empezaron a dudar de sí mismos después de recibir comentarios contradictorios. Es inquietantemente similar a cómo se comportan las personas bajo estrés, y plantea dudas sobre la fiabilidad de sus respuestas.

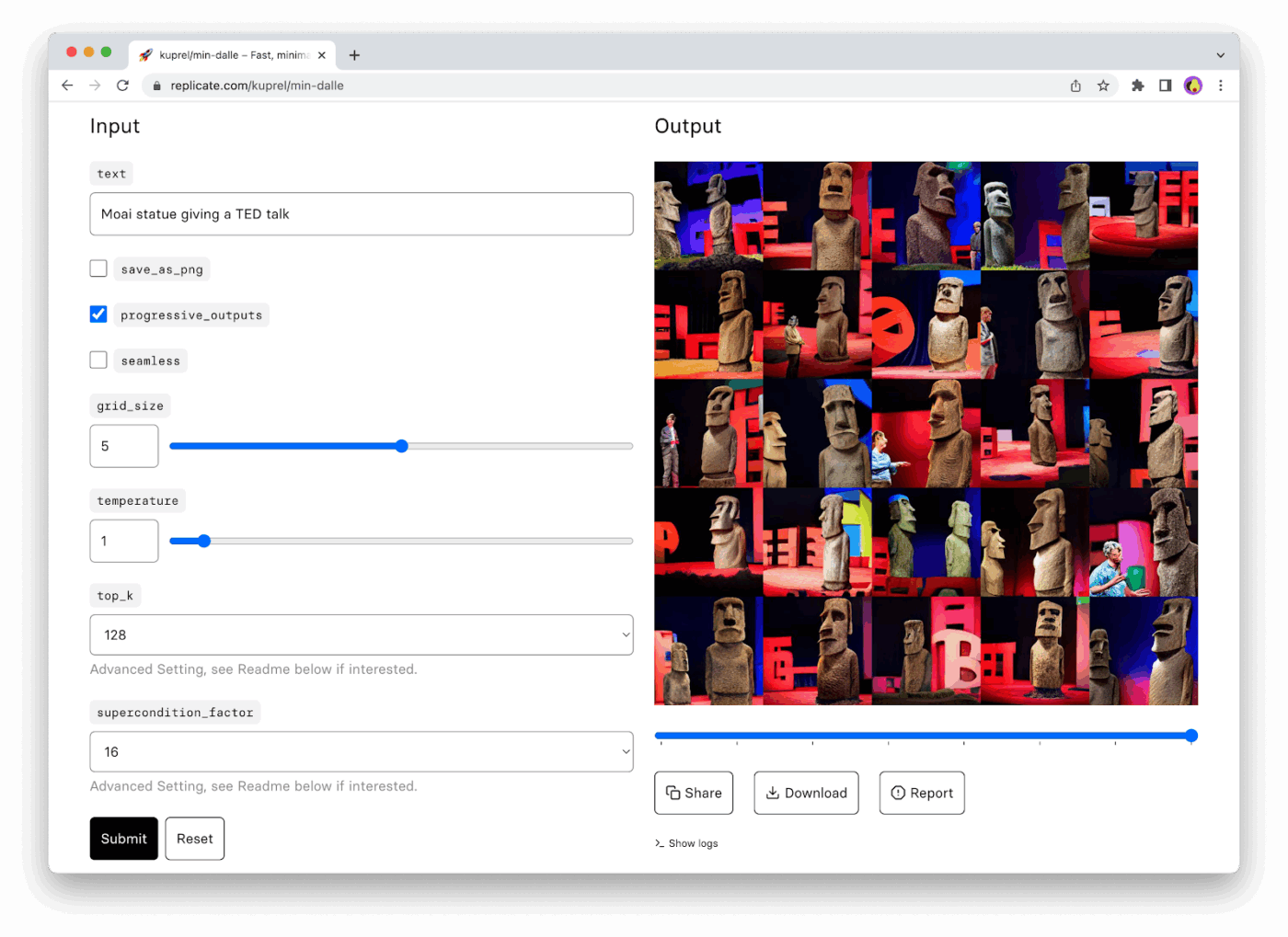

5. Replicate (la mejor opción para ejecutar modelos de IA de código abierto sin gestión de infraestructura)

a través de Replicate

Replicate es como tener una enorme biblioteca de modelos de IA sin el dolor de cabeza que supone gestionar servidores. ¿Alguien ha creado un generador de imágenes increíble? Probablemente esté en Replicate. ¿Quieres probar ese nuevo modelo de síntesis de voz del que todo el mundo habla? Solo tienes que hacer una llamada a la API.

La aplicación de IA se encarga de toda la complejidad de la infraestructura para que puedas experimentar con docenas de modelos diferentes sin comprometerte con uno solo. Solo pagas cuando utilizas algo, lo que la hace perfecta para la creación de prototipos.

Además, cuando encuentres un modelo que funcione, podrás implementar tus propias versiones personalizadas utilizando su sencillo sistema de contenedores.

Replique las mejores funciones

- Controle la versión de sus implementaciones de modelos con capacidades de reversión y pruebas A/B entre diferentes versiones de modelos.

- Configura webhooks para recibir notificaciones cuando las predicciones de larga duración sean completadas o se produzcan errores.

- Procesa por lotes múltiples entradas simultáneamente para reducir los costes por predicción y mejorar la eficiencia del rendimiento.

- Bifurca los modelos existentes para crear versiones personalizadas con diferentes parámetros o datos de entrenamiento.

Limitaciones de Replicate

- Tienes menos control sobre el entorno de alojamiento del modelo y las configuraciones.

- Existen posibles problemas de latencia para aplicaciones en tiempo real y necesidades de corporación.

- Opciones limitadas para la personalización y el ajuste de modelos.

- Dependencia de la disponibilidad y el mantenimiento de modelos de terceros.

Precios de Replicate

- Los precios varían según el modelo.

Replica valoraciones y reseñas.

- G2: No hay suficientes reseñas.

- Capterra: No hay suficientes reseñas.

¿Qué opinan los usuarios reales sobre Replicate?

Una nota de Reddit señala:

En cualquier caso, en mi opinión, Replicate es la opción más fácil de usar para probar nuevos modelos de imagen o vídeo. Dudo que sea la más rentable si tienes muchos usuarios, pero para un MVP podría ahorrarte muchas molestias y dinero (en comparación con alquilar una GPU por horas).

En cualquier caso, en mi opinión, Replicate es la opción más fácil de usar para probar nuevos modelos de imagen o vídeo. Dudo que sea la más rentable si tienes muchos usuarios, pero para un MVP podría ahorrarte muchas molestias y dinero (en comparación con alquilar una GPU por horas).

💡 Consejo profesional: Realice ajustes con moderación. No siempre es necesario ajustar un modelo para obtener resultados específicos del dominio. Pruebe primero la ingeniería de indicaciones inteligentes + la generación aumentada por recuperación (RAG). Solo invierta en ajustes si alcanza constantemente los límites máximos de precisión o relevancia.

6. TensorFlow (ideal para crear modelos de aprendizaje automático personalizados desde cero)

a través de TensorFlow

TensorFlow te ofrece un control total sobre tu destino en el aprendizaje automático (lo cual es tanto una bendición como una maldición). Google ha convertido en código abierto su marco de ML de producción, lo que significa que puedes disponer de las mismas herramientas que ellos utilizan internamente.

La flexibilidad es increíble; puedes crear cualquier cosa, desde una simple regresión lineal hasta complejas arquitecturas de transformadores.

TensorFlow Hub proporciona modelos preentrenados que puedes ajustar, mientras que TensorBoard te ofrece análisis en tiempo real del rendimiento del entrenamiento. Sin embargo, esta potencia conlleva complejidad. Tendrás que dedicar tiempo a aprender conceptos que las plataformas de nivel superior abstraen.

Las mejores funciones de TensorFlow

- Analice el perfil de rendimiento de los modelos e identifique los cuellos de botella utilizando herramientas de depuración avanzadas que muestran el uso de la memoria y gráficos de cálculo.

- Convierte modelos entre diferentes formatos, como SavedModel, TensorFlow Lite y ONNX, para garantizar la compatibilidad entre plataformas.

- Implemente funciones de pérdida personalizadas y algoritmos de optimización que no están disponibles en las bibliotecas estándar de aprendizaje automático.

- Utilice el entrenamiento de precisión mixta para reducir el uso de memoria y acelerar el entrenamiento en arquitecturas GPU modernas.

- Cree canalizaciones de datos personalizadas con tf. data que gestionan de forma eficiente grandes conjuntos de datos con preprocesamiento y aumento.

Limitaciones de TensorFlow

- Requiere importantes recursos computacionales para el entrenamiento de modelos de gran tamaño.

- Proceso de depuración complejo en comparación con las alternativas de Hugging Face de nivel superior.

- Configuración y ajuste que requieren mucho tiempo para casos de uso avanzados.

Precios de TensorFlow

- Precios personalizados

Valoraciones y reseñas de TensorFlow

- G2: 4,5/5 (más de 125 reseñas)

- Capterra: 4,6/5 (más de 100 opiniones)

¿Qué opinan los usuarios reales sobre TensorFlow?

Un usuario de G2 destaca:

Me encanta lo potente y flexible que es TensorFlow para crear y entrenar modelos de aprendizaje profundo. Keras lo hace un poco más fácil y los modelos preentrenados ahorran mucho tiempo. Además, la comunidad es genial cuando me quedo atascado. […] La curva de aprendizaje es pronunciada. Especialmente para los principiantes. A veces, los mensajes de error son demasiado complicados de entender y la depuración es frustrante. Además, requiere mucha potencia de cálculo, lo que puede ser un problema si no se dispone de hardware de gama alta.

Me encanta lo potente y flexible que es TensorFlow para crear y entrenar modelos de aprendizaje profundo. Keras lo hace un poco más fácil y los modelos preentrenados ahorran mucho tiempo. Además, la comunidad es genial cuando me quedo atascado. […] La curva de aprendizaje es pronunciada. Especialmente para los principiantes. A veces, los mensajes de error son demasiado complicados de entender y la depuración es frustrante. Además, requiere mucha potencia de cálculo, lo que puede ser un problema si no se dispone de hardware de alta gama.

🧠 Dato curioso: Los investigadores descubrieron que los modelos de lenguaje suelen sugerir paquetes de software que no existen. Alrededor del 19,7 % de las muestras de código incluían nombres inventados, lo que puede dar lugar a ataques de ocupación ilegal.

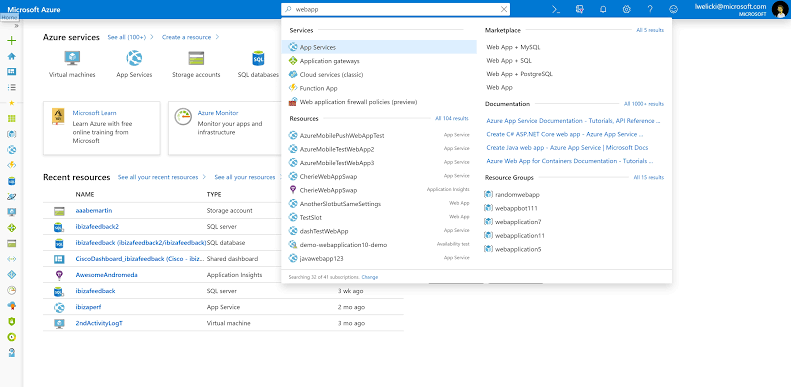

7. Azure Machine Learning (la mejor opción para integrar flujos de trabajo de ML con los servicios en la nube de Microsoft)

a través de Microsoft Azure

Azure ML es la opción natural si su organización ya utiliza Microsoft. La herramienta ofrece interfaces de apuntar y hacer clic para usuarios de empresas y entornos de programación completos para científicos de datos.

AutoML se encarga del trabajo pesado cuando necesitas resultados rápidos, probando automáticamente diferentes algoritmos e hiperparámetros. Además, la integración con Power BI permite que tus modelos se incorporen directamente a los paneles ejecutivos.

Obtendrá un sólido control de versiones para los modelos, canalizaciones de implementación automatizadas y supervisión que le avisa cuando el rendimiento del modelo comienza a degradarse.

Las mejores funciones de Azure Machine Learning

- Programa procesos de reentrenamiento automatizados que se desencadenan cuando hay nuevos datos disponibles o cuando el rendimiento del modelo se ve afectado.

- Cree entornos Docker personalizados para el entrenamiento y la implementación reproducibles de modelos en diferentes objetivos informáticos.

- Implemente funciones de interpretabilidad de modelos que expliquen las predicciones utilizando LIME, SHAP y otras técnicas de explicabilidad.

- Configura la supervisión de la deriva de datos para que te avise cuando los datos entrantes difieran significativamente de los conjuntos de datos de entrenamiento.

- Gestiona clústeres informáticos que se escalan automáticamente en función de las demandas de carga de trabajo, al tiempo que se optimiza la rentabilidad.

Limitaciones de Azure Machine Learning

- Existen preocupaciones sobre la dependencia de un único proveedor para las organizaciones que utilizan estrategias de nubes múltiples.

- Flexibilidad limitada en comparación con las alternativas de código abierto a Hugging Face.

Precios de Azure Machine Learning

- Precios personalizados

Valoraciones y reseñas de Azure Machine Learning

- G2: 4,3/5 (más de 85 opiniones)

- Capterra: 4,5/5 (30 opiniones)

¿Qué opinan los usuarios reales sobre Azure Machine Learning?

Como se ha usado compartido en G2:

El servicio es fácil de usar y tiene muchas funciones interesantes para cargar datos y detectar patrones en ellos. La interfaz podría mejorarse, pero se adapta a mis necesidades. Si tienes dudas sobre la implementación, hay mucha información en la web o puedes solicitar ayuda directamente al soporte de Microsoft.

El servicio es fácil de usar y tiene muchas funciones interesantes para cargar datos y detectar patrones en ellos. La interfaz podría mejorarse, pero se adapta a mis necesidades. Si tienes dudas sobre la implementación, hay mucha información en la web o puedes solicitar ayuda directamente al servicio de compatibilidad de Microsoft.

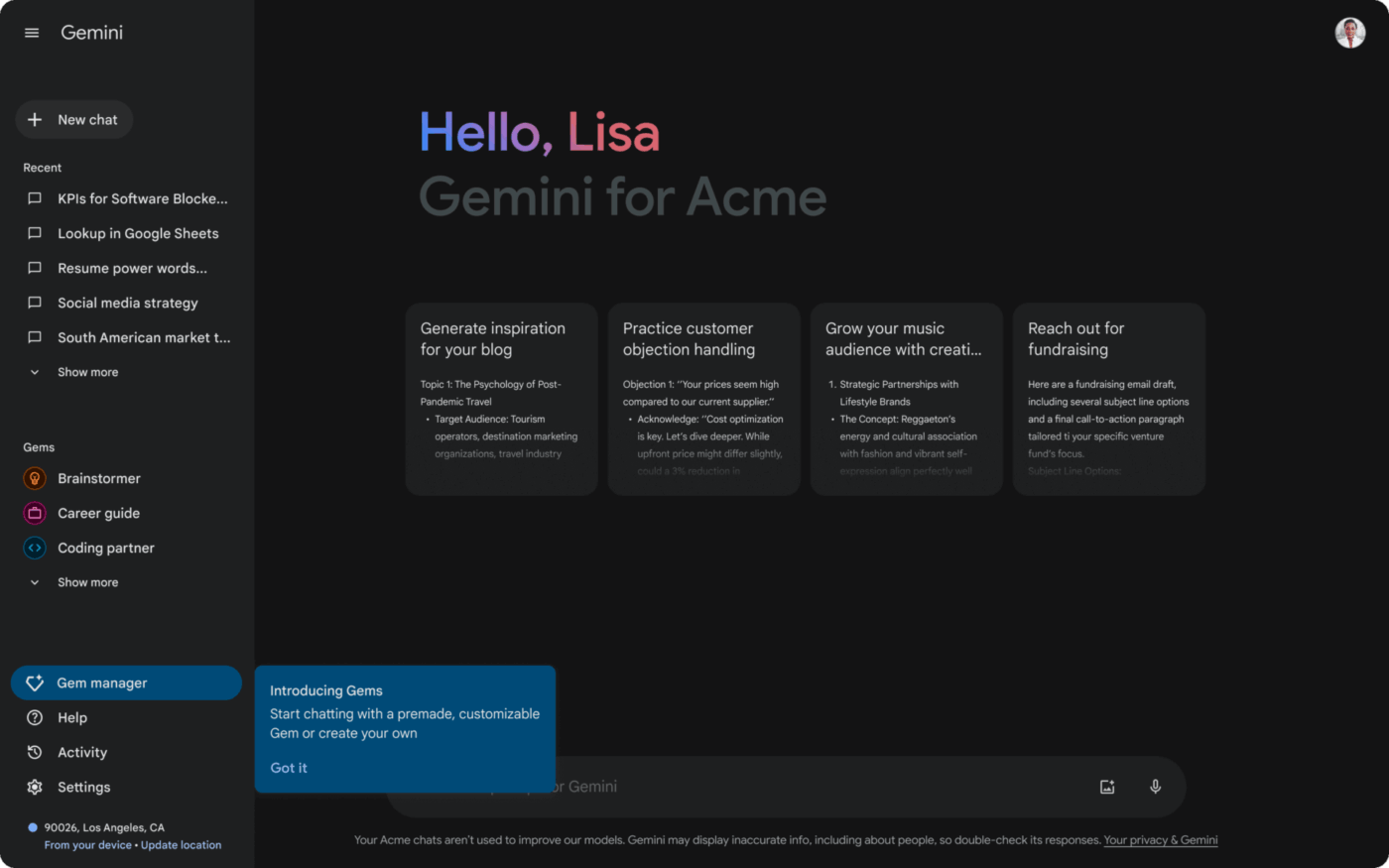

8. Google Gemini (ideal para procesar múltiples tipos de contenido en una sola interacción)

a través de Google Gemini

Gemini, de Google, entiende varios tipos de contenido al mismo tiempo. Puedes mostrar un gráfico y hacer preguntas sobre los datos, o subir imágenes y tener conversaciones sobre lo que pasa en ellas. Las capacidades matemáticas y de código son especialmente buenas. Resuelve ecuaciones complejas paso a paso y explica su razonamiento.

La ventana de contexto maneja grandes cantidades de texto, lo que la hace útil para analizar trabajos de investigación completos o documentos extensos. Lo interesante es cómo mantiene el flujo conversacional entre diferentes tipos de contenido sin perder el hilo de lo que se está discutiendo.

Las mejores funciones de Google Gemini

- Traduce entre docenas de idiomas conservando el contexto y los matices culturales del texto original.

- Genera y ejecuta código Python directamente en las conversaciones, mostrando los resultados y depurando los errores en tiempo real.

- Extraiga datos estructurados de fuentes no estructuradas, como recibos, formularios y documentos escritos a mano.

- Analiza simultáneamente los componentes visuales y de audio para obtener resúmenes detallados del contenido de los vídeos.

- Realice tareas de razonamiento complejo que requieren combinar información de múltiples fuentes y tipos de contenido.

Limitaciones de Google Gemini

- Disponibilidad limitada en determinadas regiones y para casos de uso específicos.

- Opciones de personalización de modelos menos amplias en comparación con las alternativas establecidas.

- Los usuarios han expresado su preocupación por la privacidad de los datos dentro del ecosistema de Google.

Precios de Google Gemini

- Free

- Nivel de pago: los precios varían según el modelo.

Valoraciones y reseñas de Google Gemini

- G2: 4,4/5 (más de 245 reseñas)

- Capterra: No hay suficientes reseñas.

🧠 Dato curioso: Se podría pensar que los mejores modelos cometerían menos errores, pero puede ocurrir lo contrario. A medida que los LLM se hacen más grandes y avanzados, a veces tienen más alucinaciones, especialmente cuando se les piden datos concretos. Incluso las versiones más recientes muestran errores más seguros, lo que los hace más difíciles de detectar.

9. Microsoft Copilot (ideal para mejorar la productividad en las aplicaciones de Microsoft Office)

a través de Microsoft Copilot

Copilot vive dentro de las aplicaciones de Microsoft que utilizas a diario, lo que cambia la forma en que se percibe la IA en la práctica. Entiende tu contexto de trabajo: tu estilo de escritura, los datos que analizas e incluso tu historial de reuniones.

Pídele que cree una presentación y extraerá la información relevante de tus documentos y correos electrónicos recientes.

La integración con Excel es especialmente inteligente, ya que le ayuda a analizar datos utilizando lenguaje natural en lugar de fórmulas complejas. ¿Lo mejor de todo? La curva de aprendizaje es mínima, ya que la interfaz de la herramienta de colaboración de IA se basa en las convenciones habituales de Microsoft.

Las mejores funciones de Microsoft Copilot

- Transforme los datos sin procesar en atractivas presentaciones de PowerPoint utilizando sus plantillas existentes y sus directrices de marca.

- Automatice tareas repetitivas de Excel, como tablas dinámicas, formato condicional y creación de fórmulas, mediante comandos conversacionales.

- Redacta agendas de reuniones y correos electrónicos de seguimiento basados en invitaciones de calendario y notas de reuniones anteriores.

- Diseña documentos de aspecto profesional utilizando estilos integrados y sugerencias de formato que se ajustan a los estándares de tu organización.

Limitaciones de Microsoft Copilot

- La herramienta requiere una suscripción a Microsoft 365 y un compromiso con el ecosistema, y tiene una funcionalidad limitada fuera de las aplicaciones de Microsoft.

- Rendimiento inconsistente en diferentes aplicaciones de Office

Precios de Microsoft Copilot

- Free

- Copilot Pro: 20 $ al mes

- Copilot para Microsoft 365: 30 $ al mes por usuario (facturado anualmente)

Valoraciones y reseñas de Microsoft Copilot

- G2: 4,4/5 (más de 85 reseñas)

- Capterra: No hay suficientes reseñas.

¿Qué opinan los usuarios reales sobre Microsoft Copilot?

Un usuario de Reddit dice:

Lo uso todos los días para ayudarme con las funciones más complicadas de Excel. Si tengo una idea conceptual de cómo quiero manipular los datos, expongo la situación y Copilot casi siempre me ofrece una solución práctica y útil. Me ha ayudado a familiarizarme mucho más con las funciones de matriz y a sentirme más cómodo con ellas.

Lo uso todos los días para ayudarme con las funciones más complicadas de Excel. Si tengo una idea conceptual de cómo quiero manipular los datos, expongo la situación y Copilot casi siempre me ofrece una solución práctica y útil. Me ha ayudado a familiarizarme mucho más con las funciones de matriz y a sentirme más cómodo con ellas.

📖 Lea también: Las mejores alternativas a Microsoft Copilot para facilitar su vida y sus flujos de trabajo.

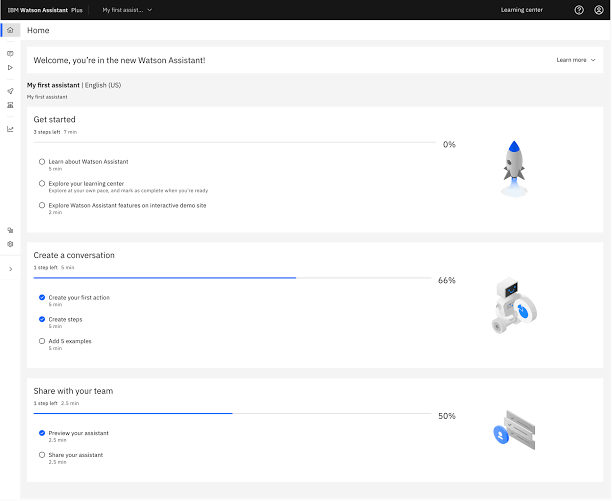

10. IBM WatsonX (la mejor opción para implementar IA en entornos empresariales altamente regulados)

a través de IBM WatsonX

IBM diseñó WatsonX específicamente para organizaciones que no pueden asumir riesgos con la IA, como bancos, hospitales y agencias gubernamentales. Cada decisión del modelo se registra, creando pistas de auditoría que los equipos de cumplimiento normativo aprecian.

La plataforma ofrece soluciones específicas para cada sector, lo que permite a las organizaciones sanitarias utilizar modelos entrenados con literatura médica y a las organizaciones de servicios financieros adquirir capacidades de evaluación de riesgos.

En función de sus requisitos de confidencialidad de datos, puede implementar modelos en sus instalaciones, en la nube de IBM o en configuraciones híbridas. Las funciones de gobernanza le permiten establecer barreras de protección y supervisar los resultados de la IA para detectar sesgos o comportamientos inesperados.

Las mejores funciones de IBM WatsonX

- Implemente un control de imparcialidad que detecte y corrija automáticamente los sesgos en las predicciones de los modelos en diferentes grupos demográficos.

- Crea plantillas personalizadas de indicaciones de IA con medidas de seguridad integradas que evitan respuestas de IA dañinas o inapropiadas.

- Genere informes de cumplimiento detallados que muestren las decisiones del modelo y el uso de datos para auditorías normativas y documentación.

- Prueba la solidez del modelo utilizando ejemplos adversarios y casos extremos para identificar posibles vulnerabilidades antes de la implementación.

- Establezca flujos de trabajo con intervención humana en los que las decisiones críticas requieran una aprobación manual antes de su ejecución.

Limitaciones de IBM WatsonX

- Costes más elevados en comparación con las alternativas nativas en la nube de Hugging Face.

- Los requisitos de configuración y configuración son complejos.

- Tiene un ciclo de innovación más lento en comparación con las plataformas de IA más recientes.

- Soporte comunitario limitado y extensiones de terceros.

Precios de IBM WatsonX

- Free

- Lo esencial: Desde 0 $ al mes (modelo de pago por uso).

- Estándar: A partir de 1050 $ al mes (modelo de pago por uso).

Valoraciones y reseñas de IBM WatsonX

- G2: 4,5/5 (más de 84 opiniones)

- Capterra: No hay suficientes reseñas.

¿Qué opinan los usuarios reales sobre IBM WatsonX?

Basado en una reseña de G2:

Como desarrollador, valoro cómo combina flexibilidad y estructura, ofreciendo un amplio intervalo de tipos de modelos, desde el ML clásico hasta los grandes modelos de lenguaje. La interfaz de usuario es limpia y la integración con los marcos de seguridad y nube existentes es sencilla, lo que ayuda a acelerar los ciclos de experimentación sin comprometer la gobernanza. […] Aunque la plataforma es potente, al principio puede resultar abrumadora, especialmente cuando se configuran flujos de trabajo más personalizados. Además, los precios podrían ser más transparentes para los usuarios que aún están explorando opciones antes de realizar la confirmación a nivel de corporación. Sería muy útil mejorar los tutoriales de incorporación para los desarrolladores nuevos en el ecosistema de IBM.

Como desarrollador, valoro cómo combina flexibilidad y estructura, ofreciendo un amplio intervalo de tipos de modelos, desde el ML clásico hasta los grandes modelos de lenguaje. La interfaz de usuario es limpia y la integración con los marcos de seguridad y nube existentes es sencilla, lo que ayuda a acelerar los ciclos de experimentación sin comprometer la gobernanza. […] Aunque la plataforma es potente, al principio puede resultar abrumadora, especialmente cuando se configuran flujos de trabajo más personalizados. Además, los precios podrían ser más transparentes para los usuarios que aún están explorando opciones antes de comprometerse a nivel de corporación. Sería muy útil mejorar los tutoriales de incorporación para los desarrolladores nuevos en el ecosistema de IBM.

🎥 Ver: Prueba tu primer agente de IA que responde contextualmente a tu trabajo. Escúchalo directamente de Zeb Evans, fundador y director ejecutivo de ClickUp:

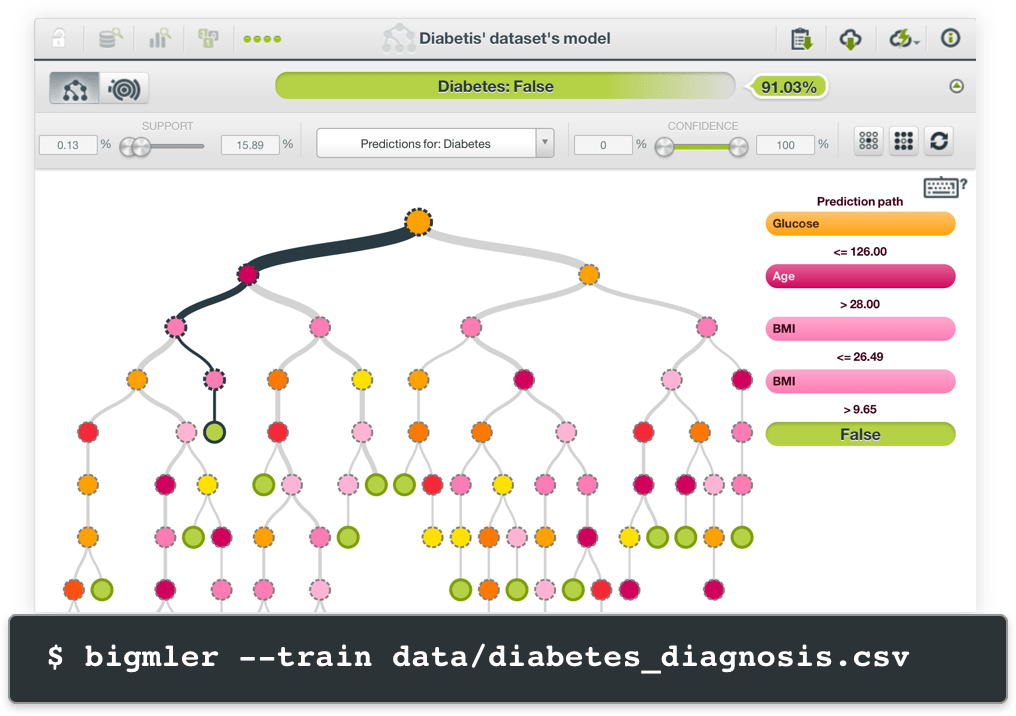

11. BigML. com (ideal para crear modelos predictivos sin necesidad de conocimientos técnicos ni de código)

vía BigML

La interfaz visual de BigML le permite crear modelos predictivos arrastrando y soltando conjuntos de datos en lugar de escribir código complejo. Cargue un archivo CSV con los datos de los clientes y BigML le ayudará a predecir cuáles son los clientes que probablemente abandonarán la empresa.

La plataforma se encarga automáticamente del preprocesamiento de datos, la selección de características y la validación de modelos. Lo que hace que BigML sea fiable es cómo explica sus predicciones. Obtiene visualizaciones claras que muestran qué factores influyen en las decisiones del modelo, lo que facilita la presentación de los resultados a las partes interesadas que necesitan comprender el «porqué» de las recomendaciones de IA.

BigML. com: mejores funciones

- Genere información y recomendaciones automatizadas a partir de sus datos utilizando explicaciones en lenguaje natural que puedan entender los equipos sin conocimientos técnicos.

- Combina múltiples algoritmos para mejorar la precisión de las predicciones y reducir los riesgos de sobreajuste con modelos conjuntos.

- Realice análisis de agrupamiento para identificar patrones ocultos y segmentos de clientes en los datos de su empresa.

- Cree modelos de previsión de series temporales para la planificación de inventarios, la predicción de la demanda y las proyecciones financieras.

- Exporte la lógica de predicción como aplicaciones independientes o intégrela directamente en los sistemas empresariales existentes.

Limitaciones de BigML.com

- Tiene compatibilidad limitada para el aprendizaje profundo y las arquitecturas de redes neuronales.

- Menos opciones de personalización en comparación con las plataformas basadas en programación.

- Comunidad y ecosistema de herramientas de terceros más reducidos.

- Menos adecuado para la investigación de vanguardia y los enfoques experimentales.

Precios de BigML.com

- 14 días de versión de prueba gratuita.

- Standard Prime: 30 $ al mes

Valoraciones y reseñas de BigML.com

- G2: 4,7/5 (más de 20 reseñas)

- Capterra: No hay suficientes reseñas.

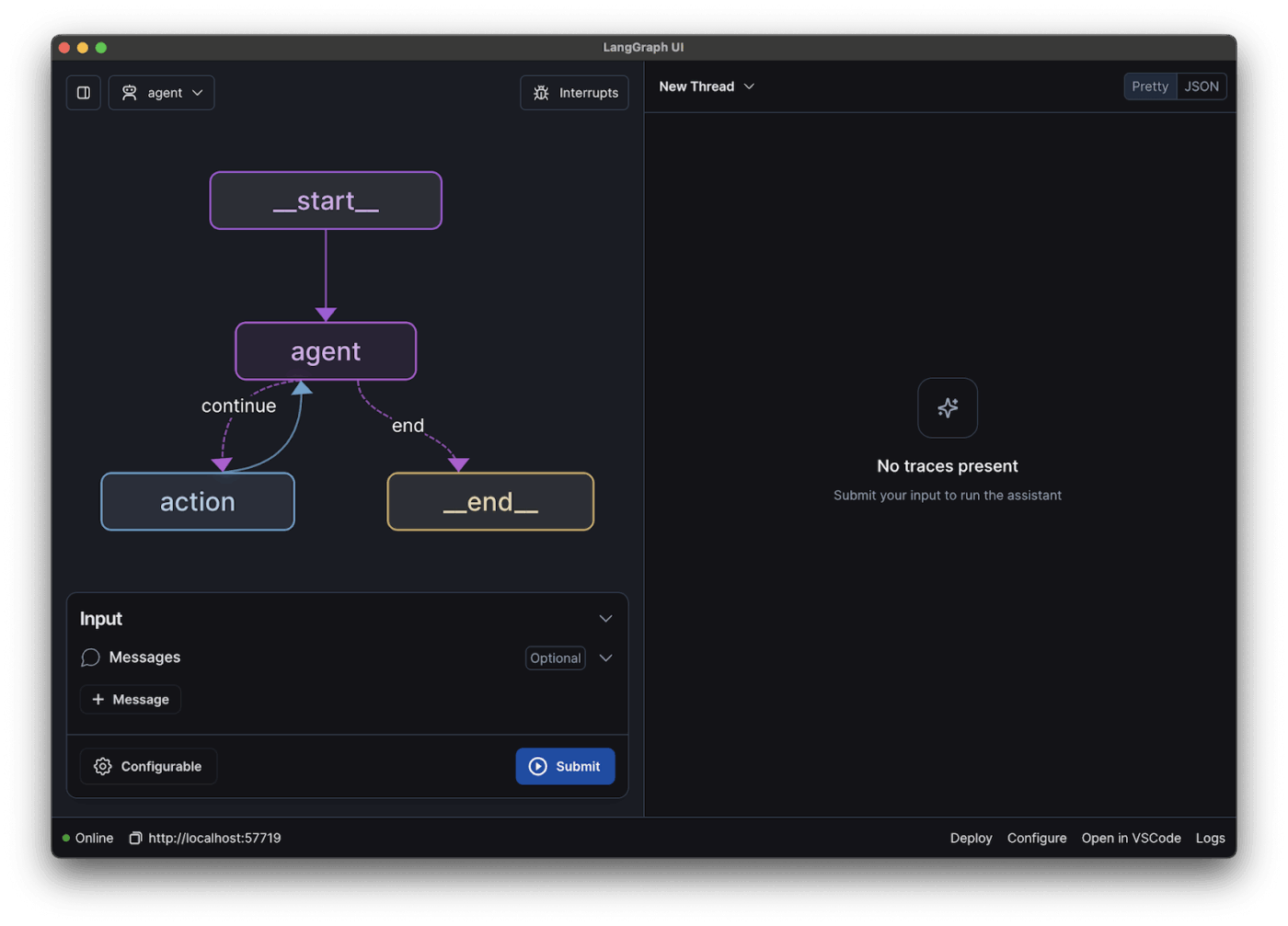

12. LangChain (ideal para desarrollar aplicaciones de IA complejas con múltiples componentes)

a través de LangChain

LangChain resuelve el problema de conectar modelos de IA con aplicaciones del mundo real. Puede crear sistemas que busquen información en bases de datos, llamen a API externas y mantengan el historial de conversaciones a lo largo de múltiples interacciones.

El marco proporciona componentes preconstruidos para patrones comunes como RAG, donde los modelos de IA pueden acceder y citar documentos específicos. Puede encadenar diferentes servicios de IA, tal vez utilizando un modelo para comprender la intención del usuario y otro para generar respuestas.

Además, las capacidades del agente LLM de LangChain son de código abierto e independientes del modelo, por lo que no estará limitado a ningún proveedor de IA en particular.

Las mejores funciones de LangChain

- Depura flujos de trabajo de IA complejos utilizando herramientas integradas de seguimiento y registro que muestran exactamente cómo fluyen los datos entre los componentes.

- Almacena en caché las costosas llamadas a la API y las respuestas de los modelos para reducir los costes y mejorar el rendimiento de las aplicaciones.

- Gestione los errores con elegancia gracias a la lógica de reintento y los mecanismos de respaldo cuando los servicios de IA no estén disponibles.

- Cree marcos de evaluación personalizados para probar el rendimiento de las aplicaciones de IA en diferentes escenarios y conjuntos de datos.

- Implemente respuestas en streaming para aplicaciones en tiempo real en las que los usuarios necesitan una respuesta inmediata durante procesos de larga duración.

Limitaciones de LangChain

- Requiere conocimientos de programación y comprensión de los conceptos de IA.

- El rápido ritmo de desarrollo puede provocar cambios radicales e inestabilidad.

- Sobrecarga de rendimiento de las capas de abstracción en aplicaciones complejas.

- Herramientas integradas limitadas de supervisión y depuración para entornos de producción.

Precios de LangChain

- Desarrollador: A partir de 0 $ al mes (luego se paga por uso).

- Además: Desde 39 $ al mes (y luego se paga por uso).

- Enterprise: Precios personalizados

Valoraciones y reseñas de LangChain

- G2: No hay suficientes reseñas.

- Capterra: No hay suficientes reseñas.

💡 Consejo profesional: antes de invertir recursos en un LLM masivo, crea un canal de recuperación de información sólido que filtre el contexto con precisión. La mayoría de las alucinaciones comienzan con entradas ruidosas, no con límites del modelo.

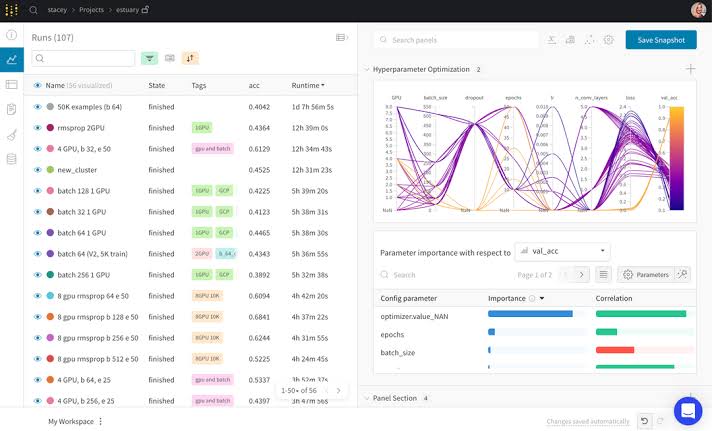

13. Weights & Biases (la mejor opción para realizar el seguimiento y comparar los resultados de los experimentos de aprendizaje automático)

vía Weights & Biases

Weights & Biases evita que el aprendizaje automático se convierta en un caos de experimentos olvidados y resultados perdidos. La plataforma captura automáticamente todo lo relacionado con el entrenamiento de su modelo: hiperparámetros, métricas, versiones de código e incluso el rendimiento del sistema.

Cuando algo funciona bien, es fácil reproducirlo. Cuando los experimentos fallan, puedes ver exactamente qué es lo que ha salido mal.

Las herramientas de visualización te ayudan a detectar tendencias en cientos de ejecuciones de entrenamiento, identificando qué enfoques producen el mejor rendimiento. A los equipos les encantan las funciones de colaboración porque todos pueden ver lo que están intentando los demás sin interferir en el trabajo de los demás.

Las mejores funciones de Weights & Biases

- Configura barridos automatizados de hiperparámetros que exploran diferentes combinaciones de parámetros e identifican las configuraciones óptimas.

- Cree paneles personalizados con gráficos interactivos que se actualizan en tiempo real a medida que avanzan los experimentos.

- Etiqueta y organiza los experimentos utilizando metadatos personalizados para encontrar resultados relevantes en grandes proyectos de investigación.

- Comparte los resultados de los experimentos externamente mediante informes públicos que no exponen código ni datos confidenciales.

- Analice el perfil del entrenamiento para identificar problemas de utilización de la GPU y optimizar la asignación de recursos.

Limitaciones de Weights & Biases

- La herramienta introduce una complejidad adicional para proyectos sencillos que no requieren un seguimiento exhaustivo.

- Los costes pueden acumularse rápidamente para equipos grandes y un seguimiento exhaustivo de los experimentos.

- Ha habido críticas sobre la documentación técnica inadecuada.

Precios de Weights & Biases

Alojado en la nube

- Free

- Ventaja: Desde 50 $ al mes.

- Enterprise: Precios personalizados

Alojamiento privado

- Gratis para uso personal.

- Enterprise avanzada: Precios personalizados

Valoraciones y reseñas de Weights & Biases

- G2: 4,7/5 (más de 40 reseñas)

- Capterra: No hay suficientes reseñas.

¿Qué opinan los usuarios reales sobre Weights & Biases?

En Reddit, un usuario dijo:

Utilizo WandB en mi trabajo varias horas al día. Es la herramienta con más funciones para esta aplicación que existe, pero su rendimiento es terriblemente malo.

Utilizo WandB en mi trabajo varias horas al día. Es la herramienta con más funciones para esta aplicación que existe, pero su rendimiento es realmente pésimo.

📮 Información de ClickUp: Solo el 12 % de los encuestados utiliza las funciones de IA integradas en las suites de productividad. Este bajo nivel de adopción sugiere que las implementaciones actuales pueden carecer de la integración contextual fluida que obligaría a los usuarios a abandonar sus plataformas conversacionales independientes preferidas.

Por ejemplo, ¿puede la IA ejecutar un flujo de trabajo de automatización basado en una indicación de texto sin formato del usuario? ¡ClickUp Brain puede hacerlo ! La IA está profundamente integrada en todos los aspectos de ClickUp, incluyendo, entre otros, resumir hilos de chat, redactar o pulir textos, extraer información del entorno de trabajo de ClickUp, generar imágenes y mucho más.

¡Únete al 40 % de los clientes de ClickUp que han sustituido más de tres aplicaciones por nuestra aplicación integral para el trabajo!

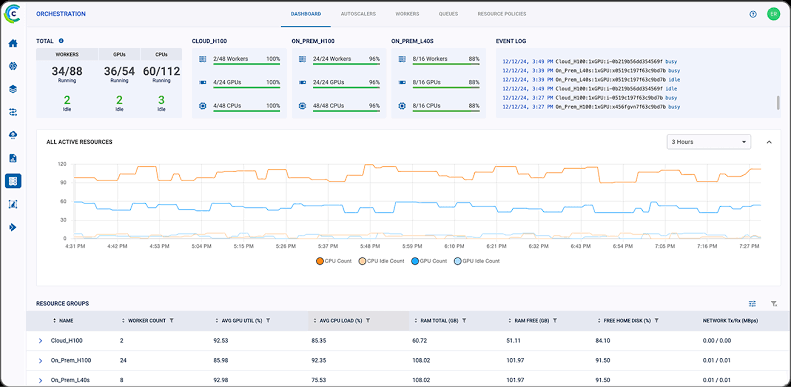

14. ClearML (la mejor opción para automatizar flujos de trabajo de operaciones de aprendizaje automático de extremo a extremo)

a través de ClearML

ClearML se encarga de la pesadilla operativa que supone gestionar modelos de aprendizaje automático en producción. La plataforma realiza un seguimiento automático de todos los aspectos de su flujo de trabajo de ML, desde el preprocesamiento de datos hasta la implementación de modelos, creando un registro de auditoría completo sin esfuerzo manual.

Cuando los modelos fallan en producción, puede rastrear los problemas hasta cambios específicos en los datos o modificaciones en el código. Las capacidades de entrenamiento distribuido le permiten escalar experimentos a través de múltiples máquinas y proveedores de nube sin problemas.

Además, la orquestación de procesos realiza la automatización de tareas repetitivas como la validación de datos, el reentrenamiento de modelos y las aprobaciones de implementación.

Las mejores funciones de ClearML

- Programa experimentos para que se ejecuten automáticamente durante las horas de menor actividad y optimiza así los costes informáticos y la utilización de los recursos.

- Compare el rendimiento de los modelos en diferentes conjuntos de datos y periodos de tiempo utilizando métricas de evaluación estandarizadas.

- Integre con los procesos de CI/CD y las herramientas de implementación existentes utilizando artefactos personalizados y registros de modelos.

- Implemente despliegues azul-verde para modelos ML con capacidades de reversión automatizadas cuando el rendimiento disminuya.

- Genere automáticamente documentación de cumplimiento normativo para sectores regulados que requieren una gobernanza detallada de los modelos.

Limitaciones de ClearML

- Configuración inicial compleja y configuración de funciones avanzadas.

- Curva de aprendizaje para equipos que pasan de una gestión de flujos de trabajo más sencilla

- La supervisión intensiva en recursos de ClearML puede afectar al rendimiento del sistema.

- Integraciones limitadas en comparación con alternativas a Hugging Face más consolidadas.

Precios de ClearML

- Free

- Pro: 15 $/mes por usuario + uso (para equipos de hasta 10 miembros)

- Escala: Precios personalizados

- Enterprise: Precios personalizados

Valoraciones y reseñas de ClearML

- G2: No hay suficientes reseñas.

- Capterra: No hay suficientes reseñas.

¿Qué opinan los usuarios reales sobre ClearML?

Como se ha usado compartido en Reddit:

Utilizamos ClearML exclusivamente para el seguimiento de experimentos y hemos alojado tanto el servidor ClearML como el agente ClearML en nuestra infraestructura interna. Hasta ahora, nuestra experiencia con ClearML ha sido excelente, especialmente en lo que respecta a la gestión de experimentos, la reproducibilidad y el flujo de trabajo de implementación.

Utilizamos ClearML exclusivamente para el seguimiento de experimentos y hemos alojado tanto el servidor ClearML como el agente ClearML en nuestra infraestructura interna. Hasta ahora, nuestra experiencia con ClearML ha sido excelente, especialmente en lo que respecta a la gestión de experimentos, la reproducibilidad y el flujo de trabajo de implementación.

🔍 ¿Sabías que...? Los sistemas híbridos superan constantemente a los de recuperación con un solo método. Integra ambos enfoques en tu motor de búsqueda de IA para equilibrar la comprensión semántica con la precisión de la coincidencia exacta.

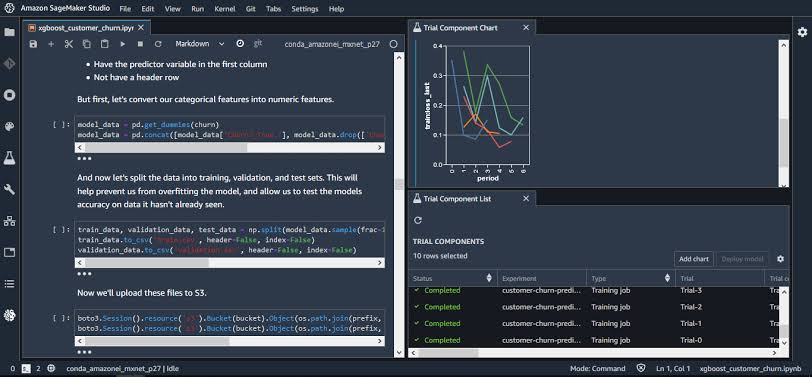

15. Amazon SageMaker (la mejor opción para gestionar ciclos de vida completos de ML en la infraestructura de AWS)

a través de Amazon SageMaker

SageMaker es una buena opción si ya utiliza AWS y necesita capacidades de ML que funcionen a la perfección con su infraestructura existente. Los cuadernos gestionados eliminan los problemas de configuración del servidor, mientras que los algoritmos integrados gestionan los casos de uso más comunes sin necesidad de código personalizado.

Ground Truth ayuda a crear conjuntos de datos de entrenamiento de alta calidad a través de flujos de trabajo de anotación gestionados, lo que resulta especialmente valioso cuando se necesitan etiquetadores humanos para datos de imagen o texto.

Cuando los modelos están listos para su producción, SageMaker se encarga de las complejidades de la implementación, como el equilibrio de carga y el escalado automático. Todo se factura a través de su cuenta AWS existente, lo que simplifica la gestión de costes.

Las mejores funciones de Amazon SageMaker

- Entrene modelos utilizando una infraestructura gestionada que aprovisiona automáticamente los recursos en función del tamaño del conjunto de datos y los requisitos computacionales.

- Implemente modelos a través de puntos finales escalables que gestionan los picos de tráfico y ajustan automáticamente la capacidad de cálculo en función de la demanda.

- Optimice el rendimiento de los modelos mediante el ajuste automático de hiperparámetros, que prueba miles de combinaciones para encontrar los ajustes óptimos.

- Supervise los modelos de producción mediante la integración con CloudWatch, que realiza el seguimiento de la precisión de las predicciones, la latencia y las métricas de calidad de los datos.

Limitaciones de Amazon SageMaker

- Su compleja estructura de precios puede generar costes inesperados para un uso a gran escala, ya que no está claro

- Hay una curva de aprendizaje para los equipos que no están familiarizados con el ecosistema y los servicios de AWS.

- La interfaz de la herramienta puede ser lenta o difícil de navegar debido a fallos técnicos.

- El uso de Amazon SageMaker dificulta la migración a otros proveedores de nube.

Precios de Amazon SageMaker

- SageMaker Unified Studio: Gratis, gratuito/a

- Precios personalizados

Valoraciones y reseñas de Amazon SageMaker

- G2: 4,3/5 (45 opiniones)

- Capterra: No hay suficientes reseñas.

¿Qué opinan los usuarios reales sobre Amazon SageMaker?

Según una reseña de G2:

Lo que más me gusta de Amazon SageMaker es su capacidad para gestionar todo el ciclo de vida del aprendizaje automático en una plataforma integrada. Simplifica la creación, el entrenamiento y la implementación de modelos, al tiempo que ofrece escalabilidad y potentes herramientas como SageMaker Studio y la automatización del ajuste de modelos.

Lo que más me gusta de Amazon SageMaker es su capacidad para gestionar todo el ciclo de vida del aprendizaje automático en una plataforma integrada. Simplifica la creación, el entrenamiento y la implementación de modelos, al tiempo que ofrece escalabilidad y potentes herramientas como SageMaker Studio y el ajuste automatizado de modelos.

💡 Consejo profesional: No entrene lo que no puede estructurar. Antes de pasar al ajuste fino, pregúntese: ¿Se puede resolver esto con lógica estructurada y un modelo base? Por ejemplo, en lugar de entrenar un modelo para detectar tipos de facturas, añada primero un clasificador simple que filtre en función de los metadatos.

Saca el máximo partido a tu flujo de trabajo con ClickUp.

Existen muchas alternativas a Hugging Face, pero ¿por qué limitarse a los modelos y las API?

ClickUp va un paso más allá.

Con ClickUp Brain y Brain MAX, puedes escribir más rápido, resumir cosas en segundos y ejecutar automatizaciones que te entienden. Está integrado directamente en tus tareas, documentos y chats, por lo que nunca tendrás que saltar entre herramientas o pestañas.

¡Regístrese en ClickUp y compruebe por qué es la alternativa más inteligente a Hugging Face! ✅