GitHub Copilot kann innerhalb weniger Minuten Hunderte von Testfällen generieren – kontrollierte Experimente zeigen, dass Entwickler dadurch 35 % schneller fertig werden –, aber hier ist der Haken: Diese KI-generierten Tests sind nur so nützlich, wie Ihre Fähigkeit zur Nachverfolgung, Organisation und Verbindung mit dem Rest Ihres Entwicklungs-Workflows.

Dieser Leitfaden führt Sie durch die Verwendung von GitHub Copilot zum schnellen Erstellen von Testfällen und zeigt Ihnen anschließend, wie Sie diese effektiv verwalten können, damit sie nicht zu einem weiteren Stapel verwaisten Code-Dateien werden.

Warum Unit-Tests für die Softwarequalität wichtig sind

Das Schreiben von Unit-Tests wird oft als mühsame Aufgabe angesehen, aber wenn man sie auslässt, führt das zu instabilem Code.

Wenn Sie kein Sicherheitsnetz in Form von Tests haben, kann eine kleine Umgestaltung zu Regressionsfehlern führen – Bugs, die bestehende Funktionen beeinträchtigen und das Vertrauen der Benutzer untergraben. Untersuchungen von IBM zeigen, dass die Behebung von Fehlern, die nach der Veröffentlichung entdeckt werden, 15-mal so viel kostet.

Dies führt zu einem Zyklus, in dem Entwickler es vermeiden, den Code zu verbessern, weil sie Angst haben, dass etwas kaputt gehen könnte, was zu einer zunehmenden technischen Verschuldung führt.

Die KI-gestützte Testgenerierung hilft, diesen Zyklus zu durchbrechen. 89 % der Unternehmen testen oder implementieren derzeit generative KI-Workflows im Bereich Qualitätsentwicklung und -prüfung. Durch die Verwendung eines Tools wie GitHub Copilot zum Erstellen von Testfällen können Sie sich auf das Wesentliche konzentrieren: das Entwerfen aussagekräftiger Tests und die Verfeinerung der Abdeckung von Randfällen.

Hier sind die Gründe, warum sich konsistente Unit-Tests auszahlen:

- Regressionsvermeidung: Gute Tests fungieren als Leitplanke und stellen sicher, dass neue Features oder Fehlerbehebungen nicht unbeabsichtigt etwas anderes beschädigen.

- Lebendige Dokumentation: Im Gegensatz zu statischer Dokumentation, die veralten kann, dienen Unit-Tests als ausführbare Beispiele dafür, wie sich Ihr Code verhalten soll.

- Sicherheit beim Refactoring: Wenn Sie über eine umfassende Testabdeckung verfügen, können Sie Ihre Codebasis mit der Gewissheit refactoren und verbessern, dass Sie sofort wissen, wenn eine Änderung unbeabsichtigte Folgen hat.

Um besser zu verstehen, wie KI-Agenten die Codierungslandschaft über die reine Testgenerierung hinaus verändern, sehen Sie sich diese Übersicht über KI-gestützte Codierungsassistenten und ihre Fähigkeiten an:

So richten Sie GitHub Copilot für die Generierung von Testfällen ein

Bevor Sie mit der Generierung von Tests beginnen können, müssen Sie GitHub Copilot in Ihrer integrierten Entwicklungsumgebung (IDE) installieren und konfigurieren. Das Setup ist unkompliziert und dauert nur wenige Minuten, aber wenn Sie es richtig durchführen, stellt Copilot sicher, dass es über den erforderlichen Kontext verfügt, um relevante Vorschläge zu unterbreiten.

Bevor Sie beginnen, benötigen Sie einige Dinge:

- Ein aktives GitHub Copilot-Abonnement (Individual, Business oder Enterprise)

- Eine unterstützte IDE, wie z. B. VS Code, eine JetBrains-IDE (wie IntelliJ oder PyCharm) oder Neovim

- Ein Test-Framework wie pytest, Jest oder JUnit, das bereits in Ihrem Projekt installiert ist.

Installieren Sie die GitHub Copilot-Erweiterung.

Zunächst müssen Sie die Copilot-Erweiterung in Ihrer IDE installieren. Dieser Vorgang ist bei den meisten unterstützten Editorsen ähnlich.

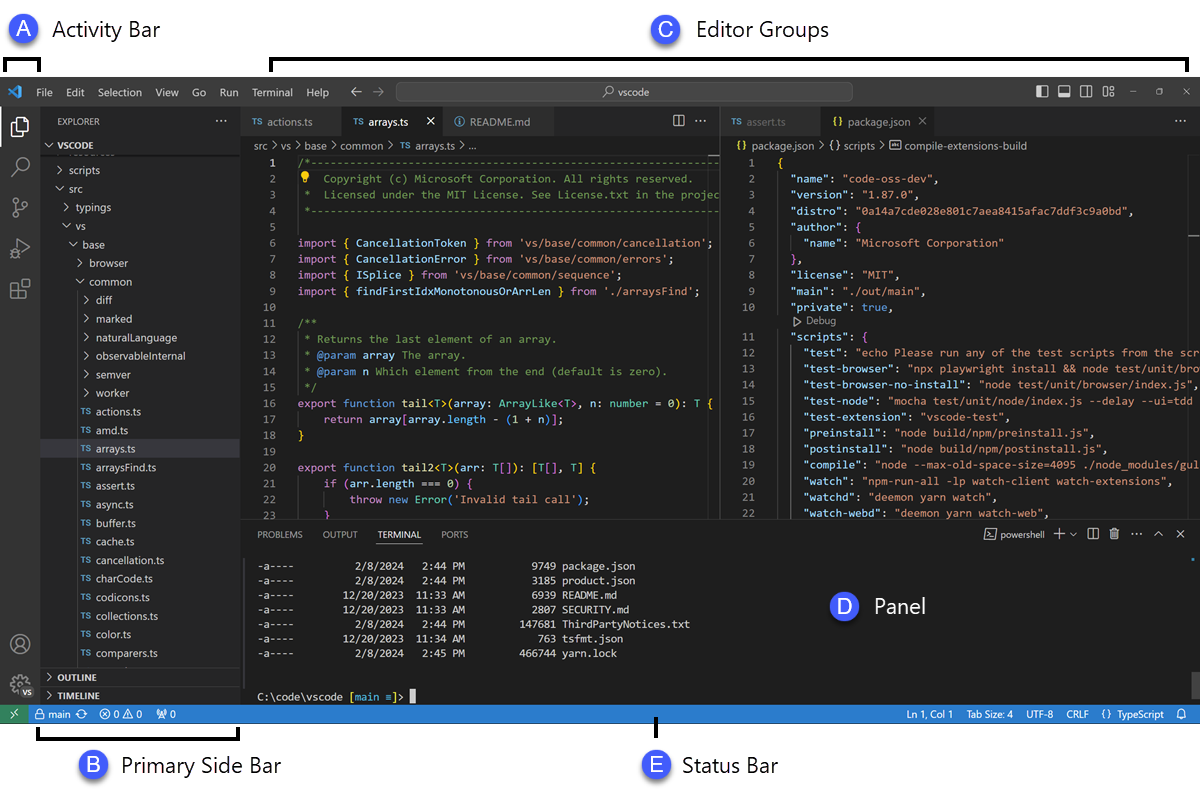

- Öffnen Sie den Marktplatz für Erweiterungen Ihrer IDE. In VS Code ist dies das Symbol „Erweiterungen“ in der Seitenleiste; in JetBrains-IDEs finden Sie es unter „Einstellungen“ → „Plugins“.

- Suchen Sie nach „GitHub Copilot“.

- Installieren Sie sowohl die Haupt-Erweiterung GitHub Copilot als auch die Erweiterung GitHub Copilot Chat, um alle Funktionen nutzen zu können.

- Sie werden aufgefordert, Ihre IDE neu zu starten, um die Installation abzuschließen.

Nach dem Neustart werden Sie aufgefordert, sich mit Ihrem GitHub-Konto anzumelden. Dieser Schritt dient zur Authentifizierung Ihres Abonnements. Sobald Sie angemeldet sind, sollte in der Leiste Ihrer IDE ein kleines Copilot-Symbol angezeigt werden, das bestätigt, dass das Programm aktiv und einsatzbereit ist.

Konfigurieren Sie Ihr Test-Framework

GitHub Copilot generiert relevantere Tests, wenn es das spezifische Testing-Setup Ihres Projekts versteht. Dazu analysiert es Ihre vorhandenen Testdateien und Konfigurationen, um die Muster Ihres Teams zu lernen und anzupassen.

- Für Python-Projekte, die pytest verwenden: Stellen Sie sicher, dass Sie pytest installiert haben (pip install pytest). Wenn Sie eine conftest.py-Datei oder vorhandene Testdateien (auch nur eine) haben, verwendet Copilot diese als Referenz für die Generierung neuer Tests.

- Für JavaScript-/TypeScript-Projekte, die Jest verwenden: Copilot sucht nach einer Datei „jest.config.js“ und Ihrer Jest-Abhängigkeit in Ihrer Datei „package.json“, um Ihr Setup zu verstehen.

- Für Java-Projekte, die JUnit verwenden: Stellen Sie sicher, dass Ihre JUnit-Abhängigkeiten in Ihrer pom.xml-Datei (für Maven) oder build.gradle-Datei (für Gradle) korrekt definiert sind.

Mindestens eine gut geschriebene Testdatei in Ihrem Projekt ist eine der besten Möglichkeiten, Copilot anzuleiten. Es übernimmt Ihre Namenskonventionen, Assertion-Stile und die Struktur Ihrer Tests, was zu konsistenteren Ergebnissen führt.

Integrieren Sie Copilot in Ihre IDE.

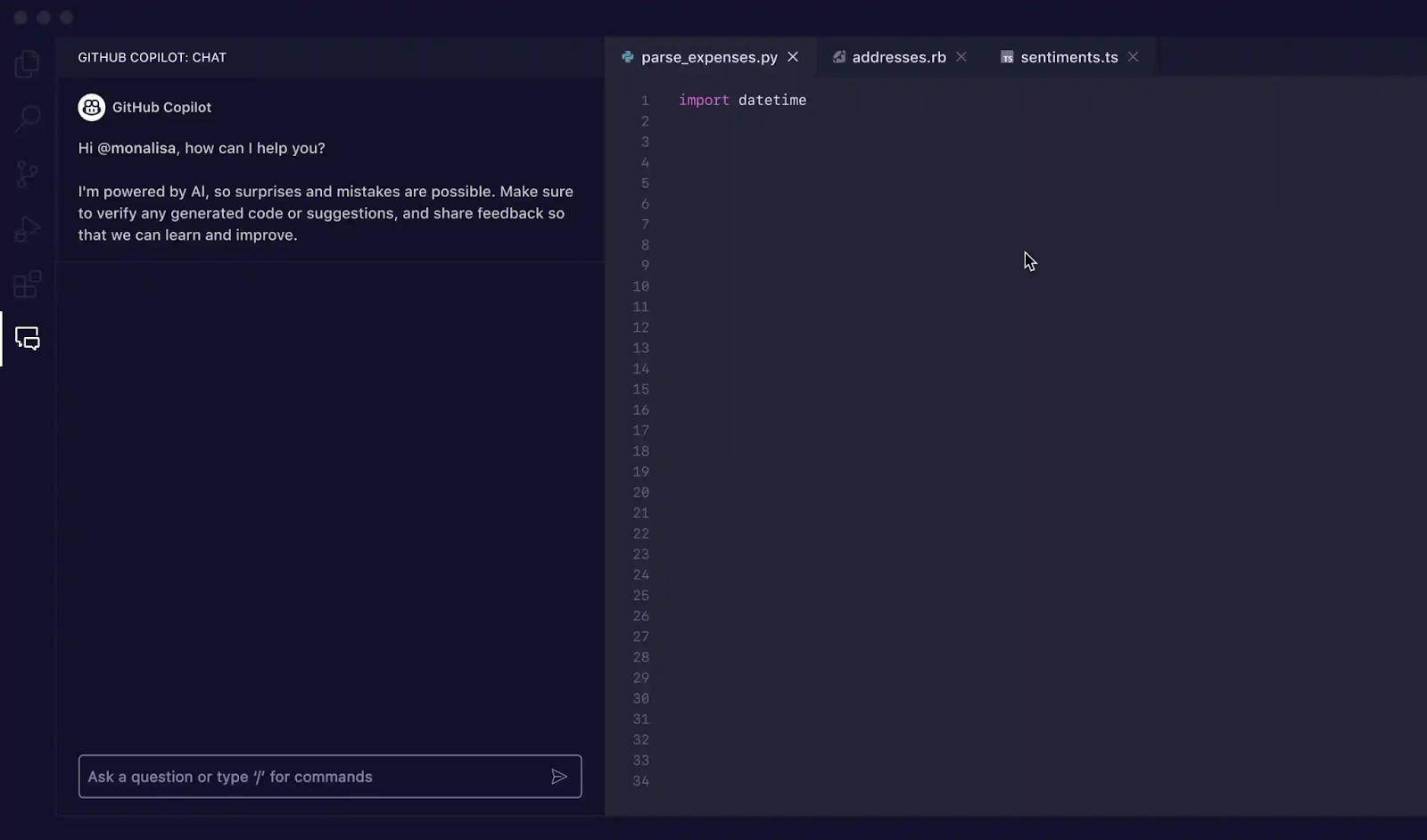

Nachdem Sie die Erweiterungen installiert haben, ist es an der Zeit, sich mit der Copilot-Oberfläche in Ihrer IDE vertraut zu machen. Die Interaktion mit Copilot zur Testgenerierung erfolgt hauptsächlich über das Copilot-Chat-Fenster.

Sie können die Chat-Ansicht mit der Verknüpfung Strg+Cmd+I (auf Mac) oder Strg+Alt+I (auf Windows/Linux) oder durch Klicken auf das Copilot-Chat-Symbol in der Leiste der Aktivitätsansicht Ihrer IDE öffnen. Dieses Chat-Fenster ist Ihr Command-Center für die Generierung von Tests.

Copilot ist kontextsensitiv, d. h. es liest Ihre aktuell geöffneten Dateien, die Dateistruktur Ihres Projekts und den von Ihnen ausgewählten Code. Um optimale Ergebnisse zu erzielen, sollten Sie die Datei mit der Funktion oder Klasse, die Sie testen möchten, immer in Ihrem Editor geöffnet und mit Sichtbarkeit haben.

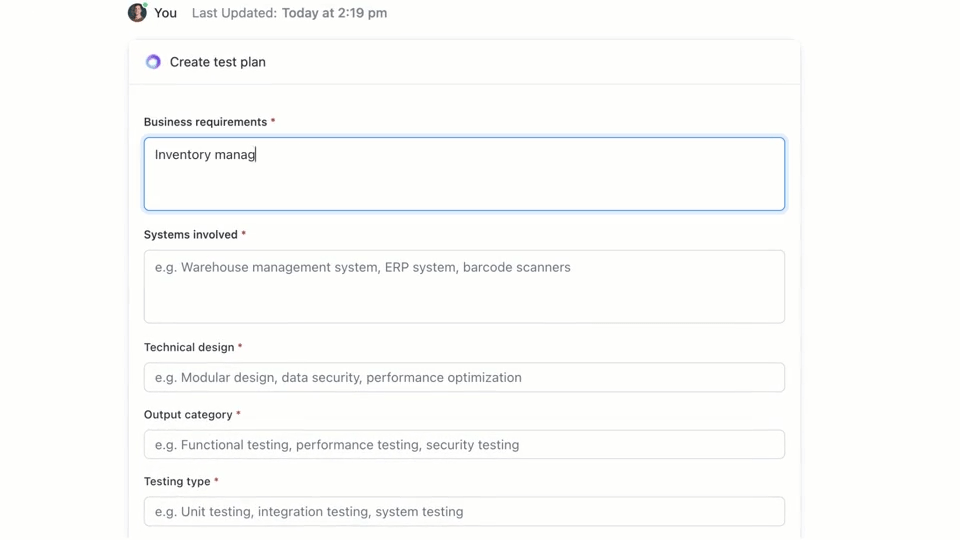

🌟 ClickUp Brain, die in ClickUp integrierte kontextbezogene KI, kann schnell einen Testplan für Sie erstellen. Probieren Sie es noch heute aus.

So schreiben Sie Testfälle mit GitHub Copilot

GitHub Copilot bietet Ihnen drei Möglichkeiten, Testfälle zu generieren: über das Chat-Fenster mit detaillierten Eingabeaufforderungen, über schnelle Slash-Befehle und über intelligente Aktionen direkt in Ihrem Editor. Jede Methode eignet sich für unterschiedliche Situationen innerhalb Ihres EntwicklungsWorkflows, je nachdem, ob Sie Geschwindigkeit oder fein abgestimmte Kontrolle benötigen.

Verwenden Sie Copilot Chat-Eingabeaufforderungen

Die Verwendung von Copilot Chat mit einer bestimmten Eingabeaufforderung ist die leistungsstärkste Methode zur Generierung von Testfällen. Sie eignet sich am besten für komplexe Funktionen oder Klassen, bei denen Sie bestimmte Szenarien definieren, Abhängigkeiten simulieren oder schwierige Randfälle behandeln müssen.

Hier ist der grundlegende Workflow:

- Öffnen Sie das Copilot-Chat-Fenster.

- Markieren Sie in Ihrem Editor die Funktion, Klasse oder den Code-Block, den Sie testen möchten.

- Schreiben Sie im Chat-Fenster eine klare, spezifische Eingabeaufforderung, in der Sie die benötigten Tests beschreiben.

Als Beispiel könnten Sie folgende Eingabeaufforderungen schreiben:

- „Schreiben Sie Unit-Tests für die ausgewählte Funktion, die den Happy Path, Randfälle wie leere Eingaben und die Fehlerbehandlung für ungültige Daten abdecken.“

- „Generieren Sie pytest-Tests für diese Klasse und erstellen Sie Fixtures, um die Verbindung zur Datenbank zu simulieren.“

- „Erstellen Sie Jest-Tests für diese React-Komponente, die Benutzerklicks simulieren und die Statusänderungen überprüfen.“

Je detaillierter Ihre Eingabe ist, desto besser werden die generierten Tests sein.

Verwenden Sie Slash-Befehle wie /tests.

Wenn Sie schnell Tests generieren müssen und keine hochspezifischen Szenarien benötigen, ist der Slash-Befehl /tests Ihr bester Freund. Er ist der schnellste Weg, um eine solide Basis für die Testabdeckung zu erhalten.

So verwenden Sie es:

- Öffnen Sie das Copilot-Chat-Fenster.

- Wählen Sie den Code, den Sie testen möchten, in Ihrem Editor aus.

- Geben Sie beim Chatten einfach /tests ein und drücken Sie die Eingabetaste.

Copilot generiert sofort eine Reihe von Unit-Tests basierend auf der Struktur und Logik des von Ihnen ausgewählten Codes. Es wird versucht, die primären Funktionen und einige gängige Eingaben abzudecken. Wenn die Ergebnisse nicht ganz richtig sind, können Sie sie jederzeit mit einer Folgeaufforderung wie „Fügen Sie nun einen Test für den Fall hinzu, dass die Eingabe null ist“ verfeinern.

Verwenden Sie intelligente Editor-Aktionen

Wenn Sie Tests generieren möchten, ohne Ihren Flow zu unterbrechen, können Sie intelligente Aktionen direkt aus Ihrem Code-Editor heraus verwenden. So müssen Sie nicht zum Chat-Fenster wechseln.

- Markieren Sie die Funktion oder Klasse, die Sie testen möchten.

- Klicken Sie mit der rechten Maustaste auf die Auswahl, um das Kontextmenü zu öffnen.

- Navigieren Sie im Kontextmenü zu „Code generieren“ und wählen Sie die Auswahl „Tests generieren“ aus.

Copilot generiert die Tests und zeigt sie in der Regel in einer neuen, temporären Registerkarte des Editors an. Dort können Sie den Code überprüfen und dann entscheiden, ob Sie eine neue Testdatei erstellen oder die Tests an eine bestehende Datei anhängen möchten.

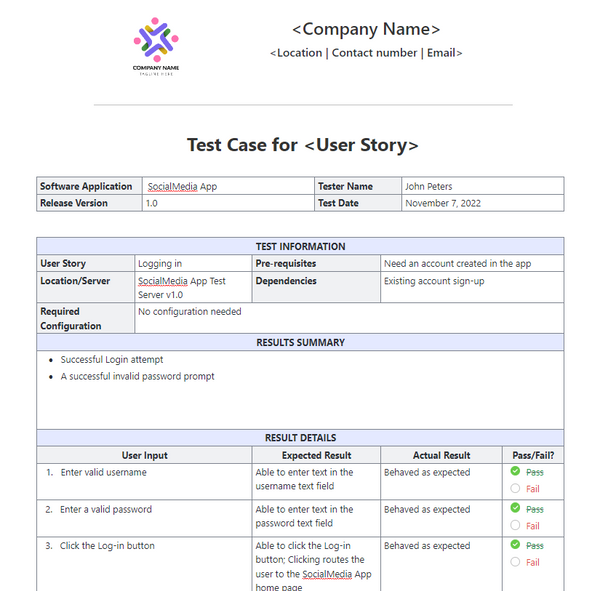

📚 Lesen Sie auch: Testfallvorlagen für Softwaretests

GitHub Copilot-Eingabeaufforderungen für die Testfallgenerierung

Ihre Eingabeaufforderungen sind das Steuerrad für GitHub Copilot. Generische Eingabeaufforderungen sind das Ergebnis generischer Tests, aber gut formulierte Eingabeaufforderungen, die der KI spezifische Anweisungen geben, sind das Ergebnis umfassender und nützlicher Testfälle. Der Schlüssel liegt darin, Copilot nicht nur zu sagen, was getestet werden soll, sondern auch, wie es getestet werden soll.

Hier sind einige Vorlagen, die Sie für verschiedene Szenarien anpassen können:

| Szenario | Prompt-Vorlage |

|---|---|

| Grundlegende Unit-Tests | „Schreiben Sie Unit-Tests für die Funktion [function_name] unter Verwendung von [framework]. Achten Sie darauf, normale Eingaben, Grenzwerte wie Null oder negative Zahlen sowie ungültige Eingaben wie null oder undefined abzudecken. “ |

| Klasse mit Abhängigkeiten | „Generieren Sie Tests für die Klasse [ClassName]. Verwenden Sie [mocking_library], um Mocks für die Abhängigkeiten [DependencyName] und [AnotherDependencyName] zu erstellen. “ |

| Asynchrone Funktionen | „Erstellen Sie Tests für diese asynchrone Funktion. Fügen Sie Tests für den Fall des Erfolgs, einen Fall, in dem das Versprechen abgelehnt wird, und ein Szenario für Zeitüberschreitungen bei Anfragen hinzu. “ |

| API-Endpunkt | „Schreiben Sie Integrationstests für diesen API-Endpunkt. Decken Sie eine erfolgreiche GET-Anfrage, eine POST-Anfrage mit gültigen Daten, eine Anfrage mit fehlendem Token für die Authentifizierung und eine Anfrage mit ungültigen Daten ab, die einen 400-Fehler zurückgeben sollte. “ |

| Datenvalidierung | „Generieren Sie Tests für diese Validierungsfunktion. Fügen Sie einen Test für ein gültiges Objekt hinzu und fügen Sie dann separate Tests für jede fehlgeschlagene Validierungsregel hinzu, um sicherzustellen, dass die richtigen Fehlermeldungen zurückgegeben werden. “ |

Tipps zur Verbesserung der Eingabeaufforderung:

- Erwähnen Sie das Framework ausdrücklich: Erwähnen Sie immer das Test-Framework (z. B. pytest, Jest, JUnit), um sicherzustellen, dass die Syntax korrekt ist.

- Definieren Sie Ihre Abdeckungsziele: Verwenden Sie fortschrittliche KI-Prompting-Techniken, um bestimmte Arten der Abdeckung anzufordern, z. B. „Randfälle“, „Fehlerbehandlung“ oder „Grenzwerttests“.

- Verwenden Sie Ihre eigenen Muster: Wenn Sie eine gute Beispieldatei haben, können Sie Copilot anweisen, „dem Testmuster in tests/test_user.py zu folgen“.

- Spezifische Assertions anfordern: Anstatt Copilot raten zu lassen, können Sie es auffordern, „zu überprüfen, ob bei ungültigen Eingaben ein ValueError ausgelöst wird”.

📚 Lesen Sie auch: Die besten Quality Assurance-Tools für Softwaretests

Beispiele für die Testgenerierung mit GitHub Copilot

So funktioniert die Arbeit in der Praxis.

Generieren Sie Unit-Tests in Python

Stellen Sie sich vor, Sie haben eine Python-Funktion, die den Gesamtpreis der Elemente in einem Warenkorb einschließlich eines Rabatts berechnet.

Beispiel-Funktion zum Testen:

Verwendete Eingabeaufforderung: „Schreiben Sie pytest-Tests für calculate_total. Berücksichtigen Sie eine leere Liste von Elementen, ein einzelnes Element, mehrere Elemente, die Anwendung eines Rabatts, einen Rabatt von 0 %, einen Rabatt von 100 % und einen ungültigen Rabattprozentsatz, der einen ValueError auslösen sollte. “

Generierte Testausgabe:

Copilot hat pytest. raises korrekt verwendet, um die Ausnahme zu überprüfen, und die wichtigsten Szenarien abgedeckt. Möglicherweise möchten Sie dennoch Tests für negative Preise oder Mengen als manuelle Verfeinerung hinzufügen.

Generieren Sie Unit-Tests in TypeScript mit Jest.

Probieren wir nun eine TypeScript-Funktion aus, die den Namen eines Benutzers in ein Format bringt.

Beispielfunktion zum Testen:

Verwendete Eingabeaufforderung: „Jest-Tests für formatDisplayName generieren. Berücksichtigen Sie einen Benutzer mit Vor- und Nachnamen, einen Benutzer mit einem Spitznamen, einen Benutzer mit einem leeren Vornamen und einen Benutzer, der nur einen Spitznamen hat. “

Generierte Testausgabe:

Die generierten Tests verwenden die Standard-Blöcke „describe“ und „it“ von Jest und verarbeiten die verschiedenen Logikpfade korrekt.

Best Practices für die Testgenerierung mit GitHub Copilot

Die Verwendung von Copilot zur Testgenerierung steigert die Produktivität erheblich, erfordert jedoch eine sorgfältige Überwachung, um die Qualität sicherzustellen.

- Überprüfen Sie jeden einzelnen Test: Das ist die goldene Regel. Copilot versteht Ihre Geschäftslogik nicht, sodass es möglicherweise einen Test generiert, der zwar erfolgreich ist, aber falsche Aussagen trifft. Lesen Sie immer den generierten Code und fragen Sie sich: „Überprüft dies tatsächlich das korrekte Verhalten?“

- Überprüfen Sie die Abdeckung von Randfällen manuell: Copilot ist gut darin, häufige Randfälle wie Null-Eingaben oder leere Zeichenfolgen zu erkennen, aber es kann sein, dass domänenspezifische Fälle übersehen werden. Hat es bei einer E-Commerce-App getestet, was passiert, wenn der Gesamtbetrag eines Warenkorbs genau dem Mindestbetrag für kostenlosen Versand entspricht? Sie sind immer noch der Experte.

- Behalten Sie einheitliche Namenskonventionen bei: Von KI generierte Testnamen können manchmal sehr allgemein sein. Nehmen Sie sich einen Moment Zeit, um sie entsprechend dem Stil Ihres Teams umzubenennen. Ein beschreibender Name wie „test_login_fails_with_incorrect_password” ist weitaus nützlicher als „test_login_2”.

- Führen Sie Tests sofort aus: Lassen Sie generierte Tests nicht unausgeführt. Führen Sie sie sofort aus, um Syntaxfehler oder offensichtlich fehlgeschlagene Assertions zu erkennen, bevor Sie den Code committen.

- Integration mit CI/CD: Fügen Sie generierte Tests zu Ihrer Continuous-Integration-Pipeline hinzu. Tests, die nur lokal ausgeführt werden, bieten nur einen begrenzten Wert.

- Achten Sie auf unzuverlässige Tests: Manchmal kann KI Tests generieren, die „unzuverlässig” sind – sie bestehen manchmal und scheitern manchmal. Dies passiert häufig bei Tests mit Zeitstempeln oder zufälligen Daten. Ersetzen Sie diese immer durch deterministische, vorhersagbare Werte.

📮ClickUp Insight: Unsere Umfragen zeigen, dass zwar 34 % der Benutzer volles Vertrauen in KI-Systeme haben, aber eine etwas größere Gruppe (38 %) einen „Vertrauen, aber überprüfen”-Ansatz verfolgt. Ein eigenständiges tool, das mit Ihrem Arbeitskontext nicht vertraut ist, birgt oft ein höheres Risiko, ungenaue oder unbefriedigende Antworten zu generieren.

Aus diesem Grund haben wir ClickUp Brain entwickelt, die KI, die Ihr Projektmanagement, Wissensmanagement und die Zusammenarbeit in Ihrem Workspace und integrierten Tools von Drittanbietern miteinander verbindet. Erhalten Sie kontextbezogene Antworten ohne Umschalten und steigern Sie Ihre Arbeitseffizienz um das 2- bis 3-fache, genau wie unsere Clients bei Seequent.

Einschränkungen bei der Verwendung von GitHub Copilot zur Generierung von Testfällen

GitHub Copilot ist zwar ein enormer Steigerer der Produktivität, aber kein Allheilmittel für Softwaretests. Um es effektiv zu nutzen und häufige Fallstricke zu vermeiden, ist es wichtig, seine Limite zu kennen. Es ist ein „Copilot“, kein Pilot – Sie sind weiterhin für den Plan verantwortlich.

Die größte Einschränkung ist das Fehlen eines geschäftlichen Kontexts. Copilot analysiert die Struktur Ihres Codes, hat jedoch keine Ahnung, was Ihre Anwendung tatsächlich für Ihre Benutzer zu erledigen hat. Es kann nicht wissen, dass ein „Premium”-Benutzer Zugriff auf bestimmte Features haben sollte, während ein „Basis”-Benutzer dies nicht sollte, es sei denn, diese Logik ist in dem Code, den es liest, eindeutig klar.

Hier sind einige weitere Schlüssel-Einschränkungen, die Sie beachten sollten:

- Es können kritische, domänenspezifische Randfälle übersehen werden: Copilot ist hervorragend darin, allgemeine Randfälle zu finden, kennt jedoch keine seltsamen Fälle, die für Ihre Branche spezifisch sind, wie beispielsweise eine Finanzberechnung, bei der Schaltjahre anders behandelt werden müssen.

- Es hat keinen Zugriff auf externe Systeme: Copilot kann keine aussagekräftigen Integrationstests für Ihre Datenbank oder eine API eines Drittanbieters generieren, da es keine Verbindung zu diesen herstellen kann. Es kann den Code erstellen, aber Sie müssen die Details selbst ergänzen.

- Es kann ein falsches Gefühl der Sicherheit vermitteln: Eine Testabdeckung von 100 % zu sehen, kann ein gutes Gefühl sein, aber wenn die Tests falsche Aussagen treffen, ist diese Abdeckungszahl bedeutungslos. Deshalb ist die Überprüfung durch Menschen so wichtig.

- Limit des Kontextfensters: Sehr große Dateien oder komplexe Klassenhierarchien können das Kontextfenster von Copilot überschreiten, was das Ergebnis unvollständiger oder allgemeiner Vorschläge sein kann.

📚 Lesen Sie auch: So verwenden Sie GitHub Copilot für die Backend-Entwicklung

So erstellen und verwalten Sie Testfälle in ClickUp

Die Generierung von Testfällen mit GitHub Copilot ist nur die Hälfte des Workflows. Sobald Tests vorhanden sind, müssen Teams diese weiterhin verfolgen, mit den Anforderungen verknüpfen und die Ausführung über Sprints und Releases hinweg verwalten.

ClickUp bietet einen zentralen Workspace, in dem KI-generierte Testfälle neben Entwicklungsaufgaben, Bugs und Sprint-Plänen gespeichert werden können – so bleiben Tests nicht in einzelnen IDEs gefangen.

ClickUp fungiert als konvergierter KI-Workspace, der Projektmanagement, Dokumentation und Teamkommunikation in einem System vereint. Für Softwareteams bedeutet dies, dass das Testfallmanagement nicht mehr mit einem separaten Tool oder einer separaten Tabelle durchgeführt werden muss.

Tests, Anforderungen, Pull Requests und Release-Diskussionen bleiben miteinander verbunden, wodurch Kontextverwirrung reduziert wird und die Qualitätssicherung zu einem wichtigen Bestandteil des Workflows zur Lieferung wird.

Die Testfall-Vorlage von ClickUp wurde entwickelt, um Ihnen zu helfen, den Fortschritt von Testfällen zu verfolgen. Damit ist es ganz einfach:

- Überprüfen Sie Ergebnisse der Tests und treffen Sie datengestützte Entscheidungen zur Fehlerbehebung.

- Entwickeln Sie benutzerdefinierte Testpläne für jedes Projekt.

- Organisieren und priorisieren Sie Testfälle für maximale Effizienz.

Erstellen Sie zunächst eine spezielle ClickUp-Liste, die als Repository für Ihre Testfälle dient. Jeder Testfall, egal ob er von einer KI generiert oder manuell geschrieben wurde, wird zu einer Aufgabe.

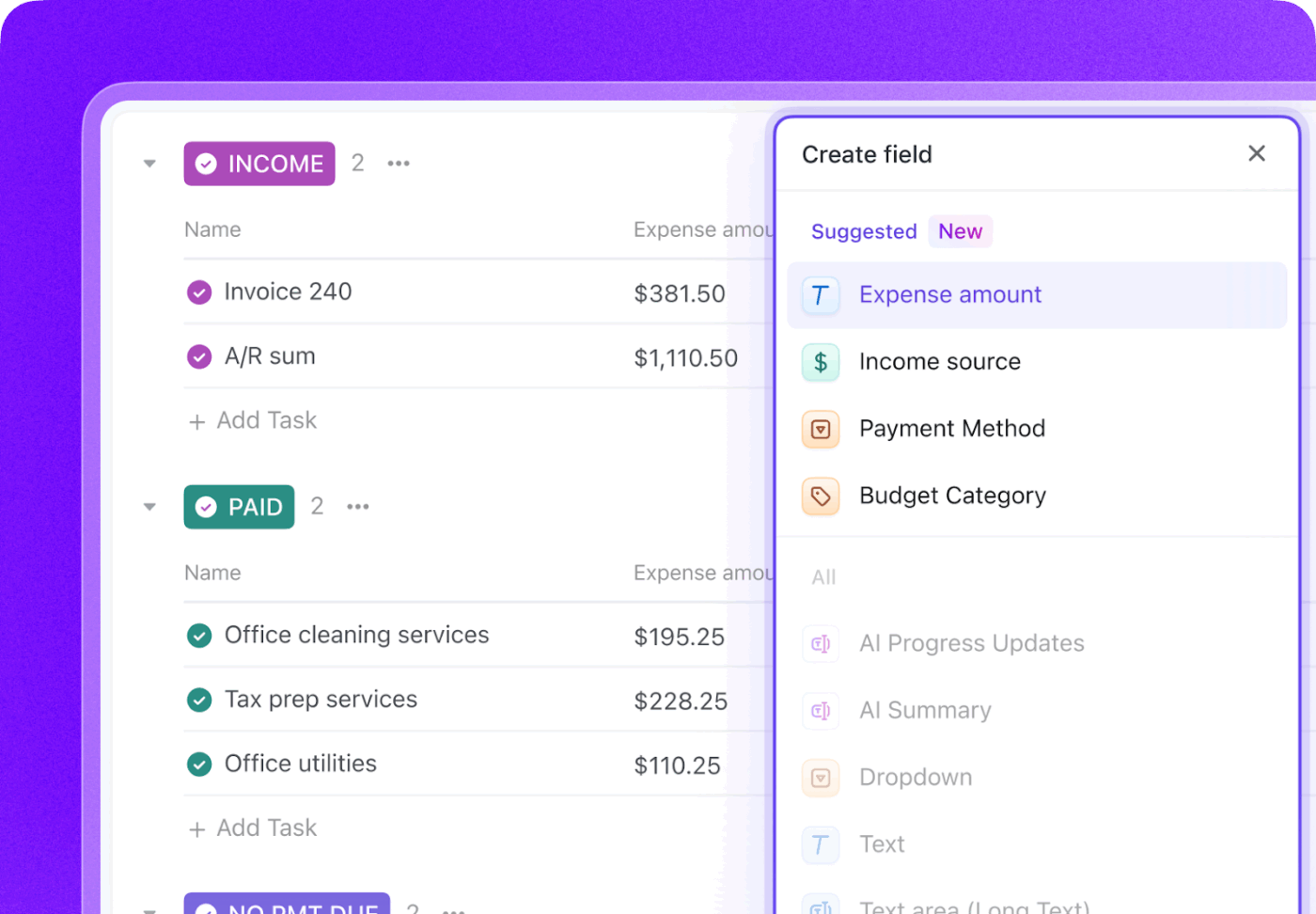

Erweitern Sie jeden Testfall mit wichtigen Metadaten mithilfe der benutzerdefinierten Felder von ClickUp, um genau die Nachverfolgung durchzuführen, die für Ihr Team wichtig ist.

- Testtyp: Ausklappbares Menü für Unit-, Integrations-, End-to-End- oder manuelle Tests

- Status der Automatisierung: Ein Status, der angibt, ob der Test automatisiert ist oder nicht.

- Priorität: Hoch, Mittel oder Niedrig

- Letztes Ausführungsdatum: Ein Feld für das Datum, um die Nachverfolgung zu ermöglichen, wann der Test zuletzt ausgeführt wurde.

Verfolgen Sie Ihren gesamten Testlebenszyklus mit ClickUp benutzerdefinierten Statussen, indem Sie einen Workflow erstellen, der Tests von „Nicht ausgeführt“ zu „Bestanden“, „Nicht bestanden“ oder „Blockiert“ verschiebt. So erhalten alle Teammitglieder, von Entwicklern bis hin zu Produktmanagern, sofortige Sichtbarkeit zum Fortschritt der Testausführung.

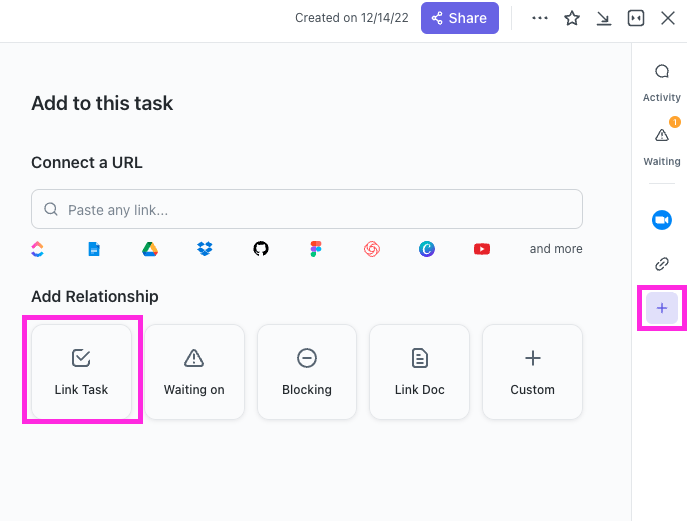

Mit ClickUp Beziehungen können Testfallaufgaben direkt mit User Stories, Features oder Epics verknüpft werden. Wenn ein Test fehlschlägt, können Sie eine Bug-Report-Aufgabe erstellen und diese sowohl mit dem fehlgeschlagenen Test als auch mit der ursprünglichen Story verknüpfen, wodurch eine lückenlose Rückverfolgbarkeitskette entsteht.

Erstellen Sie Bug-Reports in Sekundenschnelle, indem Sie ClickUp Brain auf eine fehlgeschlagene Testfallaufgabe verweisen. Da es über den Kontext Ihres gesamten Workspaces verfügt, kann es Details aus der verknüpften User Story und dem Testfall selbst abrufen.

🌟 Die Testbericht-Vorlage von ClickUp ermöglicht es Ihnen, Berichte schneller zu erstellen und gleichzeitig sicherzustellen, dass Sie Probleme identifizieren und beheben, die verbessert werden müssen.

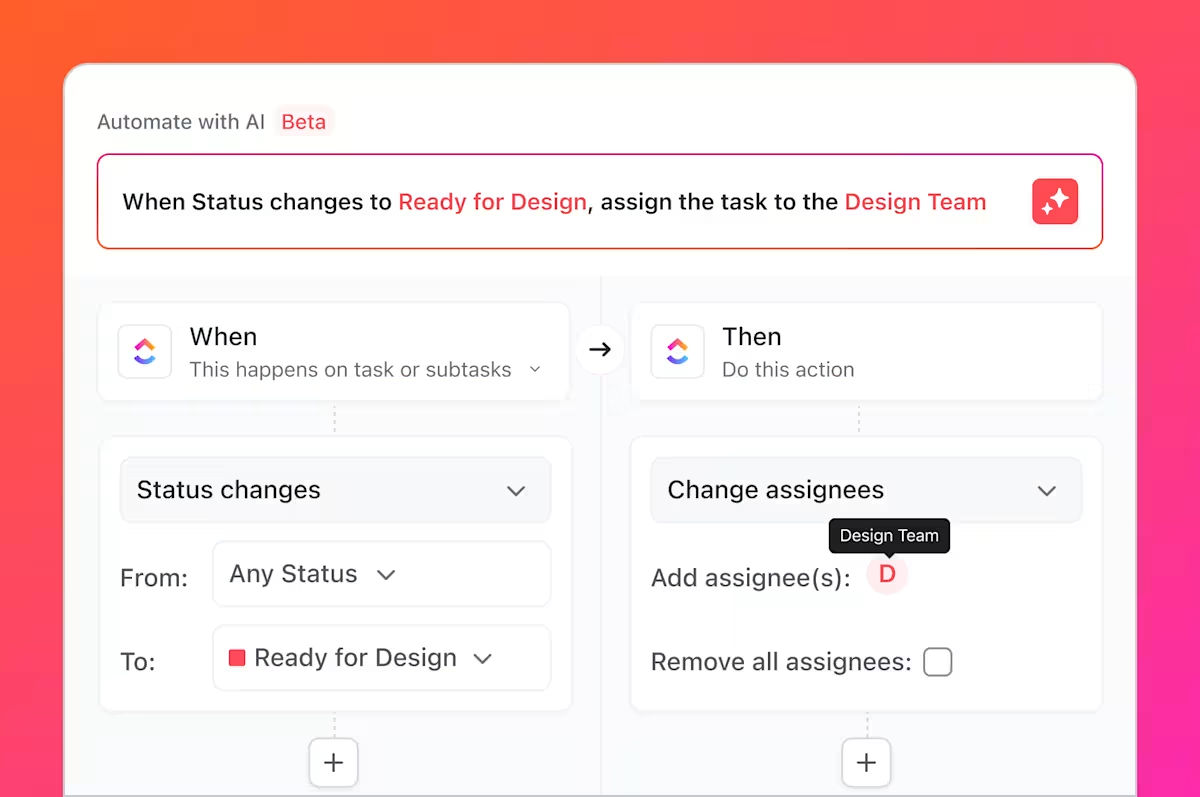

Aber das ist noch nicht alles, was Sie tun können. Sie kennen doch all die Routinearbeiten, über die wir gesprochen haben, die langweiligen und sich wiederholenden Aufgaben, die mit dem Testen immer verbunden sind? Diese können Sie mit ClickUp Automatisierungen automatisieren.

Richten Sie Regeln ein wie „Wenn der Status eines Testfalls auf „Fehlgeschlagen“ geändert wird, erstellen Sie automatisch eine neue Aufgabe in der Liste der Fehler und weisen Sie diese dem leitenden Entwickler zu. “

Durch die Integration von GitHub mit ClickUp können Testfallaufgaben mit Commits und Pull Requests verknüpft werden. Wenn Codeänderungen zusammengeführt werden, werden die zugehörigen Testaufgaben automatisch aktualisiert, sodass QA, Entwickler und Release-Manager immer auf dem Laufenden sind, was geändert wurde und was erneut getestet werden muss.

Mit ClickUp Dashboards können Sie den Testfortschritt in Echtzeit verfolgen, die Anzahl der Fehler visualisieren, die Ausführung von Testfällen anzeigen und vieles mehr.

Zusammen überbrückt dieser Workflow die Lücke zwischen KI-generierten Tests in GitHub Copilot und teamweitem Testfallmanagement in ClickUp – und bietet Teams ein einziges System zur Planung, Nachverfolgung, Automatisierung und Verbesserung ihres QA-Prozesses, ohne dass eine ständige manuelle Koordination erforderlich ist.

Sehen Sie sich dieses Video an, um Tipps zum Aufbau eines effizienten Release-Management-Workflows zu erhalten:

Vereinfachen Sie das Testfallmanagement mit ClickUp

KI-generierte Tests sind keine isolierten Artefakte mehr, sondern integrierte Komponenten Ihres Entwicklungsprozesses, die für das gesamte Team sichtbar, nachverfolgbar und umsetzbar sind.

GitHub Copilot generiert Testfälle schnell, aber Geschwindigkeit allein garantiert noch keine Qualität. Ohne klare Eigentümerschaft, Rückverfolgbarkeit der Anforderungen und Sichtbarkeit über alle Sprints hinweg können selbst gut geschriebene Tests veralten oder übersehen werden. Hier kommt ein Aufzeichnungssystem ins Spiel.

Durch die Verwaltung von Testfällen in ClickUp verwandeln Teams die von KI generierten Ergebnisse in einen wiederholbaren QA-Workflow, der Tests mit Anforderungen, Codeänderungen und Release-Zeitplänen verknüpft. Anstatt mit verschiedenen Tools und manuellen Updates zu jonglieren, arbeiten QA- und Engineering-Teams in einem gemeinsamen, kontextbezogenen Workspace. Das Ergebnis sind nicht nur mehr Tests, sondern auch mehr Vertrauen in das, was ausgeliefert wird, und warum.

Sind Sie bereit, Ihre Testfälle parallel zu Ihren Sprints und Releases zu verwalten? Starten Sie noch heute kostenlos mit ClickUp.

Häufig gestellte Fragen

Ja, Copilot kann die Struktur und Logik von Legacy-Code analysieren, um eine Test-Baseline zu generieren. Diese Tests erfordern jedoch wahrscheinlich eine umfangreiche manuelle Überprüfung und Verfeinerung, da die KI keinen Kontext zu undokumentierten Verhaltensweisen oder historischen Geschäftsregeln hat.

Die syntaktische Genauigkeit ist sehr hoch, aber die logische Genauigkeit hängt von der Klarheit Ihres Codes und der Spezifität Ihrer Eingabeaufforderungen ab. Überprüfen Sie immer die Assertions, um sicherzustellen, dass sie aussagekräftige Geschäftsanforderungen überprüfen und nicht nur die aktuelle (und möglicherweise fehlerhafte) Implementierung bestätigen.

Ja, Copilot unterstützt pytest, unittest und andere beliebte Python-Testframeworks hervorragend. Es ist in der Lage, vorhandene Muster in Ihrem Projekt zu erkennen und zu replizieren, beispielsweise die Verwendung von Fixtures oder parametrisierten Tests.

Effektive Teams verwenden eine zentralisierte Projektmanagement-Plattform, um ihre Testsuiten zu verwalten. Indem sie jeden Testfall als Aufgabe mit benutzerdefinierten Metadaten für Status und Priorität verfolgen, erhalten sie Sichtbarkeit in Bezug auf die Abdeckung und die Ausführungsergebnisse und verbinden den QA-Prozess direkt mit der Sprint-Planung und der Fehlerverfolgung.