Die meisten Teams im Unternehmen, die sich mit LLaMA beschäftigen, kommen an derselben Stelle nicht weiter: Sie laden die Modellgewichte herunter, starren auf ein Terminalfenster und stellen fest, dass sie keine Ahnung haben, wie es weitergeht.

Diese Herausforderung ist weit verbreitet: Während 88 % der Unternehmen KI in mindestens einer Funktion einsetzen, haben nur 7 % sie unternehmensweit skaliert.

Diese Anleitung führt Sie durch den gesamten Prozess, von der Auswahl der richtigen Größe des Modells für Ihren Anwendungsfall bis hin zur Feinabstimmung anhand der Daten Ihres Unternehmens, sodass Sie eine funktionierende KI-Lösung bereitstellen können, die Ihren Geschäftskontext tatsächlich versteht.

Was ist LLaMA und warum ist es für Enterprise-KI wichtig?

LLaMA (kurz für Large Language Model Meta /AI) ist eine Familie von offenen Sprachmodellen, die von Meta entwickelt wurde. Im Großen und Ganzen erfüllt es dieselben Kernfunktionen wie Modelle wie GPT oder Gemini: Es versteht Sprache, generiert Text und kann Informationen verarbeiten. Der große Unterschied besteht darin, wie Unternehmen es nutzen können.

Da LLaMA offen zugänglich ist, sind Unternehmen nicht gezwungen, nur über eine Black-Box-API mit ihm zu interagieren. Sie können es auf ihrer eigenen Infrastruktur ausführen, anhand interner Daten optimieren und kontrollieren, wie und wo es eingesetzt wird.

Für Unternehmen ist das ein großer Vorteil – insbesondere wenn Datenschutz, Compliance und Kostenvorhersagbarkeit wichtiger sind als Neuheit.

Diese Flexibilität macht LLaMA besonders attraktiv für Teams, die KI tief in ihre Workflows integrieren möchten und nicht nur als eigenständigen Chatbot einsetzen wollen. Denken Sie an interne Wissensassistenten, die Automatisierung des Kundensupports, Entwicklertools oder KI-Features, die direkt in Produkte integriert sind – ohne dass sensible Daten außerhalb des Unternehmens gesendet werden müssen.

Kurz gesagt: LLaMA ist für KI im Unternehmen wichtig, weil es Teams die Wahl zwischen Bereitstellung, benutzerdefinierter Anpassung und KI-Integration in reale Geschäftssysteme lässt. Und da KI sich vom Experimentierstadium zum alltäglichen Einsatz entwickelt, wird dieses Maß an Kontrolle weniger zu einem „Nice-to-have“ als vielmehr zu einer Notwendigkeit.

Erste Schritte mit LLaMA für Anwendungen im Unternehmen

1. Definieren Sie Ihren Anwendungsfall für Ihr Unternehmen.

Bevor Sie etwas herunterladen, sollten Sie genau festlegen, in welchen Workflows KI einen echten Unterschied machen kann. Es ist wichtig, den KI-Anwendungsfall auf die Größe des Modells abzustimmen – kleinere 8B-Modelle sind für einfache Aufgaben effizient, während größere 70B+-Modelle besser für komplexe Schlussfolgerungen geeignet sind.

Um Ihnen dabei zu helfen, die richtigen KI-Anwendungen für Ihr Geschäft zu finden, sehen Sie sich diese Übersicht über praktische KI-Anwendungsfälle in verschiedenen Funktionen des Unternehmens und Branchen an:

Gängige Ausgangspunkte sind:

- Dokumentenverarbeitung: Zusammenfassen langer Berichte oder Extrahieren wichtiger Informationen aus Verträgen

- Code-Unterstützung: Generieren von Boilerplate-Code, Erläutern von Legacy-Systemen oder Vorschlagen von Optimierungen

- Wissensabruf: Beantwortung von Mitarbeiterfragen durch Suche in internen Dokumentationen mithilfe einer Technik namens Retrieval-Augmented Generation (RAG)

- Inhalt: Entwerfen von ersten Entwürfen für Kommunikations- oder Marketingtexte

2. Voraussetzungen und Abhängigkeiten einrichten

Als Nächstes müssen Sie Ihre Hardware und Software in der richtigen Reihenfolge vorbereiten. Die Größe des Modells bestimmt Ihren Bedarf: Ein LLaMA 8B-Modell erfordert eine GPU mit etwa 15 GB VRAM, während ein 70B-Modell 131 GB oder mehr benötigt.

Ihr Software-Stack sollte Python 3. 8+, PyTorch, CUDA-Treiber und das Hugging Face-Ökosystem (Transformers, Accelerate und Bitsandbytes) umfassen.

3. Zugriff auf und Herunterladen der LLaMA-Modellgewichte

Die Modellgewichte können Sie von der offiziellen Llama-Downloadseite von Meta oder dem Hugging Face Model Hub herunterladen. Sie müssen die Llama 3 Community License akzeptieren, die eine kommerzielle Nutzung erlaubt. Je nach Ihrem Setup laden Sie die Gewichte entweder im Safetensors- oder im GGUF-Format herunter.

4. Konfigurieren Sie Ihre Entwicklungsumgebung

Nachdem Sie die Gewichte heruntergeladen haben, ist es an der Zeit, Ihre Umgebung einzurichten. Installieren Sie die erforderlichen Python-Bibliotheken, darunter Transformers, Accelerate und Bitsandbytes für die Quantisierung – ein Prozess, der den Speicherbedarf des Modells reduziert.

Laden Sie das Modell mit den richtigen Einstellungen und führen Sie einen einfachen Test durch, um sicherzustellen, dass alles korrekt funktioniert, bevor Sie mit der benutzerdefinierten Anpassung fortfahren.

💡Wenn Sie kein spezielles ML-Infrastrukturteam haben, kann dieser gesamte Prozess zum Scheitern verurteilt sein. Mit ClickUp Brain können Sie die Komplexität der Bereitstellung komplett umgehen. Es bietet KI-Funktionen wie Schreibunterstützung und Automatisierung von Aufgaben direkt in dem Arbeitsbereich, in dem Ihr Team bereits arbeitet – ohne dass Modelle heruntergeladen oder GPUs bereitgestellt werden müssen.

So passen Sie LLaMA benutzerdefiniert für Ihre Unternehmensdaten an

Die Verwendung eines LLaMA-Basismodells ist ein guter Anfang, aber es versteht die spezifischen Abkürzungen, Projektnamen oder internen Prozesse Ihres Unternehmens nicht. Dies führt zu allgemeinen, wenig hilfreichen Antworten, die echte Geschäftsprobleme nicht lösen können.

Enterprise-KI wird durch benutzerdefinierte Anpassung nützlich – indem das Modell mit Ihrer spezifischen Terminologie und Wissensbasis trainiert wird.

Bereiten Sie Ihre domänenspezifischen Trainingsdaten vor

Der Erfolg Ihrer benutzerdefinierten KI hängt mehr von der Qualität Ihrer Trainingsdaten als von der Größe des Modells oder der Rechenleistung ab. Beginnen Sie mit dem Sammeln und Bereinigen Ihrer internen Informationen.

- Interne Dokumentation: Sammeln Sie Produktspezifikationen, Prozessanleitungen und Richtliniendokumente.

- Historische Kommunikation: Sammeln Sie E-Mail-Vorlagen, Support-Ticket-Antworten und Zusammenfassungen der Meetings.

- Fachterminologie: Stellen Sie Glossare, Abkürzungsdefinitionen und branchenspezifische Sprache zusammen.

Formatieren Sie diese Informationen nach dem Sammeln in Anweisungs-Antwort-Paare für die überwachte Feinabstimmung. Eine Anweisung könnte beispielsweise lauten: „Fassen Sie dieses Support-Ticket zusammen“, und die Antwort wäre eine klare, prägnante Zusammenfassung. Dieser Schritt ist entscheidend, um dem Modell beizubringen, wie es bestimmte Aufgaben mit Ihren Daten ausführen soll.

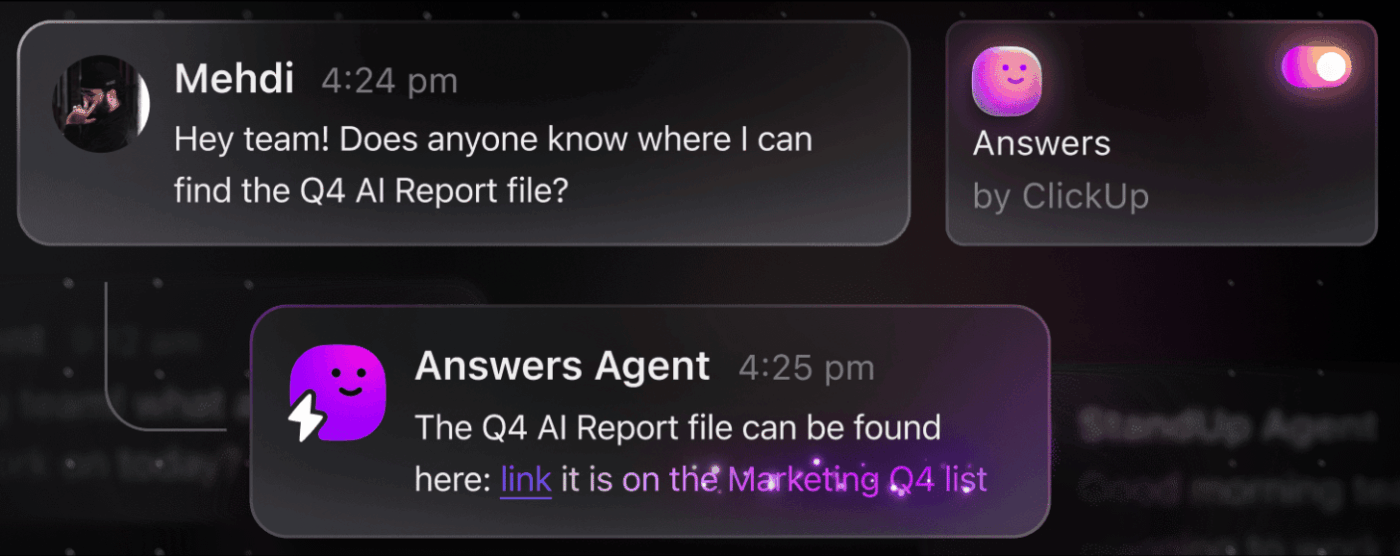

📮 ClickUp Insight: Der durchschnittliche Berufstätige verbringt täglich mehr als 30 Minuten mit der Suche nach arbeitsbezogenen Informationen – das sind über 120 Stunden pro Jahr, die durch das Durchsuchen von E-Mails, Slack-Threads und verstreuten Dateien verloren gehen. Ein intelligenter KI-Assistent, der in Ihren Workspace integriert ist, kann das ändern.

Hier kommt ClickUp Brain ins Spiel. Es liefert sofortige Einblicke und Antworten, indem es innerhalb von Sekunden die richtigen Dokumente, Unterhaltungen und Details zu Aufgaben anzeigt – so können Sie mit der Suche aufhören und mit der Arbeit beginnen.

💫 Echte Ergebnisse: Teams wie QubicaAMF haben durch die Abschaffung veralteter Wissensmanagementprozesse mit ClickUp mehr als 5 Stunden pro Woche eingespart – das sind über 250 Stunden pro Person und Jahr. Stellen Sie sich vor, was Ihr Team mit einer zusätzlichen Woche Produktivität pro Quartal alles schaffen könnte!

Optimieren Sie LLaMA für Ihren geschäftlichen Kontext

Die Feinabstimmung ist der Prozess der Anpassung des vorhandenen Wissens von LLaMA an Ihren spezifischen Anwendungsfall, wodurch die Genauigkeit bei domänenspezifischen Aufgaben erheblich verbessert wird. Anstatt ein Modell von Grund auf neu zu trainieren, können Sie parametereffiziente Methoden verwenden, die nur einen kleinen Teil der Modellparameter aktualisieren, wodurch Sie Zeit und Rechenressourcen sparen.

Zu den beliebten Feinabstimmungsmethoden gehören:

- LoRA (Low-Rank Adaptation): Bei dieser Methode werden kleine „Adapter”-Matrixen anstelle des gesamten Modells trainiert, was sie sehr effizient macht.

- QLoRA: Hier wird LoRA mit Quantisierung kombiniert, um die Feinabstimmung auf einer einzigen 48-GB-GPU zu ermöglichen und gleichzeitig die volle Feinabstimmungsleistung zu erzielen.

- Vollständige Feinabstimmung: Dabei werden alle Parameter des Modells aktualisiert, was ein Höchstmaß an benutzerdefinierter Anpassung ermöglicht, jedoch erhebliche Rechenleistung erfordert.

📚 Lesen Sie auch: Enterprise Generative KI-Tools, die die Arbeit verändern

Bewerten und iterieren Sie die Modellleistung.

Woher wissen Sie, ob Ihr benutzerdefiniertes Modell tatsächlich funktioniert? Die KI-Bewertung muss über einfache Genauigkeitswerte hinausgehen und die tatsächliche Nützlichkeit messen. Erstellen Sie Bewertungsdatensätze, die Ihre Produktionsanwendungsfälle widerspiegeln, und verfolgen Sie Metriken, die für Ihr Geschäft wichtig sind, wie Antwortqualität, sachliche Genauigkeit und Latenz.

- Qualitative Bewertung: Lassen Sie menschliche Prüfer die Ergebnisse hinsichtlich Tonfall, Nützlichkeit und Korrektheit bewerten.

- Quantitative Metriken: Verwenden Sie automatisierte Bewertungen wie BLEU oder Perplexity, um die Nachverfolgung der Leistung in großem Maßstab durchzuführen.

- Produktionsüberwachung: Nach der Bereitstellung erfolgt die Nachverfolgung des Feedbacks der Benutzer und der Fehlerquoten, um Verbesserungsmöglichkeiten zu identifizieren.

💡Dieser iterative Prozess aus Training und Bewertung kann zu einem eigenständigen Projekt werden. Verwalten Sie Ihren KI-Entwicklungszyklus direkt in ClickUp, anstatt sich in Tabellen zu verlieren.

Zentralisieren Sie Metriken und Bewertungsergebnisse in einer Ansicht mit ClickUp Dashboards. Verfolgen Sie Modellversionen, Trainingsparameter und Bewertungsergebnisse direkt neben Ihren anderen Produktarbeiten mit ClickUp Benutzerdefinierten Feldern, damit alles organisiert und sichtbar bleibt. 🛠️

Die wichtigsten Anwendungsfälle für LLaMA in Enterprise-Unternehmen

Teams geraten oft in eine Analyseparalyse und sind nicht in der Lage, von der abstrakten Begeisterung für KI zu konkreten Anwendungen überzugehen. Dank seiner Flexibilität eignet sich LLaMA für einen breiten Bereich von Enterprise-Workflows und hilft Ihnen bei der Automatisierung von Aufgaben und bei der Steigerung Ihrer Effizienz.

Hier sind einige der wichtigsten Anwendungsfälle für ein benutzerdefiniertes LLaMA-Modell:

- Interne Wissensassistenten: Verschwenden Sie keine Zeit mehr mit der Suche nach Informationen. Setzen Sie LLaMA mit RAG ein, um einen Chatbot zu erstellen, der Fragen von Mitarbeitern sofort beantworten kann, indem er Ihre internen Wikis, Richtliniendokumente und frühere Projektkommunikationen durchsucht.

- Automatisierung des Kundensupports: Optimieren Sie ein Modell anhand Ihrer Ticket-Historie, um automatisch Antworten zu entwerfen, Anfragen zu kategorisieren und komplexe Probleme an den richtigen Mitarbeiter weiterzuleiten.

- Codegenerierung und -überprüfung: Helfen Sie Ihrem Entwicklerteam, effizienter zu arbeiten. Verwenden Sie LLaMA, um Boilerplate-Code zu generieren, komplexe Legacy-Systeme zu erklären und sogar potenzielle Fehler in Pull Requests zu identifizieren, bevor sie zu Problemen werden.

- Dokumentenverarbeitung: Verwandeln Sie große Textmengen in nützliche Informationen. Fassen Sie lange Berichte zusammen, extrahieren Sie Schlüsselbegriffe aus Verträgen oder erstellen Sie in Sekundenschnelle prägnante Notizen zu Meetings aus Rohtranskripten.

- Workflows zur Erstellung von Inhalten: Überwinden Sie Schreibblockaden. Entwerfen Sie Marketingtexte, Produktbeschreibungen und interne Ankündigungen, die Ihre menschlichen Editors anschließend verfeinern und perfektionieren können.

💡Mit ClickUp Brain können Sie viele dieser Anwendungsfälle sofort nutzen.

- Fassen Sie Aufgaben-Threads zusammen, entwerfen Sie Projekt-Updates und generieren Sie Inhalte mit der KI-gestützten Schreibhilfe von ClickUp AI.

- Finden Sie mit ClickUps Enterprise Search und dem vorgefertigten Ambient Answers -Agenten sofort Antworten aus Ihrem gesamten ClickUp-Workspace.

- Erstellen Sie mit ClickUp Automatisierungen intelligente Workflows, die Routineaufgaben für Sie übernehmen.

Einschränkungen bei der Verwendung von LLaMA für Enterprise-KI

Die Selbsthosting von LLaMA bietet zwar erhebliche Kontrollmöglichkeiten, ist jedoch nicht ohne Herausforderungen. Teams unterschätzen oft den betrieblichen Aufwand und verzetteln sich in der Wartung, anstatt sich auf Innovationen zu konzentrieren. Bevor Sie sich für den „Build”-Pfad entscheiden, ist es wichtig, die potenziellen Hürden zu verstehen.

Hier sind einige der wichtigsten Limite, die es zu beachten gilt:

- Infrastrukturanforderungen: Die Ausführung großer Modelle ist kostspielig und erfordert leistungsstarke GPUs der Enterprise-Klasse, über die viele Unternehmen nicht verfügen.

- Erforderliche technische Kenntnisse: Die Bereitstellung, Feinabstimmung und Wartung eines großen Sprachmodells erfordert spezielle ML-Engineering-Kenntnisse, die sehr gefragt sind.

- Laufender Wartungsaufwand: Dies ist keine Lösung, die Sie einmal einrichten und dann vergessen können. Modelle müssen ständig überwacht, mit Updates zur Sicherheit versehen und neu trainiert werden, wenn sich Ihr Geschäft weiterentwickelt.

- Risiko von Halluzinationen: Wie alle LLMs kann auch LLaMA manchmal plausibel klingende, aber falsche Informationen generieren. Anwendungen im Unternehmen erfordern robuste Sicherheitsvorkehrungen und menschliche Aufsicht, um dieses Risiko zu mindern.

- Keine integrierten Features des Unternehmens: Wichtige Features wie Zugriffskontrolle, Audit-Protokollierung und Compliance-Tools müssen separat erstellt und verwaltet werden, was die Komplexität zusätzlich erhöht.

💡Mit ClickUp Brain können Sie diese Einschränkungen umgehen. Es bietet verwaltete KI innerhalb Ihres bestehenden Arbeitsbereichs und versorgt Sie mit KI-Funktionen für Unternehmen ohne zusätzlichen Betriebsaufwand. Mit ClickUp profitieren Sie von Sicherheit auf Unternehmensniveau und müssen sich nicht mehr um die Wartung der Infrastruktur kümmern, sodass sich Ihr Team ganz auf seine Kernaufgaben konzentrieren kann.

📮ClickUp Insight: 88 % unserer Umfrageteilnehmer nutzen KI für ihre persönlichen Aufgaben, doch über 50 % scheuen sich, sie bei der Arbeit einzusetzen. Die drei größten Hindernisse? Mangelnde nahtlose Integration, Wissenslücken oder Bedenken hinsichtlich der Sicherheit.

Was aber, wenn KI in Ihrem Workspace integriert und bereits sicher ist? ClickUp Brain, der integrierte KI-Assistent von ClickUp, macht dies möglich. Er versteht Eingaben in einfacher Sprache und löst damit alle drei Probleme bei der Einführung von KI, während er Ihren Chat, Ihre Aufgaben, Dokumente und Ihr Wissen im gesamten Workspace miteinander verbindet. Finden Sie Antworten und Erkenntnisse mit einem einzigen Klick!

Alternative KI-Tools für Anwendungsfälle in Unternehmen

Die Auswahl des richtigen KI-Tools aus den vielen verfügbaren Optionen ist für jedes Team eine Herausforderung. Sie versuchen, die Vor- und Nachteile der verschiedenen Modelle abzuwägen, befürchten jedoch, das falsche auszuwählen und Ressourcen zu verschwenden.

Dies führt häufig zu einer unkontrollierten Verbreitung von KI -Tools und -Plattformen ohne Aufsicht oder Strategie, bei der Teams mehrere unverbundene Dienste abonnieren, was zu mehr statt weniger Arbeit führt.

Hier finden Sie eine kurze Übersicht über die wichtigsten Akteure und ihre jeweiligen Aufgabenbereiche:

| Tool | Am besten geeignet für | Wichtige Überlegungen |

|---|---|---|

| LLaMA (selbst gehostet) | Maximale Kontrolle, Datenhoheit | Erfordert ML-Infrastruktur und Fachwissen. |

| OpenAI GPT-4 | Höchste Leistungsfähigkeit, minimales Setup | Daten verlassen Ihre Umgebung, nutzungsbasierte Preisgestaltung |

| Claude (Anthropic) | Aufgaben mit langem Kontext, Fokus auf Sicherheit | Ähnliche Kompromisse wie bei GPT-4 |

| Mistral | Europäische Datenresidenz, Effizienz | Kleineres Ökosystem als LLaMA |

| ClickUp Brain | Integrierte KI für den Workspace, keine Bereitstellung erforderlich | Ideal für Teams, die KI in bestehende Workflows integrieren möchten. |

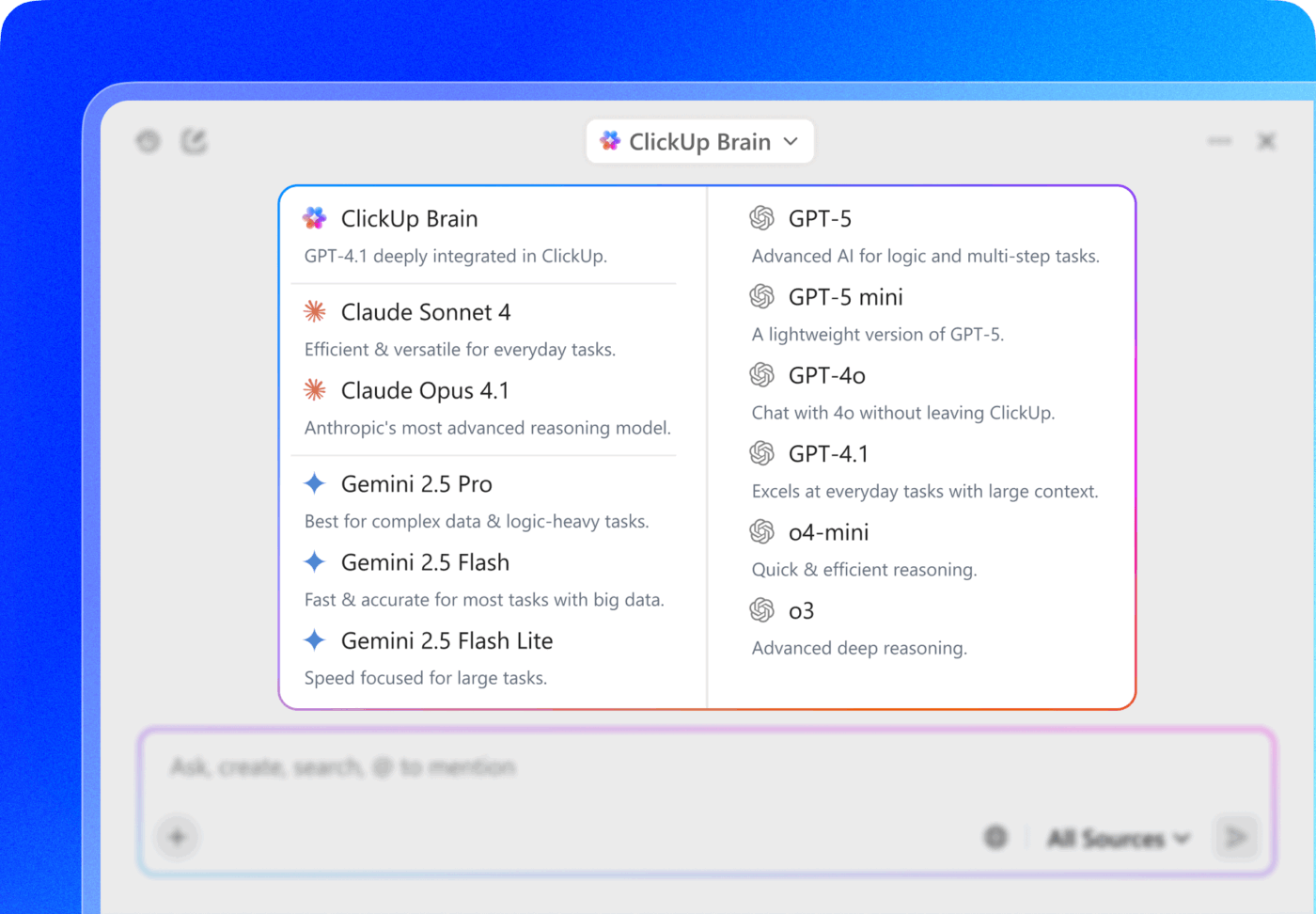

Anstatt mehrere Tools miteinander zu verbinden, um Ihre Anforderungen zu erfüllen, können Sie direkt dort auf KI zugreifen, wo Sie arbeiten. Das ist der Kern dessen, was ClickUp als weltweit erster konvergierter KI-Workspace bietet – eine einzige, sichere Plattform, auf der Projekte, Dokumente, Unterhaltungen und Analysen zusammengeführt werden.

Es vereint Ihre tools, um Kontextzerstreuung zu vermeiden, also die Fragmentierung, die entsteht, wenn Teams Stunden damit verschwenden, zwischen Apps zu wechseln und nach den Informationen zu suchen, die sie für die Aufgaben zu erledigen haben, benötigen.

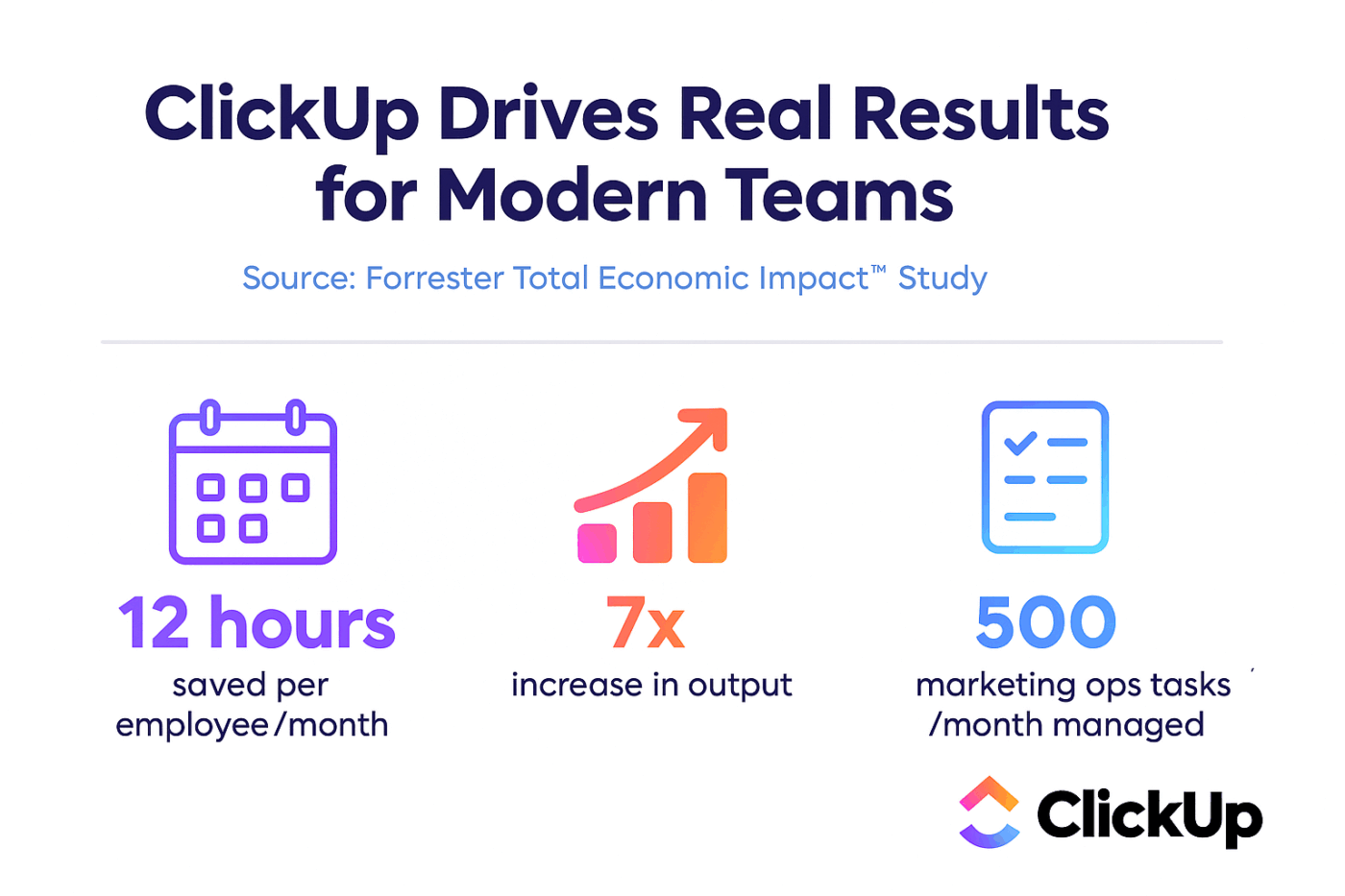

ClickUp + kontextbezogene KI = messbare Transformation

Laut einer Studie von Forrester Economic Impact™ erzielten Teams, die ClickUp einsetzten, einen ROI von 384 % und sparten bis zum dritten Jahr 92.400 Stunden ein.

Wenn Kontext, Workflows und Intelligenz an einem Ort vereint sind, arbeiten Teams nicht nur. Sie sind erfolgreich.

ClickUp bietet außerdem die Funktionen zur Sicherheit und Verwaltung, die für Bereitstellungen im Unternehmen erforderlich sind, darunter SOC 2 Typ II-Konformität, SSO-Integration, SCIM-Bereitstellung und detaillierte Berechtigungskontrollen.

Mit dem Multi-LLM-Zugang von ClickUp Brain MAX können Sie direkt über die Suchoberfläche zwischen Premium-Modellen wie ChatGPT, Claude und Gemini wählen. Die Plattform leitet Ihre Abfrage automatisch an das für die Aufgabe am besten geeignete Modell weiter, sodass Sie das Beste aus allen Welten erhalten, ohne mehrere Abonnements verwalten zu müssen.

Holen Sie sich mit ClickUp den gesamten Stack – KI-Funktionen, Projektmanagement, Dokumentation und Kommunikation – aus einer Hand, anstatt die KI-Ebene mit LLaMA von Grund auf neu aufzubauen.

Mit ClickUp vorankommen mit KI für Unternehmen

LLaMA bietet Unternehmen Teams eine offene Alternative zu geschlossenen KI-APIs und ermöglicht ihnen ein hohes Maß an Kontrolle, Kostenvorhersagbarkeit und benutzerdefinierte Anpassungsmöglichkeiten. Der Erfolg hängt jedoch nicht nur von der Technologie ab. Es ist erforderlich, das richtige Modell für den richtigen Anwendungsfall auszuwählen, in hochwertige Trainingsdaten zu investieren und robuste Bewertungsprozesse zu entwickeln.

Die Entscheidung „selbst entwickeln oder kaufen“ hängt letztendlich von der technischen Kapazität Ihres Teams ab. Die Entwicklung einer benutzerdefinierten Lösung bietet zwar maximale Flexibilität, ist jedoch auch mit erheblichen Gemeinkosten verbunden. Die eigentliche Herausforderung besteht nicht nur darin, Zugang zu KI zu erhalten, sondern diese in Ihre täglichen Workflows zu integrieren, ohne weitere KI-Silos und Datensilos zu schaffen.

Integrieren Sie LLM-Funktionen mit ClickUp Brain direkt in Ihr Projektmanagement, Ihre Dokumentation und Ihre Teamkommunikation – ohne die Komplexität des Aufbaus und der Wartung einer Infrastruktur. Starten Sie kostenlos mit ClickUp und integrieren Sie KI-Funktionen direkt in Ihre bestehenden Workflows. 🙌

Häufig gestellte Fragen (FAQ)

Ja, die Llama 3 Community License erlaubt die kommerzielle Nutzung für die meisten Unternehmen. Nur Unternehmen mit mehr als 700 Millionen aktiven Benutzern pro Monat müssen eine separate Lizenz von Meta erwerben.

LLaMA bietet durch Selbsthosting eine bessere Datenkontrolle und vorhersehbare Kosten, während GPT-4 eine höhere Out-of-the-Box-Leistung bei geringerem Setup bietet. Für mehr Produktivität sollten Sie jedoch KI-Unterstützung nutzen, ohne die zugrunde liegenden Modelle über integrierte Tools wie ClickUp Brain verwalten zu müssen.

Durch das Selbsthosting von LLaMA bleiben die Daten in Ihrer Infrastruktur, was für die Datenresidenz von Vorteil ist. Sie sind jedoch selbst für die Implementierung Ihrer eigenen Zugriffskontrollen, Audit-Protokolle und Inhaltsfilter verantwortlich – Features, die normalerweise in verwalteten KI-Diensten enthalten sind.

Die direkte Bereitstellung und Feinabstimmung von LLaMA erfordert umfangreiche Kenntnisse im Bereich ML-Engineering. Teams ohne dieses Fachwissen können über verwaltete Plattformen wie ClickUp Brain auf LLaMA-basierte Features zugreifen, die KI-Features ohne Modellbereitstellung oder technische Konfiguration bereitstellen.