Większość programistów może uruchomić Gemini API w mniej niż 10 minut.

Prawdziwe wyzwanie pojawia się po ustawieniach.

W tym przewodniku dowiesz się, jak uzyskać klucz API, zainstalować SDK i wysłać pierwsze żądanie.

Dowiesz się również, jak uporządkować cykle pracy API, aby Twój zespół nie tracił czasu na ponowne opracowywanie rozwiązań lub wyszukiwanie dokumentacji.

Czym jest API Gemini?

Gemini API to interfejs Google umożliwiający dostęp do rodziny multimodalnych modeli AI, pozwalający programistom na integrację generowania tekstu, rozumienia obrazów, pomocy w pisaniu kodu i konwersacyjnej AI z aplikacjami.

Jest przeznaczony dla zespołów produktowych, inżynierów i firm, które chcą dodać do swoich produktów potężne możliwości AI bez konieczności tworzenia od podstaw dużych modeli językowych.

Duże modele językowe Gemini, takie jak Gemini 3 Flash i Gemini 3 Pro, są multimodalne, co oznacza, że mogą obsługiwać wiele rodzajów danych wejściowych, w tym tekst, obrazy, audio i wideo. Samo API wykorzystuje architekturę REST API , która jest standardowym sposobem komunikacji systemów komputerowych przez Internet.

Aby jeszcze bardziej ułatwić tę czynność, Google udostępnia zestawy SDK dla popularnych języków, takich jak Python, JavaScript i Go. Warto zrozumieć różnicę między API a Google AI Studio.

| Główne zastosowanie | Aplikacje produkcyjne | Prototypowanie i testowanie |

| Metoda dostępu | Wywołania SDK oparte na kodzie | Wizualny interfejs internetowy |

| Najlepsze dla | Programiści tworzący aplikacje | Eksperymentowanie z podpowiedziami |

💡Wskazówka dla profesjonalistów: Przechowuj wszystkie informacje dotyczące projektu w jednym miejscu i unikaj poszukiwania informacji w różnych narzędziach, tworząc wewnętrzną bazę wiedzy dla swoich projektów AI. Dzięki ClickUp Docs możesz łączyć fragmenty kodu i dokumentację API bezpośrednio z zadaniami swojego zespołu, eliminując rozrost narzędzi i przyspieszając wdrażanie AI.

Jak uzyskać klucz API Gemini

Twój zespół może być gotowy do rozpoczęcia tworzenia, ale najpierw potrzebujesz klucza API.

Aby korzystać z Gemini API, potrzebujesz klucza do uwierzytelniania swoich żądań, a zarządzanie tymi kluczami jest pierwszym krokiem do płynniejszego zarządzania cyklem pracy. Aby rozpocząć, potrzebujesz konta Google.

Oto jak uzyskać klucz:

- Przejdź do Google AI Studio

- Zaloguj się za pomocą konta Google.

- Kliknij Uzyskaj klucz API na lewym pasku bocznym.

- Wybierz opcję Utwórz klucz API w nowym projekcie lub wybierz istniejący projekt Google Cloud.

- Natychmiast skopiuj wygenerowany klucz i przechowuj go w bezpiecznej lokalizacji.

Twój klucz API zapewnia dostęp do limitu i rozliczeń Gemini — traktuj go jak hasło. 🔑

Twój klucz API zapewnia dostęp do limitu i rozliczeń Gemini — traktuj go jak hasło. 🔑

W przypadku większych zespołów klucze można również zarządzać za pomocą Google Cloud Console, która oferuje bardziej zaawansowane opcje kontroli.

Jak zainstalować SDK Gemini

Do Twojego projektu AI dołącza nowy programista, ale zamiast pisać kod, spędza pierwszy dzień na zmaganiach z ustawieniami środowiska.

Ich wersja Pythona jest nieprawidłowa lub brakuje w niej zależności, co prowadzi do klasycznego problemu „na moim komputerze działa”.

To często powód, dla którego programiści tracą 3 godziny tygodniowo. Takie niespójności spowalniają wdrażanie nowych pracowników i powodują nieprzewidywalne błędy, które marnują cenny czas inżynierów.

SDK, czyli zestaw narzędzi programistycznych, upraszcza interakcje z API, obsługując uwierzytelnianie, formatowanie żądań i analizowanie odpowiedzi. Aby uniknąć problemów z ustawieniami, Twój zespół potrzebuje znormalizowanego, udokumentowanego procesu instalacji Gemini SDK.

Oto jak zainstalować go w najpopularniejszych środowiskach.

Dla języka Python:

- Uwaga: Potrzebny będzie Python 3. 9 lub nowszy. Korzystanie ze środowiska wirtualnego jest najlepszą praktyką uniknięcia konfliktów z innymi projektami.

Dla JavaScript/Node. js:

- Notatka: Przeznaczone do użytku w środowisku Node. js.

Po instalacji musisz skonfigurować swój klucz API jako zmienną środowiskową. Dzięki temu klucz będzie bezpieczny i nie znajdzie się w kodzie źródłowym.

- Na komputerach Mac/Linux: wyeksportuj GEMINI_API_KEY="twój-klucz-API-tutaj"

- W systemie Windows: setx GEMINI_API_KEY „twój-klucz-API-tutaj”

Masz kilka opcji dotyczących wyboru SDK:

- Python SDK: Najpopularniejszy wybór, z obszerną dokumentacją. Idealny do zastosowań związanych z nauką o danych i aplikacjami backendowymi.

- JavaScript SDK: Najlepsza opcja do tworzenia aplikacji internetowych i backendów Node.js.

- Go SDK: doskonały wybór dla programistów tworzących wysokowydajne mikrousługi w języku Go.

- REST API: Jeśli używasz języka bez oficjalnego SDK, zawsze możesz wysyłać bezpośrednie żądania HTTP do REST API.

💡Wskazówka dla profesjonalistów: Ustandaryzuj swoje środowisko programistyczne i przyspiesz wdrażanie nowych pracowników, tworząc listę kontrolną, z której może skorzystać każdy nowy członek zespołu. Zapisz ją jako szablon w zadaniu ClickUp, a jeśli ktoś napotka problemy, może skorzystać z ClickUp Brain, aby uzyskać odpowiedzi z dokumentacji Twojego zespołu. Oto krótki przewodnik:

📖 Więcej informacji: Gemini kontra ChatGPT do kodowania: które rozwiązanie jest lepsze?

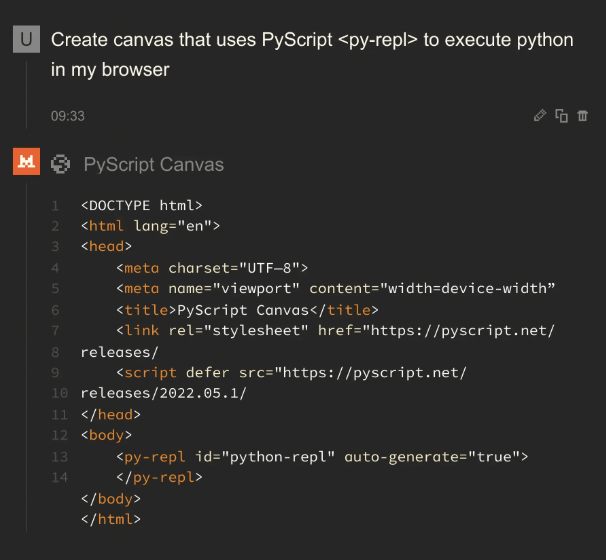

Jak złożyć pierwsze żądanie API Gemini

Twój zespół w końcu wykonuje wywołania API, ale każdy programista samodzielnie próbuje to rozgryźć.

Powodzenie wywołania API jest proste: wysyłasz podpowiedź do modelu Gemini i otrzymujesz odpowiedź.

Prawdziwym wyzwaniem jest sprawienie, aby proces ten był powtarzalny i skalowalny dla całego zespołu. Oto kilka przykładów, jak złożyć pierwsze żądanie.

Przykład w języku Python

Ten kod wysyła prostą podpowiedź tekstową do interfejsu API Gemini i wyświetla odpowiedź.

Rozbijmy to na czynniki pierwsze:

- Importuj i konfiguruj: powoduje to załadowanie biblioteki Google i ustawienie uwierzytelniania przy użyciu wcześniej skonfigurowanego klucza API.

- Inicjalizacja modelu: w tym miejscu informujesz kod, którego konkretnego modelu Gemini należy użyć. Gemini 3 Flash jest zoptymalizowany pod kątem szybkich zadań o dużej objętości, natomiast Gemini 3 Pro jest przeznaczony do głębokiego rozumowania i złożonych, wieloetapowych cykli pracy.

- Generowanie zawartości: To jest działanie. Wysyłasz swoje pytanie do modelu.

- Dostęp do wyników: Odpowiedź modelu jest przechowywana w obiekcie odpowiedzi i można uzyskać dostęp do tekstu za pomocą response. text.

📖 Więcej informacji: 10 przykładów zawartości generowanej przez AI, które mogą zainspirować Cię do tworzenia własnych

Przykład w JavaScript

Jeśli pracujesz w środowisku Node.js, proces jest podobny, ale wykorzystuje składnię async/await języka JavaScript.

Przykład REST API

Jeśli nie używasz języka Python lub JavaScript, zawsze możesz komunikować się z API bezpośrednio za pomocą komendy curl. Jest to świetne rozwiązanie do szybkich testów lub do użycia w językach bez dedykowanego SDK.

Komenda wysyła żądanie HTTP do punktu końcowego API i zwraca odpowiedź jako obiekt JSON.

Ułatw swojemu zespołowi wyszukiwanie i ponowne wykorzystywanie fragmentów kodu i podpowiedzi o powodzeniu, tworząc wspólną bibliotekę.

📖 Więcej informacji: Czym jest plan zarządzania projektami i jak go stworzyć?

Co można stworzyć za pomocą API Gemini?

Gemini API jest niezwykle wszechstronne. Oto kilka rzeczy, które możesz stworzyć:

- Narzędzia do generowania zawartości: Zautomatyzuj tworzenie szkiców blogów, postów w mediach społecznościowych i tekstów marketingowych.

- Chatboty i wirtualni asystenci: Twórz interfejsy konwersacyjne do obsługi klienta lub wewnętrznych działów pomocy technicznej.

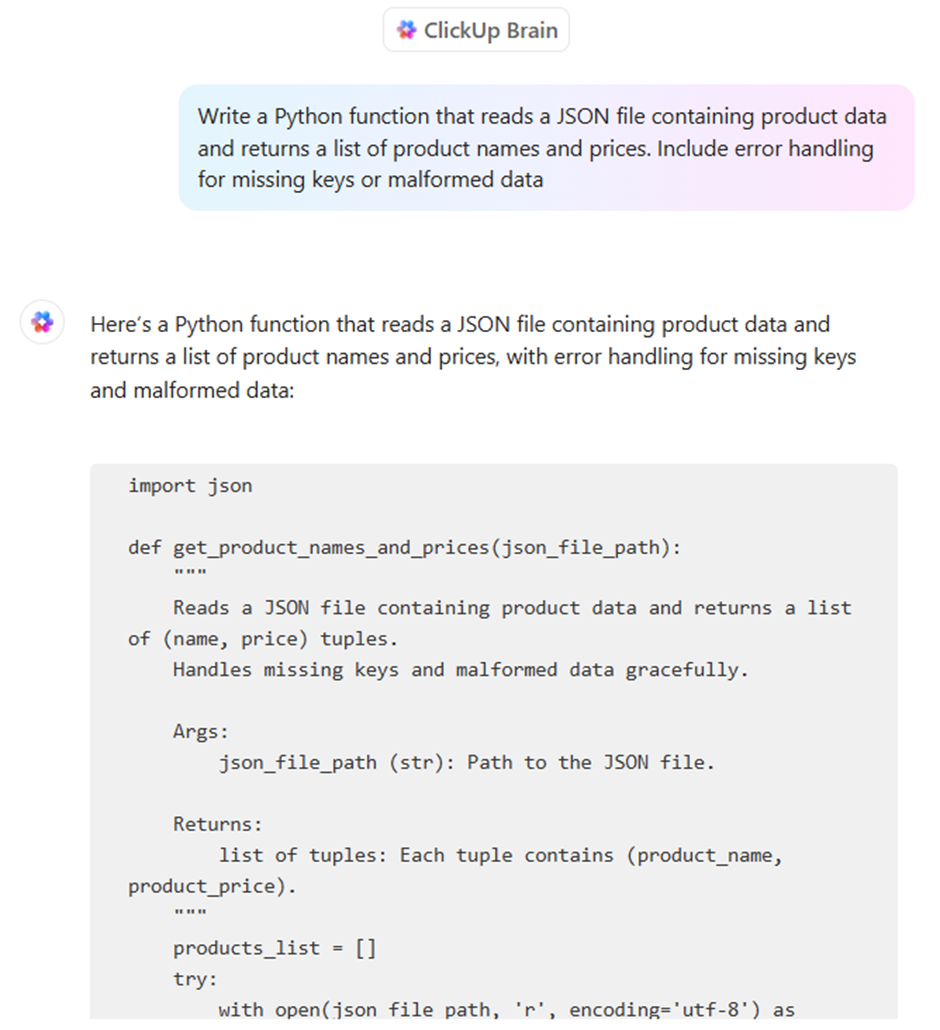

- Pomoc w pisaniu kodu: generuj fragmenty kodu, wyjaśniaj złożone funkcje i pomagaj w debugowaniu błędów.

- Pomocnicy w analizie danych: Podsumowuj obszerne raporty i wyodrębniaj kluczowe informacje z nieustrukturyzowanego tekstu.

- Aplikacje multimodalne: analizuj obrazy lub przetwarzaj zawartość wideo, aby umożliwić jej wyszukiwanie.

- Przetwarzanie dokumentów: Wyodrębniaj informacje z plików PDF i tłumacz dokumenty na różne języki.

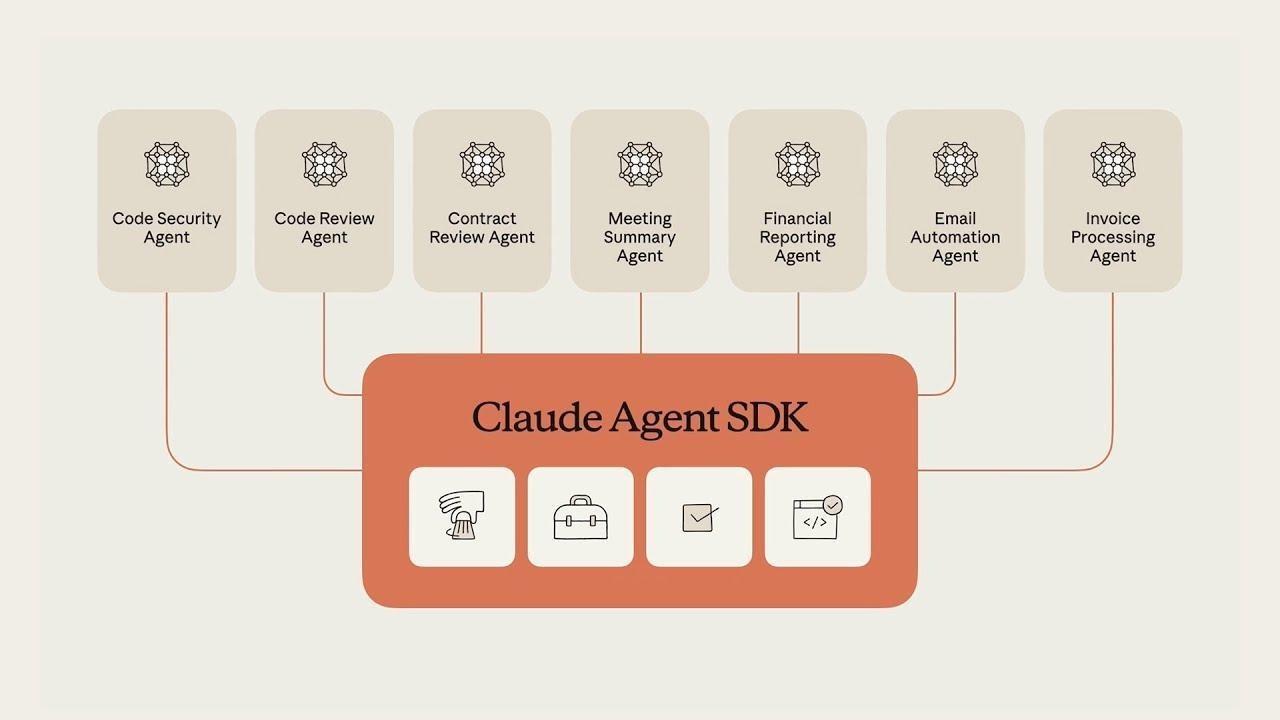

Tworzenie cykli pracy agentów za pomocą Gemini

W przeciwieństwie do standardowego chatbota, który odpowiada na pytania w sposób liniowy, cykl pracy agenta w Gemini pozwala modelowi dostrzegać cel, przemyśleć plan i wykonać serię autonomicznych działań w narzędziach zewnętrznych.

Ta „agentowa” zmiana jest napędzana przez trzy podstawowe funkcje ekosystemu Gemini 3:

- Natywny tryb „myślenia”: Korzystając z parametru thinking_level, możesz teraz przełączać się między trybem „niskim” zapewniającym szybkość a trybem „wysokim” przeznaczonym do złożonych zadań. W trybie wysokiego poziomu rozumowania Gemini 3 Pro generuje ukryte „tokeny myślowe”, aby zweryfikować własną logikę przed udzieleniem odpowiedzi, co znacznie ogranicza halucynacje.

- Podpisy myślowe: Aby zapobiec „dryfowi rozumowania” w zadaniach wieloetapowych, API wydaje teraz zaszyfrowane podpisy myślowe. Programiści muszą przekazać te podpisy z powrotem w historii rozmowy, aby zapewnić, że agent zachowuje dokładny tok myślenia podczas różnych wywołań API i wykonywania narzędzi.

- Model Context Protocol (MCP): Gemini wykorzystuje obecnie standardowy protokół MCP do tworzenia połączeń z narzędziami. Dzięki temu Twój agent może natychmiast „podłączyć się” do istniejących baz danych, Slacka lub GitHub bez konieczności pisania niestandardowego kodu integracyjnego dla każdej funkcji.

📮 ClickUp Insight: Zespoły o niskiej wydajności są 4 razy bardziej skłonne do korzystania z ponad 15 narzędzi, podczas gdy zespoły o wysokiej wydajności utrzymują efektywność, limitując swój zestaw narzędzi do 9 lub mniej platform.

A może warto używać tylko jednej platformy do wszystkiego?

ClickUp łączy Twoje zadania, projekty, dokumenty, wiki, czaty i połączenia w jednej platformie, uzupełnione o cykle pracy oparte na sztucznej inteligencji. Gotowy do inteligentniejszej pracy? ClickUp działa dla każdego zespołu, sprawia, że praca jest widoczna i pozwala skupić się na tym, co najważniejsze, podczas gdy sztuczna inteligencja zajmuje się resztą.

Przykład w języku Python: Tworzenie agenta badawczego

Ten fragment kodu pokazuje, jak zainicjować agenta o wysokim poziomie rozumowania, który utrzymuje stały „ciąg myśli” za pomocą najnowszego SDK Gemini.

📖 Więcej informacji: Jak wykorzystać chatbota w swojej firmie

Jak zabezpieczyć klucz API Gemini

Twój zespół dostarcza nowe funkcje, ale kwestie bezpieczeństwa są traktowane po macoszemu.

Klucze API są czasami pozostawiane w kodzie — co przyczyniło się do wycieku 23,7 miliona tajnych informacji do publicznego serwisu GitHub w 2024 r. — i nie ma formalnego procesu ich rotacji. Naraża to Twoją organizację na nieautoryzowane użycie, co może prowadzić do nieoczekiwanych rachunków i poważnych naruszeń bezpieczeństwa.

Reaktywne podejście do bezpieczeństwa to przepis na katastrofę. Potrzebujesz proaktywnego systemu zarządzania wiedzą do zarządzania poświadczeniami, aby chronić swoje aplikacje i dane firmy.

Oto najważniejsze najlepsze praktyki dotyczące bezpieczeństwa klucza API Gemini:

- Używaj zmiennych środowiskowych: Nigdy, przenigdy nie zapisuj kluczy bezpośrednio w kodzie źródłowym. Przechowuj je w plikach .env lub zmiennych środowiskowych systemu.

- Dodaj. env do. gitignore: Ten prosty krok zapobiega przypadkowemu commitowaniu tajnych kluczy do publicznego repozytorium kodu.

- Regularnie zmieniaj klucze: okresowo generuj nowe klucze w Google Cloud Console i wyłączaj stare.

- Wprowadź kontrolę dostępu: skorzystaj z funkcji zarządzania tożsamością i dostępem (IAM) Google Cloud, aby ograniczyć dostęp do kluczy API członkom zespołu.

- Monitoruj wykorzystanie: Obserwuj pulpit nawigacyjny wykorzystania API w Google Cloud Console, aby wykryć wszelkie nietypowe działania, które mogą sygnalizować naruszenie bezpieczeństwa.

- Używaj oddzielnych kluczy dla poszczególnych środowisk: Używaj różnych kluczy dla środowisk programistycznych, testowych i produkcyjnych, aby ograniczyć zasięg potencjalnego wycieku.

Ceny Gemini

- Gemini 3 Flash: ~0,50 USD za 1 mln wejść / 3,00 USD za 1 mln wyjść

- Gemini 3 Pro: ~2,00 USD za 1 mln danych wejściowych / 12,00 USD za 1 mln danych wyjściowych (dla kontekstu poniżej 200 tys.)

- Podstawa wyszukiwania: Należy pamiętać, że Google pobiera obecnie opłatę w wysokości 14 USD za 1000 zapytań za podstawę wyszukiwania po przekroczeniu miesięcznego limitu bezpłatnych zapytań (5000 zapytań).

Ograniczenia korzystania z API Gemini

Twoja aplikacja działa, ale napotykasz nieoczekiwane problemy.

API działa wolniej niż się spodziewałeś w godzinach szczytu lub zwraca niespójne odpowiedzi, które dezorientują użytkowników.

Pierwszym krokiem jest zrozumienie limitów API; dokumentowanie rozwiązań zastępczych pomaga w skutecznym skalowaniu.

Pamiętaj o tych typowych ograniczeniach:

- Ograniczenia szybkości: bezpłatny poziom ma ograniczenia dotyczące liczby żądań na minutę i tokenów dziennie, co może powodować wąskie gardło w aplikacjach o dużej objętości.

- Zmienność opóźnień: Czasy odpowiedzi mogą się zmieniać w zależności od złożoności podpowiedzi i ogólnego obciążenia serwera.

- Ograniczenia okna kontekstowego: Każdy model ma maksymalną liczbę tokenów (słów i części słów), które może przetworzyć w ramach jednego żądania, co może stanowić wyzwanie w przypadku streszczania bardzo długich dokumentów.

- Dostępność regionalna: Niektóre modele lub funkcje mogą nie być dostępne we wszystkich regionach geograficznych.

- Spójność wyników: Generatywna AI może generować nieco różne wyniki nawet dla tej samej podpowiedzi, co może wymagać wbudowania kroków walidacji w cykl pracy.

- Brak danych w czasie rzeczywistym: wiedza modeli nie jest aktualizowana w czasie rzeczywistym, więc nie mogą one dostarczać informacji o najnowszych wydarzeniach.

Chociaż Gemini API jest potężnym narzędziem multimodalnym, tworzenie aplikacji gotowej do produkcji często wymaga strategii wielomodelowej. W zależności od konkretnych potrzeb projektu w zakresie głębokości rozumowania lub dokładności kodowania, możesz zapoznać się z tymi alternatywami dla Gemini.

Większość narzędzi AI obiecuje ułatwić programowanie, ale często kończą one jako kolejna niepołączona zakładka w i tak już przepełnionym stosie. Możesz używać interfejsu API Gemini do zasilania zaplecza swojej aplikacji, oddzielnego narzędzia do podsumowywania notatek ze spotkań i trzeciej platformy do zarządzania zadaniami sprintu. Ta sieć rozproszonych kontekstów i odizolowanych narzędzi to „rozrost AI”.

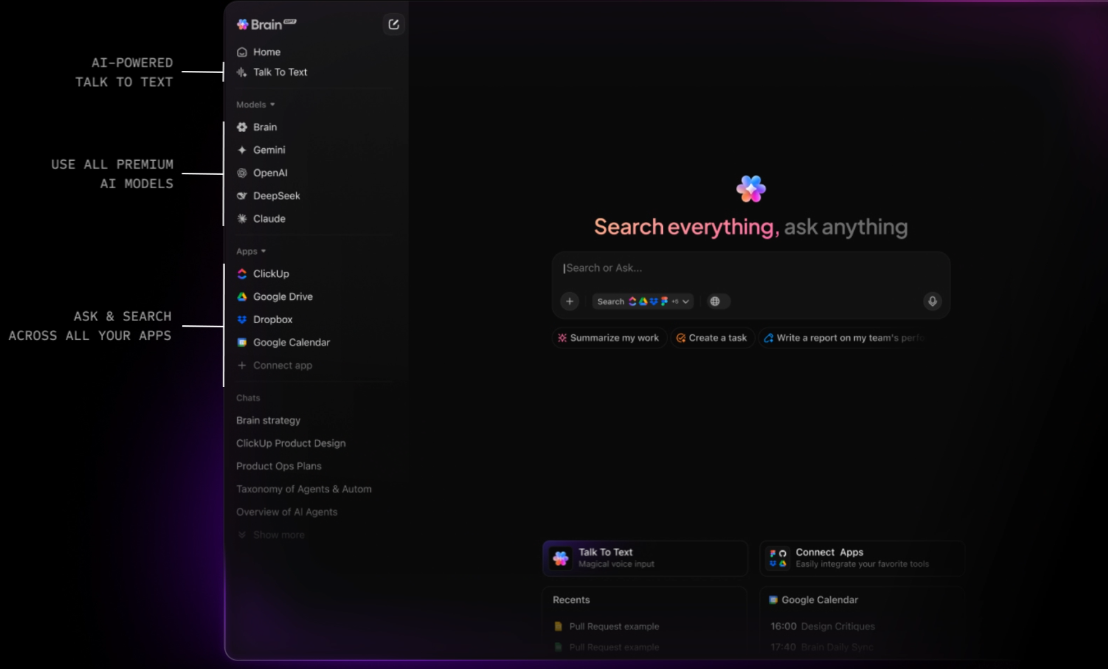

ClickUp to pierwsze zintegrowane środowisko pracy AI, które łączy zadania, dokumenty i osoby za pomocą centralnej warstwy inteligencji. W przeciwieństwie do samodzielnych interfejsów API, które wymagają tworzenia własnych systemów odzyskiwania kontekstu (RAG), ClickUp Brain już „zna” wszystko w Twoim obszarze roboczym.

Ponieważ AI jest natywnie zintegrowana, nie tylko „generuje tekst” — rozumie również powiązania między dokumentacją API Gemini, terminami projektów i postępami zespołu w czasie rzeczywistym.

Włącz funkcję „Ask AI” z dowolnego miejsca i wdrażaj autonomiczne agenty

Prawdziwa moc ClickUp polega na jego zdolności do przekształcania wiedzy w działanie. Dzięki Brain Assistant możesz „zapytać AI” z dowolnego miejsca w swoim obszarze roboczym — a nawet za pośrednictwem kompaniona na pulpicie podczas pisania kodu w IDE. Możesz natychmiast ujawnić ryzyko związane z projektem, zadając pytanie: „Jakie były opinie na temat ostatniego wdrożenia Gemini 3 Pro?” ClickUp Brain przeprowadzi dogłębne przeszukanie całej historii, dostarczając cytowaną odpowiedź wraz z linkami do konkretnego zadania lub wątku komentarzy, w którym odbyła się dyskusja.

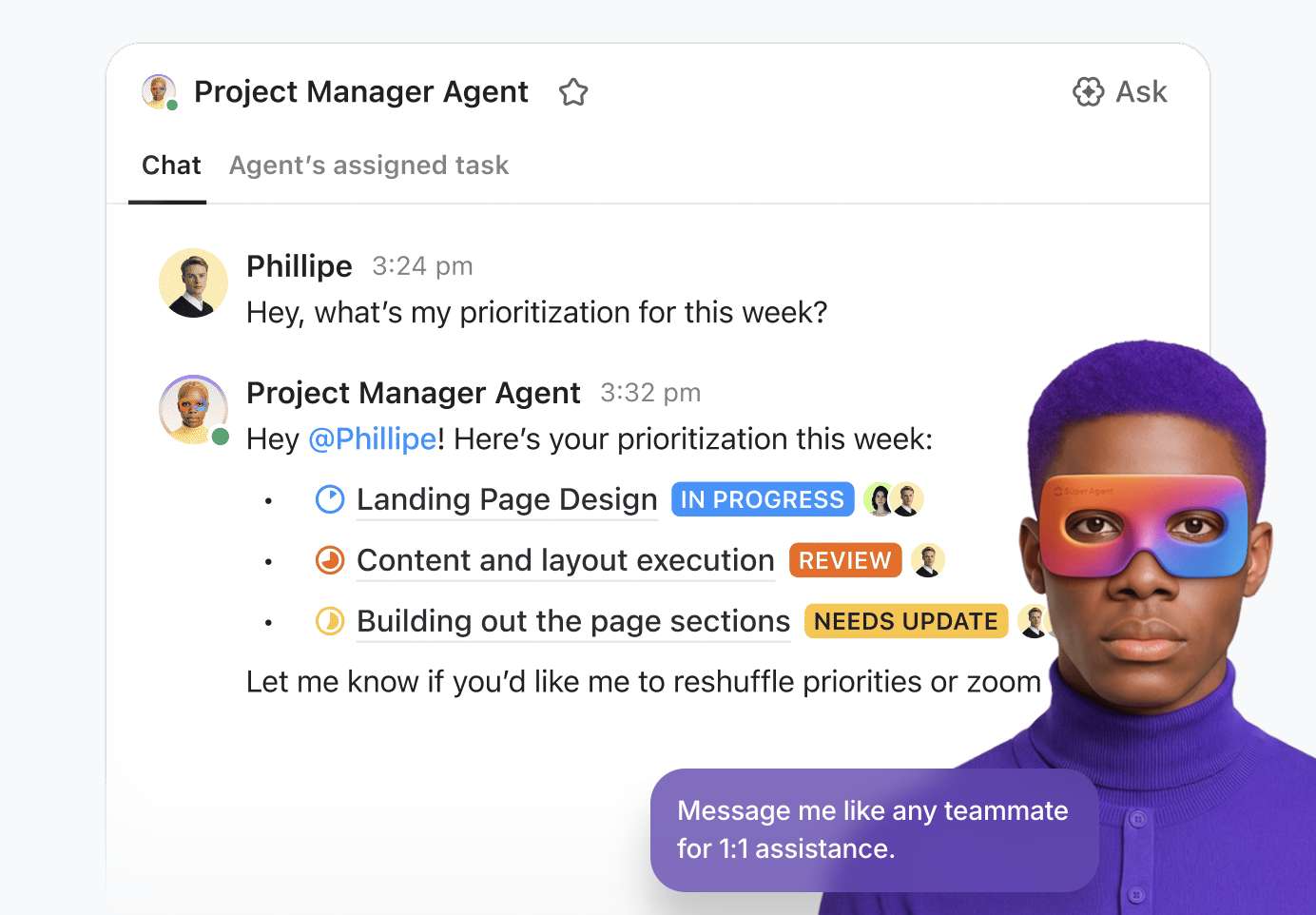

Dla zespołów tworzących złożone produkty AI ClickUp wykracza poza prostą pomoc, umożliwiając wdrożenie Super Agentów . Są to autonomiczni cyfrowi współpracownicy, którzy nie wymagają kodowania i zajmują się „rutynowymi zadaniami” w cyklu rozwoju produktu. Możesz skonfigurować agenta triage do monitorowania błędów przychodzących z integracji Gemini lub agenta zarządzania projektami, który proaktywnie identyfikuje przeszkody w sprincie i generuje codzienne podsumowania standupów na podstawie aktywności zespołu. Jest to inteligentny system, który zapewnia ciągłość procesu rozwoju 24 godziny na dobę, 7 dni w tygodniu.

Ujednolicona platforma do zarządzania pracą dla współczesnych programistów

ClickUp Docs służy jako wspólny notatnik techniczny Twojego zespołu. Niezależnie od tego, czy tworzysz projekt PRD dla nowej funkcji multimodalnej, czy przechowujesz protokoły bezpieczeństwa Gemini API, wszystko pozostaje połączone.

Linia kodu w dokumencie może natychmiast stać się zadaniem, a ClickUp Brain pozwala wykorzystać Enterprise Search do wyszukiwania plików i rozmów z połączonych aplikacji, takich jak Google Workspace, GitHub i Figma, za pomocą wyszukiwania semantycznego.

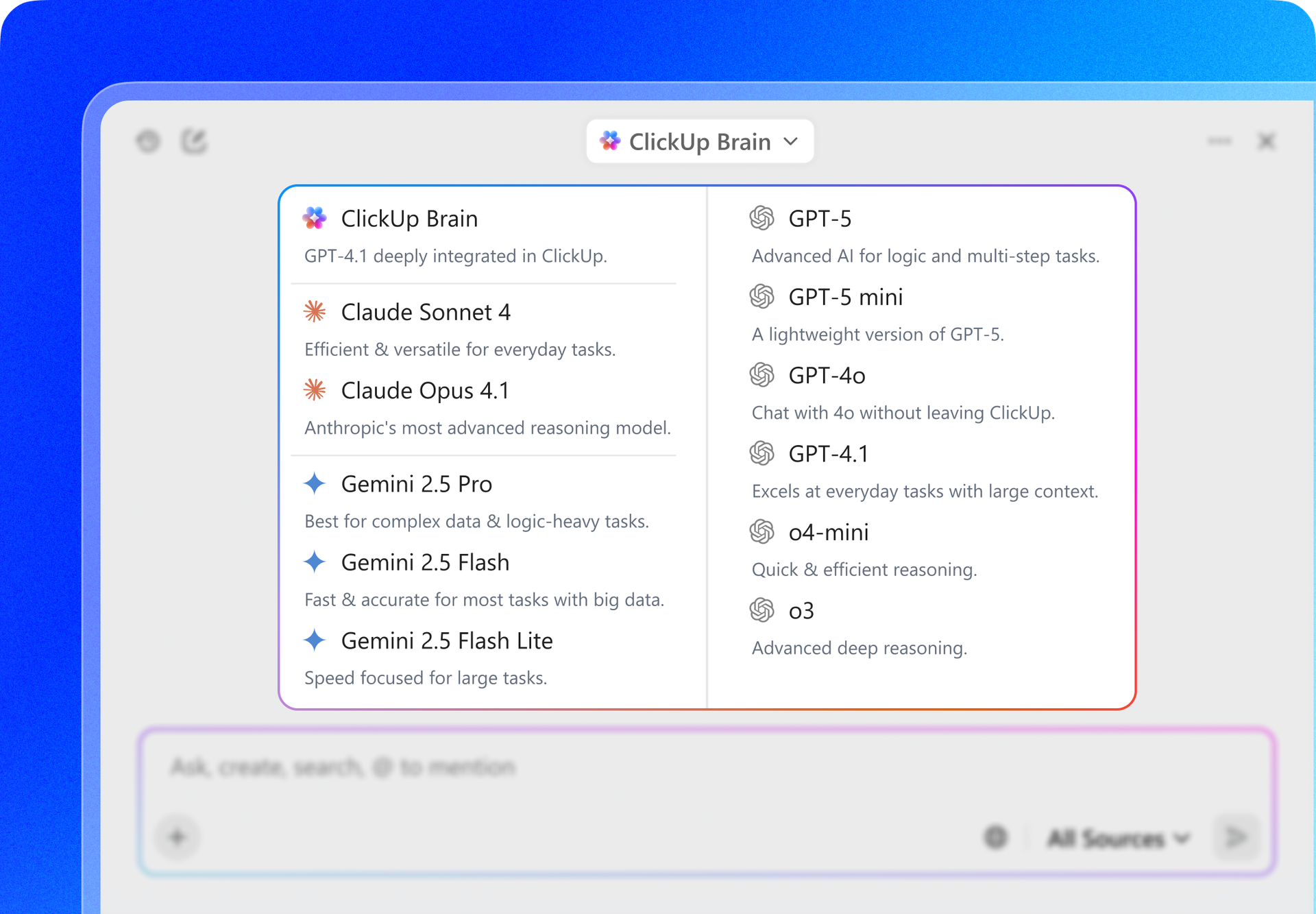

Ponadto ClickUp zapewnia elastyczność wielu modeli. Podczas tworzenia za pomocą interfejsu API Gemini możesz korzystać z interfejsu ClickUp, aby przełączać się między Gemini 3, GPT-5. 2 i Claude 4. 5 w celu porównania wyników lub sporządzenia wstępnych specyfikacji technicznych. Dzięki temu zawsze masz do dyspozycji najlepszy „mózg” do wykonania danego zadania, nie opuszczając środowiska zarządzania projektami.

Najlepsze funkcje ClickUp

Limity ClickUp

Ceny ClickUp

Oceny i recenzje ClickUp

Co o ClickUp mówią prawdziwi użytkownicy?

Szablony ClickUp, pola niestandardowe, priorytety, punkty scrumowe, plany i różne opcje wyświetlania, pomimo niewielkiej krzywej uczenia się, umożliwiły naszemu zespołowi dostosowanie narzędzia do naszych zmieniających się potrzeb i maksymalizację wydajności. Jego potężna integracja z narzędziami takimi jak Google Drive, spotkania, kalendarze i solidne wsparcie API płynnie usprawniają nasz cykl pracy. Dodatkowo formularze ClickUp znacznie zwiększają wartość naszych operacji. Ogólnie rzecz biorąc, wszystko w ClickUp jest tak potężne i użyteczne, że nie chcę niczego zmieniać. Jestem głęboko przekonany, że ClickUp został opracowany z myślą o preferencjach użytkowników, dzięki czemu idealnie odpowiada naszym potrzebom.

Zalety ClickUp: Zamiast pisać kod, aby połączyć bazę danych z LLM, BrainGPT, samodzielna superaplikacja AI od ClickUp, działa jako interfejs niezależny od modelu, już połączony z Twoimi zadaniami, dokumentami i repozytoriami kodu.

Pozwala to na:

Platforma API OpenAI pozostaje głównym konkurentem dla programistów tworzących złożone, „myślące” aplikacje. Wraz z wydaniem serii GPT-5. 2, OpenAI przeszło w kierunku „agentowego rozumowania”, w którym model automatycznie zatrzymuje się, aby zweryfikować swoją logikę przed udzieleniem odpowiedzi.

W przeciwieństwie do ścisłej integracji Gemini z Google Workspace, OpenAI oferuje bardziej modułowe podejście „Foundry”, co czyni je preferowanym wyborem dla programistów, którzy chcą platformy niezależnej od dostawcy, skalowalnej w różnych chmurach, takich jak Azure i AWS.

Gemini 3 Flash oferuje natomiast znacznie szybsze przetwarzanie wideo i znacznie większe okno kontekstowe o pojemności 2 milionów tokenów, podczas gdy GPT-5. 2 obecnie ogranicza swój natywny kontekst do 400 000 tokenów.

Najlepsze funkcje API OpenAI

Limitacje API OpenAI

Ceny API OpenAI

Oceny i recenzje interfejsu API OpenAI

Co użytkownicy mówią o OpenAI w praktyce?

Jesteśmy pod ogromnym wrażeniem modeli AI, a zwłaszcza dostępu do API. Dzięki integracji OpenAI z naszymi rozwiązaniami CRM (BROSH CRM) jesteśmy w stanie zapewnić naszym klientom realną, namacalną wartość dzięki automatyzacji opartej na sztucznej inteligencji. OpenAI umożliwia BROSH CRM dostarczanie zaawansowanych funkcji opartych na sztucznej inteligencji w wielu obszarach. Nasi klienci korzystają z wysokiej jakości, kontekstowych odpowiedzi AI w swoich kanałach komunikacyjnych, generowanych bezpośrednio z danych CRM. Znacznie poprawia to interakcje z klientami, jednocześnie oszczędzając czas i zasoby.

📖 Więcej informacji: Jak korzystać z interfejsu API ChatGPT w swoich aplikacjach

Claude, opracowany przez Anthropic, jest alternatywą dla programistów, którzy priorytetowo traktują dokładność techniczną i „ludzkie” rozumowanie. Claude 4. 5 Sonnet jest powszechnie uważany za najbardziej niezawodny model dla inżynierii oprogramowania, konsekwentnie przewyższający inne modele w testach porównawczych kodowania, takich jak SWE-bench.

Jedną z jego wyróżniających się funkcji jest Claude Code, narzędzie CLI, które pozwala modelowi na bezpośrednią interakcję z lokalnym terminalem i systemem plików w celu debugowania i wysyłania kodu.

Gemini 3 Pro doskonale radzi sobie z przetwarzaniem ogromnych ilości danych jednocześnie (np. godzinowego wideo), ale Claude jest często preferowany do zadań, w których „klimat” i precyzja wyników są ważniejsze niż sama ilość przetwarzanych danych.

Najlepsze funkcje Claude API

Limity interfejsu API Claude

Ceny API Claude

Oceny i recenzje interfejsu API Claude

Co użytkownicy mówią o Claude API?

Opłata za korzystanie z API jest wyższa niż w przypadku ChatGPT lub Gemini, ale jeśli chcesz tylko zadawać pytania, możesz po prostu skorzystać z wersji desktopowej, więc nie jest to duży problem. Nie jest to jednak najlepsza opcja, jeśli chcesz włączyć ją do aplikacji.

📖 Więcej informacji: Jak korzystać z Claude AI w celu wydajnego i dokładnego kodowania

Mistral AI zapewnia wysokowydajne modele, które stanowią alternatywę dla „zamkniętych” systemów Google i OpenAI. Jest uważany za lidera wśród przedsiębiorstw, które wymagają suwerenności danych lub chcą wdrażać modele we własnej prywatnej infrastrukturze.

Flagowe modele Mistral, takie jak Mistral Large 3, zostały zaprojektowane tak, aby były wydajne i „niefiltrowane”, dając programistom większą kontrolę nad zachowaniem modelu w porównaniu z bardziej rygorystycznymi zabezpieczeniami, które często spotyka się w Gemini lub Claude.

Najlepsze funkcje Mistral AI

Limity Mistral AI

Ceny Mistral AI/AI

Oceny i recenzje Mistral AI

Co użytkownicy mówią o Mistral AI w praktyce?

Zapytałem o postać z historii naszego kraju. GEMINI poprawnie rozróżniło dwie bardzo różne osoby o tym samym imieniu i nazwisku: jedną z nich był historyk i profesor uniwersytecki, a drugą bojownik ruchu oporu deportowany podczas II wojny światowej. Mistral AI podał mi tylko opis pierwszej z tych osób.

Alternatywne narzędzia AI do wykorzystania

Chociaż Gemini API jest potężnym narzędziem multimodalnym, tworzenie aplikacji gotowej do produkcji często wymaga strategii wielomodelowej. W zależności od konkretnych potrzeb projektu w zakresie głębokości rozumowania lub dokładności kodowania, możesz zapoznać się z tymi alternatywami dla Gemini.

1. ClickUp (najlepsze rozwiązanie dla zespołów potrzebujących AI uwzględniającej kontekst, zintegrowanej z ich cyklem pracy)

Większość narzędzi AI obiecuje ułatwić programowanie, ale często kończą one jako kolejna niepołączona zakładka w i tak już przepełnionym stosie. Możesz używać interfejsu API Gemini do obsługi zaplecza swojej aplikacji, oddzielnego narzędzia do podsumowywania notatek ze spotkań i trzeciej platformy do zarządzania zadaniami sprintu. Ta sieć rozproszonych kontekstów i odizolowanych narzędzi to „rozrost AI”.

ClickUp to pierwsze zintegrowane środowisko pracy AI, które łączy zadania, dokumenty i osoby za pomocą centralnej warstwy inteligencji. W przeciwieństwie do samodzielnych interfejsów API, które wymagają tworzenia własnych systemów odzyskiwania kontekstu (RAG), ClickUp Brain już „zna” wszystko w Twoim środowisku pracy.

Ponieważ AI jest natywnie zintegrowana, nie tylko „generuje tekst” — rozumie również powiązania między dokumentacją API Gemini, terminami realizacji projektów i postępami zespołu w czasie rzeczywistym.

Włącz funkcję „Ask AI” z dowolnego miejsca i wdrażaj autonomiczne agenty

Prawdziwa moc ClickUp polega na jego zdolności do przekształcania wiedzy w działanie. Dzięki Brain Assistant możesz „zapytać AI” z dowolnego miejsca w swoim obszarze roboczym — a nawet za pośrednictwem kompaniona na pulpicie podczas pisania kodu w IDE. Możesz natychmiast ujawnić ryzyko związane z projektem, zadając pytanie: „Jakie były opinie na temat ostatniego wdrożenia Gemini 3 Pro?” ClickUp Brain przeprowadzi dogłębne przeszukanie całej historii, dostarczając cytowaną odpowiedź wraz z linkami do konkretnego zadania lub wątku komentarzy, w którym odbyła się dyskusja.

Dla zespołów tworzących złożone produkty AI, ClickUp wykracza poza prostą pomoc, umożliwiając wdrożenie Super Agentów . Są to autonomiczni cyfrowi współpracownicy, którzy nie wymagają kodowania i zajmują się „rutynowymi zadaniami” w cyklu rozwoju oprogramowania. Możesz skonfigurować agenta triage do monitorowania błędów przychodzących z integracji Gemini lub agenta kierownika projektu, który proaktywnie identyfikuje przeszkody w sprincie i generuje codzienne podsumowania standupów na podstawie aktywności zespołu. Jest to inteligentny system, który zapewnia ciągłość procesu rozwoju 24 godziny na dobę, 7 dni w tygodniu.

Ujednolicona platforma do zarządzania pracą dla nowoczesnych programistów

ClickUp Docs służy jako wspólny notatnik techniczny Twojego zespołu. Niezależnie od tego, czy tworzysz projekt PRD dla nowej funkcji multimodalnej, czy przechowujesz protokoły bezpieczeństwa Gemini API, wszystko pozostaje połączone.

Linia kodu w dokumencie może natychmiast stać się zadaniem, a ClickUp Brain pozwala wykorzystać Enterprise Search do wyszukiwania plików i rozmów z połączonych aplikacji, takich jak Google Workspace, GitHub i Figma, za pomocą wyszukiwania semantycznego.

Ponadto ClickUp zapewnia elastyczność wielu modeli. Podczas tworzenia za pomocą interfejsu API Gemini możesz używać interfejsu ClickUp do przełączania się między Gemini 3, GPT-5. 2 i Claude 4. 5, aby porównać wyniki lub szkice specyfikacji technicznych. Dzięki temu zawsze masz do dyspozycji najlepszy „mózg” do wykonania danego zadania, nie opuszczając środowiska zarządzania projektami.

Najlepsze funkcje ClickUp

- Uniwersalne wyszukiwanie i Ask AI: Natychmiastowe pobieranie danych z ClickUp, Slack, GitHub i Drive lub prośba AI o podsumowanie dowolnego dokumentu lub wątku zadania z dowolnego miejsca w obszarze roboczym.

- Agenci bez kodowania: Wdrażaj agentów bez kodowania, aby zautomatyzować tworzenie zadań, aktualizacje statusu i raportowanie, zamieniając ręczne zarządzanie projektami w autonomiczny cykl pracy.

- Zintegrowany czat AI: Wymień @Brain w dowolnym wątku czatu ClickUp, aby natychmiast przekształcić rozmowę w sformatowane zadanie lub uzyskać podsumowanie długiej dyskusji.

- Panele kontrolne oparte na AI: Wizualizuj kondycję zespołu dzięki panelom kontrolnym działającym w czasie rzeczywistym, które wykorzystują AI do identyfikowania ryzyka związanego ze sprintami, przewidywania opóźnień i wyjaśniania trendów danych prostym językiem.

- AI Writer for Documents: Twórz projekty wymagań technicznych, standardowych procedur operacyjnych (SOP) i agend spotkań, które są wstępnie wypełnione danymi i kontekstem konkretnego projektu.

Limity ClickUp

- Skuteczność AI jest powiązana z porządkiem w Twoim obszarze roboczym; jeśli Twój zespół nie aktualizuje zadań i dokumentów, AI ma mniej „kontekstu”, z którego może czerpać odpowiedzi.

Ceny ClickUp

Oceny i recenzje ClickUp

- G2: 4,7/5 (ponad 10 900 recenzji)

- Capterra: 4,6/5 (ponad 4500 recenzji)

Co o ClickUp mówią prawdziwi użytkownicy?

Szablony ClickUp, pola niestandardowe, priorytety, punkty scrumowe, plany i różne opcje wyświetlania, pomimo niewielkiej krzywej uczenia się, umożliwiły naszemu zespołowi dostosowanie narzędzia do naszych zmieniających się potrzeb i maksymalizację wydajności. Jego potężna integracja z narzędziami takimi jak Google Drive, spotkania, kalendarze i solidne wsparcie API płynnie usprawniają nasz cykl pracy. Dodatkowo formularze ClickUp stanowią znaczną wartość dodaną dla naszych operacji. Ogólnie rzecz biorąc, wszystko w ClickUp jest tak potężne i użyteczne, że nie chcę niczego zmieniać. Jestem głęboko przekonany, że ClickUp został opracowany z myślą o preferencjach użytkowników, dzięki czemu idealnie odpowiada naszym potrzebom.

Szablony ClickUp, pola niestandardowe, priorytety, punkty scrumowe, plany i różne opcje wyświetlania, pomimo niewielkiej krzywej uczenia się, umożliwiły naszemu zespołowi dostosowanie narzędzia do naszych zmieniających się potrzeb i maksymalizację wydajności. Jego potężna integracja z narzędziami takimi jak Google Drive, spotkania, kalendarze i solidna obsługa API płynnie usprawniają nasz cykl pracy. Dodatkowo formularze ClickUp znacznie zwiększają wartość naszych operacji. Ogólnie rzecz biorąc, wszystko w ClickUp jest tak potężne i użyteczne, że nie chcę niczego zmieniać. Jestem głęboko przekonany, że ClickUp został opracowany z myślą o preferencjach użytkowników, dzięki czemu idealnie odpowiada naszym potrzebom.

Zalety ClickUp: Zamiast pisać kod, aby połączyć bazę danych z LLM, BrainGPT, samodzielna superaplikacja AI od ClickUp, działa jako interfejs niezależny od modelu, już połączony z Twoimi zadaniami, dokumentami i repozytoriami kodu.

Pozwala to na:

- Przełączaj się między modelami: użyj Gemini 3 do zadań wymagających ogromnego kontekstu 2 mln tokenów, a następnie przejdź do Claude 4. 5, aby uzyskać precyzyjne kodowanie — wszystko w tym samym oknie.

- Ujednolicone wyszukiwanie: zadaj pytanie „Jakie były ostateczne specyfikacje bezpieczeństwa API omówione podczas spotkania w zeszłym miesiącu?” i uzyskaj rzetelną odpowiedź, pobierając informacje jednocześnie ze Slacka, GitHub i ClickUp Docs.

- Talk-to-Text: Użyj aplikacji komputerowej BrainGPT, aby dyktować komendy, takie jak „Sporządź zgłoszenie Jira dotyczące integracji Gemini i przypisz je do głównego programisty” — bez konieczności używania klawiatury

2. OpenAI API (najlepsze do ogólnego zastosowania i rozumowania agentowego)

Platforma API OpenAI pozostaje głównym konkurentem dla programistów tworzących złożone, „myślące” aplikacje. Wraz z wydaniem serii GPT-5. 2, OpenAI przeszło w kierunku „agentowego rozumowania”, w którym model automatycznie zatrzymuje się, aby zweryfikować swoją logikę przed udzieleniem odpowiedzi.

W przeciwieństwie do ścisłej integracji Gemini z Google Workspace, OpenAI oferuje bardziej modułowe podejście „Foundry”, co czyni go preferowanym wyborem dla programistów, którzy chcą platformy niezależnej od dostawcy, skalowalnej w różnych chmurach, takich jak Azure i AWS.

Gemini 3 Flash oferuje natomiast znacznie szybsze przetwarzanie wideo i znacznie większe okno kontekstowe o pojemności 2 milionów tokenów, podczas gdy GPT-5. 2 obecnie ogranicza swój natywny kontekst do 400 000 tokenów.

Najlepsze funkcje API OpenAI

- Użyj trybu myślenia, aby radzić sobie ze złożonymi, wieloetapowymi problemami, które wymagają wewnętrznej weryfikacji przed wygenerowaniem ostatecznej odpowiedzi.

- Uzyskaj dostęp do Realtime API, aby tworzyć multimodalne doświadczenia o niskim opóźnieniu, w tym natywne interakcje typu speech-to-speech.

- Wykorzystaj API wyszukiwania plików (Vector Store) do tworzenia systemów RAG (Retrieval-Augmented Generation) z wbudowanym zarządzaniem dokumentami.

Limity API OpenAI

- Jeśli nie będziesz uważnie monitorować, korzystanie z tego może szybko stać się kosztowne, zwłaszcza gdy używasz modeli o wysokim poziomie rozumowania, takich jak GPT-5. 2 Pro

Ceny API OpenAI

- GPT-5. 2: 1,75 USD/1 mln danych wejściowych | 14,00 USD/1 mln danych wyjściowych

- GPT-5. 2 Pro: 21,00 USD/1 mln danych wejściowych | 168,00 USD/1 mln danych wyjściowych

- GPT-5 Mini: 0,25 USD/1 mln danych wejściowych | 2,00 USD/1 mln danych wyjściowych

Oceny i recenzje interfejsu API OpenAI

- G2: 4,7/5 (ponad 840 recenzji)

- Gartner Peer Insights: 4,4/5 (ponad 60 recenzji)

Co użytkownicy mówią o OpenAI w praktyce?

Jesteśmy pod ogromnym wrażeniem modeli AI, a zwłaszcza dostępu do API. Dzięki integracji OpenAI z naszymi rozwiązaniami CRM (BROSH CRM) jesteśmy w stanie zapewnić naszym klientom realną, namacalną wartość dzięki automatyzacji opartej na sztucznej inteligencji. OpenAI umożliwia BROSH CRM dostarczanie zaawansowanych funkcji opartych na sztucznej inteligencji w wielu obszarach. Nasi klienci korzystają z wysokiej jakości, kontekstowych odpowiedzi AI w swoich kanałach komunikacyjnych, generowanych bezpośrednio z danych CRM. Znacznie poprawia to interakcje z klientami, jednocześnie oszczędzając czas i zasoby.

Jesteśmy pod ogromnym wrażeniem modeli AI, a zwłaszcza dostępu do API. Dzięki integracji OpenAI z naszymi rozwiązaniami CRM (BROSH CRM) jesteśmy w stanie zapewnić naszym klientom realną, namacalną wartość dzięki automatyzacji opartej na sztucznej inteligencji. OpenAI umożliwia BROSH CRM dostarczanie zaawansowanych funkcji opartych na sztucznej inteligencji w wielu obszarach. Nasi klienci korzystają z wysokiej jakości, kontekstowych odpowiedzi AI w swoich kanałach komunikacyjnych, generowanych bezpośrednio z danych CRM. Znacznie poprawia to interakcje z klientami, jednocześnie oszczędzając czas i zasoby.

📖 Więcej informacji: Jak korzystać z interfejsu API ChatGPT w swoich aplikacjach

3. Claude API (najlepsze do kodowania o wysokiej stawce i pisania tekstów technicznych wymagających dużej precyzji)

Claude, opracowany przez Anthropic, jest alternatywą dla programistów, którzy priorytetowo traktują dokładność techniczną i „ludzkie” rozumowanie. Claude 4. 5 Sonnet jest powszechnie uważany za najbardziej niezawodny model dla inżynierii oprogramowania, konsekwentnie przewyższający inne modele w testach porównawczych kodowania, takich jak SWE-bench.

Jedną z jego wyróżniających się funkcji jest Claude Code, narzędzie CLI, które pozwala modelowi na bezpośrednią interakcję z lokalnym terminalem i systemem plików w celu debugowania i wysyłania kodu.

Gemini 3 Pro doskonale radzi sobie z przetwarzaniem ogromnych ilości danych jednocześnie (np. godzinowego wideo), ale Claude jest często preferowany do zadań, w których „klimat” i precyzja wyników są ważniejsze niż sama ilość przetwarzanych danych.

Najlepsze funkcje Claude API

- Utrzymuj złożoną logikę projektu za pomocą Claude Projects, które pozwala grupować powiązane dokumenty i kod w celu uzyskania lepszego kontekstu.

- Wykorzystaj buforowanie podpowiedzi, aby znacznie obniżyć koszty i opóźnienia związane z powtarzającymi się żądaniami o dużej objętości.

- Wykonuj i testuj kod w czasie rzeczywistym w środowisku modelu za pomocą narzędzia analitycznego (wykonywanie kodu).

Limity interfejsu API Claude

- Claude nie posiada obecnie natywnych narzędzi do generowania obrazów lub wideo, co wymaga od programistów integracji z API stron trzecich w celu wykonywania kreatywnych zadań wizualnych.

Ceny API Claude

- Claude 4. 5 Opus: 15,00 USD/1 mln danych wejściowych | 75,00 USD/1 mln danych wyjściowych

- Claude 4. 5 Sonnet: 3,00 USD/1 mln danych wejściowych | 15,00 USD/1 mln danych wyjściowych

- Claude 4. 5 Haiku: 1,00 USD/1 mln danych wejściowych | 5,00 USD/1 mln danych wyjściowych

Oceny i recenzje interfejsu API Claude

- G2: 4,4/5 (ponad 55 recenzji)

- Capterra: 4,6/5 (ponad 20 recenzji)

Co użytkownicy mówią o Claude API?

Opłata za korzystanie z API jest wyższa niż w przypadku ChatGPT lub Gemini, ale jeśli chcesz tylko zadawać pytania, możesz po prostu skorzystać z wersji desktopowej, więc nie jest to duży problem. Nie jest to jednak najlepsza opcja, jeśli chcesz włączyć ją do aplikacji.

Opłata za korzystanie z API jest wyższa niż w przypadku ChatGPT lub Gemini, ale jeśli chcesz tylko zadawać pytania, możesz po prostu skorzystać z wersji desktopowej, więc nie jest to duży problem. Nie jest to jednak najlepsza opcja, jeśli chcesz włączyć ją do aplikacji.

📖 Więcej informacji: Jak korzystać z Claude AI w celu wydajnego i dokładnego kodowania

4. Mistral AI (najlepszy pod względem elastyczności otwartej wagi i suwerenności danych)

Mistral AI zapewnia wysokowydajne modele, które stanowią alternatywę dla „zamkniętych” systemów Google i OpenAI. Jest uważany za lidera dla przedsiębiorstw, które wymagają suwerenności danych lub chcą wdrażać modele we własnej prywatnej infrastrukturze.

Flagowe modele Mistral, takie jak Mistral Large 3, zostały zaprojektowane tak, aby były wydajne i „niefiltrowane”, dając programistom większą kontrolę nad zachowaniem modelu w porównaniu z bardziej rygorystycznymi zabezpieczeniami, które często spotyka się w Gemini lub Claude.

Najlepsze funkcje Mistral AI

- Wdrażaj modele na własnym sprzęcie lub w VPC (Virtual Private Cloud), aby zapewnić maksymalną prywatność danych i bezpieczeństwo.

- Użyj Mistral Memories, aby zapisywać i przywoływać kluczowe informacje z różnych sesji bez konieczności ręcznego ponownego wysyłania danych.

- Skorzystaj z katalogu łączników, aby łatwo połączone swoje modele z zewnętrznymi źródłami danych, takimi jak Notion, GitHub i Slack.

Limity Mistral AI

- Dokumentacja i wsparcie społeczności dla Mistral nie są tak rozbudowane jak w przypadku Google lub OpenAI, co może skutkować większą trudnością w nauce dla nowych programistów.

Ceny Mistral AI/AI

- Mistral Large 3: 2,00 USD/1 mln danych wejściowych | 6,00 USD/1 mln danych wyjściowych

- Mistral Small: 0,20 USD/1 mln wejść | 0,60 USD/1 mln wyjść

- Mistral Free: limitowany dostęp do API w celach testowych

Oceny i recenzje Mistral AI

- G2: 4,4/5 (ograniczona liczba początkowych recenzji)

- Capterra: 4,5/5 (ograniczona liczba początkowych recenzji)

Co użytkownicy mówią o Mistral AI w praktyce?

Opinia użytkownika o widoku:

Zapytałem o postać z historii naszego kraju. GEMINI poprawnie rozróżniło dwie bardzo różne osoby o tym samym imieniu i nazwisku: jedną z nich był historyk i profesor uniwersytecki, a drugą bojownik ruchu oporu deportowany podczas II wojny światowej. Mistral AI podał mi tylko opis pierwszej z tych osób.

Zapytałem o postać z historii naszego kraju. GEMINI poprawnie rozróżniło dwie bardzo różne osoby o tym samym imieniu i nazwisku: jedną z nich był historyk i profesor uniwersytecki, a drugą bojownik ruchu oporu deportowany podczas II wojny światowej. Mistral AI podał mi tylko opis pierwszej z tych osób.

📖 Więcej informacji: Najlepsze alternatywy dla Mistral AI dla zaawansowanych modeli językowych

API stały się łatwiejsze dzięki ClickUp

Rozpoczęcie pracy z interfejsem API Google Gemini jest proste: wystarczy uzyskać klucz API, zainstalować SDK i wykonać pierwsze wywołanie API. Jednak wraz z przejściem od prostego skryptu do aplikacji produkcyjnej pojawiają się prawdziwe wyzwania — zarządzanie kluczami API, dokumentowanie podpowiedzi i organizowanie pracy zespołu.

Gemini API zapewnia potężne możliwości AI, ale zintegrowanie go z cyklem pracy może spowodować rozproszenie dokumentacji, fragmentację śledzenia projektów i niekończące się przełączanie kontekstu.

Zespoły, które centralizują rozwój AI wraz z zarządzaniem zadaniami i dokumentacją, działają szybciej i zachowują lepszy kontekst. Wybór miejsca organizacji tej pracy będzie decydował o tym, jak skutecznie możesz wprowadzać innowacje i współpracować.

Rozpocznij bezpłatnie korzystanie z ClickUp i przekonaj się, jak zintegrowany obszar roboczy może zmienić proces rozwoju sztucznej inteligencji.

Często zadawane pytania dotyczące API Gemini

Tak, Google zapewnia hojny bezpłatny pakiet dla Gemini 3 Flash i Pro za pośrednictwem Google AI Studio. Jednak specjalistyczne narzędzia, takie jak Google Search Grounding, są płatne (14 USD za 1000 zapytań) po pierwszych 5000 zapytań w miesiącu.

Google AI Studio to internetowe narzędzie do eksperymentowania z podpowiedziami i szybkiego generowania kluczy API. Gemini API to interfejs programistyczny, którego używasz w swoim kodzie, aby wbudować te możliwości AI w swoje własne aplikacje.

Tak, Gemini API oferuje wsparcie dla rozmów wieloetapowych, co czyni je doskonałym wyborem do tworzenia wewnętrznych chatbotów, botów obsługi klienta lub asystentów zespołów. API służyłoby jako „mózg” chatbota, a interfejs użytkownika byłby tworzony oddzielnie.

Ogórki są ograniczone w zależności od używanego modelu i tego, czy korzystasz z bezpłatnego, czy płatnego pakietu. Bezpłatny pakiet ma niższe ograniczenia szybkości żądań na minutę, podczas gdy płatne plany oferują wyższą przepustowość dla aplikacji produkcyjnych.