Wyszukiwarki zawsze były niezbędne do znajdowania informacji, ale zachowanie użytkowników ewoluowało. Zamiast prostych wyszukiwań słów kluczowych, takich jak "smartfony", ludzie zadają teraz bardziej szczegółowe, spersonalizowane zapytania, takie jak "najlepsze budżetowe telefony do gier". '

Tymczasem duże modele językowe (LLM), takie jak ChatGPT, przekształcają wyszukiwanie, działając jako inteligentne systemy odpowiadające na pytania.

Integrując się z tradycyjnymi wyszukiwarkami, usprawniają wyszukiwanie informacji poprzez generowanie rozszerzone o wyszukiwanie (RAG), dzięki czemu wyniki są bardziej precyzyjne i kontekstowe.

Zamiast konkurować, LLM i wyszukiwarki współpracują ze sobą, aby skuteczniej obsługiwać złożone zapytania. W tym artykule zbadamy, w jaki sposób ta integracja kształtuje przyszłość wyszukiwania.

60-sekundowe podsumowanie

- Tradycyjne wyszukiwarki często borykają się z zarządzaniem dużymi zbiorami danych, utrzymywaniem jakości danych i rozbijaniem silosów

- Stoją one również przed wyzwaniami związanymi z bezpieczeństwem, skalowalnością i dostarczaniem odpowiednich kontekstowo wyników

- Duże modele językowe, takie jak ChatGPT, zwiększają dokładność wyszukiwania, umożliwiają wyszukiwanie semantyczne i wsparcie zapytań w języku naturalnym

- LLM poprawiają również możliwości wyszukiwania multimodalnego i sprawiają, że odkrywanie wiedzy jest bardziej spersonalizowane i wydajne

- ClickUp Connected Search i możliwości AI opierają się na tych postępach, centralizując dane, umożliwiając szybkie i dokładne wyszukiwanie informacji

- ClickUp płynnie integruje się z różnymi platformami, zapewniając dostęp do zawartości w czasie rzeczywistym, usprawniając cykl pracy i poprawiając ogólną wydajność

Bez zbędnych ceregieli, przejdźmy od razu do rzeczy!

Czym są wyszukiwarki LLM?

Duże modele językowe (LLM) to zaawansowane systemy sztucznej inteligencji, które przetwarzają i generują ludzki język. Są one szkolone na rozszerzonych zbiorach danych tekstowych, dzięki czemu mogą obsługiwać takie zadania, jak tłumaczenie, streszczanie i konwersacje.

Niektóre z najpopularniejszych przykładów LLM obejmują GPT-3 i GPT-4, które są powszechnie znane ze swojej zdolności do obsługi złożonych zapytań związanych z językiem.

W przeciwieństwie do tradycyjnych wyszukiwarek, które zależą od słów kluczowych, wyszukiwarka oparta na LLM wykracza poza zapytania na poziomie powierzchni. Rozumie kontekst i intencje kryjące się za pytaniami, dostarczając bezpośrednich i szczegółowych odpowiedzi.

71% użytkowników preferuje personalizację od marek i firm, które wybierają.

Funkcje wyszukiwarek LLM

Wyszukiwarki LLM oferują zaawansowane możliwości, które na nowo definiują sposób, w jaki użytkownicy Internetu uzyskują dostęp do informacji i wchodzą z nimi w interakcję. Przyjrzyjmy się ich kluczowym funkcjom:

- Zrozumienie zapytań semantycznych: Wyszukiwarki LLM interpretują znaczenie zapytań, wykraczając poza słowa kluczowe, aby zrozumieć intencje i kontekst użytkownika

- Przetwarzanie języka naturalnego (NLP): Użytkownicy mogą formułować zapytania w sposób konwersacyjny, bez konieczności podawania dokładnych słów kluczowych, dzięki czemu wyszukiwanie jest bardziej intuicyjne

- Trafność kontekstowa: Wyniki wyszukiwania są personalizowane na podstawie wcześniejszych zapytań i interakcji, zapewniając bardziej trafne i aktualne informacje

- Generowanie odpowiedzi: Systemy te zapewniają kompleksowe odpowiedzi bezpośrednio w wynikach wyszukiwania, w tym podsumowania, wyjaśnienia, a nawet kreatywne formaty, takie jak historie lub przewodniki krok po kroku

- Integracja grafów wiedzy: Wyszukiwarki LLM wykorzystują grafy wiedzy do połączenia powiązanych pojęć i jednostek, oferując głębszy wgląd w dane

- Wyszukiwanie konwersacyjne: Użytkownicy mogą angażować się w dialog, zadając kolejne pytania i udoskonalając swoje wyszukiwania w celu uzyskania bardziej interaktywnego doświadczenia

- Adaptacyjne wyniki: Wyniki dynamicznie dostosowują się do lokalizacji, odsetków i poprzednich wyszukiwań, zapewniając bardziej spersonalizowane wrażenia

- Synteza informacji: Zamiast polegać na jednym źródle, wyszukiwarki LLM agregują dane z wielu źródeł, zapewniając szerszą perspektywę

Dzięki rosnącemu wykorzystaniu inteligentnych głośników i asystentów głosowych, 50% wszystkich wyszukiwań odbywa się obecnie za pomocą głosu. Ponieważ duże modele językowe są zintegrowane z tymi systemami, wyszukiwanie głosowe stanie się jeszcze dokładniejsze, zapewniając szybszy dostęp do informacji na wielu platformach - niezależnie od tego, czy są to pliki, zadania czy notatki ze spotkań.

Zaawansowane techniki wyszukiwania z wykorzystaniem LLM

Wraz z rozwojem technologii wyszukiwania, modele LLM, takie jak GPT-4, BERT i T5, zmieniają sposób, w jaki wyszukiwarki przetwarzają zapytania, personalizują wyniki i udoskonalają rankingi. Przyjrzyjmy się, w jaki sposób modele te redefiniują przyszłość wyszukiwania.

Jak LLM wysyłają zapytania wyszukiwania

Wyszukiwanie ewoluowało od prostych zapytań o słowa kluczowe do semantycznych wyszukiwań wektorowych. Zamiast szukać konkretnego terminu, takiego jak "góra Fuji", użytkownicy mogą wyszukiwać "góry w Japonii", a system pobiera wyniki oparte na znaczeniu.

Przeformułowanie zapytań w pytania, takie jak "Jakie są słynne góry w Japonii? ", może poprawić dokładność wyszukiwania. Duże modele językowe (LLM) również usprawniają wyszukiwanie, wyzwalając dodatkowe zapytania, jeśli zaufanie jest niskie, przy użyciu technik takich jak FLARE.

Rozumowanie łańcuchowe dodatkowo usprawnia wyszukiwanie, dzieląc zadania na logiczne kroki, jak widać w AutoGPT. Ponadto wyszukiwanie konwersacyjne pozwala asystentom LLM udoskonalać zapytania w czasie rzeczywistym, zapewniając bardziej precyzyjne wyniki podczas interakcji.

Spersonalizowane wyszukiwanie i świadomość kontekstu

Świadomość kontekstowa to jedna z najpotężniejszych funkcji wyszukiwarek LLM. W przeciwieństwie do tradycyjnych wyszukiwarek, które szeregują wyniki według dopasowania słów kluczowych, LLM uwzględniają intencje użytkownika, lokalizację, historię wyszukiwania i wcześniejsze interakcje.

Dostosowując się do danych specyficznych dla danej domeny, LLM personalizują wyniki wyszukiwania, rozpoznając wzorce i nadając priorytet odpowiedniej zawartości. Przykładowo, użytkownik często szukający przepisów wegańskich zobaczy opcje roślinne, gdy będzie szukał "najlepszych przepisów na obiad". '

Wyszukiwarki LLM interpretują również zapytania multimodalne, rozumiejąc zarówno tekst, jak i obrazy w celu uzyskania dokładniejszych wyników. Ponadto budują kontekst podłużny, ucząc się na podstawie bieżących interakcji, aby proaktywnie sugerować odpowiednie zapytania.

LLM w zmianie rankingu i poprawie wyników wyszukiwarek

LLM udoskonalają wyszukiwarki poprzez dynamiczną zmianę rankingu wyników w celu lepszego odzwierciedlenia intencji użytkownika. W przeciwieństwie do tradycyjnego rankingu opartego na słowach kluczowych, LLM wykorzystują mechanizmy uwagi do analizowania pełnego kontekstu zapytania i nadawania priorytetu odpowiedniej zawartości.

Na przykład aktualizacja BERT (Bidirectional Encoder Representations from Transformers) firmy Google zrewolucjonizowała wyszukiwanie poprzez zrozumienie kontekstu słów takich jak "apple" (owoc) vs. "Apple" (firma technologiczna).

LLM przyczyniają się również do poprawy wydajności SERP (Search Engine Results Page). Analizując czynniki takie jak współczynnik klikalności (CTR), współczynnik odrzuceń i czas przebywania, LLM mogą dostosowywać oceny w czasie rzeczywistym, zwiększając wyniki, które zapewniają wysokie zaangażowanie użytkowników.

Przeczytaj również: Jak szybko przeszukiwać pliki PDF

Popularne narzędzia wyszukiwarek LLM

W miarę rozwoju wyszukiwania opartego na AI, kilka dużych wyszukiwarek modeli językowych zyskuje na popularności dzięki swoim zaawansowanym możliwościom. Perplexity AI dostarcza bezpośrednich odpowiedzi z cytowanymi źródłami, czyniąc wyszukiwanie bardziej interaktywnym i bogatym w informacje.

You. com oferuje konfigurowalne doświadczenie, pozwalając użytkownikom na priorytetyzację źródeł, integrację podsumowań generowanych przez AI i interakcję z asystentami AI.

Wszyscy wiemy, że możemy skorzystać z tych wyszukiwarek, aby uzyskać informacje i szybkie odpowiedzi. Ale co z lokalizacją tego jednego kluczowego pliku w pracy? Albo wyciągnięcie rozmowy pełnej punktów danych do następnej ważnej prezentacji?

To właśnie tutaj ClickUp, wszystko aplikacja do pracy, wkracza do akcji!

📮 ClickUp Insight: 46% pracowników wiedzy korzysta z czatu, notatek, narzędzi do zarządzania projektami i dokumentacji zespołu, aby śledzić swoją pracę. Dla nich praca jest rozproszona na różnych platformach, co utrudnia utrzymanie porządku. Jako aplikacja do wszystkiego, ClickUp ujednolica to wszystko. Dzięki funkcjom takim jak ClickUp Email Project Management, ClickUp Notes, ClickUp Chat i ClickUp Brain, cała praca jest scentralizowana w jednym miejscu, z możliwością wyszukiwania i bezproblemowego połączenia. Pożegnaj się z nadmiarem narzędzi - powitaj wydajność bez wysiłku.

ClickUp Brain łączy zaawansowane możliwości wyszukiwania z kompleksowymi funkcjami zarządzania projektami, łącząc zadania, pliki, członków zespołu i projekty w jednym miejscu. Koniec z przełączaniem się między aplikacjami lub radzeniem sobie z rozdrobnionymi narzędziami i silosami informacyjnymi!

Koszty nieefektywności wynikające z niepołączonych narzędzi są oszałamiające:

- 2. 5 godzin dziennie: Pracownicy umysłowi spędzają około 30% swojego dnia pracy na wyszukiwaniu informacji

- 3600 przełączeń aplikacji/dzień: Pracownicy przełączają się między aplikacjami i oknami ponad 3600 razy dziennie, tracąc na to 4 godziny tygodniowo

- 23 minuty stracone: Każde przełączenie aplikacji zakłóca koncentrację, a powrót na właściwe tory zajmuje prawie 23 minuty

420 000 USD rocznie: Organizacje zatrudniające 100 pracowników tracą tę kwotę każdego roku z powodu błędnej komunikacji i niepołączonych narzędzi

Te nieefektywności prowadzą do utraty czasu, spadku morale i wzrostu kosztów operacyjnych. Na szczęście Connected AI przekształca te wyzwania w możliwości inteligentniejszego podejmowania decyzji, szybszego wyszukiwania informacji i płynnego wykonywania zadań.

Oto jak połączone wyszukiwanie ClickUp przekształca współpracę:

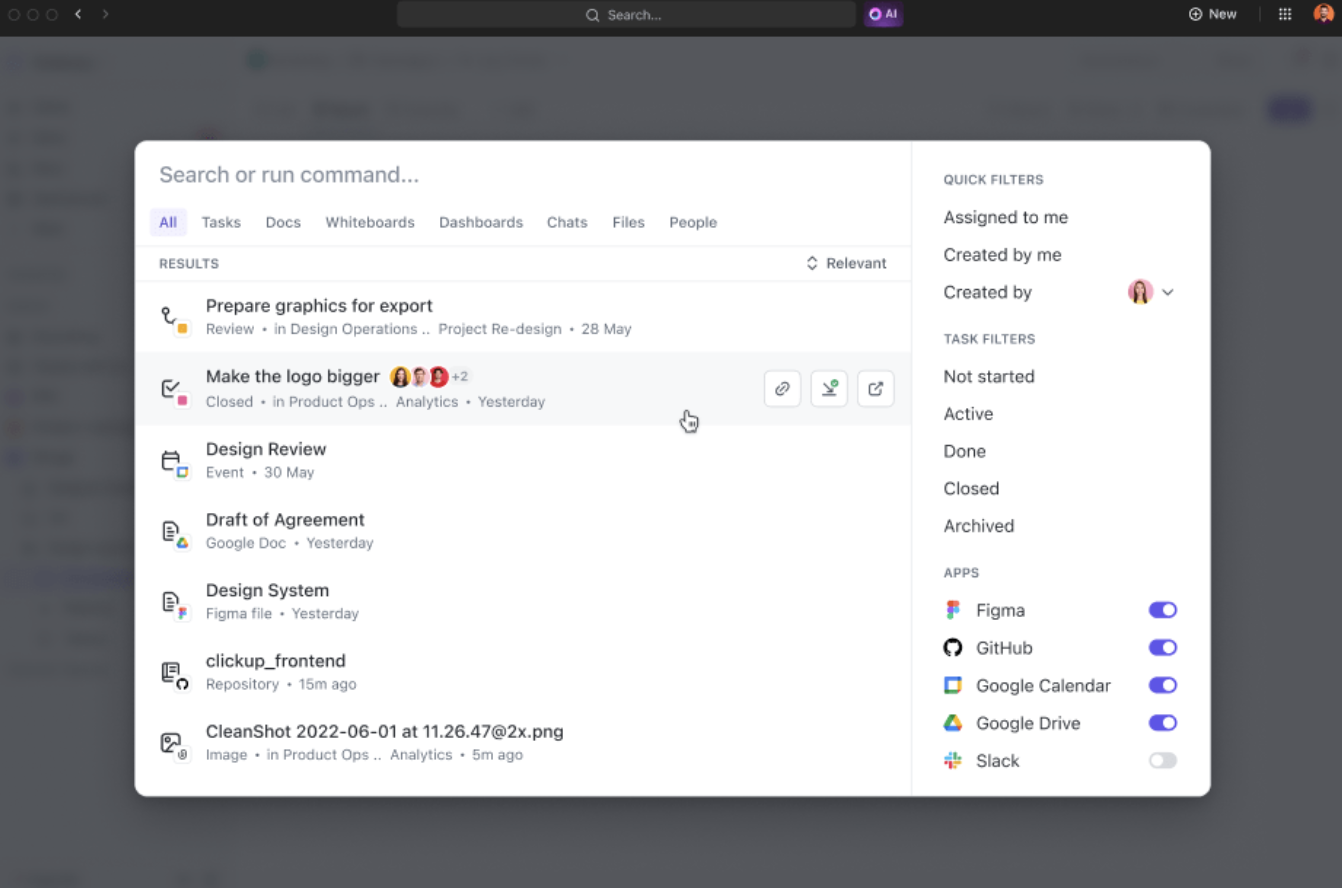

- Ujednolicone wyszukiwanie: Dostęp do wszystkich informacji Enterprise z jednej platformy, co pozwala zaoszczędzić prawie cztery godziny tygodniowo dzięki ograniczeniu przełączania aplikacji

- Istotność oparta na AI: Uzyskaj spersonalizowane, kontekstowe wyniki wyszukiwania dostosowane do Twoich projektów, usprawniając podejmowanie decyzji dzięki natychmiastowemu dostępowi do najistotniejszych informacji

- Łatwa integracja z narzędziami: Płynne połączenie z istniejącymi narzędziami, takimi jak Google Drive, SharePoint, Figma i Slack, bez konieczności skomplikowanych ustawień

Na przykład, po powrocie z urlopu wystarczy poprosić ClickUp Brain o aktualizacje dotyczące projektów. Dostarczy on starannie zorganizowane wypunktowania z krytycznymi elementami działań i dyskusjami, które miały miejsce podczas Twojej nieobecności.

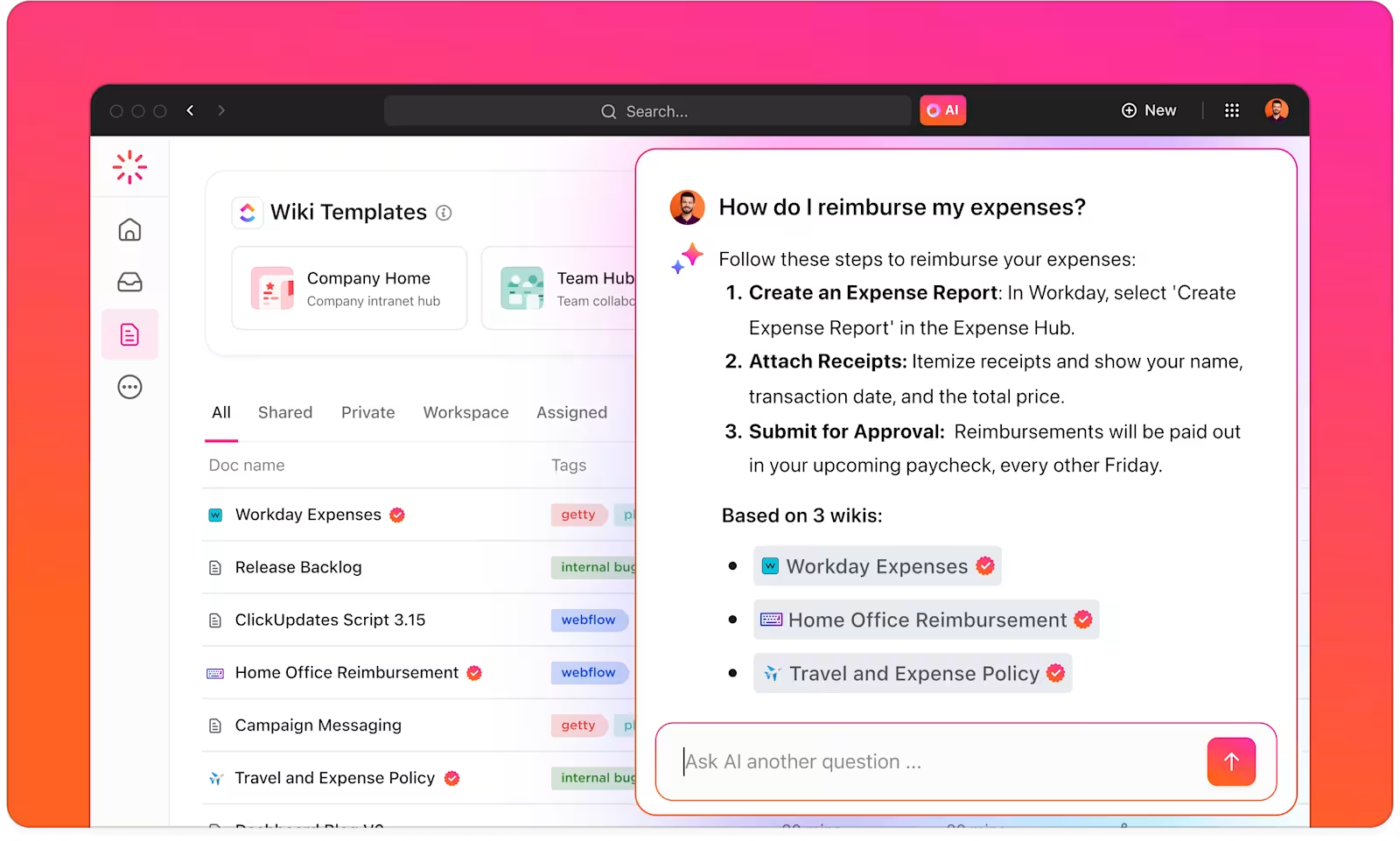

ClickUp Brain to inteligentny menedżer wiedzy, który pomaga znaleźć wszystko w obszarze roboczym i połączonych aplikacjach.

ClickUp Brain rozumie kontekst Twoich zadań i oferuje odpowiednie sugestie w oparciu o Twoje preferencje pracy lub główne działania. Dla dostawców treści, na przykład, zapewnia sugestie dotyczące danych powstania, burzy mózgów i powiązanych zadań.

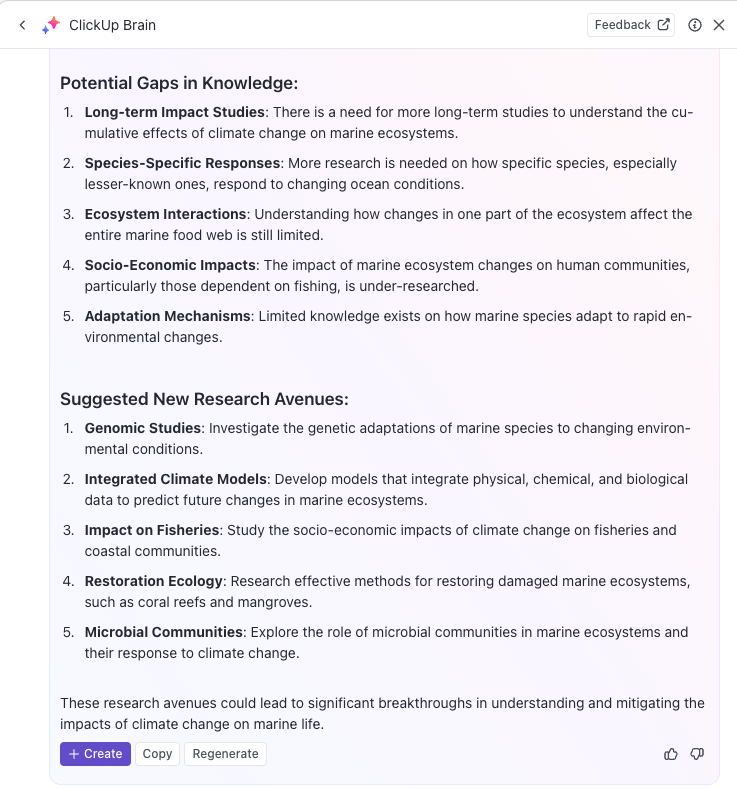

Możesz nawet użyć AI do automatyzacji powtarzalnych zadań lub aktualizacji statusów zadań za pomocą prostych podpowiedzi, pozwalając ci skupić się na głębokiej pracy. Jeśli szukasz potężnej wyszukiwarki AI, która zwiększy wydajność, ClickUp Brain jest dla Ciebie.

Dzięki ClickUp Brain możesz zoptymalizować swoją bazę wiedzy poprzez automatyczne kategoryzowanie, etykietowanie i organizowanie wszystkich istotnych informacji.

Na przykład, Teams badawcze mogą wykorzystać ClickUp do stworzenia scentralizowanego systemu zarządzania wiedzą, aby przechowywać wszystkie spostrzeżenia, dokumenty i wyniki badań w łatwo dostępnym formacie.

Co więcej, wszechstronność ClickUp Docs stanowi wsparcie dla powstania wiki, repozytoriów dokumentów i zarządzania zadaniami związanymi z wiedzą.

Możesz także organizować informacje na różne sposoby, używając przestrzeni ClickUp, folderów i list do strukturyzowania zawartości w celu szybkiego wyszukiwania. Teams może łatwo znaleźć i uzyskać dostęp do właściwych danych, gdy są potrzebne, bez marnowania czasu na przeszukiwanie wielu platform.

Ponadto platforma pomaga śledzić zadania i projekty za pośrednictwem ClickUp Tasks w oparciu o spostrzeżenia uzyskane z wyszukiwarek LLM. Wyniki wyszukiwania oparte na AI można zintegrować bezpośrednio z przepływami pracy związanymi ze śledzeniem zadań i projektów, co ułatwia wdrażanie odkrytej wiedzy.

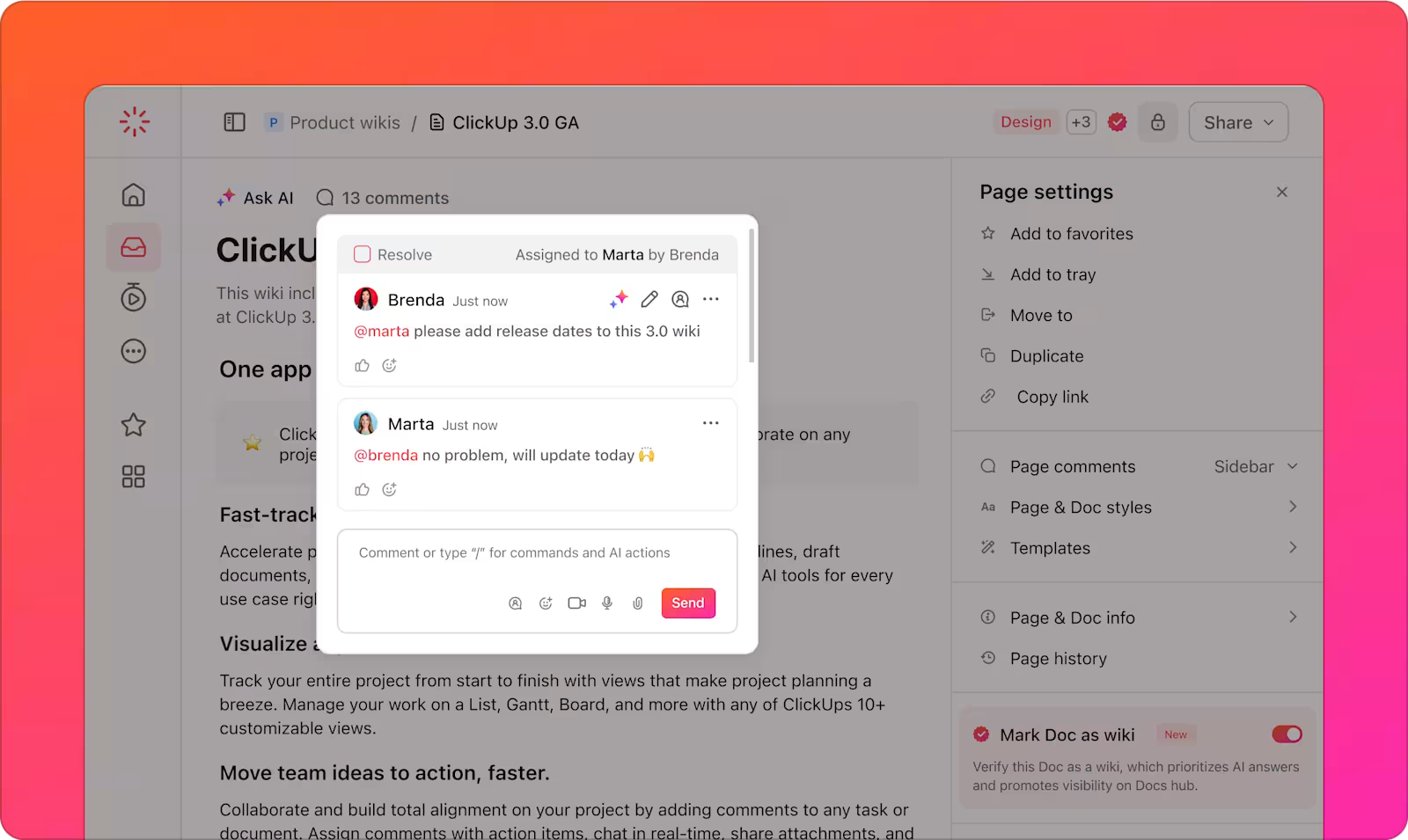

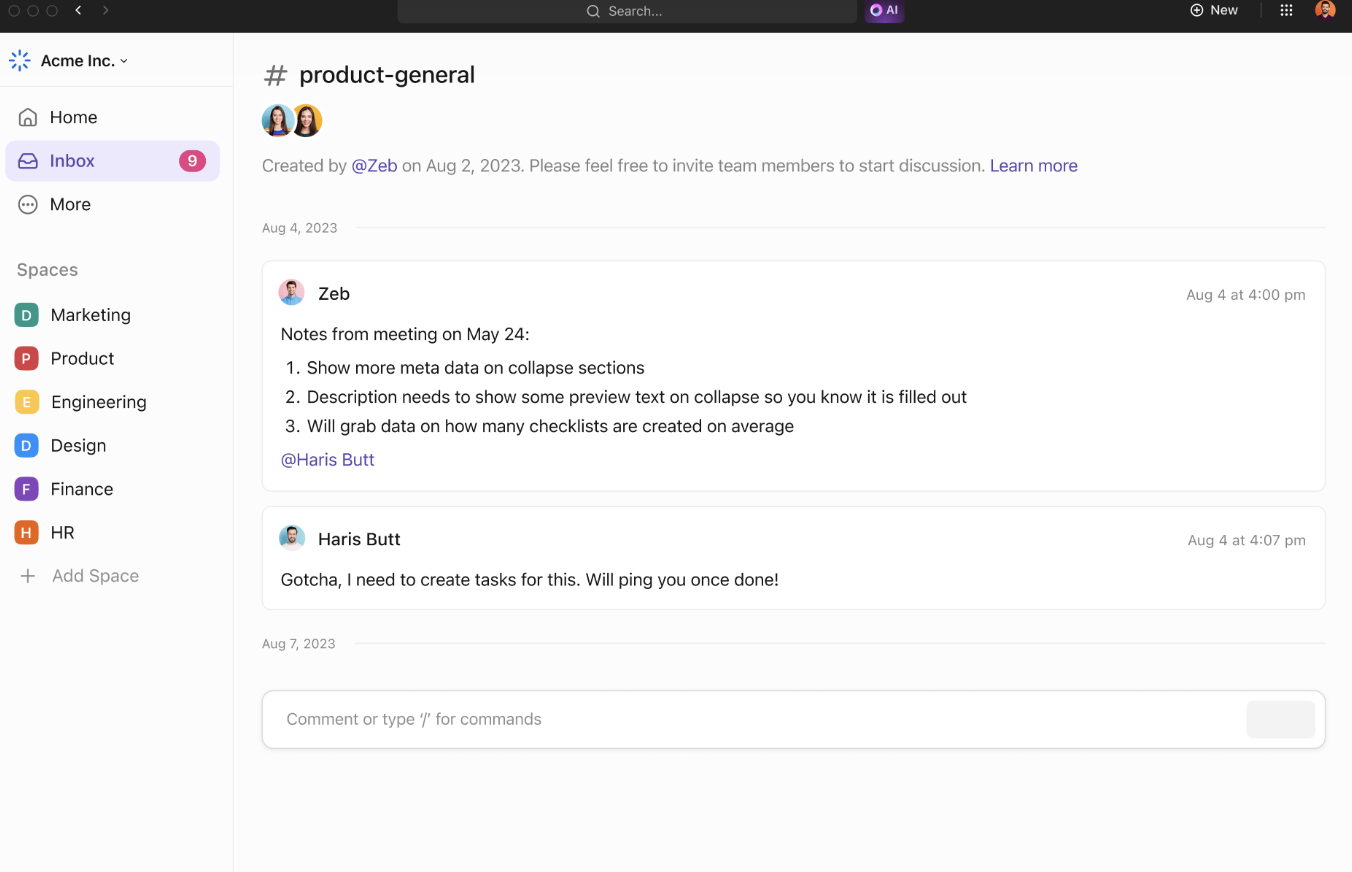

Narzędzia do współpracy ClickUp dodatkowo wspierają wydajność zespołu i udostępnianie informacji. ClickUp Chat umożliwia członkom zespołu omawianie projektów, udostępnianie spostrzeżeń i zadawanie pytań w czasie rzeczywistym.

Przypisane komentarze zapewniają przejrzysty sposób komunikowania się na temat konkretnych dokumentów lub zadań, dzięki czemu wszyscy są na bieżąco z aktualizacjami projektu.

Teams mogą współpracować, udostępniając pomysły i wizualizując koncepcje. Dodawaj notatki, przesyłaj obrazy i osadzaj połączone linki, aby uzyskać lepszy kontekst. Użyj łączników, aby połączyć pomysły i podkreślić ich relacje.

Gdy Twoje pomysły będą gotowe, przekształć je w zadania, które można śledzić za pomocą ClickUp Whiteboards, aby wszystko przebiegało zgodnie z harmonogramem.

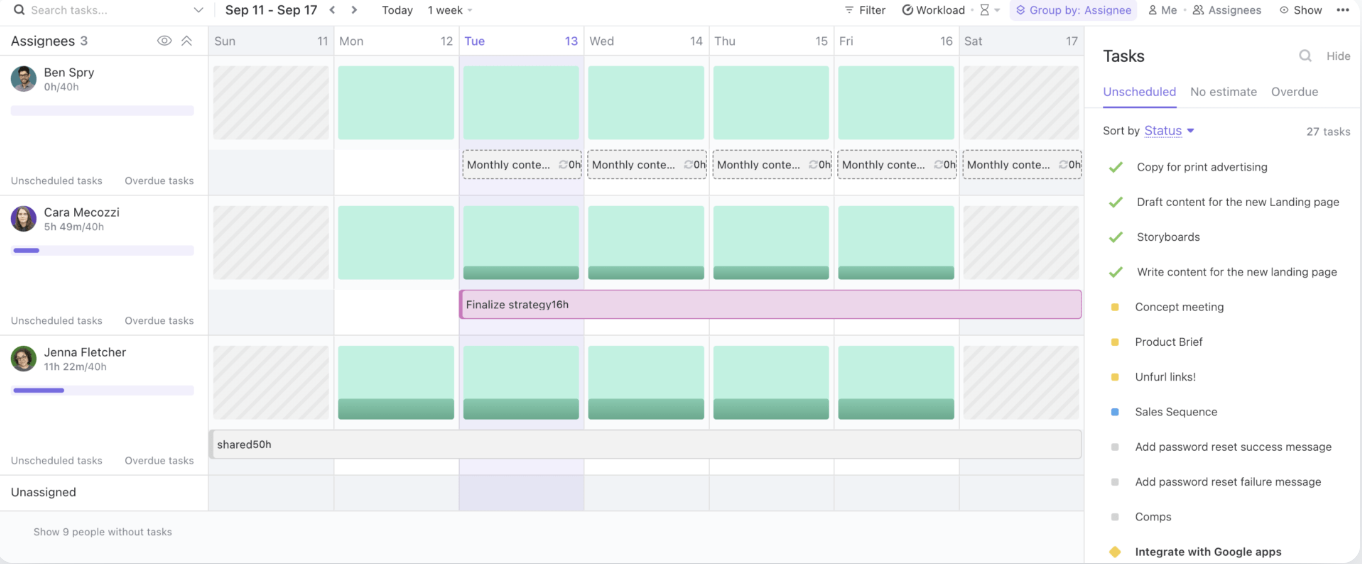

Wreszcie, widok obciążenia pracą ClickUp pozwala zarządzać obciążeniem zespołu, śledzić bieżące zadania i efektywnie przydzielać zasoby.

Zapewniając scentralizowany hub do udostępniania wiedzy i współpracy, ClickUp usprawnia cykle pracy i poprawia wydajność zespołu.

Przeczytaj również: Najlepsze oprogramowanie do zarządzania dokumentami

Najlepsze praktyki korzystania z wyszukiwarek LLM

Podczas korzystania z wyszukiwarek LLM niezbędne jest przestrzeganie najlepszych praktyk, które maksymalizują ich potencjał przy jednoczesnym zarządzaniu ryzykiem.

Strategie te pomogą Ci w pełni wykorzystać narzędzia oparte na AI, zapewniając płynne wdrożenie i długoterminowe powodzenie:

- Zdefiniuj jasne przypadki użycia: Współpracuj na wczesnym etapie między zespołami biznesowymi i technicznymi, aby ustalić konkretne, wymierne przypadki użycia. Dostosuj cele, aby upewnić się, że rozwiązanie spełnia właściwe potrzeby i ułatwia ocenę postępów

- Podczas ustalania priorytetów przypadków użycia należy wziąć pod uwagę wrażliwość danych, potencjalne ryzyko i zamierzonych użytkowników. Stosuj podejście oparte na ryzyku, aby ocenić, które projekty zapewniają największą wartość przy minimalnych szkodach

- Skupienie się na gromadzeniu, testowaniu i walidacji danych: Zapewnienie solidnych, opartych na faktach danych poprzez poprawę praktyk gromadzenia, etykietowania, przechowywania i przetwarzania danych

- Wdrożenie ustandaryzowanych procedur testowych: Twórz powtarzalne procesy testowania przy wsparciu playbooków i predefiniowanych praktyk. Zapewnienie spójnych wyników, niezawodności systemu i dobrze przetestowanych modeli AI przed wdrożeniem

- Ustawienie ciągłego monitorowania: Monitoruj wydajność systemu w czasie, dostosowując się do zmieniających się danych, zachowań użytkowników i technologii

- Przeprowadzenie kampanii szkoleniowych i komunikacyjnych: Wyposaż swój zespół w wiedzę umożliwiającą odpowiedzialne i skuteczne korzystanie z narzędzi AI. Uruchomienie programów szkoleniowych i komunikacyjnych obejmujących zarówno techniczne, jak i etyczne aspekty AI

Wyzwania i rozwiązania w wyszukiwaniu opartym na LLM

Wyszukiwarki oparte na LLM oferują ogromny potencjał, ale wiążą się również z własnym zestawem wyzwań. Poniżej przedstawiamy kilka typowych wyzwań związanych ze sztuczną inteligencją i praktyczne rozwiązania pozwalające im sprostać:

Jakość i trafność danych

Wyszukiwarki oparte na LLM w dużej mierze polegają na jakości i trafności przetwarzanych danych. Słabe lub nieaktualne dane mogą prowadzić do niedokładnych lub nieistotnych wyników wyszukiwania, wpływając na wrażenia użytkownika.

koncentrując się na wysokiej jakości, aktualnych danych, organizacje mogą zapewnić, że ich wyszukiwarka oparta na LLM zwraca trafne i wiarygodne wyniki.

Brak przejrzystości

Modele LLM są często uważane za "czarne skrzynki", w których rozumowanie stojące za ich wynikami nie jest od razu widoczne dla użytkowników. Ten brak przejrzystości może utrudniać użytkownikom zaufanie do otrzymywanych wyników.

włączając funkcje wyjaśniające do wyszukiwarki, organizacje mogą dać użytkownikom wgląd w to, dlaczego zwrócono określone wyniki.

Stronniczość i kwestie etyczne

Wyszukiwarki LLM mogą dziedziczyć uprzedzenia z danych, na których są szkolone, co może prowadzić do wypaczonych lub nieetycznych wyników. Jeśli dane szkoleniowe nie są zróżnicowane lub reprezentatywne, wyszukiwarka może odzwierciedlać te uprzedzenia, wpływając na podejmowanie decyzji i sprawiedliwość.

regularne audytowanie i aktualizowanie danych szkoleniowych ma zasadnicze znaczenie dla identyfikacji i łagodzenia tych uprzedzeń. Ponadto uwzględnianie różnorodnych zbiorów danych i monitorowanie wyników zapewnia, że wyszukiwarka generuje bardziej zrównoważone, sprawiedliwe i etyczne wyniki.

Złożoność i integracja systemu

Integracja wyszukiwarek opartych na LLM z istniejącymi cyklami pracy i aplikacjami może być zniechęcająca, zwłaszcza gdy mamy do czynienia ze starszymi wersjami systemów lub wieloma źródłami danychZłożoność połączenia tych nowych narzędzi z istniejącymi platformami może spowolnić wdrożenie.

połączone wyszukiwanie ClickUp pozwala szybko znaleźć dowolny plik, niezależnie od tego, czy jest on przechowywany w ClickUp, połączonej aplikacji, czy na dysku lokalnym.

Problem halucynacji

Halucynacje odnoszą się do instancji, w których model generuje niepoprawne, sfabrykowane lub nieistotne informacje. Dzieje się tak, ponieważ model, zamiast czerpać bezpośrednio z indeksowanych źródeł, czasami "halucynuje" dane w oparciu o wzorce wyuczone podczas szkolenia.

zaawansowane techniki, takie jak inżynieria podpowiedzi i wysokiej jakości dane szkoleniowe, zwiększają niezawodność LLM. Dostrajanie za pomocą danych specyficznych dla danej domeny zmniejsza liczbę halucynacji, a integracja grafów wiedzy zapewnia dokładne wyniki wyszukiwania oparte na faktach.

Przeczytaj również: Jak stworzyć obszar roboczy do współpracy, aby zmaksymalizować wydajność?

Przyszłość wyszukiwania dzięki LLM

Następna generacja wyszukiwania opartego na LLM obiecuje jeszcze większą precyzję, zdolność adaptacji i szybkość reakcji, szczególnie w przypadku obsługi złożonych i dynamicznych zapytań użytkowników. Systemy te będą dynamicznie dostosowywać się do zmieniających się potrzeb użytkowników, ucząc się na podstawie wcześniejszych interakcji i danych w czasie rzeczywistym.

Na przykład, w ustawieniu Enterprise, LLM może zinterpretować zapytanie typu "Znajdź analizę rezygnacji klientów z ostatniego kwartału" i zwrócić nie tylko nieprzetworzony plik, ale także zsyntetyzowane spostrzeżenia, istotne trendy i praktyczne wnioski.

Branże zależne od zarządzania ogromnymi i skomplikowanymi zestawami danych mogą zyskać najwięcej:

- W służbie zdrowia duże modele językowe mogą wesprzeć precyzję diagnostyki, analizując i porównując notatki kliniczne, wyniki obrazowania i artykuły naukowe w ciągu kilku sekund

- Specjaliści w dziedzinie prawa skorzystają z narzędzi, które mogą analizować rozszerzone orzecznictwo w celu wyróżnienia istotnych precedensów

- Zespoły finansowe mogą wykorzystywać LLM do takich zadań, jak wykrywanie oszustw w czasie rzeczywistym, predykcyjna analiza rynku i automatyzacja kontroli zgodności z przepisami

Integracja multimodalnych możliwości wyszukiwania - łączących rozpoznawanie tekstu, głosu i obrazu - jeszcze bardziej zwiększy użyteczność LLM.

Przykładowo, Teams współpracujący nad wprowadzeniem produktu na rynek może błyskawicznie przesyłać obrazy, dodawać adnotacje za pomocą poleceń głosowych oraz wyszukiwać powiązane dokumenty i raporty. Ten poziom adaptacyjności sprawia, że LLM ma kluczowe znaczenie dla zapewnienia płynnego dostępu do różnych formatów danych.

Platformy takie jak ClickUp, w połączeniu z wyszukiwaniem opartym na LLM, oferują solidne rozwiązanie do organizowania i uzyskiwania dostępu do plików, optymalizacji cyklu pracy i zwiększania wydajności podejmowania decyzji.

Zwiększ wydajność cyklu pracy dzięki wyszukiwaniu opartemu na LLM

W miarę jak wyszukiwarki oparte na sztucznej inteligencji LLM wciąż ewoluują, rewolucjonizują sposób, w jaki Business pozyskuje informacje ze stron internetowych i zarządza danymi.

Dzięki zdolności do rozumienia kontekstu, dostarczania dokładniejszych wyników i płynnej integracji z cyklami pracy Enterprise, LLM torują drogę do inteligentniejszych, szybszych i bardziej wydajnych operacji.

A gdy szukasz wyszukiwarki AI płynnie zintegrowanej z Twoim cyklem pracy, nic nie przebije ClickUp AI Brain. Niezależnie od tego, czy potrzebujesz szybko zlokalizować plik lub zadanie, przeprowadzić burzę mózgów, czy nawet zredagować e-mail, potężne możliwości ClickUp Brain w zakresie AI poradzą sobie ze wszystkim.

Integracja z kompleksowymi narzędziami do zarządzania projektami ClickUp zapewnia, że wszystko jest w zasięgu ręki, pomagając zachować porządek, zaoszczędzić czas i szybciej podejmować decyzje oparte na danych.

Na co więc czekasz? Zarejestruj się w ClickUp już dziś i zrób więcej dzięki ClickUp Brain!