La maggior parte degli sviluppatori è in grado di far funzionare l'API Gemini in meno di 10 minuti.

La vera sfida arriva dopo la configurazione.

Questa guida ti mostra come ottenere la tua chiave API, installare l'SDK ed effettuare la tua prima richiesta.

Imparerai anche come mantenere organizzati i tuoi flussi di lavoro API, in modo che il tuo team non perda tempo a reinventare soluzioni o a cercare documentazione.

Cos'è l'API Gemini?

L'API Gemini è l'interfaccia di Google per accedere alla sua famiglia di modelli di IA multimodali, che consente agli sviluppatori di integrare la generazione di testo, la comprensione delle immagini, l'assistenza al codice e l'IA di conversazione nelle applicazioni.

È progettato per team di prodotto, ingegneri e aziende che desiderano aggiungere potenti funzionalità di IA ai propri prodotti senza dover creare da zero modelli linguistici di grandi dimensioni.

I modelli linguistici di grandi dimensioni di Gemini, come Gemini 3 Flash e Gemini 3 Pro, sono multimodali, il che significa che possono gestire diversi tipi di input, inclusi testo, immagini, audio e video. L'API stessa utilizza l'architettura REST API , che è un modo standard per i sistemi informatici di comunicare su Internet.

Per rendere tutto ancora più semplice, Google fornisce kit di sviluppo software (SDK) per linguaggi popolari come Python, JavaScript e Go. È utile comprendere la differenza tra l'API e Google AI Studio.

| Utilizzo principale | Applicazioni di produzione | Prototipazione e test |

| Metodo di accesso | Chiamate SDK basate sul codice | Interfaccia visiva basata sul web |

| Ideale per | Sviluppatori che creano app | Sperimentare con i prompt |

💡Suggerimento professionale: conserva tutto il contesto del tuo progetto in un unico posto ed evita di cercare informazioni in diversi strumenti creando una knowledge base interna per i tuoi progetti di IA. Con ClickUp Docs, puoi collegare frammenti di codice e documentazione API direttamente alle attività del tuo team, eliminando la proliferazione di strumenti e accelerando l'adozione dell'IA.

Come ottenere la tua chiave API Gemini

Il tuo team potrebbe essere pronto per iniziare a creare, ma prima hai bisogno di una chiave API.

Per utilizzare l'API Gemini, è necessaria una chiave per l'autenticazione delle richieste e la gestione di queste chiavi è il primo passaggio per una gestione più fluida del flusso di lavoro. Per iniziare è necessario un account Google.

Ecco come ottenere la tua chiave:

- Vai a Google IA Studio

- Accedi con il tuo account Google

- Clicca su Ottieni chiave API nella barra laterale sinistra.

- Seleziona Crea chiave API in un nuovo progetto o scegli un progetto Google Cloud esistente.

- Copia immediatamente la chiave generata e conservala in una posizione sicura.

La tua chiave API ti garantisce l'accesso alla tua quota Gemini e alla fatturazione: trattala come una password. 🔑

La tua chiave API ti garantisce l'accesso alla tua quota Gemini e alla fatturazione: trattala come una password. 🔑

Per i team più grandi, puoi anche gestire le chiavi tramite Google Cloud Console, che offre controlli più avanzati.

Come installare l'SDK Gemini

Un nuovo sviluppatore si unisce al tuo progetto di IA, ma trascorre il suo primo giorno alle prese con la configurazione dell'ambiente invece di scrivere codice.

La loro versione Python è errata, oppure manca una dipendenza, causando il classico mal di testa da "sul mio computer funziona".

Questo è spesso il motivo per cui gli sviluppatori perdono 3 ore alla settimana. Tali incongruenze rallentano l'onboarding e introducono bug imprevedibili che fanno perdere tempo prezioso agli ingegneri.

Un SDK, o Software Development Kit, semplifica queste interazioni API gestendo per te l'autenticazione, la formattazione delle richieste e l'analisi delle risposte. Per evitare problemi di configurazione, il tuo team ha bisogno di un processo standardizzato e documentato per l'installazione dell'SDK Gemini.

Ecco come installarlo per gli ambienti più comuni.

Per Python:

- Nota: è necessario Python 3. 9 o versioni successive. L'utilizzo di un ambiente virtuale è una best practice per evitare conflitti con altri progetti.

Per JavaScript/Node. js:

- Nota: questo è destinato all'uso in un ambiente Node. js.

Dopo l'installazione, devi configurare la tua chiave API come variabile di ambiente. In questo modo la tua chiave sarà sicura e non sarà visibile nel tuo codice sorgente.

- Su Mac/Linux: esporta GEMINI_API_KEY="la tua chiave API qui"

- Su Windows: setx GEMINI_API_KEY "la tua chiave API qui"

Hai diverse opzioni per quanto riguarda l'SDK da utilizzare:

- SDK Python: la scelta più popolare, con una documentazione completa. È ideale per la scienza dei dati e le applicazioni backend.

- SDK JavaScript: la scelta migliore per creare applicazioni web e backend Node.js.

- Go SDK: un'ottima scelta per gli sviluppatori che creano microservizi ad alte prestazioni in Go.

- API REST: se utilizzi un linguaggio senza SDK ufficiale, puoi sempre effettuare richieste HTTP dirette all'API REST.

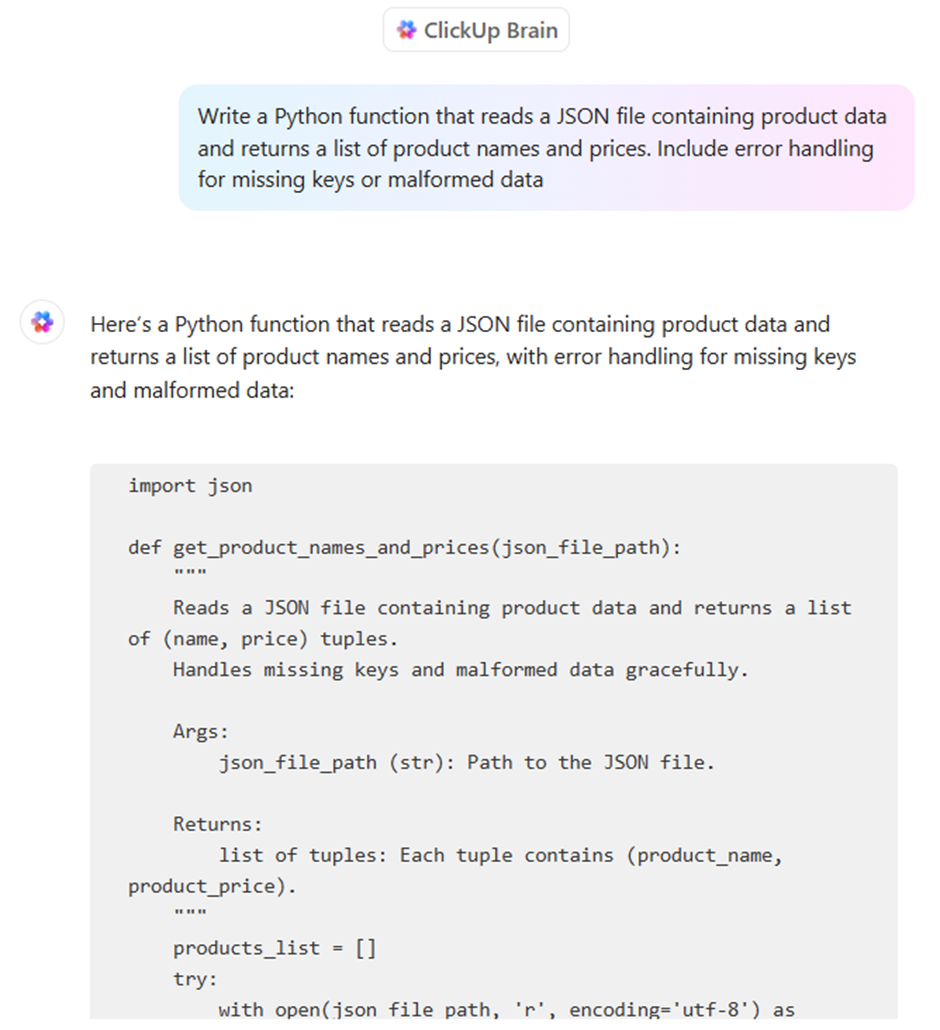

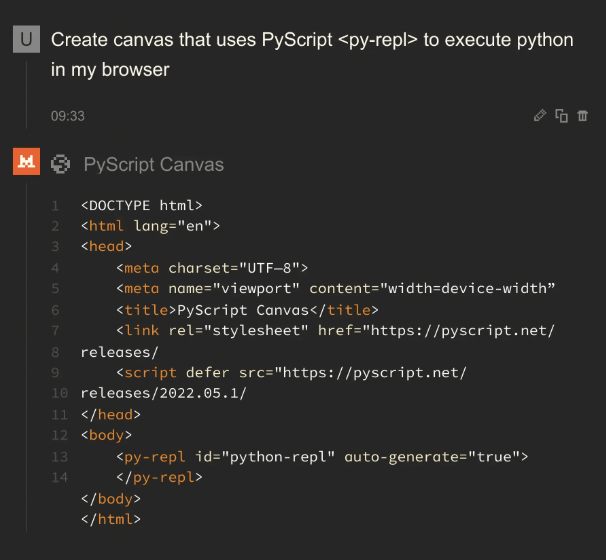

💡Suggerimento professionale: standardizza il tuo ambiente di sviluppo e velocizza l'onboarding creando una lista di controllo che ogni nuovo membro del team possa seguire. Salvala come modello in attività di ClickUp e, se qualcuno incontra difficoltà, potrà utilizzare ClickUp Brain per ottenere risposte dalla documentazione del tuo team. Ecco una guida rapida:

📖 Per saperne di più: Gemini Vs. ChatGPT per la programmazione del codice: quale è meglio?

Come effettuare la tua prima richiesta API Gemini

Il tuo team sta finalmente effettuando chiamate API, ma ogni sviluppatore sta cercando di capirne il funzionamento da solo.

Una chiamata API con esito positivo è semplice: invii un prompt a un modello Gemini e ricevi una risposta.

La vera sfida è rendere questo processo ripetibile e scalabile per tutto il tuo team. Ecco alcuni esempi su come effettuare la tua prima richiesta.

Esempio Python

Questo codice invia un semplice prompt di testo all'API Gemini e stampa la risposta.

Analizziamo questi punti nel dettaglio:

- Importa e configura: questo carica la libreria Google e imposta l'autenticazione utilizzando la chiave API configurata in precedenza.

- Inizializza il modello: qui indichi al codice quale modello Gemini specifico utilizzare. Gemini 3 Flash è ottimizzato per attività ad alta velocità e volume elevato, mentre Gemini 3 Pro è progettato per ragionamenti approfonditi e flussi di lavoro complessi e con numerosi passaggi.

- Genera contenuti: questa è l'azione. Stai inviando la tua domanda al modello.

- Accesso all'output: la risposta del modello è memorizzata nell'oggetto risposta ed è possibile accedere al testo con response. text.

📖 Per saperne di più: 10 esempi di contenuti generati dall'IA per ispirare i tuoi

Esempio JavaScript

Se lavori in un ambiente Node.js, il processo è simile ma utilizza la sintassi async/await di JavaScript.

Esempio di API REST

Se non utilizzi Python o JavaScript, puoi sempre comunicare direttamente con l'API utilizzando un comando curl. Questo è ottimo per test rapidi o per l'uso in linguaggi senza un SDK dedicato.

Questo comando invia una richiesta HTTP all'endpoint API e restituisce la risposta come oggetto JSON.

Rendi più facile per il tuo team trovare e riutilizzare frammenti di codice e prompt di successo creando una libreria condivisa.

📖 Per saperne di più: Che cos'è un piano di project management e come crearne uno?

Cosa puoi creare con l'API Gemini?

L'API Gemini è incredibilmente versatile. Ecco alcune cose che puoi creare:

- Strumenti per la generazione di contenuti: effettua l'automazione delle bozze dei blog, dei post sui social media e dei testi di marketing.

- Chatbot e assistenti virtuali: crea interfacce conversazionali per il supporto clienti o gli help desk interni.

- Assistenza alla codifica: genera frammenti di codice, spiega funzioni complesse e aiuta a correggere gli errori.

- Assistenti per l'analisi dei dati: riepiloga report complessi ed estrai informazioni chiave da testi non strutturati.

- Applicazioni multimodali: analizza immagini o elabora contenuti video per renderli ricercabili.

- Elaborazione dei documenti: estrai informazioni dai PDF e traduci i documenti in diverse lingue.

Creazione di flussi di lavoro agentici con Gemini

A differenza di un chatbot standard che risponde alle domande in modo lineare, un flusso di lavoro agentico in Gemini consente al modello di percepire un obiettivo, ragionare attraverso un piano ed eseguire una serie di azioni autonome su strumenti esterni.

Questo cambiamento "agente" è alimentato da tre funzionalità fondamentali dell'ecosistema Gemini 3:

- Modalità "pensiero" nativa: utilizzando il parametro thinking_level, ora puoi attivare/disattivare la modalità "basso" per la velocità e la modalità "alto" per attività complesse. In modalità di ragionamento elevato, Gemini 3 Pro genera "token di pensiero" nascosti per convalidare la propria logica prima di fornire una risposta, riducendo drasticamente le allucinazioni.

- Firme di pensiero: per evitare "derive di ragionamento" nelle attività multi-turno, l'API ora emette firme di pensiero crittografate. Gli sviluppatori devono restituire queste firme nella cronologia delle conversazioni per garantire che l'agente mantenga il suo esatto filo logico tra le diverse chiamate API e le esecuzioni degli strumenti.

- Model Context Protocol (MCP): Gemini ora utilizza l'MCP standard del settore per effettuare la connessione agli strumenti. Ciò consente al tuo agente di "collegarsi" istantaneamente ai tuoi database esistenti, Slack o GitHub senza dover scrivere codice di integrazione personalizzato per ogni singola funzione.

📮 Approfondimento ClickUp: i team con prestazioni scarse sono 4 volte più propensi a destreggiarsi tra più di 15 strumenti, mentre i team con prestazioni elevate mantengono l'efficienza limitando il loro toolkit a 9 o meno piattaforme.

Ma che ne dici di usare una sola piattaforma per tutto questo?

ClickUp riunisce attività, progetti, documenti, wiki, chat e chiamate in un'unica piattaforma, completa di flussi di lavoro basati sull'intelligenza artificiale. Sei pronto a lavorare in modo più intelligente? ClickUp funziona per ogni team, garantisce visibilità sul lavoro e ti consente di concentrarti su ciò che conta, mentre l'intelligenza artificiale si occupa del resto.

Esempio Python: creazione di un agente di ricerca

Questo snippet mostra come inizializzare un agente ad alto livello di ragionamento che mantiene un "filo logico" persistente tramite l'ultimo SDK Gemini.

📖 Per saperne di più: Come utilizzare un chatbot per la tua attività aziendale

Come garantire la sicurezza della tua chiave API Gemini

Il tuo team sta rilasciando nuove funzionalità/funzioni, ma le tue pratiche di sicurezza sono un ripensamento.

Le chiavi API vengono talvolta lasciate nel codice, contribuendo alla fuga di 23,7 milioni di segreti su GitHub pubblico nel 2024, e non esiste un processo formale per la loro rotazione. Ciò rende la tua organizzazione vulnerabile a un utilizzo non autorizzato, che può portare a fatture impreviste e gravi violazioni della sicurezza.

Un approccio reattivo alla sicurezza è una ricetta per il disastro. Hai bisogno di un sistema di gestione delle conoscenze proattivo per gestire le credenziali e proteggere le tue applicazioni e i dati della tua azienda.

Ecco le migliori pratiche essenziali per mantenere sicura la tua chiave API Gemini:

- Usa le variabili di ambiente: non inserire mai e poi mai le chiavi direttamente nel codice sorgente. Conservale nei file .env o nelle variabili di ambiente di sistema.

- Aggiungi. env al tuo. gitignore: questo semplice passaggio ti impedisce di inviare accidentalmente le tue chiavi segrete a un repository di codice pubblico.

- Ruota regolarmente le chiavi: genera periodicamente nuove chiavi nella Google Cloud Console e disattiva quelle vecchie.

- Implementa i controlli di accesso: utilizza Identity and Access Management (IAM) di Google Cloud per limitare chi nel tuo team può visualizzare o gestire le chiavi API.

- Monitoraggio dell'utilizzo: tieni d'occhio la dashboard di utilizzo dell'API nella Google Cloud Console per individuare eventuali attività insolite che potrebbero segnalare una compromissione.

- Utilizza chiavi separate per gli ambienti: mantieni chiavi diverse per gli ambienti di sviluppo, di gestione temporanea e di produzione per limitare il raggio d'azione di una potenziale fuga di dati.

Prezzi Gemini

- Gemini 3 Flash: ~0,50 $ per 1 milione di input / 3,00 $ per 1 milione di output

- Gemini 3 Pro: ~2,00 $ per 1 milione di input / 12,00 $ per 1 milione di output (per contesti inferiori a 200.000)

- Search Grounding: tieni presente che Google ora addebita 14 $ per ogni 1.000 query di ricerca per il grounding una volta superata la quota mensile gratis (5.000 query).

Limiti dell'utilizzo dell'API Gemini

La tua applicazione è attiva, ma stai riscontrando problemi imprevisti.

L'API è più lenta del previsto nelle ore di punta o restituisce risposte incoerenti che confondono gli utenti.

Comprendere i limiti dell'API è il primo passaggio; documentare le soluzioni alternative è ciò che ti aiuta a scalare in modo efficace.

Tieni presente questi vincoli comuni:

- Limiti di frequenza: il livello gratis ha dei limiti sulle richieste al minuto e sui token al giorno, che possono causare colli di bottiglia nelle applicazioni ad alto volume.

- Variabilità della latenza: i tempi di risposta possono variare in base alla complessità del prompt e al carico complessivo del server.

- Limiti della finestra di contesto: ogni modello ha un numero massimo di token (parole e parti di parole) che può elaborare in una singola richiesta, il che può rappresentare una sfida per il riassunto di documenti molto lunghi.

- Disponibilità regionale: alcuni modelli o funzionalità/funzioni potrebbero non essere disponibili in tutte le aree geografiche.

- Coerenza dei risultati: l'IA generativa può produrre risultati leggermente diversi anche per lo stesso prompt, il che potrebbe richiedere l'integrazione di passaggi di convalida nel flusso di lavoro.

- Nessun dato in tempo reale: le conoscenze dei modelli non vengono aggiornate in tempo reale, quindi non sono in grado di fornire informazioni su eventi molto recenti.

Sebbene l'API Gemini sia un potente strumento multimodale, la creazione di un'applicazione pronta per la produzione richiede spesso una strategia multimodello. A seconda delle esigenze specifiche del tuo progetto in termini di profondità di ragionamento o accuratezza di codifica, puoi prendere in considerazione queste alternative a Gemini.

La maggior parte degli strumenti di IA promette di semplificare lo sviluppo, ma spesso finisce per essere solo un'altra scheda scollegata in uno stack già affollato. Potresti utilizzare l'API Gemini per potenziare il backend della tua app, uno strumento separato per riepilogare gli appunti delle riunioni e una terza piattaforma per gestire le tue attività sprint. Questa rete di contesti dispersi e strumenti isolati è "espansione dell'IA".

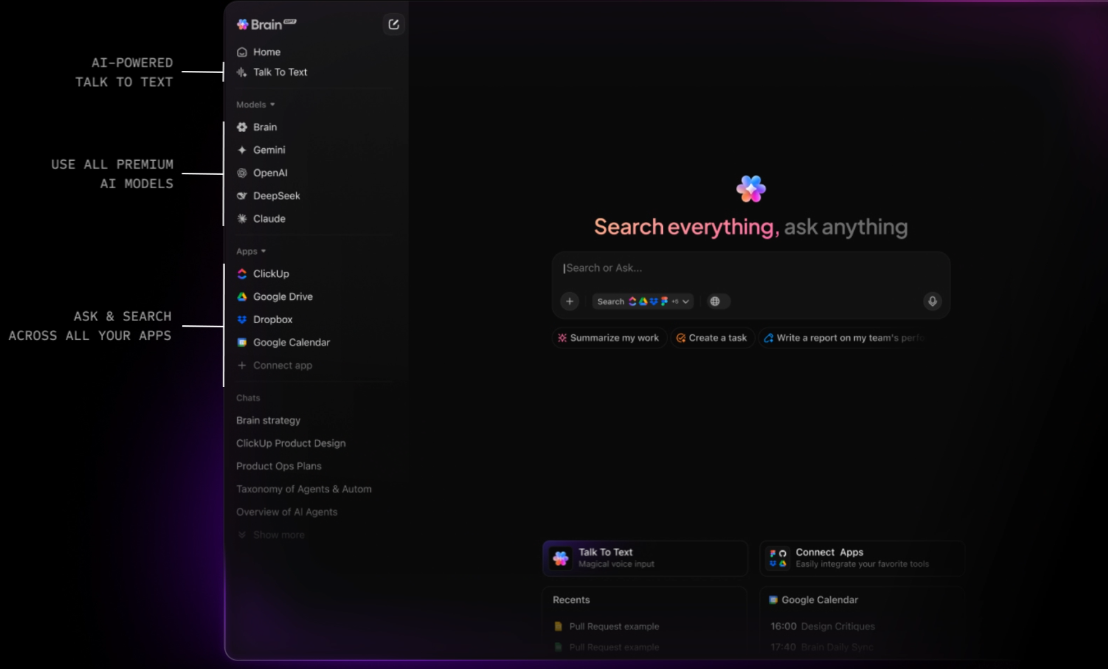

ClickUp è il primo spazio di lavoro AI convergente che collega le tue attività, i tuoi documenti e le tue persone con un livello di intelligenza centrale. A differenza delle API autonome che richiedono la creazione di sistemi di recupero del contesto (RAG) personalizzati, ClickUp Brain "conosce" già tutto ciò che si trova nel tuo spazio di lavoro.

Poiché l'IA è integrata in modo nativo, non si limita a "generare testo", ma comprende la relazione tra la documentazione dell'API Gemini, le scadenze dei tuoi progetti e lo stato in tempo reale del tuo team.

Abilita "Ask IA" da qualsiasi luogo e distribuisci agenti autonomi

Il vero potere di ClickUp risiede nella sua capacità di trasformare la conoscenza in azione. Con ClickUp Brain, puoi "chiedere all'IA" da qualsiasi punto del tuo spazio di lavoro, o anche tramite un companion desktop mentre scrivi codice nel tuo IDE. Puoi individuare immediatamente i rischi di un progetto chiedendo: "Qual è stato il feedback sull'ultima implementazione di Gemini 3 Pro?" ClickUp Brain effettuerà una ricerca approfondita nella tua cronologia, fornendo una risposta citata con link all'attività o al thread di commenti esatto in cui ha avuto luogo la discussione.

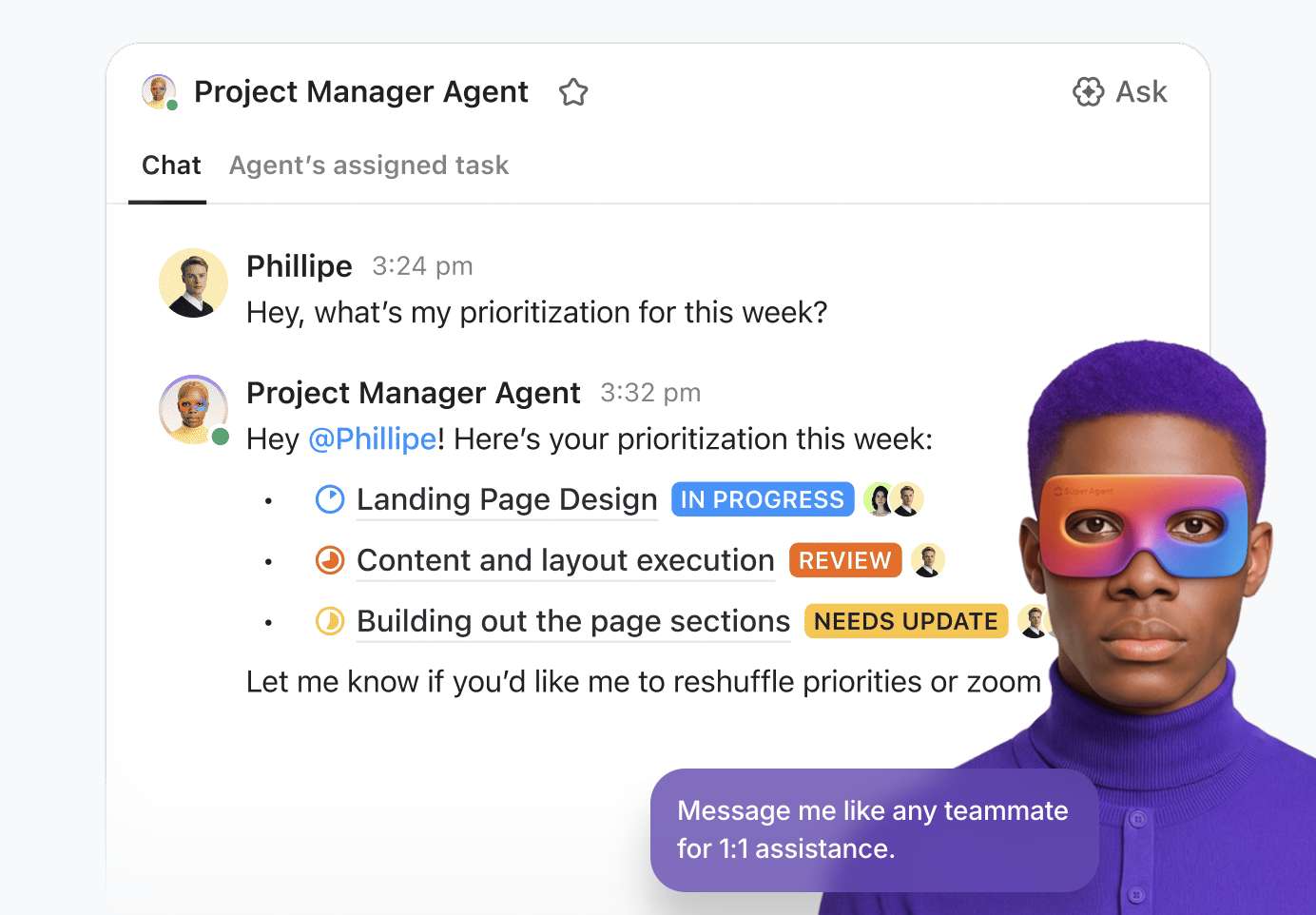

Per i team che sviluppano prodotti IA complessi, ClickUp va oltre la semplice assistenza consentendo di implementare Super Agents . Si tratta di colleghi digitali autonomi e senza codice che gestiscono il "lavoro di routine" del ciclo di vita dello sviluppo. Puoi impostare un Triage Agent per monitorare i bug in arrivo dalla tua integrazione Gemini, oppure un Project Manager Agent che identifica in modo proattivo gli ostacoli allo sprint e genera riepiloghi giornalieri basati sull'attività del tuo team. Si tratta di un sistema intelligente che mantiene la tua pipeline di sviluppo attiva 24 ore su 24, 7 giorni su 7.

Una piattaforma di gestione del lavoro unificata per lo sviluppatore moderno

ClickUp Docs funge da quaderno tecnico condiviso dal tuo team. Che tu stia redigendo un PRD per una nuova funzionalità multimodale o archiviando i tuoi protocolli di sicurezza API Gemini, tutto rimane connesso.

Una riga di codice in un documento può diventare immediatamente un'attività e ClickUp Brain ti consente di sfruttare Enterprise Search per recuperare file e conversazioni da app collegate come Google Workspace, GitHub e Figma utilizzando la ricerca semantica.

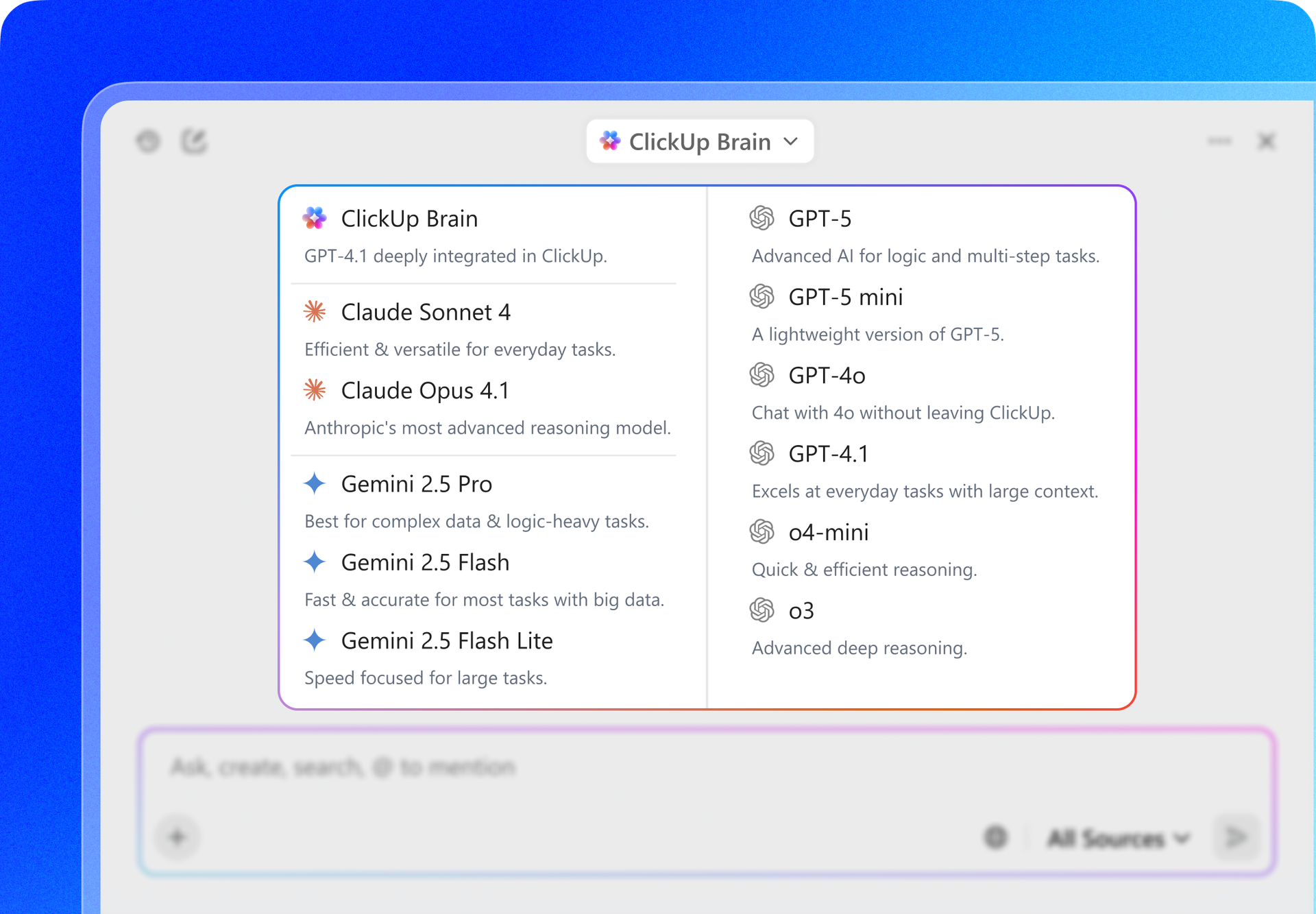

Inoltre, ClickUp offre flessibilità multimodello. Mentre crei con l'API Gemini, puoi utilizzare l'interfaccia di ClickUp per attivare/disattivare Gemini 3, GPT-5. 2 e Claude 4. 5 per confrontare i risultati o redigere specifiche tecniche. Ciò ti garantisce di avere sempre il "cervello" migliore per l'attività da svolgere senza mai uscire dal tuo ambiente di project management.

Le migliori funzionalità di ClickUp

Limitazioni di ClickUp

Prezzi di ClickUp

Valutazioni e recensioni di ClickUp

Cosa dicono gli utenti reali di ClickUp?

Una recensione di un utente dice:

I modelli, i campi personalizzati, le priorità, i punti scrum, i piani e le varie opzioni di visualizzazione di ClickUp, nonostante una leggera curva di apprendimento, hanno permesso al nostro team di adattare lo strumento alle nostre esigenze in continua evoluzione e di massimizzare l'efficienza. Le sue potenti integrazioni con strumenti come Google Drive, riunioni, calendari e il robusto supporto API migliorano il nostro flusso di lavoro in modo trasparente. Inoltre, i moduli ClickUp aggiungono un valore sostanziale alle nostre operazioni. Nel complesso, tutto in ClickUp è così potente e utile che non vorrei cambiare nulla. Sono fermamente convinto che ClickUp sia stato sviluppato tenendo conto delle preferenze degli utenti, rendendolo perfetto per le nostre esigenze.

Il vantaggio di ClickUp: invece di scrivere codice per effettuare la connessione del tuo database a un LLM, BrainGPT, la super app IA autonoma di ClickUp, funge da interfaccia indipendente dal modello già connessa alle tue attività, ai tuoi documenti e ai tuoi repository di codice.

Ti permette di:

La piattaforma API di OpenAI rimane il principale concorrente per gli sviluppatori che creano applicazioni complesse e "pensanti". Con il rilascio della serie GPT-5. 2, OpenAI si è orientata verso il" ragionamento agentico", in cui il modello si interrompe automaticamente per convalidare la propria logica prima di rispondere.

A differenza della stretta integrazione di Gemini con Google Workspace, OpenAI offre un approccio "Foundry" più modulare, rendendolo la scelta preferita dagli sviluppatori che desiderano una piattaforma indipendente dal fornitore e scalabile su diversi provider cloud come Azure e AWS.

Gemini 3 Flash, al contrario, offre un'elaborazione video significativamente più veloce e una finestra di contesto molto più ampia di 2 milioni di token, mentre GPT-5. 2 attualmente limita il suo contesto nativo a 400.000 token.

Le migliori funzionalità dell'API OpenAI

Limitazioni dell'API OpenAI

Prezzi dell'API OpenAI

Valutazioni e recensioni dell'API OpenAI

Cosa dicono gli utenti reali di OpenAI?

Una recensione di un utente dice:

Siamo rimasti estremamente colpiti dai modelli di IA e, in particolare, dall'accesso all'API. Integrando OpenAI nelle nostre soluzioni CRM (BROSH CRM), siamo in grado di offrire un valore reale e tangibile ai nostri clienti attraverso l'automazione basata sull'IA. OpenAI consente a BROSH CRM di fornire funzionalità avanzate basate sull'IA in più aree. I nostri clienti beneficiano di risposte IA di alta qualità e sensibili al contesto nei loro canali di comunicazione, generate direttamente dai dati CRM. Ciò migliora notevolmente le interazioni con i clienti, consentendo al contempo di risparmiare tempo e risorse.

📖 Per saperne di più: Come utilizzare l'API ChatGPT per le tue applicazioni

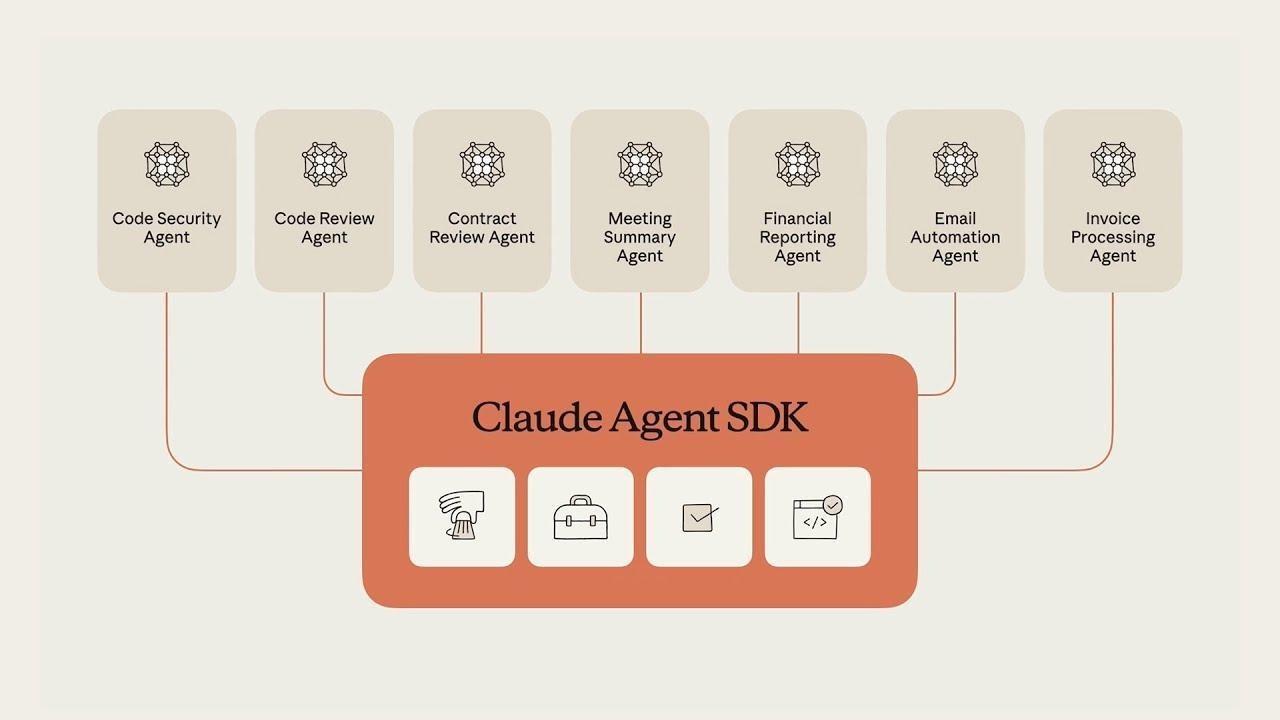

Claude, sviluppato da Anthropic, è l'alternativa ideale per gli sviluppatori che danno priorità all'accuratezza tecnica e al ragionamento "simile a quello umano". Claude 4. 5 Sonnet è ampiamente considerato il modello più affidabile per l'ingegneria del software, superando costantemente gli altri nei benchmark di codifica come SWE-bench.

Una delle sue funzionalità/funzioni distintive è Claude Code, uno strumento CLI agentico che consente al modello di interagire direttamente con il tuo terminale locale e il tuo file system per eseguire il debug e inviare il codice.

Gemini 3 Pro eccelle nell'elaborazione di enormi quantità di dati contemporaneamente (come un video di 1 ora), ma Claude è spesso preferito per attività in cui l'atmosfera e la precisione del risultato sono più importanti del semplice volume di dati elaborati.

Le migliori funzionalità dell'API Claude

Limitazioni dell'API Claude

Prezzi dell'API Claude

Valutazioni e recensioni dell'API Claude

Cosa dicono gli utenti reali dell'API Claude?

Una recensione di un utente dice:

Il costo di utilizzo dell'API è più elevato rispetto a ChatGPT o Gemini, ma se desideri solo porre delle domande, puoi semplicemente utilizzare la versione desktop, quindi non è un grosso problema. Tuttavia, non è l'opzione migliore se desideri incorporarla in un'app.

📖 Per saperne di più: Come utilizzare Claude IA per una codifica efficiente e accurata

Mistral AI fornisce modelli ad alte prestazioni che offrono un'alternativa ai sistemi "chiusi" di Google e OpenAI. È considerato un leader per le aziende che richiedono la sovranità dei dati o desiderano implementare modelli sulla propria infrastruttura privata.

I modelli di punta di Mistral, come Mistral Large 3, sono progettati per essere efficienti e "senza filtri", offrendo agli sviluppatori un maggiore controllo sul comportamento del modello rispetto alle più rigide misure di sicurezza spesso presenti in Gemini o Claude.

Le migliori funzionalità/funzioni di Mistral IA

Limitazioni di Mistral IA

Prezzi di Mistral IA

Valutazioni e recensioni di Mistral IA

Cosa dicono gli utenti reali di Mistral IA?

Ho chiesto informazioni su un personaggio storico del nostro Paese. GEMINI ha distinto correttamente due persone molto diverse tra loro con lo stesso nome e cognome: una era uno storico e professore universitario, l'altra un combattente della resistenza deportato durante la seconda guerra mondiale. Mistral IA mi ha fornito solo la descrizione del primo.

Strumenti di IA alternativi da utilizzare

Sebbene l'API Gemini sia un potente strumento multimodale, la creazione di un'applicazione pronta per la produzione richiede spesso una strategia multimodello. A seconda delle esigenze specifiche del tuo progetto in termini di profondità di ragionamento o accuratezza del codice, puoi prendere in considerazione queste alternative a Gemini.

1. ClickUp (ideale per i team che necessitano di un'IA sensibile al contesto integrata nel loro flusso di lavoro)

La maggior parte degli strumenti di IA promette di semplificare lo sviluppo, ma spesso finisce per essere solo un'altra scheda scollegata in uno stack già affollato. Potresti utilizzare l'API Gemini per potenziare il backend della tua app, uno strumento separato per riepilogare gli appunti delle riunioni e una terza piattaforma per gestire le tue attività di sprint. Questa rete di contesti dispersi e strumenti isolati è "la proliferazione dell'IA".

ClickUp è il primo spazio di lavoro AI convergente che collega le tue attività, i tuoi documenti e le tue persone con un livello di intelligenza centrale. A differenza delle API autonome che richiedono la creazione di sistemi di recupero del contesto (RAG) personalizzati, ClickUp Brain "conosce" già tutto ciò che si trova nel tuo spazio di lavoro.

Poiché l'IA è integrata in modo nativo, non si limita a "generare testo", ma comprende la relazione tra la documentazione dell'API Gemini, le scadenze dei tuoi progetti e lo stato in tempo reale del tuo team.

Abilita "Ask IA" da qualsiasi luogo e distribuisci agenti autonomi

Il vero potere di ClickUp risiede nella sua capacità di trasformare la conoscenza in azione. Con ClickUp Brain, puoi "chiedere all'IA" da qualsiasi punto del tuo spazio di lavoro, o anche tramite un companion desktop mentre scrivi codice nel tuo IDE. Puoi individuare immediatamente i rischi di un progetto chiedendo: "Qual è stato il feedback sull'ultima implementazione di Gemini 3 Pro?" ClickUp Brain effettuerà una ricerca approfondita nella tua cronologia, fornendo una risposta citata con link al task o al thread di commenti esatto in cui ha avuto luogo la discussione.

Per i team che sviluppano prodotti IA complessi, ClickUp va oltre la semplice assistenza consentendo di implementare Super Agents . Si tratta di colleghi digitali autonomi e senza codice che gestiscono il "lavoro di routine" del ciclo di vita dello sviluppo. Puoi impostare un Triage Agent per monitorare i bug in arrivo dalla tua integrazione Gemini, oppure un Project Manager Agent che identifica in modo proattivo gli ostacoli allo sprint e genera riepiloghi giornalieri basati sull'attività del tuo team. Si tratta di un sistema intelligente che mantiene la tua pipeline di sviluppo attiva 24 ore su 24, 7 giorni su 7.

Una piattaforma di gestione del lavoro unificata per lo sviluppatore moderno

ClickUp Docs funge da quaderno tecnico condiviso dal tuo team. Che tu stia redigendo un PRD per una nuova funzionalità multimodale o archiviando i tuoi protocolli di sicurezza API Gemini, tutto rimane connesso.

Una riga di codice in un documento può diventare immediatamente un'attività e ClickUp Brain ti consente di sfruttare Enterprise Search per recuperare file e conversazioni da app collegate come Google Workspace, GitHub e Figma utilizzando la ricerca semantica.

Inoltre, ClickUp offre flessibilità multimodello. Mentre crei con l'API Gemini, puoi utilizzare l'interfaccia di ClickUp per attivare/disattivare Gemini 3, GPT-5. 2 e Claude 4. 5 per confrontare i risultati o redigere specifiche tecniche. Ciò ti garantisce di avere sempre il "cervello" migliore per l'attività da svolgere senza mai uscire dal tuo ambiente di project management.

Le migliori funzionalità di ClickUp

- Ricerca universale e Ask AI: recupera istantaneamente i dati su ClickUp, Slack, GitHub e Drive, oppure chiedi all'IA di riepilogare/riassumere qualsiasi documento o thread di attività da qualsiasi punto dell'area di lavoro.

- Agenti senza codice: implementa agenti senza codice per automatizzare la creazione di attività, gli aggiornamenti di stato e la reportistica, trasformando il project management manuale in un flusso di lavoro autonomo.

- Chat AI integrata: menziona @Brain in qualsiasi thread della chat ClickUp per trasformare istantaneamente una conversazione in un'attività formattata o per ottenere un riepilogo/riassunto di una lunga discussione.

- Dashboard basato sull'IA: visualizza lo stato di salute del team con dashboard in tempo reale che utilizzano l'IA per identificare i rischi degli sprint, prevedere i ritardi e spiegare le tendenze dei dati in un linguaggio semplice.

- AI Writer for Docs: redigi requisiti tecnici, procedure operative standard e programmi delle riunioni precompilati con i dati e il contesto specifici del tuo progetto.

Limitazioni di ClickUp

- L'efficacia dell'IA è legata all'igiene della tua area di lavoro; se il tuo team non mantiene aggiornati gli impegni e i documenti, l'IA ha meno "contesto" da cui attingere per le sue risposte.

Prezzi di ClickUp

Valutazioni e recensioni di ClickUp

- G2: 4,7/5 (oltre 10.900 recensioni)

- Capterra: 4,6/5 (oltre 4.500 recensioni)

Cosa dicono gli utenti reali di ClickUp?

Una recensione di un utente dice:

I modelli, i campi personalizzati, le priorità, i punti scrum, i piani e le varie opzioni di visualizzazione di ClickUp, nonostante una leggera curva di apprendimento, hanno permesso al nostro team di adattare lo strumento alle nostre esigenze in continua evoluzione e di massimizzare l'efficienza. Le sue potenti integrazioni con strumenti come Google Drive, riunioni, calendari e il robusto supporto API migliorano il nostro flusso di lavoro in modo trasparente. Inoltre, i moduli ClickUp aggiungono un valore sostanziale alle nostre operazioni. Nel complesso, tutto in ClickUp è così potente e utile che non vorrei cambiare nulla. Sono fermamente convinto che ClickUp sia stato sviluppato tenendo conto delle preferenze degli utenti, rendendolo perfetto per le nostre esigenze.

I modelli, i campi personalizzati, le priorità, i punti scrum, i piani e le varie opzioni di visualizzazione di ClickUp, nonostante una leggera curva di apprendimento, hanno permesso al nostro team di adattare lo strumento alle nostre esigenze in continua evoluzione e di massimizzare l'efficienza. Le sue potenti integrazioni con strumenti come Google Drive, riunioni, calendari e il solido supporto API migliorano il nostro flusso di lavoro in modo trasparente. Inoltre, i moduli ClickUp aggiungono un valore sostanziale alle nostre operazioni. Nel complesso, tutto in ClickUp è così potente e utile che non vorrei cambiare nulla. Sono fermamente convinto che ClickUp sia stato sviluppato tenendo conto delle preferenze degli utenti, rendendolo perfetto per le nostre esigenze.

Il vantaggio di ClickUp: invece di scrivere codice per connettere il tuo database a un LLM, BrainGPT, la super app AI autonoma di ClickUp, funge da interfaccia indipendente dal modello già connessa alle tue attività, ai tuoi documenti e ai tuoi repository di codice.

Ti permette di:

- Attiva/disattiva i modelli: usa Gemini 3 per attività contestuali con 2 milioni di token, poi passa a Claude 4. 5 per una precisione di codifica millimetrica, il tutto nella stessa finestra.

- Ricerca unificata: chiedi "Quali sono state le specifiche di sicurezza API definitive discusse nella riunione del mese scorso?" e ottieni una risposta fondata attingendo contemporaneamente da Slack, GitHub e ClickUp Docs.

- Talk-to-Text: Usa l'app desktop BrainGPT per dettare comandi come "Crea un ticket Jira per l'integrazione Gemini e assegnalo al capo sviluppatore": non serve la tastiera

2. API OpenAI (ideale per l'intelligenza generica e il ragionamento agentico)

La piattaforma API di OpenAI rimane il principale concorrente per gli sviluppatori che creano applicazioni complesse e "pensanti". Con il rilascio della serie GPT-5. 2, OpenAI si è orientata verso il" ragionamento agentico", in cui il modello si interrompe automaticamente per convalidare la propria logica prima di rispondere.

A differenza della stretta integrazione di Gemini con Google Workspace, OpenAI offre un approccio "Foundry" più modulare, rendendolo la scelta preferita dagli sviluppatori che desiderano una piattaforma indipendente dal fornitore e scalabile su diversi provider cloud come Azure e AWS.

Gemini 3 Flash, al contrario, offre un'elaborazione video significativamente più veloce e una finestra di contesto molto più ampia di 2 milioni di token, mentre GPT-5. 2 attualmente limita il suo contesto nativo a 400.000 token.

Le migliori funzionalità dell'API OpenAI

- Usa la modalità di pensiero per gestire problemi complessi e articolati in più passaggi che richiedono una verifica interna prima di generare una risposta definitiva.

- Accedi all'API in tempo reale per creare esperienze multimodali a bassa latenza, comprese interazioni native speech-to-speech.

- Sfrutta l'API di ricerca file (Vector Store) per creare sistemi RAG (Retrieval-Augmented Generation) con gestione dei documenti integrata.

Limiti dell'API OpenAI

- L'utilizzo può diventare molto costoso se non monitorato attentamente, soprattutto quando si utilizzano modelli ad alto livello di ragionamento come GPT-5. 2 Pro

Prezzi dell'API OpenAI

- GPT-5. 2: 1,75 $/1 milione di input | 14,00 $/1 milione di output

- GPT-5. 2 Pro: 21,00 $/1 milione di input | 168,00 $/1 milione di output

- GPT-5 Mini: 0,25 $/1 milione di input | 2,00 $/1 milione di output

Valutazioni e recensioni dell'API OpenAI

- G2: 4,7/5 (oltre 840 recensioni)

- Gartner Peer Insights: 4,4/5 (oltre 60 recensioni)

Cosa dicono gli utenti reali di OpenAI?

Una recensione di un utente dice:

Siamo rimasti estremamente colpiti dai modelli di IA e, in particolare, dall'accesso all'API. Integrando OpenAI nelle nostre soluzioni CRM (BROSH CRM), siamo in grado di offrire un valore reale e tangibile ai nostri clienti attraverso l'automazione basata sull'IA. OpenAI consente a BROSH CRM di fornire funzionalità avanzate basate sull'IA in più aree. I nostri clienti beneficiano di risposte IA di alta qualità e sensibili al contesto nei loro canali di comunicazione, generate direttamente dai dati CRM. Ciò migliora notevolmente le interazioni con i clienti, consentendo al contempo di risparmiare tempo e risorse.

Siamo rimasti estremamente colpiti dai modelli di IA e, in particolare, dall'accesso all'API. Integrando OpenAI nelle nostre soluzioni CRM (BROSH CRM), siamo in grado di offrire un valore reale e tangibile ai nostri clienti attraverso l'automazione basata sull'IA. OpenAI consente a BROSH CRM di fornire funzionalità avanzate basate sull'IA in più aree. I nostri clienti beneficiano di risposte IA di alta qualità e sensibili al contesto nei loro canali di comunicazione, generate direttamente dai dati CRM. Ciò migliora notevolmente le interazioni con i clienti, consentendo al contempo di risparmiare tempo e risorse.

📖 Per saperne di più: Come utilizzare l'API ChatGPT per le tue applicazioni

3. API Claude (ideale per la codifica ad alto rischio e la scrittura tecnica ricca di sfumature)

Claude, sviluppato da Anthropic, è l'alternativa ideale per gli sviluppatori che danno priorità all'accuratezza tecnica e al ragionamento "simile a quello umano". Claude 4. 5 Sonnet è ampiamente considerato il modello più affidabile per l'ingegneria del software, superando costantemente gli altri nei benchmark di codifica come SWE-bench.

Una delle sue funzionalità/funzioni distintive è Claude Code, uno strumento CLI agentico che consente al modello di interagire direttamente con il tuo terminale locale e il tuo file system per eseguire il debug e inviare il codice.

Gemini 3 Pro eccelle nell'elaborazione di enormi quantità di dati contemporaneamente (come un video di 1 ora), ma Claude è spesso preferito per attività in cui l'atmosfera e la precisione del risultato sono più importanti del semplice volume di dati elaborati.

Le migliori funzionalità dell'API Claude

- Mantieni la logica complessa dei progetti utilizzando Claude Projects, che ti consente di raggruppare documenti e codici correlati per un contesto migliore.

- Utilizza Prompt Caching per ridurre significativamente i costi e la latenza delle richieste ripetitive e ad alto volume.

- Esegui e testa il codice in tempo reale all'interno dell'ambiente del modello utilizzando lo Strumento di analisi (Esecuzione codice)

Limitazioni dell'API Claude

- Claude attualmente non dispone di strumenti nativi per la generazione di immagini o video, richiedendo agli sviluppatori di integrarsi con API di terze parti per il lavoro creativo visivo.

Prezzi dell'API Claude

- Claude 4. 5 Opus: 15,00 $/1 milione di input | 75,00 $/1 milione di output

- Claude 4. 5 Sonnet: 3,00 $/1 milione di input | 15,00 $/1 milione di output

- Claude 4. 5 Haiku: 1,00 $/1 milione di input | 5,00 $/1 milione di output

Valutazioni e recensioni dell'API Claude

- G2: 4,4/5 (oltre 55 recensioni)

- Capterra: 4,6/5 (oltre 20 recensioni)

Cosa dicono gli utenti reali dell'API Claude?

Una recensione di un utente dice:

Il costo di utilizzo dell'API è più elevato rispetto a ChatGPT o Gemini, ma se desideri solo porre domande, puoi semplicemente utilizzare la versione desktop, quindi non è un grosso problema. Tuttavia, non è l'opzione migliore se desideri incorporarla in un'app.

Il costo di utilizzo dell'API è più elevato rispetto a ChatGPT o Gemini, ma se desideri solo porre domande, puoi semplicemente utilizzare la versione desktop, quindi non è un grosso problema. Tuttavia, non è l'opzione migliore se desideri incorporarla in un'app.

📖 Per saperne di più: Come utilizzare Claude IA per una codifica efficiente e accurata

4. Mistral IA (ideale per la flessibilità open-weight e la sovranità dei dati)

Mistral IA fornisce modelli ad alte prestazioni che offrono un'alternativa ai sistemi "chiusi" di Google e OpenAI. È considerato un leader per le aziende che richiedono la sovranità dei dati o desiderano implementare modelli sulla propria infrastruttura privata.

I modelli di punta di Mistral, come Mistral Large 3, sono progettati per essere efficienti e "senza filtri", offrendo agli sviluppatori un maggiore controllo sul comportamento del modello rispetto alle più rigide misure di sicurezza spesso presenti in Gemini o Claude.

Le migliori funzionalità/funzioni di Mistral IA

- Distribuisci i modelli sul tuo hardware o VPC (Virtual Private Cloud) per garantire la massima privacy e sicurezza dei dati.

- Usa Mistral Memories per salvare e richiamare il contesto chiave in diverse sessioni senza dover inviare nuovamente i dati manualmente.

- Accedi alla Directory dei connettori per collegare facilmente i tuoi modelli a origini dati esterne come Notion, GitHub e Slack.

Limitazioni di Mistral IA

- La documentazione e il supporto della community per Mistral non sono così completi come quelli per Google o OpenAI, il che potrebbe comportare una curva di apprendimento più ripida per i nuovi sviluppatori.

Prezzi di Mistral IA

- Mistral Large 3: 2,00 $/1 milione di input | 6,00 $/1 milione di output

- Mistral Small: 0,20 $/1 milione di input | 0,60 $/1 milione di output

- Mistral Free: accesso API limitato per i test

Valutazioni e recensioni di Mistral IA

- G2: 4. 4/5 (Recensioni iniziali limitate)

- Capterra: 4,5/5 (recensioni iniziali con limite)

Cosa dicono gli utenti reali di Mistral IA?

Ho chiesto informazioni su un personaggio storico del nostro Paese. GEMINI ha distinto correttamente due persone molto diverse tra loro con lo stesso nome e cognome: una era uno storico e professore universitario, l'altra un combattente della resistenza deportato durante la seconda guerra mondiale. Mistral IA mi ha fornito solo la descrizione del primo.

Ho chiesto informazioni su un personaggio storico del nostro Paese. GEMINI ha distinto correttamente due persone molto diverse tra loro con lo stesso nome e cognome: una era uno storico e professore universitario, l'altra un combattente della resistenza deportato durante la Seconda guerra mondiale. Mistral IA mi ha fornito solo la descrizione del primo.

📖 Per saperne di più: Le migliori alternative a Mistral IA per modelli linguistici avanzati

API semplificate con ClickUp

Iniziare a utilizzare l'API Google Gemini è semplice: basta ottenere una chiave, installare un SDK ed effettuare la prima chiamata API. Ma quando si passa da un semplice script a un'applicazione di produzione, emergono le vere sfide: gestire le chiavi, documentare i prompt e mantenere organizzato il lavoro del team.

L'API Gemini offre potenti funzionalità di IA, ma integrarla nel tuo flusso di lavoro può creare documentazione dispersiva, monitoraggio frammentato dei progetti e continui cambi di contesto.

I team che centralizzano lo sviluppo dell'IA insieme alla gestione delle attività e alla documentazione lavorano più velocemente e mantengono un contesto migliore. La scelta di dove organizzare questo lavoro determinerà l'efficacia con cui potrai innovare e collaborare.

Inizia gratis con ClickUp e scopri come uno spazio di lavoro convergente può trasformare il tuo processo di sviluppo dell'IA.

Domande frequenti sull'API Gemini

Sì, Google offre un generoso livello gratis per Gemini 3 Flash e Pro tramite Google AI Studio. Tuttavia, strumenti specializzati come Google Search Grounding comportano un costo (14 $ per 1.000 query) dopo le prime 5.000 richieste mensili.

Google AI Studio è uno strumento basato sul web che consente di sperimentare prompt e generare rapidamente chiavi API. L'API Gemini è l'interfaccia programmatica che utilizzi nel tuo codice per integrare tali funzionalità di IA nelle tue applicazioni.

Sì, l'API Gemini supporta conversazioni multi-turno, il che la rende un'ottima scelta per la creazione di chatbot interni, bot di supporto clienti o assistenti di team. L'API verrebbe utilizzata come "cervello" del chatbot e l'interfaccia utente verrebbe creata separatamente.

I limiti di frequenza variano a seconda del modello utilizzato e del tipo di abbonamento, gratuito o a pagamento. L'abbonamento gratuito ha limiti inferiori per le richieste al minuto, mentre i piani a pagamento offrono una maggiore produttività per le applicazioni di produzione.