I motori di ricerca sono sempre stati essenziali per trovare informazioni, ma il comportamento degli utenti si è evoluto. Invece di semplici ricerche per parole chiave come "smartphone", ora le persone effettuano query più specifiche e personalizzate come "i migliori telefoni economici per giocare".

Nel frattempo, i modelli linguistici di grandi dimensioni (LLM) come ChatGPT trasformano la ricerca fungendo da sistemi intelligenti di risposta alle domande.

Integrandosi con i motori di ricerca tradizionali, migliorano il recupero delle informazioni attraverso la generazione aumentata dal recupero (RAG), rendendo i risultati più precisi e sensibili al contesto.

Anziché competere tra loro, gli LLM e i motori di ricerca collaborano per gestire in modo più efficace le query complesse. In questo articolo esploreremo come questa integrazione sta plasmando il futuro della ricerca.

⏰ Riepilogo/riassunto in 60 secondi

- I motori di ricerca tradizionali spesso hanno difficoltà a gestire grandi set di dati, mantenere la qualità dei dati e abbattere i silos.

- Essi devono inoltre affrontare sfide in termini di sicurezza, scalabilità e fornitura di risultati contestualmente rilevanti.

- I modelli linguistici di grandi dimensioni, come ChatGPT, aumentano la precisione della ricerca, consentono la ricerca semantica e forniscono supporto per le query in linguaggio naturale.

- Gli LLM migliorano anche le capacità di ricerca multimodale e rendono la scoperta delle conoscenze più personalizzata ed efficiente.

- Le funzionalità di ricerca connessa e IA di ClickUp si basano su questi progressi centralizzando i tuoi dati e consentendo un recupero delle informazioni rapido e accurato.

- ClickUp si integra perfettamente con varie piattaforme, fornendo accesso in tempo reale ai tuoi contenuti, semplificando i flussi di lavoro e migliorando la produttività complessiva.

Senza ulteriori indugi, entriamo subito nel vivo dell'argomento!

Cosa sono gli LLM?

I modelli linguistici di grandi dimensioni (LLM) sono sistemi avanzati di intelligenza artificiale che elaborano e generano il linguaggio umano. Sono addestrati su ampi set di dati di testo, che li rendono in grado di gestire attività come la traduzione, il riassunto e le conversazioni.

Alcuni degli esempi più popolari di LLM includono GPT-3 e GPT-4, ampiamente riconosciuti per la loro capacità di gestire query complesse relative al linguaggio.

A differenza dei motori di ricerca tradizionali che dipendono dalle parole chiave, un motore di ricerca basato su LLM va oltre le query superficiali. Comprende il contesto e l'intento dietro alle domande, fornendo risposte dirette e dettagliate.

👀 Lo sapevate? Il 71% degli utenti preferisce la personalizzazione da parte dei marchi e delle aziende che sceglie.

Funzionalità dei motori di ricerca LLM

I motori di ricerca LLM offrono funzionalità avanzate che ridefiniscono il modo in cui gli utenti di Internet accedono alle informazioni e interagiscono con esse. Esaminiamo le loro funzionalità principali:

- Comprensione semantica delle query: i motori di ricerca LLM interpretano il significato delle query di ricerca, andando oltre le parole chiave per comprendere l'intento e il contesto dell'utente.

- Elaborazione del linguaggio naturale (NLP): gli utenti possono formulare le query in modo colloquiale senza bisogno di parole chiave esatte, rendendo le ricerche più intuitive.

- Rilevanza contestuale: i risultati della ricerca sono personalizzati in base alle query e alle interazioni precedenti, garantendo informazioni più pertinenti e aggiornate.

- Generazione di risposte: questi sistemi forniscono risposte complete direttamente nei risultati di ricerca, inclusi riepiloghi/riassunti, spiegazioni e persino formati creativi come storie o guide passo passo.

- Integrazione dei grafici di conoscenza: i motori di ricerca LLM utilizzano grafici di conoscenza per effettuare connessioni tra concetti ed entità correlati, offrendo approfondimenti più dettagliati.

- Ricerca conversazionale: gli utenti possono partecipare a una conversazione interattiva, ponendo domande di approfondimento e perfezionando le loro ricerche per un'esperienza più interattiva.

- Risultati adattivi: i risultati si adattano dinamicamente in base alla posizione, agli interessi e alle ricerche precedenti, offrendo un'esperienza più personalizzata.

- Sintesi delle informazioni: invece di affidarsi a un'unica fonte, i motori di ricerca LLM aggregano dati provenienti da più fonti, fornendo una prospettiva più ampia.

👀 Lo sapevate? Con il crescente utilizzo di altoparlanti intelligenti e assistenti vocali, il 50% di tutte le ricerche è ora basato sulla voce. Man mano che i modelli linguistici di grandi dimensioni vengono integrati in questi sistemi, le ricerche vocali diventeranno ancora più accurate, fornendo un accesso più rapido alle informazioni su più piattaforme, che si tratti di file, attività o note di riunioni.

Tecniche di ricerca avanzate con LLM

Con l'avanzare della tecnologia di ricerca, LLM come GPT-4, BERT e T5 stanno trasformando il modo in cui i motori di ricerca elaborano le query, personalizzano i risultati e perfezionano le classifiche. Scopriamo come questi modelli stanno ridefinendo il futuro della ricerca.

Come gli LLM inviano le query di ricerca

La ricerca si è evoluta dalle semplici query basate su parole chiave alle ricerche vettoriali semantiche. Invece di cercare un termine specifico come "Monte Fuji", gli utenti possono cercare "montagne in Giappone" e il sistema recupera risultati basati sul significato.

Riformulare le query in domande, come "Quali sono le montagne famose in Giappone?", può migliorare la precisione della ricerca. I modelli linguistici di grandi dimensioni (LLM) migliorano anche le ricerche attivando query aggiuntive se la confidenza è bassa, utilizzando tecniche come FLARE.

Il ragionamento a catena di pensieri migliora ulteriormente le ricerche suddividendo le attività in passaggi logici, come si vede in AutoGPT. Inoltre, la ricerca conversazionale consente agli assistenti basati su LLM di perfezionare le query in tempo reale, garantendo risultati più precisi durante l'interazione.

Ricerca personalizzata e consapevolezza del contesto

La consapevolezza contestuale è una delle funzionalità/funzioni più potenti degli LLM. A differenza dei motori di ricerca tradizionali, che classificano i risultati in base alla corrispondenza delle parole chiave, gli LLM tengono conto dell'intenzione dell'utente, della posizione, della cronologia di ricerca e delle interazioni passate.

Grazie alla messa a punto con dati specifici del dominio, gli LLM personalizzano i risultati di ricerca per riconoscere i modelli e dare priorità ai contenuti pertinenti. Ad esempio, un utente che cerca spesso ricette vegane vedrà opzioni a base vegetale quando cerca "le migliori ricette per la cena".

Gli LLM interpretano anche le query multimodali, comprendendo sia il testo che le immagini per risultati più accurati. Inoltre, costruiscono un contesto longitudinale, imparando dalle interazioni in corso per suggerire in modo proattivo query pertinenti.

LLM nel riclassificare e migliorare i risultati dei motori di ricerca

Gli LLM migliorano i motori di ricerca riclassificando dinamicamente i risultati per riflettere meglio l'intenzione dell'utente. A differenza della tradizionale classificazione basata su parole chiave, gli LLM utilizzano meccanismi di attenzione per analizzare il contesto completo di una query e dare priorità ai contenuti pertinenti.

Ad esempio, l'aggiornamento BERT (Bidirectional Encoder Representations from Transformers) di Google ha rivoluzionato la ricerca comprendendo il contesto dietro parole come "apple" (mela) e "Apple" (azienda tecnologica).

Gli LLM contribuiscono anche a migliorare l'efficienza delle SERP (pagine dei risultati dei motori di ricerca). Analizzando fattori quali il tasso di clic (CTR), la frequenza di rimbalzo e il tempo di permanenza, gli LLM possono modificare le classifiche in tempo reale, potenziando i risultati che garantiscono un elevato coinvolgimento degli utenti.

📖 Leggi anche: Come cercare rapidamente nei file PDF

Strumenti di ricerca LLM più diffusi

Con l'evoluzione della ricerca basata sull'IA, diversi motori di ricerca basati su modelli linguistici di grandi dimensioni stanno guadagnando terreno grazie alle loro funzionalità avanzate. Perplexity AI fornisce risposte dirette con fonti citate, rendendo le ricerche più interattive e informative.

You. com offre un'esperienza personalizzabile, consentendo agli utenti di dare priorità alle fonti, integrare riepiloghi/riassunti generati dall'IA e interagire con assistenti IA.

Sappiamo tutti che possiamo utilizzare questi motori di ricerca per recuperare informazioni e ottenere risposte rapide. Ma cosa succede quando si tratta di individuare quel file cruciale al lavoro? O di recuperare una conversazione ricca di dati per la tua prossima importante presentazione?

È qui che entra in gioco ClickUp, l'app che fa tutto per il lavoro!

📮 ClickUp Insight: il 46% dei knowledge worker si affida a una combinazione di chat, note, strumenti di project management e documentazione del team solo per tenere traccia del proprio lavoro. Per loro, il lavoro è disperso su piattaforme scollegate tra loro, rendendo più difficile rimanere organizzati. Come app completa per il lavoro, ClickUp unifica tutto. Con funzionalità come ClickUp Email Project Management, ClickUp Notes, ClickUp Chat e ClickUp Brain, tutto il tuo lavoro è centralizzato in un unico posto, ricercabile e perfettamente connesso. Dì addio al sovraccarico di strumenti e dai il benvenuto a una produttività senza sforzo.

ClickUp Brain combina funzionalità di ricerca avanzate con caratteristiche complete di project management, collegando attività, file, membri del team e progetti in un unico posto. Non dovrai più passare da un'app all'altra o gestire strumenti frammentati e silos di informazioni!

I costi delle inefficienze dovute a strumenti scollegati tra loro sono sbalorditivi:

- 2. 5 ore al giorno: i knowledge worker dedicano circa il 30% della loro giornata lavorativa alla ricerca di informazioni.

- 3.600 attivazioni/disattivazioni di app al giorno: i dipendenti attivano/disattivano app e finestre oltre 3.600 volte al giorno, perdendo 4 ore alla settimana per riorientarsi.

- 23 minuti persi: ogni cambio di app disturba la concentrazione e occorrono quasi 23 minuti per tornare al lavoro.

420.000 dollari all'anno: le organizzazioni con 100 dipendenti perdono ogni anno questa cifra a causa di comunicazioni errate e strumenti non collegati tra loro.

Queste inefficienze comportano perdite di tempo, calo del morale e aumento dei costi operativi. Fortunatamente, l'IA trasforma queste sfide in opportunità per un processo decisionale più intelligente, un recupero delle informazioni più rapido e un'esecuzione senza intoppi.

Ecco come la ricerca connessa di ClickUp trasforma la collaborazione:

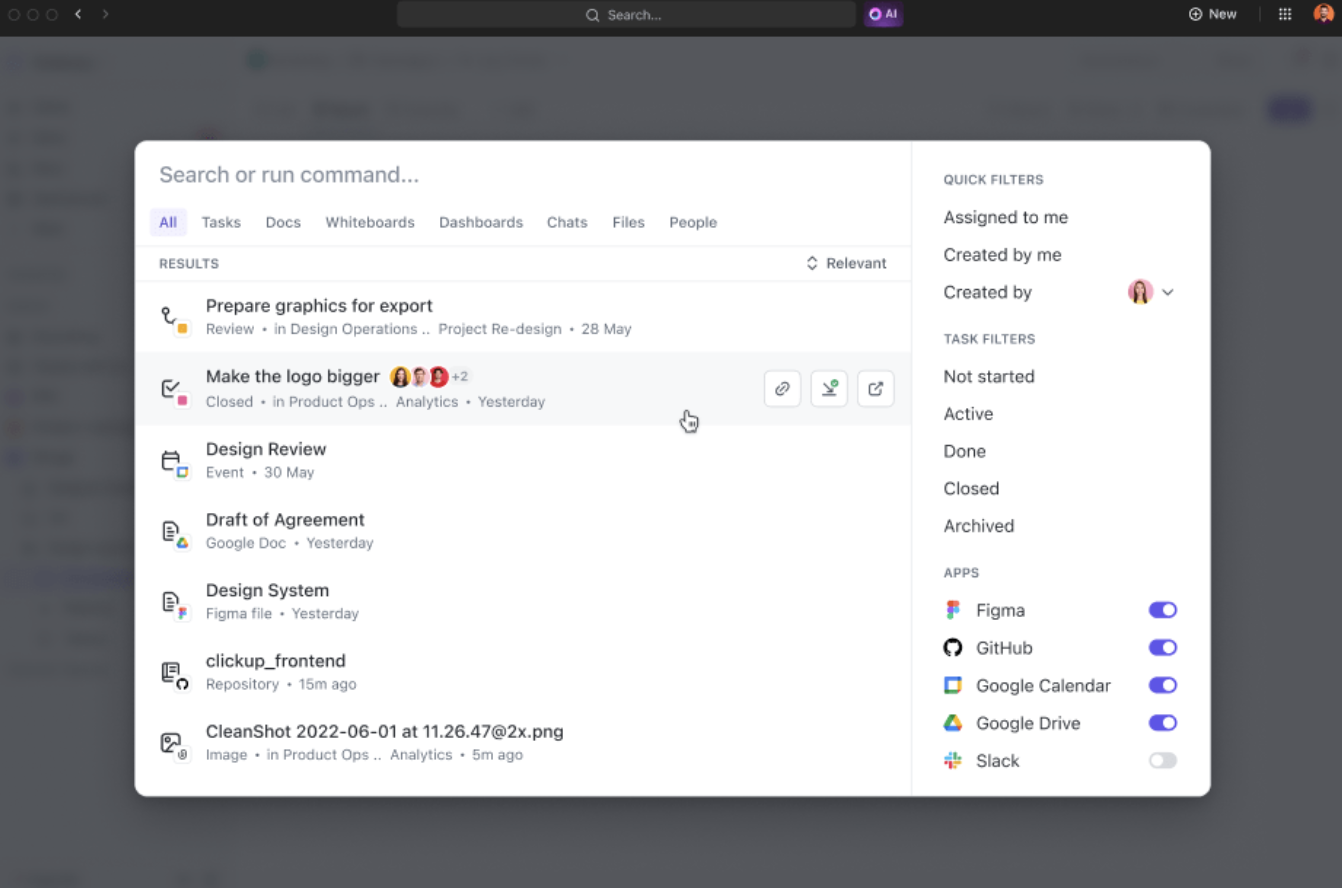

- Ricerca unificata: accedi a tutte le informazioni dell'azienda da un'unica piattaforma, risparmiando quasi quattro ore alla settimana grazie alla riduzione del passaggio da un'app all'altra da attivare/disattivare.

- Rilevanza basata sull'IA: ottieni risultati di ricerca personalizzati e contestualizzati su misura per i tuoi progetti, migliorando il processo decisionale con accesso immediato alle informazioni più rilevanti.

- Integrazione semplice degli strumenti: effettua la connessione senza problemi con strumenti esistenti come Google Drive, SharePoint, Figma e Slack senza bisogno di configurazioni complesse.

Ad esempio, al ritorno da un periodo di ferie, basta chiedere a ClickUp Brain gli aggiornamenti sui propri progetti. Il motore fornirà un elenco puntato ben organizzato con gli elementi critici e le discussioni che hanno avuto luogo durante la vostra assenza.

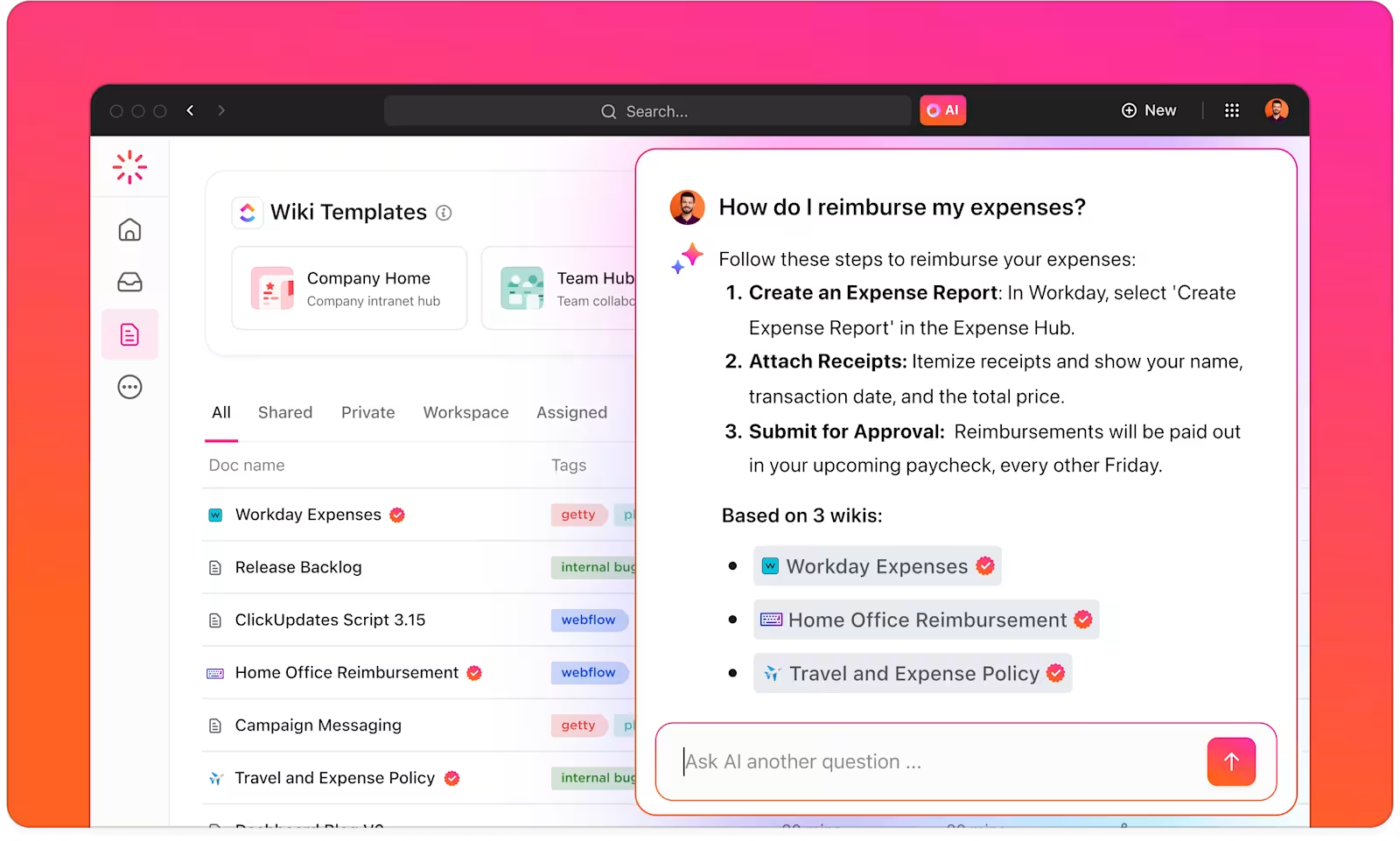

Con ClickUp Brain, hai a disposizione un gestore di conoscenze intelligente che ti aiuta a trovare tutto ciò che ti serve all'interno della tua area di lavoro di ClickUp e delle app collegate.

ClickUp Brain comprende il contesto delle tue attività e offre suggerimenti pertinenti in base alle tue preferenze di lavoro o alle tue attività principali. Ai creatori di contenuti, ad esempio, fornisce suggerimenti per la creazione di contenuti, il brainstorming e le attività correlate.

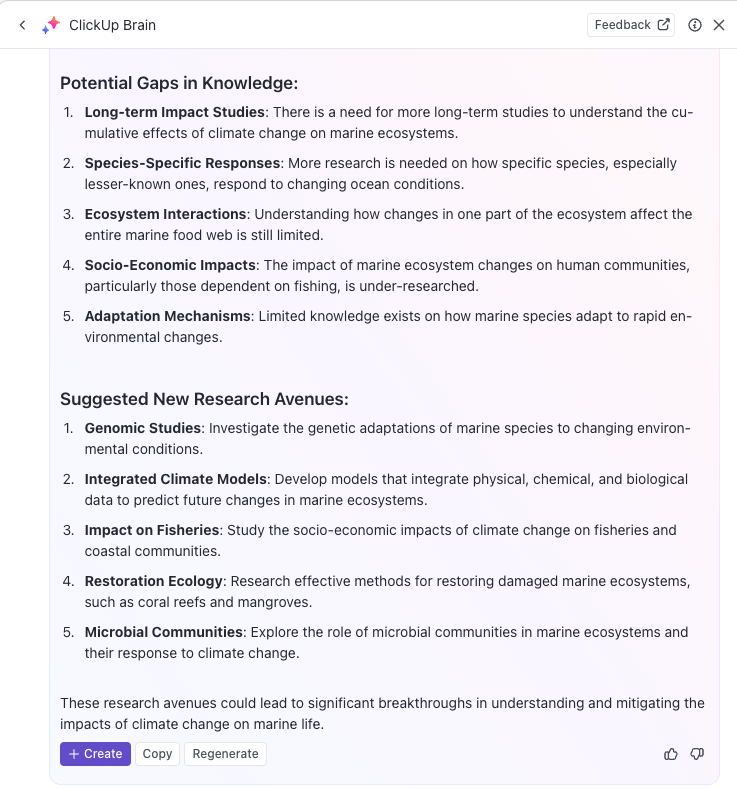

Puoi anche utilizzare l'IA per automatizzare attività ripetitive o aggiornare lo stato delle attività con semplici prompt, consentendoti di concentrarti sul lavoro approfondito. Se stai cercando un potente motore di ricerca basato sull'IA per aumentare la produttività, ClickUp Brain è la soluzione che fa per te.

Con ClickUp Brain, puoi ottimizzare la tua base di conoscenze classificando, etichettando e organizzando automaticamente tutte le informazioni rilevanti.

Ad esempio, i team di ricerca possono utilizzare ClickUp per creare un sistema centralizzato di gestione delle conoscenze in cui archiviare tutte le informazioni, i documenti e i risultati delle ricerche in un formato facilmente accessibile.

Inoltre, la versatilità di ClickUp Docs supporta la creazione di wiki, repositories di documenti e la gestione delle attività relative alla conoscenza.

Puoi anche organizzare le informazioni in vari modi, utilizzando ClickUp Spazi, cartelle ed elenchi per strutturare i contenuti e recuperarli rapidamente. Il tuo team potrà trovare e accedere facilmente ai dati giusti quando necessario, senza perdere tempo a cercare su più piattaforme.

Inoltre, la piattaforma aiuta al monitoraggio delle attività e dei progetti tramite le attività di ClickUp sulla base delle informazioni ottenute dai motori di ricerca LLM. Puoi integrare i risultati di ricerca basati sull'IA direttamente nei tuoi flussi di lavoro di monitoraggio delle attività e dei progetti, rendendo più facile l'implementazione delle conoscenze acquisite.

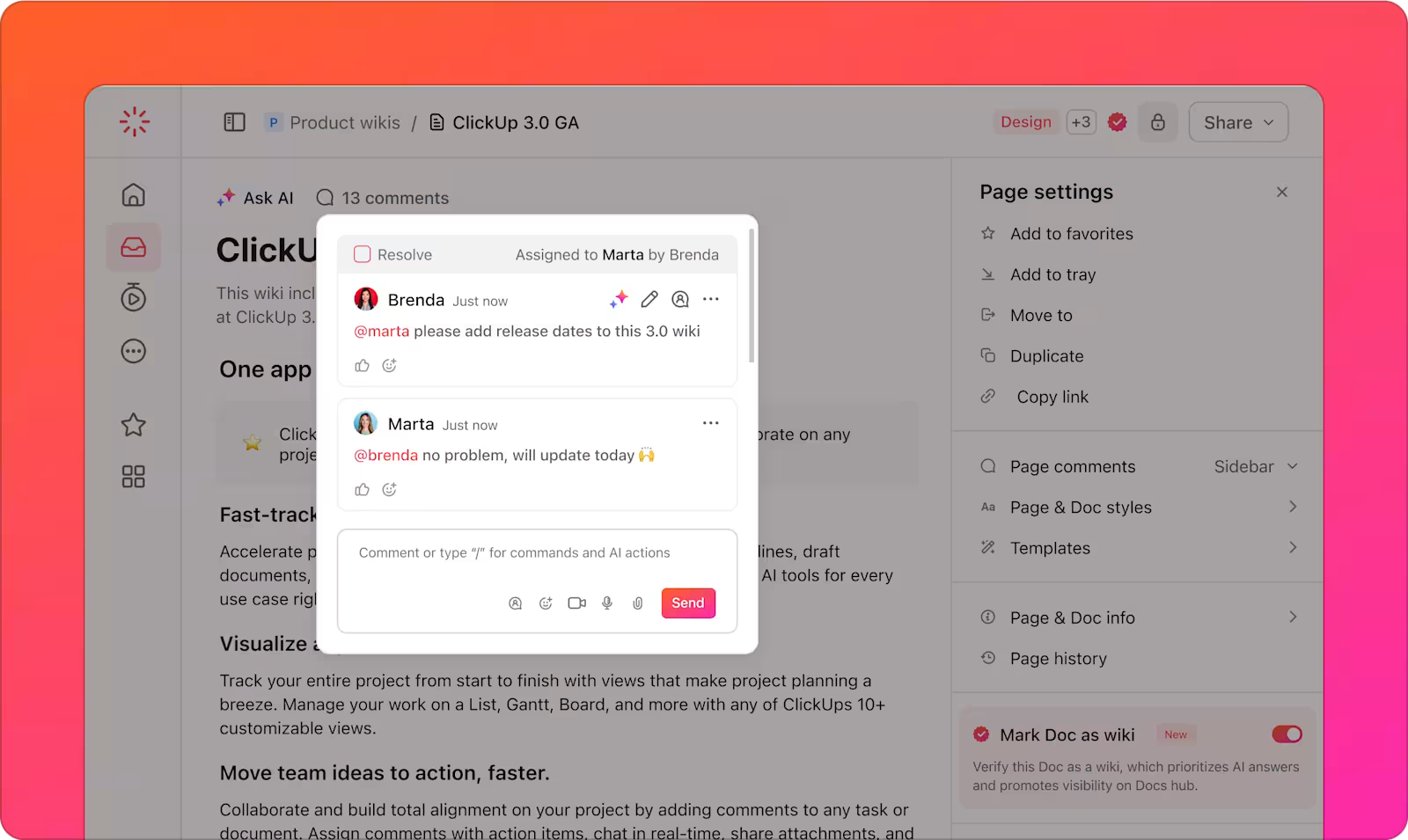

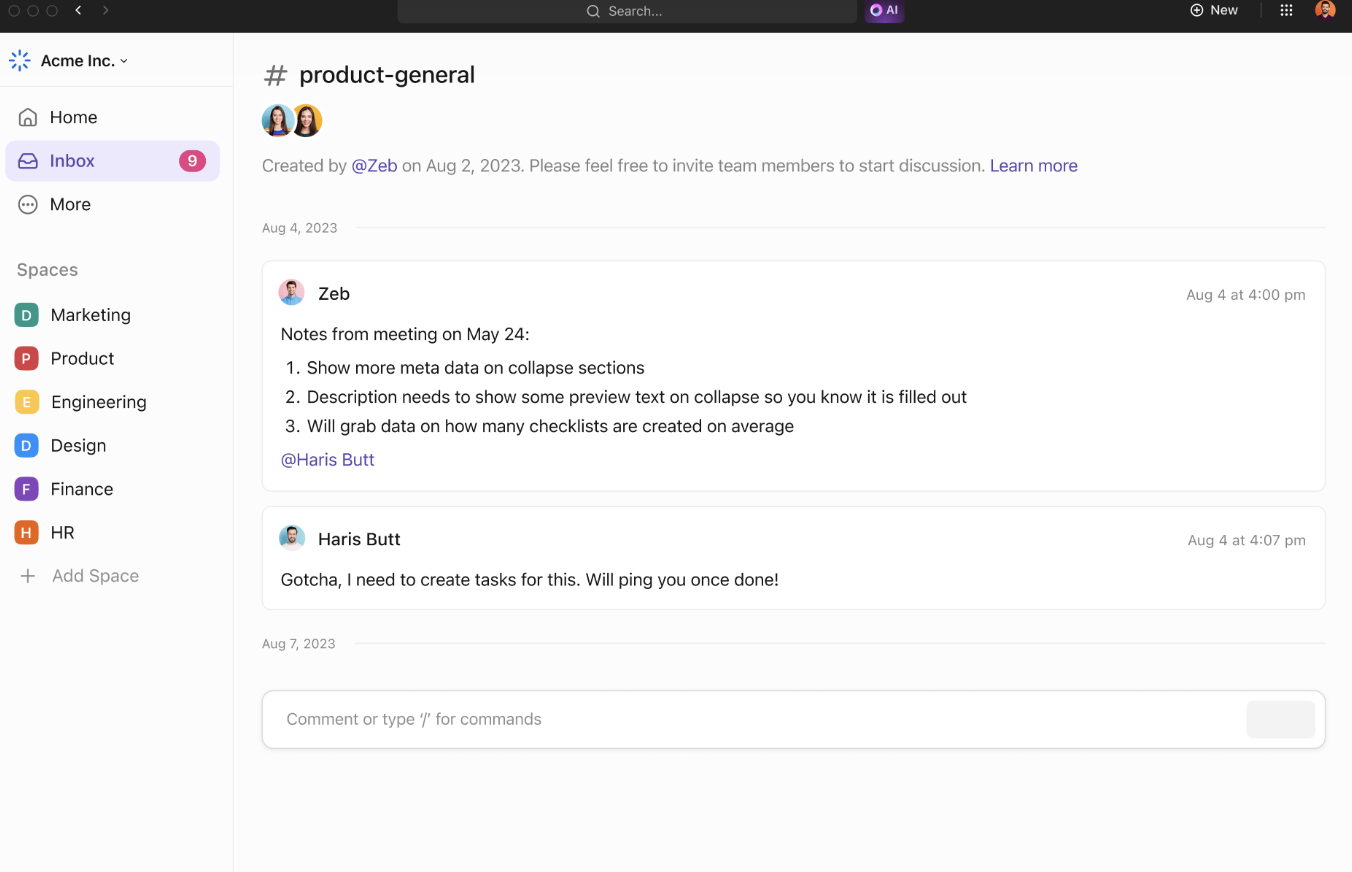

Gli strumenti di collaborazione di ClickUp supportano ulteriormente l'efficienza del team e la condivisione delle informazioni. ClickUp Chat consente ai membri del team di discutere i progetti, condividere idee e porre domande in tempo reale.

I commenti assegnati forniscono un modo chiaro per comunicare su documenti o attività specifici, garantendo che tutti rimangano informati sugli aggiornamenti del progetto.

I team possono collaborare tramite la condivisione di idee e la visualizzazione di concetti. Aggiungi note, carica immagini e incorpora link per un contesto migliore. Utilizza i connettori per collegare le idee ed evidenziare le loro relazioni.

Quando le tue idee sono pronte, convertile in attività tracciabili dalle lavagne online ClickUp per mantenere tutto in linea con i tempi previsti.

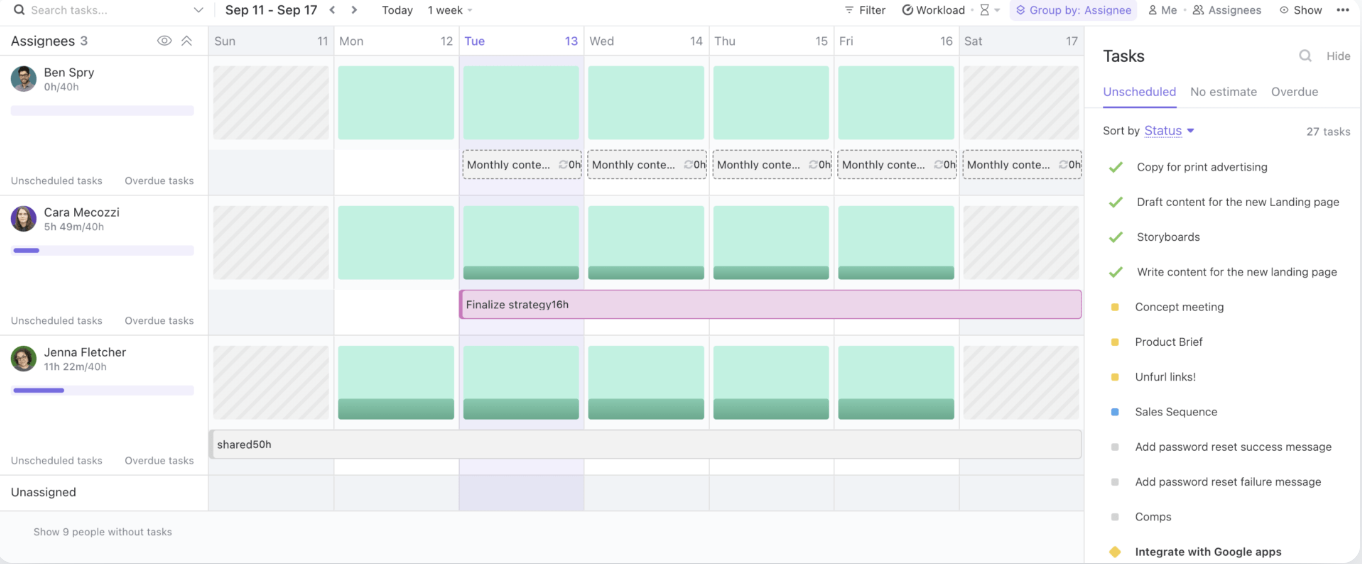

Infine, la vista Carico di lavoro di ClickUp ti consente di gestire la capacità del team, monitorare le attività in corso e allocare le risorse in modo efficace.

Fornendo un hub centralizzato per la condivisione delle conoscenze e la collaborazione, ClickUp semplifica i flussi di lavoro e migliora l'efficienza del team.

Best practice per l'utilizzo dei motori di ricerca LLM

Quando si utilizzano motori di ricerca LLM, è essenziale seguire le best practice che massimizzano il loro potenziale gestendo al contempo i rischi.

Queste strategie ti aiuteranno a ottenere il massimo dai tuoi strumenti di IA, garantendo un'implementazione fluida e un esito positivo a lungo termine:

- Definisci casi d'uso chiari: collabora sin dalle prime fasi tra i team aziendali e tecnici per stabilire casi d'uso specifici e misurabili. Allinea gli obiettivi per garantire che la soluzione soddisfi le esigenze giuste e renda facile valutare i progressi.

- Stabilisci processi di acquisizione ponderati: considera la sensibilità dei dati, i potenziali rischi e gli utenti previsti quando dai priorità ai casi d'uso. Utilizza un approccio basato su livelli di rischio per valutare quali progetti offrono il massimo valore con il minimo danno.

- Concentrati sulla raccolta, il test e la convalida dei dati: garantisci dati solidi e basati su fatti migliorando le pratiche di raccolta, etichettatura, spazio di archiviazione ed elaborazione.

- Implementa procedure di test standardizzate: crea processi di test ripetibili con supporto di playbook e pratiche predefinite. Assicurati risultati coerenti, affidabilità del sistema e modelli di IA ben testati prima dell'implementazione.

- Imposta un monitoraggio continuo: monitora le prestazioni del sistema nel tempo, adattandoti ai cambiamenti dei dati, al comportamento degli utenti e alla tecnologia.

- Lancia campagne di formazione e comunicazione: fornisci al tuo team le conoscenze necessarie per utilizzare gli strumenti di IA in modo responsabile ed efficace. Lancia programmi di formazione e comunicazione che coprano sia gli aspetti tecnici che quelli etici dell'IA.

Sfide e soluzioni nella ricerca basata su LLM

I motori di ricerca basati su LLM offrono un potenziale enorme, ma presentano anche una serie di sfide. Di seguito sono riportate alcune sfide comuni dell'IA e soluzioni pratiche per superarle:

Qualità e pertinenza dei dati

I motori di ricerca basati su LLM dipendono fortemente dalla qualità e dalla pertinenza dei dati che elaborano. Dati scadenti o obsoleti possono portare a risultati di ricerca imprecisi o irrilevanti, influenzando negativamente l'esperienza dell'utente.

✨ Concentrandosi su dati aggiornati e di alta qualità, le organizzazioni possono garantire che il loro motore di ricerca basato su LLM restituisca risultati pertinenti e affidabili.

Mancanza di trasparenza

I modelli LLM sono spesso considerati "scatole nere", in cui il ragionamento alla base dei loro risultati non è immediatamente evidente agli utenti. Questa mancanza di trasparenza può rendere difficile per gli utenti fidarsi dei risultati che ricevono.

✨ Incorporando funzionalità di spiegabilità nel motore di ricerca, le organizzazioni possono fornire agli utenti informazioni dettagliate sul motivo per cui sono stati restituiti risultati specifici.

Pregiudizi e questioni etiche

Gli LLM possono ereditare i pregiudizi dai dati su cui sono stati addestrati, il che può portare a risultati distorti o non etici. Se i dati di addestramento non sono diversificati o rappresentativi, il motore di ricerca potrebbe riflettere tali pregiudizi, influenzando il processo decisionale e l'equità.

✨ Verificare e aggiornare regolarmente i dati di addestramento è essenziale per identificare e mitigare questi pregiudizi. Inoltre, l'integrazione di set di dati diversificati e il monitoraggio dei risultati garantiscono che il motore di ricerca produca risultati più equilibrati, equi ed etici.

Complessità e integrazione del sistema

L'integrazione dei motori di ricerca basati su LLM con i flussi di lavoro e le applicazioni esistenti può essere scoraggiante, soprattutto quando si ha a che fare con sistemi legacy o più fonti di dati. La complessità della connessione di questi nuovi strumenti con piattaforme consolidate può rallentare l'implementazione.

✨ Con la ricerca connessa di ClickUp, puoi trovare rapidamente qualsiasi file, sia che sia archiviato in ClickUp, in un'app connessa o sul tuo disco locale.

Il problema delle allucinazioni

Le allucinazioni si riferiscono a istanze in cui il modello genera informazioni fattualmente errate, inventate o irrilevanti. Ciò accade perché il modello, invece di attingere direttamente dalle fonti indicizzate, a volte "allucina" i dati sulla base dei modelli appresi durante l'addestramento.

✨ Tecniche avanzate come il prompt engineering e dati di addestramento di alta qualità migliorano l'affidabilità dell'LLM. La messa a punto con dati specifici del dominio riduce le allucinazioni, mentre l'integrazione del grafico di conoscenza garantisce risultati di ricerca accurati e basati sui fatti.

Il futuro della ricerca con gli LLM

La prossima generazione di motori di ricerca basati su LLM promette una precisione, un'adattabilità e una reattività ancora maggiori, in particolare nella gestione di query utente complesse e dinamiche. Questi sistemi si adatteranno dinamicamente alle esigenze in continua evoluzione degli utenti, apprendendo dalle interazioni precedenti e dai dati in tempo reale.

Ad esempio, in un contesto di azienda, un LLM potrebbe interpretare una richiesta come "Trova l'analisi del tasso di abbandono dei clienti dell'ultimo trimestre" e restituire non solo il file grezzo, ma anche approfondimenti sintetizzati, tendenze rilevanti e conclusioni attuabili.

I settori che hanno una dipendenza dalla gestione di set di dati vasti e complessi sono quelli che trarranno i maggiori vantaggi:

- Nel settore sanitario, i modelli linguistici di grandi dimensioni possono fornire supporto per la precisione diagnostica analizzando e incrociando note cliniche, risultati di imaging e articoli di ricerca in pochi secondi.

- I professionisti legali trarranno vantaggio da strumenti in grado di analizzare una vasta giurisprudenza per evidenziare i precedenti rilevanti.

- I team finanziari possono utilizzare gli LLM per attività quali il rilevamento delle frodi in tempo reale, l'analisi predittiva dei mercati e l'automazione dei controlli di conformità.

L'integrazione di funzionalità di ricerca multimodale, che combinano il riconoscimento del testo, della voce e delle immagini, amplierà ulteriormente l'utilità degli LLM.

Ad esempio, un team che collabora al lancio di un prodotto potrebbe caricare istantaneamente immagini, aggiungere annotazioni con input vocali e recuperare documenti e report correlati. Questo livello di adattabilità rende gli LLM fondamentali per garantire un accesso senza soluzione di continuità a diversi formati di dati.

Piattaforme come ClickUp, combinate con la ricerca basata su LLM, offrono una soluzione robusta per organizzare e accedere ai file, ottimizzare i flussi di lavoro e migliorare l'efficienza del processo decisionale.

Potenzia il tuo flusso di lavoro con la ricerca basata su LLM

I motori di ricerca basati sull'IA e alimentati da LLM continuano a evolversi, rivoluzionando il modo in cui le aziende recuperano le informazioni dalle pagine web e gestiscono i dati.

Grazie alla loro capacità di comprendere il contesto, fornire risultati più accurati e integrarsi perfettamente con i flussi di lavoro dell'azienda, gli LLM stanno aprendo la strada a operazioni più intelligenti, veloci ed efficienti.

E quando si tratta di trovare un motore di ricerca basato sull'IA perfettamente integrato nel tuo flusso di lavoro, niente batte ClickUp Brain. Che tu abbia bisogno di individuare rapidamente un file o un'attività, raccogliere idee o persino redigere una bozza di email, le potenti funzionalità di IA di ClickUp Brain possono gestire tutto.

L'integrazione con gli strumenti completi di project management di ClickUp garantisce che tutto sia a portata di mano, aiutandoti a rimanere organizzato, risparmiare tempo e prendere decisioni basate sui dati più rapidamente.

Cosa aspetti? Iscriviti oggi stesso a ClickUp e ottieni di più con ClickUp Brain!