La plupart des équipes d'entreprise qui explorent LLaMA se retrouvent bloquées au même stade : elles téléchargent les poids du modèle, fixent la fenêtre du terminal et se rendent compte qu'elles ne savent pas quoi faire ensuite.

Ce défi est très répandu : alors que 88 % des entreprises utilisent l'IA dans au moins une fonction, seules 7 % l'ont déployée à l'échelle de l'organisation.

Ce guide vous accompagne tout au long du processus, depuis la sélection de la taille de modèle adaptée à votre cas d'utilisation jusqu'à son ajustement en fonction des données de votre entreprise, afin que vous puissiez déployer une solution d'IA fonctionnelle qui comprend réellement le contexte de votre activité.

Qu'est-ce que LLaMA et pourquoi est-ce important pour l'IA d'entreprise ?

LLaMA (abréviation de Large Language Model Meta IA) est une famille de modèles linguistiques ouverts créés par Meta. À un niveau élevé, il fait les mêmes tâches fondamentales que des modèles tels que GPT ou Gemini : il comprend le langage, génère du texte et peut raisonner à partir d'informations. La grande différence réside dans la manière dont les entreprises peuvent l'utiliser.

LLaMA étant open-weight, les entreprises ne sont pas obligées d'interagir avec lui uniquement via une API black-box. Elles peuvent l'exécuter sur leur propre infrastructure, l'ajuster en fonction de leurs données internes et contrôler comment et où il est déployé.

Pour les entreprises, c'est très important, surtout lorsque la confidentialité des données, la conformité et la prévisibilité des coûts priment sur la nouveauté.

Cette flexibilité rend LLaMA particulièrement attrayant pour les équipes qui souhaitent intégrer profondément l'IA dans leurs flux de travail, et non pas simplement l'ajouter sous la forme d'un chatbot autonome. Pensez aux assistants de connaissances internes, à l'automatisation du service client, aux outils de développement ou aux fonctionnalités d'IA directement intégrées aux produits, sans envoyer de données sensibles à l'extérieur de l'organisation.

En bref, LLaMA est important pour l'IA de l'entreprise car il offre aux équipes le choix en matière de déploiement, de personnalisation et d'intégration de l'IA dans les systèmes commerciaux réels. Et à mesure que l'IA passe de l'expérimentation aux opérations quotidiennes, ce niveau de contrôle devient moins un « plus » qu'une nécessité.

Comment démarrer avec LLaMA pour les applications d'entreprise

1. Définissez votre cas d'utilisation pour l'entreprise

Avant de télécharger quoi que ce soit, identifiez précisément les flux de travail dans lesquels l'IA peut avoir un impact réel. Il est essentiel d'adapter le cas d'utilisation de l'IA à la taille du modèle : les modèles 8B plus petits sont efficaces pour les tâches simples, tandis que les modèles 70B+ plus grands sont mieux adaptés au raisonnement complexe.

Pour vous aider à identifier les applications d'IA adaptées à votre entreprise, regardez cet aperçu des cas d'utilisation pratiques de l'IA dans différentes fonctions et secteurs d'activité :

Les points de départ courants sont les suivants :

- Traitement de documents : résumer de longs rapports ou extraire des informations clés de contrats.

- Assistance au codage : génération de code standard, explication des systèmes hérités ou suggestions d'optimisations.

- Récupération des connaissances : répondre aux questions des employés en effectuant des recherches dans la documentation interne à l'aide d'une technique appelée « Retrieval-Augmented Generation » (RAG).

- Génération de contenu : rédaction de premières ébauches de communications ou de textes marketing.

2. Configurer les prérequis et les dépendances

Ensuite, préparez votre matériel et vos logiciels. La taille du modèle détermine vos besoins : un modèle LLaMA 8B nécessite un GPU avec environ 15 Go de VRAM, tandis qu'un modèle 70B nécessite 131 Go ou plus.

Votre pile logicielle doit inclure Python 3. 8+, PyTorch, les pilotes CUDA et l'écosystème Hugging Face (transformateurs, accélération et bitsandbytes).

3. Accédez aux poids du modèle LLaMA et téléchargez-les.

Vous pouvez obtenir les poids du modèle sur la page officielle de téléchargement de Llama de Meta ou sur le hub de modèles Hugging Face. Vous devrez accepter la licence communautaire Llama 3, qui autorise l'utilisation commerciale. En fonction de votre installation, vous téléchargerez les poids au format safetensors ou GGUF.

4. Configurez votre environnement de développement

Une fois les poids téléchargés, il est temps de configurer votre environnement. Installez les bibliothèques Python nécessaires, notamment transformers, accelerate et bitsandbytes pour la quantification, un processus qui réduit l'empreinte mémoire du modèle.

Chargez le modèle avec les paramètres appropriés et exécutez une invite de test simple pour vous assurer que tout fonctionne correctement avant de passer à la personnalisation.

💡Si vous ne disposez pas d'une équipe dédiée à l'infrastructure ML, l'ensemble de ce processus peut s'avérer infructueux. Évitez toute la complexité du déploiement grâce à ClickUp Brain. Il offre des fonctionnalités d'IA telles que l'aide à la rédaction et l'automatisation des tâches directement dans l'environnement de travail où votre équipe opère déjà, sans qu'il soit nécessaire de télécharger des modèles ou de provisionner des GPU.

Comment personnaliser LLaMA pour les données de votre entreprise

Utiliser un modèle LLaMA de base est un bon début, mais celui-ci ne comprendra pas les acronymes, les noms de projets ou les processus internes propres à votre entreprise. Cela conduit à des réponses génériques et inutiles qui ne permettent pas de résoudre les problèmes réels de l'entreprise.

L'IA d'entreprise devient utile grâce à une personnalisation, c'est-à-dire l'entraînement du modèle à votre terminologie et à votre base de connaissances spécifiques.

Préparez vos données d'entraînement spécifiques à votre domaine

La réussite de votre IA personnalisée dépend davantage de la qualité de vos données d'entraînement que de la taille du modèle ou de la puissance de calcul. Commencez par rassembler et nettoyer vos informations internes.

- Documentation interne : rassemblez les spécifications des produits, les guides de processus et les documents relatifs aux politiques.

- Communications historiques : rassemblez des modèles d'e-mails, des réponses à des tickets d'assistance et des résumés de réunion.

- Terminologie du domaine : compilez des glossaires, des définitions d'acronymes et du vocabulaire spécifique à votre secteur d'activité.

Une fois ces informations recueillies, mettez-les en forme sous forme de paires instruction-réponse pour un réglage supervisé. Par exemple, une instruction pourrait être « Résumez ce ticket d'assistance », et la réponse serait un résumé clair et concis. Cette étape est cruciale pour apprendre au modèle à effectuer des tâches spécifiques avec vos données.

📮 ClickUp Insight : En moyenne, un professionnel passe plus de 30 minutes par jour à rechercher des informations liées à son travail, soit plus de 120 heures par an perdues à fouiller dans ses e-mails, ses fils de discussion Slack et ses fichiers éparpillés. Un assistant IA intelligent intégré à votre environnement de travail peut changer cela.

Découvrez ClickUp Brain. Il fournit des informations et des réponses instantanées en faisant apparaître les bons documents, discussions et détails de tâches en quelques secondes, afin que vous puissiez arrêter de chercher et commencer à travailler.

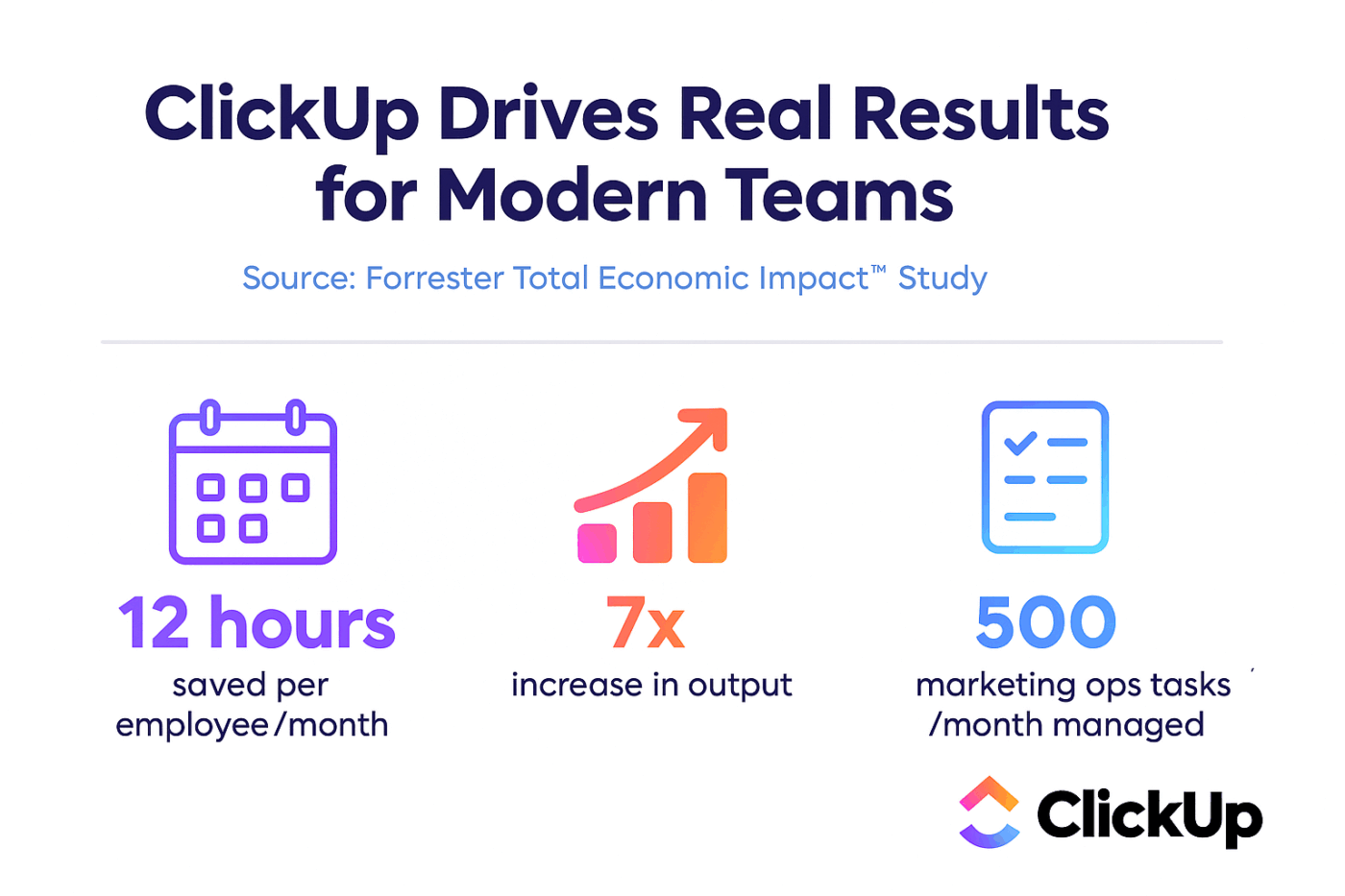

💫 Résultats concrets : des équipes telles que QubicaAMF ont gagné plus de 5 heures par semaine grâce à ClickUp, soit plus de 250 heures par an et par personne, en éliminant les processus de gestion des connaissances obsolètes. Imaginez ce que votre équipe pourrait accomplir avec une semaine supplémentaire de productivité chaque trimestre !

Affinez LLaMA en fonction du contexte de votre entreprise.

Le réglage fin est le processus qui consiste à adapter les connaissances existantes de LLaMA à votre cas d'utilisation spécifique, ce qui améliore considérablement sa précision sur des tâches spécifiques à un domaine. Au lieu de former un modèle à partir de zéro, vous pouvez utiliser des méthodes efficaces en termes de paramètres qui ne mettent à jour qu'un petit sous-ensemble des paramètres du modèle, ce qui vous permet d'économiser du temps et des ressources informatiques.

Les méthodes de réglage les plus courantes sont les suivantes :

- LoRA (Low-Rank Adaptation) : cette méthode forme de petites matrices « adaptatrices » au lieu du modèle entier, ce qui la rend très efficace.

- QLoRA : cette technologie combine LoRA et la quantification pour permettre un réglage fin sur un seul GPU de 48 Go tout en offrant des performances de réglage fin optimales.

- Réglage complet : cette option met à jour tous les paramètres du modèle, offrant le niveau de personnalisation le plus poussé, mais nécessitant une puissance de calcul importante.

📚 À lire également : Les outils d'IA générative d'entreprise qui transforment le travail

Évaluer et itérer les performances du modèle

Comment savoir si votre modèle personnalisé fonctionne réellement ? L'évaluation de l'IA doit aller au-delà des simples scores de précision et mesurer l'utilité dans le monde réel. Créez des ensembles de données d'évaluation qui reflètent vos cas d'utilisation en production et suivez les indicateurs qui comptent pour votre entreprise, tels que la qualité des réponses, l'exactitude factuelle et la latence.

- Évaluation qualitative : demandez à des évaluateurs humains d'évaluer les résultats en termes de ton, d'utilité et d'exactitude.

- Indicateurs quantitatifs : utilisez des scores automatisés tels que BLEU ou la perplexité pour suivre les performances à grande échelle.

- Suivi de la production : une fois le modèle déployé, suivez les commentaires des utilisateurs et les taux d'erreurs afin d'identifier les points à améliorer.

💡Ce processus itératif de formation et d'évaluation peut devenir un projet à part entière. Gérez le cycle de vie du développement de votre IA directement dans ClickUp au lieu de vous perdre dans des feuilles de calcul.

Centralisez les indicateurs de performance et les résultats d'évaluation dans une seule vue grâce aux tableaux de bord ClickUp. Suivez les versions des modèles, les paramètres de formation et les scores d'évaluation parallèlement à vos autres travaux sur les produits grâce aux champs personnalisés ClickUp, qui vous permettent de tout organiser et de tout visualiser. 🛠️

Principaux cas d'utilisation de LLaMA en entreprise

Les équipes se retrouvent souvent paralysées par l'analyse, incapables de passer de l'enthousiasme abstrait pour l'IA à des applications concrètes. La flexibilité de LLaMA le rend adapté à un large éventail de flux de travail d'entreprise, vous aidant à automatiser les tâches et à travailler plus efficacement.

Voici quelques-uns des principaux cas d'utilisation d'un modèle LLaMA personnalisé :

- Assistants de connaissances internes : ne perdez plus de temps à rechercher des informations. Déployez LLaMA avec RAG pour créer un chatbot capable de répondre instantanément aux questions des employés en effectuant des recherches dans vos wikis internes, vos documents de politique et vos communications de projets passés.

- Automatisation du service client : affinez un modèle à partir de l'historique de vos tickets afin de rédiger automatiquement des réponses, de classer les demandes et de transférer les problèmes complexes au bon agent humain.

- Génération et révision de code : aidez votre équipe d'ingénieurs à travailler plus efficacement. Utilisez LLaMA pour générer du code standard, expliquer des systèmes hérités complexes et même identifier les bugs potentiels dans les demandes de tirage avant qu'ils ne deviennent des problèmes.

- Traitement de documents : transformez de grands volumes de texte en informations utiles. Résumez de longs rapports, extrayez les termes clés de contrats juridiques ou générez des notes de réunion concises à partir de transcriptions brutes en quelques secondes.

- Flux de travail de création de contenu : surmontez le syndrome de la page blanche. Rédigez des textes marketing, des descriptions de produits et des annonces internes que vos éditeurs humains pourront ensuite peaufiner et perfectionner.

💡Accédez à de nombreux cas d'utilisation prêts à l'emploi avec ClickUp Brain.

- Résumez les fils de tâches, rédigez des mises à jour de projet et générez du contenu grâce à l'aide à la rédaction alimentée par l'IA de ClickUp.

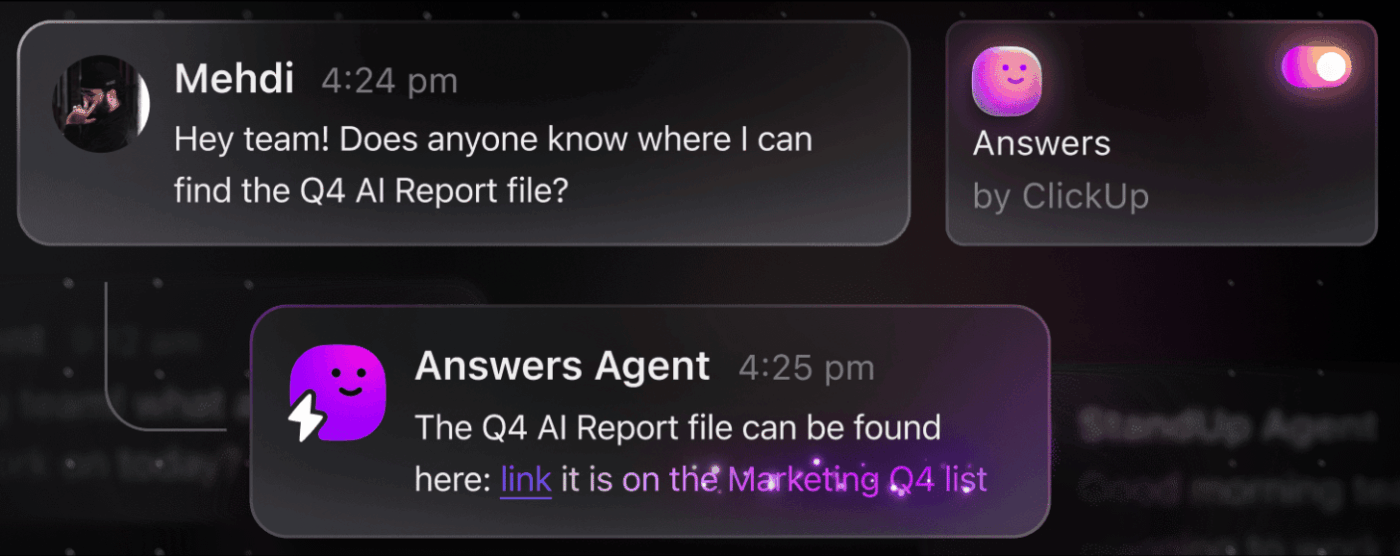

- Trouvez instantanément des réponses dans l'ensemble de vos environnements de travail grâce à la recherche d'entreprise de ClickUp et à l'agent Ambient Answers préconfiguré.

- Créez des flux de travail intelligents qui gèrent le travail routinier à votre place avec ClickUp Automatisations.

Limites de l'utilisation de LLaMA pour l'IA de l'entreprise

Bien que l'auto-hébergement de LLaMA offre un contrôle important, il n'est pas sans difficultés. Les équipes sous-estiment souvent les frais généraux opérationnels et s'enlisent dans la maintenance au lieu de se concentrer sur l'innovation. Avant de s'engager dans la voie de la « construction », il est essentiel de comprendre les obstacles potentiels.

Voici quelques-unes des principales limites à prendre en compte :

- Exigences en matière d'infrastructure : l'exécution de modèles volumineux est coûteuse et nécessite des GPU puissants de niveau entreprise, dont de nombreuses organisations ne disposent pas.

- Expertise technique requise : le déploiement, le réglage et la maintenance d'un modèle linguistique de grande envergure nécessitent des compétences spécialisées en ingénierie ML qui sont très recherchées.

- Charge de maintenance continue : il ne s'agit pas d'une solution « à configurer puis à oublier ». Les modèles nécessitent une surveillance constante, des mises à jour de sécurité et un réentraînement à mesure que votre entreprise évolue.

- Risque d'hallucination : comme tous les LLM, LLaMA peut parfois générer des informations qui semblent plausibles, mais qui sont incorrectes. Les applications d'entreprise nécessitent des garde-fous solides et une supervision humaine pour atténuer ce risque.

- Aucune fonctionnalité d'entreprise intégrée : les fonctionnalités essentielles telles que le contrôle d'accès, la journalisation des audits et les outils de conformité doivent être développées et gérées séparément, ce qui ajoute une couche supplémentaire de complexité.

💡Vous pouvez contourner ces limitations en utilisant ClickUp Brain. Il fournit une IA gérée au sein de votre environnement de travail existant, vous offrant des capacités d'IA d'entreprise sans frais généraux opérationnels. Bénéficiez d'une sécurité de niveau entreprise et éliminez la maintenance de l'infrastructure avec ClickUp, libérant ainsi votre équipe pour qu'elle puisse se concentrer sur son travail principal.

📮ClickUp Insight : 88 % des personnes interrogées dans le cadre de notre sondage utilisent l'IA pour leurs tâches personnelles, mais plus de 50 % hésitent à l'utiliser au travail. Les trois principaux obstacles ? Le manque d'intégration transparente, les lacunes en matière de connaissances ou les préoccupations liées à la sécurité.

Mais que se passe-t-il si l'IA est intégrée à votre environnement de travail et est déjà sécurisée ? ClickUp Brain, l'assistant IA intégré à ClickUp, rend cela possible. Il comprend les invites en langage naturel, résolvant ainsi les trois problèmes liés à l'adoption de l'IA tout en effectuant la connexion entre vos discussions, tâches, documents et connaissances dans tout l'environnement de travail. Trouvez des réponses et des informations en un seul clic !

Outils d'IA alternatifs pour les cas d'utilisation en entreprise

Choisir le bon outil d'IA parmi les nombreuses options disponibles est un défi pour toute équipe. Vous essayez de déterminer les compromis entre les différents modèles, mais vous craignez de faire le mauvais choix et de gaspiller des ressources.

Cela conduit souvent à une prolifération incontrôlée des outils et des plateformes d'IA, sans supervision ni stratégie, où les équipes s'abonnent à plusieurs services disparates, ce qui crée plus de travail au lieu d'en réduire.

Voici un aperçu rapide des principaux acteurs et de leur rôle :

| Outil | Idéal pour | Considérations clés |

|---|---|---|

| LLaMA (auto-hébergé) | Contrôle maximal, souveraineté des données | Nécessite une infrastructure ML et une expertise en la matière. |

| OpenAI GPT-4 | Capacité maximale, installation minimale | Les données quittent votre environnement, tarification basée sur l'utilisation |

| Claude (Anthropic) | Tâches à contexte long, accent mis sur la sécurité | Compromis similaires à ceux de GPT-4 |

| Mistral | Résidence des données en Europe, efficacité | Écosystème plus petit que LLaMA |

| ClickUp Brain | IA intégrée à l'environnement de travail, sans déploiement | Idéal pour les équipes qui souhaitent intégrer l'IA dans leurs flux de travail existants. |

Au lieu de connecter plusieurs outils pour répondre à vos besoins, pourquoi ne pas accéder à l'IA directement intégrée à votre environnement de travail ? C'est l'essence même de ClickUp, le premier espace de travail convergent basé sur l'IA au monde, une plateforme unique et sécurisée où les projets, les documents, les discussions et les analyses cohabitent.

Il unifie vos outils afin d'éliminer la fragmentation contextuelle qui survient lorsque les équipes perdent des heures à passer d'une application à l'autre et à rechercher les informations dont elles ont besoin pour faire leur travail.

ClickUp + IA contextuelle = transformation mesurable

Selon une étude Forrester Economic Impact™, les équipes utilisant ClickUp ont enregistré un retour sur investissement de 384 % et économisé 92 400 heures au bout de trois ans.

Lorsque le contexte, les flux de travail et l'intelligence sont réunis en un seul endroit, les équipes ne se contentent pas de travailler. Elles gagnent.

ClickUp offre également les fonctionnalités de sécurité et d'administration requises pour les déploiements en entreprise, avec la conformité SOC 2 Type II, l'intégration SSO, le provisionnement SCIM et des contrôles d'autorisation granulaires.

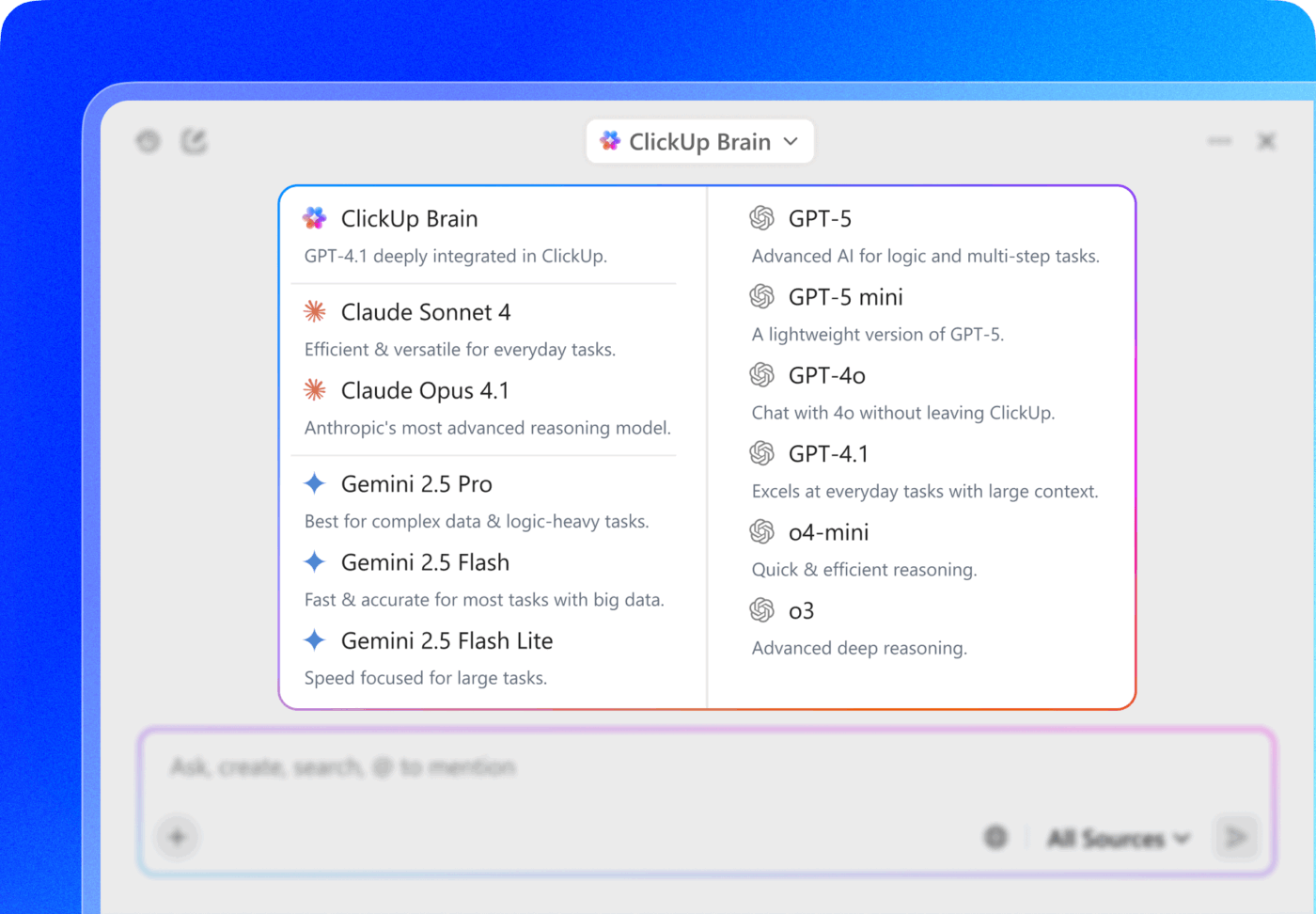

L'accès multi-LLM de ClickUp Brain MAX vous permet de choisir entre des modèles haut de gamme tels que ChatGPT, Claude et Gemini directement depuis l'interface de recherche. La plateforme achemine automatiquement votre requête vers le modèle le mieux adapté à la tâche, vous permettant ainsi de bénéficier du meilleur des deux mondes sans avoir à gérer plusieurs abonnements.

Obtenez l'ensemble des fonctionnalités (capacités d'IA, gestion de projet, documentation et communication) en un seul endroit avec ClickUp, plutôt que de créer la couche IA à partir de zéro avec LLaMA.

Allez de l'avant avec l'IA d'entreprise grâce à ClickUp

LLaMA offre aux équipes d'entreprise une alternative ouverte aux API d'IA fermées, offrant un contrôle significatif, une prévisibilité des coûts et une personnalisation. Mais la réussite ne dépend pas uniquement de la technologie. Il faut trouver le modèle adapté à chaque cas d'utilisation, investir dans des données d'entraînement de haute qualité et mettre en place des processus d'évaluation robustes.

La décision « créer ou acheter » dépend en fin de compte des capacités techniques de votre équipe. Si la création d'une solution personnalisée offre une flexibilité maximale, elle s'accompagne également de frais généraux importants. Le véritable défi ne consiste pas seulement à accéder à l'IA, mais aussi à l'intégrer dans vos flux de travail quotidiens sans créer davantage de prolifération de l'IA et de silos de données.

Intégrez les capacités LLM directement dans votre gestion de projet, votre documentation et la communication de votre équipe avec ClickUp Brain, sans la complexité liée à la création et à la maintenance d'une infrastructure. Commencez gratuitement avec ClickUp et intégrez les capacités de l'IA directement dans vos flux de travail existants. 🙌

Foire aux questions (FAQ)

Oui, la licence communautaire Llama 3 autorise l'utilisation commerciale pour la plupart des organisations. Seules les entreprises comptant plus de 700 millions d'utilisateurs actifs par mois doivent obtenir une licence distincte auprès de Meta.

LLaMA offre un meilleur contrôle des données et des coûts prévisibles grâce à l'auto-hébergement, tandis que GPT-4 offre des performances prêtes à l'emploi supérieures avec moins d'installation. Pour gagner en productivité, bénéficiez toutefois d'une assistance IA sans avoir à gérer les modèles sous-jacents grâce à des outils intégrés tels que ClickUp Brain.

L'auto-hébergement de LLaMA permet de conserver les données sur votre infrastructure, ce qui est idéal pour la résidence des données. Cependant, vous êtes responsable de la mise en œuvre de vos propres contrôles d'accès, journaux d'audit et filtres de contenu, des fonctionnalités de sécurité généralement incluses dans les services d'IA gérés.

Le déploiement et le réglage fin de LLaMA nécessitent des compétences importantes en ingénierie ML. Les équipes qui ne disposent pas de cette expertise peuvent accéder aux fonctionnalités basées sur LLaMA via des plateformes gérées telles que ClickUp Brain, qui fournit des fonctionnalités d'IA sans aucun déploiement de modèle ni configuration technique.