تتعثر معظم فرق المؤسسات التي تستكشف LLaMA عند نفس النقطة: يقومون بتنزيل أوزان النماذج، ويحدقون في نافذة المحطة الطرفية، ثم يدركون أنهم لا يعرفون ماذا يفعلون بعد ذلك.

هذا التحدي واسع الانتشار — في حين أن 88٪ من الشركات تستخدم الذكاء الاصطناعي في وظيفة واحدة على الأقل، فإن 7٪ فقط قامت بتوسيع نطاقه على مستوى المؤسسة.

يوجهك هذا الدليل خلال العملية الكاملة، بدءًا من اختيار حجم النموذج المناسب لحالة الاستخدام الخاصة بك وحتى ضبطه وفقًا لبيانات شركتك، حتى تتمكن من نشر حل ذكاء اصطناعي فعال يفهم سياق عملك بالفعل.

ما هو LLaMA ولماذا هو مهم للذكاء الاصطناعي للمؤسسات؟

LLaMA (اختصار لـ Large Language Model Meta AI) هي مجموعة من نماذج اللغة المفتوحة التي أنشأتها Meta. على مستوى عالٍ، تقوم بنفس المهام الأساسية التي تقوم بها نماذج مثل GPT أو Gemini: فهي تفهم اللغة وتولد النصوص ويمكنها الاستدلال عبر المعلومات. الفرق الكبير هو كيف يمكن للمؤسسات استخدامها.

نظرًا لأن LLaMA مفتوح الوزن، لا تضطر الشركات إلى التفاعل معه فقط من خلال واجهة برمجة تطبيقات الصندوق الأسود. يمكنهم تشغيله على بنيتهم التحتية الخاصة، وضبطه على البيانات الداخلية، والتحكم في كيفية ومكان نشره.

بالنسبة للمؤسسات، يعد هذا أمرًا بالغ الأهمية، خاصةً عندما تكون خصوصية البيانات والامتثال وقابلية التنبؤ بالتكاليف أكثر أهمية من الجدة.

هذه المرونة تجعل LLaMA جذابة بشكل خاص للفرق التي ترغب في دمج الذكاء الاصطناعي بعمق في سير عملها، وليس فقط كروبوت دردشة مستقل. فكر في المساعدين المعرفيين الداخليين، وأتمتة دعم العملاء، وأدوات المطورين، أو ميزات الذكاء الاصطناعي المدمجة مباشرة في المنتجات — دون إرسال البيانات الحساسة خارج المؤسسة.

باختصار، LLaMA مهم للذكاء الاصطناعي للمؤسسات لأنه يمنح الفرق خيار بشأن النشر والتخصيص ودمج الذكاء الاصطناعي في أنظمة الأعمال الحقيقية. ومع انتقال الذكاء الاصطناعي من مرحلة التجربة إلى العمليات اليومية، يصبح هذا المستوى من التحكم أقل من مجرد "ميزة إضافية" وأكثر من متطلب أساسي.

كيفية البدء في استخدام LLaMA للتطبيقات المؤسسية

1. حدد حالة الاستخدام في مؤسستك

قبل تنزيل أي شيء، حدد سير العمل الدقيق الذي يمكن أن يكون للذكاء الاصطناعي تأثير حقيقي عليه. إن مطابقة حالة استخدام الذكاء الاصطناعي مع حجم النموذج أمر أساسي — النماذج الأصغر حجمًا 8B فعالة في المهام البسيطة، بينما النماذج الأكبر حجمًا 70B+ أفضل في عمليات الاستدلال المعقدة.

لمساعدتك في تحديد تطبيقات الذكاء الاصطناعي المناسبة لعملك، شاهد هذا العرض العام لحالات الاستخدام العملي للذكاء الاصطناعي في مختلف وظائف المؤسسات والصناعات:

تشمل نقاط البداية الشائعة ما يلي:

- معالجة المستندات: تلخيص التقارير الطويلة أو استخراج المعلومات الأساسية من العقود

- المساعدة في الكود: إنشاء كود نموذجي، وشرح الأنظمة القديمة، أو اقتراح تحسينات

- استرجاع المعرفة: الإجابة على أسئلة الموظفين من خلال البحث في الوثائق الداخلية باستخدام تقنية تسمى Retrieval-Augmented Generation (RAG)

- إنشاء المحتوى: صياغة مسودات الاتصالات الأولية أو النصوص التسويقية

2. إعداد المتطلبات المسبقة والتبعيات

بعد ذلك، قم بترتيب الأجهزة والبرامج الخاصة بك. حجم النموذج يحدد احتياجاتك؛ يتطلب نموذج LLaMA 8B وحدة معالجة رسومات (GPU) بسعة 15 جيجابايت تقريبًا من ذاكرة VRAM، بينما يتطلب نموذج 70B سعة 131 جيجابايت أو أكثر.

يجب أن تتضمن حزمة البرامج الخاصة بك Python 3. 8+ و PyTorch وبرامج تشغيل CUDA ونظام Hugging Face البيئي (المحولات والتسريع والبتات والبايتات).

3. الوصول إلى نماذج LLaMA وتنزيلها

يمكنك الحصول على أوزان النماذج من صفحة التنزيلات الرسمية لـ Llama على Meta أو من مركز نماذج Hugging Face. ستحتاج إلى قبول ترخيص Llama 3 Community License، الذي يسمح بالاستخدام التجاري. اعتمادًا على إعداداتك، ستقوم بتنزيل الأوزان بتنسيق safetensors أو GGUF.

4. تكوين بيئة التطوير الخاصة بك

بعد تنزيل الأوزان، حان الوقت لإعداد بيئتك. قم بتثبيت مكتبات Python الضرورية، بما في ذلك المحولات والتسريع والبتات والبايتات للتكمية — وهي عملية تقلل من حجم ذاكرة النموذج.

قم بتحميل النموذج بالإعدادات الصحيحة وقم بتشغيل اختبار بسيط للتأكد من أن كل شيء يعمل بشكل صحيح قبل الانتقال إلى التخصيص.

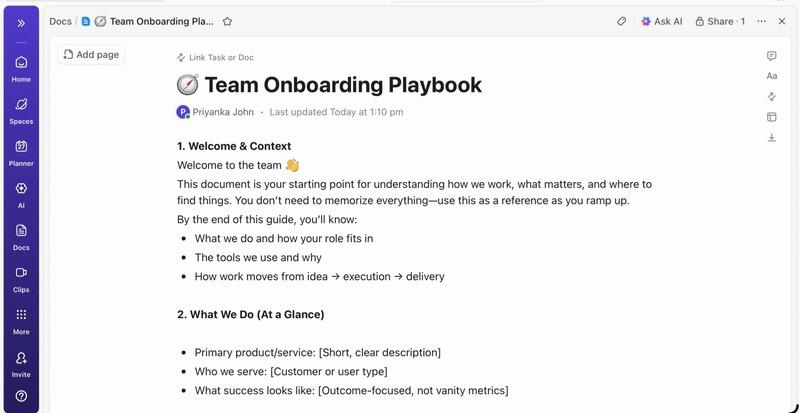

💡إذا لم يكن لديك فريق مخصص للبنية التحتية للتعلم الآلي، فقد تكون هذه العملية برمتها غير مجدية. تخطى تعقيدات النشر تمامًا باستخدام ClickUp Brain. يوفر إمكانات الذكاء الاصطناعي مثل المساعدة في الكتابة وأتمتة المهام مباشرةً داخل مساحة العمل التي يعمل فيها فريقك بالفعل — دون الحاجة إلى تنزيل النماذج أو توفير وحدات معالجة الرسومات.

كيفية تخصيص LLaMA لبيانات مؤسستك

يعد استخدام نموذج LLaMA الأساسي بداية جيدة، ولكنه لن يفهم الاختصارات الفريدة لشركتك أو أسماء المشاريع أو العمليات الداخلية. وهذا يؤدي إلى ردود عامة وغير مفيدة لا تحل المشكلات التجارية الحقيقية.

يصبح الذكاء الاصطناعي للمؤسسات مفيدًا من خلال التخصيص — تدريب النموذج على المصطلحات وقاعدة المعرفة الخاصة بك.

قم بإعداد بيانات التدريب الخاصة بمجال عملك

يعتمد نجاح الذكاء الاصطناعي المخصص لديك على جودة بيانات التدريب أكثر من حجم النموذج أو قوة الحوسبة. ابدأ بجمع وتنظيف المعلومات الداخلية لديك.

- الوثائق الداخلية: اجمع مواصفات المنتج وأدلة العمليات ووثائق السياسات

- الاتصالات التاريخية: اجمع قوالب البريد الإلكتروني وردود تذاكر الدعم وملخصات الاجتماعات

- مصطلحات المجال: تجميع قوائم المصطلحات وتعريفات الاختصارات واللغة الخاصة بالصناعة

بمجرد جمع هذه المعلومات، قم بتنسيقها في أزواج من التعليمات والاستجابات من أجل الضبط الدقيق تحت الإشراف. على سبيل المثال، قد تكون التعليمات "لخص تذكرة الدعم هذه"، وستكون الاستجابة ملخصًا واضحًا وموجزًا. هذه الخطوة مهمة للغاية لتعليم النموذج كيفية أداء مهام محددة باستخدام بياناتك.

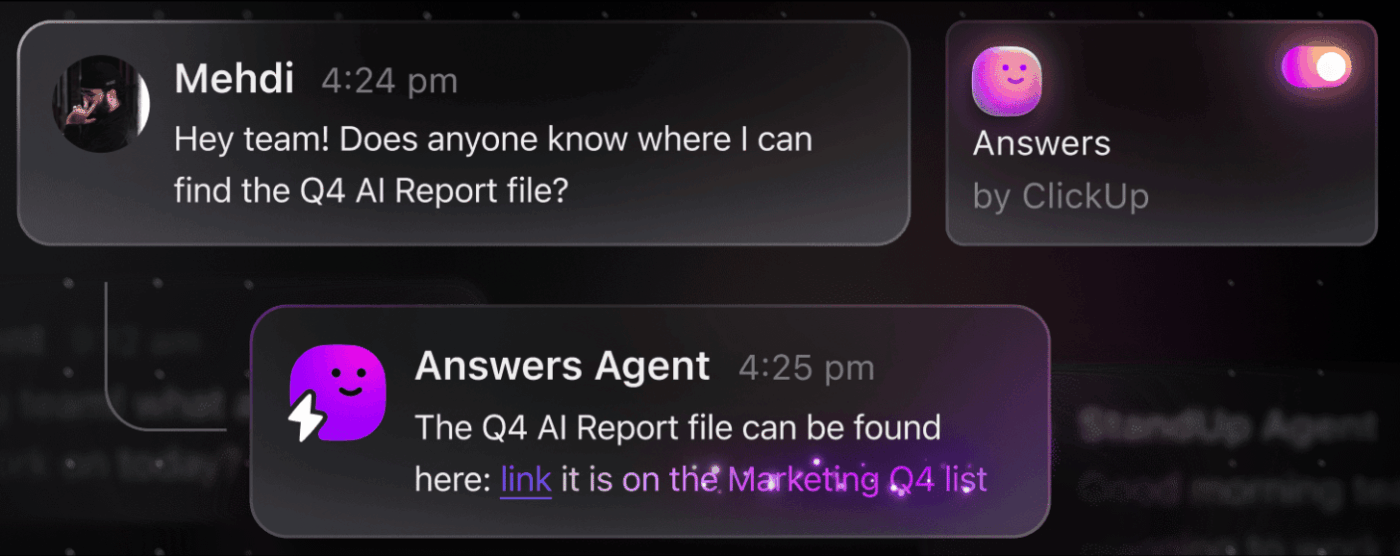

📮 ClickUp Insight: يقضي الموظف العادي أكثر من 30 دقيقة يوميًا في البحث عن معلومات متعلقة بالعمل، أي ما يزيد عن 120 ساعة سنويًا تضيع في البحث في رسائل البريد الإلكتروني ومحادثات Slack والملفات المتناثرة. يمكن لمساعد الذكاء الاصطناعي الذكي المدمج في مساحة العمل الخاصة بك تغيير ذلك.

أدخل ClickUp Brain. يوفر رؤى وإجابات فورية من خلال عرض المستندات والمحادثات وتفاصيل المهام المناسبة في ثوانٍ معدودة — حتى تتمكن من التوقف عن البحث والبدء في العمل.

💫 نتائج حقيقية: استعادت فرق مثل QubicaAMF أكثر من 5 ساعات أسبوعيًا باستخدام ClickUp — أي أكثر من 250 ساعة سنويًا لكل شخص — من خلال التخلص من عمليات إدارة المعرفة القديمة. تخيل ما يمكن أن يحققه فريقك بفضل أسبوع إضافي من الإنتاجية كل ثلاثة أشهر!

ضبط LLaMA وفقًا لسياق عملك

التحسين هو عملية تكييف المعرفة الحالية لـ LLaMA مع حالة الاستخدام المحددة الخاصة بك، مما يحسن بشكل كبير من دقتها في المهام الخاصة بالمجال. بدلاً من تدريب نموذج من الصفر، يمكنك استخدام طرق فعالة من حيث المعلمات لا تقوم إلا بتحديث مجموعة صغيرة من معلمات النموذج، مما يوفر الوقت والموارد الحسابية.

تشمل طرق الضبط الشائعة ما يلي:

- LoRA (التكيف منخفض الترتيب): تقوم هذه الطريقة بتدريب مصفوفات "مكيف" صغيرة بدلاً من النموذج بأكمله، مما يجعلها عالية الكفاءة.

- QLoRA: يجمع هذا بين LoRA والتكمية للسماح بالتحسين على وحدة معالجة رسومات واحدة سعة 48 جيجابايت مع مطابقة أداء التحسين الكامل.

- ضبط كامل: يعمل هذا على تحديث جميع معلمات النموذج، مما يوفر أعمق مستوى من التخصيص ولكنه يتطلب قوة حاسوبية كبيرة.

تقييم أداء النموذج وتكراره

كيف تعرف ما إذا كان النموذج المخصص الخاص بك يعمل بالفعل؟ يجب أن يتجاوز تقييم الذكاء الاصطناعي درجات الدقة البسيطة ويقيس الفائدة في العالم الحقيقي. قم بإنشاء مجموعات بيانات تقييم تعكس حالات الاستخدام الإنتاجية الخاصة بك وتتبع المقاييس المهمة لعملك، مثل جودة الاستجابة ودقة الحقائق والكمون.

- التقييم النوعي: اجعل المراجعين البشريين يقيمون المخرجات من حيث النبرة والفائدة والصحة.

- المقاييس الكمية: استخدم الدرجات الآلية مثل BLEU أو perplexity لتتبع الأداء على نطاق واسع.

- مراقبة الإنتاج: بمجرد النشر، تتبع ملاحظات المستخدمين ومعدلات الأخطاء لتحديد المجالات التي تحتاج إلى تحسين.

💡يمكن أن تصبح هذه العملية التكرارية للتدريب والتقييم مشروعًا بحد ذاتها. قم بإدارة دورة حياة تطوير الذكاء الاصطناعي مباشرة في ClickUp بدلاً من الضياع في جداول البيانات.

قم بتركيز مقاييس الأداء ونتائج التقييم في عرض واحد باستخدام لوحات معلومات ClickUp. تتبع إصدارات النماذج ومعلمات التدريب ونتائج التقييم جنبًا إلى جنب مع أعمالك الأخرى المتعلقة بالمنتج باستخدام حقول ClickUp المخصصة، مما يحافظ على تنظيم كل شيء ووضوحه. 🛠️

أهم حالات استخدام LLaMA في المؤسسات

غالبًا ما تتعثر الفرق في تحليلات لا تنتهي، ولا تستطيع الانتقال من الحماس النظري تجاه الذكاء الاصطناعي إلى التطبيقات العملية. مرونة LLaMA تجعله مناسبًا لمجموعة واسعة من سير العمل المؤسسي، مما يساعدك على أتمتة المهام والعمل بكفاءة أكبر.

فيما يلي بعض من أفضل حالات استخدام نموذج LLaMA المخصص:

- مساعدو المعرفة الداخليون: توقف عن إضاعة الوقت في البحث عن المعلومات. انشر LLaMA مع RAG لإنشاء روبوت دردشة يمكنه الإجابة على أسئلة الموظفين على الفور من خلال البحث في مواقع الويكي الداخلية ووثائق السياسات واتصالات المشاريع السابقة.

- أتمتة دعم العملاء: قم بضبط نموذج على سجل التذاكر الخاص بك لكتابة الردود تلقائيًا وتصنيف الاستفسارات وتصعيد المشكلات المعقدة إلى الموظف المناسب.

- إنشاء الكود ومراجعته: ساعد فريق الهندسة لديك على العمل بكفاءة أكبر. استخدم LLaMA لإنشاء كود نموذجي، وشرح الأنظمة القديمة المعقدة، وحتى تحديد الأخطاء المحتملة في طلبات السحب قبل أن تصبح مشاكل.

- معالجة المستندات: حوّل كميات كبيرة من النصوص إلى معلومات مفيدة. لخص التقارير الطويلة، واستخرج المصطلحات الرئيسية من العقود القانونية، أو أنشئ ملاحظات اجتماعات موجزة من النصوص الأولية في ثوانٍ معدودة.

- سير عمل إنشاء المحتوى: تغلب على عائق الكتابة. قم بصياغة مسودات النصوص التسويقية ووصف المنتجات والإعلانات الداخلية التي يمكن لمحرريك البشريين بعد ذلك صقلها وتحسينها.

💡يمكنك الوصول إلى العديد من حالات الاستخدام هذه فورًا باستخدام ClickUp Brain.

- لخص سلاسل المهام، وصغ مسودات تحديثات المشروع، وأنشئ محتوى باستخدام أداة المساعدة في الكتابة المدعومة بالذكاء الاصطناعي من ClickUp.

- اعثر على إجابات من جميع أنحاء مساحة العمل الخاصة بك على الفور باستخدام بحث المؤسسات من ClickUp ووكيل Ambient Answers المُعد مسبقًا.

- أنشئ سير عمل ذكي يتولى الأعمال الروتينية نيابة عنك باستخدام ClickUp Automations

قيود استخدام LLaMA في الذكاء الاصطناعي للمؤسسات

على الرغم من أن استضافة LLaMA بنفسك توفر قدرًا كبيرًا من التحكم، إلا أنها لا تخلو من التحديات. غالبًا ما تقلل الفرق من شأن النفقات التشغيلية، فتنشغل بالصيانة بدلاً من الابتكار. قبل الالتزام بمسار "البناء"، من الضروري فهم العقبات المحتملة.

فيما يلي بعض القيود الرئيسية التي يجب مراعاتها:

- متطلبات البنية التحتية: تشغيل النماذج الكبيرة مكلف ويتطلب وحدات معالجة رسومات (GPU) قوية على مستوى المؤسسات، والتي لا تمتلكها العديد من المؤسسات.

- الخبرة التقنية المطلوبة: يتطلب نشر نموذج لغوي كبير وضبطه وصيانته مهارات هندسية متخصصة في التعلم الآلي، وهي مهارات مطلوبة بشدة.

- عبء الصيانة المستمرة: هذا ليس حلاً من نوع "اضبطه وانسه". تحتاج النماذج إلى مراقبة مستمرة وتحديثات أمنية وإعادة تدريب مع تطور أعمالك.

- خطر الهلوسة: مثل جميع نماذج LLM، يمكن أن يولد LLaMA أحيانًا معلومات تبدو معقولة ولكنها غير صحيحة. تتطلب تطبيقات المؤسسات حواجز وقائية قوية وإشرافًا بشريًا للتخفيف من هذا الخطر.

- لا توجد ميزات مدمجة للمؤسسات: يجب إنشاء الميزات الهامة مثل التحكم في الوصول وتسجيل التدقيق وأدوات الامتثال وإدارتها بشكل منفصل، مما يضيف طبقة أخرى من التعقيد.

💡يمكنك تجاوز هذه القيود باستخدام ClickUp Brain. يوفر هذا البرنامج ذكاءً اصطناعيًا مُدارًا داخل مساحة العمل الحالية لديك، مما يمنحك إمكانات الذكاء الاصطناعي للمؤسسات دون تكاليف تشغيلية إضافية. احصل على أمان على مستوى المؤسسات وتخلص من صيانة البنية التحتية باستخدام ClickUp، مما يتيح لفريقك التركيز على عمله الأساسي.

📮ClickUp Insight: 88٪ من المشاركين في استطلاعنا يستخدمون الذكاء الاصطناعي في مهامهم الشخصية، لكن أكثر من 50٪ يتجنبون استخدامه في العمل. ما هي العوائق الثلاثة الرئيسية؟ عدم وجود تكامل سلس، وفجوات في المعرفة، أو مخاوف أمنية.

ولكن ماذا لو كان الذكاء الاصطناعي مدمجًا في مساحة العمل الخاصة بك وآمنًا بالفعل؟ ClickUp Brain، المساعد الذكي المدمج في ClickUp، يجعل هذا حقيقة واقعة. فهو يفهم المطالبات بلغة بسيطة، ويحل جميع المخاوف الثلاثة المتعلقة بتبني الذكاء الاصطناعي بينما يربط الدردشة والمهام والمستندات والمعرفة عبر مساحة العمل. اعثر على الإجابات والرؤى بنقرة واحدة!

أدوات الذكاء الاصطناعي البديلة لحالات الاستخدام المؤسسي

يعد اختيار أداة الذكاء الاصطناعي المناسبة من بين العديد من الخيارات المتاحة تحديًا لأي فريق. فأنت تحاول معرفة المزايا والعيوب بين النماذج المختلفة، ولكنك قلق من اختيار النموذج الخاطئ وإهدار الموارد.

غالبًا ما يؤدي ذلك إلى انتشار الذكاء الاصطناعي بشكل عشوائي — أي الانتشار غير المخطط لأدوات ومنصات الذكاء الاصطناعي دون رقابة أو استراتيجية — حيث تشترك الفرق في العديد من الخدمات غير المتصلة ببعضها البعض، مما يخلق المزيد من العمل بدلاً من تقليله.

فيما يلي تحليل سريع لأهم اللاعبين وأماكنهم المناسبة:

| أداة | الأفضل لـ | اعتبارات أساسية |

|---|---|---|

| LLaMA (مستضاف ذاتيًا) | أقصى قدر من التحكم وسيادة البيانات | يتطلب بنية تحتية وخبرة في مجال التعلم الآلي |

| OpenAI GPT-4 | أعلى قدرات، أقل إعدادات | تغادر البيانات بيئتك، وتسعير قائم على الاستخدام |

| Claude (Anthropic) | مهام طويلة المدى، التركيز على السلامة | مفاضلات مشابهة لـ GPT-4 |

| Mistral | إقامة البيانات في أوروبا، الكفاءة | نظام بيئي أصغر من LLaMA |

| ClickUp Brain | ذكاء اصطناعي متكامل في مساحة العمل، بدون حاجة إلى النشر | الأفضل للفرق التي ترغب في استخدام الذكاء الاصطناعي في سير العمل الحالي |

بدلاً من توصيل أدوات متعددة لتلبية احتياجاتك، لماذا لا تستخدم الذكاء الاصطناعي المدمج مباشرة في مكان عملك؟ هذا هو جوهر ما يقدمه ClickUp باعتباره أول مساحة عمل متكاملة للذكاء الاصطناعي في العالم — منصة واحدة آمنة تجمع بين المشاريع والوثائق والمحادثات والتحليلات.

يعمل على توحيد أدواتك للقضاء على توسع السياق، وهو التجزئة التي تحدث عندما تضيع الفرق ساعات في التبديل بين التطبيقات والبحث عن المعلومات التي تحتاجها لأداء مهامها.

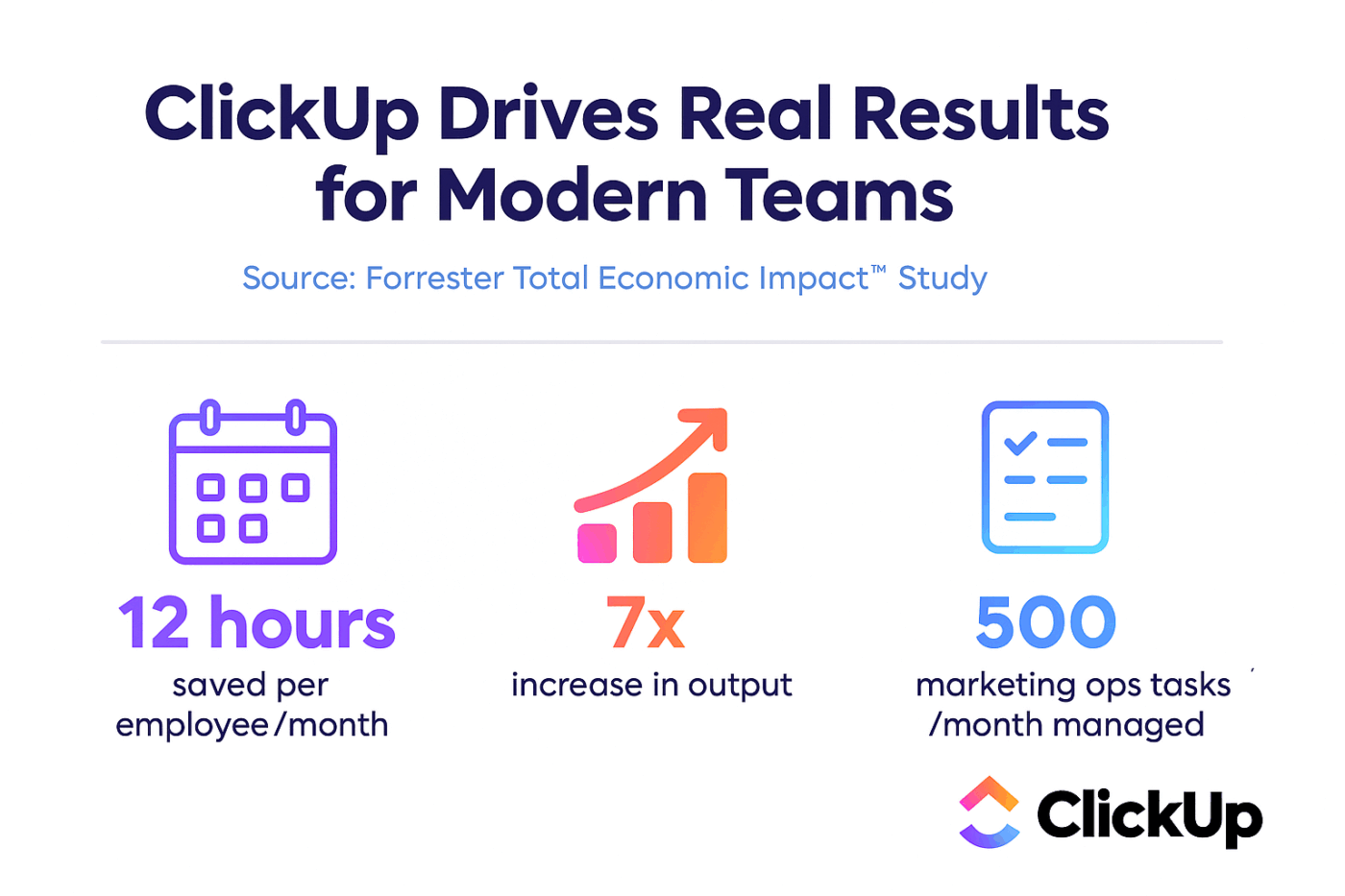

ClickUp + الذكاء الاصطناعي السياقي = تحول قابل للقياس

وفقًا لدراسة Forrester Economic Impact™، حققت الفرق التي تستخدم ClickUp عائدًا على الاستثمار بنسبة 384٪ ووفرت 92400 ساعة بحلول السنة الثالثة.

عندما يتواجد السياق وسير العمل والذكاء في مكان واحد، لا تعمل الفرق فحسب. بل تحقق النجاح.

يوفر ClickUp أيضًا إمكانات الأمان والإدارة التي تتطلبها عمليات النشر المؤسسية، مع التوافق مع SOC 2 Type II، وتكامل SSO، وتوفير SCIM، وضوابط أذونات دقيقة.

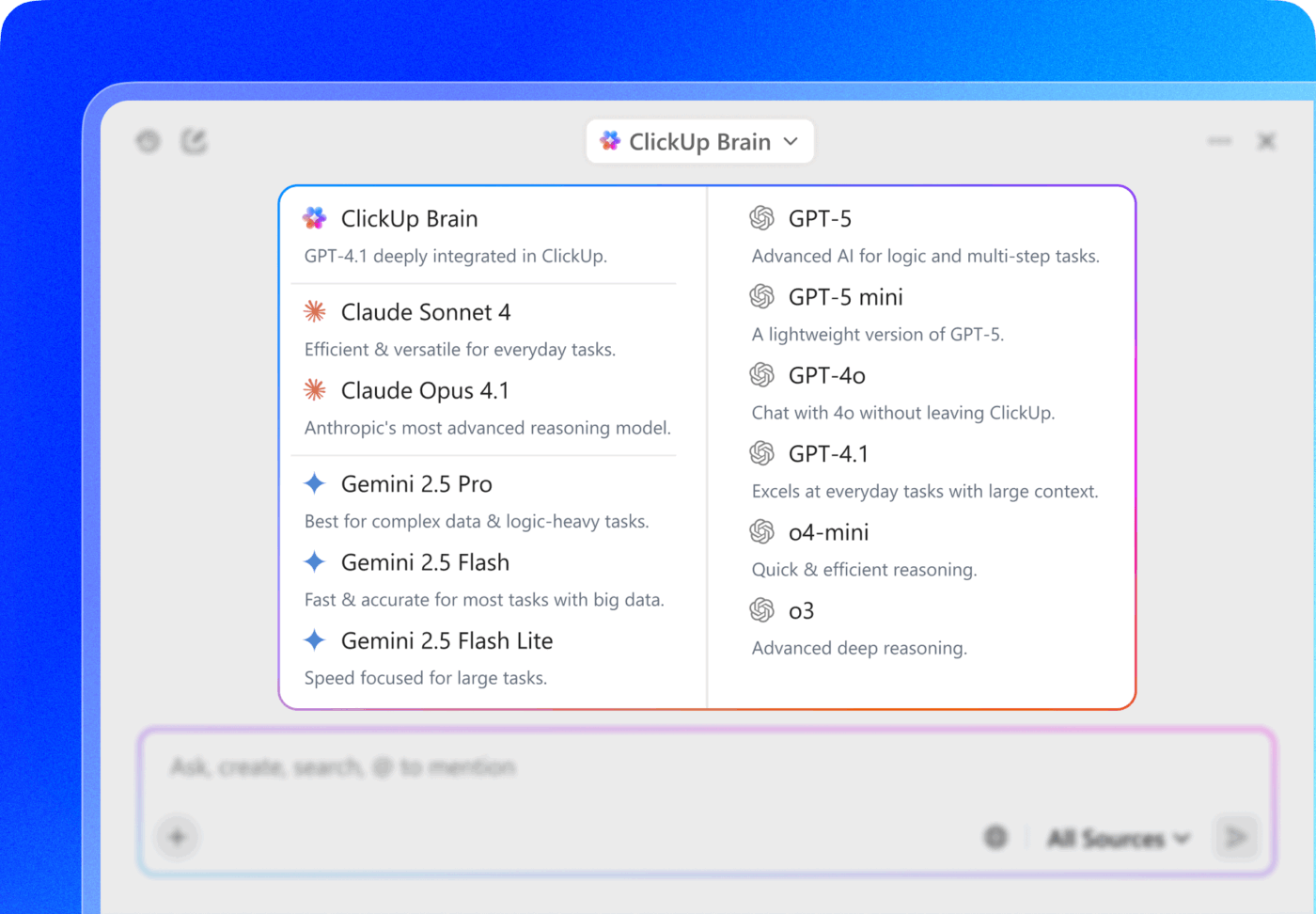

يتيح لك الوصول المتعدد إلى LLM في ClickUp Brain MAX الاختيار بين النماذج المتميزة مثل ChatGPT وClaude وGemini مباشرة من واجهة البحث. تقوم المنصة تلقائيًا بتوجيه استفسارك إلى أفضل نموذج للمهمة، حتى تحصل على أفضل النتائج دون الحاجة إلى إدارة اشتراكات متعددة.

احصل على المجموعة الكاملة — قدرات الذكاء الاصطناعي وإدارة المشاريع والتوثيق والاتصال — في مكان واحد باستخدام ClickUp، بدلاً من إنشاء طبقة الذكاء الاصطناعي من الصفر باستخدام LLaMA.

تقدم مع الذكاء الاصطناعي للمؤسسات باستخدام ClickUp

يوفر LLaMA لفرق المؤسسات بديلاً مفتوحًا عن واجهات برمجة التطبيقات المغلقة للذكاء الاصطناعي، مما يوفر تحكمًا كبيرًا وإمكانية توقع التكاليف والتخصيص. لكن النجاح لا يعتمد على التكنولوجيا وحدها. فهو يتطلب مطابقة النموذج المناسب مع حالة الاستخدام المناسبة، والاستثمار في بيانات تدريب عالية الجودة، وبناء عمليات تقييم قوية.

يعتمد قرار "البناء مقابل الشراء" في النهاية على القدرات التقنية لفريقك. في حين أن بناء حل مخصص يوفر أقصى قدر من المرونة، إلا أنه يأتي أيضًا مع تكاليف إضافية كبيرة. التحدي الحقيقي لا يكمن فقط في الوصول إلى الذكاء الاصطناعي، بل في دمجه في سير عملك اليومي دون خلق المزيد من التوسع في الذكاء الاصطناعي وصوامع البيانات.

أضف إمكانات LLM مباشرة إلى إدارة المشاريع والوثائق والتواصل بين أعضاء الفريق باستخدام ClickUp Brain—دون التعقيدات المرتبطة ببناء البنية التحتية وصيانتها. ابدأ مجانًا مع ClickUp وأضف إمكانات الذكاء الاصطناعي مباشرة إلى سير العمل الحالي. 🙌

الأسئلة الشائعة (FAQ)

نعم، تسمح رخصة Llama 3 Community License بالاستخدام التجاري لمعظم المؤسسات. فقط الشركات التي لديها أكثر من 700 مليون مستخدم نشط شهريًا تحتاج إلى الحصول على رخصة منفصلة من Meta.

يوفر LLaMA تحكمًا أكبر في البيانات وتكاليف يمكن التنبؤ بها من خلال الاستضافة الذاتية، بينما يوفر GPT-4 أداءً أعلى جاهزًا للاستخدام مع إعداد أقل. ولكن من أجل الإنتاجية، احصل على مساعدة الذكاء الاصطناعي دون إدارة النماذج الأساسية من خلال أدوات متكاملة مثل ClickUp Brain.

يحتفظ LLaMA الذاتي الاستضافة بالبيانات على البنية التحتية الخاصة بك، وهو أمر رائع بالنسبة لمكان تخزين البيانات. ومع ذلك، فأنت مسؤول عن تنفيذ ضوابط الوصول الخاصة بك وسجلات التدقيق وفلاتر المحتوى — وهي ميزات أمان يتم تضمينها عادةً في خدمات الذكاء الاصطناعي المدارة.

يتطلب نشر LLaMA وضبطها مباشرةً مهارات هندسية كبيرة في مجال التعلم الآلي. يمكن للفرق التي لا تمتلك هذه الخبرة الوصول إلى الإمكانات القائمة على LLaMA من خلال منصات مُدارة مثل ClickUp Brain، التي توفر ميزات الذكاء الاصطناعي دون الحاجة إلى نشر أي نماذج أو إجراء أي تكوينات تقنية.