A maioria das equipes empresariais que exploram o LLaMA ficam presas no mesmo ponto: baixam os pesos do modelo, ficam olhando para a janela do terminal e percebem que não têm ideia do que fazer a seguir.

Esse desafio é comum: embora 88% das empresas utilizem IA em pelo menos uma função, apenas 7% a expandiram para toda a organização.

Este guia orienta você por todo o processo, desde a seleção do tamanho de modelo adequado para o seu caso de uso até o ajuste fino com base nos dados da sua empresa, para que você possa implantar uma solução de IA funcional que realmente compreenda o contexto do seu negócio.

O que é o LLaMA e por que ele é importante para a IA empresarial?

O LLaMA (abreviação de Large Language Model Meta AI) é uma família de modelos de linguagem de peso aberto criados pela Meta. Em um nível elevado, ele faz as mesmas coisas essenciais que modelos como GPT ou Gemini: compreende a linguagem, gera texto e pode raciocinar com base nas informações. A grande diferença é como as empresas podem usá-lo.

Como o LLaMA é de peso aberto, as empresas não são obrigadas a interagir com ele apenas por meio de uma API de caixa preta. Elas podem executá-lo em sua própria infraestrutura, ajustá-lo com base em dados internos e controlar como e onde ele é implantado.

Para as empresas, isso é muito importante, especialmente quando a privacidade dos dados, a conformidade e a previsibilidade dos custos são mais importantes do que a novidade.

Essa flexibilidade torna o LLaMA particularmente atraente para equipes que desejam integrar profundamente a IA em seus fluxos de trabalho, e não apenas adicioná-la como um chatbot independente. Pense em assistentes de conhecimento internos, automação de suporte ao cliente, ferramentas de desenvolvimento ou recursos de IA incorporados diretamente aos produtos, sem enviar dados confidenciais para fora da organização.

Em resumo, o LLaMA é importante para a IA empresarial porque oferece às equipes escolha sobre a implantação, personalização e integração da IA em sistemas comerciais reais. E à medida que a IA passa da experimentação para as operações diárias, esse nível de controle se torna menos um “diferencial” e mais uma exigência.

Como começar a usar o LLaMA para aplicativos empresariais

1. Defina seu caso de uso empresarial

Antes de baixar qualquer coisa, identifique os fluxos de trabalho exatos em que a IA pode causar um impacto real. É fundamental combinar o caso de uso da IA com o tamanho do modelo — modelos menores de 8B são eficientes para tarefas simples, enquanto modelos maiores de 70B+ são melhores para raciocínios complexos.

Para ajudá-lo a identificar as aplicações de IA certas para o seu negócio, assista a esta visão geral de casos práticos de uso de IA em diferentes funções empresariais e setores:

Os pontos de partida comuns incluem:

- Processamento de documentos: resumir relatórios longos ou extrair informações importantes de contratos.

- Assistência de código: gerar código padrão, explicar sistemas legados ou sugerir otimizações.

- Recuperação de conhecimento: responda às perguntas dos funcionários pesquisando a documentação interna usando uma técnica chamada Retrieval-Augmented Generation (RAG).

- Geração de conteúdo: elaboração de comunicações preliminares ou textos de marketing

2. Configure os pré-requisitos e dependências

Em seguida, organize seu hardware e software. O tamanho do modelo determina suas necessidades; um modelo LLaMA 8B requer uma GPU com aproximadamente 15 GB de VRAM, enquanto um modelo 70B precisa de 131 GB ou mais.

Sua pilha de software deve incluir Python 3. 8+, PyTorch, drivers CUDA e o ecossistema Hugging Face (transformadores, aceleradores e bitsandbytes).

3. Acesse e baixe os pesos do modelo LLaMA

Você pode obter os pesos do modelo na página oficial de downloads do Llama da Meta ou no hub de modelos Hugging Face. Você precisará aceitar a Licença Comunitária Llama 3, que permite o uso comercial. Dependendo da sua configuração, você baixará os pesos no formato safetensors ou GGUF.

4. Configure seu ambiente de desenvolvimento

Com os pesos baixados, é hora de configurar seu ambiente. Instale as bibliotecas Python necessárias, incluindo transformadores, aceleradores e bitsandbytes para quantização — um processo que reduz o consumo de memória do modelo.

Carregue o modelo com as configurações corretas e execute um prompt de teste simples para garantir que tudo esteja funcionando corretamente antes de prosseguir com a personalização.

💡Se você não tiver uma equipe dedicada à infraestrutura de ML, todo esse processo pode ser inviável. Evite completamente a complexidade da implantação com o ClickUp Brain. Ele oferece recursos de IA, como assistência à redação e automação de tarefas, diretamente no espaço de trabalho onde sua equipe já opera — sem necessidade de downloads de modelos ou provisionamento de GPU.

Como personalizar o LLaMA para os dados da sua empresa

Usar um modelo LLaMA básico é um bom começo, mas ele não entenderá as siglas, nomes de projetos ou processos internos exclusivos da sua empresa. Isso leva a respostas genéricas e inúteis que não resolvem os problemas reais da empresa.

A IA empresarial se torna útil por meio da personalização — treinando o modelo com sua terminologia e base de conhecimento específicas.

Prepare seus dados de treinamento específicos para o domínio

O sucesso da sua IA personalizada depende mais da qualidade dos seus dados de treinamento do que do tamanho do modelo ou do poder de computação. Comece reunindo e limpando suas informações internas.

- Documentação interna: reúna especificações de produtos, guias de processos e documentos de políticas.

- Comunicações históricas: reúna modelos de e-mail, respostas a tickets de suporte e resumos de reuniões.

- Terminologia do domínio: compile glossários, definições de siglas e linguagem específica do setor.

Depois de coletadas, formate essas informações em pares de instruções e respostas para o ajuste supervisionado. Por exemplo, uma instrução pode ser “Resuma este ticket de suporte” e a resposta seria um resumo claro e conciso. Essa etapa é crucial para ensinar ao modelo como realizar tarefas específicas com seus dados.

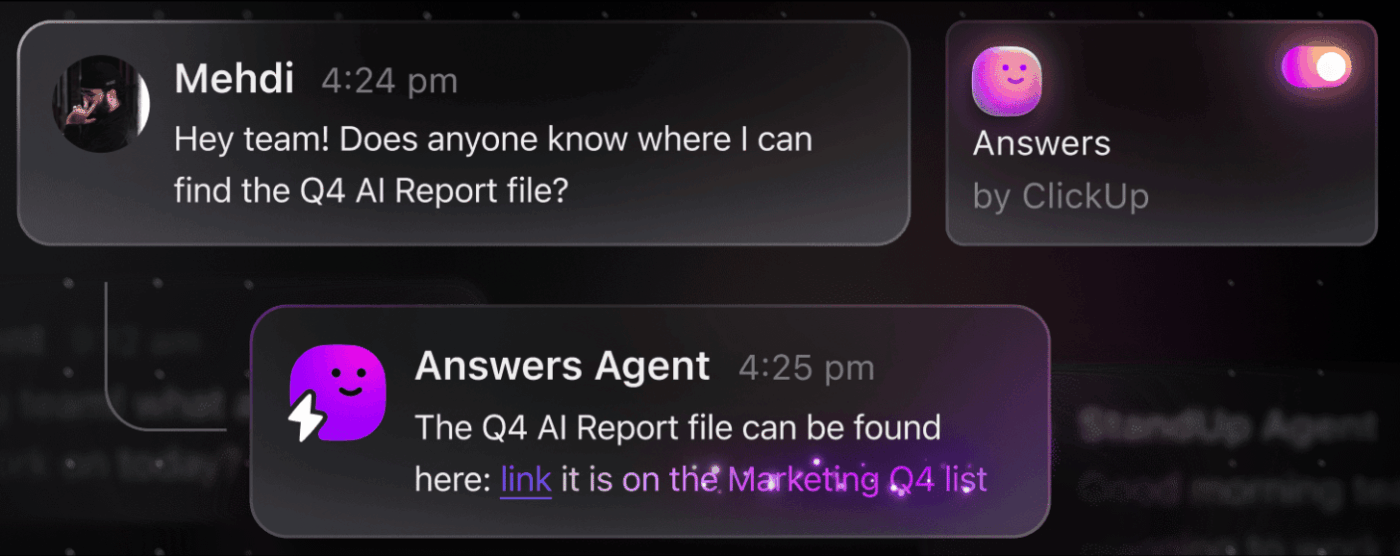

📮 ClickUp Insight: O profissional médio passa mais de 30 minutos por dia procurando informações relacionadas ao trabalho — isso significa mais de 120 horas por ano perdidas vasculhando e-mails, threads do Slack e arquivos espalhados. Um assistente de IA inteligente integrado ao seu espaço de trabalho pode mudar isso.

Conheça o ClickUp Brain. Ele fornece insights e respostas instantâneas, exibindo os documentos, conversas e detalhes de tarefas certos em segundos — para que você possa parar de pesquisar e começar a trabalhar.

💫 Resultados reais: equipes como a QubicaAMF recuperaram mais de 5 horas semanais usando o ClickUp — o que representa mais de 250 horas por ano por pessoa — ao eliminar processos desatualizados de gerenciamento de conhecimento. Imagine o que sua equipe poderia criar com uma semana extra de produtividade a cada trimestre!

Ajuste o LLaMA ao contexto do seu negócio

O ajuste fino é o processo de adaptar o conhecimento existente do LLaMA ao seu caso de uso específico, o que melhora drasticamente sua precisão em tarefas específicas do domínio. Em vez de treinar um modelo do zero, você pode usar métodos eficientes em termos de parâmetros que atualizam apenas um pequeno subconjunto dos parâmetros do modelo, economizando tempo e recursos computacionais.

Os métodos populares de ajuste incluem:

- LoRA (Low-Rank Adaptation): este método treina pequenas matrizes “adaptadoras” em vez do modelo inteiro, tornando-o altamente eficiente.

- QLoRA: combina LoRA com quantização para permitir o ajuste fino em uma única GPU de 48 GB, mantendo o desempenho total do ajuste fino.

- Ajuste completo: atualiza todos os parâmetros do modelo, oferecendo o nível mais profundo de personalização, mas exigindo um poder computacional significativo.

Avalie e itere o desempenho do modelo

Como saber se seu modelo personalizado está realmente funcionando? A avaliação da IA precisa ir além de simples pontuações de precisão e medir a utilidade no mundo real. Crie conjuntos de dados de avaliação que reflitam seus casos de uso de produção e acompanhe métricas importantes para sua empresa, como qualidade de resposta, precisão factual e latência.

- Avaliação qualitativa: peça a revisores humanos que avaliem os resultados quanto ao tom, utilidade e correção.

- Métricas quantitativas: use pontuações automatizadas como BLEU ou perplexidade para acompanhar o desempenho em escala.

- Monitoramento da produção: após a implantação, acompanhe o feedback dos usuários e as taxas de erro para identificar áreas que precisam de melhorias.

💡Esse processo iterativo de treinamento e avaliação pode se tornar um projeto em si. Gerencie seu ciclo de vida de desenvolvimento de IA diretamente no ClickUp, em vez de se perder em planilhas.

Centralize métricas de desempenho e resultados de avaliação em uma única visualização com os painéis do ClickUp. Acompanhe versões de modelos, parâmetros de treinamento e pontuações de avaliação junto com seu outro trabalho de produto com os campos personalizados do ClickUp, mantendo tudo organizado e visível. 🛠️

Principais casos de uso empresarial para o LLaMA

As equipes muitas vezes ficam presas na paralisia da análise, incapazes de passar do entusiasmo abstrato pela IA para aplicações concretas. A flexibilidade do LLaMA o torna adequado para uma ampla gama de fluxos de trabalho empresariais, ajudando você a automatizar tarefas e trabalhar com mais eficiência.

Aqui estão alguns dos principais casos de uso para um modelo LLaMA personalizado:

- Assistentes de conhecimento internos: pare de perder tempo procurando informações. Implante o LLaMA com RAG para criar um chatbot que pode responder instantaneamente às perguntas dos funcionários, pesquisando seus wikis internos, documentos de políticas e comunicações de projetos anteriores.

- Automação do suporte ao cliente: ajuste um modelo com base no seu histórico de tickets para redigir respostas automaticamente, categorizar consultas e encaminhar questões complexas ao agente humano adequado.

- Geração e revisão de código: ajude sua equipe de engenharia a trabalhar com mais eficiência. Use o LLaMA para gerar código padrão, explicar sistemas legados complexos e até mesmo identificar possíveis bugs em solicitações de pull antes que se tornem problemas.

- Processamento de documentos: transforme grandes volumes de texto em informações úteis. Resuma relatórios longos, extraia termos-chave de contratos jurídicos ou gere notas de reunião concisas a partir de transcrições brutas em segundos.

- Fluxos de trabalho de criação de conteúdo: supere o bloqueio criativo. Elabore rascunhos de textos de marketing, descrições de produtos e anúncios internos que seus editores humanos poderão refinar e aperfeiçoar.

💡Acesse muitos desses casos de uso prontos para uso com o ClickUp Brain.

- Resuma threads de tarefas, redija atualizações de projetos e gere conteúdo com a assistência de redação alimentada por IA do ClickUp.

- Encontre respostas em todo o seu espaço de trabalho instantaneamente com a Pesquisa Empresarial do ClickUp e o agente pré-construído Ambient Answers.

- Crie fluxos de trabalho inteligentes que lidam com tarefas rotineiras para você com o ClickUp Automations.

Limitações do uso do LLaMA para IA empresarial

Embora a hospedagem própria do LLaMA ofereça um controle significativo, ela não está isenta de desafios. As equipes muitas vezes subestimam a sobrecarga operacional, ficando atoladas na manutenção em vez de se dedicarem à inovação. Antes de se comprometer com o caminho da “construção”, é fundamental entender os possíveis obstáculos.

Aqui estão algumas das principais limitações a serem consideradas:

- Requisitos de infraestrutura: executar modelos grandes é caro e requer GPUs poderosas de nível empresarial que muitas organizações não têm à disposição.

- Conhecimentos técnicos necessários: a implantação, o ajuste e a manutenção de um modelo de linguagem grande exigem habilidades especializadas em engenharia de ML, que estão em alta demanda.

- Carga de manutenção contínua: esta não é uma solução do tipo “configure e esqueça”. Os modelos precisam de monitoramento constante, atualizações de segurança e retreinamento à medida que sua empresa evolui.

- Risco de alucinação: como todos os LLMs, o LLaMA às vezes pode gerar informações que parecem plausíveis, mas são incorretas. As aplicações empresariais exigem proteções robustas e supervisão humana para mitigar esse risco.

- Sem recursos empresariais integrados: recursos essenciais, como controle de acesso, registro de auditoria e ferramentas de conformidade, devem ser criados e gerenciados separadamente, adicionando outra camada de complexidade.

💡Você pode contornar essas limitações usando o ClickUp Brain. Ele fornece IA gerenciada dentro do seu espaço de trabalho existente, oferecendo recursos de IA empresarial sem sobrecarga operacional. Obtenha segurança de nível empresarial e elimine a manutenção da infraestrutura com o ClickUp, liberando sua equipe para se concentrar em seu trabalho principal.

📮ClickUp Insight: 88% dos participantes da nossa pesquisa usam IA para suas tarefas pessoais, mas mais de 50% evitam usá-la no trabalho. As três principais barreiras? Falta de integração perfeita, lacunas de conhecimento ou preocupações com segurança.

Mas e se a IA estiver integrada ao seu espaço de trabalho e já for segura? O ClickUp Brain, assistente de IA integrado do ClickUp, torna isso realidade. Ele entende comandos em linguagem simples, resolvendo todas as três preocupações relacionadas à adoção da IA, ao mesmo tempo em que conecta seu chat, tarefas, documentos e conhecimento em todo o espaço de trabalho. Encontre respostas e insights com um único clique!

Ferramentas alternativas de IA para casos de uso empresarial

Escolher a ferramenta de IA certa entre as muitas opções disponíveis é um desafio para qualquer equipe. Você está tentando descobrir as vantagens e desvantagens dos diferentes modelos, mas teme escolher o modelo errado e desperdiçar recursos.

Isso muitas vezes leva à proliferação descontrolada de IA — a disseminação não planejada de ferramentas e plataformas de IA sem supervisão ou estratégia —, em que as equipes assinam vários serviços desconectados, criando mais trabalho em vez de menos.

Aqui está uma rápida análise dos principais participantes e onde eles se encaixam:

| Ferramenta | Ideal para | Considerações importantes |

|---|---|---|

| LLaMA (auto-hospedado) | Controle máximo, soberania dos dados | Requer infraestrutura e experiência em ML. |

| OpenAI GPT-4 | Capacidade máxima, configuração mínima | Os dados saem do seu ambiente, preços baseados no uso |

| Claude (Anthropic) | Tarefas de contexto longo, foco na segurança | Compromissos semelhantes aos do GPT-4 |

| Mistral | Residência de dados europeia, eficiência | Ecossistema menor que o LLaMA |

| ClickUp Brain | IA integrada ao espaço de trabalho, sem implantação | Ideal para equipes que desejam IA dentro dos fluxos de trabalho existentes. |

Em vez de conectar várias ferramentas para atender às suas necessidades, por que não acessar a IA incorporada diretamente onde seu trabalho acontece? Esse é o cerne do que o ClickUp oferece como o primeiro Espaço de Trabalho de IA Convergente do mundo — uma plataforma única e segura onde projetos, documentos, conversas e análises coexistem.

Ele unifica suas ferramentas para eliminar a dispersão de contexto, a fragmentação que ocorre quando as equipes perdem horas alternando entre aplicativos e procurando as informações necessárias para realizar seu trabalho.

ClickUp + IA contextual = transformação mensurável

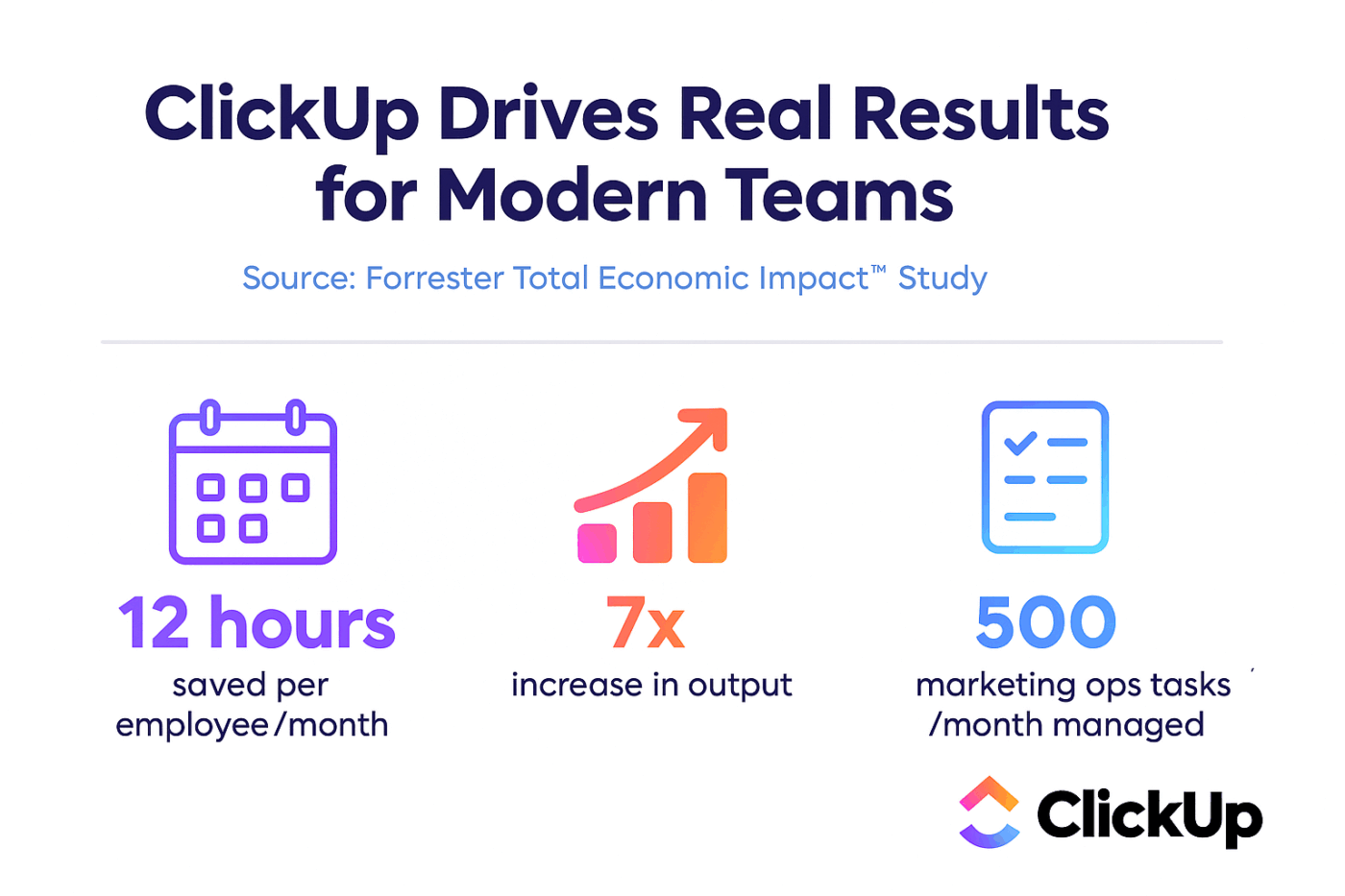

De acordo com um estudo da Forrester Economic Impact™, as equipes que usam o ClickUp obtiveram um ROI de 384% e economizaram 92.400 horas até o terceiro ano.

Quando o contexto, os fluxos de trabalho e a inteligência estão reunidos em um só lugar, as equipes não apenas trabalham. Elas vencem.

O ClickUp também oferece os recursos de segurança e administração necessários para implantações empresariais, com conformidade SOC 2 Tipo II, integração SSO, provisionamento SCIM e controles de permissão granulares.

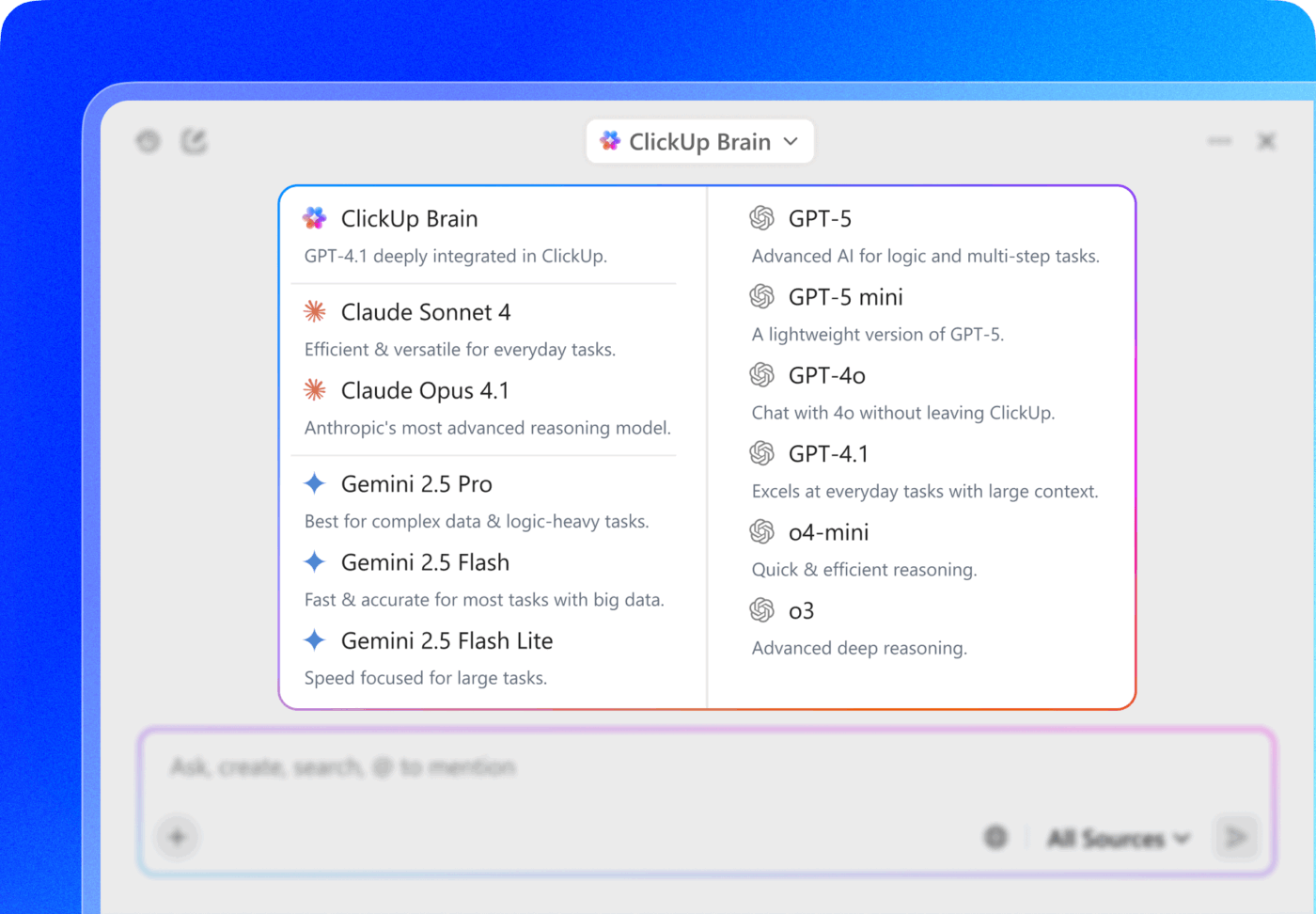

O acesso multi-LLM do ClickUp Brain MAX permite que você escolha entre modelos premium como ChatGPT, Claude e Gemini diretamente da interface de pesquisa. A plataforma encaminha automaticamente sua consulta para o melhor modelo para a tarefa, para que você obtenha o melhor de todos os mundos sem precisar gerenciar várias assinaturas.

Obtenha toda a pilha — recursos de IA, gerenciamento de projetos, documentação e comunicação — em um só lugar com o ClickUp, em vez de construir a camada de IA do zero com o LLaMA.

Avance com a IA empresarial com o ClickUp

O LLaMA oferece às equipes empresariais uma alternativa aberta às APIs de IA fechadas, proporcionando controle significativo, previsibilidade de custos e personalização. Mas o sucesso depende de mais do que apenas tecnologia. É necessário combinar o modelo certo com o caso de uso certo, investir em dados de treinamento de alta qualidade e criar processos de avaliação robustos.

A decisão entre “construir ou comprar” depende, em última análise, da capacidade técnica da sua equipe. Embora a construção de uma solução personalizada ofereça flexibilidade máxima, ela também acarreta custos significativos. O verdadeiro desafio não é apenas acessar a IA, mas integrá-la aos seus fluxos de trabalho diários sem criar mais dispersão de IA e silos de dados.

Traga os recursos de LLM diretamente para o gerenciamento de projetos, documentação e comunicação da equipe com o ClickUp Brain, sem a complexidade de construir e manter infraestrutura. Comece gratuitamente com o ClickUp e traga os recursos de IA diretamente para seus fluxos de trabalho existentes. 🙌

Perguntas frequentes (FAQ)

Sim, a licença comunitária do Llama 3 permite o uso comercial para a maioria das organizações. Apenas empresas com mais de 700 milhões de usuários ativos mensais precisam obter uma licença separada da Meta.

O LLaMA oferece maior controle de dados e custos previsíveis por meio da hospedagem própria, enquanto o GPT-4 oferece desempenho pronto para uso com menos configuração. Para produtividade, no entanto, obtenha assistência de IA sem gerenciar os modelos subjacentes por meio de ferramentas integradas como o ClickUp Brain.

A hospedagem própria do LLaMA mantém os dados em sua infraestrutura, o que é ótimo para a residência de dados. No entanto, você é responsável por implementar seus próprios controles de acesso, logs de auditoria e filtros de conteúdo — recursos de segurança que normalmente são incluídos em serviços de IA gerenciados.

A implantação e o ajuste fino do LLaMA diretamente exigem habilidades significativas em engenharia de ML. Equipes sem esse conhecimento podem acessar recursos baseados no LLaMA por meio de plataformas gerenciadas como o ClickUp Brain, que oferece recursos de IA sem qualquer implantação de modelo ou configuração técnica.