Większość zespołów testuje narzędzia do tworzenia streszczeń oparte na modelach LLM, podając im próbkę dokumentu i uznając zadanie za zrobione. Model, który doskonale radzi sobie z raportami kwartalnymi, może zepsuć wątki na Slacku, a ten, który idealnie nadaje się do dokumentów prawnych, może zniekształcić fakty zawarte w e-mailach od klientów.

W tym przewodniku przedstawiono najlepsze modele LLM do tworzenia streszczeń tekstów, sposoby ich oceny w odniesieniu do rzeczywistego obciążenia pracą oraz sposoby bezpośredniego połączenia tych streszczeń z działaniami w ramach cyklu pracy.

Modele LLM do tworzenia streszczeń w skrócie

| Model | Najlepsze dla | Najlepsze funkcje | Ceny |

|---|---|---|---|

| ClickUp Brain | Zespoły, które chcą tworzyć streszczenia bezpośrednio w ramach swojego cyklu pracyWielkość zespołu: każdy zespół korzystający z ClickUp do realizacji projektów i komunikacji | Podsumowania uwzględniające obszar roboczy, podsumowania spotkań za pomocą AI Notetaker, tworzenie zadań do wykonania, routing wielu modeli LLM, wyszukiwanie w języku naturalnym. | Free Forever; możliwość dostosowania do potrzeb Enterprise. |

| OpenAI GPT-4o | Wyrafinowane streszczenia gotowe do wykorzystania przez kadrę kierowniczą Wielkość zespołu: małe i duże zespoły wymagające wysokiej jakości wyników abstrakcyjnych | Podsumowania podobne do ludzkich, wsparcie multimodalne, ścisłe przestrzeganie instrukcji, duże okno kontekstowe. | API płatne za token, ChatGPT Plus 20 USD/miesiąc |

| Claude 3. 5 Sonnet | Dokumenty wymagające zgodności z przepisami lub o wysokim stopniu techniczności Wielkość zespołu: zespoły prawne, finansowe, Enterprise | Rozszerzone okno kontekstowe, niskie ryzyko halucynacji, doskonała kontrola formatu, silne rozumowanie. | API płatne za token, subskrypcja Claude Pro |

| Google Gemini 1. 5 Pro | Zespoły intensywnie pracujące w Google WorkspaceWielkość zespołu: zespoły operacyjne, badawcze, zespoły organizujące wiele spotkań | Okno kontekstowe do 1 mln tokenów, integracja z Google Meet i Drive, multimodalne tworzenie streszczeń. | Ceny oparte na wykorzystaniu za pośrednictwem Google AI Studio lub Vertex AI. |

| Meta LLaMA 3 | Samodzielnie hostowane i konfigurowalne potoki podsumowujące Wielkość zespołu: zespoły kierowane przez inżynierów, skupione na prywatności | W pełni samodzielnie hostowany, możliwość precyzyjnego dostosowania, wysoka jakość podsumowań, pełna kontrola nad danymi. | Bezpłatne wagi open source, obowiązują koszty infrastruktury. |

| Mistral Large | Zespoły wymagające przechowywania danych w UE i wdrożenia hybrydowego Wielkość zespołu: Enterprise z UE lub organizacje podlegające wymogom zgodności | Hybrydowy zarządzany interfejs API lub samodzielnie hostowany, wysoka jakość podsumowań, efektywne wykorzystanie tokenów. | Konkurencyjne ceny API, dostępne otwarte wagi |

Jak oceniamy oprogramowanie w ClickUp

Nasz zespół redakcyjny stosuje przejrzysty, poparty badaniami i niezależny od dostawców proces, dzięki czemu możesz mieć pewność, że nasze rekomendacje opierają się na rzeczywistej wartości produktu.

Oto szczegółowy opis tego, jak oceniamy oprogramowanie w ClickUp.

Na co należy zwrócić uwagę w modelu LLM do tworzenia streszczeń?

Wybór niewłaściwego modelu podsumowującego prowadzi do marnowania pieniędzy na nieporęczne interfejsy API, zmagania się ze skomplikowanymi ustawieniami lub po prostu uzyskiwanie niskiej jakości podsumowań, które nie są pomocne. Przed zagłębieniem się w konkretne modele, zrozumienie tego, co odróżnia skuteczne podsumowanie od ogólnych wyników, pomoże Ci dokonać mądrzejszego wyboru.

Obsługuje rzeczywiste typy dokumentów

Model, który doskonale radzi sobie z podsumowywaniem artykułów naukowych, może mieć trudności z rozmowami na Slacku lub transkrypcjami spotkań. Poszukaj modeli LLM, które zostały przetestowane w odniesieniu do konkretnych typów dokumentów, z którymi Twój zespół pracuje na co dzień — niezależnie od tego, czy są to umowy prawne, e-maile od klientów, dokumentacja techniczna czy notatki ze spotkań.

Oferuje wystarczające okno kontekstowe.

Okno kontekstowe określa, ile tekstu model może przetworzyć w jednym przejściu. Jeśli podsumowujesz godzinne transkrypcje spotkań lub długie raporty badawcze, potrzebujesz modelu z rozszerzonym oknem kontekstowym. W przeciwnym razie będziesz musiał dzielić dokumenty na fragmenty i stracić spójność, która wynika z przetwarzania wszystkiego razem.

Równowaga między szybkością a jakością

Niektóre modele stawiają na szybkość wnioskowania, a inne optymalizują jakość wyników. W przypadku tworzenia streszczeń w czasie rzeczywistym podczas spotkań ważniejsza jest szybkość. W przypadku generowania briefingów dla kadry kierowniczej priorytetem jest jakość. Zastanów się, gdzie w tym spektrum plasują się Twoje przypadki użycia.

Zapewnia odpowiednie opcje dostępu.

O tym, czy potrzebujesz zarządzanego interfejsu API, samodzielnie hostowanego wdrożenia czy podejścia hybrydowego, powinny decydować zasoby techniczne i wymagania bezpieczeństwa Twojego zespołu. Zespoły Enterprise o rygorystycznych zasadach dotyczących danych mogą wymagać opcji lokalnych, podczas gdy mniejsze zespoły mogą preferować wygodę interfejsów API w chmurze.

6 najlepszych modeli LLM do tworzenia streszczeń tekstów

Ogromna liczba dostępnych modeli sprawia, że wybór odpowiedniego stanowi wyzwanie. Każdy z poniższych modeli jest silnym konkurentem, ale to, który z nich jest „najlepszy”, zależy wyłącznie od konkretnych potrzeb Twojego zespołu. Ocenimy je pod kątem dokładności, rozmiaru okna kontekstowego, szybkości i opcji dostępu.

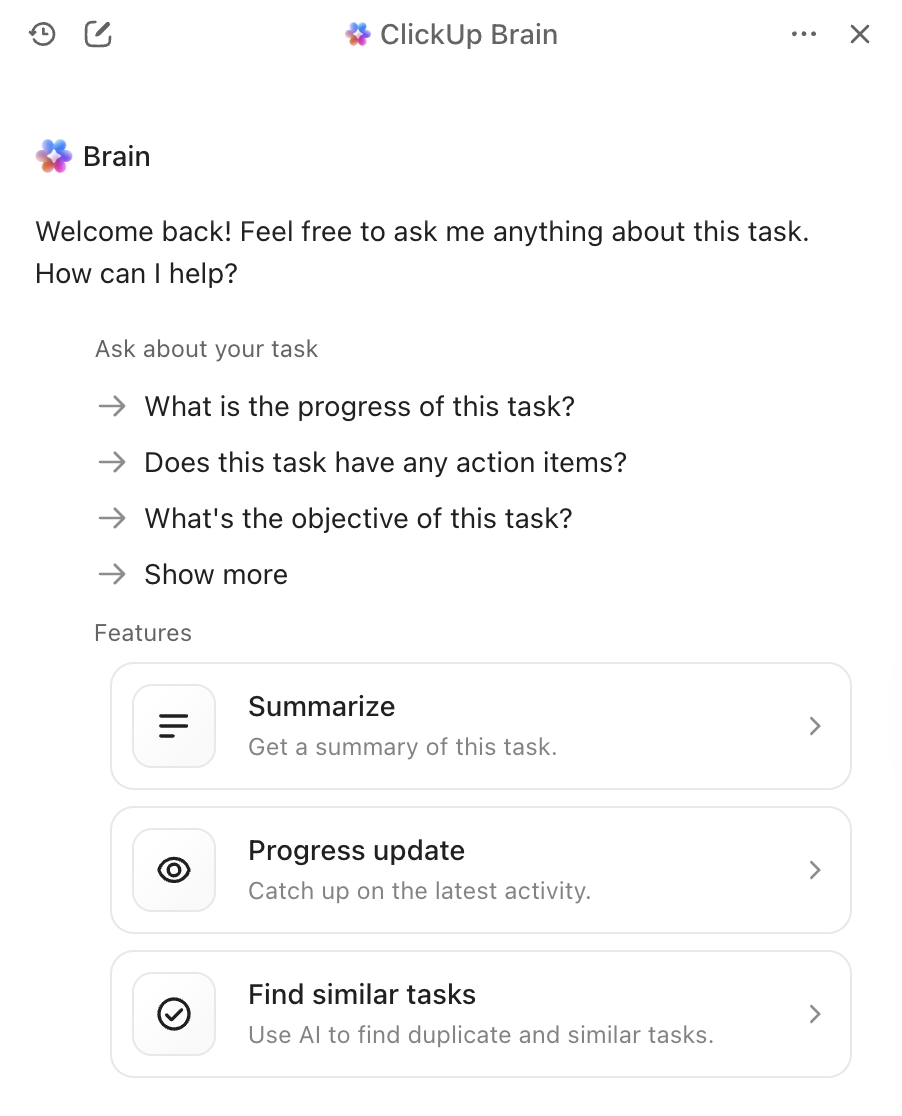

1. ClickUp Brain (najlepszy do tworzenia streszczeń opartych na AI w ramach cyklu pracy)

Największym problemem samodzielnych narzędzi do tworzenia streszczeń nie jest jakość ich streszczeń, ale to, co dzieje się później. Tworzysz świetne streszczenie, a następnie ręcznie kopiujesz je do narzędzia do zarządzania projektami, tworzysz na jego podstawie zadania i wysyłasz wiadomość do swojego zespołu o kolejnych krokach. ClickUp Brain eliminuje tę niedogodność, wprowadzając funkcję tworzenia streszczeń bezpośrednio do Twojego cyklu pracy.

Dzięki ClickUp Brain wystarczy wpisać @brain w dowolnym komentarzu do zadania lub wiadomości na czacie ClickUp i poprosić o podsumowanie kontekstu. Natychmiast wyświetla podsumowanie, korzystając ze swojej wiedzy o Twoim obszarze roboczym i nadając priorytet konkretnemu zadaniu lub kanałowi, w którym się znajdujesz. Ponieważ Brain rozumie Twoje projekty, dokumenty i rozmowy, jego podsumowania są natychmiast gotowe do wykorzystania, a nie izolowanym tekstem, który trzeba ręcznie przetwarzać.

Najlepsze funkcje ClickUp Brain

- Podsumowuje zadania, dokumenty, wątki czatu i nagrania spotkań bez opuszczania obszaru roboczego.

- Wykorzystuje wiele modeli LLM w tle, dzięki czemu uzyskujesz optymalne wyniki bez konieczności zarządzania wyborem modelu.

- Konwertuje streszczenia bezpośrednio na zadania z osobami przypisanymi i terminami wykonania.

- Rozumie kontekst Twojego obszaru roboczego, aby tworzyć bardziej trafne i przydatne streszczenia.

- Integruje się z ClickUp AI Notetaker, aby automatycznie rejestrować i podsumowywać spotkania.

Limity ClickUp Brain

- Aby w pełni wykorzystać możliwości, konieczna jest praca w ekosystemie ClickUp.

- Najlepiej nadaje się do cykli pracy zespołowej, a nie do indywidualnego przetwarzania dokumentów.

Ceny ClickUp Brain

2. OpenAI GPT-4o (najlepszy do tworzenia dopracowanych streszczeń gotowych do wykorzystania przez kadrę kierowniczą)

Jeśli potrzebujesz dopracowanego, bogatego w niuanse streszczenia, które można udostępnić kadrze kierowniczej, najlepszym wyborem będzie GPT-4o. Jego mocną stroną jest wysokiej jakości streszczanie abstrakcyjne, które pozwala uzyskać tekst brzmiący tak, jakby został napisany przez człowieka. Duże okno kontekstowe i możliwości multimodalne oznaczają, że może on streszczać nie tylko dokumenty, ale także teksty pochodzące z obrazów lub transkrypcji audio.

Dostęp do niego można uzyskać za pośrednictwem powszechnie dostępnego interfejsu API, co ułatwia integrację z istniejącymi narzędziami AI do obsługi spotkań. Minusem jest to, że jest to usługa zastrzeżona, której cena zależy od wykorzystania, a podczas podsumowywania bardzo długich dokumentów można zauważyć niewielkie opóźnienie.

Najlepsze funkcje GPT-4o

- Tworzy streszczenia o jakości zbliżonej do ludzkiej, które wymagają minimalnej edycji.

- Obsługuje dane multimodalne, w tym obrazy i transkrypcje audio.

- Oferuje obszerną dokumentację API i wsparcie w zakresie integracji.

Limity GPT-4o

- Ceny oparte na wykorzystaniu mogą się sumować w przypadku podsumowań o dużej objętości.

- Opóźnienie wnioskowania wzrasta w przypadku bardzo długich dokumentów.

- Model zastrzeżony oznacza mniejszą kontrolę nad przetwarzaniem danych.

Ceny GPT-4o

- Dostęp do API z rozliczeniem według liczby tokenów

- Subskrypcja ChatGPT Plus za 20 USD miesięcznie do użytku indywidualnego.

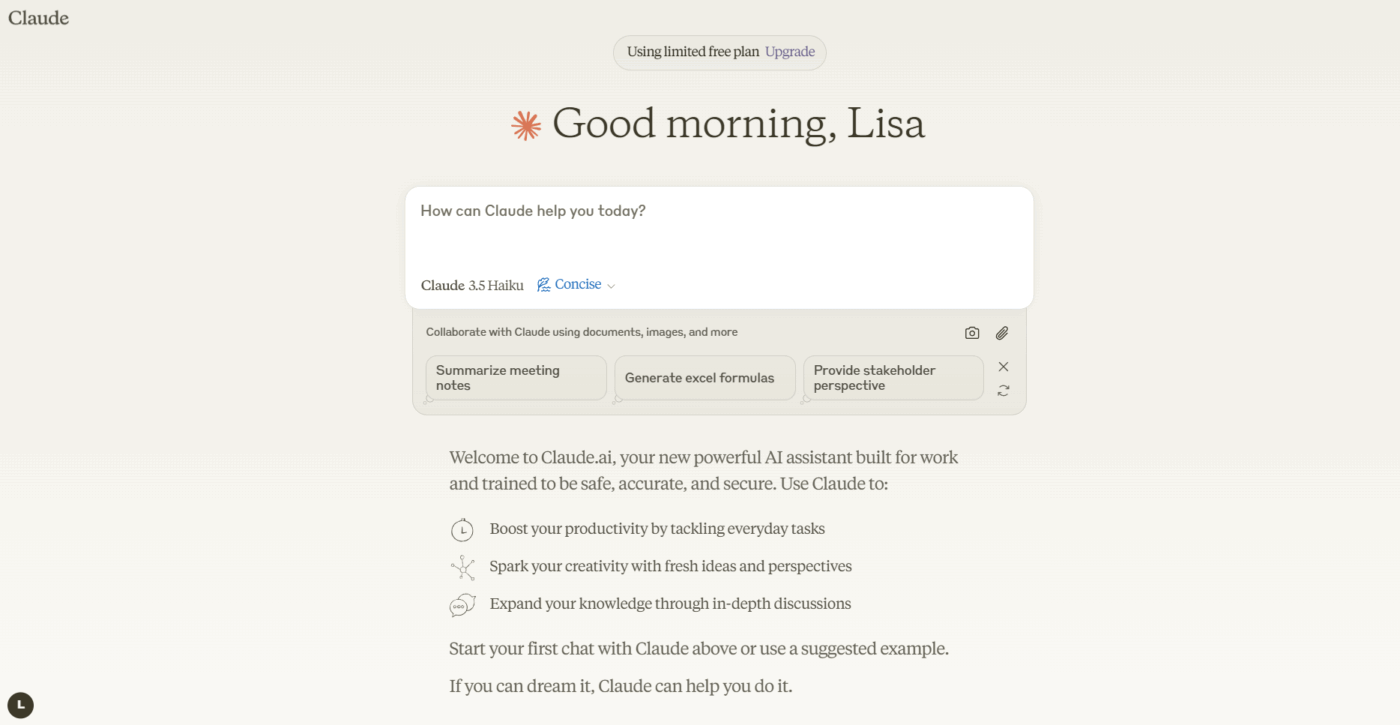

3. Anthropic Claude 3. 5 Sonnet (najlepszy do dokumentów wymagających zgodności z przepisami)

Jeśli Twój zespół zajmuje się dokumentami o wysokim stopniu poufności lub złożonym charakterze, Claude 3. 5 Sonnet został stworzony z myślą o Twoich potrzebach. Posiada rozszerzone okno kontekstowe, które pozwala mu przetwarzać i streszczać całe długie raporty za jednym razem. To, co naprawdę wyróżnia ten model, to jego zdolność do wykonywania szczegółowych instrukcji — możesz poprosić o streszczenie w określonym formacie, tonie lub z naciskiem na określone tematy, a model dostarczy je z wysoką dokładnością.

Silny nacisk firmy Anthropic na dostosowanie do wymogów bezpieczeństwa pomaga zmniejszyć ryzyko tworzenia przez model nieprawdziwych faktów, co jest kluczową funkcją dla zespołów dbających o zgodność z przepisami, pracujących z dokumentami prawnymi lub finansowymi. Dla zespołów, które już korzystają z programów do tworzenia streszczeń dokumentów opartych na AI, Claude dobrze integruje się z istniejącymi cyklami pracy.

Najlepsze funkcje Claude 3. 5 Sonnet

- Rozszerzone okno kontekstowe przetwarza całe raporty za jednym razem.

- Doskonałe przestrzeganie instrukcji dotyczących niestandardowego formatowania i wymagań dotyczących tonu.

- Silne dostosowanie do bezpieczeństwa zmniejsza ryzyko halucynacji.

Limity Claude 3. 5 Sonnet

- Model zastrzeżony, dostępność zależy od regionu

- Ceny API mogą mieć znaczenie w przypadku wykorzystania na skalę Enterprise.

Ceny Claude 3. 5 Sonnet

- Dostęp do API z rozliczeniem według liczby tokenów

- Subskrypcja Claude Pro dostępna do użytku indywidualnego.

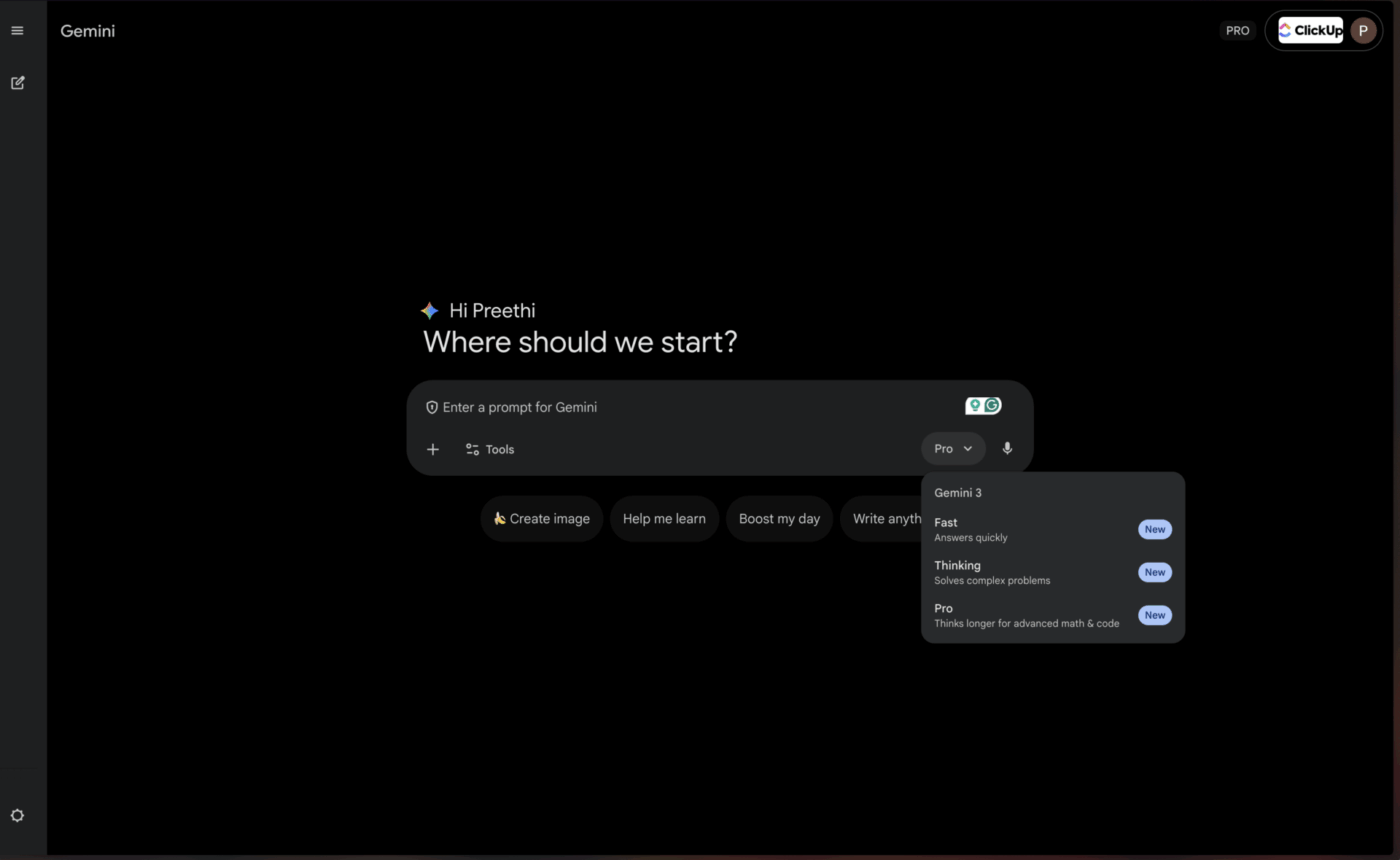

4. Google Gemini 1. 5 Pro (najlepszy dla użytkowników Google Workspace)

Dla zespołów, które już teraz funkcjonują w ekosystemie Google, Gemini 1. 5 Pro oferuje niemal niezrównany poziom wygody. Funkcja ta posiada jedno z największych obecnie dostępnych okien kontekstowych — do 1 miliona tokenów — dzięki czemu idealnie nadaje się do podsumowywania rozbudowanych transkrypcji spotkań z Google Meet lub syntezy informacji z wielu artykułów naukowych przechowywanych w Google Drive.

Dzięki natywnej integracji z Google Workspace możesz uzyskać streszczenia bez konieczności opuszczania narzędzi, z których korzystasz na co dzień. Jest to szczególnie cenne dla zespołów, które w dużym stopniu polegają na sztucznej inteligencji do tworzenia streszczeń spotkań w ekosystemie Google.

Najlepsze funkcje Gemini 1. 5 Pro

- Ogromne okno kontekstowe o pojemności 1 miliona tokenów obsługuje bardzo długie dokumenty.

- Natywna integracja z Google Workspace zapewnia płynny cykl pracy.

- Funkcje multimodalne obejmujące tekst, obrazy i wideo

Limity Gemini 1. 5 Pro

- Pełne korzyści wymagają inwestycji w ekosystem Google.

- Wydajność poza integracją z Google może pozostawać w tyle za konkurencją.

Ceny Gemini 1. 5 Pro

- Dostępne za pośrednictwem Google AI Studio i Vertex AI.

- Ceny różnią się w zależności od wykorzystania i umów Enterprise.

📌 ClickUp Insight: Przeciętny profesjonalista spędza codziennie ponad 30 minut na wyszukiwaniu informacji związanych z pracą — to ponad 120 godzin rocznie straconych na przeszukiwanie wiadomości e-mail, wątków na Slacku i rozproszonych plików. Inteligentny asystent AI wbudowany w Twój obszar roboczy może to zmienić, wyświetlając odpowiednie dokumenty, rozmowy i szczegóły zadań w ciągu kilku sekund.

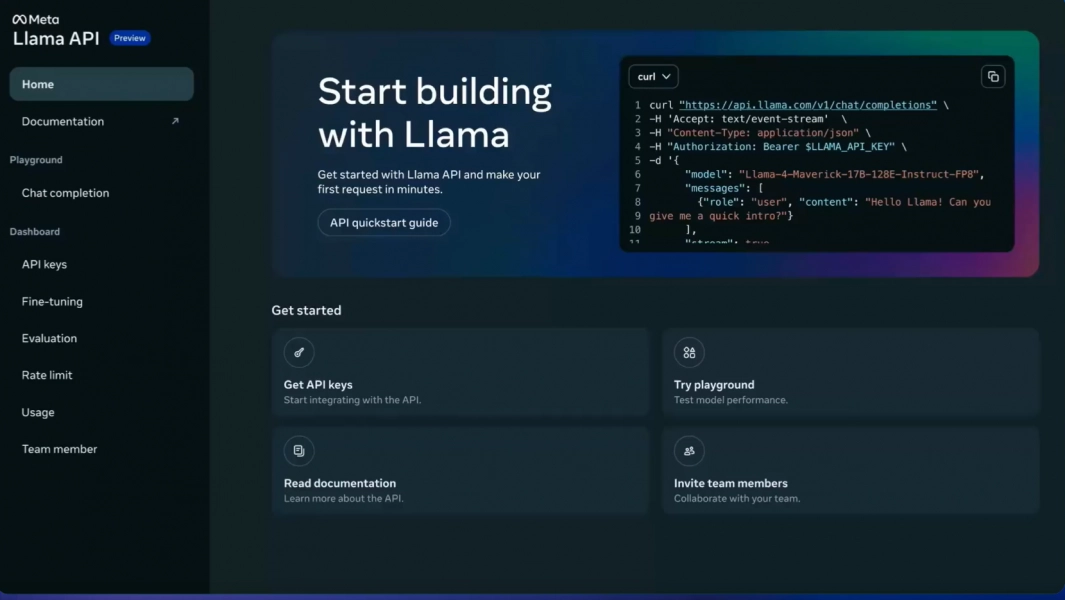

5. Meta LLaMA 3 (najlepszy do samodzielnie hostowanych, konfigurowalnych potoków)

Twój zespół potrzebuje pełnej kontroli nad danymi i chce uniknąć wysyłania poufnych informacji do usług stron trzecich. Właśnie w tym zakresie sprawdza się model open source, taki jak LLaMA 3. Możesz go hostować na własnych serwerach, dostosować do konkretnych danych swojej firmy, aby lepiej rozumiał jej żargon, i dostosować go w niestandardowy sposób — wszystko to bez opłat licencyjnych.

Jakość podsumowań jest imponująca i często dorównuje modelom zastrzeżonym. Haczyk polega na konieczności posiadania infrastruktury technicznej. Twój zespół będzie potrzebował zasobów inżynieryjnych do wdrożenia i utrzymania modelu, ponieważ nie ma gotowego do użycia zarządzanego interfejsu API. Dzięki temu idealnie nadaje się dla organizacji kierowanych przez inżynierów lub skupionych na prywatności.

3 najlepsze funkcje LLaMA

- Zakończona kontrola nad danymi dzięki samodzielnemu wdrożeniu

- Możliwość dostosowania do terminologii specyficznej dla danej dziedziny

- Brak opłat licencyjnych za użytkowanie komercyjne.

Limity LLaMA 3

- Wymaga znacznej infrastruktury technicznej do wdrożenia.

- Brak zarządzanego API — Twój zespół zajmuje się konserwacją

- Złożoność początkowych ustawień może opóźnić osiągnięcie wartości.

Ceny LLaMA 3

- Free korzystanie z licencją open source.

- Koszty infrastruktury zależą od wyboru hostingu.

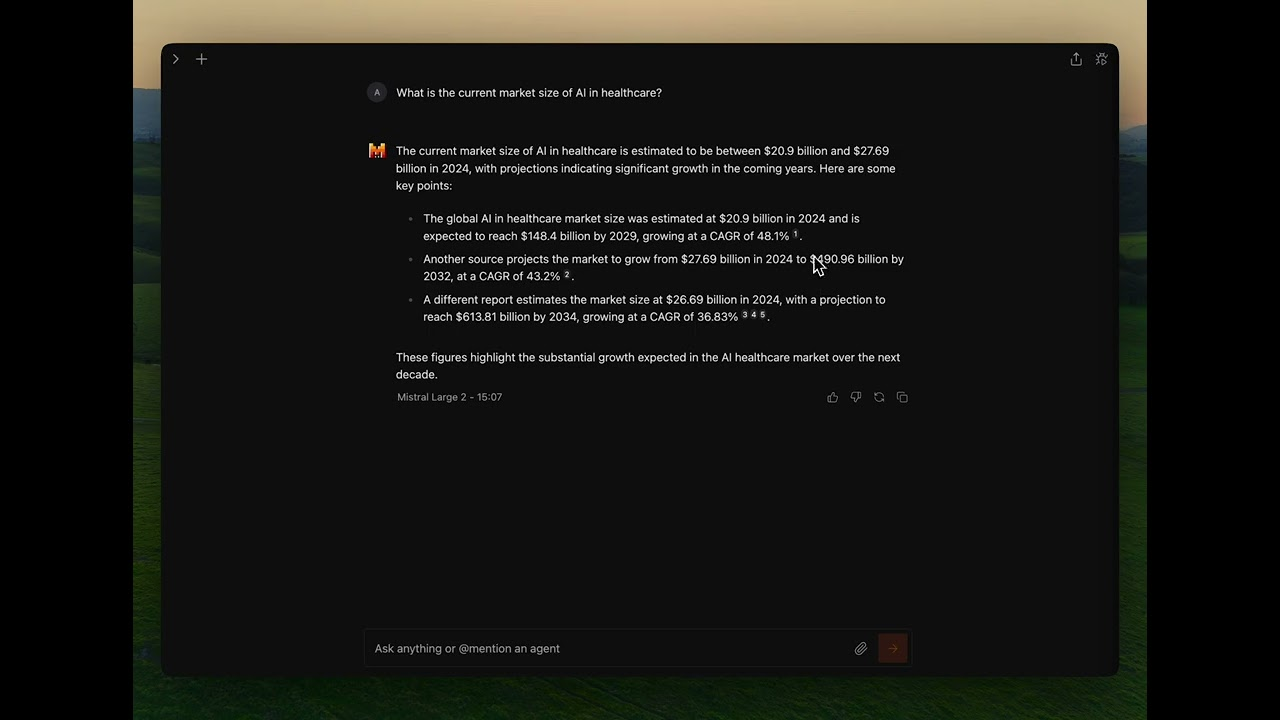

6. Mistral Large (najlepszy pod względem wymogów UE dotyczących przechowywania danych)

A co, jeśli chcesz korzystać z elastyczności rozwiązań open source, ale nie masz zasobów, aby samodzielnie zarządzać infrastrukturą? Mistral Large oferuje atrakcyjne rozwiązanie pośrednie. Opracowany przez europejską firmę, zapewnia konkurencyjną wydajność podsumowywania, kładąc duży nacisk na efektywność.

Mistral zapewnia zarówno zarządzany interfejs API ułatwiający dostęp, jak i modele o otwartej wadze dla zespołów, które chcą mieć większą kontrolę. To hybrydowe podejście jest jego kluczową zaletą. Kompromisem jest mniejszy ekosystem integracji stron trzecich w porównaniu z gigantami, takimi jak OpenAI i Google. Jest to doskonały wybór dla zespołów poszukujących równowagi między wygodą a kontrolą, zwłaszcza tych, które muszą spełniać wymogi UE dotyczące przechowywania danych.

Najlepsze funkcje Mistral Large

- Hybrydowy dostęp poprzez zarządzane API lub samodzielnie hostowane wdrożenie.

- Wysoka wydajność zgodna z europejskimi przepisami dotyczącymi przechowywania danych

- Konkurencyjne ceny w porównaniu z głównymi modelami zastrzeżonymi

Ograniczenia Mistral Large

- Mniejszy ekosystem integracji niż OpenAI lub Google.

- Mniej obszerna dokumentacja i zasoby społeczności

Ceny Mistral Large

- Dostęp do API z konkurencyjnymi cenami za token.

- Modele o otwartej wadze dostępne do samodzielnego hostingu.

💡 Wskazówka dla profesjonalistów: Jeśli Twoim głównym celem jest podsumowanie godzinnych transkrypcji spotkań za jednym razem, wybierz modele z największym oknem kontekstowym, takie jak Gemini 1. 5 Pro. Jeśli chcesz nauczyć model terminologii specyficznej dla Twojej firmy, najlepszym rozwiązaniem będzie opcja open source, taka jak LLaMA 3.

💡 Wskazówka dla profesjonalistów: Jeśli Twoim głównym celem jest podsumowanie godzinnych transkrypcji spotkań za jednym razem, wybierz modele z największym oknem kontekstowym, takie jak Gemini 1. 5 Pro. Jeśli chcesz nauczyć model terminologii specyficznej dla Twojej firmy, najlepszym wyborem będzie opcja open source, taka jak LLaMA 3.

Porównanie modeli LLM do tworzenia streszczeń

Szybkie porównanie pomaga na pierwszy rzut oka zidentyfikować model, który najlepiej odpowiada priorytetom Twojego zespołu.

ClickUp Brain wprowadza funkcję tworzenia streszczeń bezpośrednio do Twojego cyklu pracy jako zintegrowane środowisko pracy oparte na AI, które najlepiej nadaje się do przekształcania streszczeń w natychmiastowe działania, a jego główną zaletą jest optymalne działanie w ekosystemie ClickUp.

GPT-4o oferuje duże okno kontekstowe jako model zastrzeżony, najlepiej nadający się do tworzenia dopracowanych i zniuansowanych streszczeń, przy czym kluczowym kompromisem jest cena oparta na wykorzystaniu.

Claude 3. 5 Sonnet zapewnia rozszerzone okno kontekstowe jako model zastrzeżony, idealny do dokumentów wymagających zgodności z przepisami, których głównym limitem jest dostępność regionalna.

Gemini 1. 5 Pro oferuje ogromne okno kontekstowe jako model zastrzeżony, idealny dla użytkowników Google Workspace, choć problemem może być uzależnienie od ekosystemu.

LLaMA 3 zawiera duże okno kontekstowe jako model open source, odpowiedni dla samodzielnie hostowanych, konfigurowalnych potoków, ale wymaga inwestycji w infrastrukturę.

Mistral Large posiada funkcję dużego okna kontekstowego z hybrydowym podejściem do dostępu, doskonale nadającą się do potrzeb UE w zakresie przechowywania danych, choć ma mniejszy ekosystem integracji.

📖 Przeczytaj również: Najlepsze narzędzia do tworzenia streszczeń transkrypcji oparte na AI

Jak oceniać jakość podsumowań generowanych przez modele LLM

Aby wiedzieć, czy streszczenia modelu są rzeczywiście dobre, potrzebne są jasne ramy oceny. Poleganie na złym streszczeniu może być gorsze niż brak streszczenia, ponieważ może prowadzić do podejmowania złych decyzji na podstawie niedokładnych informacji.

Kluczowe kryteria oceny

Dokładność określa, czy streszczenie prawidłowo oddaje główne punkty oryginalnego tekstu, bez dodawania faktów lub popełniania błędów. Jest to niepodważalne w przypadku dokumentów o znaczeniu krytycznym dla działalności firmy.

Spójność mierzy, czy streszczenie jest łatwe do przeczytania i ma logiczny przepływ, czy też sprawia wrażenie zbioru niepowiązanych ze sobą zdań. Dobre streszczenia zachowują strukturę narracyjną.

Zwięzłość ocenia, czy streszczenie trafia w sedno, czy też jest wypełnione zbędnymi informacjami i niepotrzebnymi słowami. Najlepsze streszczenia maksymalizują gęstość informacji.

Zastrzeganie instrukcji sprawdza, czy model potrafi osiągnąć powodzenie w realizacji żądania dotyczącego określonego tonu, formatu lub obszarów zainteresowania, takich jak punkty wypunktowane lub briefingi w stylu wykonawczym.

Spójność ocenia, czy model tworzy wysokiej jakości streszczenia różnych typów dokumentów, czy też działa dobrze tylko w przypadku niektórych z nich.

Prosta struktura testowa

Wybierz trzy dokumenty, z którymi Twój zespół pracuje regularnie — brief projektu, protokół ze spotkania i wątek e-maili od klienta. Przetestuj każdy dokument za pomocą modeli, które rozważasz, używając tej samej podpowiedzi. Następnie poproś członka zespołu o ocenę wyników według powyższych kryteriów. Chociaż istnieją automatyczne wskaźniki, nic nie zastąpi ludzkiej oceny w wykrywaniu subtelnych błędów.

🔍 Czy wiesz, że... Zespoły takie jak QubicaAMF odzyskały ponad 5 godzin tygodniowo dzięki ClickUp — to ponad 250 godzin rocznie na osobę — eliminując przestarzałe procesy zarządzania wiedzą. Wyobraź sobie, co Twój zespół mógłby osiągnąć, mając dodatkowy tydzień wydajności w każdym kwartale.

🔍 Czy wiesz, że... Zespoły takie jak QubicaAMF odzyskały ponad 5 godzin tygodniowo dzięki ClickUp — to ponad 250 godzin rocznie na osobę — eliminując przestarzałe procesy zarządzania wiedzą. Wyobraź sobie, co Twój zespół mógłby osiągnąć, mając dodatkowy tydzień wydajności w każdym kwartale.

Jakie są ograniczenia stosowania modeli LLM do tworzenia streszczeń dokumentów?

Technologia ta ma rzeczywiste ograniczenia, które warto zrozumieć przed podjęciem decyzji o komitowaniu się z konkretnym rozwiązaniem.

Ryzyko halucynacji

Największym ryzykiem jest halucynacja, czyli sytuacja, w której model z przekonaniem podaje nieprawidłowe szczegóły, które brzmią wiarygodnie. Zespoły prawne, analitycy finansowi i wszyscy, którzy pracują z dokumentami wymagającymi zgodności z przepisami, powinni zawsze zlecać ludziom weryfikację podsumowań o dużym znaczeniu.

Ograniczenia okna kontekstowego

Nawet największe modele mają swój limit, więc bardzo długie dokumenty mogą wymagać podziału na fragmenty. Podział ten może spowodować, że model nie dostrzeże połączeń między odległymi sekcjami lub utraci ogólny wątek narracyjny.

Utrata niuansów

Subtelne argumenty lub poglądy mniejszości są często pomijane w streszczeniach. Jeśli zachowanie odmiennych opinii lub skrajnych przypadków ma znaczenie dla danego zastosowania, należy starannie opracować podpowiedzi lub zaakceptować pewną utratę informacji.

Wyzwania związane ze specyfiką dziedziny

Model ogólnego przeznaczenia może nie rozumieć specyficznego żargonu Twojej branży bez odpowiedniego dostosowania. Pola medyczne, prawne i techniczne często wymagają dodatkowego szkolenia lub starannego projektowania starannego projektowania podpowiedzi.

Kwestie bezpieczeństwa

Wysyłanie poufnych danych firmowych do zewnętrznego interfejsu API zawsze wiąże się z pewnym ryzykiem. W przypadku dokumentów o wysokim stopniu poufności konieczne może być stosowanie modeli hostowanych we własnym zakresie lub umów korporacyjnych zawierających szczegółowe warunki przetwarzania danych.

Nie są to powody, aby unikać tej technologii, ale są to ważne kwestie, które należy wziąć pod uwagę. Można je złagodzić dzięki inteligentnym praktykom: zawsze należy zlecać ludziom przeglądanie podsumowań o dużym znaczeniu, stosować modele hostowane we własnym zakresie w przypadku danych o wysokim stopniu wrażliwości oraz używać jasnych podpowiedzi, aby pomóc modelowi zachować ważne niuanse.

📌 ClickUp Insight: 62% pracowników wiedzy polega na narzędziach AI do konwersacji, takich jak ChatGPT i Claude. Ich znany interfejs chatbota i wszechstronne możliwości mogą wyjaśniać ich popularność w różnych rolach i branżach. Jednak przełączanie się na inną zakładkę, aby za każdym razem zadać pytanie AI, powoduje wzrost kosztów przełączania i zmiany kontekstu.

📌 ClickUp Insight: 62% pracowników wiedzy polega na narzędziach AI do konwersacji, takich jak ChatGPT i Claude. Ich znany interfejs chatbota i wszechstronne możliwości mogą wyjaśniać ich popularność w różnych rolach i branżach. Jednak przełączanie się na inną zakładkę, aby za każdym razem zadać pytanie AI, powoduje wzrost kosztów przełączania i zmiany kontekstu.

Wykorzystaj ClickUp Brain w swoim cyklu pracy związanym z tworzeniem streszczeń

Widziałeś już, jak ClickUp Brain plasuje się wśród najlepszych modeli LLM do tworzenia streszczeń. Teraz przyjrzyjmy się, jak budować cykle pracy, które przekształcają te streszczenia w rzeczywisty wzrost wydajności. Różnica między użytecznym streszczeniem a zmarnowanym wysiłkiem polega na tym, czy istnieje połączenie między nim a działaniem — i właśnie w tym zakresie wyróżnia się obszar roboczy Converged AI.

[Zastąpienie obrazu: obszar roboczy ClickUp pokazujący podsumowanie Brain zintegrowane z zadaniami i dokumentami]

Uzyskaj podsumowania dokładnie tam, gdzie pracujesz.

Wyeliminuj frustrujące ręczne przekazywanie zadań, wprowadzając funkcję tworzenia streszczeń bezpośrednio do swoich projektów. Dzięki ClickUp Brain wystarczy wpisać @brain w dowolnym komentarzu do zadania lub wiadomości na czacie ClickUp i poprosić o streszczenie kontekstu. Natychmiast wyświetli się streszczenie oparte na wiedzy o Twoim obszarze roboczym, z priorytetem dla konkretnego zadania lub kanału, w którym się znajdujesz.

Automatycznie przekształcaj nagrania ze spotkań w elementy do wykonania.

Nadrabianie zaległości po opuszczonym spotkaniu nie wymaga już godzinowego przeglądania notatek. Pozostań w pełni zaangażowany w rozmowy, podczas gdy ClickUp AI Notetaker zapisuje dla Ciebie notatki ze spotkania. Po spotkaniu dostarcza transkrypcję i podsumowanie. Możesz nawet poprosić go o automatyczne wygenerowanie działań do wykonania i przekształcenie ich w zadania ClickUp z osobami przypisanymi i terminami wykonania.

Wykorzystaj wiele modeli LLM bez konieczności zarządzania wyborem modelu.

Uzyskaj wysokiej jakości wyniki bez konieczności samodzielnego zarządzania wyborem modelu, ponieważ ClickUp Brain wykorzystuje wiele modeli LLM w tle. Oto jak wygląda ten cykl pracy w praktyce: odbywa się spotkanie, ClickUp AI Notetaker rejestruje wszystko, ClickUp Brain dostarcza podsumowanie kluczowych decyzji, a działania do wykonania są już uwzględnione w planie projektu. Możesz nawet użyć @My Brain, aby prywatnie podsumować wątek lub sporządzić odpowiedź przed udostępnieniem jej zespołowi.

✨ Rzeczywiste wyniki: Prawdziwym wyzwaniem jest przekształcenie streszczeń w działania. ClickUp Brain doskonale radzi sobie z połączaniem streszczeń bezpośrednio z zadaniami w cyklu pracy, eliminując lukę między spostrzeżeniami a realizacją, która jest zmorą samodzielnych narzędzi do tworzenia streszczeń.

✨ Rzeczywiste wyniki: Prawdziwym wyzwaniem jest przekształcenie streszczeń w działania. ClickUp Brain doskonale radzi sobie z połączaniem streszczeń bezpośrednio z zadaniami w cyklu pracy, eliminując lukę między spostrzeżeniami a realizacją, która jest zmorą samodzielnych narzędzi do tworzenia streszczeń.

Wnioski

Najlepszy model LLM do tworzenia streszczeń to taki, który odpowiada unikalnym potrzebom Twojego zespołu — niezależnie od tego, czy chodzi o ogromne okno kontekstowe dla długich raportów, elastyczność open source umożliwiającą dostosowanie do niestandardowych potrzeb, czy też płynną integrację z istniejącymi narzędziami. Przed podjęciem decyzji zawsze przetestuj najlepsze modele na własnych, rzeczywistych dokumentach, aby sprawdzić ich działanie.

Pamiętaj jednak, że streszczenie ma wartość tylko wtedy, gdy jest połączone z działaniem. Streszczanie przestaje być samodzielnym zadaniem, a staje się głęboko osadzoną funkcją platform, z których już korzystasz. Prawdziwy wzrost wydajności wynika z wypełnienia luki między uzyskaniem wglądu a podjęciem działania na jego podstawie.

Zacznij korzystać z ClickUp za darmo i wprowadź podsumowania AI bezpośrednio do zarządzania zadaniami, czatu i dokumentów.

Często zadawane pytania

Jaka jest różnica między streszczaniem ekstraktywnym a abstrakcyjnym w modelach LLM? Streszczanie ekstraktywne polega na wyciąganiu kluczowych zdań bezpośrednio z oryginalnego tekstu, podczas gdy streszczanie abstrakcyjne generuje całkowicie nowe zdania, aby przekazać podstawowe znaczenie. Nowoczesne modele LLM wykorzystują głównie metodę abstrakcyjną, co skutkuje bardziej naturalnie brzmiącymi streszczeniami, które lepiej oddają istotę materiału źródłowego.

Jak modele LLM typu open source wypadają w porównaniu z modelami zastrzeżonymi, takimi jak GPT-4, pod względem tworzenia streszczeń? Modele typu open source zapewniają pełną kontrolę nad danymi i możliwość dostosowania do konkretnych potrzeb, ale wymagają zasobów technicznych do utrzymania. Modele zastrzeżone zapewniają wygodę i łatwość użytkowania dzięki API, ale wiążą się z kosztami użytkowania i mniejszą kontrolą nad danymi. Różnica w jakości znacznie się zmniejszyła, a opcje open source, takie jak LLaMA 3, rywalizują z modelami zastrzeżonymi pod względem wydajności w wielu przypadkach użycia.

Czy narzędzia do tworzenia streszczeń oparte na modelach LLM mogą obsługiwać notatki ze spotkań i aktualizacje projektów? Tak, większość modeli LLM bardzo skutecznie tworzy streszczenia tekstów konwersacyjnych, takich jak notatki ze spotkań. Prawdziwym wyzwaniem jest przekształcenie tych streszczeń w działania, w czym doskonale sprawdzają się narzędzia takie jak ClickUp Brain, które tworzą połączenia między streszczeniami a zadaniami w cyklu pracy, zamiast pozostawiać je jako odizolowane dokumenty tekstowe.

Jakiego rozmiaru okna kontekstowego potrzebuję dla moich dokumentów? W przypadku standardowych dokumentów biznesowych zawierających mniej niż 10 000 słów większość nowoczesnych modeli LLM ma wystarczające okna kontekstowe. W przypadku transkrypcji spotkań trwających ponad godzinę lub obszernych raportów badawczych potrzebne będą modele z rozszerzonymi oknami kontekstowymi, takie jak Claude 3. 5 Sonnet lub Gemini 1. 5 Pro. Okno o rozmiarze 1 miliona tokenów w Gemini 1. 5 Pro może obsłużyć praktycznie każde zadanie podsumowania pojedynczego dokumentu.

Jak mogę zmniejszyć ryzyko halucynacji w podsumowaniach LLM? Używaj jasnych, konkretnych podpowiedzi, które wymagają od modelu podsumowania tylko tego, co jest wyraźnie określone w źródle. Jeśli dokładność ma kluczowe znaczenie, poproś o cytaty lub odniesienia do konkretnych sekcji. W przypadku dokumentów o wysokiej stawce zawsze poproś recenzenta o porównanie podsumowania z oryginałem. Rozważ modele o silniejszym dostosowaniu bezpieczeństwa, takie jak Claude, podczas pracy z zawartością wrażliwą pod względem zgodności.