Większość z nas ma pewne doświadczenie w "rozmowach" z najnowszymi narzędziami AI. Jeśli spędziłeś wystarczająco dużo czasu ze sztuczną inteligencją, wiesz już, że jest jak genialny, ale zapominalski przyjaciel, który ma świetne pomysły, ale czasami zapomina, o czym rozmawialiście. Albo ten zawsze pod telefonem kolega, który dzieli się wątpliwymi wiadomościami z losowych wątków czatu, rozpowszechniając dezinformacje.

To tylko wierzchołek góry lodowej, gdy mówimy o wyzwaniach związanych ze sztuczną inteligencją. Naukowcy z Oregon State University i Adobe opracowują nową technikę szkoleniową w celu zmniejszenia uprzedzeń społecznych w systemach sztucznej inteligencji. Jeśli ta technika okaże się niezawodna, może sprawić, że sztuczna inteligencja będzie bardziej sprawiedliwa dla wszystkich.

Ale nie uprzedzajmy faktów. To tylko jedno z wielu rozwiązań potrzebnych do stawienia czoła licznym wyzwaniom związanym ze sztuczną inteligencją, przed którymi dziś stoimy. Od problemów technicznych po dylematy etyczne, droga do niezawodnej sztucznej inteligencji jest wybrukowana złożonymi kwestiami.

Rozpakujmy razem te wyzwania związane ze sztuczną inteligencją i zobaczmy, co jest potrzebne, aby je pokonać.

10 wyzwań i rozwiązań związanych ze sztuczną inteligencją

Wraz z rozwojem technologii sztucznej inteligencji pojawia się szereg problemów. Niniejsza lista przedstawia dziesięć pilnych wyzwań związanych ze sztuczną inteligencją oraz praktyczne rozwiązania dla odpowiedzialnego i skutecznego wdrażania AI.

1. Uprzedzenia algorytmiczne

Tendencyjność algorytmów odnosi się do tendencji systemów sztucznej inteligencji do wykazywania tendencyjnych wyników, często ze względu na charakter ich danych szkoleniowych lub projektu. Te uprzedzenia mogą przejawiać się w wielu formach, często utrwalając i wzmacniając istniejące uprzedzenia społeczne.

Przykład tego został zaobserwowany w badanie akademickie obejmujące aplikację generującą sztuczną inteligencję Midjourney. Badanie ujawniło, że podczas generowania obrazów osób wykonujących różne zawody, sztuczna inteligencja nieproporcjonalnie przedstawiała starszych profesjonalistów ze specjalistycznymi tytułami zawodowymi (np. analityk) jako mężczyzn, podkreślając uprzedzenie ze względu na płeć w swoich wynikach.

Rozwiązania

- Zróżnicowane i reprezentatywne dane: Korzystanie z treningowych zestawów danych, które naprawdę odzwierciedlają różnorodność wszystkich grup, aby uniknąć uprzedzeń związanych z płcią, pochodzeniem etnicznym lub wiekiem

- Wykrywanie i monitorowanie uprzedzeń: Regularnie sprawdzaj swoje systemy sztucznej inteligencji pod kątem uprzedzeń. Powinno to być połączenie automatycznego monitorowania i własnych ręcznych przeglądów, aby upewnić się, że nic się nie wymknie

- Dostosowywanie algorytmów: Odgrywaj aktywną rolę w dostosowywaniu algorytmów AI w celu zwalczania uprzedzeń. Może to oznaczać zrównoważenie wag danych lub dodanie ograniczeń uczciwości do modeli

- Etyczne wytyczne AI: Pomagaj kształtować etyczne praktyki AI, przyjmując i wdrażając wytyczne dotyczące uczciwości i stronniczości, zapewniając, że zasady te są wplecione w każdy etap projektu AI

2. Brak przejrzystości AI powodujący nieufność

Przejrzystość w sztucznej inteligencji oznacza otwartość w zakresie sposobu działania systemów AI, w tym ich projektowania, wykorzystywanych danych i procesów decyzyjnych. Wyjaśnialność idzie o krok dalej, zapewniając, że każdy, niezależnie od umiejętności technicznych, może zrozumieć, jakie decyzje podejmuje sztuczna inteligencja i dlaczego. Koncepcje te pomagają radzić sobie z obawami dotyczącymi sztucznej inteligencji, takimi jak uprzedzenia, kwestie prywatności, a nawet zagrożenia, takie jak autonomiczne zastosowania wojskowe.

Wytłumaczalność w sztucznej inteligencji przez Unite.ai Zrozumienie decyzji podejmowanych przez sztuczną inteligencję ma kluczowe znaczenie w obszarach takich jak finanse, opieka zdrowotna i motoryzacja, gdzie ma ona znaczący wpływ. Jest to trudne, ponieważ sztuczna inteligencja często działa jak "czarna skrzynka " - nawet jej twórcy mogą mieć trudności ze wskazaniem, w jaki sposób podejmuje decyzje.

Rozwiązania

- Rozwój przejrzystej dokumentacji: Zapewnienie wyczerpujących informacji na temat modeli AI, ich procesu rozwoju, danych wejściowych i procesów decyzyjnych. Sprzyja to lepszemu zrozumieniu i stanowi podstawę zaufania

- Wdrażanie modeli sztucznej inteligencji, które można wyjaśnić: Wykorzystuj modele, które zapewniają większą przejrzystość, takie jak drzewa decyzyjne lub systemy oparte na regułach, aby użytkownicy dokładnie widzieli, w jaki sposób dane wejściowe są przekształcane w dane wyjściowe

- Korzystanie z narzędzi interpretacyjnych: Stosowanie narzędzi takich jak LIME (Local Interpretable Model-agnostic Explanations) lub SHAP (SHapley Additive exPlanations) w celu rozbicia wkładu różnych funkcji w proces decyzyjny modelu

3. Skalowanie sztucznej inteligencji jest trudniejsze niż się wydaje

Skalowanie technologii AI ma kluczowe znaczenie dla organizacji, które chcą wykorzystać jej potencjał w różnych jednostkach biznesowych. Osiągnięcie skalowalności infrastruktury AI jest jednak obarczone wieloma trudnościami.

Według Accenture, 75% liderów biznesowych uważa, że w ciągu pięciu lat wypadną z biznesu, jeśli nie będą w stanie wymyślić, jak skalować sztuczną inteligencję.

Pomimo potencjału wysokiego zwrotu z inwestycji, wiele firm ma trudności z wyjściem poza projekty pilotażowe i wdrożeniem ich na pełną skalę.

Fiasko Zillow w zakresie home-flippingu jest wyraźnym przypomnieniem wyzwań związanych ze skalowalnością AI. Ich sztuczna inteligencja, mająca na celu przewidywanie cen domów dla zysku, miała wskaźniki błędów do 6.9% , co doprowadziło do poważnych strat finansowych i odpisu zapasów w wysokości 304 milionów dolarów.

Wyzwanie związane ze skalowalnością jest najbardziej widoczne poza gigantami technologicznymi, takimi jak Google i Amazon, które posiadają zasoby umożliwiające skuteczne wykorzystanie sztucznej inteligencji. Dla większości innych, zwłaszcza firm spoza branży technologicznej, które dopiero zaczynają odkrywać sztuczną inteligencję, bariery obejmują brak infrastruktury, mocy obliczeniowej, wiedzy specjalistycznej i strategicznego wdrożenia.

Rozwiązania

- Ulepszona infrastruktura: Opracowanie solidnej infrastruktury cyfrowej, która będzie w stanie obsłużyć wdrożenia AI na dużą skalę. Na przykład usługi w chmurze i zlokalizowane centra danych zmniejszają opóźnienia i poprawiają wydajność

- **Wspieranie środowiska współpracy, w którym jednostki technologiczne i biznesowe współpracują ze sobą w celu płynnej integracji rozwiązań AI z istniejącymi modelami biznesowymi

- Zautomatyzowane narzędzia rozwoju AI: Wykorzystanie platform takich jak evoML firmy TurinTech do automatyzacji rozwoju kodów uczenia maszynowego, umożliwiając szybsze tworzenie i wdrażanie modeli

- Ciągłe uczenie się i adaptacja: Wdrożenie mechanizmów ciągłego uczenia się i aktualizacji modeli AI w celu dostosowania do rzeczywistych danych i zmieniających się warunków rynkowych, zapewniając długoterminową trafność i wydajność

- Inwestowanie w rozwój talentów: Budowanie wewnętrznej wiedzy specjalistycznej w zakresie sztucznej inteligencji poprzez szkolenia i praktyki zatrudniania, które koncentrują się na nowych technologiach sztucznej inteligencji, zmniejszając nadmierne poleganie na zewnętrznych talentach w tej dziedzinie

Przeczytaj również:_ Najważniejsze statystyki AI do poznania dzisiaj

4. Deepfake i generatywne oszustwa AI

Stan globalnego rynku generatywnej sztucznej inteligencji przez Marketresearch.biz Generatywna sztuczna inteligencja i technologie deepfake zmieniają krajobraz oszustw, zwłaszcza w sektorze usług finansowych. Sprawiają one, że tworzenie przekonujących podróbek jest łatwiejsze i tańsze.

Na przykład w styczniu 2024 r. deepfake podszywający się pod dyrektora finansowego poinstruował pracownika, aby przelał 25 milionów dolarów pokazując poważne konsekwencje takich technologii.

Ten rosnący trend podkreśla wyzwania stojące przed bankami, które starają się dostosować swoje systemy zarządzania danymi i wykrywania oszustw, aby przeciwdziałać coraz bardziej wyrafinowanym oszustwom, które nie tylko oszukują osoby fizyczne, ale także systemy bezpieczeństwa oparte na maszynach.

Potencjał takich oszustw szybko rośnie, a prognozy sugerują, że generatywna sztuczna inteligencja może spowodować straty finansowe w Stanach Zjednoczonych do poziomu nawet 40 miliardów dolarów do 2027 r., co stanowi znaczący skok z 12,3 mld USD w 2023 r.

Rozwiązania

- Zaawansowane technologie wykrywania: Banki muszą inwestować w nowsze technologie, które mogą skuteczniej wykrywać anomalie deepfake i generatywnej sztucznej inteligencji

- Nadzór ludzki: Integracja wykwalifikowanej analizy ludzkiej z reakcjami sztucznej inteligencji zwiększa wskaźniki wykrywalności i pomaga zweryfikować i zrozumieć identyfikację oszustw opartą na sztucznej inteligencji

- Wspólne wysiłki na rzecz zapobiegania oszustwom: Nawiązywanie partnerstw w różnych branżach może pomóc w opracowaniu bardziej niezawodnych mechanizmów identyfikacji i zapobiegania oszustwom

5. Wyzwania związane z interoperacyjnością i interakcją człowieka ze sztuczną inteligencją

Kiedy różne organizacje lub kraje wspólnie korzystają ze sztucznej inteligencji, muszą zapewnić, że sztuczna inteligencja zachowuje się etycznie zgodnie z zasadami wszystkich. Nazywa się to interoperacyjnością etyczną i jest szczególnie ważne w obszarach takich jak obrona i bezpieczeństwo.

Obecnie rządy i organizacje mają własny zestaw zasad i etosów. Na przykład, zapoznaj się z wytycznymi Microsoftu dotyczącymi interakcji człowieka ze sztuczną inteligencją:

wytyczne firmy Microsoft dotyczące interakcji człowieka ze sztuczną inteligencją przez_ Microsoft Brakuje jednak standaryzacji tego etosu i zasad na całym świecie.

Obecnie systemy sztucznej inteligencji mają własny zestaw zasad etycznych, które mogą być w porządku w jednym miejscu, ale problematyczne w innym. Kiedy systemy te wchodzą w interakcje z ludźmi, jeśli nie zachowują się zgodnie z oczekiwaniami, może to prowadzić do nieporozumień lub braku zaufania

Rozwiązania

- Ustalenie uniwersalnych standardów etycznych: Uzgodnienie podstawowych zasad etycznych, których muszą przestrzegać wszystkie systemy AI, niezależnie od tego, skąd pochodzą. Skupienie się na uczciwości, odpowiedzialności i przejrzystości

- Stosowanie silnego systemu certyfikacji: Zanim jakikolwiek system sztucznej inteligencji zostanie użyty, powinien przejść trudny test, aby potwierdzić, że spełnia te standardy etyczne. Może to obejmować kontrole przeprowadzane przez twórców, a także przez niezależne grupy

- Upewnij się, że wszyscy są w pętli: Zawsze jasno określaj, w jaki sposób sztuczna inteligencja podejmuje decyzje i wykorzystuje dane. Taka przejrzystość pomaga budować zaufanie i ułatwia integrację różnych systemów AI

- **Regularnie sprawdzaj systemy AI, aby upewnić się, że nadal spełniają standardy etyczne. Aktualizuj je w razie potrzeby, aby nadążać za nowymi zasadami lub technologiami

6. Etyka AI to coś więcej niż tylko dobre intencje

Sztuczna inteligencja (AI) wkracza w niemal każdą dziedzinę naszego życia - od autonomicznych samochodów po wirtualnych asystentów - i to jest genialne! Ale oto haczyk: sposób, w jaki korzystamy ze sztucznej inteligencji, może czasami wywoływać poważne etyczne bóle głowy. Istnieją drażliwe kwestie etyczne dotyczące prywatności, uprzedzeń, zwolnień z pracy i nie tylko.

Ponieważ sztuczna inteligencja jest w stanie wykonywać zadania, które wcześniej wykonywali ludzie, istnieje cała debata na temat tego, czy powinna ona w ogóle wykonywać niektóre z nich.

Na przykład, czy sztuczna inteligencja powinna pisać scenariusze filmowe? Brzmi fajnie, ale wywołało to ogromne poruszenie w świecie rozrywki, wywołując strajki w USA i Europie. I nie chodzi tylko o to, jakie zawody może przejąć sztuczna inteligencja; chodzi również o to, w jaki sposób wykorzystuje nasze dane, podejmuje decyzje, a czasem nawet się myli. To sprawia, że wszyscy, od twórców technologii po orły prawa, starają się dowiedzieć jak odpowiedzialnie obchodzić się ze sztuczną inteligencją.

Rozwiązania

- Określenie zasad: Opracowanie krystalicznie czystych wytycznych dotyczących tego, w jaki sposób należy korzystać ze sztucznej inteligencji. Oznacza to ustalenie granic, aby zapobiec niewłaściwemu wykorzystaniu i zrozumienie konsekwencji prawnych działań AI

- Poszanowanie prywatności: Ogromne ilości danych, w tym danych osobowych, są wykorzystywane do trenowania sztucznej inteligencji. Musimy być bardzo ostrożni, jeśli chodzi o sposób gromadzenia, wykorzystywania i ochrony tych danych. Chodzi o upewnienie się, że sztuczna inteligencja szanuje naszą prywatność

- Walka z uprzedzeniami: Sztuczna inteligencja jest tylko tak dobra, jak dane, z których się uczy, a czasami te dane mają uprzedzenia. Musimy usunąć te uprzedzenia z systemów sztucznej inteligencji, aby upewnić się, że są one sprawiedliwe i nie dyskryminują

- Ochrona własności intelektualnej: Sztuczna inteligencja może tworzyć dzieła w oparciu o to, czego nauczyła się z twórczości innych osób. Może to naruszać prawa autorskie i pozbawiać twórców należnych im praw, chyba że będziemy uważać

- Etyka kontra szybkość: W szalonym pędzie do wprowadzenia najnowszych technologii AI na rynek, etyka może zostać odsunięta na bok. Musimy zrównoważyć potrzebę szybkości z robieniem rzeczy we właściwy sposób

7. Mieszanie zestawów danych AI może oznaczać katastrofę

Jak dane są dzielone na potrzeby rozwoju sztucznej inteligencji przez Research Gate Podczas opracowywania Uczenie maszynowe AI modeli, prawidłowe rozróżnienie między treningowymi, walidacyjnymi i testowymi zbiorami danych może być trudne. Zbiór danych treningowych modelu AI uczy model, zbiór danych walidacyjnych dostraja go, a zbiór danych testowych ocenia jego wydajność.

Niewłaściwe zarządzanie podziałem tych zbiorów danych może prowadzić do modeli, które albo nie działają odpowiednio z powodu niedopasowania, albo działają zbyt dobrze na danych treningowych, ale słabo na nowych, niewidocznych danych z powodu przepasowania.

Ten błąd może poważnie ograniczyć zdolność modelu do skutecznego funkcjonowania w rzeczywistych zastosowaniach sztucznej inteligencji, w których kluczowa jest zdolność adaptacji i dokładność na znormalizowanych danych.

Rozwiązania

- Strukturalny podział danych: Przyjęcie systematycznego podejścia do podziału danych na zestawy treningowe, walidacyjne i testowe

- Techniki walidacji krzyżowej: Wykorzystaj metody walidacji krzyżowej, szczególnie w scenariuszach z ograniczoną ilością danych. Techniki takie jak K-krotna walidacja krzyżowa pomagają zmaksymalizować wykorzystanie treningu i zapewniają bardziej wiarygodne oszacowanie wydajności modelu na niewidocznych danych

- Randomizacja danych: Upewnij się, że podział danych jest randomizowany, aby zapobiec wprowadzeniu stronniczości AI przez kolejność danych. Pomaga to w tworzeniu zestawów treningowych i walidacyjnych, które są reprezentatywne dla całego zbioru danych

8. Ryzyko i obawy związane z automatycznym podejmowaniem decyzji

Kiedy sztuczna inteligencja podejmuje decyzje, sprawy mogą stać się trudne, zwłaszcza w krytycznych obszarach, takich jak opieka zdrowotna i bankowość. Jednym z największych problemów jest to, że nie zawsze możemy zobaczyć, w jaki sposób systemy AI podejmują decyzje.

Może to prowadzić do nieuczciwych decyzji, których nikt nie jest w stanie wyjaśnić. Ponadto systemy te są celem dla hakerów, którzy, jeśli się do nich dostaną, mogą ukraść wiele ważnych danych.

Rozwiązania

- Opracuj solidne protokoły bezpieczeństwa: Upewnij się, że systemy AI są szczelnie zamknięte przed hakerami. Aktualizuj zabezpieczenia, aby zamknąć wszelkie nowe luki, które się pojawią

- Zwiększenie przejrzystości: Korzystaj z technologii, która pomaga sztucznej inteligencji wyjaśniać swoje wybory w prosty sposób. Jeśli wszyscy zrozumieją, w jaki sposób podejmowane są decyzje, będą bardziej ufać sztucznej inteligencji

- Chroń prywatne informacje: Zabezpiecz wszystkie dane osobowe przetwarzane przez AI. Przestrzegaj przepisów, takich jak RODO, aby upewnić się, że niczyja prywatność nie jest zagrożona

- Wspieranie multidyscyplinarnej współpracy: Zbierz do współpracy ekspertów ze wszystkich dziedzin - technologii, prawa, etyki. Pomogą oni upewnić się, że decyzje podejmowane przez sztuczną inteligencję są sprawiedliwe i bezpieczne

Przeczytaj także: Najpopularniejsze_ **Narzędzia AI dla studentów

9. Brak jasnych zasad i przepisów dotyczących sztucznej inteligencji

Obecnie nie ma jednego globalnego organu nadzorującego sztuczną inteligencję; przepisy różnią się w zależności od kraju, a nawet sektora. Na przykład w Stanach Zjednoczonych nie ma żadnego centralnego organu zajmującego się sztuczną inteligencją.

To, co widzimy dzisiaj, to mozaika Zarządzanie sztuczną inteligencją i regulacje egzekwowane przez różne agencje w oparciu o ich domenę, taką jak ochrona konsumentów lub prywatność danych.

To zdecentralizowane podejście może prowadzić do niespójności i zamieszania; różne standardy mogą mieć zastosowanie w zależności od tego, gdzie i jak wdrażana jest sztuczna inteligencja. Sprawia to, że deweloperzy i użytkownicy AI mają trudności z zapewnieniem pełnej zgodności we wszystkich jurysdykcjach.

Rozwiązania

- Ustanowienie dedykowanego organu regulacyjnego ds. sztucznej inteligencji: Kraje mogłyby skorzystać na utworzeniu specjalnej agencji zajmującej się sztuczną inteligencją. Organ ten mógłby nadzorować wszystkie kwestie związane ze sztuczną inteligencją, nadążając za szybkim tempem jej rozwoju i zapewniając zgodność ze standardami bezpieczeństwa i etyki

- Współpraca międzynarodowa: Sztuczna inteligencja nie zatrzymuje się na granicach. Kraje muszą współpracować w celu stworzenia międzynarodowych standardów i umów dotyczących wykorzystania sztucznej inteligencji, podobnie jak w przypadku globalnych traktatów dotyczących ochrony środowiska

- Przejrzyste i adaptacyjne prawodawstwo: Przepisy muszą być jasne (aby firmy wiedziały, jak ich przestrzegać), ale także wystarczająco elastyczne, aby dostosować się do nowych postępów w dziedzinie sztucznej inteligencji. Regularne aktualizacje i przeglądy przepisów dotyczących sztucznej inteligencji mogą pomóc w utrzymaniu ich aktualności

- Zaangażowanie opinii publicznej i interesariuszy: Przepisy powinny być opracowywane przy udziale szerokiego grona interesariuszy, w tym firm technologicznych, etyków i ogółu społeczeństwa. Może to pomóc w zapewnieniu, że różne punkty widzenia są brane pod uwagę, a społeczeństwo bardziej ufa systemom sztucznej inteligencji

Przeczytaj również:_ **Narzędzia AI dla prawników

10. Dezinformacja ze strony AI

Wyobraź sobie technologię, która potrafi myśleć jak człowiek. To obietnica sztucznej inteligencji ogólnej (AGI), ale wiąże się ona z dużym ryzykiem. Jednym z głównych problemów jest dezinformacja.

Dzięki AGI można łatwo tworzyć fałszywe wiadomości lub przekonujące fałszywe informacje, utrudniając wszystkim ustalenie, co jest prawdą, a co nie.

Ponadto, jeśli AGI podejmuje decyzje w oparciu o te fałszywe informacje, może to prowadzić do katastrofalnych skutków, wpływając na wszystko, od polityki po życie osobiste.

Rozwiązania

- **Zawsze dokładnie sprawdzaj fakty, zanim pozwolisz AGI rozpowszechniać informacje. Korzystaj z wiarygodnych źródeł i potwierdzaj szczegóły, zanim cokolwiek zostanie upublicznione

- Naucz AGI etyki: Tak jak uczymy dzieci, co jest dobre, a co złe, musimy nauczyć AGI etycznego zachowania. Obejmuje to zrozumienie wpływu rozpowszechniania fałszywych informacji i podejmowanie decyzji, które są uczciwe i sprawiedliwe

- Utrzymywanie ludzi w pętli: Bez względu na to, jak inteligentna staje się AGI, ludzie powinni być zaangażowani w proces podejmowania decyzji. Pomaga to wychwycić błędy i zapewnia, że działania AGI odzwierciedlają nasze wartości i etykę

- Stwórz jasne zasady: Ustal ścisłe wytyczne dotyczące tego, co AGI może, a czego nie może robić, zwłaszcza jeśli chodzi o tworzenie i rozpowszechnianie informacji. Upewnij się, że zasady te są przestrzegane co do joty

Przeczytaj także: Kompletny_ Słowniczek AI Narzędzia do radzenia sobie z wyzwaniami sztucznej inteligencji

Kiedy zagłębiasz się w sztuczną inteligencję, wybór odpowiednich narzędzi nie jest tylko miłym dodatkiem; to konieczność, aby upewnić się, że Twoja podróż AI nie okaże się katastrofalna. Chodzi o uproszczenie złożoności, zabezpieczenie danych i uzyskanie wsparcia potrzebnego do rozwiązania wyzwań związanych ze sztuczną inteligencją bez rozbijania banku.

Kluczem jest wybór dostosowanego oprogramowania AI, które zwiększa produktywność, jednocześnie chroniąc prywatność i bezpieczeństwo danych.

Enter ClickUp Brain szwajcarski scyzoryk dla sztucznej inteligencji w miejscu pracy.

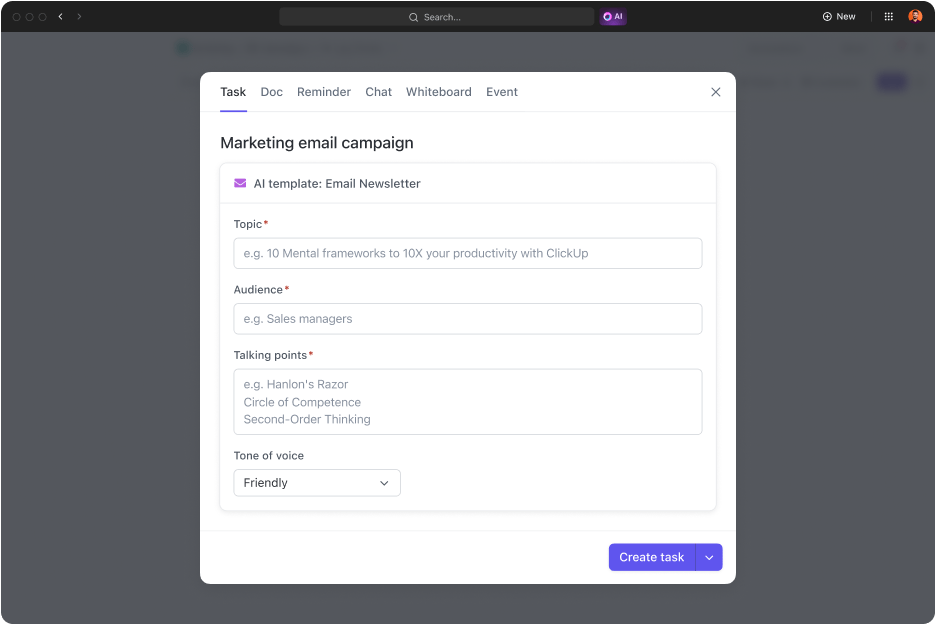

ClickUp Brain: Wydajność, bezpieczeństwo i innowacyjność w jednym

ClickUp Brain został zaprojektowany do obsługi wszystkiego, co związane ze sztuczną inteligencją - od zarządzania projektami i dokumentami po usprawnienie komunikacji w zespole. Dzięki możliwościom sztucznej inteligencji ClickUp Brain możesz sprostać wyzwaniom związanym z danymi, usprawnić zarządzanie projektami i zwiększyć produktywność, a wszystko to przy zachowaniu prostoty i bezpieczeństwa. ClickUp Brain to kompleksowe rozwiązanie, które:

- Płynnie integruje się z codzienną pracą

- Zapewnia, że Twoje dane pozostaną Twoją własnością

- Oszczędza pieniądze i zasoby

ClickUp Brain inteligentnie integruje się z przepływem pracy, aby zaoszczędzić czas i wysiłek, jednocześnie chroniąc Twoje dane. Jest on (podobnie jak reszta platformy ClickUp) zgodny z GDPR i nie wykorzystuje Twoich danych do szkoleń.

Oto jak to działa:

- AI Knowledge Manager: Czy kiedykolwiek chciałeś uzyskać natychmiastowe, dokładne odpowiedzi z dokumentów roboczych lub czatów? ClickUp Brain sprawia, że jest to możliwe. Koniec z wielogodzinnym przekopywaniem się przez pliki. Po prostu zapytaj, a otrzymasz - niezależnie od tego, czy są to szczegóły z dokumentu projektu, czy spostrzeżenia z poprzednich aktualizacji zespołu

- AI Project Manager: Wyobraź sobie, że masz pomocnika AI, który utrzymuje twoje projekty na dobrej drodze. Od automatyzacji aktualizacji zadań po podsumowanie postępów projektu, ClickUp Brain zajmuje się żmudnymi częściami, dzięki czemu możesz skupić się na szerszej perspektywie

Twórz szablony w ClickUp, aby uprościć przepływ pracy nad projektem w ciągu kilku minut

- AI Writer for Work: To narzędzie jest przełomem dla każdego, kto boi się pisać. Niezależnie od tego, czy przygotowujesz szybką wiadomość e-mail, czy opracowujesz obszerny raport, ClickUp Brain pomaga udoskonalić prozę, sprawdzić pisownię i dostosować ton do perfekcji

pisz wszystko, od kopii e-maili po agendy spotkań, szybciej i dokładniej dzięki ClickUp Brain_

Sprostanie wyzwaniom AI za pomocą odpowiednich narzędzi

Pomimo wyzwań związanych ze sztuczną inteligencją, które omówiliśmy, możemy zgodzić się, że sztuczna inteligencja przeszła długą drogę. Ewoluowała od podstawowej automatyzacji do zaawansowanych systemów, które mogą się uczyć, dostosowywać i przewidywać wyniki. Wielu z nas zintegrowało sztuczną inteligencję z różnymi aspektami naszego życia, od wirtualnych asystentów po zaawansowane narzędzia do gromadzenia i analizy danych.

Wraz z postępem sztucznej inteligencji możemy spodziewać się jeszcze większej liczby innowacji, Hacki AI i narzędzia AI w celu zwiększenia produktywności, usprawnienia procesu podejmowania decyzji i zrewolucjonizowania branż. Postęp ten otwiera nowe możliwości, prowadząc nas w kierunku przyszłości, w której sztuczna inteligencja odgrywa kluczową rolę zarówno w sferze osobistej, jak i zawodowej.

Z Narzędzia AI takich jak ClickUp Brain, możesz w pełni wykorzystać technologie AI, jednocześnie zabezpieczając się przed wyzwaniami związanymi z prywatnością i bezpieczeństwem danych. ClickUp to narzędzie do zarządzania zadaniami oparte na sztucznej inteligencji do wszystkiego, od projektów oprogramowania po marketing. Wybierz ClickUp, aby bezpiecznie przekształcić swoją organizację w podmiot oparty na danych i sztucznej inteligencji, jednocześnie zwiększając produktywność zespołu.

Gotowy do przekształcenia swoich przepływów pracy za pomocą AI? Zarejestruj się w ClickUp już teraz!