Privacy is een fundamenteel mensenrecht. En die privacy speelt ook een rol in alle aspecten van de huidige kunstmatige intelligentie. In een rapport van Cisco geeft 64% van de mensen aan bang te zijn dat ze per ongeluk gevoelige informatie kunnen delen wanneer ze AI-tools gebruiken.

Dat is een van de redenen waarom offline AI-tools steeds populairder worden. Wanneer het model lokaal draait, kun je schrijven, codeen, samenvatten en creëren – zonder alles naar de cloud te uploaden of vast te lopen wanneer de wifi uitvalt.

In deze lijst bespreken we de beste AI-tools die offline werken, waaronder een superapp waarmee je de resultaten van deze tools kunt organiseren in één samenhangend, superveilig systeem.

Wat zijn offline AI-tools?

Offline AI-tools zijn softwaretoepassingen die grote taalmodellen (LLM's) op uw lokale apparaat uitvoeren, zonder dat er een internetverbinding nodig is nadat u het model hebt gedownload. De gegevens van het model worden rechtstreeks op uw computer opgeslagen, zodat alle verwerking, of inferentie, op uw eigen CPU of GPU plaatsvindt.

Deze verwerking op het apparaat zelf heeft een aantal belangrijke voordelen:

- Volledige gegevensprivacy: uw gevoelige informatie verlaat nooit uw computer.

- Geen terugkerende kosten: zodra u de tool en het model hebt, zijn er geen abonnementskosten meer.

- Werkt overal: u kunt het gebruiken in het vliegtuig, in een afgelegen hut of tijdens een internetstoring.

- Volledige controle: u kiest zelf welke modellen u wilt gebruiken en hoe u ze wilt configureren.

De beste offline AI-tools in één oogopslag

Hier volgt een kort overzicht van de beste offline AI-tools die momenteel beschikbaar zijn.

| Naam van het gereedschap | Belangrijkste functies | Het beste voor | Prijzen* |

| ClickUp | Offline modus voor taken en herinneringen, ClickUp Brain MAX met Talk-to-Text, Enterprise Search in gekoppelde apps, documenten- en kennisbeheer, automatiseringen, plus integraties en API. | Teams die offline vastlegging plus online uitvoering, governance en AI-context in één werkruimte nodig hebben | Free Forever; aanpassing beschikbaar voor ondernemingen |

| GPT4All | Lokale chat met open modellen, LocalDocs voor privé-documenten Q&A, in-app modelontdekking en downloaden, OpenAI-compatibele lokale API-server | Gebruikers die veel waarde hechten aan privacy en een eenvoudige offline desktop-chatbot met lokale documenten willen. | Gratis abonnement beschikbaar; betaalde abonnementen beginnen bij $ 40 per gebruiker per maand. |

| LM Studio | Modelontdekking en downloaden, chat-gebruikersinterface plus lokale RAG, OpenAI-compatibele server of REST API, voorinstellingen en prestatieoptimalisatie | Ontwikkelaars en ervaren gebruikers die een gepolijste offline modelwerkbank willen | Free |

| Ollama | Eén commandomodel, lokale REST API met streaming, modelbestanden voor herbruikbare configuraties en embeddings voor RAG-pijplijnen | Ontwikkelaars die een CLI-first lokale runtime met een sterke API-laag willen | Gratis abonnement beschikbaar; betaalde abonnementen beginnen bij $ 20 per maand |

| Jan. ai | Offline UI in ChatGPT-stijl, assistenten en MCP-ondersteuning, extensies voor extra mogelijkheden en optionele OpenAI-compatibele providers | Niet-technische gebruikers die een overzichtelijke offline assistent met aangepaste instellingen willen | Gratis en open source |

| Lama-bestand | Enkelvoudig uitvoerbaar modelpakket, draagbare verdeling over verschillende besturingssystemen, lokale servermodus met webinterface en API, minimale afhankelijkheid van runtime. | Gebruikers die een draagbaar AI-bestand willen dat ze overal kunnen uitvoeren zonder installatie | Gratis en open source |

| PrivateGPT | Zelfgehoste documentinvoer en -indexering, offline RAG Q&A, contextfiltering per document, modulaire LLM en vectoropslagstack | Teams die offline vragen en antwoorden nodig hebben over interne bestanden met een controleerbare RAG-pijplijn | Gratis en open source |

| Fluister. cpp | Lokale spraak-naar-tekst, gekwantiseerde modellen voor lager resourcegebruik, VAD-ondersteuning, optionele FFmpeg-verwerking voor meer formaten | Gebruikers die een volledig offline transcriptie nodig hebben die ze in apps kunnen integreren | Gratis en open source |

| Tekstgeneratie Web UI | Browsergebaseerde gebruikersinterface voor lokale modellen, Jinja2-sjablonen voor prompts, generatiecontroles, chatvertakkingen en berichtbewerking | Gebruikers die maximale aanpassingsmogelijkheden willen in een lokale webinterface | Gratis en open source |

| llama.cpp | Krachtige inferentie-engine, brede ondersteuning voor kwantisering, lokale server met OpenAI-achtige eindpunten, embeddings en ondersteuning voor herrangschikking | Ontwikkelaars die aangepaste offline AI-apps of backends bouwen | Gratis en open source |

Hoe we software beoordelen bij ClickUp

Ons redactieteam volgt een transparant, op onderzoek gebaseerd en leveranciersonafhankelijk proces, zodat u erop kunt vertrouwen dat onze aanbevelingen gebaseerd zijn op de werkelijke productwaarde.

Hier volgt een gedetailleerd overzicht van hoe we software beoordelen bij ClickUp.

Waar u op moet letten bij de beste AI-tools die offline werken

Het evalueren van offline AI-tools kan technisch en verwarrend aanvoelen, waardoor u een tool kiest die misschien niet eens op uw computer werkt. Het belangrijkste om te overwegen is wat u wilt bereiken. Een ontwikkelaar die een AI-aangedreven app bouwt, heeft heel andere behoeften dan iemand die alleen een privé, offline AI-chatbot wil voor hulp bij het schrijven.

Dit zijn de sleutelcriteria om te evalueren:

- Eenvoudige installatie: Is er technische kennis en commandoregelwerk nodig, of is het een eenvoudige installatie met één muisklik?

- Selectie van modellen: Kun je gemakkelijk kiezen uit een breed scala aan modellen, of ben je beperkt tot slechts een paar?

- Privacygaranties: Verwerkt de tool alle gegevens lokaal, of zijn er verborgen cloudcomponenten?

- Hardwarevereisten: Werkt het goed op uw huidige computer of moet u een upgrade uitvoeren?

- Integratiemogelijkheden: Kan het een verbinding aangaan met uw andere tools, of is het een volledig op zichzelf staande applicatie?

- Geschikt voor gebruik: Is het ontworpen voor algemene chat, het stellen van vragen over uw documenten, het transcriberen van audio of het genereren van code?

Top 10 beste AI-tools die offline werken

Hier volgt een weergave van de beste offline AI-tools 👇

1. ClickUp (het beste voor het bewaren van taken, documenten en AI-context op één plek voor zowel offline als online werk)

ClickUp, 's werelds eerste Converged AI-werkruimte, is gebouwd op de blokken van 'offline AI' die niet stopt bij het genereren van een antwoord. Dat komt omdat je nog steeds een plek nodig hebt waar die output een beslissing, een taak en een volgende stap wordt die niet verdwijnt in bestanden en chats.

En in tegenstelling tot veel offline installaties die gepaard gaan met langdurige installaties en het samenvoegen van tools, biedt ClickUp u een complete uitvoeringslaag op één plek, waarbij AI bovenop dezelfde werkruimtecontext werkt.

Om te beginnen heb je de ClickUp Offline Mode, die automatisch wordt ingeschakeld en ervoor zorgt dat je werk gewoon doorgaat als je offline bent. Dat betekent dat al je taken, herinneringen en aantekeningen offline toegankelijk blijven en dat je indien nodig meer kunt toevoegen. Zodra je weer verbinding hebt, worden nieuwe taken en herinneringen automatisch gesynchroniseerd met je werkruimte (zeg maar dag tegen het kwijtraken van context 👋).

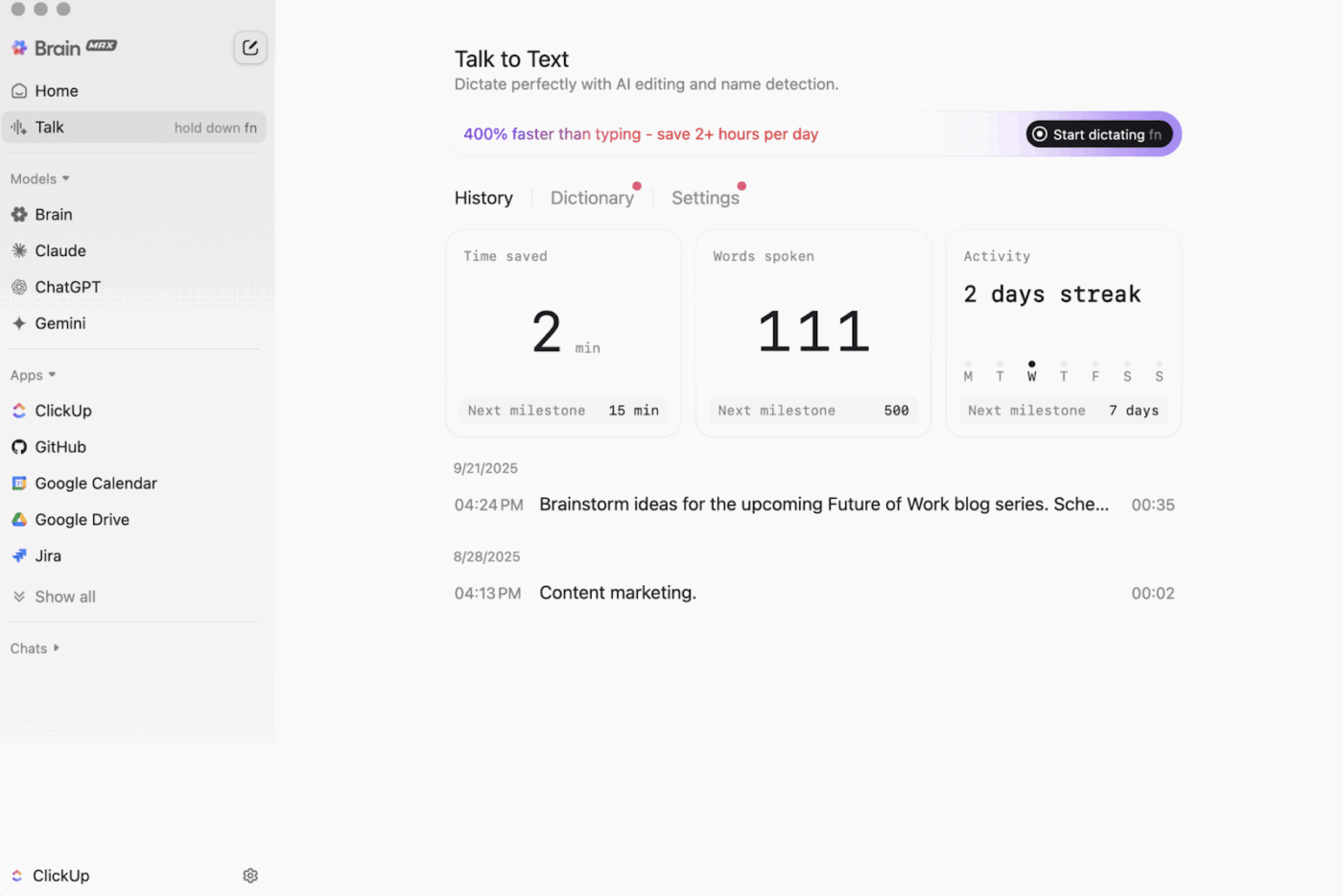

Dan is er nog ClickUp Brain MAX , de privacygerichte desktop-AI-assistent die je hele werkruimte, gekoppelde apps en zelfs het internet kan doorzoeken en opslaan.

Met Talk-to-Text kan Brain MAX je stem handsfree omzetten in tekst. Dat omvat het opstellen van een e-mail, het schrijven van een document of het vastleggen van een snelle update terwijl je onderweg bent.

Brain MAX biedt je ook Universal AI, ontwikkeld om te chatten met de nieuwste AI-modellen voor coderen, schrijven, complexe redeneringen en meer. Dat betekent dat je op één plek vragen kunt stellen aan de beste AI-modellen, waaronder ClickUp Brain plus opties zoals OpenAI, Claude en Gemini, zonder dat je tussen tools hoeft te schakelen.

Bovendien voegt ClickUp Security maatregelen voor veiligheid toe die offline tools vaak overslaan. Denk aan versleuteling, gedetailleerde toestemmingen en controles voor beheerders zoals SSO, provisioning en auditlogs, allemaal ontworpen voor teams die veiligheid op bedrijfsniveau nodig hebben.

ClickUp AI Knowledge Management helpt enorm bij de overgang van 'offline naar online'. Het biedt uw team een hub om verschillende bronnen op te slaan in Docs en wiki's, en gebruikt vervolgens ClickUp Brain om direct antwoorden uit uw hele werkruimte te halen, zodat de juiste context beschikbaar is op het moment dat het werk wordt hervat.

🎬 Agenten in actie: Gebruik Super Agents om gesynchroniseerd werk om te zetten in volgende stappen!

ClickUp Super Agents zijn door AI aangestuurde teamgenoten die u kunt aanmaken en aanpassen om meerstapswerkstroomstroomen binnen uw ClickUp-werkruimte uit te voeren. U kunt specifieke triggers, instructies en toegang tot tools configureren om ervoor te zorgen dat ze binnen de door u ingestelde grenzen werken.

Als bijvoorbeeld offline taken opnieuw zijn gesynchroniseerd, kan een Super Agent de nieuwe items scannen, samenvatten wat er is gewijzigd, actiepunten eruit halen, een update opstellen en deze naar de juiste eigenaar sturen voor beoordeling.

En omdat Super Agents beheersbaar zijn, kunt u met behulp van toestemmingen bepalen waartoe ze toegang hebben en controleren wat ze doen. 🔐

De beste functies van ClickUp

- Vind alles in uw tools: sorteer en doorzoek uw hele werkruimte, plus gekoppelde apps, vanaf één plek met ClickUp Enterprise Search.

- Bouw een echte kennisbank op: Maak wiki's en documentatie met ClickUp Docs met behulp van geneste pagina's, sjablonen, AI-assistentie en meer.

- Houd uw stack verbonden: synchroniseer uw werk met tools zoals Slack en GitHub zonder ClickUp te verlaten met ClickUp-integraties.

- Maak aangepaste werkstroom: Gebruik de ClickUp API met persoonlijke tokens of OAuth 2. 0 om op maat gemaakte automatiseringen en integraties mogelijk te maken.

- Automatiseer uw stack: trigger acties zoals het toewijzen van eigenaren, het bijwerken van statussen of het starten van overdrachten op basis van taakwijzigingen met ClickUp-automatiseringen.

Limieten van ClickUp

- Vanwege het brede bereik aan functies kunnen sommige gebruikers een leercurve tegenkomen.

Prijzen van ClickUp

Beoordelingen en recensies van ClickUp

- G2: 4,7/5 (meer dan 10.000 beoordelingen)

- Capterra: 4,6/5 (meer dan 4.000 beoordelingen)

Wat zeggen echte gebruikers over ClickUp?

Een G2-recensent zegt:

Agile-borden, integraties en aangepaste mogelijkheden. Ik vind het ook prettig dat ik gewoon offline kan gaan en toch aan taken kan blijven werken. Bovendien kan ik e-mails naar alle lijsten sturen en worden er automatisch taken aangemaakt. De editor is fantastisch, werkt zowel in MD-modus als met snelkoppelingen en biedt de mogelijkheid om de content inline te bekijken.

Agile-borden, integraties en aangepaste mogelijkheden. Ik vind het ook prettig dat ik gewoon offline kan gaan en toch aan taken kan blijven werken. Bovendien kan ik e-mails naar alle lijsten sturen en worden er automatisch taken aangemaakt. De teksteditor is fantastisch, werkt zowel in MD-modus als met snelkoppelingen en biedt de mogelijkheid om de content inline te bekijken.

2. GPT4All (het beste voor privé, offline AI-chatten met lokale LLM's)

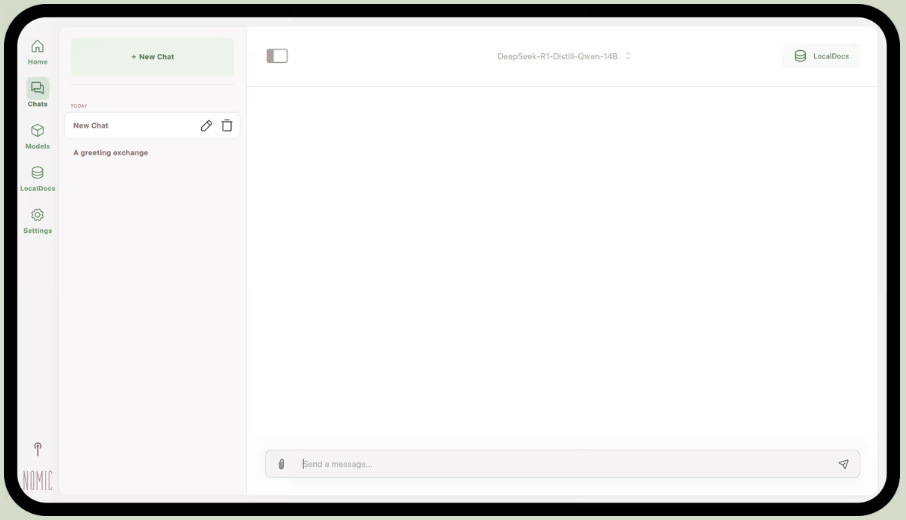

GPT4All, onderdeel van Nomic.ai, is een desktop-app waarmee je open-source grote taalmodellen rechtstreeks op je computer kunt uitvoeren, zodat je met een AI-assistent kunt chatten zonder afhankelijk te zijn van internettoegang of cloud-API-aanroepen. Het is ontwikkeld voor mensen die een 'local-first'-installatie willen, waarbij prompts, reacties en bestanden op het apparaat blijven staan.

De beste functie is LocalDocs, dat gebruikmaakt van een vorm van retrieval-augmented generation waarmee u privé met uw eigen documenten kunt chatten. U kunt de app naar een map met pdf's of tekstbestanden verwijzen, waarna deze een lokale kennisbank aanmaakt waar u vragen aan kunt stellen.

GPT4All bevat ook een samengestelde bibliotheek met populaire modellen zoals Llama en Mistral, die u rechtstreeks via de app kunt downloaden.

De beste functies van GPT4All

- Start een lokale API-server (compatibel met OpenAI) om GPT4All-modellen te gebruiken in andere apps en automatiseringen.

- Zoek, vergelijk en download GGUF-modellen vanuit de app, met sorteeropties zoals likes, downloads en uploaddatum.

- Pas van contextlengte, maximale uitvoerlengte, top-p, top-k, herhalingsstraf, CPU-threads en zelfs GPU-laagontlasting aan (plus Metal-ondersteuning op Apple Silicon).

Beperkingen van GPT4All

- De prestaties zijn sterk afhankelijk van de hardware van uw computer.

- Het indexeren van grote documentverzamelingen kan traag zijn.

Prijzen van GPT4All

- Gratis desktop-app

- Business: $40 per gebruiker per maand (Nomic AI)

- Onderneming: Aangepaste prijzen (Nomic AI)

GPT4All beoordelingen en recensies

- G2: Onvoldoende beoordelingen

- Capterra: Onvoldoende beoordelingen

Wat zeggen echte gebruikers over GPT4All?

Een Reddit-gebruiker zegt:

Dit is de beste die ik heb geprobeerd met RAG, verslaat alles, en zelfs LM Studio in eenvoud. Ik vind het leuk hoe je het aan een map koppelt, en het houdt de veranderingen bij en verwerkt ze voor je. Nog in een vroeg stadium, net als de rest, maar dit wordt mijn standaard voor de korte termijn.

Dit is de beste die ik heb geprobeerd met RAG, verslaat alles, en zelfs LM Studio in eenvoud. Ik vind het leuk hoe je het aan een map koppelt, en het houdt de veranderingen bij en verwerkt ze voor je. Nog in een vroeg stadium, net als de rest, maar dit wordt mijn standaard voor de korte termijn.

📮 ClickUp Insight: 88% van de respondenten van onze enquête gebruikt AI voor persoonlijke taken, maar meer dan 50% schuwt het gebruik ervan op het werk. De drie belangrijkste belemmeringen? Gebrek aan naadloze integratie, kennislacunes of bezorgdheid over de veiligheid. Maar wat als AI in uw werkruimte is ingebouwd en al veilig is? ClickUp Brain,

De ingebouwde AI-assistent van ClickUp maakt dit mogelijk. Hij begrijpt vragen in gewone taal en lost alle drie de zorgen over het gebruik van AI op, terwijl hij je chat, taken, documenten en kennis in de hele ClickUp-werkruimte met elkaar verbindt. Vind antwoorden en inzichten met één klik!

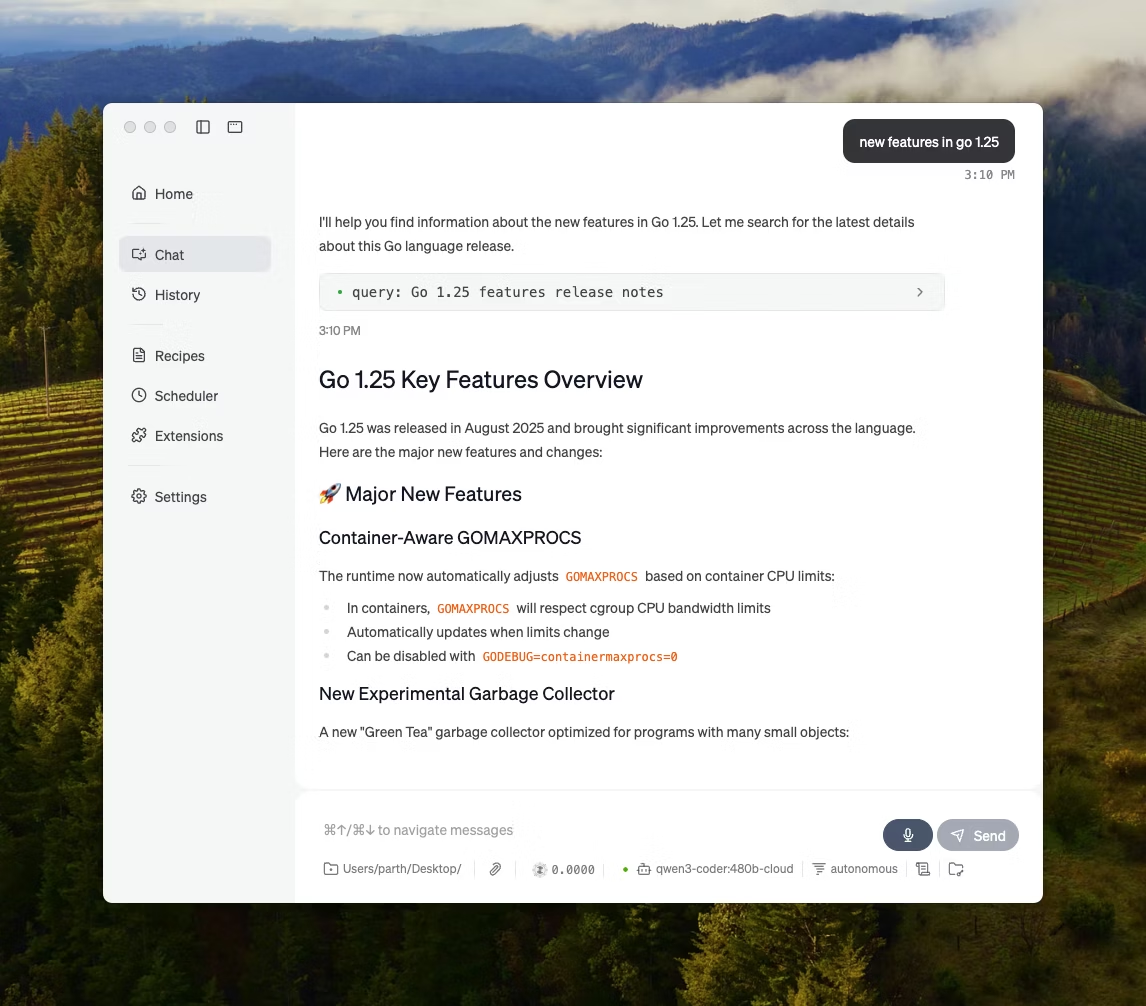

3. LM Studio (het meest geschikt voor een gepolijste offline modelwerkbank met prestatieoptimalisatie)

via LM Studio

LM Studio is een lokale AI-desktop-app die is ontwikkeld om open-source modellen te vinden, te testen en uit te voeren in een gebruikersinterface, zonder dat je afhankelijk bent van een terminal. De app is gericht op experimenteren, zoals het kiezen van een model, het lokaal uitvoeren ervan en het herhalen van prompts en instellingen met een strakkere feedbackloop dan de meeste CLI-first-installaties.

Het ondersteunt ook chatten met documenten volledig offline (lokale RAG), waarbij u bestanden als bijlagen aan een gesprek toevoegt en ernaar verwijst tijdens reacties. Dat maakt het ideaal voor offline onderzoek, studienotities of interne werkstroomen waarbij uploaden geen optie is.

LM Studio biedt u ook uitgebreide controle over hoe de AI werkt, met opties om de temperatuur, contextlengte en GPU-gebruik aan te passen.

De beste functies van LM Studio

- Gebruik de OpenAI-compatibiliteitsmodus of de eigen REST API van LM Studio, afhankelijk van wat uw app verwacht.

- LM Studio biedt zowel JavaScript- als Python SDK-opties voor het bouwen van lokale werkstroom-werkflows bovenop uw modellen.

- Sla een systeemmelding + parameters op als voorinstelling en gebruik deze vervolgens opnieuw in verschillende chats (voorinstellingen kunnen ook worden geïmporteerd vanuit een bestand/URL en worden gepubliceerd om te delen via de LM Studio hub).

Beperkingen van LM Studio

- LM Studio kan de computer laten vastlopen tijdens het uitvoeren van DeepSeek R1 32B.

- Sommige gebruikers markeren de app als een probleem op het gebied van gegevensveiligheid en privacy vanwege niet-gecontroleerde gesloten code.

Prijzen LM Studio

- Gratis voor thuis- en werkgebruik

Beoordelingen en recensies van LM Studio

- G2: Onvoldoende beoordelingen

- Capterra: Onvoldoende beoordelingen

Wat zeggen echte gebruikers over LM Studio?

Een Reddit-gebruiker zegt:

Het is geweldig. Het werkt gewoon, supergemakkelijk om op te starten. Heeft de mooiste gebruikersinterface van alle concurrenten.

Het is geweldig. Het werkt gewoon, supergemakkelijk om op te starten. Heeft de mooiste gebruikersinterface van alle concurrenten.

4. Ollama (het meest geschikt voor het uitvoeren van lokale LLM's met een eenvoudige CLI + lokale server)

Ollama is een lokale modelrunner die zich meer gedraagt als een LLM-runtime dan als een zelfstandige chat-app. Het is terminal-first, ontworpen om open modellen op te halen en uit te voeren met snelle commando's (zoals ollama run llama3), en ze vervolgens beschikbaar te maken via een lokale service waarop andere interfaces kunnen worden aangesloten.

De kracht van Ollama ligt in zijn REST API. Zodra Ollama op de achtergrond draait, kan elke applicatie ermee communiceren via eenvoudige HTTP-verzoeken. Dit helpt bij het inbouwen van AI-functies in uw eigen software.

Ollama biedt ook een bibliotheek met populaire modellen die met één commando kunnen worden gedownload, en u kunt aangepaste modelconfiguraties maken, die vergelijkbaar zijn met Dockerfiles voor AI.

De beste functies van Ollama

- Maak herbruikbare, versieerbare modelrecepten (basismodelselectie, promptsjablonen, systeemberichten, parameters, adapters) met behulp van een Modelfile.

- Voer modellen uit via eindpunten zoals chatten/genereren met optionele streaming voor realtime tokenuitvoer in apps en scripts.

- Genereer embeddings voor semantische zoek- en opvraagpijplijnen met behulp van de embeddingsmogelijkheden en aanbevolen embeddingsmodellen van Ollama.

Beperkingen van Ollama

- Het heeft geen ingebouwde grafische interface, dus niet-technische gebruikers hebben een aparte frontend-tool nodig.

- De macOS-desktop-app van Ollama reageert mogelijk niet wanneer u offline bent, zelfs als de modellen al zijn gedownload, terwijl de CLI blijft werken.

Ollama-prijzen

- Free

- Pro: $20/maand

- Maximaal: $100/maand

Ollama beoordelingen en recensies

- G2: Onvoldoende beoordelingen

- Capterra: Onvoldoende beoordelingen

Wat zeggen echte gebruikers over Ollama?

Een recensent van Producthunt zegt:

Eenvoudig te implementeren en te beheren. Ollama maakt het uitvoeren van lokale LLM's zo eenvoudig. Combineer het met OpenWebUI voor de ultieme ervaring.

Eenvoudig te implementeren en te beheren. Ollama maakt het uitvoeren van lokale LLM's zo eenvoudig. Combineer het met OpenWebUI voor de ultieme ervaring.

🧠 Leuk weetje: Spraak-naar-tekst begon als 'alleen cijfers'. AUDREY (1952) van Bell Labs herkende de cijfers 0-9, en in een aantekening wordt vermeld dat het het beste werkte wanneer het werd uitgesproken door de uitvinder ervan.

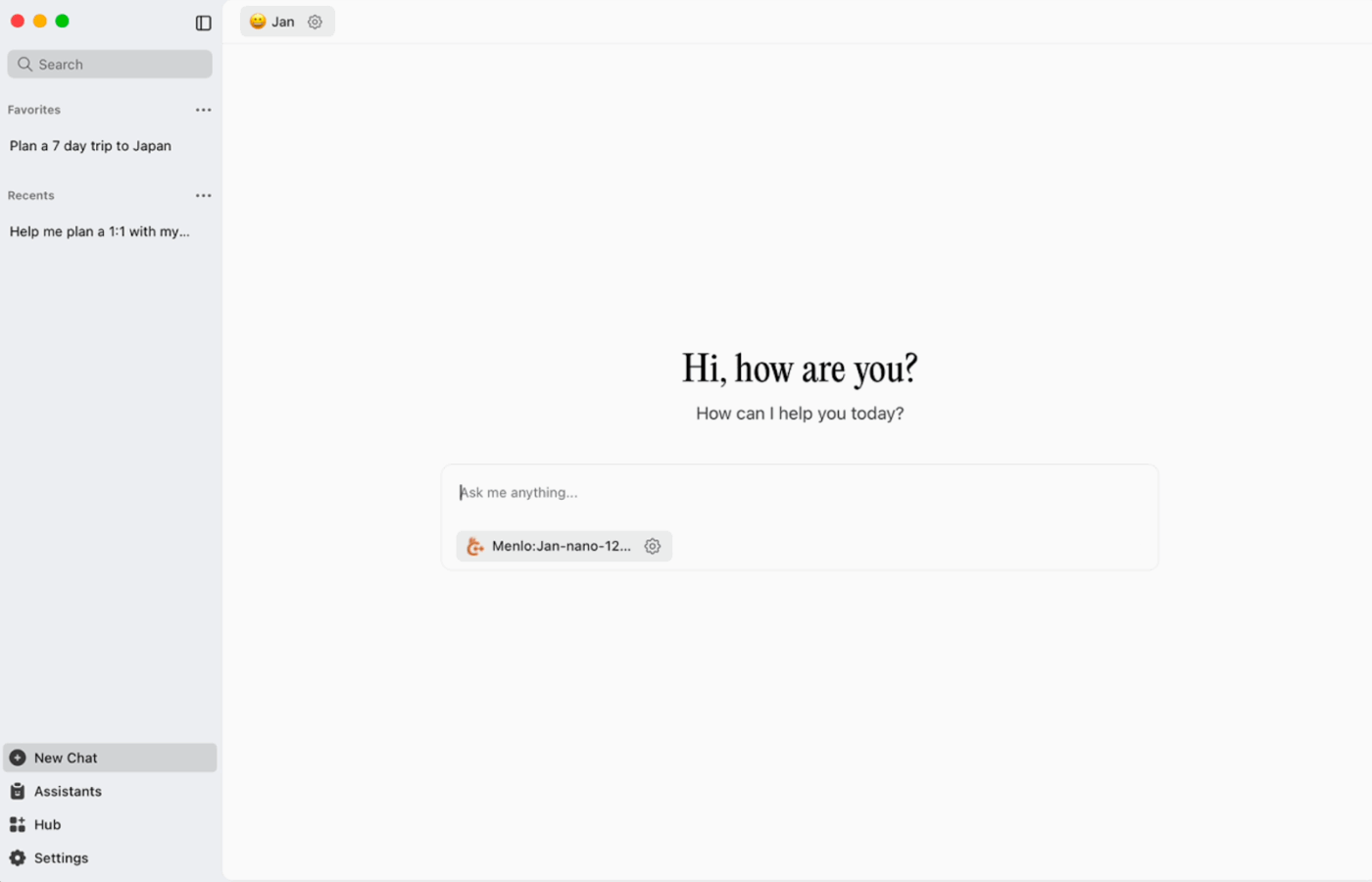

5. Jan. ai (het beste voor een offline, privacygerichte assistent in ChatGPT-stijl)

Jan. ai is een open-source desktopassistent die een ChatGPT-achtige chatervaring biedt voor macOS, Windows en Linux, waarbij lokaal gebruik standaard is. Het programma draait op het apparaat wanneer u dat wilt, terwijl de geschiedenis van de gesprekken en gebruiksgegevens lokaal worden opgeslagen en niet van uw computer verdwijnen.

Het ondersteunt het lokaal uitvoeren van open-source modellen en maakt ook optionele verbindingen mogelijk met externe providers zoals OpenAI-compatibele API's, waardoor het flexibel is wanneer offline gebruik de prioriteit heeft, maar soms toch toegang tot de cloud nodig is.

Jan. ai beste functies

- Maak assistenten met hun eigen instructies en instellingen en schakel vervolgens tussen hen op het tabblad Assistenten in plaats van elke keer opnieuw prompts te schrijven.

- Maak een verbinding tussen Jan en MCP-tools en databronnen met behulp van een open standaard die is ontwikkeld voor werkstroomprocessen waarin tools worden gebruikt.

- Installeer extensies om nieuwe functies toe te voegen, zoals zoeken op internet of een code-interpreter. Dankzij deze modulaire aanpak kunt u eenvoudig beginnen en gaandeweg meer mogelijkheden toevoegen.

Jan. ai limieten

- Jan kan het laden van een modelbestand toestaan dat nog niet volledig is gedownload, wat tot verwarrend of inconsistent gedrag kan leiden totdat het bestand volledig is gedownload.

- Het inschakelen van de API kan interfereren met threaded chats, en basis-endpoints zoals 'get loaded model' of 'swap model' werken mogelijk niet soepel.

Jan. AI-prijzen

- Open source

Jan. ai beoordelingen en recensies

- G2: Onvoldoende beoordelingen

- Capterra: Onvoldoende beoordelingen

Wat zeggen echte gebruikers over Jan. ai?

Een Reddit-gebruiker zegt:

Jan. ai is mijn favoriete lokale LLM-app. Hij is geweldig.

Jan. ai is mijn favoriete lokale LLM-app. Hij is geweldig.

6. Llamafile (het meest geschikt voor het verpakken van een LLM in een draagbaar uitvoerbaar bestand)

Llamafile is een door Mozilla geleid project dat een volledige open-source LLM bundelt in één uitvoerbaar bestand. In plaats van een runtime te installeren, afhankelijkheden te beheren of een aparte gebruikersinterface te koppelen, download je één bestand en voer je het uit als een app.

Het kernidee is verdeling. Een 'llamafile' bevat de modelgewichten plus een gecompileerde runtime, gebouwd om op meerdere besturingssystemen te draaien met minimale installatie. Dit is vooral handig wanneer een offline tool moet worden gedeeld met teamgenoten, studenten of klanten die geen installatieproblemen willen oplossen.

De beste functies van Llamafile

- Llamafile combineert llama.cpp met Cosmopolitan Libc om brede binaire portabiliteit te ondersteunen, waardoor platformspecifieke verpakkingswerkzaamheden worden verminderd.

- De servermodus biedt een web-GUI en een OpenAI API-compatibele completions-eindpunt, wat handig is voor lokale app-ontwikkeling en het vervangen van cloudoproepen tijdens het testen.

- Verpakte llamafiles zijn ontworpen om te draaien op gangbare x86_64- en ARM64-machines, wat de verdeling over gemengde vloten eenvoudiger maakt.

Limieten van Llamafile

- De selectie beperkt zich tot wat is verpakt als een Llamafile.

- De grootte van de bestanden is erg groot omdat het volledige model is ingebed.

Prijzen van Llamafile

- Gratis en open source

Llamafile beoordelingen en recensies

- G2: Onvoldoende beoordelingen

- Capterra: Onvoldoende beoordelingen

🧠 Leuk weetje: De eerste website is nog steeds te bezoeken. CERN host deze letterlijk op info.cern.ch en noemt het de 'startpagina van de eerste website'.

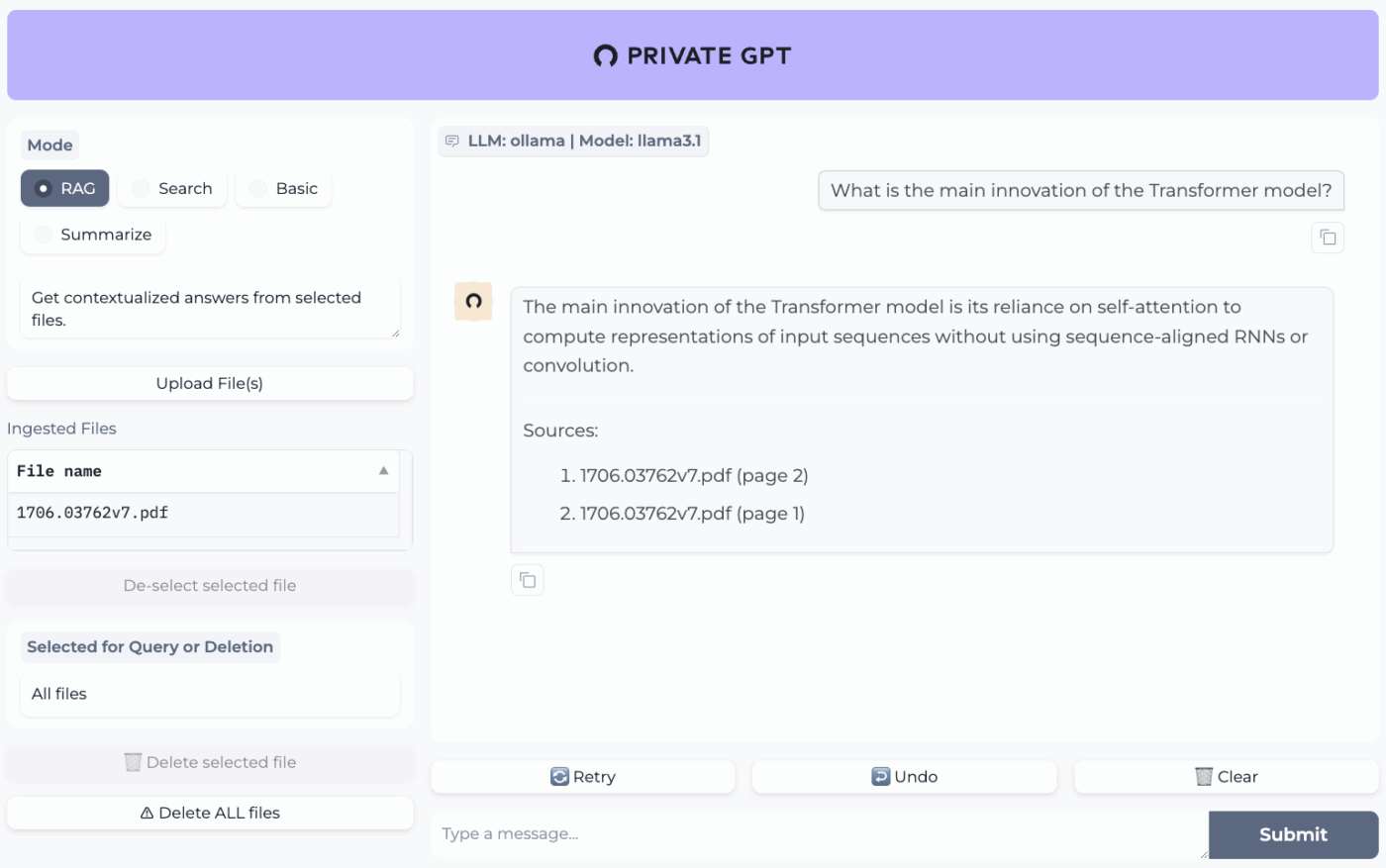

7. PrivateGPT (het beste voor offline vragen en antwoorden over uw bestanden met een zelfgehoste RAG-stack)

PrivateGPT is een productieklaar, zelfgehost project dat is ontwikkeld voor werkstroomen waarbij u met uw documenten kunt chatten. Het neemt lokale bestanden op, indexeert ze en beantwoordt vragen door relevante context uit uw eigen content op te halen in plaats van te vertrouwen op het geheugen van een cloudchatbot. Het project is ontworpen om volledig offline te werken, met de belofte dat de gegevens binnen uw uitvoeringsomgeving blijven.

Wat het onderscheidt van algemene offline chat-apps is de modulaire architectuur. Met andere woorden, je kunt de LLM, embedding provider en vector store mixen en matchen op basis van je hardware en privacybeperkingen, en vervolgens alles uitvoeren achter een lokale API + UI.

De beste functies van PrivateGPT

- Importeer PDF's, DOCX, PPT/PPTX/PPTM, CSV, EPUB, Markdown, JSON, MBOX, IPYNB, afbeeldingen (JPG/PNG/JPEG) en zelfs MP3/MP4 met behulp van de ingebouwde importpijplijn.

- Configureer laagprofielen met PGPT_PROFILES (bijvoorbeeld local,cuda) om meerdere instellingbestanden samen te voegen en implementaties te wisselen zonder uw basisconfiguratie te herschrijven.

- Filter reacties op een specifieke subset van opgenomen documenten met behulp van context_filter bij het aanroepen van contextuele aanvullings-endpoints.

Limiet van PrivateGPT

- Heeft hogere hardwarevereisten omdat meerdere componenten tegelijkertijd worden uitgevoerd.

- Het importeren van meerdere documenten uit één enkel bestand (bijvoorbeeld één PDF-bestand dat één document per pagina genereert) kan het indexeringsvolume en de complexiteit vergroten bij het beheren van grote uploads.

Prijzen PrivateGPT

- Open source

Beoordelingen en recensies van PrivateGPT

- G2: Onvoldoende beoordelingen

- Capterra: Onvoldoende beoordelingen

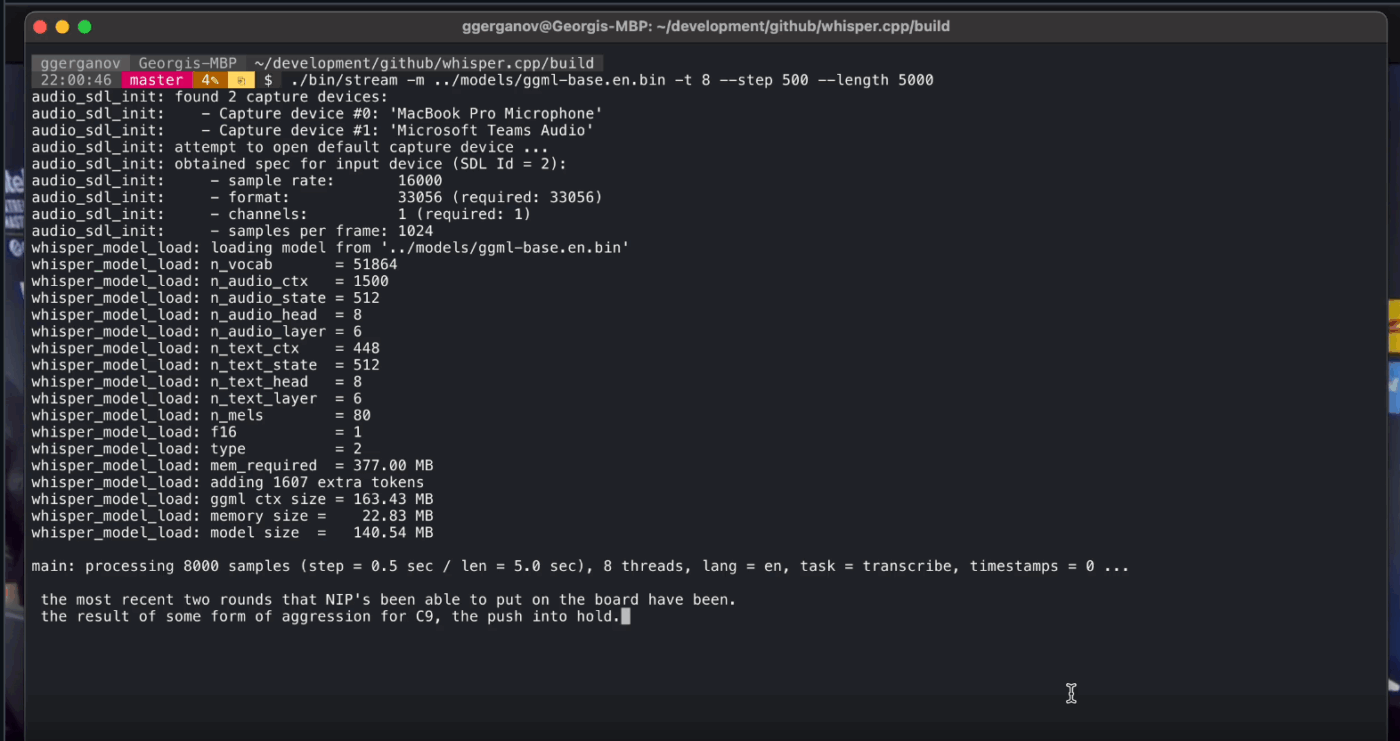

8. Whisper. cpp (het beste voor volledig offline spraak-naar-tekst die je in apps kunt integreren)

Whisper. cpp is een krachtige C/C++-implementatie van het automatische spraakherkenningsmodel Whisper van OpenAI, dat is ontwikkeld om lokaal te draaien zonder zware runtime-afhankelijkheden. Het is populair voor offline transcriptiepijplijnen waarbij u een kleine, draagbare binaire code of een C-achtige bibliotheek wilt die u in uw eigen product kunt meeleveren.

Het is ook flexibel in verschillende omgevingen, met officiële ondersteuning voor desktop, mobiel, WebAssembly, Docker en zelfs Raspberry Pi-klasse hardware, waardoor het geschikt is voor offline tools die op meer dan één plek moeten worden uitgevoerd.

De 'cpp' in de naam verwijst naar de focus op prestaties. Deze implementatie is aanzienlijk sneller en gebruikt minder geheugen dan op Python gebaseerde alternatieven, waardoor realtime transcriptie mogelijk is op moderne computers zonder dat een krachtige GPU nodig is.

Whisper. cpp beste functies

- Voer spraakactiviteitsdetectie (VAD) uit als onderdeel van het project om spraak te segmenteren en ruis en lege audiotranscripties in streaming-achtige werkstroomen te verminderen.

- Kwantiseer Whisper-modellen om de benodigde schijfruimte en het geheugengebruik te verminderen, met meerdere kwantisatieopties die zijn ontworpen voor snellere lokale inferentie.

- Bouw met optionele ondersteuning voor FFmpeg op Linux om meer invoerformaten te verwerken dan alleen het standaard WAV-pad.

Whisper. cpp-limieten

- Whisper. cpp's CLI verwacht standaard 16-bits WAV-invoer, wat een extra conversiestap toevoegt bij het werken met MP3, MP4, M4A of andere gangbare formaten.

- Het labelt sprekers niet standaard (diarisatie), waardoor het moeilijk is om citaten correct toe te schrijven in opnames met meerdere sprekers.

Whisper. cpp-prijzen

- Open source

Whisper. cpp beoordelingen en recensies

- G2: Onvoldoende beoordelingen

- Capterra: Onvoldoende beoordelingen

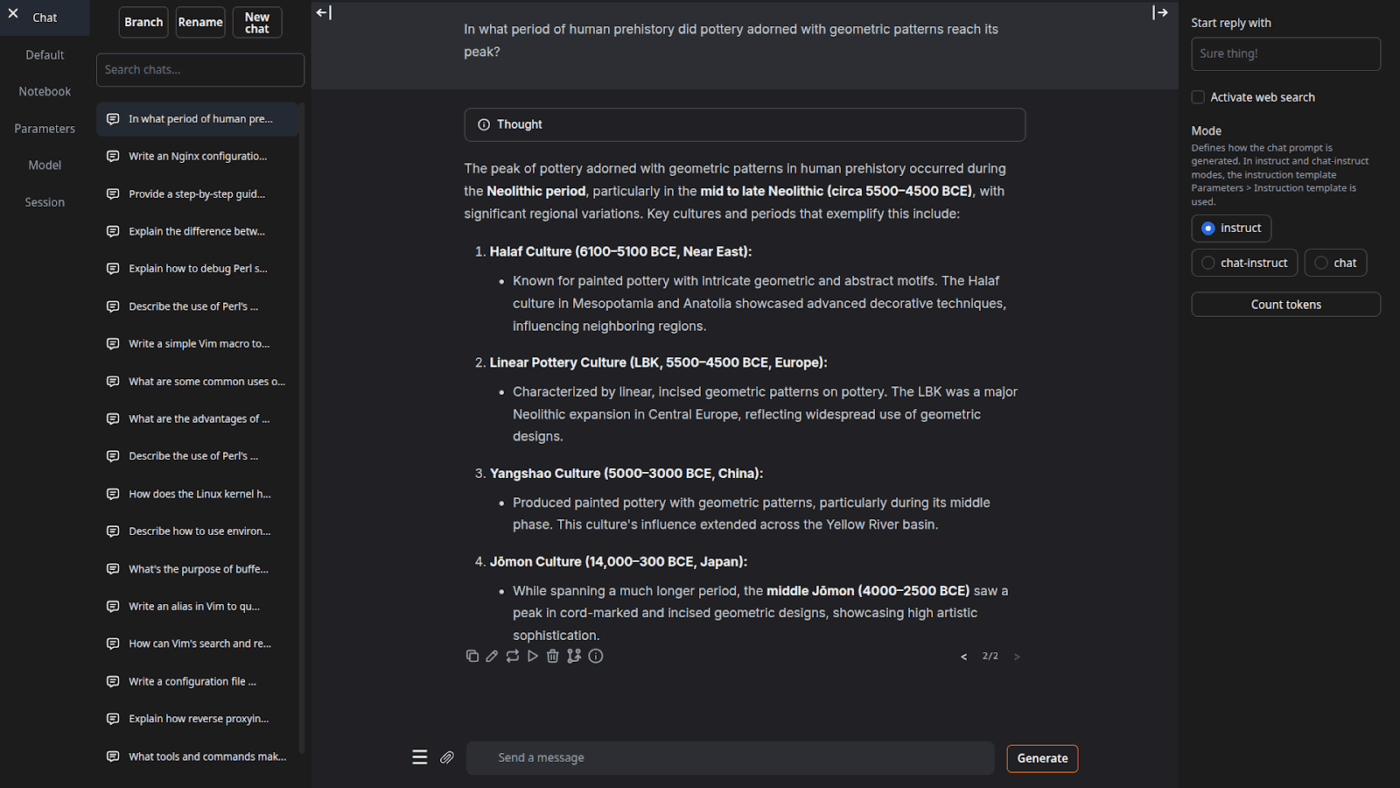

9. Tekstgeneratie Web UI (het meest geschikt voor gebruikers die een browsergebaseerde cockpit voor lokale LLM's willen)

Text Generation Web UI (vaak 'oobabooga' genoemd) is een op Gradio gebaseerde webinterface voor het uitvoeren van lokale modellen, met een sterke nadruk op controle en experimenteren. Het gedraagt zich meer als een volledige werkbank: meerdere model-backends, meerdere interactiemodi en veel knoppen voor het genereren van gedrag.

Het leunt ook op 'writer/dev'-werkstroomen die veel offline tools overslaan, met functies zoals automatisering van promptformaten, generatie in notitieboekstijl en vertakkingen in gesprekken. Voor offline installaties die nog steeds een web-UI nodig hebben, is het een van de meest configureerbare frontends in deze categorie.

Tekstgeneratie Web UI beste functies

- Automatische promptopmaak met behulp van Jinja2-sjablonen, waardoor fouten in het promptformat tussen verschillende modelfamilies worden verminderd

- Pas tientallen instellingen aan om de output van de AI af te stemmen op uw specifieke behoeften, of het nu gaat om creatief schrijven, coderen of rollenspel.

- Berichten bewerken met versienavigatie en gesprekstakken, waarbij meerdere richtingen van hetzelfde chatgesprek behouden blijven zonder opnieuw te beginnen

Beperkingen van de webinterface voor tekstgeneratie

- Het installatieprogramma met één muisklik vereist ~10 GB schijfruimte en downloadt PyTorch, waardoor de installatie zwaar aanvoelt op machines met beperkte opslagruimte.

- Het OpenAI-compatibele embeddings-eindpunt maakt gebruik van sentence-transformers/all-mpnet-base-v2 met 768-dimensionale embeddings, wat aannames kan doorbreken in pijplijnen die zijn gebouwd rond de 1536-dimensionale standaardinstellingen van OpenAI.

Prijzen voor tekstgeneratie via webinterface

- Open source

Beoordelingen en recensies van Text Generation Web UI

- G2: Onvoldoende beoordelingen

- Capterra: Onvoldoende beoordelingen

10. Llama. cpp (het meest geschikt voor krachtige lokale LLM-inferentie op CPU en GPU)

Llama. cpp is een C/C++-inferentie-engine en toolchain voor het lokaal uitvoeren van LLM's met minimale afhankelijkheden en sterke prestaties over een breed bereik aan hardware. Het is minder een 'chat-app' en meer een lokale runtime waar je werkstroommen omheen bouwt, of dat nu een CLI, een lokale HTTP-server of een ingebouwde bibliotheek in je eigen product is.

Hoewel het zelf geen eindgebruikersapplicatie is, is Llama. cpp de motor achter veel van de tools op deze lijst, waaronder GPT4All en LM Studio. Het introduceerde het GGUF-modelformat, dat de standaard is geworden voor het draaien van grote modellen op consumentenhardware door hun grootte efficiënt te verkleinen.

Het biedt ook bindingen voor populaire programmeertalen zoals Python en Rust, en de servermodus kan een OpenAI-compatibele API bieden.

Llama. cpp beste functies

- Start een lokale server die compatibel is met de OpenAI API, met een ingebouwde web-UI en een /v1/chat/completions-eindpunt, met behulp van llama-server.

- Voer een inbeddingsmodel (en zelfs een herrangschikkingsmodel) uit vanaf dezelfde server voor offline RAG-pijplijnen met behulp van /embedding en /reranking.

- Kwantiseer modellen tot 1,5-bit tot 8-bit om het geheugengebruik te verminderen en lokale inferentie te versnellen, en versnel vervolgens de uitvoering met CUDA/Metal plus Vulkan/SYCL-backends indien beschikbaar.

Beperkingen van Llama.cpp

- Llama. cpp wordt niet geleverd als een gepolijste desktopassistent, wat betekent dat offline gebruik vaak CLI-commando's of het hosten van llama-server vereist, en veel gebruikers vertrouwen op UI's van derden voor dagelijks chatten.

- De compatibiliteit van Llama.cpp met OpenAI is niet altijd 1:1 met elke OpenAI-clientfunctie, en gebruikers melden discrepanties rond gestructureerde uitvoerparameters zoals response_format in /v1/chat/completions.

Llama. cpp-prijzen

- Open source

Wat zeggen echte gebruikers over Llama. cpp?

Een recensent van Sourceforge zegt:

Geweldig. AI democratiseren voor iedereen. En het werkt fantastisch!

Geweldig. AI democratiseren voor iedereen. En het werkt fantastisch!

Zet offline AI-output om in echt werk met ClickUp

Het kiezen van de juiste offline AI-tool draait eigenlijk om het afstemmen van de tool op de taak.

Als je hier bent, ben je waarschijnlijk bezig met het optimaliseren van drie dingen: privacy, geen afhankelijkheid van internet en vrijheid van weer een nieuw abonnement.

De tools op deze lijst presteren op dat vlak op verschillende manieren. Dat betekent dat sommige beter zijn voor schrijven en codeen, andere voor zoeken, aantekeningen maken of creatief werk.

Maar voor teams is de grootste uitdaging niet alleen het lokaal uitvoeren van AI. Het is het omzetten van AI-output in echte werkstroomen.

Met de AI-mogelijkheden van ClickUp geïntegreerd in uw taken, documenten en kennis, kunt u eenvoudig de volgende stappen weergeven op dezelfde plek waar het werk plaatsvindt (alles met bedrijfsniveau van veiligheid).

Probeer ClickUp gratis uit en ontdek hoe het eruit ziet wanneer AI en uitvoering eindelijk samengaan. ✨

Veelgestelde vragen over offline AI-tools

Ja, na het downloaden van de modelbestanden kunnen veel AI-tools volledig op uw apparaat worden uitgevoerd zonder dat er internet nodig is. Dit maakt ze perfect voor het verwerken van gevoelige gegevens of voor gebruik op locaties met een slechte internetverbinding.

Lokale LLM's verwerken alle gegevens op uw persoonlijke apparaat, zodat uw informatie nooit uw machine verlaat, terwijl cloudgebaseerde AI uw prompts naar externe servers stuurt voor verwerking. Lokale tools zijn over het algemeen gratis te gebruiken na installatie, terwijl cloud-AI vaak abonnementskosten met zich meebrengt, maar mogelijk krachtigere modellen biedt.

Kleinere modellen met 1-3 miljard parameters kunnen op de meeste moderne laptops met 8 GB RAM worden uitgevoerd. Grotere, krachtigere modellen met 7 miljard of meer parameters presteren het beste met 16 GB of meer RAM en een speciale GPU, waarbij Apple Silicon Macs en NVIDIA GPU's een aanzienlijke prestatieverbetering bieden.

![De 10 beste AI-tools die offline werken in [jaar]](https://clickup.com/blog/wp-content/uploads/2026/01/image-1298.png)