„Zapach nowego oprogramowania” zwykle znika w momencie, gdy cykl pracy rozczarowuje. Zdarza się to nawet najlepszym z nas — w rzeczywistości dotyczy to prawie 60% zespołów, co jasno pokazuje, że tradycyjne oceny nie przynoszą oczekiwanych wyników.

Potrzebujesz sposobu, aby odpowiednio wcześnie wykrywać ryzyka i móc podjąć odpowiednie działania. W tym przewodniku omówimy, jak oceniać oprogramowanie za pomocą AI, aby wykrywać ryzyka operacyjne i przeszkody we wdrożeniu, zanim podejmiesz ostateczną decyzję. Przedstawimy Ci schemat weryfikacji narzędzi i wykrywania ukrytych ryzyk, a także wyjaśnimy, jak uporządkować ocenę w ClickUp. 🔍

Co oznacza ocena oprogramowania za pomocą AI?

Ocena oprogramowania za pomocą AI oznacza wykorzystanie AI jako warstwy badawczej i decyzyjnej podczas procesu zakupowego. Zamiast ręcznie przeglądać strony internetowe dostawców, recenzje, dokumentację i prezentacje, Twój zespół może wykorzystać AI do spójnego porównania opcji i wczesnego sprawdzenia twierdzeń dostawców.

Ma to znaczenie, gdy oceny obejmują wiele narzędzi i opinii. /AI konsoliduje te dane w jednym widoku i podkreśla luki lub niespójności, które łatwo przeoczyć podczas ręcznego przeglądu. Uściśla również konkretne pytania dotyczące AI i ogólnych możliwości oprogramowania, aby uzyskać bezpośrednią odpowiedź od dostawcy.

Różnica staje się bardziej wyraźna, gdy porównasz tradycyjną ocenę oprogramowania z podejściem wspomaganym przez AI.

Tradycyjna ocena oprogramowania a ocena wspomagana AI

Tradycyjne oceny oprogramowania często wymagają tworzenia listy kandydatów na podstawie rozproszonych stron dostawców i sprzecznych recenzji. W końcu wracasz do tych samych podstawowych pytań, ponownie weryfikując szczegóły, gdy próbujesz podjąć decyzję.

To dlatego 83% nabywców ostatecznie zmienia swoją pierwotną listę dostawców w trakcie procesu — jest to wyraźny znak, jak niestabilne mogą być wczesne decyzje, gdy informacje są fragmentaryczne. Można uniknąć tej ponownej pracy, wykorzystując AI do wstępnej syntezy informacji, co zapewni stosowanie tych samych rygorystycznych kryteriów w odniesieniu do każdego narzędzia od samego początku.

| Tradycyjna ocena | Ocena wspomagana AI |

|---|---|

| Porównanie funkcji w zakładkach i arkuszach kalkulacyjnych | Tworzenie porównań obok siebie na podstawie jednej podpowiedzi |

| Indywidualne czytanie recenzji | Podsumowanie nastrojów i powtarzających się tematów we wszystkich źródłach |

| Ręczne sporządzanie pytań do zapytania ofertowego | Tworzenie kwestionariuszy dla dostawców w oparciu o określone kryteria |

| Czekanie na telefony od sprzedawców w celu wyjaśnienia podstawowych kwestii | Bezpośrednie zapytania o informacje w dokumentacji publicznej i bazach wiedzy |

Mając na uwadze tę różnicę, łatwiej jest dostrzec, w którym momencie cyklu oceny AI ma największe znaczenie.

Gdzie AI wpisuje się w cykl oceny

AI jest najbardziej przydatna podczas odkrywania, porównywania i walidacji, gdy dane wejściowe są obszerne i łatwe do błędnej interpretacji. Jest najbardziej przydatna podczas odkrywania i porównywania, gdy przeglądasz duże ilości danych i próbujesz sprawdzić swoje wstępne założenia.

Początkowo AI pomaga wyjaśnić problemy i kryteria oceny. Później przejmuje rolę stratega, konsolidując wyniki i przekazując decyzje interesariuszom.

Sztuczna inteligencja najlepiej sprawdza się jako pierwsza warstwa syntezy. Ostateczne decyzje nadal wymagają weryfikacji kluczowych informacji zawartych w dokumentacji, umowach i wersjach próbnych.

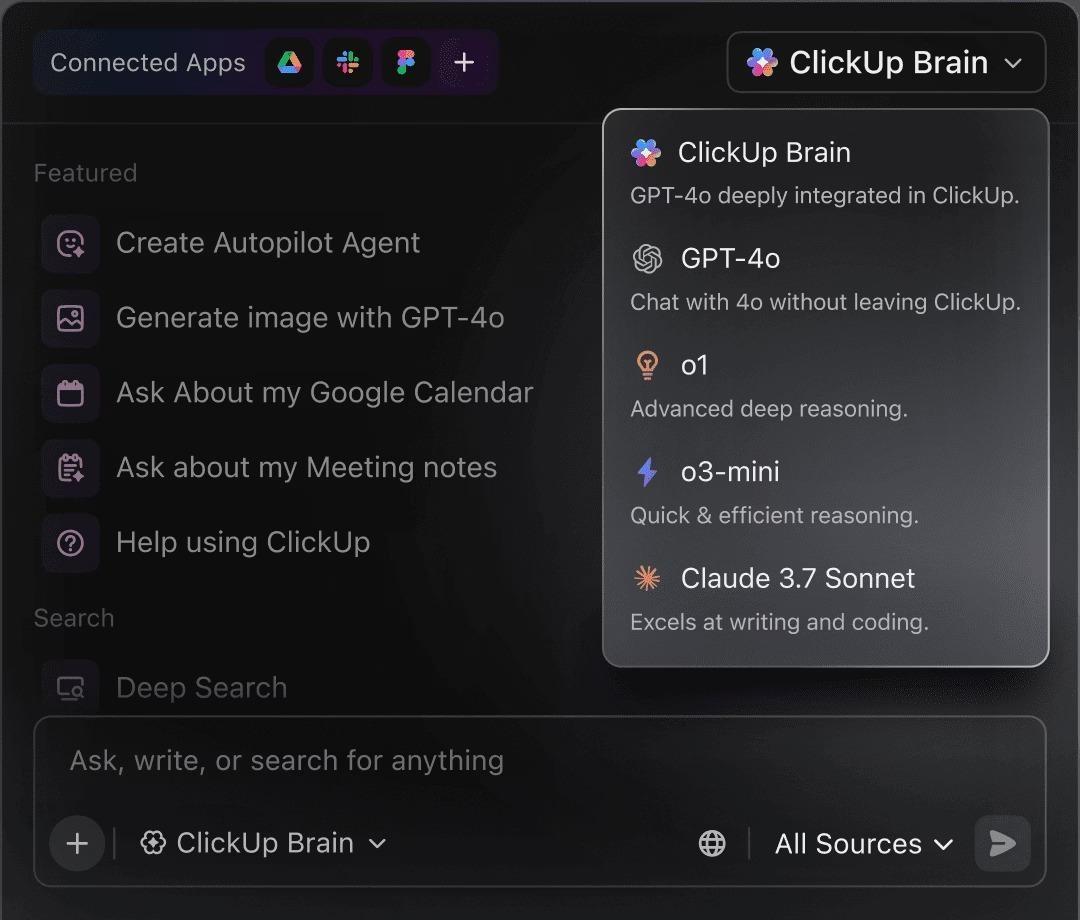

📮 ClickUp Insight: 88% respondentów naszej ankiety korzysta z AI do zadań osobistych, ale ponad 50% unika jej używania w pracy. Trzy główne przeszkody? Brak płynnej integracji, braki w wiedzy lub obawy dotyczące bezpieczeństwa. A co, jeśli sztuczna inteligencja jest wbudowana w Twój obszar roboczy ClickUp i jest już bezpieczna? ClickUp Brain, wbudowany asystent AI ClickUp, sprawia, że staje się to rzeczywistością. Rozumie podpowiedzi w prostym języku, rozwiązując wszystkie trzy problemy związane z wdrażaniem sztucznej inteligencji, jednocześnie łącząc czat, zadania, dokumenty i wiedzę w całym obszarze roboczym ClickUp. Znajdź odpowiedzi i spostrzeżenia za pomocą jednego kliknięcia!

Dlaczego warto używać AI do oceny oprogramowania

AI ogranicza nakład pracy badawczej i zapewnia spójną perspektywę dla wszystkich narzędzi, ułatwiając porównywanie i uzasadnianie ocen. Jej wpływ przejawia się w kilku praktycznych aspektach:

- Szybkość: skróć czas ręcznego wyszukiwania informacji, które zajmuje dni lub tygodnie, dzięki równoległemu wysyłaniu zapytań do wielu źródeł.

- Zakres: Odkryj mniej znane narzędzia i wczesne sygnały ostrzegawcze, które łatwo przeoczyć podczas ręcznej weryfikacji.

- Spójność: Oceniaj każdą opcję według tych samych kryteriów, zamiast zmieniać standardy w trakcie procesu.

- Dokumentacja: Twórz przejrzyste podsumowania i zestawienia porównawcze, które interesariusze mogą przeglądać i kwestionować.

🔍 Czy wiesz, że... Oczekuje się, że przejście z chatbotów na agentów AI (systemy, które mogą planować i wykonywać wieloetapowe zadania) zwiększy wydajność zakupów i oprogramowania o 25% do 40%.

🔍 Czy wiesz, że... Oczekuje się, że przejście z chatbotów na agentów AI (systemy, które mogą planować i wykonywać wieloetapowe zadania) zwiększy wydajność zakupów i oprogramowania o 25% do 40%.

Dlaczego ocena oprogramowania AI wymaga nowych pytań

Podczas weryfikacji narzędzi opartych na sztucznej inteligencji tradycyjne funkcje i listy kontrolne zgodności pokazują tylko połowę obrazu. Standardowe kryteria zazwyczaj koncentrują się na tym, co narzędzie robi, ale sztuczna inteligencja wprowadza zmienność i ryzyko, których starsze struktury nie są w stanie uchwycić.

Zmienia to pytania, które musisz potraktować priorytetowo:

- Nieprzejrzystość modelu: Zrozum, w jaki sposób generowane są wyniki, gdy widoczność procesu wnioskowania jest ograniczona.

- Przetwarzanie danych: wyjaśnij, w jaki sposób dane firmy są przechowywane, ponownie wykorzystywane lub wykorzystywane do celów szkoleniowych.

- Zmienność wyników: Sprawdź spójność, gdy ta sama podpowiedź daje różne wyniki.

- Szybka iteracja: uwzględnij zmiany zachowania między wersjami demonstracyjnymi, wersjami próbnymi i produkcyjnymi.

- Głębokość integracji: upewnij się, że funkcje AI zapewniają wsparcie dla rzeczywistych cykli pracy, a nie są tylko odizolowanymi funkcjami.

Mówiąc prościej, ocena oprogramowania AI opiera się w mniejszym stopniu na sprawdzaniu powierzchniowym, a w większym na pytaniach dotyczących zachowania, kontroli i długoterminowej zgodności.

13 pytań, które należy zadać podczas oceny oprogramowania AI

Wykorzystaj te pytania jako wspólny kwestionariusz dla dostawców AI, aby móc porównać odpowiedzi bezpośrednio, a nie dopiero po wdrożeniu.

| Pytania, które należy zadać | Jak brzmi mocna odpowiedź |

|---|---|

| 1) Jakie dane przetwarza AI i gdzie się znajdują? | „Oto dane, do których mamy dostęp, miejsce ich przechowywania (opcje regionalne), sposób ich szyfrowania oraz okres przechowywania”. |

| 2) Czy którekolwiek z naszych danych są wykorzystywane do szkolenia, obecnie lub w przyszłości? | „Domyślnie nie. Szkolenie jest opcjonalne, co znajduje odzwierciedlenie w umowie/umowie o przetwarzaniu danych”. |

| 3) Kto z dostawcy ma dostęp do naszych danych? | „Dostęp jest oparty na rolach, kontrolowany i ograniczony do określonych funkcji. Oto, w jaki sposób rejestrujemy i sprawdzamy dostęp”. |

| 4) Jakie modele obsługują tę funkcję i czy wersje zmieniają się w sposób niezauważalny? | „Oto modele, których używamy, sposób ich wersjonowania oraz sposób powiadamiania użytkowników o zmianach w zachowaniu”. |

| 5) Co się dzieje, gdy AI nie ma pewności? | „Wykrywamy sygnały budzące zaufanie, prosimy o wyjaśnienia lub bezpiecznie wycofujemy się, zamiast zgadywać”. |

| 6) Jeśli uruchomimy tę samą podpowiedź dwukrotnie, czy powinniśmy spodziewać się takiego samego wyniku? | „Oto, czym jest deterministyczność w przeciwieństwie do zmienności i jak skonfigurować spójność, gdy ma to znaczenie”. |

| 7) Jakie są rzeczywiste limity kontekstowe? | „Są to praktyczne limity (rozmiar dokumentu/głębia historii). Oto, co robimy, gdy kontekst ulega skróceniu”. |

| 8) Czy możemy sprawdzić, dlaczego AI wydała daną rekomendację lub podjęła dane działanie? | „Możesz sprawdzić dane wejściowe, wyjściowe i ślad tego, dlaczego polecono X. Działania mają ścieżkę audytu”. |

| 9) Jakie zatwierdzenia są wymagane przed podjęciem działania? | „Działania wysokiego ryzyka wymagają przeglądu, zatwierdzenia mogą być oparte na rolach, a także istnieje ścieżka eskalacji”. |

| 10) W jakim stopniu można to dostosować do różnych zespołów i ról? | „Możesz ujednolicić podpowiedzi/szablony, ograniczyć dostęp do ich zmiany i dostosować wyniki do poszczególnych ról”. |

| 11) Czy integruje się z rzeczywistymi cyklami pracy, czy tylko „połącza się”? | „Oferujemy wsparcie dla dwukierunkowej synchronizacji i rzeczywistych wyzwalaczy/akcji. Oto sposób obsługi błędów i monitorowania ich”. |

| 12) Jeśli obniżymy wersję lub anulujemy subskrypcję, co przestanie działać i co będziemy mogli wyeksportować? | „Oto dokładnie, co zachowujesz, co możesz eksportować i w jaki sposób usuwamy dane na żądanie”. |

| 13) Jak monitorować jakość w czasie? | „Śledzimy odchylenia i incydenty, przeprowadzamy oceny, publikujemy informacje o nowych wersjach i mamy jasny proces eskalacji i wsparcia”. |

💡 Wskazówka dla profesjonalistów: Rozważ scentralizowanie odpowiedzi na te pytania we wspólnym kwestionariuszu dostawców AI, aby dostrzec wzorce i kompromisy. Twój zespół może ponownie wykorzystać je podczas kolejnych ocen, zamiast za każdym razem zaczynać od nowa, co usprawni zarządzanie cyklem pracy.

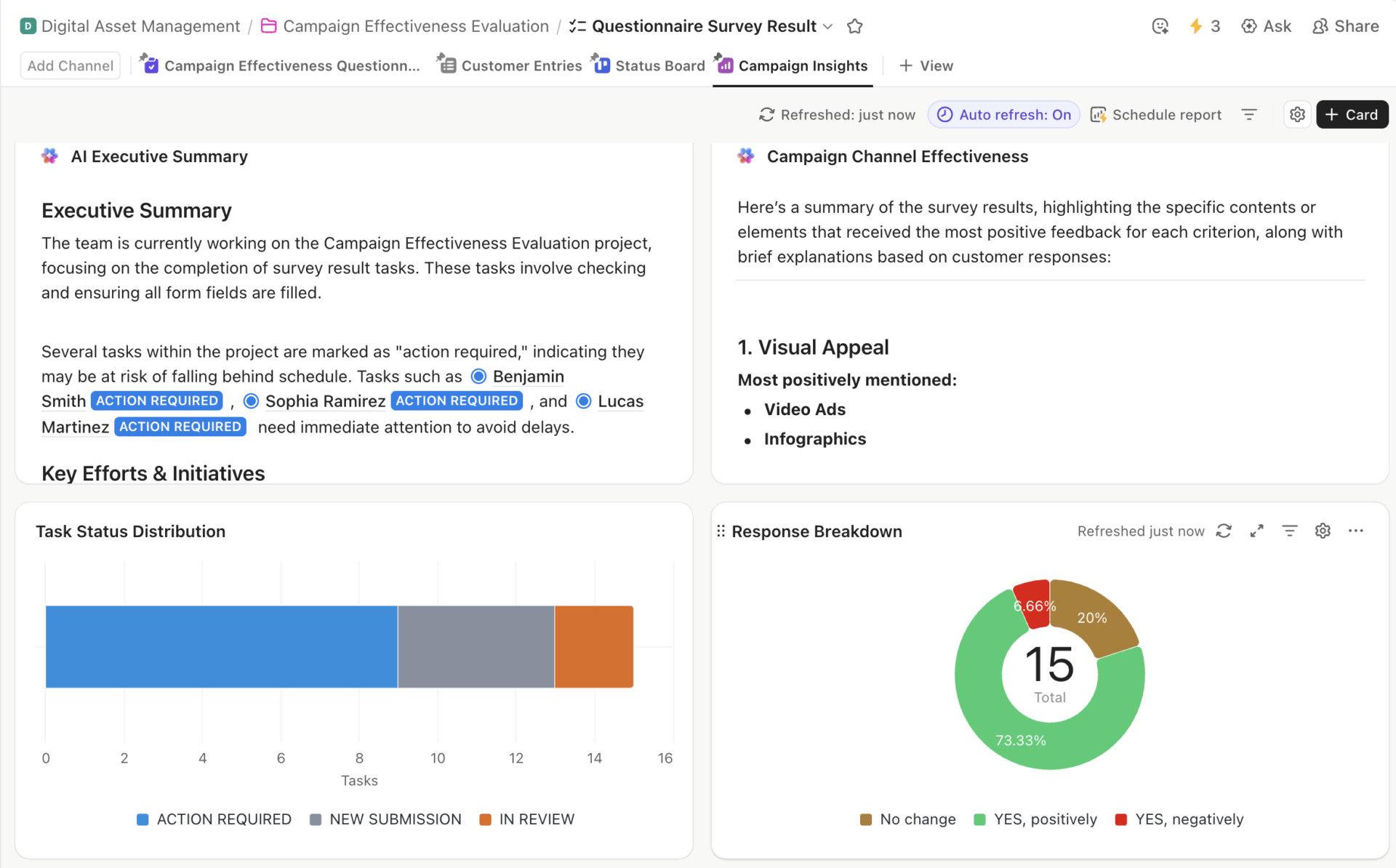

Szablon kwestionariusza ClickUp zawierający podsumowanie AI, dystrybucję zadań, skuteczność kanałów i zestawienie odpowiedzi.

Możesz skorzystać z szablonu kwestionariusza ClickUp, aby zapewnić zespołowi jedno, uporządkowane miejsce do gromadzenia odpowiedzi dostawców i porównywania narzędzi. Pozwala on również dostosować pola i przypisać właścicieli, dzięki czemu można ponownie wykorzystać tę samą strukturę przy przyszłych zakupach bez konieczności odbudowywania procesu od podstaw.

Krok po kroku: jak oceniać oprogramowanie z wykorzystaniem AI

Poniższe etapy pokazują, w jaki sposób Twój zespół może wykorzystać AI do ustrukturyzowania oceny oprogramowania, dzięki czemu decyzje będą łatwe do prześledzenia i sprawdzenia w późniejszym czasie.

Etap 1: Określenie potrzeb w zakresie oprogramowania za pomocą AI (świadomość problemu)

Większość ocen kończy się niepowodzeniem, zanim jeszcze obejrzysz prezentację. Jest to częsta pułapka: od razu przechodzisz do porównań, nie uzgadniając najpierw, jaki problem faktycznie próbujesz rozwiązać. AI jest tutaj najbardziej przydatna, ponieważ wymusza jasność na wczesnym etapie.

Wyobraź sobie na przykład, że jesteś w agencji marketingowej i szukasz narzędzia do zarządzania projektami, mając niejasny cel, taki jak lepsza współpraca. AI pomaga zawęzić ten cel, udzielając podpowiedzi na temat cyklu pracy, wielkości zespołu i istniejących zasobów technologicznych, skutecznie przekształcając luźne pomysły w konkretne wymagania.

Spróbuj wykorzystać AI, aby zgłębić takie pytania, jak:

- Z jakimi konkretnymi trudnościami boryka się obecnie mój zespół?

- Które funkcje są „niezbędne”, a które „mile widziane” w naszej branży?

- Jakich narzędzi zazwyczaj używają zespoły naszej wielkości?

- Jaki zakres budżetu jest realistyczny dla tych wymagań?

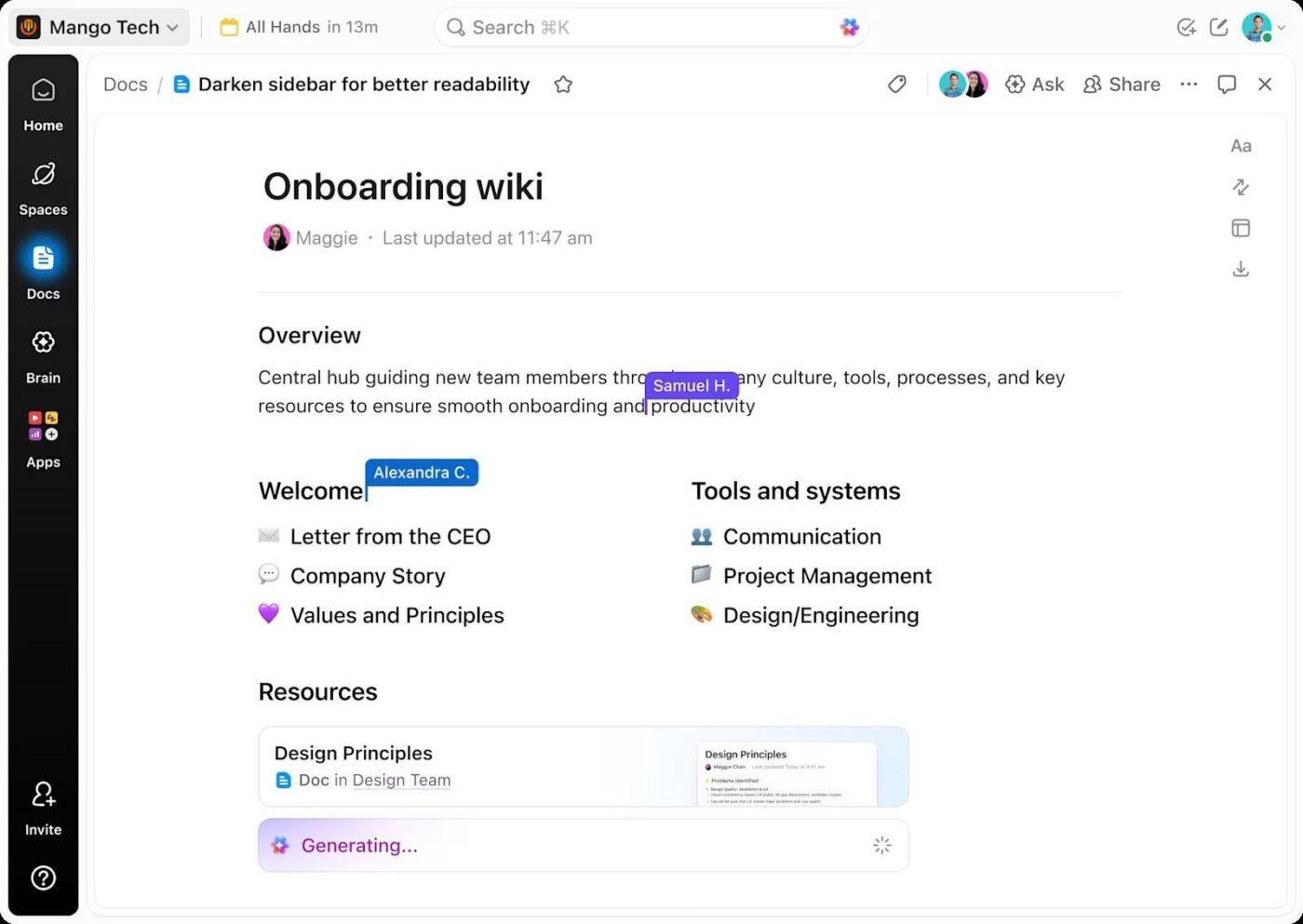

W miarę jak odpowiedzi nabierają kształtu, mniej prawdopodobne jest, że będziesz poszukiwać imponujących funkcji, które nie odpowiadają rzeczywistym potrzebom. Wszystko to możesz zapisać w ClickUp Docs, gdzie wymagania są przechowywane jako wspólne odniesienie, a nie jednorazowa lista kontrolna.

W miarę pojawiania się nowych informacji dokument ewoluuje:

- Obawy interesariuszy stają się wyraźnymi ograniczeniami

- Nowo zidentyfikowane kategorie oprogramowania są rejestrowane przed rozpoczęciem porównań.

Ponieważ dokumenty znajdują się w tym samym obszarze roboczym co zadania związane z oceną, kontekst nie ulega zmianie. Przechodząc do fazy badań lub demonstracji, możesz bezpośrednio połączyć swoje działania z już zweryfikowanymi wymaganiami.

📌 Rezultat: Proces oceny jest jasno zdefiniowany, dzięki czemu kolejny krok jest znacznie bardziej ukierunkowany.

Etap 2: Odkrywanie opcji oprogramowania z wykorzystaniem AI (świadomość rozwiązań)

Po ustaleniu wymagań problem się zmienia. Pytanie przestaje skupiać się na tym, czego potrzebujemy, a zaczyna na tym, co realistycznie pasuje. Ocena również zwalnia tempo, rozszerzając zakres poszukiwań i zacierając granice między opcjami.

AI ogranicza ten chaos, przypisując opcje bezpośrednio do kryteriów, takich jak branża, wielkość zespołu, zakres budżetu i podstawowe cykle pracy, zanim przejdzie do głębszej analizy.

Na tym etapie Twoje podpowiedzi mogą wyglądać następująco:

- Jakie narzędzia programowe spełniają te wymagania?

- Jakie są wiarygodne alternatywy dla [nazwa narzędzia] dla zespołu naszej wielkości?

- Które narzędzia są odpowiednie dla agencji, a które dla zespołów Enterprise?

- Które opcje mogą zapewnić wsparcie dla rozwoju bez konieczności wprowadzania większych zmian?

Aby zachować porządek, możesz śledzić każdego kandydata jako osobny element w zadaniach ClickUp. Każde narzędzie otrzymuje jedno zadanie z właścicielem, linkami do badań, notatkami z wyników AI i jasnymi kolejnymi krokami. W miarę jak opcje są rozwijane lub odrzucane, lista jest aktualizowana w jednym miejscu, bez konieczności śledzenia kontekstu w różnych rozmowach.

📌 Wynik: W rezultacie otrzymujesz zawężoną listę potencjalnych opcji, z których każda ma własność i historię, gotową do znacznie głębszego porównania.

Etap 3: Porównanie funkcji i cen za pomocą AI (etap rozważania)

Krótkie listy powodują nowy problem: zmęczenie porównywaniem. Funkcje nie są jasno dopasowane, poziomy cenowe zaciemniają ograniczenia, a kategorie dostawców nie są dostosowane do sposobu pracy zespołów.

Możesz użyć AI, żeby wyrównać różnice między narzędziami, dopasowując funkcje do ich wymagań, podsumowując poziomy cenowe prostym językiem i pokazując ograniczenia, które pojawiają się tylko na dużą skalę. Pokazuje to takie problemy, jak ograniczone automatyzacje czy ceny dodatków, co pozwala zaoszczędzić czas.

W tym momencie warto zadać sobie pytanie:

- Jakie funkcje są dostępne w poszczególnych przedziałach cenowych?

- Gdzie występują limity w planach bezpłatnych lub podstawowych?

- Które funkcje wiążą się z dodatkowymi kosztami lub mają słabą skalowalność?

- W jakich obszarach narzędzia się pokrywają, a w jakich różnią się między sobą w znaczący sposób?

Gdy te dane będą już dostępne, stwórz tabele porównawcze w ClickUp Documents, oparte na pierwotnych wymaganiach, a nie na kategoriach marketingowych dostawców.

Korzystając z ClickUp Brain, możesz generować zwięzłe podsumowania zalet i wad bezpośrednio na podstawie porównania. Dzięki temu interpretacja pozostaje oparta na materiałach źródłowych, co zapobiega rozbieżnościom w oddzielnych notatkach lub rozmowach.

📌 Wynik: Twoje decyzje są zawężone w oparciu o udokumentowane kompromisy, a nie przeczucia. Łatwiej jest wskazać, dlaczego jedna opcja jest lepsza, a druga nie, dzięki zachowaniu uzasadnienia wraz z samym porównaniem.

Etap 4: Ocena integracji i dopasowania cyklu pracy do AI

Dwa narzędzia mogą wydawać się podobne na papierze, ale zachowywać się zupełnie inaczej w istniejącym środowisku. Dlatego tak ważne jest ustalenie, czy nowe narzędzie upraszcza pracę, czy też stanowi dodatkowe obciążenie.

Sztuczna inteligencja dopasowuje każde narzędzie z listy do Twoich obecnych ustawień. Oprócz pytania o to, jakie integracje są dostępne, możesz sprawdzić, jak faktycznie przebiega przepływ pracy. Na przykład, co się dzieje, gdy potencjalny klient pojawia się w Twoim CRM lub gdy otrzymujesz zgłoszenie do wsparcia technicznego?

Pytania na tym etapie brzmią następująco:

- Co się psuje, gdy to narzędzie współdziała z naszymi istniejącymi systemami?

- Które operacje wymagają interwencji człowieka?

- Gdzie automatyzacja zawodzi w sposób niezauważalny lub synchronizuje dane tylko w jedną stronę?

- Czy to narzędzie ogranicza koordynację, czy też ją rozdziela?

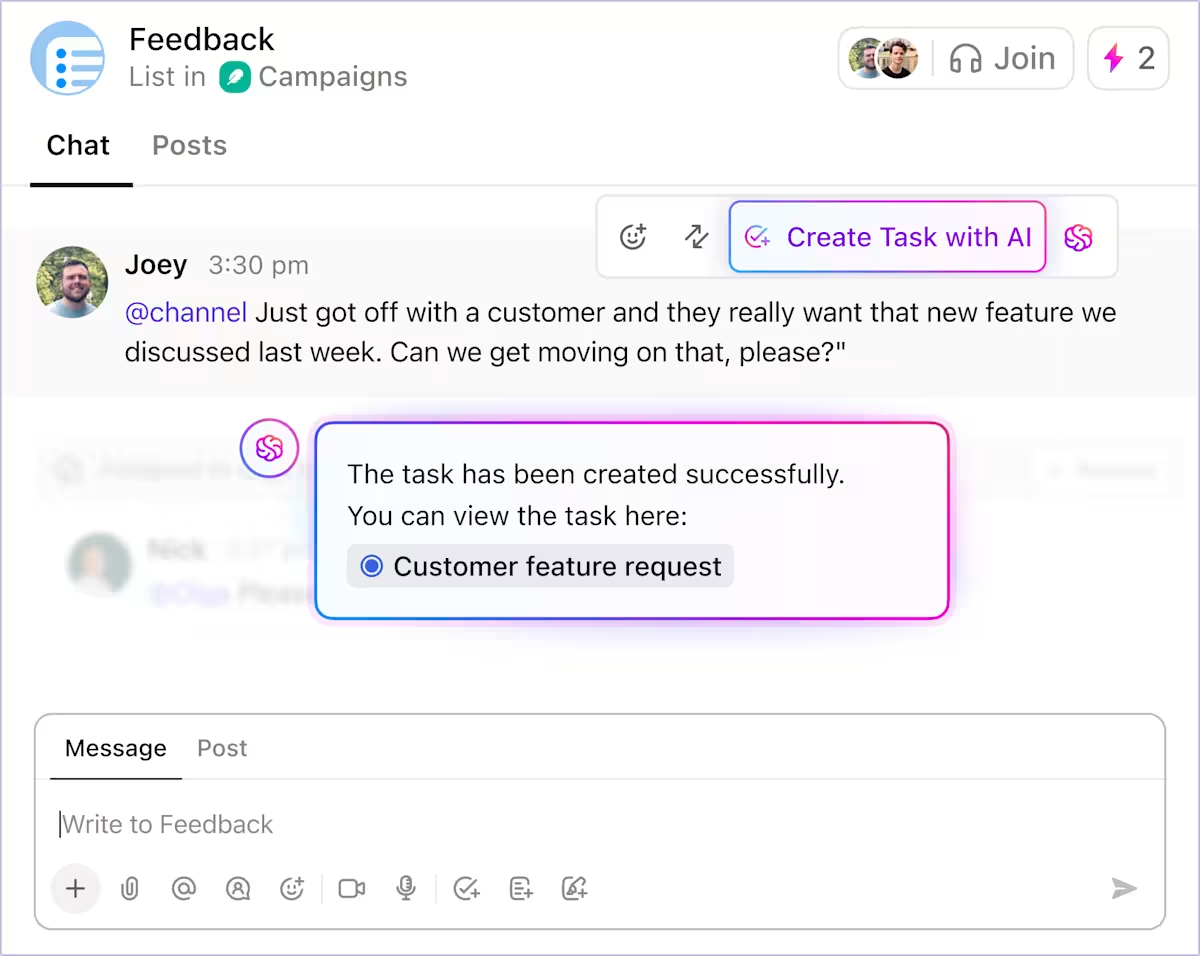

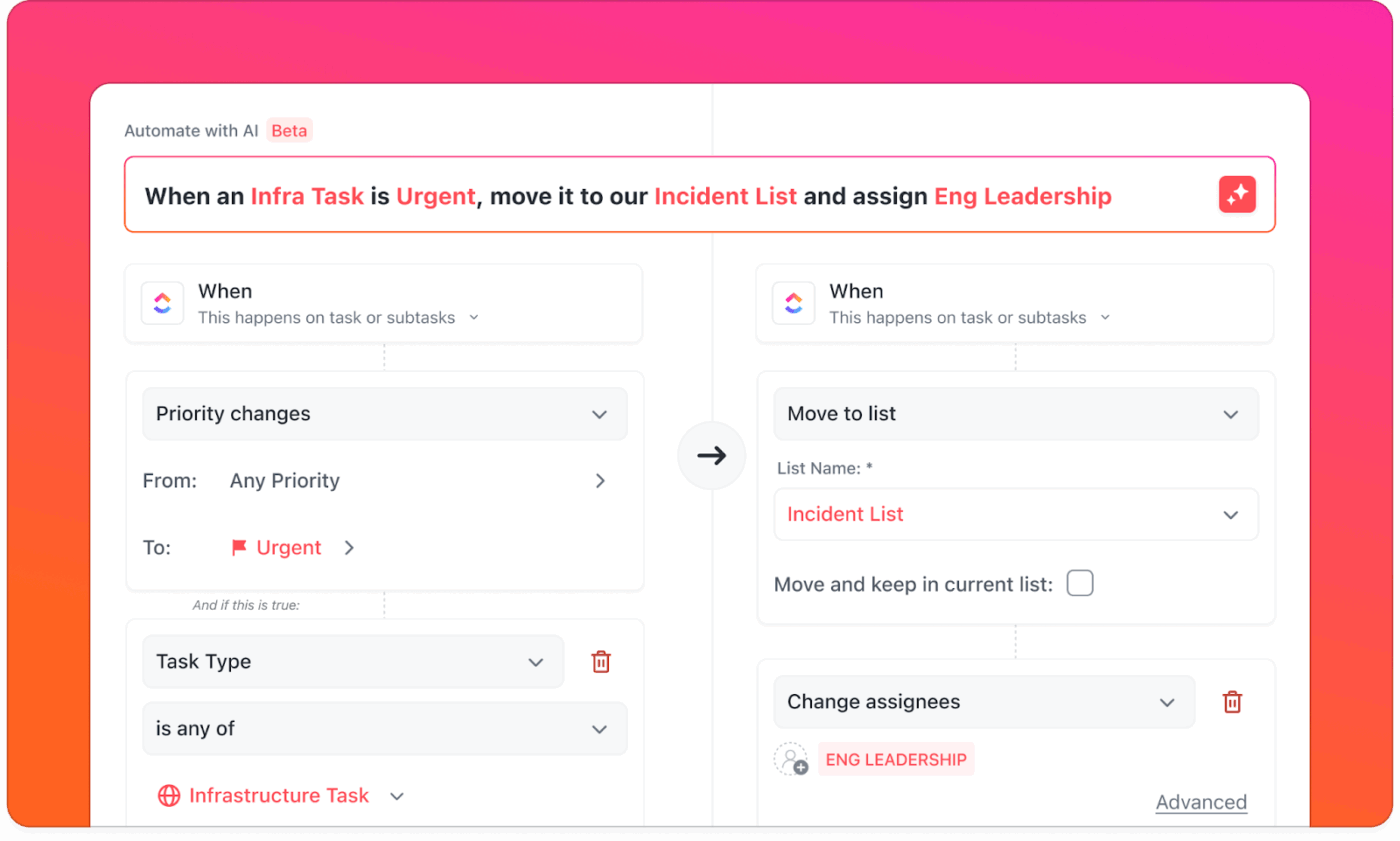

Podkreśla takie problemy, jak brakujące wyzwalacze lub integracje, które wydają się zakończone, ale nadal powodują awarie. ClickUp jest w tym przypadku dobrym wyborem, ponieważ integracje i automatyzacja działają w ramach tego samego systemu.

ClickUp Integrations łączy ponad 1000 narzędzi, w tym Slack, HubSpot i GitHub, aby zwiększyć widoczność. Oferuje również wsparcie dla tworzenia zadań, aktualizowania statusów, kierowania pracą i uruchamiania działań następczych w obszarze roboczym, w którym już odbywa się realizacja.

Korzystając z automatyzacji ClickUp, możesz sprawdzić, czy rutynowe przejścia przebiegają konsekwentnie bez nadzoru. Pozwalają one pominąć łączenie zewnętrznych narzędzi i zdefiniować zachowanie raz, umożliwiając jego zastosowanie w przestrzeniach, listach i cyklach pracy.

📌 Wynik: Pod koniec tego etapu różnica staje się bardziej wyraźna.

- Niektóre narzędzia mają szerokie możliwości połączeń, ale nadal wymagają koordynacji pracy przez ludzi.

- Inni włączają tę koordynację do samego cyklu pracy.

To zrozumienie ma zazwyczaj większe znaczenie niż równoważność funkcji przy podejmowaniu ostatecznej decyzji.

Etap 5: Sprawdzanie rzeczywistego zastosowania za pomocą AI (etap podejmowania decyzji)

Obecnie decyzja rzadko zależy od brakujących funkcji lub niejasnych cen. Trudniej jest odpowiedzieć na pytanie, czy narzędzie będzie nadal działać, gdy minie efekt nowości i rozpocznie się rzeczywiste użytkowanie.

Sztuczna inteligencja staje się tutaj przydatna jako narzędzie do wyszukiwania wzorców, a nie jako narzędzie badawcze. AI może podsumować powtarzające się tematy we wszystkich dostarczonych przez Ciebie źródłach recenzji (G2, dokumentacja, fora), a następnie pomóc Ci sprawdzić, czy problemy grupują się według wielkości zespołu lub przypadku użycia.

Typowe pytania na tym etapie obejmują:

- Jakie problemy zgłaszają użytkownicy po pierwszych kilku miesiącach?

- Które cykle pracy mają trudności wraz ze wzrostem wykorzystania?

- Jakie tematy powtarzają się na stronach z recenzjami, takich jak G2 i Reddit?

- Jakie zespoły żałują wyboru tego narzędzia?

AI potrafi odróżnić trudności związane z wdrażaniem od limitów strukturalnych lub wykazać, czy skargi dotyczą określonych wielkości zespołów, branż lub przypadków użycia. Kontekst ten pomaga zdecydować, czy problem jest możliwym do zaakceptowania kompromisem, czy też fundamentalną niezgodnością.

W miarę gromadzenia się informacji możesz zapewnić widoczność danych w panelach ClickUp Dashboards — podczas śledzenia ryzyka, otwartych pytań, obaw związanych z wdrożeniem i wzorców recenzentów w jednym miejscu. Twoi interesariusze mogą zobaczyć te same sygnały: powtarzające się skargi, ryzyko związane z wdrożeniem, zależności i nierozwiązane luki.

📌 Wynik: Ten etap zapewnia jasność co do tego, gdzie mogą pojawić się tarcia, kto odczuje je jako pierwszy i czy Twoja organizacja jest przygotowana, aby je zaabsorbować.

Etap 6: Ostateczna decyzja i zakup z wykorzystaniem AI

Na tym etapie ocena jest już w dużej mierze zrobiona, ale nawet jeśli właściwa opcja jest oczywista, decyzje mogą pozostać w zawieszeniu, jeśli zespół nie jest w stanie pokazać, jak wdrożenie będzie wyglądało w praktyce.

Możesz wykorzystać AI do skonsolidowania wszystkiego, czego nauczyłeś się do tej pory, w postaci gotowych do podjęcia decyzji wyników. Obejmują one streszczenia wykonawcze porównujące ostateczne opcje, jasne oświadczenia dotyczące zaakceptowanych kompromisów oraz plany wdrożeniowe przewidujące ewentualne tarcia.

Możesz oczekiwać, że AI odpowie na takie pytania, jak:

- Która opcja najlepiej pasuje do naszych celów i budżetu, biorąc pod uwagę wszystko, czego się dowiedzieliśmy?

- Jakie kompromisy świadomie akceptujemy?

- Jak wygląda realistyczne wdrożenie w ciągu pierwszych 30, 60 lub 90 dni?

- Jak wyjaśnić tę decyzję kierownictwu w sposób, który wytrzyma krytyczną ocenę?

Ponieważ ClickUp Brain ma dostęp do pełnego kontekstu oceny — dokumentów, porównań, zadań, opinii i ryzyka — może generować podsumowania i listy kontrolne wdrożenia, eliminując potrzebę stosowania ogólnych szablonów oceny. Można go używać do tworzenia notatek dla kierownictwa, planów wdrożeniowych i uzgadniania wskaźników powodzenia z właścicielami bez konieczności eksportowania kontekstu do oddzielnych narzędzi.

📌 Rezultat: Po udostępnianiu tych materiałów rozmowa nabiera innego charakteru. Zainteresowane strony analizują te same dowody, założenia i ryzyka w jednym miejscu. Pytania stają się bardziej skierowane na cele, a poparcie pojawia się w sposób bardziej naturalny.

Co należy przetestować w wersji próbnej, aby nie dać się zwieść prezentacjom

Podczas wersji próbnej sprawdzaj cykle pracy, a nie funkcje:

- Przeprowadź jeden rzeczywisty cykl pracy od początku do końca (przyjęcie → przekazanie → zatwierdzenie → raportowanie).

- Przetestuj uprawnienia przy użyciu rzeczywistych ról (administrator, menedżer, współpracownik, gość).

- Zmierz czas ustawień i punkty awarii (miejsca, w których użytkownicy napotykają trudności).

- Wymuś wyjątki (przerwanie przekazania, brakujące pole, opóźnione zatwierdzenie)

- Zadaj pytanie: Co się psuje, gdy zwiększasz liczbę użytkowników, projektów lub automatyzacji?

Typowe błędy popełniane podczas oceny oprogramowania z wykorzystaniem AI

AI może usprawnić ocenę oprogramowania, ale tylko wtedy, gdy jest stosowana w sposób zdyscyplinowany. Unikaj następujących błędów:

- Brak weryfikacji wyników AI: AI może błędnie interpretować funkcje, ceny lub limity, dlatego weryfikacja ma kluczowe znaczenie.

- Pomijanie etapu określania wymagań: Porównanie narzędzi bez jasno określonych potrzeb prowadzi do poszukiwania funkcji zamiast rozwiązywania problemów.

- Ignorowanie głębokości integracji: deklarowane integracje mogą jedynie synchronizować dane, a nie zapewnić wsparcie dla bieżącego zarządzania cyklem pracy.

- Zaniedbywanie kwestii prywatności danych: Niejasne zasady dostępu do danych, ich przechowywania lub ponownego wykorzystywania stwarzają ryzyko związane z przestrzeganiem przepisów.

- Izolowana ocena: Wczesne wykluczenie użytkowników końcowych często prowadzi do późniejszych problemów z wdrożeniem.

- Mylenie funkcji AI z możliwościami AI: Dodatkowy chatbot nie oferuje takiej samej wartości jak AI wbudowana w podstawowe cykle pracy.

Najlepsze praktyki w zakresie oceny oprogramowania opartego na AI

Ocena oprogramowania oparta na AI działa najlepiej, gdy stosuje się ją systematycznie przy podejmowaniu decyzji, korzystając z poniższych praktyk:

Te najlepsze praktyki są łatwe do wdrożenia, jeśli dysponujesz centralną platformą, taką jak ClickUp, która pozwala nimi zarządzać.

- Zadawaj coraz bardziej szczegółowe pytania: zacznij od zdefiniowania problemu, a następnie zawężaj pytania w miarę jak wymagania, ograniczenia i kompromisy stają się coraz bardziej jasne.

- Porównaj wyniki AI z rzeczywistymi danymi: sprawdź funkcje, ceny i limity w dokumentacji dostawcy i wiarygodnych źródłach recenzji.

- Scentralizuj notatki, decyzje i zatwierdzenia: przechowuj wymagania, ustalenia, ryzyka i zatwierdzenia w jednym wspólnym obszarze roboczym, aby uniknąć fragmentacji kontekstu.

- Oceniaj narzędzia na podstawie cyklu pracy: skup się na tym, jak przebiega praca od początku do końca, zamiast porównywać pojedyncze funkcje.

Wykorzystaj ClickUp do operacjonalizacji decyzji dotyczących oprogramowania

Ocena oprogramowania nie kończy się niepowodzeniem z powodu braku informacji. Kończy się niepowodzeniem, ponieważ decyzje są rozproszone między narzędziami, rozmowami i dokumentami, które nie są przystosowane do współpracy.

ClickUp przenosi ocenę do jednego obszaru roboczego, w którym wymagania, badania, porównania i zatwierdzenia pozostają ze sobą połączone. Możesz dokumentować potrzeby w ClickUp Docs, śledzić dostawców jako zadania, podsumowywać wyniki w ClickUp Brain i zapewnić kierownictwu widoczność w czasie rzeczywistym za pomocą pulpitów nawigacyjnych bez tworzenia rozbudowanego systemu SaaS.

Ponieważ ocena towarzyszy realizacji, uzasadnienie jej wyników pozostaje widoczne i możliwe do zweryfikowania, nawet gdy zespół ulega zmianom lub narzędzia wymagają ponownej oceny. To, co zaczyna się jako proces zakupowy, staje się częścią sposobu podejmowania decyzji w organizacji.

Jeśli Twój zespół już korzysta z AI do oceny oprogramowania, ClickUp pomaga przekształcić tę wiedzę w działanie bez konieczności dodawania kolejnego systemu do zarządzania.

Rozpocznij korzystanie z ClickUp za darmo i scentralizuj swoje decyzje dotyczące oprogramowania. ✨

Często zadawane pytania

Tak, gdy dokładność oznacza wykrywanie wzorców, niespójności i brakujących informacji w wielu źródłach, AI może pomóc w ocenie oprogramowania. Może ona porównywać funkcje, podsumowywać recenzje i testować twierdzenia dostawców na dużą skalę, co sprawia, że ocena na wczesnym i średnim etapie jest bardziej wiarygodna.

Niejasne podpowiedzi lub nieprawidłowe wyniki mogą powodować powstawanie błędów. Należy stosować jasno określone wymagania, zadawać pytania porównawcze i weryfikować twierdzenia w oparciu o podstawowe źródła, takie jak dokumentacja i wersje próbne.

Nie, AI może zawęzić opcje i przygotować bardziej precyzyjne pytania do prezentacji, ale nie jest w stanie odtworzyć praktycznego zastosowania. Prezentacje i wersje próbne są nadal niezbędne do przetestowania cyklu pracy, użyteczności i przyjęcia przez zespół w rzeczywistych warunkach.

Skuteczne zespoły dokumentują decyzje dotyczące oprogramowania, centralizując wymagania, porównania i ostateczne uzasadnienia w jednym wspólnym obszarze roboczym. Pozwala to zachować kontekst i zapobiega powtarzającym się dyskusjom podczas ponownego przeglądania narzędzi w późniejszym terminie.

Oceniając odpowiedzi oprogramowania AI, zwracaj uwagę na niejasne twierdzenia, niespójne wyjaśnienia i brakujące szczegóły dotyczące przetwarzania danych lub zachowania modelu.