Zoekmachines zijn altijd essentieel geweest voor het vinden van informatie, maar het gedrag van gebruikers is veranderd. In plaats van eenvoudige zoekopdrachten op trefwoorden zoals 'smartphones', stellen mensen nu meer specifieke, gepersonaliseerde query's zoals 'beste budgettelefoons voor gaming'. '

Ondertussen transformeren grote taalmodellen (LLM's) zoals ChatGPT het zoeken door te fungeren als intelligente vraag-antwoordsystemen.

Ze integreren met traditionele zoekmachines en verbeteren het ophalen van informatie door middel van retrieval-augmented generation (RAG), waardoor resultaten nauwkeuriger en contextbewuster worden.

In plaats van met elkaar te concurreren, werken LLM's en zoekmachines samen om complexe query's effectiever af te handelen. In dit artikel onderzoeken we hoe deze integratie de toekomst van zoeken vorm geeft.

⏰ 60-seconden samenvatting

- Traditionele zoekmachines worstelen vaak met het beheer van grote datasets, het behoud van datakwaliteit en het afbreken van silo's

- Ze worden ook geconfronteerd met uitdagingen op het gebied van veiligheid, schaalbaarheid en het bieden van contextueel relevante resultaten

- Grote taalmodellen, zoals ChatGPT, verbeteren de zoeknauwkeurigheid, maken semantisch zoeken mogelijk en ondersteunen query's in natuurlijke taal

- LLM's verbeteren ook de multimodale zoekmogelijkheden en maken het vinden van kennis persoonlijker en efficiënter

- ClickUp's Connected Search en AI-mogelijkheden bouwen voort op deze vooruitgang door uw gegevens te centraliseren, waardoor informatie snel en nauwkeurig kan worden opgezocht

- ClickUp integreert naadloos met verschillende platforms, biedt real-time toegang tot uw content, stroomlijnt workflows en verbetert de algehele productiviteit

Zonder verder oponthoud, laten we beginnen!

Wat zijn LLM's?

Grote taalmodellen (LLM's) zijn geavanceerde kunstmatige intelligentiesystemen die menselijke taal verwerken en genereren. Ze worden getraind op uitgebreide tekstdatasets, waardoor ze taken als vertalen, samenvatten en gesprekken kunnen verwerken.

Enkele van de populairste voorbeelden van LLM's zijn GPT-3 en GPT-4, die alom bekend staan om hun vermogen om complexe taalgerelateerde query's te verwerken.

In tegenstelling tot traditionele zoekmachines die afhankelijk zijn van trefwoorden, gaat een op LLM gebaseerde zoekmachine verder dan query's op oppervlakteniveau. Het begrijpt de context en intentie achter vragen en geeft directe en gedetailleerde antwoorden.

👀 Did You Know? 71% van de gebruikers geeft de voorkeur aan personalisatie van de merken en bedrijven die ze kiezen.

Functies van LLM zoekmachines

LLM zoekmachines bieden geavanceerde mogelijkheden die de manier herdefiniëren waarop internetgebruikers toegang krijgen tot en interactie hebben met informatie. Laten we eens kijken naar hun sleutel functies:

- Inzicht in semantische query's: LLM zoekmachines interpreteren de betekenis achter zoekopdrachten en gaan verder dan zoekwoorden om de intentie en context van gebruikers te begrijpen

- Natuurlijke taalverwerking (NLP): Gebruikers kunnen query's conversatief formuleren zonder exacte trefwoorden, waardoor zoekopdrachten intuïtiever worden

- Contextuele relevantie: Zoekresultaten worden gepersonaliseerd op basis van eerdere query's en interacties, wat zorgt voor relevantere en actuelere informatie

- Het genereren van antwoorden: Deze systemen bieden uitgebreide antwoorden direct in de zoekresultaten, inclusief samenvattingen, uitleg en zelfs creatieve formats zoals verhalen of stap-voor-stap gidsen

- Integratie van kennisgrafieken: LLM zoekmachines gebruiken kennisgrafieken om gerelateerde concepten en entiteiten met elkaar te verbinden, waardoor diepere inzichten worden verkregen

- Conversationeel zoeken: Gebruikers kunnen deelnemen aan een dialoog heen en weer, vervolgvragen stellen en hun zoekopdrachten verfijnen voor een meer interactieve ervaring

- Adaptieve resultaten: Resultaten worden dynamisch aangepast op basis van locatie, rente en eerdere zoekopdrachten, voor een meer persoonlijke ervaring

- Informatiesynthese: In plaats van te vertrouwen op één enkele bron, aggregeren LLM zoekmachines gegevens uit meerdere bronnen, waardoor een breder perspectief ontstaat

👀 Wist u dat? Met het toenemende gebruik van slimme luidsprekers en spraakassistenten, is 50% van alle zoekopdrachten nu gebaseerd op spraak. Als er grote taalmodellen worden geïntegreerd in deze systemen, worden spraakopzoekingen nog nauwkeuriger en bieden ze snellere toegang tot informatie op meerdere platforms, of het nu gaat om bestanden, taken of aantekeningen van vergaderingen.

Geavanceerde zoektechnieken met LLM's

Naarmate de zoektechnologie zich ontwikkelt, veranderen LLM's zoals GPT-4, BERT en T5 de manier waarop zoekmachines query's verwerken, resultaten personaliseren en rankings verfijnen. Laten we eens onderzoeken hoe deze modellen de toekomst van zoeken opnieuw definiëren.

Hoe LLM's zoekopdrachten verzenden

Zoeken is geëvolueerd van eenvoudige query's op trefwoorden naar semantische vectorzoekopdrachten. In plaats van te zoeken naar een specifieke term zoals 'Mount Fuji', kunnen gebruikers zoeken naar 'bergen in Japan', waarna het systeem op betekenis gebaseerde resultaten oplevert.

Het herformuleren van query's in vragen, zoals "Wat zijn de beroemde bergen in Japan?", kan de zoeknauwkeurigheid verbeteren. Grote taalmodellen (LLM's) verbeteren zoekopdrachten ook door extra query's te triggeren als het vertrouwen laag is, met behulp van technieken zoals FLARE.

Chain-of-thought redenering verbetert zoekopdrachten nog verder door Taken op te splitsen in logische stappen, zoals te zien is in AutoGPT. Bovendien kunnen LLM-assistenten met behulp van conversational search query's in realtime verfijnen, zodat de resultaten tijdens de interactie nauwkeuriger zijn.

Gepersonaliseerd zoeken en contextbewustzijn

Contextbewustzijn is een van de krachtigste functies van LLM's. In tegenstelling tot traditionele zoekmachines, die resultaten rangschikken op basis van trefwoordovereenkomsten, houden LLM's rekening met de intentie van de gebruiker, de locatie, de zoekgeschiedenis en eerdere interacties.

Door verfijning met domeinspecifieke gegevens personaliseren LLM's zoekresultaten om patronen te herkennen en relevante content prioriteit te geven. Een gebruiker die bijvoorbeeld vaak naar veganistische recepten zoekt, zal plantaardige opties te zien krijgen wanneer hij zoekt naar 'beste dinerrecepten. '

LLM's interpreteren ook multimodale query's en begrijpen zowel tekst als afbeeldingen voor nauwkeurigere resultaten. Bovendien bouwen ze longitudinale context op en leren ze van lopende interacties om proactief relevante query's voor te stellen.

LLM's in het opnieuw rangschikken en verbeteren van de resultaten van zoekmachines

LLM's verbeteren zoekmachines door resultaten dynamisch opnieuw te rangschikken om de intentie van gebruikers beter weer te geven. In tegenstelling tot traditionele rangschikking op basis van trefwoorden, gebruiken LLM's aandachtsmechanismen om de volledige context van een query te analyseren en relevante content prioriteit te geven.

Bijvoorbeeld, Google's BERT (Bidirectional Encoder Representations from Transformers) update heeft het zoeken gerevolutioneerd door de context achter woorden als 'apple' (fruit) vs. 'Apple' (techbedrijf) te begrijpen.

LLM's dragen ook bij aan een efficiëntere SERP (Search Engine Results Page). Door factoren zoals click-through rate (CTR), bounce rate en verblijftijd te analyseren, kunnen LLM's rankings in realtime aanpassen, waardoor resultaten met een hoge gebruikersbetrokkenheid worden gestimuleerd.

📖 Lees ook: PDF-bestanden snel doorzoeken

Populaire LLM zoekmachine tools

Naarmate AI-gestuurd zoeken zich verder ontwikkelt, winnen verschillende zoekmachines met grote taalmodellen aan populariteit vanwege hun geavanceerde mogelijkheden. Perplexity AI geeft directe antwoorden met geciteerde bronnen, waardoor zoekopdrachten interactiever en informatiever worden.

You. com biedt een aanpasbare ervaring waarmee gebruikers bronnen kunnen prioriteren, door AI gegenereerde samenvattingen kunnen integreren en kunnen communiceren met AI-assistenten.

We weten allemaal dat we deze zoekmachines kunnen gebruiken om informatie op te zoeken en snel antwoorden te krijgen. Maar hoe zit het met het vinden van dat ene cruciale bestand op het werk? Of het ophalen van een gesprek vol gegevenspunten voor je volgende grote presentatie?

Dit is waar ClickUp, de alles app voor werk, in beeld komt!

clickUp Insight: 46% van de kenniswerkers vertrouwt op een mix van chatten, aantekeningen, projectmanagement tools en teamdocumentatie om hun werk bij te houden. Voor hen is het werk verspreid over verschillende platforms, waardoor het moeilijker is om georganiseerd te blijven. ClickUp is de alles-in-één app voor werk en brengt alles samen. Met functies als ClickUp E-mail Projectmanagement, ClickUp Aantekeningen, ClickUp Chatten en ClickUp Brain wordt al uw werk op één plek gecentraliseerd, doorzoekbaar en naadloos met elkaar verbonden. Zeg vaarwel tegen een overdaad aan hulpmiddelen en verwelkom moeiteloze productiviteit.

ClickUp Brain combineert geavanceerde zoekfuncties met uitgebreide functies voor projectmanagement en verbindt taken, bestanden, leden van teams en projecten op één plek. Nooit meer schakelen tussen apps of omgaan met gefragmenteerde tools en informatiesilo's!

De kosten van inefficiëntie door losgekoppelde tools zijn enorm:

- 2. 5 uur/dag: Kenniswerkers besteden ongeveer 30% van hun werkdag aan het zoeken naar informatie

- 3600 keer per dag van app wisselen: Werknemers schakelen dagelijks meer dan 3600 keer tussen apps en vensters, waardoor ze 4 uur per week verliezen aan heroriëntatie

- 23 verloren minuten: Elke app switch verstoort de focus en het duurt bijna 23 minuten om weer op het juiste spoor te komen

420.000 dollar per jaar: Organisaties met 100 werknemers verliezen dit bedrag elk jaar door miscommunicatie en losgekoppelde tools

Deze inefficiënties leiden tot tijdverlies, een verminderd moreel en hogere operationele kosten. Gelukkig zet Connected AI deze uitdagingen om in kansen voor slimmere besluitvorming, snellere informatieterugwinning en naadloze uitvoering.

Ontdek hoe ClickUp's Connected Search samenwerking verandert:

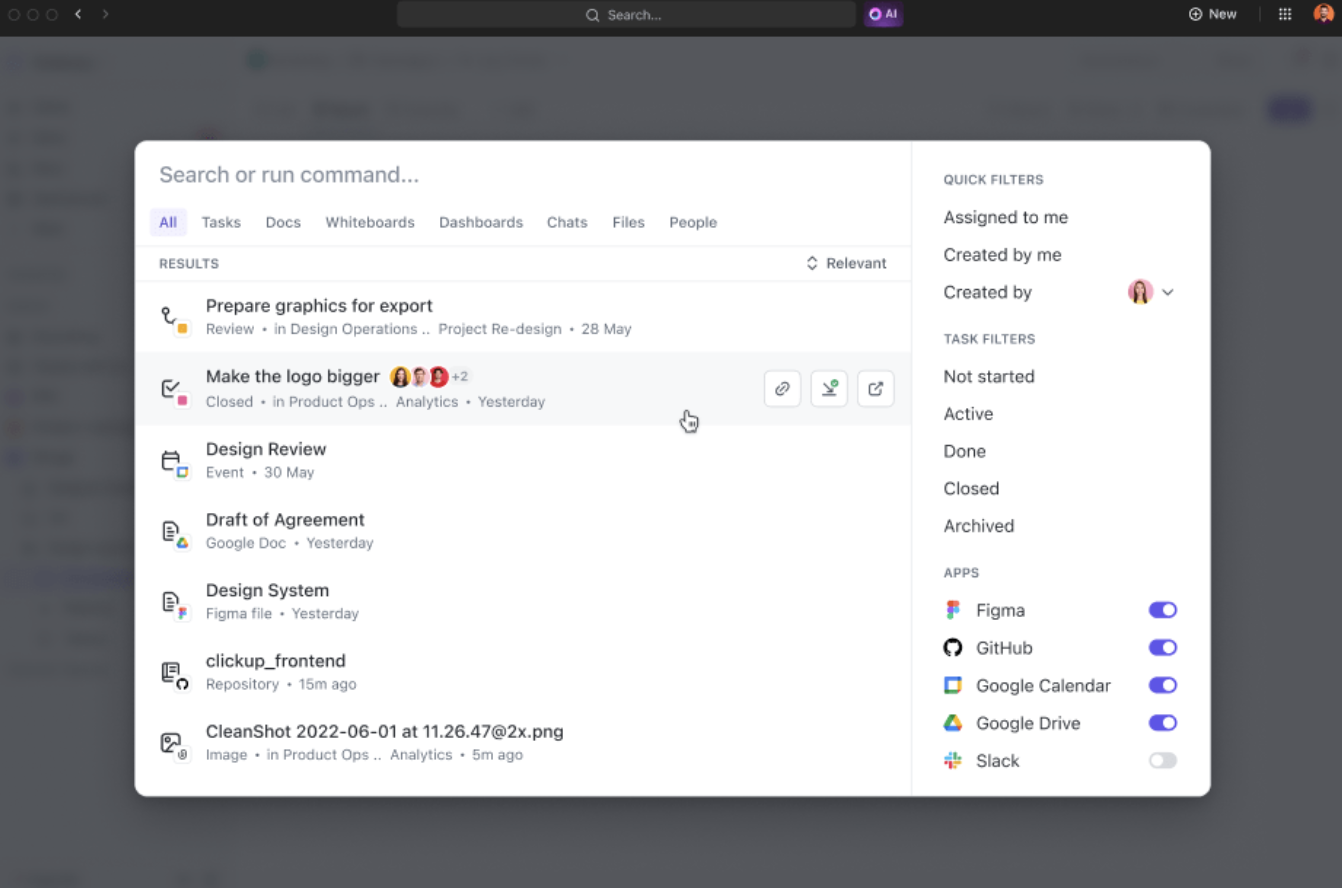

- Unified search: Krijg toegang tot alle informatie van uw onderneming vanaf één platform en bespaar bijna vier uur per week door het schakelen tussen apps te verminderen

- AI-aangedreven relevantie: Ontvang gepersonaliseerde, contextbewuste zoekresultaten op maat van uw projecten en verbeter de besluitvorming met directe toegang tot de meest relevante inzichten

- Moeiteloze integratie van tools: Verbind naadloos met bestaande tools zoals Google Drive, SharePoint, Figma en Slack zonder complexe installatie

Voorbeeld: als u terugkomt van uw verlof, vraagt u ClickUp Brain gewoon om updates over uw projecten. Het zal netjes georganiseerde opsommingstekens geven met belangrijke actie-items en discussies die plaatsvonden terwijl u weg was.

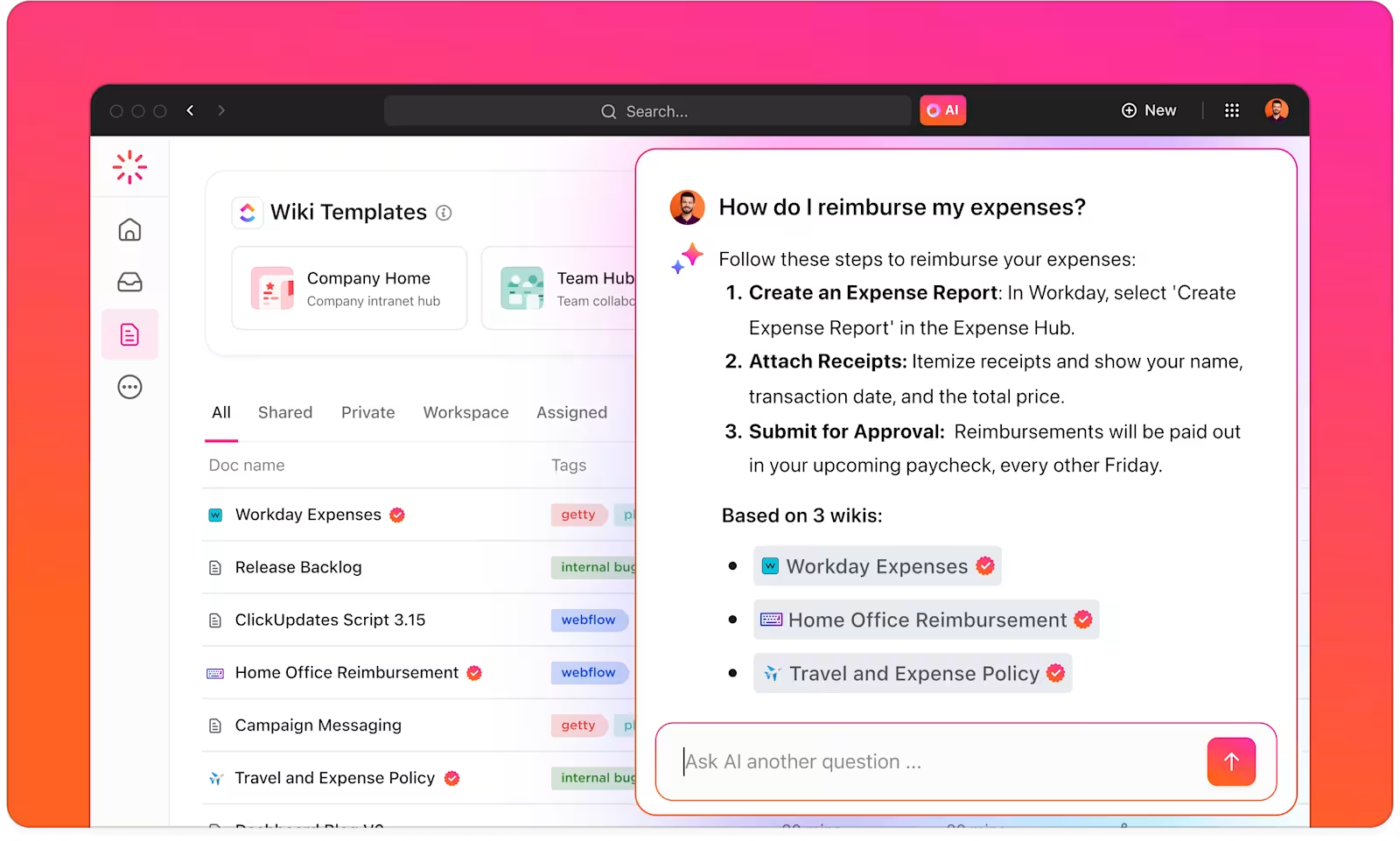

Met ClickUp Brain beschikt u over een intelligente kennismanager die u helpt alles te vinden binnen uw werkruimte en aangesloten apps.

ClickUp Brain begrijpt de context van uw taken en biedt relevante suggesties op basis van uw werkvoorkeuren of primaire activiteiten. Voor makers van content biedt het bijvoorbeeld suggesties voor het aanmaken van content, brainstormen en aanverwante taken.

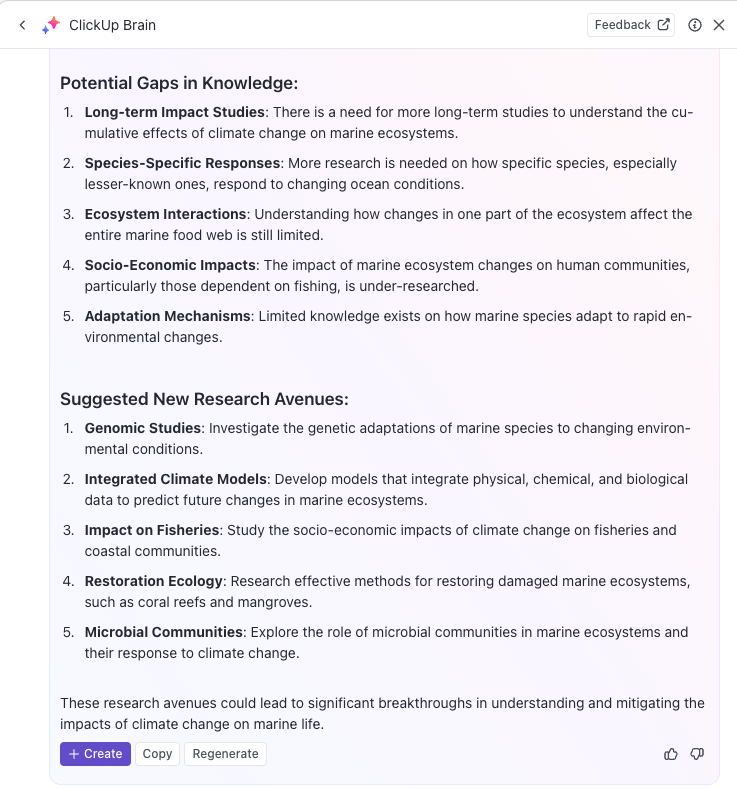

U kunt AI zelfs gebruiken om terugkerende taken te automatiseren of de status van taken bij te werken met eenvoudige prompts, zodat u zich kunt concentreren op het echte werk. Als u op zoek bent naar een krachtige AI-zoekmachine om uw productiviteit te verhogen, dan bent u bij ClickUp Brain aan het juiste adres.

Met ClickUp Brain kunt u uw kennisbank optimaliseren door alle relevante informatie automatisch te categoriseren, taggen en organiseren.

Onderzoeksteams kunnen ClickUp bijvoorbeeld gebruiken om een gecentraliseerd kennisbeheersysteem te creëren waarin alle inzichten, documenten en onderzoeksresultaten in een gemakkelijk toegankelijk format worden opgeslagen.

Verder ondersteunt de veelzijdigheid van ClickUp Docs het aanmaken van wiki's, opslagplaatsen voor documenten en kennisgerelateerd Taakbeheer.

U kunt informatie ook op verschillende manieren organiseren door ClickUp Spaces, mappen en lijsten te gebruiken om content te structureren en snel terug te vinden. Uw team kan gemakkelijk de juiste gegevens vinden en openen wanneer dat nodig is, zonder tijd te verspillen aan het doorzoeken van meerdere platforms.

Daarnaast helpt het platform bij het bijhouden van taken en projecten via ClickUp-taaken op basis van inzichten die zijn verkregen via LLM-zoekmachines. U kunt AI-gestuurde zoekresultaten rechtstreeks integreren in uw workflows voor het bijhouden van taken en projecten, zodat u de kennis die u hebt ontdekt gemakkelijker kunt implementeren.

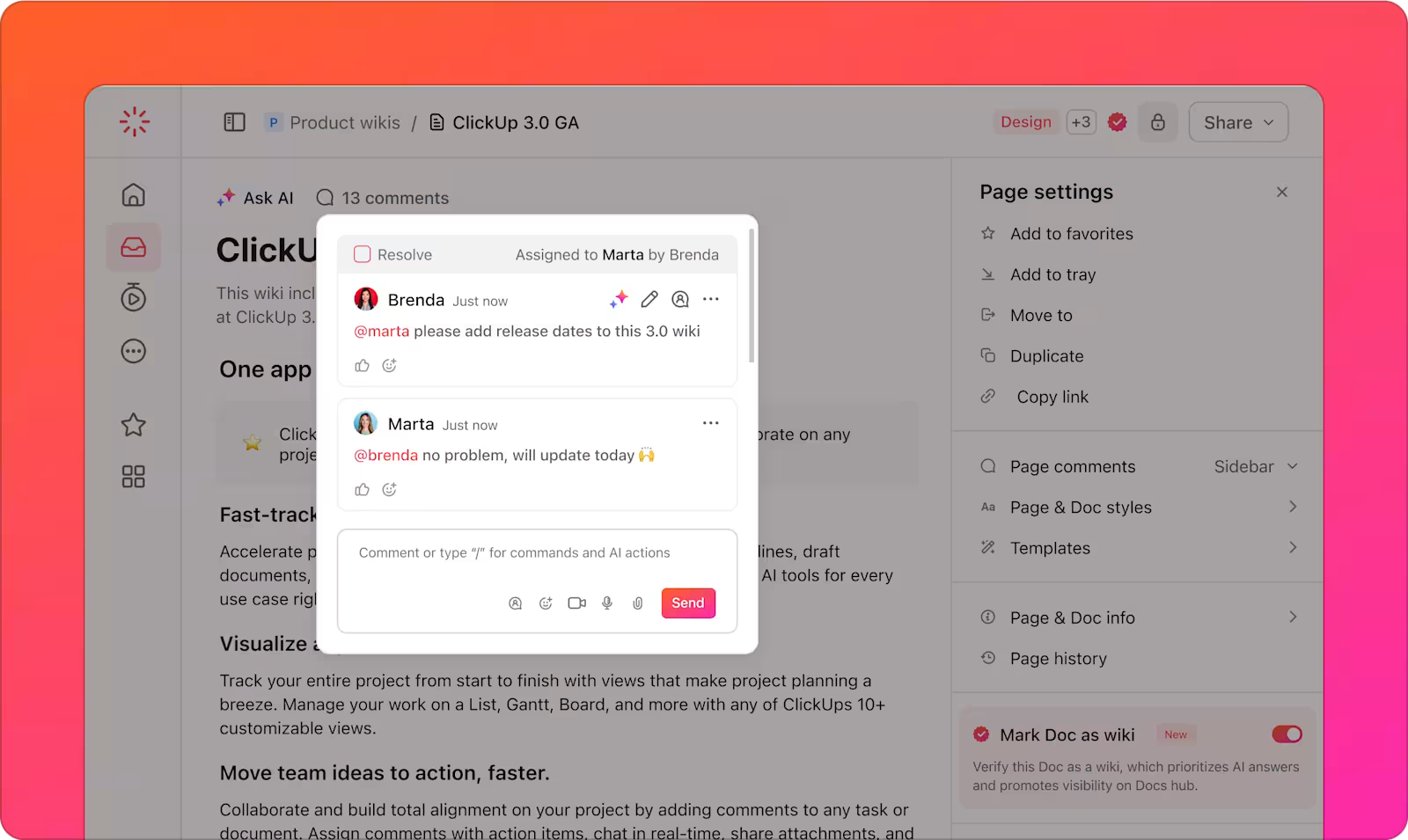

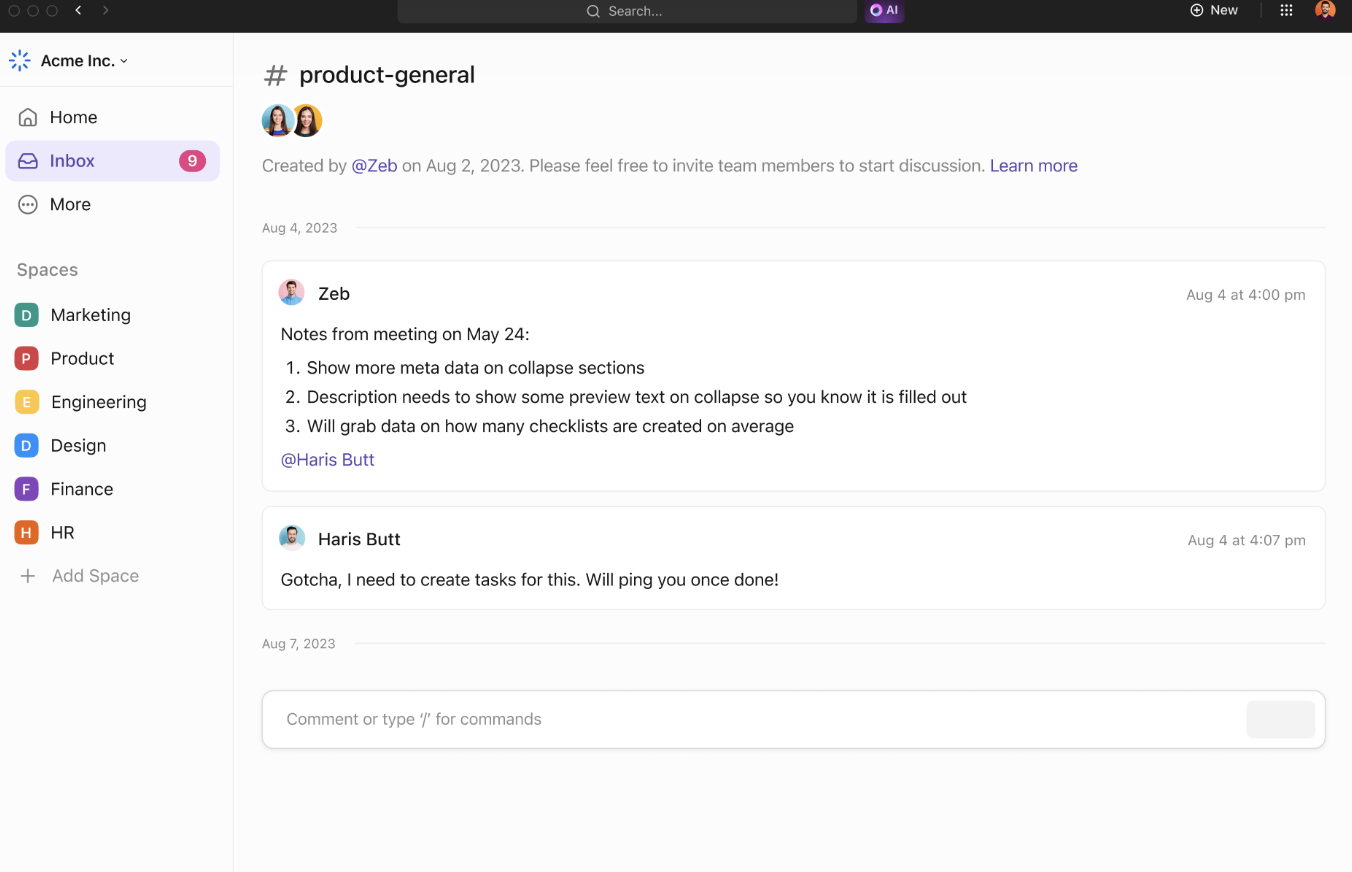

De samenwerkingstools van ClickUp ondersteunen de efficiëntie van teams en het delen van informatie. Met ClickUp Chat kunnen leden van het team in realtime projecten bespreken, inzichten delen en vragen stellen.

Toegewezen opmerkingen bieden een duidelijke manier om te communiceren over specifieke documenten of taken, zodat iedereen op de hoogte blijft van projectupdates.

Teams kunnen samenwerken door ideeën te delen en concepten te visualiseren. Voeg aantekeningen toe, upload afbeeldingen en koppel koppelingen voor een betere context. Gebruik connectoren om ideeën te koppelen en hun relaties te benadrukken.

Als uw ideeën klaar zijn, zet ze dan om in traceerbare Taken van ClickUp-taakborden om alles op schema te houden.

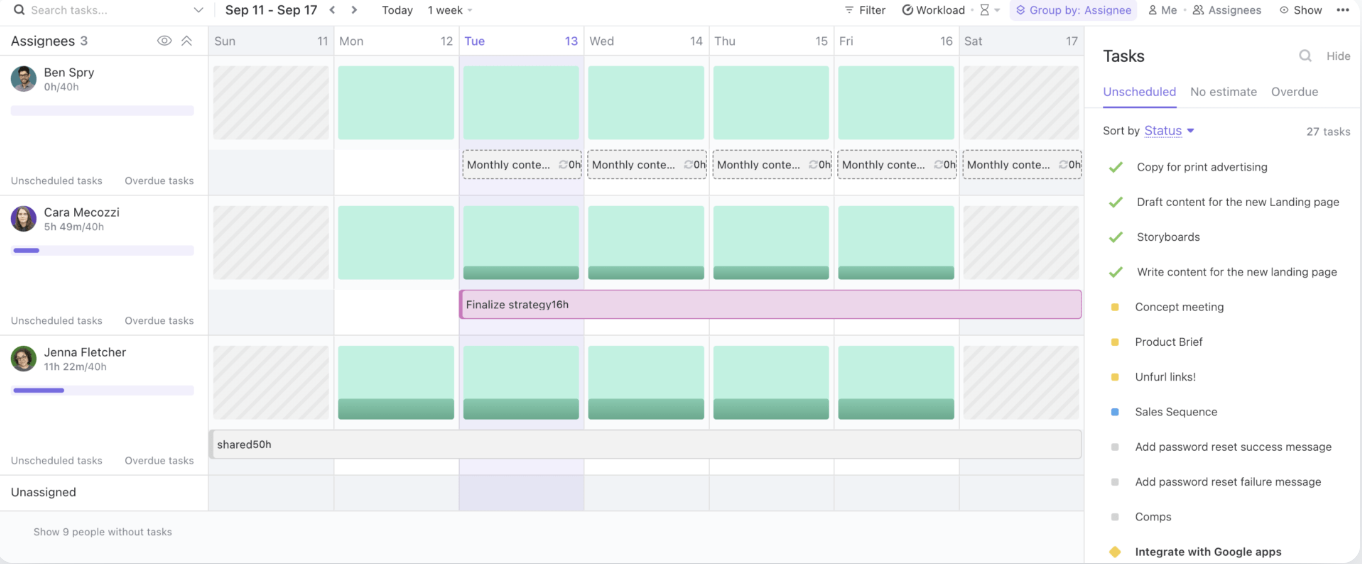

Tot slot kunt u met de werklastweergave van ClickUp de capaciteit van uw teams beheren, lopende taken bijhouden en resources effectief toewijzen.

Door een gecentraliseerde hub voor kennisdeling en samenwerking te bieden, stroomlijnt ClickUp workflows en verbetert het de efficiëntie van teams.

Best practices voor het gebruik van LLM-zoekmachines

Bij het gebruik van LLM-zoekmachines is het essentieel om best practices te volgen die het potentieel maximaliseren en tegelijkertijd de risico's beheersen.

Met deze strategieën haalt u het meeste uit uw AI-tools en zorgt u voor een soepele implementatie en succes op de lange termijn:

- Duidelijke use cases definiëren: Werk in een vroeg stadium samen met business en technische teams om specifieke, meetbare use cases op te stellen. Stem doelstellingen op elkaar af om ervoor te zorgen dat de oplossing aan de juiste behoeften voldoet en dat de voortgang gemakkelijk te evalueren is

- Zorg voor doordachte intakeprocessen: Houd bij het prioriteren van use cases rekening met de gevoeligheid van gegevens, mogelijke risico's en de beoogde gebruikers. Gebruik een risicogerichte aanpak om te beoordelen welke projecten de meeste waarde bieden met minimale schade

- Focus op het verzamelen, testen en valideren van gegevens: Zorg voor solide, op feiten gebaseerde gegevens door de verzameling, label-, opslag- en verwerkingspraktijken te verbeteren

- Implementeer gestandaardiseerde testprocedures: Creëer herhaalbare testprocessen ondersteund door playbooks en vooraf gedefinieerde praktijken. Zorg voor consistente resultaten, betrouwbaarheid van het systeem en goed geteste AI-modellen voordat u het systeem inzet

- Continue bewaking instellen: Bewaak de systeemprestaties in de loop van de tijd en pas ze aan veranderende gegevens, gebruikersgedrag en technologie aan

- Rol trainings- en communicatiecampagnes uit: Equip je team met de kennis om AI-tools verantwoord en effectief te gebruiken. Trainings- en communicatieprogramma's lanceren die zowel technische als ethische aspecten van AI behandelen

Uitdagingen en oplossingen voor LLM-gestuurd zoeken

LLM-gestuurde zoekmachines bieden een enorm potentieel, maar hebben ook hun eigen uitdagingen. Hieronder vindt u enkele veelvoorkomende AI-uitdagingen en praktische oplossingen om ze te overwinnen:

Kwaliteit en relevantie van gegevens

LLM-gestuurde zoekmachines zijn sterk afhankelijk van de kwaliteit en relevantie van de gegevens die ze verwerken. Slechte of verouderde gegevens kunnen leiden tot onnauwkeurige of irrelevante zoekresultaten, met alle gevolgen van dien voor de gebruikerservaring.

door zich te richten op actuele gegevens van hoge kwaliteit kunnen organisaties ervoor zorgen dat hun LLM-zoekmachine relevante en betrouwbare resultaten oplevert.

Gebrek aan transparantie

LLM-modellen worden vaak beschouwd als 'black boxes', waarbij de redenering achter hun output niet direct duidelijk is voor gebruikers. Dit gebrek aan transparantie kan het voor gebruikers moeilijk maken om de resultaten die ze ontvangen te vertrouwen.

door functies voor uitlegbaarheid in de zoekmachine op te nemen, kunnen organisaties gebruikers inzicht geven in waarom bepaalde resultaten zijn teruggestuurd.

Vooringenomenheid en ethische bezwaren

LLM's kunnen vooroordelen overerven van de gegevens waarop ze zijn getraind, wat kan leiden tot scheve of onethische resultaten. Als de trainingsgegevens niet divers of representatief zijn, kan de zoekmachine deze vooroordelen weerspiegelen, wat invloed heeft op de besluitvorming en eerlijkheid.

het regelmatig controleren en bijwerken van de trainingsgegevens is essentieel voor het identificeren en verminderen van deze vooroordelen. Bovendien zorgt het opnemen van verschillende datasets en het monitoren van de resultaten ervoor dat de zoekmachine evenwichtigere, eerlijkere en ethischere resultaten oplevert.

Systeemcomplexiteit en integratie

Het integreren van LLM-gestuurde zoekmachines met bestaande workflows en applicaties kan lastig zijn, vooral als het gaat om verouderde systemen of meerdere gegevensbronnen. De complexiteit van het verbinden van deze nieuwe tools met gevestigde platforms kan de implementatie vertragen.

met ClickUp's Connected Search kunt u snel elk bestand vinden, of het nu is opgeslagen in ClickUp, een verbonden app of uw lokale schijf.

Het probleem van hallucinaties

Hallucinaties verwijzen naar Instances waarbij het model feitelijk onjuiste, verzonnen of irrelevante informatie genereert. Dit komt doordat het model, in plaats van direct uit geïndexeerde databronnen te putten, soms gegevens 'hallucineert' op basis van patronen die tijdens de training zijn aangeleerd.

geavanceerde technieken zoals prompt engineering en hoogwaardige trainingsgegevens vergroten de betrouwbaarheid van LLM. Fijnafstemming met domeinspecifieke gegevens vermindert hallucinaties, terwijl integratie van kennisgrafieken zorgt voor op feiten gebaseerde, nauwkeurige resultaten.

De toekomst van zoeken met LLM's

De volgende generatie LLM-gestuurde zoekmachines belooft nog meer precisie, aanpassingsvermogen en reactiesnelheid, vooral bij het verwerken van complexe en dynamische query's van gebruikers. Deze systemen zullen zich dynamisch aanpassen aan de veranderende behoeften van gebruikers, waarbij ze leren van eerdere interacties en real-time gegevens.

In een instelling voor ondernemingen kan een LLM bijvoorbeeld een verzoek interpreteren als 'Zoek de klantverloopanalyse van het laatste kwartaal' en niet alleen het ruwe bestand retourneren, maar ook samengestelde inzichten, relevante trends en bruikbare aanknopingspunten.

Bedrijfstakken die afhankelijk zijn van het beheer van enorme en ingewikkelde gegevenssets zullen hier het meest bij winnen:

- In de gezondheidszorg kunnen grote taalmodellen diagnostische precisie ondersteunen door klinische aantekeningen, resultaten van beeldvorming en onderzoeksrapporten binnen enkele seconden te analyseren en met elkaar te vergelijken

- Juridische professionals zullen profiteren van tools die uitgebreide jurisprudentie kunnen ontleden om relevante precedenten te markeren

- Teams in de financiële sector kunnen LLM's gebruiken voor taken als realtime fraudedetectie, voorspellende marktanalyse en automatisering van nalevingscontroles

De integratie van multimodale zoekmogelijkheden - een combinatie van tekst-, stem- en beeldherkenning - zal het nut van LLM's nog verder vergroten.

Een team dat samenwerkt aan een productlancering kan bijvoorbeeld direct afbeeldingen uploaden, annotaties maken met spraakinvoer en gerelateerde documenten en rapportages ophalen. Dit niveau van aanpasbaarheid maakt LLM's cruciaal voor naadloze toegang tot verschillende formats van gegevens.

Platforms als ClickUp bieden in combinatie met LLM-gebaseerd zoeken een robuuste oplossing voor het organiseren en openen van bestanden, het optimaliseren van werkstromen en het stimuleren van efficiënte besluitvorming.

Supercharge uw werkstroom met zoeken op basis van LLM

AI-gestuurde zoekmachines met LLM's blijven zich ontwikkelen en zorgen voor een revolutie in de manier waarop bedrijven informatie van webpagina's halen en gegevens beheren.

Dankzij hun vermogen om context te begrijpen, nauwkeurigere resultaten te leveren en naadloos te integreren met de workflows van ondernemingen, maken LLM's de weg vrij voor slimmere, snellere en efficiëntere activiteiten.

En bij het zoeken naar een AI-zoekmachine die naadloos in uw werkstroom is geïntegreerd, gaat er niets boven ClickUp Brain. Of u nu snel een bestand of een taak moet vinden, ideeën moet brainstormen of zelfs een e-mail moet opstellen, de krachtige AI-mogelijkheden van ClickUp Brain kunnen het allemaal aan.

De integratie met ClickUp's uitgebreide projectmanagement tools zorgt ervoor dat alles binnen handbereik is, zodat u georganiseerd blijft, tijd bespaart en sneller datagestuurde beslissingen neemt.

Dus waar wacht u nog op? Meld u vandaag nog aan voor ClickUp en krijg meer Klaar met ClickUp Brain!