La privacidad es un derecho humano fundamental. Y esa privacidad también se extiende a todos los aspectos de la IA actual. En un informe de Cisco, el 64 % de las personas temen que se produzca un uso compartido accidental de información confidencial al utilizar herramientas de IA.

Esa es una de las razones por las que las herramientas de IA sin conexión están ganando popularidad. Cuando el modelo se ejecuta localmente, puedes escribir, crear código, resumir y crear, sin tener que subir todo a la nube ni quedarte bloqueado cuando se cae la conexión wifi.

En esta lista, repasaremos las mejores herramientas de IA que funcionan sin conexión, entre las que se encuentra una superaplicación que te ayuda a organizar lo que producen estas herramientas en un sistema cohesionado y de alta seguridad.

¿Qué son las herramientas de IA sin conexión?

Las herramientas de IA sin conexión son aplicaciones de software que ejecutan grandes modelos de lenguaje (LLM) en su dispositivo local, sin necesidad de conexión (a internet) una vez descargado el modelo. Los datos del modelo se almacenan directamente en su ordenador, por lo que todo el procesamiento, o inferencia, se realiza en su propia CPU o GPU.

Este procesamiento en el dispositivo tiene varias ventajas clave:

- Privacidad total de los datos: su información confidencial nunca sale de su ordenador.

- Sin cuotas recurrentes: una vez que tienes la herramienta y el modelo, no hay costes de suscripción.

- Funciona en cualquier lugar: puedes utilizarlo en un avión, en una cabaña remota o durante un corte de Internet.

- Control total: tú eliges qué modelos utilizar y cómo configurarlos.

Las mejores herramientas de IA sin conexión de un vistazo

Aquí tienes un breve resumen de las mejores herramientas de IA sin conexión disponibles en la actualidad.

| Nombre de la herramienta | Funciones principales | Ideal para | Precios* |

| ClickUp | Modo sin conexión para tareas y recordatorios, ClickUp Brain MAX, que incluye conversión de voz a texto, búsqueda empresarial en aplicaciones conectadas, gestión de documentos y conocimientos, automatizaciones, además de integraciones y API. | Equipos que necesitan captura offline más ejecución online, gobernanza y contexto de IA en un único entorno de trabajo. | Gratis para siempre; personalización disponible para corporaciones. |

| GPT para todos | Chatear local con modelos abiertos, LocalDocs para preguntas y respuestas sobre documentos privados, descubrimiento y descarga de modelos en la aplicación, servidor API local compatible con OpenAI. | Usuarios preocupados por la privacidad que desean un chatbot de escritorio sencillo sin conexión con documentos locales. | Plan gratuito disponible; los planes de pago comienzan en 40 $/usuario/mes. |

| LM Estudio | Descubrimiento y descarga de modelos, interfaz de usuario de chat más RAG local, servidor compatible con OpenAI o API REST, preajustes y ajuste del rendimiento. | Desarrolladores y usuarios avanzados que desean un entorno de trabajo offline perfeccionado. | Free |

| Ollama | Un modelo de comando, API REST local con streaming, archivos de modelo para configuraciones reutilizables e incrustaciones para canalizaciones RAG. | Desarrolladores que desean un tiempo de ejecución local basado en CLI con una sólida capa API. | Plan Free disponible; planes de pago a partir de 20 $ al mes. |

| Enero ai | Interfaz de usuario sin conexión al estilo ChatGPT, asistentes y soporte para MCP, extensiones para capacidades añadidas y proveedores opcionales compatibles con OpenAI. | Usuarios sin conocimientos técnicos que desean un asistente offline sencillo y personalizado. | Gratis y de código abierto |

| Llamafile | Empaquetado de modelo ejecutable único, distribución portátil entre sistemas operativos, modo de servidor local con interfaz de usuario web y API, tiempo de ejecución con dependencias mínimas. | Usuarios que desean un archivo IA portátil sin instalación que puedan ejecutar en cualquier lugar. | Gratis y de código abierto |

| PrivateGPT | Ingesta y índice de documentos autohospedados, preguntas y respuestas RAG sin conexión, filtrado de contexto por documento, LLM modular y pila de almacenamiento vectorial. | Teams que necesitan preguntas y respuestas fuera de línea sobre archivos internos con un canal RAG controlable. | Gratuito y de código abierto |

| Susurro. cpp | Conversión de voz a texto local, modelos cuantificados para un menor uso de recursos, compatibilidad con VAD, manejo opcional de FFmpeg para más formatos. | Usuarios que necesitan una transcripción totalmente offline que puedan integrar en aplicaciones. | Gratuito y de código abierto |

| Interfaz de usuario web para la generación de texto | Interfaz de usuario basada en navegador para modelos locales, plantillas de indicaciones Jinja2, controles de generación, ramificación de chat y edición de mensajes. | Usuarios que desean una interfaz web local muy personalizada. | Gratuito y de código abierto |

| llama. cpp | Motor de inferencia de alto rendimiento, amplia compatibilidad con cuantificación, servidor local con puntos finales al estilo OpenAI, incrustaciones y soporte para reclasificación. | Desarrolladores que crean aplicaciones o backends de IA personalizados sin conexión. | Gratis y de código abierto |

Cómo evaluamos el software en ClickUp

Nuestro equipo editorial sigue un proceso transparente, respaldado por investigaciones y neutral con respecto a los proveedores, por lo que puede confiar en que nuestras recomendaciones se basan en el valor real del producto.

A continuación, te ofrecemos un resumen detallado de cómo evaluamos el software en ClickUp.

Qué buscar en las mejores herramientas de IA que funcionan sin conexión

Evaluar herramientas de IA sin conexión puede parecer técnico y confuso, lo que puede llevarte a elegir una herramienta que tal vez ni siquiera funcione en tu ordenador. Lo más importante que debes tener en cuenta es lo que quieres lograr. Un desarrollador que crea una app basada en IA tiene necesidades muy diferentes a las de alguien que solo quiere un chatbot de IA privado y sin conexión para ayudarle a escribir.

Estos son los criterios clave que hay que evaluar:

- Facilidad de configuración: ¿Requiere conocimientos técnicos y trabajo con la línea de comandos, o se trata de una sencilla instalación con un solo clic?

- Selección de modelos: ¿Puedes elegir fácilmente entre una amplia variedad de modelos o estás limitado a unos pocos?

- Garantías de privacidad: ¿La herramienta procesa todos los datos localmente o hay componentes ocultos en la nube?

- Requisitos de hardware: ¿Funcionará bien en tu equipo actual o necesitas actualizarlo?

- Capacidades de integración: ¿Se puede conectar con otras herramientas o es una aplicación totalmente independiente?

- Aplicación adecuada: ¿Está diseñado para chatear en general, hacer preguntas sobre tus documentos, transcribir audio o generar código?

Las 10 mejores herramientas de IA que funcionan sin conexión

Aquí tienes una vista general de las mejores herramientas de IA sin conexión 👇

1. ClickUp (ideal para mantener las tareas, los documentos y el contexto de IA en un solo lugar, tanto en el trabajo offline como online).

ClickUp, el primer entorno de trabajo con IA convergente del mundo, se basa en los bloques de la «IA offline», que no se limita a generar una respuesta. Esto se debe a que aún se necesita un lugar donde ese resultado se convierta en una decisión, una tarea y un siguiente paso que no desaparezca en archivos y chats.

A diferencia de muchas configuraciones offline que requieren largas instalaciones y la integración de herramientas, ClickUp te ofrece una capa de ejecución completa en un solo lugar, con IA que funciona sobre el mismo contexto del entorno de trabajo.

Para empezar, tienes el modo sin conexión de ClickUp, que se activa automáticamente y mantiene el trabajo en marcha cuando hay actividad sin conexión. Eso significa que todas tus tareas, recordatorios y notas siguen estando accesibles mientras estás sin conexión, con la opción de añadir más si es necesario. Una vez que te vuelves a conectar, las nuevas tareas y recordatorios se sincronizan automáticamente con tu entorno de trabajo de ClickUp (di adiós a la pérdida de contexto 👋).

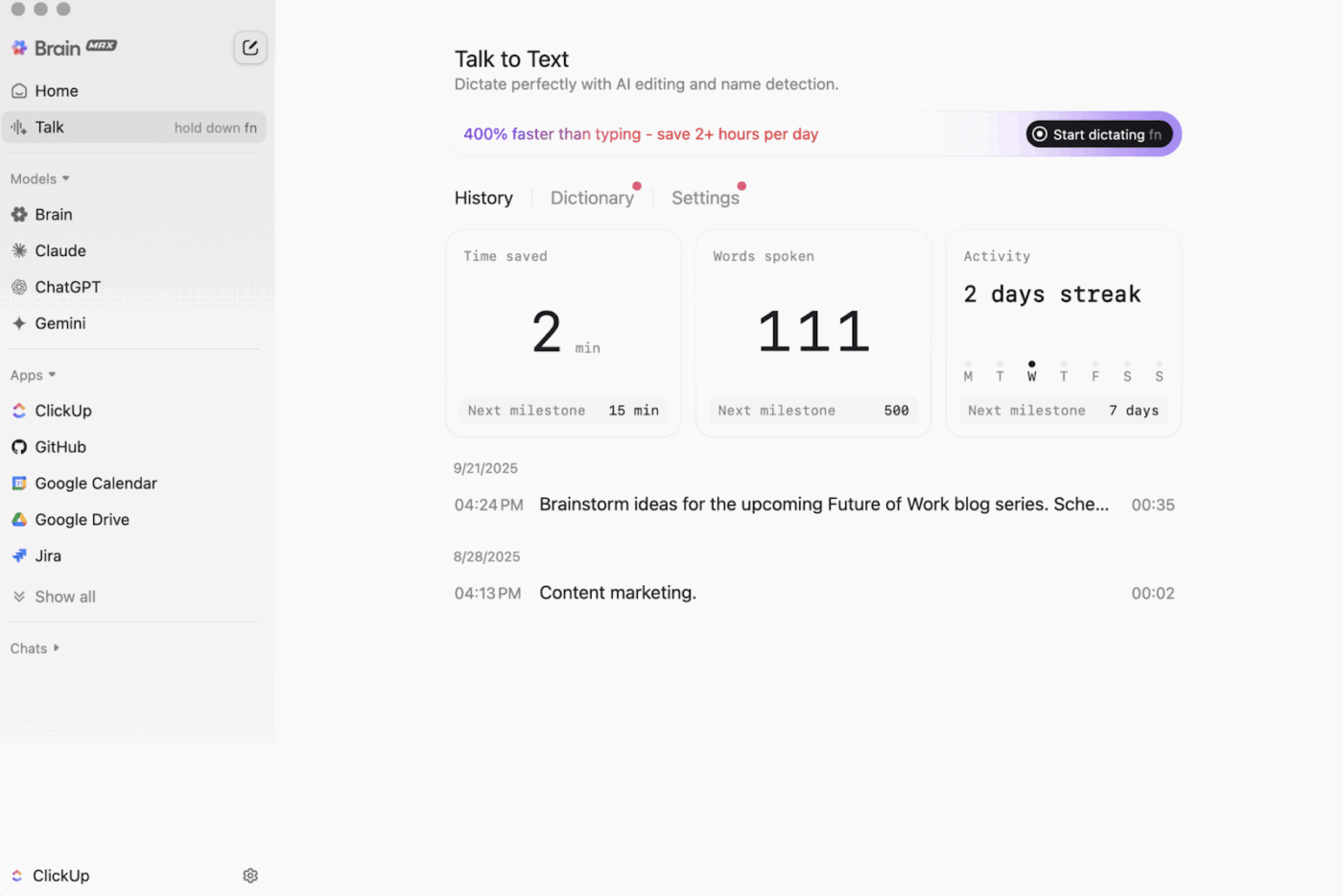

Luego está ClickUp Brain MAX , el compañero de IA para escritorio que prioriza la privacidad y que puede almacenar y buscar en todo tu entorno de trabajo, aplicaciones conectadas e incluso en la web.

Con Talk-to-Text en la mezcla, Brain MAX puede convertir tu voz en texto sin necesidad de usar las manos. Esto incluye redactar un correo electrónico, escribir un documento o capturar una actualización rápida mientras estás en movimiento.

Brain MAX también te ofrece Universal AI, diseñado para chatear con los últimos modelos de IA para codificación, escritura, razonamiento complejo y mucho más. Esto significa que puedes hacer preguntas a los mejores modelos de IA en un solo lugar, incluyendo ClickUp Brain y opciones como OpenAI, Claude y Gemini, sin tener que cambiar de herramienta.

Además, ClickUp Security añade medidas de seguridad que las herramientas offline suelen omitir. Piensa en cifrado, permisos granulares y controles de administración como SSO, aprovisionamiento y registros de auditoría, todo ello diseñado para equipos que necesitan seguridad de nivel empresarial.

La gestión del conocimiento con IA de ClickUp es de gran ayuda en la transición «de offline a online». Proporciona a tu equipo un hub para almacenar diferentes recursos en documentos y wikis, y luego utiliza ClickUp Brain para obtener respuestas instantáneas de todo tu entorno de trabajo, de modo que el contexto adecuado esté disponible en el momento en que se reanuda el trabajo.

🎬 Agentes en acción: ¡Utiliza Super Agents para convertir el trabajo sincronizado en los siguientes pasos!

Los superagentes de ClickUp son compañeros de equipo impulsados por IA que puedes crear y personalizar para ejecutar flujos de trabajo de varios pasos dentro de tu entorno de trabajo de ClickUp. Puedes configurar desencadenantes específicos, instrucciones y acceso a herramientas para garantizar que actúen dentro de los límites que establezcas.

Por ejemplo, después de sincronizar las tareas fuera de línea, un superagente puede escanear los nuevos elementos, resumir los cambios, extraer los pasos a tomar, redactar una actualización y enviarla al propietario adecuado para su revisión.

Y como los Super Agentes son controlables, puedes controlar a qué pueden acceder mediante permisos y auditar lo que hacen. 🔐

Las mejores funciones de ClickUp

- Encuentre cualquier cosa en sus herramientas: ordene y busque en todo su entorno de trabajo, además de en las aplicaciones conectadas, desde un solo lugar con ClickUp Enterprise Search.

- Crea una base de conocimientos real: Crea wikis y documentos con ClickUp Docs utilizando páginas anidadas, plantillas, asistencia con IA y mucho más.

- Mantén tu pila conectada: sincroniza tu trabajo con herramientas como Slack y GitHub sin salir de ClickUp con las integraciones de ClickUp.

- Cree flujos de trabajo personalizados: utilice la API de ClickUp con tokens personales u OAuth 2.0 para impulsar automatizaciones e integraciones a medida.

- Automatiza tu pila: utiliza desencadenantes para activar acciones como asignar propietarios, actualizar estados o iniciar traspasos en función de los cambios en las tareas con ClickUp Automatizaciones.

Limitaciones de ClickUp

- Debido al amplio intervalo de funciones, algunos usuarios pueden enfrentarse a una curva de aprendizaje.

Precios de ClickUp

Valoraciones y reseñas de ClickUp

- G2: 4,7/5 (más de 10 000 opiniones)

- Capterra: 4,6/5 (más de 4000 opiniones)

¿Qué opinan los usuarios reales sobre ClickUp?

Un crítico de G2 dice:

Tableros ágiles, integraciones y personalización. Además, me gusta el hecho de que puedo desconectarme y seguir trabajando en las tareas. Además, puedo enviar correos electrónicos a cualquiera de las listas y crear tareas automáticamente. El editor de texto es fabuloso, funciona tanto en modo MD como con atajos, lo que permite previsualizar el contenido en línea.

Tableros ágiles, integraciones y personalización. Además, me gusta el hecho de que puedo desconectarme y seguir trabajando en las tareas. Además, puedo enviar correos electrónicos a cualquiera de las listas y crear tareas automáticamente. El editor de texto es fabuloso, funciona tanto en modo MD como con atajos, lo que te permite previsualizar el contenido en línea.

2. GPT4All (ideal para chatear de manera privada y sin conexión con IA y modelos de lenguaje grandes locales)

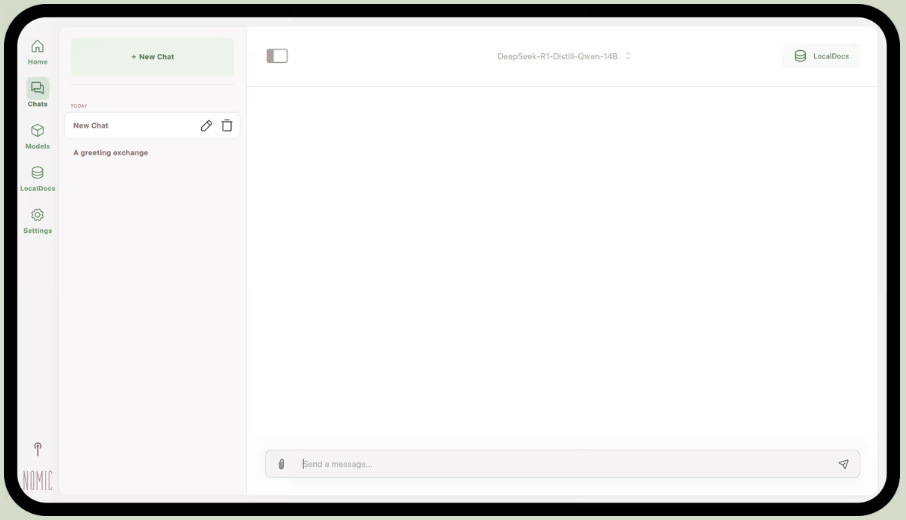

Parte de Nomic.ai, GPT4All es una aplicación de escritorio que te permite ejecutar modelos de lenguaje de código abierto directamente en tu ordenador, para que puedas chatear con un asistente de IA sin depender del acceso a Internet ni de llamadas a la API en la nube. Está diseñada para personas que desean una configuración «local primero», en la que las indicaciones, las respuestas y los archivos permanecen en el dispositivo.

Su mejor función es LocalDocs, que utiliza una forma de generación aumentada por recuperación para permitirte chatear con tus propios documentos de forma privada. Puedes indicar a la aplicación una carpeta de archivos PDF o de texto, y esta creará una base de conocimientos local a la que podrás hacer preguntas.

GPT4All también incluye una biblioteca seleccionada de modelos populares como Llama y Mistral, que se pueden descargar directamente a través de la app.

Las mejores funciones de GPT4All

- Inicie un servidor API local (compatible con OpenAI) para utilizar los modelos GPT4All dentro de otras aplicaciones y automatizaciones.

- Busca, compara y descarga modelos GGUF desde la app, con opciones de clasificación como «Me gusta», descargas y fecha de subida.

- Ajusta la longitud del contexto, la longitud máxima de salida, top-p, top-k, la penalización por repetición, los hilos de la CPU e incluso la descarga de la capa GPU (además de la compatibilidad con Metal en Apple Silicon).

Limitaciones de GPT4All

- El rendimiento tiene una gran dependencia del hardware de tu ordenador.

- El índice de grandes colecciones de documentos puede ser lento.

Precios de GPT4All

- Aplicación de escritorio gratuita

- Empresa: 40 $ por usuario al mes (Nomic IA)

- Corporación: Precios personalizados (Nomic IA)

Valoraciones y reseñas de GPT4All

- G2: No hay suficientes reseñas.

- Capterra: No hay suficientes reseñas.

¿Qué opinan los usuarios reales sobre GPT4All?

Un usuario de Reddit dice:

Es el mejor que he probado con RAG, supera a todos los demás, incluso a LM Studio en cuanto a simplicidad. Me gusta la forma en que se correlaciona con una carpeta y realiza el seguimiento y gestiona los cambios por ti. Todavía está en una fase temprana de madurez, como el resto, pero va a ser mi opción predeterminada a corto plazo.

Es el mejor que he probado con RAG, supera a todo, incluso a LM Studio en cuanto a simplicidad. Me gusta la forma en que se correlaciona con una carpeta y realiza el seguimiento y gestiona los cambios por ti. Todavía está en una fase temprana de madurez, como el resto, pero va a ser mi opción predeterminada a corto plazo.

📮 Información de ClickUp: El 88 % de los participantes en nuestra encuesta utilizan la IA para sus tareas personales, pero más del 50 % evitan utilizarla en el trabajo. ¿Cuáles son las tres principales barreras? La falta de integración fluida, las lagunas de conocimiento o las preocupaciones en materia de seguridad. Pero, ¿y si la IA estuviera integrada en tu entorno de trabajo y ya fuera segura? ClickUp Brain,

El asistente de IA integrado de ClickUp lo hace realidad. Entiende las indicaciones en lenguaje sencillo, resuelve las tres preocupaciones relacionadas con la adopción de la IA y conecta tus chats, tareas, documentos y conocimientos en todo el entorno de trabajo. ¡Encuentra respuestas e información con un solo clic!

3. LM Studio (ideal para un banco de trabajo offline perfeccionado con ajuste del rendimiento)

a través de LM Studio

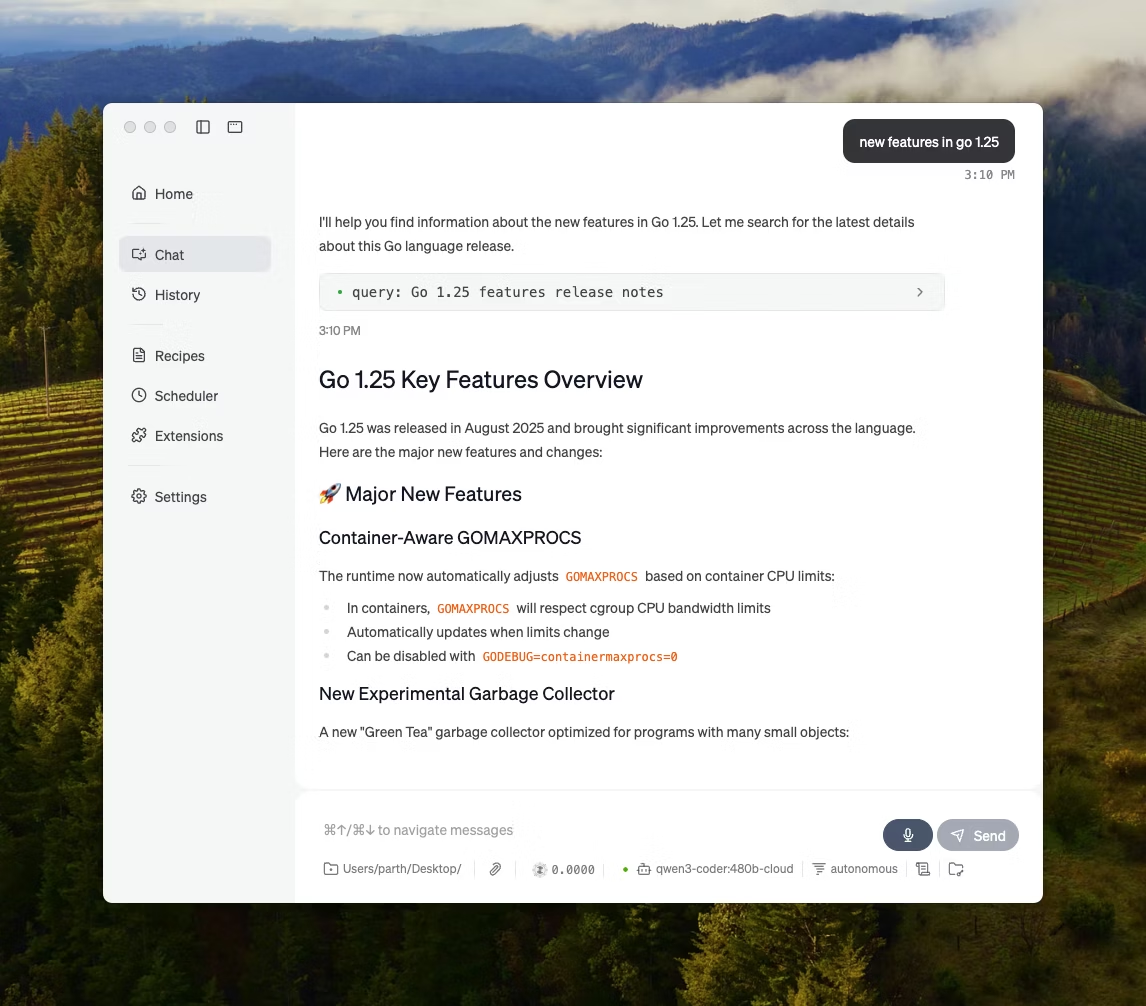

LM Studio es una aplicación de escritorio local con IA diseñada para buscar, probar y ejecutar modelos de código abierto en una interfaz de usuario, sin necesidad de utilizar un terminal. Está orientada a la experimentación, como elegir un modelo, ejecutarlo localmente e iterar sobre indicaciones y ajustes con un ciclo de retroalimentación más ajustado que la mayoría de las configuraciones que dan prioridad a la CLI.

También ofrece compatibilidad para chatear con documentos completamente sin conexión (RAG local), donde puedes adjuntar archivos a una conversación y hacer referencia a ellos durante las respuestas. Esto lo hace ideal para investigaciones sin conexión, notas de estudio o flujos de trabajo de documentos internos donde no es posible realizar cargas.

LM Studio también te ofrece un control detallado sobre el funcionamiento de la IA, con opciones para ajustar la temperatura, la longitud del contexto y el uso de la GPU.

Las mejores funciones de LM Studio

- Utiliza el modo de compatibilidad OpenAI o la API REST propia de LM Studio, dependiendo de lo que requiera tu aplicación.

- LM Studio ofrece opciones SDK tanto en JavaScript como en Python para crear flujos de trabajo locales sobre sus modelos.

- Guarda una indicación del sistema + parámetros como un ajuste preestablecido y reutilízalo en los chats (los ajustes preestablecidos también se pueden importar desde un archivo/URL y publicar para compartirlos a través del hub de LM Studio).

Limitaciones de LM Studio

- LM Studio puede bloquear el ordenador mientras se ejecuta DeepSeek R1 32B.

- Algunos usuarios señalan la aplicación como un problema de seguridad y privacidad de los datos debido a su código fuente cerrado no auditado.

Precios de LM Studio

- Gratis para uso doméstico y laboral.

Valoraciones y reseñas de LM Studio

- G2: No hay suficientes reseñas.

- Capterra: No hay suficientes reseñas.

¿Qué opinan los usuarios reales sobre LM Studio?

Un usuario de Reddit dice:

Es genial. Simplemente funciona, es muy fácil de poner en marcha y empezar a usar. Tiene la interfaz de usuario más atractiva de todos los competidores.

Es genial. Simplemente funciona, es muy fácil de poner en marcha y empezar a usar. Tiene la interfaz de usuario más atractiva de todos los competidores.

4. Ollama (ideal para ejecutar LLM locales con una sencilla CLI + servidor local)

Ollama es un ejecutor de modelos local que se comporta más como un tiempo de ejecución LLM que como una aplicación de chat independiente. Es principalmente un terminal, diseñado para extraer y ejecutar modelos abiertos con comandos rápidos (como ollama run llama3) y, a continuación, exponerlos a través de un servicio local sobre el que pueden asentarse otras interfaces.

La fortaleza de Ollama reside en su API REST. Una vez que Ollama se ejecuta en segundo plano, cualquier aplicación puede comunicarse con ella mediante simples solicitudes HTTP. Esto ayuda a incorporar funciones de IA en su propio software.

Ollama también ofrece una biblioteca de modelos populares que se pueden descargar con un solo comando, y permite crear configuraciones de modelos personalizadas, que son como archivos Dockerfiles para IA.

Las mejores funciones de Ollama

- Cree recetas de modelos reutilizables y versionables (selección de modelos base, plantillas de mensajes, mensajes del sistema, parámetros, adaptadores) utilizando un archivo Modelfile.

- Ejecute modelos a través de puntos finales como chatear/generar con streaming opcional para la salida de tokens en tiempo real en apps y scripts.

- Genere incrustaciones para procesos de búsqueda y recuperación semánticas utilizando la capacidad de incrustación de Ollama y los modelos de incrustación recomendados.

Limitaciones de Ollama

- No tiene interfaz gráfica integrada, por lo que los usuarios sin conocimientos técnicos necesitarán una herramienta independiente.

- La aplicación de escritorio macOS de Ollama puede dejar de responder mientras está sin conexión, incluso cuando los modelos ya se han descargado, mientras que la CLI sigue funcionando.

Precios de Ollama

- Free

- Pro: 20 $ al mes

- Máximo: 100 $ al mes

Valoraciones y reseñas de Ollama

- G2: No hay suficientes reseñas.

- Capterra: No hay suficientes reseñas.

¿Qué opinan los usuarios reales sobre Ollama?

Un crítico de Producthunt dice:

Fácil de implementar y gestionar. Ollama facilita enormemente la ejecución de LLM locales. Combínalo con OpenWebUI para disfrutar de la mejor experiencia.

Fácil de implementar y gestionar. Ollama facilita enormemente la ejecución de LLM locales. Combínalo con OpenWebUI para disfrutar de la mejor experiencia.

🧠 Dato curioso: La conversión de voz a texto comenzó como «solo dígitos». AUDREY (1952) de Bell Labs reconocía los dígitos del 0 al 9, y según una nota, funcionaba mejor cuando hablaba su inventor.

5. Jan. IA (Lo mejor para un asistente offline, que prioriza la privacidad, al estilo ChatGPT)

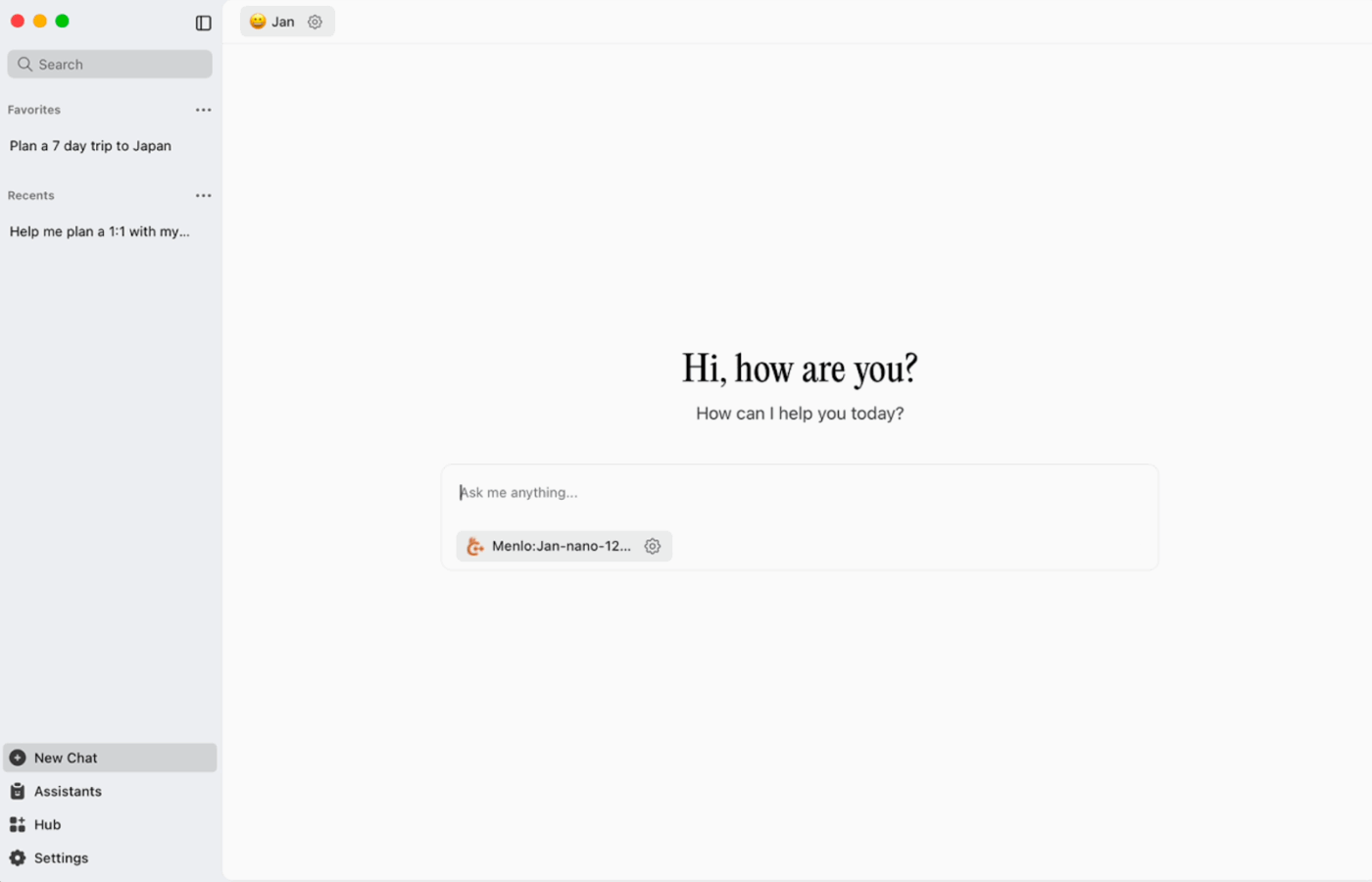

Jan. ai es un asistente de escritorio de código abierto que ofrece una experiencia de chat similar a ChatGPT para macOS, Windows y Linux, con un uso local como opción predeterminada. Se ejecuta en el dispositivo cuando lo deseas, mientras que el historial de conversaciones y los datos de uso se almacenan localmente y no salen de tu ordenador.

Admite la ejecución de modelos de código abierto de forma local y también permite conexiones opcionales a proveedores remotos, como API compatibles con OpenAI, lo que lo hace flexible cuando el uso sin conexión es la prioridad, pero a veces se necesita acceso a la nube.

Enero: las mejores funciones de IA

- Crea asistentes con sus propias indicaciones y ajustes, y luego cambia entre ellos desde la pestaña Asistentes en lugar de reescribir las indicaciones cada vez.

- Conecta Jan a las herramientas MCP y las fuentes de datos utilizando un estándar abierto creado para flujos de trabajo basados en el uso de herramientas.

- Instala extensiones para añadir nuevas funciones, como búsqueda web o un intérprete de código. Este enfoque modular te permite empezar de forma sencilla y añadir más potencia a medida que avanzas.

Enero. Limitaciones de la IA.

- Jan puede permitir la carga de un archivo de modelo que aún no se ha descargado por completo, lo que puede generar un comportamiento confuso o inconsistente hasta que el archivo se complete.

- Activar la API puede interferir con los chats en cadena, y es posible que los puntos finales básicos como «obtener modelo cargado» o «cambiar modelo» no funcionen correctamente.

Precio de enero ai

- Código abierto

Enero. Valoraciones y reseñas de IA.

- G2: No hay suficientes reseñas.

- Capterra: No hay suficientes reseñas.

¿Qué opinan los usuarios reales sobre Jan. ai?

Un usuario de Reddit dice:

Jan. ai es mi aplicación LLM local favorita. Es genial.

Jan. ai es mi aplicación LLM local favorita. Es genial.

6. Llamafile (ideal para empaquetar un LLM en un archivo ejecutable portátil)

Llamafile es un proyecto liderado por Mozilla que agrupa un LLM de código abierto completo en un solo archivo ejecutable. En lugar de instalar un tiempo de ejecución, gestionar dependencias o conectar una interfaz de usuario independiente, se descarga un solo archivo y se ejecuta como una app, aplicación.

La idea central es la distribución. Un «llamafile» incluye los pesos del modelo más un tiempo de ejecución compilado, diseñado para funcionar en múltiples sistemas operativos con una configuración mínima. Resulta especialmente útil cuando es necesario realizar el uso compartido de una herramienta sin conexión con compañeros de equipo, estudiantes o clientes que no pueden resolver problemas de instalación.

Las mejores funciones de Llamafile

- Llamafile combina llama.cpp con Cosmopolitan Libc para ofrecer compatibilidad amplia con formatos binarios, lo que reduce el trabajo de empaquetado específico de la plataforma.

- El modo servidor proporciona una interfaz gráfica de usuario web y un punto final de completaciones compatible con la API de OpenAI, útil para el desarrollo de aplicaciones locales y la sustitución de llamadas a la nube durante las pruebas.

- Los archivos llamafiles empaquetados están diseñados para ejecutarse en máquinas x86_64 y ARM64 comunes, lo que simplifica la distribución en flotas mixtas.

Limitaciones de Llamafile

- La selección de modelos se limita a lo que se ha empaquetado como un Llamafile.

- El tamaño de los archivos es muy grande, ya que se ha integrado todo el modelo.

Precios de Llamafile

- Gratis y de código abierto

Valoraciones y reseñas de Llamafile

- G2: No hay suficientes reseñas.

- Capterra: No hay suficientes reseñas.

🧠 Dato curioso: Todavía se puede visitar la primera página web. El CERN la aloja literalmente en info.cern.ch, y la denomina «la cuna de la primera página web».

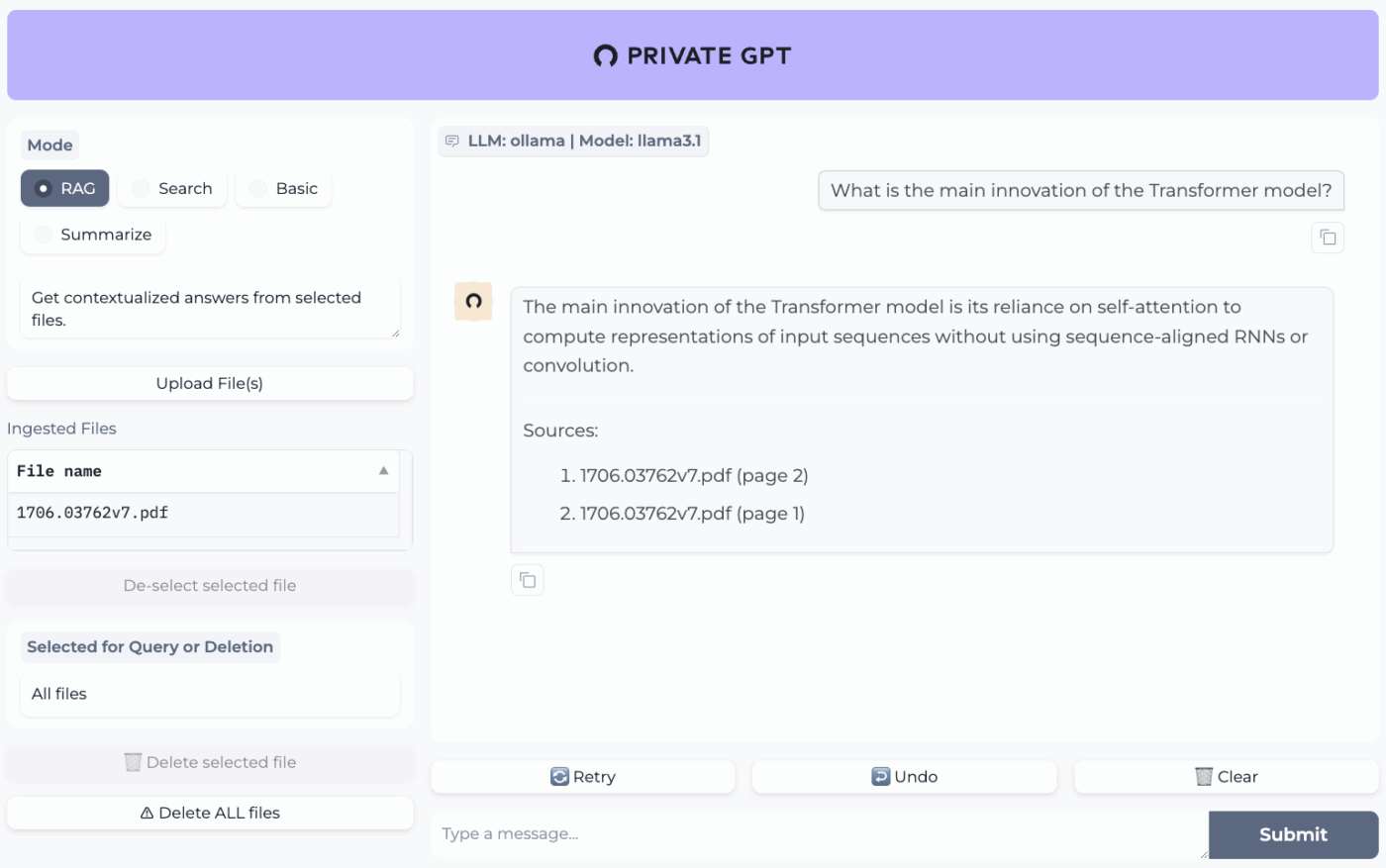

7. PrivateGPT (ideal para preguntas y respuestas sin conexión sobre tus archivos con una pila RAG autohospedada)

PrivateGPT es un proyecto autohospedado y listo para su uso, creado para flujos de trabajo de «chat con tus documentos». Ingesta archivos locales, los indexa y responde a preguntas recuperando el contexto relevante de tu propio contenido, en lugar de depender de la memoria de un chatbot en la nube. El proyecto está diseñado para funcionar completamente sin conexión, con la garantía de que los datos permanecen dentro de tu entorno de ejecución.

Lo que lo diferencia de las aplicaciones de chat offline de uso general es su arquitectura modular. En otras palabras, puedes combinar el LLM, el proveedor de incrustación y el almacén de vectores en función de tu hardware y tus restricciones de privacidad, y luego ejecutar todo detrás de una API + UI local.

Las mejores funciones de PrivateGPT

- Ingesta archivos PDF, DOCX, PPT/PPTX/PPTM, CSV, EPUB, Markdown, JSON, MBOX, IPYNB, imágenes (JPG/PNG/JPEG) e incluso MP3/MP4 utilizando el canal de ingesta integrado.

- Configure perfiles de capa con PGPT_PROFILES (por ejemplo, local, cuda) para combinar varios ajustes y cambiar implementaciones sin reescribir su configuración base.

- Filtrar las respuestas a un subconjunto específico de documentos ingestados utilizando context_filter al llamar a los puntos finales de completaciones contextuales.

Limitaciones de PrivateGPT

- Tiene mayores requisitos de hardware debido a la ejecución simultánea de múltiples componentes.

- La ingesta de varios documentos desde un único archivo (por ejemplo, un PDF que genera un documento por página) puede aumentar el volumen y la complejidad del índice al gestionar cargas de gran tamaño.

Precios de PrivateGPT

- Código abierto

Valoraciones y reseñas de PrivateGPT

- G2: No hay suficientes reseñas.

- Capterra: No hay suficientes reseñas.

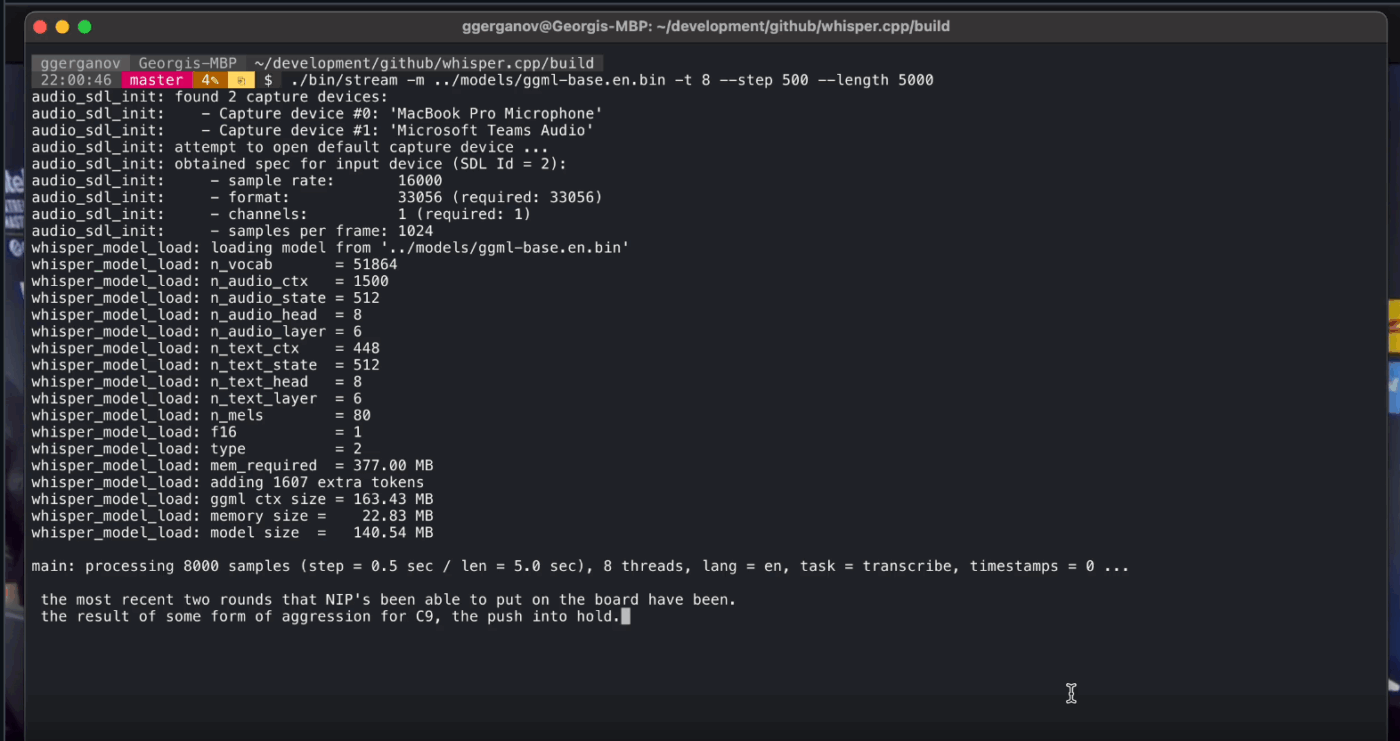

8. Whisper. cpp (Lo mejor para la conversión de voz a texto totalmente sin conexión que se puede integrar en aplicaciones).

Whisper. cpp es una implementación C/C++ de alto rendimiento del modelo de reconocimiento automático de voz Whisper de OpenAI, diseñada para ejecutarse localmente sin dependencias de tiempo de ejecución pesadas. Es popular para procesos de transcripción sin conexión en los que se necesita un binario pequeño y portátil o una biblioteca de estilo C que se pueda incluir en el propio producto.

También es flexible en distintos entornos, con compatibilidad oficial que abarca equipos de escritorio, dispositivos móviles, WebAssembly, Docker e incluso hardware de clase Raspberry Pi, lo que lo hace adecuado para herramientas sin conexión que necesitan ejecutarse en más de un lugar.

Las siglas «cpp» de su nombre indican su enfoque en el rendimiento. Esta implementación es significativamente más rápida y utiliza menos memoria que las alternativas basadas en Python, lo que hace posible la transcripción en tiempo real en ordenadores modernos sin necesidad de una potente GPU.

Whisper. Las mejores funciones de cpp

- Ejecutar la detección de actividad de voz (VAD) como parte del proyecto para segmentar el habla y reducir las transcripciones con ruido y audio vacío en flujos de trabajo de tipo streaming.

- Cuantifique los modelos Whisper para reducir los requisitos de disco y memoria, con múltiples opciones de cuantificación diseñadas para una inferencia local más rápida.

- Compilar con compatibilidad opcional para FFmpeg en Linux para manejar más formatos de entrada además de la ruta básica solo para WAV.

Susurro. Limitaciones de cpp.

- Whisper. La CLI de cpp espera entradas WAV de 16 bits de forma predeterminada, lo que añade un paso de conversión adicional cuando se trabaja con MP3, MP4, M4A u otros formatos comunes.

- No hay rótulos nativos para los hablantes (diarización), lo que dificulta atribuir correctamente las citas en grabaciones con varios hablantes.

Whisper. Precios de cpp

- Código abierto

Whisper. Valoraciones y reseñas de cpp

- G2: No hay suficientes reseñas.

- Capterra: No hay suficientes reseñas.

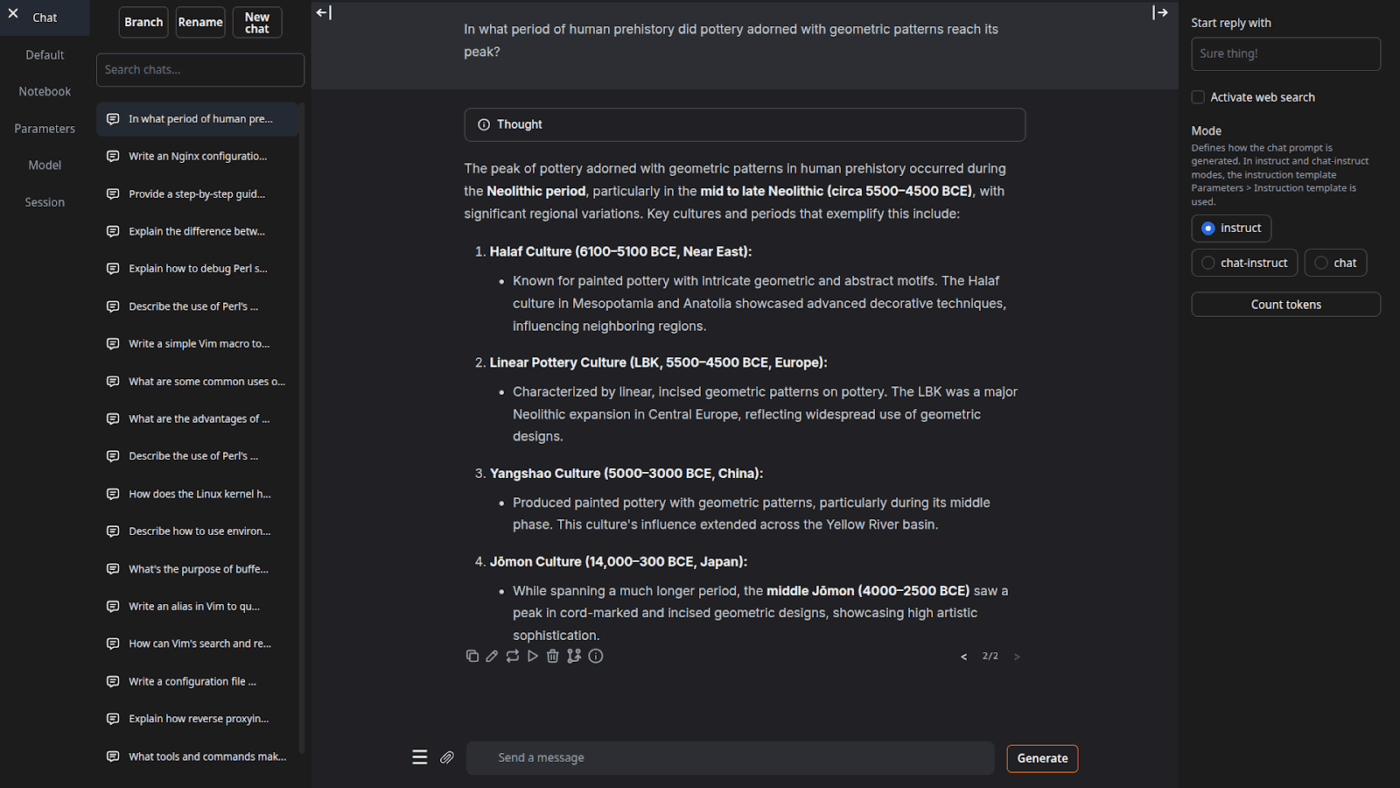

9. Interfaz de usuario web para generación de texto (ideal para usuarios que desean una cabina basada en navegador para LLM locales)

Text Generation Web UI (a menudo denominada «oobabooga») es una interfaz web basada en Gradio para ejecutar modelos locales con un gran énfasis en el control y la experimentación. Se comporta más como un banco de trabajo completo: múltiples backends de modelos, múltiples modos de interacción y muchos controles para el comportamiento de generación.

También se inclina por los flujos de trabajo de «escritor/desarrollador» que muchas herramientas offline omiten, con funciones como la automatización del formato de indicaciones, la generación de estilo cuaderno y la ramificación de conversaciones. Para configuraciones offline que aún necesitan una interfaz de usuario web, es una de las interfaces más configurables de esta categoría.

Las mejores funciones de la interfaz de usuario web para la generación de texto

- Formateo automático de indicaciones mediante plantillas Jinja2, lo que reduce los errores de formato de indicaciones en diferentes familias de modelos.

- Ajusta docenas de ajustes para optimizar los resultados de la IA según tus necesidades específicas, ya sea para escritura creativa, código o juegos de rol.

- Edición de mensajes con navegación por versiones y ramificación de conversaciones, manteniendo múltiples direcciones del mismo chat sin tener que empezar de nuevo.

Limitaciones de la interfaz de usuario web para la generación de texto

- El instalador de un solo clic requiere ~10 GB de espacio en disco y descarga PyTorch, lo que hace que la configuración resulte pesada en equipos con limitaciones de almacenamiento.

- El punto final de incrustaciones compatible con OpenAI utiliza sentence-transformers/all-mpnet-base-v2 con incrustaciones de 768 dimensiones, lo que puede romper las suposiciones en los procesos creados en torno a los valores predeterminados/as de 1536 dimensiones de OpenAI.

Precios de la interfaz de usuario web para la generación de texto

- Código abierto

Valoraciones y reseñas de Text Generation Web UI

- G2: No hay suficientes reseñas.

- Capterra: No hay suficientes reseñas.

10. Llama. cpp (Óptimo para inferencia LLM local de alto rendimiento en CPU y GPU)

Llama. cpp es un motor de inferencia y una cadena de herramientas C/C++ para ejecutar LLM localmente con dependencias mínimas y un rendimiento sólido en un amplio intervalo de hardware. No es tanto una «aplicación de chat» como un entorno de ejecución local en el que se crean flujos de trabajo, ya sea una CLI, un servidor HTTP local o una biblioteca integrada en su propio producto.

Aunque no es una aplicación para el usuario final, Llama. cpp es el motor que impulsa muchas de las herramientas de esta lista, incluidas GPT4All y LM Studio. Introdujo el formato de modelo GGUF, que se ha convertido en el estándar para ejecutar modelos grandes en hardware de consumo al reducir eficazmente su tamaño.

También ofrece enlaces para lenguajes de programación populares como Python y Rust, y su modo servidor puede proporcionar una API compatible con OpenAI.

Las mejores funciones de Llama. cpp

- Inicie un servidor local compatible con la API de OpenAI con una interfaz de usuario web integrada y un punto final /v1/chat/completions utilizando llama-server.

- Ejecuta un modelo de incrustación (e incluso un modelo de reclasificación) desde el mismo servidor para canalizaciones RAG sin conexión utilizando /embedding y /reranking.

- Cuantifique los modelos de 1,5 bits a 8 bits para reducir el uso de memoria y acelerar la inferencia local, y luego acelere las ejecuciones con CUDA/Metal más backends Vulkan/SYCL cuando estén disponibles.

Llama. Limitaciones de cpp

- Llama. cpp no se comercializa como un asistente de escritorio perfeccionado, lo que significa que el uso sin conexión a menudo implica comandos CLI o alojar llama-server, y muchos usuarios dependen de interfaces de usuario de terceros para chatear diariamente.

- La compatibilidad de Llama.cpp con OpenAI no siempre es 1:1 con todas las funciones del cliente OpenAI, y los usuarios informan de discrepancias en torno a parámetros de salida estructurados como response_format en /v1/chat/completions.

Llama. Precios de cpp

- Código abierto

¿Qué opinan los usuarios reales sobre Llama. cpp?

Un crítico de Sourceforge dice:

Genial. Democratizar la IA para todos. ¡Y funciona muy bien!

Genial. Democratizar la IA para todos. ¡Y funciona muy bien!

Convierta los resultados de la IA sin conexión en trabajo real con ClickUp

Elegir la herramienta de IA offline adecuada consiste realmente en encontrar la herramienta que mejor se adapte al trabajo.

Si estás aquí, probablemente estés buscando tres cosas: privacidad, no tener dependencia de Internet y no estar atado a otra suscripción más.

Las herramientas de esta lista cumplen con ese objetivo de diferentes maneras. Es decir, algunas son mejores para escribir y programar, otras para buscar, tomar notas o realizar trabajos creativos.

Pero para los equipos, el mayor reto no es solo ejecutar la IA localmente. Es convertir los resultados de la IA en flujos de trabajo reales.

Con la capacidad de IA de ClickUp integrada en tus tareas, documentos y conocimientos, puedes ver fácilmente los siguientes pasos en el mismo lugar donde se realiza el trabajo (todo ello con seguridad de nivel empresarial).

Prueba ClickUp gratis y descubre cómo es cuando la IA y la ejecución finalmente conviven. ✨

Preguntas frecuentes sobre las herramientas de IA sin conexión

Sí, tras descargar los archivos del modelo, muchas herramientas de IA pueden ejecutarse íntegramente en tu dispositivo sin necesidad de conexión a internet. Esto las hace perfectas para manejar datos confidenciales o trabajar en ubicaciones con mala conectividad.

Los LLM locales procesan todos los datos en tu dispositivo personal, por lo que tu información nunca sale de tu máquina, mientras que la IA basada en la nube envía tus indicaciones a servidores remotos para su procesamiento. Las herramientas locales suelen ser gratis tras su configuración, mientras que la IA en la nube suele implicar cuotas de suscripción, pero puede ofrecer modelos más potentes.

Los modelos más pequeños, con entre 1000 y 3000 millones de parámetros, pueden ejecutarse en la mayoría de los portátiles modernos con 8 GB de RAM. Los modelos más grandes y potentes, con 7000 millones de parámetros o más, funcionan mejor con 16 GB o más de RAM y una GPU dedicada, y los Mac con Apple Silicon y las GPU NVIDIA proporcionan un aumento significativo del rendimiento.

![Las 10 mejores herramientas de IA que funcionan sin conexión en [año]](https://clickup.com/blog/wp-content/uploads/2026/01/image-1298.png)