Der Datenschutz ist ein grundlegendes Menschenrecht. Und dieser Datenschutz erstreckt sich auch auf alle Aspekte der heutigen künstlichen Intelligenz. In einem Bericht von Cisco geben 64 % der Menschen an, dass sie befürchten, bei der Nutzung von KI-Tools versehentlich sensible Informationen freigeben zu können.

Das ist einer der Gründe, warum Offline-KI-Tools immer beliebter werden. Wenn das Modell lokal ausgeführt wird, können Sie schreiben, Code schreiben, zusammenfassen und erstellen – ohne Alles in die Cloud hochladen zu müssen oder bei einem Ausfall des WLANs nicht mehr weiterzukommen.

In dieser Liste stellen wir Ihnen die besten KI-Tools vor, die offline funktionieren, darunter eine Super-App, mit der Sie die Ergebnisse dieser Tools in einem einheitlichen, hochsicheren System organisieren können.

Was sind Offline-KI-Tools?

Offline-KI-Tools sind Softwareanwendungen, die große Sprachmodelle (LLMs) auf Ihrem lokalen Gerät ausführen, ohne dass nach dem Herunterladen des Modells eine Internetverbindung erforderlich ist. Die Daten des Modells werden direkt auf Ihrem Computer gespeichert, sodass die gesamte Verarbeitung oder Inferenz auf Ihrer eigenen CPU oder GPU erfolgt.

Diese Verarbeitung auf dem Gerät hat mehrere wesentliche Schlüssel:

- Vollständiger Datenschutz: Ihre sensiblen Daten verlassen niemals Ihren Computer.

- Keine wiederkehrenden Gebühren: Sobald Sie das tool und das Modell haben, fallen keine Kosten für Abonnements mehr an.

- Funktioniert überall: Sie können es im Flugzeug, in einer abgelegenen Hütte oder während eines Internetausfalls verwenden.

- Volle Kontrolle: Sie entscheiden, welche Modelle Sie verwenden und wie Sie diese konfigurieren möchten.

Die besten Offline-KI-Tools auf einen Blick

Hier ist eine kurze Zusammenfassung der besten Offline-KI-Tools, die derzeit verfügbar sind.

| Werkzeugname | Wichtigste Features | Am besten geeignet für | Preise* |

| ClickUp | Offline-Modus für Aufgaben und Erinnerungen, ClickUp Brain MAX mit Talk-to-Text, Unternehmenssuche über verbundene Apps, Dokumente und Wissensmanagement, Automatisierungen sowie Integrationen und API | Teams, die Offline-Erfassung sowie Online-Ausführung, Governance und KI-Kontext in einem Workspace benötigen | Free Forever; benutzerdefinierte Anpassung für Unternehmen verfügbar |

| GPT für alle | Lokaler Chat mit offenen Modellen, LocalDocs für private Dokumenten-Fragen und Antworten, Modellsuche und -herunterladung in der App, OpenAI-kompatibler lokaler API-Server | Datenschutz-bewusste Benutzer, die einen einfachen Offline-Desktop-Chatbot mit lokalen Dokumenten wünschen | Free-Plan verfügbar; kostenpflichtige Pläne beginnen bei 40 $/Benutzer/Monat |

| LM Studio | Modellsuche und -herunterladungen, Chat-Benutzeroberfläche plus lokales RAG, OpenAI-kompatibler Server oder REST-API, Voreinstellungen und Leistungsoptimierung | Entwickler und Power-Benutzer, die eine ausgefeilte Offline-Modell-Workbench wünschen | Free |

| Ollama | Ein Befehlsmodell, lokale REST-API mit Streaming, Modelldateien für wiederverwendbare Konfigurationen und Einbettungen für RAG-Pipelines | Entwickler, die eine CLI-first lokale Laufzeitumgebung mit einer starken API-Schicht wünschen | Free-Plan verfügbar; kostenpflichtige Pläne beginnen bei 20 $/Monat |

| Jan. /AI | Offline-Benutzeroberfläche im ChatGPT-Stil, Assistenten und MCP-Support, Erweiterungen für zusätzliche Funktionen und optionale OpenAI-kompatible Anbieter | Nicht-technische Benutzer, die einen übersichtlichen Offline-Assistenten mit benutzerdefinierten Anpassungsmöglichkeiten wünschen | Kostenlos und quelloffen |

| Lama-Datei | Einzelnes ausführbares Modellpaket, portable Verteilung über verschiedene Betriebssysteme hinweg, lokaler Servermodus mit Web-UI und API, minimale Abhängigkeiten zur Laufzeit | Benutzer, die eine portable KI-Datei ohne Installation wünschen, die sie überall ausführen können | Kostenlos und quelloffen |

| PrivateGPT | Selbst gehostete Dokumentenerfassung und Indexierung, Offline-RAG-Fragen und Antworten, Kontextfilterung nach Dokument, modulares LLM und Vektorspeicher-Stack | Teams, die Offline-Fragen und Antworten zu internen Dateien mit einer kontrollierbaren RAG-Pipeline benötigen | Kostenlos und quelloffen |

| Flüstern. cpp | Lokale Sprach-zu-Text-Umwandlung, quantisierte Modelle für geringeren Ressourcenverbrauch, VAD-Support, optionale FFmpeg-Verarbeitung für weitere Formate | Benutzer, die eine vollständig offline verfügbare Transkription benötigen, die sie in Apps einbetten können | Kostenlos und quelloffen |

| Textgenerierung Web-Benutzeroberfläche | Browser-Benutzeroberfläche für lokale Modelle, Jinja2-Prompt-Vorlagen, Generierungssteuerungen, Chat-Verzweigungen und Bearbeitung der Nachrichten | Benutzer, die eine maximale benutzerdefinierte Anpassung in einer lokalen Weboberfläche wünschen | Kostenlos und quelloffen |

| llama.cpp | Hochleistungsfähige Inferenz-Engine, umfassende Quantisierungsunterstützung, lokaler Server mit Endpunkten im OpenAI-Stil, Einbettungen und Support für Reranking | Entwickler, die benutzerdefinierte Offline-KI-Apps oder Backends erstellen | Kostenlos und quelloffen |

Wie wir Software bei ClickUp bewerten

Unser Redaktionsteam folgt einem transparenten, wissenschaftlich fundierten und herstellerneutralen Prozess, sodass Sie darauf vertrauen können, dass unsere Empfehlungen auf dem tatsächlichen Wert des Produkts basieren.

Hier finden Sie eine detaillierte Übersicht darüber, wie wir bei ClickUp Software bewerten.

Was Sie bei den besten KI-Tools, die offline funktionieren, beachten sollten

Die Bewertung von Offline-KI-Tools kann technisch und verwirrend sein, sodass Sie möglicherweise ein Tool auswählen, das auf Ihrem Computer gar nicht läuft. Das Wichtigste, was Sie berücksichtigen sollten, ist, was Sie erreichen möchten. Ein Entwickler, der eine KI-gestützte App erstellt, hat ganz andere Anforderungen als jemand, der lediglich einen privaten, offline verfügbaren KI-Chatbot als Schreibhilfe nutzen möchte.

Hier sind die Schlüssel zur Bewertung:

- Einfaches Setup: Sind technische Kenntnisse und die Arbeit mit der Befehlszeile erforderlich oder handelt es sich um ein einfaches Ein-Klick-Setup?

- Auswahl der Modelle: Können Sie problemlos aus einer Vielzahl von Modellen auswählen oder sind Sie auf wenige Modelle beschränkt?

- Datenschutzgarantien: Verarbeitet das tool alle Daten lokal oder gibt es versteckte Cloud-Komponenten?

- Hardwareanforderungen: Funktioniert es auf Ihrem aktuellen Rechner einwandfrei oder benötigen Sie ein Upgrade?

- Integrationsmöglichkeiten: Kann es mit Ihren anderen Tools verbunden werden oder handelt es sich um eine vollständig eigenständige Anwendung?

- Geeignet für folgende Anwendungsfälle: Ist es zum Chatten, zum Fragenstellen über Ihre Dokumente, zur Transkription von Audioaufnahmen oder zur Generierung von Code konzipiert?

Die 10 besten KI-Tools, die offline funktionieren

Hier ist eine Ansicht der besten Offline-Tools für KI 👇

1. ClickUp (Ideal, um Aufgaben, Dokumente und KI-Kontext sowohl offline als auch online an einem Ort zu verwalten)

ClickUp, der weltweit erste konvergierte KI-Workspace, basiert auf den Blöcken der „Offline-KI“, die nicht bei der Generierung einer Antwort Halt macht. Denn Sie benötigen nach wie vor einen Ort, an dem diese Ausgabe zu einer Entscheidung, einer Aufgabe und einem nächsten Schritt wird, der nicht in Dateien und Chats verschwindet.

Im Gegensatz zu vielen Offline-Setups, die mit langwierigen Installationen und Tool-Stitching verbunden sind, bietet Ihnen ClickUp eine komplette Ausführungsebene an einem Ort, wobei die KI auf derselben Workspace-Umgebung basiert.

Zunächst einmal gibt es den ClickUp-Offline-Modus, der sich automatisch einschaltet und die Arbeit auch dann weiterlaufen lässt, wenn Sie offline sind. Das bedeutet, dass alle Ihre Aufgaben, Erinnerungen und Notizen auch offline zugänglich bleiben und Sie bei Bedarf weitere hinzufügen können. Sobald Sie wieder online sind, werden neue Aufgaben und Erinnerungen automatisch mit Ihrem ClickUp-Workspace synchronisiert (verabschieden Sie sich von verlorenen Kontexten 👋).

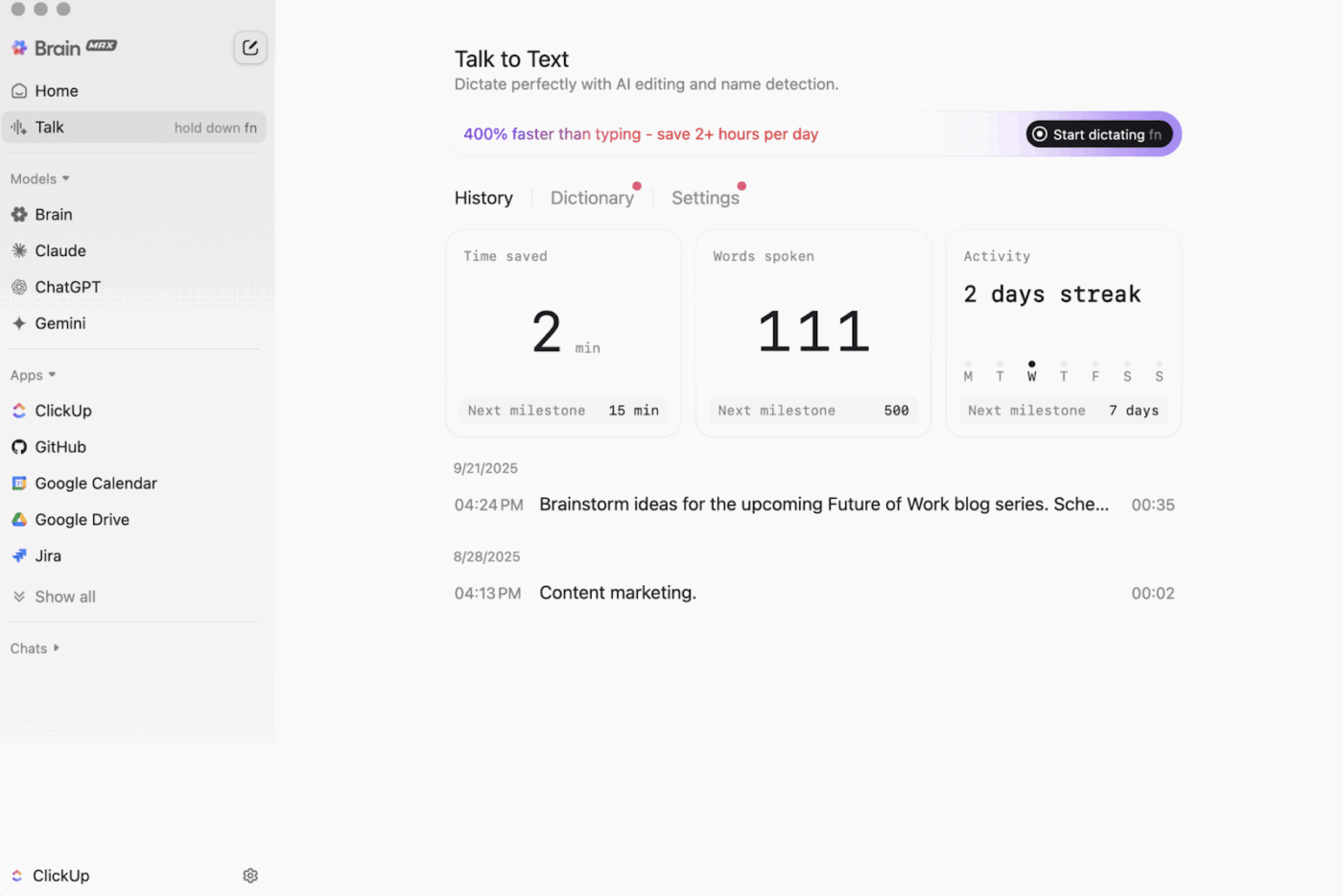

Dann gibt es noch ClickUp Brain MAX , den datenschutzorientierten Desktop-KI-Begleiter, der Ihren gesamten Workspace, verbundene Apps und sogar das Internet speichern und durchsuchen kann.

Mit Talk-to-Text kann Brain MAX Ihre Stimme freihändig in Text umwandeln. Dazu gehört das Verfassen einer E-Mail, das Schreiben eines Dokuments oder das Erfassen einer kurzen Aktualisierung, während Sie unterwegs sind.

Brain MAX bietet Ihnen außerdem Universal AI, eine universelle KI, die für den Austausch mit den neuesten KI-Modellen für Codierung, Schreiben, komplexes Denken und vieles mehr entwickelt wurde. Das bedeutet, dass Sie Fragen an die besten KI-Modelle an einem Ort stellen können, darunter ClickUp Brain sowie Optionen wie OpenAI, Claude und Gemini, ohne zwischen verschiedenen Tools umschalten zu müssen.

Darüber hinaus bietet ClickUp Security zusätzliche Sicherheitsvorkehrungen, die bei Offline-Tools häufig fehlen. Dazu gehören Verschlüsselung, detaillierte Berechtigungen und Verwaltungskontrollen wie SSO, Provisioning und Audit-Protokolle, die speziell für Teams entwickelt wurden, die Sicherheit auf Enterprise-Niveau benötigen.

ClickUp AI Knowledge Management ist eine große Hilfe beim Übergang von „offline zu online“. Es bietet Ihrem Team einen hub, um verschiedene Ressourcen in Dokumenten und Wikis zu speichern, und nutzt dann ClickUp Brain, um sofortige Antworten aus Ihrem gesamten Workspace zu beziehen, sodass der richtige Kontext verfügbar ist, sobald die Arbeit wieder aufgenommen wird.

🎬 Agenten in Aktion: Nutzen Sie Super Agents, um synchronisierte Arbeit in nächste Schritte umzuwandeln!

ClickUp Super Agents sind KI-gestützte Teammitglieder, die Sie erstellen und benutzerdefiniert anpassen können, um mehrstufige Workflows in Ihrem ClickUp-Workspace auszuführen. Sie können bestimmte Auslöser, Anweisungen und den Zugriff auf Tools konfigurieren, um sicherzustellen, dass sie innerhalb der von Ihnen festgelegten Grenzen agieren.

Beispielsweise kann ein Super Agent nach der Synchronisierung von Offline-Aufgaben die neuen Elemente scannen, die Änderungen zusammenfassen, Schritte ableiten, einen Entwurf für eine Aktualisierung erstellen und diesen zur Überprüfung an den richtigen Eigentümer weiterleiten.

Und da Super Agents steuerbar sind, können Sie mit Berechtigungen kontrollieren, worauf sie zugreifen können, und ihre Aktivitäten überprüfen. 🔐

Die besten Features von ClickUp

- Finden Sie alles in Ihren Tools: Sortieren und durchsuchen Sie Ihren gesamten Arbeitsbereich sowie verbundene Apps von einem Ort aus mit ClickUp Enterprise Search.

- Eine echte Wissensdatenbank aufbauen: Erstellen Sie mit ClickUp Docs Wikis und Dokumentationen mit verschachtelten Seiten, Vorlagen, KI-Unterstützung und vielem mehr.

- Bleiben Sie in Verbindung: Durchführen Sie die Synchronisierung Ihrer Arbeit mit Tools wie Slack und GitHub, ohne ClickUp zu verlassen – dank ClickUp-Integrationen.

- Erstellen Sie benutzerdefinierte Workflows: Verwenden Sie die ClickUp-API mit persönlichen Tokens oder OAuth 2.0, um maßgeschneiderte Automatisierungen und Integrationen zu ermöglichen.

- Automatisieren Sie Ihren Stack: Verwenden Sie als Auslöser für Aktionen wie die Zuweisung von Eigentümern, die Aktualisierung des Status oder die Einleitung von Übergaben ClickUp Automatisierungen basierend auf Änderungen der Aufgaben.

Einschränkungen von ClickUp

- Aufgrund des breiten Bereichs an Features kann es für einige Benutzer zu einer gewissen Einarbeitungszeit kommen.

ClickUp-Preise

ClickUp-Bewertungen und Rezensionen

- G2: 4,7/5 (über 10.000 Bewertungen)

- Capterra: 4,6/5 (über 4.000 Bewertungen)

Was sagen echte Benutzer über ClickUp?

Ein G2-Rezensent sagt:

Agile Boards, Integrationen und benutzerdefinierte Anpassungsmöglichkeiten. Außerdem gefällt mir, dass ich einfach offline gehen und trotzdem weiter an Aufgaben arbeiten kann. Darüber hinaus kann ich E-Mails an beliebige Listen senden und Aufgaben automatisch erstellen lassen. Der Editor ist fantastisch, funktioniert sowohl im MD-Modus als auch mit Verknüpfungen und ermöglicht eine Inline-Vorschau des Inhalts.

Agile Boards, Integrationen und benutzerdefinierte Anpassungsmöglichkeiten. Außerdem gefällt mir, dass ich einfach offline gehen und trotzdem weiter an Aufgaben arbeiten kann. Darüber hinaus kann ich E-Mails an beliebige Listen senden und Aufgaben automatisch erstellen lassen. Der Editor ist fantastisch, funktioniert sowohl im MD-Modus als auch mit Verknüpfungen und ermöglicht eine Inline-Vorschau des Inhalts.

2. GPT4All (Am besten geeignet für Privat-KI-Chats mit lokalen LLMs)

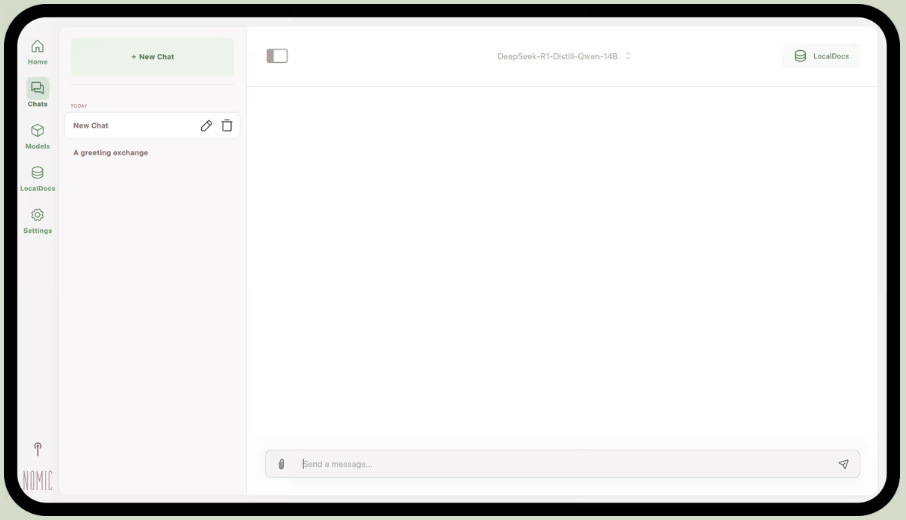

GPT4All ist Teil von Nomic.ai und eine Desktop-App, mit der Sie Open-Source-Sprachmodelle direkt auf Ihrem Computer ausführen können, sodass Sie mit einem KI-Assistenten chatten können, ohne auf einen Internetzugang oder Cloud-API-Aufrufe angewiesen zu sein. Es wurde für Personen entwickelt, die ein „Local-First”-Setup wünschen, bei dem Eingabeaufforderungen, Antworten und Dateien auf dem Gerät verbleiben.

Das beste Feature ist LocalDocs, das eine Form der retrieval-augmented generation nutzt, um Ihnen zu ermöglichen, privat mit Ihren eigenen Dokumenten zu chatten. Sie können die App auf einen Ordner mit PDF- oder Textdateien verweisen, woraufhin sie eine lokale Wissensdatenbank erstellt, an die Sie Fragen stellen können.

GPT4All enthält auch eine kuratierte Bibliothek beliebter Modelle wie Llama und Mistral, die Sie direkt über die App herunterladen können.

Die besten Features von GPT4All

- Starten Sie einen lokalen API-Server (OpenAI-kompatibel), um GPT4All-Modelle in anderen Apps und Automatisierungen zu verwenden.

- Suchen, vergleichen und herunterladen Sie GGUF-Modelle innerhalb der App, mit Sortieroptionen wie Likes, Downloads und Upload-Datum.

- Kontextlänge, maximale Ausgabelänge, Top-p, Top-k, Wiederholungsstrafe, CPU-Threads und sogar GPU-Layer-Offloading (plus Metal-Support auf Apple Silicon) anpassen

Limitierungen von GPT4All

- Die Leistung ist stark von der Hardware Ihres Computers abhängig.

- Das Indexieren großer Dokumentensammlungen kann langsam sein.

GPT4All-Preise

- Kostenlose Desktop-App

- Geschäft: 40 $ pro Benutzer und Monat (Nomic KI)

- Unternehmen: Benutzerdefinierte Preisgestaltung (Nomic KI)

GPT4All Bewertungen und Rezensionen

- G2: Nicht genügend Bewertungen

- Capterra: Nicht genügend Bewertungen

Was sagen echte Benutzer über GPT4All?

Ein Reddit-Benutzer sagt:

Das ist das beste Programm, das ich mit RAG ausprobiert habe, es übertrifft alles andere und ist sogar einfacher als LM Studio. Mir gefällt, wie man es einem Ordner zuordnet und es die Nachverfolgung der Änderungen für einen übernimmt. Es ist noch nicht ganz ausgereift, wie die anderen auch, aber es wird kurzfristig mein Standard-Programm sein.

Das ist das beste Programm, das ich mit RAG ausprobiert habe, es übertrifft alles andere und ist sogar einfacher als LM Studio. Mir gefällt, wie man es einem Ordner zuordnet und es die Änderungen für einen verfolgt und verarbeitet. Es ist noch nicht ganz ausgereift, wie die anderen auch, aber es wird kurzfristig mein Standard-Programm sein.

📮 ClickUp Insight: 88 % unserer Umfrageteilnehmer nutzen KI für ihre persönlichen Aufgaben, doch über 50 % scheuen sich davor, sie bei der Arbeit einzusetzen. Die drei größten Hindernisse? Mangelnde nahtlose Integration, Wissenslücken oder Sicherheitsbedenken. Aber was wäre, wenn KI in Ihren Arbeitsbereich integriert und bereits sicher wäre? ClickUp Brain,

Der integrierte KI-Assistent von ClickUp macht dies möglich. Er versteht Eingaben in einfacher Sprache und löst damit alle drei Bedenken hinsichtlich der Einführung von KI, während er Ihren Chat, Ihre Aufgaben, Dokumente und Ihr Wissen im gesamten Workspace miteinander verbindet. Finden Sie Antworten und Erkenntnisse mit einem einzigen Klick!

3. LM Studio (Am besten geeignet für eine ausgefeilte Offline-Modell-Workbench mit Leistungsoptimierung)

über LM Studio

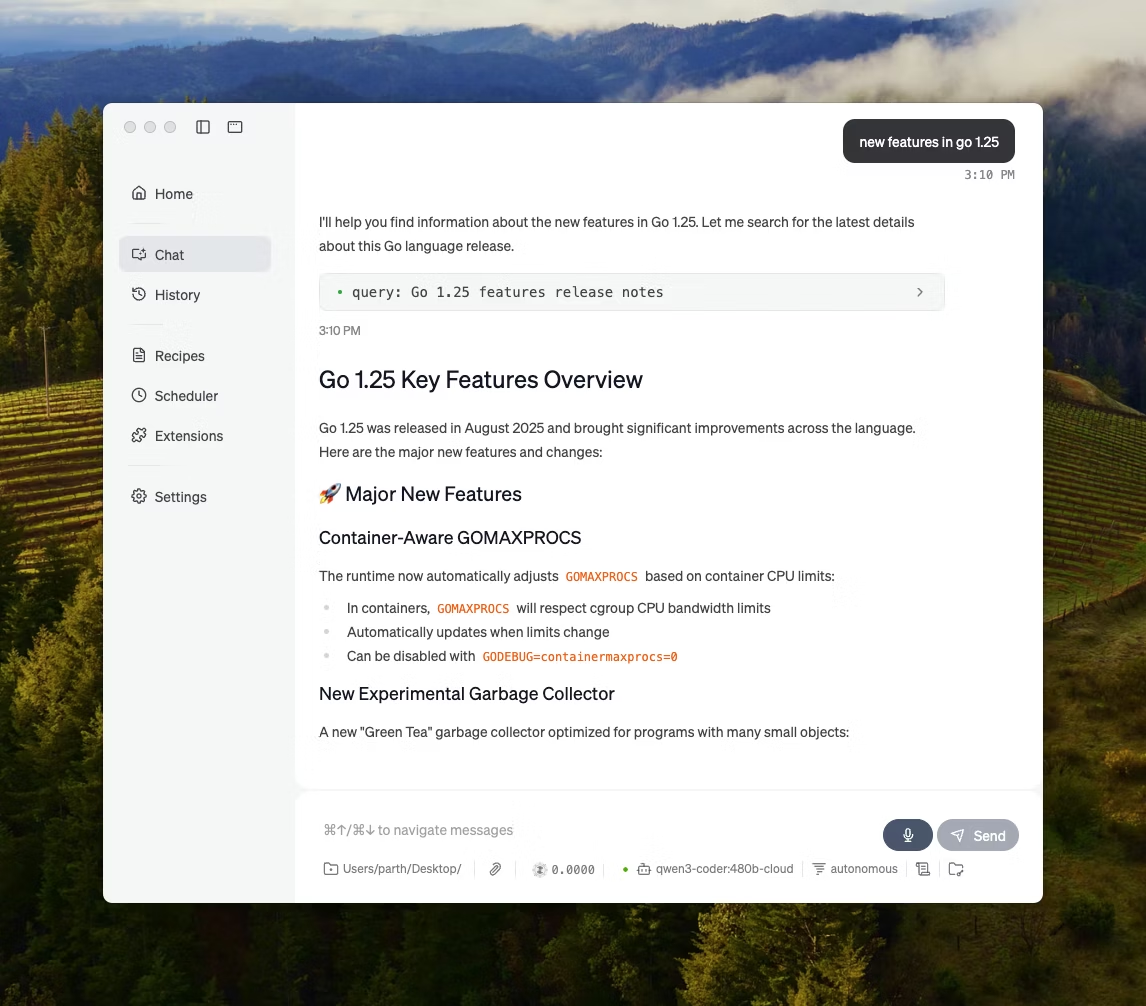

LM Studio ist eine lokale KI-Desktop-App, die darauf ausgelegt ist, Open-Source-Modelle in einer Benutzeroberfläche zu finden, zu testen und auszuführen, ohne auf ein Terminal angewiesen zu sein. Sie ist auf Experimente ausgerichtet, wie z. B. die Auswahl eines Modells, dessen lokale Ausführung und die Iteration von Eingabeaufforderungen und Einstellungen mit einer engeren Feedbackschleife als bei den meisten CLI-first-Setups.

Es unterstützt auch das Chatten mit Dokumenten vollständig offline (lokales RAG), wobei Sie Dateien als Anhänge an eine Unterhaltung anhängen und diese während der Antworten referenzieren können. Das macht es ideal für Offline-Recherchen, Studiennotizen oder interne Dokumenten-Workflows, bei denen Uploads nicht möglich sind.

LM Studio bietet Ihnen außerdem umfassende Kontrollmöglichkeiten über die Funktionsweise der KI, mit Optionen zur Anpassung von Temperatur, Kontextlänge und GPU-Auslastung.

Die besten Features von LM Studio

- Verwenden Sie den OpenAI-Kompatibilitätsmodus oder die eigene REST-API von LM Studio, je nachdem, was Ihre App erwartet.

- LM Studio bietet sowohl JavaScript- als auch Python-SDK-Optionen für die Erstellung lokaler Workflows auf Basis Ihrer Modelle.

- Speichern Sie eine Systemaufforderung + Parameter als Voreinstellung und verwenden Sie diese dann in verschiedenen Chats wieder (Voreinstellungen können auch aus einer Datei/URL importiert und über den LM Studio hub freigegeben werden).

Limitierungen von LM Studio

- LM Studio kann den Computer während der Ausführung von DeepSeek R1 32B zum Absturz bringen.

- Einige Benutzer beanstanden die App aufgrund ihres nicht geprüften Closed-Source-Codes als Problem für die Sicherheit der Daten und den Datenschutz.

Preise von LM Studio

- Kostenlos für den privaten und beruflichen Gebrauch

Bewertungen und Rezensionen zu LM Studio

- G2: Nicht genügend Bewertungen

- Capterra: Nicht genügend Bewertungen

Was sagen echte Benutzer über LM Studio?

Ein Reddit-Benutzer sagt:

Es ist großartig. Es funktioniert einfach, ist superleicht zu bedienen und sofort einsatzbereit. Hat die schönste Benutzeroberfläche aller Mitbewerber.

Es ist großartig. Es funktioniert einfach, ist superleicht zu bedienen und sofort einsatzbereit. Hat die schönste Benutzeroberfläche aller Mitbewerber.

4. Ollama (Am besten geeignet für die Ausführung lokaler LLMs mit einer einfachen CLI + lokalem Server)

Ollama ist ein lokaler Modell-Runner, der sich eher wie eine LLM-Laufzeitumgebung als wie eine eigenständige Chat-App verhält. Es ist terminalorientiert und dafür ausgelegt, offene Modelle mit schnellen Befehlen (wie „ollama run llama3“) abzurufen und auszuführen und sie dann über einen lokalen Dienst verfügbar zu machen, auf den andere Schnittstellen zugreifen können.

Die Stärke von Ollama liegt in seiner REST-API. Sobald Ollama im Hintergrund läuft, kann jede Anwendung über einfache HTTP-Anfragen mit ihm kommunizieren. Dies hilft Ihnen dabei, KI-Features in Ihre eigene Software zu integrieren.

Ollama bietet auch eine Bibliothek mit beliebten Modellen, die mit einem Befehl heruntergeladen werden können, und Sie können benutzerdefinierte Modellkonfigurationen erstellen, die wie Dockerfiles für KI sind.

Die besten Features von Ollama

- Erstellen Sie wiederverwendbare, versionierbare Modellrezepte (Auswahl des Basismodells, Prompt-Vorlagen, Systemmeldungen, Parameter, Adapter) mithilfe einer Modelfile.

- Modelle über Endpunkte wie Chatten/Generieren mit optionalem Streaming für die Echtzeit-Token-Ausgabe in Apps und Skripten ausführen

- Generieren Sie Einbettungen für semantische Such- und Abruf-Pipelines mithilfe der Einbettungsfunktion von Ollama und empfohlenen Einbettungsmodellen.

Einschränkungen von Ollama

- Es verfügt über keine integrierte grafische Benutzeroberfläche, sodass nicht-technische Benutzer ein separates Frontend-Tool benötigen.

- Die macOS-Desktop-App von Ollama reagiert möglicherweise nicht, wenn sie offline ist, selbst wenn die Modelle bereits heruntergeladen wurden, während die CLI weiterhin funktioniert.

Ollama-Preise

- Free

- Pro: 20 $/Monat

- Maximal: 100 $/Monat

Ollama Bewertungen und Rezensionen

- G2: Nicht genügend Bewertungen

- Capterra: Nicht genügend Bewertungen

Was sagen echte Benutzer über Ollama?

Ein Rezensent von Producthunt sagt:

Einfach zu implementieren und zu verwalten. Ollama macht die Ausführung lokaler LLMs zum Kinderspiel. Kombinieren Sie es mit OpenWebUI für ein ultimatives Erlebnis.

Einfach zu implementieren und zu verwalten. Ollama macht die Ausführung lokaler LLMs so einfach. Kombinieren Sie es mit OpenWebUI für das ultimative Erlebnis.

🧠 Interessante Tatsache: Die Sprach-zu-Text-Umwandlung begann zunächst nur mit Ziffern. AUDREY (1952) von Bell Labs erkannte die Ziffern 0–9, und auf einem Konto wurde Notiz davon gemacht, dass das System am besten funktionierte, wenn die Ziffern von seinem Erfinder gesprochen wurden.

5. Jan. KI (Am besten geeignet für einen Offline-Assistenten im ChatGPT-Stil, bei dem Datenschutz an erster Stelle steht)

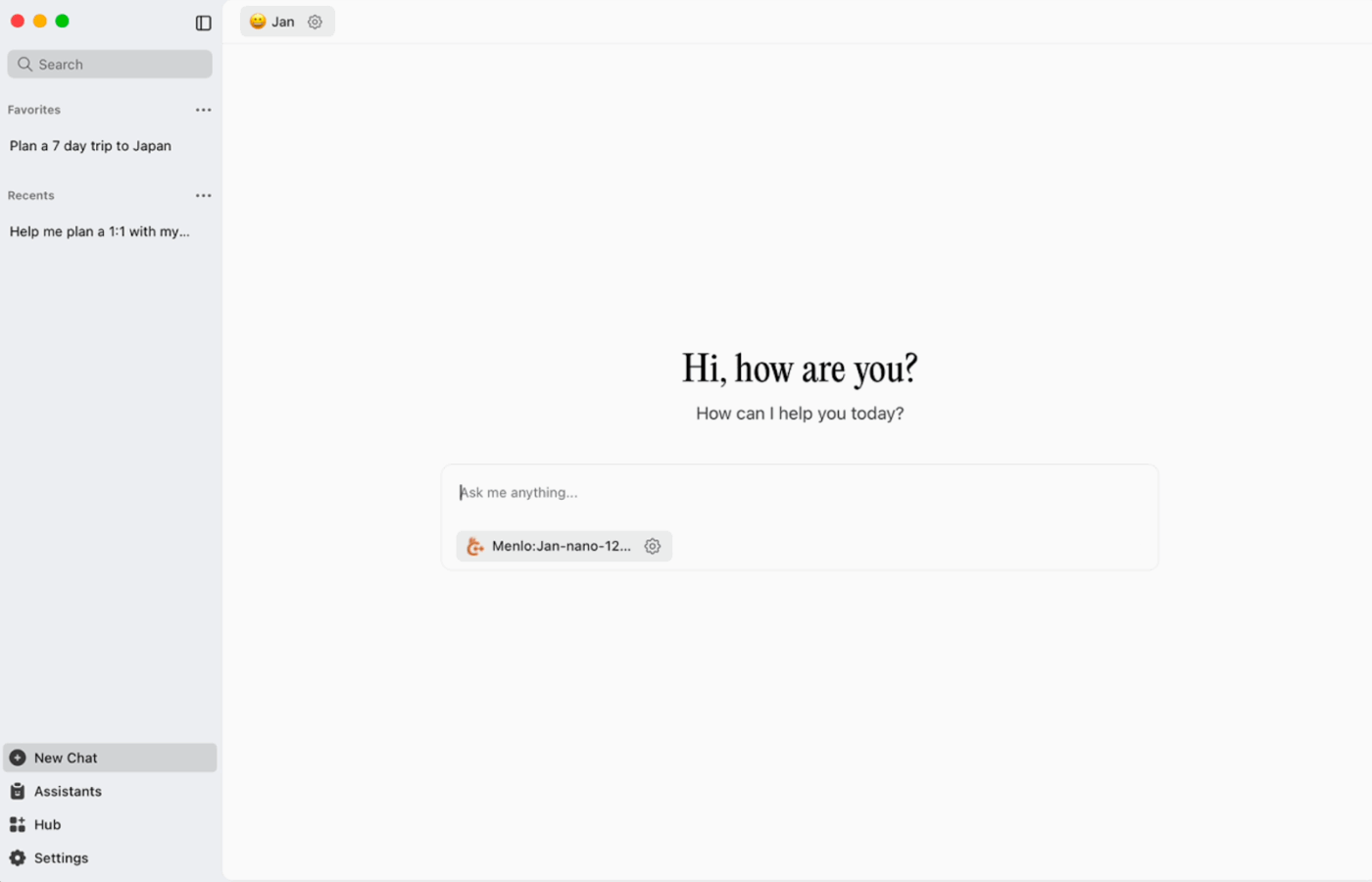

Jan. ai ist ein Open-Source-Desktop-Assistent, der eine ChatGPT-ähnliche Chat-Erfahrung auf macOS, Windows und Linux bietet, wobei die lokale Nutzung als Standard eingestellt ist. Er läuft auf dem Gerät, wenn Sie es wünschen, während der Verlauf der Unterhaltungen und die Nutzungsdaten lokal gespeichert werden und Ihren Computer nicht verlassen.

Es unterstützt die lokale Ausführung von Open-Source-Modellen und ermöglicht optional auch Verbindungen zu Remote-Anbietern wie OpenAI-kompatiblen APIs. Dadurch ist es flexibel, wenn die Offline-Nutzung Priorität hat, aber manchmal auch Cloud-Zugriff erforderlich ist.

Jan. ai beste Features

- Erstellen Sie Assistenten mit eigenen Anweisungen und Einstellungen und wechseln Sie dann über die Registerkarte „Assistenten“ zwischen ihnen, anstatt jedes Mal die Eingabeaufforderungen neu zu schreiben.

- Stellen Sie die Verbindung zwischen Jan und MCP-Tools und Datenquellen mithilfe eines offenen Standards her, der für toolbasierte Workflows entwickelt wurde.

- Installieren Sie Erweiterungen, um neue Features wie die Websuche oder einen Code-Interpreter hinzuzufügen. Dieser modulare Ansatz ermöglicht Ihnen einen einfachen Einstieg und die schrittweise Erweiterung der Leistungsfähigkeit.

Jan. ai Limitierungen

- Jan kann das Laden einer Modelldatei zulassen, die noch nicht vollständig heruntergeladen wurde, was zu verwirrenden oder inkonsistenten Verhaltensweisen führen kann, bis die Datei abgeschlossen ist.

- Das Aktivieren der API kann zu Störungen bei Thread-Chats führen, und grundlegende Endpunkte wie „geladenes Modell abrufen“ oder „Modell austauschen“ funktionieren möglicherweise nicht reibungslos.

Jan. KI-Preisgestaltung

- Open Source

Jan. ai Bewertungen und Rezensionen

- G2: Nicht genügend Bewertungen

- Capterra: Nicht genügend Bewertungen

Was sagen echte Benutzer über Jan. KI?

Ein Reddit-Benutzer sagt:

Jan. ai ist meine bevorzugte lokale KI-App. Sie ist großartig.

Jan. ai ist meine bevorzugte lokale KI-App. Sie ist großartig.

6. Llamafile (Am besten geeignet, um ein LLM in eine portable ausführbare Datei zu verpacken)

Llamafile ist ein von Mozilla geleitetes Projekt, das eine vollständige Open-Source-LLM in einer einzigen ausführbaren Datei bündelt. Anstatt eine Laufzeitumgebung zu installieren, Abhängigkeiten zu verwalten oder eine separate Benutzeroberfläche zu integrieren, laden Sie eine einzige Datei herunter und führen sie wie eine App aus.

Der Kerngedanke ist die Verteilung. Eine „Llamafile“-Datei enthält die Modellgewichte sowie eine kompilierte Laufzeitumgebung, die für die Ausführung auf mehreren Betriebssystemen mit minimalem Setup entwickelt wurde. Dies ist besonders praktisch, wenn ein Offline-Tool mit Teamkollegen, Studenten oder Kunden freigegeben werden muss, die sich nicht mit der Fehlerbehebung bei Installationen befassen möchten.

Die besten Features von Llamafile

- Llamafile kombiniert llama.cpp mit Cosmopolitan Libc, um eine umfassende Binärportabilität zu unterstützen und plattformspezifische Paketierungsarbeit zu reduzieren.

- Der Servermodus bietet eine Web-GUI sowie einen mit der OpenAI-API kompatiblen Endpunkt für Vervollständigungen, der für die lokale App-Entwicklung und das Austauschen von Cloud-Aufrufen während des Testens nützlich ist.

- Verpackte Lama-Dateien sind für die Ausführung auf gängigen x86_64- und ARM64-Rechnern ausgelegt, was die Verteilung über gemischte Flotten hinweg vereinfacht.

Limitierungen von Llamafile

- Die Auswahl der Modelle ist auf das beschränkt, was als Llamafile gepackt wurde.

- Die Größen der Dateien sind sehr groß, da das gesamte Modell eingebettet ist.

Preise für Llamafile

- Kostenlos und quelloffen

Llamafile Bewertungen und Rezensionen

- G2: Nicht genügend Bewertungen

- Capterra: Nicht genügend Bewertungen

🧠 Interessante Tatsache: Die erste Website kann noch immer besucht werden. Das CERN hostet sie unter info.cern.ch und bezeichnet sie als „Startseite der ersten Website”.

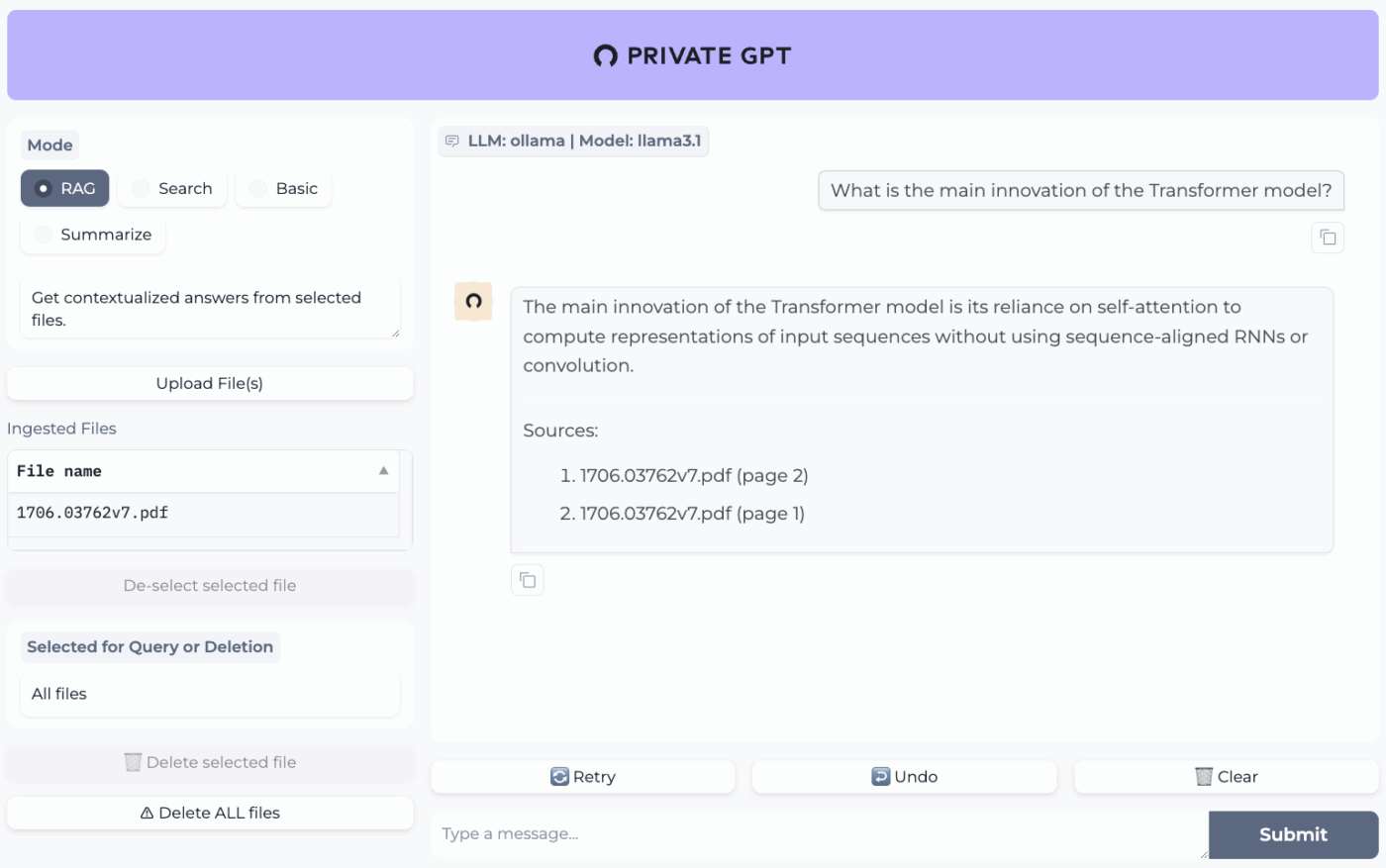

7. PrivateGPT (Am besten geeignet für Offline-Fragen und Antworten zu Ihren Dateien mit einem selbst gehosteten RAG-Stack)

PrivateGPT ist ein produktionsreifes, selbst gehostetes Projekt, das für Workflows zum „Chatten mit Ihren Dokumenten” entwickelt wurde. Es nimmt lokale Dateien auf, indexiert sie und beantwortet Fragen, indem es relevante Kontexte aus Ihren eigenen Inhalten abruft, anstatt sich auf den Speicher eines Cloud-Chatbots zu verlassen. Das Projekt ist so konzipiert, dass es vollständig offline läuft, wobei die Daten in Ihrer Ausführungsumgebung verbleiben.

Was es von allgemeinen Offline-Chat-Apps unterscheidet, ist die modulare Architektur. Mit anderen Worten: Sie können das LLM, den Anbieter für Embeddings und den Vektorspeicher entsprechend Ihrer Hardware und Datenschutzanforderungen kombinieren und dann alles hinter einer lokalen API + UI ausführen.

Die besten Features von PrivateGPT

- Importieren Sie PDFs, DOCX, PPT/PPTX/PPTM, CSV, EPUB, Markdown, JSON, MBOX, IPYNB, Bilder (JPG/PNG/JPEG) und sogar MP3/MP4 mithilfe der integrierten Import-Pipeline.

- Konfigurieren Sie Profile mit PGPT_PROFILES (z. B. local,cuda), um mehrere Einstellungen zusammenzuführen und Bereitstellungen zu wechseln, ohne Ihre Basiskonfiguration neu schreiben zu müssen.

- Filtern Sie Antworten auf eine bestimmte Teilmenge der erfassten Dokumente mithilfe von context_filter, wenn Sie Endpunkte für kontextbezogene Vervollständigungen aufrufen.

Limit von PrivateGPT

- Hat höhere Hardwareanforderungen, da mehrere Komponenten gleichzeitig ausgeführt werden.

- Die Erfassung mehrerer Dokumente aus einer einzigen Datei (z. B. eine PDF-Datei, die ein Dokument pro Seite generiert) kann das Indexierungsvolumen und die Komplexität bei der Verwaltung großer Uploads erhöhen.

Preise für PrivateGPT

- Open Source

PrivateGPT-Bewertungen und Rezensionen

- G2: Nicht genügend Bewertungen

- Capterra: Nicht genügend Bewertungen

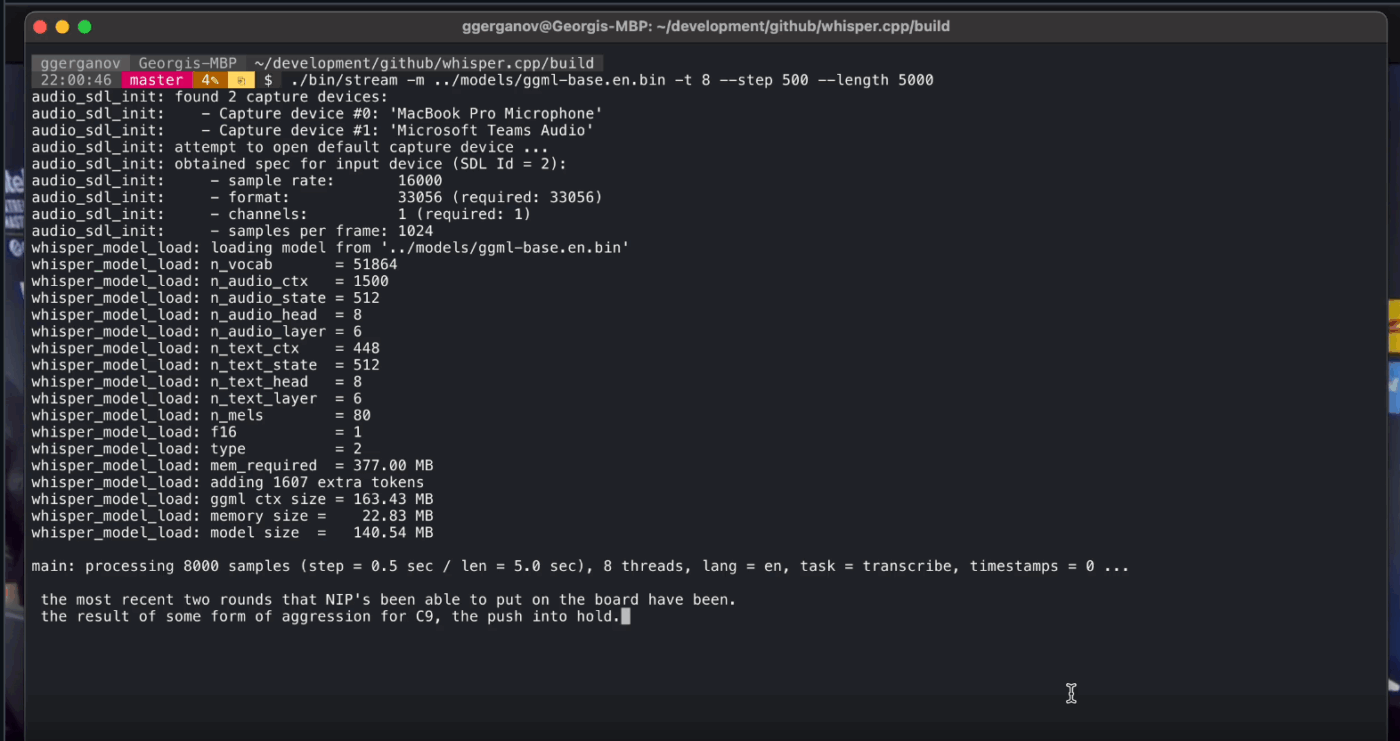

8. Whisper. cpp (Am besten geeignet für vollständig offline arbeitende Sprach-zu-Text-Funktionen, die Sie in Apps einbetten können)

Whisper.cpp ist eine leistungsstarke C/C++-Implementierung des automatischen Spracherkennungsmodells Whisper von OpenAI, das für die lokale Ausführung ohne umfangreiche Laufzeitabhängigkeiten entwickelt wurde. Es ist beliebt für Offline-Transkriptionspipelines, bei denen Sie eine kleine, portable Binärdatei oder eine Bibliothek im C-Stil benötigen, die Sie in Ihr eigenes Produkt integrieren können.

Es ist außerdem flexibel in verschiedenen Umgebungen einsetzbar und wird offiziell auf Desktop-Computern, Mobilgeräten, WebAssembly, Docker und sogar auf Hardware der Raspberry Pi-Klasse unterstützt. Damit eignet es sich besonders für Offline-Tools, die an mehreren Orten ausgeführt werden müssen.

Das „cpp” im Namen steht für den Fokus auf Leistung. Diese Implementierung ist deutlich schneller und benötigt weniger Speicher als Python-basierte Alternativen, sodass eine Echtzeit-Transkription auf modernen Computern ohne leistungsstarke GPU möglich ist.

Whisper. cpp – die besten Features

- Führen Sie die Sprachaktivitätserkennung (VAD) als Teil des Projekts durch, um Sprache zu segmentieren und laute, leere Audio-Transkriptionen in Streaming-Workflows zu reduzieren.

- Quantisieren Sie Whisper-Modelle, um den Speicherplatz- und Speicherbedarf zu reduzieren, mit mehreren Quantisierungsoptionen für eine schnellere lokale Inferenz.

- Erstellen Sie mit optionalem FFmpeg-Support unter Linux, um über den grundlegenden WAV-Pfad hinaus weitere Formate zu verarbeiten.

Whisper. cpp-Limitierungen

- Die CLI von Whisper.cpp erwartet standardmäßig 16-Bit-WAV-Eingaben, was bei der Arbeit mit MP3, MP4, M4A oder anderen gängigen Formaten einen zusätzlichen Konvertierungsschritt erfordert.

- Es bietet keine nativen Beschreibungen für Sprecher (Diarisierung), was es schwierig macht, Zitate in Aufnahmen mit mehreren Sprechern korrekt zuzuordnen.

Whisper. cpp Preisgestaltung

- Open Source

Whisper. cpp Bewertungen und Rezensionen

- G2: Nicht genügend Bewertungen

- Capterra: Nicht genügend Bewertungen

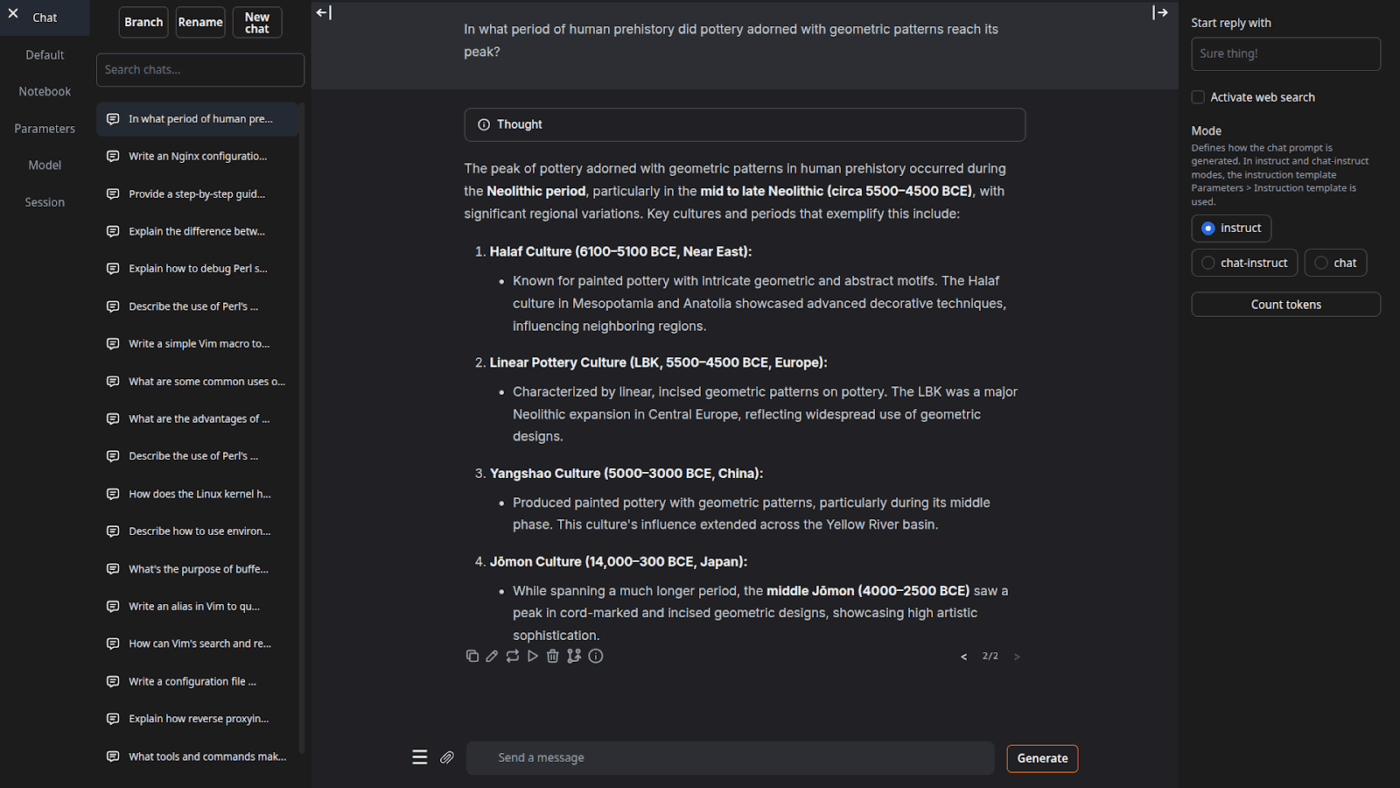

9. Text Generation Web UI (Am besten geeignet für Benutzer, die ein browserbasiertes Cockpit für lokale LLMs wünschen)

Text Generation Web UI (oft auch „oobabooga” genannt) ist eine Gradio-basierte Webschnittstelle zum Ausführen lokaler Modelle mit starkem Fokus auf Steuerung und Experimentieren. Sie verhält sich eher wie eine vollständige Workbench: mehrere Modell-Backends, mehrere Interaktionsmodi und viele Regler für das Generierungsverhalten.

Es stützt sich auch auf „Writer/Dev“-Workflows, die viele Offline-Tools überspringen, mit Features wie der Automatisierung des Eingabeaufforderungs-Formats, der Erstellung im Notizbuchstil und der Verzweigung von Unterhaltungen. Für Offline-Setups, die weiterhin eine Web-Benutzeroberfläche benötigen, ist es eines der am besten konfigurierbaren Frontends in dieser Kategorie.

Die besten Features der Web-Benutzeroberfläche zur Textgenerierung

- Automatische Formatierung des Prompts mithilfe von Jinja2-Vorlagen, wodurch Fehler beim Format des Prompts über verschiedene Modellfamilien hinweg reduziert werden

- Passen Sie Dutzende von Einstellungen an, um die Ausgabe der KI genau auf Ihre spezifischen Bedürfnisse abzustimmen, sei es für kreatives Schreiben, Programmieren oder Rollenspiele.

- Nachrichtenbearbeitung mit Versionsnavigation und Unterhaltungsbereichen, wobei mehrere Richtungen desselben Chats beibehalten werden, ohne von vorne beginnen zu müssen

Einschränkungen der Web-Benutzeroberfläche für die Textgenerierung

- Der Ein-Klick-Installer benötigt etwa 10 GB Speicherplatz und lädt PyTorch herunter, wodurch das Setup auf Geräten mit begrenztem Speicher sehr aufwendig erscheint.

- Der OpenAI-kompatible Embeddings-Endpunkt verwendet sentence-transformers/all-mpnet-base-v2 mit 768-dimensionalen Embeddings, was zu Abweichungen von den Annahmen in Pipelines führen kann, die auf den 1536-dimensionalen Standards von OpenAI basieren.

Preise für die Textgenerierung über die Web-Benutzeroberfläche

- Open Source

Bewertungen und Rezensionen zur Textgenerierung über die Web-Benutzeroberfläche

- G2: Nicht genügend Bewertungen

- Capterra: Nicht genügend Bewertungen

10. Llama.cpp (Am besten geeignet für leistungsstarke lokale LLM-Inferenz über CPU und GPU)

Llama.cpp ist eine C/C++-Inferenz-Engine und Toolchain für die lokale Ausführung von LLMs mit minimalen Abhängigkeiten und starker Leistung in einem breiten Bereich von Hardwareplattformen. Es handelt sich weniger um eine „Chat-App“ als vielmehr um eine lokale Laufzeitumgebung, in der Sie Workflows erstellen können, sei es eine CLI, ein lokaler HTTP-Server oder eine eingebettete Bibliothek in Ihrem eigenen Produkt.

Llama.cpp ist zwar keine Endbenutzeranwendung, aber die Engine, die viele der tools in dieser Liste antreibt, darunter GPT4All und LM Studio. Es führte das GGUF-Modellformat ein, das durch die effiziente Reduzierung der Größe zum Standard für die Ausführung großer Modelle auf Verbraucherhardware geworden ist.

Es bietet auch Bindungen für beliebte Programmiersprachen wie Python und Rust, und sein Server-Modus kann eine OpenAI-kompatible API bereitstellen.

Llama. cpp – die besten Features

- Starten Sie einen OpenAI-API-kompatiblen lokalen Server mit einer integrierten Web-Benutzeroberfläche und einem Endpunkt /v1/chat/completions unter Verwendung von llama-server.

- Führen Sie ein Einbettungsmodell (und sogar ein Neuranking-Modell) vom selben Server für Offline-RAG-Pipelines mit /embedding und /reranking aus.

- Quantisieren Sie Modelle auf 1,5 bis 8 Bit, um den Speicherbedarf zu reduzieren und die lokale Inferenz zu beschleunigen, und beschleunigen Sie dann die Ausführung mit CUDA/Metal plus Vulkan/SYCL-Backends, sofern verfügbar.

Llama. cpp-Limitierungen

- Llama.cpp wird nicht als ausgereifter Desktop-Assistent ausgeliefert, was bedeutet, dass die Offline-Nutzung oft CLI-Befehle oder das Hosten von llama-Server erfordert und viele Benutzer für das Chatten täglich auf Benutzeroberflächen von Drittanbietern angewiesen sind.

- Die OpenAI-Kompatibilität von Llama.cpp entspricht nicht immer 1:1 allen OpenAI-Client-Features, und Benutzer melden Unstimmigkeiten bei strukturierten Ausgabeparametern wie response_format in /v1/chat/completions.

Llama. cpp Preisgestaltung

- Open Source

Was sagen echte Benutzer über Llama.cpp?

Ein Sourceforge-Rezensent sagt:

Großartig. KI für alle zugänglich machen. Und es funktioniert hervorragend!

Großartig. KI für alle zugänglich machen. Und es funktioniert hervorragend!

Verwandeln Sie Offline-KI-Ergebnisse mit ClickUp in echte Arbeit

Bei der Auswahl des richtigen Offline-KI-Tools geht es vor allem darum, das tool an die jeweilige Aufgabe anzupassen.

Wenn Sie hier sind, haben Sie wahrscheinlich die Wahrscheinlichkeit, drei Dinge zu optimieren: Datenschutz, keine Abhängigkeit vom Internet und die Freiheit, nicht an ein weiteres Abonnement gebunden zu sein.

Die Tools auf dieser Liste erfüllen diese Anforderungen auf unterschiedliche Weise. Das heißt, einige eignen sich besser zum Schreiben und Programmieren, andere für die Suche, Notizen oder kreative Arbeit.

Für Teams besteht die größere Herausforderung jedoch nicht nur darin, KI lokal auszuführen. Es geht darum, die Ergebnisse der KI in echte Workflows umzusetzen.

Mit den KI-Funktionen von ClickUp, die in Ihre Aufgaben, Dokumente und Ihr Wissen integriert sind, können Sie ganz einfach die nächsten Schritte an derselben Stelle anzeigen, an der die Arbeit erledigt wird (und das alles mit Sicherheit auf Unternehmensniveau).

Probieren Sie ClickUp kostenlos aus und sehen Sie selbst, wie es aussieht, wenn KI und Umsetzung endlich zusammenkommen. ✨

Häufig gestellte Fragen zu Offline-KI-Tools

Ja, nach dem ersten Herunterladen der Modelldateien können viele KI-Tools vollständig auf Ihrem Gerät ausgeführt werden, ohne dass eine Internetverbindung erforderlich ist. Dadurch eignen sie sich perfekt für den Umgang mit sensiblen Daten oder für die Arbeit an Orten mit schlechter Internetverbindung.

Lokale LLMs verarbeiten alle Daten auf Ihrem persönlichen Gerät, sodass Ihre Informationen niemals Ihr Gerät verlassen, während cloudbasierte KI Ihre Eingaben zur Verarbeitung an Remote-Server sendet. Lokale Tools sind nach dem Setup in der Regel kostenlos nutzbar, während Cloud-KI oft mit Abonnementgebühren verbunden ist, aber möglicherweise leistungsfähigere Modelle bietet.

Kleinere Modelle mit 1 bis 3 Milliarden Parametern können auf den meisten modernen Laptops mit 8 GB RAM ausgeführt werden. Größere, leistungsfähigere Modelle mit 7 Milliarden oder mehr Parametern erzielen die beste Leistung mit 16 GB oder mehr RAM und einer dedizierten GPU, wobei Apple Silicon Macs und NVIDIA-GPUs eine deutliche Leistungssteigerung bieten.

![Die 10 besten KI-Tools, die im Jahr [Jahr] offline funktionieren](https://clickup.com/blog/wp-content/uploads/2026/01/image-1298.png)