コードレビュー:唯一「LGTM」が「問題なさそう」…あるいは「全部考え直す前にマージしてくれ」を意味する場所。

コードレビューが仕事であれば、バグはユーザーを苛立たせる前に修正され、チームは連携を保ち、本番環境の障害発生時には知識がより迅速に共有されます。

では、それが仕事の場合、プルリクエストが何日も放置される。レビュアーが完全に姿を消したり、「うーん」といった意味不明なコメントを残して再び消えたりすることもある。あるチームはセミコロンの位置まで細かく説明を求め、別のチームはコンパイルさえ通れば何でも承認し、基本的な基準すら合意できない。

このブログ記事では、開発者がチーム横断的なコードレビューを効率化し、この混乱から脱して人々が使えるものをリリースする方法について理解します。

また、ClickUpがこのワークフローにどのように組み込まれるかも探っていきます。📝

標準化されたコードレビュープロセスのメリット

標準化されたレビューは、誰がレビューを行うかに関わらず一貫して問題を検出します。コードレビューチェックリストは、セキュリティ脆弱性、パフォーマンス問題、互換性のない変更を体系的に捕捉します。

時間の経過とともに積み重なるメリットをご紹介します。📈

- 迅速なレビュー: 著者はコードを書く前に期待される内容を把握しているため、プルリクエストが初回で承認される頻度が高まります

- 効果的な学習: 建設的なフィードバックが一貫した原則に基づいて行われる場合、個々のレビュアーの好みによる場合よりも、ジュニア開発者の成長が加速します

- 摩擦の低減:リンターが既に強制しているフォーマットについて議論する時間を誰も無駄にしません

- 予測可能な成果:開発者は、どのレビュアーが割り当てられるかを心配する代わりに、高品質なコードの記述に集中できる

🔍 ご存知でしたか? 「プルリクエスト」という用語が広く普及したのは、2008年にGitHubがサービスを開始してからです。GitHubは開発者が関連性のある一貫した方法でプルリクエストを編集できるよう、プルリクエストテンプレート(PRT)を導入しました。それ以前は、開発者は変更の提案や議論に電子メールスレッドやパッチファイルを使用していました。

クロスチームのコードレビューにおける一般的な課題

組織の境界によって責任の所在が不明確になったり、集中仕事が妨げられたり、相反する期待が生じたりすると、チーム横断的なコードレビューは失敗に終わります。

以下が典型的な問題点です:

- 異なるコードスタイルが衝突し、レビューがロジックではなくフォーマットに関する議論に変わってしまう

- コミュニケーションが問題となるのは、チームが異なるツールを使用したり専門用語で話したりする場合です。単純な質問に数日かかることもあり、プルリクエスト全体をブロックする原因となります。

- 複数のチームが関与する場合、意思決定者が誰なのか誰も把握できません。結果として、責任範囲外と考えている人物の承認を待つという宙ぶらりんの状態に陥ります。

- タイムゾーンの違いが待ち問題を生み出し、各フィードバックのやり取りに丸一日かかるため、30分の会話が1週間にも及ぶやり取りに膨れ上がる。

- 正式なコードレビューが無視されるのは、あなたの仕事が他チームにとって優先度が高くないからです。彼らは自チームの納期に集中している間、あなたのコードは待機状態に置かれたままになります。

- コードレビュアーは文脈を欠いている。コードベースで物事が機能する理由を理解していないため、既知のエッジケースを処理しているのに誤りと指摘したり、ドメインを理解していないために真の問題を見逃したりする可能性があります。

🚀 ClickUpの優位性:ClickUp Brainは、開発チームにコードレビューを遅延させる欠落した文脈を提供します。AI搭載のアシスタントがClickUpワークスペースを理解しているため、特定の機能が存在する理由や、あるロジックが何を処理する意図を説明できます。

例えば、チェックアウトフロー内の特定の行にフラグが立てられた場合、ソフトウェアチーム向けAIは「これは前回のsprintで修正したエッジケース対応の一部です」と説明し、関連するドキュメントやタスクをワークスペースから抽出して追加のコンテキストを提供します。これにより、レビュー担当者は意図を推測する時間を削減できます。

📌 このプロンプトを試してみてください: チェックアウトAPIにおけるリトライロジックの目的を説明し、過去のバグ修正や機能更新とリンクされているかどうかを教えてください。

チーム横断的なコードレビューを効率化するベストプラクティス

複数のチームが関与する場合、コードレビューは開発者の生産性を低下させがちです。開発者がチーム横断的なレビューを効率化し、生産性を維持する方法をご紹介します。👇

プルリクエストの説明を詳細に記述する

「支払いフローのバグを修正」と書くのをやめ、何が壊れていたのか、そして修正がなぜ機能するのかを説明しましょう。また、以下のことも行いたいでしょう:

- チケットリンク、元の問題を再現するためのステップ、およびテスト内容を記載してください

- 共有インフラを変更する際に確認したチームをリストしてください

- プルリクエストの300行中、重要な50行を指す「レビューの焦点をここに」セクションを追加する

レビュー担当者が変更内容を20分ではなく2分で理解できるなら、より迅速で質の高いフィードバックが得られます。

💡 プロのコツ:変更を提案する際は、その変更がなぜ重要なのかを説明しましょう。これにより知識の記録が残り、繰り返しの質問が減り、将来のレビュアーの助けになります。

所有権を明確にする

適切な担当者を自動タグ付けするCODEOWNERSファイルを追加する。

READMEにテーブルを追加しましょう:『認証コード変更 → @security-team 必須、@backend-team 任意』これにより、5つのチームのコードに関わるプルリクエストが作成された際、誰の承認を待てば良いか、誰が知識共有のためだけに参加しているかが明確になります。

応答時間を徹底し、自身の作業を妨げないようにする

締め切りは誰かが忙しいからといって止まるものではないため、チーム全体がレビュー対応を通常のワークフローの一部として扱うことが有効です。

24時間以内に返答がない場合は連絡を促しましょう。48時間以上経過した場合は、担当者の上司にエスカレートするか別のレビュアーを探してください。また、レビュアーが長々としたコメントを10個も残した場合、「10分後にさっと電話で話そう」と提案し、リアルタイムで議論をまとめることも可能です。

💡 プロの秘訣: リスクと範囲でPRを事前分類しましょう。各PRに低リスク、中リスク、高リスクのタグを付け、複数チームに影響するかどうかをメモします。これにより、ピアレビューが迅速に行われ、レビュアーはすぐに注力すべき箇所を把握でき、高リスクの変更には特に注意が払われます。

アーキテクチャ決定を記録する

PostgresではなくRedisをキャッシュに使用するなど、非自明な選択を行った場合は、アーキテクチャ決定記録(ADR)またはチームのwikiに記録してください。そしてプルリクエスト内でその記録がリンクされていることを必ず記載してください。

これにより、外部レビュアーは既に議論・決定済みの判断について疑問を呈することをやめられます。さらに、新規メンバーが同じ過ちを繰り返すことも防げます。

一般的なパターン向けの例プルリクエストを作成する

誰かがチーム横断的なプルリクエストを完璧に仕上げた時(説明が明確で、コード構造が整い、あらゆるエッジケースに対応している)、その例をブックマークしましょう。新規メンバーと共有し、レビュー時に参照してください。

「サービス間認証の一般的な処理方法はこちら」とリンクされている方が、毎回一から説明する必要がありません。組織が参考にできる優良例のライブラリを構築しましょう。

📖 こちらもご覧ください:ソフトウェア開発における/AIの活用方法(ユースケースとツール)

コードレビューワークフローを改善するツール

チーム横断的なコードレビューを改善するための主要ツールをご紹介します。🧑💻

ClickUp(クロスチームでの集中型コードレビューとコミュニケーションに最適)

ClickUpのソフトウェアプロジェクト管理ソリューションは、プロジェクト管理、ナレッジ管理、チャットを統合した仕事のためのすべてアプリです。/AIによって駆動され、より速く、よりスマートに働くことを支援します。

複数のプルリクエスト、レビューサイクル、ドキュメント更新を管理する開発チームにとって、コードレビュープロセスの各フェーズに構造と責任体制をもたらします。

チーム間でレビューを円滑に進め、コミュニケーションを明確に保つ方法をご紹介します。💻

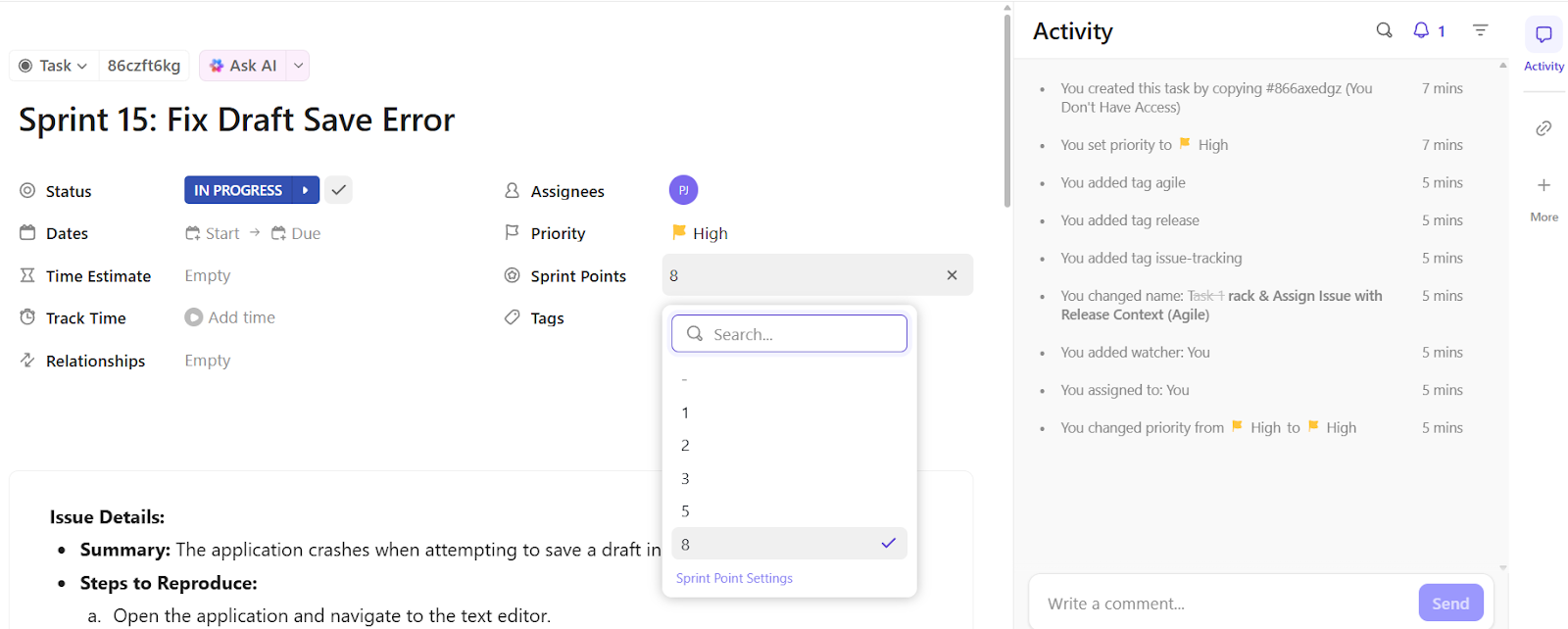

レビューの透明性と進行を保つ

ClickUpタスクはすべてのプルリクエストに適切な場所を提供します。各タスクはレビューの背景、レビュアーの割り当て、進捗を一箇所に集約するため、PRが紛失したり放置されたりすることはありません。チームはsprint、リポジトリ、ステータスでレビュータスクをフィルタリングし、未処理のタスクを素早く確認できます。

バックエンド開発者がAPIレスポンス最適化のためのプルリクエストをプッシュしたとします。彼らは「プロダクトエンドポイント向けAPIキャッシュの最適化」というタスクを作成し、プルリクエストをリンクします。このタスクにはテスト結果、レビュアーのタグ付け、重点的に確認すべき箇所の簡易チェックリストが含まれます。レビュアーは直接タスク内にメモを記入し、ステータスを「変更要求中」に更新した後、DevOpsチームに再割り当てします。

作業を遅らせるすべてを自動化

ClickUpの自動化機能は、レビュー遅延の原因となる煩雑な手作業を排除します。レビューアの割り当て、タスクの進捗管理、チーム通知といった反復作業を自動処理するため、エンジニアは本質的なフィードバック提供に集中できます。

次のような自動化ルールを構築できます:

- ファイルタイプやチームに基づいてレビュー担当者を自動割り当て(例:すべてのフロントエンド/PRをUIレビュー担当者に割り当て)

- プルリクエストが48時間以上レビューされない場合は開発リーダーに通知してください

- プルリクエストがマージされたら、QAテストやドキュメント作成のためのサブタスクを作成する

フィードバックの混乱を明確な行動に変える

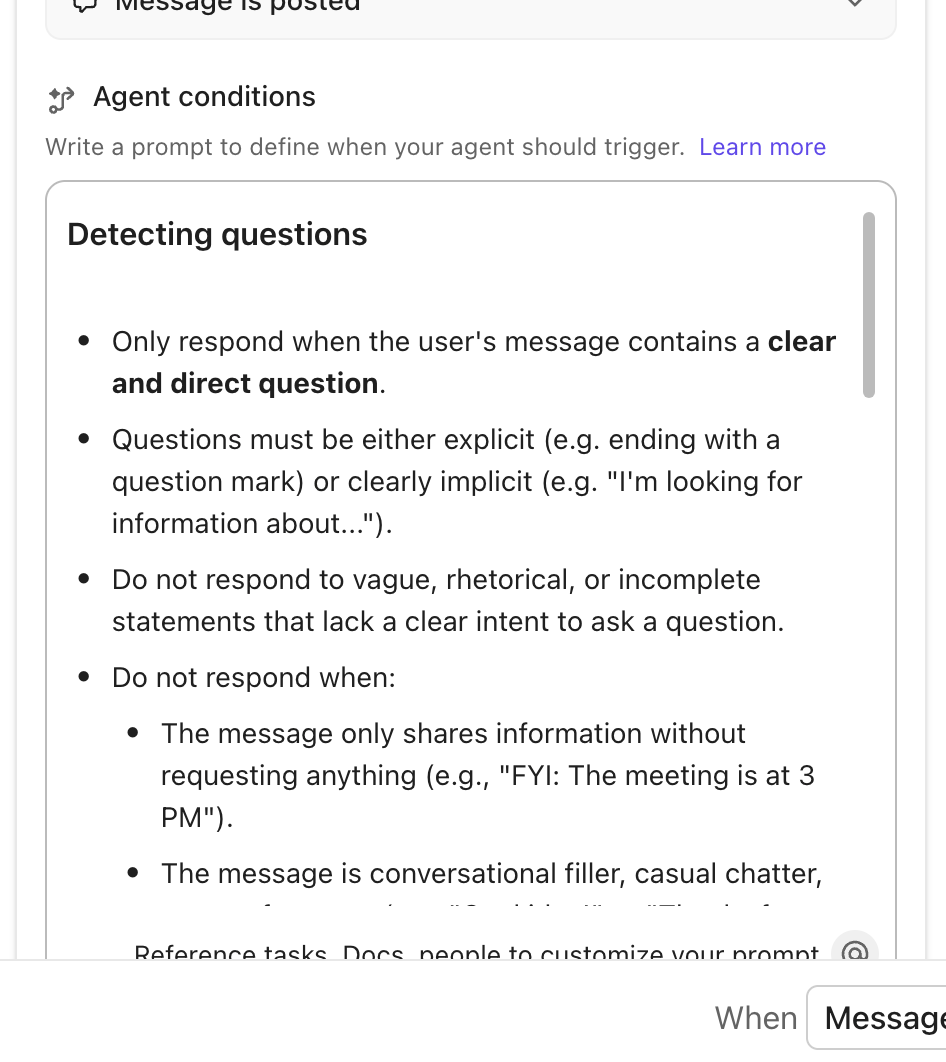

開発者向けAIツール「ClickUp Brain」は、レビューのフォローアップを容易にします。レビューアのフィードバックを瞬時に要約し、障害要因を特定し、所有者や期限付きの具体的なタスクに変換します。

例えば、300件ものコメントが並ぶプルリクエストのスレッド。そこには「細かい修正」「後で修正」「テストが必要」といった指摘が散見されます。ClickUp Brainはたった1つのプロンプトで、主要な問題を抽出し、「APIエラー処理の更新」や「ページネーションのユニットテスト追加」といったサブタスクを作成し、適切な開発者に割り当てます。

✅ 以下のプロンプトをお試しください:

- このタスクに関するすべてのフィードバックを要約し、アクションアイテムを割り当ててください。

- 今週のすべてのプルリクエスト関連コメントからプロジェクト更新情報を生成する

- 最近のコードレビュースレッドでメンションされたブロック要因をリストアップする

次に取るべきステップを忘れないうちに記録する

レビューの議論では、小さなリファクタリング、パフォーマンス調整、テスト要件など、将来的な改善点が明らかになることがよくあります。ClickUp AIエージェントはこれらを自動的に処理し、手動入力なしでレビューの知見を追跡可能なタスクに変換します。

AIエージェントを活用して以下のことが可能です:

- 繰り返し発生する問題(例:テスト不足)を検出し、それらに対するフォローアップタスクを作成する

- ディスカッションのパターンに基づいてバックログアイテムを自動的に割り当てる

- レビュー中に報告される一般的なバグを特定し記録する

例、複数のプルリクエストが同じモジュールでユニットテストの欠落を指摘している場合、AIエージェントが「UserService.jsのユニットテストを追加」という新規タスクを作成し、QA担当者に割り当て、関連するすべてのプルリクエストをリンクできます。

ClickUpの主な機能

- サードパーティツールとの連携:GitHub、GitLab、Bitbucketなどのリポジトリをワークスペースに接続します。すべてのコミット、プルリクエスト、ブランチは、ClickUp連携機能により対応するClickUpタスクと同期されます。

- コーディング標準をアクセスしやすく保つ: コーディングガイドライン、レビュアーチェックリスト、再利用可能なコードスニペットを共同編集可能なClickUpドキュメントに保存し、仕事の拡散を防ぎましょう

- 明確なドキュメントを維持する:長いプルリクエストをプロンプトとして、ClickUp BrainのAI Writer for Workに、要約する、関連セクションを抽出する、または指定したトーンでのコードドキュメントを作成するように指示します。

ClickUpの制限事項

- 豊富なカスタムオプションは、新規ユーザーにとって圧倒的になる可能性があります

ClickUpの価格

ClickUpの評価とレビュー

- G2: 4.7/5 (10,400件以上のレビュー)

- Capterra: 4.6/5 (4,400件以上のレビュー)

📮 ClickUpインサイト:システムが機能しない時、従業員は創意工夫を凝らします——しかし、それが常に良い結果をもたらすとは限りません。従業員の17%は、電子メールの保存、スクリーンショットの撮影、手作業でのメモ作成といった個人的な回避策に頼って仕事を追跡しています。 一方、20%の従業員は必要な情報を見つけられず、同僚に尋ねるしかなく、双方の集中時間を妨げています。ClickUpなら、電子メールを追跡可能なタスクに変換したり、チャットをタスクにリンクしたり、AIから回答を得たり、すべて単一のワークスペース内で実現できます!

💫 実証済み結果: QubicaAMFのようなチームは、時代遅れのナレッジ管理プロセスを排除することで、ClickUpを活用し週5時間以上(年間1人あたり250時間以上)の時間を創出しました。四半期ごとに1週間分の生産性が追加されたら、あなたのチームが何を創造できるか想像してみてください!

2. Gerrit(コミットレベルのレビュー精度に最適)

Gerritはパッチベースのレビューシステムを採用しており、各コミットをマージ前に承認が必要な個別の変更として扱います。レビュアーは「Code-Review +2」や「Verified +1」といったラベルを付与し、マージ準備状態を決定する投票システムを構築します。この手法により、他のツールで頻発する「承認して放置」の問題を防止します。

Gerritの優れた機能

- 既存のGitワークフローとシームレスに仕事をするため、Git対応のSSHおよびHTTPSサーバーを活用してください

- リポジトリ履歴を乱すことなく、個々のパッチを複数回のリビジョンで反復改善する

- refs/for/ブランチ規約により、すべてのコード行が同じ厳格なチェックポイントを通過することを保証します

Gerritのリミット

- プラットフォームから直接マージ競合を解決するのは困難です。自動でログアウトされる場合があるためです。

Gerritの価格

- ブロンズ: 年間13,000ドル(最大100ユーザー)

- シルバー: 年額18,000ドル(最大100ユーザー)

- ゴールド: 39,000ドル/年(最大100ユーザー)

- プラチナ: 90,000ドル/年(最大100ユーザー)

Gerritの評価とレビュー

- G2: 4.3/5 (30件以上のレビュー)

- Capterra: レビューが不十分

🔍 ご存知ですか? Linuxのような多くのオープンソースプロジェクトは、1970年代を彷彿とさせるパッチベースのレビューワークフローに依然として大きく依存しています。

3. GitHub(分散型非同期コードレビューに最適)

プルリクエストはGitHubのレビューワークフローの中核を成し、提案された変更点に関する会話のスレッドを形成します。開発者は具体的な行単位の編集を提案でき、著者はインターフェースから直接適用できるため、「代わりにこれを試してみて」といったコメントのやり取りが不要になります。さらに、スレッド解決状況の追跡機能により、長引く議論の中でフィードバックが埋もれる心配がありません。

GitHubの優れた機能

- 開発者がコードを書く際に、GitHub CopilotによるAI駆動のコードレビューを活用する

- 「必須レビュアー」とCODEOWNERSによる自動化ルーティングで、自身の領域に影響する変更を適切な担当者が確実に確認できるようにします

- GitHubの非同期モデルを活用し、レビューが継続的に行われるようにする

GitHubの制限事項

- 設定と権限は混乱を招きやすく、特に複数のリポジトリを管理する企業組織にとってはそうです。

GitHubの価格

- Free

- チーム: ユーザーあたり月額4ドル

- 企業: ユーザーあたり月額21ドル

GitHubの評価とレビュー

- G2: 4.6/5 (2,600件以上のレビュー)

- Capterra: 4.3/5 (6,140件以上のレビュー)

🧠 豆知識:コードレビューの概念は1950年代に遡ります。当時、IBM 704などの初期メインフレームで仕事をするプログラマーたちは、ジョブを実行する前に互いのパンチカードを手作業で検査し、エラーを確認していました。

4. SonarQube(自動化されたセキュリティスキャンワークフローに最適)

SonarQubeは静的解析による自動レビューを実行し、35以上の言語にわたり6,500以上のルールを適用してバグ、脆弱性、セキュリティホールを検出します。コーディング用AIエージェントはCI/CDパイプラインに組み込まれ、コードが人間のレビュアーに到達する前のゲートキーパーとして機能します。

SonarQubeの主な機能

- テストカバレッジ、重複、セキュリティ評価に基づいて合格/不合格の閾値を設定する品質ゲートを活用する

- 静的アプリケーションセキュリティテスト(SAST)エンジンがセキュリティ脆弱性を検出し、テスト開始前にエラー修正のガイダンスを提供します

- 技術的負債の蓄積を時系列で可視化し、どのリファクタリング仕事が最も重要かを判断する

SonarQubeの制限事項

- 潜在的な問題を指摘しますが、ビジネスロジックが妥当かどうかを判断することはできません

SonarQubeの価格

- Free

- チーム: 月額32ドル

- 企業: カスタム価格

SonarQubeの評価とレビュー

- G2: 4.5/5 (120件以上のレビュー)

- Capterra: 4.5/5 (60件以上のレビュー)

🤝 親切なリマインダー:レビュー担当者は1回のセッションに30~60分を費やすよう促してください。長時間のセッションは集中力を低下させ、微妙なバグを見逃す可能性を高めます。

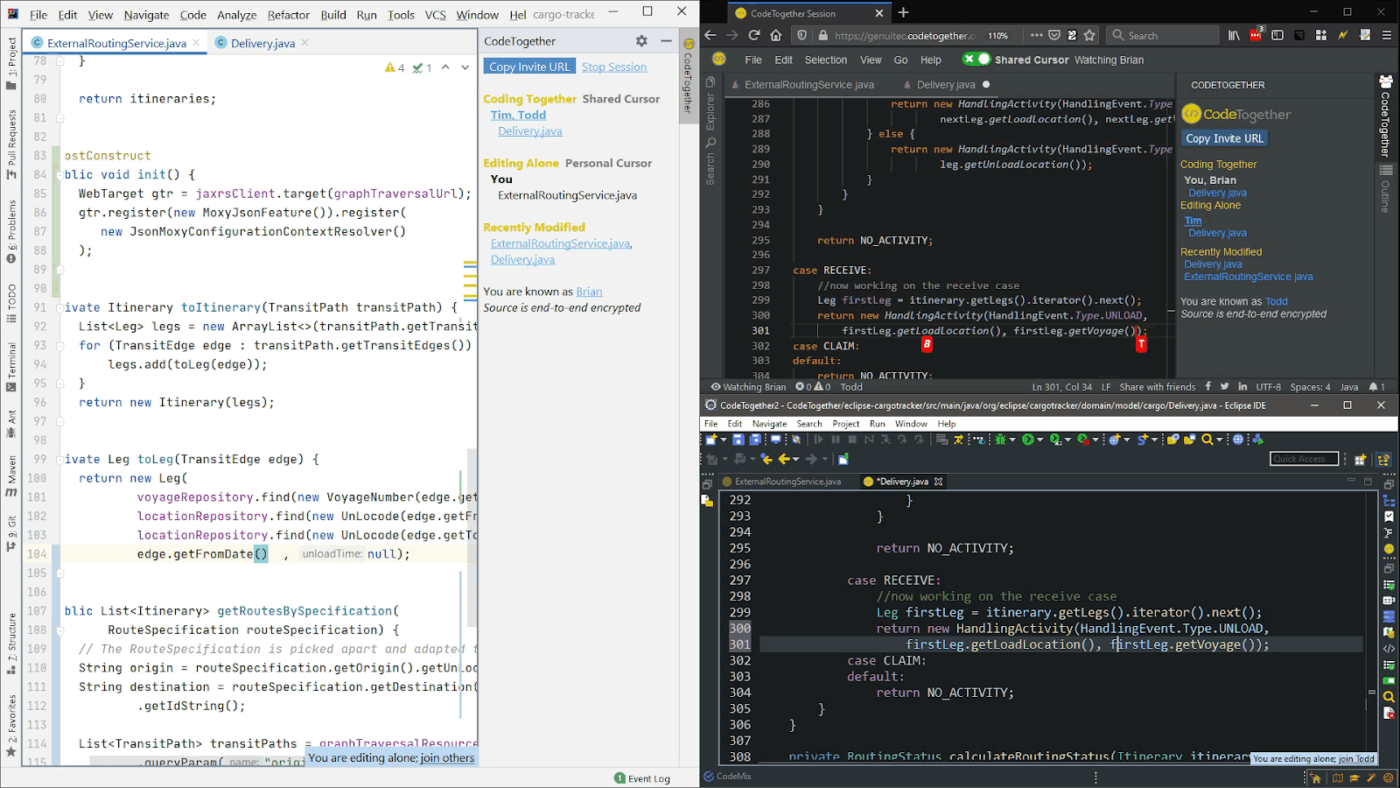

5. CodeTogether(同期型ペアレビューに最適)

CodeTogetherはリアルタイム共同コードレビューをコードエディターに直接統合し、従来の非同期レビュープロセスをライブペアプログラミングセッションへと変革します。開発者はEclipse、IntelliJ、VS Codeから直接参加可能。実際、ゲストはホストのIDEと一致させる必要がなく、ブラウザ経由での参加さえ可能です。

CodeTogetherの主な機能

- ソフトウェア開発環境に組み込まれた音声、ビデオ、テキストチャットを活用する

- 共有コードを仕事として扱う際にも、自身のエディター設定、テーマ、ショートカットを維持できます

- ツール内でドキュメント作成やトレーニング目的のセッションを記録する

CodeTogetherのリミット

- オフライン機能がなく、古いソフトウェアや複数言語では仕事にならない可能性があります

CodeTogetherの価格

- スタータープラン: 月額10ドル/ユーザー

- ビジネスプラン: ユーザーあたり月額49ドル

- エンタープライズプラン: カスタム価格

CodeTogetherの評価とレビュー

- G2: レビューが不十分

- Capterra: レビューが不十分

チーム横断的なコラボレーション戦略

距離や異なるスケジュール、競合する優先度があっても、活発なコラボレーションを構築する方法をご紹介します。🪄

最初から非同期処理を考慮した設計

おそらく、他チームのレビュアーはあなたと同時刻にオンラインになることはないでしょう。無理に「さっと電話」を入れようとするより、こちらの方が効果的です:

- プルリクエストの説明文にはすべてを前倒しで記載する: レビュアーが別の大陸にいて12時間は返信しないと想定して記述しましょう。解決しようとしている問題は何ですか?試して失敗したことは?難しい部分はどこですか?

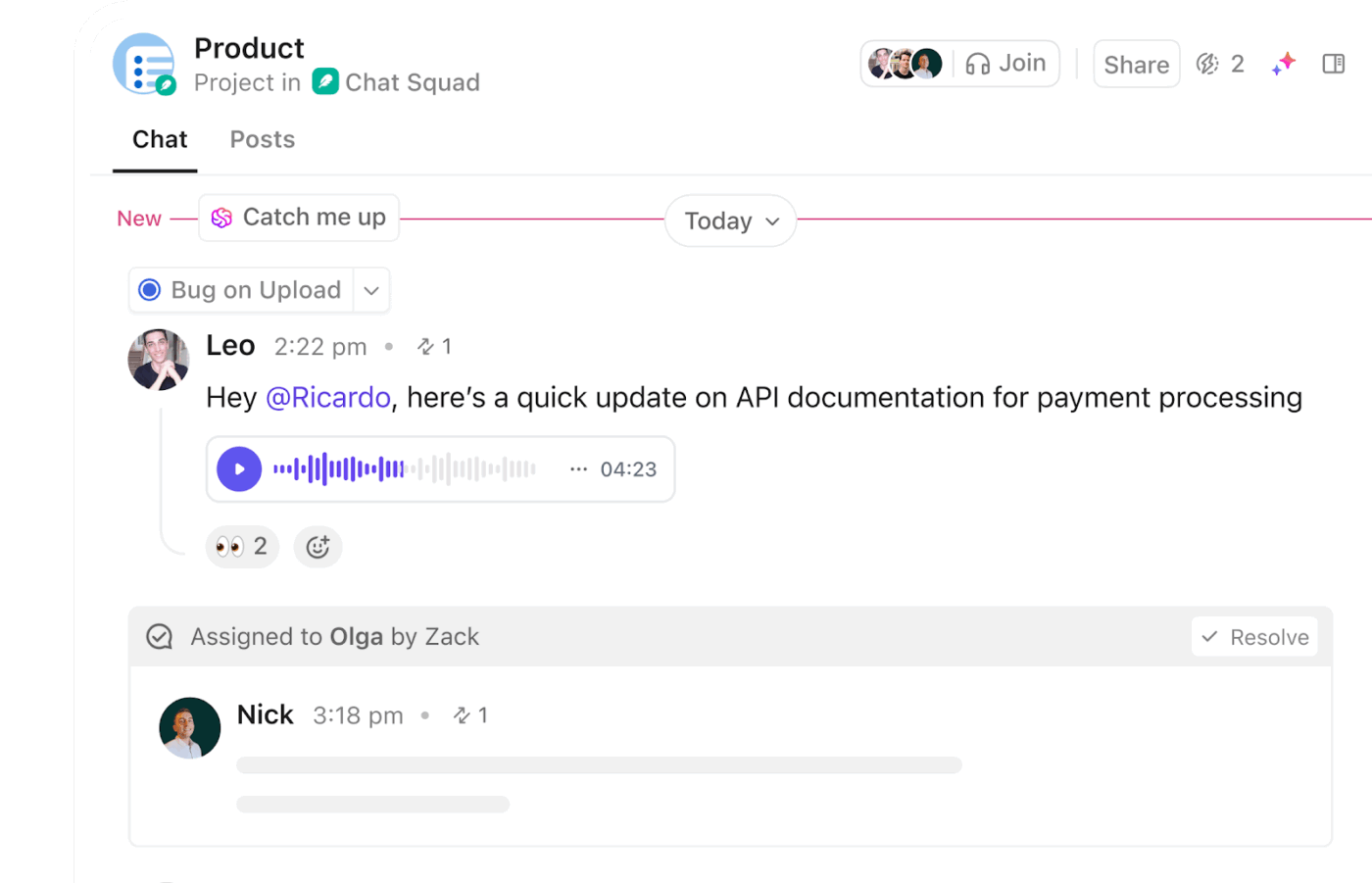

- 複雑な内容はビデオで記録:変更点をClickUp Clipで解説すれば、2日間にわたる20件以上のチャットメッセージより効果的です。レビュアーは2倍速で視聴し、構築内容を理解できます

- 明らかな疑問に答える:「既存のUserServiceを使わなかったのはなぜか?」といった質問が説明文で明確に回答されていることを確認してください

🚀 ClickUpの優位性:非同期レビューは、コミュニケーションが明確で追跡しやすい場合にのみ機能します。ClickUp Chatは、そうした会話を作業自体と常に接続させるため、更新情報が一夜にして埋もれることはありません。

プルリクエストのリンクを投稿し、簡単な背景情報を共有し、レビューが必要なチームメンバーをタグ付けできます。これらの機能はモバイルデバイスでも利用可能です。

ドキュメント作成を宿題のように扱うのはやめましょう

コードドキュメントの作成は機能リリースの一部です。すべてのクロスチームPRでは以下を必須とします:

- サービスが存在する理由と相互連携方法を説明するアーキテクチャドキュメントへのリンク

- デプロイやスケーリングの方法を変更した際は、ランブックを更新してください

- 2つ以上のサービスが相互に通信するあらゆるシナリオに、図を追加してください。

通常、次のような流れになります:最初のクロスチームPRは、ドキュメントが存在しないため苦痛を伴い、そのPRの一部としてドキュメントを作成します。次の5つのPRは、レビュアーがセルフサービスできるためスムーズに進みます。10回目のPRまでには、知識が頭の外に蓄積されるため、新しいチームメンバーも自信を持ってあなたのコードをレビューできるようになります。

ツールを連携させる

手動でのコンテキスト切り替えがレビューの妨げになります。すべてを接続しましょう:

- プルリクエストはチケットに自動リンクされているため、レビュアーはビジネス上の文脈を確認できます

- チケットはプルリクエストとリンクされているため、プロダクトマネージャーはリリース内容を把握できます

- デプロイの成功時と失敗時の両方でCI/CDコメントを付与する

目標は、1つのリンクをクリックするだけで全体像が把握できるようにすることです。

🚀 ClickUpの優位性: ClickUp Brain MAXなら、ツールを統合し、AIツールの乱立を解消できます。コンテキスト対応のユニバーサル検索により、ClickUp、GitHub、さらにはGoogle Driveから関連するプルリクエスト、チケット、ドキュメントを数秒で呼び出せます。音声コマンドでタブを切り替えずにチケットを作成・更新でき、AI駆動の自動化によりエコシステム全体で更新が確実にフローします。

絶対に壊せない部分をペアレビューする

リファクタリングのレビュー担当者を1人に? 仕事は進む。全マイクロサービスに影響する認証変更のレビュー担当者を1人に? 深夜2時のインシデントを招く行為だ。重要システムでは:

- 少なくとも2名のレビュアーを割り当ててください。1人はロジックのバグを、もう1人はセキュリティ問題を発見します。

- 「Codeowners」チャンネルで、ペアレビューが必要なパスを明示的に示してください

- 追加の精査を詫びる必要はありません。ペアレビューが本番環境をダウンさせる可能性のあるバグを初めて発見した時、その価値は百倍にもなるのです。

確かに遅いですが、本番環境でのインシデントはさらに遅いのです。

🔍 ご存知ですか? 1970年代にIBMに在籍していたマイケル・フェイガンは、ピアコードレビューのための最初の正式なシステム「フェイガン検査」を開発しました。この構造化されたプロセスは、開発ライフサイクルの早い段階で欠陥を検出するために、プラン、準備、検査ミーティング、再作業、フォローアップといった役割とステップを定義しています。

クロスチームレビューの担当をローテーションする

外部PRを常に同じ人物がレビューするとボトルネックが発生し、燃え尽き症候群につながる可能性があります。理想的なシナリオは以下の通りです:

- 全チーム横断のクロスチーム仕事に対して、週単位のレビュー担当者を割り当てる

- 共有カレンダーに記入して、誰が担当中か皆が把握できるようにしましょう

- sprintプランに組み込もう。レビュー業務は「余分」な仕事ではなく、業務の一部だ

- 1~2週間ごとにローテーションし、知識を広める

ローテーション中の担当者は、その週の障害解消役であることを自覚している。他の全員が、自身の仕事に集中できることを理解している。

四半期ごとにコードレビューの振り返りを実施する

ここでは特に、チーム横断的なレビューについて説明します:

- 前四半期で最悪のプルリクエストを提示し、その問題点を議論する

- 優れたプルリクエストを強調し、全員が模倣するテンプレートとして活用する

- 議論を終わらせるべき事項について投票し、決定内容を文書化する

- レビューで重大なバグをほぼ見逃すところだったニアミス事例を明らかにする

ここで「プルリクエストはもっと丁寧に書くべきだ」という漠然とした考えを、「私たちのチームにとって理想的なプルリクエストの具体例」へと変えるのです。

効率化されたコードレビューの成功を測定する

測定しなければ、より優れたプログラマーになるのは困難です。しかし、多くのチームはレビューの効果を示すものではない見せかけのメトリクスを追跡しています。

重要なポイントはこちらです。📊

レビューの所要時間(ただし適切に追跡すること)

平均値だけを測定する場合、機能開発が頓挫している間に1週間放置されるプルリクエストが隠れてしまうことを忘れてはなりません。注目すべきは次の点です:

- 初回レビューまでの時間:業界標準は24時間です。もし御社の場合3日かかるなら、それがボトルネックです

- マージまでの時間: ほとんどのプルリクエストでは、作成からデプロイまで72時間以内であるべきです

- 平均ではなく95パーセンタイルで測る: 平均が2日でも95パーセンタイルが2週間なら、チームの半数は常にブロックされている状態だ

レビューで発見されたバグ vs. 本番環境で発生したバグ

レビューの目的は、顧客がやることする前にバグを捕捉することにあります。追跡:

- 最近マージされたコードに起因するP0/P1インシデントはどれほど発生していますか? 10%を超える場合、レビューは仕事をしていない

- レビューで検出されるバグの種類は?SQLインジェクション脆弱性?素晴らしい。セミコロン漏れ?リンターが対応すべき問題だ

- どのような問題が本番環境に漏れるのか? スタイル上の問題は見つかるが競合条件を見逃すようなレビューは、本質的な問題を見誤っている。

🔍 ご存知でしたか?コードレビューに対する不安は、経験の浅い開発者にリミットされたことではありません。調査によると、あらゆる経験レベルの開発者がコードレビューに関連する不安を経験することが判明しています。これは「影響を受けるのは経験の浅い開発者だけ」という一般的な誤解に疑問を投げかけるものです。

開発者の満足度

レビューが仕事をしていない場合、チームはあなたに伝えます。ただし、四半期ごとに尋ねた場合のみです:

- レビューは有益か、それとも単なる形式主義か?(1~10点評価)

- レビュー待ちで作業がブロックされていると感じていませんか?

- コメントは建設的か、それとも細かいことにこだわっているだけか?

- 他チームへのレビュー依頼をためらっていませんか?

満足度が低下している場合、メトリクスは問題なく見えても開発プロセスは機能不全に陥っている可能性があります。レビュー担当者が変数名の些細な議論に時間を費やし、アーキテクチャ上の問題を見逃しているかもしれません。あるいは、チーム横断レビューが敵対的な雰囲気になっているかもしれません。こうした問題は番号では把握できず、チームの声がそれを教えてくれます。

💡 プロの秘訣:ClickUpフォームで四半期ごとのフィードバックループを作成し、チームがレビュープロセスをどう感じているかを把握しましょう。ソフトウェア開発テンプレートを活用すれば、レビューの有用性、作業の妨げになるか、フィードバックが建設的かといった焦点を絞った質問を素早く作成できます。

ベロシティ(ただし賢く活用すること)

レビューの効率化は、実際にリリースを早めましたか?

- 変更前後のsprintごとのストーリーポイントまたは機能

- パイプライン全体におけるコミットから本番環境への移行までの時間

- ただしバグレポートにも注意を払うこと。処理速度が倍増しても本番環境のインシデントが3倍になれば、品質危機へと自らを「効率化」してしまったことになる。

ここでの目標は、品質を維持しながら持続可能なスピードを達成することです。両方を測定しなければ、単にバグをどれだけ速くリリースできるかを測っているに過ぎません。

誰もが確認できるダッシュボードを構築する

ClickUpダッシュボードを作成し、すべてのプルリクエスト、レビュアー、結果を一つに追跡。リリースサイクルを遅延させる要因を可視化しましょう。

以下の点を強調するカードを設定してください:

- 48時間以上待機中のプルリクエスト(所有者名付き)(公開された責任ほどやる気を引き出すものはありません)

- チームごとの平均レビュー時間を可視化し、ボトルネックを明確化

- 1人あたりの完了するレビュー数 フリーライダーを特定するために

- 検出されたバグと見逃されたバグを品質チェックとして

オフィスのボードに貼るか、Mondayのスタンドアップで共有しましょう。メトリクスの可視性が実現されると、それが重要視されるようになります。

ソフトウェアプロジェクト管理用のダッシュボード作成方法を学ぶには、こちらのビデオをご覧ください:

ClickUpではレポートの自動配信も設定可能です。適切な担当者が自動的にインサイトを受け取れるよう、電子メールを追加し、配信頻度(毎日・毎週・毎月)の選択だけで、PDF形式のスナップショットが自動送信されます。

その後、コメントパターンを簡単に確認できます:

- PRあたりの平均コメント数: 30以上なら問題あり。PRが大きすぎる?基準が不明確?レビュアーが些細なことにこだわっている?

- 修正の繰り返し回数: PRの平均修正回数が4回である場合、変更すべき点が明確に伝えられていない可能性があります

- ゼロコメント承認:フィードバックなしですべてが承認されるなら、レビューは見せかけだけの儀式に過ぎない

VMwareのPMOであるテレサ・ソスコットがClickUpについて語った内容は以下の通りです:

ClickUpダッシュボードは私たちにとって真のゲームチェンジャーです。なぜなら、今まさに何が起きているかをリアルタイムのビューで把握できるからです。完了した仕事も進行中の仕事も、簡単に確認できます*

ClickUpダッシュボードは私たちにとって真のゲームチェンジャーです。なぜなら、今まさに何が起きているかをリアルタイムのビューで把握できるからです。完了した仕事も進行中の仕事も、簡単に確認できます*

チーム横断レビューのバランス

一部のチームが全ての仕事を担っている一方で、他のチームは消えているのか?

- チームごとのレビュー依頼数と実施数の比較: チームが50件のレビューを依頼し、そのうち5件しか完了していない場合、これは持続不可能です

- レスポンス率:どのチームが定期的に他チームからのプルリクエストを無視しているか?

このデータを活用して期待値の再調整や明確化を図りましょう。「お互いのコードをレビューし合う」という関係は、暗黙の了解ではなく明文化すべきです。

ClickUpでGitのフローをシームレスに

効果的なコードレビューはチームを前進させます。フィードバックを協働に変え、直前の予期せぬ問題を防止し、マージ前に全ての開発者が自信を持てるようにします。プロセスがフローすれば、リリースサイクル全体が軽快に感じられるでしょう。

ClickUpはこのフローを大幅に強化します。レビュータスク、チーム更新、議論を接続した空間で結びつけ、ClickUp Brainがプロセスを推進します。レビュー依頼は自動的に適切な担当者に届き、コメントは実行可能なタスクに変換され、すべてのプルリクエストは更新を追跡しなくても可視性のあるまま維持されます。

今すぐ無料でClickUpに登録し、すべて(そして全員)がクリックする(連携する)ことで、コードレビューがどれほど迅速に進むかをご確認ください。 ✅

よくある質問(FAQ)

コードレビューを効率化するには、プルリクエストを管理可能な状態に保つことに注力し、コード変更を1回あたり200~400行程度にリミットしましょう。明確なレビューチェックリストを設定し、タイムリーなフィードバックを提供します。リンティング、静的解析、CI/CD統合などの自動化により、日常的な品質チェックを処理できます。

専門知識に基づいてレビュアーを割り当て、コラボレーションツールでコメントを一元管理しましょう。ClickUpはプルリクエストをタスクにリンクさせることで、誰が何をレビューしているかを全員が把握でき、タイムゾーンを超えて期限を可視化します。

コーディング標準の徹底、自動テストの実行、静的解析ツールの活用によりコード品質を向上させます。頻繁かつ体系的なピアレビューを実施し、クリーンで可読性が高く、十分にテストされたコードを優先します。ClickUpダッシュボードでは品質メトリクスの追跡、レビュアー向けチェックリストの管理、コード健全性を監視するレポート作成が可能です。

GitHub、GitLab、Bitbucketなどのプラットフォームはクロスチームのレビューに最適です。DangerやSonarQubeといったコードレビューツールはチェックを自動化できます。さらに、PR追跡をClickUpに統合することで全員の連携を強化し、ボトルネックを削減できます。

通常、2~3名のレビュアーが仕事です。1名は当該コード領域に精通しているべきであり、もう1名は新たな視点を提供できます。日常的な変更や小規模チームでは1名のレビュアーで十分ですが、重大な変更や大規模な変更には3名以上が必要です。

自動化によりテスト実行、コードスタイルチェック、脆弱性検出、未処理レビューのリマインダー送信が可能になります。ClickUpの自動化機能はプルリクエストの割り当て、ステータス更新、レビュアーへの通知を自動化し、プロセスを迅速かつ一貫性のあるものにします。