La mayoría de los desarrolladores pueden poner en marcha la API Gemini en menos de 10 minutos.

El verdadero reto llega después de la configuración.

Esta guía le muestra cómo obtener su clave de API, instalar el SDK y realizar su primera solicitud.

También aprenderás a mantener organizados tus flujos de trabajo de API, para que tu equipo no pierda tiempo reinventando soluciones o buscando documentación.

¿Qué es la API Gemini?

La API Gemini es la interfaz de Google para acceder a su familia de modelos de IA multimodal, lo que permite a los desarrolladores integrar la generación de texto, la comprensión de imágenes, la asistencia con código y la IA de conversación en las aplicaciones.

Está diseñado para equipos de producto, ingenieros y empresas que desean añadir potentes capacidades de IA a sus productos sin tener que crear grandes modelos de lenguaje desde cero.

Los grandes modelos de lenguaje de Gemini, como Gemini 3 Flash y Gemini 3 Pro, son multimodales, lo que significa que pueden manejar múltiples tipos de entrada, incluyendo texto, imágenes, audio y vídeo. La API en sí misma utiliza la arquitectura REST API , que es una forma estándar para que los sistemas informáticos se comuniquen a través de Internet.

Para que sea aún más fácil, Google proporciona kits de desarrollo de software (SDK) para lenguajes populares como Python, JavaScript y Go. Es útil comprender la diferencia entre la API y Google AI Studio.

| Uso principal | Aplicaciones de producción | Creación de prototipos y pruebas |

| Método de acceso | Llamadas SDK basadas en código | Interfaz visual basada en web. |

| Ideal para | Desarrolladores que crean aplicaciones | Experimentar con indicaciones |

💡Consejo profesional: mantén todo el contexto de tu proyecto en un solo lugar y evita tener que buscar información en diferentes herramientas creando una base de conocimientos interna para tus proyectos de IA. Con ClickUp Docs, puedes vincular fragmentos de código y documentación de API directamente a las tareas de tu equipo, lo que elimina la proliferación de herramientas y acelera la adopción de la IA.

Cómo obtener tu clave de API de Gemini

Es posible que su equipo esté listo para empezar a crear, pero primero necesita una clave de API.

Para utilizar la API Gemini, necesitas una clave para la autenticación de tus solicitudes, y gestionar estas claves es el primer paso para una gestión más fluida del flujo de trabajo. Necesitarás una cuenta de Google para empezar.

A continuación te explicamos cómo obtener tu clave:

- Navega a Google AI Studio.

- Inicie sesión con su cuenta de Google.

- Haz clic en Obtener clave de API en la barra lateral izquierda.

- Seleccione Crear clave de API en un nuevo proyecto o elija un proyecto de Google Cloud existente.

- Copia inmediatamente la clave generada y guárdala en una ubicación segura.

Tu clave de API te da acceso a tu cuota y facturación de Gemini, así que trátala como si fuera una contraseña. 🔑

Tu clave de API te da acceso a tu cuota y facturación de Gemini, así que trátala como si fuera una contraseña. 🔑

Para equipos más grandes, también puedes gestionar las claves a través de Google Cloud Console, que ofrece controles más avanzados.

Cómo instalar el SDK de Gemini

Un nuevo desarrollador se une a tu proyecto de IA, pero pasa su primer día luchando con la configuración del entorno en lugar de escribir código.

Su versión de Python es incorrecta o les falta una dependencia, lo que provoca el clásico dolor de cabeza de «funciona en mi máquina».

Esta es a menudo la razón por la que los desarrolladores pierden tres horas a la semana. Estas inconsistencias ralentizan la incorporación e introducen incidencias impredecibles que hacen perder un tiempo valioso a los ingenieros.

Un SDK, o kit de desarrollo de software, simplifica estas interacciones con la API al encargarse de la autenticación, el formato de las solicitudes y el análisis de las respuestas por ti. Para evitar problemas de configuración, tu equipo necesita un proceso estandarizado y documentado para instalar el SDK de Gemini.

A continuación te explicamos cómo instalarlo en los entornos más comunes.

Para Python:

- Nota: Necesitarás Python 3. 9 o una versión más reciente. El uso de un entorno virtual es una buena práctica para evitar conflictos con otros proyectos.

Para JavaScript/Node. js:

- Nota: Esto es para su uso en un entorno Node. js.

Después de la instalación, debes configurar tu clave de API como una variable de entorno. Esto mantiene tu clave segura y fuera de tu código fuente.

- En Mac/Linux: export GEMINI_API_KEY="tu-clave-de-API-aquí"

- En Windows: setx GEMINI_API_KEY «tu-clave-de-API-aquí»

Tienes varias opciones para elegir qué SDK utilizar:

- SDK de Python: la opción más popular, con una amplia documentación. Es ideal para aplicaciones de ciencia de datos y backend.

- SDK de JavaScript: la mejor opción para crear aplicaciones web y backends Node.js.

- Go SDK: una excelente opción para los desarrolladores que crean microservicios de alto rendimiento en Go.

- API REST: si utilizas un lenguaje sin SDK oficial, siempre puedes realizar solicitudes HTTP directas a la API REST.

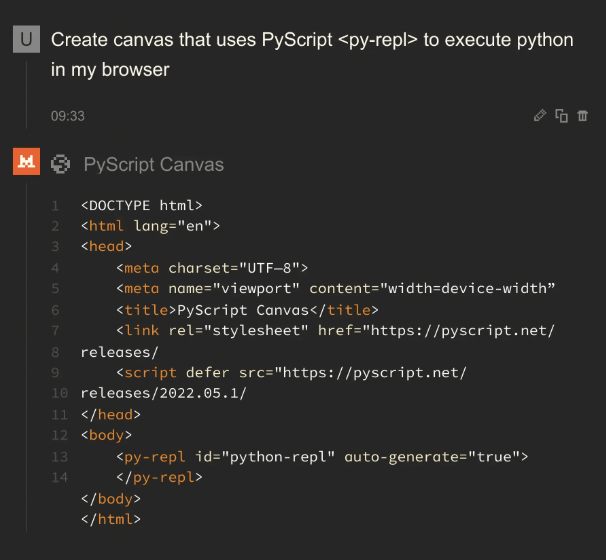

💡Consejo profesional: Estandariza tu entorno de desarrollo y acelera la incorporación creando una lista de control que todos los nuevos miembros del equipo puedan seguir. Guárdala como plantilla en ClickUp Tasks y, si alguien tiene algún problema, podrá utilizar ClickUp Brain para obtener respuestas de la documentación de tu equipo. Aquí tienes una guía rápida:

📖 Más información: Gemini frente a ChatGPT para la programación del código: ¿cuál es mejor?

Cómo realizar tu primera solicitud de API Gemini

Tu equipo por fin está realizando llamadas API, pero cada desarrollador lo está descubriendo por su cuenta.

Un intento correcto de llamada API es sencillo: envías una indicación a un modelo Gemini y recibes una respuesta.

El verdadero reto es hacer que ese proceso sea repetible y escalable para todo tu equipo. Aquí tienes algunos ejemplos de cómo realizar tu primera solicitud.

Ejemplo en Python

Este código envía una sencilla indicación de texto a la API Gemini e imprime la respuesta.

Veamos esto con más detalle:

- Importar y configurar: esto carga la biblioteca de Google y configura la autenticación utilizando la clave de API que ha configurado anteriormente.

- Inicializar modelo: aquí le indicas al código qué modelo Gemini específico debe utilizar. Gemini 3 Flash está optimizado para tareas de alta velocidad y gran volumen, mientras que Gemini 3 Pro está diseñado para razonamientos profundos y flujos de trabajo complejos de varios pasos.

- Generar contenido: Esta es la acción. Estás enviando tu pregunta al modelo.

- Acceso a la salida: la respuesta del modelo se almacena en el objeto de respuesta, y puede acceder al texto con response. text.

📖 Más información: 10 ejemplos de contenido generado por IA para inspirarte.

Ejemplo de JavaScript

Si trabajas en un entorno Node.js, el proceso es similar, pero utiliza la sintaxis async/await de JavaScript.

Ejemplo de API REST

Si no utilizas Python o JavaScript, siempre puedes comunicarte con la API directamente mediante un comando curl. Esto es ideal para pruebas rápidas o para su uso en lenguajes sin un SDK específico.

Este comando envía una solicitud HTTP al punto final de la API y devuelve la respuesta como un objeto JSON.

Facilita a tu equipo la búsqueda y reutilización de fragmentos de código y indicaciones exitosas creando una biblioteca compartida.

📖 Más información: ¿Qué es un plan de gestión de proyectos y cómo se crea?

¿Qué puedes crear con la API Gemini?

La API Gemini es increíblemente versátil. Estas son algunas de las cosas que puedes crear:

- Herramientas de generación de contenido: Realiza la automatización de borradores de blogs, publicaciones en redes sociales y textos de marketing.

- Chatbots y asistentes virtuales: crea interfaces conversacionales para el soporte al cliente o los servicios de asistencia interna.

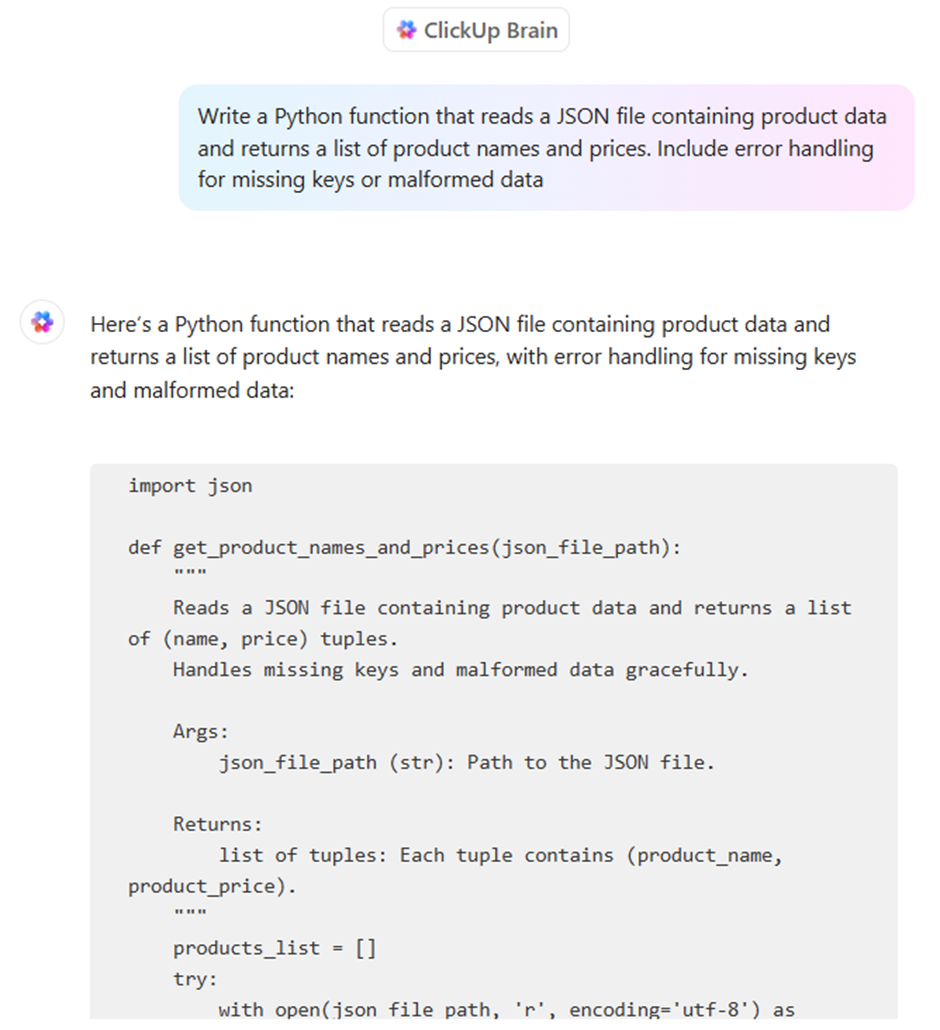

- Asistencia con el código: Genera fragmentos de código, explica funciones complejas y ayuda a depurar errores.

- Ayudantes de análisis de datos: resume informes densos y extrae información clave de textos no estructurados.

- Aplicaciones multimodales: Analiza imágenes o procesa contenido de vídeo para que sea susceptible de búsqueda.

- Procesamiento de documentos: extrae información de archivos PDF y traduce documentos a diferentes idiomas.

Creación de flujos de trabajo agenticos con Gemini

A diferencia de un chatbot estándar que responde a las preguntas de forma lineal, un flujo de trabajo agentico en Gemini permite al modelo percibir una meta, razonar a través de un plan y ejecutar una serie de acciones autónomas en herramientas externas.

Este cambio «agénico» se basa en tres funciones fundamentales del ecosistema Gemini 3:

- Modo «pensamiento» nativo: con el parámetro thinking_level, ahora puedes alternar entre «bajo» para tareas rápidas y «alto» para tareas complejas. En el modo de razonamiento alto, Gemini 3 Pro genera «tokens de pensamiento» ocultos para validar su propia lógica antes de dar una respuesta, lo que reduce drásticamente las alucinaciones.

- Firmas de pensamiento: Para evitar la «deriva del razonamiento» en tareas de múltiples turnos, la API ahora emite firmas de pensamiento cifradas. Los desarrolladores deben devolver estas firmas en el historial de conversaciones para garantizar que el agente mantenga su línea de pensamiento exacta en las diferentes llamadas a la API y ejecuciones de herramientas.

- Protocolo de contexto de modelo (MCP): Gemini ahora utiliza el MCP estándar del sector para conectarse a las herramientas. Esto permite a tu agente «conectarse» instantáneamente a tus bases de datos existentes, Slack o GitHub sin que tengas que escribir código de integración personalizado para cada función.

📮 Información de ClickUp: Los equipos con bajo rendimiento son cuatro veces más propensos a utilizar más de 15 herramientas, mientras que los equipos con alto rendimiento mantienen su eficiencia limitando su conjunto de herramientas a nueve plataformas o menos.

Pero, ¿qué tal si utilizas una sola plataforma para todo?

ClickUp reúne tus tareas, proyectos, documentos, wikis, chats y llamadas en una única plataforma, con flujos de trabajo impulsados por IA. ¿Listo para trabajar de forma más inteligente? ClickUp funciona para todos los equipos, hace que el trabajo sea visible y te permite centrarte en lo que importa, mientras que la IA se encarga del resto.

Ejemplo en Python: Creación de un agente de investigación

Este fragmento muestra cómo inicializar un agente de alto razonamiento que mantiene un «hilo de pensamiento» persistente a través del último SDK de Gemini.

📖 Más información: Cómo utilizar un chatbot para tu empresa

Cómo mantener segura tu clave de API de Gemini

Tu equipo está lanzando funciones, pero tus prácticas de seguridad son una cuestión secundaria.

Las claves de API a veces se dejan en el código, lo que contribuyó a la filtración de 23,7 millones de secretos al GitHub público en 2024, y no existe un proceso formal para rotarlas. Esto deja a su organización vulnerable al uso no autorizado, lo que puede dar lugar a facturas inesperadas y graves violaciones de seguridad.

Un enfoque reactivo de la seguridad es una receta para el desastre. Necesitas un sistema de gestión del conocimiento proactivo para gestionar las credenciales y proteger tus aplicaciones y los datos de tu empresa.

Estas son las mejores prácticas esenciales para mantener segura tu clave de API de Gemini:

- Utiliza variables de entorno: Nunca, jamás, codifiques claves directamente en tu código fuente. Almacénalas en archivos .env o en variables de entorno del sistema.

- Añade. env a tu. gitignore: Este sencillo paso evita que envíes accidentalmente tus claves secretas a un repositorio de código público.

- Rote las claves con regularidad: genere periódicamente nuevas claves en Google Cloud Console y desactive las antiguas.

- Implementa controles de acceso: utiliza la gestión de identidades y accesos (IAM) de Google Cloud para restringir quiénes de tu equipo pueden ver o gestionar las claves de API.

- Supervisa el uso: mantén un ojo en el panel de control de uso de la API en Google Cloud Console para detectar cualquier actividad inusual que pueda indicar un compromiso.

- Utiliza claves separadas para cada entorno: mantén claves diferentes para tus entornos de desarrollo, ensayo y producción para limitar el alcance de una posible fuga.

Precios de Gemini

- Gemini 3 Flash: ~0,50 $ por cada millón de entradas / 3,00 $ por cada millón de salidas

- Gemini 3 Pro: ~2,00 $ por cada millón de entradas / 12,00 $ por cada millón de salidas (para contextos inferiores a 200 000).

- Base de búsqueda: Ten en cuenta que Google ahora cobra 14 $ por cada 1000 consultas de búsqueda para la base una vez que se supera la asignación mensual gratuita (5000 consultas).

Limitaciones del uso de la API Gemini

Tu aplicación está en funcionamiento, pero te estás encontrando con problemas inesperados.

La API es más lenta de lo esperado durante las horas punta o devuelve respuestas inconsistentes que confunden a los usuarios.

Comprender los límites de la API es el primer paso; documentar tus soluciones alternativas es lo que te ayudará a escalar de forma eficaz.

Ten en cuenta estas limitaciones comunes:

- Límites de velocidad: el nivel gratuito tiene límites en las solicitudes por minuto y los tokens por día, lo que puede suponer un cuello de botella para las aplicaciones de gran volumen.

- Variabilidad de la latencia: los tiempos de respuesta pueden variar en función de la complejidad de tu indicación y de la carga general del servidor.

- Restricciones de la ventana de contexto: cada modelo tiene un número máximo de tokens (palabras y partes de palabras) que puede procesar en una sola solicitud, lo que puede suponer un reto a la hora de resumir documentos muy largos.

- Disponibilidad regional: es posible que algunos modelos o funciones no estén disponibles en todas las regiones geográficas.

- Consistencia de los resultados: la IA generativa puede producir resultados ligeramente diferentes incluso para la misma indicación, lo que puede requerir que incorpore pasos de validación en su flujo de trabajo.

- Sin datos en tiempo real: los conocimientos de los modelos no se actualizan en tiempo real, por lo que no pueden proporcionar información sobre eventos muy recientes.

Aunque la API Gemini es una potente herramienta multimodal, la creación de una aplicación lista para la producción a menudo requiere una estrategia multimodelo. Dependiendo de las necesidades específicas de su proyecto en cuanto a profundidad de razonamiento o precisión del código, puede consultar estas alternativas a Gemini.

La mayoría de las herramientas de IA prometen facilitar el desarrollo, pero a menudo terminan siendo solo otra pestaña desconectada en una pila ya abarrotada. Es posible que utilices la API Gemini para impulsar el backend de tu app, una herramienta independiente para resumir las notas de las reuniones y una tercera plataforma para gestionar tus tareas de sprint. Esta red de contextos dispersos y herramientas aisladas es lo que se conoce como «expansión de la IA».

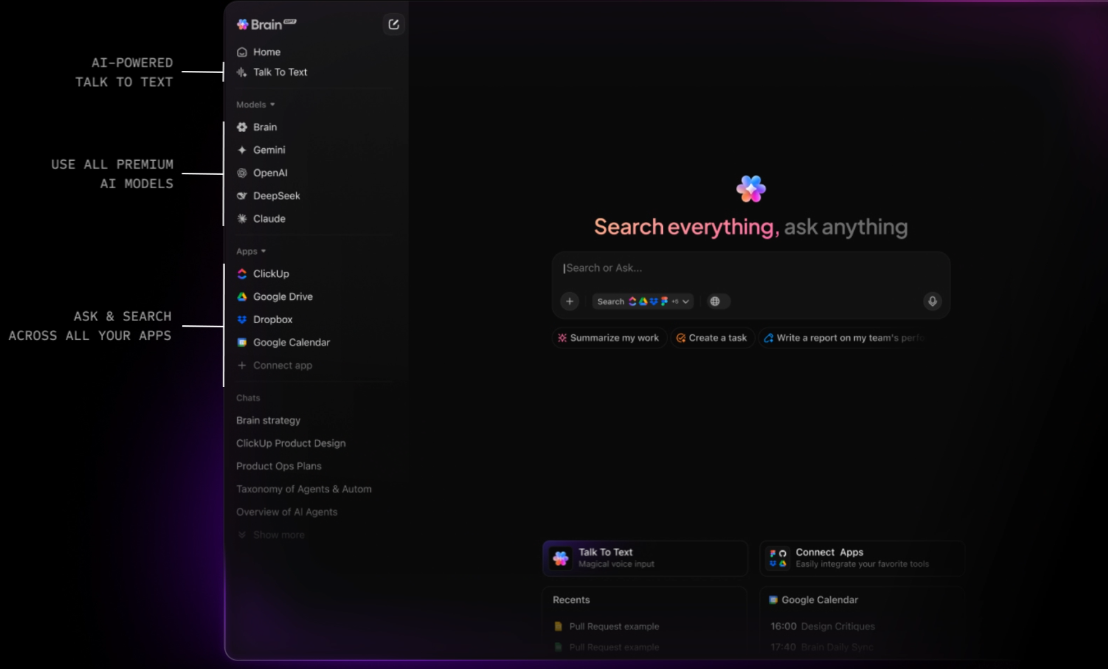

ClickUp es el primer entorno de trabajo de IA convergente que conecta tus tareas, documentos y personas con una capa de inteligencia central. A diferencia de las API independientes que requieren que crees tus propios sistemas de recuperación de contexto (RAG), ClickUp Brain ya «conoce» todo lo que hay en tu entorno de trabajo.

Dado que la IA está integrada de forma nativa, no solo «genera texto», sino que comprende la relación entre la documentación de la API Gemini, los plazos de tus proyectos y el progreso en tiempo real de tu equipo.

Habilita «Ask IA» desde cualquier lugar e implementa agentes autónomos.

El verdadero poder de ClickUp reside en su capacidad para convertir el conocimiento en acción. Con el Brain Assistant, puedes «preguntar a la IA» desde cualquier lugar de tu entorno de trabajo, o incluso a través de un compañero de escritorio mientras escribes código en tu IDE. Puedes detectar instantáneamente los riesgos del proyecto preguntando: «¿Cuál fue la opinión sobre la última implementación de Gemini 3 Pro?». ClickUp Brain buscará en profundidad en todo tu historial y te proporcionará una respuesta citada con enlaces a la tarea exacta o al hilo de comentarios donde tuvo lugar la discusión.

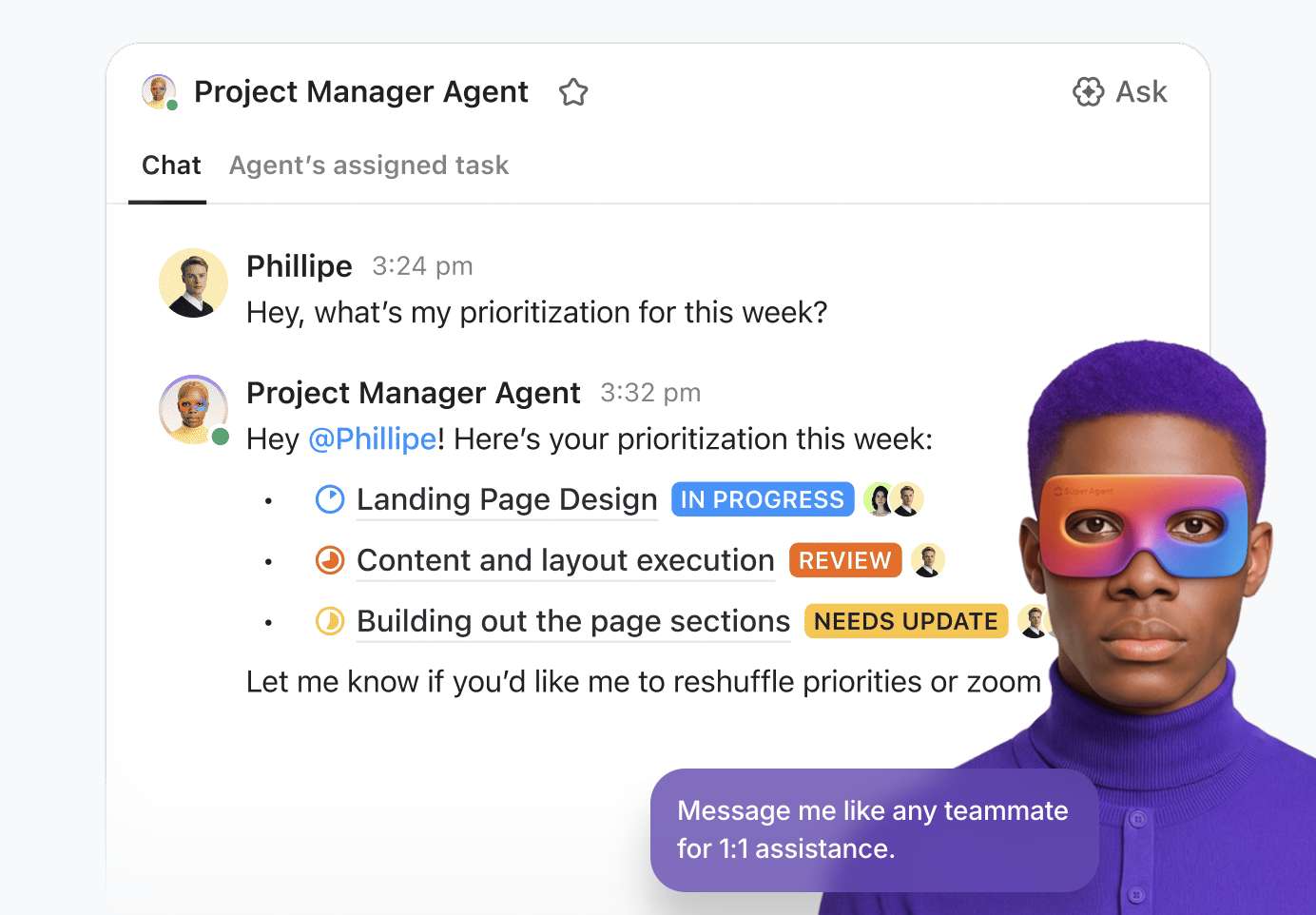

Para los equipos que crean productos de IA complejos, ClickUp va más allá de la simple asistencia al permitirle implementar Superagentes . Se trata de compañeros de equipo digitales autónomos y sin código que se encargan del «trabajo pesado» de su ciclo de vida de desarrollo. Puedes configurar un agente de triaje para supervisar las incidencias entrantes de tu integración Gemini, o un agente de gestión de proyectos que identifica de forma proactiva los obstáculos del sprint y genera resúmenes diarios basados en la actividad de tu equipo. Se trata de un sistema inteligente que mantiene tu canal de desarrollo en funcionamiento las 24 horas del día, los 7 días de la semana.

Una plataforma de gestión del trabajo unificada para el desarrollador moderno

ClickUp Docs sirve como el cuaderno técnico compartido de tu equipo. Ya sea que estés redactando un PRD para una nueva función multimodal o almacenando tus protocolos de seguridad de la API Gemini, todo permanece conectado.

Una línea de código en un documento puede convertirse instantáneamente en una tarea, y ClickUp Brain te permite aprovechar Enterprise Search para recuperar archivos y conversaciones de aplicaciones conectadas como Google Workspace, GitHub y Figma mediante la búsqueda semántica.

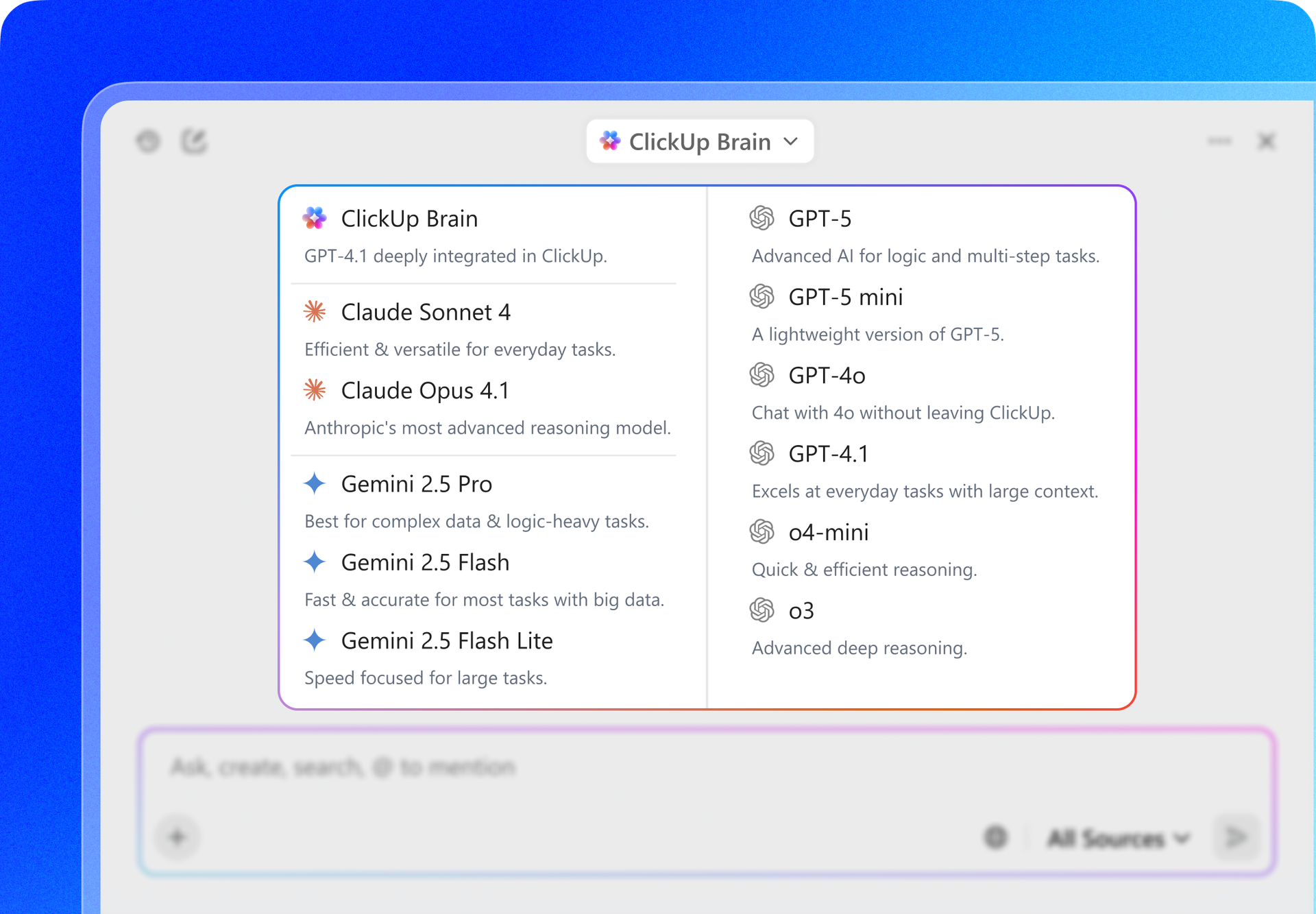

Además, ClickUp ofrece flexibilidad multimodelo. Mientras creas con la API Gemini, puedes utilizar la interfaz de ClickUp para alternar entre Gemini 3, GPT-5. 2 y Claude 4. 5 para comparar resultados o redactar especificaciones técnicas. Esto garantiza que siempre dispongas del mejor «cerebro» para la tarea en cuestión sin tener que salir de tu entorno de gestión de proyectos.

Las mejores funciones de ClickUp

Limitaciones de ClickUp

Precios de ClickUp

Valoraciones y reseñas de ClickUp

¿Qué opinan los usuarios reales sobre ClickUp?

Una reseña de un usuario dice:

Las plantillas, los campos personalizados, las prioridades, los puntos scrum, los planes y las diversas opciones de visualización de ClickUp, a pesar de requerir un ligero aprendizaje, han permitido a nuestro equipo adaptar la herramienta a nuestras necesidades cambiantes y maximizar la eficiencia. Sus potentes integraciones con herramientas como Google Drive, reuniones, calendarios y el sólido soporte de API mejoran nuestro flujo de trabajo a la perfección. Además, los formularios de ClickUp añaden un valor sustancial a nuestras operaciones. En general, todo en ClickUp es tan potente y útil que no quiero cambiar nada. Creo firmemente que ClickUp se ha desarrollado teniendo en cuenta las preferencias de los usuarios, lo que lo hace perfecto para nuestras necesidades.

La ventaja de ClickUp: en lugar de escribir código para conectar tu base de datos a un LLM, BrainGPT, la superaplicación de IA independiente de ClickUp, actúa como una interfaz independiente del modelo que ya está conectada a tus tareas, documentos y repositorios de código.

Te permite:

La plataforma API de OpenAI sigue siendo el principal competidor para los desarrolladores que crean aplicaciones complejas y «inteligentes». Con el lanzamiento de la serie GPT-5. 2, OpenAI ha avanzado hacia el «razonamiento agénico», en el que el modelo se detiene automáticamente para validar su lógica antes de responder.

A diferencia de la estrecha integración de Gemini con el entorno de trabajo de Google, OpenAI ofrece un enfoque «Foundry» más modular, lo que lo convierte en la opción preferida para los desarrolladores que desean una plataforma independiente del proveedor que se adapte a diferentes proveedores de nube, como Azure y AWS.

Gemini 3 Flash, por el contrario, ofrece un procesamiento de vídeo significativamente más rápido y una ventana de contexto mucho más grande, de 2 millones de tokens, mientras que GPT-5. 2 limita actualmente su contexto nativo a 400 000 tokens.

Las mejores funciones de la API de OpenAI

Límites de la API de OpenAI

Precios de la API de OpenAI

Valoraciones y reseñas de la API de OpenAI

¿Qué opinan los usuarios reales sobre OpenAI?

Una reseña de un usuario dice:

Nos han impresionado mucho los modelos de IA y, especialmente, el acceso a la API. Al integrar OpenAI en nuestras soluciones de CRM (BROSH CRM), podemos ofrecer un valor real y tangible a nuestros clientes a través de la automatización impulsada por la IA. OpenAI permite a BROSH CRM proporcionar capacidades avanzadas basadas en la IA en múltiples áreas. Nuestros clientes se benefician de respuestas de IA de alta calidad y sensibles al contexto en sus canales de comunicación, generadas directamente a partir de los datos de CRM. Esto mejora drásticamente las interacciones con los clientes, al tiempo que ahorra tiempo y recursos.

📖 Más información: Cómo utilizar la API de ChatGPT para tus aplicaciones

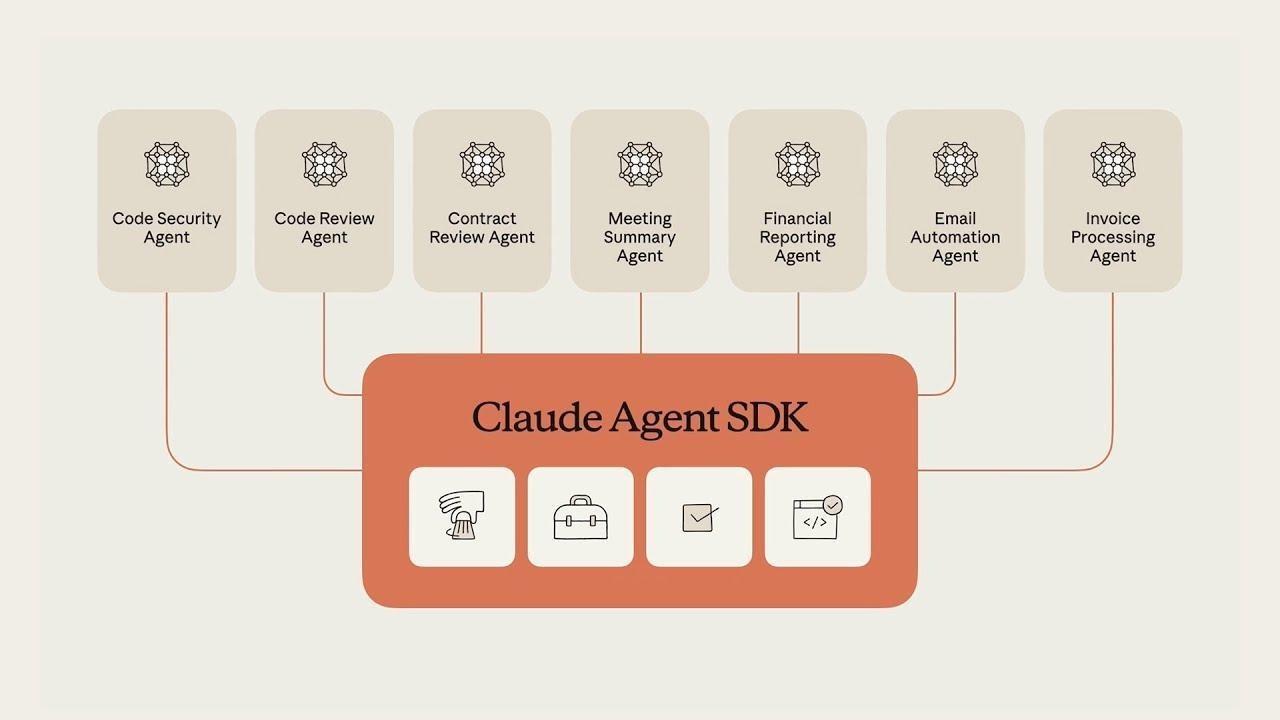

Claude, desarrollado por Anthropic, es la alternativa ideal para los desarrolladores que priorizan la precisión técnica y el razonamiento «similar al humano». Claude 4. 5 Sonnet está ampliamente considerado como el modelo más fiable para la ingeniería de software, superando constantemente a otros en pruebas de código como SWE-bench.

Una de sus funciones más destacadas es Claude Code, una herramienta CLI de agentes que permite al modelo interactuar directamente con tu terminal local y tu sistema de archivos para depurar y enviar código.

Gemini 3 Pro destaca en el procesamiento de grandes cantidades de datos a la vez (como un vídeo de una hora), pero Claude suele ser la opción preferida para tareas en las que el «estilo» y la precisión del resultado son más importantes que el volumen de datos procesados.

Las mejores funciones de la API de Claude

Limitaciones de la API de Claude

Precios de la API de Claude

Valoraciones y reseñas de la API de Claude

¿Qué opinan los usuarios reales sobre la API de Claude?

Una reseña de un usuario dice:

La tarifa de uso de la API es más cara que la de ChatGPT o Gemini, pero si solo quieres hacer preguntas, puedes usar la versión de escritorio, así que no es gran cosa. Sin embargo, no es la mejor opción si quieres incorporarla a una aplicación.

📖 Más información: Cómo utilizar Claude IA para una codificación eficiente y precisa

Mistral AI proporciona modelos de alto rendimiento que ofrecen una alternativa a los sistemas «cerrados» de Google y OpenAI. Se considera líder para las corporaciones que requieren soberanía de datos o desean implementar modelos en su propia infraestructura privada.

Los modelos insignia de Mistral, como Mistral Large 3, están diseñados para ser eficientes y «sin filtros», lo que ofrece a los desarrolladores un mayor control sobre el comportamiento del modelo en comparación con las estrictas medidas de seguridad que suelen encontrarse en Gemini o Claude.

Las mejores funciones de Mistral IA

Limitaciones de Mistral IA

Precios de Mistral IA

Valoraciones y reseñas de Mistral IA

¿Qué opinan los usuarios reales sobre Mistral IA?

Le pregunté por una figura de la historia de nuestro país. GEMINI distinguió correctamente entre dos personas muy diferentes con el mismo nombre y apellido: una era historiadora y profesora universitaria, y la otra, un luchador de la resistencia deportado durante la Segunda Guerra Mundial. Mistral IA solo me dio la descripción de la primera.

Herramientas de IA alternativas que puedes utilizar

Aunque la API Gemini es una potente herramienta multimodal, la creación de una aplicación lista para la producción a menudo requiere una estrategia multimodelo. Dependiendo de las necesidades específicas de su proyecto en cuanto a profundidad de razonamiento o precisión de codificación, puede consultar estas alternativas a Gemini.

1. ClickUp (ideal para equipos que necesitan una IA sensible al contexto integrada en su flujo de trabajo)

La mayoría de las herramientas de IA prometen facilitar el desarrollo, pero a menudo terminan siendo solo otra pestaña desconectada en una pila ya abarrotada. Es posible que utilices la API Gemini para impulsar el backend de tu app, una herramienta independiente para resumir las notas de las reuniones y una tercera plataforma para gestionar tus tareas de sprint. Esta red de contextos dispersos y herramientas aisladas es lo que se conoce como «expansión de la IA».

ClickUp es el primer entorno de trabajo de IA convergente que conecta tus tareas, documentos y personas con una capa de inteligencia central. A diferencia de las API independientes que requieren que crees tus propios sistemas de recuperación de contexto (RAG), ClickUp Brain ya «conoce» todo lo que hay en tu entorno de trabajo.

Dado que la IA está integrada de forma nativa, no solo «genera texto», sino que comprende la relación entre la documentación de la API Gemini, los plazos de tus proyectos y el progreso en tiempo real de tu equipo.

Habilita «Ask IA» desde cualquier lugar e implementa agentes autónomos.

El verdadero poder de ClickUp reside en su capacidad para convertir el conocimiento en acción. Con el Brain Assistant, puedes «preguntar a la IA» desde cualquier lugar de tu entorno de trabajo, o incluso a través de un compañero de escritorio mientras escribes código en tu IDE. Puedes detectar instantáneamente los riesgos del proyecto preguntando: «¿Cuál fue la opinión sobre la última implementación de Gemini 3 Pro?». ClickUp Brain buscará en profundidad en todo tu historial y te proporcionará una respuesta citada con enlaces a la tarea exacta o al hilo de comentarios donde tuvo lugar la discusión.

Para los equipos que crean productos de IA complejos, ClickUp va más allá de la simple asistencia al permitirle implementar Superagentes . Se trata de compañeros de equipo digitales autónomos y sin código que se encargan del «trabajo pesado» de su ciclo de vida de desarrollo. Puedes configurar un agente de triaje para supervisar las incidencias entrantes de tu integración Gemini, o un agente de gestión de proyectos que identifica de forma proactiva los obstáculos del sprint y genera resúmenes diarios basados en la actividad de tu equipo. Se trata de un sistema inteligente que mantiene tu canal de desarrollo en funcionamiento las 24 horas del día, los 7 días de la semana.

Una plataforma de gestión del trabajo unificada para el desarrollador moderno

ClickUp Docs sirve como el cuaderno técnico compartido de tu equipo. Ya sea que estés redactando un PRD para una nueva función multimodal o almacenando tus protocolos de seguridad de la API Gemini, todo permanece conectado.

Una línea de código en un documento puede convertirse instantáneamente en una tarea, y ClickUp Brain te permite aprovechar Enterprise Search para recuperar archivos y conversaciones de aplicaciones conectadas como Google Workspace, GitHub y Figma mediante la búsqueda semántica.

Además, ClickUp ofrece flexibilidad multimodelo. Mientras creas con la API Gemini, puedes utilizar la interfaz de ClickUp para alternar entre Gemini 3, GPT-5. 2 y Claude 4. 5 para comparar resultados o redactar especificaciones técnicas. Esto garantiza que siempre dispongas del mejor «cerebro» para la tarea en cuestión sin tener que salir de tu entorno de gestión de proyectos.

Las mejores funciones de ClickUp

- Búsqueda universal y Ask IA: recupera datos al instante en ClickUp, Slack, GitHub y Drive, o pide a la IA que resuma cualquier documento o hilo de tareas desde cualquier lugar del entorno de trabajo.

- Agentes sin código: Implemente agentes sin código para automatizar la creación de tareas, las actualizaciones de estado y la elaboración de informes, convirtiendo la gestión de proyectos en un flujo de trabajo autónomo.

- Chat con IA integrado: realiza una mención de @Brain en cualquier hilo de chat de ClickUp para convertir instantáneamente una conversación en una tarea con formato u obtener un resumen de una discusión larga.

- Paneles de control con tecnología de IA: visualiza el estado del equipo con paneles de control en tiempo real que utilizan IA para identificar riesgos de sprint, predecir retrasos y explicar las tendencias de los datos en un lenguaje sencillo.

- AI Writer for Docs: redacta requisitos técnicos, POE y agendas de reuniones que se rellenan previamente con los datos y el contexto específicos de tu proyecto.

Limitaciones de ClickUp

- La eficacia de la IA está ligada a la higiene de tu entorno de trabajo; si tu equipo no mantiene actualizadas las tareas y los documentos, la IA tendrá menos «contexto» del que extraer sus respuestas.

Precios de ClickUp

Valoraciones y reseñas de ClickUp

- G2: 4,7/5 (más de 10 900 reseñas)

- Capterra: 4,6/5 (más de 4500 reseñas)

¿Qué opinan los usuarios reales sobre ClickUp?

Una reseña de un usuario dice:

Las plantillas, los campos personalizados, las prioridades, los puntos scrum, los planes y las diversas opciones de visualización de ClickUp, a pesar de requerir un ligero aprendizaje, han permitido a nuestro equipo adaptar la herramienta a nuestras necesidades cambiantes y maximizar la eficiencia. Sus potentes integraciones con herramientas como Google Drive, reuniones, calendarios y el sólido soporte de API mejoran nuestro flujo de trabajo a la perfección. Además, los formularios de ClickUp añaden un valor sustancial a nuestras operaciones. En general, todo en ClickUp es tan potente y útil que no quiero cambiar nada. Creo firmemente que ClickUp se ha desarrollado teniendo en cuenta las preferencias de los usuarios, lo que lo hace perfecto para nuestras necesidades.

Las plantillas, los campos personalizados, las prioridades, los puntos scrum, los planes y las diversas opciones de visualización de ClickUp, a pesar de requerir un ligero aprendizaje, han permitido a nuestro equipo adaptar la herramienta a nuestras necesidades cambiantes y maximizar la eficiencia. Sus potentes integraciones con herramientas como Google Drive, reuniones, calendarios y el sólido soporte de API mejoran nuestro flujo de trabajo a la perfección. Además, los formularios de ClickUp añaden un valor sustancial a nuestras operaciones. En general, todo en ClickUp es tan potente y útil que no quiero cambiar nada. Creo firmemente que ClickUp se ha desarrollado teniendo en cuenta las preferencias de los usuarios, lo que lo hace perfecto para nuestras necesidades.

La ventaja de ClickUp: en lugar de escribir código para conectar tu base de datos a un LLM, BrainGPT, la superaplicación de IA independiente de ClickUp, actúa como una interfaz independiente del modelo que ya está conectada a tus tareas, documentos y repositorios de código.

Te permite:

- Cambia entre modelos: utiliza Gemini 3 para tareas de contexto masivas de 2 millones de tokens y, a continuación, cambia a Claude 4. 5 para obtener una precisión de codificación milimétrica, todo en la misma ventana.

- Búsqueda unificada: Pregunta: «¿Cuáles fueron las especificaciones finales de seguridad de la API que se discutieron en la reunión del mes pasado?», y obtén una respuesta fundamentada extraída simultáneamente de Slack, GitHub y ClickUp Docs.

- Talk-to-Text: Utiliza la aplicación de escritorio BrainGPT para dictar comandos como «Redacta un ticket de Jira para la integración de Gemini y asígnaselo al desarrollador principal» sin necesidad de teclado.

2. API de OpenAI (la mejor para inteligencia de uso general y razonamiento agentivo)

La plataforma API de OpenAI sigue siendo el principal competidor para los desarrolladores que crean aplicaciones complejas y «inteligentes». Con el lanzamiento de la serie GPT-5. 2, OpenAI ha avanzado hacia el «razonamiento agénico», en el que el modelo se detiene automáticamente para validar su lógica antes de responder.

A diferencia de la estrecha integración de Gemini con el entorno de trabajo de Google, OpenAI ofrece un enfoque «Foundry» más modular, lo que lo convierte en la opción preferida para los desarrolladores que desean una plataforma independiente del proveedor que se adapte a diferentes proveedores de nube, como Azure y AWS.

Gemini 3 Flash, por el contrario, ofrece un procesamiento de vídeo significativamente más rápido y una ventana de contexto mucho más grande, de 2 millones de tokens, mientras que GPT-5. 2 limita actualmente su contexto nativo a 400 000 tokens.

Las mejores funciones de la API de OpenAI

- Utiliza el modo de pensamiento para manejar problemas complejos de varios pasos que requieren verificación interna antes de generar una respuesta final.

- Accede a la API en tiempo real para crear experiencias multimodales de baja latencia, incluidas interacciones nativas de voz a voz.

- Aprovecha la API de búsqueda de archivos (Vector Store) para crear sistemas RAG (Retrieval-Augmented Generation) con gestión de documentos integrada.

Límites de la API de OpenAI

- El uso puede resultar muy costoso si no se supervisa cuidadosamente, especialmente cuando se utilizan modelos de alto razonamiento como GPT-5. 2 Pro

Precios de la API de OpenAI

- GPT-5. 2: 1,75 $/1 millón de entradas | 14,00 $/1 millón de salidas

- GPT-5. 2 Pro: 21,00 $/1 millón de entradas | 168,00 $/1 millón de salidas

- GPT-5 Mini: 0,25 $/1 millón de entradas | 2,00 $/1 millón de salidas

Valoraciones y reseñas de la API de OpenAI

- G2: 4,7/5 (más de 840 reseñas)

- Gartner Peer Insights: 4,4/5 (más de 60 opiniones)

¿Qué opinan los usuarios reales sobre OpenAI?

Una reseña de un usuario dice:

Nos han impresionado mucho los modelos de IA y, especialmente, el acceso a la API. Al integrar OpenAI en nuestras soluciones de CRM (BROSH CRM), podemos ofrecer un valor real y tangible a nuestros clientes a través de la automatización impulsada por la IA. OpenAI permite a BROSH CRM proporcionar capacidades avanzadas basadas en la IA en múltiples áreas. Nuestros clientes se benefician de respuestas de IA de alta calidad y sensibles al contexto en sus canales de comunicación, generadas directamente a partir de los datos de CRM. Esto mejora drásticamente las interacciones con los clientes, al tiempo que ahorra tiempo y recursos.

Nos han impresionado mucho los modelos de IA y, especialmente, el acceso a la API. Al integrar OpenAI en nuestras soluciones de CRM (BROSH CRM), podemos ofrecer un valor real y tangible a nuestros clientes a través de la automatización impulsada por la IA. OpenAI permite a BROSH CRM proporcionar capacidades avanzadas basadas en la IA en múltiples áreas. Nuestros clientes se benefician de respuestas de IA de alta calidad y sensibles al contexto en sus canales de comunicación, generadas directamente a partir de los datos de CRM. Esto mejora drásticamente las interacciones con los clientes, al tiempo que ahorra tiempo y recursos.

📖 Más información: Cómo utilizar la API de ChatGPT para tus aplicaciones

3. API de Claude (ideal para codificación de alto riesgo y redacción técnica matizada)

Claude, desarrollado por Anthropic, es la alternativa ideal para los desarrolladores que priorizan la precisión técnica y el razonamiento «similar al humano». Claude 4. 5 Sonnet es ampliamente considerado como el modelo más fiable para la ingeniería de software, superando constantemente a otros en pruebas de rendimiento de código como SWE-bench.

Una de sus funciones más destacadas es Claude Code, una herramienta CLI de agentes que permite al modelo interactuar directamente con tu terminal local y tu sistema de archivos para depurar y enviar código.

Gemini 3 Pro destaca en el procesamiento de grandes cantidades de datos a la vez (como un vídeo de 1 hora), pero Claude suele ser la opción preferida para tareas en las que el «estilo» y la precisión del resultado son más importantes que el volumen de datos procesados.

Las mejores funciones de la API de Claude

- Mantén la lógica de proyectos complejos utilizando Claude Projects, que te permite agrupar documentos y códigos relacionados para mejorar el contexto.

- Utiliza Prompt Caching para reducir significativamente los costes y la latencia de las solicitudes repetitivas y de gran volumen.

- Ejecuta y prueba el código en tiempo real dentro del entorno del modelo utilizando la herramienta de análisis (ejecución de código).

Limitaciones de la API de Claude

- Actualmente, Claude carece de herramientas nativas de generación de imágenes o vídeos, lo que obliga a los desarrolladores a integrarse con API de terceros para el trabajo creativo visual.

Precios de la API de Claude

- Claude 4. 5 Opus: 15,00 $/1 millón de entradas | 75,00 $/1 millón de salidas

- Claude 4. 5 Sonnet: 3,00 $/1 millón de entradas | 15,00 $/1 millón de salidas

- Claude 4. 5 Haiku: 1,00 $/1 millón de entradas | 5,00 $/1 millón de salidas

Valoraciones y reseñas de la API de Claude

- G2: 4,4/5 (más de 55 reseñas)

- Capterra: 4,6/5 (más de 20 reseñas)

¿Qué opinan los usuarios reales sobre la API de Claude?

Una reseña de un usuario dice:

La tarifa de uso de la API es más cara que la de ChatGPT o Gemini, pero si solo quieres hacer preguntas, puedes usar la versión de escritorio, así que no es gran cosa. Sin embargo, no es la mejor opción si quieres incorporarla a una aplicación.

La tarifa de uso de la API es más cara que la de ChatGPT o Gemini, pero si solo quieres hacer preguntas, puedes usar la versión de escritorio, así que no es gran cosa. Sin embargo, no es la mejor opción si quieres incorporarla a una app.

📖 Más información: Cómo utilizar Claude IA para una codificación eficiente y precisa

4. Mistral IA (la mejor opción en cuanto a flexibilidad de peso abierto y soberanía de datos)

Mistral IA proporciona modelos de alto rendimiento que ofrecen una alternativa a los sistemas «cerrados» de Google y OpenAI. Se considera líder para las corporaciones que requieren soberanía de datos o desean implementar modelos en su propia infraestructura privada.

Los modelos insignia de Mistral, como Mistral Large 3, están diseñados para ser eficientes y «sin filtros», lo que ofrece a los desarrolladores un mayor control sobre el comportamiento del modelo en comparación con las estrictas medidas de seguridad que suelen encontrarse en Gemini o Claude.

Las mejores funciones de Mistral IA

- Implemente modelos en su propio hardware o VPC (nube privada virtual) para obtener la máxima privacidad y seguridad de los datos.

- Utiliza Mistral Memories para guardar y recuperar el contexto clave en diferentes sesiones sin tener que reenviar los datos manualmente.

- Accede al Directorio de conectores para enlazar fácilmente tus modelos a fuentes de datos externas como Notion, GitHub y Slack.

Limitaciones de Mistral IA

- La documentación y el soporte de la comunidad para Mistral no son tan amplios como los de Google u OpenAI, lo que puede suponer una curva de aprendizaje más pronunciada para los nuevos desarrolladores.

Precios de Mistral IA

- Mistral Large 3: 2,00 $/1 millón de entradas | 6,00 $/1 millón de salidas

- Mistral Small: 0,20 $/1 millón de entradas | 0,60 $/1 millón de salidas

- Mistral Free: límite en el acceso a la API para realizar pruebas.

Valoraciones y reseñas de Mistral IA

- G2: 4,4/5 (reseñas iniciales con límite)

- Capterra: 4,5/5 (reseñas iniciales con límite de comentarios)

¿Qué opinan los usuarios reales sobre Mistral IA?

Le pregunté por una figura de la historia de nuestro país. GEMINI distinguió correctamente entre dos personas muy diferentes con el mismo nombre y apellido: una era historiadora y profesora universitaria, y la otra, un luchador de la resistencia deportado durante la Segunda Guerra Mundial. Mistral IA solo me dio la descripción de la primera.

Le pregunté por una figura de la historia de nuestro país. GEMINI distinguió correctamente entre dos personas muy diferentes con el mismo nombre y apellido: una era historiadora y profesora universitaria, y la otra, un luchador de la resistencia deportado durante la Segunda Guerra Mundial. Mistral IA solo me dio la descripción de la primera.

📖 Más información: Las mejores alternativas a Mistral IA para modelos lingüísticos avanzados

Las API se simplifican con ClickUp

Comenzar a utilizar la API de Google Gemini es muy sencillo: obtienes una clave, instalas un SDK y realizas tu primera llamada a la API. Pero a medida que pasas de un script sencillo a una aplicación de producción, surgen los verdaderos retos: gestionar claves, documentar indicaciones y mantener organizado el trabajo de tu equipo.

La API Gemini ofrece potentes capacidades de IA, pero integrarla en tu flujo de trabajo puede generar documentación dispersa, un seguimiento fragmentado de los proyectos y un cambio de contexto interminable.

Los equipos que centralizan su desarrollo de IA junto con la gestión de tareas y la documentación avanzan más rápido y mantienen un mejor contexto. La elección del lugar donde organices este trabajo determinará la eficacia con la que puedas innovar y colaborar.

Empieza gratis con ClickUp y descubre cómo un entorno de trabajo convergente puede transformar tu proceso de desarrollo de IA.

Preguntas frecuentes sobre la API Gemini

Sí, Google ofrece un generoso nivel gratuito para Gemini 3 Flash y Pro a través de Google AI Studio. Sin embargo, las herramientas especializadas como Google Search Grounding tienen un coste (14 $ por cada 1000 consultas) después de las primeras 5000 indicaciones al mes.

Google AI Studio es una herramienta basada en la web para experimentar con indicaciones y generar rápidamente claves de API. La API Gemini es la interfaz programática que se utiliza en el código para incorporar esas capacidades de IA en las propias aplicaciones.

Sí, la API Gemini admite conversaciones de varios turnos, lo que la convierte en una excelente opción para crear chatbots internos, bots de soporte al cliente o asistentes de equipo. Utilizarías la API como el «cerebro» del chatbot y crearías la interfaz de usuario por separado.

Los límites de velocidad varían en función del modelo que utilices y de si estás en el nivel gratuito o de pago. El nivel gratuito tiene límites más bajos en las solicitudes por minuto, mientras que los planes de pago ofrecen un mayor rendimiento para las aplicaciones de producción.