Los motores de búsqueda siempre han sido esenciales para encontrar información, pero el comportamiento de los usuarios ha evolucionado. En lugar de búsquedas simples por palabras clave como «teléfonos inteligentes», ahora la gente realiza consultas más específicas y personalizadas como «los mejores teléfonos económicos para jugar».

Mientras tanto, los modelos de lenguaje grandes (LLM), como ChatGPT, transforman la búsqueda al actuar como sistemas inteligentes de preguntas y respuestas.

Al integrarse con los motores de búsqueda tradicionales, mejoran la recuperación de información mediante la generación aumentada por recuperación (RAG), lo que hace que los resultados sean más precisos y sensibles al contexto.

En lugar de competir, los LLM y los motores de búsqueda trabajan juntos para gestionar consultas complejas de forma más eficaz. En este artículo, exploraremos cómo esta integración está dando forma al futuro de las búsquedas.

⏰ Resumen de 60 segundos

- Los motores de búsqueda tradicionales suelen tener dificultades para gestionar grandes conjuntos de datos, mantener la calidad de los datos y romper los silos.

- También se enfrentan a retos en materia de seguridad, escalabilidad y obtención de resultados contextualmente relevantes.

- Los modelos de lenguaje grandes, como ChatGPT, aumentan la precisión de la búsqueda, permiten la búsqueda semántica y ofrecen compatibilidad con consultas en lenguaje natural.

- Los LLM también mejoran las capacidades de búsqueda multimodal y hacen que el descubrimiento de conocimientos sea más personalizado y eficiente.

- Las funciones de búsqueda conectada y IA de ClickUp se basan en estos avances al centralizar sus datos, lo que permite una recuperación de información rápida y precisa.

- ClickUp se integra a la perfección con diversas plataformas, lo que le permite acceder a su contenido en tiempo real, optimizar los flujos de trabajo y mejorar la productividad general.

Sin más preámbulos, ¡vamos a ello!

¿Qué son los LLM?

Los modelos de lenguaje grandes (LLM) son sistemas avanzados de inteligencia artificial que procesan y generan lenguaje humano. Se entrenan con amplios conjuntos de datos de texto, lo que les permite realizar tareas como traducción, resumen y conversaciones.

Algunos de los ejemplos más populares de LLM son GPT-3 y GPT-4, ampliamente reconocidos por su capacidad para gestionar consultas complejas relacionadas con el lenguaje.

A diferencia de los motores de búsqueda tradicionales que dependen de palabras clave, un motor de búsqueda basado en LLM va más allá de las consultas superficiales. Entiende el contexto y la intención detrás de las preguntas, y ofrece respuestas directas y detalladas.

👀 ¿Sabías que... El 71 % de los usuarios prefiere la personalización de las marcas y empresas que eligen.

Funciones de los motores de búsqueda LLM

Los motores de búsqueda LLM ofrecen capacidades avanzadas que redefinen la forma en que los usuarios de Internet acceden a la información e interactúan con ella. Examinemos sus funciones clave:

- Comprensión semántica de las consultas: los motores de búsqueda LLM interpretan el significado que hay detrás de las consultas de búsqueda, yendo más allá de las palabras clave para comprender la intención y el contexto del usuario.

- Procesamiento del lenguaje natural (NLP): los usuarios pueden formular consultas de forma coloquial sin necesidad de utilizar palabras clave exactas, lo que hace que las búsquedas sean más intuitivas.

- Relevancia contextual: los resultados de búsqueda se personalizan en función de consultas e interacciones anteriores, lo que garantiza una información más relevante y actualizada.

- Generación de respuestas: estos sistemas proporcionan respuestas completas directamente en los resultados de búsqueda, incluyendo resúmenes, explicaciones e incluso formatos creativos como historias o guías paso a paso.

- Integración de grafos de conocimiento: los motores de búsqueda LLM utilizan grafos de conocimiento para establecer conexiones entre conceptos y entidades relacionados, lo que ofrece una visión más profunda.

- Búsqueda conversacional: los usuarios pueden entablar una conversación bidireccional, haciendo preguntas de seguimiento y refinando sus búsquedas para disfrutar de una experiencia más interactiva.

- Resultados adaptables: los resultados se ajustan dinámicamente en función de la ubicación, los intereses y las búsquedas anteriores, lo que proporciona una experiencia más personalizada.

- Síntesis de información: en lugar de basarse en una única fuente, los motores de búsqueda LLM agregan datos de múltiples fuentes, lo que proporciona una perspectiva más amplia.

👀 ¿Sabías que... Con el uso cada vez mayor de altavoces inteligentes y asistentes de voz, el 50 % de todas las búsquedas se realizan ahora por voz. A medida que se integren modelos de lenguaje grandes en estos sistemas, las búsquedas por voz serán aún más precisas y proporcionarán un acceso más rápido a la información en múltiples plataformas, ya sean archivos, tareas o notas de reuniones.

Técnicas de búsqueda avanzadas con LLM

A medida que avanza la tecnología de búsqueda, los LLM como GPT-4, BERT y T5 están transformando la forma en que los motores de búsqueda procesan las consultas, personalizan los resultados y refinan las clasificaciones. Exploremos cómo estos modelos están redefiniendo el futuro de la búsqueda.

Cómo envían las LLM las consultas de búsqueda

La búsqueda ha evolucionado desde simples consultas por palabras clave hasta búsquedas semánticas vectoriales. En lugar de buscar un término específico como «Monte Fuji», los usuarios pueden buscar «montañas en Japón» y el sistema recupera resultados basados en el significado.

Reformular las consultas en forma de preguntas, como «¿Cuáles son las montañas más famosas de Japón?», puede refinar la precisión de la búsqueda. Los modelos de lenguaje grandes (LLM) también mejoran las búsquedas al actuar como desencadenantes de consultas adicionales si la confianza es baja, utilizando técnicas como FLARE.

El razonamiento en cadena mejora aún más las búsquedas al dividir las tareas en pasos lógicos, como se ve en AutoGPT. Además, la búsqueda conversacional permite a los asistentes impulsados por LLM refinar las consultas en tiempo real, lo que garantiza resultados más precisos a lo largo de una interacción.

Búsqueda personalizada y reconocimiento del contexto

La conciencia contextual es una de las funciones más potentes de los LLM. A diferencia de los motores de búsqueda tradicionales, que clasifican los resultados por coincidencias de palabras clave, los LLM tienen en cuenta la intención del usuario, la ubicación, el historial de búsqueda y las interacciones anteriores.

Mediante el ajuste con datos específicos del dominio, los LLM personalizan los resultados de búsqueda para reconocer patrones y priorizar el contenido relevante. Por ejemplo, un usuario que busca con frecuencia recetas veganas verá opciones basadas en plantas cuando busque «las mejores recetas para la cena».

Los LLM también interpretan consultas multimodales, entendiendo tanto el texto como las imágenes para obtener resultados más precisos. Además, crean un contexto longitudinal, aprendiendo de las interacciones continuas para sugerir consultas relevantes de forma proactiva.

Los LLM en la reclasificación y mejora de los resultados de los motores de búsqueda

Los LLM mejoran los motores de búsqueda al reordenar dinámicamente los resultados para reflejar mejor la intención del usuario. A diferencia de la clasificación tradicional basada en palabras clave, los LLM utilizan mecanismos de atención para analizar el contexto completo de una consulta y dar prioridad al contenido relevante.

Por ejemplo, la actualización BERT (Bidirectional Encoder Representations from Transformers) de Google revolucionó las búsquedas al comprender el contexto detrás de palabras como «apple» (manzana) frente a «Apple» (empresa tecnológica).

Los LLM también contribuyen a mejorar la eficiencia de las SERP (páginas de resultados de los motores de búsqueda). Mediante el análisis de factores como la tasa de clics (CTR), la tasa de rebote y el tiempo de permanencia, los LLM pueden ajustar las clasificaciones en tiempo real, potenciando los resultados que proporcionan un alto nivel de interacción por parte de los usuarios.

📖 Lea también: Cómo buscar rápidamente en archivos PDF

Herramientas populares de motores de búsqueda LLM

A medida que evoluciona la búsqueda impulsada por IA, varios motores de búsqueda con modelos de lenguaje grandes están ganando terreno por sus capacidades avanzadas. Perplexity AI proporciona respuestas directas con fuentes citadas, lo que hace que las búsquedas sean más interactivas e informativas.

You. com ofrece una experiencia personalizable, que permite a los usuarios priorizar fuentes, integrar resúmenes generados por IA e interactuar con asistentes de IA.

Todos sabemos que podemos recurrir a estos motores de búsqueda para recuperar información y obtener respuestas rápidas. Pero, ¿qué hay de la ubicación de ese archivo crucial en el trabajo? ¿O recuperar una conversación llena de datos para su próxima gran presentación?

¡Aquí es donde entra en escena ClickUp, la aplicación que lo tiene todo para el trabajo!

📮 ClickUp Insight: el 46 % de los trabajadores del conocimiento utilizan una combinación de chat, notas, herramientas de gestión de proyectos y documentación del equipo solo para realizar el seguimiento de su trabajo. Para ellos, el trabajo se encuentra disperso en plataformas desconectadas, lo que dificulta mantenerse organizado. Como la aplicación integral para el trabajo, ClickUp lo unifica todo. Con funciones como ClickUp Gestión de proyectos por correo electrónico, ClickUp Notes, ClickUp Chat y ClickUp Brain, todo su trabajo se centraliza en un solo lugar, se puede buscar y se conecta a la perfección. Diga adiós a la sobrecarga de herramientas y dé la bienvenida a la productividad sin esfuerzo.

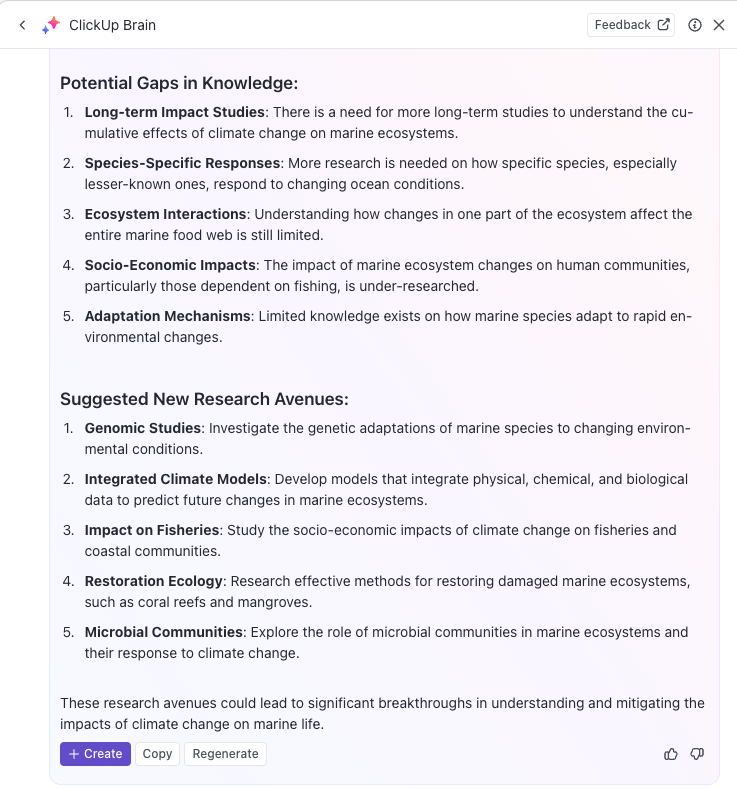

ClickUp Brain combina capacidades de búsqueda avanzadas con funciones completas de gestión de proyectos, conectando tareas, archivos, miembros del equipo y proyectos, todo en un solo lugar. ¡Se acabó cambiar de aplicación o lidiar con herramientas fragmentadas y silos de información!

Los costes de la ineficiencia debida a herramientas desconectadas son astronómicos:

- 2. 5 horas al día: los trabajadores del conocimiento dedican alrededor del 30 % de su jornada laboral a buscar información.

- 3600 cambios de aplicación al día: los empleados cambian entre aplicaciones y ventanas más de 3600 veces al día, lo que les hace perder 4 horas a la semana en reorientarse.

- 23 minutos perdidos: cada cambio de aplicación interrumpe la concentración, y se tarda casi 23 minutos en volver a centrarse.

420 000 dólares al año: las organizaciones con 100 empleados pierden esta cantidad cada año debido a la falta de comunicación y a la desconexión entre herramientas.

Estas ineficiencias provocan pérdidas de tiempo, disminución de la moral y aumento de los costes operativos. Afortunadamente, Connected IA convierte estos retos en oportunidades para una toma de decisiones más inteligente, una recuperación de información más rápida y una ejecución fluida.

Así es como la búsqueda conectada de ClickUp transforma la colaboración:

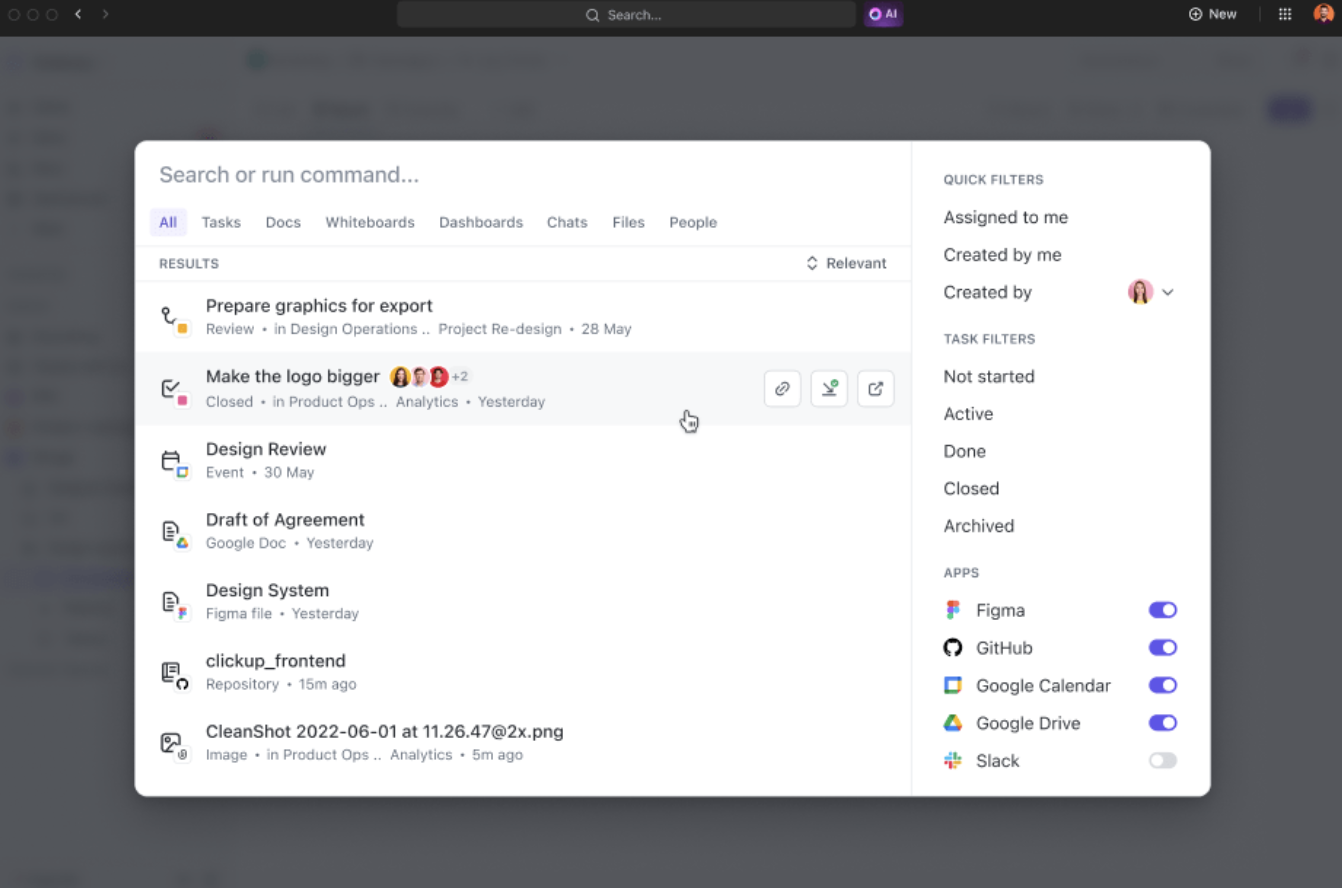

- Búsqueda unificada: acceda a toda la información de su corporación desde una única plataforma, lo que le permitirá ahorrar casi cuatro horas a la semana al reducir el cambio entre aplicaciones.

- Relevancia impulsada por IA: obtenga resultados de búsqueda personalizados y sensibles al contexto, adaptados a sus proyectos, lo que mejora la toma de decisiones con acceso instantáneo a la información más relevante.

- Integración sencilla de herramientas: conéctese sin problemas con herramientas existentes como Google Drive, SharePoint, Figma y Slack sin necesidad de configuraciones complejas.

Por ejemplo, cuando regrese de unas vacaciones, simplemente pida a ClickUp Brain que le informe sobre las novedades de sus proyectos. Le proporcionará una lista ordenada con los elementos clave, las acciones críticas y las discusiones que se produjeron mientras usted estaba fuera.

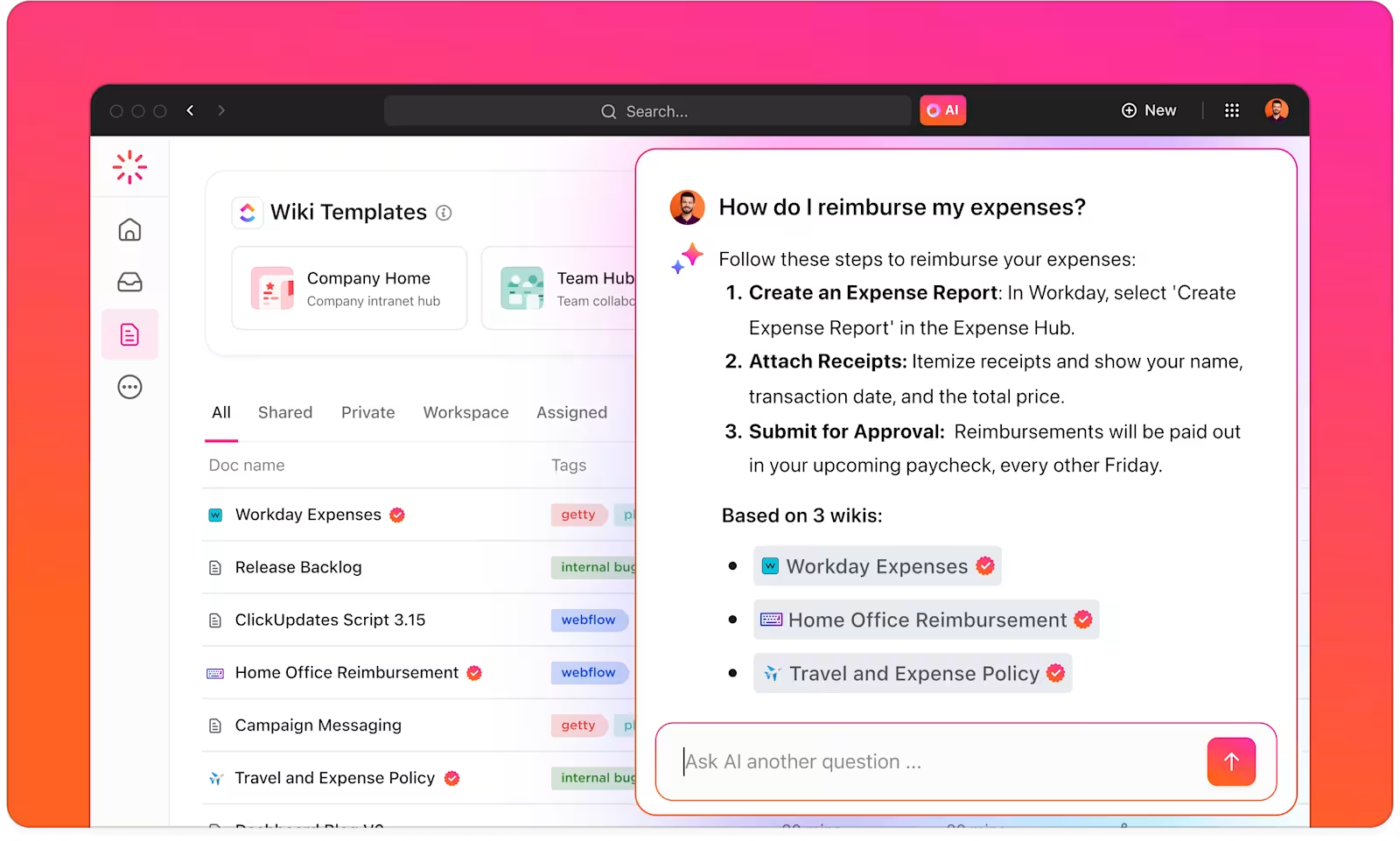

Con ClickUp Brain, dispondrá de un gestor de conocimientos inteligente que le ayudará a encontrar todo lo que necesite dentro de su entorno de trabajo y las aplicaciones conectadas.

ClickUp Brain comprende el contexto de sus tareas y ofrece sugerencias relevantes basadas en sus preferencias de trabajo o actividades principales. Para los creadores de contenido, por ejemplo, proporciona sugerencias para la creación de contenido, la lluvia de ideas y tareas relacionadas.

Incluso puede utilizar la IA para automatizar tareas repetitivas o actualizar el estado de las tareas con simples indicaciones, lo que le permite centrarse en el trabajo profundo. Si busca un potente motor de búsqueda con IA para aumentar la productividad, ClickUp Brain es lo que necesita.

Con ClickUp Brain, puede optimizar su base de conocimientos clasificando, etiquetando y organizando automáticamente toda la información relevante.

Por ejemplo, los equipos de investigación pueden utilizar ClickUp para crear un sistema centralizado de gestión del conocimiento en el que almacenar todos los conocimientos, documentos y resultados de investigación en un formato fácilmente accesible.

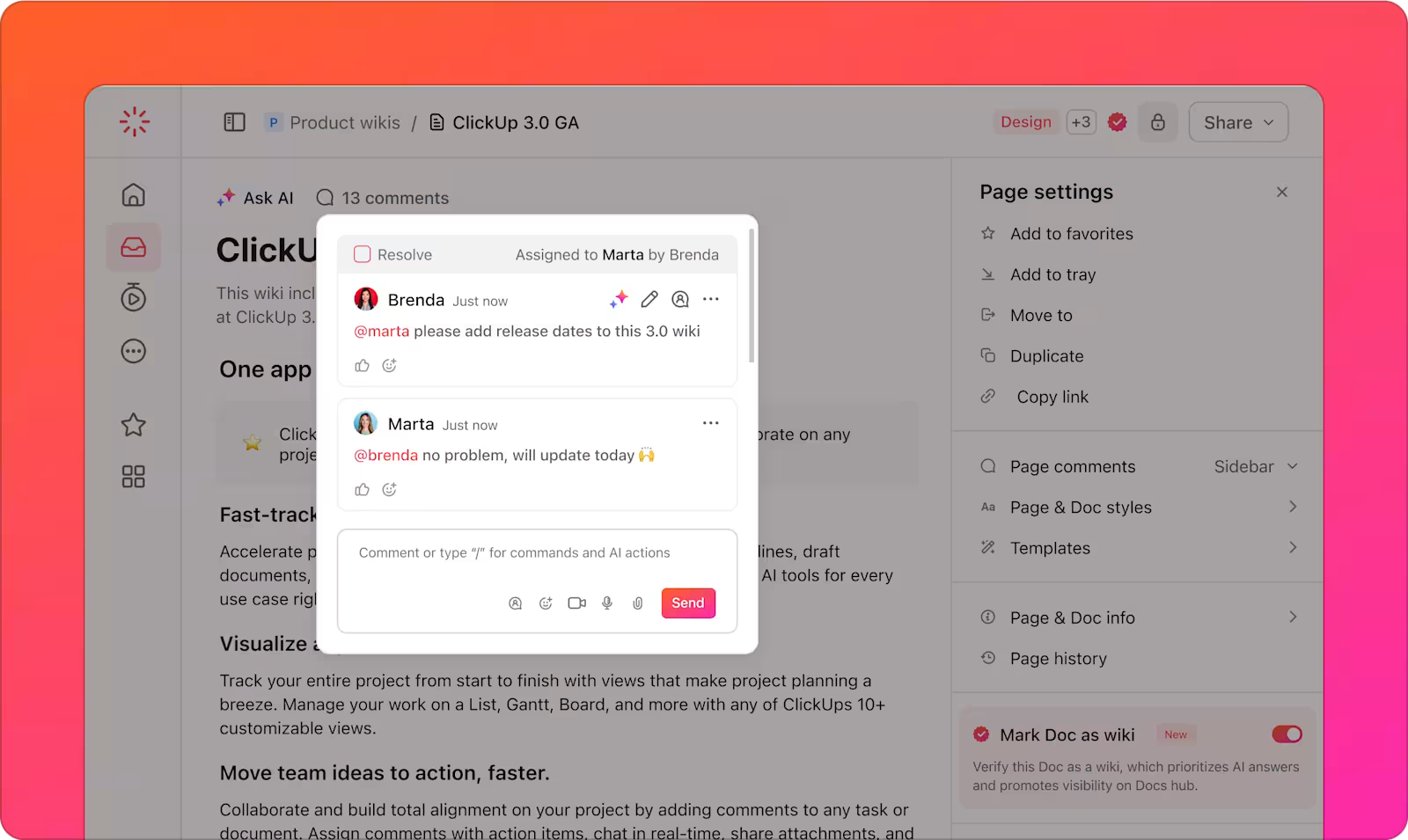

Además, la versatilidad de ClickUp Docs permite la creación de wikis, repositorios de documentos y la gestión de tareas relacionadas con el conocimiento.

También puede organizar la información de diversas formas, utilizando ClickUp espacios, carpetas y listas para estructurar el contenido y poder recuperarlo rápidamente. Su equipo podrá encontrar y acceder fácilmente a los datos adecuados cuando los necesite, sin perder tiempo buscando en múltiples plataformas.

Además, la plataforma ayuda al seguimiento de las tareas y los proyectos a través de las tareas de ClickUp, basándose en la información obtenida de los motores de búsqueda LLM. Puede integrar los resultados de búsqueda impulsados por IA directamente en sus flujos de trabajo de seguimiento de tareas y proyectos, lo que facilita la implementación de los conocimientos que ha descubierto.

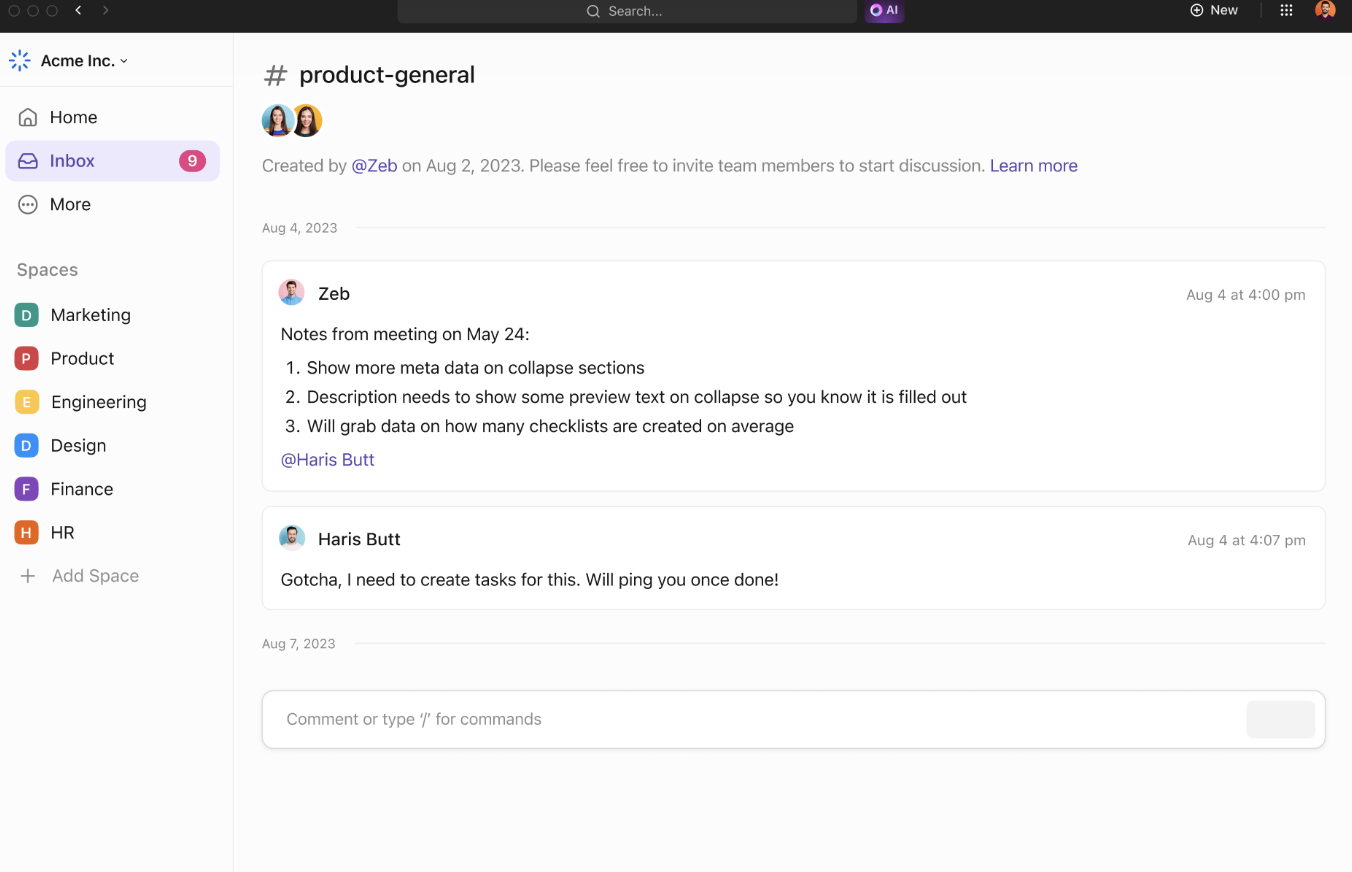

Las herramientas de colaboración de ClickUp refuerzan aún más la eficiencia del equipo y el intercambio de información. ClickUp Chat permite a los miembros del equipo debatir proyectos, compartir ideas y hacer preguntas en tiempo real.

Los comentarios asignados proporcionan una forma clara de comunicarse sobre documentos o tareas específicos, lo que garantiza que todos estén informados sobre las actualizaciones del proyecto.

Los equipos pueden colaborar mediante el uso compartido de ideas y la visualización de conceptos. Añada notas, cargue imágenes e incruste enlaces para mejorar el contexto. Utilice conectores para enlazar ideas y resaltar sus relaciones.

Cuando tenga listas sus ideas, conviértalas en tareas rastreables desde ClickUp Pizarras para mantener todo según lo previsto.

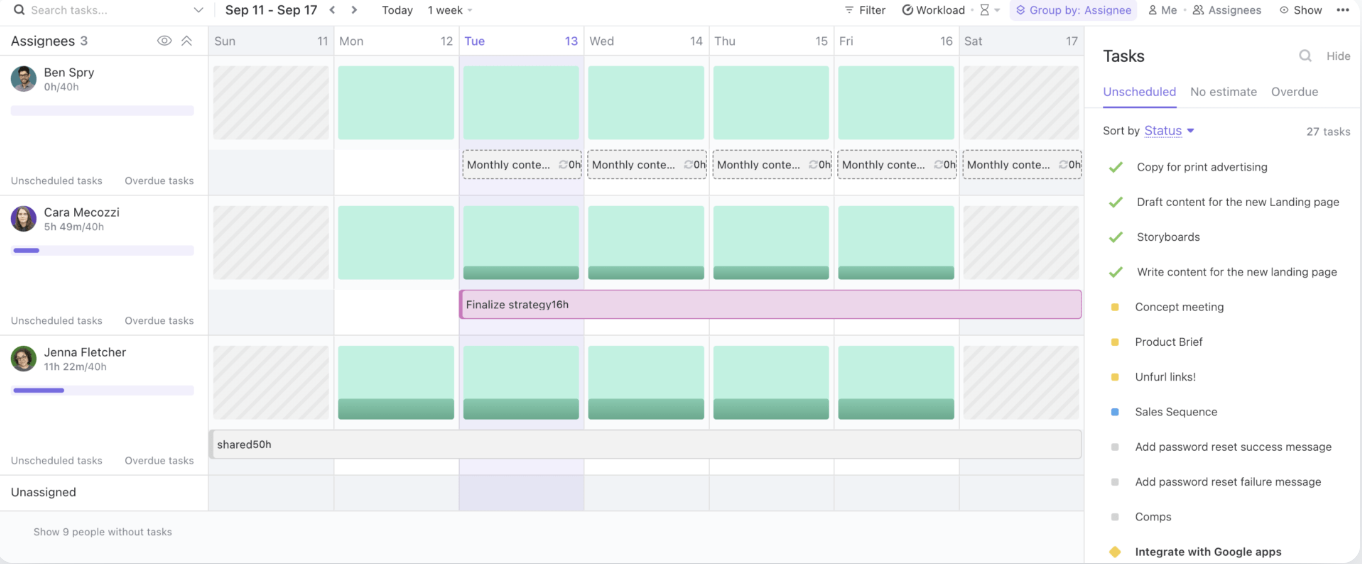

Por último, la vista Carga de trabajo de ClickUp le permite gestionar la capacidad del equipo, realizar el seguimiento de las tareas en curso y asignar los recursos de forma eficaz.

Al proporcionar un hub centralizado para el intercambio de conocimientos y la colaboración, ClickUp agiliza los flujos de trabajo y mejora la eficiencia del equipo.

📖 Lea también: El mejor software de gestión de documentos para organizarse

Buenas prácticas para el uso de motores de búsqueda LLM

Al utilizar motores de búsqueda LLM, es esencial seguir las buenas prácticas que maximizan su potencial y gestionan los riesgos.

Estas estrategias le ayudarán a sacar el máximo partido a sus herramientas de IA, garantizando una implementación fluida y un éxito a largo plazo:

- Defina casos de uso claros: colabore desde el principio entre los equipos comerciales y técnicos para establecer casos de uso específicos y medibles. Alinee los objetivos para garantizar que la solución satisfaga las necesidades adecuadas y facilite la evaluación del progreso.

- Establezca procesos de admisión bien pensados: tenga en cuenta la sensibilidad de los datos, los riesgos potenciales y los usuarios previstos al priorizar los casos de uso. Utilice un enfoque por niveles de riesgo para evaluar qué proyectos aportan más valor con el mínimo daño.

- Céntrese en la recopilación, prueba y validación de datos: garantice datos sólidos y basados en hechos mejorando las prácticas de recopilación, rótulos, almacenamiento y procesamiento.

- Implemente procedimientos de prueba estandarizados: Cree procesos de prueba repetibles respaldados por manuales y prácticas predefinidas. Garantice resultados consistentes, la fiabilidad del sistema y modelos de IA bien probados antes de la implementación.

- Configure la supervisión continua: supervise el rendimiento del sistema a lo largo del tiempo, adaptándose a los cambios en los datos, el comportamiento de los usuarios y la tecnología.

- Lance campañas de formación y comunicación: Dote a su equipo de los conocimientos necesarios para utilizar las herramientas de IA de forma responsable y eficaz. Ponga en marcha programas de formación y comunicación que abarquen tanto los aspectos técnicos como los éticos de la IA.

Retos y soluciones en la búsqueda impulsada por LLM

Los motores de búsqueda basados en LLM ofrecen un enorme potencial, pero también plantean una serie de retos. A continuación se presentan algunos retos comunes de la IA y soluciones prácticas para superarlos:

Calidad y relevancia de los datos

Los motores de búsqueda basados en LLM dependen en gran medida de la calidad y la relevancia de los datos que procesan. Los datos deficientes u obsoletos pueden dar lugar a resultados de búsqueda inexactos o irrelevantes, lo que afecta a la experiencia del usuario.

✨ Al centrarse en datos de alta calidad y actualizados, las organizaciones pueden garantizar que su motor de búsqueda basado en LLM ofrezca resultados relevantes y fiables.

Falta de transparencia

Los modelos LLM suelen considerarse «cajas negras», ya que el razonamiento que hay detrás de sus resultados no es inmediatamente evidente para los usuarios. Esta falta de transparencia puede hacer que a los usuarios les resulte difícil confiar en los resultados que obtienen.

✨ Al incorporar funciones de explicabilidad en el motor de búsqueda, las organizaciones pueden ofrecer a los usuarios información sobre por qué se han obtenido resultados específicos.

Sesgos y cuestiones éticas

Los LLM pueden heredar sesgos de los datos con los que se entrenan, lo que puede dar lugar a resultados sesgados o poco éticos. Si los datos de entrenamiento no son diversos o representativos, el motor de búsqueda podría reflejar esos sesgos, lo que afectaría a la toma de decisiones y a la imparcialidad.

✨ La auditoría y actualización periódicas de los datos de entrenamiento son esenciales para identificar y mitigar estos sesgos. Además, la incorporación de conjuntos de datos diversos y la supervisión de los resultados garantizan que el motor de búsqueda produzca resultados más equilibrados, justos y éticos.

Complejidad e integración del sistema

La integración de los motores de búsqueda basados en LLM con los flujos de trabajo y las aplicaciones existentes puede resultar abrumadora, sobre todo cuando se trata de sistemas heredados o múltiples fuentes de datos. La complejidad de la conexión de estas nuevas herramientas con plataformas ya establecidas puede ralentizar la implementación.

✨ Con la búsqueda conectada de ClickUp, puede encontrar rápidamente cualquier archivo, ya sea que esté almacenado en ClickUp, en una aplicación conectada o en su unidad local.

El problema de las alucinaciones

Las alucinaciones se refieren a instancias en las que el modelo genera información objetivamente incorrecta, inventada o irrelevante. Esto ocurre porque el modelo, en lugar de extraerla directamente de fuentes indexadas, a veces «alucina» datos basándose en patrones aprendidos durante el entrenamiento.

✨ Las técnicas avanzadas, como la ingeniería de indicaciones y los datos de entrenamiento de alta calidad, mejoran la fiabilidad de LLM. El ajuste con datos específicos del dominio reduce las alucinaciones, mientras que la integración del gráfico de conocimiento garantiza resultados de búsqueda precisos y basados en hechos.

El futuro de la búsqueda con LLM

La próxima generación de búsquedas impulsadas por LLM promete una precisión, adaptabilidad y capacidad de respuesta aún mayores, especialmente en el manejo de consultas complejas y dinámicas de los usuarios. Estos sistemas se adaptarán dinámicamente a las necesidades cambiantes de los usuarios, aprendiendo de interacciones anteriores y datos en tiempo real.

Por ejemplo, en un entorno de corporación, un LLM podría interpretar una solicitud como «Buscar el análisis de la pérdida de clientes del último trimestre» y devolver no solo el archivo sin procesar, sino también información sintetizada, tendencias relevantes y conclusiones prácticas.

Las industrias que dependen de la gestión de conjuntos de datos vastos y complejos son las que más se beneficiarán:

- En el ámbito de la atención sanitaria, los modelos de lenguaje grandes pueden contribuir a la precisión del diagnóstico mediante el análisis y la comparación de notas clínicas, resultados de imágenes y artículos de investigación en cuestión de segundos.

- Los profesionales del ámbito jurídico se beneficiarán de herramientas que pueden analizar la extensión de la jurisprudencia para destacar los precedentes relevantes.

- Los equipos financieros pueden utilizar los LLM para tareas como la detección de fraudes en tiempo real, el análisis predictivo de mercados y la automatización de las comprobaciones de cumplimiento normativo.

La integración de capacidades de búsqueda multimodal, que combinan el reconocimiento del texto, la voz e imágenes, ampliará aún más la utilidad de los LLM.

Por ejemplo, un equipo que colabora en el lanzamiento de un producto podría cargar imágenes al instante, añadir anotaciones con entradas de voz y recuperar documentos e informes relacionados. Este nivel de adaptabilidad hace que los LLM sean cruciales para garantizar un acceso fluido a diversos formatos de datos.

Plataformas como ClickUp, combinadas con la búsqueda impulsada por LLM, ofrecen una solución robusta para organizar y acceder a archivos, optimizar los flujos de trabajo e impulsar la eficiencia en la toma de decisiones.

Potencia tu flujo de trabajo con la búsqueda impulsada por LLM.

A medida que los motores de búsqueda impulsados por IA y basados en LLM continúan evolucionando, están revolucionando la forma en que las empresas recuperan información de las páginas web y gestionan los datos.

Gracias a su capacidad para comprender el contexto, ofrecer resultados más precisos e integrarse a la perfección en los flujos de trabajo de las corporaciones, los LLM están allanando el camino para operaciones más inteligentes, rápidas y eficientes.

Y cuando se trata de encontrar un motor de búsqueda basado en IA que se integre a la perfección en su flujo de trabajo, nada supera a ClickUp Brain. Tanto si necesita localizar rápidamente un archivo o una tarea, como si necesita generar ideas o incluso redactar un correo electrónico, las potentes capacidades de IA de ClickUp Brain pueden encargarse de todo.

La integración con las completas herramientas de gestión de proyectos de ClickUp garantiza que todo esté al alcance de la mano, lo que le ayuda a mantenerse organizado, ahorrar tiempo y tomar decisiones basadas en datos con mayor rapidez.

¿A qué espera? ¡Regístrese hoy mismo en ClickUp y sea más productivo con ClickUp Brain!