Czy Twój model AI kiedykolwiek udzielił pewnej odpowiedzi, którą użytkownicy uznali za przestarzałą? To rodzaj doświadczenia, które kończy się tym, że Twój zespół kwestionuje każdą jego odpowiedź.

Brzmi jak koszmar każdego dewelopera i entuzjasty AI, prawda?

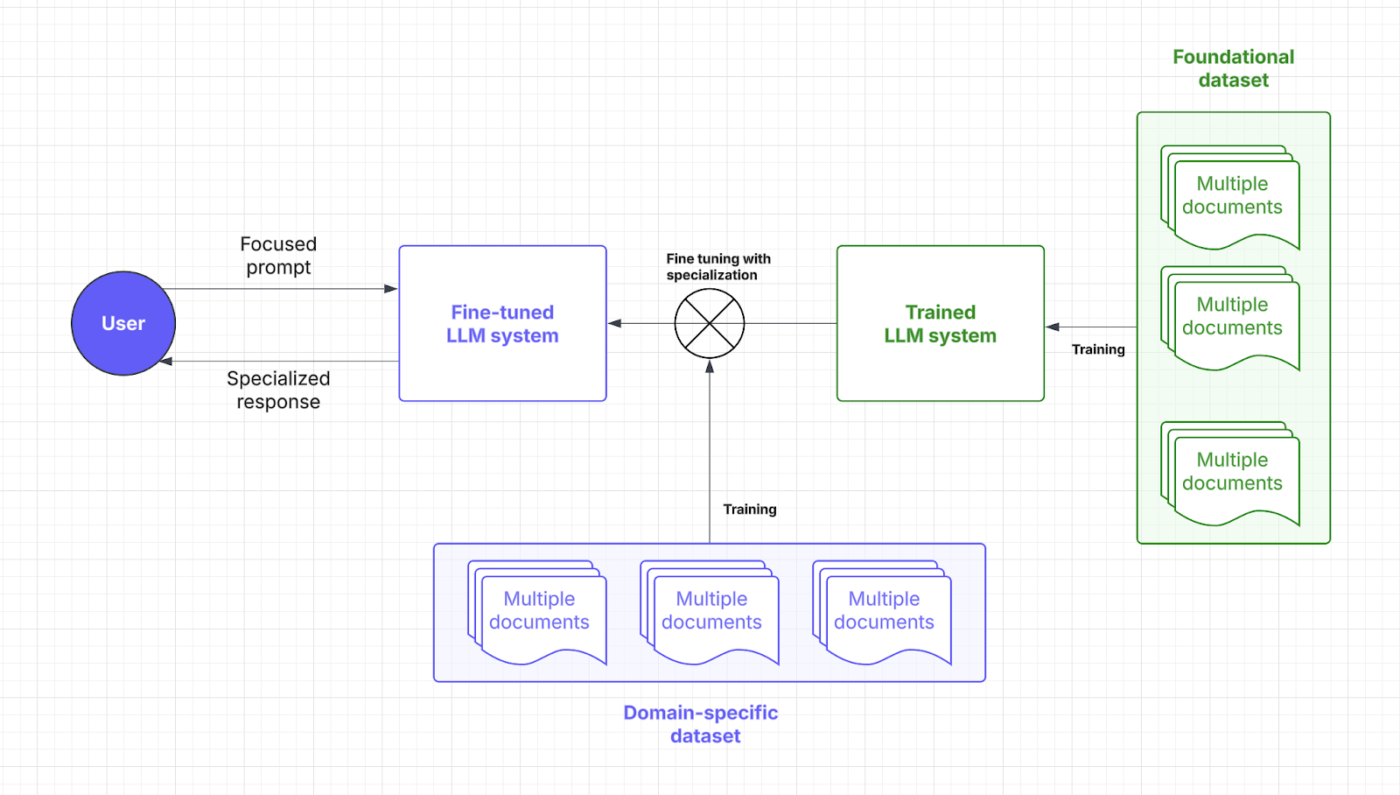

Duże modele językowe (LLM) działają w oparciu o dane treningowe, ale w miarę starzenia się tych danych pojawiają się nieścisłości. Ponieważ ponowne szkolenie kosztuje miliony, optymalizacja jest mądrzejszym rozwiązaniem.

Retrieval Augmented Generation (RAG) i precyzyjne dostrajanie to najlepsze metody zwiększania dokładności. Jednak biorąc pod uwagę różnice między każdym podejściem, są one idealne do różnych zastosowań. Właściwa struktura jest kluczem do skutecznej poprawy LLM.

Ale która z nich jest odpowiednia dla Ciebie?

W tym artykule omówiono ten dylemat w przewodniku RAG vs. dostrajanie precyzyjne. Niezależnie od tego, czy pracujesz z danymi specyficznymi dla domeny, czy też szukasz wysokiej jakości rozwiązań do wyszukiwania danych, tutaj znajdziesz odpowiedzi!

⏰60-sekundowe podsumowanie

- Poprawa wydajności LLM i modeli AI jest kluczowym elementem każdej funkcji biznesowej i rozwojowej. Chociaż RAG i dostrajanie są popularnymi podejściami, ważne jest, aby zrozumieć ich niuanse i wpływ

- RAG wyposaża LLM w zewnętrzny system pobierania danych w czasie rzeczywistym, redukując koszty przekwalifikowania

- Dostrajanie optymalizuje LLM poprzez szkolenie na wyspecjalizowanych zestawach danych, poprawiając dokładność dla zadań specyficznych dla danej domeny

- RAG jest najlepszy dla szybko zmieniających się środowisk danych, takich jak finanse, aktualizacje prawne i obsługa klienta

- Precyzyjne dostrajanie jest idealne dla AI specyficznej dla marki, branż wymagających zgodności z przepisami i analizy nastrojów

- ClickUp Brain łączy obie te metody, wykorzystując RAG do kontekstowego wglądu i dostrajania do dostosowanej automatyzacji i generowania zawartości

- Narzędzia ClickUp AI doładowują wyszukiwanie wiedzy, automatyzację cyklu pracy i zarządzanie projektami w celu uzyskania najwyższej wydajności

Co to jest generowanie z rozszerzonym odzyskiwaniem (RAG)?

Szukasz nowych raportów i ankiet, których nie wykorzystałeś w LLM? W tym miejscu potrzebujesz RAG. Aby lepiej to zrozumieć, przejdźmy do podstaw tego podejścia.

Definicja RAG

RAG to framework AI, który obejmuje dodatkowe wyszukiwanie informacji dla LLM w celu poprawy dokładności odpowiedzi. Przed wygenerowaniem odpowiedzi LLM pobiera najbardziej istotne dane ze źródeł zewnętrznych, takich jak źródła wiedzy lub bazy danych.

Potraktuj to jako asystenta badawczego w LLM lub generatywnym modelu AI.

LLM, zwłaszcza generatory tekstu, mogą mieć halucynacje, generując fałszywe, ale wiarygodne informacje. Wszystko z powodu luk w danych treningowych.

Kluczowe zalety RAG

To już chyba jasne. RAG to dodatkowa warstwa połączonej AI, której potrzebuje Twój proces biznesowy. Aby zwrócić uwagę na jego potencjał, oto zalety, które oferuje:

- Zmniejszone koszty szkolenia: Eliminuje potrzebę częstego przekwalifikowania modelu dzięki dynamicznemu wyszukiwaniu informacji. Prowadzi to do bardziej opłacalnego wdrażania AI, zwłaszcza w domenach z szybko zmieniającymi się danymi

- Skalowalność: Rozszerza wiedzę LLM bez zwiększania rozmiaru głównego systemu. Pomagają firmom w skalowaniu, zarządzaniu dużymi zbiorami danych i uruchamianiu większej liczby zapytań bez ponoszenia wysokich kosztów obliczeniowych

- Aktualizacje w czasie rzeczywistym: Odzwierciedlają najnowsze informacje w każdej odpowiedzi i utrzymują trafność modelu. Priorytetowe traktowanie dokładności poprzez aktualizacje w czasie rzeczywistym ma kluczowe znaczenie w wielu operacjach, w tym w analizie finansowej, opiece zdrowotnej i audytach zgodności

📮 ClickUp Insight: Połowa naszych respondentów zmaga się z wdrożeniem AI; 23% po prostu nie wie, od czego zacząć, a 27% potrzebuje więcej szkoleń do zrobienia czegokolwiek zaawansowanego.

ClickUp rozwiązuje ten problem dzięki znajomemu interfejsowi czatu, który przypomina pisanie tekstów. Teams mogą od razu wskoczyć do gry z prostymi pytaniami i prośbami, a następnie naturalnie odkrywać bardziej zaawansowane funkcje automatyzacji i cykle pracy w miarę ich rozwoju, bez onieśmielającej krzywej uczenia się, która powstrzymuje tak wiele osób.

Przypadki użycia RAG

Zastanawiasz się, gdzie RAG błyszczy? Rozważ te kluczowe przypadki użycia:

Chatboty i obsługa klienta

Zapytania klientów często wymagają aktualnych i kontekstowych odpowiedzi. RAG zwiększa możliwości chatbota poprzez pobieranie najnowszych artykułów dotyczących wsparcia, zasad i kroków rozwiązywania problemów.

Umożliwia to dokładniejszą pomoc w czasie rzeczywistym bez rozszerzenia wstępnego szkolenia.

Dynamiczne wyszukiwanie dokumentów

RAG optymalizuje wyszukiwanie dokumentów poprzez pobieranie najistotniejszych sekcji z rozległych repozytoriów. Zamiast ogólnych podsumowań, LLM może dostarczyć precyzyjnych odpowiedzi z zaktualizowanych podręczników, prac badawczych lub dokumentów prawnych.

Wdrożenie mechanizmów LLM opartych na RAG sprawia, że wyszukiwanie informacji jest szybsze i bardziej precyzyjne.

🧠 Ciekawostka: Meta, która jest właścicielem Facebooka, Instagrama, wątków i WhatsApp, wprowadziła RAG do rozwoju LLM w 2020 roku.

Co to jest dostrajanie?

Przejdźmy do zrobienia precyzyjnego dostrojenia.

Definicja dostrajania

Dostrajanie obejmuje szkolenie wstępnie wytrenowanego modelu językowego. Tak, wiele szkoleń, które można wyjaśnić za pomocą punktu i skupienia.

🧠 Czy wiesz, że: W szkoleniu Large Language Model (LLM) "wagi" są regulowanymi parametrami w sieci neuronowej, które określają siłę połączeń między neuronami, zasadniczo przechowując wyuczone informacje; proces uczenia optymalizuje te wagi, aby zminimalizować błędy przewidywania.

z drugiej strony, "Focus" obejmuje kilka aspektów: obejmuje staranną selekcję danych w celu zapewnienia jakości i trafności, wykorzystanie mechanizmów uwagi w celu nadania priorytetu odpowiednim segmentom danych wejściowych oraz celowe dostrajanie w celu wyspecjalizowania modelu do określonych zadań.

Dzięki wyspecjalizowanym zestawom danych, dostrajanie pozwala modelom AI zawęzić wykonywanie zadań specyficznych dla danej domeny. Dostosowując wagi i skupienie modelu, LLM zyskuje więcej kontekstowego zrozumienia i dokładności.

Pomyśl o dostrojeniu tego stopnia magistra, którego potrzebuje Twój LLM, aby mówić językiem Twojej branży. Przyjrzyjmy się, gdzie ta strategia AI wkracza w proces podpowiedzi:

Korzyści z dostrajania

Techniki precyzyjnego dostrajania to po prostu ulepszanie AI. To bardziej jak możliwość przybliżenia wcześniej zdefiniowanych szczegółów. Oto korzyści, które się z tym wiążą:

- Optymalizacja pod kątem konkretnego zadania: Specjalistyczne zbiory danych wyostrzają odpowiedzi LLM dla konkretnych zadań. Chcesz pomóc użytkownikom ominąć ból głowy związany ze złożonymi podpowiedziami? Dostrajanie pomaga programistom uzyskać dopasowane rozwiązania AI

- Zwiększona dokładność dla niszowych zastosowań: Wiedza o domenie redukuje błędy i zwiększa precyzję każdej odpowiedzi. Precyzyjne dostrajanie zwiększa również niezawodność LLM, pozwalając Businessowi odpocząć od mikrozarządzania i ręcznego nadzoru

- Niestandardowe podejście do marki i zgodności z przepisami: Precyzyjne dostosowywanie uczy LLM terminów, stylu i przepisów firmowych. Pozwala to zachować spójny wizerunek marki i zgodność z przepisami branżowymi

➡️ Przeczytaj także: AI Techniques: Opanowanie uczenia maszynowego, głębokiego uczenia i NLP

Przypadki użycia dostrajania dokładnego

Proces dostrajania odblokowuje docelową wydajność. Oto, gdzie się wyróżnia:

Systemy kontroli jakości specyficzne dla domeny

Branże takie jak prawo, opieka zdrowotna i finanse polegają na precyzyjnych, świadomych domeny odpowiedziach AI. Precyzyjne dostrajanie wyposaża LLM w specjalistyczną wiedzę, zapewniając dokładne odpowiedzi na pytania (QA).

Prawny asystent AI może na przykład bardziej precyzyjnie interpretować umowy, podczas gdy chatbot medyczny może dostarczać wskazówek opartych na objawach przy użyciu zaufanych zbiorów danych.

Analiza nastrojów i niestandardowe cykle pracy

Firmy wykorzystują dopracowany model do monitorowania marek, analizowania opinii klientów i automatyzacji cykli pracy dostosowanych do niestandardowych potrzeb operacyjnych. Narzędzie oparte na AI może wykrywać zniuansowane nastroje w recenzjach produktów, pomagając firmom udoskonalić ich ofertę.

W HR połączenie dostrajania z przetwarzaniem języka naturalnego pomaga AI analizować ankiety pracowników i oznaczać obawy związane z miejscem pracy z większą świadomością kontekstową.

Wskazówka dla profesjonalistów: Dokładne dostrojenie może obejmować dodanie bardziej zróżnicowanych danych w celu usunięcia potencjalnych błędów. Nie jest to dokładnie specyficzne dla domeny, ale nadal jest to kluczowa aplikacja.

Porównanie: RAG vs. Fine-Tuning

Nie da się ukryć, że obie strategie AI mają na celu zwiększenie wydajności.

Ale wybór nadal wydaje się dość trudny, prawda? Oto zestawienie dostrajania vs. RAG, które pomoże Ci podjąć właściwą decyzję dotyczącą inwestycji w LLM.

| Aspekt | RAG (Retrieval-augmented generation) | Dokładne dostrojenie |

| Definicja | Umożliwia LLM pobieranie w czasie rzeczywistym istotnych danych z zewnętrznych źródeł za pomocą dedykowanego systemu | Trenuje wstępnie wytrenowany model z wyspecjalizowanymi zestawami danych dla zadań specyficznych dla domeny |

| Wydajność i dokładność | Świetnie nadaje się do pobierania danych w czasie rzeczywistym, ale dokładność zależy od jakości danych zewnętrznych | Poprawia dokładność kontekstową i odpowiedzi specyficzne dla zadania |

| Wymagania dotyczące kosztów i zasobów | Bardziej opłacalne rozwiązanie skupiające się na dostępie do danych w czasie rzeczywistym | Wymaga więcej zasobów na początkowe szkolenie, ale jest opłacalne w dłuższej perspektywie |

| Konserwacja i skalowalność | Wysoka skalowalność i elastyczność, ale zależność od częstotliwości aktualizacji źródeł zewnętrznych | Wymaga częstych aktualizacji i konserwacji, ale oferuje stabilną długoterminową wydajność |

| Przypadki użycia | Chatboty, dynamiczne wyszukiwanie dokumentów, analiza w czasie rzeczywistym | Systemy kontroli jakości specyficzne dla danej domeny, analiza sentymentu i niestandardowy głos marki |

| Kiedy wybrać | Szybko zmieniające się dane, aktualizacje w czasie rzeczywistym i priorytetyzacja kosztów zasobów | Niszowe segmenty klientów, logika specyficzna dla domeny, niestandardowe podejście do marki |

| Idealne dla | Branże potrzebują dokładnych informacji w czasie rzeczywistym (finanse, prawo, obsługa klienta) | Branże wymagające określonego języka, zgodności lub kontekstu (opieka zdrowotna, prawo, HR) |

Potrzebujesz nieco więcej jasności, aby rozwiać swoje wątpliwości? Oto porównanie kluczowych aspektów, które mają wpływ na Twoje potrzeby.

Wydajność i dokładność

Jeśli chodzi o wydajność, RAG odgrywa kluczową rolę, pobierając nowe dane z zewnętrznych źródeł. Jego dokładność i czas reakcji zależą od jakości tych danych. Ta zależność od zewnętrznych baz danych umożliwia RAG skuteczne dostarczanie aktualnych informacji.

Z drugiej strony, dostrajanie poprawia sposób, w jaki model przetwarza i reaguje poprzez specjalistyczne przekwalifikowanie. Proces ten zapewnia bardziej dokładne kontekstowo odpowiedzi, szczególnie w przypadku niszowych aplikacji. Precyzyjnie dostrojone modele LLM są idealne do utrzymania spójności w branżach o surowych wymaganiach, takich jak opieka zdrowotna czy finanse.

Podsumowanie: RAG świetnie sprawdza się w przypadku danych w czasie rzeczywistym, a precyzyjne dostrajanie pozwala uzyskać kontekstowo dokładne odpowiedzi.

Użytkownik Reddit mówi,

Jeśli korzystasz z małego modelu i dobrej bazy danych w potoku RAG, możesz generować wysokiej jakości zestawy danych, lepiej niż przy użyciu danych wyjściowych z wysokiej jakości AI.

Jeśli korzystasz z małego modelu i dobrej bazy danych w potoku RAG, możesz generować wysokiej jakości zestawy danych, lepiej niż przy użyciu danych wyjściowych z wysokiej jakości AI.

💡 Pro Tip: Aby ukierunkować LLM na konkretny wynik, skup się na skutecznej, podpowiedzi inżynieryjnej.

Wymagania dotyczące kosztów i zasobów

RAG jest zazwyczaj bardziej opłacalny z góry, ponieważ dodaje tylko warstwę do zewnętrznego pobierania danych. Unikając konieczności ponownego trenowania całego modelu, jest to opcja znacznie bardziej przyjazna dla budżetu, zwłaszcza w dynamicznych środowiskach. Jednak koszty operacyjne związane z dostępem do danych w czasie rzeczywistym i ich przechowywaniem mogą się sumować.

Precyzyjne dostrojenie wymaga większego przygotowania zestawu danych i zasobów szkoleniowych, ale jest inwestycją długoterminową. Po precyzyjnym dostrojeniu LLM wymaga mniejszej liczby aktualizacji, co prowadzi do przewidywalnej wydajności i oszczędności kosztów. Programiści powinni rozważyć początkową inwestycję w stosunku do bieżących kosztów operacyjnych.

Podsumowanie: Metoda RAG jest opłacalna, łatwa do wdrożenia i przynosi szybkie korzyści. Precyzyjne dostrojenie z góry wymaga dużych zasobów, ale poprawia jakość LLM i obniża koszty operacyjne w dłuższej perspektywie.

💡 Pro Tip: Twój system RAG jest tak inteligentny, jak dane, z których czerpie. Utrzymuj swoje źródła w czystości i wypełniaj je dokładnymi, aktualnymi danymi!

Konserwacja i skalowalność

RAG oferuje doskonałą skalowalność, ponieważ skupia się głównie na rozbudowie zewnętrznego źródła. Jego elastyczność i zdolność adaptacji sprawiają, że jest idealny dla szybko zmieniających się branż. Konserwacja zależy jednak od częstotliwości aktualizacji zewnętrznych baz danych.

Dostrajanie wymaga dość częstej konserwacji, zwłaszcza gdy zmieniają się informacje specyficzne dla domeny. Chociaż wymaga więcej zasobów, zapewnia większą spójność w czasie i stopniowo wymaga mniejszej liczby dostosowań. To powiedziawszy, skalowalność dla dostrajania jest znacznie bardziej złożona, obejmując bardziej rozszerzenie i zróżnicowane zbiory danych.

Podsumowanie: RAG jest najlepszy do szybkiego skalowania i dostrajania w celu minimalnej konserwacji i stabilnej wydajności.

Użytkownik Reddit dodaje,

Gdy zadanie jest małe, często bardziej efektywne jest po prostu uzyskanie większego modelu niż dostrajanie mniejszego.

Gdy zadanie jest małe, często bardziej efektywne jest po prostu uzyskanie większego modelu niż dostrajanie mniejszego.

👀 Czy wiesz, że Istnieją rozwiązania AI, które mogą teraz pachnieć. Biorąc pod uwagę złożoność zapachów, wymaga to regularnego dostrajania i wyszukiwania złożonych danych.

Które podejście jest odpowiednie dla danego przypadku użycia?

Pomimo zrozumienia niuansów, podjęcie decyzji może wydawać się puste bez widocznego odniesienia lub kontekstu. Przeanalizujmy kilka scenariuszy biznesowych podkreślających, w jaki sposób każdy z modeli AI działa lepiej.

Kiedy wybrać RAG

RAG pomaga zasilić LLM odpowiednimi faktami i informacjami, w tym standardami technicznymi, rejestrami sprzedaży, opiniami klientów i nie tylko.

Jak to zrobić? Rozważ te scenariusze, aby zaadoptować RAG do swoich działań:

Przypadek użycia #1: Analiza w czasie rzeczywistym

- Scenariusz: Firma fintech dostarcza inwestorom wiedzę rynkową opartą na AI. Użytkownicy pytają o trendy giełdowe, a system musi pobierać najnowsze raporty rynkowe, dokumenty SEC i wiadomości

- Dlaczego RAG wygrywa: Rynki giełdowe zmieniają się szybko, więc ciągłe przekwalifikowywanie modeli AI jest kosztowne i nieefektywne. RAG utrzymuje ostrość, pobierając tylko najświeższe dane finansowe, obniżając koszty i zwiększając dokładność

- Zasada kciuka: RAG powinien być strategią dla AI obsługującej szybko zmieniające się dane. Popularne zastosowania to analiza danych w mediach społecznościowych, optymalizacja zużycia energii, wykrywanie zagrożeń cybernetycznych i śledzenie zamówień

Przypadek użycia #2: Kontrola danych i zgodność z przepisami

- Scenariusz: Asystent AI pomaga prawnikom sporządzać umowy i weryfikować zgodność ze zmieniającymi się przepisami, pobierając najnowsze ustawy, precedensy i orzeczenia

- Dlaczego RAG wygrywa: Weryfikacja aspektów prawnych i handlowych nie gwarantuje dogłębnych aktualizacji behawioralnych. RAG całkiem dobrze radzi sobie z tym zadaniem, pobierając teksty prawne z centralnego zbioru danych w czasie rzeczywistym

- Zasada kciuka: RAG przoduje w analizach opartych na zasobach i statystykach. Świetnymi sposobami na maksymalizację tego byłoby wykorzystanie medycznych asystentów AI do zaleceń dotyczących leczenia i chatbotów dla klientów do rozwiązywania problemów i aktualizacji zasad

Nadal zastanawiasz się, czy potrzebujesz RAG w swoim LLM? Oto krótka lista kontrolna:

- Potrzebujesz nowych, wysokiej jakości danych do zrobienia bez zmiany samego LLM?

- Czy Twoje informacje często się zmieniają?

- Czy LLM musi pracować z dynamicznymi informacjami zamiast statycznych danych treningowych?

- Chcesz uniknąć dużych wydatków i czasochłonnego przekwalifikowania modelu?

➡️ Przeczytaj również: Najlepsze narzędzia inżynierii podpowiedzi dla generatywnej AI

Kiedy precyzyjne dostrajanie jest bardziej skuteczne

Jak już wcześniej wspomnieliśmy, dostrajanie to szkoła dla absolwentów AI. Twój LLM może nawet nauczyć się branżowego żargonu. Oto branżowe spojrzenie na to, kiedy naprawdę błyszczy:

Przypadek użycia #1: Dodanie głosu i tonacji marki

- Scenariusz: Luksusowa marka tworzy konsjerża AI do interakcji z klientami w wyrafinowanym, ekskluzywnym tonie. Musi on uosabiać tonację, frazowanie i niuanse emocjonalne specyficzne dla marki

- Dlaczego dostrajanie wygrywa: Dostrajanie pomaga modelowi AI uchwycić i odtworzyć unikalny głos i ton marki. Zapewnia spójne doświadczenie w każdej interakcji

- Zasada kciuka: Dokładne dostrojenie jest bardziej skuteczne, jeśli twoje LLM muszą dostosować się do konkretnej wiedzy specjalistycznej. Jest to idealne rozwiązanie w przypadku wciągających gier zorientowanych na gatunek, tematycznych i empatycznych opowieści, a nawet markowych tekstów marketingowych

Ciekawostka: LLM przeszkolone w zakresie umiejętności miękkich doskonale radzą sobie z analizą nastrojów i satysfakcji pracowników. Jednak tylko 3% firm korzysta obecnie z generatywnego AI w HR.

Przypadek użycia #2: Moderacja zawartości i wgląd kontekstowy

- Scenariusz: Platforma mediów społecznościowych wykorzystuje model AI do wykrywania szkodliwej zawartości. Koncentruje się on na rozpoznawaniu języka specyficznego dla platformy, pojawiającego się slangu i naruszeń kontekstowych

- Dlaczego dostrajanie wygrywa: Miękkie umiejętności, takie jak formułowanie zdań, są często poza zasięgiem systemów RAG. Precyzyjne dostrajanie poprawia zrozumienie przez LLM niuansów specyficznych dla platformy i żargonu branżowego, szczególnie w zakresie moderacji zawartości

- Zasada kciuka: Wybór dostrajania jest rozsądny, gdy mamy do czynienia z różnicami kulturowymi lub regionalnymi. Dotyczy to również dostosowywania się do terminów branżowych, takich jak język medyczny, prawniczy lub techniczny

Masz zamiar dostroić swój LLM? Zadaj sobie te kluczowe pytania:

- Czy Twój LLM musi być dostarczony do niszowego segmentu klientów lub tematu marki?

- Czy chcesz dodać do logiki LLM dane zastrzeżone lub specyficzne dla domeny?

- Potrzebujesz szybszych odpowiedzi bez utraty dokładności?

- Czy twoje LLM dostarczają rozwiązania offline?

- Czy można przydzielić dedykowane zasoby i moc obliczeniową do przekwalifikowania?

Poprawa doświadczenia użytkownika jest świetna. Jednak wiele firm potrzebuje również AI jako zwiększenia wydajności, aby uzasadnić wysokie koszty inwestycji. Właśnie dlatego przyjęcie wstępnie wytrenowanego modelu AI jest często wyborem dla wielu osób.

Czy wiesz, że AI ma potencjał do zrobienia automatyzacji czynności, która pozwala zaoszczędzić do 70% czasu pracowników. Skuteczne proszenie AI o spostrzeżenia odgrywa tutaj ogromną rolę!

Jak ClickUp wykorzystuje zaawansowane techniki AI

Wybór między RAG a precyzyjnym dostrajaniem to dość obszerna debata.

Nawet przejrzenie kilku wątków na Reddicie wystarczy, by wprowadzić w błąd. Ale kto powiedział, że musisz wybrać tylko jeden?

Wyobraź sobie, że masz konfigurowalne modele AI, automatyzację i zarządzanie zadaniami w jednym miejscu. Oto ClickUp, aplikacja do wszystkiego w pracy. Łączy ona zarządzanie projektami, dokumentację i komunikację w zespole pod jednym dachem i jest zasilana przez AI nowej generacji.

Krótko mówiąc, wyróżnia się we wszystkim, zwłaszcza dzięki kompleksowemu rozwiązaniu AI: ClickUp Brain.

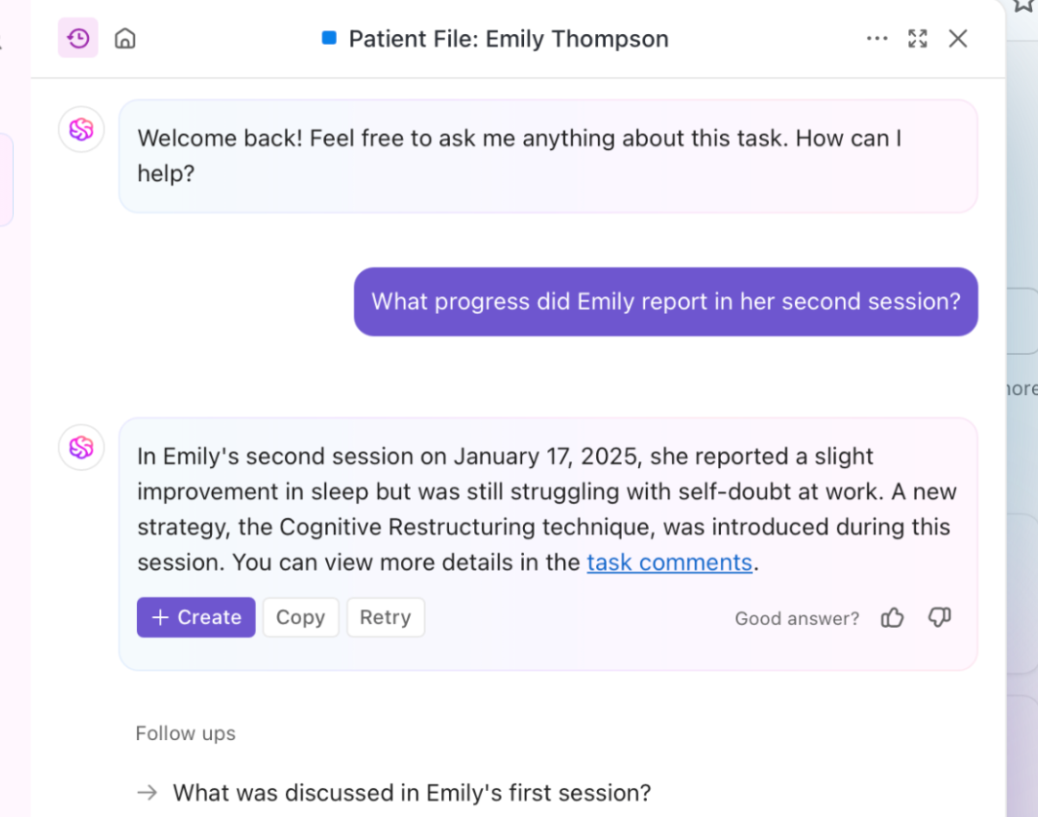

Potrzebujesz szybkich, kontekstowych spostrzeżeń? Brain pobiera informacje w czasie rzeczywistym z dokumentów, zadań i zasobów. To jest właśnie RAG w akcji. Co więcej, jego podstawowy LLM, Brain, może generować raportowanie i rutynowe aktualizacje projektów.

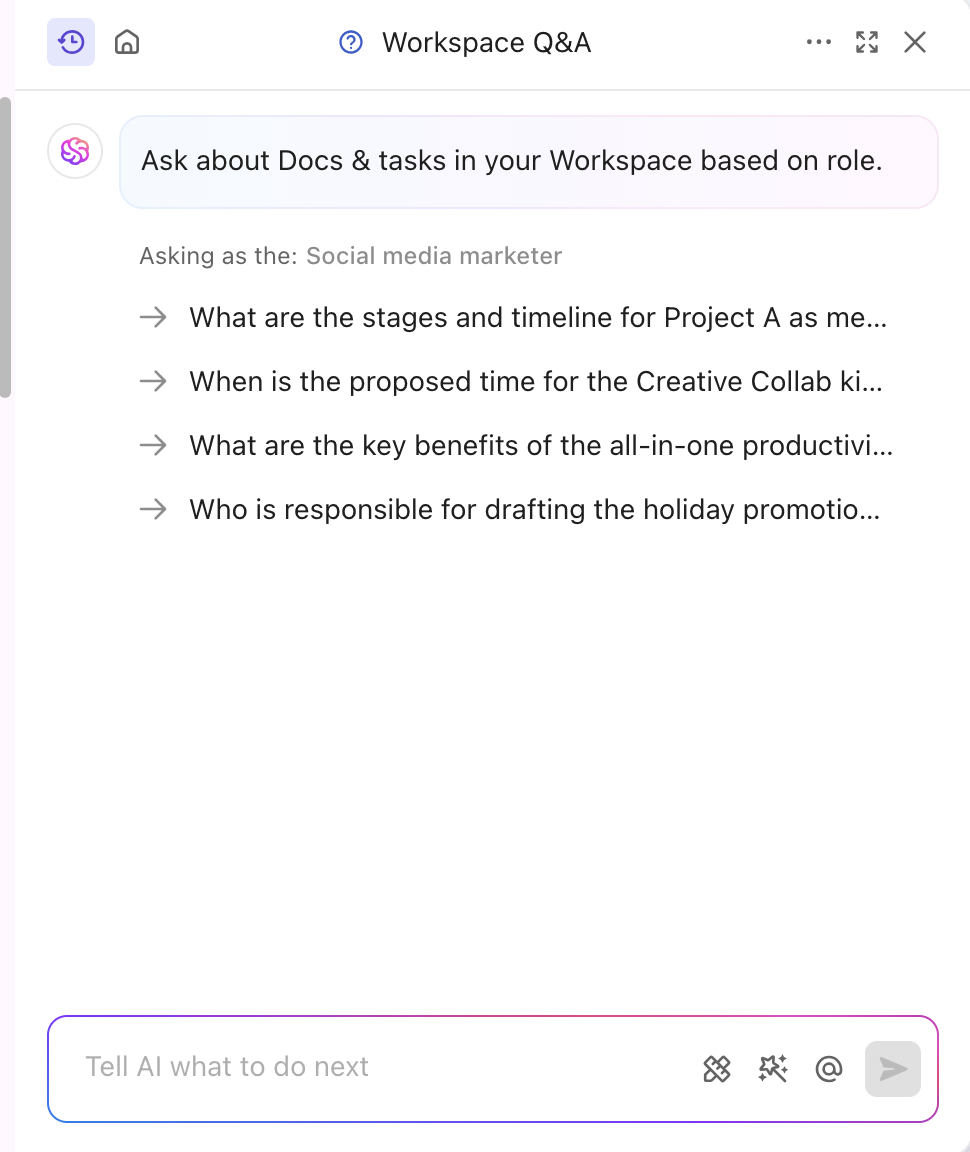

Narzędzie AI jest również precyzyjnie dostrojone do branży i segmentu, dostarczając profesjonalnych i kreatywnych spostrzeżeń. Personalizuje nawet zawartość w czasie rzeczywistym bez konieczności ręcznego szkolenia. Brain łączy dostrajanie i RAG w celu automatyzacji aktualizacji projektów, przydzielania zadań i powiadomień o cyklu pracy. Chcesz odpowiedzi dostosowanych do Twojej roli? ClickUp Brain również może to zrobić!

Oprócz specjalizacji w zawartości, ClickUp zasila również swoją platformę potężną funkcją AI opartą na wiedzy.

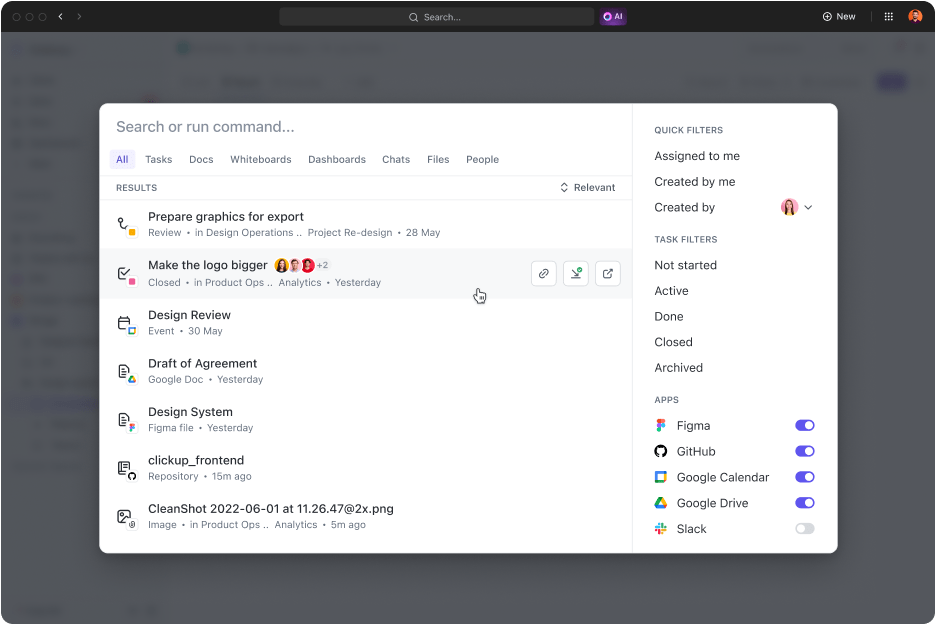

ClickUp Connected Search to narzędzie oparte na AI, które szybko pobiera dowolne zasoby ze zintegrowanej przestrzeni. Niezależnie od tego, czy potrzebujesz dokumentów do dzisiejszego standupu, czy odpowiedzi na dowolne zadanie, proste zapytanie wyciąga linki źródłowe, cytaty i szczegółowe spostrzeżenia.

Uruchamia również aplikacje, przeszukuje historię schowków i tworzy snippety. A co najlepsze? Wszystko to jest dostępne za pomocą jednego kliknięcia z centrum dowodzenia, paska akcji lub pulpitu.

Eksperci od marketingu cyfrowego, prezes Hum JAM mówi nawet,

ClickUp to najbardziej niesamowite narzędzie do automatyzacji pracy zespołu typu "wszystko w jednym", które umożliwia śledzenie, automatyzację i pomiar powodzenia działań zespołu. Zaufaj mi, gdy mówię, że Twój zespół nie może żyć bez tego narzędzia.

ClickUp to najbardziej niesamowite narzędzie do automatyzacji pracy zespołu typu "wszystko w jednym", które umożliwia śledzenie, automatyzację i pomiar powodzenia działań zespołu. Zaufaj mi, gdy mówię, że Twój zespół nie może żyć bez tego narzędzia.

➡️ Przeczytaj także: Różnica między uczeniem maszynowym a sztuczną inteligencją

Zwiększanie mocy Gen AI i dokładności LLM dzięki ClickUp

Odpowiedzi mocy RAG, wyostrzone przez świeże dane zewnętrzne i dostrajanie, są używane do określonych zadań i zachowań. Oba poprawiają wydajność AI, ale właściwe podejście określa tempo i wydajność.

W dynamicznych branżach decyzja często sprowadza się do tego, którą metodę przyjąć jako pierwszą. Potężne, wstępnie wytrenowane rozwiązanie jest zwykle mądrzejszym wyborem.

Jeśli chcesz poprawić jakość i wydajność usług, ClickUp jest świetnym partnerem. Jego możliwości AI napędzają generowanie zawartości, wyszukiwanie danych i odpowiedzi analityczne. Ponadto platforma zawiera ponad 30 narzędzi, które obejmują wszystko, od zarządzania zadaniami po generowanie oszałamiających wizualizacji.

Zarejestruj się w ClickUp już dziś!