De 'nieuwe software-geur' verdwijnt meestal zodra een werkstroom teleurstelt. Het overkomt zelfs de besten onder ons – sterker nog, het overkomt bijna 60% van de teams, wat duidelijk maakt dat traditionele evaluaties geen resultaten opleveren.

U hebt een manier nodig om risico's vroeg genoeg aan het licht te brengen om actie te kunnen ondernemen. In deze gids onderzoeken we hoe u software met AI kunt evalueren om operationele risico's en belemmeringen voor de acceptatie aan het licht te brengen voordat u vastzit. We bieden u het kader om tools te beoordelen en verborgen risico's aan het licht te brengen, terwijl we uitleggen hoe u de evaluatie georganiseerd kunt houden in ClickUp. 🔍

Wat houdt het evalueren van software met AI in?

Software evalueren met AI betekent dat u AI gebruikt als een onderzoeks- en besluitvormingslaag tijdens het aankoopproces. In plaats van handmatig websites van leveranciers, recensies, documentatie en demo's te scannen, kan uw team AI gebruiken om opties consistent te vergelijken en de claims van leveranciers vroegtijdig aan een drukproef te onderwerpen.

Dit is belangrijk wanneer evaluaties zich uitstrekken over verschillende tools en meningen. AI consolideert deze input in één weergave en benadrukt hiaten of inconsistenties die gemakkelijk over het hoofd worden gezien bij handmatige beoordelingen. Het verfijnt ook de specifieke vragen die moeten worden gesteld over AI en algemene softwaremogelijkheden om een duidelijk antwoord van de leverancier te krijgen.

Het verschil wordt duidelijker wanneer u traditionele software-evaluatie vergelijkt met een AI-ondersteunde aanpak.

Traditionele software-evaluatie versus AI-ondersteunde evaluatie

Bij traditionele software-evaluaties moet u vaak een shortlist samenstellen op basis van verspreide leverancierspagina's en tegenstrijdige beoordelingen. Uiteindelijk komt u steeds weer terug bij dezelfde basisvragen en moet u details opnieuw controleren, net wanneer u een beslissing wilt nemen.

Dat is de reden waarom 83% van de kopers uiteindelijk halverwege hun oorspronkelijke lijst met leveranciers wijzigt – een duidelijk teken van hoe onzeker uw vroege beslissingen kunnen aanvoelen wanneer uw input gefragmenteerd is. U kunt dat extra werk overslaan door AI te gebruiken om informatie vooraf te synthetiseren, zodat u vanaf het begin dezelfde strenge criteria op elke tool kunt toepassen.

| Traditionele evaluatie | AI-ondersteunde evaluatie |

|---|---|

| Functies vergelijken in tabbladen en spreadsheets | Zij-aan-zij-vergelijkingen genereren vanuit één enkele prompt |

| Recensies afzonderlijk lezen | Samenvatting van sentiment en terugkerende thema's uit verschillende bronnen |

| RFP-vragen handmatig opstellen | Vragenlijsten voor leveranciers opstellen op basis van gedefinieerde criteria |

| Wachten op verkoopgesprekken om basisinformatie te verduidelijken | Directe queries uitvoeren in openbare documentatie en kennisbanken |

Met dat onderscheid in gedachten is het gemakkelijker om precies te zien waar AI het meeste gewicht in de schaal legt tijdens de evaluatiecyclus.

Waar past AI in de evaluatiecyclus?

AI is het meest nuttig tijdens het ontdekken, vergelijken en valideren, wanneer er veel input is en deze gemakkelijk verkeerd kan worden geïnterpreteerd. Het is het meest nuttig tijdens het ontdekken en vergelijken, wanneer u door grote hoeveelheden gegevens ploegt en uw vroege aannames onder druk wilt testen.

In eerste instantie helpt AI bij het verduidelijken van probleemstellingen en evaluatiecriteria. Later neemt het de rol van strateeg op zich, waarbij het bevindingen consolideert en beslissingen communiceert aan belanghebbenden.

AI werkt het beste als een eerste syntheselaag. Voor definitieve beslissingen moeten kritieke beweringen in documentatie, contracten en proefversies nog steeds worden geverifieerd.

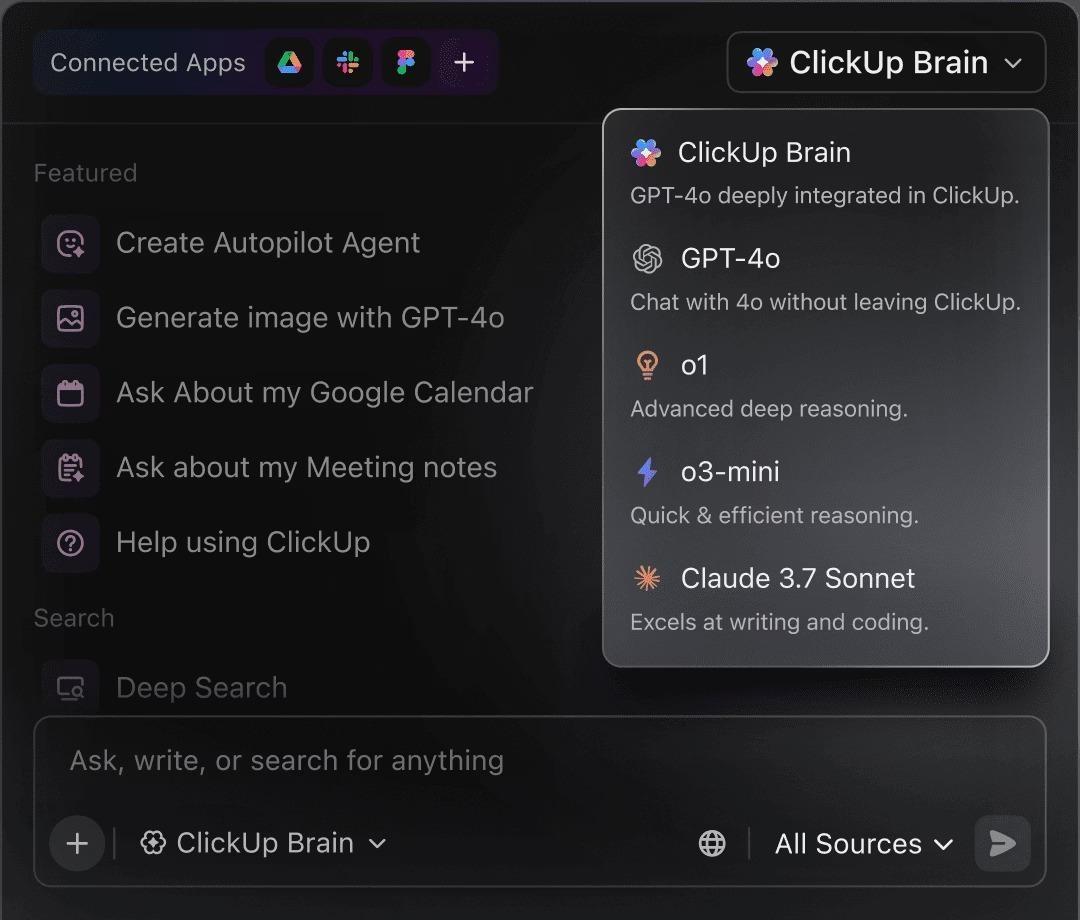

📮 ClickUp Insight: 88% van de respondenten in onze enquête gebruikt AI voor persoonlijke taken, maar meer dan 50% schuwt het gebruik ervan op het werk. De drie belangrijkste belemmeringen? Gebrek aan naadloze integratie, kennislacunes of bezorgdheid over de veiligheid. Maar wat als AI in uw werkruimte is ingebouwd en al veilig is? ClickUp Brain, de ingebouwde AI-assistent van ClickUp, maakt dit mogelijk. Het begrijpt prompts in gewone taal en lost alle drie de bezorgdheden over de invoering van AI op, terwijl het uw chat, taken, documenten en kennis in de hele werkruimte met elkaar verbindt. Vind antwoorden en inzichten met één enkele klik!

Waarom AI gebruiken voor software-evaluatie?

AI vermindert de onderzoeksdruk en past een consistente lens toe op alle tools, waardoor evaluaties gemakkelijker te vergelijken en te verdedigen zijn. De impact ervan komt op een aantal praktische manieren tot uiting:

- Snelheid: Bespaar dagen of weken aan handmatig onderzoek door meerdere bronnen tegelijk te queryen.

- Dekking: Ontdek minder bekende tools en vroege waarschuwingssignalen die gemakkelijk over het hoofd worden gezien bij handmatige beoordelingen.

- Consistentie: Evalueer elke optie aan de hand van dezelfde criteria in plaats van halverwege het proces van standaard af te wijken.

- Documentatie: Genereer duidelijke samenvattingen en vergelijkingen als weergaven die belanghebbenden kunnen bekijken en beoordelen.

🔍 Wist u dat? De verschuiving van chatbots naar AI-agenten (systemen die taken met meerdere stappen kunnen plannen en uitvoeren) zal naar verwachting de efficiëntie van inkoop en software met 25% tot 40% verhogen .

🔍 Wist u dat? De verschuiving van chatbots naar AI-agenten (systemen die taken met meerdere stappen kunnen plannen en uitvoeren) zal naar verwachting de efficiëntie van inkoop en software met 25% tot 40% verhogen .

Waarom het evalueren van AI-software nieuwe vragen vereist

Wanneer u AI-gestuurde tools beoordeelt, vertellen traditionele functies en nalevingschecklists slechts het halve verhaal. Standaardcriteria richten zich meestal op wat een tool doet, maar AI introduceert variabiliteit en risico's die verouderde frameworks niet kunnen vastleggen.

Het verandert de vragen die u moet prioriteren:

- Modelopaciteit: begrijp hoe outputs worden gegenereerd wanneer de zichtbaarheid van het redeneringsproces niet volledig is.

- Gegevensverwerking: Maak duidelijk hoe bedrijfsgegevens worden opgeslagen, hergebruikt of gebruikt voor training.

- Outputvariabiliteit: Test de consistentie wanneer dezelfde prompt verschillende resultaten oplevert.

- Snelle iteratie: houd rekening met gedragsveranderingen tussen demo's, proefversies en productiegebruik.

- Integratiediepte: Controleer of de AI-mogelijkheden echte werkstroomen ondersteunen, en geen geïsoleerde functies.

Simpel gezegd: het evalueren van AI-software is minder afhankelijk van oppervlakkige controles en meer van vragen over gedrag, controle en geschiktheid op de lange termijn.

13 vragen die u moet stellen bij het evalueren van AI-software

Gebruik deze vragen als een gedeelde vragenlijst voor AI-leveranciers, zodat u de antwoorden direct naast elkaar kunt vergelijken, en niet pas na de implementatie.

| Vragen die u moet stellen | Hoe een sterk antwoord klinkt |

|---|---|

| 1) Welke gegevens verwerkt de AI en waar worden deze opgeslagen? | “Dit zijn de gegevens waartoe we toegang hebben, waar we ze opslaan (regio-opties), hoe we ze versleutelen en hoe lang we ze bewaren. ” |

| 2) Wordt onze data nu of later gebruikt voor training? | “Standaard niet. Training is alleen opt-in en dat wordt ook zo vermeld in het contract/de DPA. ” |

| 3) Wie bij de leverancier heeft toegang tot onze gegevens? | “Toegang is rolgebaseerd, gecontroleerd en beperkt tot specifieke functies. Hier leest u hoe we toegang registreren en controleren. ” |

| 4) Welke modellen ondersteunen de functie en veranderen versies stilzwijgend? | "Dit zijn de modellen die we gebruiken, hoe we ze voor versies gebruiken en hoe we u op de hoogte brengen wanneer het gedrag verandert. " |

| 5) Wat gebeurt er als de AI twijfelt? | "We brengen vertrouwenssignalen naar voren, vragen om opheldering of vallen veilig terug in plaats van te gissen. " |

| 6) Als we dezelfde prompt twee keer uitvoeren, kunnen we dan hetzelfde resultaat verwachten? | “Dit is het verschil tussen deterministisch en variabel, en hoe u kunt configureren voor consistentie wanneer dat belangrijk is. ” |

| 7) Wat zijn de werkelijke limieten van de context? | “Dit zijn de praktische limieten (documentgrootte/geschiedenisdiepte). Dit is wat we doen als de context wordt afgekapt. ” |

| 8) Kunnen we zien waarom de AI een aanbeveling heeft gedaan of een actie heeft ondernomen? | “U kunt invoer, uitvoer en een spoor van waarom het X heeft aanbevolen, inspecteren. Acties hebben een audittrail. ” |

| 9) Welke goedkeuringen zijn er voordat het in werking treedt? | "Risicovolle acties moeten worden beoordeeld, goedkeuringen kunnen op basis van rollen worden gegeven en er is een escalatiepad." |

| 10) In hoeverre is dit aanpasbaar voor verschillende teams en rollen? | "U kunt prompts/sjablonen standaardiseren, beperken wie ze kan wijzigen en de output per rol aanpassen." |

| 11) Kan het worden geïntegreerd in echte werkstroomen of kan het alleen maar 'verbinden'? | “We ondersteunen tweerichtingssynchronisatie en echte triggers/acties. Hier vindt u informatie over hoe we omgaan met storingen en hoe we deze monitoren. ” |

| 12) Als we downgraden of annuleren, wat gaat er dan verloren en wat kunnen we exporteren? | "Dit is precies wat u behoudt, wat u kunt exporteren en hoe we gegevens op verzoek verwijderen. " |

| 13) Hoe controleert u de kwaliteit in de loop van de tijd? | “We houden afwijkingen en incidenten bij, voeren evaluaties uit, publiceren release notes en hebben een duidelijk escalatie- en ondersteuningsproces. ” |

💡 Pro-tip: Overweeg om de antwoorden op deze vragen te centraliseren in een gedeelde AI-leveranciersvragenlijst om patronen en afwegingen te ontdekken. Uw team kan deze vragen bij verschillende evaluaties hergebruiken in plaats van elke keer opnieuw te beginnen, wat de werkstroom verbetert.

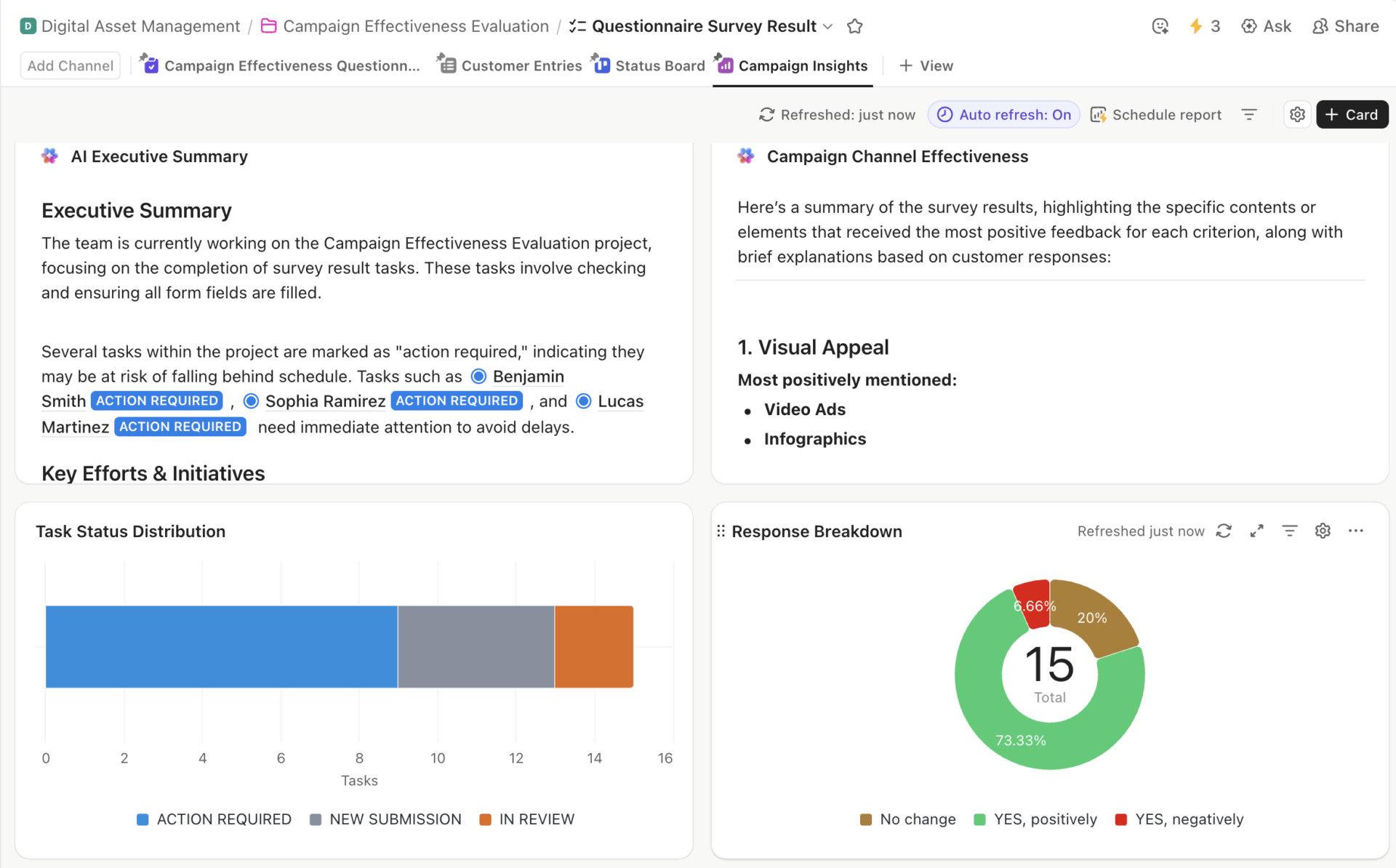

ClickUp-vragenlijstsjabloon met een AI-samenvatting, taakverdeling, kanaaleffectiviteit en responsverdeling.

U kunt het ClickUp-sjabloon voor vragenlijsten gebruiken om uw team één gestructureerde plek te bieden waar ze de antwoorden van leveranciers kunnen vastleggen en tools naast elkaar kunnen vergelijken. U kunt ook velden aanpassen en eigenaren toewijzen, zodat u hetzelfde kader kunt hergebruiken voor toekomstige aankopen zonder uw proces helemaal opnieuw op te bouwen.

Stap voor stap: hoe u software met AI kunt evalueren

De onderstaande fasen laten zien hoe uw team AI kan gebruiken om software-evaluatie te structureren, zodat beslissingen traceerbaar blijven en later gemakkelijk kunnen worden herzien.

Fase 1: Uw softwarebehoeften definiëren met AI (probleembewustzijn)

De meeste evaluaties mislukken nog voordat u een demo hebt gezien. Het is een veelvoorkomende valkuil: u begint meteen met vergelijken zonder eerst overeenstemming te bereiken over het probleem dat u daadwerkelijk probeert op te lossen. AI is hier zeer nuttig omdat het al in een vroeg stadium duidelijkheid afdwingt.

Stel je bijvoorbeeld voor dat je bij een marketingbureau werkt en op zoek bent naar een projectmanagementtool met een vaag doel, zoals betere samenwerking. AI helpt je die intentie te verfijnen door je te vragen naar details over je werkstroom, teamgrootte en bestaande tech stack, waardoor vage ideeën effectief worden omgezet in concrete vereisten.

Probeer AI te gebruiken om vragen te onderzoeken zoals:

- Met welke specifieke knelpunten heeft mijn team momenteel te maken?

- Welke functies zijn 'must-haves' en welke zijn 'nice-to-haves' voor onze branche?

- Op welke tools vertrouwen teams van onze grootte doorgaans voor dit doel?

- Welk budgetbereik is realistisch voor deze vereisten?

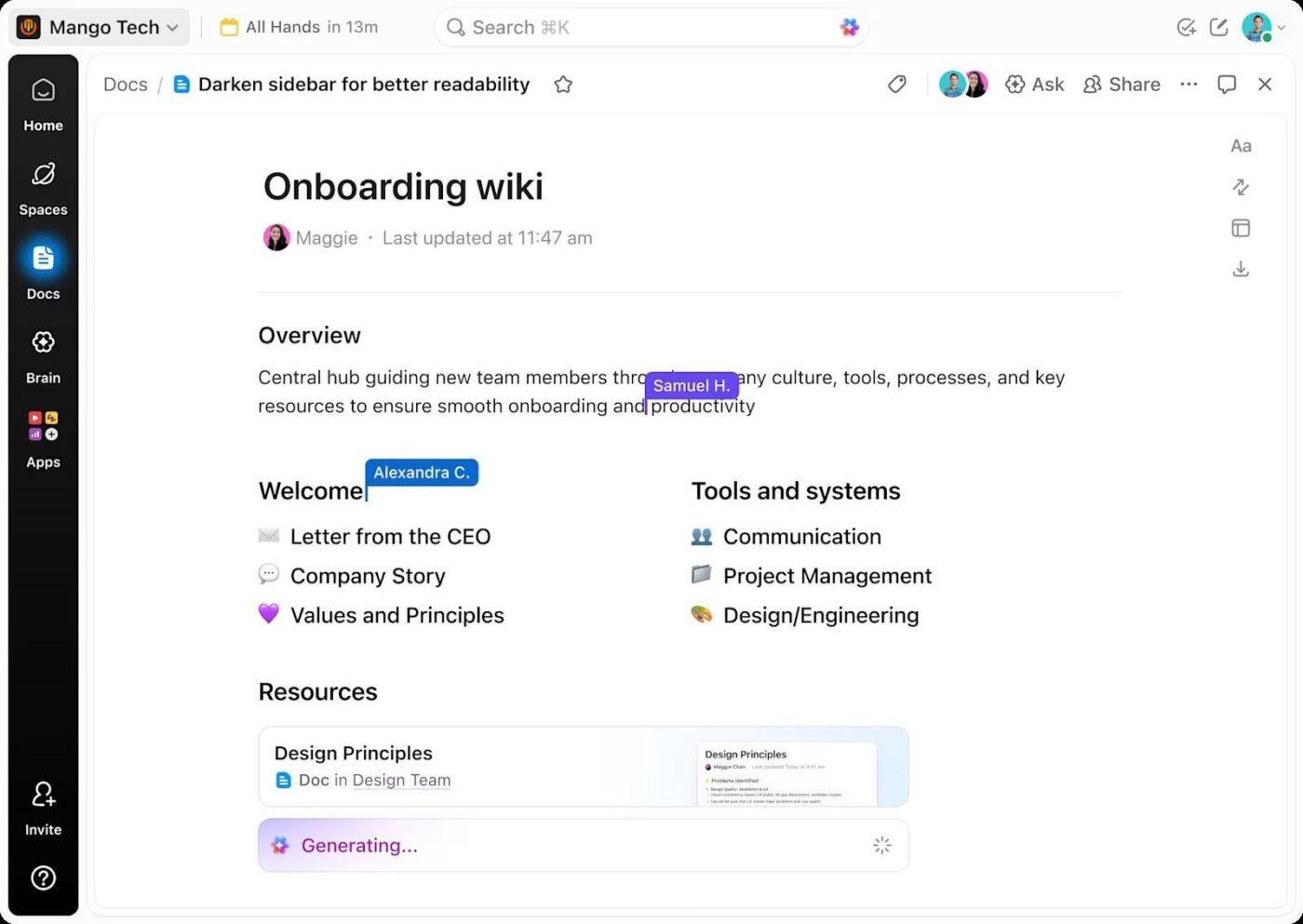

Naarmate deze antwoorden vorm krijgen, zul je minder snel achter indrukwekkende functies aan gaan die niet aan je werkelijke behoeften voldoen. Je kunt dit allemaal vastleggen in ClickUp Docs, waar vereisten als gedeelde referentie worden bewaard in plaats van als een eenmalige checklist.

Naarmate er nieuwe input binnenkomt, evolueert het document:

- De zorgen van belanghebbenden worden expliciete beperkingen

- Nieuw geïdentificeerde softwarecategorieën worden vastgelegd voordat de vergelijkingen beginnen.

Omdat documenten in dezelfde werkruimte staan als evaluatietaken, blijft de context behouden. Wanneer u naar de onderzoeks- of demofase gaat, kunt u uw activiteiten rechtstreeks koppelen aan de vereisten die u al hebt gevalideerd.

📌 Resultaat: Het evaluatieproces is duidelijk gedefinieerd, waardoor de volgende stap veel gerichter is.

Fase 2: Softwareopties ontdekken met AI (oplossingsbewustzijn)

Zodra de vereisten zijn vastgesteld, verandert het probleem. De vraag verschuift van wat we nodig hebben naar wat realistisch gezien past. Ook de evaluatie verloopt hier trager, terwijl de zoekopdracht wordt uitgebreid en de opties door elkaar heen lopen.

AI beperkt de wildgroei door opties direct aan criteria te brengen, zoals branche, grootte van het team, budget en kernwerkstroomen, voordat er dieper op de materie wordt ingegaan.

In deze fase kunnen uw prompts er als volgt uitzien:

- Welke softwaretools voldoen aan deze vereisten?

- Wat zijn geloofwaardige alternatieven voor [naam tool] voor een team van onze grootte?

- Welke tools zijn geschikt voor agentschappen en welke voor teams van ondernemingen?

- Welke opties kunnen groei ondersteunen zonder ingrijpende aanpassingen?

Om dit overzichtelijk te houden, kunt u elke kandidaat als een apart item bijhouden in ClickUp-taaken. Elke tool krijgt een enkele taak met een eigenaar, links naar onderzoek, aantekeningen van AI-output en duidelijke volgende stappen. Naarmate opties vorderen of afvallen, wordt de lijst op één plek bijgewerkt, zonder dat u de context in verschillende gesprekken hoeft te achterhalen.

📌 Resultaat: Het resultaat is een beperkte shortlist met haalbare opties, elk met hun eigen eigendom en geschiedenis, klaar voor een veel diepgaandere vergelijking.

Fase 3: Functies en prijzen vergelijken met AI (overwegingsfase)

Shortlists creëren een nieuw probleem: vergelijkingsmoeheid. Functies sluiten niet goed op elkaar aan, prijsniveaus verhullen beperkingen en leverancierscategorieën sluiten niet aan bij de manier waarop teams werken.

U kunt AI gebruiken om verschillen tussen tools te normaliseren door functies aan hun eigen vereisten in kaart te brengen, prijsniveaus in duidelijke bewoordingen samen te vatten en beperkingen aan het licht te brengen die alleen op grote schaal voorkomen. Het brengt problemen zoals beperkte automatisering of prijzen voor add-ons aan het licht, waardoor u tijd bespaart.

Op dit moment wilt u het volgende vragen:

- Welke functies zijn bij elke prijsklasse inbegrepen?

- Waar leggen gratis of instapabonnementen limieten op?

- Welke functies kosten extra of zijn slecht schaalbaar?

- Waar overlappen tools elkaar en waar verschillen ze op belangrijke punten?

Zodra deze input beschikbaar is, kunt u in ClickUp-documenten vergelijkingstabellen maken, met de oorspronkelijke vereisten als vorm in plaats van de marketingcategorieën van leveranciers.

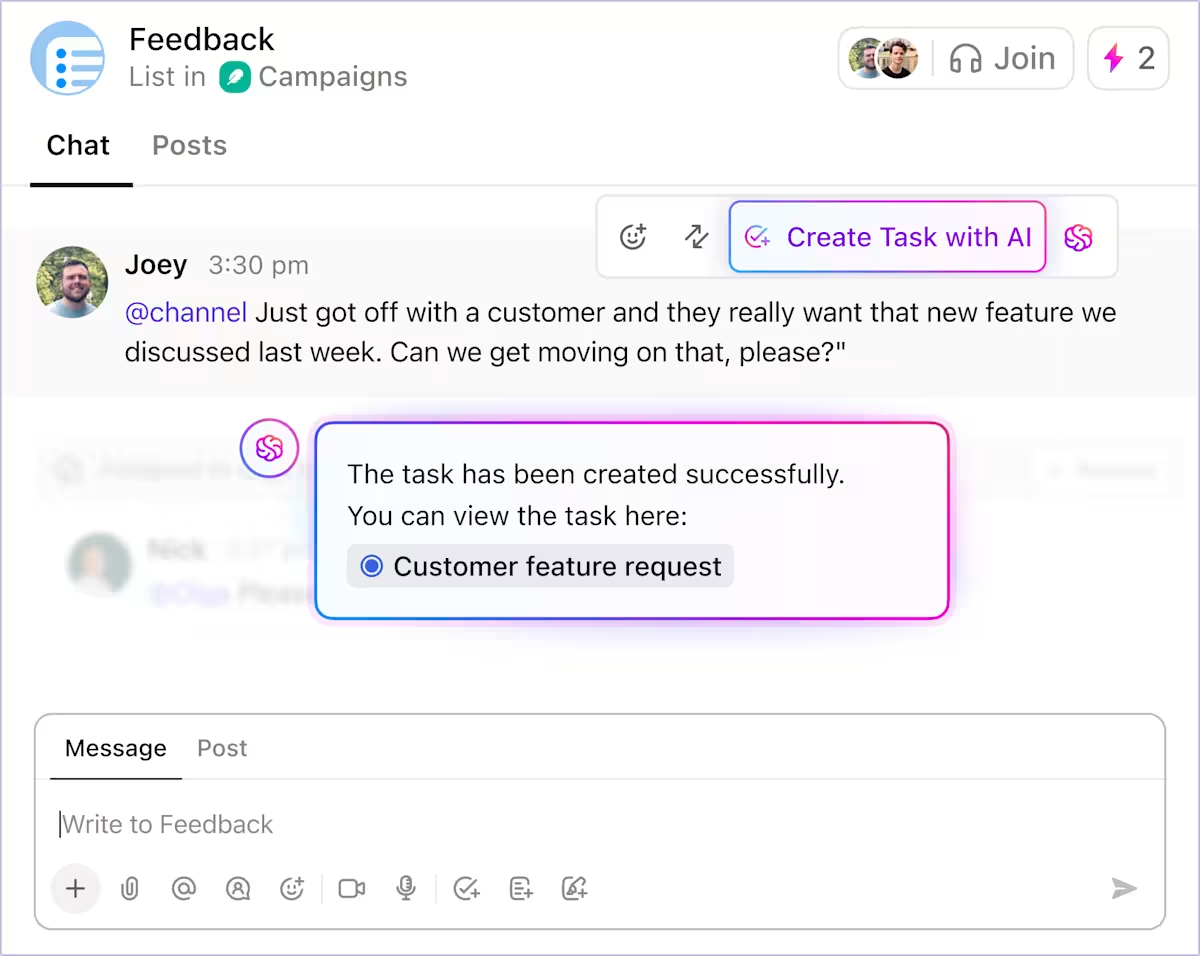

Met ClickUp Brain kunt u direct vanuit de vergelijking beknopte samenvattingen van de voor- en nadelen genereren. Zo blijft de interpretatie gebaseerd op het bronmateriaal en voorkomt u dat u afdwaalt naar aparte aantekeningen of gesprekken.

📌 Resultaat: Uw beslissingen worden beperkt op basis van gedocumenteerde afwegingen, niet op basis van uw intuïtie. Het wordt gemakkelijker om precies aan te geven waarom de ene optie wel en de andere niet wordt gekozen, waarbij de redenering naast de vergelijking zelf wordt bewaard.

Fase 4: Integraties en werkstroomgeschiktheid evalueren met AI

Twee tools kunnen op papier vergelijkbaar lijken, maar zich in uw bestaande stack heel anders gedragen. Het is dus van cruciaal belang om te bepalen of de nieuwe tool het werk vereenvoudigt of juist extra werk met zich meebrengt.

AI brengt elke tool op uw shortlist in kaart in uw huidige installatie. U vraagt niet alleen welke integraties er zijn, maar u kunt ook testen hoe de werkstroom daadwerkelijk verloopt. Wat gebeurt er bijvoorbeeld wanneer een lead in uw CRM verschijnt of een supportticket binnenkomt?

Vragen in deze fase klinken als volgt:

- Wat gaat er mis wanneer deze tool wordt geïntegreerd in onze bestaande systemen?

- Welke overdrachten vereisen menselijke tussenkomst?

- Waar mislukken automatiseringen stilzwijgend of synchroniseren ze slechts in één richting?

- Vermindert deze tool de coördinatie of verdeelt deze opnieuw?

Het belicht problemen zoals ontbrekende triggers of integraties die compleet lijken, maar toch problemen veroorzaken. ClickUp is in dit geval een goede keuze, omdat integraties en automatisering binnen hetzelfde systeem werken.

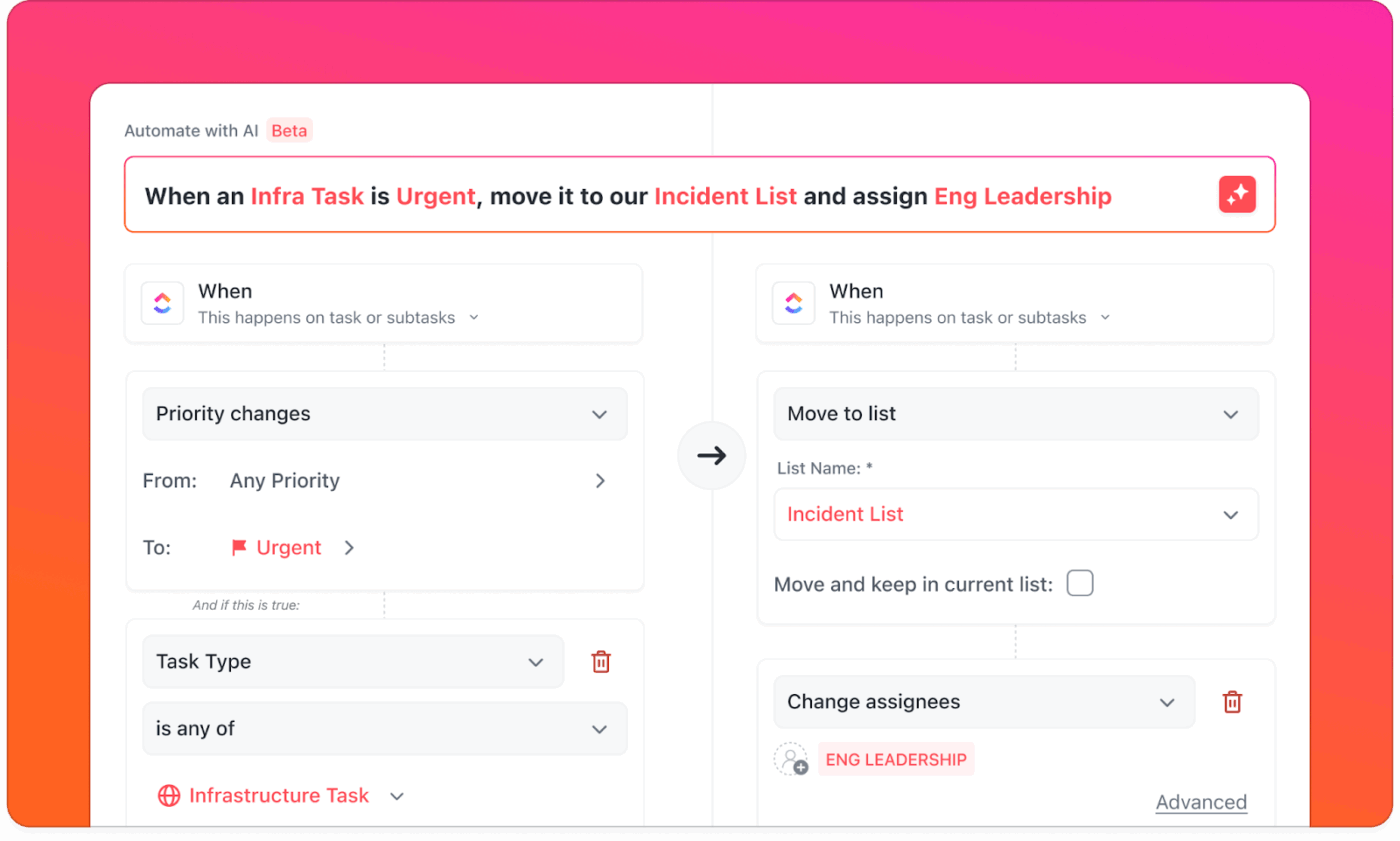

ClickUp Integrations verbindt meer dan 1000 tools, waaronder Slack, HubSpot en GitHub, om de zichtbaarheid te vergroten. Ze ondersteunen ook het aanmaken van taken, het bijwerken van statussen, het routeren van werk en het triggeren van follow-ups binnen de werkruimte waar de uitvoering al plaatsvindt.

Met ClickUp-automatiseringen kunt u controleren of routinematige overgangen consistent en zonder toezicht verlopen. Ze kunnen het koppelen van externe tools overslaan en het gedrag eenmalig definiëren, zodat het kan worden toegepast op ruimtes, lijsten en werkstroomen.

📌 Resultaat: Aan het einde van deze fase wordt het verschil duidelijker.

- Sommige tools bieden uitgebreide verbindingen, maar vereisen nog steeds dat mensen het werk coördineren.

- Anderen integreren de coördinatie in de werkstroom zelf.

Dit inzicht weegt vaak zwaarder dan gelijkwaardige functies wanneer de uiteindelijke beslissing wordt genomen.

Fase 5: Het gebruik in de praktijk valideren met AI (beslissingsfase)

Tegenwoordig hangt de beslissing zelden af van ontbrekende functies of onduidelijke prijzen. Wat moeilijker te beantwoorden is, is of de tool blijft werken als de nieuwigheid eraf is en het echte gebruik begint.

AI is hier nuttig als patroonzoeker in plaats van als onderzoeker. AI kan terugkerende thema's in de door u verstrekte beoordelingsbronnen (G2, documentatie, forums) samenvatten en u vervolgens helpen te testen of problemen zich voordoen op basis van de grootte van het team of de gebruikssituatie.

Veelgestelde vragen in deze fase zijn onder meer:

- Welke problemen melden mensen na de eerste paar maanden?

- Welke werkstroom heeft moeite met de groeiende gebruik?

- Welke thema's komen terug op beoordelingssites zoals G2 en Reddit?

- Welke soorten teams hebben spijt van hun keuze voor deze tool?

AI kan onderscheid maken tussen onboarding-frictie en structurele limieten, of laten zien of klachten zich concentreren rond bepaalde teamgroottes, sectoren of gebruikssituaties. Die context helpt bij het bepalen of het probleem een beheersbare afweging is of een fundamentele mismatch.

Naarmate er meer inzichten worden verzameld, kunt u de gegevens zichtbaar maken in ClickUp dashboards, waar u risico's, openstaande vragen, zorgen over de uitrol en patronen van beoordelaars op één plek kunt bijhouden. Uw stakeholders kunnen dezelfde signalen zien: terugkerende klachten, risico's bij de implementatie, afhankelijkheden en onopgeloste hiaten.

📌 Resultaat: Deze fase biedt duidelijkheid over waar wrijving waarschijnlijk zal ontstaan, wie dit als eerste zal merken en of uw organisatie voorbereid is om dit op te vangen.

Fase 6: Definitieve beslissing en buy-in met AI

Het evaluatiewerk is nu grotendeels klaar, maar zelfs als de juiste optie duidelijk is, kan de beslissing nog steeds uitblijven als uw team niet kan aantonen hoe de implementatie in de praktijk zal werken.

U kunt AI gebruiken om alles wat u tot nu toe hebt geleerd te consolideren tot beslissingsklare resultaten. Dat omvat samenvattingen waarin de uiteindelijke opties worden vergeleken, duidelijke verklaringen van aanvaarde compromissen en implementatieplannen die anticiperen op wrijving.

U kunt van AI verwachten dat het vragen beantwoordt zoals:

- Welke optie past het beste bij onze doelen en ons budget, gezien alles wat we hebben geleerd?

- Welke compromissen accepteren we bewust?

- Hoe ziet een realistische implementatie eruit in de eerste 30, 60 of 90 dagen?

- Hoe leggen we deze beslissing uit aan het management op een manier die kritische vragen kan doorstaan?

Omdat ClickUp Brain toegang heeft tot de volledige evaluatiecontext – documenten, vergelijkingen, taken, feedback en risico's – kan het samenvattingen en implementatiechecklists genereren, waardoor generieke evaluatiesjablonen overbodig worden. U kunt het gebruiken om memo's voor het management op te stellen, onboardingplannen te maken en eigenaren op één lijn te brengen met betrekking tot successtatistieken, zonder de context naar afzonderlijke tools te exporteren.

📌 Resultaat: Zodra deze materialen worden gedeeld, verandert het gesprek. Uw stakeholders bekijken dezelfde bewijzen, aannames en risico's op één plek. Vragen worden doelgerichter en buy-in volgt vaak op een meer natuurlijke manier.

Wat u tijdens de proefversie moet testen, zodat u niet wordt misleid door demo's

Test tijdens proefversies de werkstroom, niet de functies:

- Voer één echte werkstroom van begin tot eind uit (ontvangst → overdracht → goedkeuring → rapportage)

- Test toestemmingen met echte rollen (beheerder, manager, bijdrager, gast)

- Meet de tijd van de installatie en knelpunten (waar mensen vastlopen)

- Forceer uitzonderingen (onderbreking van overdracht, ontbrekend veld, vertraagde goedkeuring)

- Vraag: Wat gaat er mis wanneer u het aantal gebruikers, projecten of automatiseringen uitbreidt?

Veelgemaakte fouten bij het evalueren van software met AI

AI kan software-evaluatie versterken, maar alleen als het met discipline wordt gebruikt. Vermijd deze misstappen:

- AI-output niet verifiëren: AI kan functies, prijzen of limieten verkeerd interpreteren, waardoor verificatie van cruciaal belang is.

- De vereistenfase overslaan: Tools vergelijken zonder duidelijke behoeften leidt tot het najagen van functies in plaats van het oplossen van problemen.

- De integratiediepte negeren: Beweerde integraties synchroniseren mogelijk alleen gegevens, maar ondersteunen geen doorlopende werkstroombeheer.

- Vragen over gegevensprivacy negeren: Onduidelijke beleidsregels voor toegang tot, opslagruimte of hergebruik van gegevens creëren downstream compliance-risico's.

- Geïsoleerde evaluatie: Als gebruikers in een vroeg stadium worden buitengesloten, leidt dit vaak tot wrijving bij de implementatie later.

- AI-functies verwarren met AI-mogelijkheden: een toegevoegde chatbot biedt niet dezelfde waarde als AI die in kernwerkstroomen is geïntegreerd.

Best practices voor AI-gestuurde software-evaluatie

AI-gestuurde software-evaluatie werkt het beste wanneer u deze systematisch toepast bij alle beslissingen met behulp van de onderstaande werkwijzen:

Deze best practices zijn eenvoudig te implementeren wanneer u een centraal platform zoals ClickUp hebt om ze te beheren.

- Stel steeds specifiekere vragen: begin met het definiëren van het probleem en maak de vragen vervolgens steeds specifieker naarmate de vereisten, beperkingen en afwegingen duidelijker worden.

- Controleer AI-outputs aan de hand van echte gegevens: valideer functies, prijzen en limieten aan de hand van documentatie van leveranciers en betrouwbare beoordelingsbronnen.

- Centraliseer aantekeningen, beslissingen en goedkeuringen: bewaar vereisten, bevindingen, risico's en goedkeuringen in één gedeelde werkruimte om versnipperde context te voorkomen.

- Evalueer tools op basis van werkstroom: Focus op hoe het werk van begin tot eind verloopt in plaats van geïsoleerde mogelijkheden te vergelijken.

Gebruik ClickUp om softwarebeslissingen operationeel te maken

Software-evaluatie mislukt niet omdat u informatie mist. Het mislukt omdat uw beslissingen verspreid raken over tools, gesprekken en documenten die niet zijn ontworpen om samen te werken.

ClickUp brengt evaluatie samen in één werkruimte, waar vereisten, onderzoek, vergelijkingen en goedkeuringen met elkaar verbonden blijven. U kunt behoeften documenteren in ClickUp Docs, leveranciers volgen als taken, bevindingen samenvatten in ClickUp Brain en leidinggevenden realtime zichtbaarheid geven via dashboards zonder dat er een wildgroei aan SaaS ontstaat.

Aangezien evaluatie hand in hand gaat met uitvoering, blijft de redenering erachter ook zichtbaar en controleerbaar, wanneer uw team verandert of tools opnieuw moeten worden geëvalueerd. Wat begint als een aankoopproces, wordt onderdeel van de manier waarop uw organisatie beslissingen neemt.

Als uw team al AI gebruikt om software te evalueren, helpt ClickUp u om die inzichten om te zetten in actie zonder dat u een extra systeem hoeft te beheren.

Ga gratis aan de slag met ClickUp en centraliseer uw softwarebeslissingen. ✨

Veelgestelde vragen

Ja, wanneer nauwkeurigheid betekent dat patronen, inconsistenties en ontbrekende informatie in vele bronnen moeten worden opgespoord, kan AI helpen bij het evalueren van software. Het kan functies vergelijken, beoordelingen samenvatten en claims van leveranciers op grote schaal aan stresstests onderwerpen, waardoor evaluaties in de vroege en middenfase betrouwbaarder worden.

Door vage prompts of onjuiste outputs kan er vooringenomenheid ontstaan. Gebruik duidelijk omschreven vereisten, stel vergelijkende vragen en controleer beweringen aan de hand van primaire bronnen zoals documentatie en proefversies.

Nee, AI kan opties beperken en scherpere demovragen voorbereiden, maar het kan het praktische gebruik niet repliceren. Demo's en proefversies zijn nog steeds nodig om werkstroom, bruikbaarheid en acceptatie door het team in reële omstandigheden te testen.

Effectieve teams documenteren softwarebeslissingen door vereisten, vergelijkingen en uiteindelijke redeneringen te centraliseren in één gedeelde werkruimte. Zo blijft de context behouden en worden herhaalde discussies voorkomen wanneer tools later opnieuw worden bekeken.

Let bij het evalueren van antwoorden van AI-software op vage beweringen, inconsistente uitleg en ontbrekende details over gegevensverwerking of modelgedrag.