GitHub Copilotは数分で数百のテストケースを生成可能——管理された実験では開発者の作業が35%短縮——ただし注意点:AI生成テストの有用性は、それらを追跡・整理し開発ワークフロー全体に接続させる能力に依存します。

このガイドでは、GitHub Copilotを使用してテストケースを迅速に作成する方法を解説し、その後、孤立したコードファイルの山と化さないよう効果的に管理する手法を紹介します。

ソフトウェア品質においてユニットテストが重要な理由

ユニットテストの作成はしばしば面倒な作業と見なされますが、それを省略すると脆弱なコードにつながります。

テストという安全網がない場合、小さなリファクタリングでも回帰欠陥(既存機能を破壊しユーザーの信頼を損なうバグ)を引き起こす可能性があります。IBMの研究によれば、リリース後に発見された欠陥の修正コストは15倍も高くなります。

これにより、開発者は「何が壊れるか」を恐れてコード改善を避け、技術的負債が積み上がるというサイクルが生まれます。

AI支援によるテスト生成はこのサイクルを断ち切る助けとなり、現在89%の組織が品質保証とテスト分野で生成AIワークフローの試験導入または本格導入を進めています。GitHub Copilotのようなツールでテストケースの骨組みを作成すれば、真に重要な作業に集中できます:意味のあるテストの設計とエッジケースカバレッジの精緻化です。

一貫したユニットテストが効果を発揮する理由:

- 回帰防止: 優れたテストはガードレールの役割を果たし、新機能やバグ修正が意図せず他の機能を壊すのを防ぎます

- 生きているドキュメント: 古くなる静的なドキュメントとは異なり、ユニットテストはコードがどのように動作すべきかを示す実行可能な例として機能します

- リファクタリングの確信: 包括的なテストカバレッジがあれば、変更が意図しない結果をもたらすかどうかを即座に把握できるという確信を持って、コードベースをリファクタリングし改善できます。

テスト生成を超えてAIエージェントがコーディング環境をどう変革しているかを理解するには、AI搭載コーディングアシスタントとその機能の概要動画をご覧ください:

テストケース生成のためのGitHub Copilot設定方法

テスト生成を開始する前に、統合開発環境(IDE)にGitHub Copilotをインストールしセットアップする必要があります。セットアッププロセスは簡単で数分で完了しますが、正しく設定することでCopilotが適切な提案を行うためのコンテキストを確保できます。

始める前に以下の準備が必要です:

- 有効な GitHub Copilot サブスクリプション(個人、ビジネス、または企業)

- 対応するIDE(例:VS Code、JetBrains IDE(IntelliJやPyCharmなど)、Neovim)

- プロジェクトに既にインストールされているpytest、Jest、JUnitなどのテストフレームワーク

GitHub Copilot拡張機能をインストールする

まず、IDEにCopilot拡張機能をインストールする必要があります。この手順は、ほとんどのサポートされるエディターで同様です。

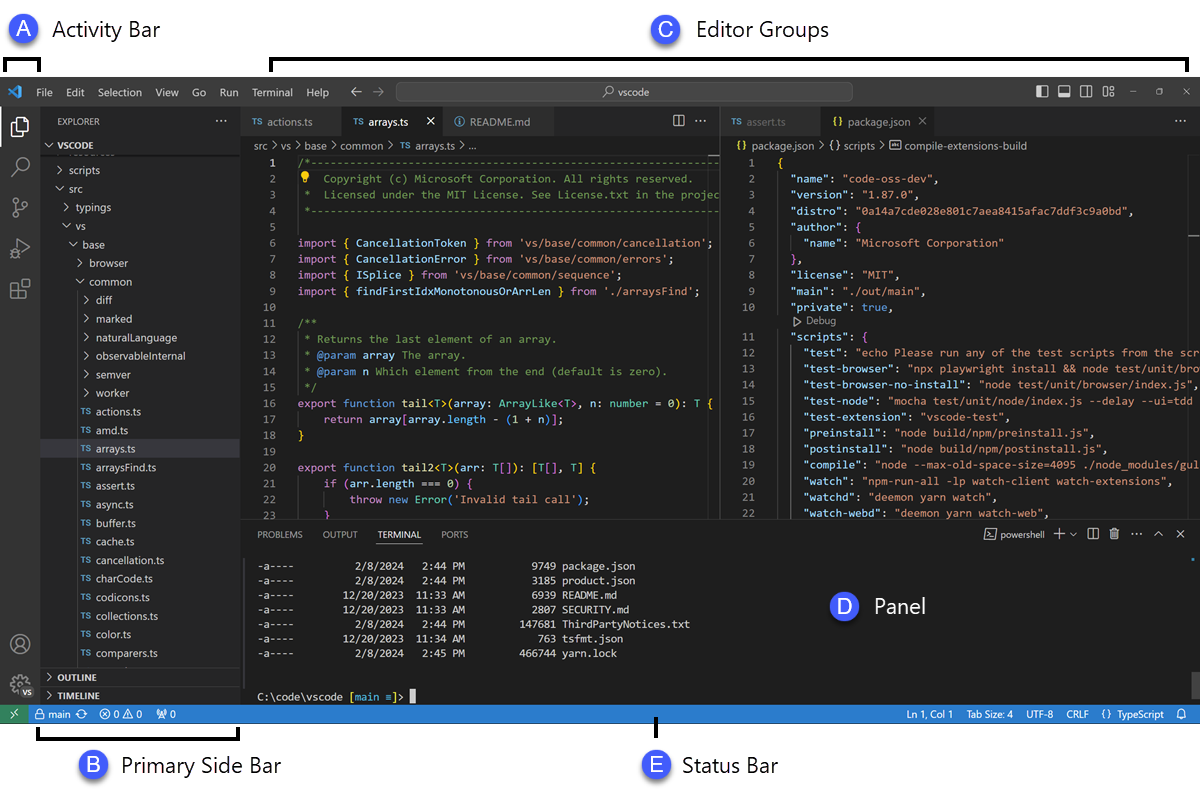

- IDEの拡張機能マーケットプレイスを開きます。VS Codeではサイドバーの「拡張機能」アイコン、JetBrains IDEでは「設定」→「プラグイン」からアクセスできます。

- 「GitHub Copilot」を検索

- 完全な機能を利用するには、メインのGitHub Copilot拡張機能とGitHub Copilot Chat拡張機能の両方をインストールしてください

- インストールを完了するには、IDEの再起動を要求するプロンプトが表示されます

再起動後、GitHubアカウントでのサインインが求められます。このステップでサブスクリプションが認証されます。ログイン後、IDEのステータスバーに小さなCopilotアイコンが表示され、機能が有効で利用可能な状態であることを確認できます。

テストフレームワークの設定

GitHub Copilotは、プロジェクト固有のテストセットアップを理解することで、より関連性の高いテストを生成します。既存のテストファイルと設定を分析し、チームのパターンを学習・適合させることでこれを実現します。

- pytestを使用するPythonプロジェクトの場合: pytestがインストールされていることを確認してください(pip install pytest)。conftest.pyファイルや既存のテストファイル(1つでも)がある場合、Copilotはそれらを新しいテスト生成の参照として使用します。

- Jestを使用するJavaScript/TypeScriptプロジェクト向け: Copilotは、セットアップを把握するために`jest.config.js`ファイルと`package.json`内のJest依存関係を検索します

- JUnitを使用するJavaプロジェクトの場合: pom.xml(Maven用)またはbuild.gradle(Gradle用)ファイルでJUnitの依存関係が正しく定義されていることを確認してください。

プロジェクト内に少なくとも1つ、適切に記述されたテストファイルを用意することが、Copilotを導く最良の方法の一つです。これにより、命名規則、アサーションのスタイル、テストの構造化方法が認識され、より一貫性のある出力が得られます。

CopilotをIDEに統合する

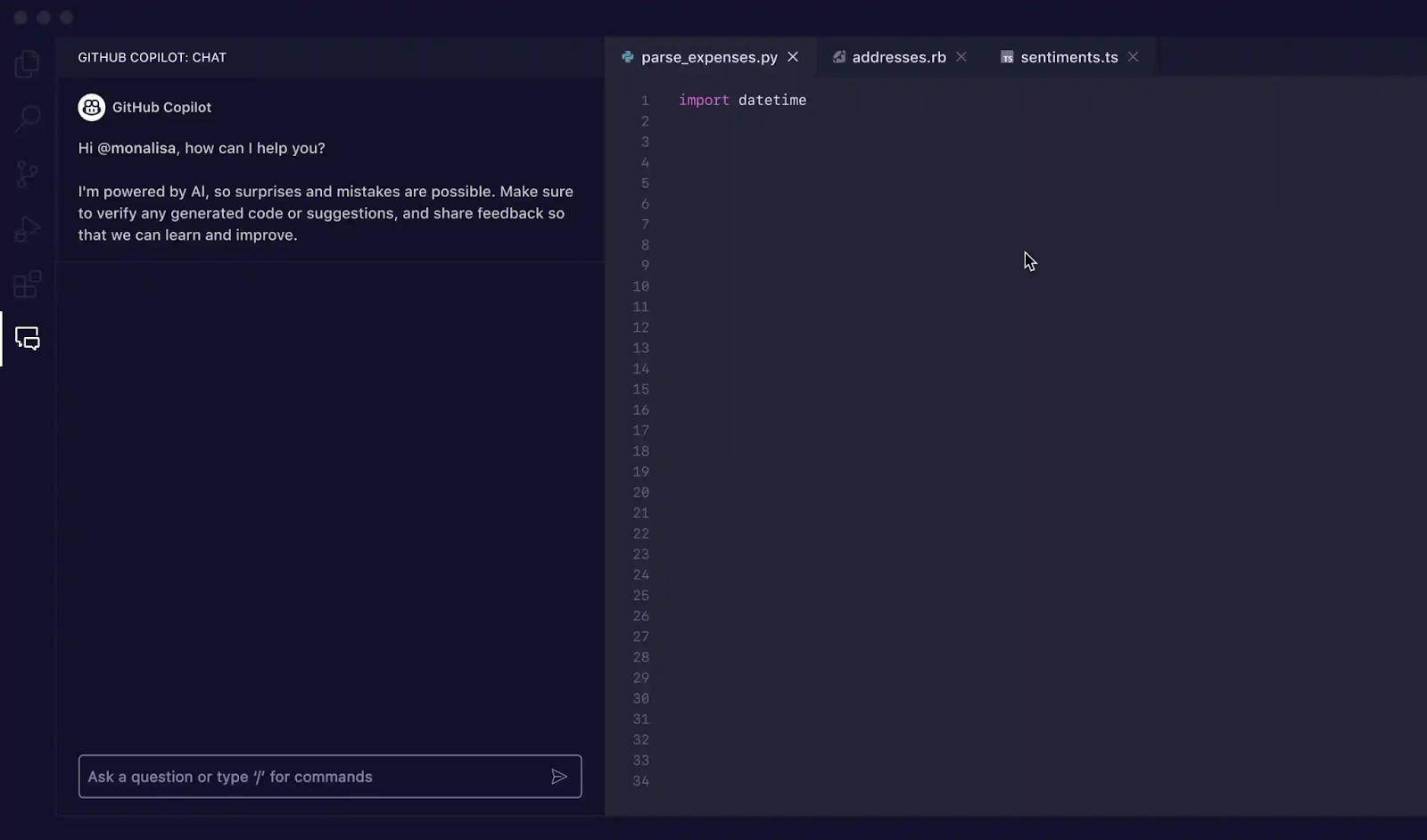

拡張機能をインストールしたら、IDE内のCopilotインターフェースに慣れましょう。テスト生成における主な操作は、Copilot チャットパネルを通じて行います。

チャットビューは、キーボードショートカット Ctrl+Cmd+I(Mac)または Ctrl+Alt+I(Windows/Linux)で、あるいはIDEのアクティビティバーにあるCopilot Chatアイコンをクリックして開けます。このチャットパネルがテスト生成の指令センターとなります。

Copilotはコンテキストを認識します。つまり、現在開いているファイル、プロジェクトのファイル構造、選択したコードを読み取ります。最適な結果を得るには、テスト対象の機能やクラスを含むファイルを常にエディターで開いて可視させておいてください。

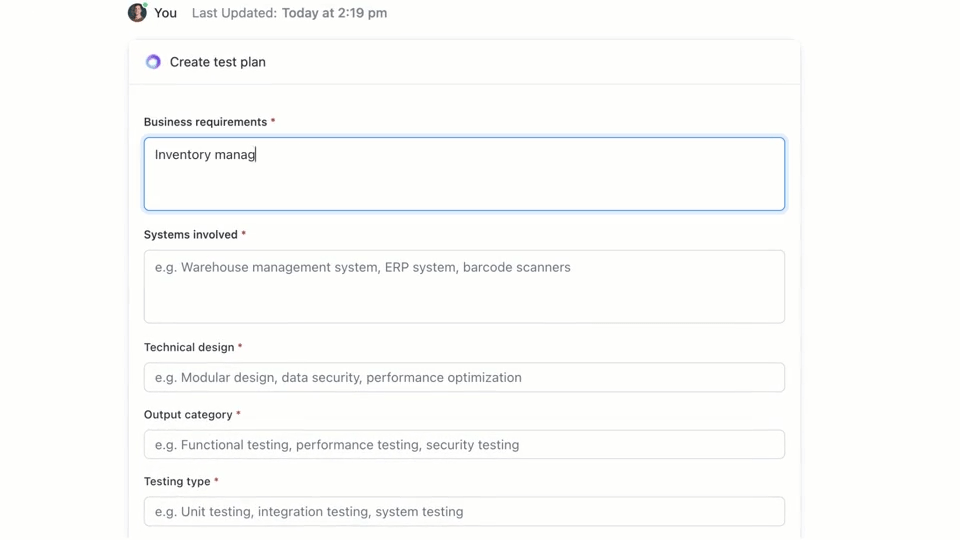

🌟ClickUp Brain(ClickUp全体に統合されたコンテキストAI)がテストプランを素早く作成します。今すぐお試しください。

GitHub Copilotでテストケースを書く方法

GitHub Copilotでは主に3つの方法でテストケースを生成できます:詳細なプロンプトを伴うチャットパネルの使用、スラッシュコマンドの使用、エディター内でのスマートアクションの直接使用です。各方法は、スピードを重視するか細かい制御を必要とするかによって、開発ワークフロー内の異なる状況に適しています。

Copilot チャットプロンプトを活用する

特定のプロンプトを用いたCopilot Chatの使用が、テストケース生成において最も強力な手法です。複雑な機能やクラスにおいて、特定のシナリオ定義、依存関係のモック化、または扱いにくい境界条件の処理が必要な場合に最適です。

基本的なワークフローは以下の通りです:

- Copilot チャットパネルを開く

- エディターでテスト対象の機能、クラス、またはコードブロックを選択

- 必要なテストを明確かつ具体的に記述したプロンプトをチャットパネルに入力してください

例えば、以下のようなプロンプトを記述できます:

- 「選択した機能に対して、正常処理フロー、空入力などの境界条件、無効データに対するエラー処理をカバーするユニットテストを作成する」

- 「このクラス用のpytestテストを生成し、データベース接続をモックするためのフィクスチャを作成してください」

- 「このReactコンポーネント向けに、ユーザーのクリックをシミュレートし状態変化を検証するJestテストを作成する」

プロンプトに詳細を詰め込めば詰め込むほど、生成されるテストの質は向上します。

/tests などのスラッシュコマンドを使用する

高度に特定のシナリオを必要とせず、テストを迅速に生成する必要がある場合、/tests スラッシュコマンドが最適です。これはテストカバレッジの確かな基盤を構築する最速の方法です。

使用方法:

- Copilot チャットパネルを開く

- エディターでテスト対象のコードを選択

- チャット入力欄で「/tests」と入力し、Enterキーを押すだけ

Copilotは選択したコードの構造とロジックに基づき、即座に一連の単体テストを生成します。主要な機能と一般的な入力値をカバーするよう試みます。結果が不十分な場合は、「入力がnullの場合のテストを追加して」といったフォローアッププロンプトでいつでも調整可能です。

エディタースマートアクションを活用する

作業のフローを中断せずにテストを生成したい時は、コードエディターから直接スマートアクションを利用できます。これによりチャットパネルに切り替える必要がなくなります。

- テスト対象の機能またはクラスをハイライトします

- 選択範囲を右クリックしてコンテキストメニューを開く

- コンテキストメニューの「コードを生成」に移動し、「テストを生成」を選択します

Copilotがテストを生成し、通常は新しい一時的なエディタータブに表示します。そこでコードを確認し、新しいテストファイルを作成するか、既存のファイルにテストを追加するかを選択できます。

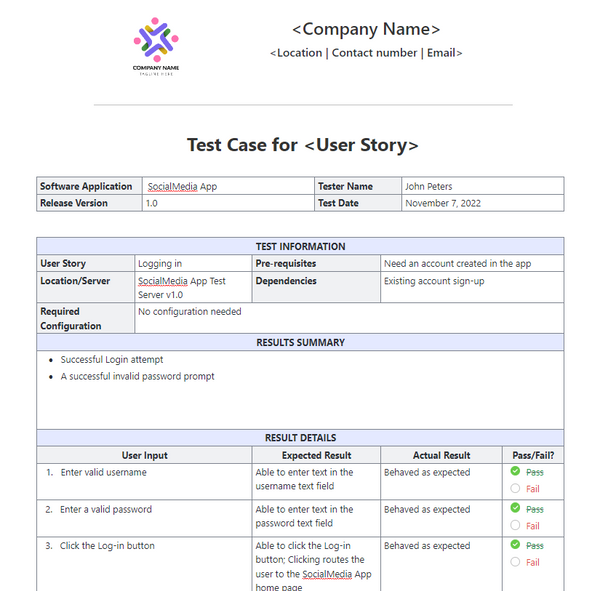

📚 こちらもご覧ください:ソフトウェアテスト用テストケーステンプレート

テストケース生成のためのGitHub Copilotプロンプト

プロンプトはGitHub Copilotの操縦桿です。汎用的なプロンプトは汎用的なテストを生みますが、AIに具体的な指示を与える巧みなプロンプトは包括的で有用なテストケースの結果を生み出します。重要なのは、Copilotに「何を」テストするかだけでなく、「どのように」テストするかを伝えることです。

以下は様々なシナリオに合わせて調整可能なテンプレートです:

| シナリオ | プロンプトテンプレート |

|---|---|

| 基本ユニットテスト | 「[function_name]機能に対して[framework]を使用した単体テストを作成してください。通常の入力値、ゼロや負の番号などの境界値、nullやundefinedなどの無効な入力値を必ずカバーするようにしてください。」 |

| 依存関係を持つクラス | 「[ClassName] クラスのテストを生成してください。[mocking_library] を使用して、[DependencyName] および [AnotherDependencyName] 依存関係に対するモックを作成してください。」 |

| 非同期機能 | 「この非同期機能のテストを作成してください。成功ケース、プロミスが拒否されるケース、リクエストタイムアウトのシナリオを含むテストを含めてください。」 |

| APIエンドポイント | 「このAPIエンドポイントの統合テストを作成してください。成功するGETリクエスト、有効なデータを含むPOSTリクエスト、認証トークンが欠落したリクエスト、および400エラーを返すべき無効なデータを含むリクエストをカバーしてください。」 |

| データ検証 | 「この検証機能のテストを生成してください。有効なオブジェクトに対するテストを含め、さらに各検証ルール違反に対する個別のテストを追加し、正しいエラーメッセージが返されることを確認してください。」 |

プロンプト改善のヒント:

- フレームワークを明示的に指定する: 構文が正しいことを保証するため、常にテストフレームワーク(例: pytest、Jest、JUnit)にメンションを付けてください

- カバレッジ目標を定義する:高度なAIプロンプト技術を活用し、「エッジケース」「エラー処理」「境界値テスト」など特定のカバレッジタイプを要求する

- 自身のパターンを参照する: 優れた例ファイルがある場合、Copilotに「tests/test_user.py のテストパターンに従う」と指示できます。

- 特定の断言を要求する: Copilotに推測させる代わりに、「無効な入力に対してValueErrorが発生することを断言する」と指示できます。

📚 こちらもご覧ください:ソフトウェアテスト向け最高品質保証ツール

GitHub Copilot テスト生成の例

実際の仕事のやり方をご紹介します。

Pythonでユニットテストを生成する

ショッピングカートのアイテム合計金額(割引を含む)を計算するPython機能があるとします。

テスト対象のサンプル機能:

使用プロンプト: 「calculate_total 関数の pytest テストを作成してください。空のアイテムリスト、単一アイテム、複数アイテム、割引適用、0% 割引、100% 割引、および ValueError を発生させるべき無効な割引率をカバーすること。」

生成されたテスト出力:

Copilotはpytest.raisesを正しく使用して例外をチェックし、主要なシナリオをカバーしました。ただし、負の価格や数量に対するテストは手動で追加することをお勧めします。

JestでTypeScriptのユニットテストを生成する

では、ユーザーの名前をフォーマットするTypeScript機能を作成してみましょう。

テスト対象のサンプル機能:

使用プロンプト: 「formatDisplayName の Jest テストを生成してください。以下のケースをカバーします:- ファーストネームとラストネームを持つユーザー- ニックネームを持つユーザー- ファーストネームが空のユーザー- ニックネームのみを持つユーザー」

生成されたテスト出力:

生成されたテストはJestの標準的なdescribeおよびitブロックを使用し、異なるロジック分岐を適切に処理します。

GitHub Copilotによるテスト生成のベストプラクティス

Copilotによるテスト生成は生産性を大幅に向上させますが、品質を確保するためには慎重な監視が必要です。

- すべてのテストを必ず確認する:これが黄金律です。Copilotはビジネスロジックを理解しないため、テストは通過しても間違ったことを検証するテストを生成する可能性があります。生成されたコードを必ず読み、「これは実際に正しい動作を検証しているか?」と自問してください。

- エッジケースのカバレッジを手動で確認: Copilotはnull入力や空ストリングといった一般的なエッジケースの検出に優れていますが、ドメイン固有のケースを見逃す可能性があります。例えばECアプリの場合、カートの合計金額が送料無料の最低金額にぴったり合った時の動作はテストされましたか? 専門家であるあなた自身の確認が不可欠です。

- 命名規則の一貫性を維持する: AI生成のテスト名は汎用的になりがちです。チームのスタイルに合わせて名前を変更しましょう。test_login_fails_with_incorrect_password のような説明的な名前は、test_login_2 よりもはるかに有用です。

- テストを即時実行:生成したテストを放置しないでください。コードをコミットする前に、構文エラーや明らかに失敗するアサーションを捕捉するため、直ちに実行しましょう。

- CI/CDとの連携: 生成されたテストを継続的インテグレーションパイプラインに追加。ローカル環境でのみ実行されるテストは限定的な価値しか提供しない

- 不安定なテストに注意:AIが生成するテストには「不安定」なもの(時々通過し、時々失敗する)が存在します。タイムスタンプやランダムデータを含むテストで頻発します。常に確定的で予測可能な値に置き換えてください

📮ClickUpインサイト:当社のアンケートによると、ユーザーの34%がAIシステムを完全に信頼して運用している一方、わずかに多い38%のグループは「信頼するが検証する」アプローチを維持しています。業務の文脈を理解していないスタンドアロンツールは、不正確または不十分な応答を生成するリスクが高い傾向があります。

これが、ワークスペース全体と統合されたサードパーティツールを横断し、プロジェクト管理・ナレッジ管理・コラボレーションを繋ぐAI「ClickUp Brain」を開発した理由です。コンテキストに応じた応答を切り替えなしで得られ、Seequentのクライアント様と同様に作業効率が2~3倍向上します。

GitHub Copilotによるテストケース生成のリミット

GitHub Copilotは生産性を大幅に向上させるツールですが、ソフトウェアテストの万能薬ではありません。効果的に活用し、よくある落とし穴を避けるには、そのリミットを理解することが重要です。これは「コパイロット」であって「パイロット」ではありません。飛行プランの責任は依然としてあなたにあります。

最大の制限はビジネス文脈の欠如です。Copilotはコード構造を分析しますが、アプリケーションがユーザーに対して実際に何をやるべきか理解できません。「プレミアム」ユーザーは特定の機能にアクセスできる一方、「ベーシック」ユーザーはアクセスできないといったロジックを、読み取っているコードに明示的に記述されていない限り認識できません。

以下に留意すべきその他の主要な制約事項を挙げます:

- 重要なドメイン固有のエッジケースを見逃す可能性があります: Copilotは一般的なエッジケースを見つけるのは得意ですが、業界固有の特殊なケース(例:閏年を別々に扱う必要がある金融計算など)は認識しません。

- 外部システムへのアクセス不可: CopilotはデータベースやサードパーティAPIに接続できないため、意味のある統合テストを生成できません。コードの骨組みは作成できますが、詳細部分は手動で埋める必要があります。

- 誤った安心感を与える可能性がある:100%のテストカバレッジは気分が良いが、テストが間違ったことを検証している場合、そのカバレッジ数値は無意味だ。だからこそ人間のレビューが極めて重要なのである

- コンテキストウィンドウのリミット: 非常に大きなファイルや複雑なクラス階層は、Copilotのコンテキストウィンドウを超える結果となり、不完全または汎用的な提案が生じる場合があります。

📚 こちらもご覧ください:GitHub Copilotでバックエンド開発を行う方法

ClickUpでのテストケース作成と管理方法

GitHub Copilotによるテストケース生成はワークフローの半分に過ぎません。テストが存在する後は、チームはそれらを追跡し、要件にリンクし、スプリントやリリースを跨いだ実行を管理する必要があります。

ClickUpは、AI生成のテストケースを開発タスク、バグ、スプリントプランと同一の集中管理ワークスペースに配置できるため、テストが個々のIDE内に閉じ込められることはありません。

ClickUpは統合型AIワークスペースとして機能し、プロジェクト管理、ドキュメント管理、チームコミュニケーションを一元化します。ソフトウェアチームにとって、これはテストケース管理が別ツールやスプレッドシートで管理される必要がなくなることを意味します。

テスト、要件、プルリクエスト、リリース議論がすべて接続され、コンテキストの拡散を抑制。QAをデリバリーワークフローの主要な要素として位置付けます。

ClickUpのテストケーステンプレートは、テストケースの進捗追跡を支援するために設計されています。これにより以下の作業が容易になります:

- テスト結果を確認し、バグ修正に関するデータ駆動型の意思決定を行う

- 各プロジェクト向けにカスタムテストプランを開発する

- テストケースを整理・優先順位付けし、最大限の効率を実現

専用のClickUpリストを作成し、テストケースリポジトリとして活用することから始めます。AI生成か手動作成かを問わず、各テストケースはタスクとして登録されます。

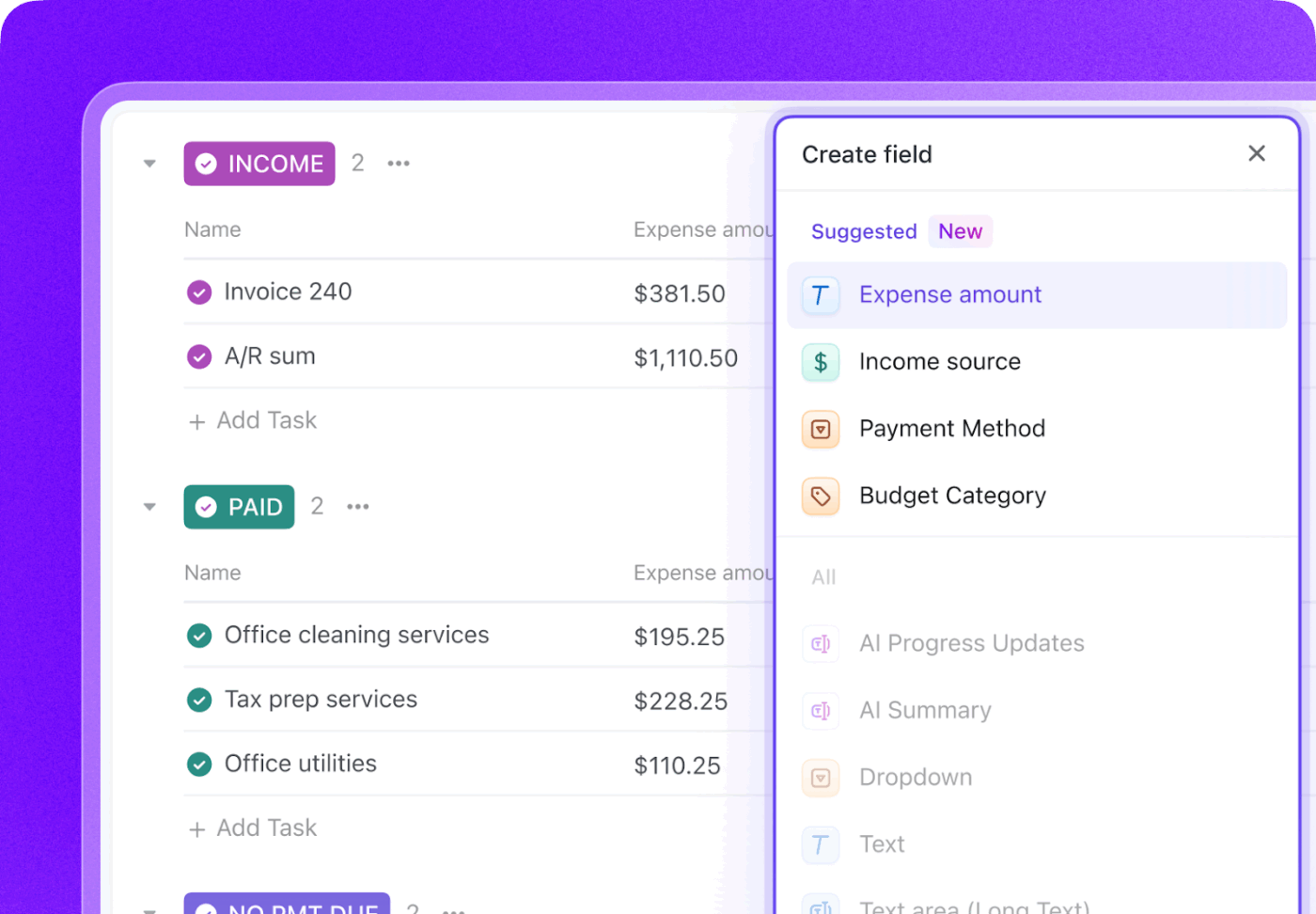

ClickUpカスタムフィールドで各テストケースに重要なメタデータを付与し、チームにとって真に重要な要素を正確に追跡しましょう。

- テストタイプ: ユニット、統合、エンドツーエンド、または手動から選択するドロップダウン

- 自動化ステータス: テストが自動化されているか否かを示すステータス

- 優先度: 高、中、低

- 最終実行日: テストが最後に実行された日付を追跡するための日付フィールド

ClickUpカスタムステータスでテストライフサイクル全体を追跡:ワークフローを作成し、テストを「未実行」から「合格」「不合格」「ブロック」へ移行させます。これにより開発者からプロダクトマネージャーまで、チーム全員がテスト実行の進捗を即座に把握できます。

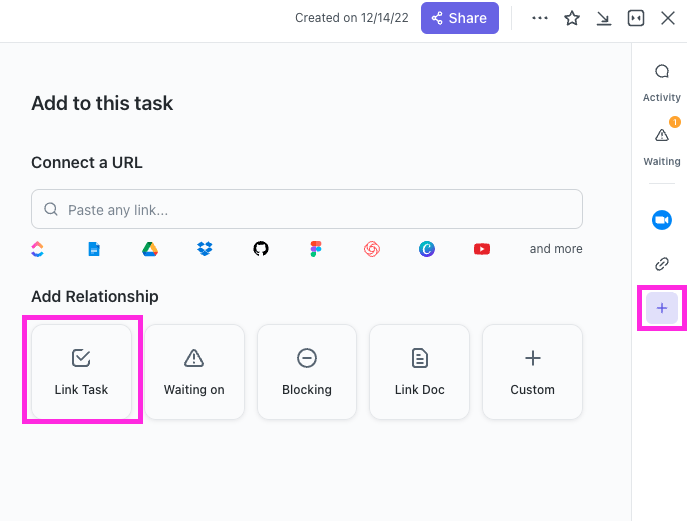

ClickUpのリレーションシップ機能により、テストケースタスクをユーザーストーリー、機能、またはエピックに直接リンクできます。テストが失敗した場合、バグレポートタスクを作成し、失敗したテストと元のストーリーの両方にリンクすることで、完全なトレーサビリティの連鎖を構築できます。

ClickUp Brainで失敗したテストケースタスクを指定するだけで、数秒でバグレポートの下書きを作成。ワークスペース全体のコンテキストを把握しているため、関連するユーザーストーリーやテストケース自体の詳細情報を自動的に取り込めます。

🌟ClickUpのテストレポートテンプレートを使えば、改善が必要な問題を確実に特定・対応しながら、より迅速にレポートを作成できます。

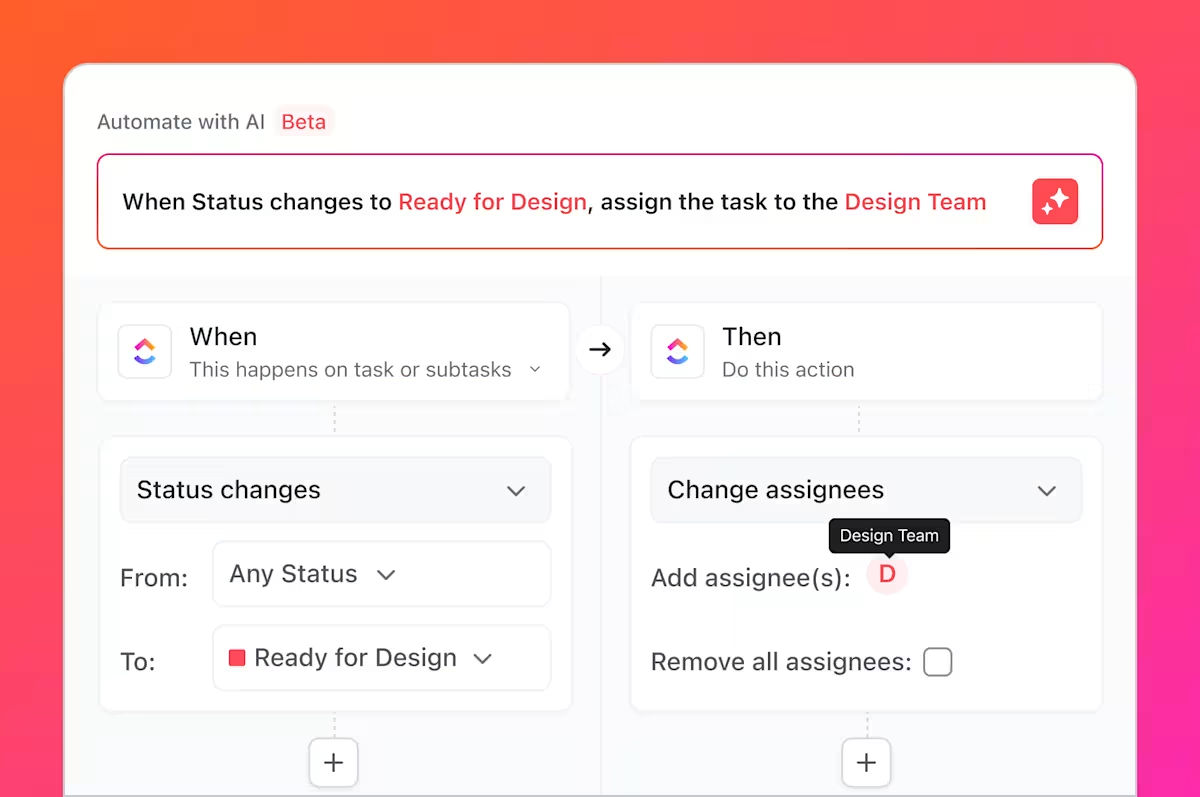

しかし、やることはその程度ではありません。テストに必ず伴う退屈で反復的なタスク、つまり先ほどお話しした煩雑なタスクを、ClickUp Automationsで自動化できます。

「テストケースのステータスが失敗に変わった場合、バグリストに新しいタスクを自動作成し、リード開発者に割り当てる」といったルールを設定する。

GitHubとClickUpを連携させることで、テストケースタスクをコミットやプルリクエストにリンクできます。コード変更がマージされると、関連するテストタスクが自動更新されるため、QA担当者、開発者、リリースマネージャーが変更内容と再テストが必要な箇所を常に把握できます。

ClickUpダッシュボードでは、リアルタイムのテスト進捗状況の追跡、バグ件数の可視化、テストケースの実行状況などを確認できます。

このワークフローにより、GitHub CopilotでAI生成されたテストとClickUpでのチーム全体のテストケース管理のギャップを埋めます。これにより、チームは手動での調整を頻繁に行うことなく、QAプロセスのプラン、追跡、自動化、改善を単一システムで実現できます。

効率的なリリース管理ワークフロー構築のコツはこちらをご覧ください:

ClickUpでテストケース管理を簡素化する

AI生成テストはもはや孤立した成果物ではありません。開発プロセスに統合された可視性・追跡可能な構成要素として、チーム全体が活用できる形となります。

GitHub Copilotはテストケースを迅速に生成しますが、速度だけでは品質は保証されません。明確な所有権、要件のトレーサビリティ、スプリント横断的な可視性がない場合、よく書かれたテストでさえ陳腐化したり見落とされたりする可能性があります。そこで記録システムが重要になるのです。

ClickUpでテストケースを管理することで、チームはAI生成の出力を反復可能なQAワークフローに変換します。このワークフローはテストを要件、コード変更、リリースタイムラインに接続します。ツールの切り替えや手動更新に追われる代わりに、QAチームとエンジニアリングチームは共有されたコンテキストワークスペースで作業します。その結果、テスト数が増えるだけでなく、リリース内容とその根拠に対する確信も深まります。

スプリントやリリースと並行してテストケースを管理する準備はできていますか?今すぐClickUpで無料で始めましょう。

よくある質問

はい、Copilotはレガシーコードの構造とロジックを分析し、テストのベースラインを生成できます。ただし、これらのテストには大幅な手動レビューと改良が必要となるでしょう。AIは文書化されていない動作や過去のビジネスルールに関する文脈を持たないためです。

構文の正確性は非常に高いですが、論理的な正確性はコードの明瞭さとプロンプトの具体性に依存します。アサーションは常に確認し、単なる現状(おそらく欠陥のある)実装の確認ではなく、意味のあるビジネス要件を検証していることを保証してください。

はい、Copilotはpytest、unittest、その他の主要なPythonテストフレームワークを強力にサポートします。プロジェクト内の既存パターン(フィクスチャの使用やパラメータ化テストなど)を認識し再現する能力に優れています。

効果的なチームは、テストスイート管理に一元化されたプロジェクト管理プラットフォームを活用します。各テストケースをステータスや優先度といったカスタムメタデータ付きタスクとして追跡することで、カバレッジや実行結果の可視性を獲得。これによりQAプロセスをスプリント計画やバグ追跡に直接接続させます。