Die meisten Entwickler können die Gemini-API in weniger als 10 Minuten zum Laufen bringen.

Die eigentliche Herausforderung kommt nach dem Setup.

Dieser Leitfaden zeigt Ihnen, wie Sie Ihren API-Schlüssel erhalten, das SDK installieren und Ihre erste Anfrage stellen.

Außerdem erfahren Sie, wie Sie Ihre API-Workflows organisieren können, damit Ihr Team keine Zeit damit verschwendet, Lösungen neu zu erfinden oder nach Dokumentationen zu suchen.

Was ist die Gemini-API?

Die Gemini-API ist die Schnittstelle von Google für den Zugriff auf seine Familie multimodaler KI-Modelle, mit der Entwickler Textgenerierung, Bildverständnis, Code-Unterstützung und dialogorientierte KI in Anwendungen integrieren können.

Es wurde für Produktteams, Ingenieure und Unternehmen entwickelt, die ihre Produkte um leistungsstarke KI-Funktionen erweitern möchten, ohne große Sprachmodelle von Grund auf neu erstellen zu müssen.

Die großen Sprachmodelle von Gemini, wie Gemini 3 Flash und Gemini 3 Pro, sind multimodal, d. h. sie können mehrere Arten von Eingaben verarbeiten, darunter Text, Bilder, Audio und Video. Die API selbst verwendet die REST-API-Architektur , eine Standardmethode für die Kommunikation von Computersystemen über das Internet.

Um es noch einfacher zu machen, bietet Google Software Development Kits (SDKs) für gängige Sprachen wie Python, JavaScript und Go an. Es ist hilfreich, den Unterschied zwischen der API und Google KI Studio zu verstehen.

| Hauptverwendung | Produktionsanwendungen | Prototyping und Testen |

| Zugriffsmethode | Code-basierte SDK-Aufrufe | Webbasierte visuelle Benutzeroberfläche |

| Am besten geeignet für | Entwickler, die Apps erstellen | Experimentieren mit Eingabeaufforderungen |

💡Profi-Tipp: Bewahren Sie alle Projektkontexte an einem Ort auf und vermeiden Sie die Suche nach Informationen in verschiedenen Tools, indem Sie eine interne Wissensdatenbank für Ihre KI-Projekte erstellen. Mit ClickUp Docs können Sie Code-Schnipsel und API-Dokumentationen direkt mit den Aufgaben Ihres Teams verknüpfen, wodurch die Tool-Ausbreitung vermieden und die Einführung von KI beschleunigt wird.

So erhalten Sie Ihren Gemini-API-Schlüssel

Ihr Team ist vielleicht bereit mit der Entwicklung zu beginnen, aber zuerst benötigen Sie einen API-Schlüssel.

Um die Gemini-API nutzen zu können, benötigen Sie einen Schlüssel zur Authentifizierung Ihrer Anfragen. Die Verwaltung dieser Schlüssel ist der erste Schritt zu einem reibungsloseren Workflow-Management. Sie benötigen ein Google-Konto, um loszulegen.

So erhalten Sie Ihren Schlüssel:

- Navigieren Sie zu Google KI Studio

- Melden Sie sich mit Ihrem Google-Konto an.

- Klicken Sie in der linken Seitenleiste auf API-Schlüssel abrufen.

- Wählen Sie API-Schlüssel in einem neuen Projekt erstellen oder wählen Sie ein bestehendes Google Cloud-Projekt aus.

- Kopieren Sie Ihren generierten Schlüssel sofort und bewahren Sie ihn an einem sicheren Speicherort auf.

Ihr API-Schlüssel gewährt Ihnen Zugriff auf Ihr Gemini-Kontingent und Ihre Abrechnung – behandeln Sie ihn wie ein Passwort. 🔑

Ihr API-Schlüssel gewährt Ihnen Zugriff auf Ihr Gemini-Kontingent und Ihre Abrechnung – behandeln Sie ihn wie ein Passwort. 🔑

Für größere Teams können Sie Schlüssel auch über die Google Cloud Console verwalten, die erweiterte Kontrollfunktionen bietet.

So installieren Sie das Gemini SDK

Ein neuer Entwickler tritt Ihrem KI-Projekt bei, verbringt jedoch seinen ersten Tag damit, sich mit dem Setup der Umgebung herumzuschlagen, anstatt Code zu schreiben.

Ihre Python-Version ist falsch oder es fehlt eine Abhängigkeit, was zu dem klassischen Problem „Auf meinem Rechner funktioniert es“ führt.

Dies ist oft der Grund, warum Entwickler pro Woche drei Stunden Zeit verlieren. Solche Inkonsistenzen verlangsamen die Einarbeitung und führen zu unvorhersehbaren Fehlern, die wertvolle Entwicklungszeit verschwenden.

Ein SDK (Software Development Kit) vereinfacht diese API-Interaktionen, indem es die Authentifizierung, die Formatierung von Anfragen und die Analyse von Antworten für Sie übernimmt. Um Probleme beim Setup zu vermeiden, benötigt Ihr Team einen standardisierten, dokumentierten Prozess für die Installation des Gemini SDK.

Hier erfahren Sie, wie Sie es für die gängigsten Umgebungen installieren.

Für Python:

- Notiz: Sie benötigen Python 3. 9 oder neuer. Die Verwendung einer virtuellen Umgebung ist eine Best Practice, um Konflikte mit anderen Projekten zu vermeiden.

Für JavaScript/Node. js:

- Notiz: Dies ist für die Verwendung in einer Node.js-Umgebung vorgesehen.

Nach der Installation müssen Sie Ihren API-Schlüssel als Umgebungsvariable einrichten. So bleibt Ihr Schlüssel sicher und außerhalb Ihres Codes.

- Auf Mac/Linux: export GEMINI_API_KEY="Ihr-API-Schlüssel-hier"

- Unter Windows: setx GEMINI_API_KEY „Ihr-API-Schlüssel-hier”

Sie haben mehrere Optionen, welches SDK Sie verwenden möchten:

- Python SDK: Die beliebteste Wahl mit umfangreicher Dokumentation. Ideal für Data Science und Backend-Anwendungen.

- JavaScript SDK: Die beste Option für die Erstellung von Webanwendungen und Node.js-Backends.

- Go SDK: Eine gute Wahl für Entwickler, die leistungsstarke Microservices in Go erstellen.

- REST-API: Wenn Sie eine Sprache ohne offizielles SDK verwenden, können Sie jederzeit direkte HTTP-Anfragen an die REST-API stellen.

💡Profi-Tipp: Standardisieren Sie Ihre Entwicklungsumgebung und beschleunigen Sie die Einarbeitung, indem Sie eine Checkliste erstellen, die jedes neue Teammitglied befolgen kann. Speichern Sie diese als Vorlage in ClickUp Aufgaben, und wenn jemand auf Probleme stößt, kann er ClickUp Brain verwenden, um Antworten aus der Dokumentation Ihres Teams zu erhalten. Hier ist eine kurze Anleitung:

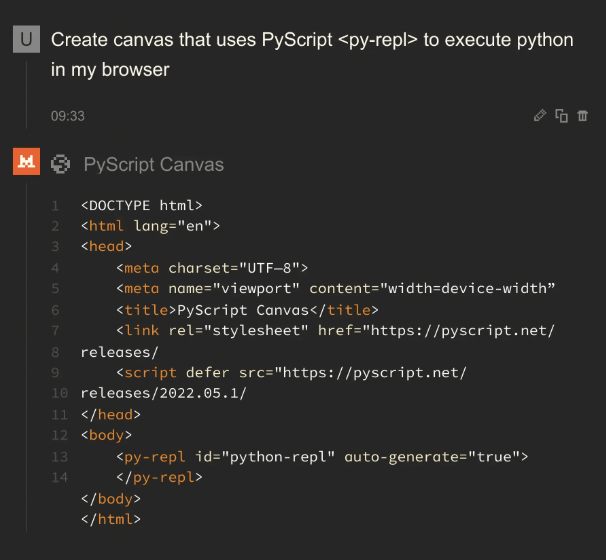

So erstellen Sie Ihre erste Gemini-API-Anfrage

Ihr Team führt endlich API-Aufrufe durch, aber jeder Entwickler muss sich selbst zurechtfinden.

Ein Erfolg beim API-Aufruf ist ganz einfach: Sie senden eine Eingabeaufforderung an ein Gemini-Modell und erhalten eine Antwort.

Die eigentliche Herausforderung besteht darin, diesen Prozess für Ihr gesamtes Team wiederholbar und skalierbar zu machen. Hier sind einige Beispiele, wie Sie Ihre erste Anfrage stellen können.

Python-Beispiel

Dieser Code sendet eine einfache Textanforderung an die Gemini-API und gibt die Antwort aus.

Schauen wir uns das genauer an:

- Importieren und konfigurieren: Hiermit wird die Google-Bibliothek geladen und die Authentifizierung mit dem zuvor konfigurierten API-Schlüssel eingerichtet.

- Modell initialisieren: Hier teilen Sie dem Code mit, welches spezifische Gemini-Modell verwendet werden soll. Gemini 3 Flash ist für schnelle Aufgaben mit hohem Volumen optimiert, während Gemini 3 Pro für tiefgreifende Schlussfolgerungen und komplexe, mehrstufige Workflows ausgelegt ist.

- Inhalte generieren: Dies ist die Aktion. Sie senden Ihre Frage an das Modell.

- Zugriff auf die Ausgabe: Die Antwort des Modells wird im Antwort-Objekt gespeichert, und Sie können mit response.text auf den Text zugreifen.

JavaScript-Beispiel

Wenn Sie in einer Node.js-Umgebung arbeiten, ist der Vorgang ähnlich, verwendet jedoch die async/await-Syntax von JavaScript.

Beispiel für eine REST-API

Wenn Sie Python oder JavaScript nicht verwenden, können Sie jederzeit mit einem Curl-Befehl direkt mit der API kommunizieren. Dies eignet sich hervorragend für schnelle Tests oder für die Verwendung in Sprachen ohne dediziertes SDK.

Dieser Befehl sendet eine HTTP-Anfrage an den API-Endpunkt und gibt die Antwort als JSON-Objekt zurück.

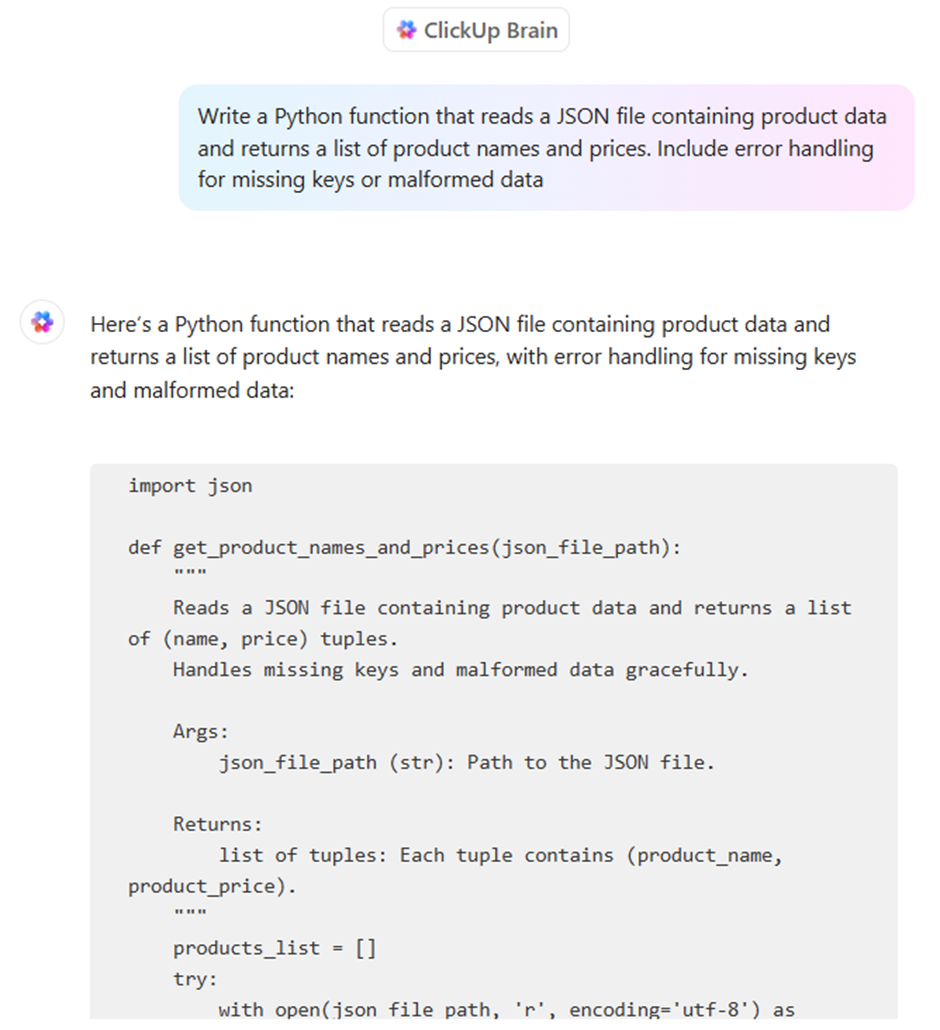

Erleichtern Sie Ihrem Team das Auffinden und Wiederverwenden erfolgreicher Code-Schnipsel und Prompts, indem Sie eine gemeinsame Bibliothek erstellen.

Was können Sie mit der Gemini-API erstellen?

Die Gemini-API ist unglaublich vielseitig. Hier sind einige Dinge, die Sie erstellen können:

- Tools zur Inhaltserstellung: Automatisieren Sie Blog-Entwürfe, Social-Media-Beiträge und Marketingtexte.

- Chatbots und virtuelle Assistenten: Erstellen Sie dialogorientierte Schnittstellen für den Kundensupport oder interne Helpdesks.

- Code-Unterstützung: Generieren Sie Code-Schnipsel, erklären Sie komplexe Funktionen und helfen Sie bei der Behebung von Fehlern.

- Hilfsmittel für die Datenanalyse: Fassen Sie umfangreiche Berichte zusammen und extrahieren Sie wichtige Erkenntnisse aus unstrukturierten Texten.

- Multimodale Anwendungen: Analysieren Sie Bilder oder verarbeiten Sie Video-Inhalte, um sie durchsuchbar zu machen.

- Dokumentenverarbeitung: Extrahieren Sie Informationen aus PDF-Dateien und übersetzen Sie Dokumente in verschiedene Sprachen.

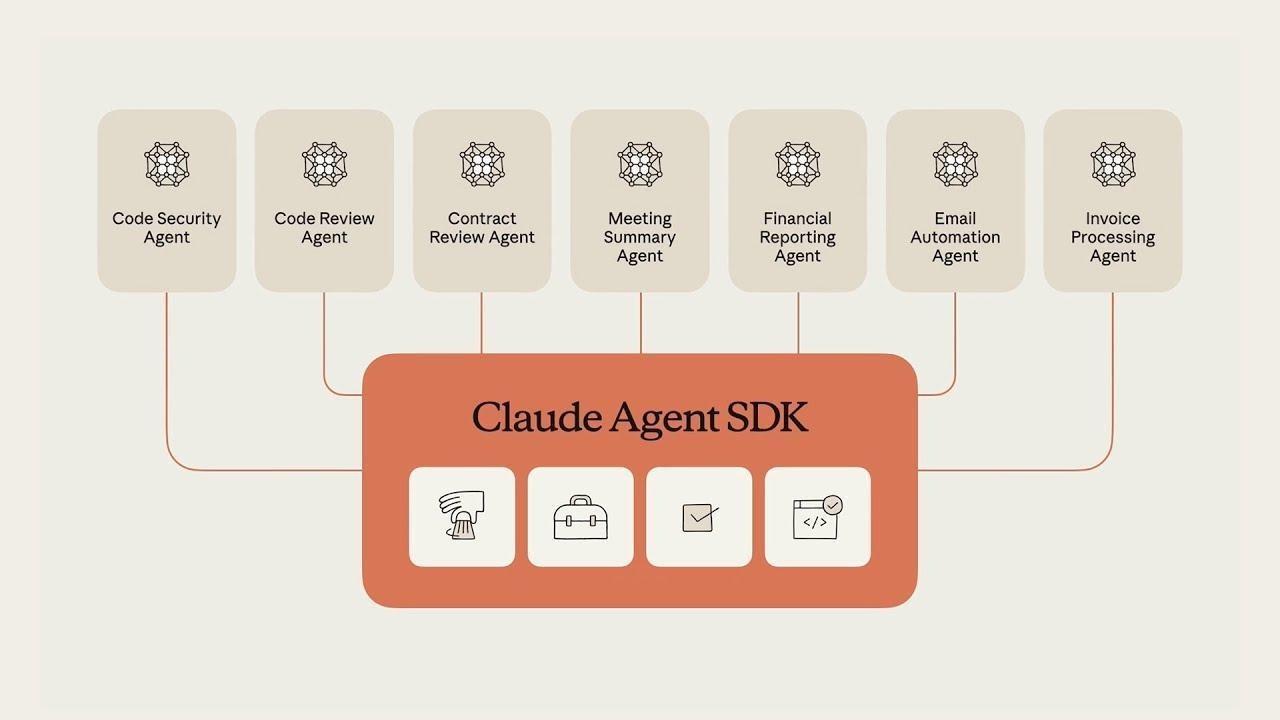

Agentische Workflows mit Gemini erstellen

Im Gegensatz zu einem Standard-Chatbot, der Fragen linear beantwortet, ermöglicht ein agenter Workflow in Gemini dem Modell, ein Ziel zu erkennen, einen Plan zu durchdenken und eine Reihe autonomer Aktionen über externe Tools hinweg auszuführen.

Dieser „agente” Wandel wird durch drei Kern-Features im Gemini 3-Ökosystem ermöglicht:

- Nativer „Denkmodus“: Mit dem Parameter „thinking_level“ können Sie nun zwischen „low“ für Geschwindigkeit und „high“ für komplexe Aufgaben umschalten. Im Modus „high-reasoning“ generiert Gemini 3 Pro versteckte „Gedankentoken“, um seine eigene Logik zu validieren, bevor es eine Antwort gibt, wodurch Halluzinationen drastisch reduziert werden.

- Thought Signatures: Um „Reasoning Drift” bei mehrstufigen Aufgaben zu verhindern, gibt die API nun verschlüsselte Thought Signaturen aus. Entwickler müssen diese Signaturen im Verlauf der Unterhaltung zurückgeben, um sicherzustellen, dass der Agent seinen genauen Gedankengang über verschiedene API-Aufrufe und Tool-Ausführungen hinweg beibehält.

- Model Context Protocol (MCP): Gemini verwendet jetzt das branchenübliche MCP, um eine Verbindung zu Tools herzustellen. Dadurch kann Ihr Agent sofort eine Verbindung zu Ihren bestehenden Datenbanken, Slack oder GitHub herstellen, ohne dass Sie für jede einzelne Funktion einen benutzerdefinierten Integrationscode schreiben müssen.

📮 ClickUp Insight: Teams mit geringer Leistung jonglieren viermal häufiger mit mehr als 15 Tools, während Teams mit hoher Leistung ihre Effizienz aufrechterhalten, indem sie ihr Toolkit auf neun oder weniger Plattformen beschränken.

Aber wie wäre es, wenn Sie dafür nur eine einzige Plattform verwenden würden?

ClickUp vereint Ihre Aufgaben, Projekte, Dokumente, Wikis, Chats und Anrufe auf einer einzigen Plattform, komplett mit KI-gestützten Workflows. Sind Sie bereit, smarter zu arbeiten? ClickUp eignet sich für jedes Team, macht die Arbeit sichtbar und ermöglicht es Ihnen, sich auf das Wesentliche zu konzentrieren, während die KI den Rest erledigt.

Python-Beispiel: Erstellen eines Forschungsagenten

Dieser Ausschnitt zeigt, wie man einen hochintelligenten Agenten initialisiert, der mithilfe des neuesten Gemini SDK einen beständigen „Gedankengang” aufrechterhält.

📖 Weiterlesen: So nutzen Sie einen Chatbot für Ihr Geschäft

So sichern Sie Ihren Gemini-API-Schlüssel

Ihr Team liefert Features aus, aber Ihre Praktiken zur Sicherheit sind nur eine Nebensache.

API-Schlüssel werden manchmal im Code hinterlassen – was zu den 23,7 Millionen Geheimnissen beiträgt, die 2024 an das öffentliche GitHub durchgesickert sind – und es gibt keinen formalen Prozess für deren Rotation. Dadurch ist Ihr Unternehmen anfällig für unbefugte Nutzung, was zu unerwarteten Rechnungen und schwerwiegenden Sicherheitsverletzungen führen kann.

Ein reaktiver Ansatz in Sachen Sicherheit ist ein Rezept für eine Katastrophe. Sie benötigen ein proaktives Wissensmanagementsystem für die Verwaltung von Anmeldedaten, um Ihre Anwendungen und die Daten Ihres Unternehmens zu schützen.

Hier sind die wichtigsten Best Practices für die Sicherheit Ihres Gemini-API-Schlüssels:

- Verwenden Sie Umgebungsvariablen: Speichern Sie Schlüssel niemals direkt in Ihrem Code. Speichern Sie sie in .env-Dateien oder Systemumgebungsvariablen.

- Fügen Sie. env zu Ihrer. gitignore hinzu: Dieser einfache Schritt verhindert, dass Sie versehentlich Ihre geheimen Schlüssel in einem öffentlichen Code-Repository committen.

- Schlüssel regelmäßig rotieren: Generieren Sie regelmäßig neue Schlüssel in der Google Cloud Console und deaktivieren Sie die alten.

- Implementieren Sie Zugriffskontrollen: Verwenden Sie die Identitäts- und Zugriffsverwaltung (IAM) von Google Cloud, um einzuschränken, wer in Ihrem Team API-Schlüssel anzeigen oder verwalten kann.

- Nutzung überwachen: Behalten Sie das API-Nutzungs-Dashboard in der Google Cloud Console im Auge, um ungewöhnliche Aktivitäten zu erkennen, die auf eine Kompromittierung hindeuten könnten.

- Verwenden Sie separate Schlüssel für verschiedene Umgebungen: Verwenden Sie unterschiedliche Schlüssel für Ihre Entwicklungs-, Staging- und Produktionsumgebungen, um die Auswirkungen einer möglichen Sicherheitslücke zu begrenzen.

Preise für Gemini

- Gemini 3 Flash: ~0,50 $ pro 1 Million Eingaben / 3,00 $ pro 1 Million Ausgaben

- Gemini 3 Pro: ~2,00 $ pro 1 Million Eingaben / 12,00 $ pro 1 Million Ausgaben (für Kontexte unter 200.000)

- Suchgrundlage: Beachten Sie, dass Google nun 14 US-Dollar pro 1.000 Abfragen für die Suchgrundlage berechnet, sobald Sie das monatliche kostenlose Kontingent (5.000 Abfragen) überschreiten.

Einschränkungen bei der Verwendung der Gemini-API

Ihre Anwendung ist live, aber Sie stoßen auf unerwartete Probleme.

Die API ist während der Spitzenzeiten langsamer als erwartet oder liefert inkonsistente Antworten, die die Benutzer verwirren.

Der erste Schritt besteht darin, die Limite der API zu verstehen. Die Dokumentation Ihrer Workarounds hilft Ihnen dabei, effektiv zu skalieren.

Beachten Sie diese häufigen Einschränkungen:

- Ratenlimits: Die kostenlose Stufe hat Limite für Anfragen pro Minute und Token pro Tag, was bei Anwendungen mit hohem Volumen zu Engpässen führen kann.

- Latenzschwankungen: Die Antwortzeiten können je nach Komplexität Ihrer Eingabe und der Gesamtbelastung des Servers schwanken.

- Einschränkungen des Kontextfensters: Jedes Modell hat eine maximale Anzahl von Tokens (Wörter und Wortteile), die es in einer einzigen Anfrage verarbeiten kann, was bei der Zusammenfassung sehr langer Dokumente eine Herausforderung darstellen kann.

- Regionale Verfügbarkeit: Einige Modelle oder Features sind möglicherweise nicht in allen geografischen Regionen verfügbar.

- Konsistenz der Ergebnisse: Generative KI kann selbst bei identischen Eingaben leicht unterschiedliche Ergebnisse liefern, sodass Sie möglicherweise Validierungsschritte in Ihren Workflow einbauen müssen.

- Keine Echtzeitdaten: Das Wissen der Modelle wird nicht in Echtzeit aktualisiert, sodass sie keine Informationen zu aktuellen Ereignissen liefern können.

Die Gemini-API ist zwar ein multimodales Kraftpaket, doch für die Erstellung einer produktionsreifen Anwendung ist oft eine Multi-Modell-Strategie erforderlich. Je nach den spezifischen Anforderungen Ihres Projekts hinsichtlich der Tiefe der Argumentation oder der Genauigkeit des Codes können Sie sich diese Gemini-Alternativen ansehen.

Die meisten KI-Tools versprechen, die Entwicklung zu vereinfachen, aber oft enden sie nur als weitere unverbundene Registerkarten in einem bereits überfüllten Stack. Möglicherweise verwenden Sie die Gemini-API für das Backend Ihrer App, ein separates Tool zum Zusammenfassen von Notizen aus Meetings und eine dritte Plattform zum Verwalten Ihrer Sprint-Aufgaben. Dieses Netz aus verstreuten Kontexten und isolierten Tools ist „KI-Ausbreitung”.

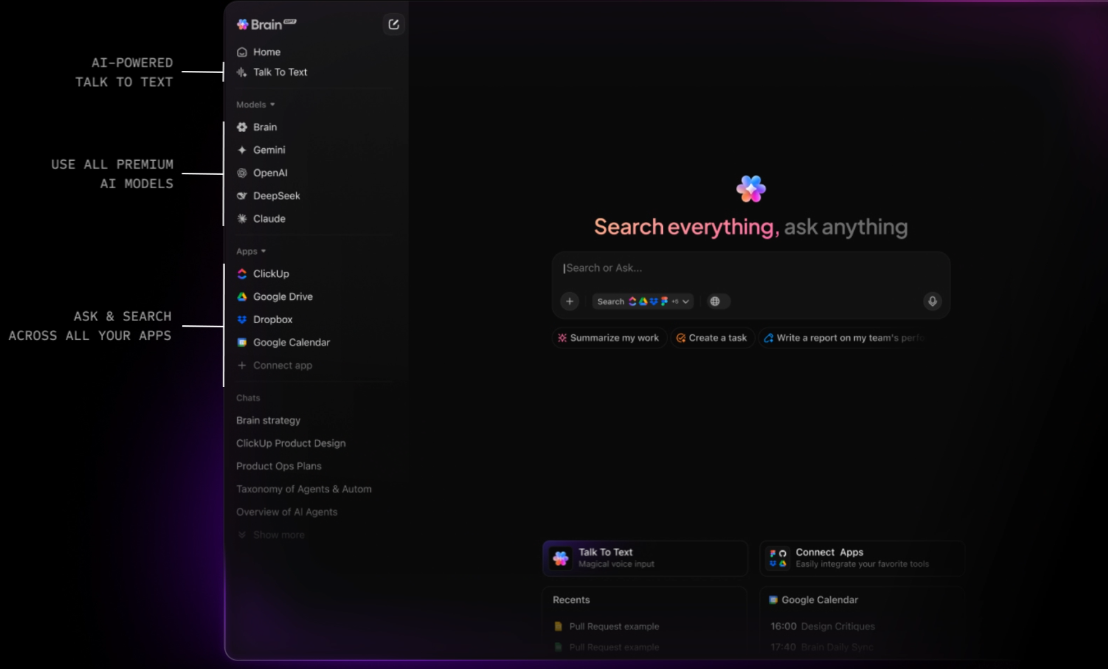

ClickUp ist der erste konvergierte KI-Workspace, der Ihre Aufgaben, Dokumente und Mitarbeiter mit einer zentralen Intelligenzschicht verbindet. Im Gegensatz zu eigenständigen APIs, bei denen Sie Ihre eigenen Kontextabrufsysteme (RAG) erstellen müssen, „weiß“ ClickUp Brain bereits alles über Ihren Workspace.

Da die KI nativ integriert ist, „generiert“ sie nicht nur Text, sondern versteht auch die Beziehungen zwischen Ihrer Gemini-API-Dokumentation, Ihren Projektfristen und dem Echtzeit-Fortschritt Ihres Teams.

Aktivieren Sie „Ask KI” von überall aus und setzen Sie autonome Agenten ein.

Die wahre Stärke von ClickUp liegt in seiner Fähigkeit, Wissen in Handeln umzusetzen. Mit dem Brain Assistant können Sie von überall in Ihrem Workspace aus „KI fragen“ – oder sogar über einen Desktop-Begleiter, während Sie Code in Ihrer IDE schreiben. Sie können Projektrisiken sofort aufdecken, indem Sie fragen: „Wie war das Feedback zur letzten Gemini 3 Pro-Implementierung?“ ClickUp Brain durchsucht Ihren gesamten Verlauf und liefert eine zitierte Antwort mit Links zu der genauen Aufgabe oder dem Kommentar-Thread, in dem die Diskussion stattgefunden hat.

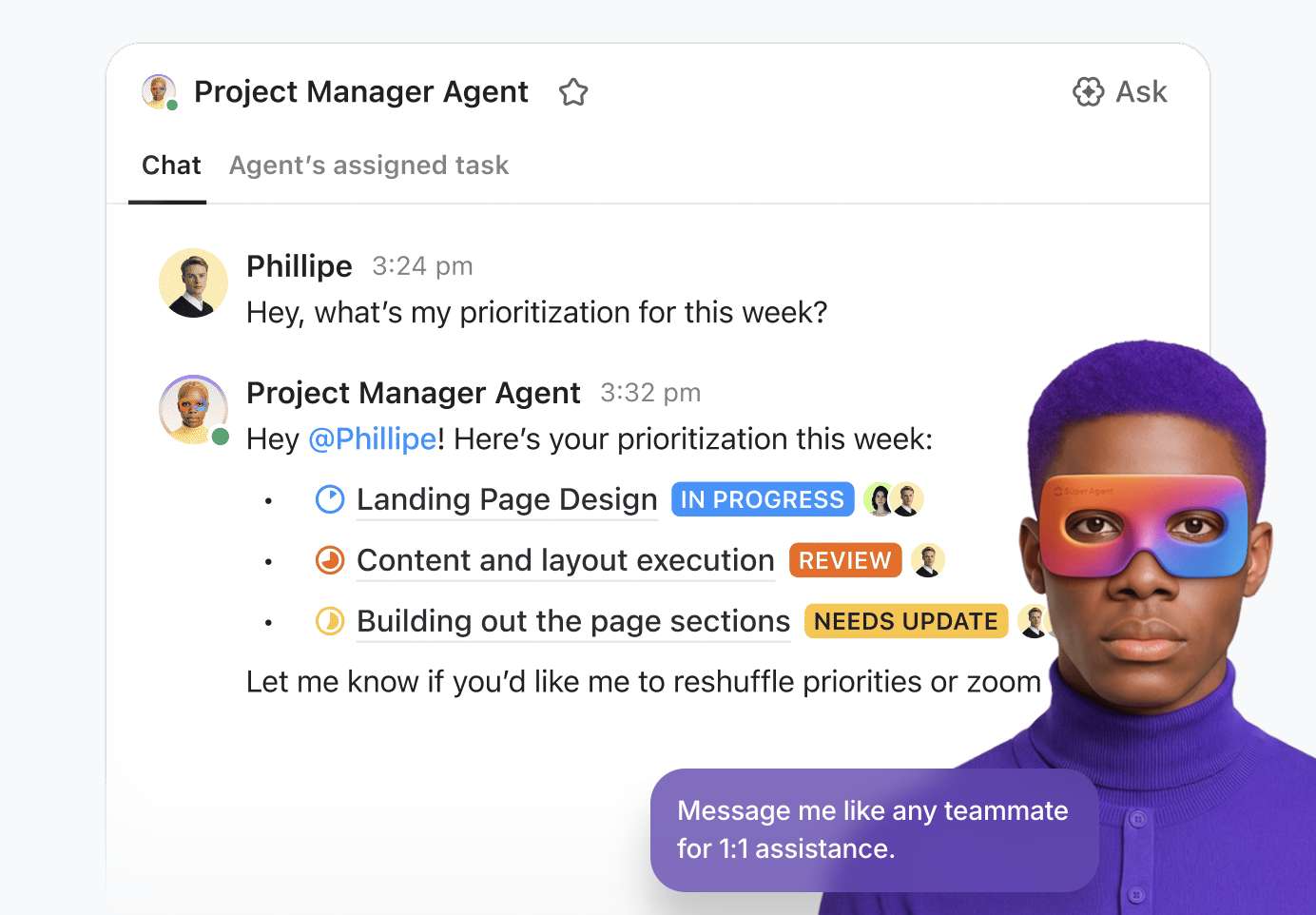

Für Teams, die komplexe KI-Produkte entwickeln, geht ClickUp über einfache Unterstützung hinaus, indem es Ihnen die Bereitstellung von Super Agents ermöglicht. Dabei handelt es sich um autonome digitale Teammitglieder ohne Programmieraufwand, die die „Routinearbeiten” Ihres Entwicklungszyklus übernehmen. Sie können einen Triage-Agenten einrichten, um eingehende Fehler aus Ihrer Gemini-Integration zu überwachen, oder einen Projektmanager-Agenten, der proaktiv Sprint-Blockaden identifiziert und tägliche StandUp-Zusammenfassungen basierend auf den Aktivitäten Ihres Teams erstellt. Es handelt sich um ein intelligentes System, das Ihre Entwicklungspipeline rund um die Uhr am Laufen hält.

Eine einheitliche Plattform für das Arbeitsmanagement für den modernen Entwickler

ClickUp Docs dient als gemeinsames technisches Notizbuch Ihres Teams. Ganz gleich, ob Sie ein PRD für ein neues multimodales Feature entwerfen oder Ihre Gemini-API-Sicherheitsprotokolle speichern – alles bleibt miteinander verbunden.

Eine Codezeile in einem Dokument kann sofort zu einer Aufgabe werden, und mit ClickUp Brain können Sie Enterprise Search nutzen, um Dateien und Unterhaltungen aus verbundenen Apps wie Google Workspace, GitHub und Figma mithilfe der semantischen Suche abzurufen.

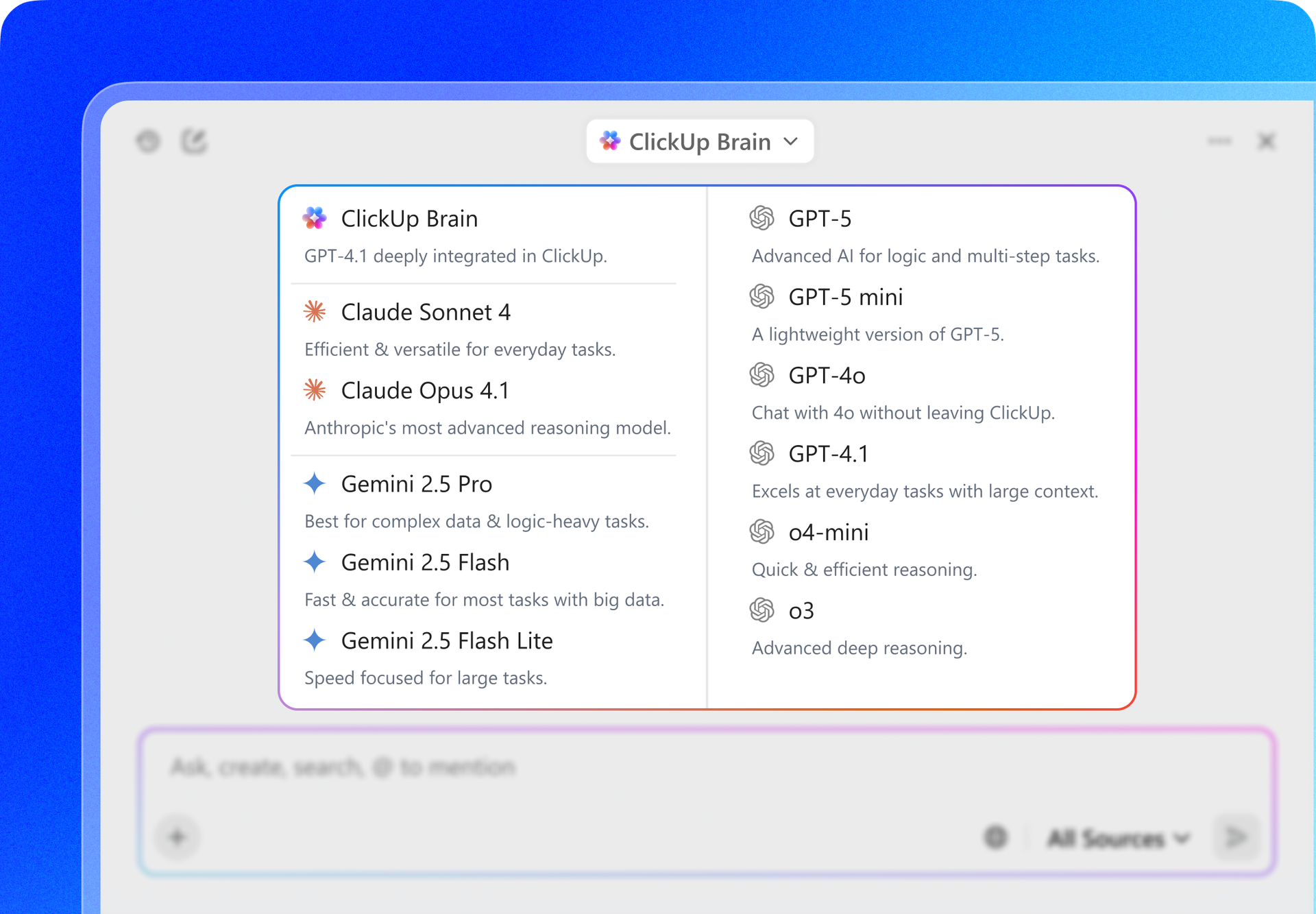

Darüber hinaus bietet ClickUp Multi-Modell-Flexibilität. Während Sie mit der Gemini-API arbeiten, können Sie über die Benutzeroberfläche von ClickUp zwischen Gemini 3, GPT-5. 2 und Claude 4. 5 umschalten, um Ergebnisse zu vergleichen oder technische Spezifikationen zu entwerfen. So haben Sie immer das beste „Gehirn” für die jeweilige Aufgabe zur Verfügung, ohne jemals Ihre Projektmanagement-Umgebung verlassen zu müssen.

Die besten Features von ClickUp

Limitierungen von ClickUp

Preise für ClickUp

Bewertungen und Rezensionen zu ClickUp

Was sagen echte Benutzer über ClickUp?

Eine Bewertung eines Benutzers lautet:

Die Vorlagen, benutzerdefinierten Felder, Prioritäten, Scrum-Punkte, Pläne und verschiedenen Ansichtsoptionen von ClickUp haben es unserem Team trotz einer leichten Lernkurve ermöglicht, das Tool an unsere sich entwickelnden Bedürfnisse anzupassen und die Effizienz zu maximieren. Die leistungsstarken Integrationen mit Tools wie Google Drive, Meetings, Kalendern und die robuste API-Unterstützung verbessern unseren Workflow nahtlos. Darüber hinaus bieten die ClickUp-Formulare einen erheblichen Mehrwert für unsere Abläufe. Insgesamt ist alles in ClickUp so leistungsstark und nützlich, dass ich nichts daran ändern möchte. Ich bin fest davon überzeugt, dass ClickUp unter Berücksichtigung der Benutzerpräferenzen entwickelt wurde und somit perfekt auf unsere Bedürfnisse zugeschnitten ist.

Der Vorteil von ClickUp: Anstatt Code zu schreiben, um Ihre Datenbank mit einem LLM zu verbinden, fungiert BrainGPT, eine eigenständige KI-Super-App von ClickUp, als modellunabhängige Schnittstelle, die bereits mit Ihren Aufgaben, Dokumenten und Code-Repos verbunden ist.

Damit können Sie:

Die API-Plattform von OpenAI bleibt der Hauptkonkurrent für Entwickler, die komplexe, „denkende” Anwendungen erstellen. Mit der Veröffentlichung der GPT-5. 2-Serie hat sich OpenAI in Richtung „Agentic Reasoning” bewegt, bei dem das Modell automatisch pausiert, um seine Logik zu validieren, bevor es antwortet.

Im Gegensatz zur engen Integration von Gemini in Google Workspace bietet OpenAI einen modulareren „Foundry”-Ansatz, was es zur bevorzugten Wahl für Entwickler macht, die eine herstellerneutrale Plattform suchen, die sich über verschiedene Cloud-Anbieter wie Azure und AWS hinweg skalieren lässt.

Gemini 3 Flash bietet dagegen eine deutlich schnellere Verarbeitung von Videos und ein viel größeres Kontextfenster mit 2 Millionen Tokens, während GPT-5. 2 seinen nativen Kontext derzeit auf 400.000 Tokens begrenzt.

Die besten Features der OpenAI-API

Limitierungen der OpenAI-API

Preise für die OpenAI-API

Bewertungen und Rezensionen zur OpenAI-API

Was sagen echte Benutzer über OpenAI?

Eine Bewertung eines Benutzers lautet:

Wir sind sehr beeindruckt von den KI-Modellen und insbesondere vom API-Zugriff. Durch die Integration von OpenAI in unsere CRM-Lösungen (BROSH CRM) können wir unseren Kunden durch KI-gestützte Automatisierung einen echten, greifbaren Wert bieten. OpenAI ermöglicht es BROSH CRM, fortschrittliche KI-basierte Funktionen in mehreren Bereichen anzubieten. Unsere Kunden profitieren von hochwertigen, kontextbezogenen KI-Antworten in ihren Kommunikationskanälen, die direkt aus CRM-Daten generiert werden. Dies verbessert die Kundeninteraktionen erheblich und spart gleichzeitig Zeit und Ressourcen.

📖 Weiterlesen: So verwenden Sie die ChatGPT-API für Ihre Anwendungen

Claude, entwickelt von Anthropic, ist die erste Wahl für Entwickler, die Wert auf technische Genauigkeit und „menschenähnliches” Denken legen. Claude 4. 5 Sonnet gilt weithin als das zuverlässigste Modell für die Softwareentwicklung und übertrifft andere Modelle bei Coding-Benchmarks wie SWE-bench regelmäßig.

Eine der herausragenden Features ist Claude Code, ein agentenbasiertes CLI-Tool, mit dem das Modell direkt mit Ihrem lokalen Terminal und Dateisystem interagieren kann, um Code zu debuggen und zu versenden.

Gemini 3 Pro eignet sich hervorragend für die Verarbeitung großer Datenmengen auf einmal (z. B. ein einstündiges Video), aber Claude wird oft für Aufgaben bevorzugt, bei denen die „Stimmung” und Präzision der Ausgabe wichtiger sind als die reine Menge der verarbeiteten Daten.

Die besten Features der Claude-API

Limitierungen der Claude-API

Preise für die Claude-API

Bewertungen und Rezensionen zur Claude-API

Was sagen echte Benutzer über die Claude-API?

Eine Bewertung eines Benutzers lautet:

Die API-Nutzungsgebühr ist teurer als bei ChatGPT oder Gemini, aber wenn Sie nur Fragen stellen möchten, können Sie einfach die Desktop-Version verwenden, sodass dies kein großes Problem darstellt. Wenn Sie die API jedoch in eine App integrieren möchten, ist dies nicht die beste Option.

📖 Weiterlesen: Wie Sie Claude KI für effizientes und präzises Codieren nutzen können

Mistral AI bietet leistungsstarke Modelle, die eine Alternative zu den „geschlossenen” Systemen von Google und OpenAI darstellen. Es gilt als führend für Unternehmen, die Datenhoheit benötigen oder Modelle auf ihrer eigenen privaten Infrastruktur einsetzen möchten.

Die Flaggschiff-Modelle von Mistral, wie Mistral Large 3, sind auf Effizienz und „Ungefiltertsein” ausgelegt und geben Entwicklern mehr Kontrolle über das Verhalten des Modells als die strengeren Sicherheitsvorkehrungen, die oft bei Gemini oder Claude zu finden sind.

Die besten Features von Mistral KI

Einschränkungen von Mistral KI

Preise für Mistral KI

Bewertungen und Rezensionen zu Mistral KI

Was sagen echte Benutzer über Mistral KI?

Ich habe nach einer Persönlichkeit aus der Geschichte unseres Landes gefragt. GEMINI hat korrekt zwischen zwei sehr unterschiedlichen Personen mit demselben Vor- und Nachnamen unterschieden: Der eine war Historiker und Universitätsprofessor, der andere ein Widerstandskämpfer, der während des Zweiten Weltkriegs deportiert wurde. Mistral /AI hat mir nur die Beschreibung des ersten gegeben.

Alternative KI-Tools

Die Gemini-API ist zwar ein multimodales Kraftpaket, doch für die Erstellung einer produktionsreifen Anwendung ist oft eine Multi-Modell-Strategie erforderlich. Je nach den spezifischen Anforderungen Ihres Projekts hinsichtlich der Tiefe der Argumentation oder der Genauigkeit des Codes können Sie sich diese Gemini-Alternativen ansehen.

1. ClickUp (Am besten geeignet für Teams, die eine kontextbezogene KI benötigen, die in ihren Workflow integriert ist)

Die meisten KI-Tools versprechen, die Entwicklung zu vereinfachen, aber oft enden sie nur als weitere unverbundene Registerkarten in einem bereits überfüllten Stack. Möglicherweise verwenden Sie die Gemini-API für das Backend Ihrer App, ein separates Tool zum Zusammenfassen von Meeting-Notizen und eine dritte Plattform zum Verwalten Ihrer Sprint-Aufgaben. Dieses Netz aus verstreuten Kontexten und isolierten Tools ist „KI-Ausbreitung”.

ClickUp ist der erste konvergierte KI-Workspace, der Ihre Aufgaben, Dokumente und Mitarbeiter mit einer zentralen Intelligenzschicht verbindet. Im Gegensatz zu eigenständigen APIs, bei denen Sie Ihre eigenen Kontextabrufsysteme (RAG) erstellen müssen, „weiß“ ClickUp Brain bereits alles über Ihren Workspace.

Da die KI nativ integriert ist, „generiert“ sie nicht nur Text, sondern versteht auch die Beziehungen zwischen Ihrer Gemini-API-Dokumentation, Ihren Projektfristen und dem Echtzeit-Fortschritt Ihres Teams.

Aktivieren Sie „Ask KI” von überall aus und setzen Sie autonome Agenten ein.

Die wahre Stärke von ClickUp liegt in seiner Fähigkeit, Wissen in Handeln umzusetzen. Mit dem Brain Assistant können Sie von überall in Ihrem Workspace aus „KI fragen“ – oder sogar über einen Desktop-Begleiter, während Sie Code in Ihrer IDE schreiben. Sie können Projektrisiken sofort aufdecken, indem Sie fragen: „Wie war das Feedback zur letzten Gemini 3 Pro-Implementierung?“ ClickUp Brain durchsucht Ihren gesamten Verlauf und liefert eine zitierte Antwort mit Links zu der genauen Aufgabe oder dem Kommentar-Thread, in dem die Diskussion stattgefunden hat.

Für Teams, die komplexe KI-Produkte entwickeln, geht ClickUp über einfache Unterstützung hinaus, indem es Ihnen die Bereitstellung von Super Agents ermöglicht. Dabei handelt es sich um autonome digitale Teamkollegen ohne Programmieraufwand, die die „Routinearbeiten” Ihres Entwicklungszyklus übernehmen. Sie können einen Triage-Agenten einrichten, um eingehende Fehler aus Ihrer Gemini-Integration zu überwachen, oder einen Projektmanager-Agenten, der proaktiv Sprint-Blockaden identifiziert und tägliche StandUp-Zusammenfassungen basierend auf den Aktivitäten Ihrer Teams erstellt. Es handelt sich um ein intelligentes System, das Ihre Entwicklungspipeline rund um die Uhr am Laufen hält.

Eine einheitliche Plattform für das Arbeitsmanagement für den modernen Entwickler

ClickUp Docs dient als gemeinsames technisches Notizbuch Ihres Teams. Ganz gleich, ob Sie ein PRD für ein neues multimodales Feature entwerfen oder Ihre Gemini-API-Protokolle zur Sicherheit speichern – alles bleibt miteinander verbunden.

Eine Codezeile in einem Dokument kann sofort zu einer Aufgabe werden, und mit ClickUp Brain können Sie Enterprise Search nutzen, um Dateien und Unterhaltungen aus verbundenen Apps wie Google Workspace, GitHub und Figma mithilfe der semantischen Suche abzurufen.

Darüber hinaus bietet ClickUp Multi-Modell-Flexibilität. Während Sie mit der Gemini-API arbeiten, können Sie über die Benutzeroberfläche von ClickUp zwischen Gemini 3, GPT-5. 2 und Claude 4. 5 umschalten, um Ergebnisse zu vergleichen oder technische Spezifikationen zu entwerfen. So haben Sie immer das beste „Gehirn” für die jeweilige Aufgabe zur Verfügung, ohne jemals Ihre Umgebung des Projektmanagements verlassen zu müssen.

Die besten Features von ClickUp

- Universal Search & Ask AI: Rufen Sie Daten aus ClickUp, Slack, GitHub und Drive sofort ab oder bitten Sie die KI, Dokumente oder Aufgaben-Threads aus dem gesamten Workspace zusammenzufassen.

- No-Code-Agenten: Setzen Sie No-Code-Agenten ein, um die Erstellung von Aufgaben, Aktualisierungen des Status und die Berichterstellung zu automatisieren und so das manuelle Projektmanagement in einen autonomen Workflow zu verwandeln.

- Integrierter KI-Chat: Erwähnen Sie @Brain in einem beliebigen ClickUp-Chat-Thread, um eine Unterhaltung sofort in eine formatierte Aufgabe umzuwandeln oder eine Zusammenfassung einer langen Diskussion zu erhalten.

- KI-gestützte Dashboards: Visualisieren Sie den Zustand Ihres Teams mit Echtzeit-Dashboards, die mithilfe von KI Sprint-Risiken identifizieren, Verzögerungen vorhersagen und Datentrends in einfacher Sprache erklären.

- KI-Writer für Dokumente: Erstellen Sie Entwürfe für technische Anforderungen, SOPs und Tagesordnungen für Meetings, die bereits mit den spezifischen Daten und dem Kontext Ihres Projekts vorbelegt sind.

Limitierungen von ClickUp

- Die Effektivität der KI hängt von der Ordnung in Ihrem Workspace ab. Wenn Ihr Team Aufgaben und Dokumente nicht auf dem neuesten Stand hält, hat die KI weniger „Kontext“, aus dem sie ihre Antworten beziehen kann.

Preise für ClickUp

Bewertungen und Rezensionen zu ClickUp

- G2: 4,7/5 (über 10.900 Bewertungen)

- Capterra: 4,6/5 (über 4.500 Bewertungen)

Was sagen echte Benutzer über ClickUp?

Eine Bewertung eines Benutzers lautet:

Die Vorlagen, benutzerdefinierten Felder, Prioritäten, Scrum-Punkte, Pläne und verschiedenen Ansichtsoptionen von ClickUp haben es unserem Team trotz einer leichten Lernkurve ermöglicht, das Tool an unsere sich entwickelnden Bedürfnisse anzupassen und die Effizienz zu maximieren. Die leistungsstarken Integrationen mit Tools wie Google Drive, Meetings, Kalendern und die robuste API-Unterstützung verbessern unseren Workflow nahtlos. Darüber hinaus bieten die ClickUp-Formulare einen erheblichen Mehrwert für unsere Abläufe. Insgesamt ist alles in ClickUp so leistungsstark und nützlich, dass ich nichts daran ändern möchte. Ich bin fest davon überzeugt, dass ClickUp unter Berücksichtigung der Benutzerpräferenzen entwickelt wurde und somit perfekt auf unsere Bedürfnisse zugeschnitten ist.

Die Vorlagen, benutzerdefinierten Felder, Prioritäten, Scrum-Punkte, Pläne und verschiedenen Ansichtsoptionen von ClickUp haben es unserem Team trotz einer leichten Lernkurve ermöglicht, das Tool an unsere sich entwickelnden Bedürfnisse anzupassen und die Effizienz zu maximieren. Die leistungsstarken Integrationen mit Tools wie Google Drive, Meetings, Kalendern und die robuste API-Unterstützung verbessern unseren Workflow nahtlos. Darüber hinaus bieten die ClickUp-Formulare einen erheblichen Mehrwert für unsere Abläufe. Insgesamt ist alles in ClickUp so leistungsstark und nützlich, dass ich nichts daran ändern möchte. Ich bin fest davon überzeugt, dass ClickUp unter Berücksichtigung der Benutzerpräferenzen entwickelt wurde und somit perfekt auf unsere Bedürfnisse zugeschnitten ist.

Der Vorteil von ClickUp: Anstatt Code zu schreiben, um Ihre Datenbank mit einem LLM zu verbinden, fungiert BrainGPT, eine eigenständige KI-Super-App von ClickUp, als modellunabhängige Schnittstelle, die bereits mit Ihren Aufgaben, Dokumenten und Code-Repos verbunden ist.

Damit können Sie:

- Umschalten zwischen Modellen: Verwenden Sie Gemini 3 für umfangreiche Aufgaben mit 2 Millionen Token und wechseln Sie dann zu Claude 4. 5 für präzises Codieren – alles im selben Fenster.

- Einheitliche Suche: Fragen Sie: „Was waren die endgültigen Spezifikationen für die Sicherheit der API, die im Meeting letzten Monats besprochen wurden?“ und erhalten Sie eine fundierte Antwort, die gleichzeitig aus Slack, GitHub und ClickUp-Dokumenten stammt.

- Talk-to-Text: Verwenden Sie die BrainGPT-Desktop-App, um Befehle wie „Entwerfen Sie ein Jira-Ticket für die Gemini-Integration und weisen Sie es dem leitenden Entwickler zu” zu diktieren – ganz ohne Tastatur.

2. OpenAI-API (am besten geeignet für allgemeine Intelligenz und agentenbasiertes Denken)

Die API-Plattform von OpenAI bleibt der wichtigste Konkurrent für Entwickler, die komplexe, „denkende” Anwendungen erstellen. Mit der Veröffentlichung der GPT-5. 2-Serie hat sich OpenAI in Richtung „Agentic Reasoning” bewegt, bei dem das Modell automatisch pausiert, um seine Logik zu validieren, bevor es antwortet.

Im Gegensatz zur engen Integration von Gemini in Google Workspace bietet OpenAI einen modulareren „Foundry”-Ansatz, was es zur bevorzugten Wahl für Entwickler macht, die eine herstellerneutrale Plattform suchen, die sich über verschiedene Cloud-Anbieter wie Azure und AWS hinweg skalieren lässt.

Gemini 3 Flash bietet dagegen eine deutlich schnellere Verarbeitung von Videos und ein viel größeres Kontextfenster mit 2 Millionen Tokens, während GPT-5. 2 seinen nativen Kontext derzeit auf 400.000 Tokens begrenzt.

Die besten Features der OpenAI-API

- Verwenden Sie den Denkmodus, um komplexe, mehrstufige Probleme zu lösen, die eine interne Überprüfung erfordern, bevor eine endgültige Antwort generiert wird.

- Greifen Sie auf die Echtzeit-API zu, um multimodale Erlebnisse mit geringer Latenz zu erstellen, einschließlich nativer Sprach-zu-Sprach-Interaktionen.

- Nutzen Sie die Dateisuch-API (Vector Store), um RAG-Systeme (Retrieval-Augmented Generation) mit integrierter Dokumentenverwaltung zu erstellen.

Limitierungen der OpenAI-API

- Die Nutzung kann sehr schnell teuer werden, wenn sie nicht sorgfältig überwacht wird, insbesondere bei der Verwendung von Modellen mit hoher Rechenleistung wie GPT-5. 2 Pro

Preise für die OpenAI-API

- GPT-5. 2: 1,75 $/1 Mio. Eingabe | 14,00 $/1 Mio. Ausgabe

- GPT-5. 2 Pro: 21,00 $/1 Mio. Eingaben | 168,00 $/1 Mio. Ausgaben

- GPT-5 Mini: 0,25 $/1 Mio. Eingaben | 2,00 $/1 Mio. Ausgaben

Bewertungen und Rezensionen zur OpenAI-API

- G2: 4,7/5 (über 840 Bewertungen)

- Gartner Peer Insights: 4,4/5 (über 60 Bewertungen)

Was sagen echte Benutzer über OpenAI?

Eine Bewertung eines Benutzers lautet:

Wir sind äußerst beeindruckt von den KI-Modellen und insbesondere vom API-Zugriff. Durch die Integration von OpenAI in unsere CRM-Lösungen (BROSH CRM) können wir unseren Kunden durch KI-gestützte Automatisierung einen echten, greifbaren Wert bieten. OpenAI ermöglicht es BROSH CRM, fortschrittliche KI-basierte Funktionen in mehreren Bereichen anzubieten. Unsere Kunden profitieren von hochwertigen, kontextbezogenen KI-Antworten in ihren Kommunikationskanälen, die direkt aus CRM-Daten generiert werden. Dies verbessert die Kundeninteraktionen erheblich und spart gleichzeitig Zeit und Ressourcen.

Wir sind äußerst beeindruckt von den KI-Modellen und insbesondere vom API-Zugriff. Durch die Integration von OpenAI in unsere CRM-Lösungen (BROSH CRM) können wir unseren Kunden durch KI-gestützte Automatisierung einen echten, greifbaren Wert bieten. OpenAI ermöglicht es BROSH CRM, fortschrittliche KI-basierte Funktionen in mehreren Bereichen anzubieten. Unsere Kunden profitieren von hochwertigen, kontextbezogenen KI-Antworten in ihren Kommunikationskanälen, die direkt aus CRM-Daten generiert werden. Dies verbessert die Kundeninteraktion erheblich und spart gleichzeitig Zeit und Ressourcen.

📖 Weiterlesen: So verwenden Sie die ChatGPT-API für Ihre Anwendungen

3. Claude API (am besten geeignet für anspruchsvolle Programmieraufgaben und nuancierte technische Texte)

Claude, entwickelt von Anthropic, ist die erste Wahl für Entwickler, die Wert auf technische Genauigkeit und „menschenähnliches” Denken legen. Claude 4. 5 Sonnet gilt weithin als das zuverlässigste Modell für die Softwareentwicklung und übertrifft andere Modelle bei Coding-Benchmarks wie SWE-bench regelmäßig.

Ein herausragendes Feature ist Claude Code, ein agentenbasiertes CLI-tool, mit dem das Modell direkt mit Ihrem lokalen Terminal und Dateisystem interagieren kann, um Code zu debuggen und zu versenden.

Gemini 3 Pro eignet sich hervorragend für die Verarbeitung großer Datenmengen auf einmal (z. B. ein einstündiges Video), aber Claude wird oft für Aufgaben bevorzugt, bei denen die „Stimmung” und Präzision der Ausgabe wichtiger sind als die reine Menge der verarbeiteten Daten.

Die besten Features der Claude-API

- Verwalten Sie komplexe Projektlogik mit Claude Projects, mit dem Sie verwandte Dokumente und Codes gruppieren können, um einen besseren Kontext zu erhalten.

- Verwenden Sie Prompt Caching, um die Kosten und Latenz für sich wiederholende Anfragen mit hohem Volumen erheblich zu reduzieren.

- Führen Sie Code in Echtzeit innerhalb der Modellumgebung mit dem Analyse-Tool (Codeausführung) aus und testen Sie ihn.

Limitierungen der Claude-API

- Claude verfügt derzeit nicht über native tools zur Bild- oder Video-Generierung, sodass Entwickler für visuelle kreative Arbeiten APIs von Drittanbietern integrieren müssen.

Preise für die Claude-API

- Claude 4. 5 Opus: 15,00 $/1 Mio. Eingaben | 75,00 $/1 Mio. Ausgaben

- Claude 4. 5 Sonnet: 3,00 $/1 Mio. Eingabe | 15,00 $/1 Mio. Ausgabe

- Claude 4. 5 Haiku: 1,00 $/1 Mio. Eingaben | 5,00 $/1 Mio. Ausgaben

Bewertungen und Rezensionen zur Claude-API

- G2: 4,4/5 (über 55 Bewertungen)

- Capterra: 4,6/5 (über 20 Bewertungen)

Was sagen echte Benutzer über die Claude-API?

Eine Bewertung eines Benutzers lautet:

Die API-Nutzungsgebühr ist teurer als bei ChatGPT oder Gemini, aber wenn Sie nur Fragen stellen möchten, können Sie einfach die Desktop-Version verwenden, sodass dies kein großes Problem darstellt. Wenn Sie die API jedoch in eine App integrieren möchten, ist dies nicht die beste Option.

Die API-Nutzungsgebühr ist teurer als bei ChatGPT oder Gemini, aber wenn Sie nur Fragen stellen möchten, können Sie einfach die Desktop-Version verwenden, sodass dies kein großes Problem darstellt. Wenn Sie die API jedoch in eine App integrieren möchten, ist dies nicht die beste Option.

4. Mistral KI (Am besten geeignet für offene Flexibilität und Datenhoheit)

Mistral AI bietet leistungsstarke Modelle, die eine Alternative zu den „geschlossenen” Systemen von Google und OpenAI darstellen. Es gilt als führend für Unternehmen, die Datenhoheit benötigen oder Modelle auf ihrer eigenen privaten Infrastruktur einsetzen möchten.

Die Flaggschiff-Modelle von Mistral, wie Mistral Large 3, sind auf Effizienz und „Ungefiltertsein” ausgelegt und geben Entwicklern mehr Kontrolle über das Verhalten des Modells als die strengeren Sicherheitsvorkehrungen, die oft bei Gemini oder Claude zu finden sind.

Die besten Features von Mistral KI

- Stellen Sie Modelle auf Ihrer eigenen Hardware oder VPC (Virtual Private Cloud) bereit, um maximalen Datenschutz und Sicherheit zu gewährleisten.

- Verwenden Sie Mistral Memories, um wichtige Kontexte über verschiedene Sitzungen hinweg zu speichern und abzurufen, ohne Daten manuell erneut senden zu müssen.

- Greifen Sie auf das Connectors Directory zu, um Ihre Modelle ganz einfach mit externen Datenquellen wie Notion, GitHub und Slack zu verknüpfen.

Einschränkungen von Mistral KI

- Die Dokumentation und der Community-Support für Mistral sind nicht so umfangreich wie der für Google oder OpenAI, was für neue Entwickler zu einer steileren Lernkurve führen kann.

Preise für Mistral KI

- Mistral Large 3: 2,00 $/1 Mio. Eingaben | 6,00 $/1 Mio. Ausgaben

- Mistral Small: 0,20 $/1 Mio. Eingaben | 0,60 $/1 Mio. Ausgaben

- Mistral Free: Limitierter API-Zugriff für Testzwecke

Bewertungen und Rezensionen zu Mistral KI

- G2: 4,4/5 (mit Limit an ersten Bewertungen)

- Capterra: 4,5/5 (mit Limit an ersten Bewertungen)

Was sagen echte Benutzer über Mistral KI?

Eine Benutzeransicht sagt:

Ich habe nach einer Persönlichkeit aus der Geschichte unseres Landes gefragt. GEMINI hat korrekt zwischen zwei sehr unterschiedlichen Personen mit demselben Vor- und Nachnamen unterschieden: Der eine war Historiker und Universitätsprofessor, der andere ein Widerstandskämpfer, der während des Zweiten Weltkriegs deportiert wurde. /AI hat mir nur die Beschreibung des ersten gegeben.

Ich habe nach einer Persönlichkeit aus der Geschichte unseres Landes gefragt. GEMINI hat korrekt zwischen zwei sehr unterschiedlichen Personen mit demselben Vor- und Nachnamen unterschieden: Der eine war Historiker und Universitätsprofessor, der andere ein Widerstandskämpfer, der während des Zweiten Weltkriegs deportiert wurde. Mistral /AI hat mir nur die Beschreibung des ersten gegeben.

APIs leicht gemacht mit ClickUp

Der Einstieg in die Google Gemini API ist ganz einfach: Sie erhalten einen Schlüssel, installieren ein SDK und führen Ihren ersten API-Aufruf durch. Aber wenn Sie von einem einfachen Skript zu einer Produktionsanwendung übergehen, tauchen die eigentlichen Herausforderungen auf: die Verwaltung von Schlüsseln, die Dokumentation von Eingabeaufforderungen und die Organisation der Arbeit Ihres Teams.

Die Gemini-API bietet leistungsstarke KI-Funktionen, aber die Integration in Ihren Workflow kann zu verstreuten Dokumentationen, fragmentierter Projekt-Nachverfolgung und endlosen Kontextwechseln führen.

Teams, die ihre KI-Entwicklung zusammen mit ihrer Aufgabenverwaltung und Dokumentation zentralisieren, arbeiten schneller und behalten einen besseren Überblick. Die Wahl des Ortes, an dem Sie diese Arbeit organisieren, entscheidet darüber, wie effektiv Sie innovativ sein und zusammenarbeiten können.

Starten Sie kostenlos mit ClickUp und erleben Sie, wie ein konvergierter Workspace Ihren KI-Entwicklungsprozess verändern kann.

Häufig gestellte Fragen zur Gemini-API

Ja, Google bietet über Google AI Studio eine großzügige kostenlose Stufe für Gemini 3 Flash und Pro an. Spezialisierte Tools wie Google Search Grounding sind jedoch nach den ersten 5.000 Abfragen pro Monat kostenpflichtig (14 $/1.000 Abfragen).

Google AI Studio ist ein webbasiertes Tool zum Experimentieren mit Eingabeaufforderungen und zum schnellen Generieren von API-Schlüsseln. Die Gemini-API ist die programmatische Schnittstelle, die Sie in Ihrem Code verwenden, um diese KI-Funktionen in Ihre eigenen Anwendungen zu integrieren.

Ja, die Gemini-API unterstützt Multi-Turn-Unterhaltungen, was sie zu einer hervorragenden Wahl für die Erstellung interner Chatbots, Bots für den Kundensupport oder Teamassistenten macht. Sie würden die API als „Gehirn“ des Chatbots verwenden und die Benutzeroberfläche separat erstellen.

Die Ratenlimits variieren je nach dem von Ihnen verwendeten Modell und je nachdem, ob Sie die kostenlose oder eine kostenpflichtige Stufe nutzen. Die kostenlose Stufe hat niedrigere Limite für Anfragen pro Minute, während kostenpflichtige Pläne einen höheren Durchsatz für Produktionsanwendungen bieten.