Suchmaschinen waren schon immer unverzichtbar für die Informationssuche, aber das Benutzerverhalten hat sich weiterentwickelt. Anstelle einfacher Stichwortsuchen wie „Smartphones” stellen Benutzer heute spezifischere, personalisierte Abfragen wie „beste preisgünstige Smartphones für Spiele” auf.

Gleichzeitig verändern große Sprachmodelle (LLMs) wie ChatGPT die Suche, indem sie als intelligente Frage-Antwort-Systeme fungieren.

Durch die Integration in herkömmliche Suchmaschinen verbessern sie die Informationsgewinnung durch Retrieval-Augmented Generation (RAG) und sorgen so für präzisere und kontextbezogene Ergebnisse.

Anstatt miteinander zu konkurrieren, arbeiten LLMs und Suchmaschinen zusammen, um komplexe Abfragen effektiver zu bearbeiten. In diesem Artikel untersuchen wir, wie diese Integration die Form der Suche prägt.

⏰ 60-Sekunden-Zusammenfassung

- Herkömmliche Suchmaschinen haben oft Schwierigkeiten mit der Verwaltung großer Datensätze, der Aufrechterhaltung der Datenqualität und der Aufhebung von Silos.

- Sie stehen jedoch auch vor Herausforderungen in Bezug auf Sicherheit, Skalierbarkeit und die Bereitstellung kontextbezogener Ergebnisse.

- Große Sprachmodelle wie ChatGPT verbessern die Suchgenauigkeit, ermöglichen semantische Suche und unterstützen Abfragen in natürlicher Sprache.

- LLMs verbessern auch die multimodalen Suchfunktionen und machen die Wissensgewinnung personalisierter und effizienter.

- Die Connected Search- und KI-Funktionen von ClickUp bauen auf diesen Fortschritten auf, indem sie Ihre Daten zentralisieren und eine schnelle und genaue Informationsbeschaffung ermöglichen.

- ClickUp lässt sich nahtlos in verschiedene Plattformen integrieren, bietet Echtzeit-Zugriff auf Ihre Inhalte, optimiert Workflows und verbessert die Gesamtproduktivität.

Lassen Sie uns ohne weitere Umschweife gleich loslegen!

Was sind LLMs?

Große Sprachmodelle (LLMs) sind fortschrittliche Systeme künstlicher Intelligenz, die menschliche Sprache verarbeiten und generieren. Sie werden anhand umfangreicher Textdatensätze trainiert und sind damit in der Lage, Aufgaben wie Übersetzungen, Zusammenfassungen und Unterhaltungen zu bewältigen.

Zu den bekanntesten Beispielen für LLMs gehören GPT-3 und GPT-4, die weithin für ihre Fähigkeit bekannt sind, komplexe sprachbezogene Abfragen zu verarbeiten.

Im Gegensatz zu herkömmlichen Suchmaschinen, die von einer Abhängigkeit von Schlüsselwörtern geprägt sind, geht eine LLM-basierte Suchmaschine über oberflächliche Abfragen hinaus. Sie versteht den Kontext und die Absicht hinter Fragen und liefert direkte und detaillierte Antworten.

👀 Wussten Sie schon? 71 % der Benutzer bevorzugen Personalisierung von den Marken und Geschäften, für die sie sich entscheiden.

Features von LLM-Suchmaschinen

LLM-Suchmaschinen bieten fortschrittliche Features, die den Zugriff und die Interaktion von Benutzern des Internets mit Informationen neu definieren. Sehen wir uns ihre wichtigsten Features einmal genauer an:

- Semantisches Verständnis von Abfragen: LLM-Suchmaschinen interpretieren die Bedeutung hinter Abfragen und gehen über Schlüsselwörter hinaus, um die Absicht und den Kontext des Benutzers zu verstehen.

- Natürliche Sprachverarbeitung (NLP): Benutzer können Abfragen in Form von Unterhaltungen formulieren, ohne genaue Schlüsselwörter zu benötigen, wodurch die Suche intuitiver wird.

- Kontextuelle Relevanz: Die Suchergebnisse werden auf der Grundlage früherer Abfragen und Interaktionen personalisiert, wodurch relevantere und aktuellere Informationen gewährleistet werden.

- Antwortgenerierung: Diese Systeme liefern direkt in den Suchergebnissen umfassende Antworten, darunter Zusammenfassungen, Erklärungen und sogar kreative Formate wie Geschichten oder Schritt-für-Schritt-Anleitungen.

- Integration von Wissensgraphen: LLM-Suchmaschinen verwenden Wissensgraphen, um verwandte Konzepte und Entitäten miteinander zu verbinden und so tiefere Einblicke zu ermöglichen.

- Unterhaltung: Benutzer können einen Dialog führen, Folgefragen stellen und ihre Suche verfeinern, um ein interaktiveres Erlebnis zu erzielen.

- Adaptive Ergebnisse: Die Ergebnisse werden dynamisch an den Speicherort, die Interessen und frühere Suchanfragen angepasst und bieten so ein personalisierteres Erlebnis.

- Informationssynthese: Anstatt sich auf eine einzige Quelle zu verlassen, aggregieren LLM-Suchmaschinen Daten aus mehreren Quellen und bieten so eine breitere Perspektive.

👀 Wussten Sie schon? Mit der zunehmenden Verbreitung von Smart Speakern und Sprachassistenten werden mittlerweile 50 % aller Suchanfragen per Spracheingabe durchgeführt. Durch die Integration großer Sprachmodelle in diese Systeme werden Sprachsuchen noch präziser und ermöglichen einen schnelleren Zugriff auf Informationen über mehrere Plattformen hinweg – egal, ob es sich um Dateien, Aufgaben oder Notizen zu Meetings handelt.

Fortgeschrittene Suchtechniken mit LLMs

Mit dem Fortschritt der Suchtechnologie verändern LLMs wie GPT-4, BERT und T5 die Art und Weise, wie Suchmaschinen Abfragen verarbeiten, Ergebnisse personalisieren und Rankings verfeinern. Lassen Sie uns untersuchen, wie diese Modelle die Zukunft der Suche neu definieren.

Wie LLMs Abfragen senden

Die Suche hat sich von einfachen Stichwortsuchen zu semantischen Vektorsuchen weiterentwickelt. Anstatt eine bestimmte Abfrage wie „Mount Fuji“ durchzuführen, können Benutzer nach „Berge in Japan“ suchen, und das System liefert bedeutungsbasierte Ergebnisse.

Durch Umformulieren von Suchanfragen in Fragen – wie beispielsweise „Was sind die berühmten Berge in Japan?“ – lässt sich die Suchgenauigkeit verbessern. Große Sprachmodelle (LLMs) optimieren die Suche zusätzlich als Auslöser, wenn die Zuverlässigkeit gering ist, mithilfe von Techniken wie FLARE.

Das „Chain-of-Thought“-Denken verbessert die Suche zusätzlich, indem es Aufgaben in logische Schritte unterteilt, wie bei AutoGPT zu sehen ist. Darüber hinaus ermöglicht die dialogorientierte Suche LLM-gestützten Assistenten, Abfragen in Echtzeit zu verfeinern und so während der gesamten Interaktion präzisere Ergebnisse zu gewährleisten.

Personalisierte Suche und Kontextbewusstsein

Kontextbewusstsein ist eines der leistungsstärksten Features von LLMs. Im Gegensatz zu herkömmlichen Suchmaschinen, die Ergebnisse nach Keyword-Übereinstimmungen ordnen, berücksichtigen LLMs die Absicht des Benutzers, den Standort, den Suchverlauf und frühere Interaktionen.

Durch die Feinabstimmung mit domänenspezifischen Daten personalisieren LLMs die Suchergebnisse, um Muster zu erkennen und relevante Inhalte zu priorisieren. Ein Benutzer, der beispielsweise häufig nach veganen Rezepten sucht, wird bei der Suche nach den „besten Rezepten für das Abendessen” pflanzliche Optionen angezeigt bekommen.

LLMs interpretieren auch multimodale Abfragen und verstehen sowohl Text als auch Bilder, um genauere Ergebnisse zu erzielen. Darüber hinaus bauen sie einen longitudinalen Kontext auf und lernen aus laufenden Interaktionen, um proaktiv relevante Abfragen vorzuschlagen.

LLMs beim Re-Ranking und der Verbesserung von Suchergebnissen

LLMs verbessern Suchmaschinen, indem sie die Ergebnisse dynamisch neu ordnen, um die Absicht des Benutzers besser widerzuspiegeln. Im Gegensatz zum herkömmlichen keywordbasierten Ranking verwenden LLMs Aufmerksamkeitsmechanismen, um den gesamten Kontext einer Abfrage zu analysieren und relevante Inhalte zu priorisieren.

Das BERT-Update (Bidirectional Encoder Representations from Transformers) von Google ist ein Beispiel dafür, wie es die Suche revolutioniert hat, indem es den Kontext hinter Wörtern wie „apple” (Apfel) und „Apple” (Technologieunternehmen) versteht.

LLMs tragen auch zu einer verbesserten Effizienz der SERP (Search Engine Results Page) bei. Durch die Analyse von Faktoren wie Klickrate (CTR), Absprungrate und Verweildauer können LLMs Rankings in Echtzeit anpassen und so Ergebnisse mit hoher Interaktion der Benutzer verbessern.

📖 Lesen Sie auch: So suchen Sie schnell in PDF-Dateien

Beliebte LLM-Suchmaschinen-Tools

Mit der Weiterentwicklung der KI-gesteuerten Suche gewinnen mehrere Suchmaschinen mit großen Sprachmodellen aufgrund ihrer fortschrittlichen Funktionen zunehmend an Bedeutung. Perplexity AI liefert direkte Antworten mit Quellenangaben und macht die Suche dadurch interaktiver und informativer.

You. com bietet eine anpassbare Erfahrung, bei der Benutzer Quellen priorisieren, KI-generierte Zusammenfassungen integrieren und mit KI-Assistenten interagieren können.

Wir alle wissen, dass wir diese Suchmaschinen nutzen können, um Informationen abzurufen und schnelle Antworten zu erhalten. Aber wie sieht es mit dem Speicherort einer bestimmten wichtigen Datei bei der Arbeit aus? Oder mit dem Abrufen einer Unterhaltung voller Datenpunkte für Ihre nächste große Präsentation?

Hier kommt ClickUp, die Allround-App für die Arbeit, ins Spiel!

📮 ClickUp Insight: 46 % der Wissensarbeiter verlassen sich auf eine Mischung aus Chat, Notizen, Projektmanagement-Tools und Teamdokumentation, um die Nachverfolgung ihrer Arbeit zu gewährleisten. Für sie ist die Arbeit auf verschiedene, nicht miteinander verbundene Plattformen verteilt, was es schwieriger macht, den Überblick zu behalten. Als Allround-App für die Arbeit vereint ClickUp alles unter einem Dach. Mit Features wie ClickUp E-Mail Projektmanagement, ClickUp Notizen, ClickUp Chat und ClickUp Brain wird Ihre gesamte Arbeit an einem Ort zentralisiert, ist durchsuchbar und nahtlos miteinander verbunden. Verabschieden Sie sich von der Überlastung durch zu viele Tools – begrüßen Sie mühelose Produktivität.

ClickUp Brain kombiniert erweiterte Suchfunktionen mit umfassenden Funktionen des Projektmanagements und erstellt Verbindungen zwischen Aufgaben, Dateien, Teammitgliedern und Projekten an einem Ort. Kein Wechseln zwischen Apps oder Umgang mit fragmentierten Tools und Informationssilos mehr!

Die Kosten für Ineffizienzen aufgrund unzusammenhängender tools sind enorm:

- 2. 5 Stunden/Tag: Wissensarbeiter verbringen etwa 30 % ihres Arbeitstages mit der Suche nach Informationen.

- 3.600 App-Wechsel pro Tag: Mitarbeiter umschalten täglich über 3.600 Mal zwischen Apps und Fenstern und verlieren dadurch 4 Stunden pro Woche, um sich neu zu orientieren.

- 23 Minuten verloren: Jeder Wechsel zwischen Apps stört die Konzentration, und es dauert fast 23 Minuten, bis man wieder im Arbeitsfluss ist.

420.000 US-Dollar jährlich: Unternehmen mit 100 Mitarbeitern verlieren jedes Jahr diesen Betrag aufgrund von Missverständnissen und unzusammenhängenden tools.

Diese Ineffizienzen führen zu Zeitverlust, verminderter Arbeitsmoral und erhöhten Betriebskosten. Glücklicherweise verwandelt Connected AI diese Herausforderungen in Chancen für intelligentere Entscheidungen, schnellere Informationsbeschaffung und nahtlose Ausführung.

So verändert die vernetzte Suche von ClickUp die Zusammenarbeit:

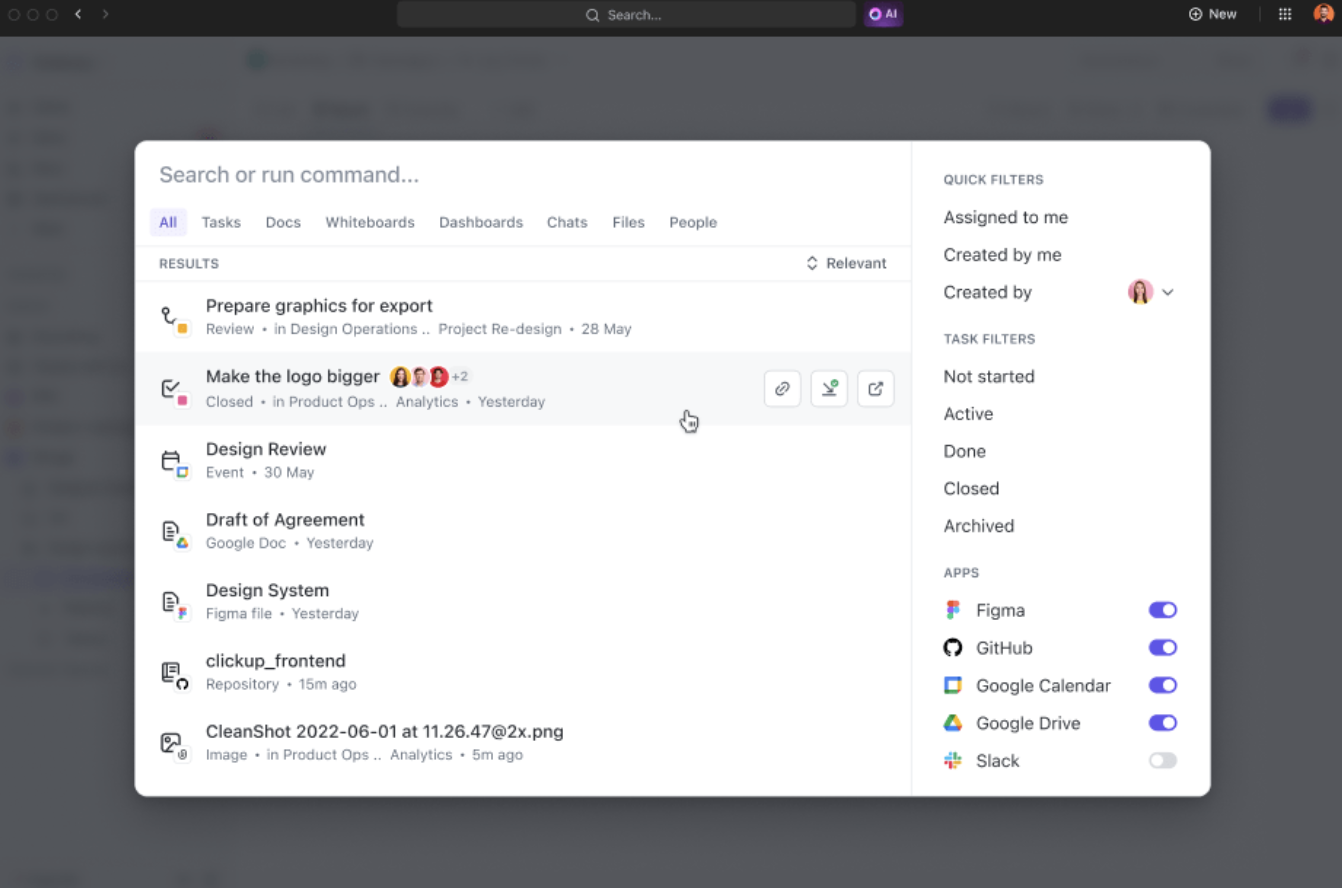

- Einheitliche Suche: Greifen Sie von einer einzigen Plattform aus auf alle Informationen des Unternehmens zu und sparen Sie fast vier Stunden pro Woche, indem Sie weniger zwischen verschiedenen Apps umschalten müssen.

- KI-gestützte Relevanz: Erhalten Sie personalisierte, kontextbezogene Suchergebnisse, die auf Ihre Projekte zugeschnitten sind, und verbessern Sie Ihre Entscheidungsfindung durch sofortigen Zugriff auf die relevantesten Erkenntnisse.

- Mühelose Tool-Integration: Nahtlose Verbindung mit bestehenden Tools wie Google Drive, SharePoint, Figma und Slack ohne komplexes Setup

Wenn Sie beispielsweise aus dem Urlaub zurückkehren, fragen Sie ClickUp Brain einfach nach Updates zu Ihren Projekten. Es liefert Ihnen übersichtliche Stichpunkte mit wichtigen Aktionselementen und Diskussionen, die während Ihrer Abwesenheit stattgefunden haben.

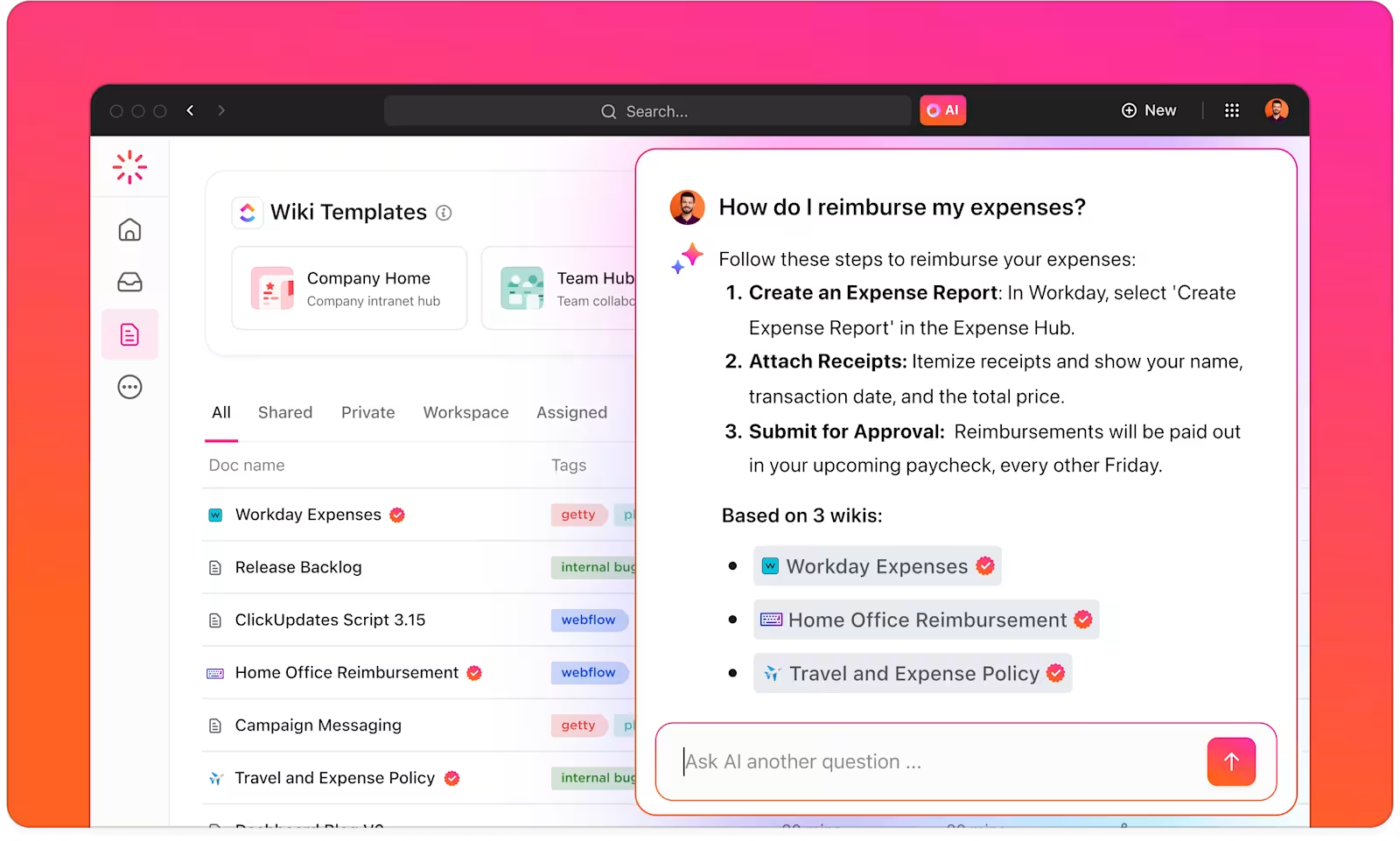

Mit ClickUp Brain verfügen Sie über einen intelligenten Wissensmanager, der Ihnen hilft, alles in Ihrem Workspace und den verbundenen Apps zu finden.

ClickUp Brain versteht den Kontext Ihrer Aufgaben und bietet relevante Vorschläge basierend auf Ihren Arbeitspräferenzen oder Hauptaktivitäten. Für Content-Ersteller bietet es beispielsweise Vorschläge für die Erstellung von Inhalten, Brainstorming und damit verbundene Aufgaben.

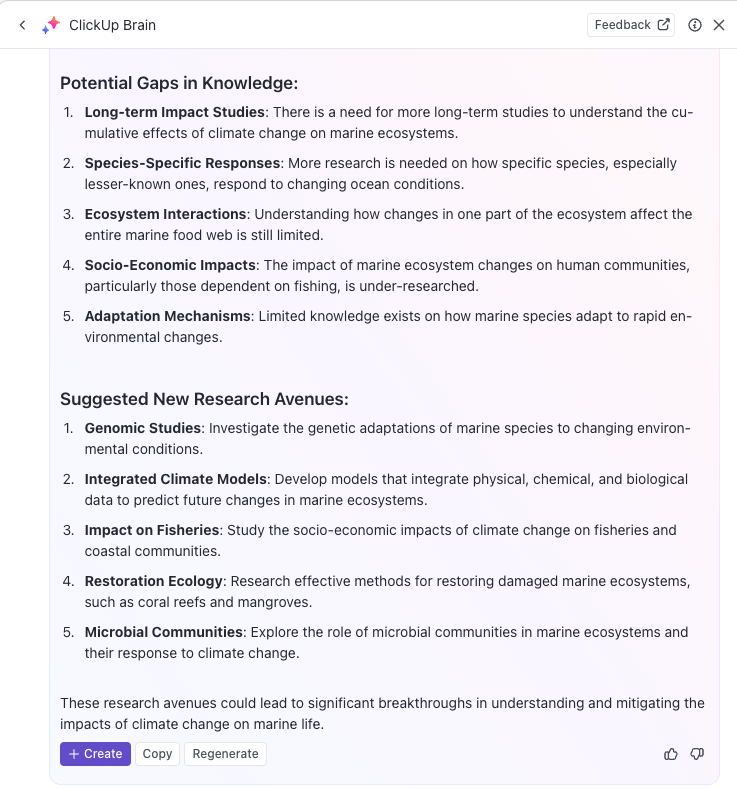

Sie können KI sogar nutzen, um wiederholende Aufgaben zu automatisieren oder den Status von Aufgaben mit einfachen Eingabeaufforderungen zu aktualisieren, sodass Sie sich auf Ihre eigentliche Arbeit konzentrieren können. Wenn Sie auf der Suche nach einer leistungsstarken KI-Suchmaschine sind, um Ihre Produktivität zu steigern, ist ClickUp Brain genau das Richtige für Sie.

Mit ClickUp Brain können Sie Ihre Wissensdatenbank optimieren, indem Sie alle relevanten Informationen automatisch kategorisieren, tags geben und organisieren.

Beispiel: Forschungsteams können beispielsweise ClickUp nutzen, um ein zentrales Wissensmanagementsystem zu erstellen, in dem alle Erkenntnisse, Dokumente und Forschungsergebnisse in einem leicht zugänglichen Format gespeichert werden.

Darüber hinaus unterstützt die Vielseitigkeit von ClickUp Docs die Erstellung von Wikis, Dokumenten-Repositorys und das wissensbezogene Aufgabenmanagement.

Sie können Informationen auch auf verschiedene Weise organisieren, indem Sie ClickUp Spaces, Ordner und Listen verwenden, um Inhalte für einen schnellen Abruf zu strukturieren. Ihr Team kann die richtigen Daten bei Bedarf leicht finden und darauf zugreifen, ohne Zeit mit der Suche auf mehreren Plattformen zu verschwenden.

Darüber hinaus hilft die Plattform bei der Nachverfolgung von Aufgaben und Projekten über ClickUp Aufgaben basierend auf Erkenntnissen, die aus LLM-Suchmaschinen gewonnen wurden. Sie können KI-gestützte Suchergebnisse direkt in Ihre Workflows zur Nachverfolgung von Aufgaben und Projekten integrieren, wodurch es einfacher wird, das gewonnene Wissen umzusetzen.

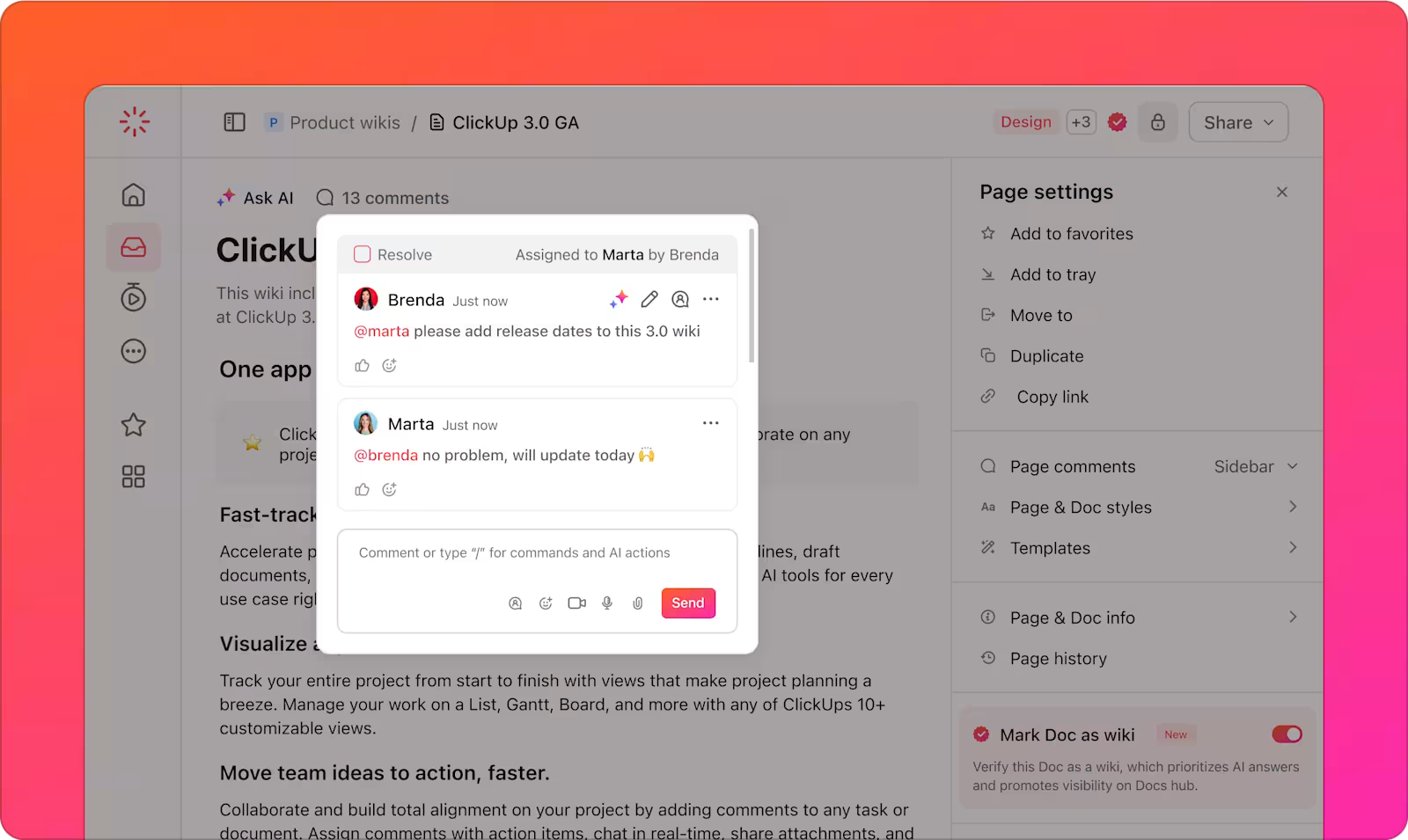

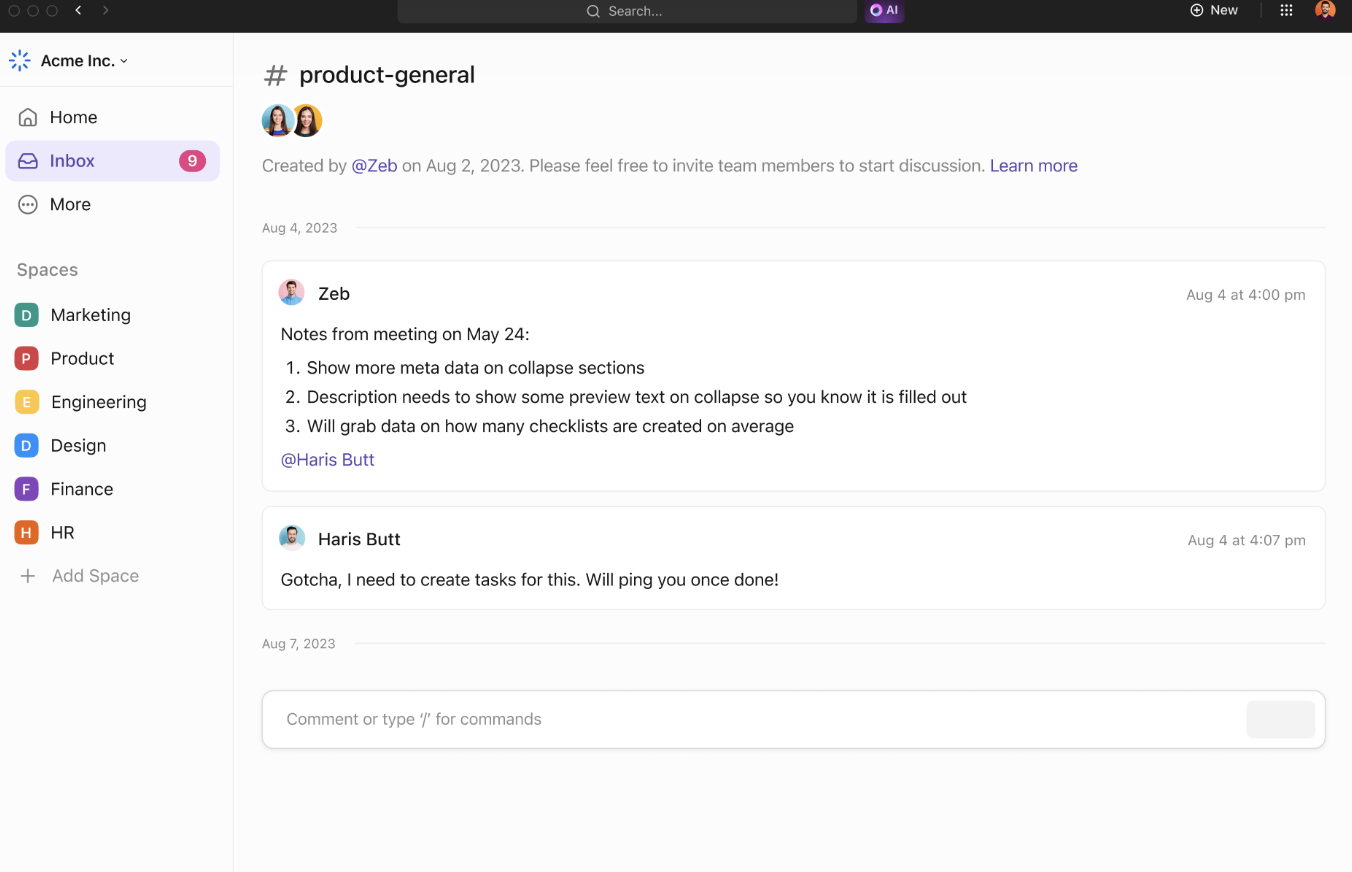

Die Collaboration-Tools von ClickUp unterstützen die Effizienz des Teams und den Informationsaustausch zusätzlich. Mit ClickUp Chat können Teammitglieder Projekte diskutieren, Erkenntnisse austauschen und Fragen in Echtzeit stellen.

Zugewiesene Kommentare bieten eine klare Möglichkeit, über bestimmte Dokumente oder Aufgaben zu kommunizieren, sodass alle über Aktualisierungen des Projekts auf dem Laufenden bleiben.

Teams können zusammenarbeiten, indem sie Ideen freigeben und Konzepte visualisieren. Fügen Sie Notizen hinzu, laden Sie Bilder hoch und betten Sie Links ein, um den Kontext besser zu verdeutlichen. Verwenden Sie Konnektoren, um Ideen zu verknüpfen und ihre Beziehungen hervorzuheben.

Wenn Ihre Ideen ausgereift sind, wandeln Sie sie in ClickUp Whiteboards in nachverfolgbare Aufgaben um, damit alles im Zeitplan bleibt.

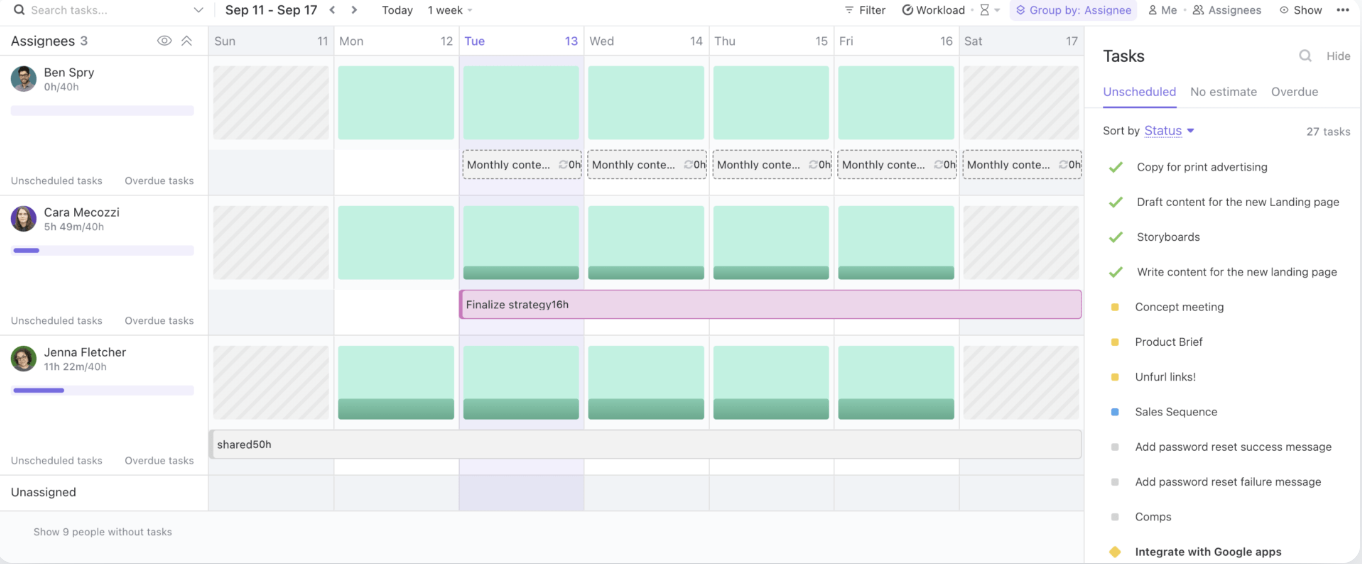

Schließlich können Sie mit der ClickUp-Workload-Ansicht die Kapazitäten Ihres Teams verwalten, laufende Aufgaben verfolgen und Ressourcen effektiv zuweisen.

Durch die Bereitstellung eines zentralen hubs für Wissensaustausch und Zusammenarbeit optimiert ClickUp Workflows und verbessert die Effizienz von Teams.

📖 Lesen Sie auch: Die beste Dokumentenmanagement-Software für mehr Organisation

Best Practices für die Verwendung von LLM-Suchmaschinen

Bei der Verwendung von LLM-Suchmaschinen ist es unerlässlich, Best Practices zu befolgen, die ihr Potenzial maximieren und gleichzeitig Risiken minimieren.

Diese Strategien helfen Ihnen dabei, das Beste aus Ihren KI-gestützten Tools herauszuholen und eine reibungslose Implementierung sowie langfristigen Erfolg sicherzustellen:

- Klare Anwendungsfälle definieren: Arbeiten Sie frühzeitig mit den Geschäfts- und Technikteams zusammen, um spezifische, messbare Anwendungsfälle zu ermitteln. Stimmen Sie die Ziele aufeinander ab, um sicherzustellen, dass die Lösung den richtigen Anforderungen entspricht und Fortschritte leicht zu bewerten sind.

- Richten Sie durchdachte Aufnahmeprozesse ein: Berücksichtigen Sie bei der Priorisierung von Anwendungsfällen die Sensibilität der Daten, potenzielle Risiken und die vorgesehenen Benutzer. Verwenden Sie einen risikobasierten Ansatz, um zu beurteilen, welche Projekte den größten Wert bei minimalem Schaden bieten.

- Konzentrieren Sie sich auf Datenerfassung, -prüfung und -validierung: Sorgen Sie für solide, faktenbasierte Daten, indem Sie die Verfahren zur Erfassung, Beschreibung, Speicherung und Verarbeitung verbessern.

- Implementieren Sie standardisierte Testverfahren: Erstellen Sie wiederholbare Testprozesse, die durch Playbooks und vordefinierte Praktiken unterstützt werden. Stellen Sie konsistente Ergebnisse, Systemzuverlässigkeit und gut getestete KI-Modelle vor der Bereitstellung sicher.

- Richten Sie eine kontinuierliche Überwachung ein: Überwachen Sie die Systemleistung im Zeitverlauf und passen Sie sich an veränderte Daten, Benutzerverhalten und Technologien an.

- Führen Sie Schulungs- und Kommunikationskampagnen durch: Vermitteln Sie Ihrem Team das nötige Wissen, um KI-Tools verantwortungsbewusst und effektiv einzusetzen. Starten Sie Schulungs- und Kommunikationsprogramme, die sowohl technische als auch ethische Aspekte der KI abdecken.

Herausforderungen und Lösungen bei der LLM-gesteuerten Suche

LLM-gesteuerte Suchmaschinen bieten ein enormes Potenzial, bringen jedoch auch eine Reihe von Herausforderungen mit sich. Im Folgenden finden Sie einige häufige KI-Herausforderungen und praktische Lösungen zu deren Bewältigung:

Datenqualität und Relevanz

LLM-gesteuerte Suchmaschinen sind in hohem Maße von der Qualität und Relevanz der von ihnen verarbeiteten Daten abhängig. Mangelhafte oder veraltete Daten können zu ungenauen oder irrelevanten Suchergebnissen führen und somit die Erfahrung der Benutzer beeinträchtigen.

✨ Durch die Konzentration auf hochwertige, aktuelle Daten können Unternehmen sicherstellen, dass ihre LLM-gestützte Suchmaschine relevante und zuverlässige Ergebnisse liefert.

Mangelnde Transparenz

LLM-Modelle werden oft als „Black Boxes“ betrachtet, bei denen die Gründe für ihre Ergebnisse für die Benutzer nicht sofort ersichtlich sind. Diese mangelnde Transparenz kann es für Benutzer schwierig machen, den erhaltenen Ergebnissen zu vertrauen.

✨ Durch die Integration von Erklärungs-Features in die Suchmaschine können Unternehmen ihren Benutzern Einblicke geben, warum bestimmte Ergebnisse zurückgegeben wurden.

Voreingenommenheit und ethische Bedenken

LLMs können Vorurteile aus den Daten übernehmen, mit denen sie trainiert wurden, was zu verzerrten oder unethischen Ergebnissen führen kann. Wenn die Trainingsdaten nicht vielfältig oder repräsentativ sind, kann die Suchmaschine diese Vorurteile widerspiegeln, was sich auf die Entscheidungsfindung und Fairness auswirkt.

✨ Die regelmäßige Überprüfung und Aktualisierung der Trainingsdaten ist unerlässlich, um diese Verzerrungen zu identifizieren und zu mindern. Darüber hinaus sorgt die Einbeziehung vielfältiger Datensätze und die Überwachung der Ergebnisse dafür, dass die Suchmaschine ausgewogenere, fairere und ethischere Ergebnisse liefert.

Systemkomplexität und Integration

Die Integration von LLM-gesteuerten Suchmaschinen in bestehende Workflows und Anwendungen kann eine Herausforderung sein, insbesondere wenn es sich um Legacy-Systeme oder mehrere Datenquellen handelt. Die Komplexität der Verbindung dieser neuen Tools mit etablierten Plattformen kann die Implementierung verlangsamen.

✨ Mit der vernetzten Suche von ClickUp können Sie schnell jede Datei finden, egal ob sie in ClickUp, einer verbundenen App oder auf Ihrem lokalen Laufwerk gespeichert ist.

Das Problem der Halluzinationen

Halluzinationen beziehen sich auf Instanzen, in denen das Modell sachlich falsche, erfundene oder irrelevante Informationen generiert. Dies geschieht, weil das Modell manchmal Daten auf der Grundlage von während des Trainings erlernten Mustern „halluziniert“, anstatt sie direkt aus Index-Quellen zu beziehen.

✨ Fortschrittliche Techniken wie Prompt Engineering und hochwertige Trainingsdaten verbessern die Zuverlässigkeit von LLM. Die Feinabstimmung mit domänenspezifischen Daten reduziert Halluzinationen, während die Integration von Wissensgraphen faktenbasierte, genaue Suchergebnisse gewährleistet.

Die Zukunft der Suche mit LLMs

Die nächste Generation der LLM-gesteuerten Suche verspricht noch mehr Präzision, Anpassungsfähigkeit und Reaktionsschnelligkeit, insbesondere bei der Bearbeitung komplexer und dynamischer Abfragen der Benutzer. Diese Systeme passen sich dynamisch an die sich wandelnden Bedürfnisse der Benutzer an und lernen aus früheren Interaktionen und Echtzeitdaten.

In einem Unternehmensumfeld könnte ein LLM beispielsweise eine Anfrage wie „Finde die Kundenabwanderungsanalyse des letzten Quartals” interpretieren und nicht nur die Rohdatei zurückgeben, sondern auch synthetisierte Erkenntnisse, relevante Trends und umsetzbare Schlussfolgerungen.

Branchen, die von einer Abhängigkeit von der Verwaltung umfangreicher und komplexer Datensätze betroffen sind, profitieren am meisten davon:

- Im Gesundheitswesen können große Sprachmodelle die Diagnosegenauigkeit unterstützen, indem sie klinische Notizen, Bildgebungsergebnisse und Forschungsarbeiten in Sekundenschnelle analysieren und miteinander abgleichen.

- Juristen profitieren von Tools, die umfangreiche Rechtsprechung durchsuchen können, um relevante Präzedenzfälle hervorzuheben.

- Finanzteams können LLMs für Aufgaben wie Echtzeit-Betrugserkennung, prädiktive Marktanalysen und die Automatisierung von Compliance-Prüfungen einsetzen.

Die Integration multimodaler Suchfunktionen – die Text-, Sprach- und Bilderkennung kombinieren – wird den Nutzen von LLMs weiter ausbauen.

Beispielsweise könnte ein Team, das an einer Produkteinführung arbeitet, sofort Bilder hochladen, diese mit Spracheingaben kommentieren und zugehörige Dokumente und Berichte abrufen. Diese Anpassungsfähigkeit macht LLMs unverzichtbar, um einen nahtlosen Zugriff auf verschiedene Formate zu gewährleisten.

Plattformen wie ClickUp bieten in Kombination mit LLM-gestützter Suche eine robuste Lösung für die Organisation und den Zugriff auf Dateien, die Optimierung von Workflows und die Steigerung der Effizienz bei der Entscheidungsfindung.

Optimieren Sie Ihren Workflow mit LLM-gestützter Suche

Mit ihrer kontinuierlichen Weiterentwicklung revolutionieren KI-gesteuerte Suchmaschinen auf Basis von LLMs die Art und Weise, wie Unternehmen Informationen aus Seiten abrufen und Daten verwalten.

Mit ihrer Fähigkeit, den Kontext zu verstehen, genauere Ergebnisse zu liefern und sich nahtlos in Workflows von Unternehmen zu integrieren, ebnen LLMs den Weg für intelligentere, schnellere und effizientere Abläufe.

Und wenn Sie eine KI-Suchmaschine suchen, die sich nahtlos in Ihren Workflow integrieren lässt, gibt es nichts Besseres als ClickUp Brain. Ob Sie schnell den Speicherort einer Datei oder Aufgabe finden, Ideen sammeln oder sogar eine E-Mail entwerfen möchten – die leistungsstarken KI-Funktionen von ClickUp Brain können all das bewältigen.

Durch die Integration mit den umfassenden Tools für Projektmanagement von ClickUp haben Sie alles griffbereit, können besser organisiert arbeiten, Zeit sparen und schneller datengestützte Entscheidungen treffen.

Worauf warten Sie noch? Melden Sie sich noch heute bei ClickUp an und erledigen Sie mehr mit ClickUp Brain!