Bảo mật là một quyền con người cơ bản. Và bảo mật này cũng ảnh hưởng đến mọi khía cạnh của trí tuệ nhân tạo (AI) ngày nay. Theo một báo cáo của Cisco, 64% người dùng lo lắng rằng họ có thể vô tình chia sẻ thông tin nhạy cảm khi sử dụng các công cụ AI.

Đó là một trong những lý do khiến các công cụ AI ngoại tuyến ngày càng phổ biến. Khi mô hình được chạy cục bộ, bạn có thể viết, mã hóa, tóm tắt và tạo nội dung mà không cần tải lên đám mây hoặc bị gián đoạn khi kết nối Wi-Fi bị ngắt.

Trong danh sách này, chúng tôi sẽ giới thiệu các công cụ AI tốt nhất có thể hoạt động offline, trong đó có một ứng dụng đa năng giúp bạn tổ chức các kết quả mà các công cụ này tạo ra thành một hệ thống thống nhất và cực kỳ bảo mật.

Công cụ AI ngoại tuyến là gì?

Các công cụ AI ngoại tuyến là các ứng dụng phần mềm chạy các mô hình ngôn ngữ lớn (LLMs) trên thiết bị cục bộ của bạn, mà không cần kết nối internet sau khi bạn tải xuống mô hình. Dữ liệu của mô hình được lưu trữ trực tiếp trên máy tính của bạn, vì vậy tất cả quá trình xử lý hoặc suy luận đều diễn ra trên CPU hoặc GPU của chính bạn.

Xử lý trên thiết bị này mang lại một số lợi ích chính:

- Bảo mật dữ liệu tuyệt đối: Thông tin nhạy cảm của bạn sẽ không bao giờ rời khỏi máy tính của bạn.

- Không có phí định kỳ: Sau khi bạn đã có công cụ và mô hình, sẽ không có chi phí đăng ký.

- Sử dụng được ở bất kỳ đâu: Bạn có thể sử dụng nó trên máy bay, trong một cabin hẻo lánh hoặc trong trường hợp mất kết nối internet.

- Kiểm soát hoàn toàn: Bạn có thể lựa chọn các mô hình cần sử dụng và cách cấu hình chúng.

Các công cụ AI offline tốt nhất trong nháy mắt

Dưới đây là tóm tắt nhanh về các công cụ AI offline tốt nhất hiện có.

| Tên công cụ | Tính năng chính | Phù hợp nhất cho | Giá cả* |

| ClickUp | Chế độ ngoại tuyến cho công việc và nhắc nhở, ClickUp Brain MAX bao gồm Chuyển đổi giọng nói thành văn bản, Tìm kiếm doanh nghiệp trên các ứng dụng kết nối, Quản lý tài liệu và kiến thức, Tự động hóa, cùng với Tích hợp và API. | Các nhóm cần khả năng thu thập dữ liệu ngoại tuyến kết hợp với thực thi trực tuyến, quản trị và bối cảnh AI trong một không gian làm việc duy nhất. | Miễn phí vĩnh viễn; Tùy chỉnh có sẵn cho doanh nghiệp. |

| GPT Cho Mọi Người | Trò chuyện trực tiếp với các mô hình mở, LocalDocs cho câu hỏi và trả lời tài liệu riêng tư, khám phá và tải xuống mô hình trong ứng dụng, máy chủ API cục bộ tương thích với OpenAI. | Người dùng quan tâm đến bảo mật muốn sử dụng một chatbot desktop đơn giản hoạt động offline với tài liệu lưu trữ cục bộ. | Kế hoạch miễn phí có sẵn; Kế hoạch trả phí bắt đầu từ $40/người dùng/tháng |

| LM Studio | Phát hiện và tải xuống mô hình, giao diện trò chuyện cùng RAG cục bộ, máy chủ tương thích với OpenAI hoặc API REST, cài đặt sẵn và tối ưu hóa hiệu suất. | Nhà phát triển và người dùng cao cấp muốn có một môi trường làm việc ngoại tuyến chuyên nghiệp. | Miễn phí |

| Ollama | Mô hình lệnh duy nhất, API REST cục bộ với tính năng truyền dữ liệu thời gian thực, tệp cấu hình (Modelfiles) cho các cấu hình có thể tái sử dụng và các mô hình nhúng (embeddings) cho các đường ống RAG. | Các nhà phát triển muốn một môi trường chạy cục bộ ưu tiên giao diện dòng lệnh (CLI) với lớp API mạnh mẽ. | Kế hoạch miễn phí có sẵn; Kế hoạch trả phí bắt đầu từ $20/tháng |

| Tháng 1. ai | Giao diện người dùng (UI) ngoại tuyến theo phong cách ChatGPT, trợ lý ảo và hỗ trợ MCP, các phần mở rộng để mở rộng chức năng, và các nhà cung cấp tương thích với OpenAI (tùy chọn). | Người dùng không chuyên muốn một trợ lý ngoại tuyến gọn gàng với khả năng tùy chỉnh. | Miễn phí và mã nguồn mở |

| Llamafile | Gói phần mềm dạng tệp thực thi duy nhất, phân phối linh hoạt trên các hệ điều hành, chế độ máy chủ cục bộ với giao diện web và API, môi trường chạy với ít phụ thuộc nhất. | Người dùng muốn có một tệp AI di động không cần cài đặt, có thể chạy ở bất kỳ đâu. | Miễn phí và mã nguồn mở |

| GPT Riêng tư | Nhập liệu và chỉ mục tài liệu tự lưu trữ, hỏi đáp RAG ngoại tuyến, lọc ngữ cảnh theo tài liệu, mô hình ngôn ngữ lớn (LLM) mô-đun và bộ lưu trữ vectơ. | Các nhóm cần chức năng hỏi đáp (Q&A) ngoại tuyến trên các tệp nội bộ với một quy trình RAG có thể kiểm soát. | Miễn phí và mã nguồn mở |

| Thì thầm. cpp | Chuyển đổi giọng nói thành văn bản cục bộ, mô hình lượng tử hóa để giảm tiêu thụ tài nguyên, hỗ trợ VAD, xử lý FFmpeg tùy chọn cho nhiều định dạng hơn. | Người dùng cần bản chép lời hoàn toàn offline có thể nhúng vào ứng dụng. | Miễn phí và mã nguồn mở |

| Giao diện người dùng web cho việc tạo văn bản | Giao diện người dùng dựa trên trình duyệt cho các mô hình cục bộ, mẫu lời nhắc Jinja2, điều khiển tạo nội dung, phân nhánh cuộc trò chuyện và chỉnh sửa tin nhắn. | Người dùng muốn tùy chỉnh tối đa trong giao diện web địa phương. | Miễn phí và mã nguồn mở |

| llama. cpp | Bộ xử lý suy luận hiệu suất cao, hỗ trợ lượng tử hóa rộng, máy chủ cục bộ với các điểm cuối theo phong cách OpenAI, hỗ trợ nhúng và xếp hạng lại. | Nhà phát triển đang xây dựng các ứng dụng AI ngoại tuyến tùy chỉnh hoặc hệ thống backend. | Miễn phí và mã nguồn mở |

Cách chúng tôi đánh giá phần mềm tại ClickUp

Đội ngũ biên tập của chúng tôi tuân thủ một quy trình minh bạch, dựa trên nghiên cứu và không thiên vị nhà cung cấp, vì vậy bạn có thể tin tưởng rằng các đề xuất của chúng tôi dựa trên giá trị thực sự của sản phẩm.

Dưới đây là hướng dẫn chi tiết về quy trình đánh giá phần mềm tại ClickUp.

Những yếu tố cần xem xét khi lựa chọn các công cụ AI tốt nhất có thể hoạt động offline

Đánh giá các công cụ AI ngoại tuyến có thể khiến bạn cảm thấy phức tạp và bối rối, dẫn đến việc bạn chọn một công cụ có thể không chạy được trên máy tính của mình. Điều quan trọng nhất cần xem xét là mục tiêu bạn muốn đạt được. Một nhà phát triển đang xây dựng ứng dụng AI có nhu cầu hoàn toàn khác so với người chỉ muốn một chatbot AI riêng tư, ngoại tuyến để hỗ trợ viết lách.

Dưới đây là các tiêu chí chính để đánh giá:

- Độ dễ dàng thiết lập: Có yêu cầu kiến thức kỹ thuật và công việc trên dòng lệnh, hay chỉ cần thiết lập bằng một cú nhấp chuột đơn giản?

- Lựa chọn mô hình: Bạn có thể dễ dàng lựa chọn từ nhiều mô hình khác nhau, hay bạn chỉ bị giới hạn trong một số ít mô hình?

- Cam kết bảo mật: Công cụ này có xử lý tất cả dữ liệu trên máy cục bộ hay có các thành phần đám mây ẩn?

- Yêu cầu phần cứng: Máy tính hiện tại của bạn có thể chạy tốt hay bạn cần nâng cấp?

- Khả năng tích hợp: Ứng dụng này có thể kết nối với các công cụ khác của bạn hay là một ứng dụng hoàn toàn độc lập?

- Phù hợp với trường hợp sử dụng: Nó được thiết kế cho trò chuyện chung, hỏi đáp về tài liệu của bạn, chuyển đổi âm thanh thành văn bản hay tạo mã?

Top 10 công cụ AI tốt nhất có thể sử dụng offline

Dưới đây là chế độ xem tổng quan về các công cụ AI offline tốt nhất 👇

1. ClickUp (Phù hợp nhất để quản lý công việc, tài liệu và ngữ cảnh AI trong một nền tảng duy nhất, cả khi làm việc trực tuyến và ngoại tuyến)

ClickUp, nền tảng Không gian Làm việc AI tích hợp đầu tiên trên thế giới, được xây dựng dựa trên nền tảng "AI ngoại tuyến" không chỉ dừng lại ở việc tạo ra câu trả lời. Bởi vì bạn vẫn cần một nơi để kết quả đó trở thành quyết định, công việc và bước tiếp theo, không bị mất tích trong các tệp tin và cuộc trò chuyện.

Và khác với nhiều thiết lập offline yêu cầu cài đặt phức tạp và tích hợp công cụ, ClickUp cung cấp cho bạn một lớp thực thi hoàn chỉnh trong một nền tảng duy nhất, với trí tuệ nhân tạo (AI) hoạt động trên cùng một bối cảnh không gian làm việc.

Đầu tiên, bạn có Chế độ Ngoại tuyến của ClickUp, tự động kích hoạt và duy trì công việc diễn ra suôn sẻ ngay cả khi không có kết nối mạng. Điều đó có nghĩa là tất cả các công việc, nhắc nhở và ghi chú của bạn vẫn có thể truy cập được khi offline, và bạn có thể thêm mới nếu cần. Khi kết nối lại, các công việc và nhắc nhở mới sẽ tự động đồng bộ trở lại Không gian Làm việc của bạn (tạm biệt việc mất bối cảnh 👋).

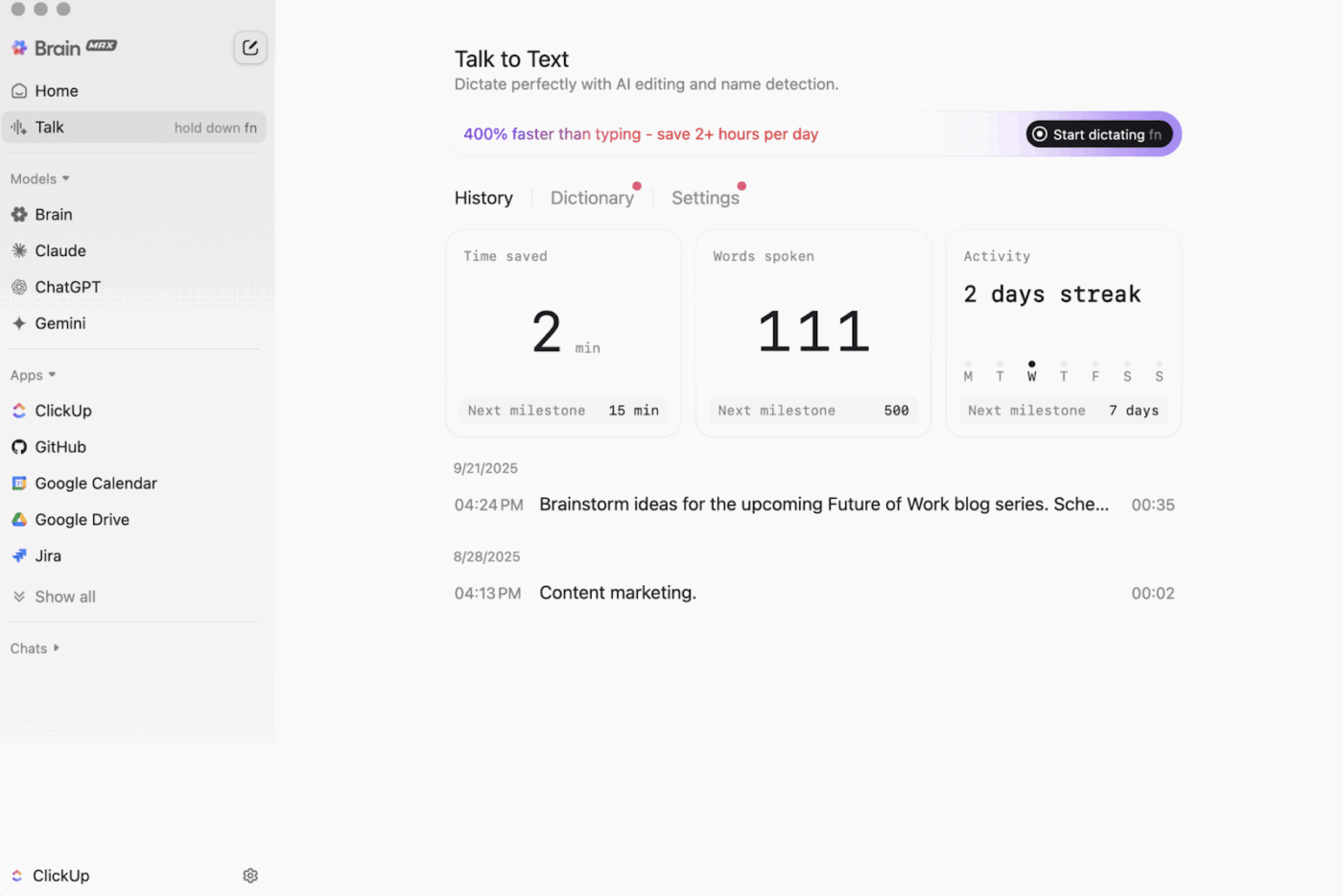

Sau đó là ClickUp Brain MAX , trợ lý AI trên desktop ưu tiên bảo mật, có thể lưu trữ và tìm kiếm trên toàn bộ không gian làm việc, các ứng dụng kết nối và thậm chí cả trên web.

Với tính năng Chuyển giọng nói thành văn bản , Brain MAX có thể chuyển đổi giọng nói của bạn thành văn bản mà không cần dùng tay. Điều này bao gồm việc soạn thảo email, viết tài liệu hoặc ghi chú nhanh khi bạn đang di chuyển.

Brain MAX cũng cung cấp cho bạn Trí tuệ Nhân tạo (AI) Tích hợp, được thiết kế để trò chuyện với các mô hình AI mới nhất trong lĩnh vực lập trình, viết lách, suy luận phức tạp và nhiều hơn nữa. Điều đó có nghĩa là bạn có thể đặt câu hỏi cho các mô hình AI hàng đầu tại một nơi duy nhất, bao gồm ClickUp Brain cùng các tùy chọn như OpenAI, Claude và Gemini, mà không cần chuyển đổi giữa các công cụ.

Hơn nữa, ClickUp Security cung cấp các biện pháp bảo mật mà các công cụ ngoại tuyến thường bỏ qua. Đó là mã hóa, quyền truy cập chi tiết và các tính năng quản trị như SSO, cấp quyền truy cập và nhật ký kiểm tra, tất cả đều được thiết kế dành cho các nhóm cần mức độ bảo mật cấp doanh nghiệp.

ClickUp AI Quản lý Kiến thức hỗ trợ đáng kể trong quá trình chuyển giao từ môi trường offline sang online. Nó cung cấp cho nhóm của bạn một trung tâm để lưu trữ các tài nguyên khác nhau trong tài liệu và wikis, sau đó sử dụng ClickUp Brain để trích xuất câu trả lời tức thì từ toàn bộ không gian làm việc của bạn, đảm bảo thông tin bối cảnh chính xác luôn sẵn sàng ngay khi công việc tiếp tục.

🎬 Các đại lý hành động: Sử dụng Super Agents để biến công việc đồng bộ thành các bước tiếp theo!

ClickUp Super Agents là các trợ lý ảo được hỗ trợ bởi trí tuệ nhân tạo (AI) mà bạn có thể tạo và tùy chỉnh để thực hiện các quy trình làm việc nhiều bước trong Không gian Làm việc ClickUp của mình. Bạn có thể cấu hình các điều kiện kích hoạt cụ thể, hướng dẫn và quyền truy cập công cụ để đảm bảo chúng hoạt động trong phạm vi bạn đã cài đặt.

Ví dụ, sau khi các công việc ngoại tuyến được đồng bộ hóa trở lại, một Super Agent có thể quét các mục mới, tóm tắt những thay đổi, xác định các bước hành động, soạn thảo bản cập nhật và chuyển nó đến chủ sở hữu phù hợp để xem xét.

Và vì Super Agents có thể được quản lý, bạn có thể kiểm soát quyền truy cập của họ thông qua các quyền truy cập và theo dõi các hoạt động của họ. 🔐

Các tính năng nổi bật của ClickUp

- Tìm kiếm mọi thứ trong các công cụ của bạn: Sắp xếp và tìm kiếm toàn bộ không gian làm việc của bạn, cùng với các ứng dụng kết nối, từ một nơi duy nhất với ClickUp Enterprise Search.

- Xây dựng một cơ sở kiến thức thực sự: Tạo wiki và tài liệu với ClickUp Docs bằng cách sử dụng trang con, mẫu, trợ lý AI và nhiều tính năng khác.

- Giữ kết nối với stack của bạn: Đồng bộ hóa công việc với các công cụ như Slack và GitHub mà không cần rời khỏi ClickUp nhờ tính năng tích hợp ClickUp.

- Tạo quy trình làm việc tùy chỉnh: Sử dụng API ClickUp với token cá nhân hoặc OAuth 2.0 để triển khai các tự động hóa và tích hợp được tùy chỉnh.

- Tự động hóa quy trình làm việc của bạn: Kích hoạt các hành động như chỉ định chủ sở hữu, cập nhật trạng thái hoặc khởi động quá trình chuyển giao dựa trên sự thay đổi của công việc với ClickUp Automations.

Giới hạn của ClickUp

- Do có phạm vi tính năng đa dạng, một số người dùng có thể gặp phải khó khăn ban đầu khi làm quen.

Giá cả của ClickUp

Đánh giá và nhận xét về ClickUp

- G2: 4. 7/5 (hơn 10.000 đánh giá)

- Capterra: 4.6/5 (hơn 4.000 đánh giá)

Người dùng thực tế đang nói gì về ClickUp?

Một nhà phê bình G2 cho biết:

Bảng Agile, tích hợp và tùy chỉnh. Ngoài ra, tôi thích việc có thể làm việc ngoại tuyến mà vẫn tiếp tục xử lý các công việc. Hơn nữa, tôi có thể gửi email đến bất kỳ danh sách công việc nào và các công việc sẽ được tạo tự động. Trình chỉnh sửa văn bản rất tuyệt vời, hoạt động cả ở chế độ MD và hỗ trợ phím tắt, cho phép xem trước nội dung trực tiếp.

Bảng Agile, tích hợp và tùy chỉnh. Ngoài ra, tôi thích việc có thể làm việc ngoại tuyến mà vẫn tiếp tục xử lý các công việc. Hơn nữa, tôi có thể gửi email đến bất kỳ Danh sách công việc nào và các công việc sẽ được tạo tự động. Trình chỉnh sửa văn bản rất tuyệt vời, hoạt động cả ở chế độ MD và sử dụng phím tắt, cho phép xem trước nội dung trực tiếp.

2. GPT4All (Phù hợp nhất cho trò chuyện AI riêng tư, ngoại tuyến với các mô hình ngôn ngữ lớn (LLMs) cục bộ)

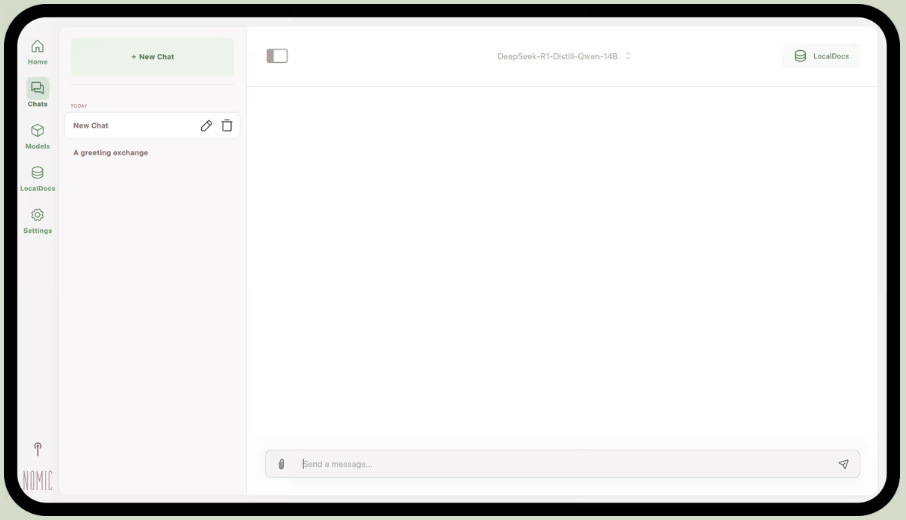

Là một phần của Nomic.ai, GPT4All là ứng dụng máy tính cho phép bạn chạy các mô hình ngôn ngữ lớn mã nguồn mở trực tiếp trên máy tính của mình, giúp bạn trò chuyện với trợ lý AI mà không cần kết nối internet hoặc gọi API đám mây. Ứng dụng này được thiết kế cho những người muốn thiết lập "ưu tiên cục bộ", nơi các lệnh, phản hồi và tệp tin được lưu trữ trực tiếp trên thiết bị.

Tính năng nổi bật nhất của nó là LocalDocs, sử dụng một biểu mẫu sinh ra được tăng cường bằng việc truy xuất (retrieval-augmented generation) để cho phép bạn trò chuyện riêng tư với các tài liệu của chính mình. Bạn có thể chỉ định ứng dụng truy cập vào một thư mục chứa các tệp PDF hoặc văn bản, và nó sẽ tạo ra một cơ sở kiến thức cục bộ mà bạn có thể đặt câu hỏi về nó.

GPT4All cũng bao gồm một thư viện được tuyển chọn các mô hình phổ biến như Llama và Mistral, mà bạn có thể tải xuống trực tiếp qua ứng dụng.

Các tính năng nổi bật của GPT4All

- Khởi chạy máy chủ API cục bộ (tương thích với OpenAI) để sử dụng các mô hình GPT4All trong các ứng dụng và quy trình tự động hóa khác.

- Tìm kiếm, so sánh và tải xuống các mô hình GGUF trực tiếp trong ứng dụng, với các tùy chọn sắp xếp như số lượt thích, số lượt tải xuống và ngày tải lên.

- Điều chỉnh độ dài bối cảnh, độ dài đầu ra tối đa, top-p, top-k, mức phạt lặp lại, số luồng CPU và thậm chí cả việc chuyển giao lớp GPU (cùng với hỗ trợ Metal trên Apple Silicon)

Giới hạn của GPT4All

- Hiệu suất phụ thuộc rất nhiều vào phần cứng của máy tính của bạn.

- Việc lập chỉ mục cho các bộ sưu tập tài liệu lớn có thể mất nhiều thời gian.

Giá cả của GPT4All

- Ứng dụng máy tính miễn phí

- Kinh doanh: $40 mỗi người dùng mỗi tháng (Nomic AI)

- Enterprise: Giá cả tùy chỉnh (Nomic AI)

Đánh giá và nhận xét về GPT4All

- G2: Không đủ đánh giá

- Capterra: Không đủ đánh giá

Người dùng thực tế đang nói gì về GPT4All?

Một người dùng Reddit cho biết:

Đây là phiên bản tốt nhất mà tôi đã thử với RAG, vượt trội hơn tất cả, thậm chí cả LM Studio về độ đơn giản. Tôi thích cách bạn gán nó vào một thư mục và nó tự động theo dõi và xử lý các thay đổi cho bạn. Hiện tại nó vẫn còn ở giai đoạn phát triển ban đầu, giống như các phiên bản khác, nhưng đây sẽ là lựa chọn mặc định của tôi trong thời gian ngắn hạn.

Đây là phiên bản tốt nhất mà tôi đã thử với RAG, vượt trội hơn tất cả, thậm chí cả LM Studio về độ đơn giản. Tôi thích cách bạn gán nó vào một thư mục và nó tự động theo dõi và xử lý các thay đổi cho bạn. Hiện tại nó vẫn còn ở giai đoạn phát triển ban đầu, giống như các phiên bản khác, nhưng đây sẽ là lựa chọn mặc định của tôi trong thời gian ngắn hạn.

📮 ClickUp Insight: 88% số người tham gia khảo sát của chúng tôi sử dụng trí tuệ nhân tạo (AI) cho các công việc cá nhân, nhưng hơn 50% lại e ngại sử dụng nó trong công việc. Ba rào cản chính là gì? Thiếu tích hợp mượt mà, khoảng cách kiến thức hoặc lo ngại về bảo mật. Nhưng nếu AI được tích hợp sẵn vào Không gian Làm việc ClickUp và đã được bảo mật sẵn thì sao? ClickUp Brain,

Trợ lý AI tích hợp sẵn của ClickUp biến điều này thành hiện thực. Nó hiểu các yêu cầu bằng ngôn ngữ thông thường, giải quyết cả ba vấn đề liên quan đến việc áp dụng AI đồng thời kết nối các cuộc trò chuyện, công việc, tài liệu và kiến thức của bạn trên toàn bộ không gian làm việc. Tìm câu trả lời và thông tin chi tiết chỉ với một cú nhấp chuột!

3. LM Studio (Phù hợp nhất cho một môi trường làm việc ngoại tuyến chuyên nghiệp với tối ưu hóa hiệu suất)

qua LM Studio

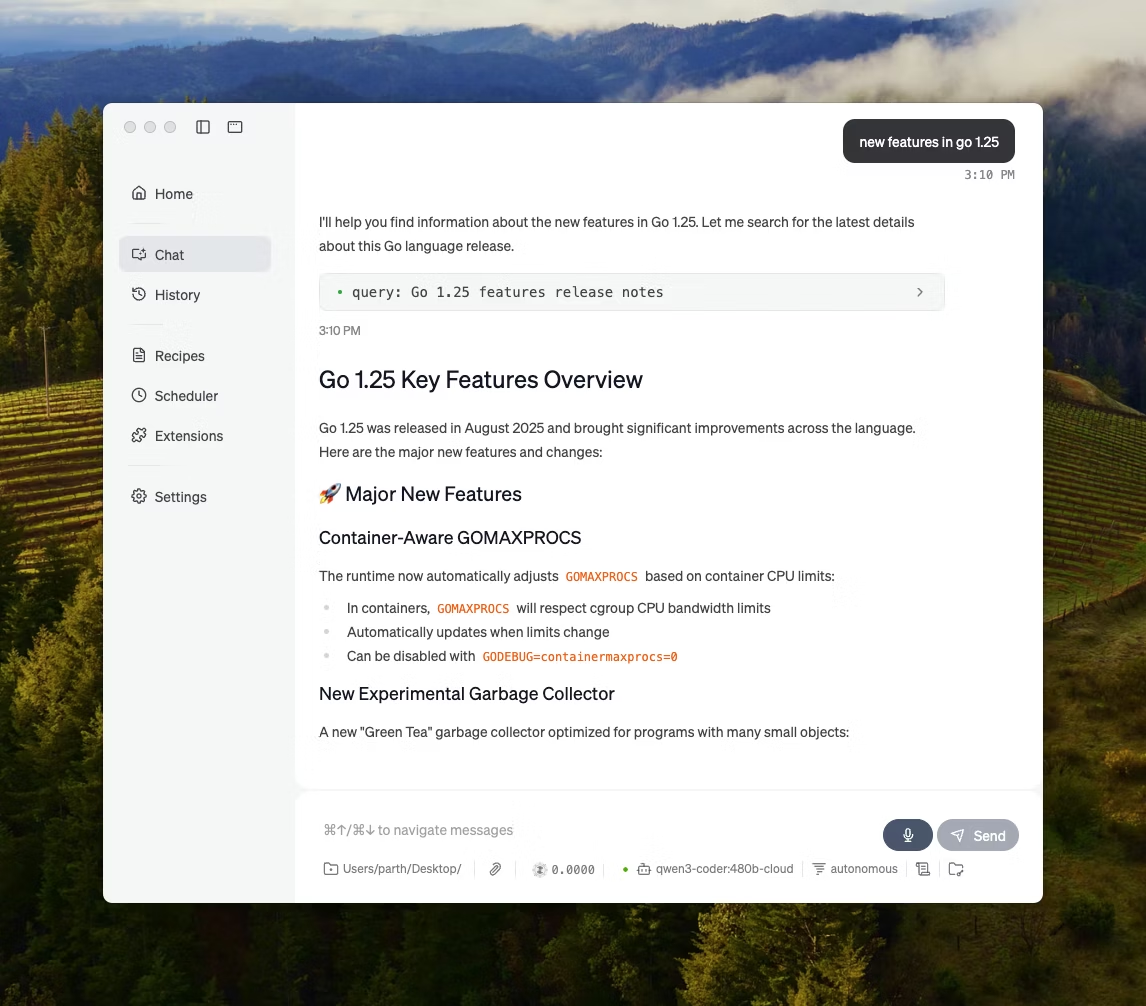

LM Studio là một ứng dụng máy tính AI địa phương được phát triển để tìm kiếm, thử nghiệm và chạy các mô hình nguồn mở trong giao diện người dùng (UI), mà không cần phải sử dụng terminal. Ứng dụng này tập trung vào việc thử nghiệm, như chọn một mô hình, chạy nó trên máy cục bộ và điều chỉnh các lời nhắc và cài đặt với vòng phản hồi nhanh hơn so với các thiết lập dựa trên CLI truyền thống.

Nó cũng hỗ trợ trò chuyện với tài liệu hoàn toàn offline (RAG cục bộ), nơi bạn có thể đính kèm tệp vào cuộc hội thoại và tham chiếu chúng trong các phản hồi. Điều này khiến nó trở nên lý tưởng cho nghiên cứu offline, ghi chú học tập hoặc quy trình làm việc với tài liệu nội bộ nơi việc tải lên không phải là một lựa chọn.

LM Studio cũng cung cấp cho bạn quyền kiểm soát chi tiết về cách AI hoạt động, với các tùy chọn để điều chỉnh nhiệt độ, độ dài ngữ cảnh và sử dụng GPU.

Các tính năng nổi bật của LM Studio

- Sử dụng chế độ tương thích OpenAI hoặc API REST riêng của LM Studio, tùy thuộc vào yêu cầu của ứng dụng của bạn.

- LM Studio cung cấp cả hai tùy chọn SDK JavaScript và Python để xây dựng các quy trình làm việc cục bộ dựa trên các mô hình của bạn.

- Lưu lời nhắc hệ thống + tham số dưới dạng cài đặt sẵn, sau đó sử dụng lại trong các trò chuyện (cài đặt sẵn cũng có thể được nhập từ tệp/URL và chia sẻ thông qua LM Studio Hub)

Giới hạn của LM Studio

- LM Studio có thể làm máy tính bị treo khi đang chạy DeepSeek R1 32B.

- Một số người dùng đã báo cáo ứng dụng này là một vấn đề về bảo mật dữ liệu và quyền riêng tư do mã nguồn đóng không được kiểm toán.

Bảng giá của LM Studio

- Miễn phí cho sử dụng tại nhà và trong công việc

Đánh giá và nhận xét về LM Studio

- G2: Không đủ đánh giá

- Capterra: Không đủ đánh giá

Người dùng thực tế đang nói gì về LM Studio?

Một người dùng Reddit cho biết:

Nó thật tuyệt vời. Nó hoạt động rất tốt, cực kỳ dễ dàng để bắt đầu sử dụng. Giao diện người dùng (UI) của nó là đẹp nhất so với tất cả các đối thủ cạnh tranh.

Nó thật tuyệt vời. Nó hoạt động rất tốt, cực kỳ dễ dàng để bắt đầu sử dụng. Giao diện người dùng (UI) của nó đẹp nhất so với tất cả các đối thủ cạnh tranh.

⭐ Bonus: Tìm kiếm thần kinh: Trí tuệ nhân tạo đang cách mạng hóa việc truy xuất thông tin như thế nào?

4. Ollama (Phù hợp nhất để chạy các mô hình ngôn ngữ lớn (LLMs) cục bộ với giao diện dòng lệnh (CLI) đơn giản và máy chủ cục bộ)

Ollama là một trình chạy mô hình cục bộ hoạt động giống như một runtime của mô hình ngôn ngữ lớn (LLM) hơn là một ứng dụng trò chuyện độc lập. Nó được thiết kế để ưu tiên giao diện dòng lệnh, cho phép kéo và chạy các mô hình mở bằng các lệnh nhanh (ví dụ: `ollama run llama3`), sau đó cung cấp chúng thông qua một dịch vụ cục bộ mà các giao diện khác có thể tích hợp lên trên.

Sức mạnh của Ollama nằm ở API REST của nó. Khi Ollama đã được khởi chạy ở chế độ nền, bất kỳ ứng dụng nào cũng có thể giao tiếp với nó thông qua các yêu cầu HTTP đơn giản. Điều này giúp tích hợp các tính năng AI vào phần mềm của riêng bạn.

Ollama cũng cung cấp một thư viện các mô hình phổ biến có thể được tải xuống chỉ với một lệnh, và bạn có thể tạo các cấu hình mô hình tùy chỉnh, tương tự như Dockerfiles cho AI.

Các tính năng nổi bật của Ollama

- Tạo các công thức mô hình có thể tái sử dụng và quản lý phiên bản (lựa chọn mô hình cơ sở, mẫu lời nhắc, thông báo hệ thống, tham số, bộ điều hợp) bằng cách sử dụng tệp mô hình (Modelfile).

- Chạy các mô hình qua các điểm cuối như trò chuyện/generate với tùy chọn truyền dữ liệu thời gian thực để tạo token trong ứng dụng và kịch bản.

- Tạo các embedding cho các quy trình tìm kiếm và truy xuất ngữ nghĩa bằng cách sử dụng khả năng tạo embedding của Ollama và các mô hình embedding được khuyến nghị.

Giới hạn của Ollama

- Nó không có giao diện đồ họa tích hợp sẵn, do đó người dùng không có kiến thức kỹ thuật sẽ cần một công cụ giao diện người dùng riêng biệt.

- Ứng dụng máy tính macOS của Ollama có thể không phản hồi khi offline, ngay cả khi các mô hình đã được tải xuống, trong khi giao diện dòng lệnh (CLI) vẫn hoạt động bình thường.

Giá của Ollama

- Miễn phí

- Ưu điểm: $20/tháng

- Max: $100/tháng

Đánh giá và nhận xét về Ollama

- G2: Không đủ đánh giá

- Capterra: Không đủ đánh giá

Người dùng thực tế đang nói gì về Ollama?

Một nhà đánh giá trên Producthunt cho biết:

Dễ dàng triển khai và quản lý. Ollama giúp việc chạy các mô hình ngôn ngữ lớn (LLMs) trên máy cục bộ trở nên đơn giản. Kết hợp với OpenWebUI để có trải nghiệm tối ưu.

Dễ dàng triển khai và quản lý. Ollama giúp việc chạy các mô hình ngôn ngữ lớn (LLMs) trên máy cục bộ trở nên đơn giản. Kết hợp với OpenWebUI để có trải nghiệm tối ưu.

🧠 Thông tin thú vị: Công nghệ chuyển đổi giọng nói thành văn bản ban đầu chỉ nhận diện các con số. Hệ thống AUDREY của Bell Labs ( 1952) có thể nhận diện các con số từ 0 đến 9, và trong một ghi chú, hệ thống hoạt động tốt nhất khi được phát âm bởi chính nhà phát minh của nó.

5. Jan. ai (Phù hợp nhất cho một trợ lý kiểu ChatGPT hoạt động offline và ưu tiên bảo mật)

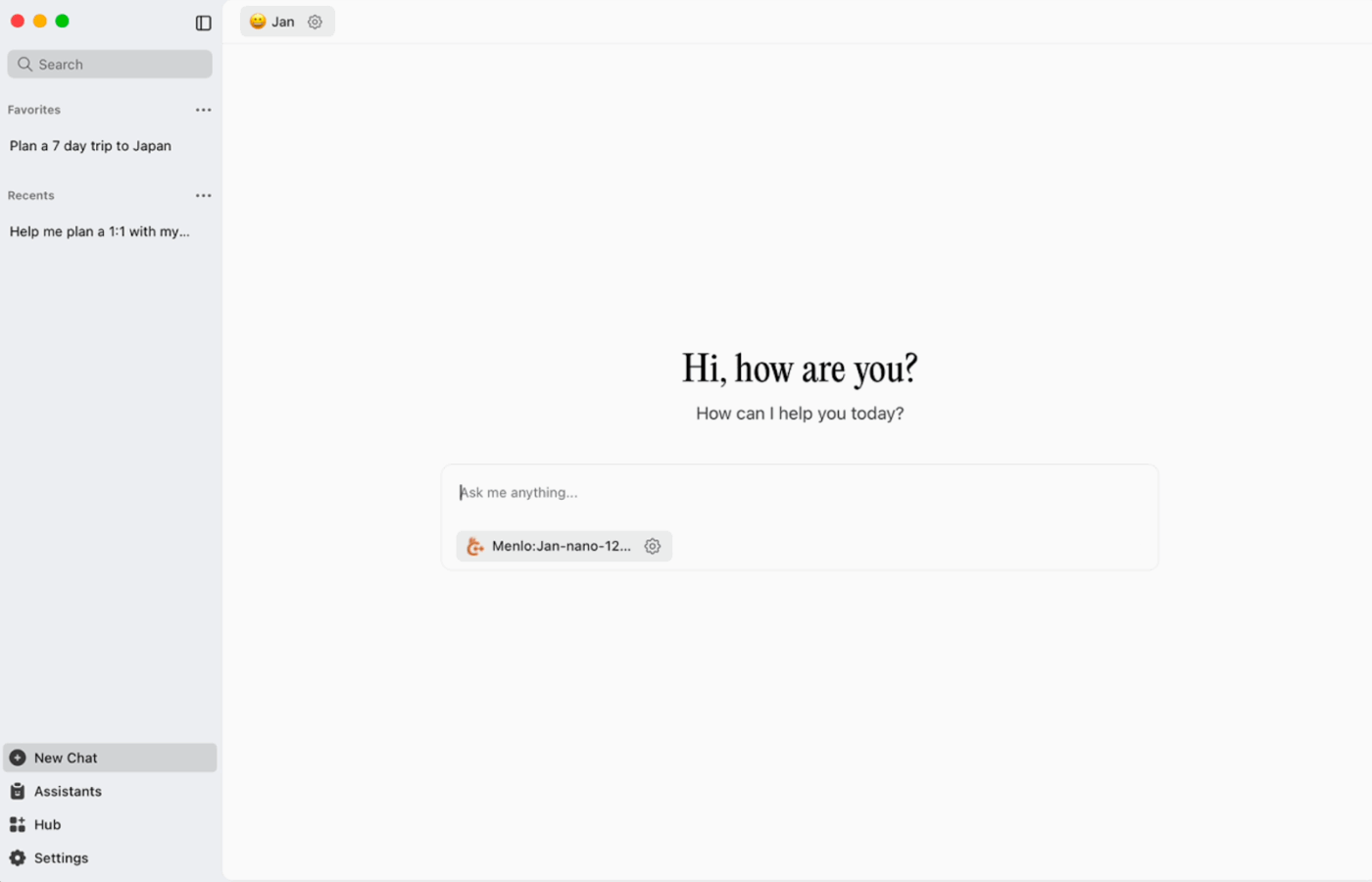

Jan. ai là một trợ lý desktop mã nguồn mở mang đến trải nghiệm trò chuyện tương tự ChatGPT cho macOS, Windows và Linux, với chế độ sử dụng cục bộ là mặc định. Ứng dụng chạy trực tiếp trên thiết bị khi bạn muốn, trong khi lịch sử cuộc hội thoại và dữ liệu sử dụng được lưu trữ cục bộ và không rời khỏi máy tính của bạn.

Nó hỗ trợ chạy các mô hình nguồn mở trên máy cục bộ và cũng cho phép kết nối tùy chọn với các nhà cung cấp từ xa như các API tương thích với OpenAI, điều này giúp nó linh hoạt khi sử dụng offline là ưu tiên hàng đầu, nhưng đôi khi vẫn cần truy cập đám mây.

Tháng 1. Tính năng nổi bật của AI

- Tạo các trợ lý với hướng dẫn và cài đặt riêng của họ, sau đó chuyển đổi giữa chúng từ tab Trợ lý thay vì phải viết lại các lời nhắc mỗi lần.

- Kết nối Jan với các công cụ MCP và nguồn dữ liệu bằng một tiêu chuẩn mở được thiết kế cho các quy trình làm việc theo phong cách sử dụng công cụ.

- Cài đặt các phần mở rộng để thêm các tính năng mới như tìm kiếm web hoặc trình thông dịch mã. Phương pháp mô-đun này cho phép bạn bắt đầu với các tính năng cơ bản và dần dần bổ sung thêm các tính năng mạnh mẽ hơn theo thời gian.

Giới hạn của trí tuệ nhân tạo (AI)

- Jan có thể cho phép tải một tệp mô hình chưa được tải xuống hoàn toàn, điều này có thể gây ra hành vi gây nhầm lẫn hoặc không nhất quán cho đến khi tệp được tải xuống hoàn thành.

- Bật API có thể gây xung đột với các cuộc trò chuyện đa luồng, và các điểm cuối cơ bản như ‘get loaded model’ hoặc ‘swap model’ có thể không hoạt động trơn tru.

Giá của Jan. ai

- Nguồn mở

Tháng 1. Đánh giá và nhận xét của AI

- G2: Không đủ đánh giá

- Capterra: Không đủ đánh giá

Người dùng thực tế đang nói gì về Jan. ai?

Một người dùng Reddit cho biết:

Jan. ai là ứng dụng LLM địa phương mà tôi thường sử dụng. Nó rất tuyệt vời.

Jan. ai là ứng dụng LLM địa phương mà tôi thường sử dụng. Nó thật tuyệt vời.

6. Llamafile (Phù hợp nhất để đóng gói mô hình ngôn ngữ lớn (LLM) thành tệp thực thi di động)

Llamafile là một dự án do Mozilla dẫn đầu, gói gọn một mô hình ngôn ngữ lớn (LLM) mã nguồn mở đầy đủ vào một tệp thực thi duy nhất. Thay vì cài đặt môi trường chạy, quản lý các phụ thuộc hoặc tích hợp giao diện người dùng riêng biệt, bạn chỉ cần tải xuống một tệp và chạy nó như một ứng dụng.

Ý tưởng cốt lõi là phân phối. Một 'llamafile' bao gồm trọng số mô hình cùng với một runtime đã được biên dịch, được thiết kế để chạy trên nhiều hệ điều hành khác nhau với ít thao tác thiết lập. Điều này đặc biệt hữu ích khi cần chia sẻ một công cụ offline với đồng nghiệp, sinh viên hoặc khách hàng mà không cần họ phải tự khắc phục sự cố thiết lập.

Các tính năng nổi bật của Llamafile

- Llamafile kết hợp llama.cpp với Cosmopolitan Libc để hỗ trợ khả năng tương thích nhị phân rộng rãi, giảm thiểu công việc đóng gói cụ thể cho từng nền tảng.

- Chế độ máy chủ cung cấp giao diện người dùng web (GUI) cùng với điểm cuối hoàn thành tương thích với API OpenAI, hữu ích cho việc phát triển ứng dụng cục bộ và thay thế các cuộc gọi đám mây trong quá trình thử nghiệm.

- Các gói phần mềm llamafiles được thiết kế để chạy trên các máy tính thông dụng sử dụng kiến trúc x86_64 và ARM64, giúp việc phân phối trở nên đơn giản hơn trên các hệ thống hỗn hợp.

Giới hạn của Llamafile

- Việc lựa chọn mô hình bị giới hạn trong những mô hình đã được đóng gói dưới dạng Llamafile.

- Kích thước tệp rất lớn vì toàn bộ mô hình được nhúng bên trong.

Giá của Llamafile

- Miễn phí và mã nguồn mở

Đánh giá và nhận xét về Llamafile

- G2: Không đủ đánh giá

- Capterra: Không đủ đánh giá

🧠 Thông tin thú vị: Trang web đầu tiên vẫn có thể truy cập được. CERN thực sự lưu trữ nó tại info.cern.ch, gọi nó là "ngôi nhà của trang web đầu tiên".

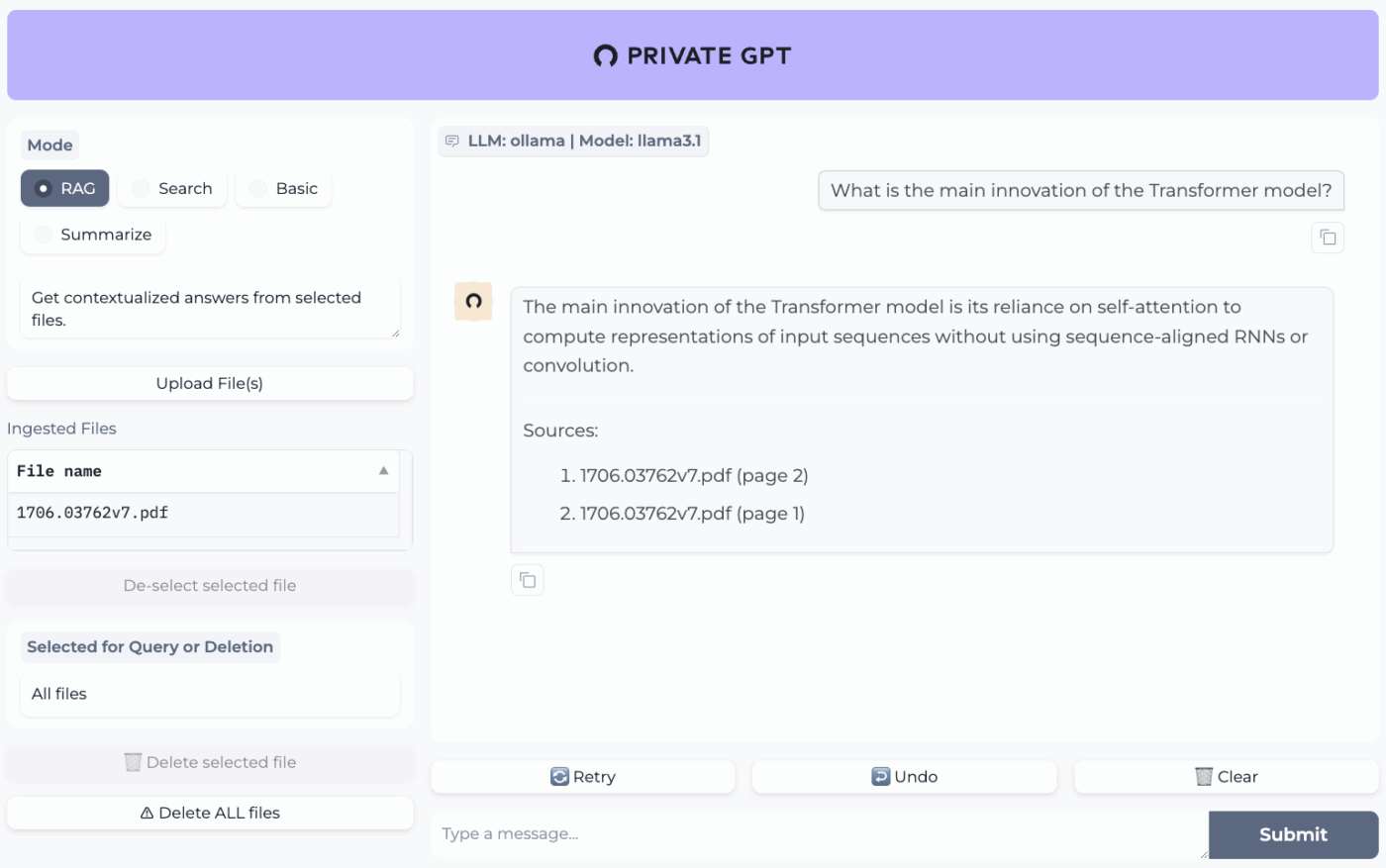

7. PrivateGPT (Phù hợp nhất cho việc hỏi đáp ngoại tuyến trên các tệp tin của bạn với hệ thống RAG tự lưu trữ)

PrivateGPT là một dự án sẵn sàng cho sản xuất, có thể tự triển khai, được thiết kế cho các quy trình làm việc "trò chuyện với tài liệu của bạn". Dự án này nhập các tệp cục bộ, lập chỉ mục cho chúng và trả lời câu hỏi bằng cách trích xuất ngữ cảnh liên quan từ chính nội dung của bạn, thay vì dựa vào bộ nhớ của chatbot đám mây. Dự án được thiết kế để hoạt động hoàn toàn offline, với cam kết rằng dữ liệu sẽ được lưu trữ bên trong môi trường thực thi của bạn.

Điều làm cho nó khác biệt so với các ứng dụng trò chuyện ngoại tuyến thông thường là kiến trúc mô-đun. Nói cách khác, bạn có thể kết hợp linh hoạt mô hình ngôn ngữ lớn (LLM), nhà cung cấp nhúng và kho lưu trữ vectơ dựa trên phần cứng và các yêu cầu về bảo mật của mình, sau đó chạy tất cả thông qua một API và giao diện người dùng (UI) cục bộ.

Các tính năng nổi bật của PrivateGPT

- Nhập các tệp PDF, DOCX, PPT/PPTX/PPTM, CSV, EPUB, markdown, JSON, MBOX, IPYNB, hình ảnh (JPG/PNG/JPEG) và thậm chí cả MP3/MP4 thông qua quy trình nhập liệu tích hợp sẵn.

- Cấu hình các hồ sơ cấu hình lớp bằng PGPT_PROFILES (ví dụ: local,cuda) để hợp nhất nhiều tệp cài đặt và chuyển đổi giữa các bản triển khai mà không cần viết lại cấu hình cơ sở.

- Lọc các phản hồi cho một tập con cụ thể của các tài liệu đã nhập bằng cách sử dụng context_filter khi gọi các điểm cuối hoàn thành ngữ cảnh.

Giới hạn của PrivateGPT

- Có yêu cầu phần cứng cao hơn do phải chạy nhiều thành phần cùng lúc.

- Nhập nhiều tài liệu từ một tệp duy nhất (ví dụ: một tệp PDF tạo ra một tài liệu cho mỗi trang) có thể làm tăng khối lượng và độ phức tạp của quá trình chỉ mục khi quản lý các tệp tải lên có dung lượng lớn.

Giá của PrivateGPT

- Nguồn mở

Đánh giá và nhận xét về PrivateGPT

- G2: Không đủ đánh giá

- Capterra: Không đủ đánh giá

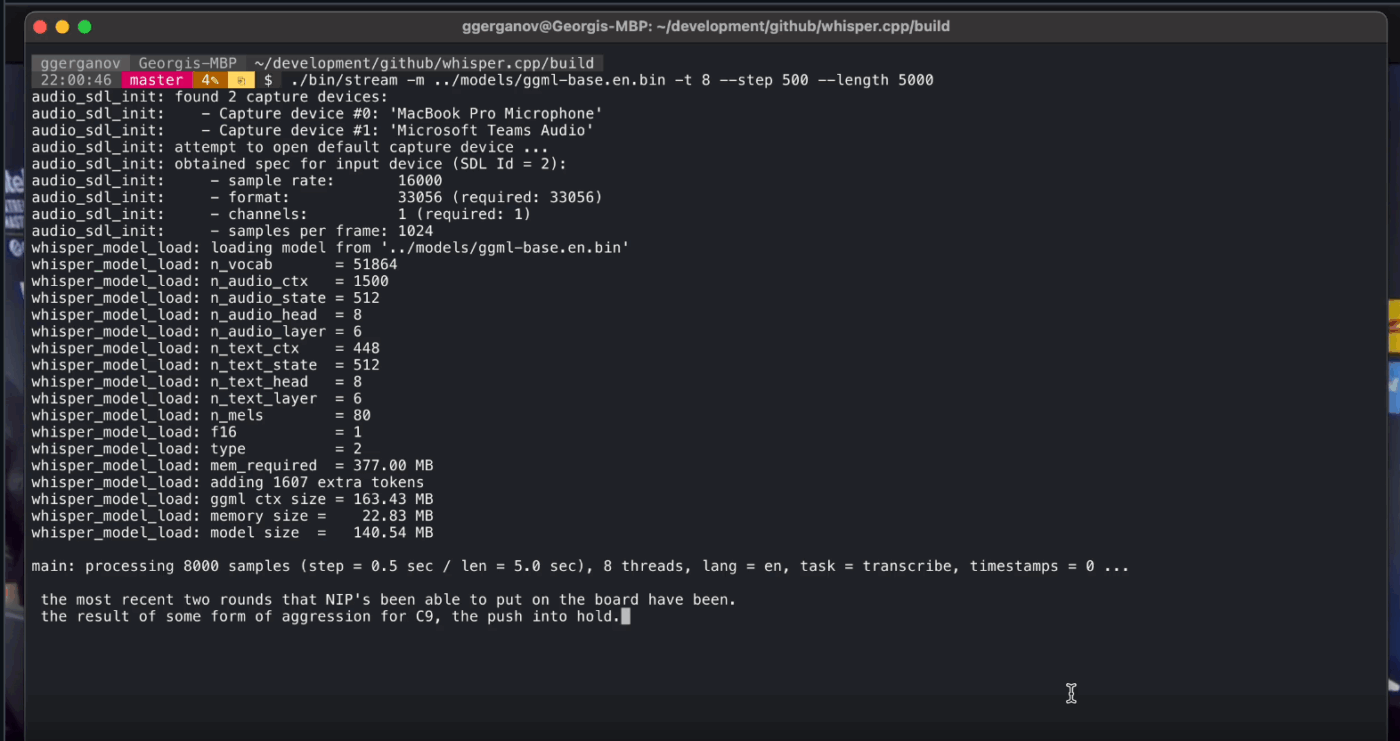

8. Whisper. cpp (Phù hợp nhất cho chuyển đổi giọng nói thành văn bản hoàn toàn offline có thể tích hợp vào ứng dụng)

Whisper.cpp là một triển khai C/C++ hiệu suất cao của mô hình nhận dạng giọng nói tự động Whisper của OpenAI, được thiết kế để chạy cục bộ mà không cần các phụ thuộc runtime nặng nề. Nó được ưa chuộng trong các quy trình chuyển đổi văn bản thành giọng nói ngoại tuyến, nơi bạn cần một tệp nhị phân nhỏ gọn, di động hoặc một thư viện kiểu C có thể tích hợp vào sản phẩm của riêng bạn.

Nó cũng linh hoạt trên nhiều môi trường, với hỗ trợ chính thức bao gồm máy tính để bàn, thiết bị di động, WebAssembly, Docker và thậm chí cả phần cứng thuộc loại Raspberry Pi, điều này khiến nó trở thành lựa chọn phù hợp cho các công cụ ngoại tuyến cần chạy trên nhiều nền tảng khác nhau.

Chữ 'cpp' trong tên của nó thể hiện sự tập trung vào hiệu suất. Phiên bản này hoạt động nhanh hơn đáng kể và sử dụng ít bộ nhớ hơn so với các giải pháp dựa trên Python, cho phép chuyển đổi văn bản thời gian thực trên các máy tính hiện đại mà không cần đến GPU mạnh mẽ.

Whisper. cpp - Các tính năng nổi bật

- Thực hiện phát hiện hoạt động giọng nói (VAD) như một phần của dự án để phân đoạn giọng nói và giảm thiểu các bản chép âm thanh ồn ào, trống rỗng trong các quy trình làm việc theo kiểu phát trực tuyến.

- Tối ưu hóa mô hình Quantize Whisper để giảm yêu cầu về dung lượng đĩa và bộ nhớ, với nhiều tùy chọn lượng tử hóa được thiết kế để tăng tốc độ suy luận cục bộ.

- Xây dựng với hỗ trợ FFmpeg tùy chọn trên Linux để xử lý nhiều định dạng đầu vào hơn ngoài định dạng WAV cơ bản.

Whisper. Giới hạn của cpp

- Whisper. cpp's CLI mặc định yêu cầu đầu vào là tệp WAV 16-bit, điều này đòi hỏi thêm một bước chuyển đổi khi làm việc với các định dạng phổ biến như MP3, MP4, M4A hoặc các định dạng khác.

- Nó không tự động gắn nhãn cho người nói (diarization), điều này khiến việc gán trích dẫn chính xác trong các bản ghi âm có nhiều người nói trở nên khó khăn.

Whisper. Giá cpp

- Nguồn mở

Whisper. Đánh giá và nhận xét về cpp

- G2: Không đủ đánh giá

- Capterra: Không đủ đánh giá

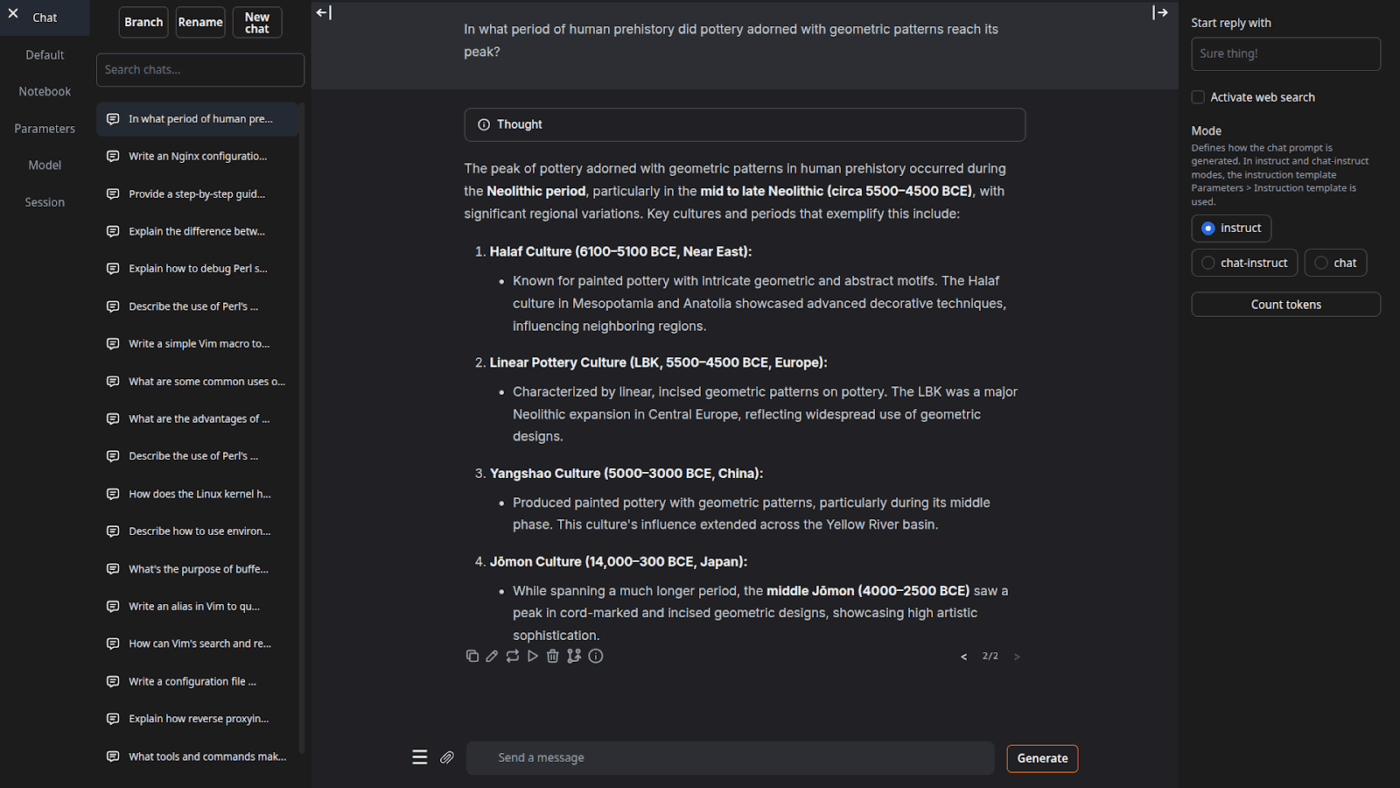

9. Giao diện người dùng web cho việc tạo văn bản (Phù hợp nhất cho người dùng muốn sử dụng giao diện trình duyệt để điều khiển các mô hình ngôn ngữ lớn (LLMs) cục bộ)

Giao diện web tạo văn bản (thường được gọi là 'oobabooga') là một giao diện web dựa trên Gradio để chạy các mô hình cục bộ với trọng tâm mạnh mẽ vào kiểm soát và thử nghiệm. Nó hoạt động giống như một môi trường làm việc đầy đủ: nhiều nền tảng mô hình, nhiều chế độ tương tác và nhiều tùy chọn điều chỉnh cho hành vi tạo văn bản.

Nó cũng tập trung vào các quy trình làm việc "viết/phát triển" mà nhiều công cụ offline bỏ qua, với các tính năng như tự động hóa định dạng lời nhắc, tạo nội dung theo phong cách sổ tay và phân nhánh cuộc hội thoại. Đối với các thiết lập offline vẫn cần giao diện web, đây là một trong những giao diện người dùng linh hoạt nhất trong phân loại này.

Các tính năng nổi bật của Giao diện người dùng web cho việc tạo văn bản

- Tự động định dạng lời nhắc bằng cách sử dụng mẫu Jinja2, giúp giảm thiểu lỗi định dạng lời nhắc trên các gia đình mô hình khác nhau.

- Điều chỉnh hàng chục cài đặt để tinh chỉnh đầu ra của AI cho nhu cầu cụ thể của bạn, dù là viết sáng tạo, lập trình hay chơi vai.

- Chỉnh sửa tin nhắn với tính năng điều hướng phiên bản và phân nhánh cuộc hội thoại, cho phép duy trì nhiều hướng khác nhau của cùng một cuộc trò chuyện mà không cần bắt đầu lại từ đầu.

Giới hạn của giao diện người dùng web cho việc tạo văn bản

- Trình cài đặt một cú nhấp chuột yêu cầu khoảng 10GB không gian đĩa và tải xuống PyTorch, điều này khiến quá trình thiết lập trở nên nặng nề trên các máy tính có không gian lưu trữ hạn chế.

- Điểm cuối nhúng tương thích với OpenAI sử dụng mô hình sentence-transformers/all-mpnet-base-v2 với nhúng 768 chiều, điều này có thể làm phá vỡ các giả định trong các quy trình được xây dựng dựa trên các giá trị mặc định 1536 chiều của OpenAI.

Giá dịch vụ tạo văn bản qua giao diện web

- Nguồn mở

Đánh giá và nhận xét về giao diện người dùng web tạo văn bản

- G2: Không đủ đánh giá

- Capterra: Không đủ đánh giá

10. Llama. cpp (Phù hợp nhất cho việc suy luận mô hình ngôn ngữ lớn (LLM) hiệu suất cao trên cả CPU và GPU)

Llama.cpp là một bộ công cụ và hệ thống suy luận C/C++ cho phép chạy các mô hình ngôn ngữ lớn (LLMs) trên máy cục bộ với ít phụ thuộc và hiệu suất mạnh mẽ trong một phạm vi rộng của loại phần cứng khác nhau. Nó không phải là một "ứng dụng trò chuyện" mà là một môi trường chạy cục bộ, nơi bạn có thể xây dựng các quy trình làm việc xung quanh, cho dù đó là giao diện dòng lệnh (CLI), máy chủ HTTP cục bộ hay thư viện nhúng bên trong sản phẩm của riêng bạn.

Mặc dù không phải là một ứng dụng dành cho người dùng cuối, Llama.cpp là động cơ cung cấp sức mạnh cho nhiều công cụ trong danh sách này, bao gồm GPT4All và LM Studio. Nó đã giới thiệu định dạng mô hình GGUF, đã trở thành tiêu chuẩn để chạy các mô hình lớn trên phần cứng tiêu dùng bằng cách giảm kích thước của chúng một cách hiệu quả.

Nó cũng cung cấp các gói thư viện cho các ngôn ngữ lập trình phổ biến như Python và Rust, và chế độ máy chủ của nó có thể cung cấp một API tương thích với OpenAI.

Llama. cpp - Những tính năng nổi bật

- Khởi chạy một máy chủ cục bộ tương thích với API OpenAI, tích hợp giao diện web và điểm cuối /v1/chat/completions bằng cách sử dụng llama-server.

- Chạy mô hình nhúng (và thậm chí mô hình xếp hạng lại) từ cùng một máy chủ cho các đường ống RAG ngoại tuyến bằng cách sử dụng /embedding và /reranking.

- Chuyển đổi mô hình sang định dạng 1,5 bit đến 8 bit để giảm sử dụng bộ nhớ và tăng tốc độ suy luận cục bộ, sau đó tăng tốc các tác vụ bằng CUDA/Metal cùng với các nền tảng Vulkan/SYCL khi có sẵn.

Giới hạn của Llama.cpp

- Llama.cpp không được phát hành dưới dạng một trợ lý desktop hoàn chỉnh, điều này có nghĩa là việc sử dụng offline thường yêu cầu sử dụng các lệnh CLI hoặc chạy máy chủ llama-server, và nhiều người dùng phải dựa vào các giao diện người dùng của bên thứ ba cho việc trò chuyện hàng ngày.

- Tính tương thích của Llama.cpp với OpenAI không phải lúc nào cũng hoàn toàn tương ứng 1:1 với mọi tính năng của client OpenAI, và người dùng đã báo cáo sự không khớp xung quanh các tham số đầu ra có cấu trúc như response_format trong /v1/chat/completions.

Giá của Llama. cpp

- Nguồn mở

Người dùng thực tế đang nói gì về Llama. cpp?

Một người đánh giá trên Sourceforge cho biết:

Tuyệt vời. Dân chủ hóa trí tuệ nhân tạo cho mọi người. Và nó hoạt động rất tốt!

Tuyệt vời. Dân chủ hóa trí tuệ nhân tạo cho mọi người. Và nó hoạt động rất tốt!

Chuyển đổi đầu ra AI ngoại tuyến thành công việc thực tế với ClickUp

Lựa chọn công cụ AI ngoại tuyến phù hợp thực sự là việc chọn công cụ phù hợp với công việc.

Nếu bạn đang ở đây, có lẽ bạn đang tối ưu hóa cho ba điều: bảo mật, không phụ thuộc vào internet và tự do khỏi việc bị ràng buộc vào một gói đăng ký khác.

Các công cụ trong danh sách này đáp ứng nhu cầu đó theo những cách khác nhau. Nghĩa là, một số công cụ phù hợp hơn cho việc viết và lập trình, trong khi những công cụ khác lại phù hợp cho việc tìm kiếm, ghi chú hoặc công việc sáng tạo.

Nhưng đối với các nhóm, thách thức lớn hơn không chỉ là triển khai AI trên máy cục bộ. Đó là việc biến kết quả đầu ra của AI thành các quy trình làm việc thực tế.

Với khả năng AI của ClickUp được tích hợp vào các công việc, tài liệu và kiến thức của bạn, bạn có thể dễ dàng xác định các bước tiếp theo ngay tại nơi công việc diễn ra (với mức độ bảo mật cấp doanh nghiệp).

Hãy thử ClickUp miễn phí và xem điều gì sẽ xảy ra khi trí tuệ nhân tạo (AI) và thực thi cuối cùng được kết hợp hoàn hảo. ✨

Câu hỏi thường gặp về các công cụ AI ngoại tuyến

Đúng vậy, sau khi tải xuống ban đầu các tệp mô hình, nhiều công cụ AI có thể hoạt động hoàn toàn trên thiết bị của bạn mà không cần kết nối internet. Điều này khiến chúng trở nên lý tưởng để xử lý dữ liệu nhạy cảm hoặc thực hiện công việc tại các địa điểm có kết nối internet yếu.

Các mô hình ngôn ngữ lớn (LLMs) cục bộ xử lý tất cả dữ liệu trên thiết bị cá nhân của bạn, do đó thông tin của bạn không bao giờ rời khỏi máy tính của bạn, trong khi AI dựa trên đám mây gửi các lệnh của bạn đến các máy chủ từ xa để xử lý. Các công cụ cục bộ thường miễn phí sau khi thiết lập, trong khi AI đám mây thường yêu cầu phí đăng ký nhưng có thể cung cấp các mô hình mạnh mẽ hơn.

Các mô hình nhỏ hơn với 1-3 tỷ tham số có thể chạy trên hầu hết các laptop hiện đại có 8GB RAM. Các mô hình lớn hơn, mạnh mẽ hơn với 7 tỷ tham số trở lên hoạt động tốt nhất với 16GB RAM trở lên và card đồ họa chuyên dụng (GPU), với các máy Mac sử dụng chip Apple Silicon và GPU NVIDIA mang lại cải thiện đáng kể về hiệu năng.

![10 công cụ AI tốt nhất hoạt động offline trong [năm]](https://clickup.com/blog/wp-content/uploads/2026/01/image-1298.png)