A privacidade é um direito humano fundamental. E essa privacidade também se aplica a todos os aspectos da inteligência artificial atual. Em um relatório da Cisco, 64% das pessoas se preocupam com a possibilidade de compartilhar acidentalmente informações confidenciais ao usar ferramentas de IA.

Essa é uma das razões pelas quais as ferramentas de IA offline estão ganhando popularidade. Quando o modelo é executado localmente, você pode escrever, codificar, resumir e criar — sem precisar enviar tudo para a nuvem ou ficar preso quando o Wi-Fi cai.

Nesta lista, abordaremos as melhores ferramentas de IA que funcionam offline, entre as quais se destaca um super aplicativo que ajuda você a organizar o que essas ferramentas produzem em um sistema coeso e super seguro.

O que são ferramentas de IA offline?

Ferramentas de IA offline são aplicativos de software que executam grandes modelos de linguagem (LLMs) em seu dispositivo local, sem a necessidade de conexão com a internet após o download do modelo. Os dados do modelo são armazenados diretamente em seu computador, portanto, todo o processamento, ou inferência, ocorre em sua própria CPU ou GPU.

Esse processamento no dispositivo tem várias vantagens importantes:

- Privacidade total dos dados: suas informações confidenciais nunca saem do seu computador.

- Sem taxas recorrentes: depois de adquirir a ferramenta e o modelo, não há custos de assinatura.

- Funciona em qualquer lugar: você pode usá-lo em um avião, em uma cabana remota ou durante uma interrupção na internet.

- Controle total: você escolhe quais modelos usar e como configurá-los.

As melhores ferramentas de IA offline em resumo

Aqui está um breve resumo das melhores ferramentas de IA offline disponíveis atualmente.

| Nome da ferramenta | Principais características | Ideal para | Preços* |

| ClickUp | Modo offline para tarefas e lembretes, ClickUp Brain MAX, que inclui conversão de voz em texto, pesquisa empresarial em aplicativos conectados, gerenciamento de documentos e conhecimento, automações, além de integrações e API. | Equipes que precisam de captura offline, execução online, governança e contexto de IA em um único espaço de trabalho | Gratuito para sempre; personalização disponível para empresas |

| GPT4Todos | Bate-papo local com modelos abertos, LocalDocs para perguntas e respostas sobre documentos privados, descoberta e downloads de modelos no aplicativo, servidor API local compatível com OpenAI | Usuários preocupados com a privacidade que desejam um chatbot simples para desktop offline com documentos locais | Plano gratuito disponível; planos pagos a partir de US$ 40/usuário/mês |

| LM Studio | Descoberta e downloads de modelos, interface de usuário de chat mais RAG local, servidor compatível com OpenAI ou API REST, predefinições e ajuste de desempenho | Desenvolvedores e usuários avançados que desejam uma bancada de trabalho offline aperfeiçoada | Gratuito |

| Ollama | Um modelo de comando, API REST local com streaming, arquivos de modelo para configurações reutilizáveis e incorporações para pipelines RAG | Desenvolvedores que desejam um tempo de execução local com prioridade para CLI e uma camada de API robusta | Plano gratuito disponível; planos pagos a partir de US$ 20/mês |

| Jan. ai | IU offline no estilo ChatGPT, assistentes e suporte a MCP, extensões para recursos adicionais e provedores opcionais compatíveis com OpenAI. | Usuários não técnicos que desejam um assistente offline simples e personalizável | Gratuito e de código aberto |

| Llamafile | Empacotamento de modelo executável único, distribuição portátil entre sistemas operacionais, modo de servidor local com interface de usuário web e API, tempo de execução com dependência mínima | Usuários que desejam um arquivo de IA portátil sem instalação que possam executar em qualquer lugar | Gratuito e de código aberto |

| PrivateGPT | Ingestão e indexação de documentos auto-hospedados, perguntas e respostas RAG offline, filtragem de contexto por documento, LLM modular e pilha de armazenamento vetorial. | Equipes que precisam de perguntas e respostas offline sobre arquivos internos com um pipeline RAG controlável | Gratuito e de código aberto |

| Whisper. cpp | Conversão de voz local em texto, modelos quantizados para menor uso de recursos, suporte a VAD, manipulação opcional do FFmpeg para mais formatos | Usuários que precisam de uma transcrição totalmente offline que possam incorporar em aplicativos | Gratuito e de código aberto |

| Geração de texto na interface do usuário da Web | Interface do usuário baseada em navegador para modelos locais, modelos de prompt Jinja2, controles de geração, ramificação de chat e edição de mensagens | Usuários que desejam personalização máxima em uma interface web local | Gratuito e de código aberto |

| llama.cpp | Mecanismo de inferência de alto desempenho, amplo suporte à quantização, servidor local com pontos finais no estilo OpenAI, incorporações e suporte à reclassificação. | Desenvolvedores que criam aplicativos ou back-ends de IA offline personalizados | Gratuito e de código aberto |

Como analisamos o software na ClickUp

Nossa equipe editorial segue um processo transparente, baseado em pesquisas e independente de fornecedores, para que você possa confiar que nossas recomendações são baseadas no valor real do produto.

Aqui está um resumo detalhado de como analisamos o software na ClickUp.

O que procurar nas melhores ferramentas de IA que funcionam offline

Avaliar ferramentas de IA offline pode parecer técnico e confuso, levando você a escolher uma ferramenta que talvez nem funcione no seu computador. O mais importante a considerar é o que você deseja alcançar. Um desenvolvedor que está criando um aplicativo com tecnologia de IA tem necessidades muito diferentes de alguém que deseja apenas um chatbot de IA privado e offline para auxiliar na escrita.

Aqui estão os principais critérios a serem avaliados:

- Facilidade de configuração: É necessário ter conhecimentos técnicos e saber usar a linha de comando, ou é uma instalação simples com um clique?

- Seleção de modelos: Você consegue escolher facilmente entre uma ampla variedade de modelos ou está limitado a apenas alguns?

- Garantias de privacidade: a ferramenta processa todos os dados localmente ou há componentes ocultos na nuvem?

- Requisitos de hardware: Ele terá um bom desempenho em sua máquina atual ou você precisa fazer uma atualização?

- Recursos de integração: Ele pode se conectar a outras ferramentas ou é um aplicativo totalmente independente?

- Adequação ao caso de uso: Ele foi projetado para bate-papos gerais, perguntas sobre seus documentos, transcrição de áudio ou geração de código?

As 10 melhores ferramentas de IA que funcionam offline

Aqui está uma visão geral das melhores ferramentas offline de IA 👇

1. ClickUp (Ideal para manter tarefas, documentos e contexto de IA em um único lugar, tanto no trabalho offline quanto online)

O ClickUp, o primeiro espaço de trabalho com IA convergente do mundo, foi desenvolvido com base em blocos de “IA offline” que não se limitam a gerar uma resposta. Isso porque você ainda precisa de um lugar onde essa resposta se transforme em uma decisão, uma tarefa e um próximo passo que não desapareça em arquivos e chats.

E, ao contrário de muitas configurações offline que exigem instalações demoradas e integração de ferramentas, o ClickUp oferece uma camada de execução completa em um único lugar, com IA trabalhando no mesmo contexto do espaço de trabalho.

Para começar, você tem o Modo Offline do ClickUp, que é ativado automaticamente e mantém o trabalho em andamento quando há atividade offline. Isso significa que todas as suas tarefas, lembretes e notas permanecem acessíveis enquanto você estiver offline, com a opção de adicionar mais, se necessário. Assim que você se reconectar, novas tarefas e lembretes serão sincronizados automaticamente com o seu espaço de trabalho (diga adeus à perda de contexto).

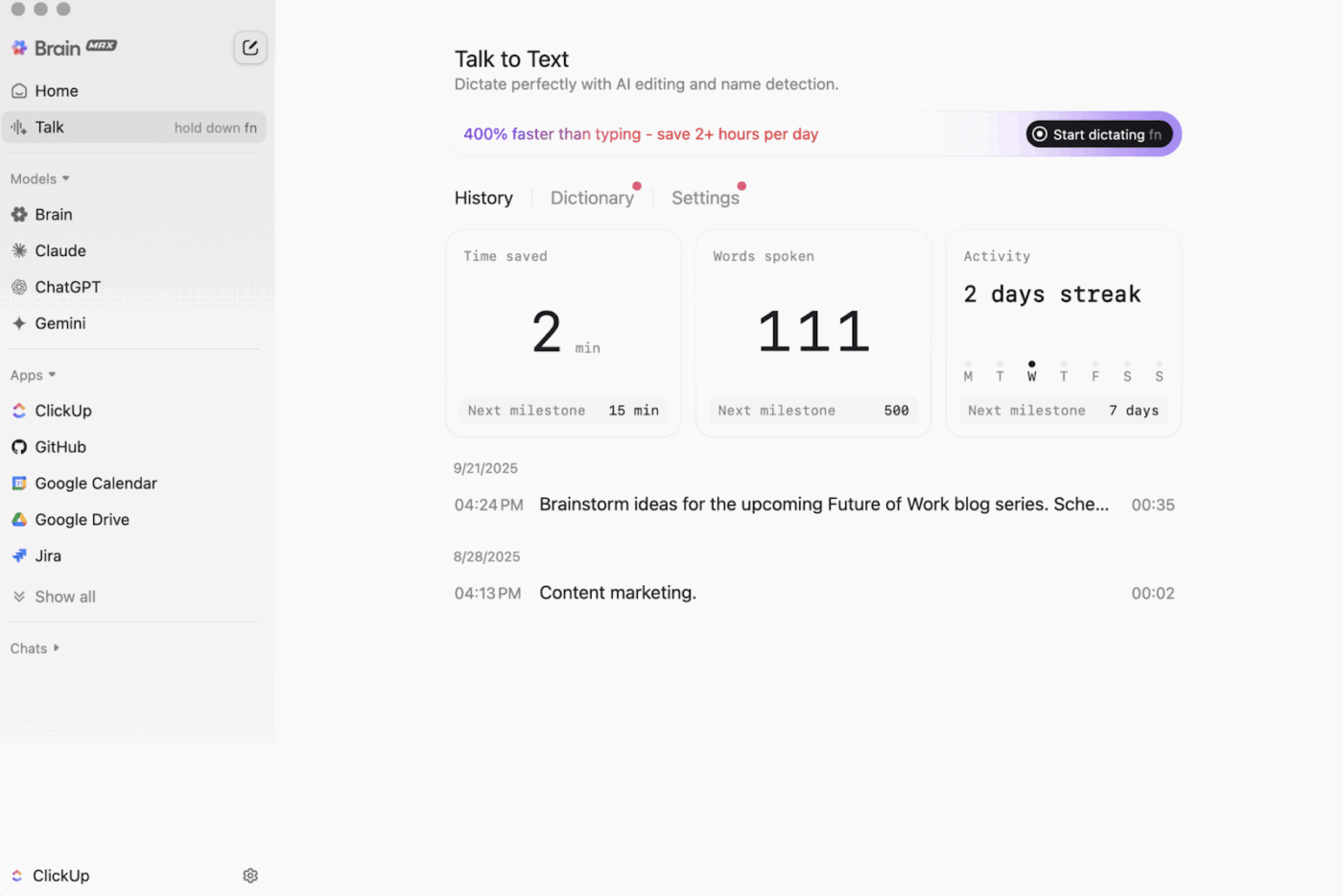

Depois, há o ClickUp Brain MAX , o companheiro de IA para desktop que prioriza a privacidade e pode armazenar e pesquisar em todo o seu espaço de trabalho, aplicativos conectados e até mesmo na web.

Com o Talk-to-Text integrado, o Brain MAX pode converter sua voz em texto sem usar as mãos. Isso inclui redigir um e-mail, escrever um documento ou capturar uma atualização rápida enquanto você está em movimento.

O Brain MAX também oferece a Universal AI, criada para conversar com os modelos mais recentes de IA para codificação, redação, raciocínio complexo e muito mais. Isso significa que você pode fazer perguntas aos melhores modelos de IA em um só lugar, incluindo o ClickUp Brain e opções como OpenAI, Claude e Gemini, sem precisar alternar entre ferramentas.

Além disso, o ClickUp Security adiciona proteções que as ferramentas offline frequentemente ignoram. Pense em criptografia, permissões granulares e controles administrativos como SSO, provisionamento e logs de auditoria, todos projetados para equipes que precisam de segurança de nível empresarial.

O ClickUp AI Knowledge Management ajuda muito na transição do “offline para o online”. Ele oferece à sua equipe um hub para armazenar diferentes recursos em documentos e wikis e, em seguida, usa o ClickUp Brain para obter respostas instantâneas em todo o seu espaço de trabalho, para que o contexto certo esteja disponível no momento em que o trabalho for retomado.

🎬 Agentes em ação: Use os Super Agentes para transformar o trabalho sincronizado em próximos passos!

Os Super Agentes do ClickUp são colegas de equipe com tecnologia de IA que você pode criar e personalizar para executar fluxos de trabalho com várias etapas dentro do seu Espaço de Trabalho do ClickUp. Você pode configurar gatilhos, instruções e acesso a ferramentas específicos para garantir que eles ajam dentro dos limites que você definir.

Por exemplo, após a sincronização das tarefas offline, um Super Agente pode verificar os novos itens, resumir o que mudou, definir as etapas de ação, redigir uma atualização e encaminhá-la ao responsável correto para revisão.

E como os Super Agentes são controláveis, você pode controlar o que eles podem acessar com permissões e auditar o que eles fazem. 🔐

Melhores recursos do ClickUp

- Encontre qualquer coisa em suas ferramentas: classifique e pesquise em todo o seu espaço de trabalho, além de aplicativos conectados, em um só lugar com o ClickUp Enterprise Search.

- Crie uma base de conhecimento real: crie wikis e documentação com o ClickUp Docs usando páginas aninhadas, modelos, assistência de IA e muito mais.

- Mantenha sua pilha conectada: sincronize o trabalho com ferramentas como Slack e GitHub sem sair do ClickUp com as integrações do ClickUp.

- Crie fluxos de trabalho personalizados: use a API do ClickUp com tokens pessoais ou OAuth 2.0 para impulsionar automações e integrações personalizadas.

- Automatize sua pilha: acione ações como atribuir proprietários, atualizar status ou iniciar transferências com base em alterações de tarefas com o ClickUp Automations.

Limitações do ClickUp

- Devido à ampla gama de recursos, alguns usuários podem enfrentar uma curva de aprendizado.

Preços do ClickUp

Avaliações e comentários sobre o ClickUp

- G2: 4,7/5 (mais de 10.000 avaliações)

- Capterra: 4,6/5 (mais de 4.000 avaliações)

O que os usuários reais estão dizendo sobre o ClickUp?

Um revisor do G2 afirma:

Quadros ágeis, integrações e personalização. Além disso, gosto do fato de poder ficar offline e continuar trabalhando nas tarefas. Adicionalmente, posso enviar e-mails para qualquer uma das listas e criar tarefas automaticamente. O editor de texto é fabuloso, funcionando tanto no modo MD quanto com atalhos, permitindo visualizar o conteúdo em linha.

Quadros ágeis, integrações e personalização. Além disso, gosto do fato de poder ficar offline e continuar trabalhando nas tarefas. Adicionalmente, posso enviar e-mails para qualquer uma das listas e criar tarefas automaticamente. O editor de texto é fabuloso, funcionando tanto no modo MD quanto com atalhos, permitindo visualizar o conteúdo em linha.

2. GPT4All (Ideal para bate-papos privados e offline com IA usando LLMs locais)

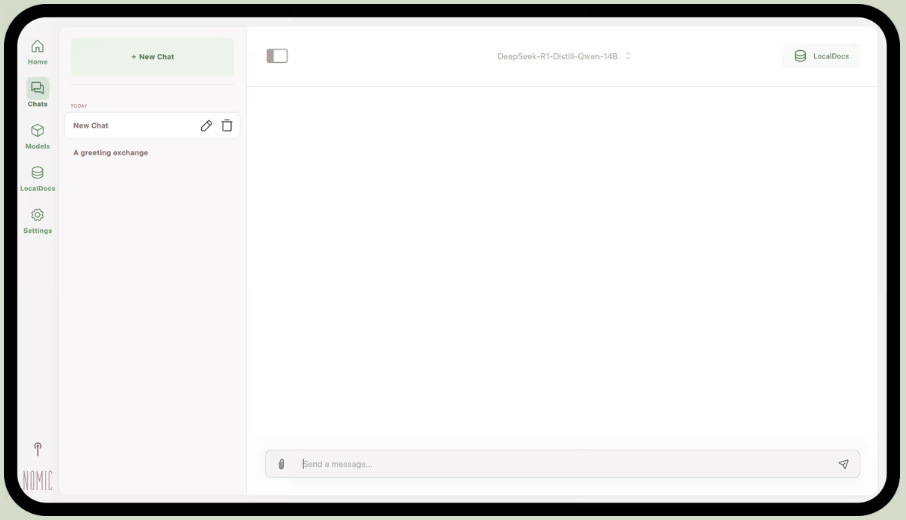

Parte do Nomic.ai, o GPT4All é um aplicativo para desktop que permite executar modelos de linguagem de código aberto diretamente no seu computador, para que você possa conversar com um assistente de IA sem depender de acesso à Internet ou chamadas de API na nuvem. Ele foi desenvolvido para pessoas que desejam uma configuração “local-first”, na qual prompts, respostas e arquivos permanecem no dispositivo.

Sua melhor característica é o LocalDocs, que usa uma forma de geração aumentada por recuperação para permitir que você converse com seus próprios documentos de forma privada. Você pode direcionar o aplicativo para uma pasta de PDFs ou arquivos de texto, e ele criará uma base de conhecimento local sobre a qual você poderá fazer perguntas.

O GPT4All também inclui uma biblioteca com modelos populares como Llama e Mistral, que você pode baixar diretamente pelo aplicativo.

Melhores recursos do GPT4All

- Inicie um servidor API local (compatível com OpenAI) para usar modelos GPT4All em outros aplicativos e automações.

- Pesquise, compare e baixe modelos GGUF dentro do aplicativo, com opções de classificação como curtidas, downloads e data de upload.

- Ajuste o comprimento do contexto, o comprimento máximo de saída, top-p, top-k, penalidade de repetição, threads da CPU e até mesmo descarregamento da camada da GPU (além do suporte a Metal no Apple Silicon).

Limitações do GPT4All

- O desempenho depende muito do hardware do seu computador.

- A indexação de grandes coleções de documentos pode ser lenta.

Preços do GPT4All

- Aplicativo gratuito para desktop

- Negócio: US$ 40 por usuário por mês (Nomic AI)

- Empresa: Preços personalizados (Nomic AI)

Avaliações e comentários do GPT4All

- G2: Não há avaliações suficientes

- Capterra: Não há avaliações suficientes

O que os usuários reais estão dizendo sobre o GPT4All?

Um usuário do Reddit diz:

Este é o melhor que já experimentei com RAG, supera todos os outros e até mesmo o LM Studio em termos de simplicidade. Gosto da forma como ele é mapeado para uma pasta e rastreia e gerencia as alterações para você. Ainda está em fase inicial de desenvolvimento, como os demais, mas será minha opção padrão no curto prazo.

Este é o melhor que já experimentei com RAG, supera todos os outros e até mesmo o LM Studio em termos de simplicidade. Gosto da forma como ele é mapeado para uma pasta e rastreia e gerencia as alterações para você. Ainda está em fase inicial de desenvolvimento, como os demais, mas será minha opção padrão no curto prazo.

📮 ClickUp Insight: 88% dos participantes da nossa pesquisa utilizam IA para suas tarefas pessoais, mas mais de 50% evitam utilizá-la no trabalho. Quais são as três principais barreiras? Falta de integração perfeita, lacunas de conhecimento ou preocupações com segurança. Mas e se a IA fosse incorporada ao seu espaço de trabalho e já fosse segura? ClickUp Brain,

O assistente de IA integrado do ClickUp torna isso realidade. Ele entende comandos em linguagem simples, resolvendo as três preocupações relacionadas à adoção da IA, ao mesmo tempo em que conecta seu chat, tarefas, documentos e conhecimento em todo o espaço de trabalho. Encontre respostas e insights com um único clique!

3. LM Studio (Ideal para uma bancada de trabalho offline aperfeiçoada com ajuste de desempenho)

via LM Studio

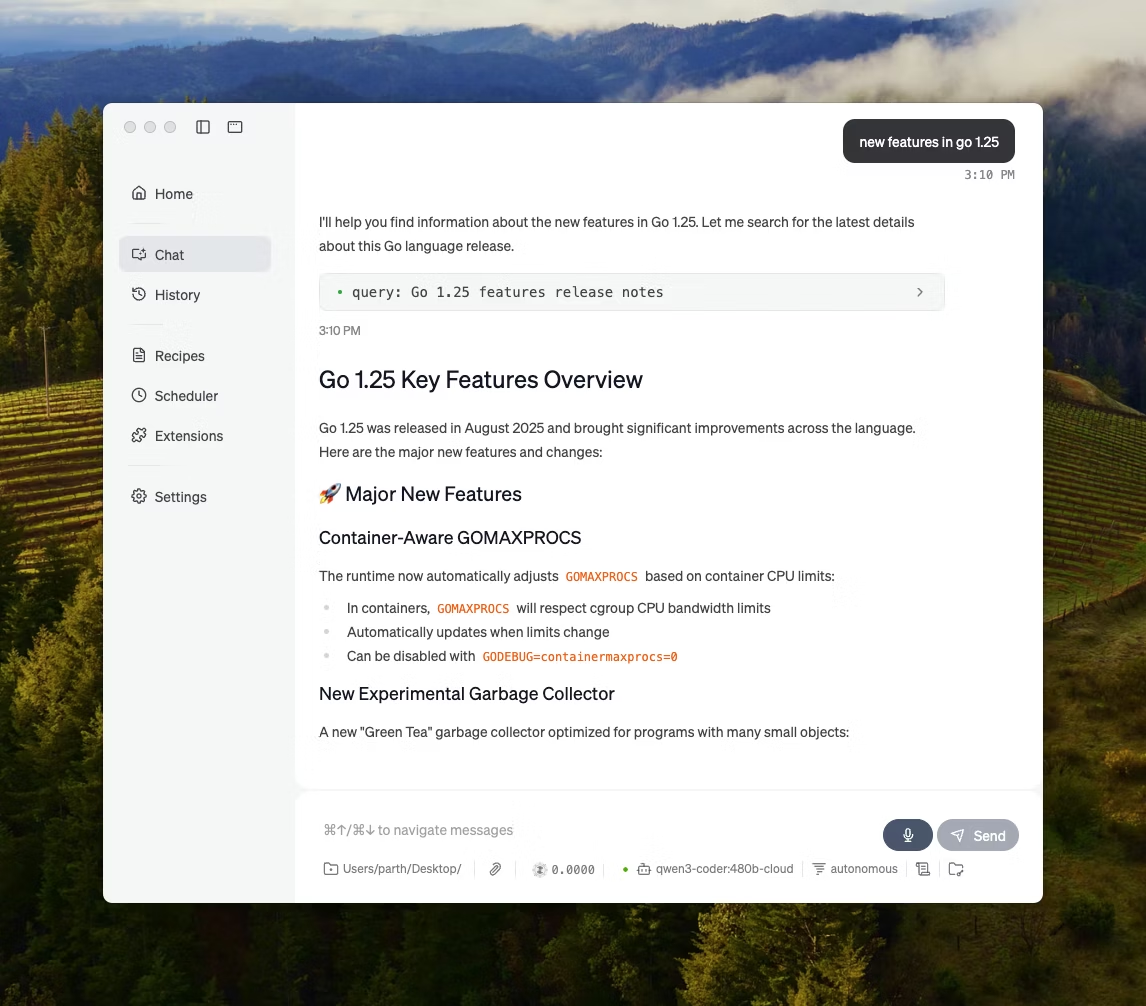

O LM Studio é um aplicativo local de IA para desktop desenvolvido para localizar, testar e executar modelos de código aberto em uma interface de usuário, sem a necessidade de usar um terminal. Ele é voltado para experimentação, como escolher um modelo, executá-lo localmente e iterar em prompts e configurações com um ciclo de feedback mais restrito do que a maioria das configurações que priorizam a CLI.

Ele também oferece suporte ao bate-papo com documentos totalmente offline (RAG local), onde você anexa arquivos a uma conversa e os referencia durante as respostas. Isso o torna ideal para pesquisas offline, notas de estudo ou fluxos de trabalho de documentos internos onde uploads não são uma opção.

O LM Studio também oferece controle detalhado sobre como a IA funciona, com opções para ajustar a temperatura, o comprimento do contexto e o uso da GPU.

Melhores recursos do LM Studio

- Use o modo de compatibilidade OpenAI ou a API REST do LM Studio, dependendo do que seu aplicativo espera.

- O LM Studio oferece opções de SDK em JavaScript e Python para criar fluxos de trabalho locais com base em seus modelos.

- Salve um prompt do sistema + parâmetros como uma predefinição e reutilize-o em chats (as predefinições também podem ser importadas de um arquivo/URL e publicadas para compartilhamento através do LM Studio Hub).

Limitações do LM Studio

- O LM Studio pode travar o computador durante a execução do DeepSeek R1 32B.

- Alguns usuários sinalizam o aplicativo como uma preocupação em termos de segurança de dados e privacidade devido ao código-fonte fechado não auditado.

Preços do LM Studio

- Gratuito para uso doméstico e profissional

Avaliações e comentários sobre o LM Studio

- G2: Não há avaliações suficientes

- Capterra: Não há avaliações suficientes

O que os usuários reais estão dizendo sobre o LM Studio?

Um usuário do Reddit diz:

É ótimo. Funciona muito bem, é super fácil de configurar e começar a usar. Tem a interface de usuário mais bonita entre todos os concorrentes.

É ótimo. Funciona muito bem, é super fácil de configurar e começar a usar. Tem a interface de usuário mais bonita entre todos os concorrentes.

4. Ollama (Ideal para executar LLMs locais com uma CLI simples + servidor local)

O Ollama é um executor de modelos local que se comporta mais como um tempo de execução LLM do que como um aplicativo de bate-papo independente. Ele é voltado para terminais, projetado para extrair e executar modelos abertos com comandos rápidos (como ollama run llama3) e, em seguida, expô-los por meio de um serviço local no qual outras interfaces podem se basear.

A força do Ollama reside na sua API REST. Quando o Ollama está em execução em segundo plano, qualquer aplicativo pode se comunicar com ele por meio de solicitações HTTP simples. Isso ajuda a incorporar recursos de IA ao seu próprio software.

O Ollama também oferece uma biblioteca de modelos populares que podem ser baixados com um único comando, e você pode criar configurações de modelos personalizadas, que são como Dockerfiles para IA.

Melhores recursos do Ollama

- Crie receitas de modelos reutilizáveis e versionáveis (seleção de modelo base, modelos de prompt, mensagens do sistema, parâmetros, adaptadores) usando um Modelfile.

- Execute modelos por meio de pontos finais como chat/gerar com streaming opcional para saída de token em tempo real em aplicativos e scripts

- Gere embeddings para pipelines de pesquisa e recuperação semânticas usando o recurso de embeddings do Ollama e os modelos de embedding recomendados.

Limitações do Ollama

- Não possui interface gráfica integrada, portanto, usuários sem conhecimentos técnicos precisarão de uma ferramenta front-end separada.

- O aplicativo para desktop macOS da Ollama pode deixar de responder enquanto estiver offline, mesmo quando os modelos já estiverem baixados, enquanto a CLI continua funcionando.

Preços do Ollama

- Gratuito

- Prós: US$ 20/mês

- Máximo: $100/mês

Avaliações e comentários sobre Ollama

- G2: Não há avaliações suficientes

- Capterra: Não há avaliações suficientes

O que os usuários reais estão dizendo sobre o Ollama?

Um crítico do Producthunt afirma:

Fácil de implementar e gerenciar. O Ollama facilita muito a execução de LLMs locais. Combine-o com o OpenWebUI para obter a melhor experiência possível.

Fácil de implementar e gerenciar. O Ollama facilita muito a execução de LLMs locais. Combine-o com o OpenWebUI para obter a melhor experiência possível.

🧠 Curiosidade: A conversão de voz em texto começou apenas com “dígitos”. O AUDREY (1952) da Bell Labs reconhecia os dígitos de 0 a 9, e um relato observa que ele funcionava melhor quando falado por seu inventor.

5. Jan. ai (Ideal para um assistente offline do tipo ChatGPT que prioriza a privacidade)

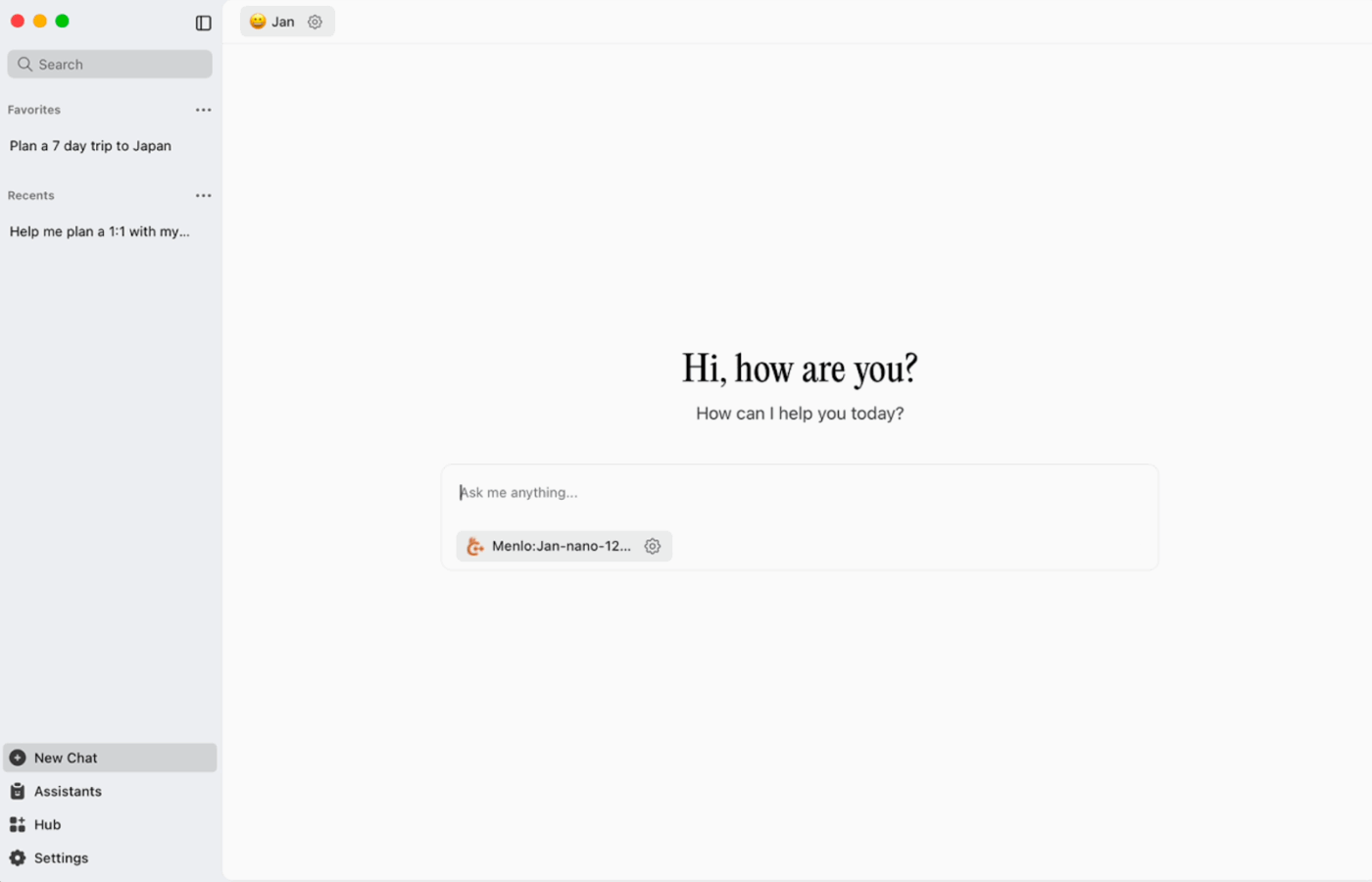

O Jan. ai é um assistente de desktop de código aberto que oferece uma experiência de chat semelhante ao ChatGPT para macOS, Windows e Linux, com uso local como padrão. Ele é executado no dispositivo quando você deseja, enquanto o histórico de conversas e os dados de uso são armazenados localmente e não saem do seu computador.

Ele suporta a execução de modelos de código aberto localmente e também permite conexões opcionais com provedores remotos, como APIs compatíveis com OpenAI, o que o torna flexível quando o uso offline é a prioridade, mas o acesso à nuvem às vezes é necessário.

Jan. ai melhores recursos

- Crie assistentes com suas próprias instruções e configurações e, em seguida, alterne entre eles na guia Assistentes, em vez de reescrever as instruções a cada vez.

- Conecte o Jan às ferramentas MCP e fontes de dados usando um padrão aberto criado para fluxos de trabalho do tipo uso de ferramentas.

- Instale extensões para adicionar novos recursos, como pesquisa na web ou um interpretador de código. Essa abordagem modular permite que você comece de forma simples e adicione mais recursos à medida que avança.

Limitações da IA em janeiro

- O Jan pode permitir o carregamento de um arquivo de modelo que ainda não foi totalmente baixado, o que pode criar um comportamento confuso ou inconsistente até que o arquivo esteja completo.

- Ativar a API pode interferir nos chats em thread, e endpoints básicos como “obter modelo carregado” ou “trocar modelo” podem não funcionar corretamente.

Preços da IA em janeiro

- Código aberto

Avaliações e comentários da Jan. ai

- G2: Não há avaliações suficientes

- Capterra: Não há avaliações suficientes

O que os usuários reais estão dizendo sobre o Jan. ai?

Um usuário do Reddit diz:

Jan. ai é o meu aplicativo LLM local preferido. É ótimo.

Jan. ai é o meu aplicativo LLM local preferido. É ótimo.

6. Llamafile (Ideal para empacotar um LLM em um arquivo executável portátil)

O Llamafile é um projeto liderado pela Mozilla que reúne um LLM totalmente open-source em um único arquivo executável. Em vez de instalar um runtime, gerenciar dependências ou conectar uma interface de usuário separada, você baixa um arquivo e o executa como um aplicativo.

A ideia central é a distribuição. Um “llamafile” inclui os pesos do modelo e um tempo de execução compilado, criado para funcionar em vários sistemas operacionais com configuração mínima. É especialmente útil quando uma ferramenta offline precisa ser compartilhada com colegas de equipe, alunos ou clientes que não vão resolver problemas de instalação.

Principais recursos do Llamafile

- O Llamafile combina o llama.cpp com o Cosmopolitan Libc para oferecer ampla portabilidade binária, reduzindo o trabalho de empacotamento específico da plataforma.

- O modo servidor oferece uma interface gráfica de usuário (GUI) na web e um endpoint de conclusões compatível com a API OpenAI, útil para o desenvolvimento de aplicativos locais e a substituição de chamadas na nuvem durante os testes.

- Os arquivos lamafiles empacotados são projetados para serem executados em máquinas x86_64 e ARM64 comuns, o que simplifica a distribuição em frotas mistas.

Limitações do Llamafile

- A seleção de modelos é limitada ao que foi empacotado como um Llamafile.

- Os tamanhos dos arquivos são muito grandes, pois todo o modelo está incorporado.

Preços do Llamafile

- Gratuito e de código aberto

Avaliações e comentários do Llamafile

- G2: Não há avaliações suficientes

- Capterra: Não há avaliações suficientes

🧠 Curiosidade: O primeiro site ainda pode ser visitado. O CERN o hospeda literalmente em info.cern.ch, chamando-o de “lar do primeiro site”.

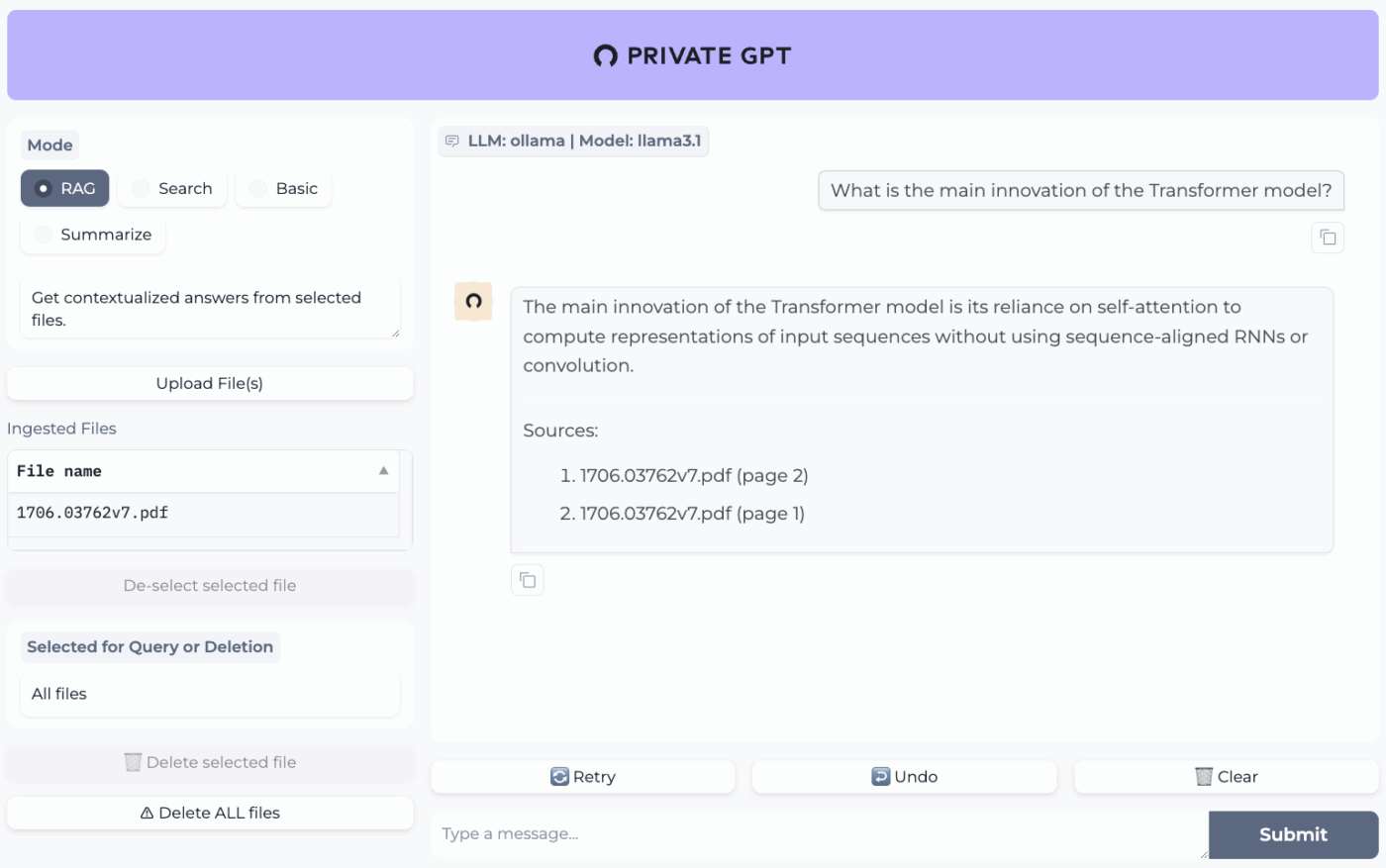

7. PrivateGPT (Ideal para perguntas e respostas offline sobre seus arquivos com uma pilha RAG auto-hospedada)

O PrivateGPT é um projeto pronto para produção e auto-hospedado, criado para fluxos de trabalho do tipo “converse com seus documentos”. Ele ingere arquivos locais, indexa-os e responde a perguntas recuperando o contexto relevante do seu próprio conteúdo, em vez de depender da memória de um chatbot na nuvem. O projeto foi projetado para funcionar totalmente offline, com a garantia de que os dados permanecem dentro do seu ambiente de execução.

O que o diferencia dos aplicativos de bate-papo offline de uso geral é a arquitetura modular. Em outras palavras, você pode misturar e combinar o LLM, o provedor de incorporação e o armazenamento vetorial com base em suas restrições de hardware e privacidade e, em seguida, executar tudo por meio de uma API + UI local.

Melhores recursos do PrivateGPT

- Ingira PDFs, DOCX, PPT/PPTX/PPTM, CSV, EPUB, Markdown, JSON, MBOX, IPYNB, imagens (JPG/PNG/JPEG) e até mesmo MP3/MP4 usando o pipeline de ingestão integrado.

- Configure perfis de camada com PGPT_PROFILES (por exemplo, local, cuda) para mesclar vários arquivos de configuração e alternar entre implantações sem reescrever sua configuração base.

- Filtre as respostas para um subconjunto específico de documentos inseridos usando o filtro de contexto ao chamar pontos finais de preenchimento contextual.

Limitações do PrivateGPT

- Tem requisitos de hardware mais elevados devido à execução simultânea de vários componentes.

- A ingestão de vários documentos a partir de um único arquivo (por exemplo, um PDF que gera um documento por página) pode aumentar o volume e a complexidade da indexação ao gerenciar uploads grandes.

Preços do PrivateGPT

- Código aberto

Avaliações e comentários do PrivateGPT

- G2: Não há avaliações suficientes

- Capterra: Não há avaliações suficientes

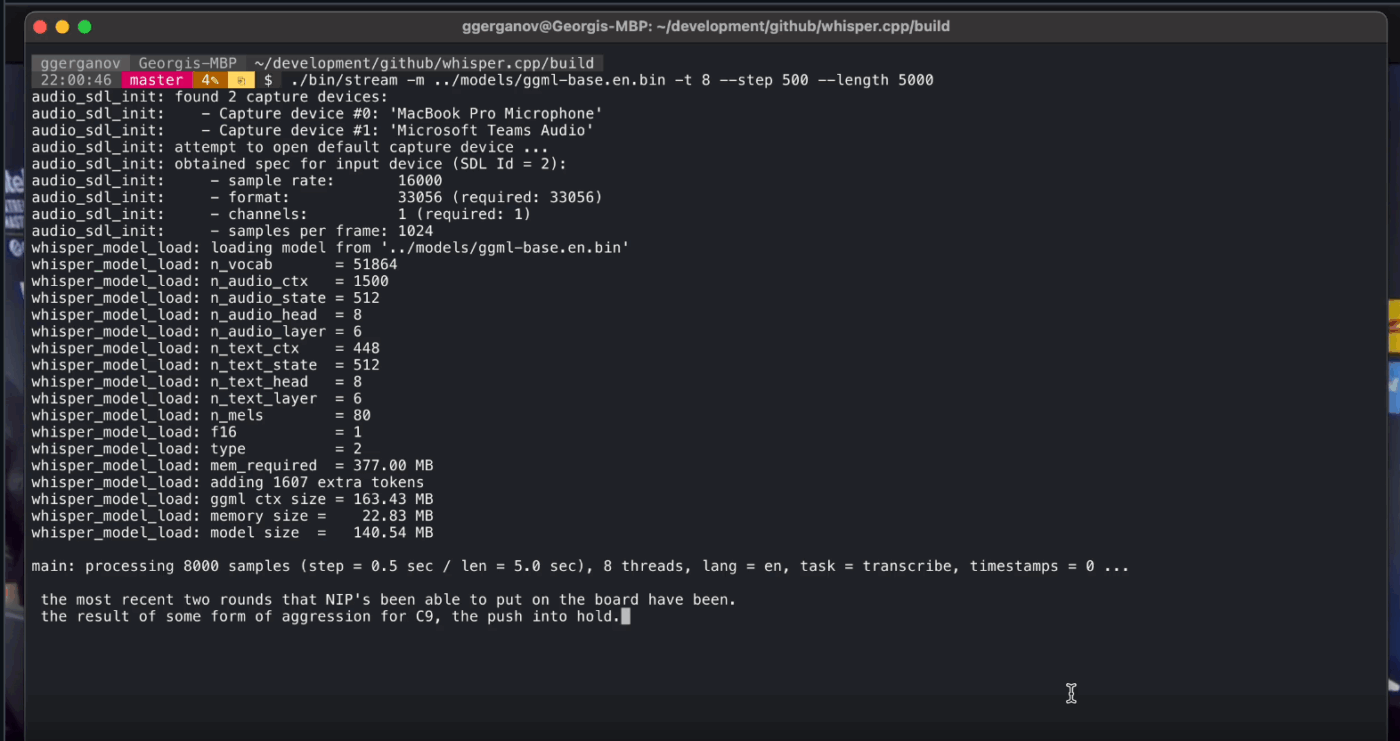

8. Whisper. cpp (Ideal para conversão de voz em texto totalmente offline que você pode incorporar em aplicativos)

Whisper. cpp é uma implementação C/C++ de alto desempenho do modelo de reconhecimento automático de fala Whisper da OpenAI, criado para ser executado localmente sem dependências de tempo de execução pesadas. É popular para pipelines de transcrição offline, nos quais você deseja um binário pequeno e portátil ou uma biblioteca no estilo C que possa enviar dentro do seu próprio produto.

Ele também é flexível em todos os ambientes, com suporte oficial para desktop, dispositivos móveis, WebAssembly, Docker e até mesmo hardware da classe Raspberry Pi, o que o torna adequado para ferramentas offline que precisam ser executadas em mais de um lugar.

O “cpp” em seu nome significa seu foco no desempenho. Essa implementação é significativamente mais rápida e usa menos memória do que as alternativas baseadas em Python, tornando possível a transcrição em tempo real em computadores modernos sem a necessidade de uma GPU potente.

Whisper. cpp melhores recursos

- Execute a Detecção de Atividade de Voz (VAD) como parte do projeto para segmentar a fala e reduzir transcrições com ruído e áudio vazio em fluxos de trabalho do tipo streaming.

- Quantize modelos Whisper para reduzir os requisitos de disco e memória, com várias opções de quantização projetadas para uma inferência local mais rápida.

- Compile com suporte opcional ao FFmpeg no Linux para lidar com mais formatos de entrada além do caminho básico apenas para WAV.

Limitações do Whisper.cpp

- A CLI do Whisper.cpp espera entradas WAV de 16 bits por padrão, o que adiciona uma etapa extra de conversão ao trabalhar com MP3, MP4, M4A ou outros formatos comuns.

- Ele não identifica os locutores de forma nativa (diarização), o que dificulta a atribuição correta das citações em gravações com vários locutores.

Preços do Whisper. cpp

- Código aberto

Whisper. Avaliações e comentários sobre cpp

- G2: Não há avaliações suficientes

- Capterra: Não há avaliações suficientes

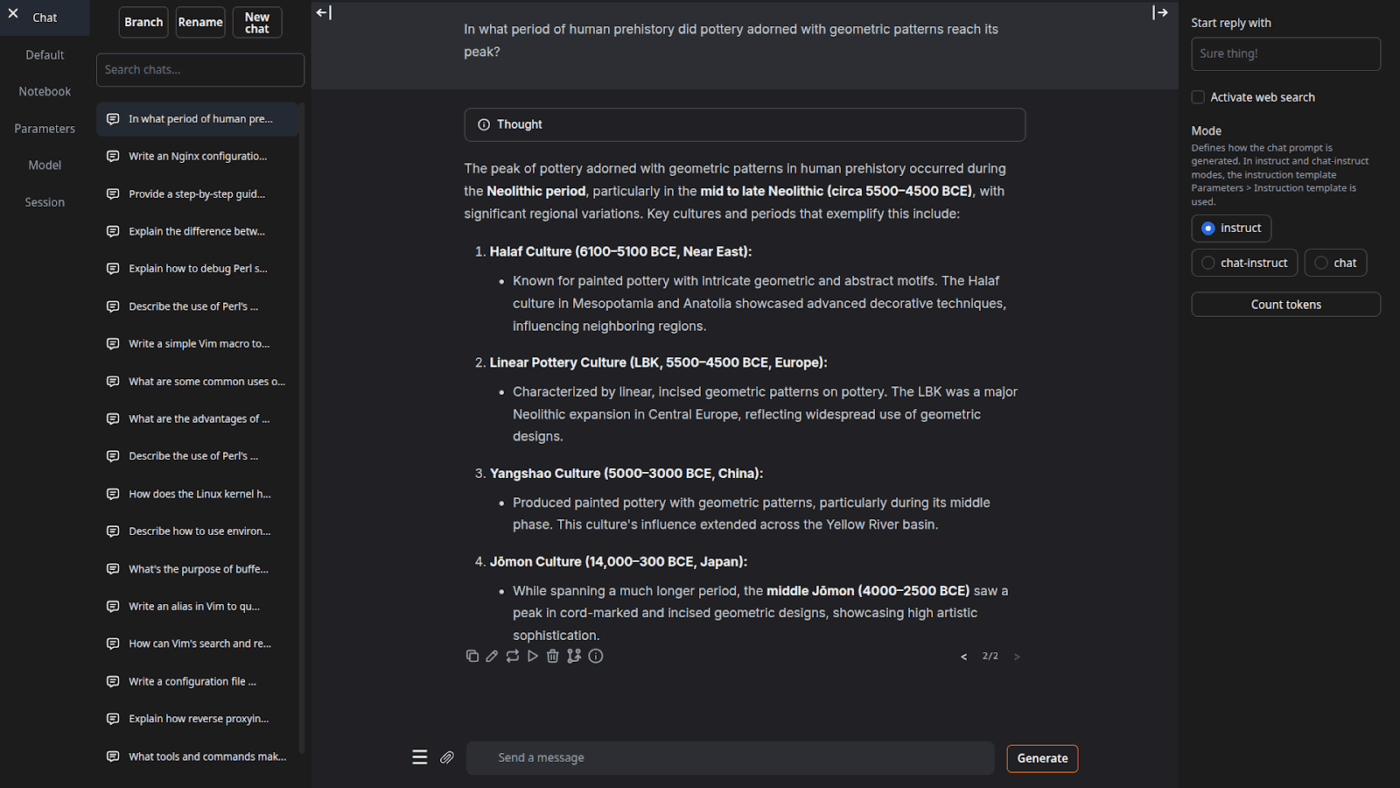

9. Interface de usuário da Web para geração de texto (ideal para usuários que desejam um cockpit baseado em navegador para LLMs locais)

A Text Generation Web UI (frequentemente chamada de “oobabooga”) é uma interface web baseada em Gradio para executar modelos locais com grande ênfase no controle e na experimentação. Ela se comporta mais como uma bancada de trabalho completa: vários backends de modelo, vários modos de interação e muitos botões para o comportamento de geração.

Ele também se inclina para fluxos de trabalho de “escritor/desenvolvedor” que muitas ferramentas offline ignoram, com recursos como automação de formato de prompt, geração no estilo notebook e ramificação de conversas. Para configurações offline que ainda precisam de uma interface de usuário da web, é um dos front-ends mais configuráveis nesta categoria.

Melhores recursos da interface do usuário da Web para geração de texto

- Formatação automática de prompts usando modelos Jinja2, reduzindo erros de formatação de prompts em diferentes famílias de modelos

- Ajuste dezenas de configurações para otimizar a produção da IA de acordo com suas necessidades específicas, seja para escrita criativa, programação ou interpretação de papéis.

- Edição de mensagens com navegação por versão e ramificação de conversas, mantendo várias direções do mesmo chat sem precisar recomeçar

Limitações da interface do usuário da Web para geração de texto

- O instalador com um clique requer cerca de 10 GB de espaço em disco e baixa o PyTorch, o que torna a configuração pesada em máquinas com armazenamento limitado.

- O endpoint de embeddings compatível com OpenAI usa sentence-transformers/all-mpnet-base-v2 com embeddings de 768 dimensões, o que pode quebrar as premissas em pipelines construídos em torno dos padrões de 1536 dimensões da OpenAI.

Preços da interface do usuário da Web para geração de texto

- Código aberto

Avaliações e comentários sobre a interface do usuário da Web para geração de texto

- G2: Não há avaliações suficientes

- Capterra: Não há avaliações suficientes

10. Llama.cpp (Ideal para inferência LLM local de alto desempenho em CPU e GPU)

Llama. cpp é um mecanismo de inferência C/C++ e um conjunto de ferramentas para executar LLMs localmente com dependências mínimas e forte desempenho em uma ampla gama de hardware. É menos um “aplicativo de bate-papo” e mais um tempo de execução local onde você cria fluxos de trabalho, seja uma CLI, um servidor HTTP local ou uma biblioteca incorporada dentro do seu próprio produto.

Embora não seja um aplicativo para o usuário final, o Llama.cpp é o mecanismo que alimenta muitas das ferramentas desta lista, incluindo o GPT4All e o LM Studio. Ele introduziu o formato de modelo GGUF, que se tornou o padrão para executar modelos grandes em hardware de consumo, reduzindo eficientemente seu tamanho.

Ele também oferece ligações para linguagens de programação populares, como Python e Rust, e seu modo servidor pode fornecer uma API compatível com OpenAI.

Llama. cpp melhores recursos

- Inicie um servidor local compatível com a API OpenAI com uma interface de usuário web integrada e um endpoint /v1/chat/completions usando o llama-server.

- Execute um modelo de incorporação (e até mesmo um modelo de reclassificação) a partir do mesmo servidor para pipelines RAG offline usando /embedding e /reranking.

- Quantize modelos de 1,5 bits a 8 bits para reduzir o uso de memória e acelerar a inferência local, depois acelere as execuções com back-ends CUDA/Metal e Vulkan/SYCL, quando disponíveis.

Limitações do Llama.cpp

- O Llama.cpp não é fornecido como um assistente de desktop aperfeiçoado, o que significa que o uso offline geralmente envolve comandos CLI ou hospedagem do llama-server, e muitos usuários dependem de interfaces de usuário de terceiros para bate-papos diários.

- A compatibilidade do Llama.cpp com o OpenAI nem sempre é 1:1 com todos os recursos do cliente OpenAI, e os usuários relatam incompatibilidades em torno de parâmetros de saída estruturados, como response_format em /v1/chat/completions.

Preços do Llama.cpp

- Código aberto

O que os usuários reais estão dizendo sobre o Llama. cpp?

Um revisor do Sourceforge afirma:

Fantástico. Democratizando a IA para todos. E funciona muito bem!

Fantástico. Democratizando a IA para todos. E funciona muito bem!

Transforme resultados de IA offline em trabalho real com o ClickUp

Escolher a ferramenta de IA offline certa significa, na verdade, adequar a ferramenta à tarefa.

Se você está aqui, provavelmente está buscando otimizar três coisas: privacidade, independência da internet e liberdade de não ficar preso a mais uma assinatura.

As ferramentas desta lista atendem a essa necessidade de diferentes maneiras. Ou seja, algumas são melhores para escrever e programar, outras para pesquisar, fazer anotações ou trabalhos criativos.

Mas, para as equipes, o maior desafio não é apenas executar a IA localmente. É transformar os resultados da IA em fluxos de trabalho reais.

Com a capacidade de IA do ClickUp integrada às suas tarefas, documentos e conhecimento, você pode facilmente revelar os próximos passos no mesmo local onde o trabalho é realizado (tudo com segurança de nível empresarial).

Experimente o ClickUp gratuitamente e veja como é quando a IA e a execução finalmente coexistem. ✨

Perguntas frequentes sobre ferramentas de IA offline

Sim, após o download inicial dos arquivos do modelo, muitas ferramentas de IA podem ser executadas inteiramente no seu dispositivo, sem necessidade de conexão com a internet. Isso as torna perfeitas para lidar com dados confidenciais ou trabalhar em locais com conectividade ruim.

Os LLMs locais processam todos os dados no seu dispositivo pessoal, de modo que suas informações nunca saem da sua máquina, enquanto a IA baseada em nuvem envia suas solicitações para servidores remotos para processamento. As ferramentas locais geralmente são gratuitas após a configuração, enquanto a IA em nuvem geralmente envolve taxas de assinatura, mas pode oferecer modelos mais poderosos.

Modelos menores, com 1 a 3 bilhões de parâmetros, podem ser executados na maioria dos laptops modernos com 8 GB de RAM. Modelos maiores e mais potentes, com 7 bilhões ou mais de parâmetros, têm melhor desempenho com 16 GB ou mais de RAM e uma GPU dedicada, com os Macs Apple Silicon e as GPUs NVIDIA proporcionando aumentos significativos de desempenho.

![As 10 melhores ferramentas de IA que funcionam offline em [ano]](https://clickup.com/blog/wp-content/uploads/2026/01/image-1298.png)