La maggior parte dei team testa gli strumenti di riassunto LLM fornendo loro un documento campione e considerandolo terminato. Il modello che funziona alla perfezione con i tuoi rapporti trimestrali potrebbe rovinare le tue conversazioni su Slack, mentre quello perfetto per le memorie legali potrebbe distorcere i fatti contenuti nelle email dei tuoi clienti.

Questa guida ti illustra i migliori LLM per la riepilogazione/riassunzione di testi, come valutarli in base al tuo carico di lavoro effettivo e come effettuare la connessione diretta tra i riassunti e le azioni nel tuo flusso di lavoro.

Panoramica dei modelli di riepilogo LLM

| Modello | Ideale per | Funzionalità migliori | Prezzi |

|---|---|---|---|

| ClickUp Brain | Teams che desiderano riassumere direttamente all'interno del proprio flusso di lavoro Dimensione del team: qualsiasi team che utilizza ClickUp per progetti e comunicazione | Riepiloghi sensibili all'area di lavoro, riepiloghi delle riunioni con IA Notetaker, creazione di azioni da intraprendere, instradamento multi-LLM, ricerca in linguaggio naturale. | Gratis per sempre; personalizzazione disponibile per le aziende. |

| OpenAI GPT-4o | Sintesi raffinate e pronte per i dirigenti Dimensione del team: team di piccole e grandi dimensioni che necessitano di risultati di riepilogo di alta qualità | Riepiloghi/riassunti simili a quelli umani, supporto multimodale, forte capacità di seguire le istruzioni, ampia finestra contestuale. | API pay-per-token, ChatGPT Plus 20 $/mese |

| Claude 3. 5 Sonnet | Documenti sensibili dal punto di vista della conformità o altamente tecnici Dimensione del team: team legali, finanziari, dell'azienda | Finestra di contesto estesa, bassa allucinazione, ottimo controllo del formato, ragionamento solido. | API pay-per-token, sottoscrizione Claude Pro |

| Google Gemini 1. 5 Pro | Teams che lavorano intensamente in Google WorkspaceDimensione del team: team operativi, di ricerca e con un elevato numero di riunioni | Finestra contestuale fino a 1 milione di token, integrazione con Google Meet e Drive, sintesi multimodale. | Prezzi basati sull'utilizzo tramite Google IA Studio o Vertex AI |

| Meta LLaMA 3 | Pipeline di riassunto self-hosted e personalizzabili Dimensione del team: team guidati da ingegneri e incentrati sulla privacy | Completamente self-hosted, capacità di fine-tuning, elevata qualità di riassunto, controllo completo dei dati. | Pesi open source gratis, si applicano i costi di infrastruttura |

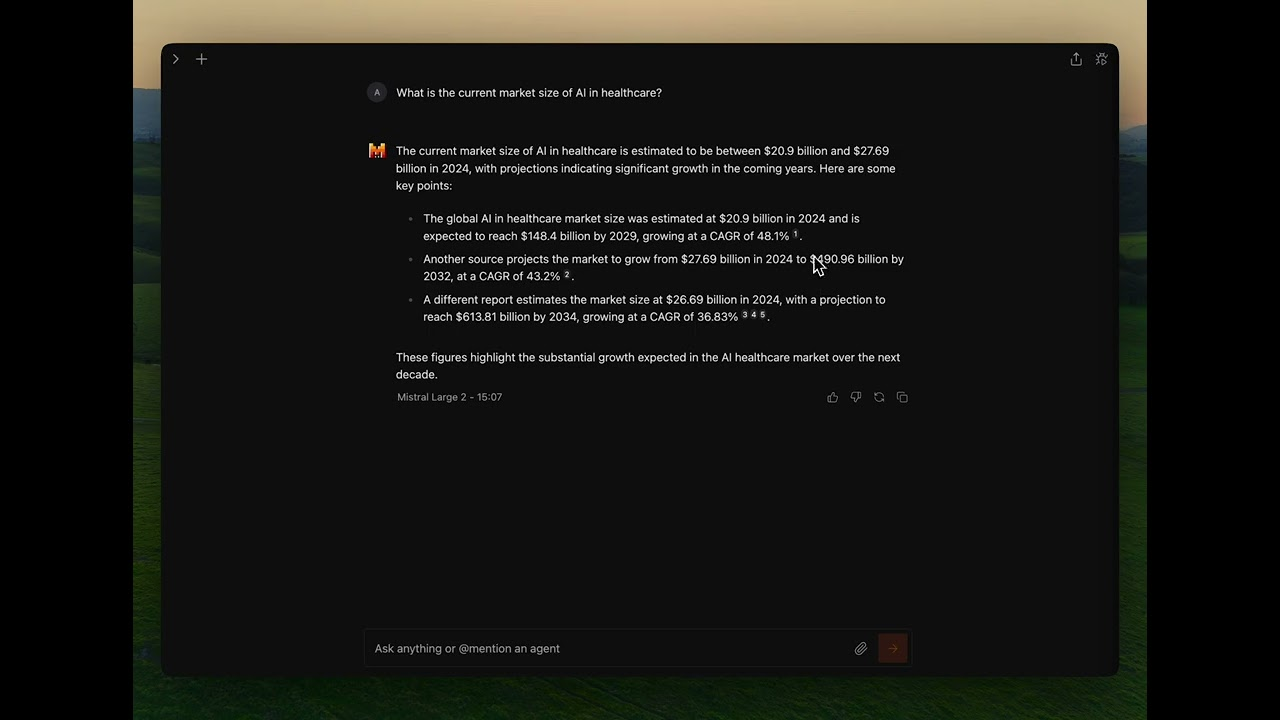

| Mistral Large | Teams che necessitano di residenza dei dati nell'Unione europea e implementazione ibrida Dimensione del team: aziende dell'Unione europea o organizzazioni orientate alla conformità | API ibrida gestita o self-hosted, elevata qualità di riassunto, uso efficiente dei token | Prezzi API competitivi, pesi aperti disponibili |

Come valutiamo il software su ClickUp

Il nostro team editoriale segue un processo trasparente, supportato da ricerche e indipendente dai fornitori, quindi puoi fidarti che i nostri consigli si basano sul valore reale dei prodotti.

Ecco una panoramica dettagliata di come valutiamo il software in ClickUp.

Cosa cercare in un LLM per il riassunto?

Scegliere il modello di riepilogo sbagliato comporta uno spreco di denaro in API poco intuitive, difficoltà con configurazioni complesse o semplicemente riepiloghi/riassunti di bassa qualità che non sono utili. Prima di approfondire i modelli specifici, capire cosa distingue un riepilogo efficace da un output generico ti aiuta a fare una scelta più intelligente.

Gestisce i tuoi tipi di documenti reali

Un modello eccellente nel riassumere articoli di ricerca potrebbe avere difficoltà con le conversazioni su Slack o le trascrizioni delle riunioni. Cerca LLM che siano stati testati sui tipi di documenti specifici con cui il tuo team lavora quotidianamente, che si tratti di contratti legali, email dei clienti, documentazione tecnica o note delle riunioni.

Offre una finestra contestuale sufficiente

La finestra di contesto determina la quantità di testo che il modello è in grado di elaborare in un unico passaggio. Se stai riepilogando trascrizioni di riunioni di un'ora o lunghi rapporti di ricerca, hai bisogno di un modello con una finestra di contesto estesa. Altrimenti, dovrai suddividere i documenti in blocchi e perderai la coerenza che deriva dall'elaborazione di tutto il testo insieme.

Equilibrio tra velocità e qualità

Alcuni modelli danno priorità alla velocità di inferenza, mentre altri ottimizzano la qualità dell'output. Per la sintesi in tempo reale durante le riunioni, la velocità è più importante. Per la generazione di briefing esecutivi, la qualità ha la precedenza. Considera dove si collocano i tuoi casi d'uso in questo spettro.

Fornisce opzioni di accesso appropriate

Le risorse tecniche e i requisiti di sicurezza del tuo team dovrebbero guidarti nella scelta tra un'API gestita, un'implementazione self-hosted o un approccio ibrido. Le aziende con politiche rigorose in materia di dati potrebbero richiedere opzioni on-premise, mentre i team più piccoli potrebbero preferire la comodità delle API cloud.

I 6 migliori LLM per la sintesi di testi

Il numero schiacciante di modelli disponibili rende difficile scegliere quello giusto. Ciascuno dei modelli riportati di seguito rappresenta un valido concorrente, ma quello "migliore" dipende interamente dalle esigenze specifiche del tuo team. Li valuteremo in base a accuratezza, dimensione della finestra contestuale, velocità e opzioni di accesso.

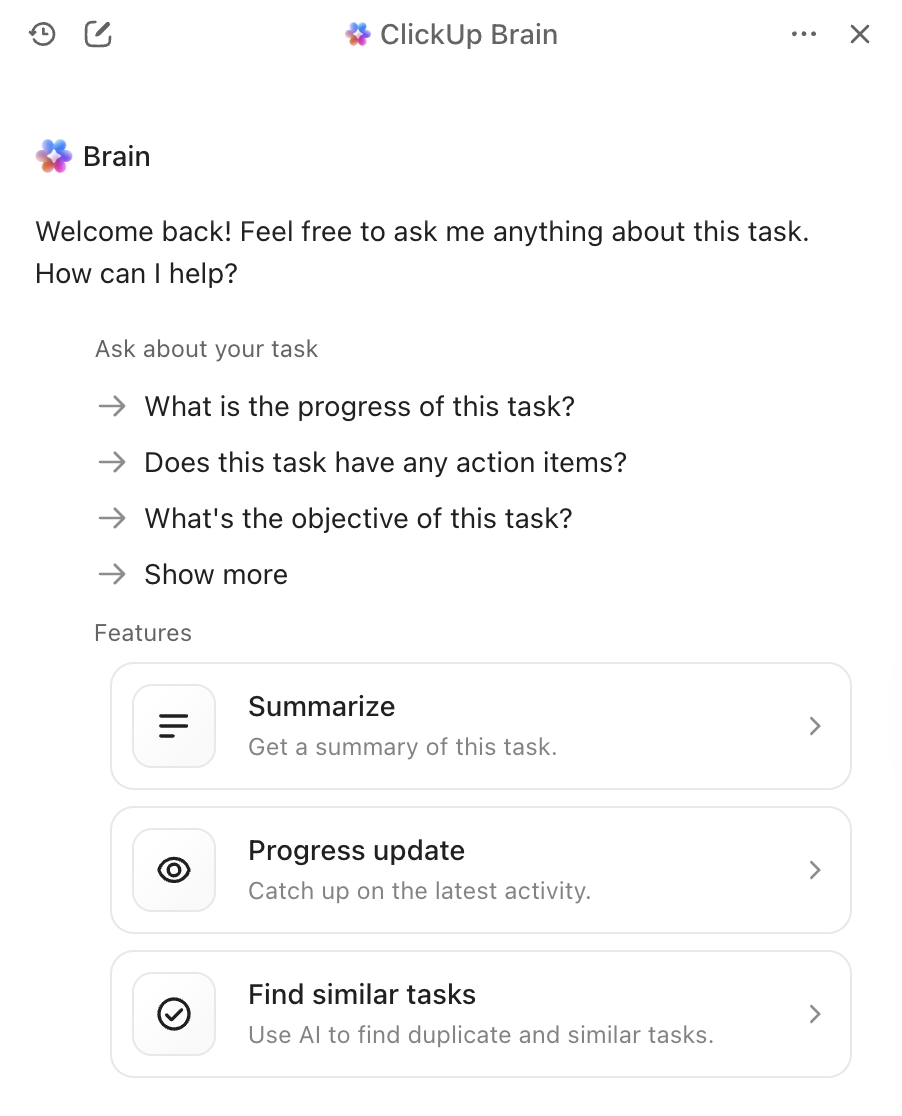

1. ClickUp Brain (ideale per la sintesi basata sull'IA all'interno del tuo flusso di lavoro)

Il problema principale degli strumenti di sintesi autonomi non è la qualità dei loro riassunti, ma ciò che accade dopo. Si genera un riassunto eccellente, poi lo si copia manualmente nello strumento di project management, si creano delle attività e si invia un messaggio al team sui passaggi successivi. ClickUp Brain elimina questo attrito integrando la sintesi direttamente nel flusso di lavoro.

Con ClickUp Brain, basta digitare @brain in qualsiasi commento relativo a un'attività o messaggio di ClickUp Chat e chiedergli di riepilogare il contesto. Fornisce immediatamente un riepilogo utilizzando la sua conoscenza del tuo spazio di lavoro, dando priorità all'attività o al canale specifico in cui ti trovi. Poiché Brain comprende i tuoi progetti, documenti e conversazioni, i suoi riepiloghi sono immediatamente utilizzabili, invece di essere testi isolati che devi elaborare manualmente.

Le migliori funzionalità di ClickUp Brain

- Riassume attività, documenti, thread di chat e registrazioni di riunioni senza uscire dalla tua area di lavoro.

- Sfrutta più LLM dietro le quinte per ottenere risultati ottimali senza dover gestire la selezione dei modelli.

- Converte i riassunti direttamente in attività con assegnatari e date di scadenza

- Comprende il contesto dell'area di lavoro per fornire riepiloghi/riassunti più pertinenti e fruibili.

- Si integra con ClickUp AI Notetaker per acquisire e riassumere automaticamente le riunioni.

Limiti di ClickUp Brain

- Per ottenere tutti i vantaggi è necessario lavorare all'interno dell'ecosistema ClickUp.

- Ideale per i flussi di lavoro di gruppo piuttosto che per l'elaborazione di singoli documenti.

Prezzi di ClickUp Brain

2. OpenAI GPT-4o (ideale per riepiloghi/riassunti raffinati e pronti per i dirigenti)

Quando hai bisogno di un riepilogo/riassunto raffinato, ricco di sfumature e pronto per la condivisione con i dirigenti, GPT-4o è la scelta migliore. Il suo punto di forza risiede nella sintesi astratta di alta qualità, che produce un testo che sembra scritto da un essere umano. L'ampia finestra contestuale e le capacità multimodali consentono di riepilogare testi provenienti da immagini o trascrizioni audio, non solo da documenti.

È possibile accedervi tramite un'API ampiamente disponibile, che ne facilita l'integrazione negli strumenti di IA esistenti per le riunioni. Il compromesso è che si tratta di un servizio proprietario con prezzi basati sull'utilizzo e che potresti notare un leggero ritardo durante il riassunto di documenti molto lunghi.

Le migliori funzionalità di GPT-4o

- Produce riepiloghi/riassunti astratti di qualità umana che richiedono una modifica minima.

- Gestisce input multimodali, inclusi immagini e trascrizioni audio.

- Offre una documentazione API completa e supporto per l'integrazione.

Limiti di GPT-4o

- I prezzi basati sull'utilizzo possono aumentare in caso di riassunto di grandi volumi.

- La latenza di inferenza aumenta con documenti molto lunghi

- Un modello proprietario comporta un minore controllo sulla gestione dei dati.

Prezzi di GPT-4o

- Accesso API con tariffazione pay-per-token

- Sottoscrizione ChatGPT Plus a 20 $ al mese per uso individuale

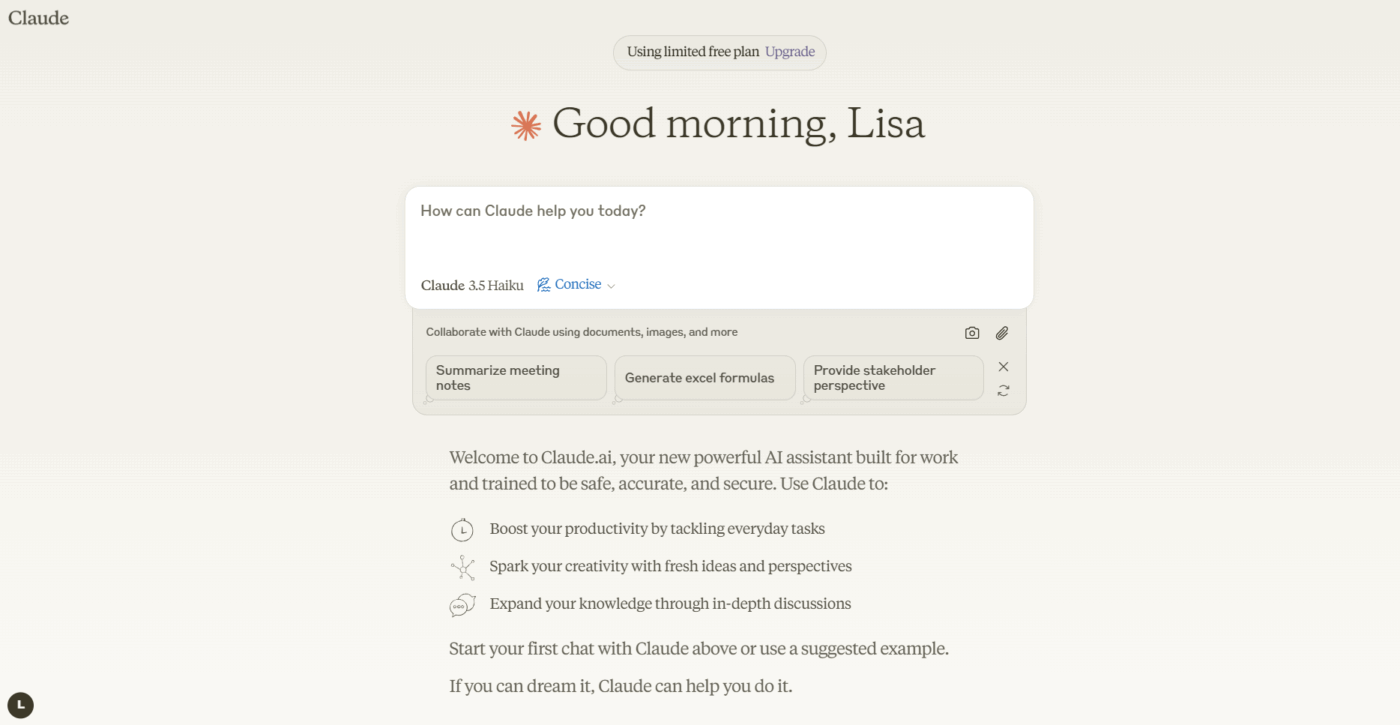

3. Anthropic Claude 3. 5 Sonnet (ideale per documenti sensibili in materia di conformità)

Se il tuo team ha a che fare con documenti altamente sensibili o complessi, Claude 3. 5 Sonnet è stato progettato pensando alle tue esigenze. Vanta una finestra di contesto estesa, che gli consente di elaborare e riepilogare interi rapporti di lunga durata in un unico passaggio. Ciò che lo distingue davvero è la sua capacità di seguire istruzioni sfumate: puoi richiedere un riepilogo/riassunto in un formato specifico, con un tono particolare o incentrato su determinati argomenti, e lui lo fornirà con elevata accuratezza.

La forte attenzione di Anthropic all'allineamento della sicurezza contribuisce a ridurre il rischio che il modello inventi fatti, una funzionalità fondamentale per i team attenti alla conformità che lavorano con documenti legali o finanziari. Per i team che già utilizzano strumenti di riassunto di documenti basati sull'IA, Claude si integra bene nei flussi di lavoro esistenti.

Claude 3. 5 Sonnet: le migliori funzionalità/funzioni

- La finestra di contesto estesa elabora interi report in un unico passaggio.

- Eccellente capacità di seguire le istruzioni per la formattazione personalizzata e i requisiti di tono

- Un forte allineamento alla sicurezza riduce il rischio di allucinazioni.

Limiti di Claude 3. 5 Sonnet

- Modello proprietario con variazioni di disponibilità a livello regionale

- Il prezzo delle API può essere significativo per un utilizzo su scala aziendale.

Prezzi di Claude 3. 5 Sonnet

- Accesso API con tariffazione pay-per-token

- Sottoscrizione Claude Pro disponibile per uso individuale

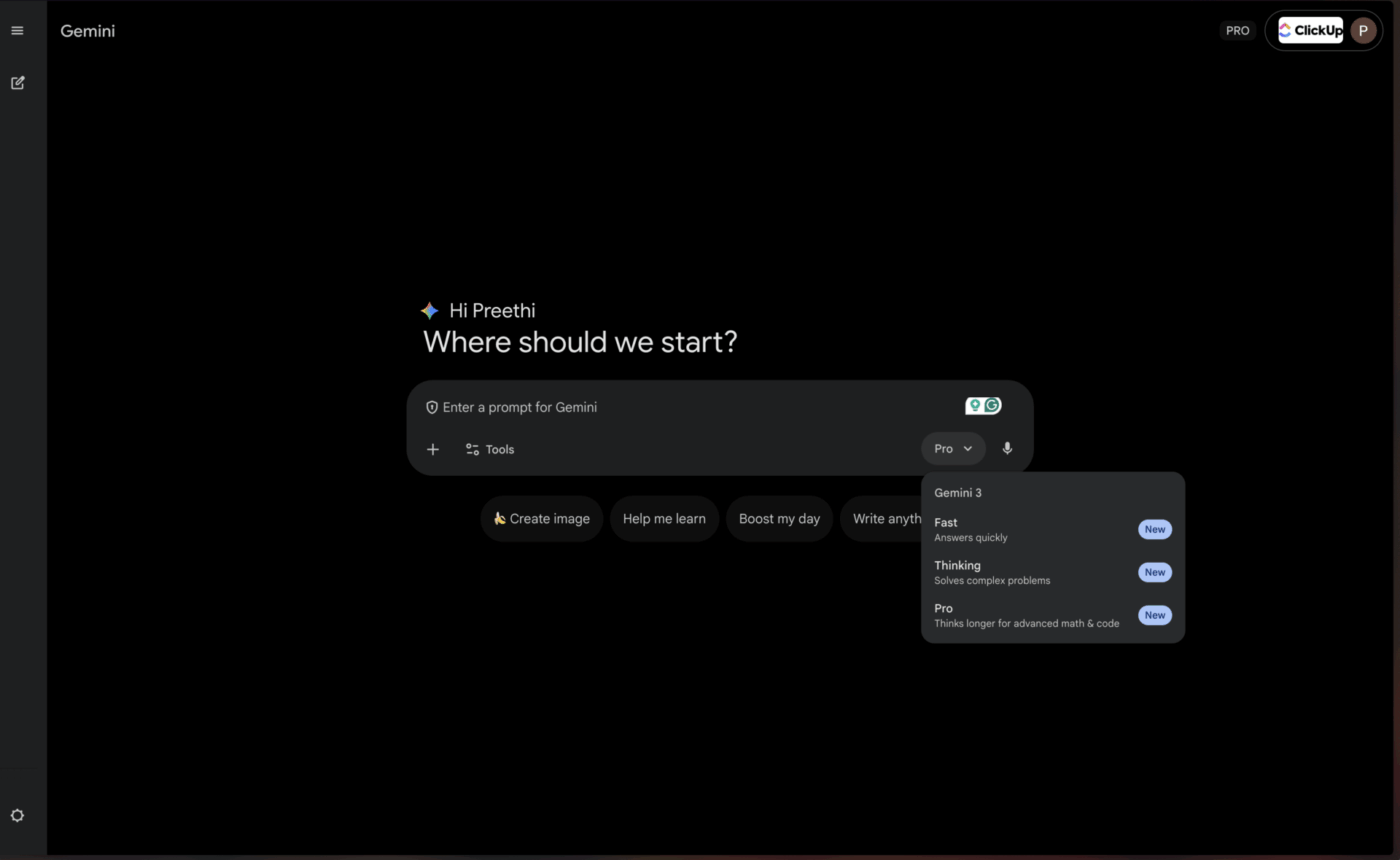

4. Google Gemini 1. 5 Pro (ideale per gli utenti di Google Workspace)

Per i team che già vivono e respirano nell'ecosistema Google, Gemini 1. 5 Pro offre un livello di praticità quasi imbattibile. Offre una delle finestre di contesto più grandi attualmente disponibili (fino a 1 milione di token), che lo rende perfetto per riepilogare le trascrizioni di riunioni di Google Meet o sintetizzare le informazioni provenienti da più documenti di ricerca archiviati in Google Drive.

L'integrazione nativa con Google Workspace ti consente di ottenere riassunti senza mai abbandonare gli strumenti che utilizzi quotidianamente. Ciò lo rende particolarmente prezioso per i team che fanno ampio uso dei sintetizzatori di riunioni basati sull'IA all'interno dell'ecosistema Google.

Le migliori funzionalità/funzioni di Gemini 1. 5 Pro

- Una finestra contestuale massiccia da 1 milione di token gestisce documenti estremamente lunghi.

- Integrazione nativa con Google Workspace per un flusso di lavoro senza interruzioni

- Funzionalità multimodali per testo, immagini e video

Limiti di Gemini 1. 5 Pro

- Per sfruttare appieno i vantaggi è necessario investire nell'ecosistema Google.

- Le prestazioni al di fuori dell'integrazione con Google potrebbero essere inferiori rispetto alla concorrenza.

Prezzi di Gemini 1. 5 Pro

- Disponibile tramite Google IA Studio e Vertex AI.

- I prezzi variano in base all'utilizzo e agli accordi di azienda.

📌 ClickUp Insight: un professionista medio trascorre più di 30 minuti al giorno alla ricerca di informazioni relative al lavoro, ovvero oltre 120 ore all'anno perse a setacciare email, thread di Slack e file sparsi. Un assistente IA intelligente integrato nell'area di lavoro di ClickUp può cambiare questa situazione, facendo emergere i documenti, le conversazioni e i dettagli delle attività giusti in pochi secondi.

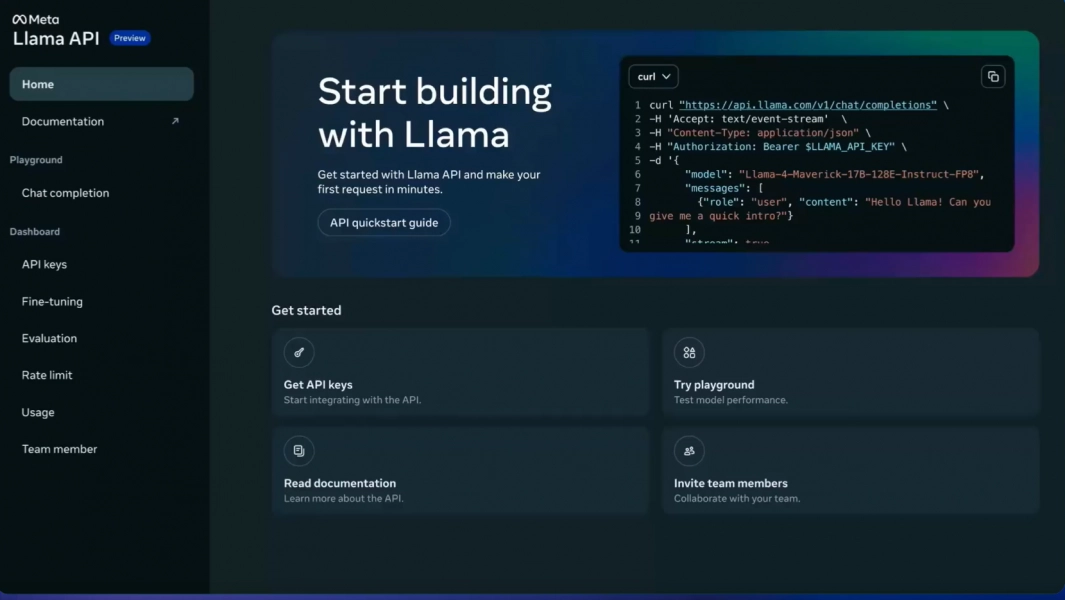

5. Meta LLaMA 3 (ideale per pipeline personalizzabili e self-hosted)

Il tuo team ha bisogno di avere il pieno controllo sui propri dati e vuole evitare di inviare informazioni sensibili a un servizio di terze parti. È qui che un modello open source come LLaMA 3 dà il meglio di sé. Puoi ospitarlo sui tuoi server, ottimizzarlo in base ai dati specifici della tua azienda per comprendere meglio il tuo gergo e personalizzarlo come meglio credi, il tutto senza costi di licenza.

La qualità del riassunto è impressionante e spesso rivaleggia con quella dei modelli proprietari. Il problema è la necessità di un'infrastruttura tecnica. Il tuo team avrà bisogno delle risorse ingegneristiche per implementare e mantenere il modello, poiché non è disponibile un'API gestita pronta all'uso. Questo lo rende perfetto per le organizzazioni guidate dall'ingegneria o incentrate sulla privacy.

Le 3 migliori funzionalità/funzioni di LLaMA 3

- Controllo completo dei dati con implementazione self-hosted

- Capacità di ottimizzazione per la terminologia specifica di un determinato settore

- Nessun costo di licenza per uso commerciale

Limiti di LLaMA 3

- Richiede un'infrastruttura tecnica significativa per l'implementazione.

- Nessuna API gestita: la manutenzione è a carico del tuo team.

- La complessità della configurazione iniziale può ritardare il time-to-value.

Prezzi di LLaMA 3

- Utilizzo gratis con licenza open source.

- I costi dell'infrastruttura dipendono dalle scelte di hosting

6. Mistral Large (ideale per i requisiti di residenza dei dati nell'Unione europea)

Cosa fare se desideri la flessibilità dell'open source ma non hai le risorse per gestire l'infrastruttura da solo? Mistral Large offre una soluzione intermedia interessante. Sviluppato da un'azienda europea, offre prestazioni di riassunto competitive con una forte attenzione all'efficienza.

Mistral fornisce sia un'API gestita per un facile accesso sia modelli open-weight per i team che desiderano un maggiore controllo. Questo approccio ibrido è il suo principale vantaggio. Il compromesso è un ecosistema più piccolo di integrazioni di terze parti rispetto a giganti come OpenAI e Google. È una scelta eccellente per i team che cercano un equilibrio tra convenienza e controllo, in particolare quelli con requisiti di residenza dei dati nell'Unione europea.

Le migliori funzionalità/funzioni di Mistral Large

- Accesso ibrido tramite API gestita o implementazione self-hosted

- Prestazioni eccellenti con conformità alla normativa europea sulla residenza dei dati

- Prezzi competitivi rispetto ai principali modelli proprietari

Limitazioni di Mistral Large

- Ecosistema di integrazione più piccolo rispetto a OpenAI o Google

- Documentazione e risorse della community meno estese

Prezzi di Mistral Large

- Accesso API con prezzi competitivi per token

- Modelli open-weight disponibili per l'auto-hosting

💡 Suggerimento professionale: se il tuo obiettivo principale è riassumere in un colpo solo le trascrizioni di riunioni della durata di un'ora, dai la priorità ai modelli con la finestra di contesto più ampia, come Gemini 1. 5 Pro. Se devi insegnare al modello la terminologia specifica della tua azienda, un'opzione open source come LLaMA 3 è la scelta giusta.

💡 Suggerimento professionale: se il tuo obiettivo principale è riassumere in un colpo solo le trascrizioni delle riunioni della durata di un'ora, dai la priorità ai modelli con la finestra di contesto più ampia, come Gemini 1. 5 Pro. Se devi insegnare al modello la terminologia specifica della tua azienda, un'opzione open source come LLaMA 3 è la scelta giusta.

Confronto tra modelli di riepilogo LLM

Il confronto rapido ti aiuta a identificare a colpo d'occhio quale modello è più in linea con le priorità del tuo team.

ClickUp Brain integra la sintesi direttamente nel tuo flusso di lavoro come area di lavoro AI convergente, ideale per trasformare i riassunti in azioni immediate, con il vantaggio di funzionare in modo ottimale all'interno dell'ecosistema ClickUp.

GPT-4o offre un'ampia finestra contestuale come modello proprietario, ideale per riepiloghi/riassunti raffinati e ricchi di sfumature, con il compromesso fondamentale rappresentato dal prezzo basato sull'utilizzo.

Claude 3. 5 Sonnet offre una finestra di contesto estesa come modello proprietario, ideale per documenti sensibili alla conformità con disponibilità regionale come limite primario.

Gemini 1. 5 Pro offre un'ampia finestra contestuale come modello proprietario, perfetto per gli utenti di Google Workspace, anche se il lock-in dell'ecosistema potrebbe rappresentare un problema.

LLaMA 3 include un'ampia finestra di contesto come modello open source, adatto a pipeline personalizzabili self-hosted, ma richiede investimenti in infrastrutture.

Mistral Large offre una funzionalità/funzione con un approccio di accesso ibrido, eccellente per le esigenze di residenza dei dati nell'Unione europea, sebbene abbia un ecosistema di integrazione più ridotto.

📖 Leggi anche: I migliori sintetizzatori di trascrizioni che riepilogano/riassumono

Come valutare la qualità della sintesi degli LLM che riepilogano/riassumono

Per sapere se i riassunti di un modello sono effettivamente validi è necessario un quadro di valutazione chiaro. Affidarsi a un riassunto scadente può essere peggio che non avere alcun riassunto, poiché può portare a decisioni errate basate su informazioni inaccurate.

Criteri chiave per la valutazione

L'accuratezza determina se il riassunto cattura correttamente i punti principali del testo originale senza inventare fatti o commettere errori. Questo è un requisito imprescindibile per i documenti critici per l'ambito aziendale.

La coerenza misura se il riassunto è di facile lettura e ha un flusso logico o se sembra un insieme disordinato di frasi scollegate. I riassunti efficaci mantengono la struttura narrativa.

La concisione valuta se il riepilogo/riassunto va dritto al punto o è pieno di parole inutili e superflue. I riepiloghi/riassunti migliori massimizzano la densità delle informazioni.

Il rispetto delle istruzioni verifica se il modello ha un esito positivo nel seguire correttamente le tue richieste relative a toni, formati o aree di interesse specifici, come elenchi puntati o briefing in stile esecutivo.

La coerenza valuta se il modello produce riassunti di alta qualità su diversi tipi di documenti o se funziona bene solo su alcuni di essi.

Un semplice framework di test

Scegli tre documenti con cui il tuo team lavora regolarmente: una sintesi di progetto, una trascrizione di una riunione e una conversazione via email con un cliente. Esegui ogni documento attraverso i modelli che stai prendendo in considerazione con lo stesso prompt. Quindi chiedi a un membro del team di valutare i risultati in base ai criteri sopra indicati. Sebbene esistano metriche automatizzate, nulla batte una revisione umana per individuare errori sottili.

🔍 Lo sapevi? Team come QubicaAMF hanno recuperato più di 5 ore alla settimana utilizzando ClickUp, ovvero oltre 250 ore all'anno a persona, eliminando processi di gestione delle conoscenze obsoleti. Immagina cosa potrebbe realizzare il tuo team con una settimana in più di produttività ogni trimestre.

🔍 Lo sapevi? Team come QubicaAMF hanno recuperato più di 5 ore alla settimana utilizzando ClickUp, ovvero oltre 250 ore all'anno a persona, eliminando processi di gestione delle conoscenze obsoleti. Immagina cosa potrebbe realizzare il tuo team con una settimana in più di produttività ogni trimestre.

Quali sono i limiti dell'utilizzo degli LLM per la riassunzione dei documenti?

Questa tecnologia presenta dei limiti reali che è importante comprendere prima di committere a un approccio particolare.

Rischi di allucinazione

Il rischio maggiore è l'allucinazione, ovvero quando il modello afferma con sicurezza dettagli errati che sembrano plausibili. I team legali, gli analisti finanziari e chiunque lavori con documenti sensibili dal punto di vista della conformità dovrebbero sempre sottoporre a revisione umana i riassunti di grande importanza.

Limiti della finestra contestuale

Anche i modelli più grandi hanno un limite, quindi i documenti estremamente lunghi potrebbero dover essere suddivisi in blocchi. Questa suddivisione può causare la perdita di connessioni tra sezioni distanti o la perdita dell'arco narrativo complessivo da parte del modello.

Perdita di sfumature

Gli argomenti sottili o i punti di vista minoritari vengono spesso appiattiti nei riassunti/riepiloghi. Se preservare le opinioni dissenzienti o i casi limite è importante per il tuo caso d'uso, dovrai creare prompt con attenzione o accettare una certa perdita di informazioni.

Sfide legate alla specificità del dominio

Un modello generico potrebbe non comprendere il gergo specifico del tuo campo senza un'adeguata messa a punto. I campi medico, legale e tecnico richiedono spesso una formazione aggiuntiva o un'attenta progettazione dei prompt.

Considerazioni sulla sicurezza

L'invio di dati aziendali sensibili a un'API di terze parti comporta sempre un certo grado di rischio. Per i documenti altamente riservati, potrebbero essere necessari modelli self-hosted o accordi di azienda con termini specifici per il trattamento dei dati.

Questi non sono motivi per evitare la tecnologia, ma sono considerazioni importanti. È possibile mitigarli con pratiche intelligenti: far sempre revisionare da un essere umano i riassunti ad alto rischio, utilizzare modelli self-hosted per i dati altamente sensibili e utilizzare prompt chiari per aiutare il modello a preservare le sfumature importanti.

📌 ClickUp Insight: il 62% dei knowledge worker si affida a strumenti di IA conversazionale come ChatGPT e Claude. La loro interfaccia chatbot familiare e le loro capacità versatili potrebbero spiegare la loro popolarità in diversi ruoli e settori. Tuttavia, passare a un'altra scheda per porre una domanda all'IA ogni volta comporta costi aggiuntivi in termini di tempo e di cambio di contesto.

📌 ClickUp Insight: il 62% dei knowledge worker si affida a strumenti di IA conversazionale come ChatGPT e Claude. La loro interfaccia chatbot familiare e le loro capacità versatili potrebbero spiegare la loro popolarità in diversi ruoli e settori. Tuttavia, passare a un'altra scheda per porre una domanda all'IA ogni volta comporta costi aggiuntivi in termini di tempo e di cambio di contesto.

Utilizza ClickUp Brain nel tuo flusso di lavoro di riassunto

Hai visto come ClickUp Brain si colloca tra i migliori LLM per il riassunto. Ora esploriamo come creare flussi di lavoro che trasformino tali riassunti in reali aumenti di produttività. La differenza tra un riassunto utile e uno sforzo inutile sta nel fatto che esso sia collegato all'azione, ed è qui che Converged AI Workspace eccelle.

[Immagine di riferimento: area di lavoro di ClickUp che mostra la sintesi Brain integrata con attività e documenti]

Ottieni riassunti direttamente sul posto di lavoro

Elimina il frustrante passaggio manuale integrando la sintesi direttamente nei tuoi progetti. Con ClickUp Brain, basta digitare @brain in qualsiasi commento di attività o messaggio di chat ClickUp e chiedergli di riepilogare il contesto. Fornisce immediatamente un riepilogo/riassunto utilizzando la sua conoscenza del tuo spazio di lavoro, dando priorità all'attività o al canale specifico in cui ti trovi.

Trasforma automaticamente le registrazioni delle riunioni in elementi da intraprendere

Per recuperare il ritardo dopo una riunione persa non è più necessario passare ore a leggere gli appunti. Rimani completamente coinvolto nelle conversazioni mentre ClickUp AI Notetaker acquisisce gli appunti della riunione per te. Dopo la riunione, fornisce una trascrizione e un riepilogo/riassunto. Puoi anche chiedergli di generare automaticamente delle azioni da intraprendere e trasformarle in attività di ClickUp con assegnatari e date di scadenza.

Sfrutta più LLM senza dover gestire la selezione dei modelli.

Ottieni risultati di alta qualità senza dover gestire personalmente la selezione dei modelli, perché ClickUp Brain sfrutta più LLM dietro le quinte. Ecco come si presenta questo flusso di lavoro nella pratica: si tiene una riunione, ClickUp AI Notetaker cattura tutto, ClickUp Brain fornisce un riassunto delle decisioni chiave e le azioni da intraprendere sono già nel tuo piano di progetto. Puoi anche usare @My Brain per riassumere in privato una discussione o redigere una risposta prima di condividerla con il team.

✨ Risultati reali: la vera sfida è trasformare i riassunti in azioni concrete. ClickUp Brain eccelle nella connessione diretta dei riassunti alle attività del tuo flusso di lavoro, eliminando il divario tra intuizione ed esecuzione che affligge gli strumenti di riepilogazione autonomi.

✨ Risultati reali: la vera sfida è trasformare i riassunti in azioni concrete. ClickUp Brain eccelle nella connessione diretta dei riassunti alle attività del tuo flusso di lavoro, eliminando il divario tra intuizione ed esecuzione che affligge gli strumenti di riepilogazione autonomi.

Conclusione

Il miglior LLM per il riassunto è quello che si adatta alle esigenze specifiche del tuo team, che si tratti di una finestra di contesto estesa per report lunghi, flessibilità open source per la personalizzazione o integrazione perfetta con gli strumenti esistenti. Prima di prendere una decisione definitiva, prova sempre le tue scelte migliori con i tuoi documenti reali per verificarne le prestazioni.

Ma ricorda, un riepilogo/riassunto è utile solo se collegato all'azione. La sintesi sta passando da un'attività autonoma a una funzionalità profondamente integrata nelle piattaforme in cui già lavori. Il vero aumento di produttività deriva dal colmare il divario tra l'ottenimento di un'intuizione e l'agire di conseguenza.

Inizia gratis con ClickUp e integra la sintesi IA direttamente nella gestione delle attività, nella chat e nei documenti.

Domande frequenti

Qual è la differenza tra il riepilogo estrattivo e quello astratto dei modelli LLM? Il riepilogo estrattivo funziona estraendo le frasi chiave direttamente dal testo originale, mentre il riepilogo astratto genera frasi completamente nuove per trasmettere il significato fondamentale. I moderni modelli LLM utilizzano principalmente il metodo astratto, che produce riepiloghi dal suono più naturale che catturano meglio l'essenza del materiale di partenza.

Come si comportano gli LLM open source rispetto ai modelli proprietari come GPT-4 per la riassunzione/riepilogazione? I modelli open source offrono il controllo completo sui dati e la possibilità di ottimizzarli in base alle esigenze specifiche, ma richiedono risorse tecniche per la manutenzione. I modelli proprietari offrono praticità e facilità d'uso tramite un'API, ma comportano costi di utilizzo e un minore controllo sui dati. Il divario di qualità si è notevolmente ridotto, con opzioni open source come LLaMA 3 che rivaleggiano con le prestazioni proprietarie in molti casi d'uso.

Gli strumenti di riepilogo LLM sono in grado di gestire appunti di riunioni e aggiornamenti di progetto? Sì, la maggior parte degli LLM è molto efficace nel riepilogare testi conversazionali come gli appunti di riunioni. La vera sfida è trasformare tali riepiloghi in azioni concrete, ed è qui che strumenti come ClickUp Brain eccellono, collegando i riepiloghi direttamente alle attività del tuo flusso di lavoro anziché lasciarli come documenti di testo isolati.

Di quale dimensione della finestra di contesto ho bisogno per i miei documenti? Per i documenti aziendali standard con meno di 10.000 parole, la maggior parte dei moderni LLM dispone di finestre di contesto sufficienti. Per trascrizioni di riunioni di oltre un'ora o rapporti di ricerca completi, sono necessari modelli con finestre di contesto estese come Claude 3. 5 Sonnet o Gemini 1. 5 Pro. La finestra da 1 milione di token di Gemini 1. 5 Pro è in grado di gestire praticamente qualsiasi attività di riepilogamento/riassunto di un singolo documento.

Come posso ridurre il rischio di allucinazioni nei riassunti LLM? Utilizza prompt chiari e specifici che chiedono al modello di riepilogare/riassumere solo ciò che è esplicitamente indicato nella fonte. Richiedi citazioni o riferimenti a sezioni specifiche quando l'accuratezza è fondamentale. Per i documenti ad alto rischio, chiedi sempre a un revisore umano di confrontare il riassunto con l'originale. Prendi in considerazione modelli con un allineamento di sicurezza più forte come Claude quando lavori con contenuti sensibili alla conformità.