La maggior parte di noi ha avuto qualche esperienza di "dialogo" con gli ultimi strumenti di IA disponibili sul mercato. Se hai trascorso abbastanza tempo con l'IA, sai già che è come quell'amico brillante ma smemorato che ha ottime idee ma a volte dimentica ciò di cui avete parlato. O quel collega sempre al telefono che effettua la condivisione di notizie dubbie da thread casuali, diffondendo disinformazione.

Questa è solo la punta dell'iceberg quando parliamo delle sfide dell'intelligenza artificiale.

I ricercatori dell'Oregon State University e di Adobe stanno sviluppando una nuova tecnica di formazione per ridurre i pregiudizi sociali nei sistemi di IA. Se questa tecnica si dimostrerà affidabile, potrebbe rendere l'IA più equa per tutti.

Ma non corriamo troppo. Questa è solo una delle tante soluzioni necessarie per affrontare le numerose sfide dell'IA che dobbiamo affrontare oggi. Dai problemi tecnici ai dilemmi etici, la strada verso un'IA affidabile è costellata di problemi complessi.

Analizziamo insieme queste sfide dell'IA e vediamo cosa serve per superarle.

10 sfide e soluzioni dell'IA

Con il progresso della tecnologia IA, emergono una serie di problemi. Questo elenco esplora dieci sfide urgenti dell'IA e delinea soluzioni pratiche per un'implementazione responsabile ed efficiente dell'IA.

1. Distorsione algoritmica

Il bias algoritmico si riferisce alla tendenza dei sistemi di IA a produrre risultati distorti, spesso a causa della natura dei dati di addestramento o della loro progettazione. Questi bias possono manifestarsi in numerose forme, spesso perpetuando e amplificando i pregiudizi sociali esistenti.

Soluzioni

- Dati diversificati e rappresentativi: utilizza set di dati di addestramento che riflettano realmente la diversità di tutti i gruppi per evitare pregiudizi legati al genere, all'etnia o all'età

- Rilevamento e monitoraggio dei pregiudizi: controlla regolarmente i tuoi sistemi di IA per individuare eventuali pregiudizi. Ciò dovrebbe avvenire attraverso una combinazione di monitoraggio automatico e revisioni manuali da parte tua, per garantire che nulla sfugga al controllo.

- Adeguamenti algoritmici: assumi un ruolo attivo nell'adeguamento degli algoritmi di IA per combattere i pregiudizi. Ciò potrebbe significare riequilibrare i pesi dei dati o aggiungere vincoli di equità ai tuoi modelli

- Linee guida etiche sull'IA: contribuisci a definire pratiche etiche nell'ambito dell'IA adottando e implementando linee guida che affrontano questioni quali l'equità e la parzialità, assicurandoti che tali principi siano integrati in ogni fase del tuo progetto di IA.

2. La mancanza di trasparenza dell'IA causa sfiducia

La trasparenza nell'IA significa essere aperti su come funzionano i sistemi di IA, compreso il loro design, i dati che utilizzano e i loro processi decisionali. La spiegabilità fa un passo avanti garantendo che chiunque, indipendentemente dalle proprie competenze tecniche, possa comprendere quali decisioni sta prendendo l'IA e perché. Questi concetti aiutano ad affrontare i timori relativi all'IA, come i pregiudizi, i problemi relativi alla privacy o persino i rischi come gli usi militari autonomi.

Soluzioni

- Sviluppa una documentazione chiara: fornisci dettagli completi sui modelli di IA, sul loro processo di sviluppo, sugli input di dati e sui processi decisionali. Ciò favorisce una migliore comprensione e getta le basi per la fiducia.

- Implementazione di modelli di IA spiegabili: utilizzate modelli che offrono maggiore trasparenza, come alberi decisionali o sistemi basati su regole, in modo che gli utenti possano vedere esattamente come gli input vengono trasformati in output.

- Utilizza strumenti di interpretabilità: applica strumenti come LIME (Local Interpretable Model-agnostic Explanations) o SHAP (SHapley Additive exPlanations) per analizzare il contributo delle varie funzionalità/funzioni nel processo decisionale del modello.

3. Scalare l'IA è più difficile di quanto sembri

Il potenziamento della tecnologia IA è fondamentale per le organizzazioni che mirano a sfruttarne il potenziale in varie unità aziendali. Tuttavia, il raggiungimento di questa scalabilità dell'infrastruttura IA è irto di complessità.

Nonostante il potenziale di un elevato ritorno sull'investimento, molte aziende hanno difficoltà a passare dai progetti pilota all'implementazione su larga scala.

Il fiasco di Zillow nel settore immobiliare è un chiaro promemoria delle sfide legate alla scalabilità dell'IA. La loro IA, volta a prevedere i prezzi delle case a scopo di lucro, ha registrato tassi di errore fino al 6,9%, causando gravi perdite finanziarie e una svalutazione dell'inventario pari a 304 milioni di dollari.

La sfida della scalabilità è più evidente al di fuori dei giganti tecnologici come Google e Amazon, che dispongono delle risorse necessarie per sfruttare efficacemente l'IA. Per la maggior parte delle altre aziende, in particolare quelle non tecnologiche che stanno appena iniziando a esplorare l'IA, gli ostacoli includono la mancanza di infrastrutture, potenza di calcolo, competenze e implementazione strategica.

Soluzioni

- Infrastruttura potenziata: sviluppa un'infrastruttura digitale robusta in grado di gestire implementazioni di IA su larga scala. Ad esempio, i servizi cloud e i data center localizzati riducono la latenza e migliorano le prestazioni

- Team interdisciplinari: promuovete un ambiente collaborativo in cui le unità tecnologiche e commerciali lavorino insieme per integrare perfettamente le soluzioni di IA nei modelli di business esistenti

- Strumenti automatizzati per lo sviluppo dell'IA: utilizza piattaforme come evoML di TurinTech per automatizzare lo sviluppo di codici di machine learning, consentendo una creazione e un'implementazione più rapide dei modelli.

- Apprendimento e adattamento continui: implementa meccanismi di apprendimento e aggiornamento continui dei modelli di IA per adattarli ai dati reali e alle mutevoli condizioni di mercato, garantendo rilevanza ed efficienza a lungo termine.

- Investi nello sviluppo dei talenti: sviluppa competenze interne in materia di IA attraverso pratiche di formazione e assunzione incentrate sulle tecnologie emergenti di IA, riducendo l'eccessiva dipendenza dai talenti esterni in questo campo.

Leggi anche: Statistiche essenziali sull'IA da conoscere oggi

4. Deepfake e frodi generative dell'IA

L'IA generativa e le tecnologie deepfake stanno trasformando il panorama delle frodi, in particolare nel settore dei servizi finanziari. Rendono più facile e meno costoso creare falsi convincenti.

Ad esempio, nel gennaio 2024, un deepfake che impersonava un CFO ha ordinato a un dipendente di trasferire 25 milioni di dollari, mettendo in evidenza le gravi implicazioni di tali tecnologie.

Questa tendenza in crescita evidenzia le sfide che le banche devono affrontare nel tentativo di adattare i propri sistemi di gestione dei dati e di rilevamento delle frodi per contrastare truffe sempre più sofisticate che ingannano non solo le persone, ma anche i sistemi di sicurezza basati su macchine.

Soluzioni

- Tecnologie di rilevamento avanzate: le banche devono investire in tecnologie più recenti in grado di rilevare in modo più efficace le anomalie dell'IA generativa e dei deepfake.

- Supervisione umana: l'integrazione di analisi umane qualificate con le risposte dell'IA migliora i tassi di rilevamento e aiuta a verificare e comprendere l'identificazione delle frodi basata sull'IA

- Lavoro collaborativo per la prevenzione delle frodi: la creazione di partnership all'interno e tra i vari settori può aiutare a sviluppare meccanismi più solidi per identificare e prevenire le frodi

5. Sfide relative all'interoperabilità e all'interazione tra uomo e IA

Quando diverse organizzazioni o paesi utilizzano insieme l'IA, devono garantire che essa si comporti in modo etico secondo le regole di tutti. Questo concetto è chiamato interoperabilità etica ed è particolarmente importante in settori come la difesa e la sicurezza.

Al momento, i governi e le organizzazioni hanno le proprie regole e la propria filosofia. Ad esempio, dai un'occhiata alle Linee guida Microsoft per l'interazione uomo-IA:

Tuttavia, manca una standardizzazione di questa filosofia e delle regole a livello globale.

Al momento, i sistemi di IA sono dotati di una serie di regole etiche che possono essere adeguate in un contesto ma problematiche in un altro. Quando questi sistemi interagiscono con gli esseri umani, se non si comportano come previsto, possono causare malintesi o sfiducia.

Soluzioni

- Stabilisci standard etici universali: concorda regole etiche di base che tutti i sistemi di IA devono seguire, indipendentemente dalla loro provenienza. Concentrati su equità, responsabilità e trasparenza

- Utilizza un sistema di certificazione rigoroso: prima di essere utilizzato, qualsiasi sistema di IA dovrebbe superare un test rigoroso per confermare che soddisfi questi standard etici. Ciò potrebbe includere controlli da parte degli autori e anche da parte di gruppi indipendenti

- Assicurati che tutti siano informati: Sii sempre chiaro su come l'IA prende le decisioni e utilizza i dati. Questa trasparenza aiuta a creare fiducia e rende più facile l'integrazione di diversi sistemi di IA

- Tenete d'occhio la situazione: controllate regolarmente i sistemi di IA per assicurarvi che continuino a soddisfare gli standard etici. Aggiornateli secondo necessità per stare al passo con le nuove regole o tecnologie

6. L'etica dell'IA non si limita alle buone intenzioni

L'intelligenza artificiale (IA) sta entrando in quasi ogni aspetto della nostra vita, dalle auto a guida autonoma agli assistenti virtuali, ed è fantastico! Ma c'è un problema: il modo in cui utilizziamo l'IA può talvolta sollevare seri problemi etici. Esistono questioni etiche spinose relative alla privacy, ai pregiudizi, alla sostituzione dei posti di lavoro e altro ancora.

Poiché l'IA è in grado di svolgere attività che prima erano di competenza degli esseri umani, è in corso un ampio dibattito sul fatto che debba o meno svolgere alcune di queste attività.

Ad esempio, l'IA dovrebbe scrivere sceneggiature cinematografiche? Sembra interessante, ma ha suscitato un enorme scalpore nel mondo dello spettacolo con scioperi in tutti gli Stati Uniti e in Europa. E non si tratta solo di quali lavori l'IA può svolgere al posto nostro, ma anche di come utilizza i nostri dati, prende decisioni e talvolta commette errori. Questo ha spinto tutti, dai tecnici agli esperti legali, a cercare di capire come gestire l'IA in modo responsabile.

Soluzioni

- Chiarisci le regole: sviluppa linee guida chiare su come dovrebbe essere utilizzata l'IA. Ciò significa stabilire dei limiti per prevenire un uso improprio e comprendere le implicazioni legali delle azioni dell'IA.

- Rispetta la privacy: per addestrare l'IA vengono utilizzate enormi quantità di dati, comprese informazioni personali. Dobbiamo prestare molta attenzione a come questi dati vengono raccolti, utilizzati e protetti. Si tratta di garantire che l'IA rispetti la nostra privacy.

- Combattere i pregiudizi: l'IA è efficace solo quanto i dati da cui apprende e, talvolta, questi dati presentano pregiudizi. Dobbiamo eliminare questi pregiudizi dai sistemi di IA per garantire che siano equi e non discriminatori.

- Proteggi la proprietà intellettuale: l'IA può sfornare lavori basati su ciò che ha appreso dalle opere creative altrui. Questo può violare i diritti d'autore e privare gli autori di ciò che spetta loro, a meno che non stiamo attenti.

- Etica contro velocità: nella corsa sfrenata per portare sul mercato le ultime tecnologie di IA, l'etica può passare in secondo piano. Dobbiamo trovare un equilibrio tra la necessità di velocità e il fare le cose nel modo giusto.

7. Mescolare i set di dati dell'IA potrebbe rivelarsi un disastro

Quando si sviluppano modelli di machine learning basati sull'IA, può essere difficile distinguere correttamente tra set di dati di addestramento, convalida e test. Il set di dati di addestramento del modello di IA insegna al modello, il set di dati di convalida lo ottimizza e il set di dati di test ne valuta le prestazioni.

Questo errore può compromettere gravemente la capacità del modello di funzionare efficacemente nelle applicazioni di IA del mondo reale, dove l'adattabilità e l'accuratezza sui dati standardizzati sono fondamentali.

Soluzioni

- Suddivisione strutturata dei dati: adotta un approccio sistematico per suddividere i dati in set di addestramento, convalida e test

- Tecniche di validazione incrociata: utilizzate metodi di validazione incrociata, specialmente in scenari con dati limitati. Tecniche come la validazione incrociata K-fold aiutano a massimizzare l'utilizzo della formazione e forniscono una stima più solida delle prestazioni del modello su dati non visibili.

- Randomizzazione dei dati: assicurati che la suddivisione dei dati sia casuale per evitare che l'ordine dei dati introduca distorsioni nell'IA. Ciò contribuisce a creare set di addestramento e convalida rappresentativi dell'insieme di dati complessivo.

8. Rischi e preoccupazioni legati al processo decisionale automatizzato

Quando l'IA prende decisioni, le cose possono diventare complicate, specialmente in settori critici come la sanità e il settore bancario. Uno dei problemi principali è che non sempre è possibile capire come i sistemi di IA arrivano alle loro decisioni.

Questo può portare a decisioni ingiuste che nessuno è in grado di spiegare. Inoltre, questi sistemi sono traguardi per gli hacker che, se riescono a penetrarvi, potrebbero rubare molti dati importanti.

Soluzioni

- Sviluppa protocolli di sicurezza robusti: assicurati che i sistemi di IA siano protetti contro gli hacker. Continua ad aggiornare la sicurezza per chiudere eventuali nuove falle che potrebbero emergere

- Migliora la trasparenza: utilizza tecnologie che aiutano l'IA a spiegare le sue scelte in termini semplici. Se tutti capiscono come vengono prese le decisioni, avranno più fiducia nell'IA.

- Proteggi le informazioni private: proteggi tutti i dati personali gestiti dall'IA. Rispetta le leggi come il GDPR per garantire che la privacy di nessuno venga compromessa

- Promuovi la collaborazione multidisciplinare: coinvolgi esperti di tutti i campi (tecnologia, diritto, etica) affinché lavorino insieme. Possono aiutarti a garantire che le decisioni dell'IA siano eque e sicure

Leggi anche: Gli strumenti di IA più popolari tra gli studenti

9. Mancanza di regole e normative chiare sull'IA

Al momento non esiste un unico organismo di controllo globale per l'IA; la regolamentazione varia da paese a paese e persino da settore a settore. Ad esempio, negli Stati Uniti non esiste un organismo centrale specifico per l'IA.

Questo approccio decentralizzato può portare a incongruenze e confusione; possono essere applicati standard diversi a seconda di dove e come viene implementata l'IA. Ciò rende difficile per gli sviluppatori e gli utenti dell'IA garantire la piena conformità in tutte le giurisdizioni.

Soluzioni

- Istituire un organismo di regolamentazione dedicato all'IA: i paesi potrebbero trarre vantaggio dall'istituzione di un'agenzia specifica dedicata all'IA. Questo organismo potrebbe supervisionare tutti i problemi relativi all'IA, tenendo il passo con il rapido sviluppo dell'IA e garantendo il rispetto degli standard di sicurezza ed etici.

- Cooperazione internazionale: l'IA non si ferma ai confini. I paesi devono collaborare per creare standard e accordi internazionali sull'uso dell'IA, analogamente a come funzionano i trattati globali per la protezione dell'ambiente.

- Legislazione chiara e adattabile: le leggi devono essere chiare (in modo che le aziende sappiano come conformarsi), ma anche sufficientemente flessibili da adattarsi ai nuovi progressi dell'IA. Aggiornamenti e revisioni regolari delle leggi sull'IA potrebbero contribuire a mantenerle pertinenti.

- Coinvolgimento del pubblico e delle parti interessate: le normative dovrebbero essere sviluppate con il contributo di un'ampia gamma di parti interessate, tra cui aziende tecnologiche, esperti di etica e il pubblico in generale. Ciò può contribuire a garantire che vengano presi in considerazione diversi punti di vista e che il pubblico riponga maggiore fiducia nei sistemi di IA.

Leggi anche: Strumenti di IA per avvocati

10. Disinformazione derivante dall'IA

Immagina di avere una tecnologia in grado di pensare come un essere umano. Questa è la promessa dell'intelligenza artificiale generale (AGI), ma comporta grandi rischi. La disinformazione è uno dei problemi principali in questo ambito.

Con l'AGI, è facile creare notizie false o informazioni errate convincenti, rendendo più difficile per tutti capire cosa è vero e cosa non lo è.

Inoltre, se l'AGI prende decisioni basate su queste informazioni false, può portare a risultati disastrosi, che influenzano tutto, dalla politica alla vita personale.

Soluzioni

- Imposta controlli rigorosi: verifica sempre i fatti prima di consentire all'AGI di diffondere informazioni. Utilizza fonti affidabili e conferma i dettagli prima di rendere pubblico qualsiasi contenuto.

- Insegnare l'etica all'AGI: proprio come insegniamo ai bambini a distinguere il bene dal male, dobbiamo insegnare all'AGI il comportamento etico. Ciò include la comprensione dell'impatto della diffusione di informazioni false e l'adozione di decisioni eque e giuste

- Mantieni gli esseri umani nel ciclo decisionale: indipendentemente dal livello di intelligenza raggiunto dall'AGI, mantieni gli esseri umani coinvolti nel processo decisionale. Ciò aiuta a individuare gli errori e garantisce che le azioni dell'AGI riflettano i nostri valori e la nostra etica.

- Crea regole chiare: stabilisci linee guida rigorose su ciò che l'AGI può e non può fare, soprattutto quando si tratta di creare e diffondere informazioni. Assicurati che queste regole vengano seguite alla lettera

Leggi anche: Il glossario completo dell' IA

Strumenti per affrontare le sfide dell'IA

Quando sei immerso nell'IA, scegliere gli strumenti giusti non è solo un optional, ma è fondamentale per garantire che il tuo percorso nell'IA non si trasformi in un disastro. Si tratta di semplificare ciò che è complesso, garantire la sicurezza dei tuoi dati e ottenere il supporto necessario per risolvere le sfide dell'IA senza spendere una fortuna.

La chiave è scegliere un software di IA su misura che migliori la produttività, salvaguardando al contempo la tua privacy e la sicurezza dei tuoi dati.

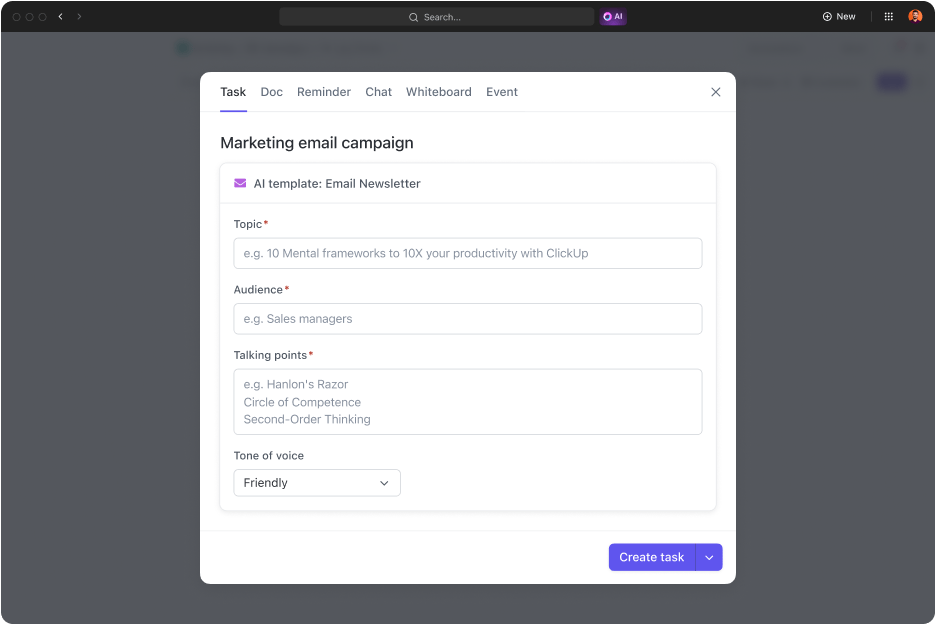

Entra in ClickUp Brain, il coltellino svizzero per l'IA sul tuo posto di lavoro.

ClickUp Brain: efficienza, sicurezza e innovazione, tutto in uno

ClickUp Brain è progettato per gestire tutto ciò che riguarda l'IA, dalla gestione dei progetti e dei documenti al miglioramento della comunicazione all'interno del team. Con le funzionalità di IA di ClickUp Brain, puoi affrontare le sfide legate ai dati, migliorare la project management e aumentare la produttività, il tutto mantenendo la semplicità e la sicurezza. ClickUp Brain è una soluzione completa che:

- Si integra perfettamente nel tuo lavoro quotidiano

- Garantisce che i tuoi dati rimangano tuoi

- Risparmia denaro e risorse

ClickUp Brain si integra in modo intelligente nel tuo flusso di lavoro per farti risparmiare tempo e lavoro richiesto, salvaguardando al contempo i tuoi dati. È (come il resto della piattaforma ClickUp) conforme al GDPR e non utilizza i tuoi dati per la formazione.

Ecco come funziona:

- AI Knowledge Manager: hai mai desiderato ottenere risposte immediate e accurate dai tuoi documenti di lavoro o dalle chat? ClickUp Brain lo rende possibile. Non dovrai più cercare nei file per ore. Basta chiedere e riceverai ciò che desideri, che si tratti di dettagli da un documento di progetto o approfondimenti dagli aggiornamenti passati del team.

- AI Project Manager: immagina di avere un assistente AI che ti aiuta a mantenere i tuoi progetti in carreggiata. Dall'automazione degli aggiornamenti delle attività alla riaggregazione dei progressi del progetto, ClickUp Brain si occupa delle parti più noiose, così tu puoi concentrarti sul quadro generale.

- AI Writer for Work: questo strumento è una vera rivoluzione per chiunque abbia paura di scrivere. Che si tratti di redigere una breve email o di redigere un rapporto completo, ClickUp Brain aiuta a perfezionare la prosa, controllare l'ortografia e regolare il tono alla perfezione.

Affrontare le sfide dell'IA con gli strumenti giusti

Nonostante le sfide dell'IA che abbiamo discusso, possiamo concordare sul fatto che l'intelligenza artificiale ha fatto molta strada. Si è evoluta dall'automazione di base a sistemi sofisticati in grado di apprendere, adattarsi e prevedere i risultati. Molti di noi hanno ormai integrato l'IA in vari aspetti della propria vita, dagli assistenti virtuali agli strumenti avanzati di raccolta e analisi dei dati.

Con il progresso dell'IA, possiamo aspettarci ancora più innovazioni, hack e strumenti di IA per aumentare la produttività, migliorare il processo decisionale e rivoluzionare i settori industriali. Questo progresso apre nuove possibilità, guidandoci verso un futuro in cui l'IA svolgerà un ruolo cruciale sia nella sfera personale che in quella professionale.

Con strumenti di IA come ClickUp Brain, puoi sfruttare al massimo le tecnologie di IA proteggendoti al contempo dalle sfide poste dall'IA in materia di privacy e sicurezza dei dati. ClickUp è il tuo strumento di gestione delle attività basato sull'IA per tutto, dai progetti software al marketing. Scegli ClickUp per trasformare in modo sicuro la tua organizzazione in un'entità basata sui dati e sull'IA, aumentando al contempo la produttività del team.

Sei pronto a trasformare i tuoi flussi di lavoro con l'IA? Iscriviti subito a ClickUp!