La plupart des développeurs peuvent faire fonctionner l'API Gemini en moins de 10 minutes.

Le véritable défi commence après l'installation.

Ce guide vous montre comment obtenir votre clé API, installer le SDK et effectuer votre première requête.

Vous apprendrez également à organiser vos flux de travail API afin que votre équipe ne perde pas de temps à réinventer des solutions ou à rechercher de la documentation.

Qu'est-ce que l'API Gemini ?

L'API Gemini est l'interface de Google permettant d'accéder à sa famille de modèles d'IA multimodaux, qui permet aux développeurs d'intégrer la génération de texte, la compréhension d'images, l'assistance au codage et l'IA conversationnelle dans leurs applications.

Elle est conçue pour les équipes produit, les ingénieurs et les entreprises qui souhaitent ajouter de puissantes capacités d'IA à leurs produits sans avoir à créer de grands modèles linguistiques à partir de zéro.

Les grands modèles linguistiques de Gemini, tels que Gemini 3 Flash et Gemini 3 Pro, sont multimodaux, ce qui signifie qu'ils peuvent traiter plusieurs types d'entrées, notamment du texte, des images, de l'audio et de la vidéo. L'API elle-même utilise l'architecture REST API , qui est un moyen standard pour les systèmes informatiques de communiquer sur Internet.

Pour vous faciliter encore plus la tâche, Google fournit des kits de développement logiciel (SDK) pour les langages courants tels que Python, JavaScript et Go. Il est utile de comprendre la différence entre l'API et Google AI Studio.

| Utilisation principale | Applications de production | Prototypage et tests |

| Méthode d'accès | Appels SDK basés sur le code | Interface visuelle basée sur le Web |

| Idéal pour | Développeurs créant des applications | Expérimenter avec les invites |

💡Conseil de pro : conservez tout le contexte de votre projet au même endroit et évitez de rechercher des informations dans différents outils en créant une base de connaissances interne pour vos projets d'IA. Avec ClickUp Docs, vous pouvez lier des extraits de code et de la documentation API directement aux tâches de votre équipe, ce qui élimine la prolifération des outils et accélère l'adoption de l'IA.

Comment obtenir votre clé API Gemini

Votre équipe est peut-être prête à commencer à créer, mais vous devez d'abord obtenir une clé API.

Pour utiliser l'API Gemini, vous avez besoin d'une clé pour effectuer l'authentification de vos demandes, et la gestion de ces clés est la première étape vers une gestion plus fluide des flux de travail. Vous aurez besoin d'un compte Google pour commencer.

Voici comment obtenir votre clé :

- Accédez à Google IA Studio

- Connectez-vous avec votre compte Google.

- Cliquez sur Obtenir une clé API dans la barre latérale gauche.

- Sélectionnez Créer une clé API dans un nouveau projet ou choisissez un projet Google Cloud existant.

- Copiez immédiatement la clé générée et conservez-la dans un emplacement sûr.

Votre clé API vous donne accès à votre quota Gemini et à votre facturation. Traitez-la comme un mot de passe. 🔑

Votre clé API vous donne accès à votre quota Gemini et à votre facturation. Traitez-la comme un mot de passe. 🔑

Pour les équipes plus importantes, vous pouvez également gérer les clés via la console Google Cloud, qui offre des contrôles plus avancés.

Comment installer le SDK Gemini

Un nouveau développeur rejoint votre projet IA, mais il passe sa première journée à se débattre avec l'installation de l'environnement au lieu d'écrire du code.

Leur version Python est erronée ou il leur manque une dépendance, ce qui conduit au casse-tête classique « ça marche sur ma machine ».

C'est souvent la raison pour laquelle les développeurs perdent 3 heures par semaine. Ces incohérences ralentissent l'intégration et introduisent des bugs imprévisibles qui font perdre un temps précieux aux ingénieurs.

Un SDK, ou kit de développement logiciel, simplifie ces interactions API en gérant pour vous l'authentification, le formatage des requêtes et l'analyse des réponses. Pour éviter les problèmes d'installation, votre équipe a besoin d'un processus standardisé et documenté pour installer le SDK Gemini.

Voici comment l'installer pour les environnements les plus courants.

Pour Python :

- Note : vous aurez besoin de Python 3. 9 ou d'une version plus récente. L'utilisation d'un environnement virtuel est une bonne pratique pour éviter les conflits avec d'autres projets.

Pour JavaScript/Node. js :

- Note : ceci est destiné à être utilisé dans un environnement Node.js.

Après l'installation, vous devez configurer votre clé API en tant que variable d'environnement. Cela permet de sécuriser votre clé et de la garder hors de votre code source.

- Sur Mac/Linux : exportez GEMINI_API_KEY="votre-clé-API-ici"

- Sous Windows : setx GEMINI_API_KEY « votre-clé-API-ici »

Vous avez plusieurs options pour choisir le SDK à utiliser :

- SDK Python : le choix le plus populaire, avec une documentation complète. Il est idéal pour la science des données et les applications backend.

- SDK JavaScript : la meilleure option pour créer des applications web et des backends Node.js.

- Go SDK : un excellent choix pour les développeurs qui créent des microservices haute performance dans Go.

- API REST : si vous utilisez un langage sans SDK officiel, vous pouvez toujours envoyer des requêtes HTTP directes à l'API REST.

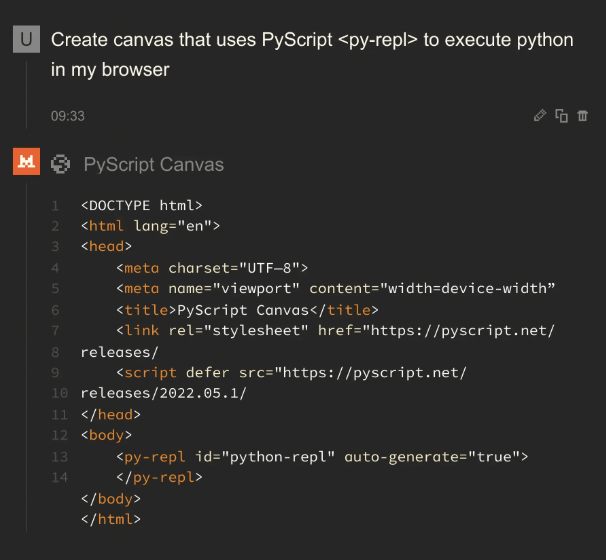

💡Conseil de pro : standardisez votre environnement de développement et accélérez l'intégration en créant une checklist que chaque nouveau membre de l'équipe peut suivre. Enregistrez-la comme modèle dans ClickUp Tasks, et si quelqu'un rencontre des difficultés, il pourra utiliser ClickUp Brain pour obtenir des réponses à partir de la documentation de votre équipe. Voici un guide rapide :

📖 En savoir plus : Gemini ou ChatGPT pour le codage : lequel est le meilleur ?

Comment effectuer votre première requête API Gemini

Votre équipe effectue enfin des appels API, mais chaque développeur doit se débrouiller seul.

Une réussite de l'appel API est simple : vous envoyez une invitation à un modèle Gemini et recevez une réponse.

Le véritable défi consiste à rendre ce processus reproductible et évolutif pour l'ensemble de votre équipe. Voici quelques exemples pour vous aider à effectuer votre première requête.

Exemple Python

Ce code envoie une simple invite de texte à l'API Gemini et affiche la réponse.

Voyons cela plus en détail :

- Importation et configuration : cette opération charge la bibliothèque Google et configure l'authentification à l'aide de la clé API que vous avez configurée précédemment.

- Initialiser le modèle : ici, vous indiquez au code quel modèle Gemini spécifique utiliser. Gemini 3 Flash est optimisé pour les tâches à grande vitesse et à haut volume, tandis que Gemini 3 Pro est conçu pour le raisonnement approfondi et les flux de travail complexes en plusieurs étapes.

- Générer du contenu : C'est l'action. Vous envoyez votre question au modèle.

- Accès à la sortie : la réponse du modèle est stockée dans l'objet response, et vous pouvez accéder au texte avec response. text.

📖 Pour en savoir plus : 10 exemples de contenu généré par l'IA pour inspirer vos propres créations

Exemple JavaScript

Si vous travaillez dans un environnement Node.js, le processus est similaire, mais utilise la syntaxe async/await de JavaScript.

Exemple d'API REST

Si vous n'utilisez pas Python ou JavaScript, vous pouvez toujours communiquer directement avec l'API à l'aide d'une commande curl. C'est idéal pour effectuer des tests rapides ou pour une utilisation dans des langages sans SDK dédié.

Cette commande envoie une requête HTTP au point de terminaison de l'API et renvoie la réponse sous forme d'objet JSON.

Facilitez la recherche et la réutilisation de fragments de code et d'invites réussies par votre équipe en créant une bibliothèque partagée.

📖 En savoir plus : Qu'est-ce qu'un plan de gestion de projet et comment en créer un ?

Que pouvez-vous créer avec l'API Gemini ?

L'API Gemini est incroyablement polyvalente. Voici quelques exemples de ce que vous pouvez créer :

- Outils de génération de contenu : effectuez l’automatisation des brouillons de blog, des publications sur les réseaux sociaux et des textes marketing.

- Chatbots et assistants virtuels : créez des interfaces de discussion pour le service client ou les services d'assistance internes.

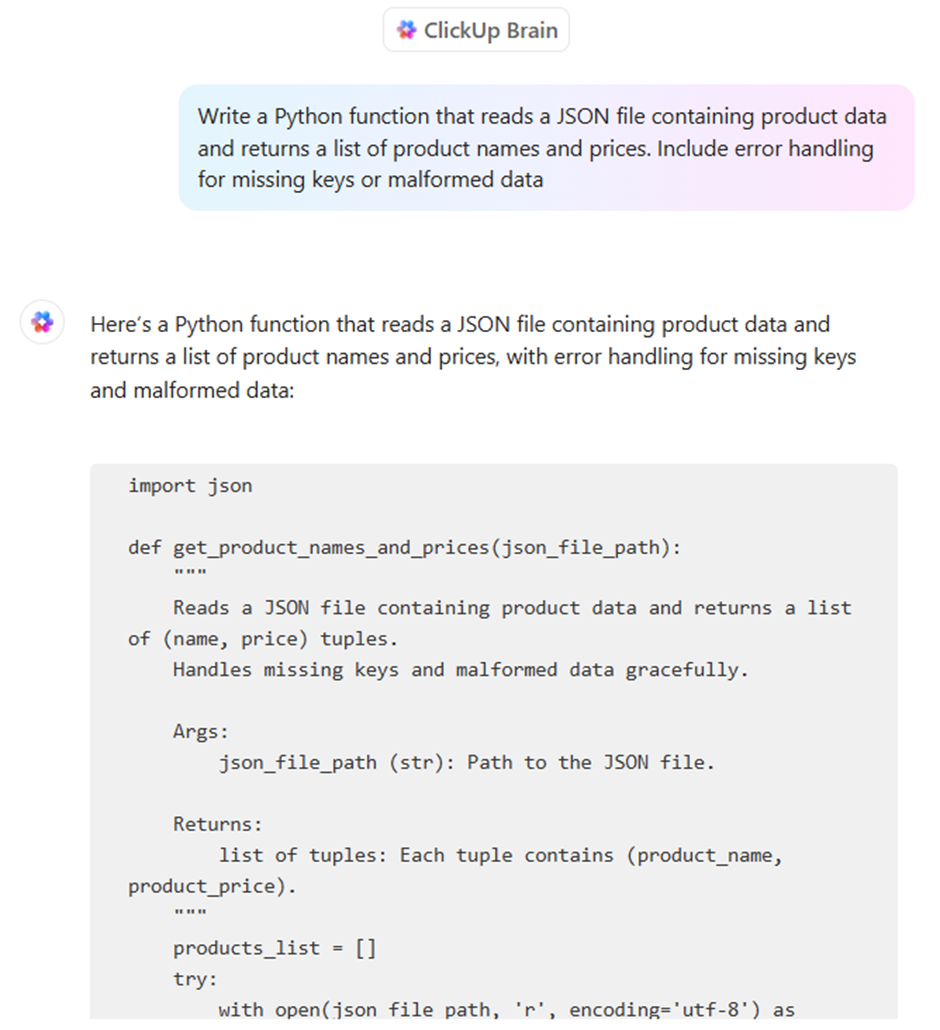

- Assistance au codage : générez des extraits de code, expliquez des fonctions complexes et aidez à déboguer les erreurs.

- Aides à l'analyse des données : résumez des rapports denses et extrayez des informations clés à partir de textes non structurés.

- Applications multimodales : analysez des images ou traitez du contenu de vidéo pour le rendre consultable.

- Traitement de documents : extrayez des informations à partir de fichiers PDF et traduisez des documents dans différentes langues.

Création de flux de travail agentifs avec Gemini

Contrairement à un chatbot standard qui répond aux questions de manière linéaire, un flux de travail agentique dans Gemini permet au modèle de percevoir un objectif, de raisonner à travers un plan et d'exécuter une série d'actions autonomes à travers des outils externes.

Cette transition « agentique » s'appuie sur trois fonctionnalités essentielles de l'écosystème Gemini 3 :

- Mode « réflexion » natif : grâce au paramètre thinking_level, vous pouvez désormais activer/désactiver entre « faible » pour la vitesse et « élevé » pour les tâches complexes. En mode de raisonnement élevé, Gemini 3 Pro génère des « jetons de réflexion » cachés pour valider sa propre logique avant de fournir une réponse, ce qui réduit considérablement les hallucinations.

- Signatures de pensée : afin d'éviter toute « dérive de raisonnement » dans les tâches à plusieurs étapes, l'API émet désormais des signatures de pensée cryptées. Les développeurs doivent renvoyer ces signatures dans l'historique des discussions afin de garantir que l'agent conserve exactement le même raisonnement d'un appel API à l'autre et d'une exécution d'outil à l'autre.

- Protocole de contexte de modèle (MCP): Gemini utilise désormais le protocole MCP, norme industrielle, pour se connecter aux outils. Cela permet à votre agent de réaliser une connexion instantanée à vos bases de données existantes, à Slack ou à GitHub sans que vous ayez à écrire du code d'intégration personnalisé pour chaque fonction.

📮 ClickUp Insight : les équipes peu performantes sont 4 fois plus susceptibles d'utiliser plus de 15 outils, tandis que les équipes très performantes maintiennent leur efficacité en limitant leur boîte à outils à 9 plateformes ou moins.

Mais pourquoi ne pas utiliser une seule plateforme pour tout cela ?

ClickUp rassemble vos tâches, projets, documents, wikis, chats et appels sur une seule plateforme, avec des flux de travail alimentés par l'IA. Prêt à travailler plus intelligemment ? ClickUp fonctionne pour toutes les équipes, apporte de la visibilité au travail et vous permet de vous concentrer sur l'essentiel pendant que l'IA s'occupe du reste.

Exemple Python : création d'un agent de recherche

Cet extrait montre comment initialiser un agent à haut niveau de raisonnement qui maintient un « fil de pensée » persistant via le dernier SDK Gemini.

📖 En savoir plus : Comment utiliser un chatbot pour votre entreprise

Comment assurer la sécurité de votre clé API Gemini

Votre équipe livre des fonctionnalités, mais vos pratiques de sécurité sont reléguées au second plan.

Les clés API sont parfois laissées dans le code, contribuant ainsi aux 23,7 millions de secrets divulgués sur GitHub en 2024, et il n'existe aucun processus officiel pour les faire tourner. Cela rend votre organisation vulnérable à une utilisation non autorisée, ce qui peut entraîner des factures imprévues et de graves failles de sécurité.

Une approche réactive de la sécurité est la recette du désastre. Vous avez besoin d'un système de gestion des connaissances proactif pour gérer les identifiants afin de protéger vos applications et les données de votre entreprise.

Voici les bonnes pratiques essentielles pour assurer la sécurité de votre clé API Gemini :

- Utilisez des variables d'environnement : ne codez jamais, au grand jamais, les clés directement dans votre code source. Stockez-les dans des fichiers .env ou des variables d'environnement système.

- Ajoutez. env à votre. gitignore : cette étape simple vous évite de commettre accidentellement vos clés secrètes dans un référentiel de code public.

- Changez régulièrement de clés : générez périodiquement de nouvelles clés dans la console Google Cloud et désactivez les anciennes.

- Mettez en place des contrôles d'accès : utilisez la gestion des identités et des accès (IAM) de Google Cloud pour limiter les membres de votre équipe autorisés à afficher ou gérer les clés API.

- Surveillez l'utilisation : gardez un œil sur le tableau de bord d'utilisation de l'API dans la console Google Cloud afin de repérer toute activité inhabituelle qui pourrait indiquer une compromission.

- Utilisez des clés distinctes pour chaque environnement : conservez des clés différentes pour vos environnements de développement, de test et de production afin de limiter l'impact d'une éventuelle fuite.

Tarifs Gemini

- Gemini 3 Flash : ~0,50 $ par million d'entrées / 3,00 $ par million de sorties

- Gemini 3 Pro : environ 2,00 $ par million d'entrées / 12,00 $ par million de sorties (pour un contexte inférieur à 200 000)

- Recherche de base : veuillez noter que Google facture désormais 14 $ pour 1 000 requêtes de recherche pour la recherche de base une fois que vous avez dépassé le quota mensuel gratuit (5 000 requêtes).

Limites de l'utilisation de l'API Gemini

Votre application est en ligne, mais vous rencontrez des problèmes inattendus.

L'API est plus lente que prévu pendant les heures de pointe ou renvoie des réponses incohérentes qui déroutent les utilisateurs.

Comprendre les limites de l'API est la première étape ; documenter vos solutions de contournement vous aidera à évoluer efficacement.

Soyez conscient de ces contraintes courantes :

- Limites de fréquence : le niveau gratuit impose des limites sur le nombre de requêtes par minute et de jetons par jour, ce qui peut créer des goulots d'étranglement pour les applications à fort volume.

- Variabilité de la latence : les temps de réponse peuvent varier en fonction de la complexité de vos invitations et de la charge globale du serveur.

- Contraintes de la fenêtre de contexte : chaque modèle a un nombre maximal de tokens (mots et parties de mots) qu'il peut traiter en une seule requête, ce qui peut poser un défi pour résumer des documents très longs.

- Disponibilité régionale : certains modèles ou certaines fonctionnalités peuvent ne pas être disponibles dans toutes les régions géographiques.

- Cohérence des résultats : l'IA générative peut produire des résultats légèrement différents même pour une même invitation, ce qui peut vous obliger à intégrer des étapes de validation dans votre flux de travail.

- Pas de données en temps réel : les connaissances des modèles ne sont pas mises à jour en temps réel, ils ne peuvent donc pas fournir d'informations sur des évènements très récents.

Bien que l'API Gemini soit une puissance multimodale, la création d'une application prête à la production nécessite souvent une stratégie multimodèle. En fonction des besoins spécifiques de votre projet en matière de profondeur de raisonnement ou de précision de codage, vous pouvez vous tourner vers ces alternatives à Gemini.

La plupart des outils d'IA promettent de faciliter le développement, mais ils finissent souvent par n'être qu'un onglet supplémentaire dans une pile déjà bien remplie. Vous pouvez utiliser l'API Gemini pour alimenter le backend de votre application, un outil distinct pour résumer les notes de réunion et une troisième plateforme pour gérer vos tâches de sprint. Ce réseau de contextes dispersés et d'outils cloisonnés est ce qu'on appelle la « prolifération de l'IA ».

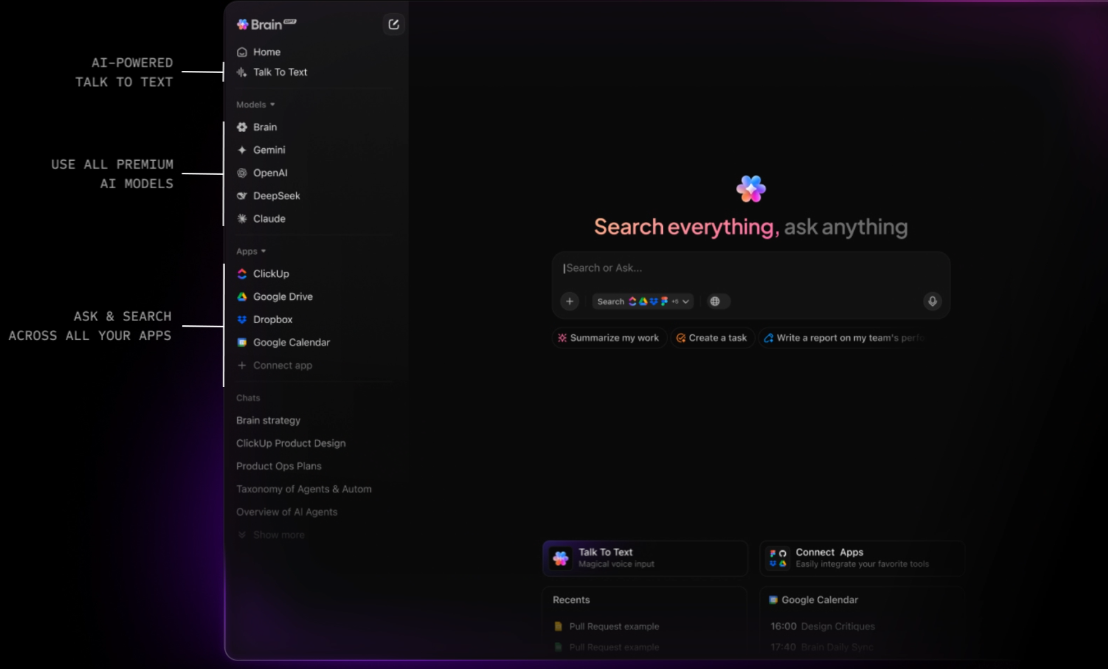

ClickUp est le premier espace de travail IA convergent qui relie vos tâches, vos documents et vos collaborateurs à une couche d'intelligence centrale. Contrairement aux API autonomes qui vous obligent à créer vos propres systèmes de récupération de contexte (RAG), ClickUp Brain « connaît » déjà tout ce qui se trouve dans votre environnement de travail.

Comme l'IA est intégrée en natif, elle ne se contente pas de « générer du texte » : elle comprend la relation entre votre documentation API Gemini, les échéances de vos projets et la progression en temps réel de votre équipe.

Activez « Ask IA » où que vous soyez et déployez des agents autonomes

La véritable puissance de ClickUp réside dans sa capacité à transformer les connaissances en actions. Avec ClickUp Brain, vous pouvez « demander à l'IA » depuis n'importe où dans votre environnement de travail, ou même via un compagnon de bureau pendant que vous écrivez du code dans votre IDE. Vous pouvez instantanément mettre en évidence les risques liés à un projet en demandant : « Quels ont été les commentaires sur la dernière implémentation de Gemini 3 Pro ? » ClickUp Brain effectuera une recherche approfondie dans tout votre historique et vous fournira une réponse citée avec des liens vers la tâche ou le fil de discussion exact où la discussion a eu lieu.

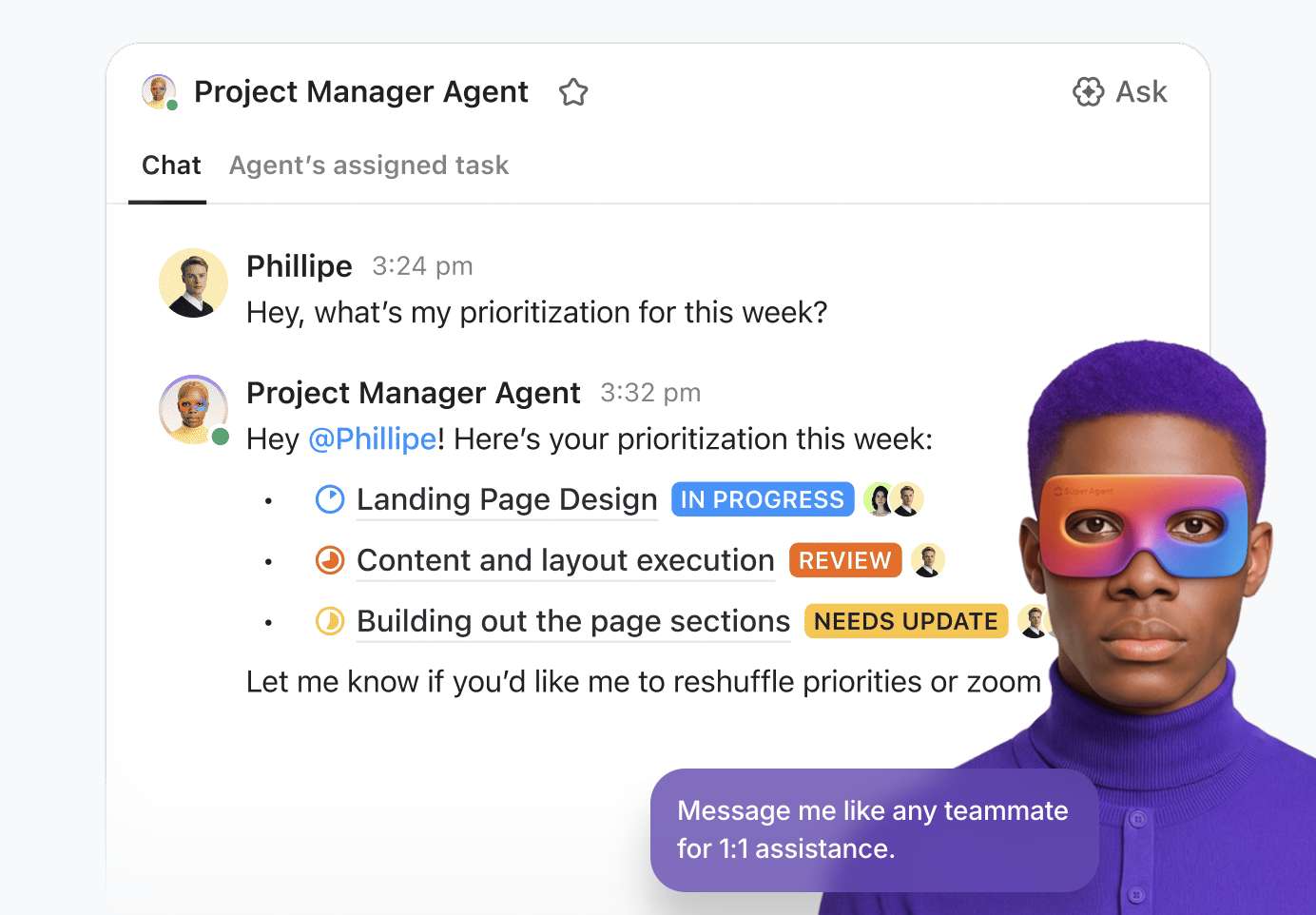

Pour les équipes qui développent des produits IA complexes, ClickUp va au-delà de la simple assistance en vous permettant de déployer des Super Agents . Il s'agit de coéquipiers numériques autonomes et sans code qui gèrent les tâches fastidieuses de votre cycle de développement. Vous pouvez configurer un agent de triage pour surveiller les bogues entrants provenant de votre intégration Gemini, ou un agent de gestion de projet qui identifie de manière proactive les obstacles au sprint et génère des résumés quotidiens basés sur l'activité de votre équipe. Il s'agit d'un système intelligent qui permet à votre pipeline de développement de fonctionner 24 heures sur 24, 7 jours sur 7.

Une plateforme de gestion du travail unifiée pour les développeurs modernes

ClickUp Docs sert de cahier technique partagé à votre équipe. Que vous rédigiez un PRD pour une nouvelle fonctionnalité multimodale ou que vous stockiez vos protocoles de sécurité API Gemini, tout reste connecté.

Une ligne de code dans un document peut instantanément devenir une tâche, et ClickUp Brain vous permet d'utiliser Enterprise Search pour récupérer des fichiers et des discussions à partir d'applications connectées telles que Google Workspace, GitHub et Figma à l'aide d'une recherche sémantique.

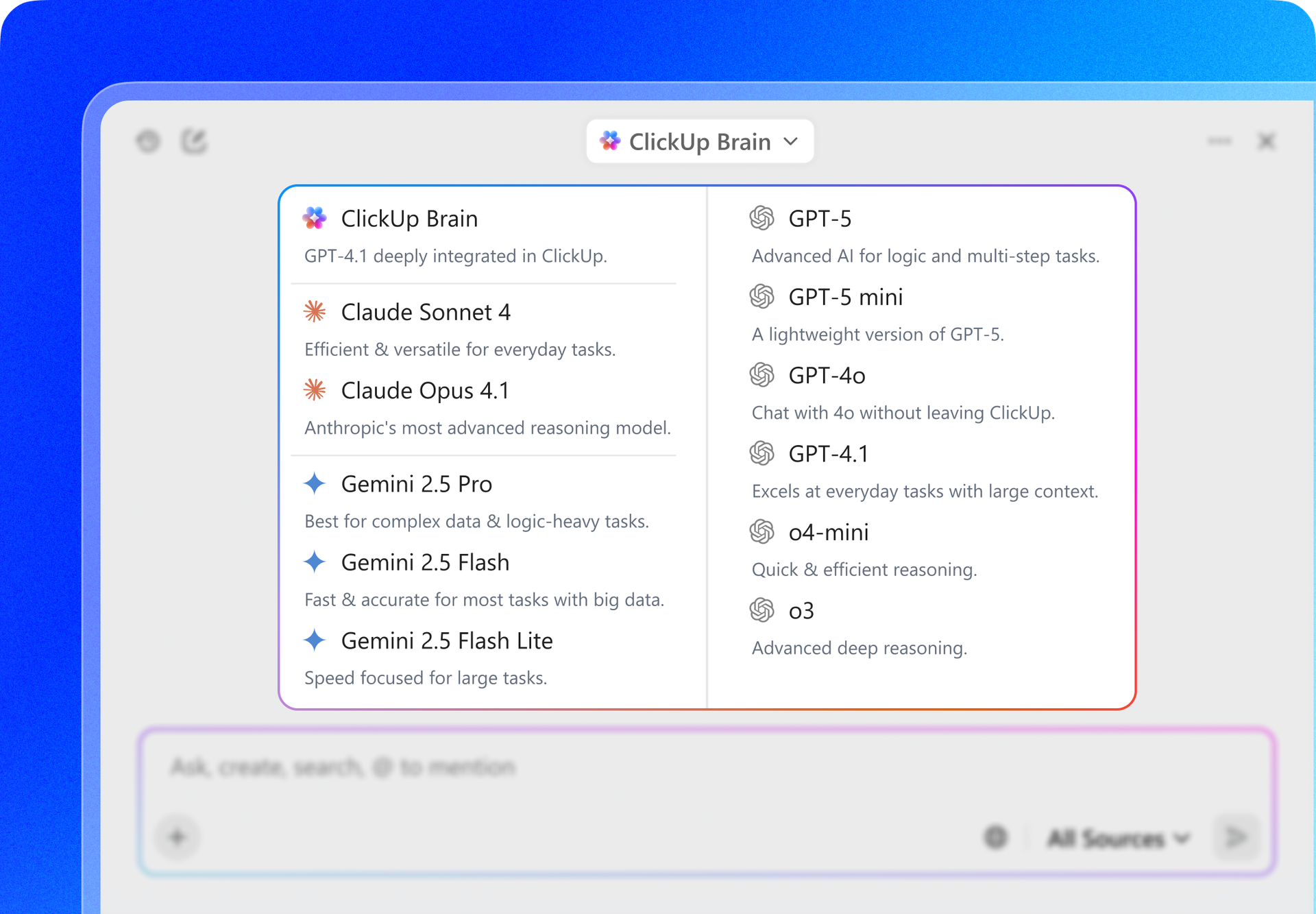

De plus, ClickUp offre une flexibilité multimodèle. Pendant que vous créez avec l'API Gemini, vous pouvez utiliser l'interface de ClickUp pour activer/désactiver Gemini 3, GPT-5. 2 et Claude 4. 5 afin de comparer les résultats ou de rédiger des spécifications techniques. Cela vous garantit de toujours disposer du meilleur « cerveau » pour la tâche à accomplir sans jamais quitter votre environnement de gestion de projet.

Les meilleures fonctionnalités de ClickUp

Limitations de ClickUp

Tarifs ClickUp

Évaluations et avis sur ClickUp

Que disent les utilisateurs réels à propos de ClickUp ?

Un avis d'utilisateur dit :

Les modèles, champs personnalisés, priorités, points scrum, plans et diverses options d'affichage de ClickUp, malgré une légère courbe d'apprentissage, ont permis à notre équipe d'adapter l'outil à nos besoins en constante évolution et d'optimiser notre efficacité. Ses puissantes intégrations avec des outils tels que Google Drive, les réunions, les calendriers et la prise en charge robuste de l'API améliorent notre flux de travail de manière transparente. De plus, les formulaires ClickUp apportent une valeur ajoutée considérable à nos opérations. Dans l'ensemble, tout dans ClickUp est si puissant et utile que je ne voudrais rien changer. Je suis convaincu que ClickUp a été développé en tenant compte des préférences des utilisateurs, ce qui le rend parfait pour nos besoins.

L'avantage ClickUp : au lieu d'écrire du code pour établir la connexion entre votre base de données et un LLM, BrainGPT, la super application IA autonome de ClickUp, agit comme une interface indépendante du modèle déjà connectée à vos tâches, vos documents et vos référentiels de code.

Cela vous permet de :

La plateforme API d'OpenAI reste le principal concurrent des développeurs qui créent des applications complexes et « intelligentes ». Avec la sortie de la série GPT-5. 2, OpenAI s'est orienté vers le « raisonnement agentique », où le modèle s'interrompt automatiquement pour valider sa logique avant de répondre.

Contrairement à l'intégration étroite de Gemini avec Google Workspace, OpenAI propose une approche « Foundry » plus modulaire, ce qui en fait le choix préféré des développeurs qui recherchent une plateforme indépendante des fournisseurs et évolutive sur différents fournisseurs de cloud tels qu'Azure et AWS.

Gemini 3 Flash, en revanche, offre un traitement vidéo nettement plus rapide et une fenêtre contextuelle beaucoup plus grande de 2 millions de jetons, alors que GPT-5. 2 limite actuellement son contexte natif à 400 000 jetons.

Meilleures fonctionnalités de l'API OpenAI

Limitations de l'API OpenAI

Tarifs de l'API OpenAI

Évaluations et avis sur l'API OpenAI

Que disent les utilisateurs réels à propos d'OpenAI ?

Un avis d'utilisateur dit :

Nous avons été extrêmement impressionnés par les modèles d'IA et, en particulier, par l'accès à l'API. En intégrant OpenAI à nos solutions CRM (BROSH CRM), nous sommes en mesure d'offrir une valeur réelle et tangible à nos clients grâce à l'automatisation basée sur l'IA. OpenAI permet à BROSH CRM de fournir des fonctionnalités avancées basées sur l'IA dans de nombreux domaines. Nos clients bénéficient de réponses IA de haute qualité et personnalisées au contexte dans leurs canaux de communication, générées directement à partir des données CRM. Cela améliore considérablement les interactions avec les clients tout en permettant un gain de temps et de ressources.

📖 En savoir plus : Comment utiliser l'API ChatGPT pour vos applications

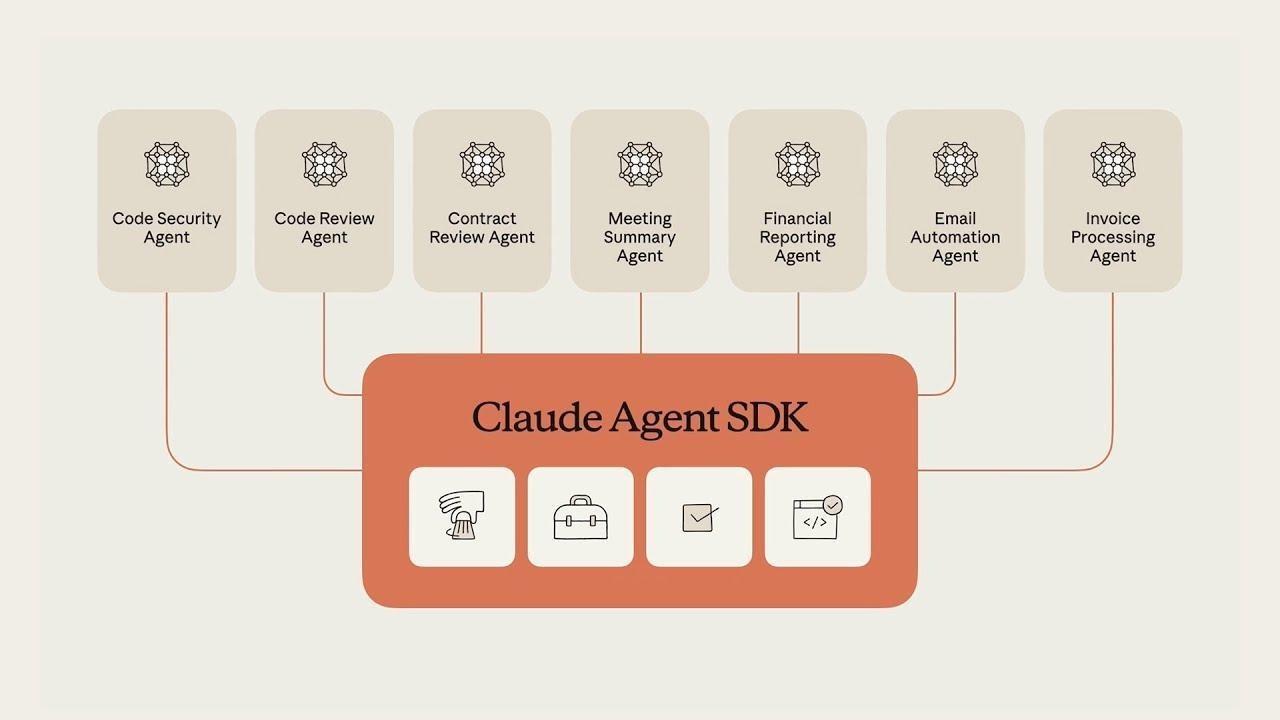

Claude, développé par Anthropic, est l'alternative incontournable pour les développeurs qui privilégient la précision technique et le raisonnement « humain ». Claude 4. 5 Sonnet est largement considéré comme le modèle le plus fiable pour l'ingénierie logicielle, surpassant régulièrement les autres sur les benchmarks de codage tels que SWE-bench.

L'une de ses fonctionnalités phares est Claude Code, un outil CLI agentique qui permet au modèle d'interagir directement avec votre terminal local et votre système de fichiers pour déboguer et expédier du code.

Gemini 3 Pro excelle dans le traitement simultané de quantités massives de données (comme une vidéo d'une heure), mais Claude est souvent préféré pour les tâches où l'« ambiance » et la précision du résultat sont plus importantes que le volume de données traitées.

Les meilleures fonctionnalités de l'API Claude

Limitations de l'API Claude

Tarifs de l'API Claude

Évaluations et avis sur l'API Claude

Que disent les utilisateurs réels à propos de l'API Claude ?

Un avis d'utilisateur dit :

Les frais d'utilisation de l'API sont plus élevés que ceux de ChatGPT ou Gemini, mais si vous souhaitez simplement poser des questions, vous pouvez utiliser la version de bureau, ce qui n'est pas très contraignant. Cependant, ce n'est pas la meilleure option si vous souhaitez l'intégrer à une application.

📖 En savoir plus : Comment utiliser Claude IA pour un codage efficace et précis

Mistral AI fournit des modèles haute performance qui offrent une alternative aux systèmes « fermés » de Google et OpenAI. Il est considéré comme un leader pour les entreprises qui ont besoin de souveraineté en matière de données ou qui souhaitent déployer des modèles sur leur propre infrastructure privée.

Les modèles phares de Mistral, tels que Mistral Large 3, sont conçus pour être efficaces et « sans filtre », offrant aux développeurs un meilleur contrôle sur le comportement du modèle par rapport aux garde-fous de sécurité plus stricts que l'on trouve souvent dans Gemini ou Claude.

Les meilleures fonctionnalités de Mistral IA

Limitations de Mistral IA

Tarifs de Mistral IA

Évaluations et avis sur Mistral IA

Que disent les utilisateurs réels à propos de Mistral IA ?

Un avis d'utilisateur dit :

J'ai posé une question sur un personnage historique de notre pays. GEMINI a correctement distingué deux personnes très différentes portant le même prénom et le même nom : l'une était historienne et professeure d'université, l'autre était un résistant déporté pendant la Seconde Guerre mondiale. Mistral IA ne m'a donné que la description de la première.

Autres outils d'IA à utiliser

Bien que l'API Gemini soit une puissance multimodale, la création d'une application prête à la production nécessite souvent une stratégie multimodèle. En fonction des besoins spécifiques de votre projet en matière de profondeur de raisonnement ou de précision de codage, vous pouvez vous tourner vers ces alternatives à Gemini.

1. ClickUp (idéal pour les équipes qui ont besoin d'une IA contextuelle intégrée à leur flux de travail)

La plupart des outils d'IA promettent de faciliter le développement, mais ils finissent souvent par n'être qu'un onglet supplémentaire dans une pile déjà bien remplie. Vous pouvez utiliser l'API Gemini pour alimenter le backend de votre application, un outil distinct pour résumer les notes de réunion et une troisième plateforme pour gérer vos tâches de sprint. Ce réseau de contextes dispersés et d'outils cloisonnés est ce qu'on appelle la « prolifération de l'IA ».

ClickUp est le premier espace de travail IA convergent qui établit la connexion entre vos tâches, vos documents et vos collaborateurs à une couche d'intelligence centrale. Contrairement aux API autonomes qui vous obligent à créer vos propres systèmes de récupération de contexte (RAG), ClickUp Brain « connaît » déjà tout ce qui se trouve dans votre environnement de travail.

Comme l'IA est intégrée en natif, elle ne se contente pas de « générer du texte » : elle comprend la relation entre votre documentation API Gemini, les échéances de vos projets et la progression en temps réel de votre équipe.

Activez « Ask IA » où que vous soyez et déployez des agents autonomes

La véritable puissance de ClickUp réside dans sa capacité à transformer les connaissances en actions. Avec ClickUp Brain, vous pouvez « demander à l'IA » depuis n'importe où dans votre environnement de travail, ou même via un compagnon de bureau pendant que vous écrivez du code dans votre IDE. Vous pouvez instantanément mettre en évidence les risques liés à un projet en demandant : « Quels ont été les commentaires sur la dernière implémentation de Gemini 3 Pro ? » ClickUp Brain effectuera une recherche approfondie dans tout votre historique et vous fournira une réponse citée avec des liens vers la tâche ou le fil de discussion exact où la discussion a eu lieu.

Pour les équipes qui développent des produits IA complexes, ClickUp va au-delà de la simple assistance en vous permettant de déployer des Super Agents . Il s'agit de coéquipiers numériques autonomes et sans code qui gèrent les tâches fastidieuses de votre cycle de développement. Vous pouvez configurer un agent de triage pour surveiller les bogues entrants provenant de votre intégration Gemini, ou un agent de gestion de projet qui identifie de manière proactive les obstacles au sprint et génère des résumés quotidiens basés sur l'activité de votre équipe. Il s'agit d'un système intelligent qui permet à votre pipeline de développement de fonctionner 24 heures sur 24, 7 jours sur 7.

Une plateforme de gestion du travail unifiée pour les développeurs modernes

ClickUp Docs sert de cahier technique partagé à votre équipe. Que vous rédigiez un PRD pour une nouvelle fonctionnalité multimodale ou que vous stockiez vos protocoles de sécurité API Gemini, tout reste connecté.

Une ligne de code dans un document peut instantanément devenir une tâche, et ClickUp Brain vous permet d'utiliser Enterprise Search pour récupérer des fichiers et des discussions à partir d'applications connectées telles que Google Workspace, GitHub et Figma à l'aide d'une recherche sémantique.

De plus, ClickUp offre une flexibilité multimodèle. Pendant que vous créez avec l'API Gemini, vous pouvez utiliser l'interface de ClickUp pour activer/désactiver Gemini 3, GPT-5. 2 et Claude 4. 5 afin de comparer les résultats ou de rédiger des spécifications techniques. Cela vous garantit de toujours disposer du meilleur « cerveau » pour la tâche à accomplir sans jamais quitter votre environnement de gestion de projet.

Les meilleures fonctionnalités de ClickUp

- Recherche universelle et Ask AI : récupérez instantanément des données sur ClickUp, Slack, GitHub et Drive, ou demandez à l'IA de résumer n'importe quel document ou fil de discussion à partir de n'importe quel endroit de l'espace de travail.

- Agents sans code : déployez des agents sans code pour automatiser la création de tâches, les mises à jour de statut et la création de rapports, transformant ainsi la gestion de projet manuelle en un flux de travail autonome.

- Chat IA intégré : mentionnez @Brain dans n'importe quel fil de discussion ClickUp Chat pour transformer instantanément une discussion en une tâche formatée ou pour obtenir un résumé d'une longue discussion.

- Tableaux de bord alimentés par l'IA : visualisez la santé de votre équipe grâce à des tableaux de bord en temps réel qui utilisent l'IA pour identifier les risques liés aux sprints, prévoir les retards et expliquer les tendances des données dans un langage simple.

- AI Writer for Docs : rédigez des cahiers des charges techniques, des procédures opératoires normalisées et des agendas de réunion préremplis avec les données et le contexte spécifiques à votre projet.

Limitations de ClickUp

- L'efficacité de l'IA dépend de l'hygiène de votre environnement de travail ; si votre équipe ne met pas à jour les tâches et les documents, l'IA dispose de moins de « contexte » pour élaborer ses réponses.

Tarifs ClickUp

Évaluations et avis sur ClickUp

- G2 : 4,7/5 (plus de 10 900 avis)

- Capterra : 4,6/5 (plus de 4 500 avis)

Que disent les utilisateurs réels à propos de ClickUp ?

Un avis d'utilisateur dit :

Les modèles, champs personnalisés, priorités, points scrum, plans et diverses options d'affichage de ClickUp, malgré une légère courbe d'apprentissage, ont permis à notre équipe d'adapter l'outil à nos besoins en constante évolution et d'optimiser notre efficacité. Ses puissantes intégrations avec des outils tels que Google Drive, les réunions, les calendriers et la prise en charge robuste de l'API améliorent notre flux de travail de manière transparente. De plus, les formulaires ClickUp apportent une valeur ajoutée considérable à nos opérations. Dans l'ensemble, tout dans ClickUp est si puissant et utile que je ne voudrais rien changer. Je suis convaincu que ClickUp a été développé en tenant compte des préférences des utilisateurs, ce qui le rend parfait pour nos besoins.

Les modèles, champs personnalisés, priorités, points scrum, plans et diverses options d'affichage de ClickUp, malgré une légère courbe d'apprentissage, ont permis à notre équipe d'adapter l'outil à nos besoins en constante évolution et d'optimiser notre efficacité. Ses puissantes intégrations avec des outils tels que Google Drive, les réunions, les calendriers et la prise en charge robuste de l'API améliorent notre flux de travail de manière transparente. De plus, les formulaires ClickUp apportent une valeur ajoutée considérable à nos opérations. Dans l'ensemble, tout dans ClickUp est si puissant et utile que je ne voudrais rien changer. Je suis convaincu que ClickUp a été développé en tenant compte des préférences des utilisateurs, ce qui le rend parfait pour nos besoins.

L'avantage ClickUp : au lieu d'écrire du code pour connecter votre base de données à un LLM, BrainGPT, la super application IA autonome de ClickUp, agit comme une interface indépendante du modèle déjà connectée à vos tâches, vos documents et vos référentiels de code.

Cela vous permet de :

- Activez/désactivez les modèles : utilisez Gemini 3 pour les tâches contextuelles massives de 2 millions de tokens, puis passez à Claude 4. 5 pour une précision de codage optimale, le tout dans la même fenêtre.

- Recherche unifiée : posez la question « Quelles étaient les spécifications finales en matière de sécurité API discutées lors de la réunion du mois dernier ? » et obtenez une réponse fondée provenant simultanément de Slack, GitHub et ClickUp Docs.

- Talk-to-Text : Utilisez l'application de bureau BrainGPT pour dicter des commandes telles que « Rédigez un ticket Jira pour l'intégration Gemini et attribuez-le au développeur principal » — aucun clavier n'est nécessaire

2. API OpenAI (idéale pour l'intelligence générale et le raisonnement agentique)

La plateforme API d'OpenAI reste le principal concurrent des développeurs qui créent des applications complexes et « intelligentes ». Avec la sortie de la série GPT-5. 2, OpenAI s'est orienté vers le « raisonnement agentique », où le modèle s'interrompt automatiquement pour valider sa logique avant de répondre.

Contrairement à l'intégration étroite de Gemini avec Google Workspace, OpenAI propose une approche « Foundry » plus modulaire, ce qui en fait le choix préféré des développeurs qui recherchent une plateforme indépendante des fournisseurs et évolutive sur différents fournisseurs de cloud tels qu'Azure et AWS.

Gemini 3 Flash, en revanche, offre un traitement vidéo nettement plus rapide et une fenêtre contextuelle beaucoup plus grande de 2 millions de tokens, alors que GPT-5. 2 limite actuellement son contexte natif à 400 000 tokens.

Meilleures fonctionnalités de l'API OpenAI

- Utilisez le mode réflexion pour traiter des problèmes complexes en plusieurs étapes qui nécessitent une vérification interne avant de générer une réponse finale.

- Accédez à l'API en temps réel pour créer des expériences multimodales à faible latence, y compris des interactions natives de la parole à la parole.

- Tirez parti de l'API de recherche de fichiers (Vector Store) pour créer des systèmes RAG (Retrieval-Augmented Generation) avec gestion intégrée des documents.

Limitations de l'API OpenAI

- L'utilisation peut rapidement devenir coûteuse si elle n'est pas surveillée attentivement, en particulier lorsque vous utilisez des modèles à haut niveau de raisonnement comme GPT-5. 2 Pro

Tarifs de l'API OpenAI

- GPT-5. 2 : 1,75 $/1 million d'entrées | 14,00 $/1 million de sorties

- GPT-5. 2 Pro : 21,00 $/1 million d'entrées | 168,00 $/1 million de sorties

- GPT-5 Mini : 0,25 $/1 million d'entrées | 2,00 $/1 million de sorties

Évaluations et avis sur l'API OpenAI

- G2 : 4,7/5 (plus de 840 avis)

- Gartner Peer Insights : 4,4/5 (plus de 60 avis)

Que disent les utilisateurs réels à propos d'OpenAI ?

Un avis d'utilisateur dit :

Nous avons été extrêmement impressionnés par les modèles d'IA et, en particulier, par l'accès à l'API. En intégrant OpenAI à nos solutions CRM (BROSH CRM), nous sommes en mesure d'offrir une valeur réelle et tangible à nos clients grâce à l'automatisation basée sur l'IA. OpenAI permet à BROSH CRM de fournir des fonctionnalités avancées basées sur l'IA dans de nombreux domaines. Nos clients bénéficient de réponses IA de haute qualité et personnalisées dans leurs canaux de communication, générées directement à partir des données CRM. Cela améliore considérablement les interactions avec les clients tout en permettant un gain de temps et de ressources.

Nous avons été extrêmement impressionnés par les modèles d'IA et, en particulier, par l'accès à l'API. En intégrant OpenAI à nos solutions CRM (BROSH CRM), nous sommes en mesure d'offrir une valeur réelle et tangible à nos clients grâce à l'automatisation basée sur l'IA. OpenAI permet à BROSH CRM de fournir des fonctionnalités avancées basées sur l'IA dans de nombreux domaines. Nos clients bénéficient de réponses IA de haute qualité et personnalisées au contexte dans leurs canaux de communication, générées directement à partir des données CRM. Cela améliore considérablement les interactions avec les clients tout en permettant un gain de temps et de ressources.

📖 En savoir plus : Comment utiliser l'API ChatGPT pour vos applications

3. API Claude (idéale pour le codage à haut risque et la rédaction technique nuancée)

Claude, développé par Anthropic, est l'alternative incontournable pour les développeurs qui privilégient la précision technique et le raisonnement « humain ». Claude 4. 5 Sonnet est largement considéré comme le modèle le plus fiable pour l'ingénierie logicielle, surpassant régulièrement les autres sur les benchmarks de codage tels que SWE-bench.

L'une de ses fonctionnalités phares est Claude Code, un outil CLI agentique qui permet au modèle d'interagir directement avec votre terminal local et votre système de fichiers pour déboguer et expédier du code.

Gemini 3 Pro excelle dans le traitement simultané de quantités massives de données (comme une vidéo d'une heure), mais Claude est souvent préféré pour les tâches où l'« ambiance » et la précision du résultat sont plus importantes que le volume de données traitées.

Les meilleures fonctionnalités de l'API Claude

- Effectuez la maintenance d'une logique de projet complexe à l'aide de Claude Projects, qui vous permet de regrouper des documents et du code connexes pour un meilleur contexte.

- Utilisez la mise en cache des instructions pour réduire considérablement les coûts et la latence des requêtes répétitives et volumineuses.

- Exécutez et testez du code en temps réel dans l'environnement du modèle à l'aide de l'outil d'analyse (exécution de code).

Limitations de l'API Claude

- Claude ne dispose actuellement pas d'outils natifs de génération d'images ou de vidéos, ce qui oblige les développeurs à intégrer des API tierces pour les travaux de création visuelle.

Tarifs de l'API Claude

- Claude 4. 5 Opus : 15,00 $/1 million d'entrées | 75,00 $/1 million de sorties

- Claude 4. 5 Sonnet : 3,00 $/1 Mo d'entrée | 15,00 $/1 Mo de sortie

- Claude 4. 5 Haiku : 1,00 $/1 million d'entrées | 5,00 $/1 million de sorties

Évaluations et avis sur l'API Claude

- G2 : 4,4/5 (plus de 55 avis)

- Capterra : 4,6/5 (plus de 20 avis)

Que disent les utilisateurs réels à propos de l'API Claude ?

Un avis d'utilisateur dit :

Les frais d'utilisation de l'API sont plus élevés que ceux de ChatGPT ou Gemini, mais si vous souhaitez simplement poser des questions, vous pouvez utiliser la version de bureau, ce qui n'est pas très contraignant. Cependant, ce n'est pas la meilleure option si vous souhaitez l'intégrer à une application.

Les frais d'utilisation de l'API sont plus élevés que ceux de ChatGPT ou Gemini, mais si vous souhaitez simplement poser des questions, vous pouvez utiliser la version de bureau, ce qui n'est pas très contraignant. Cependant, ce n'est pas la meilleure option si vous souhaitez l'intégrer à une application.

📖 En savoir plus : Comment utiliser Claude IA pour un codage efficace et précis

4. Mistral IA (Idéal pour la flexibilité en matière de poids ouvert et la souveraineté des données)

Mistral IA fournit des modèles haute performance qui offrent une alternative aux systèmes « fermés » de Google et OpenAI. Il est considéré comme un leader pour les entreprises qui ont besoin de souveraineté en matière de données ou qui souhaitent déployer des modèles sur leur propre infrastructure privée.

Les modèles phares de Mistral, tels que Mistral Large 3, sont conçus pour être efficaces et « sans filtre », offrant aux développeurs un meilleur contrôle sur le comportement du modèle par rapport aux garde-fous de sécurité plus stricts que l'on trouve souvent dans Gemini ou Claude.

Les meilleures fonctionnalités de Mistral IA

- Déployez des modèles sur votre propre matériel ou VPC (Virtual Private Cloud) pour une confidentialité et une sécurité maximales des données.

- Utilisez Mistral Memories pour enregistrer et rappeler le contexte clé entre différentes sessions sans avoir à renvoyer manuellement les données.

- Accédez au répertoire des connecteurs pour lier facilement vos modèles à des sources de données externes telles que Notion, GitHub et Slack.

Limitations de Mistral IA

- La documentation et l'assistance communautaire pour Mistral ne sont pas aussi complètes que celles de Google ou OpenAI, ce qui peut entraîner une courbe d'apprentissage plus raide pour les nouveaux développeurs.

Tarifs de Mistral IA

- Mistral Large 3 : 2,00 $/1 million d'entrées | 6,00 $/1 million de sorties

- Mistral Small : 0,20 $/1 million d'entrées | 0,60 $/1 million de sorties

- Mistral Free : accès API limité à des fins de test

Évaluations et avis sur Mistral IA

- G2 : 4,4/5 (avis initiaux limités)

- Capterra : 4,5/5 (avis initiaux limités)

Que disent les utilisateurs réels à propos de Mistral IA ?

Un avis d'utilisateur dit :

J'ai posé une question sur un personnage historique de notre pays. GEMINI a correctement distingué deux personnes très différentes portant le même prénom et le même nom : l'une était historienne et professeure d'université, l'autre était un résistant déporté pendant la Seconde Guerre mondiale. Mistral IA ne m'a donné que la description de la première.

J'ai posé une question sur un personnage historique de notre pays. GEMINI a correctement distingué deux personnes très différentes portant le même prénom et le même nom : l'une était historienne et professeure d'université, l'autre était un résistant déporté pendant la Seconde Guerre mondiale. Mistral IA ne m'a donné que la description de la première.

Les API simplifiées avec ClickUp

La prise en main de l'API Google Gemini est simple : vous obtenez une clé API, installez un SDK et effectuez votre premier appel API. Mais lorsque vous passez d'un simple script à une application de production, les véritables défis apparaissent : gérer les clés API, documenter les invites et organiser le travail de votre équipe.

L'API Gemini offre de puissantes capacités d'IA, mais son intégration dans votre flux de travail peut entraîner une documentation dispersée, un suivi fragmenté des projets et des changements de contexte incessants.

Les équipes qui centralisent leur développement IA parallèlement à la gestion des tâches et à la documentation avancent plus rapidement et conservent un meilleur contexte. Le choix de l'endroit où vous organisez ce travail déterminera votre capacité à innover et à collaborer efficacement.

Commencez gratuitement avec ClickUp et découvrez comment un environnement de travail convergent peut transformer votre processus de développement IA.

Foire aux questions sur l'API Gemini

Oui, Google propose une offre gratuite généreuse pour Gemini 3 Flash et Pro via Google AI Studio. Cependant, les outils spécialisés tels que Google Search Grounding sont payants (14 $ pour 1 000 requêtes) après vos 5 000 premières requêtes chaque mois.

Google AI Studio est un outil web permettant d'expérimenter des invites et de générer rapidement des clés API. L'API Gemini est l'interface programmatique que vous utilisez dans votre code pour intégrer ces capacités d'IA dans vos propres applications.

Oui, l'API Gemini prend en charge les discussions à plusieurs tours, ce qui en fait un excellent choix pour créer des chatbots internes, des bots de service client ou des assistants d'équipe. Vous utiliseriez l'API comme le « cerveau » du chatbot et créeriez l'interface utilisateur séparément.

Les limites de fréquence varient en fonction du modèle que vous utilisez et selon que vous bénéficiez d'un abonnement gratuit ou d'un forfait payant. L'abonnement gratuit impose des limites plus strictes en termes de requêtes par minute, tandis que les forfaits payants offrent un débit plus élevé pour les applications de production.